Материалы по тегу: s

|

30.01.2024 [14:25], Сергей Карасёв

ICANN предлагает создать домен .Internal для локальных сетейКорпорация по управлению доменными именами и IP-адресами (ICANN) организовала общественное обсуждение предложения по созданию доменной зоны верхнего уровня (TLD) .Internal, предназначенной для частного использования и локальных (внутренних) сетей. Идея состоит в том, что .Internal будет выполнять те же функции, что и, например, IPv4-блок 192.168.x.x. Этот диапазон не используется в общедоступном интернете. Указанные адреса предназначены для применения исключительно в локальных сетях, а их распределение никем не контролируется.

Источник изображения: pixabay.com Консультативный комитет ICANN по безопасности и стабильности (SSAC) рекомендовал создать домен верхнего уровня вроде .Internal в 2020 году. Тогда отмечалось, что многие предприятия и поставщики устройств специально используют TLD, которых нет в корневой зоне, когда им необходимы имена для частного применения. Однако такая практика является нескоординированной и, как утверждается, может нанести вред пользователям интернета — отчасти из-за того, что DNS-серверы вынуждены обрабатывать и отклонять запросы к доменам, используемым только в локальных сетях. Вместе с тем DNS-серверы не могут предотвратить внутреннее использование специальных TLD. Поэтому SSAC рекомендует создать домен, который изначально зарезервирован для локальных сетей. На этапе дебатов были получены 35 предложений по названию такого TLD. Оценки проводились для всех шести языков ООН: английского, арабского, испанского, китайского, русского и французского. В ходе обсуждения многие кандидаты «были признаны неподходящими из-за отсутствия значимости». В итоге, остались два подходящих варианта: .Private и .Internal. При этом .Private решено отклонить, поскольку это имя может ассоциироваться с завышенным уровнем приватности и вызывать противоречия. После получения обратной связи и отзывов от участников рынка правление ICANN, как планируется, одобрит создание домена .Internal.

29.01.2024 [19:39], Сергей Карасёв

Eviden и Microsoft сообща займутся облачными технологиями и ИИКомпания Eviden, дочерняя структура Atos, и корпорация Microsoft объявили о заключении соглашения о стратегическом партнёрстве сроком на пять лет. Договор охватывает облачную сферу, а также решения на основе ИИ для промышленного сектора. Договор, как отмечается, поможет сторонам в реализации стратегии, нацеленной на цифровую трансформацию и расширение бизнес-возможностей с помощью передовых технологий. В рамках партнёрства компании намерены совместно разрабатывать и внедрять продукты для анализа больших данных и ИИ, а также облачные сервисы. Ожидается, что сотрудничество поможет Eviden привлечь дополнительно $2,8 млрд на расширение облачных услуг. Достичь этого планируется путём развития таких направлений, как финансовые услуги, автомобилестроение, производство, энергетика, коммунальные услуги, здравоохранение, науки о жизни и государственный сектор. По условиям договора, Eviden и Microsoft откроют несколько совместных отраслевых центров инноваций, что позволит ускорить исследования и разработки в области генеративного ИИ. Eviden намерена повышать квалификацию своих сотрудников по всему миру. В частности, будут получены более 16 тыс. новых сертификатов Microsoft в течение следующих пяти лет. Eviden также планирует расширить бизнес, связанный с продуктами Microsoft, создав более 50 команд со специалистами по продажам и поддержке, а также архитекторами решений в приоритетных странах, включая Северную Америку, Великобританию, Германию, Францию, Испанию, Нидерланды, Бельгию, Австрию и Швейцарию. Eviden ускорит развитие средств обеспечения безопасности с помощью платформы AIsaac (MDR) и других технологий Microsoft. Запланировано использование облачных приложений на базе GenAI Launchpad и внедрение Copilot.

29.01.2024 [16:46], Руслан Авдеев

AWS получила разрешение на строительство кампуса ЦОД в чилийской столицеAmazon Web Services (AWS) получила «добро» на реализацию в столице Чили проекта строительства ЦОД стоимостью $205 млн. По данным Datacenter Dynamics, кампус в Сантьяго будет первым, построенным Amazon в Южной Америке. Строительство будет проводиться в два этапа и начнётся уже в марте 2024-го. Ёмкость ЦОД объявят позже. Кампус будет построен на участке площадью 18,7 га в районе Padre Hurtado. Там разместятся здания ЦОД, а также 12 резервных дизельных генераторов и система кондиционирования с низким уровнем потребления воды. Наконец, на объекте будут смонтированы системы охлаждения и пожарной безопасности. Возведение первой очереди ЦОД площадью 4630 м2 намерены завершить в апреле следующего года, а в эксплуатацию его введут месяцем позже. Вторая очередь площадью 3470 м2 будет готова в 2028 году. Возможность строительства дата-центра в Чили рассматривалась как минимум с 2017 года. В январе прошлого года компания запустила в Сантьяго небольшую локальную зону. Проект крупного ЦОД был предложен в 2022 году, но только сейчас его, наконец, одобрил местный природоохранный надзорный орган Servicio de Evaluación Ambiental de la República de Chile (SEA). Oracle тем временем запустила в Чили уже второй облачный регион.

28.01.2024 [00:16], Сергей Карасёв

AWS потратит $10 млрд на создание в США кампусов ЦОД общей площадью 688 гаОблачная платформа Amazon Web Services (AWS), по сообщению ресурса Datacenter Dynamics, займётся реализацией крупного проекта по строительству сети дата-центров в округе Мадисон (Миссисипи, США). Инициатива получила название «Проект Атлас» (Project Atlas). Суммарные затраты оцениваются в $10 млрд. «Проект Атлас» уже одобрен на законодательном уровне, причём власти утвердили ряд стимулирующих мер. Это, в частности, 100 % освобождение от корпоративного подоходного налога на 10 лет, а также налоговые льготы на продажи и любые инвестиции, сделанные в течение 12 месяцев после завершения проекта. Amazon также получит возврат в размере 3,15 % от затрат на строительство и полное освобождение от налога на продажи и использование оборудования. Более того, компания получит 30-летнее освобождение от налогов при условии, что будет ежегодно инвестировать в регионе как минимум $500 млн и открывать по 50 дополнительных рабочих мест. В результате Amazon начнёт платить подоходный налог через 10 лет, а все налоговые льготы прекратят своё действие только в 2057 году. Согласно обнародованным данным, инвестиции Amazon предусматривают создание ряда кампусов ЦОД в двух промышленных зонах округа Мэдисон, что позволит сформировать не менее 1 тыс. рабочих мест. Эти дата-центры займут в общей сложности площадь около 688 га. Ожидается, что в проект будут вовлечены 6–7 тыс. строителей. Завершить работы планируется к 2027 году. Питанием новые объекты обеспечит энергетическая компания Entergy Mississippi. Для этого будут развёрнуты дополнительные солнечные фермы в Хиндсе, Вашингтоне и Таллахатчи. Ожидается, что Entergy Mississippi вложит в эти площадки от $2 до $3 млрд. Amazon утверждает, что с 2010 года она инвестировала $2,3 млрд в проекты, включающие пять солнечных ферм и ветряную электростанцию в Миссисипи. Кроме того, Amazon пообещала создать различные обучающие программы, в том числе бесплатные, в области сетевых инфраструктур, дата-центров и облаков для старшеклассников, студентов и преподавателей местных образовательных организаций.

27.01.2024 [22:18], Сергей Карасёв

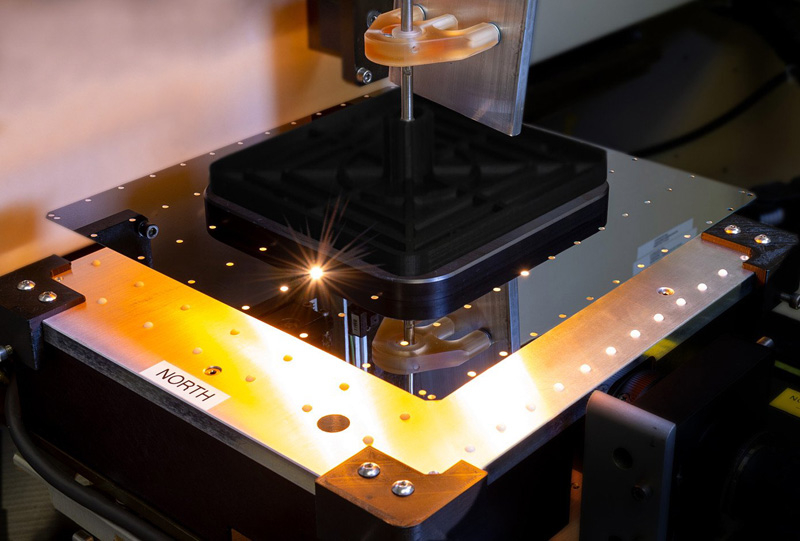

Разработчик гигантских ИИ-чипов Cerebras намерен провести IPO во II половине 2024 годаАмериканский стартап Cerebras Systems, занимающийся разработкой чипов для систем машинного обучения и других ресурсоёмких задач, по информации Bloomberg, намерен осуществить первичное публичное размещение акций (IPO) во II половине текущего года. Соответствующие переговоры уже ведутся с консультантами. Cerebras была основана в 2015 году. Она является разработчиком интегрированных чипов WSE (Wafer Scale Engine) размером с кремниевую пластину, которые содержат сотни тысяч тензорных ядер для работы с крупными ИИ-моделями. Компания осуществила несколько раундов финансирования, получив оценку на уровне $4 млрд. В число инвесторов входят Alpha Wave Ventures, Altimeter, Benchmark, Coatue, Eclipse, Moore и VY.

Источник изображения: Cerebras Как сообщает Bloomberg, ссылаясь на информацию, полученную от осведомлённых источников, Cerebras ведёт переговоры о дополнительном привлечении средств в частном порядке перед IPO. Ожидается, что в рамках выхода на биржу оценочная стоимость стартапа превысит $4 млрд. Переговоры на тему публичного размещения акций продолжаются, но окончательное решение по данному вопросу пока не принято. В июле 2023 года Cerebras объявила о создании первого из девяти запланированных ИИ-суперкомпьютеров. Система под названием Condor Galaxy 1 (CG-1) стоимостью $100 млн расположена в Санта-Кларе (Калифорния, США). Она обеспечивает производительность FP16 на уровне 2 Эфлопс. В проекте приняла участие холдинговая группа G42 из ОАЭ. Кроме того, Cerebras сообщила о намерении поддержать пилотный проект Национального исследовательского ресурса по искусственному интеллекту (NAIRR), который реализуется Национальным научным фондом США (NSF). Cerebras предоставит специалистам NAIRR удалённый доступ к вычислительным ресурсам своего суперкомпьютера.

26.01.2024 [21:42], Руслан Авдеев

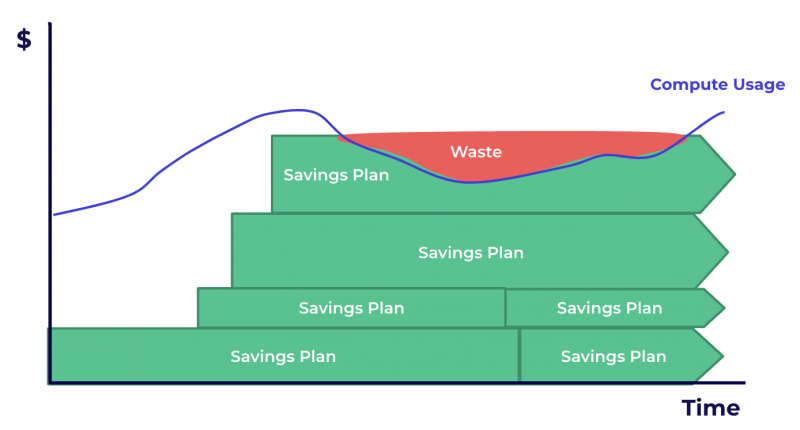

Клиенты AWS ежегодно теряют миллиарды долларов из-за неоптимального использования облакаБолее половины организаций, пользующихся облачными сервисами AWS, могли бы существенно сэкономить, следует из доклада ProsperOps — в совокупности клиенты ежегодно теряют до $20 млрд из-за недостаточного внимания к тарификации. В рамках исследования были изучены обезличенные данные сотен аккаунтов AWS. Выяснилось, что менее половины компаний использовали доступные им скидки или иные возможности для сокращения расходов. При этом «облачный перерасход» — хорошо задокументированный феномен. Проведённое в прошлом году компанией HashiCorp исследование показало, что 94 % предприятий признали тот факт, что они зря тратят часть денег на облачные сервисы из-за избыточного выделения ресурсов или недоиспользования имеющихся. Дело осложняется и крайне запутанной системой тарификации облачных ресурсов. Между тем у AWS имеются разнообразные методы формирования цен. Наиболее известны т.н. Savings Plans, в рамках которых можно заказать заданный объём ресурсов на длительный срок, получив существенную скидку. В докладе указывается, что 38 % организаций пользуются подобной скидкой — поскольку её легко применять и рассчитывать. Однако если фактическое использование окажется ниже ожидаемого, разницу в расходах AWS не вернёт. 18 % организаций прибегают к планам Standard Reserved Instances, где также даётся существенная скидка в обмен на заблаговременное резервирование EC2-инстансов. Ограничений в случае применения подобного тарифа больше, но имеются и некоторые преимущества, вроде возможности как покупать, так и продавать инстансы другим клиентам AWS. Наконец, реже всего используются Convertible Reserved Instances, хотя как раз они обеспечивают наиболее гибкий подход к освоению ресурсов, но ими пользуются только 14 % из опрошенных организаций. Эксперты уверены, что наиболее эффективными в плане экономии являются Convertible Reserved Instances и Savings Plans. Однако на практике не всем умеют грамотно пользоваться этими опциями. Более того, компании, расходующие в год менее $1 млн на облачную инфраструктуру, как выяснилось, ещё и наименее эффективно расходуют средства, тогда как крупные заказчики (более $5 млн/год) гораздо более аккуратно подходят к тратам.

25.01.2024 [15:21], Руслан Авдеев

Danfoss поможет Google охладить дата-центры и утилизировать их тепло, а Google упростит работу Danfoss с помощью ИИКомпания Danfoss заключила с Google соглашение о внедрении в ЦОД последней новых систем охлаждения. Как сообщает пресс-служба Danfoss, решения компании помогут утилизировать избыточное тепло дата-центров, а Google в рамках партнёрства обеспечит доступ к своим ИИ-сервисам. Это позволит оптимизировать взаимодействие Danfoss с с клиентами, внутренние рабочие процессы и поднять производительность в целом. Danfoss разрабатывает системы охлаждения, отопления, преобразования энергии, управления двигателями и иное промышленное оборудование. В дата-центрах Google компания намерена внедрить малошумные безмасляные компрессоры Turbocor с магнитными подшипниками, применяемые в системах воздушного или водяного охлаждения. Дополнительно будут использоваться модули Danfoss для повторного использования тепла, которые обеспечат «зелёный» обогрев не только помещений самой Google, но и расположенных поблизости коммерческих и жилых строений. Применение ИИ-решений Google позволит Danfoss оптимизировать внутренние операции и пользовательский опыт. Например, ИИ можно применять для сбора информации, автоматизации базы знаний, а также создания описаний продуктов и использования чат-ботов в электронной коммерции. Как заявляют в Google, речь идёт о сотрудничестве с лидером в создании энергоэффективных систем, именно такие решения помогут выполнить цель техногиганта по полному переводу ЦОД на «безуглеродную» энергию к 2030 году. В Danfoss также подчеркнули, что ИИ поможет произвести революцию в строительстве и декарбонизации ЦОД. Ранее Google и Danfoss совместно с Schneider Electric и Danish Data Center Industry учредители в Дании платформу Net Zero Innovation Hub, основной целью которой является ускорение «зелёной трансформации» дата-центров.

25.01.2024 [14:41], Сергей Карасёв

Для звёзд — Xeon, для гравитации — EPYC: Lenovo обновила HPC-кластер Кардиффского университетаКомпания Lenovo поставила в Кардиффский университет в Великобритании 90 серверов ThinkSystem, которые позволили поднять производительность кластера Hawk HPC приблизительно в два раза. Система применяется для решения сложных задач в таких областях, как астрофизика и наука о жизни. Lenovo и британский поставщик IT-решений Logicalis предоставили HPC-ресурсы для двух исследовательских групп в Кардиффском университете. Одна из них — научная коллаборация, участвующая в проекте лазерно-интерферометрической гравитационно-волновой обсерватории (LIGO). Эта инициатива нацелена на обнаружение гравитационных волн. Сообщается, что для проекта LIGO компания Lenovo предоставила 75 серверов ThinkSystem SR645, оснащённых процессорами AMD EPYC Genoa. Эти системы поддерживают до 6 Тбайт оперативной памяти DDR5-4800 в виде 24 модулей и до трёх ускорителей PCIe (2 × PCIe 5.0 и 1 × PCIe 4.0). Отмечается, что установка серверов позволила удвоить вычислительные мощности, доступные исследователям. Вторая исследовательская группа в Кардиффском университете, изучающая процессы звёздообразования, получила 15 серверов Lenovo ThinkSystem SR630 на платформе Intel Xeon Sapphire Rapids и два сервера хранения ThinkSystem SR650 с возможностью установки 20 накопителей LFF или 40 накопителей SFF. Группа сосредоточена на анализе спиральных галактик, таких как наш Млечный Путь. Приобретённые серверы помогут в выполнении сложных задач моделирования.

24.01.2024 [23:23], Владимир Мироненко

«СОЛЛЕРС» перенесла ЦОД на площадку УАЗ без простоев и потерьГруппа «СОЛЛЕРС» сообщила об успешном завершении проекта миграции своей вычислительной инфраструктуры, ранее размещавшейся на арендованной территории, на площадку Ульяновского автомобильного завода (УАЗ). Реализацией проекта занимались специалисты «СОЛЛЕРС» при поддержке системного интегратора PROF-IT GROUP. В итоге основная вычислительная система группы была перенесена в ЦОД в планируемые сроки и с заданными параметрами без каких-либо простоев. Перед выполнением работ по миграции была проведена модернизации площадки для обеспечения размещения необходимого оборудования на территории УАЗ, увеличена площадь помещения, выполнены строительные работы, перестроена существующая корпоративная сеть передачи данных для повышения отказоустойчивости.

Источник изображения: «СОЛЛЕРС» ЦОД оснащён необходимыми для работы инженерными системами: автоматической системой газового пожаротушения, охранной сигнализацией, системой видеонаблюдения и СКУД, системой кондиционирования и мониторинга состояния окружающей среды. На территории завода была проложена высокоскоростная кабельная система, которая обеспечивает отказоустойчивую работу сети в цехах. Также была создана бесперебойная сеть электропитания для всех элементов обновлённой инфраструктуры. Перенос ЦОД производился поэтапно с финальной приёмкой и запуском в эксплуатацию в октябре 2023 года. Новый ЦОД УАЗ позволит группе совместно с ЦОД в Елабуге развивать кластер высоконагруженных цифровых ИТ-решений.

24.01.2024 [20:15], Сергей Карасёв

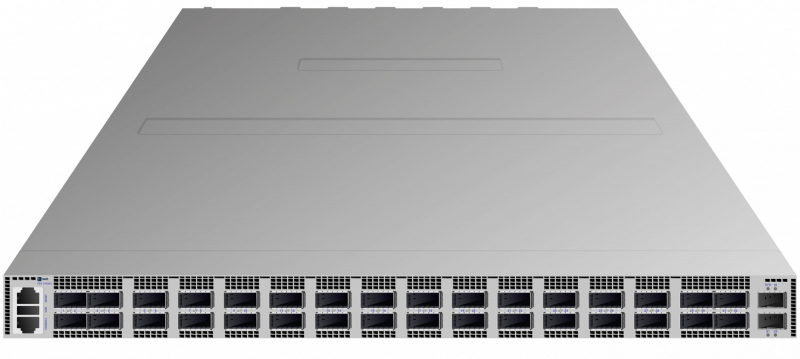

Fplus представила самый быстрый российский коммутатор — FDS-7532D1 с 32 портами 400GbEРоссийский производитель инфраструктурного IT-оборудования Fplus анонсировал устройство FDS-7532D1: это, как утверждается, самый быстрый на сегодняшний день коммутатор в России. Новинка оснащена 32 портами 400GbE (QSFP56-DD), а скорость коммутации при максимальной загрузке достигает 25,6 Тбит/с. Коммутаторы серии FDS предназначены для организации высокоскоростных сетей передачи данных. Решения подходят для современных дата-центров, а также для корпоративных и операторских инфраструктур, где могут применяться на уровне ядра. Используемые ASIC вендор предпочитает не раскрывать. Модель FDS-7532D1 выполнена в форм-факторе 1RU с габаритами 440 × 588 × 44 мм; масса составляет около 16 кг. Заявленное энергопотребление — 1600 Вт, максимальная рабочая температура — 45 °C. В конструкции применены шесть (5+1) съёмных блоков вентиляторов и два (1+1) блока питания. Интерфейсы управления OOB: один RJ-45 и два SFP+. Количество VLAN достигает 4 тыс., размер MAC FDB — 256 тыс. записей, количество ECMP-групп — 10 тыс. Коммутаторы серии FDS построены на базе ASIC с неблокируемой матрицей коммутации. В устройствах могут использоваться трансиверы SFP, SFP+, SFP28, QSFP+, QSFP28, QSFP56 и QSFP56-DD. Упомянуты единый интерфейс командной строки (CLI) со стандартным для отрасли синтаксисом и широкий набор поддерживаемых типовых инструментов автоматизации управления. Коммутаторы серии FDS также поддерживают установку альтернативных операционных систем. В производстве коммутаторов задействовано несколько площадок, расположенных на территории России, в том числе собственный завод Fplus в Подмосковье. Разработкой устройств занимаются две RnD-команды: одна отвечает за аппаратную часть, вторая — за ПО. Fplus направила документы о включении коммутатора FDS-7532D1 в Единый реестр российской радиоэлектронной продукции Минпромторга. |

|