Материалы по тегу: s

|

06.12.2024 [12:03], Сергей Карасёв

Delta Computers представила СХД Delta Marlin с поддержкой 36 NVMe SSD с интерфейсом PCIe 5.0Компания Delta Computers, российский производитель IT-оборудования и поставщик ПО, анонсировала СХД Delta Marlin, рассчитанную на работу с накопителями U.2 NVMe, оснащёнными интерфейсом PCIe 5.0. Кроме того, представлена платформа хранения Delta Guepard с гибкими вариантами конфигурации. Решение Delta Marlin — система высокой плотности, которая может использоваться как для расширения дискового пространства сервера, так и в составе высокоскоростных программного-определяемых СХД. Возможна организация двухконтроллерного сценария благодаря dual-port режиму SSD. Система в зависимости от варианта исполнения допускает установку 18 накопителей SFF толщиной 7мм или девяти SSD толщиной 15 мм. Кроме того, возможно подключение до 36 накопителей в 2OU-модуле. Предусмотрены два слота расширения для карт PCIe 5.0 х16 HHHL. Применяется встроенное ПО Delta BMC. Питание осуществляется от общей DC-шины OCP на 12 В. В системе охлаждения задействованы шесть вентиляторов с резервированием по схеме N+1. В свою очередь, Delta Guepard — это семейство СХД, оптимизированных для высокопроизводительных приложений, требующих низкой задержки ввода-вывода и высокой пропускной способности. Устройства основаны на модульной архитектуре. Модификации Delta Guepard Gen 1 в форм-факторах 4U и 6U/8U рассчитаны соответственно на 30 и 60 накопителей SFF/LFF SATA HDD или U.2 (7–15 мм) NVMe SSD. Максимальная суммарная вместимость — 720 (30 накопителей) и 1440 (60 накопителей) Тбайт. Варианты Delta Guepard Gen 2 в исполнениях 4U и 6U/8U допускают установку до 36 и 72 накопителей U.2 NVMe, а общая вместимость составляет до 276 и 552 Тбайт. Все устройства Delta Guepard наделены двумя контроллерами. Возможно формирование массивов RAID 0/1/5/6/10/50/60/70. Поддерживаются протоколы SMB v2/v3, NFS v3/v4, AFP, FTP, а также Fibre Channel; iSCSI; InfiniBand (FDR, QDR, DDR, EDR). Питание осуществляется от централизованного шинопровода OCP на 12 В. В продажу решения поступят в I квартале 2025 года.

06.12.2024 [12:00], Руслан Авдеев

Новая веха: консорциум PCI-SIG теперь включает 1000 компаний со всего мираКонсорциум PCI-SIG — организация, ответственная за разработку и распространение стандарта PCI Express (PCIe), объявила о достижении важной вехи — теперь в её составе насчитывается тысяча компаний. Как сообщает пресс-служба организации, технология PCIe, представленная ещё в 2003 году, в последнее время стала ключевым IO-стандартом, а в 2022 году PCI-SIG отметила 30-летие своей инновационной деятельности. В следующем году планируется представить новейший стандарт PCIe 7.0. По словам главы PCI-SIG Эла Янеса (Al Yanes), в последние 32 года именно многообразие участников консорциума позволило создать надёжный, универсально совместимый (в том числе обратно совместимый) интерфейс. Ожидается, что его внедрение продолжится и в новых сферах ИИ и машинного обучения (ML), а также HPC-вычислений в целом.

Источник изображения: DESIGNECOLOGIST/unsplash.com PCI-SIG уже разработала разнообразные технологии и спецификации PCI, а также шесть поколений интерфейса PCIe. В числе наиболее актуальных инноваций — представленные в 2024 году спецификации кабелей CopprLink для внутренних и внешних соединений, а также создание рабочих групп, изучающих оптические соединения. Участники PCI-SIG получают:

Участие в PCI-SIG свободно, о преимуществах и условиях вступления можно узнать на сайте компании или в её социальных сетях. Ещё в июне 2024 года сообщалось, что разработка и внедрение новых стандартов PCI Express не ускорятся, но PCI-SIG не видит в этом проблемы.

05.12.2024 [13:37], Сергей Карасёв

AWS представила инстансы EC2 P5en на базе NVIDIA H200 и кастомизированных чипов Intel XeonОблачная платформа AWS объявила о доступности инстансов EC2 P5en, рассчитанных на такие нагрузки, как глубокое обучение, генеративный ИИ, обработка данных в реальном времени и приложения HPC. В основу новых экземпляров положены аппаратные компоненты Intel и NVIDIA. В частности, задействованы кастомизированные процессоры Xeon Sapphire Rapids. У них все ядра могут одновременно работать на турбо-частоте 3,2 ГГц, а максимальная частота отдельных ядер достигает 3,8 ГГц. Кроме того, применяются ИИ-ускорители NVIDIA H200 и адаптеры AWS Elastic Fabric Adapter (EFA) v3 с пропускной способностью до 3,2 Тбит/с. Конфигурация инстансов EC2 P5en включает 192 vCPU, 2048 ГиБ памяти, восемь ускорителей H200 и восемь SSD вместимостью 3,84 Тбайт каждый. Пропускная способность EBS составляет 100 Гбит/с. Отмечается, что экземпляры P5en демонстрируют увеличение производительности локального хранилища до двух раз и пропускной способности EBS до 25 % по сравнению с инстансами P5 на базе NVIDIA H100.

Источник изображения: NVIDIA На сегодняшний день инстансы EC2 P5en доступны в американских регионах AWS US East (Огайо) и US West (Орегон), а также в Азиатско-Тихоокеанском регионе в Токио. Предлагаются различные тарифные опции, включая оплату по мере использования. Ранее были представлены инстансы EC2 P5e с процессорами AMD EPYC Milan, 2 ТиБ памяти, восемью ускорителями NVIDIA H200 и восемью NVMe SSD на 3,84 Тбайт каждый. У этих экземпляров пропускная способность EBS равна 80 Гбит/с.

05.12.2024 [09:13], Руслан Авдеев

AWS представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную

aws

hardware

pue

водоснабжение

дизель

ибп

ии

охлаждение

сжо

сша

цод

экология

электропитание

энергетика

энергоэффективность

AWS рассказала об инновациях, внедряемых в её ЦОД для поддержки ИИ-нагрузкок следующего поколения. По данным DataCenter Dynamics, нововведения связаны в первую очередь с электропитанием и охлаждением. Они направлены на повышение энергоэффективности дата-центров AWS. Первые ЦОД на базе новой архитектуры заработают в начале 2025 года. Новые решения в свежих новых дата-центрах компании по всему миру, а некоторые начнут применять уже на существующих объектах. В компании подчёркивают, что решения изначально спроектированы как модульные, поэтому возможная поэтапная модернизация площадок для внедрения СЖО, повышения энергоэффективности и снижения углеродного следа. Так, AWS упростит электрическую и механическую структуру новых ЦОД, чтобы облегчит их обслуживание и повысить надёжность. В частности, упростится подход к распределению энергии внутри ЦОД, а источники резервного питания будут размещаться ближе к стойкам. Это позволит повысить доступность инфраструктуры до 99,9999 % времени, а количество стоек, которых могут коснуться проблемы с энергоснабжением, снизится на 89 %. Также уменьшится количество вентиляторов для отвода горячего воздуха. Вместо этого будет применяться естественный перепад давления, что положительно скажется на энергопотреблении. Вместе с тем AWS намерено вшестеро увеличить мощность стойки в следующие два года, и ещё втрое — в будущем. Впрочем, в ИИ-серверах, где мощность ускорителей приближается к 1 кВт, без СЖО обойтись сложно. AWS готовит суперкластеры Project Rainier и Project Ceiba на базе AWS Tranium2 и NVIDIA Blackwell соответственно, поэтому она вместе с крупным производителем СЖО будет внедрять прямое жидкостное охлаждение и в новых, и в старых ЦОД. В некоторых случаях будет использоваться и гибридное охлаждение. Одним из главных плюсов новой архитектуры охлаждения является гибкость — акцент на воздушное или жидкостное охлаждение будет делаться в зависимости от потребностей оборудования и возможностей конкретных дата-центров. Заодно AWS использовала имеющиеся данные и генеративный ИИ для поиска наиболее эффективного способа размещения стоек в своих ЦОД, добавив ещё 12 % вычислительных мощностей на каждую площадку. Новая технология будет применяться как к новому оборудованию для ИИ-систем, так и для других типов техники. Также компания внедрила собственную систему управления механическими и электрическими устройствами — она поможет стандартизировать мониторинг и эксплуатацию дата-центров. Наконец, предприняты усилия по повышению экобезопасности дата-центров. AWS заявила, что новая архитектура охлаждения снизит потребление энергии на 46 % во времена пиковых нагрузок без увеличения потребления воды. Доля углеродных выбросов при производстве бетона, используемого при строительстве ЦОД, уменьшена на 35 % относительно средней по отрасли, кроме того, на 35 % сокращается потребление стали в целом, а та, что используется, поступает из электродуговых печей, а не газовых, что сокращает косвенные выбросы. Наконец, резервные генераторы AWS переведут на возобновляемое дизельное топливо. Дополнительно AWS совместно с Orbital Materials запустила пилотный проект по тестированию разработанного с помощью ИИ материала, помогающего захватывать в дата-центрах углекислый газ — речь идёт о «губке на атомном уровне», взаимодействующей только с молекулами углекислоты. Тестирование материала, три года разрабатывавшегося компаниями, начнётся в начале 2025 года. По данным Orbital, новый материал значительно дешевле аналогов. В дальнейшем стартап планирует испытать разработанные с помощью ИИ технологии для экономии воды и охлаждения чипов. DataCenter Dynamics также отмечает, что AWS впервые раскрыла показатель PUE своих дата-центров. В среднем он составляет 1,15, а самая лучшая площадка достигла 1,04. Для сравнения: у Google эти показатели составляют 1,1 и 1,06 соответственно, у Microsoft — 1,18 и 1,12 (у новых объектов). ЦОД Meta✴ в среднем имеют PUE около 1,08, а Oracle говорит об 1,15.

04.12.2024 [17:43], Сергей Карасёв

AWS построит распределённый ИИ-суперкомпьютер Project Rainier с десятками тысяч ИИ-ускорителей Trainium2Облачная платформа AWS официально представила инстансы EC2 Trn2 и Trn2 UltraServer — самые высокопроизводительные решения EC2, ориентированные на ИИ-приложения, машинное обучение и задачи инференса. В основу положены фирменные ускорители Amazon Trainium2 второго поколения. ИИ-ускорители Trainium2 содержат восемь ядер NeuronCore и 96 ГиБ памяти HBM с пропускной способностью 2,9 Тбайт/с. Ядра могут адресоваться и использоваться по отдельности или же пары физических ядер могут быть сгруппированы в один логический блок. Trainium2 обеспечивает FP8-быстродействие до 1,3 Пфлопс, а FP8-производительность в разреженных вычислениях достигает 5,2 Пфлопс. Инстансы EC2 Trn2 содержат 16 ускорителей Trainum2, связанных посредством интерконнекта NeuronLink. В сумме это даёт 128 ядер NeuronCore и 1,5 ТиБ памяти HBM с суммарной пропускной способностью 46 Тбайт/с. Производительность на операциях FP8 достигает 20,8 Пфлопс. Каждый инстанс включает 192 vCPU, 2 ТиБ памяти и адаптеры AWS Elastic Fabric Adapter (EFA) v3 на 3,2 Тбит/с. Утверждается, что инстансы Trn2 обеспечивают в четыре раза более высокую производительность, в четыре раза большую пропускную способность памяти и в три раза большую ёмкость памяти, нежели инстансы Trn1. Кроме того, экземпляры Trn2 предлагают на 30–40 % лучшее соотношение цены и производительности, чем EC2 P5e и P5en на базе GPU. Инстансы Trn2 доступны в регионе AWS US East (Огайо), а в ближайшем будущем появятся и в других зонах. В свою очередь, платформа UltraServer включает четыре инстанса Trn2 (64 ускорителя Trainum2) с интерконнектом NeuronLink с низкой задержкой. В сумме это даёт 512 ядер NeuronCore и 6 ТиБ памяти HBM с суммарной пропускной способностью 185 Тбайт/с. Быстродействие на операциях FP8 составляет 83 Пфлопс (332 Пфлопс в разреженных вычислениях). Новые узлы используют СЖО. Десятки тысяч ускорителей Trainium2 могут формировать кластеры EC2 UltraCluster. В частности, такую систему в рамках инициативы Project Rainier компания Amazon намерена создать в партнёрстве со стартапом Anthropic, который специализируются на технологиях генеративного ИИ. Интересно, что ИИ-суперкомпьютер Project Rainier будет распределённым — его узлы разместятся сразу в нескольких ЦОД. ВОЛС между дата-центрами организует Lumen. Одной из причин от попытки построить один гигантский кампус называется невозможность быстро получить достаточно энергии в одном месте, хотя у компании уже есть площадка рядом с АЭС. Недавно Amazon объявила о намерении удвоить инвестиции в Anthropic, доведя их до $8 млрд. Создание системы Rainier планируется завершить в следующем году. Ожидается, что она станет одним из крупнейших в мире вычислительных кластеров для обучения моделей ИИ. По заявлениям AWS, комплекс обеспечит в пять раз более высокую производительность по сравнению с платформой, которую Anthropic использовала до сих пор для разработки своих языковых моделей. Достанутся ли Anthropic и ресурсы ещё облачного ИИ-суперкомпьютера Project Ceiba, который получит 21 тыс. суперчипов NVIDIA Blackwell, не уточняется. Кроме того, по сообщению The Register, компания Amazon приоткрыла завесу тайны над ИИ-ускорителями следующего поколения — изделиями Trainium3. По сравнению с предшественниками они, как утверждается, обеспечат четырёхкратное увеличение быстродействия. Говорится, что Trainium3 станет первым специализированным ускорителем для ИИ и машинного обучения, созданным на основе 3-нм техпроцесса. Эффективность по сравнению с Trainium2 увеличится примерно на 40 %. Ожидается, что на коммерческом рынке изделия Trainium3 появятся в конце 2025 года.

04.12.2024 [15:44], Руслан Авдеев

Marvell перенесёт разработку чипов в облако AWS, а AWS получит от Marvell новые чипы для своих ЦОДКомпания Marvell Technology, занимающаяся полупроводниковыми инфраструктурными решениями, объявила о расширении стратегического партнёрства с Amazon Web Services (AWS). Стороны заключили соглашение сроком на пять лет, включающее сотрудничество в работе над несколькими продуктами AWS, а также использование облачной инфраструктуры техногиганта, сообщает пресс-служба Marvell. Соглашение касается широкого спектра решений Marvell, предназначенных для дата-центров. В том числе речь идёт о поставке кастомизированных ИИ-чипов для AWS, оптических и электрических DSP, PCIe-ретаймеров, оптических сетевых решениях, чипсетов для коммутаторов и др. Компетенции Marvell позволят AWS усовершенствовать собственные продукты, сетевое оборудование и СХД, добившись большей эффективности и снижения стоимости эксплуатации. Для автоматизации проектирования электроники (EDA) в Marvell приняли подход cloud first, разработка ведётся с использованием облака AWS, где компании доступны практически неограниченные вычислительные ресурсы. В Marvell уже заявили, что решения AWS EDA помогут компании быстро, гибко и безопасно масштабировать проектирование полупроводников с лучшим в своём классе временем выхода на рынок. Сотрудничество играет на руку и AWS — продукты Marvell активно используются в инфраструктуре Amazon.

03.12.2024 [17:58], Сергей Карасёв

Delta Computers представила первый в России модульный восьмипроцессорный сервер Delta SpiderРоссийская компания Delta Computers анонсировала систему Delta Spider. Это, как утверждается, первый в РФ модульный восьмипроцессорный сервер на аппаратной платформе Intel Xeon Sapphire Rapids. В составе Delta Spider применяются чипы с 60 ядрами, значение TDP которых может достигать 385 Вт. Возможны конфигурации с двумя, четырьмя и восемью процессорами, что в сумме даёт до 480 ядер. Процессоры объединены шиной UPI. Поддерживается память DDR5-4400/4800, объём которой в максимальной конфигурации составляет 32 Тбайт (128 × 256 Гбайт). Доступны базовые варианты Spider L и Spider XL в формате 7OU и 13OU соответственно. Допускается установка соответственно 16 и 32 SSD типоразмера SFF (U.2; NVMe) толщиной 7 мм или 8 и 16 SSD толщиной 15 мм. В модуле управления предусмотрены ещё два посадочных места для SSD (U.2; NVMe) толщиной 7 мм. Версия Spider L располагает 12 слотами для карт PCIe 5.0 х16 HHHL, модификация Spider XL — 24 слотами. Серверы оборудованы гибридной системой охлаждения (вода+воздух) Delta Hybrid Cooling с возможность горячей замены вентиляторов, которая позволяет процессорам постоянно работать в Boost-режиме. Питание осуществляется от централизованного шинопровода OCP (12 В). Модуль управления наделён двумя портами USB 3.0, разъёмом 1GbE RJ-45, интерфейсами D-Sub и Mini-DP, а также сервисным портом USB Type-C. Применяется разработанное в России микропрограммное обеспечение Delta BIOS и Delta BMC. По заявлениям Delta Computers, платформа Delta Spider подходит для высоконагруженных приложений, таких как системы управления предприятием (ERP и CRM), автоматизированные банковские системы (ABS), аналитические сервисы принятия решений реального времени, биллинговые и платежные системы, а также иных in-memory приложений.

03.12.2024 [11:01], Сергей Карасёв

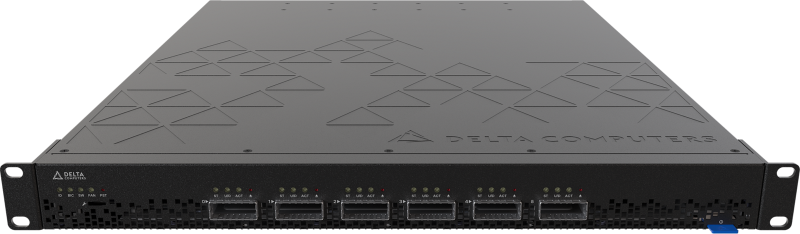

Delta Computers представила российские 400G-коммутатор Delta Dragonfly и PCIe-коммутатор Delta FirebirdРоссийский производитель IT-оборудования Delta Computers анонсировал Ethernet-коммутатор Delta Dragonfly типа Bare Metal, предназначенный для развёртывания высокоскоростных инфраструктур уровня ядра сети, а также уровней агрегации и доступа в средних и крупных компаниях. Решение выполнено в форм-факторе 1U с габаритами 630 × 439 × 43 мм. Задействованы ASIC Broadcom Tomahawk 3 (коммутационная ёмкость — 12,8 Тбит/с), а также процессор Intel Xeon Emerald Rapids. Предусмотрены четыре слота для модулей оперативной памяти DDR5-5600. Для Delta Dragonfly доступны модификации DN5032, DN4032, DN3032, DN4424, а также DN3424 с поддержкой соответственно 32 портов QSFP-DD 400 Гбит/с, 32 портов QSFP-56 200 Гбит/с, 32 портов QSFP-28 100 Гбит/с, 24 портов QSFP-56 200 Гбит/с и четырёх портов QSFP-DD 400 Гбит/с, а также 24 портов QSFP-28 100 Гбит/с и четырёх портов QSFP-DD 400 Гбит/с. Все варианты располагают двумя разъёмами SFP+ 10 Гбит/с. Коммутаторы могут получать питание от двух блоков CRPS, общей DC-шины OCP (12 В) или от сети 48–60 В телеком-стандарта (Telco Rack). В системе охлаждения задействованы пять вентиляторов. Применяется созданные в России прошивки Delta BIOS и Delta BMC. Утверждается, что Delta Dragonfly является оптимальным выбором для ЦОД, корпоративных сред и HPC-платформ. Кроме того, компания Delta Computers представила высокоскоростной PCIe-коммутатор Delta Firebird, обеспечивающий возможность объединения до шести устройств по интерфейсу PCIe 5.0 x16 в кластер. Горизонтальная масштабируемость на базе PCIe 5.0 позволяет создавать разнообразные конфигурации кластеров высоконагруженных систем. Изделие выполнено в формате 1U с размерами 481 × 629 × 43 мм. Возможно питание от двух блоков CRPS или от централизованного шинопровода OCP на 12 В. Применено встроенное ПО Delta BMC. Оба коммутатора могут быть использованы в стандартных 19″ серверных стойках и в OCP-шасси формата 21″.

03.12.2024 [10:00], Сергей Карасёв

Астрофизики Японии получили суперкомпьютер Aterui III на базе Intel Xeon MaxЦентр вычислительной астрофизики Национальной астрономической обсерватории Японии (NAOJ) объявил о вводе в эксплуатацию суперкомпьютера NS-06 Aterui III на платформе HPE Cray XD2000. Новый НРС-комплекс планируется применять в качестве «лаборатории теоретической астрономии» для исследования широкого спектра астрофизических явлений. Архитектура Aterui III предполагает применение модулей двух типов — System M с высокой пропускной способностью памяти (3,2 Тбайт/с на узел, что в 12,5 раза больше, чем у Aterui II) и System P с большим объёмом памяти (512 Гбайт в расчёте на узел, в 1,3 раза больше по сравнению с Aterui II). Все узлы оснащены двумя процессорами Intel Xeon Sapphire Rapids. В частности, задействованы 208 узлов System M с чипами Xeon CPU Max 9480 (56C/112T; 1,9–3,5 ГГц; 350 Вт). Таким образом, суммарное количество ядер достигает 23 296. Каждый узел несёт на борту 128 Гбайт памяти, а её совокупный объём составляет 26,6 Тбайт. Общая пропускная способность — 665 Тбайт/с. Кроме того, в состав Aterui III включены 80 узлов System P с парой процессоров Xeon Platinum 8480+ (56C/112T; 2,0–3,8 ГГц; 350 Вт). В общей сложности применяются 8960 ядер и 40,96 Тбайт памяти с суммарной пропускной способностью 98,24 Тбайт/с (614 Гбайт/с на узел). В целом, суперкомпьютер использует 288 узлов с 32 256 ядрами CPU. Кластер на базе System M обеспечивает производительность на уровне 1,4 Пфлопс, сегмент на основе System P — около 0,57 Пфлопс. Общее быстродействие НРС-комплекса достигает почти 2 Пфлопс.

03.12.2024 [05:58], Руслан Авдеев

Сдайте ваши файлы: Amazon открыла в США пункты выгрузки данных в AWSAmazon представила сервис AWS Data Transfer Terminal — пункты, где можно быстро и безопасно выгрузить большие объёмы данных в облако AWS. Первые терминалы расположены в Лос-Анджелесе и Нью-Йорке, в будущем планируется добавить пункты приёма данных и в других локациях по всему миру. Использование пунктов AWS Data Transfer Terminal позволит значительно снизить время передачи данных (не считая времени на дорогу и обратно) в хранилища S3, EFS и др. Например, можно выгрузить большие датасеты от парка беспилотных машин, видеофайлы или картографические данные для дальнейшего анализа и обработки. Также с собой можно принести носители Snowball, хотя в целом AWS постепенно сворачивает сервисы Snow по физической доставке данных в облако. Список терминалов доступен в AWS Management Console, где можно заранее назначить дату и время визита и вписать участников. В назначенный час сотрудник AWS проверит документы и проводит до отдельной комнаты, где есть патч-панель, оптоволоконный кабель и ПК. Патч-панель интегрирована в небольшую стойку, а компьютер можно использовать для контроля процесса передачи данных. Примечательно, что в целях безопасности на зданиях и в помещениях нет никаких символов AWS. Плата за гигабайты не предусмотрена, вместо этого платить придётся за время загрузки в регионы AWS. При этом доступны только те регионы, которые находятся на том же континенте, где и пользователь. |

|