Материалы по тегу: nvidia

|

12.06.2024 [09:49], Владимир Мироненко

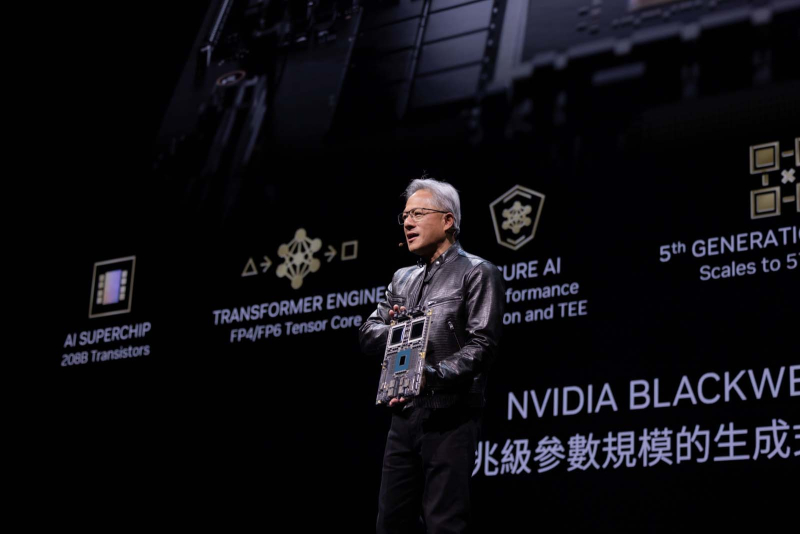

Суверенный ИИ может стать для NVIDIA новым источником роста доходовСейчас во многих странах Азии, Ближнего Востока, Европы и в США наблюдается всплеск интереса к внедрению ИИ, что вызвало резкий рост расходов на вычислительные мощности, пишет The Wall Street Journal. Правительства стран увеличивают бюджеты и используют различные рычаги для стимулирования локальных компаний и транснациональных корпораций к строительству новых ЦОД и модернизации существующих с целью развития собственных ИИ-технологий и обучения больших языковых моделей (LLM) на языках и данных граждан своей страны. Этот тренд ресурс WSJ объясняет стремлением стран к большей стратегической самостоятельности на фоне растущей напряжённости между США и Китаем, сосредоточенной на технологиях, а также намерением защитить национальную культуру и национальную безопасность в связи с бурным развитием ИИ-технологий. В прошлом месяце NVIDIA сообщила, что так называемые инициативы в области суверенного ИИ, как ожидается, принесут её в этом году почти $10 млрд, тогда как в прошлом году это направление не было для неё доходным. Из $26 млрд выручки NVIDIA за прошлый квартал почти половина поступила от крупных компаний, занимающихся облачными вычислениями, которые арендуют доступ к её чипам. Новое направление сулит выгоду NVIDIA и другим американским технологическим компаниями, занятым в сфере строительства и эксплуатации ЦОД, и ищущим новые источники роста, поскольку спрос частного сектора на ИИ-технологии может снизиться. Глава NVIDIA Дженсен Хуанг (Jensen Huang, на фото выше) в последние месяцы провёл немало встреч с правительственными чиновниками разных стран, чтобы убедить их в необходимости инвестиций в ИИ со стороны государства. В сентябре прошлого года он встречался с премьер-министром Индии Нарендрой Моди, в декабре — с премьер-министрами Японии и Сингапура. В этом году он провёл встречи с официальными лицами ОАЭ и Канады. и побывал на Тайване. Среди крупнейших спонсоров суверенного ИИ — Сингапур, чей национальный суперкомпьютерный центр оснащается новейшими чипами NVIDIA, а государственная телекоммуникационная компания Singtel в сотрудничестве с NVIDIA занята расширением своего парка ЦОД в Юго-Восточной Азии. Страна также стала инициатором создания LLM для языков Юго-Восточной Азии. В свою очередь, Канада планирует выделить $1,5 млрд в рамках суверенной вычислительной стратегии для стартапов и исследователей, а в Японии после визита Хуанга объявили о планах инвестировать в этом году около $740 млн в наращивание вычислительной мощности для разработки ИИ для нужд страны. Аналогичные инициативы нашли поддержку Европе. Например, во Франции и Италии телекоммуникационные компании создают ИИ-суперкомпьютеры с чипами NVIDIA для разработки LLM с поддержкой национальных языков. Кения в прошлом месяце подписала с Microsoft и поддерживаемой ОАЭ компанией G42, занимающейся ИИ, соглашение о строительстве в стране ЦОД стоимостью $1 млрд на геотермальной энергии с целью обучения ИИ-модели непосредственно на суахили и английском языке. «Правительствам теперь нужны суверенные облака для инфраструктуры ИИ и конфиденциальных данных, а американские технологические компании стремятся помочь в их создании», — говорит Ну Векслер (Nu Wexler), бывший сотрудник по связям с общественностью в Google, Meta✴ и Twitter (нынешней X). Китай также стремится занять позиции на рынке суверенного ИИ. Он предлагает строительство ЦОД и возможности ИИ африканским странам, включая Египет. Но китайские ИИ-чипы пока уступают по производительности ускорителям NVIDIA и других американских компаний, что часто делает США предпочтительным поставщиком, несмотря на экспортные ограничения, отметил WSJ. По мнению аналитиков, тренд на развитие суверенного ИИ может стать для NVIDIA спасительным кругом, когда наступит сокращение закупок ИИ-чипов со стороны основной группы клиентов технологических компаний, таких как Microsoft, Amazon и Google.

11.06.2024 [17:09], Руслан Авдеев

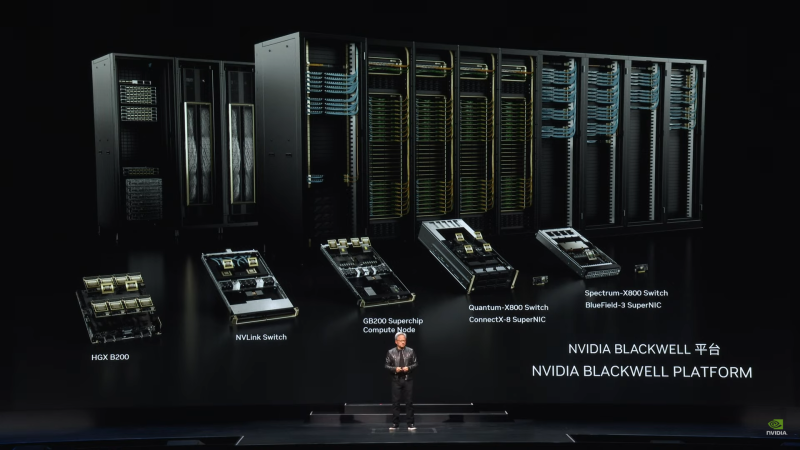

Foxconn построит на Тайване передовой вычислительный центр на базе суперускорителей NVIDIA BlackwellПроизводитель электроники Foxconn намерен построить на острове передовой вычислительный центр в Гаосюне (Тайань). Datacenter Dynamics информирует, что центр, который будет готов в 2026 году, получит 64 суперускорителя NVIDIA Blackwell GB200 NVL72. Foxconn и NVIDIA будут сотрудничать и над созданием «цифровых двойников» для производственных компаний, электромобилей и систем умного города. Проекты будут реализованы на платформе NVIDIA Omniverse. В NVIDIA заявили, что сейчас происходит расцвет новой эры вычислений, ставшей драйвером спроса на дата-центры для генеративного ИИ. Также в компании подчеркнули, что Foxconn является ведущим поставщиком вычислительных решений NVIDIA и одним из ключевых новаторов в деле внедрения генеративного ИИ в промышленности и робототехнике. Используя платформы NVIDIA Omniverse и Isaac, компания задействует передовые ИИ-технологии и систему цифровых двойников для создания передового вычислительного центра в Гаосюне. Основанная в 1974 году компания Foxconn в последнее время стремится расширить долю рынка в полупроводниковой индустрии на фоне медленного роста продаж смартфонов. Дочерняя компания Ingrays выпускает серверы, системы хранения данных и HPC-компоненты, включая HPC-платформы на основе чипов NVIDIA. Ранее появилась информация о том, что компания намерена превратить опосредованно принадлежащий ей завод Sharp по выпуску LCD-панелей в дата-центр, но тот расположен в Япони и к текущему проекту не имеет прямого отношения.

11.06.2024 [15:22], Сергей Карасёв

3,76 млн ускорителей в 2023 году: NVIDIA захватила 98 % рынка GPU для ЦОДПо оценкам аналитической фирмы Tech Insights, которые приводит ресурс HPC Wire, компания NVIDIA в 2023 году отгрузила приблизительно 3,76 млн ускорителей на базе GPU, ориентированных на ЦОД. Это более чем на 1 млн штук превосходит результат 2022 года, когда поставки таких изделий оценивались в 2,64 млн единиц. С учётом решений AMD и Intel общий объём поставок GPU-ускорителей для ЦОД в 2023 году составил 3,85 млн единиц против примерно 2,67 млн штук в 2022 году. Правда, столь малая доля отгрузок решений AMD и Intel вызывает некоторые сомнения. Как отмечает аналитик Tech Insights Джеймс Сандерс (James Sanders), в настоящее время на рынке не хватает аппаратных ресурсов для удовлетворения всех ИИ-потребностей. А поэтому будет расти спрос на ускорители и специализированные чипы разработчиков, конкурирующих с NVIDIA. Согласно подсчётам TechInsights, по итогам 2023-го NVIDIA контролировала около 98 % мирового рынка ускорителей на базе GPU для дата-центров. Схожий результат компания продемонстрировала и годом ранее. Такой рост связан со стремительным развитием ИИ-приложений и увеличением спроса на НРС-системы. При этом на NVIDIA приходится и 98 % выручки от реализации таких ускорителей: в 2023 году они принесли компании $36,2 млрд, что более чем в три раза превышает прошлогодний показатель в $10,9 млрд. По данным TechInsights, в 2023 году AMD поставила около 50 тыс. ускорителей для ЦОД, а Intel — примерно 40 тыс. единиц (в оригинальном материале HPCWire указаны на порядок более высокие значения; корректировка сделана в соответствии с оставшейся долей в 2 % рынка). В 2024-м, как полагают эксперты, спрос на такие продукты в глобальном масштабе поднимется. Речь, в частности, идёт об ускорителях серии Instinct MI300, разработанных AMD. При этом AMD заявляет, что намерена выпускать новые решения ежегодно: ускоритель MI325X запланирован на 2024 год, MI350 — на 2025-й, а MI400 — на 2026-й. В свою очередь, Intel продвигает изделия Gaudi3. Специализированные ИИ-чипы проектируют и ведущие гиперскейлеры. Так, AWS в конце прошлого года представила ИИ-ускоритель Trainium2, предназначенный для обучения нейронных сетей. Google анонсировала изделия Cloud TPU v5p, а Microsoft — Maia 100. Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis.

09.06.2024 [12:36], Сергей Карасёв

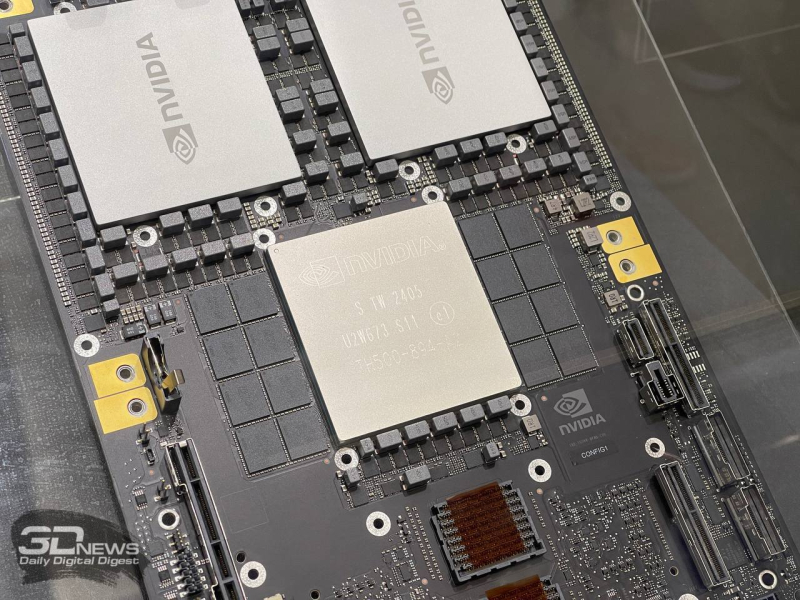

ASUS представила ИИ-систему ESC AI POD на базе NVIDIA GB200 NVL72Компания ASUS анонсировала мощный вычислительный комплекс ESC AI POD, предназначенный для решения ресурсоёмких задач в области ИИ и НРС. В основу новинки положена платформа NVIDIA GB200 NVL72 на архитектуре Blackwell. Решение ESC NM2N721-E1 использует 72 ускорителя NVIDIA Blackwell и 36 процессоров NVIDIA Grace, объединённых интерконнекта NVIDIA NVLink 5. Утверждается, что ESC AI POD поддерживает работу с большими языковыми моделями (LLM), насчитывающими до триллиона параметров. В состав системы входят вычислительные узлы, коммутаторы, а также полки питания 1U мощностью 33 кВт. Возможно развёртывание воздушно-жидкостного или полностью жидкостного охлаждения. Кроме того, ASUS продемонстрировала в рамках Computex 2024 другие новинки. В их числе — системы, выполненные на модульной архитектуре NVIDIA MGX. Это, в частности, сервер ESC NM1-E1 типоразмера 2U, комплектующийся суперчипом NVIDIA Grace Hoppe GH200. Он использует технологию NVIDIA NVLink-C2C и поддерживает воздушное охлаждение. Кроме того, показаны серверы ESC NM2-E1 и ESR1-511N-M1 (стандарта 1U).

Среди других решений упоминаются серверы ESC N8 на платформе Intel Xeon Emerald Rapids и ESC N8A на базе AMD EPYC 9004 (Genoa). Эти системы несут на борту ускорители NVIDIA Blackwell. Кроме того, ASUS готовит новые ИИ-решения, оснащённые сетевым ускорителем NVIDIA BlueField-3 SuperNIC.

07.06.2024 [15:42], Руслан Авдеев

«ИИ-гигафабрика» xAI разместится в гигантском дата-центре в ТеннесиИИ-стартап xAI, курируемый Илоном Маском (Elon Musk), намерен построить гигантский дата-центр с самым производительным в мире ИИ-суперкомпьютером. По данным Datacenter Dynamics, ЦОД разместится в окрестностях Мемфиса (штат Теннесси), а пока ожидает одобрения властей. В обозримом будущем компания должна получить сотни тысяч ускорителей для обучения новых моделей, в частности, чат-бота Grok, предлагаемого, например, по подписке в социальной сети X (Twitter). Ранее в Сеть утекла информация, что NVIDIA передаст xAI чипы, изначально предназначавшиеся для Tesla — Маск весьма вольно распоряжается активами подконтрольных ему бизнесов, часто вызывая недовольство инвесторов. Пока проект ожидает окончательного разрешения от местного бизнес-инкубатора Memphis Shelby County Economic Development Growth Engine (EDGE), а также муниципальных и федеральных властей. Впрочем, гораздо важнее дождаться одобрения энергетической компании Tennessee Valley Authority (TVA). Реализация проекта сулит появление высокооплачиваемых рабочих мест и увеличение доходов штата, что поможет поддерживать и модернизировать местную инфраструктуру. Муниципальные власти уже назвали проект «крупнейшей мультимиллиардной инвестицией в истории Мемфиса, а Маск окрестил ЦОД «гигафабрикой для вычислений» по аналогии с Tesla Gigafactory. По данным местных СМИ, приглянувшаяся Маску площадка принадлежит инвесткомпании Phoenix Investors, сотрудничающей с xAI и местными властями. Ранее объект управлялся компанией Electrolux. Неизвестно, насколько масштабной будет первая фаза проекта и сколько средств на неё потратят. Ранее Маск заявлял, что xAI развернёт в ближайшие месяцы 100 тыс. ускорителей NVIDIA H100, а кластер из ещё 300 тыс. B200 введут в эксплуатацию следующим летом. Считается, что xAI арендует около 16 тыс. H100 у Oracle Cloud, также компания пользуется услугами AWS и свободными мощностями X (Twitter).

07.06.2024 [13:35], Руслан Авдеев

Новый трюк КНР: китайские компании пытаются использовать запрещённые к экспорту чипы на территории самих СШАКитайские компании, лишённые доступа к передовым ИИ-чипам из-за введённых США санкций, освоили новую схему обхода ограничений. По данным The Register, теперь они покупают доступ к подсанкционному оборудованию непосредственно на территории Соединённых Штатов. О возможности подобной схемы эксперты предупреждали уже давно. По слухам, Alibaba и Tencent вели переговоры с NVIDIA о получении тем или иным способом доступа к ускорителям, продажа которых в Китай ограничена — бизнесы из КНР рассматривали возможность использовать их в ЦОД на территории США. China Telecom, как считается, тоже вела переговоры с облачными провайдерами о получении доступа к высокопроизводительному ИИ-оборудованию. Другими словами, китайский бизнес намерен обходить американские санкции, покупая или арендуя оборудование под боком у Вашингтона. Владелец TikTok — компания ByteDance, похоже, тоже участвует в подобных схемах со своим партнёром Oracle, у которого она арендует доступ к передовым ускорителям NVIDIA.

Источник изображения: Mark Daynes/unsplash.com В NVIDIA ответили на запросы журналистов, сообщив, что поддерживают новые дата-центры в США, расширяя вычислительные экосистемы и создавая рабочие места. В компании подчеркнули, что все клиенты американских ЦОД должны соблюдать местные законы, включая правила экспортного контроля и прочие ограничения. США уже годами вовлечены в «полупроводниковую войну» и применили в отношении Китая несколько пакетов санкций, призванных ограничить доступ Китаю к данным о передовых архитектурах чипов и современному оборудованию для их производства. Конечно, КНР ищет пути для обхода ограничений — например, компании вроде Huawei неоднократно ловили на попытках так или иначе обмануть американскую санкционную машину. В то же время США пытаются наладить производство чипов на территории страны — сегодня большинство передовых полупроводников выпускается на Тайване. Это только усилит желание КНР получить доступ к самым современным технологиям и подстегнёт не только инвестиции в полупроводниковую отрасль, но и поиск новых путей обхода санкций. Правда, пока не известно, могут ли считаться китайские компании, пытающиеся организовать вычисления на территории США, нарушителями законов или они просто ловко нашли пробел в американском законодательстве.

07.06.2024 [10:33], Сергей Карасёв

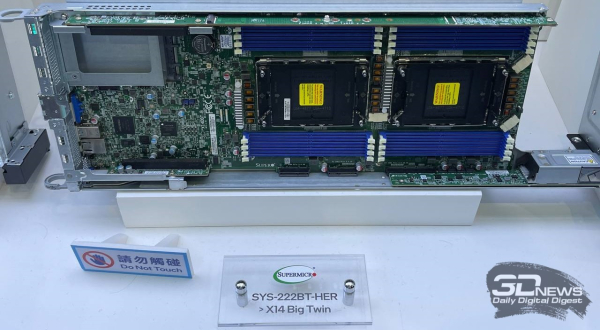

Supermicro представила серверы семейства X14 на платформе Intel Xeon 6, в том числе с СЖОКомпания Supermicro анонсировала серверы нового поколения X14 на аппаратной платформе Intel Xeon 6. Дебютировало большое количество стоечных систем разного класса для облачных приложений, периферийных вычислений, телекоммуникационных сервисов и пр. Как и ожидалось, в серию X14 вошли модели SuperBlade для НРС-задач и аналитики данных, высокопроизводительные серверы Hyper для масштабируемых облачных рабочих нагрузок, решения CloudDC для дата-центров, системы Hyper-E для периферийных задач, а также устройства WIO, BigTwin, GrandTwin и Edge/Telco. Кроме того, дебютировали серверы хранения Petascale Storage, которые, по заявлениям Supermicro, обеспечивают лучшие в отрасли показатели плотности и производительности. Эти решения в формате 1U или 2U поддерживают работу с накопителями EDSFF E1.S и E3.S. Новые серверы комплектуются процессорами Intel Xeon 6, ранее известными под кодовым именем Sierra Forest. Чипы могут содержать до 144 энергоэффективных E-ядер. В дальнейшем Supermicro выпустит серверы с процессорами Xeon 6 с производительными P-ядрами (ранее — Granite Rapids). Готовятся GPU-системы для ИИ-нагрузок, обучения больших языковых моделей (LLM) и ресурсоёмких приложений НРС. Кроме того, будут представлены многоузловые платформы. Для некоторых новинок предусмотрено использование СЖО.

На выставке Computex 2024 компания Supermicro также демонстрирует ИИ-системы SuperCluster на базе NVIDIA Blackwell и NVIDIA HGX H100/H200. Эти мощные комплексы могут оснащаться воздушным или жидкостным охлаждением.

06.06.2024 [13:23], Руслан Авдеев

Маск подтвердил передачу ИИ-стартапу xAI 12 тыс. ускорителей H100, предназначавшихся TeslaГлава Tesla и других компаний Илон Маск (Elon Musk) подтвердил передачу ускорителей NVIDIA H100, ранее заказанных Tesla, социальной сети X и ИИ-стартапу xAI. Слухи об этом, напоминает The Register, появились в СМИ — в распоряжение журналистов попала внутренняя документация и электронная переписка с NVIDIA. В частности, в одной из записок за декабрь прошлого года прямо указывалось, что Илон отдаёт приоритет внедрению 12 тыс. ускорителей в X вместо Tesla. Общая стоимость такого количества H100 превышает $500 млн. Вместо этого заказанные для X экземпляры H100 позже будут переданы Tesla (поставки ожидались в январе и июне 2024 года). Кроме того, есть проблемы и с созданием ИИ-суперкомпьютера Dojo на базе собственных чипов, который должен улучшить положение Tesla. Приоритетным для Маска, вероятно, является кластер H100, создаваемый X и тесно связанным с сетью стартапом xAI. Компании совместно работают над большими языковыми моделями, стоящими за чат-ботом Grok, уже доступным премиум-подписчикам X. По данным утечки из NVIDIA, 100 тыс. H100 приказано передать к концу года в xAI для создания «крупнейшего в мире» кластера ускорителей, который разместится в Северной Дакоте.

Источник изображения: Alexander Shatov/unsplash.com Хотя на уровне компаний комментариев не поступало, сам Маск подтвердил, что у Tesla просто не было места для чипов NVIDIA, поэтому они хранились на складе. При этом ещё не так давно Маск уверял инвесторов Tesla, как важны HPC-системы и ИИ для компании. Более того, ещё в апреле появилась новость о том, что автопроизводитель только в течение одного квартала вложил в ИИ $1 млрд. Также миллиардер сообщал, что один из заводов Tesla в Техасе вместит 50 тыс. H100 для обучения систем автономного вождения, в общей сложности число ускорителей достигло бы 85 тыс. Пока нет точных данных об обстоятельствах передачи ускорителей между Tesla и X или xAI. Нет даже информации о том, заплатила ли уже Tesla за «железо» и получила ли за него какую-то компенсацию. Условия передачи H100 могут иметь большое значение с учётом того, что Маск не является единоличным владельцем Tesla. Если выяснится, что Маск злоупотребил властью, к нему могут возникнуть вопросы как у инвесторов, так и у регуляторов. Впрочем, Tesla не впервые приходится делиться активами с X. Вскоре после покупки Twitter более 50 сотрудников автопроизводителя якобы отправили на «усиление» социальной соцсети. Есть данные, что сотрудников Tesla привлекают к работам и в других компаниях Маска, причём без дополнительной платы. Время для новостей не особенно удачное — на следующей неделе акционеры Tesla будут голосовать по ряду предложений, главным из которых является официальный перенос штаб-квартиры в Техас. Также речь пойдёт о переизбрании брата Кимбала, брата Илона Маска (Kimbal Musk), в совет директоров и других ключевых для бизнесмена вопросах. Тем временем в Tesla падают продажи со II половины 2022 года, увольняют сотрудников и, главное, стоимость акций компании падает критическими темпами. Приказ передать H100 станет дополнительным козырем в руках критиков миллиардера, которые утверждают, что его активное участие в других проектах мешает ему сконцентрироваться на автобизнесе и эффективно выполнять обязанности главы Tesla.

05.06.2024 [22:51], Илья Коваль

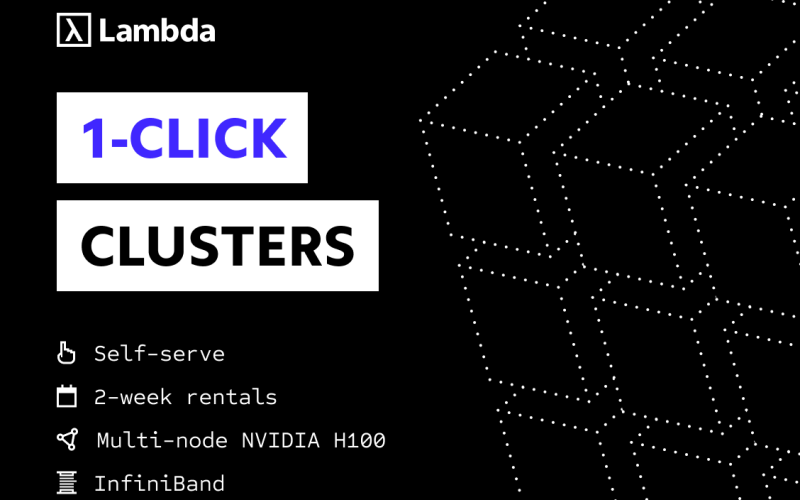

ИИ-кластер в один клик и без долгого ожидания: Lambda Labs представила услугу краткосрочной аренды до 512 NVIDIA H100Облачный провайдер Lambda Labs представил услугу 1-Click Clusters, которая позволяет без длительного ожидания получить ИИ-кластер, включающий от 64 до 512 ускорителей NVIDIA H100, на срок от двух недель по единой цене $4,49/час за каждый ускоритель. По словам сооснователя компании, данное предложение является уникальным и с рыночной, и с технической точки зрения. Lambda Labs говорит, что на практике большинству ИИ-разработчиков как правило требуется доступ к кластерам из десятков или сотен ускорителей на относительно короткие периоды обучения и проверки моделей длительностью несколько недель. При этом долгосрочная аренда кластера, который будет периодически простаивать, обходится дорого. А аренда на короткий срок нередко сопряжена с длительным ожиданием доступности ускорителей как раз в тот момент, когда они больше всего нужны. При этом без общения с отделом продаж вряд ли удастся обойтись. Именно поэтому Lambda Lambs и предложила услугу 1-Click Clusters, в рамках которой на получение ИИ-кластера уходит не более нескольких дней. Аппаратная составляющая включает узлы на базе HGX H100 с 208 vCPU, 1,9 Тбайт RAM и локальным NVMe-хранилищем ёмкостью 24 Тбайт. Все узлы связаны 400G-интерконнектом NVIDIA Quantum-2 InfiniBand, а каждому ускорителю полагается свой адаптер NVIDIA ConnectX-7. Как утверждает сооснователь Lambda Labs, мало кто из облачных провайдеров способен «нарезать» крупную InfiniBand-фабрику, объединяющую тысячи ускорителей, на небольшие виртуализированные кластеры, причём делать это без участия человека. В состав каждого кластера также входят три управляющих узла: 8 vCPU, 34 Гбайт RAM, 208 Гбайт NVMe SSD и один внешний IP-адрес. За интернет-подключение отвечают два общих 100-Гбит/с канала, причём плата не берётся ни за входящий, ни за исходящий трафик. Дополнительно можно арендовать сетевое хранилище по цене $0,20/мес. за каждый Гбайт. Кластеры поставляются вместе с набором ПО Lambda Stack, который включает все необходимые драйверы и библиотеки, популярные фреймворки и средства разработки.

05.06.2024 [14:58], Руслан Авдеев

Зачем арендовать, когда можно купить: CoreWeave захотела приобрести за $1 млрд своего хостинг-провайдера Core Scientific [Обновлено]Облачный провайдер CoreWeave предложил $1 млрд компании Core Scientific, предоставляющей хостинг для HPC-систем и параллельно занимающейся криптомайнингом. Datacenter Dynamics сообщает, что предложение поступило всего через несколько дней после подписания соглашения на аренду 200 МВт в течение 12 лет за $3,5 млрд. Как сообщают отраслевые источники, речь идёт о покупке компании из расчёта $5,75 за акцию — это несколько меньше биржевой стоимости Core Scientific на момент предложения. Компании сотрудничают уже несколько лет — в Core Scientific говорят об аренде «тысяч ускорителей» с 2019 по 2022 гг. Если соглашение об аренде 200 МВт останется в силе, то последней придётся модифицировать многочисленные площадки для размещения ускорителей NVIDIA, принадлежащих CoreWeave. Модернизация должна начаться летом 2024 года, а закончить её планируется в первой половине 2025-го. На это потребуется около $300 млн, которые будут получены от платежей CoreWeave за хостинг, но инвестировать можно будет не более половины от ежемесячной платы. Договор с CoreWeave позволяет дважды продлить аренду мощностей сроком на пять лет, в том числе на других площадках Core Scientific. Предполагается, что сделка с CoreWeave позволит диверсифицировать бизнес и сбалансировать майнинг и хостинг для ИИ-проектов для максимизации прибыли и минимизации рисков. В Core Scientific заявили, что из доступных ей почти 1,2 ГВт мощностей она может выделить до 500 МВТ для HPC/ИИ-хостинга. Часть майнинговых проектов перенесут с одних площадок на другие, компактно высвобождая место для HPC-кластеров. CoreWeave, основанная в 2017 году, в своё время и сама занималась криптовалютами и блокчейн-технологиями, но впоследствии переключилась на облачные ИИ-платформы. Компания привлекла миллиарды долларов в качестве инвестиций и просто в долг. На сегодня она предлагает сервисы в трёх регионах: US East (Нью-Джерси), US West (Невада) и US Central (Иллинойс). Компания активно арендует мощности и к концу 2023 года намеревалась управлять 14 дата-центрами, а к концу 2024 — 28 ЦОД. CoreWeave заявила, что потратит $1,6 млрд на постройку ЦОД для ИИ-супероблака, перенесёт часть мощностей в ЦОД Chirisa, арендует дата-центры Flexential и TierPoint в США. В марте этого года CoreWeave арендовала 16 МВт в ЦОД Core Scientific в Остине (Техас). Компания считается крупным клиентом Digital Realty, арендующим стойки для «десятков тысяч» ускорителей в одном из ЦОД на западном побережье США. Недавно компания анонсировала строительство двух ЦОД в Великобритании и присматривается к ЦОД EdgeConneX в Барселоне. Прямым конкурентом компании считается Lambda Labs, масштабы бизнеса которой гораздо скромнее. Core Scientific тоже основана в 2017 году, но управляет криптомайнинговыми кампусами ЦОД в США. Всего компания располагает 745 МВт доступной энергии и ещё 372 МВт зарезервированной ёмкости. У неё имеется собственное майнинговое оборудование и, конечно, на её мощностях расположено оборудование клиентов. Впрочем, дела Core Scientific идут довольно плохо — в декабре 2022 года она подала заявление о банкротстве, после чего цена её акций упала на 98 %. UPD 06.06.2024: руководство Core Scientific отказалось от предложения CoreWeave о покупке, отметив, что ведёт переговоры с другими клиентами по поводу предоставления ёмкостей для хостинга HPC- и ИИ-проектов. Компания считает, что для неё это пока более прибыльно, чем продажа. На фоне последних новостей акции компании выросли. UPD 26.06.2024: CoreWeave подписала с Core Scientific ещё одно соглашение об аренде, на этот раз на 12 лет и 70 МВт. |

|