Материалы по тегу: ibm

|

30.03.2025 [01:58], Владимир Мироненко

IBM сокращает персонал в США, но активно нанимает малоопытных сотрудников в ИндииПосле того, как ресурс The Register сообщил на прошлой неделе о планах IBM сократить около 9 тыс. рабочих мест в США в 2025 году, с ним связались нынешние и уволенные сотрудники, которые подтвердили, что сокращения персонала в США даже более значительные, чем сообщалось, и компания постепенно перемещает рабочие места в Индию. Это подтверждают и размещаемые IBM на своём сайте вакансии. Если 7 января 2024 года на нём было всего 173 открытых вакансии в Индии, то 23 ноября 2024 года для работы в этой стране было размещено 2946 вакансий, а на момент публикации статьи — 3866 вакансий. Сотрудник IBM, которого уже известили о сокращении его рабочего места (Resource Action, RA), рассказал, что об этом ему сообщили после того, как ему поручили обучить навыкам работы недавно нанятых работников в Индии. После получения уведомления о RA сотрудники имеют право в течение установленного периода подать заявку на отрытые вакансии в других подразделениях IBM. Но то, что у IBM в США есть открытые вакансии, вовсе не означает, что компания собирается нанимать здесь сотрудников. «Все, к кому я обращался внутри компании с просьбой о переводе, говорили одно и то же: “Я могу нанимать только в Индии”», — сообщил источник The Register. С подобной ситуацией сталкивались и другие собеседники ресурса. Один из бывших сотрудников IBM рассказал, что в IV квартале 2024 года было много увольнений, по слухам, исчисляемых тысячами, однако в Индии, наоборот, было размещено более тысячи вакансий. «Фаворитизм был вопиющим», — отметил он. По его словам, у многих из уволенных был большой опыт работы с облаком, но их заменили людьми без особого опыта или даже новичками. Также IBM передала на полный аутсорсинг в Индию вопросы обеспечения качества (QA). «Они пытались заменить высококвалифицированных QA-инженеров — некоторые из которых имели более десяти лет опыта — новыми сотрудниками, обученными всего за полгода. Последствия были предсказуемы: резкое снижение качества и эффективности», — рассказал источник. «На этом этапе IBM может также перенести свою штаб-квартиру в Индию, поскольку она больше не отдает приоритет США», — то ли в шутку, то ли всерьёз предположил один из источников. Собеседник The Register, рассказавший о сокращениях в подразделении Cloud Classic, сообщил, что увольнения проводятся и в других подразделениях IBM. Его слова подтверждаются появившимися недавно сообщениями об сокращениях рабочих мест в филиале компании в Северной Каролине, а также в Канаде. В феврале 2024 года представитель IBM сообщил The Register, что компания ожидает завершить 2024 год примерно с тем же уровнем занятости, что и в начале года. Вместе с тем, IBM сократила 11,9 тыс. рабочих мест или 4,2 % общей численности в 2024 году, в то время в Индии было добавлено около 3 тыс. открытых вакансий. Поэтому, как полагает The Register, данные о планируемом IBM сокращении рабочих мест в 2025 году в пределах 9 тыс. являются заниженными, поскольку сокращение, как ожидается, будет более масштабным.

11.03.2025 [16:08], Руслан Авдеев

IBM засудила разработчика эмулятора мейнфреймов LzLabsКомпания IBM одержала победу в лондонском суде над LzLabs, разработавшей эмулятор Software Defined Mainframe (SDM) для запуска приложений для мейнфреймов на обычных x86-серверах под управлением Linux. По мнению IBM, LzLabs фактически украла её интеллектуальную собственность и теперь представляет угрозу её бизнесу, сообщает Datacenter Dynamics. IBM подала в суд на LzLabs и связанные компании несколько лет назад. IT-гигант заявил, что Winsopia — дочерняя структура LzLabs — приобрела у IBM мейнфрейм и сопутствующую лицензию в 2013 году. Позже компания использовала полученные продукты для реверс-инжиниринга — фактически она декомпилировала ПО IBM. В вынесенном в понедельник Высоким судом Лондона вердикте говорится, что швейцарская LzLabs и её владелец Джон Мурс (John Moores) нарушили условия лицензирования, чтобы разработать собственное программное обеспечение для создания относительно недорогой альтернативы мейнфреймам IBM. По мнению суда, Winsopia нарушила условия лицензирования, а LzLabs и Мурс незаконно способствовали этому. Последний является основателем компании BMC Software, а также контролирует фонд JMI Equity, инвестирующий в IT-бизнесы. Ответчики утверждали, что программное обеспечение их компании разрабатывалось более десяти лет без влияния технологий IBM. LzLabs основали в 2011 году, первый продукт появился в 2016-м. Речь шла о платформе, позволявшей переносить рабочие нагрузки с мейнфреймов (COBOL или PL/I) на x86-серверы под управлением Linux, в том числе в облаках. С тех пор компания добавила поддержки контейнеризированных рабочих нагрузок, что упрощает перенос приложений с мейнфреймов на современные облачные платформы. Так, швейцарская телеком-компания Swisscom перенесла свои приложения на платформу LzLabs SDM, развёрнутую в облаке, без перекомпиляции исходного кода. Другими словами, LzLabs стала конкурентом IBM в сфере мейнфреймов. Сама IBM «в восторге» от решения британского суда, который признал, что ответчики шли на нарушения систематически и намеренно для получения критически важных технологий IBM для мейнфреймов. При этом IBM вложила в соответствующие решения миллиарды долларов. Дальнейшие слушания состоятся в текущем году — предстоит выяснить, какую компенсацию может получить IBM. Претензии к ещё одной британской дочерней структуре, LzLabs Limited, а также к действующему и бывшему генеральным директорам компании-ответчика отклонены. IBM подала отдельный иск против LzLabs в Техасе в 2022 году, обвинив последнюю в нарушении патентного законодательства. В данном случае IBM требует компенсации ущерба и судебного запрета на использование её интеллектуальной собственности. Тем временем в США не поддержали иск компании BMC Software к IBM на $1,6 млрд. IBM ещё в 2017 году обвиняли в том, что та незаконно заменила в мейнфреймах AT&T программное обеспечение BMC на собственное. Если в 2022 году суд в Техасе обязал IBM выплатить более миллиарда долларов, то недавно Верховный суд США отклонил это решение после успешной апелляции в 2024 году, постановив, что AT&T по собственному желанию заменила одно ПО на другое и что это не противоречит условиям контракта. Верховный суд отказался рассматривать очередную апелляцию BMC, фактически подтвердив прежнее решение суда.

04.03.2025 [14:38], Руслан Авдеев

IBM закрыла R&D-центр в Китае, оставив без работы 1,8 тыс. специалистовПодразделение IBM China Investment Company Limited (IBMV) и её дочерние компании прекратили работу в КНР. Уход компании из Китая 1 марта скажется на карьерах более 1,8 тыс. сотрудников, занимавшихся исследованиями, разработками и тестированием в Пекине, Шанхае, Даляне и других городах, сообщает DigiTimes. По данным местных источников, штаб-квартира IBMV в Пекине уже пустует. После того, как Китай и США установили дипломатические отношения в 1979 году, IBM начала вести дела с КНР, инвестируя в местный бизнес на фоне экономического бума. Основанная в 1992 году компания IBMV курировала инициативы IBM в Китае. В августе 2024 года IBM неожиданно объявила, что сократит R&D-активность в Китае и что это коснётся более 1,6 тыс. человек. По слухам, распространяющимся в китайском сегменте интернета, на новый шаг компания, возможно, пошла под влиянием её главы Арвинда Кришны (Arvind Krishna) родом из Индии. У КНР и Индии довольно напряжённые отношения, а теперь последняя ещё и претендует на то, чтобы стать «мировой фабрикой» вместо Поднебесной, хотя производственные потенциалы пока несопоставимы. Так или иначе, недавно штат лабораторий в Пекине, Шанхае и Даляне оповестили в ходе онлайн-встречи, что их задачи будут переданы за рубеж.

Источник изображения: zhang kaiyv/unsplash.com С 1992 года в Китае работает полностью принадлежащее IBM коммерческое подразделение, которое сразу же стало приносить прибыль, в основном благодаря продаже мейнфреймов. Со временем IBM сместила фокус с выпуска оборудования на разработку ПО с полным спектром обслуживания, включая консалтинг (IBMC). По слухам, в 2025 году здесь также пройдут сокращения. Сейчас почти половина бизнеса IBM приходится именно на программное обеспечение, причём компания регулярно проводит увольнения в других регионах, а часть персонала и вовсе намерена заменить ИИ. В 2023 году эскалация отношений между США и Китаем привела к падению выручки и оттоку китайских клиентов, что, возможно, тоже сподвигло IBM отказаться от исследований и разработок в Китае. Признаки того, что IBM может уйти из КНР, были и ранее. Например, местные сотрудники компании неофициально сообщали журналистам о сокращении бизнеса. В 2023 году некоторых сотрудников перевели на другие задачи, а часть работ перенесли в Индию и Юго-Восточную Азию. Пока не вполне ясна и судьба совместного с китайской Inspur предприятия Inspur Business Machines (тоже IBM), сформированного для выпуска мощных серверных систем на базе открытой архитектуры POWER для крупного бизнеса. Правда, в 2023 году Вашингтон закрыл Inspur доступ к новейшим технологиям США, но в Китае POWER-процессоры разрабатываются уже давно.

03.03.2025 [11:30], Сергей Карасёв

IBM завершила сделку по покупке HashiCorp за $6,4 млрдКорпорация IBM после получения необходимых разрешений со стороны регулирующих органов завершила процедуру поглощения HashiCorp — разработчика набора открытых инструментов для управления облачной инфраструктурой. Стоимость сделки составила $6,4 млрд. О намерении купить HashiCorp компания IBM объявила в апреле прошлого года. Предполагалось, что слияние будет завершено до конца 2024-го, но сделкой заинтересовались различные антимонопольные органы, включая Управление по защите конкуренции и рынкам Великобритании (CMA) и Федеральную комиссию по торговле США (FTC). Одобрения были окончательно получены в феврале. Слияние является частью масштабной инициативы IBM, направленной на развитие концепции гибридного облака и повсеместное внедрение инструментов ИИ. Благодаря интеграции решений HashiCorp и IBM клиенты получат комплексную платформу для автоматизации развёртывания и координации рабочих нагрузок в различных инфраструктурах, включая локальные среды, гипермасштабируемые и частные облака. Особое внимание будет уделено объединению возможностей системы HashiCorp Terraform и платформа Ansible, которую IBM получила в результате приобретения Red Hat в 2018 году. Эти инструменты автоматизации сокращают объём работы, связанной с настройкой IT-инфраструктуры. Terraform ориентирована на предоставление облачных ресурсов, в то время как Ansible можно использовать для настройки ПО, работающего поверх этих ресурсов. Другим направлением совместной деятельности станет интеграция HashiCorp Vault (управление ключами шифрования, паролями и т.п.) с различными продуктами IBM, включая Ansible, OpenShift и Guardium. Кроме того, планируется интеграции Terraform и Cloudability (помогает компаниям отслеживать свои расходы на облако). В целом, как ожидается, покупка HashiCorp поможет IBM укрепить позиции в различных стратегических областях, таких как платформы Red Hat, Watsonx, безопасность данных, IT-автоматизация и консалтинг. Компании уже начали процесс объединения своих программных продуктов.

28.02.2025 [12:16], Сергей Карасёв

IBM представила СХД FlashSystem C200 формата 2U с эффективной ёмкостью 2,3 ПбайтКорпорация IBM анонсировала систему хранения FlashSystem C200 класса All-Flash, которая, как утверждается, предлагает оптимальный баланс цены, производительности и вместимости. Новинка может рассматриваться в качестве альтернативы платформам на основе HDD и гибридным решениям. Устройство выполнено в форм-факторе 2U с двумя контроллерами. Задействованы в общей сложности 32 ядра Intel Xeon (модель процессоров не уточняется). Говорится о наличии 32 Гбайт «кеш-памяти». Установлены два блока питания неназванной мощности. СХД базируется на накопителях FlashCore Modules (FCM) четвёртого поколения: задействованы проприетарные изделия IBM на чипах QLC NAND. Утверждается, что такие изделия обеспечивают в 5,5 раза больше циклов записи, чем стандартные QLC-накопители. В общей сложности в состав FlashSystem C200 включены 24 модуля FCM ёмкостью 46 Тбайт каждый. Это обеспечивает «сырую» вместимость в 1,1 Пбайт, тогда как эффективная ёмкость с учётом компрессии достигает 2,3 Пбайт. Заявленная задержка составляет 1–2 мс, показатель IOPS — до 200 тыс. Пропускная способность — до 23 Гбайт/с. Система оптимизирована для последовательных нагрузок.

Источник изображения: IBM Система располагает восемью портами 10GbE. Опционально могут быть добавлены порты Ethernet в конфигурации 8 × 25/10GbE NVMe-TCP и Fibre Channel в конфигурации 16 × 32G FC/NVMe-FC. Кроме того, предусмотрен выделенный сетевой порт управления на основе разъёма RJ45. FlashSystem C200 может применяться в составе многоуровневого хранилища. По заявлениям IBM, новая СХД обеспечивает 10-кратный прирост производительности по сравнению с решениями на базе HDD. При этом достигается снижение энергопотребления, а также повышение экономической эффективности благодаря сокращению капитальных затрат и расходов на техническое обслуживание. Новинка поступит в продажу 21 марта по цене $381 тыс.

31.01.2025 [08:46], Владимир Мироненко

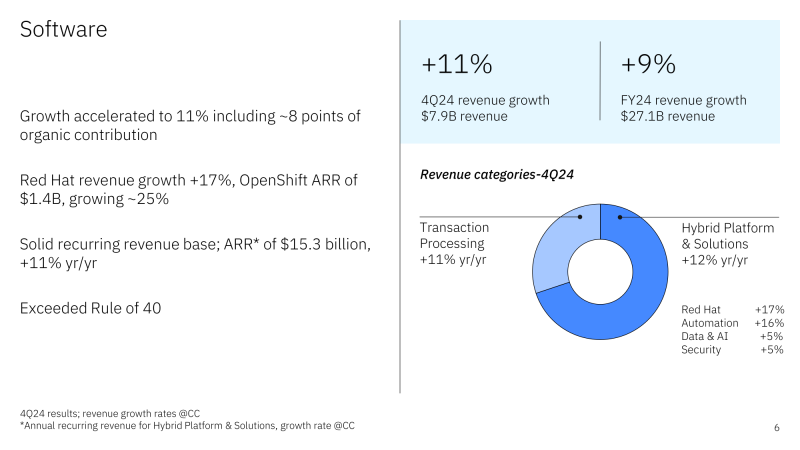

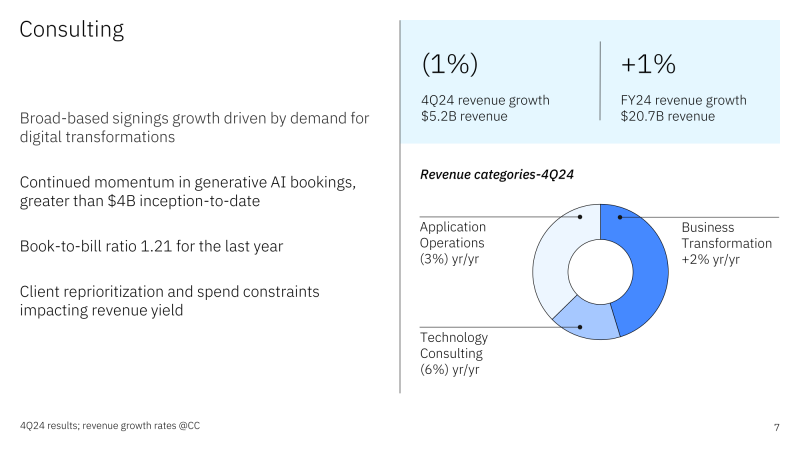

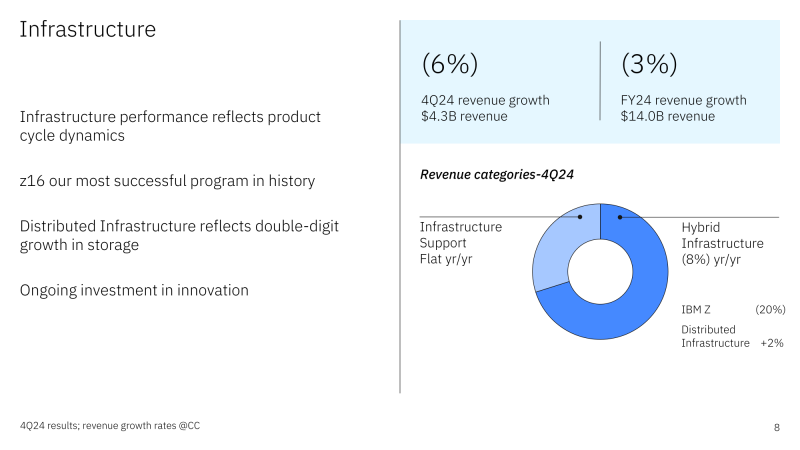

Почти половина бизнеса IBM теперь приходится на ПО — компания делает ставку на ИИ и open sourceИнвесторы поддержали стратегию развития IBM направления, касающегося развёртывания технологий ИИ, что нашло выражение в росте акций после публикации компанией отчёта за IV квартал и 2024 финансовый год, завершившийся 31 декабря, пишет газета The Wall Street Journal. Также свою роль сыграло то, что основные показатели IBM превысили прошлогодние результаты и прогнозы Уолл-стрит. Ранее IBM объявила, что приняла подход открытых инноваций к ИИ, открыв исходный код своих решений. В мае компания выпустила открытые модели Granite Foundation, а до этого она вместе с NASA сделала открытой базовую ИИ-модель для анализа спутниковых данных и выложила её на Hugging Face. Финансовый директор IBM Джеймс Кавано (James Kavanaugh) отметил, что стратегия open source делает технологию более экономически эффективной и более простой в масштабировании. Это соответствует подходу китайского стартапа DeepSeek, ИИ-модели которого вызвали шок на рынке. Общая выручка IBM за IV квартал увеличилась на 1 % до $17,6 млрд, что соответствует ожиданиям аналитиков, опрошенных LSEG. При этом скорректированная прибыль на разведённую акцию (Non-GAAP) составила $3,92 при прогнозе аналитиков $3,75. Чистая прибыль (GAAP) IBM за квартал составила $2,92 млрд или $3,09 на разведённую акцию, тогда как годом ранее эти показатели равнялись $3,29 млрд и $3,55 на акцию. Подразделение ПО увеличило выручку в годовом исчислении на 10 % до $7,92 млрд, чему способствовал рост выручки Red Hat на 16 %. Платформа OpenShift обеспечила почти половину этого объёма. Выручка подразделения по автоматизации увеличилась на 15 %, подразделения по обработке данных и ИИ — на 4 %. Компания отметила, что объём бизнеса в сфере генеративного ИИ теперь составляет более $5 млрд, что почти на $2 млрд больше, чем кварталом ранее. Гендиректор IBM Арвинд Кришна (Arvind Krishna) сообщил, что на ПО теперь приходится около 45 % бизнеса IBM с годовым оборотом более $15 млрд и двузначным ростом. Продажи консалтингового подразделения IBM снижаются четвёртый квартал подряд, на это раз на 2 % до $5,18 млрд. Клиенты продолжают перенаправлять средства из традиционных консалтинговых проектов в проекты, ориентированные на ИИ, сообщил Кавано, отметив, что скорее всего, это временно. «Мы завершили год с самым высоким в истории зафиксированным количеством заказов за квартал, рост — на 23 %, — сказал он. — Мы по-прежнему имеем дело с очень динамичной средой вокруг того, как клиенты расставляют приоритеты в расходах». Около 80 % заказов поступает от консалтингового подразделения, а остальное — от подразделения ПО. Выручка инфраструктурного подразделения снизилась в отчётном квартале на 7,6 % до $4,26 млрд, что отражает приближающееся окончание трёхлетнего жизненного цикла мейнфреймов z16, продажи которых упали на 21 %. Ожидается, что следующее поколение z17 выйдет в середине года, что обеспечит рост доходов во II полугодии 2025-го. За весь 2024 финансовый год выручка IBM составила $62,8 млрд, превысив показатель 2023 финансового года на 1 %. Подразделение ПО увеличило выручку на 8 %, а у консалтингового подразделения этот показатель снизился на 1 %. У инфраструктурного подразделения выручка упала больше — на 4 %. В 2025 году IBM ожидает рост выручки не менее чем на 5 %. После публикации финансового отчёта акции компании выросли на внебиржевых торгах на 9 %, сообщил ресурс SiliconANGLE. За последние 12 месяцев цена акции IBM увеличилась на 22 %. Как отмечает The Register, компания сэкономила $3,5 млрд на операционных расходах в прошлом году и намеревается сэкономить столько же в 2025-м, что косвенно указывает на новую волну увольнений. В 2024 году их было как минимум две. Сведения о размере штата компания не обновляла уже больше года.

18.01.2025 [22:31], Владимир Мироненко

CoreWeave поставит IBM ИИ-суперкомпьютер на базе NVIDIA GB200 NVL72 для обучения моделей GraniteCoreWeave и IBM заключили соглашение о сотрудничестве, в рамках которого стартап поставит IBM один из первых своих ИИ-суперкомпьютеров на базе NVIDIA GB200 NVL72 с интерконнектом Quantum-2 InfiniBand. В качестве хранилища будет использоваться высокопроизводительная All-Flash СХД IBM Storage Scale System. IBM будет использовать облачную платформу CoreWeave для обучения семейства больших языковых моделей (LLM) Granite. Сообщается, что облачная платформа CoreWeave специально создана для обеспечения ведущей в отрасли производительности, надёжности и отказоустойчивости с безопасностью корпоративного уровня. Фирменный набор ПО и облачные сервисы предоставляют инструменты, необходимые для управления самой сложной и масштабной ИИ-инфраструктурой. В рамках соглашения о сотрудничестве клиенты CoreWeave получат доступ к платформе IBM Storage. По словам вице-президента по ИИ в IBM Research, платформа CoreWeave позволит дополнить возможности IBM при разработке передовых, производительных и экономичных моделей для поддержки корпоративных приложений и ИИ-агентов. В свою очередь, IBM Storage Scale System расширяет возможности CoreWeave. «В рамках сотрудничества мы будем использовать этот суперкомпьютер для продвижения открытых технологий, таких как Kubernetes, которые будут поддерживать вычисления ИИ в гибридной облачной среде», — добавил представитель IBM. Вероятно, IBM не хватает собственных вычислительных ресурсов — в ноябре появилась информация о том, что компания готова арендовать у AWS ИИ-ускорители за почти полмиллиарда долларов.

31.12.2024 [14:20], Сергей Карасёв

Регулятор Великобритании проверит сделку IBM по покупке HashiCorp за $6,4 млрдУправление по защите конкуренции и рынкам Великобритании (CMA) инициировало проверку сделки по покупке корпорацией IBM компании HashiCorp, которая специализируется на разработке набора открытых инструментов для управления облачной инфраструктурой. О планах по поглощению HashiCorp корпорация IBM объявила в апреле 2024 года. Стоимость сделки составляет $6,4 млрд. Приобретение HashiCorp, как ожидается, поможет IBM в реализации масштабной инициативы, направленной на развитие концепции гибридного облака и повсеместное внедрение инструментов ИИ. Ранее изучением последствий слияния занялась Федеральная торговая комиссия США (FTC). Теперь собственное расследование начал британский регулятор. В рамках проверки CMA определит, может ли приобретение ухудшить конкуренцию. Регулятор намерен собрать от участников рынка отзывы о сделке до 16 января 2025-го. Если будет установлено, что слияние несет антимонопольные риски, CMA примет решение о необходимости инициирования более глубокого расследования. Такая проверка может привести к вынесению постановления о блокировке сделки или о пересмотре определённых условий соглашения о покупке. Расследование CMA, как отмечает Siliconangle, может быть сосредоточено на тех отраслевых сегментах, где IBM и HashiCorp имеют сильные позиции. В частности, HashiCorp разрабатывает платформу Terraform, автоматизирующую задачи администрирования и конфигурирования облачных сред. В свою очередь, IBM предлагает схожий инструмент под названием Ansible, который она получила в результате приобретения Red Hat в 2018 году. Тогда как Terraform чаще всего используется для настройки именно облачных сред, Ansible лучше подходит для локальных развёртываний. Объединив эти продукты, IBM может предложить клиентам комплексное решение. Кроме того, деятельность HashiCorp и IBM пересекается в сегменте оркестрации. Платформа Red Hat OpenShift от IBM использует Kubernetes для управления рабочими нагрузками, а HashiCorp предлагает альтернативу под названием Nomad. HashiCorp также предоставляет ряд других инструментов, некоторые из которых автоматизируют задачи управления инфраструктурой, не входящие в зону охвата Terraform и Nomad.

20.11.2024 [17:16], Руслан Авдеев

AWS предоставит IBM доступ к ИИ-ускорителям на $475 миллионовAWS близка к заключению сделки с компанией IBM на сумму $475 млн. По данным Business Insider, компания готовится предоставить компании IBM доступ к своим облачным ИИ-решениям. Компании ведут переговоры о пятилетнем использовании IBM ИИ-ускорителей в облаке Amazon. В частности, IBM планирует задействовать инстансы EC2 с чипами NVIDIA, что подтверждается одним из внутренних документов Amazon. По некоторым данным, сотрудничество уже началось — IBM начала обучать отдельные модели на указанных системах с использованием платформы AWS SageMaker. Однако переговоры ещё продолжаются, и подписание окончательного соглашения пока не гарантировано. Примечательно, что IBM имеет собственное облако, где так же предоставляет доступ к ускорителям. Однако, по оценкам экспертов, её доля на мировом облачном рынке не превышает 10 %. Ранее, в 2024 году, IBM анонсировала увеличение использования сервисов AWS для своей платформы Watson AI. Компании намерены интегрировать IBM watsonx.governance с платформой Amazon SageMaker, чтобы помочь клиентам эффективно управлять рисками, связанными с ИИ-моделями, и упростить их использование.

Источник изображения: AWS Amazon активно продвигает чипы собственной разработки — Inferentia и Trainium, а ранее в этом месяце пообещала предоставить «кредиты» исследователям в сфере ИИ на сумму $110 млн для доступа к свои чипам в рамках программы Build on Trainium. Пока неизвестно, намерена ли IBM применять чипы AWS или отдаст предпочтение более популярным решениям, таким как продукты NVIDIA.

20.11.2024 [13:04], Руслан Авдеев

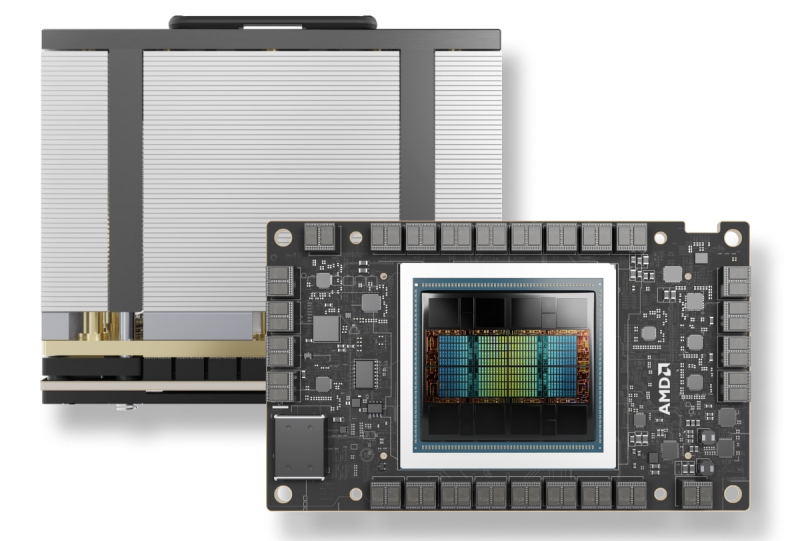

IBM и AMD расширяют сотрудничество: Instinct MI300X появится в облаке IBM CloudКомпания IBM объявила о расширении сотрудничества с AMD для предоставления ускорителей Instinct MI300X в формате «ускорители как услуга» (Accelerators-as-a-Service). По словам IBM, новое решение расширяет возможности и энергоэффективность генеративных ИИ-моделей и HPC-приложений. AMD Instinct MI300X станут доступны в IBM watsonx, а также будут поддерживаться в Red Hat Enterprise Linux AI. Они дополнят портфолио IBM Cloud, уже включающее Intel Gaudi 3 и NVIDIA H100. Ускоритель AMD Instinct MI300X оснащён 192 Гбайт памяти HBM3. И относительно малое количество ускорителей способно обеспечить работу больших ИИ-моделей, что позволяет снизить затраты с сохранением производительности и масштабируемости. Ускорители будут доступны в составе виртуальных серверов и частных виртуальных облаков, а также в контейнеризированных средах IBM Cloud Kubernetes Service и IBM Red Hat OpenShift. Кроме того, для MI300X будут доступны LLM Granite и инструмент InstructLab. Речь идёт в том числе об интеграции программных решений IBM с ПО AMD ROCm. По словам компании, предложенные решения обеспечит клиентов гибкой, безопасной, высокопроизводительной и масштабируемой средой для рабочих нагрузок ИИ. AMD Instinct MI300X станут доступны пользователям IBM Cloud в I половине 2025 года. |

|