Материалы по тегу: ibm

|

27.10.2024 [13:15], Владимир Мироненко

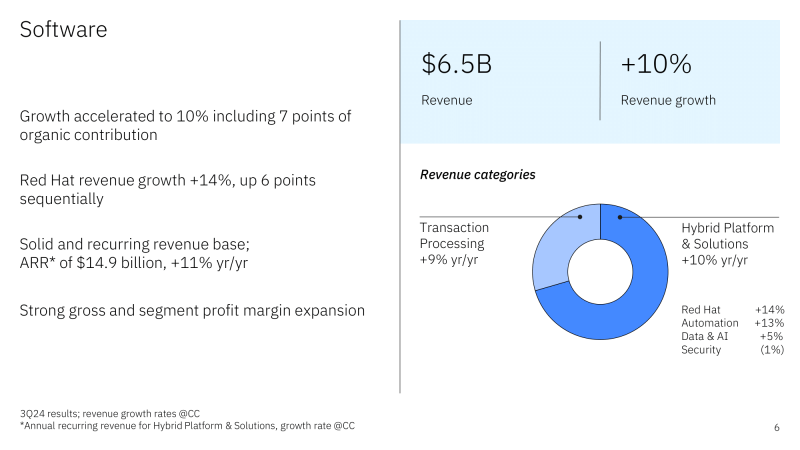

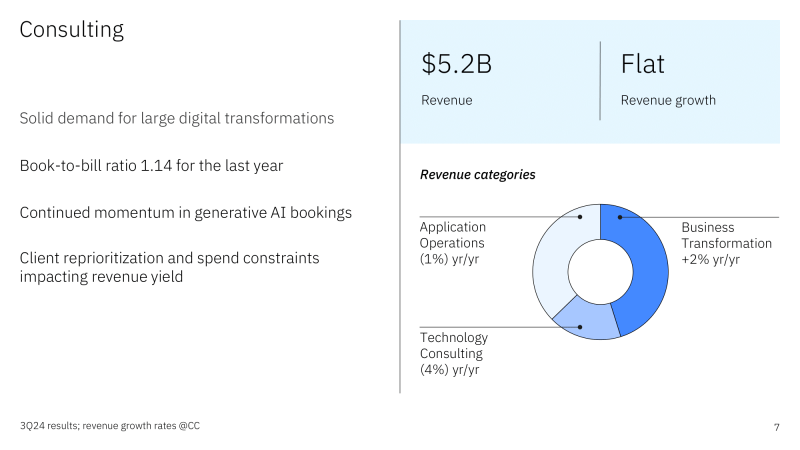

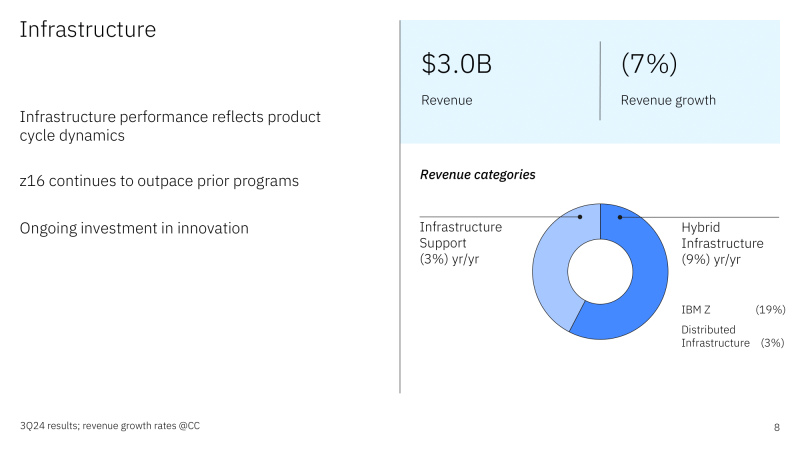

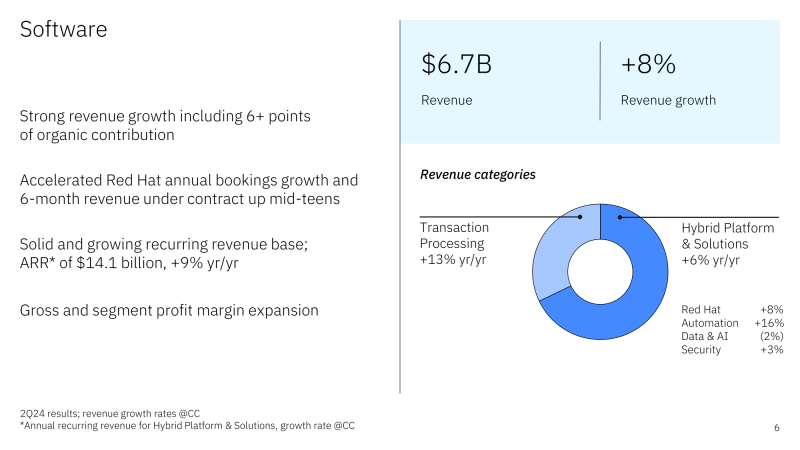

IBM разочаровала инвесторов слабой выручкой — мейнфреймы z16 завершают цикл, зато Red Hat показала ростIBM сообщила финансовые результаты III квартала 2024 года, завершившегося 30 сентября. После объявления результатов акции компании упали с $233 до $216 за шт., после чего отыграли до $255, поскольку выручка оказалась ниже ожиданий Уолл-стрит. Выручка IBM составила $14,97 млрд, что на 1,5 % больше результата аналогичного квартала годом ранее, но ниже консенсус-прогноза аналитиков, опрошенных LSEG, равного $15,07 млрд. При этом скорректированная прибыль на акцию (Non-GAAP) оказалась немного выше прогноза аналитиков $2,30 против $2,23. По GAAP у IBM были чистые убытки $330 млн (36 центов на акцию) по сравнению с чистой прибылью в $1,70 млрд ($1,84 на акцию) в аналогичном квартале годом ранее. Убытки образовались из-за единовременного платежа по пенсионному расчету в рамках соглашения со страховой компанией Prudential. ПО принесло IBM $6,52 млрд выручки, превысив прошлогодний результат на 9,7 %, а также консенсус-прогноз аналитиков, опрошенных StreetAccount, равный $6,37 млрд. Выручка Red Hat выросла год к году на 14 %, тогда как во II квартале рост составил 7 %. Джим Кавано (Jim Kavanaugh), финансовый директор IBM, отметил в ходе телефонной конференции с аналитиками, что это был самый успешный квартал по подпискам с момента приобретения Red Hat в 2019 году, а также то, что бизнес Red Hat удвоился с момента приобретения. Выручка подразделения по автоматизации увеличилась на 13 %, подразделения по обработке данных и ИИ — на 5 %. Валовая прибыль от продаж ПО составила 83 %, что выше, чем у других сегментов. Также отмечено, что доля выручки от ПО в общем объёме выручки составила 45 %. Генеральный директор Арвинд Кришна сообщил, что в августе была первая годовщина с момента приобретения Apptio, которая достигла «сильной синергии с нашими возможностями автоматизации и более широким портфелем программного обеспечения». Он добавил, что ожидаемое приобретение HashiCorp укрепит позиции IBM в сфере автоматизации инфраструктуры. Хотя выручка подразделения по обработке данных и ИИ выросла на 5 %, Кришна заявил, что бизнес IBM в области генеративного ИИ теперь составляет около $3 млрд в заказах, что больше, чем $2 млрд в последнем квартале. Старший аналитик Forrester Research Inc. Дарио Маисто (Dario Maisto) выразил мнение, что IBM хорошо продвигается в области ИИ, отметив её решение сделать открытыми ИИ-модели Granite Foundation. До этого IBM и NASA сделали открытой базовую ИИ-модели для анализа спутниковых данных и выложили её на Hugging Face. Самым большим разочарованием, как пишет ресурс SiliconANGLE, стал консалтинговый бизнес IBM, который остаётся на прежнем уровне из года в год, отражая то, что Кавано назвал «динамичной рыночной средой», когда предприятия тратят деньги с большой осторожностью. Консалтинговое подразделение принесло компании $5,2 млрд (снижение на 0,5 %). Инфраструктурное подразделение получило $3,65 млрд выручки (снижение на 7,0 %). При этом продажи в сегменте мейнфреймов IBM z упали на 19 %. Мейнфреймы z16 были выпущены в 2022 году, а это означает, что это поколение доступно уже 10-й квартал и его цикл подходит к концу. Арвинд Кришна отметил, что поколение z16 превзошло своих предшественников, и что ситуация улучшится, когда дебютирует поколение z17. Что касается прогноза, то в текущем квартале IBM ожидает рост выручки на уровне III квартала, драйвером которого будет ПО. Несмотря на нынешнее падение акций IBM, их рост с начала года составил 35 %.

14.10.2024 [14:58], Руслан Авдеев

В Брукхейвенской национальной лаборатории накопилось уже более 300 Пбайт физических данных — это больше, чем вся письменная история человечестваЦентр научных данных и вычислений (SDCC) Брукхейвенской национальной лаборатории (BNL) Министерства энергетики США (DoE) похвастался, что в его хранилищах находится уже свыше 300 Пбайт информации. Как сообщает Datacenter Dynamics, речь идёт о третьем по величине хранилище научных данных в Соединённых Штатах и крупнейшем в США архиве ленточных накопителей. Хранящиеся данные связаны с экспериментами в области ядерной физики и физики элементарных частиц. В пресс-релизе Брукхейвенской лаборатории руководство SDCC заявляет, что в архиве хранится вшестеро больше данных, чем составила бы вся письменная история человечества, начиная с источников на санскрите (50 Пбайт). В частности, в хранилище находятся данные, полученные в экспериментах на Релятивистском коллайдере тяжелых ионов (RHIC) Министерства энергетики США, который с 2000 года работает в Брукхейвенской лаборатории, и данные эксперимента ATLAS на Большом адронном коллайдере (БАК). Вся информация доступна онлайн и по запросу. Сведения хранятся в высокотехнологичной роботизированной ленточной библиотеке. В лаборатории уже разработано собственное ПО и веб-сайт для мониторинга передачи данных, структура также сотрудничает с другими лабораториями Министерства энергетики и IBM над развитием системы управления информацией — High-Performance Storage System (HPSS). Последняя гарантирует, что разные системы хранения данных, от лент до дисков, могут эффективно использоваться в различных комбинациях. Также разработано ПО, используемое физиками для доступа к информации SDCC. Представители SDCC сообщают, что лаборатория пользуется преимуществами гибридной СХД: данные хранятся в основном на лентах и переносятся на диски только в случае необходимости, что снижает стоимость эксплуатации и повышает экологичность хранения. Так, диски требуют охлаждения и энергию, тогда как ленты вне периода эксплуатации попросту лежат в библиотеках. Сами ленточные библиотеки размещены в специальных залах с оптимизированными энергопотреблением и охлаждением. Также имеются запасные ёмкости для растущего «кеша» данных, собираемых лабораториями. В рамках эксперимента sPHENIX учёные намерены получить около 565 Пбайт данных, которые одновременно пишутся и на диски, и на ленты. В следующем году на смену RHIC придёт EIC, который, как ожидается, будет генерировать 220 Пбайт/год. Отмечается, что ёмкость ленточных хранилищ обычно удваивается каждые 4–5 лет, а сами они становятся всё более компактными. Периодически перенося данные со старых носителей на новые, специалисты освобождают в библиотеке немало места. Сейчас потенциальная ёмкость библиотек Лаборатории составляет порядка 1,5 Эбайт, но учёные надеются, что со временем доведут её до 3 Эбайт. Примечательно, что спрос на ленточные картриджи только растёт. В 2023 году поставки достигли рекордного значения в 153 Эбайт. Правда, помогло это не всем вендорам.

19.09.2024 [12:12], Руслан Авдеев

IBM без лишнего шума отправит на улицу до 6 тыс. сотрудниковIBM увольняет значительное количество сотрудников, причём пытается сделать это без лишней огласки. По данным The Register, от массовых увольнений пострадал в первую очередь коллектив IBM Cloud, в последние дни сокращения коснулись тысяч людей. По данным одного из источников издания, всё «происходит втайне». По его словам, менеджер сообщил о необходимости подписания соглашения о неразглашении информации (NDA), запрещающее сообщать кому-либо детали увольнения. Впрочем, многочисленные сообщения на форумах, в социальных сетях и на других площадках позволяют предположить, что речь действительно идёт о масштабных увольнениях. На вопрос журналистов о вероятных сокращениях представитель IBM ответил, что ранее в этом году компания сообщала о «перебалансировке» рабочей силы, которая коснётся лишь небольшой доли общемирового штата. В финансовом отчёте компании за I квартал 2024 года утверждается, что она потратит $400 млн на «перебалансировку», связанную с планируемыми увольнениями. Для сравнения, в 2023 году подобная практика обошлась в $300 млн, тогда планировалось уволить 3900 человек. При этом компания намерена закончить 2024 год с примерно тем же количеством сотрудников, что и начинала. Происходит оптимизация бизнеса — вероятно, смена бизнес-стратегии предполагает увольнение специалистов одного профиля и приглашения на работу другого. На конец 2023 года в компании насчитывалось 288 тыс. человек по всему миру. По словам представителя IBM, в этом году речь идёт об единичных процентах возможных увольнений. В случае сокращения 1 % штата речь может идти о 2880 сотрудниках, 2 % — 5760 сотрудниках, 3 % — 8640 сотрудниках и т.д. Если предположить, что увольнение каждого из них в текущем году в среднем обойдётся во столько же, во сколько и в прошлом, можно говорить об отправке на улицу 5200 человек исходя из сумму в $400 млн, выделенной на это, подсчитали The Register. В прошлом году глава IBM Арвинд Кришна (Arvind Krishna) заявил, что намерен заменить около 7800 сотрудников на ИИ, но не указал, когда именно это произойдёт. Теперь представители IBM отмалчиваются по поводу того, сколько именно людей потеряет работу и на какие должности примут новых чтобы, как заявлено, сохранить приблизительно прежнюю численность. По данным источников СМИ, сокращения в первую очередь коснутся программистов senior-уровня, специалистов по продажам и сотрудников поддержки. При этом набор сотрудников будет продолжаться в Индии, где IBM уже давно набирает кадры в приоритетном порядке. При этом под сокращение, по данным источников, попадают в первую очередь люди в возрасте 50–55 лет, занимающие довольно высокие должности и получающие высокую зарплату. Несмотря на прошлые и актуальные иски, связанные с увольнениями, в IBM настаивают, что систематическая дискриминация по возрасту в компании отсутствует.

18.09.2024 [11:23], Владимир Мироненко

Генеративный ИИ «оживляет» мейнфреймыМейнфреймы по-прежнему сохраняют актуальность, несмотря бурное развитие ИИ-технологий и облачных сервисов, пишет The Register со ссылкой на новое исследование State of Mainframe Modernization компании Kyndryl. Согласно данным опроса 500 топ-менеджеров ИТ-индустрии, многие организации интегрируют свои мейнфреймы с публичными и частными облачными платформами и совершенствуют свои программы модернизации, перемещая некоторые рабочие нагрузки с мейнфрейма и обновляя другие на месте, чтобы продолжать пользоваться такими преимуществами мейнфреймов, как безопасность и надёжность. Kyndryl сообщила, что 86 % респондентов развёртывают или планируют развёртывать инструменты и приложения генеративного ИИ в своей среде мейнфреймов. Исходя из этого Kyndryl назвала 2024 год «годом внедрения ИИ на мейнфреймах». Сама IBM заявила, что генеративный ИИ стал движущей силой в её бизнесе мейнфреймов, проносящим больше выручки в последние кварталы. Большая часть участников опроса (80 %) всё ещё находится на стадии изучения возможностей генеративного ИИ, но вместе с тем 41 % респондентов надеется использовать его для ускорения операций и снижения их подверженности человеческим ошибкам. Между тем, 33 % респондентов нацелены на улучшение клиентского опыта, например, за счёт повышения персонализации, а также разблокировании критически важных данных и преобразование неструктурированных данных в полезную информацию, в то время как треть участников опроса планирует использовать генеративный ИИ для извлечения бизнес-информации из своих данных, управляемых мейнфреймами, чтобы помочь в разработке новых продуктов или услуг. Согласно Kyndryl, генеративный ИИ также может помочь в модернизации, «проливая свет на внутреннюю работу монолитных приложений», что, как утверждается, может компенсировать нехватку навыков работы с мейнфреймами у нынешних сотрудников. Вместе с тем меньшая часть респондентов, чьи компании применяют мейнфреймы, не планирует использовать генеративный ИИ в какой-либо форме, ссылаясь на проблемы безопасности и регулирования в качестве причины своего нежелания или говоря о наличии других приоритетов. Опрос показал, что компании, продолжающие эксплуатировать мейнфреймы, стремятся использовать их с максимальной эффективностью, но также и пользоваться гибкостью облачных сервисов. Хотя 96 % респондентов заявили, что перемещают некоторые рабочие нагрузки с мейнфреймов (около трети), 89 % согласились, что эти системы по-прежнему чрезвычайно или очень важны для их бизнес-операций. В отчёте Kyndryl выделено три основных варианта модернизации мейнфреймов, причём большинство организаций использует их сочетания. Один из них — миграция, перенос некоторых или всех приложений и данных в облако или на локальную альтернативу. Второй вариант — интеграция данных и приложений мейнфрейма с другими платформами, что позволяет, например, новым облачным приложениям получать к ним доступ. Как ожидается, эта модель будет использоваться чаще с продолжающейся эволюцией генеративного ИИ, сообщила Kyndryl. Третий вариант — модернизация рабочих нагрузок на мейнфрейме, определение того, какие приложения следует сохранить, заменить или удалить, что подразумевает модернизацию исходного кода приложений или использование более современных языков, а также использование новых технологий, таких как ИИ и контейнеризация. Это уже второе исследование State of Mainframe Modernization компании Kyndryl, и в этом году больше респондентов заявили, что они сосредоточены в первую очередь на модернизации или интеграции с облаком, в то время как меньшее количество выбрали в качестве первоочередной задачи перенос рабочих нагрузок с мейнфрейма. Около 53 % респондентов заявили о росте использования мейнфреймов в этом году, а 49 % сообщили, что ожидают дальнейшего роста использования в течение следующих 12 месяцев. По словам Kyndryl, окупаемость инвестиций в проекты модернизации мейнфреймов составляет от 114 до 225 %. Что также важно, 66 % респондентов заявили, что уровень безопасности, предлагаемый мэйнфреймами, является для них самым важным фактором, и почти половина опрошенных назвала обеспечение безопасности основной причиной инвестиций в модернизацию. Один из руководителей ИТ-отдела оптовой компании в США сообщил, что был принят гибридный облачный подход, поскольку он позволяет хранить конфиденциальные данные в защищённой среде мейнфрейма, используя облако для менее важных рабочих нагрузок. Также в исследовании сообщается о сохранении проблемы с нехваткой персонала с соответствующим опытом работы с мейнфреймами. 18 % респондентов из компаний, интегрирующих мейнфреймы с другими платформами, заявили, что недостаточный опыт был основным препятствием для успеха проекта, в то время как более четверти участников опроса выразили обеспокоенность тем, что их организациям не хватает необходимого уровня навыков для эффективной модернизации мейнфреймов. IBM пытается решить проблему с кадрами, представив в начале этого года пару инициатив по решению проблемы нехватки инженеров. Также отмечено, что что 43 % респондентов указали, что у них нет навыков использования возможностей ИИ и генеративного ИИ, что заставляет всё больше организаций обращаться к внешним поставщикам, таким как Kyndryl, для реализации своих проектов модернизации. Подводя итоги, Kyndryl сделала вывод о том, что мейнфрейм остаётся важнейшей ИТ-средой для многих предприятий и даже становится всё более актуальным благодаря своей безопасности, надёжности и производительности.

13.09.2024 [10:22], Сергей Карасёв

Некогда самый мощный в мире суперкомпьютер Summit уйдёт на покой в ноябреВысокопроизводительный вычислительный комплекс Summit, установленный в Окриджской национальной лаборатории (ORNL) Министерства энергетики США, будет выведен из эксплуатации в ноябре 2024 года. Обслуживать машину становится всё дороже, а по эффективности она уступает современным суперкомпьютерам. Summit был запущен в 2018 году и сразу же возглавил рейтинг мощнейших вычислительных систем мира TOP500. Комплекс насчитывает 4608 узлов, каждый из которых оборудован двумя 22-ядерными процессорами IBM POWER9 с частотой 3,07 ГГц и шестью ускорителями NVIDIA Tesla GV100. Узлы соединены через двухканальную сеть Mellanox EDR InfiniBand, что обеспечивает пропускную способность в 200 Гбит/с для каждого сервера. Энергопотребление машины составляет чуть больше 10 МВт. FP64-быстродействие Summit достигает 148,6 Пфлопс (Linpack), а пиковая производительность составляет 200,79 Пфлопс. За шесть лет своей работы суперкомпьютер ни разу не выбывал из первой десятки TOP500: так, в нынешнем рейтинге он занимает девятую позицию. Отправить Summit на покой планировалось в начале 2024-го. Однако затем была запущена инициатива SummitPLUS, и срок службы вычислительного комплекса увеличился практически на год. Отмечается, что этот суперкомпьютер оказался необычайно продуктивным. Он обеспечил исследователям по всему миру более 200 млн часов работы вычислительных узлов. В настоящее время ORNL эксплуатирует ряд других суперкомпьютеров, в число которых входит Frontier — самый мощный НРС-комплекс в мире. Его пиковое быстродействие достигает 1714,81 Пфлопс, или более 1,7 Эфлопс. При этом энергопотребление составляет 22 786 кВт: таким образом, система Frontier не только быстрее, но и значительно энергоэффективнее Summit. А весной этого года из-за растущего количества сбоев и протечек СЖО на аукционе был продан 5,34-ПФлопс суперкомпьютер Cheyenne.

09.09.2024 [12:10], Руслан Авдеев

LLM в комплекте: Red Hat выпустила платформу RHEL AI для работы с генеративным ИИRed Hat объявила о запуске платформы Red Hat Enterprise Linux AI (RHEL AI) для создания генеративных ИИ-решений в облачных средах. По данным Silicon Angle, анонсированный три месяца назад пакет ПО сделали общедоступным в ходе мероприятия Red Hat Summit. Ранее анонсированный пакет включает семейство открытых языковых моделей IBM Granite, а также инструмент настройки моделей InstructLab, разработанный самой RedHat. Всё это объединили в образ RHEL для развёртывания в гибридных облаках и на локальных площадках. В компании сообщили, что RHEL AI упростит и удешевит разработку компактных и недорогих моделей. Затраты на обучение моделей могут быть очень высокими, в Red Hat сообщают, что на создание некоторых передовых моделей уходит до $200 млн. И это только на обучение, без учёта стоимости самих данных и настройки, критически важной для выполнения специальных задач каждой конкретной компании. В Red Hat уверяют, что будущее за небольшими генеративными ИИ-моделями, большинство которых будет open source.

Источник изображения: Red Hat В компании рассчитывают, что RHEL AI станет основной платформой для создания «бюджетных» и открытых решений. По умолчанию предоставляется библиотека бесплатных LLM Granite общего назначения. InstructLab поможет в тонкой настройке моделей без обширных навыков, связанными с наукой о данных. А интеграция с Red Hat OpenShift AI упростит обучение, настройку и обслуживание моделей. RHEL AI позволит разворачивать генеративный ИИ в непосредственной близости от баз данных и хранилищ компаний. RHEL AI оптимизирован для развёртывания на новейших серверах Dell PowerEdge и обеспечивает все возможности, предоставляемые подпиской Red Hat, в т.ч. круглосуточную поддержку, расширенную поддержку жизненного цикла моделей и, например, правовую защиту Open Source Assurance. Поскольку RHEL AI фактически является расширением Red Hat Enterprise Linux, дистрибутив можно использовать и на любом другом оборудовании, в том числе в облаках. Решение уже доступно у AWS и IBM Cloud, в Google Cloud и Azure появится возможность использовать его позже в этом году. В IBM Cloud ожидается появление предложения «как услуги» — по подписке в самом облаке, но только в следующем году. Ранее сообщалось, что для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти и хранилище от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

31.08.2024 [00:39], Алексей Степин

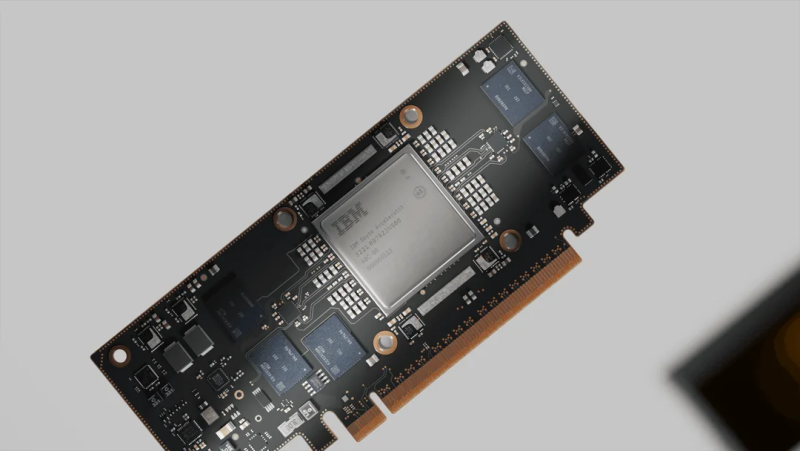

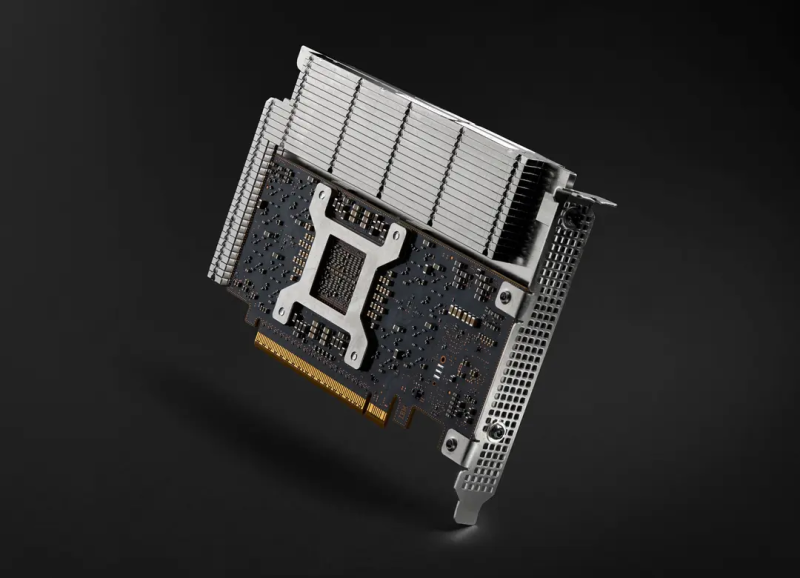

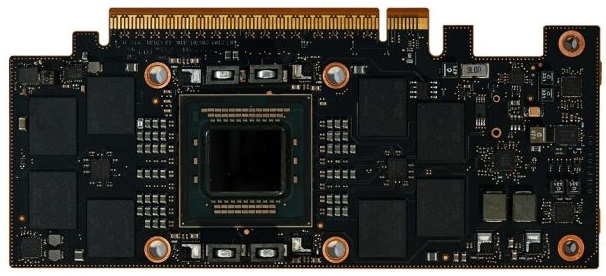

Новые мейнфреймы IBM z получат ИИ-ускорители SpyreВместе с процессорами Telum II для систем z17 компания IBM представила и собственные ускорители Spyre, ещё больше расширяющие возможности будущих мейнфреймов в области обработки ИИ-нагрузок. Они станут дополнением к встроенным в Telum ИИ-блокам.

Источник изображений: IBM Spyre представляет собой плату расширения с интерфейсом PCIe 5.0 x16 и теплопакетом 75 Вт. Помимо самого нейропроцессора IBM на ней установлено 128 Гбайт памяти LPDDR5, а производительность в ИИ-задачах оценивается производителем в более чем 300 Топс, т.е. новинки подходят для инференса крупных моделей. Сам чип приозводится с использованием 5-нм техпроцесса Samsung 5LPE и содержит 26 млрд транзисторов, а площадь его кристалла составляет 330 мм2. Spyre включает 32 ядра, каждое из которых дополнено 2 Мбайт быстрой скрэтч-памяти. Отдельно отмечено, что последняя не является кешем. При этом заявлена эффективность использования доступных вычислительных ресурсов — свыше 55 % на ядро. Каждое ядро содержит 78 матричных блоков и раздельные FP16-аккумуляторы, по восемь на «вход» и «выход». Интересно, что ядра Spyre и скрэтч-память используют отдельные кольцевые двунаправленные шины разной разрядности (32 и 128 бит соответственно), причём с оперативной памятью на скорости 200 Гбайт/с соединена именно вторая. Каждый узел (drawer) на базе Telum II способен вместить восемь плат Spyre, которые формируют логический кластер, располагающий 1 Тбайт памяти с совокупной ПСП 1,6 Тбайт/с, но, разумеется, каждая плата будет ограничена 128 Гбайт/с из-за интерфейса PCIe 5.0 x16. Spyre создан с упором на предиктивный и генеративный ИИ, благо в полной комплектации новые мейнфреймы могут нести 96 таких ускорителей и развивать до 30 ПОпс (Петаопс). Новинки рассчитаны на работу в средах zCX или Linux on Z, сопровождаются оптимизированным набором библиотек и совместимы с популярными фреймворками Pytoch, TensorFlow и ONNX. Они станут частью программных платформ IBM watsonx и Red Hat OpenShift. Новые мейнфреймы IBM z17 должны дебютировать на рынке в 2025 году. А в собственном облаке IBM будет также полагаться и на Intel Gaudi 3.

30.08.2024 [23:53], Алексей Степин

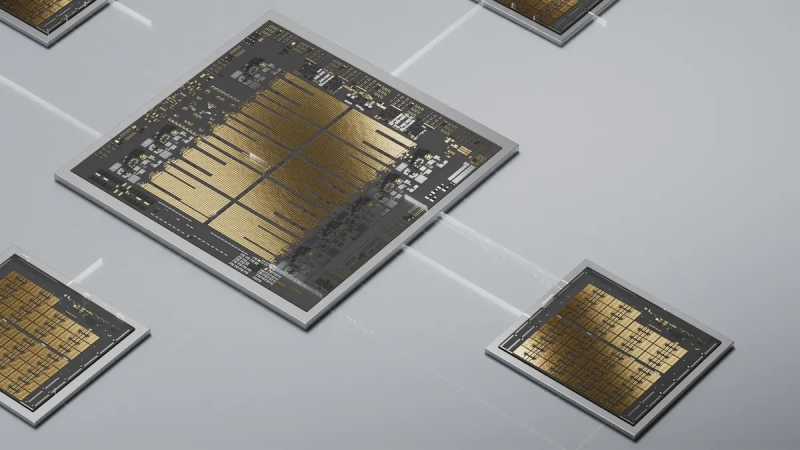

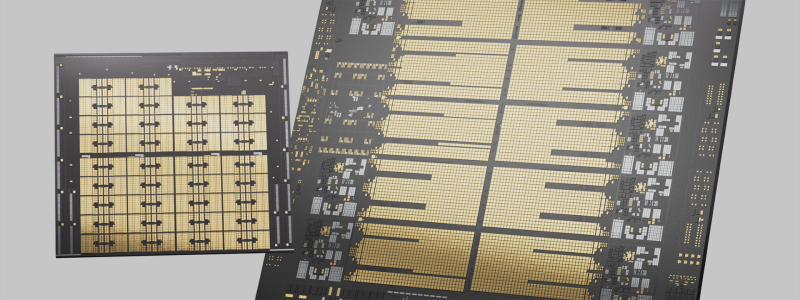

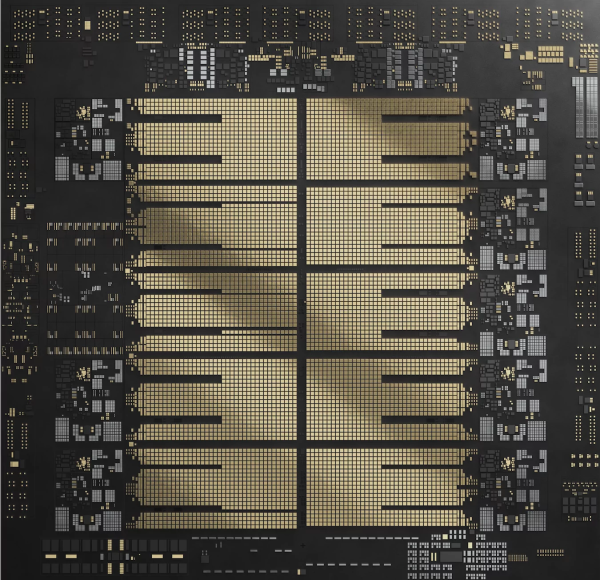

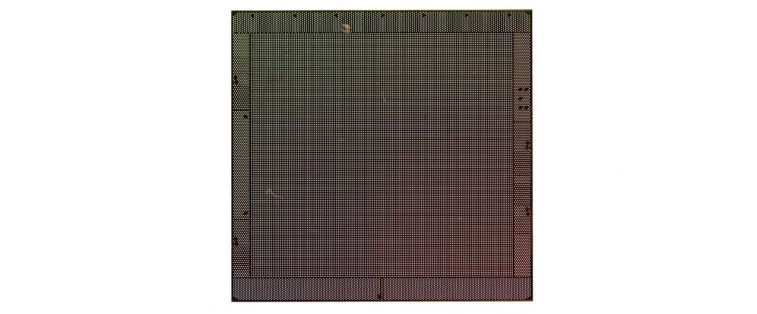

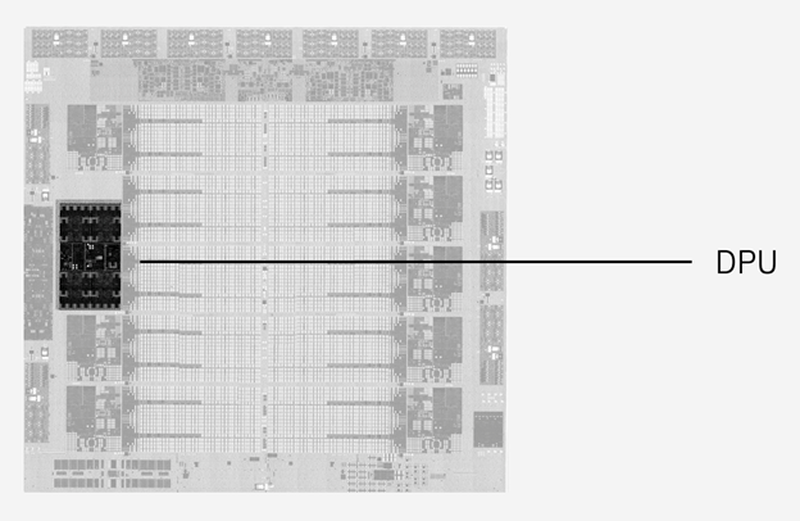

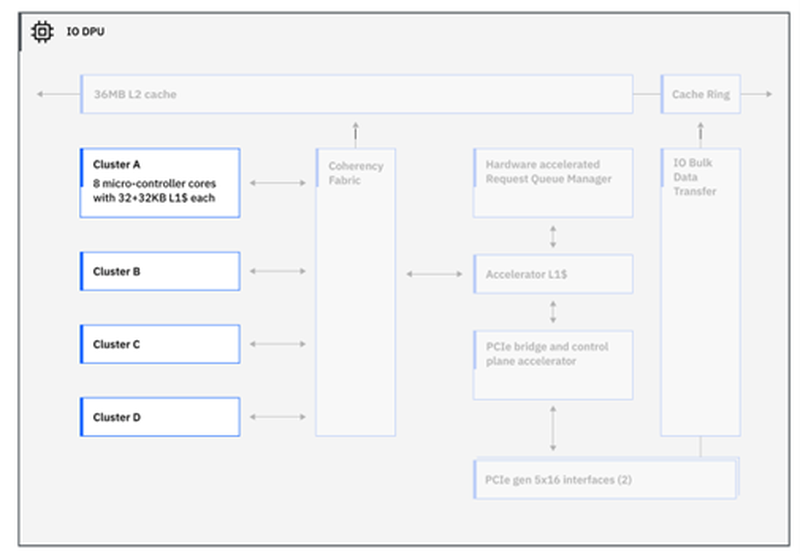

IBM представила процессор Telum II: 8 × 5,5 ГГц, 2,88 Гбайт L4-кеш, улучшенный ИИ-ускоритель и встроенный DPUНесмотря на доминирование архитектур x86 и Arm, а также растущую популярность RISC-V, востребованность классических мейнфреймов IBM на базе z/Architecture по-прежнему остаётся высокой, и компания продолжает активно развивать данное направление. На этой неделе IBM представила наследника Telum — процессор Telum II, в котором не только получили развитие заложенные ранее идеи, но и были реализованы достаточно серьёзные нововведения. Telum II будет выпускаться Samsung по 5-нм техпроцессу 5HPP (43 млрд транзисторов, 600 мм2). Он по-прежнему имеет восемь ядер с фиксированной рабочей частотой 5,5 ГГц. Сами ядра подверглись усовершенствованию, пусть и достаточно минорному: повышена точность предсказания ветвлений, улучшены механизмы сквозной записи и трансляции адресов. Это должно обеспечить новинке 20 % преимущества в пересчёте на процессорный разъём в сравнении с предшественником. Также благодаря новому техпроцессу удалось снизить площадь ядра на 20 %, а энергопотребление — на 15 %. Для поддержания постоянной тактовой частоты в Telum II используется новый блок управления напряжениями. Серьёзно улучшена подсистема кешей: объём кеш-памяти подрос на 40 %, всего разделов L2-кеша десять. Каждый из них имеет объём 36 Мбайт, а латентность не превышает 3,6 нс. Объёмы виртуальных кешей L3 (11,5 нс) и L4 (48,5 нс) выросли до 360 Мбайт (на процессор) и 2,88 Гбайт (на узел) соответственно. Сама технология виртуального кеширования такова, что текущее свободное место в L2 может использоваться для любой задачи, где может быть востребовано. На 30 % повышена пропускная способность связи чипа с внешним миром, а общение на межузловом уровне теперь шифруется. Встроенный ИИ-блок в Telum II в сравнении с предыдущим поколением стал вчетверо быстрее — 24 Топс. Сам сопроцессор имеет архитектуру, оптимальную для работы с LLM и нагрузками, в которых активно используется сравнительный анализ структурных или текстовых массивов данных. Есть поддержка INT8/FP16. При этом любой ИИ-ускоритель Telum II может работать с любым из ядер в пределах узла (drawer), что в предельной конфигурации даёт производительность на уровне 192 Топс, а для полностью сконфигурированной системы этот показатель равен 768 Топс. «Снаружи» ИИ-ускоритель доступен в виде набора CISC-инструкций.  А вот блок DPU дебютировал в Telum II впервые. Что интересно, архитектурно он не располагается «позади» PCI Express, как это бывает в системах на базе x86 или Arm, а имеет когерентное подключение к кешу L2 процессорных ядер, и при этом имеет свою подсистему кешей. Применение DPU, по словам IBM, позволило снизить энергозатраты на обслуживание операций ввода-вывода на 70 %. DPU жизненно необходим, поскольку на мейнфреймах будут работать тысячи инстансов, а самим системам теперь полагается и внешний ИИ-ускоритель Spyre.  Всего в состав DPU входит четыре кластера по по восемь программируемых микроядер, каждое из которых имеет кеш L1 объёмом 32+32 Кбайт и работает под управлением кастомных протоколов, разработанных IBM. DPU предоставляет шину PCI Express 5.0 и в полной конфигурации c 32 процессорами и 12 модулями расширения по 16 слотов x16 в каждом система на базе Telum II может работать со 192 адаптерами PCIe.  Компания-производитель позиционирует новые системы, как enterpise-решения широкого спектра для сценариев с использованием ИИ, в том числе, в режиме Ensemble AI, в котором одновременно над задачей могут работать модели разного размера и сложности. В этом режиме малая модель выявления мошеннических атак может работать как быстрое средство, а для отдельных, особенно важных транзакций в работу включается более сложная, но и более эффективная модель класса LLM. Процессоры Telum II станут основой как новых мейнфреймов IBM Z, работающих под управлением классической z/OS, так и Linux. Ожидается, что платформы IBM z17 на базе Telum II будут доступны уже в следующем году.

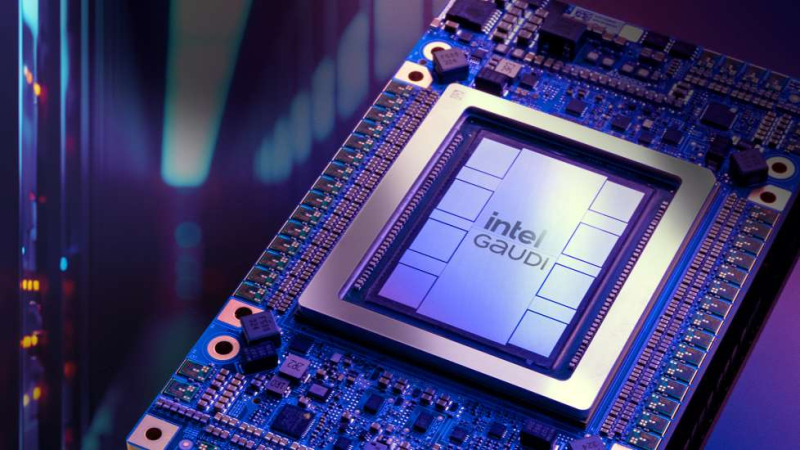

30.08.2024 [13:11], Руслан Авдеев

ИИ-ускорители Intel Gaudi 3 дебютируют в облаке IBM CloudКомпании Intel и IBM намерены активно сотрудничать в сфере облачных ИИ-решений. По данным HPC Wire, доступ к ускорителям Intel Gaudi 3 будет предоставляться в облаке IBM Cloud с начала 2025 года. Сотрудничество обеспечит и поддержку Gaudi 3 ИИ-платформой IBM Watsonx. IBM Cloud станет первым поставщиком облачных услуг, принявшим на вооружение Gaudi 3 как для гибридных, так и для локальных сред. Взаимодействие компаний позволит внедрять и масштабировать современные ИИ-решения, а комбинированное использование Gaudi 3 с процессорами Xeon Emerald Rapids откроет перед пользователями дополнительные возможности в облаках IBM. Gaudi 3 будут применяться и в задачах инференса на платформе Watsonx — клиенты смогут оптимизировать исполнение таких нагрузок с учётом соотношения цены и производительности. Для помощи клиентам в различных отраслях, в том числе тех, деятельность которых жёстко регулируется, компании предложат возможности IBM Cloud для гибкого масштабирования нагрузок, а интеграция Gaudi 3 в среду IBM Cloud Virtual Servers for VPC позволит компаниям, использующим аппаратную базу x86, быстрее и безопаснее использовать свои решения, чем до интеграции. Ранее сообщалось, что модель Gaudi 3 готова бросить вызов ускорителям NVIDIA. В своё время Intel выступила с заявлением о 50 % превосходстве новинки в инференс-сценариях над NVIDIA H100, а также о 40 % преимуществе в энергоэффективности при значительно меньшей стоимости. Позже Intel публично раскрыла стоимость новых ускорителей, нарушив негласные правила рынка.

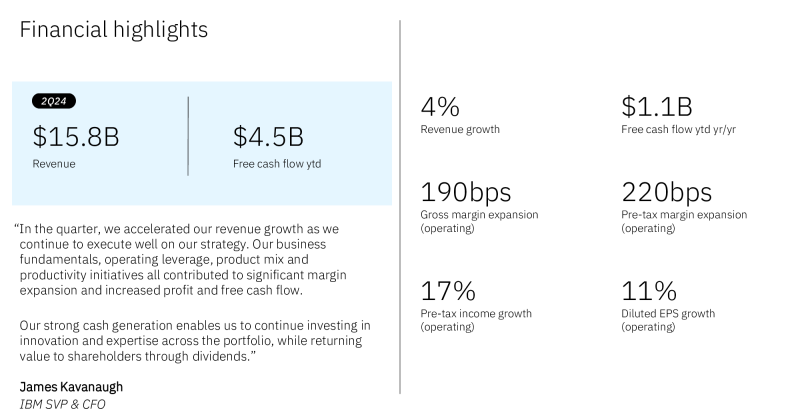

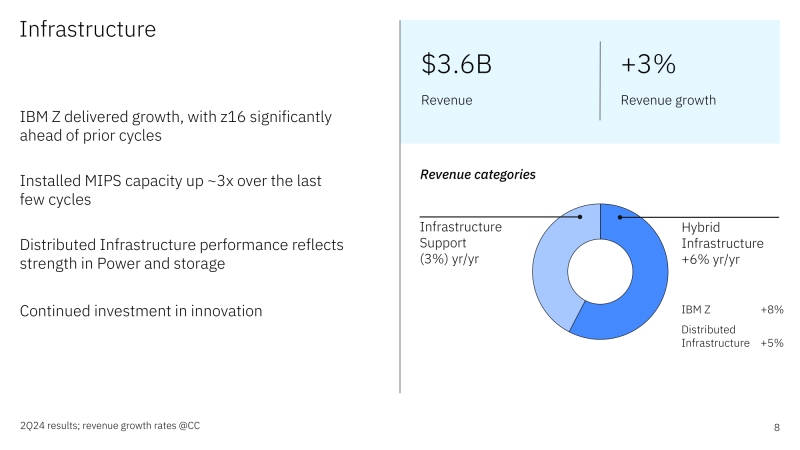

26.07.2024 [17:11], Владимир Мироненко

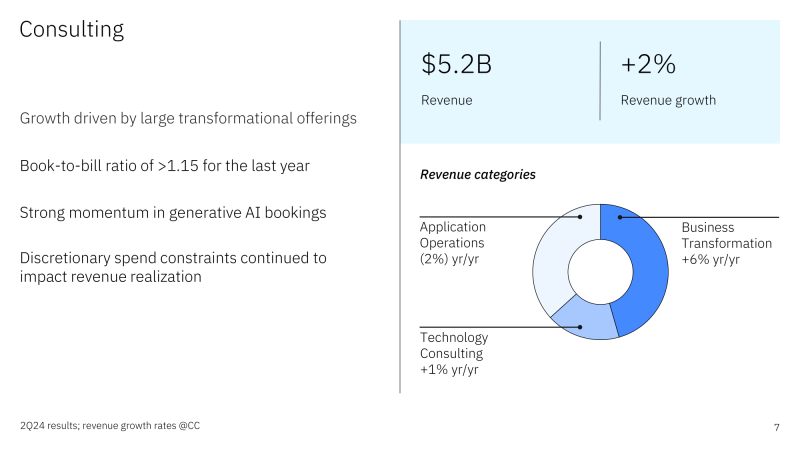

Заказы на ИИ и мейнфреймы z16 помогли IBM увеличить выручку и прибыльIBM сообщила финансовые результаты II квартала 2024 года, завершившегося 30 июня. Выручка компании за этот период выросла на 1,9 % до $15,77 млрд с $15,48 млрд во втором квартале 2023 года, превзойдя консенсус-прогноз аналитиков, опрошенных LSEG, в размере $15,62 млрд. Чистая прибыль (GAAP) составила $1,83 млрд или $1,96 на акцию, что выше показателя в $1,58 млрд или $1,72 на акцию годом ранее. Скорректированная чистая прибыль (Non-GAAP) в размере $2,43 на акцию значительно превышает консенсус-прогноз аналитиков в $2,20. IBM заявила, что ИИ сыграл центральную роль в общем росте выручки. Гендиректор Арвинд Кришна (Arvind Krishna) отметил, что портфель заказов компании на ИИ превысил $2 млрд, чему способствовал запуск год назад её платформы разработки watsonx. Основные бизнес-подразделения IBM продемонстрировали хорошие результаты несмотря на геополитическую неопределённость в ряде регионов мира. Компания сообщила о росте выручки подразделения по разработке ПО год к году на 7,1 % до $6,74 млрд, что превышает консенсус-прогноз аналитиков, опрошенных StreetAccount, в размере $6,49 млрд. В этом квартале Red Hat показала рост на 7 %, что относительно мало для приобретённого компанией программного бизнеса, который когда-то стабильно рос более чем на 20 % в квартал. Однако Кришна заявил, что заказы для Red Hat выросли в этом квартале, что является многообещающим знаком для второго полугодия. В свою очередь, финансовый директор Джим Кавано (Jim Kavanaugh) сообщил инвесторам, что бизнес IBM Red Hat «всё ещё растёт хорошо» с ростом заказов год к году на 20 %, а заказы OpenShift растут вдвое быстрее. Рост выручки подразделения по автоматизации составил 15 %, выручка подразделения по обработке данных и ИИ упала на 3 %. Консалтинговое подразделение IBM принесло выручку в размере $5,18 млрд, что на 0,9 % меньше год к году и немного ниже прогноза Уолл-стрит в размере $5,23 млрд. Кришна объяснил слабый рост «такими факторами, как процентные ставки и инфляция, влияющие на время принятия решений и дискреционные расходы» — проблемами, которые присутствовали весь год. В свою очередь, инфраструктурное подразделение получило $3,65 млрд выручки, что на 0,7 % больше показателя аналогичного периода 2023 года и выше консенсус-прогноза Уолл-стрит в размере $3,51 млрд. Финансовый директор IBM Джим Кавано отметил хорошие продажи мейнфреймов z16 текущего поколения, вышедших в 2022 году. «Мы уже более двух лет в цикле z16, и показатели выручки продолжают превосходить предыдущие циклы», — цитирует ресурс DatacenterDynamics заявление Кавано. «IBM Z остаётся устойчивой платформой для критически важных рабочих нагрузок, стимулируя как аппаратное обеспечение, так и связанное с ним ПО, системы хранения и внедрения услуг», — добавил он. Доход компании от распределённой инфраструктуры вырос на 3 %. «Рост был обусловлен спросом на рабочие нагрузки с интенсивным использованием данных на Power10 во главе с SAP HANA. Системы хранения снова продемонстрировали рост в этом квартале, включая рост высокопроизводительных систем хранения, связанных с циклом z16, и решений, разработанных для защиты, управления и доступа к данным для масштабирования генеративного ИИ», — сказал Кавано. IBM также сообщила, что по-прежнему ожидает рост выручки в 2024 году в пределах 4–6 %, в то время как свободный денежный поток должен превысить отметку в $12 млрд. Как сообщается, акции IBM выросли с начала года на 14 %, что соответствует росту индекса S&P 500. Из значимых событий в прошедшем квартале следует отметить заключение соглашения IBM по покупке HashiCorp, разработчика открытых инструментов для управления облачной инфраструктурой, за $6,4 млрд. Хотя Федеральная комиссия по торговле США (FTC) начала антимонопольную проверку сделки, что может затянуть её завершение, Кришна заявил аналитикам, что сделка будет закрыта во второй половине года. Также было объявлено о партнёрстве IBM с Palo Alto Networks Inc., которая приобретёт ресурсы QRadar Software as a Service (SaaS) и станет предпочтительным партнёром IBM в области кибербезопасности в сетевых, облачных и защитных операциях. |

|