Материалы по тегу: hardware

|

30.07.2025 [11:40], Сергей Карасёв

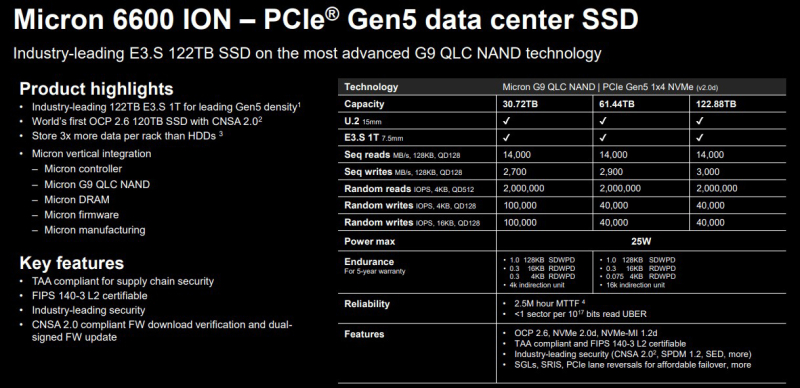

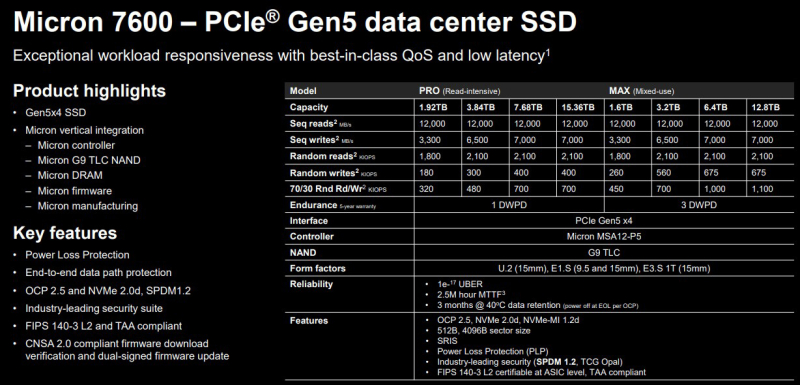

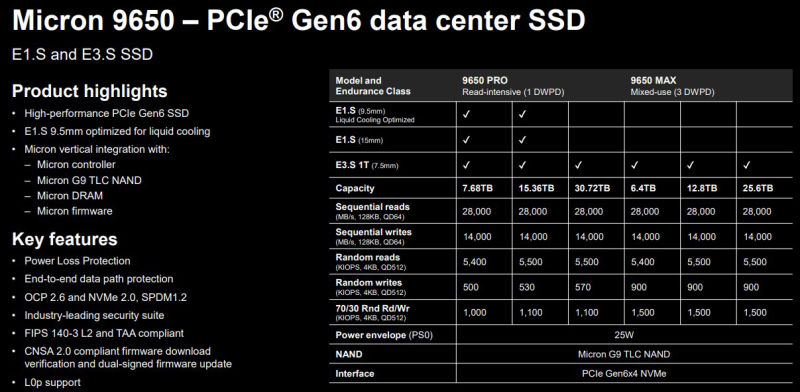

Micron представила новые SSD для дата-центров: PCIe 6.0, до 28 Гбайт/с и до 122,88 ТбайтКомпания Micron Technology анонсировала SSD серий 6600 ION, 7600 и 9650 для дата-центров и систем корпоративного класса. Новинки, подходящие в том числе для ресурсоёмких нагрузок ИИ, предлагаются в различных форм-факторах — U.2, E1.S и E3.S. Изделия Micron 6600 ION оптимизированы для сред, в которых постоянно генерируются и обрабатываются большие массивы данных: это может быть, например, инфраструктура интернета вещей (IoT). Устройства выполнены на основе флеш-чипов G9 QLC NAND, а для обмена данными задействован интерфейс PCIe 5.0 x4 (NVMe 2.0d). Доступны исполнения E3.S 1T и U.2. В семейство Micron 6600 ION входят модификации вместимостью 30,72, 61,44 и 122,88 Тбайт. В I половине 2026 года появится вариант ёмкостью 245 Тбайт. Скорость последовательного чтения информации достигает 14 000 Мбайт/с, скорость последовательной записи — 3000 Мбайт/с. Показатель IOPS при произвольном чтении блоков данных по 4 Кбайт составляет до 2 млн, при произвольной записи — до 100 тыс. Показатель надёжности достигает 1 DWPD (полная перезапись в сутки) при последовательном доступе и от 0,075 до 0,3 DWPD при случайном доступе. Накопители серии Micron 7600, в свою очередь, подходят для задач ИИ. Устройства выпускаются в форматах U.2 (15 мм), E1.S (9,5 и 15 мм) и E3.S 1T (15 мм). Применены чипы флеш-памяти G9 TLC NAND и интерфейс PCIe 5.0 x4 (NVMe 2.0d). Скорость последовательных чтения и записи — до 12 000 и 7000 Мбайт/с соответственно. Покупатели смогут выбирать между модификациями Micron 7600 Pro и Micron 7600 Max. В первом случае вместимость варьируется от 1,92 до 15,36 Тбайт, а надёжность находится на уровне 1 DWPD (на протяжении пяти лет). Величина IOPS — до 2,1 млн при чтении и до 400 тыс. при записи. В случае Micron 7600 Max ёмкость составляет от 1,6 до 12,8 Тбайт, показатель DWPD равен 3. Значение IOPS — до 2,1 млн при произвольном чтении и до 675 тыс. при произвольной записи. Micron заявляет о задержке менее 1 мс при 99,9999 % операций. Изделия Micron 9650 специально разработаны для обучения ИИ-моделей, инференса в режиме реального времени и других задач, при которых критическое значение имеют производительность и стабильная пропускная способность. Устройства в форм-факторах E3.S и E1.S оснащены интерфейсом PCIe 6.0 х4 (NVMe 2.0). Используются чипы флеш-памяти G9 TLC NAND. Максимальная скорость последовательного чтения заявлена на уровне 28 000 Мбайт/с, последовательной записи — 14 000 Мбайт/с. Устройства E1.S допускают применение жидкостного охлаждения. Серия включает версии Micron 9650 Pro (1 DWPD) и Micron 9650 Max (3 DWPD) вместимостью 7,68–30,72 и 6,4–25,6 Тбайт соответственно. Показатель IOPS при произвольном чтении достигает 5,5 млн, при произвольной записи — 1,1 млн у Pro и 1,5 млн у Max. Максимальное энергопотребление у всех представленных изделий находится на уровне 25 Вт. Средняя наработка на отказ (MTTF) — 2,5 млн часов при температуре до +50 °C. Пробные поставки устройств Micron 7600 и Micron 9650 уже начались, а SSD серии Micron 6600 ION выйдут позднее в текущем квартале.

29.07.2025 [16:38], Сергей Карасёв

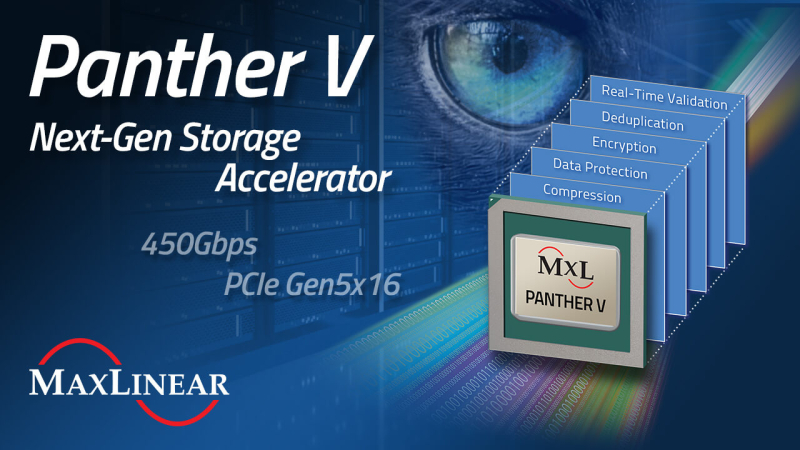

MaxLinear представила DPU Panther V с пропускной способностью 450 Гбит/сКомпания MaxLinear анонсировала ускоритель обработки данных Panther V, предназначенный для использования в дата-центрах и инфраструктурах гиперскейлеров. Решение берёт на себя выполнение таких ресурсоёмких операций с данными, как сжатие, дедупликация, шифрование и проверка в реальном времени. В результате, снижается нагрузка на CPU, уменьшаются задержки, повышаются общая производительность и энергоэффективность, а также сокращаются капитальные и эксплуатационные затраты. Новинка выполнена на той же архитектуре, которая лежит в основе DPU Panther III. При этом вместо интерфейса PCIe 4.0 используется PCIe 5.0 (x16). Пропускная способность увеличена более чем в два раза — с 200 до 450 Гбит/с. Устройство оптимизировано для НРС-задач, гипермасштабируемых и гиперконвергентных архитектур, рабочих нагрузок ИИ и машинного обучения. Упомянут механизм дедупликации структурированных данных MaxHash вплоть до 15:1 (в сочетании с алгоритмами глубокого сжатия). Это значительно повышает эффективную вместимость и увеличивает срок службы NVMe SSD. Реализованы различные средства обеспечения безопасности, включая сквозную защиту данных, ЕСС и пр. Говорится о развитой программной экосистеме: это SDK с унифицированными API, а также интеллектуальный балансировщик нагрузки для бесшовной интеграции в средах Linux и FreeBSD. Возможно объединение в системе нескольких ускорителей Panther V с суммарной пропускной способностью свыше 3,2 Тбит/с.

29.07.2025 [14:58], Руслан Авдеев

Удар по Ирландии: Amazon отказалась от строительства фабрики серверов в стране за €300 млнAmazon отказалась от нового объекта в Дублине. Инвестиции, оцениваемые приблизительно в €300 млн ($353 млн), предназначались для AWS. По имеющимся данным, компания планировала построить новую площадку для производства передовых серверных стоек для ЦОД, сообщает Bloomberg. Отмена такого знакового проекта вызывает особое беспокойство у местных экспертов, учитывая огромную зависимость страны от прямых иностранных инвестиций, в первую очередь из США. Сегодня в Ирландии более 600 тыс. человек работают в иностранных компаниях — это около 20 % от общего числа работающего населения. Инвестиции приносят немалые деньги и государству. В прошлом году Ирландия получила рекордные €39 млрд корпоративного налога. В результате в стране сформировался даже бюджетный профицит — довольно редкое явление для современных европейских стран. В AWS сообщили, что компания разочарована тем, что проект не удалось реализовать, но предполагаются и другие инвестиции в Ирландию, если для этого будут созданы благоприятные условия. На Amazon в стране сегодня уже работает порядка 6,5 тыс. человек. Эта новость усиливает обеспокоенность властей страны нестабильностью корпоративного налога — особенно с учётом того, что президент США и его соратники неоднократно подчёркивали, что профицитом Ирландия обязана именно Америке. С учётом столь значимой угрозы правительство Ирландии уже дало понять, что в текущем году придётся расходовать бюджет более осторожно — в отличие от 2024 года, когда средства буквально «раздавались».

Источник изображения: Dmitry Ant/unsplash.com По данным Bloomberg, решение AWS связано с проблемами энергоснабжения проекта и большими сроками подключения объекта к электросети. Решение Amazon может усилить беспокойство, связанное с нехваткой электричества для ИИ, дата-центров и других передовых технологий — особенно в тех местах, где энергетические сети уже находятся в плохом состоянии и под большой нагрузкой. Хотя бум ИИ позволил выделить на ЦОД миллиарды долларов, строительство некоторых объектов уже пришлось отменить. В марте-апреле сообщалось, что Microsoft отложила реализацию в текущем году ряда проектов, в том числе в Индонезии, Великобритании, Австралии и нескольких штатах США, включая Огайо. Желая повысить конкурентоспособность отрасли ЦОД, правительство Ирландии буквально на днях подписало обновлённый план развития инфраструктуры на €112 млрд, рассчитанный до 2030 года, и направленный на решение проблем с размещением, энергоснабжением и водными ресурсами. Инвестиции в ключевые коммунальные структуры уже пострадали от мирового финансового кризиса, и это стало большим разочарованием для предприятий различного назначения. Ассоциация IBEC (Irish Business and Employers Confederation) — крупнейший лоббист интересов бизнеса в Ирландии — призвала правительство отдать приоритет инфраструктуре в сравнении с другими расходами, включая сокращение налогов. Утверждается, что стране необходимо наверстать десятилетия недостаточных инвестиций и задержек в реализации планов. Американская торговая палата в Ирландии (American Chamber of Commerce in Ireland) также предупредила, что инфраструктура является критически важным приоритетом для её членов. На этом фоне положение с энергоснабжением в стране настолько серьёзное, что в феврале местный регулятор CRU предложил операторам ЦОД самим заняться строительством электростанций и энергохранилищ. Проблема в том, что Ирландские ЦОД за восемь лет увеличили энергопотребление на 473 %. В июне сообщалось, что Ирландия готова разрешить дата-центрам строить не только электростанции, но и частные линии электропередач.

29.07.2025 [14:42], Руслан Авдеев

Crusoe и Tallgrass построят в Вайоминге ИИ ЦОД мощностью 1,8 ГВтCrusoe и Tallgrass намерены построить кампус ИИ-дата-центра мощностью 1,8 ГВт на юго-востоке Вайоминга. Потенциально объект может быть масштабирован до 10 ГВт. Цель партнёрства — удовлетворение растущего спроса на вычислительную инфраструктуру за счёт использования «вертикально интегрированной» модели ИИ ЦОД от Crusoe и значительных энергетических и инфраструктурных активов Tallgrass в регионе, сообщает Converge! Речь идёт об одном из крупнейших кампусов ИИ ЦОД в стране. Строительство будет обеспечиваться за счёт энергии, получаемой из природного газа, с перспективой перехода на возобновляемые источники в будущем. Также свою роль сыграет инфраструктура компании Tallgrass, включая доступ к водным ресурсам и систему захвата и хранения CO₂ для снижения вредных выбросов. Площадка в Вайоминге расширяет портфолио проектов Crusoe до более 20 ГВт, включающее крупные начинания вроде объекта на 1,2 ГВт в Абилине (Техас), предназначенного для проекта Stargate, а также второго ЦОД на 1 ГВт, строительство которого уже начато.

Источник изображения: Mimi Thian/unspalsh.com В своё время Crusoe развёртывала инфраструктуру ЦОД для майнинга с получением энергии за счёт попутного (факельного) газа на нефтеносных полях. Теперь компания окончательно отказалась от майнинга и превратилась в поставщика комплексной ИИ-инфраструктуры, ориентированного на устойчивое развитие и масштабирование. Ожидается, что новый кампус будет поддерживать широкий спектр ИИ-задач. Он позволит создать новые рабочие места в строительстве, производстве, энергетике и технологическом секторе в целом. Tallgrass имеет более чем десятилетний опыт работы в Вайоминге и владеет тысячами километров трубопроводов и ключевой инфраструктурой по всему штату. При поддержке Blackstone компания расширила свою деятельность, занявшись, в частности, улавливанием углекислого газа и производством водорода. Новое партнёрство осуществляется в рамках более масштабных усилий штата и федеральных властей, направленных на ускорение развития внутренней ИИ-инфраструктуры в США и стимулирование экономического роста на местах. Особое значение проект приобретает в контексте растущей нагрузки на энергосистемы США из-за спроса на ИИ-вычисления. Новые проекты, реализуемые совместно поставщиками вычислительной инфраструктуры и энергетическими компаниями, фактически меняют географию размещения будущих ЦОД и принципы их проектирования. Благодаря богатым энергетическим ресурсам и благоприятной нормативно-правовой базе Вайоминг может претендовать на роль ключевого игрока в этих трансформациях. По последним данным Crusoe заказала у GE Vernova 19 газотурбинных установок LM2500XPRESS на основе авиационных двигателей в дополнение к десяти уже купленным. Впрочем, использовать их, вероятно, будут в Техасе.

29.07.2025 [14:30], Владимир Мироненко

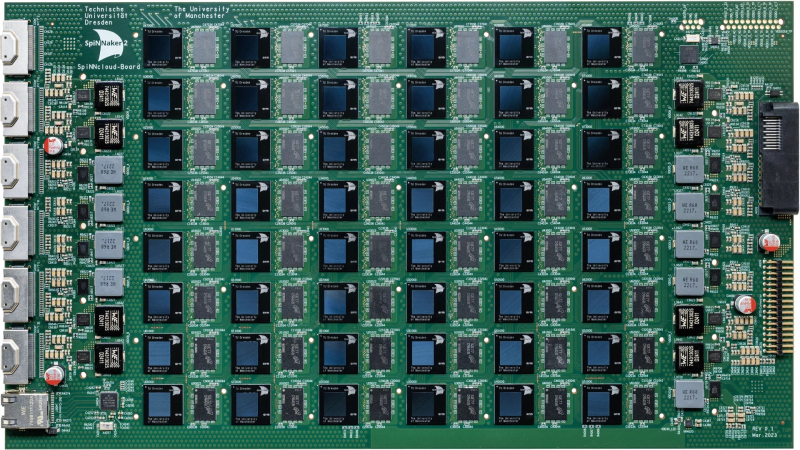

Стартап SpiNNcloud поставит Лейпцигскому университету «нейроморфный» суперкомпьютер для создания новых лекарств in silicoСтартап SpiNNcloud Systems из Дрездена (Германия) сообщил о заключении сделки на поставку Лейпцигскому университету нейроморфного суперкомпьютера, основанного на принципах функционирования человеческого мозга и предназначенного для разработки новых лекарственных препаратов. Суперкомпьютер будет использоваться учёными для моделирования сворачивания белков в рамках исследований в области персонализированной медицины, объединяющей достижения геномики, ИИ, робототехники и новейших диагностических технологий. Стоимость сделки не разглашается. В суперкомпьютере применена высокопараллельная архитектура с 48 чипами SpiNNaker2 на серверной плате, каждый из которых содержит 152 Arm-ядра со специализированными ускорителями и потребляет 0,8–2,5 Вт. Вся система, оснащённая 4320 чипами с 656 640 ядрами, помещается в одну стойку, но университет решил развернуть её в двух стойках, сообщил Гектор Гонсалес (Hector Gonzalez), соучредитель и генеральный директор SpiNNcloud, отметив, что общий энергетический бюджет системы составляет 25 кВт. Новый подход к разработке лекарств использует исключительную параллельность и масштабируемость суперкомпьютера для развёртывания миллионов небольших моделей, которым поручено находить соответствия между молекулами и профилями пациентов. Эта конструкция обеспечивает эффективные, событийно-ориентированные вычисления, позволяя выполнять сложное моделирование и разрабатывать новые персонализированные препараты с более высокой скоростью сходимости и при более низком энергопотреблении по сравнению с традиционными системами на базе GPU. «Точное и детализированное управление процессорами позволяет использовать очень разреженный маршрут, не задействуя все ядра, — поясняет Гонсалес. — Это один из фундаментальных аспектов, который очень сложно реализовать на GPU, поскольку GPU устроен как каскад вычислительных блоков, которые необходимо задействовать максимально полно, чтобы добиться синхронной эффективности». «Архитектура SpiNNcloud делает возможным скрининг миллиардов молекул in silico (виртуальное клиническое исследование)», — сообщил Кристиан Майр (Christian Mayr), соучредитель SpiNNcloud. По его словам, изначально разработанная для моделирования биологических нейронных сетей серверная система SpiNNcloud адаптирована для массивно-параллельного выполнения небольших гетерогенных задач. Прототип нейронной сети позволяет провести скрининг 20 млрд молекул менее чем за час — это на два порядка быстрее, чем на 1000 CPU-ядер. Гонсалес сообщил ресурсу EE Times, что индивидуальный подход к разработке лекарств, используемый в персонализированной медицине, хорошо вписывается в архитектуру SpiNNcloud. «Это множество небольших моделей, которые взаимодействуют друг с другом через чрезвычайно быструю сеть», — пояснил он. «Наша вычислительная архитектура <…> уникально подходит для развёртывания эффективных алгоритмов, требующих динамической разреженности и экстремального параллелизма», — добавил глава SpiNNcloud. «Экстремальный параллелизм SpiNNcloud делает их идеально подходящими для задач, связанных со сворачиванием белков, например, для поиска низкомолекулярных лекарственных препаратов, — отметил Йенс Майлер (Jens Meiler), профессор Института Александра фон Гумбольдта по Интернету и обществу и директор Института поиска лекарственных препаратов Лейпцигского университета. — «Фолдинг белков можно рассматривать как задачу оптимизации, в которой белок стремится найти своё наименьшее энергетическое состояние. Суперкомпьютеры SpiNNcloud хорошо справляются с такими задачами». Самая крупная система, развёрнутая SpiNNcloud на данный момент, включает 30 тыс. чипов (более 5 млрд вычислительных элементов) в Дрезденском университете. «Максимально возможная система, которую мы можем спроектировать, – это 16 стоек, — говорит Гонсалес. — При более чем 16 стойках будет сложно поддерживать достаточную связанность между моделями». По его словам, можно было бы развернуть в Лейпциге и более крупный суперкомпьютер с большим числом ядер, но компании пришлось учитывать финансовые ограничения университета. Как сообщает EE Times, SpiNNcloud также тестирует своё оборудование в новых исследовательских направлениях, основанных на классических методах глубокого обучения, в частности, в работе с MoE-моделями. По словам Гонсалеса, архитектура SpiNNcloud хорошо подходит для таких задач. Разработчик выразил надежду, что архитектуры, вдохновлённые принципами работы мозга, такие как SpiNNcloud, позволят создавать новые типы моделей, невозможные для реализации на массовом оборудовании.

29.07.2025 [11:12], Сергей Карасёв

AAEON выпустила PICO-MTU4-SEMI — самый компактный в мире компьютер с процессором Intel Core UltraКомпания AAEON анонсировала устройство PICO-MTU4-SEMI: это, как утверждается, самый компактный на рынке индустриальный компьютер, оснащённый процессором Intel Core Ultra. Новинка может применяться в составе робототехнических платформ, систем автоматизации производств и складов и пр. Устройство несёт на борту чип Core Ultra 125U поколения Meteor Lake: изделие объединяет 12 ядер (два производительных, восемь энергоэффективных и два с низким энергопотреблением) с максимальной тактовой частотой 4,3 ГГц в Turbo-режиме. Опционально может быть установлен процессор Core Ultra 7 165U с аналогичной конфигурацией вычислительных ядер и частотой до 4,9 ГГц. В состав изделий входит ускоритель Intel Graphics. Используется пассивное охлаждение, а ребристая верхняя поверхность корпуса выполняет функции радиатора для рассеяния тепла. Объём оперативной памяти LPDDR5-6400 может достигать 32 Гбайт в виде одного модуля. Есть коннектор M.2 2280 M-Key для SSD с интерфейсом PCIe 4.0 x4 или SATA-3, а также разъём M.2 2230 E-Key (PCIe 4.0 x1 + USB 2.0) для адаптера Wi-Fi. В оснащение входят сетевые контроллеры Intel I226 стандарта 2.5GbE и Intel I219 1GbE. Новинка располагает двумя последовательными портами RS-232/422/485 и двумя портами USB 3.2 Gen2, интерфейсом HDMI 1.4 (с поддержкой разрешения до 3840 × 2160 пикселей; 30 к/с), двумя гнёздами RJ45 для сетевых кабелей. Питание (12 В) подаётся через DC-разъём. Габариты устройства составляют 108 × 95 × 43 мм, вес — около 0,6 кг. Диапазон рабочих температур простирается от -10 до +50 °C. Заявлена совместимость с Windows 10/11 и Ubuntu 22.04.2 (kernel 5.19.0 32). Предусмотрен встроенный модуль TPM 2.0 для обеспечения безопасности.

29.07.2025 [11:10], Руслан Авдеев

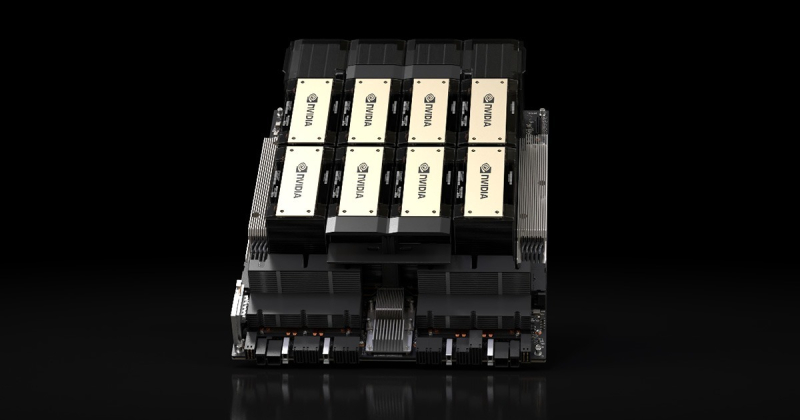

NVIDIA заказала у TSMC производство 300 тыс. ИИ-ускорителей H20 в ответ на высокий спрос в КитаеНа прошлой неделе NVIDIA обратилась к тайваньской TSMC с заказом на выпуск 300 тыс. ИИ-ускорителей H20. Причиной тому — большой спрос на специально ослабленные чипы в Китае, сообщает Reuters со ссылкой на осведомлённые источники. Один из них подчеркнул, что высокий спрос в Поднебесной фактически заставил NVIDIA не полагаться на существующие запасы, а сделать новый заказ. Дело в том, что в июле администрация президента США Дональда Трампа (Donald Trump) вновь позволила продавать ухудшенные ускорители H20 в Китай — в апреле их поставки в страну были запрещены полностью. В своё время NVIDIA разрабатывала H20 специально для китайского рынка — после очередных экспортных ограничений, введённых США на поставку в Китай в конце 2023 года. H20 далеко не так хорош, как модели вроде NVIDIA H100 и, тем более, NVIDIA Blackwell, которые свободно поставляются в некоторые, «дружественные» США страны. По данным источников, новые заказы у TSMC дополнят уже имеющиеся запасы в 600-700 тыс. ускорителей H20, которые находятся на складах NVIDIA. Для сравнения, по данным экспертов SemiAnalysis, в 2024 году NVIDIA продала около 1 млн чипов H20. В ходе поездки в Пекин в текущем месяце глава NVIDIA Дженсен Хуанг заявил, что возобновление производства H20 будет зависеть от объёмов новых заказов на эти ускорители. При этом он добавил, что на «перезапуск» цепочки поставок потребуется девять месяцев. После визита Хуанга СМИ сообщали, что NVIDIA имеет ограниченные запасы H20 на складах и пока не имеет немедленных планов на возобновление производства полупроводниковых пластин для них.

Источник изображения: NVIDIA Для поставок H20 разработчику потребуется получать экспортные лицензии у американских властей. В середине июля компания якобы получила заверения в том, что они скоро будут выданы. Правда, Министерство торговли США всё ещё должно одобрить выдачу лицензий. В понедельник NVIDIA отказалась комментировать новые заказы или статус своих заявок на получение экспортных лицензий. Министерство торговли пока воздерживается от комментариев. По некоторым данным, NVIDIA запросила у китайских компаний, заинтересованных в закупках ускорителей H20, представить новую документацию, в том числе прогнозируемые объёмы закупок. По данным представителя администрации Трампа, возобновление продаж H20 в Китай стало одним из результатов переговоров о закупке в КНР редкоземельных магнитов, необходимых во многих отраслях. В своё время Пекин ограничил их экспорт в разгар американо-китайской торговой войны. Решение возобновить экспорт H20 в КНР вызвало осуждение ряда американских политиков, как демократов, так и республиканцев. Те считают, что это помешает США сохранить лидерство в сфере ИИ-технологий. Тем не менее, Дженсен Хуанг не так давно раскритиковал запрет на продажу чипов в Китай, заявив, что это только ускоряет технический прогресс в Поднебесной. Многие политики из США считают, что сохранение экспорта помешает Китаю полностью перейти на собственные решения, такие как продукция Huawei. До апрельского запрета китайские технологические гиганты, включая Tencent, ByteDance и Alibaba, увеличили закупки H20, внедряя относительно недорогие и эффективные ИИ-модели DeepSeek китайской разработки, а также собственные модели. Популярность продуктов NVIDIA в Китае трудно переоценить — их активно ремонтируют в КНР и ввозят контрабандой в страну. После запрета на продажи Р20 в апреле, NVIDIA предупредила, что должна буквально «списать» запасы на $5,5 млрд, а Хуанг заявил в одном из интервью, что компания потеряет от отказа от потенциальных продаж ещё $15 млрд.

28.07.2025 [15:10], Руслан Авдеев

К октябрю 2025 года Малайзия установит правила устойчивого развития дата-центров в странеМалайзия намерена ввести в действие Рамочную программу устойчивого развития дата-центров (Sustainable Data Centre Framework) к октябрю 2025 года. Эти усилия предпринимаются в рамках стремления упорядочить развитие цифровой инфраструктуры и укрепить позиции страны в качестве регионального хаба для данных, сообщает портал F&L Asia. Инициатива возглавлена Министерством цифровых технологий (KDX) и направлена на формирование чёткой и согласованной политики для национальных и региональных органов власти. Это должно способствовать развитию цифровой экономики страны. Объявление было сделано после совместного заседания, проведённого министром инвестиций, торговли и промышленности (MITI) Тенгку Датуком Сери Зафрулом Азизом (Tengku Datuk Seri Zafrul Aziz), а также министром цифровых технологий Гобиндом Сингхом Део (Gobind Singh Deo). Центральным органом, ответственным за одобрение инвестиций в расширение дата-центров, объявлено Малайзийское агентство по развитию инвестиций (MIDA). Рамочная программа охватывает различные направления — от утверждения новых проектов и сертификации инвестиций до расширения существующих объектов. Также планируется чётко разграничить полномочия федеральных и региональных властей, чтобы избежать дублирования функций. Это должно обеспечить более «плавное» внедрение регуляторных норм.

Источник изображения: Polina Kuzovkova/unsplash.com По словам главы MITI, программа направлена на создание экологически устойчивой, конкурентоспособной, стратегически выверенной и привлекательной для инвесторов экосистемы дата-центров на территории Малайзии. ЦОД, по его словам, являются ключевым элементом цифровой экономики, обеспечивающим «эффект мультипликатора» и привлекающим инвестиции. Программа также поддержит стремление Малайзии стать крупным региональным IT-хабом, особенно в сфере цифровой инфраструктуры и облачных вычислений — на фоне ограничений, с которыми сталкивается соседний Сингапур в связи с нехваткой площадей под строительство новых дата-центров. Разработкой рамочной программы руководит специальная рабочая группа по дата-центрам (Data Centre Task Force, DCTF), сформированная ещё в феврале 2023 года. В её задачи входят координация национальной политики, оптимизация процедур согласования проектов и мониторинг прогресса в развитии инфраструктуры сектора ЦОД. В начале 2025 года Малайзия и Сингапур подписали соглашение о создании особой экономической зоны JS-SEZ.Согласно плану, компании будут открывать азиатско-тихоокеанские штаб-квартиры в Сингапуре, а производство и другие виды деятельности переносить в близлежащие регионы, такие как Джохор (Малайзия). Такой подход особенно важен для отраслей, требующих значительных земельных ресурсов, например для строительства дата-центров — в условиях острого дефицита свободных площадей, энергии и природных ресурсов в самом Сингапуре. Впрочем, у Малайзии, вероятно, более обширные самостоятельные планы. По данным июльского доклада Cushman & Wakefield, Малайзия, Таиланд и Япония станут лидерами по росту ЦОД в Азиатско-Тихоокеанском регионе. Ещё в конце 2024 сообщалось, что Малайзия открывает Национальный офис ИИ для становления в стране ключевого ИИ-хаба Юго-Восточной Азии.

28.07.2025 [15:04], Руслан Авдеев

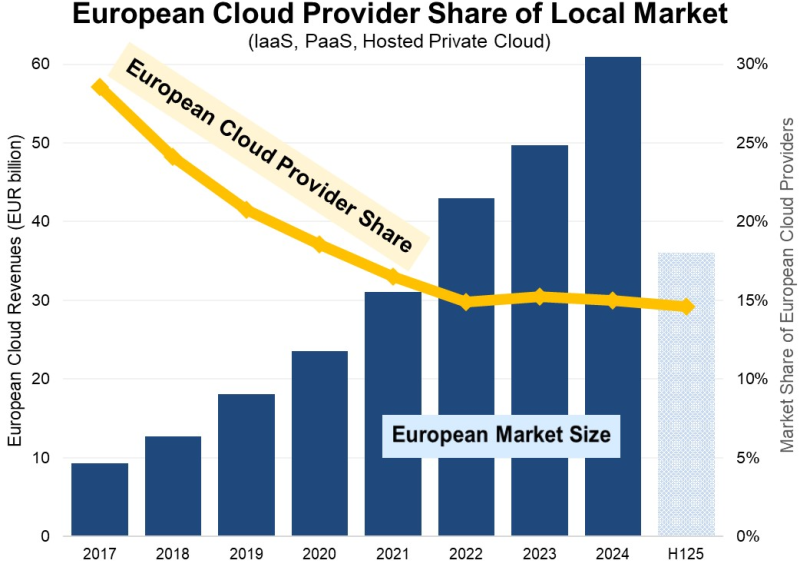

Доля европейских облачных провайдеров на местном рынке снизилась до 15 % и остаётся на этом уровне годамиКак свидетельствуют новые данные Synergy Research Group, европейские операторы облачных сервисов с 2017 по 2024 годы увеличили свои местные доходы более чем втрое. Правда, за тот же период облачный рынок вырос более чем в шесть раз, составив в 2024 году €61 млрд ($70 млрд), сообщает пресс-служба компании. При этом доля европейских облачных провайдеров на местном рынке снизилась с 29 % в 2017 году до 15 % в 2022 году, и с тех пор сохраняется на одном уровне. Основными бенефициарами стали Amazon (AWS), Microsoft и Google — на эту тройку приходится 70 % рынка региона. Среди европейских провайдеров лидируют SAP и Deutsche Telekom, но на каждого из них приходится лишь по 2 % европейского рынка. Определённую роль играют и OVHCloud, Telecom Italia, Orange, а также многочисленные игроки национального и регионального масштабов. Оставшаяся часть европейского рынка приходится на мелких облачных провайдеров из США и Азии. Как утверждают в Synergy, выручка от облачной инфраструктуры (включая IaaS, PaaS и хостинг частных облаков) в I полугодии текущего года составила €36 млрд, а за весь год она вырастет год к году на 24 %. Большая часть рынка приходится на IaaS- и PaaS-сервисы, и они растут быстрее, чем сегмент частных облаков. Драйвером рынка становится искусственный интеллект (ИИ) — рост генеративных сервисов на основе ИИ, вроде GPUaaS и GenAI PaaS, составляет 140–160 %.

Источник изображения: Synergy Research Group По статистике Synergy, крупнейшими облачными рынками в регионе являются Великобритания и Германия, но только сейчас крупнейшими рынками с самыми высокими темпами роста названы Ирландия, Испания и Италия. По словам представителя Synergy Research, на рынке облачных услуг начинающим игрокам приходится делать огромные финансовые ставки, иметь долгосрочное видение инвестиционной политики и грядущих прибылей, а также всё время совершенствовать бизнес. При этом ни одна европейская компания не соответствует этим критериям, и на рынке предсказуемо доминируют американские компании. Они ежеквартально вкладывают в европейские программы капиталовложения порядка €10 млрд — конкурировать с ними местному бизнесу буквально невозможно. В результате европейские облачные поставщики в основном обслуживают локальные группы клиентов с специфическими для региона потребностями, иногда взаимодействуя с крупными американскими провайдерами. Хотя многие европейские поставщики облачных услуг, вероятно, продолжат расти, вряд ли они смогут существенно изменить положение дел на облачном рынке. В конце мая эксперты заявили, что европейским пользователям отказаться от американских облаков сегодня уже практически невозможно. Более того, в июне SAP заявила, что не видит смысла в строительстве Европой собственной облачной инфраструктуры. Между тем, тотальное доминирование американского бизнеса в Европе грозит местным облачным провайдерам серьёзными проблемами. Так, в мае 2025 года сообщалось, что Microsoft всё ещё не создала продукта, удовлетворяющего требованиям соглашения с ассоциацией европейских облачных провайдеров CISPE. В рамках действующей под эгидой CISPE инициативы было решено, что относительно действий компании всё ещё «существуют опасения, хотя предложены меры для исправления». Кроме того, в июле Microsoft признала, что не может гарантировать суверенитет данных в Европе. Наконец, CISPE подала иск в Европейский суд общей юрисдикции, утверждая, что Еврокомиссия не выдвинула никаких условий, мешающих Broadcom злоупотреблять доминирующим положением на рынке. CISPE заявляет, что доминирование ПО VMware на рынке виртуализации означает, что обновление условий лицензирования затронут практически всех европейских облачных операторов и их пользователей. Год назад CISPE прямо заявила, что новая лицензионная политика Broadcom грозит банкротством небольшим облачным провайдерам.

28.07.2025 [14:16], Сергей Карасёв

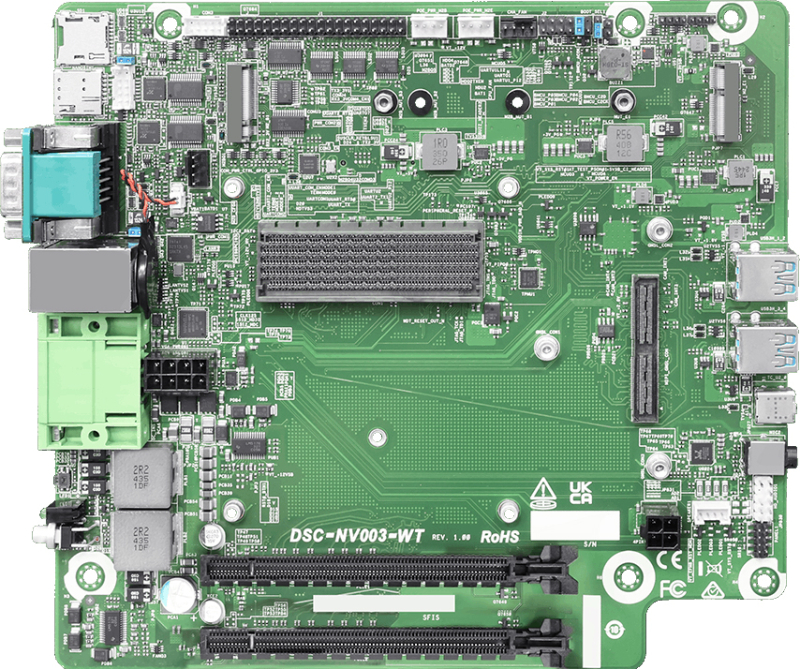

ASRock Industrial представила платформу NVIDIA Jetson AGX Orin для периферийных ИИ-устройствКомпания ASRock Industrial анонсировала комплект для разработчиков NVIDIA Jetson AGX Orin Developer Kit. Решение предназначено для построения периферийных ИИ-устройств, роботов, дронов, дистанционно управляемых систем и пр. В основу новинки положена аппаратная платформа NVIDIA Jetson AGX Orin. Комплект представлен в трёх вариантах — Jetson AGX Orin Industrial (JAOi), Jetson AGX Orin 64GB (JAO 64GB) и Jetson AGX Orin 32GB (JAO 32GB). ИИ-производительность достигает соответственно 248, 275 и 200 TOPS (INT8). Во всех случаях конфигурация включает GPU на архитектуре Ampere, CPU на базе Arm Cortex-A78AE и флеш-модуль eMMC 5.1 вместимостью 64 Гбайт. Версия JAOi несёт на борту 64 Гбайт памяти LPDDR5 DRAM с поддержкой ECC, тогда как модификации JAO 64GB и JAO 32GB укомплектованы соответственно 64 и 32 Гбайт LPDDR5 DRAM. Все варианты располагают коннектором M.2 Key M 2280 для NVMe SSD с интерфейсом PCIe 3.0 x4, разъёмом M.2 Key B 3042/3052/2280 для модема 4G/5G (плюс слот Nano SIM) и коннектором M.2 Key E 2230 (PCIe 3.0 x1; USB 2.0) для адаптера Wi-Fi / Bluetooth. Предусмотрены два разъёма PCIe x16 (на уровне сигналов PCIe 4.0 x8), слот microSD (UHS-I/SDR-50), четыре порта USB 3.2 Gen2x1 Type-A, разъём USB 2.0 Type-C и интерфейс HDMI 2.0. В оснащение входят сетевые контроллеры Marvell_88E1512-A0-NNP2C000 Gigabit Ethernet и Intel I226IT с гнёздами RJ45. Реализованы два последовательных порта RS-232/422/485 через коннектор DB9 и разъём на плате. Кроме того, упомянута 40-контактная колодка с поддержкой I2S, I2C (×2), SPI, UART, CAN(×2), PWM (×2) и пр. Через модули M.2 E Key и B Key, а также карты PCIe могут быть добавлены до 12 портов PoE (IEEE 802.3af) для питания внешних устройств, таких как камеры. Имеется встроенный модуль TPM 2.0 для обеспечения безопасности. Диапазон рабочих температур простирается от -25 до +45 °C. Питание в диапазоне 12–48 В подаётся через DC-разъём. Габариты изделия составляют 190,32 × 210,31 мм. |

|