Материалы по тегу: google

|

07.12.2023 [21:04], Сергей Карасёв

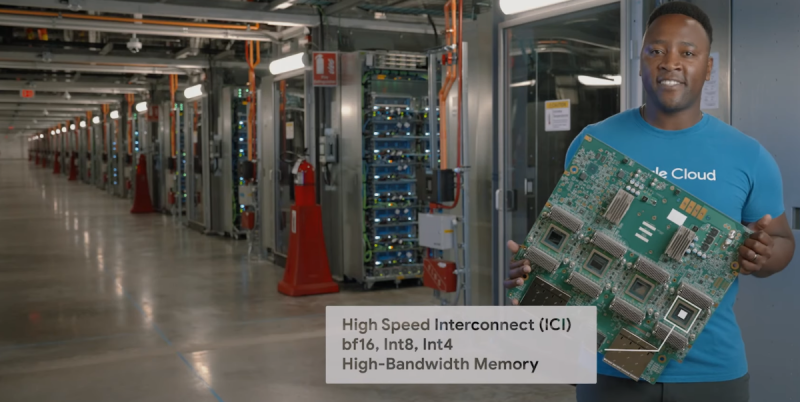

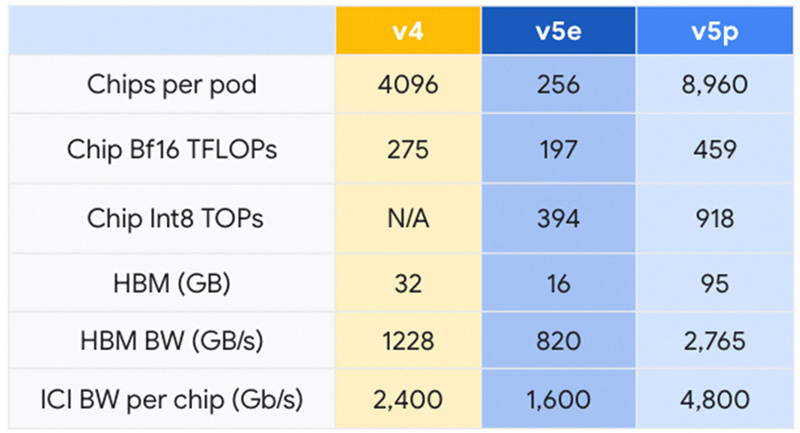

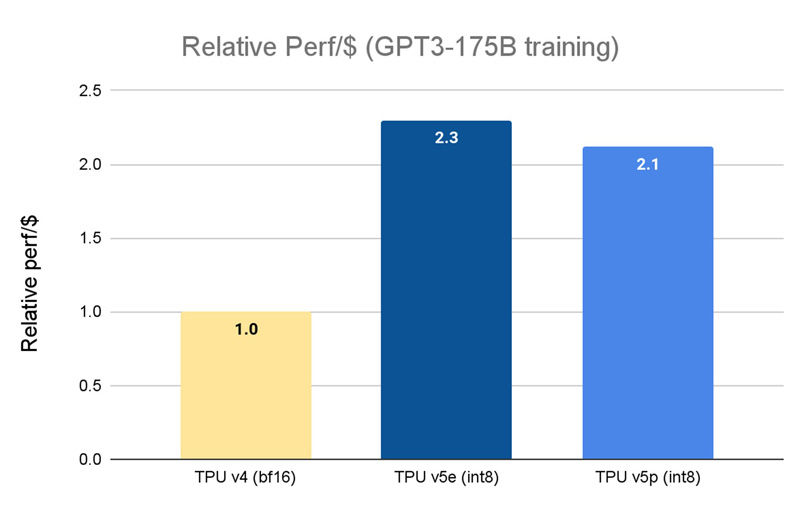

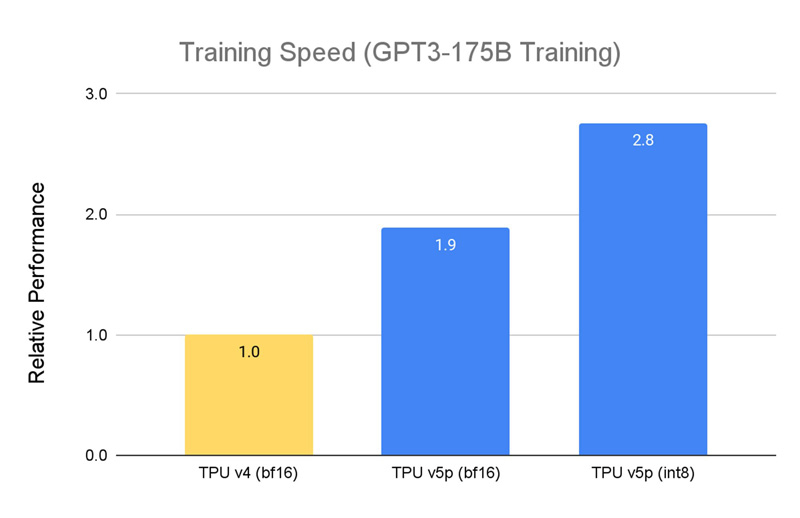

Google представила Cloud TPU v5p — свой самый мощный ИИ-ускорительКомпания Google анонсировала свой самый высокопроизводительный ускоритель для задач ИИ — Cloud TPU v5p. По сравнению с изделием предыдущего поколения TPU v4 обеспечивается приблизительно 1,7-кратный пророст быстродействия на операциях BF16. Впрочем, для Google важнее то, что она наряду с AWS является одной из немногих, кто при разработке ИИ не зависит от дефицитных ускорителей NVIDIA. К этому же стремится сейчас и Microsoft. Решение Cloud TPU v5p оснащено 95 Гбайт памяти HBM с пропускной способностью 2765 Гбайт/с. Для сравнения: конфигурация TPU v4 включает 32 Гбайт памяти HBM с пропускной способностью 1228 Гбайт/с.

Источник изображений: Google Кластер на базе Cloud TPU v5p может содержать до 8960 чипов, объединённых высокоскоростным интерконнектом со скоростью передачи данных до 4800 Гбит/с на чип. В случае TPU v4 эти значения составляют соответственно 4096 чипов и 2400 Гбит/с. Что касается производительности, то у Cloud TPU v5p она достигает 459 Тфлопс (BF16) против 275 Тфлопс у TPU v4. На операциях INT8 новинка демонстрирует результат до 918 TOPS.  В августе нынешнего года Google представила ИИ-ускоритель TPU v5e, созданный для обеспечения наилучшего соотношения стоимости и эффективности. Это изделие с 16 Гбайт памяти HBM (820 Гбит/с) показывает быстродействие 197 Тфлопс и 394 TOPS на операциях BF16 и INT8 соответственно. При этом решение обеспечивает относительную производительность на доллар на уровне $1,2 в пересчёте на чип в час. У TPU v4 значение равно $3,22, а у новейшего Cloud TPU v5p — $4,2 (во всех случаях оценка выполнена на модели GPT-3 со 175 млрд параметров).  По заявлениям Google, чип Cloud TPU v5p может обучать большие языковые модели в 2,8 раза быстрее по сравнению с TPU v4. Более того, благодаря SparseCores второго поколения скорость обучения моделей embedding-dense увеличивается приблизительно в 1,9 раза. На базе TPU и GPU компания предоставляет готовый программно-аппаратный стек AI Hypercomputer для комплексной работы с ИИ. Система объединяет различные аппаратные ресурсы, включая различные типы хранилищ и оптический интерконнект Jupiter, сервисы GCE и GKE, популярные фреймворки AX, TensorFlow и PyTorch, что позволяет быстро и эффективно заниматься обучением современных моделей, а также организовать инференс.

07.10.2023 [18:30], Сергей Карасёв

Видео с котиками подождут: Google тестирует систему перераспределения нагрузок в ЦОД в часы пикКорпорация Google, по сообщению Datacenter Dynamics, тестирует специализированную систему, которая позволяет динамически снижать энергопотребление определённых дата-центров в зависимости от текущей нагрузки на локальную энергосеть. Новая система, как отмечается, является дальнейшим развитием технологии перемещения нагрузок между различными ЦОД в зависимости от уровня доступности «зелёной» энергии. Соответствующую функцию Google начала использовать в 2020 году. При этом речь идёт только о задачах, для которых не критичны задержки или требования о суверенитете данных — например, транскодирование видео для YouTube или обновление словарной базы Google Translate. Похожий инструмент внедряет и Microsoft.

Источник изображения: Google Тестируемая теперь система даёт возможность во время перегрузок местных электросетей переносить несрочные вычислительные задачи на другое время и/или в другое место. Таким образом, в часы пик дата-центры Google сокращают потребление энергии, что снижает вероятность возникновения сбоев в энергосистеме региона, где располагается оборудование. В настоящее время эта система развёрнута в ЦОД на Тайване, в Орегоне и по всей Европе. В дальнейшем планируется её внедрение в других облачных зонах. Google уверяет, что использование функции перераспределения нагрузок не влияет на качество предоставляемых услуг. Отмечается, что Google планирует нагрузки, опираясь в том числе на информацию от операторов электрических сетей. Некоторые задачи перенаправляются в другие ЦОД, тогда как выполнение некритичных операций просто откладывается. Система была опробована в Европе зимой 2022–2023 гг., когда произошёл резкий рост цен на энергоносители. Google использовала технологию для снижения энергопотребления на своих объектах в Нидерландах, Бельгии, Ирландии, Финляндии и Дании периоды типовой пиковой нагрузки. А в Орегоне и Небраске Google снижала энергопотребление дата-центров во время недавних экстремальных погодных явлений.

30.08.2023 [16:04], Алексей Степин

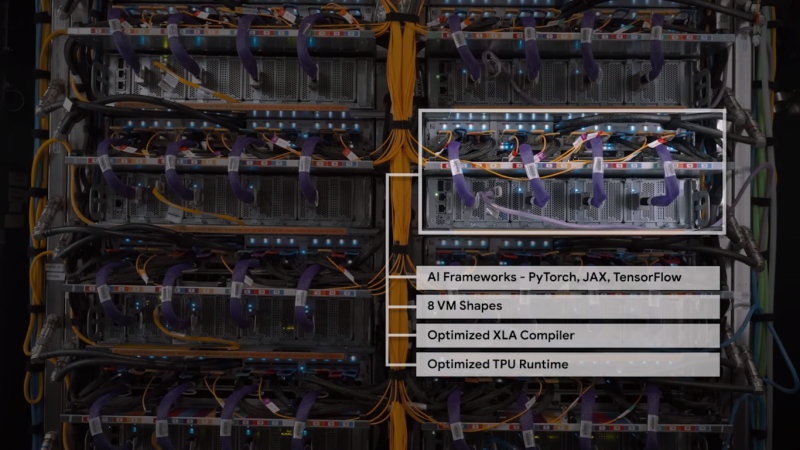

Google Cloud анонсировала новое поколение собственных ИИ-ускорителей TPU v5eКак известно, Google Cloud использует в своей инфраструктуре не только сторонние ускорители, но и TPU собственной разработки. Эти кастомные ASIC компания продолжает активно развивать — она анонсировала предварительную доступность виртуальных машин с новейшими TPU v5e, разработка которых заняла более двух лет. Сам чип TPU v5e позиционируется Google как эффективный со всех точек зрения ускоритель, предназначенный для обучения нейросетей или инференс-систем среднего и большого классов. В сравнении с TPU v4 он, по словам Google, обеспечивает вдвое более высокую производительность в пересчёте на доллар для обучения больших языковых моделей (LLM) и генеративных нейросетей. Для инференс-систем преимущество по тому же критерию составляет 2,5x. В сравнении с аналогичными решениями на базе других чипов, например, GPU, выигрыш может составить и 4x. Каждый чип TPU v5e включает четыре блока матричных вычислений, по одному блоку для скалярных и векторных расчётов, а также HBM2-память. Компания отмечает, что не экономит на технических характеристиках TPU v5e в угоду рентабельности. Кластеры могут включать до 256 чипов TPU v5e, объединённых высокоскоростным интерконнектом с совокупной пропускной способностью более 400 Тбит/с. Производительность такой платформы составляет 100 Попс (Петаопс) в INT8-вычислениях. Правда, здесь есть нюанс: INT8-производительности TPU v5e составляет 393 Тфлопс против 275 Тфлопс у v4, но вот BF16-производительность у TPU v4 составляет те же 275 Тфлопс, тогда как у v5e этот показатель равен уже 197 Тфлопс. В настоящее время для предварительного тестирования доступно уже восемь вариантов инстансов на базе v5e, а в зависимости от конфигурации количество TPU может составлять от 1 до более чем 250. В рамках платформы обеспечена полная интеграция с Google Kubernetes Engine, собственной платформой Vertex AI, а также с большинством современных фреймворков, включая PyTorch, TensorFlow и JAX. Работа с TPU v5e будет значительно дешевле, чем с TPU v4 — $1,2/час против $3,4/час (за чип). В настоящее время машины с TPU v5e доступны только в североамериканском регионе (us-west4), но в дальнейшем возможность их использования появится в регионах EMEA (Нидерланды) и APAC (Сингапур). Также Google предлагает опробовать технологию Multislice, позволяющей объединять в единый комплекс десятки тысяч TPU v5e или TPU v4, где каждый «слайс» может содержать до 3072 чипов TPU (v4). В максимальной конфигурации можно развернуть 64 инстанса, работающих с 256 кластерами TPU v5e. Сама компания уже использует новые чипы для своего поисковика и Google Photos.

07.04.2023 [20:36], Сергей Карасёв

Google заявила, что её ИИ-кластеры на базе TPU v4 и оптических коммутаторов эффективнее кластеров на базе NVIDIA A100 и InfiniBandКомпания Google обнародовала новую информацию о своей облачной суперкомпьютерной платформе Cloud TPU v4, предназначенной для решения задач ИИ и машинного обучения с высокой эффективностью. Система может использоваться в том числе для работы с крупномасштабными языковыми моделями (LLM). Один кластер Cloud TPU Pod содержит 4096 чипов TPUv4, соединённых между собой через оптические коммутаторы (OCS). По словам Google, решение OCS быстрее, дешевле и потребляют меньше энергии по сравнению с InfiniBand. Google также утверждает, что в составе её платформы на OCS приходится менее 5 % от общей стоимости. Причём данная технология даёт возможность динамически менять топологию для улучшения масштабируемости, доступности, безопасности и производительности. Отмечается, что платформа Cloud TPU v4 в 1,2–1,7 раза производительнее и расходует в 1,3–1,9 раза меньше энергии, чем платформы на базе NVIDIA A100 в системах аналогичного размера. Правда, пока компания не сравнивала TPU v4 с более новыми ускорителями NVIDIA H100 из-за их ограниченной доступности и 4-нм архитектуры (по сравнению с 7-нм у TPU v4). Благодаря ключевым инновациям в области интерконнекта и специализированных ускорителей (DSA, Domain Specific Accelerator) платформа Google Cloud TPU v4 обеспечивает почти 10-кратный прирост в масштабировании производительности по сравнению с TPU v3. Это также позволяет повысить энергоэффективность примерно в 2–3 раза по сравнению с современными DSA ML и сократить углеродный след примерно в 20 раз по сравнению с обычными дата-центрами.

20.12.2022 [17:06], Владимир Мироненко

В результате судебного разбирательства выяснилось, что на один ЦОД Google приходится четверть объёма потребления питьевой воды американского городкаGoogle раскрыла объёмы потребления воды своих ЦОД. На этот шаг компания пошла после судебного процесса между местной газетой The Oregonian и властями Даллеса (штат Орегон), которые пытались сохранить данную информацию в секрете. В прошлом году The Oregonian затребовала данные о водопотреблении у Google, но не получила их и обратилась к городским властям. Муниципалитет отказался предоставлять эту информацию, объявив её коммерческой тайной, после чего газета подала к нему иск. В итоге городским властям пришлось пойти на попятную. Выяснилось, что в течение 2021 года на объектах поисковой компании в Даллесе было израсходовано около 1,2 млрд л воды, что гораздо меньше по сравнению с 3,8 млрд л, израсходованными инфраструктурой ЦОД Google в Каунсил-Блаффсе (штат Айова). В целом в 2021 году потребление воды на объектах Google в США составило 12,4 млрд л, а за пределами США — 4,4 млрд л. Сама компания считает, что это не так уж и много, утверждая, что общее годовое потребление воды её дата-центрами сопоставимо с расходом воды на обслуживание 29 полей для гольфа на юго-западе США. Google уточнила, что речь идёт о питьевой воде и указанные объёмы не включают воду из других источников, например, морскую воду. По данным The Oregonian, потребление воды ЦОД Google в Даллесе почти утроилось за последние пять лет и теперь составляет более четверти всего объёма воды, используемой в городе. Эти цифры будут расти, поскольку компания планирует построить в городе ещё два ЦОД. Следует также отметить, что Даллес находится в засушливом регионе и здесь наблюдается пик многолетней засухи.

Изображение: Google Исполнительный директор некоммерческой правозащитной группы WaterWatch Джон ДеВоу (John DeVoe) заявил, что увеличение потребления ЦОД воды в два или три раза в течение следующего десятилетия может иметь серьёзные последствия для обитателей водоёмов и других водопользователей в районе Даллеса. Он отметил, что потребление воды в городе удвоилось с 2002 по 2021 год, что поставило под угрозу протекающую здесь реку и отдельные виды обитающих в ней рыб. ДеВоу уточнил, что на долю Google приходится до 29 % всего городского потребления воды. В свою очередь, Google и городские власти заявили, что заключённый контракт учитывает потребности города в воде и что компания обязуется выделить $28,5 млн на модернизацию систем поставки воды. Кроме того, она передала городу права на использование воды на своих промышленных землях в обмен на большее количество воды из городских резервуаров. Город обязался предоставить Google больше воды для новых ЦОД, начав перекачку не использовавшихся ранее подземных вод. Понимая, что у общественности растёт обеспокоенность по поводу значительных объёмов расхода воды ЦОД, технологические компании весьма неохотно делятся такой информацией. Согласно исследованию Uptime Institute, лишь около половины компаний сообщает об использовании воды или выбросах углекислого газа в ЦОД.

23.09.2022 [19:58], Алексей Степин

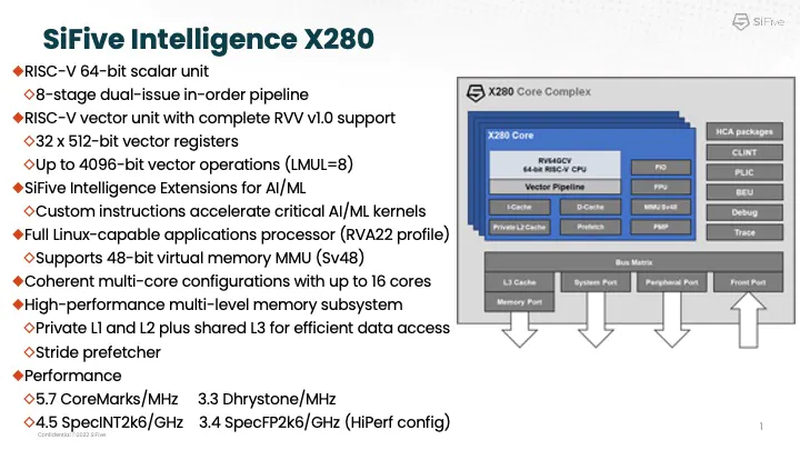

Google заявила, что использует процессоры SiFive Intelligence X280 на RISC-V вместе со своим TPUАрхитектура RISC-V продолжает понемногу набирать популярность и завоевывать внимание ведущих игроков на рынке информационных технологий. На мероприятии AI Hardware Summit в совместном выступлении ведущего архитектора SiFive и архитектора Google TPU было отмечено, что Google уже использует процессоры с ядрами Intelligence X280. Эти ядра — один из вариантов воплощения архитектуры RISC-V, из продвигаемых SiFive. Анонс Intelligence X280 состоялся ещё в апреле 2021 года, когда SiFive выпустила апдейт 21G1, основной упор в котором был сделан на максимизацию характеристик уже существующих ядер RISC-V в области операций с плавающей запятой.

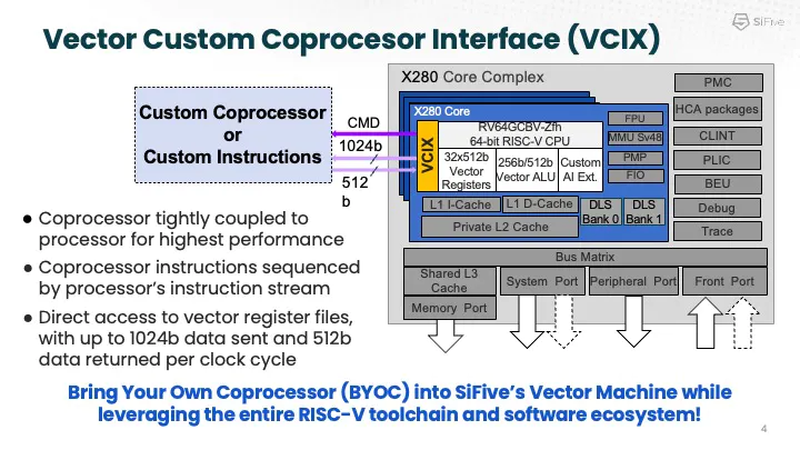

Процессорное ядро Intelligence X280 и его возможности. Источник: SiFive Как следует из названия, данный вариант процессора оптимизирован под задачи машинного интеллекта: ядра RISC-V в нём дополнены векторными конвейерами RISC-V Vector (RVV) с производительностью 4,5 Тфлопс BF16 и 9,2 Топс INT8 на ядро. Одной из самых интересных технологий в Intelligence X280 является интерфейс Vector Coprocessor Interface eXtension (VCIX).

Устройство VCIX. Источник: SiFive Он позволяет подключать внешние ускорители векторных операций напрямую к регистровому файлу X280, минуя основную шину и кеши. Такой подход минимизирует накладные расходы и не требует использования специальных средств при программировании системы, поскольку связка из X280 и подключённого по VCIX ускорителя работает полностью прозрачно в рамках стандартных средств разработки SiFive.

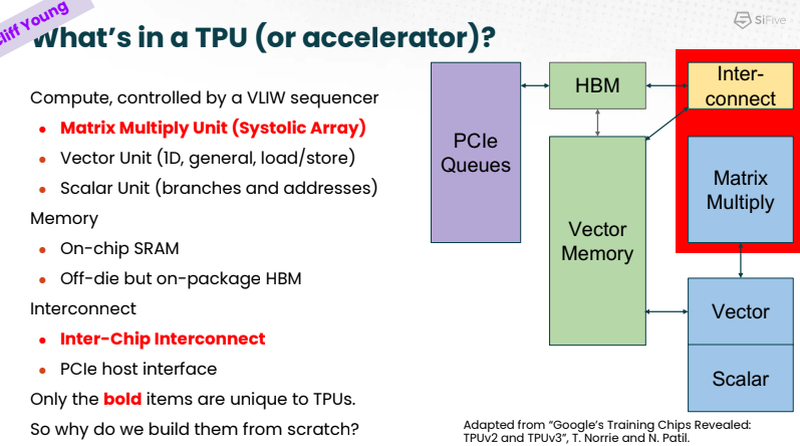

Сильные стороны Google TPU. Источник: SiFive На саммите в Санта-Кларе разработчики SiFive и Google TPU рассказали, что процессоры Intelligence X280 используются в качестве хост-процессоров к ускорителям систолической векторной математики Google MXU; правда, о масштабах внедрения RISC-V в Google сведений приведено не было.

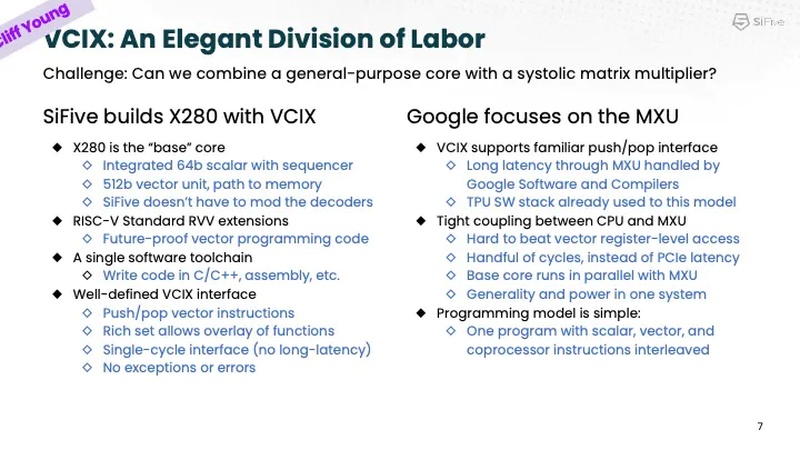

Разделение труда Intelligence X280 и Google TPU. Источник: SiFive Ранее уже появлялась информация, что Google активно тестирует ASIC сторонних разработчиков в связке со своим TPU, в частности, чипы Broadcom, дабы разгрузить его от второстепенных задач и сделать упор на сильных сторонах — матричной математике и быстром интерконнекте. Похоже, SiFive Intelligence X280 решает задачу интеграции подобного рода задач более изящно: как отметил в выступлении Клифф Янг (Cliff Young), архитектор Google TPU, с помощью VCIX можно построить машину, позволяющую усидеть на двух стульях (build a machine that lets you have your cake and eat it too).

06.09.2022 [16:16], Руслан Авдеев

Google ввела в эксплуатацию 150-Тбит/с подводный кабель Equiano длиной 15 тыс. км и стоимостью $1 млрдКомпания Google помогла повысить качество связи между Западной Европой и Южной Африкой, введя в эксплуатацию 150-Тбит/с подводный интернет-кабель Equiano стоимостью $1 млрд. Как сообщает Datacenter Dynamics, кабель назван в честь рождённого в Нигерии писателя Олауда Эквиано (Olaudah Equiano). Протяжённость кабеля, проложенного из Португалии в Южную Африку, составляет 15 тыс. км, он имеет 9 ответвлений и состоит из 12 оптоволоконных пар с поддержкой SDM (Space Division Multiplexing). Месяц назад завершилось приземление кабеля в окрестностях Кейптауна, а на прошлой неделе Google провела церемонию открытия. В Google утверждают, что его эксплуатация позволит создать 1,6 млн рабочих мест, а цена передачи данных в регионе должна упасть на 16-21 %. Проект, изначально анонсированный в 2019 году, является одним из крупнейших в портфолио подводных интернет-кабелей Google — он проложен от Португалии вдоль западного побережья африканского континента.

Источник изображения: Google Это один из шести кабелей, принадлежащих Google из числа уже действующих и находящихся в разработке, и девятнадцатый по счёту из тех, в создание которых Google инвестировала. В точках ответвлений к кабелю получили возможность подключиться и другие страны, включая Намибию и Того. Также планируется подключение Нигерии, Демократической республики Конго и островов Св. Елены. Весной сообщалось, что Google также намерена проложить подводный транстихоокеанский интернет-кабель Topaz от канадского Ванкувера до Миэ и Ибараки в Японии.

26.12.2021 [15:15], Владимир Мироненко

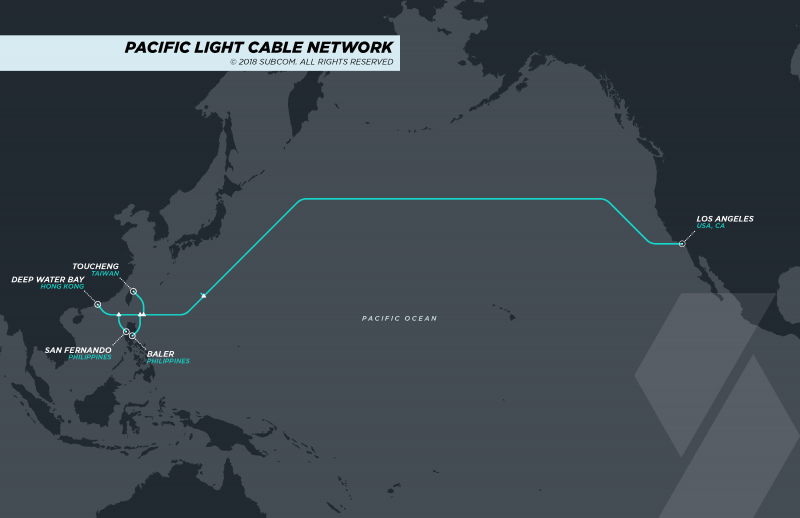

FCC рекомендуют одобрить подводный интернет-кабель Pacific Light Cable Network между США и АзиейКомитет Team Telecom, объединяющий представитилей нескольких министерств США и изучающий вопросы безопасности телекоммуникационных проектов с зарубежным участием, рекомендовал FCC одобрить использование кабеля Pacific Light Cable Network (PLCN), соединяющего США и Азию, после того, как Google и Meta✴ (Facebook✴) договорились «ограничить доступ к информации и инфраструктуре третьему члену консорциума, китайской компании Pacific Light Data Communications Co Ltd». Прокладка 120-Тбит/с кабеля Pacific Light Cable Network протяжённостью почти 12 тыс. км практически завершена, но его ввод в эксплуатацию неоднократно откладывали из-за отсутствия утверждения Федеральной комиссии по связи (FCC). Кабель, содержащий шесть оптоволоконных пар, изначально был предназначен для соединения США, Тайваня, Филиппин и Гонконга. Но в связи с ростом напряжённости между США и Китаем и усилением контроля Пекина над Гонконгом регулирующие органы США отказались одобрять проект. В июне 2020 года FCC призвали отклонить проект, который стал бы первой возможностью обеспечения связи напрямую между США и Гонконгом. В 2016 году, когда было объявлено о прокладке кабеля, крупнейшим инвестором проекта была китайская компания Pacific Light Data Communications Co. (PLDC). Затем магнат Вэй Цзюнькан (Wei Junkang) продал большую часть своей доли в PLDC, владеющей четырьмя парами волокон, «дочке» китайской телеком-компании Dr. Peng Telecom & Media Group, которую подозревают в связи с Huawei и властями Китая соответственно. Теперь Google и Meta✴ договорились, что PLDC будет иметь ограниченный доступ к инфраструктуре и информации, а также отказались от использования гонконгского участка кабеля. Компании также планируют ежегодно проводить оценку рисков в отношении сохранности конфиденциальных данных и рассмотрят возможность добавления маршрутов до Индонезии, Сингапура и Вьетнама.

10.11.2021 [14:45], Руслан Авдеев

Google инвестирует $1 млрд в биржевую группу CME Exchange и станет её облачным провайдеромКрупнейшая в мире группа биржевых площадок Chicago Mercantile Exchange (CME Exchange) заключила с Google соглашение, согласно которому последняя инвестирует в финансовые сервисы $1 млрд. В обмен техногигант получит не только ценные бумаги, но и выгодный контракт на предоставление облачных сервисов. CME Exchange построила собственные дата-центры в США, а в Европе пользуется услугами Equinix. Пять лет назад году главный ЦОД компании был продан CyrusOne за $130 млн с договором «обратной» аренды на 15 лет — здесь размещается основная торговая платформа CME Globex и другие сервисы. В 2018 году CyrusOne даже построила здесь телекоммуникационную вышку высотой порядка 100 м, на которой клиенты могут разместить свои антенны для организации прямой связи с платформой. Теперь же CME Group планирует переместить всю свою IT-инфраструктуру в облако Google Cloud в несколько этапов. Как ожидается, партнёрство позволит CME Group быстрее предоставлять клиентам новые продукты и сервисы. Google получит конвертируемые привилегированные акции без права голоса и контракт на обслуживание CME Group в течение 10 лет — начиная с 2022 года.

16.08.2021 [15:59], Сергей Карасёв

Facebook✴ и Google проложат в Тихом океане интернет-кабель длиной 12 тыс. км и ёмкостью 190 Тбит/сGoogle и Facebook✴ реализуют крупномасштабный проект под кодовым названием Apricot по обеспечению высокоскоростным интернет-доступом ряда стран Азиатско-Тихоокеанского региона. Речь идёт о прокладке подводной магистрали протяжённостью приблизительно 12 тыс. км. В рамках проекта будут проложены две волоконно-оптические линии — Echo и Bifrost. Они свяжут Азиатско-Тихоокеанский регион с Северной Америкой. В настоящее время проект ждёт одобрения со стороны регулирующих органов. Предполагается, что после ввода новых линий в эксплуатацию начальная пропускная способность превысит 190 Тбит/с. Магистраль свяжет Японию, Тайвань, Гуам, Филиппины, Индонезию и Сингапур.  Завершить работы в рамках инициативы Apricot планируется в 2024 году. Проект поможет Google и Facebook✴ улучшить доступность своих многочисленных сервисов для пользователей в регионе. Отмечается, что каналы Echo и Bifrost смогут поддерживать растущие объёмы трафика для сотен миллионов пользователей и миллионов бизнес-структур. |

|