Материалы по тегу: cloud

|

12.08.2025 [22:50], Владимир Мироненко

VK Tech увеличила в I полугодии 2025 года выручку в полтора раза, а количество клиентов выросло более чем втроеРоссийский разработчик корпоративного ПО VK Tech, входящий в холдинг VK, сообщил аудированные финансовые результаты за I полугодие 2025 года. Выручка компании выросла на 48,2 % год к году до 6,7 млрд руб. Около 70% всей выручки принесли облачная платформа VK Cloud и сервисы VK WorkSpace, которые она охарактеризовала как якорные продукты. Скорректированная EBITDA увеличилась в 2,7 раза год к году до 0,7 млрд руб., рентабельность по EBITDA выросла на 5 п.п. до 11 %. Компания отметила значительный рост клиентской базы — в 3,1 раза год к году, до 20,4 тыс. Среди новых клиентов — компании финансового, потребительского, транспортного, телекоммуникационного секторов, в том числе ДОМ.РФ, «Островок», Lamoda, РЖД, «Билайн». Выручка от контрактов с крупными клиентами выросла на 72,4 % год к году, в том числе благодаря росту числа крупных клиентов на 25,0 %. Рекуррентная выручка (не связанная с оказанием единоразовых услуг) год к году выросла вдвое благодаря существенному росту числа клиентов, использующих облачные сервисы по подписке. С учетом сезонности продаж on-premise доля рекуррентной выручки в общем объёме превысила 70 %. Выручка направления «Облачная платформа» (VK Cloud) выросла на 32,9 % год к году до 2,7 млрд руб., при этом продажи по модели on-cloud увеличились на 43,6 %. Также компания увеличила количество проектов на базе публичного облака — на 14,4 %. Выручка направления «Сервисы продуктивности» (VK WorkSpace) выросла на 89,2 % год к году до 2,1 млрд руб. При этом объём продаж в формате on-cloud увеличился в 2,5 раза. Средняя ежемесячная аудитория активных пользователей платных учётных записей по облачной модели увеличилась на 86,0 %. Выручка направления «Дата-сервисы» осталась на прошлогоднем уровне, составив 0,9 млрд руб. Как отметила компания, основную часть выручки направления приносят продажи по модели on-premise и исторически она формируется во II полугодии. Выручка направления «Бизнес-приложения» выросла в 2,2 раза год к году до 1,1 млрд руб., в основном благодаря расширению клиентской базы по всем продуктам направления. В числе главных событий I полугодия компания назвала запуск облегченной конфигурации платформы VK Cloud для построения инфраструктурных частных облаков во внутреннем контуре заказчика — Private Cloud Light; запуск первого в России облачного Data Lakehouse; презентацию Secure Cloud — защищённой облачной платформы на базе VK Cloud, предназначенной для размещения государственных информационных систем. Также в отчётном периоде вышла новая версия платформы Private Cloud 4.2 — решения для построения частного облака на базе VK Cloud.

07.08.2025 [16:00], Владимир Мироненко

В Yandex Cloud AI Studio появились открытые модели OpenAIYandex B2B Tech открыла API-доступ на платформе Yandex Cloud AI Studio к новым рассуждающим open source моделям OpenAI gpt-oss-120b и gpt-oss-20b. С помощью новых моделей можно создавать агентские системы для выполнения различных задач, например, для автоматизации рекрутмента и технической поддержки, анализа и обработки документов и первичной коммуникации с клиентами, говорит компания. Доступность новых моделей по API позволяет российскому бизнесу использовать технологии OpenAI в бизнес-процессах без задействования собственной инфраструктуры. Использовать ИИ-модели напрямую у разработчика российским компаниям вряд ли удастся, так как для этого нужно передавать данные для обработки за рубеж, что идёт вразрез с требованиями российского законодательства. Как отметила Yandex B2B Tech, при использовании Yandex Cloud AI Studio данные компаний хранятся и обрабатываются в российских ЦОД, и её сервис полностью соответствует требованиям закона «О персональных данных». Сообщается, что указанные нейросети сопоставимы по качеству с ведущими моделями OpenAI o3-mini и o4-mini, и в некоторых сценариях превосходят GPT-4o и o1. В них допускается регулировка интенсивности рассуждений и скорости генерации ответа. Вскоре для этих моделей будет доступен вызов функций для взаимодействия с внешними приложениями, что позволит осуществлять поиск информации в интернете при генерации ответа.

29.07.2025 [21:59], Владимир Мироненко

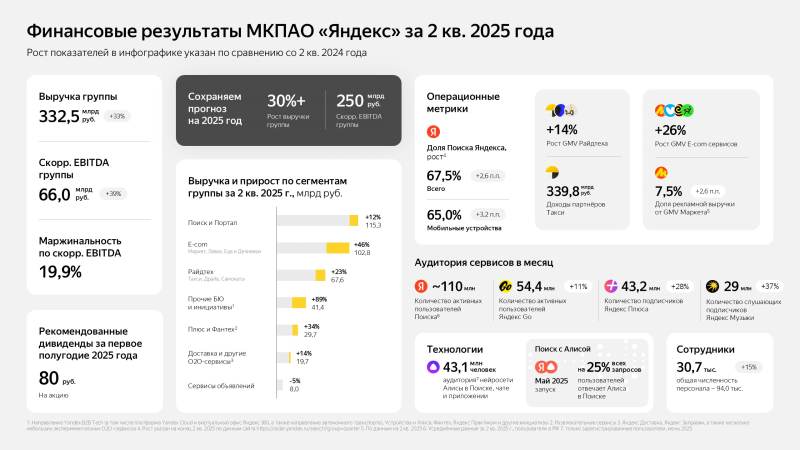

Выручка Yandex B2B Tech выросла во втором квартале 2025 года на 59 %«Яндекс» объявил неаудированные финансовые результаты за II квартал 2025 года, завершившийся 30 июня. Согласно отчёту, составленному в соответствии с международными стандартами финансовой отчётности (МСФО), выручка компании за этот период увеличилась на 33 % в годовом выражении — до 332,5 млрд руб. Компания завершила квартал с чистой прибылью в размере 16,2 млрд руб., тогда как годом ранее зафиксировала убыток в 31,8 млрд руб. Скорректированная чистая прибыль выросла за год на 34 % — с 22,7 до 30,4 млрд руб. Также увеличились скорректированный показатель EBITDA — на 39 % (с 47,6 до 66,0 млрд руб.) — и рентабельность скорректированного показателя EBITDA — на 0,8 п.п., до 19,9 %. Общая численность персонала компании выросла на 11 % и составила 94 043 человека. В категории «Прочие бизнес-юниты и инициативы», включающей направление Yandex B2B Tech (в том числе платформу Yandex Cloud, виртуальный офис «Яндекс 360», а также ряд других сервисов), выручка направления Yandex B2B Tech выросла в годовом выражении на 59 % — до 11,4 млрд руб. Компания отметила, что продолжит развивать и расширять линейку продуктов в сфере кибербезопасности, в том числе за счёт объединения усилий с SolidSoft, а также увеличивать число сервисов, доступных не только в облаке, но и по модели on-premises. «Яндекс» сообщил, что сохранил прежний прогноз на 2025 год, включая рост выручки более чем на 30 % в годовом выражении и скорректированный показатель EBITDA свыше 250 млрд руб.

29.07.2025 [14:30], Владимир Мироненко

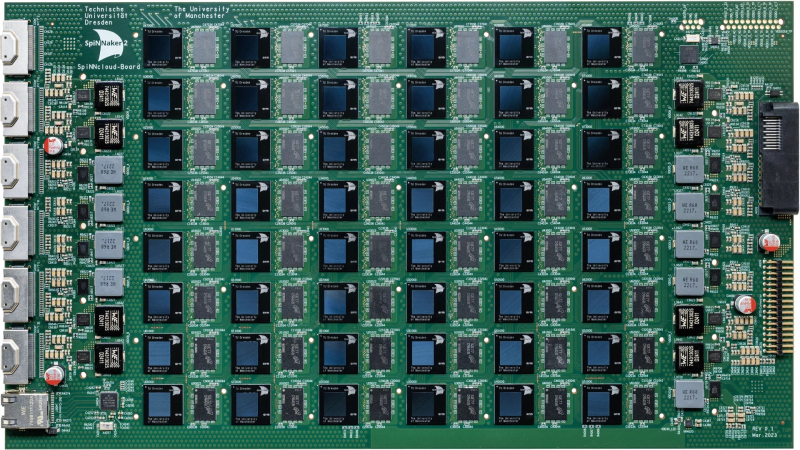

Стартап SpiNNcloud поставит Лейпцигскому университету «нейроморфный» суперкомпьютер для создания новых лекарств in silicoСтартап SpiNNcloud Systems из Дрездена (Германия) сообщил о заключении сделки на поставку Лейпцигскому университету нейроморфного суперкомпьютера, основанного на принципах функционирования человеческого мозга и предназначенного для разработки новых лекарственных препаратов. Суперкомпьютер будет использоваться учёными для моделирования сворачивания белков в рамках исследований в области персонализированной медицины, объединяющей достижения геномики, ИИ, робототехники и новейших диагностических технологий. Стоимость сделки не разглашается. В суперкомпьютере применена высокопараллельная архитектура с 48 чипами SpiNNaker2 на серверной плате, каждый из которых содержит 152 Arm-ядра со специализированными ускорителями и потребляет 0,8–2,5 Вт. Вся система, оснащённая 4320 чипами с 656 640 ядрами, помещается в одну стойку, но университет решил развернуть её в двух стойках, сообщил Гектор Гонсалес (Hector Gonzalez), соучредитель и генеральный директор SpiNNcloud, отметив, что общий энергетический бюджет системы составляет 25 кВт. Новый подход к разработке лекарств использует исключительную параллельность и масштабируемость суперкомпьютера для развёртывания миллионов небольших моделей, которым поручено находить соответствия между молекулами и профилями пациентов. Эта конструкция обеспечивает эффективные, событийно-ориентированные вычисления, позволяя выполнять сложное моделирование и разрабатывать новые персонализированные препараты с более высокой скоростью сходимости и при более низком энергопотреблении по сравнению с традиционными системами на базе GPU. «Точное и детализированное управление процессорами позволяет использовать очень разреженный маршрут, не задействуя все ядра, — поясняет Гонсалес. — Это один из фундаментальных аспектов, который очень сложно реализовать на GPU, поскольку GPU устроен как каскад вычислительных блоков, которые необходимо задействовать максимально полно, чтобы добиться синхронной эффективности». «Архитектура SpiNNcloud делает возможным скрининг миллиардов молекул in silico (виртуальное клиническое исследование)», — сообщил Кристиан Майр (Christian Mayr), соучредитель SpiNNcloud. По его словам, изначально разработанная для моделирования биологических нейронных сетей серверная система SpiNNcloud адаптирована для массивно-параллельного выполнения небольших гетерогенных задач. Прототип нейронной сети позволяет провести скрининг 20 млрд молекул менее чем за час — это на два порядка быстрее, чем на 1000 CPU-ядер. Гонсалес сообщил ресурсу EE Times, что индивидуальный подход к разработке лекарств, используемый в персонализированной медицине, хорошо вписывается в архитектуру SpiNNcloud. «Это множество небольших моделей, которые взаимодействуют друг с другом через чрезвычайно быструю сеть», — пояснил он. «Наша вычислительная архитектура <…> уникально подходит для развёртывания эффективных алгоритмов, требующих динамической разреженности и экстремального параллелизма», — добавил глава SpiNNcloud. «Экстремальный параллелизм SpiNNcloud делает их идеально подходящими для задач, связанных со сворачиванием белков, например, для поиска низкомолекулярных лекарственных препаратов, — отметил Йенс Майлер (Jens Meiler), профессор Института Александра фон Гумбольдта по Интернету и обществу и директор Института поиска лекарственных препаратов Лейпцигского университета. — «Фолдинг белков можно рассматривать как задачу оптимизации, в которой белок стремится найти своё наименьшее энергетическое состояние. Суперкомпьютеры SpiNNcloud хорошо справляются с такими задачами». Самая крупная система, развёрнутая SpiNNcloud на данный момент, включает 30 тыс. чипов (более 5 млрд вычислительных элементов) в Дрезденском университете. «Максимально возможная система, которую мы можем спроектировать, – это 16 стоек, — говорит Гонсалес. — При более чем 16 стойках будет сложно поддерживать достаточную связанность между моделями». По его словам, можно было бы развернуть в Лейпциге и более крупный суперкомпьютер с большим числом ядер, но компании пришлось учитывать финансовые ограничения университета. Как сообщает EE Times, SpiNNcloud также тестирует своё оборудование в новых исследовательских направлениях, основанных на классических методах глубокого обучения, в частности, в работе с MoE-моделями. По словам Гонсалеса, архитектура SpiNNcloud хорошо подходит для таких задач. Разработчик выразил надежду, что архитектуры, вдохновлённые принципами работы мозга, такие как SpiNNcloud, позволят создавать новые типы моделей, невозможные для реализации на массовом оборудовании.

22.07.2025 [11:44], Руслан Авдеев

«Нейроаналитик» «Яндекса» ускорит анализ и визуализацию данныхYandex B2B Tech создала «Нейроаналитика», ИИ-агента, предназначенного для аналитики и визуализации данных. Отмечается, что агент снизит нагрузку на сотрудников-аналитиков и позволит ускорить формирование отчётов, а также проверку бизнес-гипотез в среднем на 30 %. Внешние компании получат доступ к первому варианту агента в сентябре 2025 года. Доступ к новой версии Yandex DataLens с ИИ-агентом будет предоставляться как в облаке, так и в формате on-premise. В пресс-службе компании сообщают, что с помощью нового инструмента можно будет искать инсайты и делать выводы, основанные на информации, отображённой в виде таблиц и графиков. Кроме того, ИИ-агент поможет формировать и редактировать «сложные визуализации» полученной информации. Агент «Нейроаналитик» будет встроен в интерфейс Yandex DataLens в виде чата и будет поддерживать обращения к нейросети на естественном языке — для того, чтобы перестроить визуализацию или, например, изменить расчётную формулу. ИИ-модель по запросу скорректирует соответствующие параметры. Будущее BI-платформы (Business Intelligence), предназначенной для сбора, анализа, визуализации и интерпретации данных с целью поддержки принятия бизнес-решений в компании видят в развитии новых функций на базе ИИ. Отмечается, что с такими функциями аналитика станет доступнее для разных позиций в компаниях.

Источник изображения: Miguelangel Miquelena/unsplash.com Первыми доступ к «Нейроаналитику» получили сотрудники подразделений «Яндекса». Только за первые две недели работы инструмент протестирован 4 тыс. человек. Отмечается, что ПО будет полезно как аналитикам, так и всем, кто работает с большими массивами информации. Кроме того, аналитика пригодится и в личных проектах — для анализа рынка акций или даже изучения динамики цен на товары в маркетплейсе. В основе «Нейроаналитика» лежат технологии Yandex Cloud AI Studio. На платформе доступны новейшие генеративные нейросети «Яндекса», ИИ-модели синтеза и распознавания речи, а также актуальные LLM и VLM на open source основе. Товарный знак «Яндекс Нейроаналитик» уже зарегистрирован «Роспатентом».

22.07.2025 [10:01], Владимир Мироненко

«Яндекс» купила 50 % SolidSoft, чтобы создать с ней СПYandex B2B Tech объявила о создании с SolidSoft, одним из крупнейших российских разработчиков межсетевых экранов для защиты веб-приложений (WAF, Web Application Firewall), совместного предприятия, которое будет развивать решения для обеспечения кибербезопасности, в частности, инструменты для защиты бизнесом своих веб-приложений от атак и других современных угроз. «Яндекс» и SolidSoft будут участвовать в СП в равных долях, для чего «Яндекс» приобретает 50 % SolidSoft с возможностью увеличения своей доли в будущем. Сумма сделки не разглашается. По оценке Apple Hills Digital, сообщает Forbes, стоимость SolidSoft может составлять 3–4 млрд руб., следовательно, стоимость сделки может оцениваться в 1,5–2 млрд руб. Возглавят СП основатели SolidSoft. Сделка не отразится на действующих соглашениях SolidSoft с клиентами и партнёрами, а также на её дальнейших планах по разработке собственных решений. По данным Rusprofile, выручка «Солидсофт» в 2024 году составила 903 млн руб. (рост — 46 %), чистая прибыль — 635 млн руб. (рост — 68 %). Сообщается, что сделка позволит Yandex Cloud усилить информационную безопасность, которая является одним из самых востребованных направлений на платформе. За 2024 год потребление сервисов ИБ в Yandex Cloud выросло в 2,1 раза. По оценке Yandex B2B Tech, в прошлом году объём российского рынка решений для защиты веб-приложений составлял более 30 млрд руб. В рамках сделки компании буду использовать опыт и технологии друг друга и развивать свои продукты в синергии. Сообщается, что они объединят возможности межсетевого экрана SolidWall WAF и Smart Web Security — сервиса Yandex Cloud, который защищает от DDoS-атак и ботов, для более надёжной комплексной защиты. Также СП будет использовать для усиления механизмов защиты ИИ-технологии. Решения СП будут доступны как в облаке, так и по модели on-premises. У ряда продуктов Yandex Cloud уже есть on-premise-версии: СУБД YDB, сервис для работы с генеративными моделями Foundation Models, речевые технологии Yandex SpeechKit, а также BI‑инструмент DataLens.

16.07.2025 [16:43], Владимир Мироненко

Поиск смысла: в СУБД Yandex YDB появился векторный поиск, позволяющий искать по смысловым связямYandex B2B Tech объявила о выходе новой версии СУБД YDB, в которой добавлен векторный поиск. Он позволяет искать не по ключевым словам, а по смыслу. Благодаря возможности устанавливать неочевидные связи между объектами с его помощью можно искать по разнородным данным — текстам, картинкам, видеороликам и аудиофайлам, невзирая на имеющиеся ошибки в текстах и опечатки. Векторный поиск доступен в облаке, а также локально по модели on-premises. Как сообщает Yandex B2B Tech, векторная технология обеспечивает представление данных, по которым ведётся поиск, в виде числовых векторов (эмбеддингов). Сравнивая векторы, можно определить семантическую близость соответствующих им объектов. Новая технология будет, в первую очередь, востребована у компаний в сфере ИИ. В частности, с её помощью можно повысить точность рекомендаций товаров или качество ответов ИИ-ассистента.

Источник изображения: Yandex B2B Tech Технический директор YDB, отметил, что сейчас ИИ-ассистентов стремятся внедрить практически во всех отраслях. Технология компании позволяет создавать ассистентов на архитектуре RAG (Retrieval-Augmented Generation) без дообучения — когда ответ большой языковой модели (LLM) дополняется данными из собственных баз знаний. С помощью векторного поиска можно находить в базах необходимую информацию и добавлять её в ответы LLM. ИИ-ассистент компании «Алиса» уже использует новую технологию. Пользователи версии «Алиса Про» могут попросить её учитывать при составлении ответов свои предпочтения и интересы. В этом случае «Алиса» будет подстраиваться под конкретного пользователя и вести диалог в персонализированной манере. Согласно пресс-релизу, в YDB доступны две версии векторного поиска: точный и приближённый. Точный поиск обеспечивает наилучший результат, но при этом для него требуются сложные вычисления, если данных много. В случае приближённого поиска можно искать по миллиардам векторов за десятки-сотни миллисекунд — даже если корпус векторов не помещается в оперативную память. Такую возможность в мире предоставляют лишь несколько компаний, говорит «Яндекс». Сообщается, что векторный поиск для YDB развивается при поддержке созданного «Яндексом» Фонда технологических инициатив (YATF). В 2025 году он выделил на новаторские проекты внутри компании 330 млн руб.

04.07.2025 [08:39], Руслан Авдеев

Облако с ИИ: Alibaba расширяет ЦОД в Малайзии и на ФилиппинахAlibaba Group Holding развивает дата-центры в Малайзии и на Филиппинах на волне популярности ИИ-проектов. На днях её облачное подразделение запустило свой третий ЦОД в Малайзии, а в октябре намерено открыть второй дата-центр на Филиппинах, сообщает Bloomberg. Также Alibaba Cloud откроет глобальный центр компетенций в соседнем Сингапуре, что поможет ускорить внедрение ИИ в различных сферах — более 5 тыс. предприятий и 100 тыс. разработчиков получат доступ к передовым ИИ-моделям. По словам главы Alibaba Эдди Ву (Eddie Wu), долгосрочной стратегией компании является глобализация её бизнеса. В следующие три года Alibaba ускорит создание глобальной облачной сети в Китае, Японии, Южной Корее, странах Юго-Восточной Азии и на Ближнем Востоке. Планируется и экспансия в Европе, США, Таиланд и Мексике. Всего компания намерена потратить на ИИ-инфраструктуру почти $53 млрд. Пока неизвестно, насколько планы китайского IT-гиганта осуществимы, поскольку совсем недавно появилась информация о масштабном сотрудничестве Малайзии с Huawei в сфере ИИ, но спустя буквально пару дней власти страны дезавуировали прежние заявления на высшем уровне, вероятно, под давлением США. Впрочем, Alibaba не испытывает такого санкционного давления, как Huawei, и широко известна операциями в сфере электронной коммерции за пределами Китая. Компания давно занимается системами искусственного интеллекта и создаёт специальные приложения на основе ИИ-моделей Qwen, параллельно развивая облачные сервисы. После выхода на мировую арену китайского ИИ-стартапа DeepSeek Эдди Ву заявил в феврале 2025 года, что главной целью Alibaba стало создание общего искусственного интеллекта, не уступающего возможностями человеческому сознанию. Это является и целью отрасли в целом.

27.06.2025 [17:45], Андрей Крупин

VK Tech представил линейку новых сервисов информационной безопасностиРазработчик корпоративного программного обеспечения VK Tech (входит в экосистему VK) сообщил о доступности заказчикам новых решений для обеспечения информационной безопасности бизнеса. Всего компанией представлено четыре решения — все они являются собственными разработками VK, выполнены в формате сервисов и включены в состав облачной платформы VK Cloud во всех вариантах поставки. В числе продуктов: платформа для автоматизации проверки безопасности кода Security Gate, система централизованного сбора и анализа событий безопасности Security Information and Event Management (SIEM), сервис контроля доступа к ресурсам Zero Trust Architecture (ZTA) и система защиты данных Data Security Posture Management (DSPM), которая показывает, где в организации находятся конфиденциальные данные, как они используются, и кто имеет к ним доступ.

Источник изображения: Flipsnack / unsplash.com По заверениям разработчика, все четыре продукта отличаются высокой производительностью при обработке больших массивов информации. Так, Security Gate способен в течение суток сканировать более 40 тысяч репозиториев и 1 млрд строк кода. SIEM-система позволяет обрабатывать до 10 млн событий в секунду (EPS) и хранить до 15 Пбайт телеметрии в сжатом виде для быстрого поиска и расследования инцидентов. Система DSPM способна анализировать более 1 петабайта данных ежедневно. «Утечка данных способна нанести бизнесу многомиллионные убытки и подорвать доверие пользователей. Мы превратили наработанную внутри VK экспертизу в готовые сервисы — от DevSecOps до Zero Trust — чтобы наши клиенты могли выдерживать и нейтрализовывать современные кибератаки без роста операционных затрат», — отмечает VK.

27.06.2025 [16:15], Владимир Мироненко

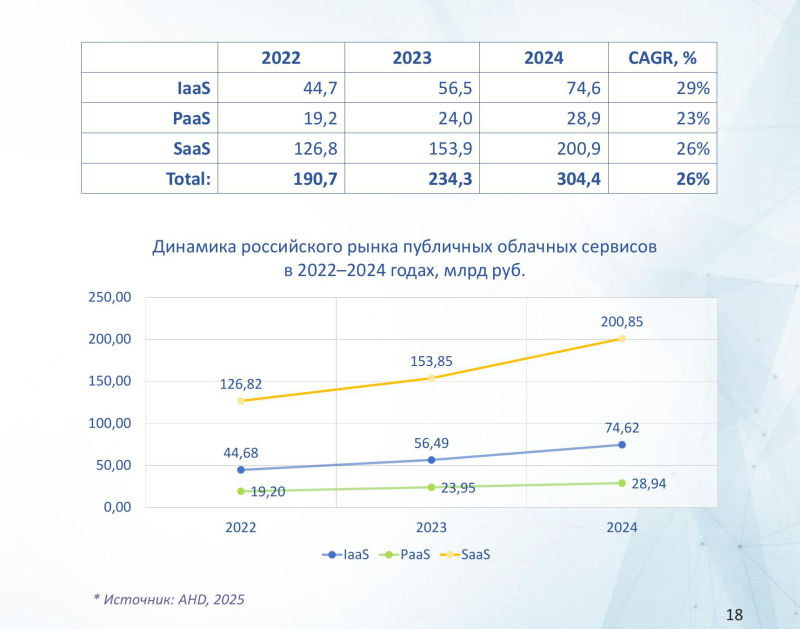

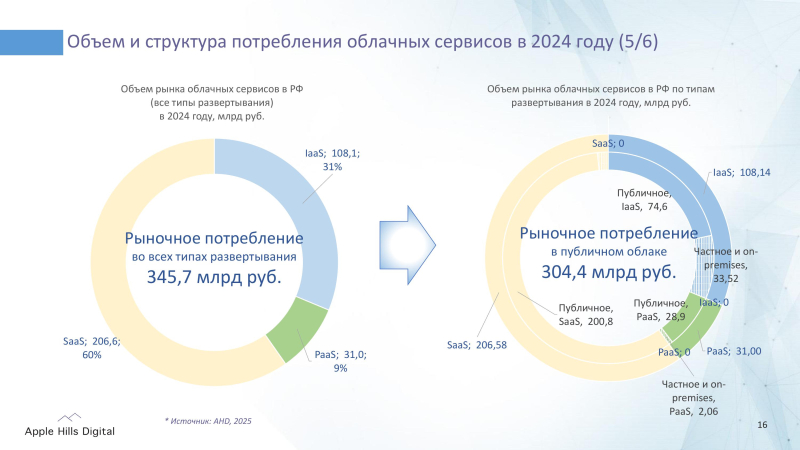

Инфраструктура в публичном облаке России ежегодно увеличивается почти на третьВ период с 2022 по 2024 год на российском рынке облачных сервисов среди наиболее динамично развивающихся сегментов рынка следует отметить инфраструктуру в публичном облаке (IaaS) со среднегодовым темпом роста (CAGR) в размере 29 %, сообщается в исследовании компании Apple Hills Digital проведенном по методологии IDC, которое было дополнено экспертным анализом от VK Tech. Особенно активно растёт спрос на услуги GPU-accelerated server — в среднем за год на 39,3 % — на фоне роста числа задач в области машинного обучения, обработки больших данных и аналитики. Как ожидается, подсегмент GPU-accelerated server сохранит высокие темпы и в дальнейшем — его CAGR в период с 2024 по 2029 год превысит 26 %. За это время российский рынок публичных IaaS увеличится более чем в 2,3 раза до 170,8 млрд руб. в 2029 году. Среднегодовой темп роста (CAGR) рынка за этот период составит 18,1 %. В исследовании проведён анализ рынка облачных сервисов как в публичном облаке, так и в гибридных моделях использования — в частных облаках (Private Cloud), которые могут быть развёрнуты у провайдера и заказчика (on-premise). В 2024 году объём потребления в частных облаках (Private Cloud и On-Premise Cloud) превысил 40 млрд руб., составив 12 % всего рынка облачных сервисов. Реагируя на спрос, ведущие российские провайдеры вывели на рынок решения для развёртывания облачных сервисов в закрытых средах, соответствующих требованиям к информационной безопасности и запросу регулятора. Сегмент PaaS в России развивается медленнее других сегментов. Его доля рынка публичных облачных сервисов в 2024 году составила лишь 9 % или 28,9 млрд руб., что более чем вдвое ниже доли PaaS на мировом рынке публичных облачных сервисов, которая, согласно данным IDC, составляет 20 %. Основная причина этого заключается в отсутствии полноценной замены многим иностранным платформенным продуктам, что ограничивает развитие сегмента и в целом замедляет эволюцию российского рынка облачных сервисов, хотя российские провайдеры уже предлагают отдельные ML-Ops решения. Согласно прогнозу аналитиков, с 2024 по 2029 год российский рынок публичных PaaS увеличится более чем в 3 раза до 89 млрд руб. в 2029 году. Среднегодовой темп роста (CAGR) за этот период составит 25,1 %. Исследователи отметили, что на объём российского рынка влияет распространение в России практики внутреннего потребления облачных сервисов, которое рассматривается отдельно от рыночного потребления. На долю внутреннего потребления в 2024 году пришлось около 12 % от общего потребления облачных сервисов в России или 47 млрд руб., на рыночное потребление — 88 % или 345,7 млрд руб. Общий объём потребления облачных сервисов в РФ включая сегменты IaaS, PaaS и SaaS составил 392,7 млрд руб. Внутреннее потребление развито в сегментах PaaS (до 30 %) и IaaS (25 %), что свидетельствует о высоком технологическом уровне и преимуществах в ресурсах крупных групп с собственными облачными платформами и цифровыми инфраструктурами. Apple Hills Digital отмечает, что российский рынок облачных сервисов находится под влиянием крупных финансовых и технологических групп, рост внутреннего потребления облачных сервисов в которых опережает темпы его развития. Также отмечается рост интереса к облачным сервисам в частных облаках провайдера и on-premise для повышения надёжности, безопасности и независимости ИТ инфраструктуры крупных заказчиков. VK Tech активно развивает VK Cloud в направлении платформенных сервисов, предлагая решения как публичного, так и частного облака. В 2024 году выручка её направления облачной платформы выросла на 82,3 % год к году до 5,8 млрд руб. |

|