Материалы по тегу: разработка

|

20.02.2026 [23:37], Руслан Авдеев

«Гонка вооружений» в сфере ИИ бессмысленна — США и Китай преследуют совершенно разные целиВ ИИ уже вложено больше денег, чем потребовалось для высадки людей на Луну, а в 2026 году расходы на технологию могут достигнуть $700 млрд, почти удвоившись год к году. В США политики и бизнес часто стремятся в этой сфере «победить Китай», однако такой подход предполагает общую цель двух стран и относительную «симметрию» при её достижении. На деле цели у стран на рынке ИИ весьма разные, сообщает IEEE Spectrum. По словам Селины Сюй (Selina Xu), руководящей исследованиями и стратегическими инициативами, касающимися Китая и ИИ в офисе Эрика Шмидта (Eric Schmidt), бывшего главы Google, внимательное изучение развития ИИ в двух странах показывает, что они не стремятся в этой сфере к одним и тем же целям. Более того, они движутся совсем в разных направлениях. По мнению Сюй, США делают акцент на масштабирование, стремясь создать «общий искусственный интеллект» (AGI), тогда как для Китая важнее повышение экономических показателей и использование в реальном мире. По словам Сюй, менталитет «гонки на выживание» способен только навредить — правительства и компании будут пренебрегать необходимыми мерами безопасности для достижения мнимого «первенства». Отчасти это уже наблюдается, например, в сфере энергетики, где администрация президента США продвигает «атомные кампусы» с ослабленными требованиями к безопасности АЭС. Сам Шмидт уже предупреждал об опасности стремления США к доминированию в области ИИ. По мере развития систем машинного обучения в 2010-х гг., видные общественные деятели вроде Стивена Хокинга и Илона Маска уже предупреждали, что универсальный потенциал ИИ невозможно будет отделить от военного и экономического — повторяется модель конкуренции времён Холодной войны. По мнению некоторых экспертов, концепция такого «состязания» выгодна передовым лабораториям, инвесторам и СМИ, которым просто удобнее оперировать простыми метриками успеха вроде размера моделей, контрольных показателей и большей вычислительной мощности. В парадигме «гонки вооружений» «общий искусственный интеллект» — и есть «финишная линия», победителем станет тот, кто первый её достигнет. Тем временем, как считают эксперты, нет никакой гарантии, что страна, создавшая AGI, станет именно победителем и её интересы восторжествуют, поскольку такой искусственный интеллект будет умнее людей и, следовательно, неуправляемым и непредсказуемым. Кроме того, Китай и США совсем-по разному подходят к реализации ИИ-проектов и экономические условия этих стран кардинально отличаются. После десятилетий быстрого роста КНР столкнулась с экономическим спадом, поэтому страна стремится найти новый «двигатель экономики». Вместо того, чтобы вкладывать ресурсы в «спекулятивные» модели развития искусственного интеллекта, Поднебесная рассматривает ИИ как инструмент, позволяющий совершенствовать действующие отрасли, от здравоохранения до энергетики и сельского хозяйства, как инструмент, улучшающий жизнь обычных людей. Для этого ИИ внедряется в производство, логистику, энергетику, финансы и госуслуги. Автопроизводители активно внедряют роботов на заводах с минимальным участием людей, по имеющейся статистике на 2024 год в КНР использовалось впятеро больше промышленных роботов, чем в США. Сельскохозяйственные модели помогают фермерам, в здравоохранении ИИ-инструменты помогают врачам ставить диагнозы и лечить пациентов и др. Даже очень маленькие предприятия изучают возможность использовать ИИ для повышения производительности. В США ИИ-модели тоже внедряются в разные отрасли всё чаще, но основной акцент делается на сервис и обработку информации с применением больших языковых моделей (LLM). Они применяются для обработки неструктурированных данных и автоматизации коммуникаций. Например, банками используются помощники на основе LLM для помощи в управлении счетами пользователей и обработки их рутинных запросов, LLM помогают врачам извлекать ключевые данные из медицинских записей и клинической документации. По словам отраслевых экспертов, LLM больше подходят для экономики США, ориентированной на сферу услуг, чем для китайской индустриальной экономики. Конечно, Китай и США конкурируют в некоторых областях, связанных с ИИ, в частности, касающихся разработки и производства полупроводников для обеспечения работы искусственного интеллекта. Также обе страны стремятся обрести контроль над цепочками поставок для обеспечения национальной безопасности. Китай, безусловно, стремится избавиться от зависимости от американских чипов. Важной сферой для конкуренции является ИИ для военного применения, поскольку та или иная сторона может получить преимущества в плоскости отдельных военных технологий. При этом Китай всё ещё не подобрал «фаворита» для военного и промышленного сектора. После триумфального дебюта DeepSeek в 2025 году, главный получатель средств для разработки «общего искусственного интеллекта» так и не выбран, а вкладывать все средства в AGI страна, похоже, не планирует, поскольку это слишком рискованно. На деле американские и китайские компании до сих пор сотрудничают, несмотря на постепенное «разделение» экономик двух стран. Фактически, по мнению Сюй, для создания безопасного и заслуживающего доверия ИИ было бы лучше, чтобы исследователи и политики США и КНР наладили диалог и достигли консенсуса относительно того, что запрещено, а потом конкурировали бы в этих рамках. В концепции «гонки вооружений» упускается из виду реальная ситуация на местах, обмен опытом между компаниями, обмен научными данными, переток талантов с одного рынка на другой и то, насколько тесно переплетены экосистемы двух стран в целом.

19.02.2026 [15:57], Руслан Авдеев

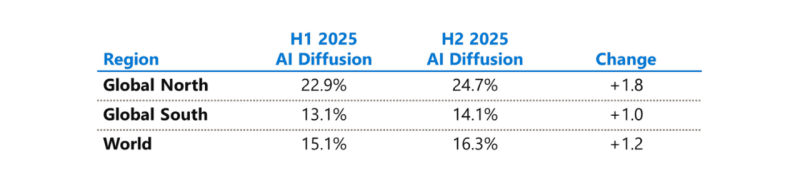

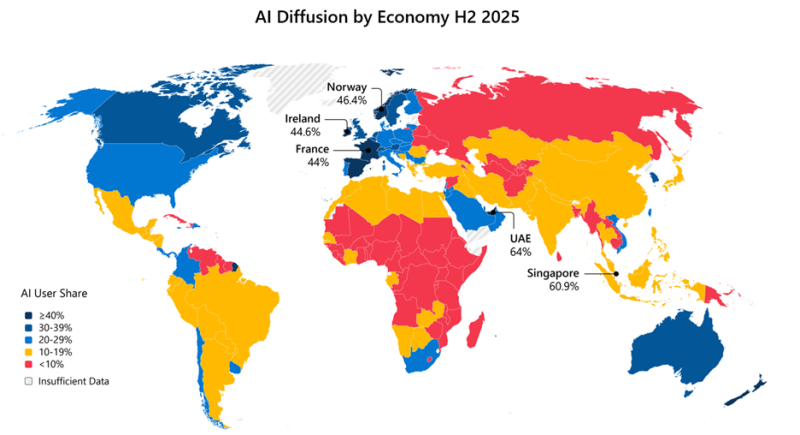

Microsoft бросилась исправлять ИИ-неравенство в мире и выделила на это $50 млрдНа недавнем мероприятии India AI Impact Summit представители Microsoft объявили, что компания готовится инвестировать к концу десятилетия $50 млрд для того, чтобы обеспечить доступ к ИИ странам Глобального Юга. Технологии искусственного интеллекта стремительно распространяются, но чрезвычайно неравномерно в мировом масштабе. В докладе Microsoft AI Diffusion Report утверждается, что в странах Глобального Севера ИИ используется вдвое активнее, чем на юге, и неравенство продолжает увеличиваться. Это сказывается не только на национальном и региональном экономическом росте, но и перспективах развития. Более века неравный доступ к электроэнергии увеличивал экономический разрыв между Глобальным Севером и Югом. С ИИ может произойти аналогичная история. Потребности в новых технологиях требуют существенных инвестиций и больших усилий правительств, частного сектора и НКО. Выделенные Microsoft $50 млрд призваны поддержать новые возможности в странах Глобального Юга. Программа развития ИИ состоит из пяти элементов:

Инфраструктура жизненно необходима для распространения ИИ, говорит компания. ИИ требует энергии, каналов связи, вычислительных мощностей. Только в последнем финансовом году Microsoft инвестировала более $8 млрд в инфраструктуру ЦОД, обслуживающую Глобальный Юг, включая Индию, Мексику, страны Африки, Южной Америки, Юго-Восточной Азии и Ближнего Востока. В первую очередь компания стремится расширить доступ в интернет 250 млн человек в макрорегионе. Microsoft заявила, что уже помогла получить доступ в интернет 117 млн человек в Африке. Инвестиции в ИИ-инфраструктуру осуществляются с учётом необходимости обеспечения местного суверенитета, хотя не так давно компания объявила, что не может обеспечить суверенитет данных в Европе из-за особенностей американского законодательства. Microsoft заявила о создании суверенного управления в публичных облаках, частных суверенных предложениях и тесном сотрудничестве с национальными партнёрами на местах. Утверждается, что в эру ИИ вся информация остаётся в руках клиентов под их полным контролем, без передачи сторонним провайдерам. При этом Глобальный Юг требует огромных инвестиций в инфраструктуру ЦОД, энергетику и связь, что крайне затруднительно без зарубежных инвестиций, в том числе со стороны техногигантов. В числе прочего для удовлетворения этих потребностей было сформировано партнёрство Trusted Tech Alliance, объединяющее 16 ведущих технологических компаний из 11 стран с четырёх континентов.

Источник изображения: Microsoft Однако ЦОД и интернет-каналы — лишь часть необходимой инфраструктуры. Не меньшее значение имеет доступ к технологиям для школ, университетов и НКО и цифровым компетенциям. В предыдущем финансовом году Microsoft инвестировала в программы для государств Глобального Юга $2 млрд, включая гранты, пожертвования, льготы и обучающие программы. В 2025 году компания запустила инициативу Microsoft Elevate, призванную к 2028 году подготовить 20 млн дипломированных специалистов с востребованными ИИ-компетенциями. В Индии компания обучила уже 5,6 млн человек, а к 2030 году намерена довести это число до 20 млн. Компания подготовит 2 млн учителей из более 200 тыс. школ и вузов, а также оснастит 25 тыс. учебных учреждений ИИ-инфраструктурой. Ещё одно направление — создание и доработка ИИ-моделей на местных языках, поскольку локальные решения пока что хуже, чем решения на английском языке. Microsoft поддержала инвестиции в инициативу LINGUA Africa (выделено $5,5 млн) по сбору языковых данных и развитие моделей для африканских языков. Дополнительно совершенствуется бенчмарк MLCommons AILuminate для индийских и азиатских языков для оценки безопасности ИИ вне англоязычной среды. Совместно с образовательными и коммерческими структурами из Индии, Японии, Кореи и Сингапура при участии Microsoft создаётся мультиязычная и мультимодальная подборка из 7 тыс. высококачественных промптов для хинди, тамильского, малайского, японского и корейского языков. Также Microsoft развивает метод Samiksha для учёта локальных языковых и культурных контекстов. Samiksha позволяет выявлять сбои, которые часто упускаются «англоцентричными» методами оценки. В Африке компания совместно с NASA, властями и др. организациями будет применять ИИ к спутниковым данным для анализа продовольственной ситуации. Технология уже отработана в Индии. В рамках Project Gecko компания развивает ИИ-технологии совместно с сообществами в Восточной Африке и Южной Азии для поддержки с/х. В том числе речь идёт о семействе моделей для распознавания речи Paza, способных работать на мобильных устройствах с шестью кенийскими языками. Ведутся работы над многоязыковыми инструментами Copilot, Multimodal Critical Thinking (MMCT) Agent для анализа видео с учётом голоса и текста, адаптацией LLM к низкоресурсным языкам (в т.ч. чичева, инуктитут, маори) и т.д.

Источник изображения: Microsoft Для ускоренного внедрения ИИ нужно понимать, где и как применяется ИИ, с каким недостатками приходится сталкиваться разработчикам, говорит Microsoft. На основе статистики публичных репозиториев GitHub и метрик Azure Foundry компания участвует в создании «рейтинга» Global AI Adoption Index Всемирного Банка. Например, индийское сообщество из 24 млн разработчиков — второе по величине на GitHub и самое быстрорастущее среди 30 ведущих экономик. С 2020 года ежегодный прирост составляет более 26 %, в 2025 году он составил более 36 %. Индийские специалисты занимают второе место в мире по вкладу в open source, использованию GitHub Education, по вкладу в публичные ИИ-проекты и др. Такие данные помогают точнее направлять инвестиции в инфраструктурные проекты, языковые технологии и на обучение. Поддержка подобных метрик помогает измерять достигнутый прогресс. Microsoft подчёркивает, что компания акцентирует внимание в вопросах внедрения ИИ на необходимости создания доступной инфраструктуры, надёжно работающих в реальном мире системах, а также технологиях, которые могут применяться с учётом местных условий. Для этого компания намерена работать с партнёрами, включая обмен данными для оценки прогресса.

19.02.2026 [10:22], Андрей Крупин

«Группа Астра» и «Банк ПСБ» создадут центр ИБ-компетенций и разработки доверенных отраслевых решений«Группа Астра» и «Банк ПСБ» заключили соглашение о сотрудничестве в сфере информационной безопасности. Подписанный «Группой Астра» и «Банком ПСБ» документ предполагает создание совместного предприятия, деятельность которого будет сосредоточена на реализации комплекса мер в области защиты информационных активов и цифровых процессов. Приоритетными направлениями станут развёртывание и эксплуатация единой сервисной платформы для централизованного предоставления ИБ-услуг, в том числе для дочерних компаний финансовой организации. Параллельно будут идти разработка и вывод на рынок линейки специализированных решений для наращивания безопасности IT-систем: различных сервисов, платформенных и программно-аппаратных комплексов.

Источник изображения: пресс-служба «Группы Астра» / astra.ru «Мы уверены, что вместе с коллегами достигнем качественного прорыва в обеспечении информационной безопасности, объединив экспертизу в сфере защиты финансовых систем и передовые отечественные технологии. Создание совместного предприятия станет не только инструментом минимизации операционных рисков, но и точкой роста для стратегической перспективы: мы планируем сформировать самодостаточную экосистему, способную задавать отраслевые стандарты киберустойчивости, стать драйвером для развития смежных направлений и укрепить позиции российских решений в высокотехнологичном сегменте», — говорится в заявлении «Группы Астра».

16.02.2026 [16:47], Руслан Авдеев

Для безопасности и совместимости: IT-гиганты сформировали трансграничное объединение Trusted Tech AllianceВ ходе мероприятия Munich Security Conference мировые лидеры в сфере IT-технологий и ключевые игроки ИИ-рынка заключили соглашение о создании объединения Trusted Tech Alliance (TTA), объединяющего 15 компаний, из Африки, Азии, Европы и Северной Америки для продвижения общих принципов безопасных и совместимых технологий, сообщает Converge! Digest. Интересы группы охватывают весь цифровой стек, от технологий связи до облачных решений и полупроводников, ПО и ИИ. Объединение позиционируется, как трансграничная коалиция, ориентированная на прозрачность, безопасность и защиты данных на фоне растущей геополитической фрагментации. Среди основателей числятся AWS, Microsoft, Google Cloud, Nokia, Ericsson и Anthropic, а также Cassava Technologies, Cohere, Hanwha Group, Jio Platforms, Nscale, NTT, Rapidus, Saab и SAP. От участников объединения требуется соблюдение пяти принципов: прозрачное корпоративное управление, безопасные методы разработки, контроль цепочки поставок, открытость и устойчивость цифровых экосистем, уважение верховенства закона и защиты данных. Участники обязаны применять обязывающие на уровне контрактов гарантии обеспечения надёжности и качества в отношениях поставщиков и поддерживать независимые механизмы оценки.

Источник изображения: krakenimages/unsplash.com Группа подчёркивает, что будет работать с лицами, принимающими решения (ЛПР), и клиентами, чтобы согласовать доверенные технологические практики с целью обеспечения национальной безопасности и экономической конкурентоспособности. Также планируется расширить членство в TTA и сформировать унифицированные подходы к разработке совместимых глобальных технологических стандартов. 15 основателей находятся в десяти странах на четырёх континентах. По словам Ericsson, ни одна компания или страна не может создать безопасный и надёжный цифровой стек в одиночку — доверия и безопасности можно добиться только совместно. Лидеры TTA позиционируют инициативу как ответ на растущий скептицизм, касающийся цифровых технологий и роста спроса со стороны правительств и корпоративных клиентов на надёжную, суверенную и безопасную инфраструктуру. Как отмечает Converge, создание TTA отражает ускоренное согласование позиций между облачными гиперскейлерами, телеком-вендорами, разработчиками ИИ-моделей и игроками полупроводникового рынка по мере того, как правительства ужесточают требования, касающиеся суверенитета данных, прозрачности цепочек поставок и управления ИИ-проектами. С учётом того, что участники контролируют ключевые точки ИИ-рынка, от Rapidus, предлагающей передовые решения для разработки ИИ-полупроводников до Anthropic и Cohere, разрабатывающих передовые модели, речь фактически идёт о том, что TTA берёт под контроль важнейшие узлы индустрии в стеке ИИ-инфраструктуры, пытаясь переформатировать стандарты до того, как «нормативная фрагментация» между регионами ужесточится.

03.02.2026 [14:51], Андрей Крупин

«Байкал Электроникс» открыл свободный доступ к документации на серийный микроконтроллер Baikal-UРоссийский разработчик микропроцессоров «Байкал Электроникс» запустил публичный портал, содержащий полный комплект документации на серийный микроконтроллер Baikal-U (BE-U1000). На площадке представлены сведения технического характера, принципиальные схемы, чертежи печатных плат, SDK, API и прочая информация для разработчиков устройств на базе упомянутого изделия. BE-U1000 представляет собой трёхъядерный 32-бит микроконтроллер общего назначения, в основу которого положена архитектура RISC-V. Характеристики устройства позволяют применять его в индустрии интернета вещей, автоматизированных системах управления технологическими процессами, машиностроении, робототехнике, промышленной автоматике, управлении электродвигателями и других отраслях. Изделие включено в реестр Минпромторга РФ и подходит для программ импортозамещения, а также государственных закупок.

Микроконтроллер Baikal-U (источник изображения: baikalelectronics.ru) По словам компании «Байкал Электроникс», размещённая в открытом доступе документация призвана упростить процесс разработки аппаратных решений на базе отечественного микроконтроллера Baikal-U, сократить время интеграции и сделать работу удобной для инженерных команд, технологических партнёров, сообществ разработчиков и образовательных проектов.  Портал будет регулярно обновляться и дополняться — планируется публикация новых практических примеров применения Baikal-U и прикладных заметок, а также дальнейшее улучшение пользовательского опыта при работе с продуктами компании.

26.01.2026 [21:48], Владимир Мироненко

NVIDIA инвестировала в CoreWeave ещё $2 млрд, чтобы та побыстрее построила ИИ ЦОД на 5 ГВтNVIDIA и CoreWeave объявили о расширении партнёрских отношений, что позволит CoreWeave ускорить создание более чем 5 ГВт мощностей ИИ ЦОД к 2030 году. NVIDIA также инвестировала $2 млрд в обыкновенные акции класса А CoreWeave по цене $87,20/шт. Как сообщается в пресс-релизе, «инвестиции отражают уверенность NVIDIA в бизнесе, команде и стратегии роста CoreWeave как облачной платформы, построенной на инфраструктуре NVIDIA». Акции CoreWeave выросли на 14 % в ходе утренних торгов и на 30 % с начала года, несмотря на продолжающиеся операционные убытки, отметил ресурс Investing. Компании сообщили, что с целью удовлетворения продолжающегося роста спроса на ИИ и потребности в вычислительных ресурсах они углубляют согласование своей инфраструктуры, ПО и платформ. Компании намерены:

Несмотря на то, что гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) категорически не согласен с концепцией циклического финансирования, новые инвестиции вряд ли полностью развеют критику, отметил Investing. Многие аналитики по-прежнему рассматривают эти соглашения как косвенную поддержку NVIDIA спроса на собственные чипы. Глава CoreWeave Майкл Интратор (Michael Intrator) ранее назвал обвинения в циклическом финансировании «нелепыми», отметив, что общая доля NVIDIA остаётся относительно небольшой по сравнению с общим объёмом привлечённого CoreWeave капитала, превышающим $25 млрд.

Источник изображения: NVIDIA CoreWeave продолжает осуществлять диверсификацию своей клиентской базы. В ходе последнего квартального отчёта компания сообщила, что вклад крупнейшего заказчика в общую выручку не превышает 35 %. Для сравнения, в 2024-м году около 62 % от суммарной выручки CoreWeave приходилось на Microsoft. Вторым по величине заказчиком была NVIDIA (15 %), которая обязалась выкупить у CoreWeave все нераспроданные ИИ-мощности. У Microsoft имеются контракты с несколькими неооблаками на общую сумму более $60 млрд. Если ранее Microsoft скупала мощности в интересах OpenAI, то теперь OpenAI скупает мощности у CoreWeave напрямую, общая сумма контрактов достигла $22,4 млрд. Кроме того, в рамках партнёрского соглашения с IBM компания CoreWeave обязалась поставить ей один из своих первых ИИ-суперкомпьютеров на базе NVIDIA GB200 NVL72. В числе клиентов CoreWeave также Meta✴, заключившая с ней контракт на $14,2 млрд. Впрочем, для снижения рисков, связанных с крупными заимствованиями для развёртывания ИИ-инфраструктуры IT-гиганты проводят сделки по обеспечению своих проектов через компании специального назначения — SPV (special-purpose vehicle), финансируемые большей частью инвесторами с Уолл-стрит. Чтобы обеспечить выполнение обязательств по развёртыванию ИИ-инфраструктуры в рамках обязательств по контрактам с ИИ-компаниями, CoreWeave прибегает к заимствованиям. В частности, для развёртывания облачной инфраструктуры в рамках долгосрочного соглашения с OpenAI компания договорилась об отложенном кредите (DDTL 3.0) на сумму $2,6 млрд.

20.01.2026 [17:15], Сергей Карасёв

«Базальт СПО» приглашает на XXI ежегодную конференцию «Свободное программное обеспечение в высшей школе»«Базальт СПО» совместно с Институтом программных систем им. А.К. Айламазяна РАН проводит XXI Ежегодную конференцию «Свободное программное обеспечение в высшей школе» (OSEDUCONF). Мероприятие пройдёт 6–8 февраля 2026 года в г. Переславле-Залесском на базе ИПС РАН. Ведущие учёные, педагоги, разработчики и администраторы расскажут об опыте внедрения СПО и организации образовательного процесса, создания благоприятных условий для вовлечения студентов в реальные проекты разработки свободных программных продуктов. Оргкомитет принимает заявки на доклады по следующим темам:

Сроки подачи заявок Для слушателей:

Участие бесплатное. Онлайн-трансляция конференции будет доступна на VK Видео и странице конференции. Зарегистрироваться на конференцию и ознакомиться с информацией о форматах и шаблонах тезисов можно на сайте. По вопросам, связанным с докладами, тезисами, программой конференции, регистрацией, размещением, трансфером можно обратиться к организаторам по электронной почте conference@lists.altlinux.org.

14.01.2026 [17:14], Руслан Авдеев

Евросоюз делает ставку open source, чтобы избавиться от зависимости от IT-гигантов из США

open source

software

евросоюз

импортозамещение

информационная безопасность

конфиденциальность

разработка

сша

Еврокомиссия начала новый раунд консультаций, связанный с открытым ПО, которое, как предполагается, это поможет местным разработчикам снизить зависимость от платформ американских IT-гигантов и перейти к созданию собственных open source альтернатив, сообщает The Register. В документе Call for Evidence Брюссель заявляет, что привычка ЕС полагаться на «неевропейских» (фактически американских) техногигантов стала «стратегической обузой», ограничивающей выбор, ослабляющей возможность конкурировать и создающей риски в цепочках поставок во всех сферах, от облачных сервисов до критической инфраструктуры. Консультации, которые продлятся до 3 февраля — первые шаги в рамках разработки официальной стратегии формирования «европейских открытых цифровых экосистем» (European Open Digital Ecosystems), благодаря которым open source будет рассматриваться как ключевой элемент инфраструктуры, а не просто дополнение, которое «неплохо было бы иметь». По данным Еврокомиссии, зависимость от зарубежных вендоров усложняет для Евросоюза контроль собственного цифрового стека, потенциально угрожает безопасности и надёжности в важных секторах. Open source даёт возможность избавиться от зависимости и лежит в основе обширного портфолио высококачественных и безопасных цифровых решений, которые можно использовать как жизнеспособные альтернативы проприетарным платформам.

Источник изображения: Shahadat Rahman/unsplash.com Как заявляют в Еврокомиссии, сильный и развитый сектор open source может внести эффективный вклад в инновации Евросоюза и ускорить стандартизацию, усиливая конкурентоспособность объединения для сохранения его суверенитета. Кроме того, это обеспечит экономическое процветание, надёжность и будет способствовать распространению влияния во всём мире. Отдельные техноэнтузиасты, стартапы, малые и средние бизнесы вносят значительный вклад, выводя продукты open source на рынок. По расчётам самой Еврокомиссии, 70–90 % современного ПО полагается на open source компоненты, т.е. фактически ПО с открытым исходными кодом лежит в основе цифровой экономики всего мира. В Брюсселе считают, что ЕС вносит в этот процесс значительный вклад, хотя коммерческую и стратегическую выгоду нередко в итоге получают крупные технологические компании, расположенные в других регионах. Для того, чтобы избежать этого, Еврокомиссия намерена обозначить новый подход к open source и пересмотреть свою стратегию, в основном сконцентрированную на том, как структуры ЕС используют и обмениваются кодом в рамках объединения. Теперь Евросоюз намерен обращаться с open source как с экономическим и политическим активом, напрямую связанным с суверенитетом, конкурентоспособностью и кибербезопасностью. Во многом вопрос касается решений, связанных с облачными и ИИ-сервисами, безопасностью, открытой аппаратной составляющей и промышленным ПО, в том числе приложений для автомобилей и др. На этот раз Еврокомиссия будет акцентировать внимание на масштабировании и внедрении такого ПО вместо очередных экспериментальных проектов.

Источник изображения: James Harrison/unsplash.com В Брюсселе признают, что только финансовые вливания не способны обеспечить решение проблемы. ЕС поддерживал программные проекты самой разной направленности, но лишь единицы из них смогли пережить стадию грантов и выжить на рынке. Теперь заявляется, что для масштабирования проекта недостаточно поддержки open source только с помощью программ поддержки исследований и инноваций. Критически важно поддерживать развивающиеся сообщества разработчиков и бизнесов в их намерениях масштабировать проекты. Комиссия изложила возможные меры, включая стимулы для публичных и частных пользователей для участия в развитии базовых проектов, поддержку бизнесов ЕС в сфере open source и помощь стартапам, рискующим не преуспеть в период роста. Также открытый код представлен как инструмент оптимизации прозрачности цепочек поставок и упрощения поиска уязвимостей. При этом ПО с открытым кодом тесно связано с могущественными технологическими платформами, поскольку американские техногиганты активно монетизируют общедоступный мировой код. Даже принадлежащая с некоторых пор Microsoft платформа GitHub предупредила, что устойчивость инфраструктуры open source под вопросом — с таким же мнением осенью выступали крупные открытые проекты в рамках Open Source Security Foundation (OpenSSF).

20.12.2025 [15:09], Сергей Карасёв

Вот на эти два процента Linux и живёт: Linux Foundation получила в 2025 году $311,3 млн, но на ядро потратила лишь $8,4 млнОрганизация Linux Foundation опубликовала финансовые показатели деятельности в 2025 году. Общие поступления достигли $311,3 млн, что на 6,5 % больше по сравнению с предыдущим годом, когда они составляли $292,2 млн. При этом расходы сократились на 5 % — с $299,7 млн до $284,8 млн. В общем объёме выручки на пожертвования и взносы, а также средства участников организации в 2025-м пришлось $133,3 млн. Ещё $83,6 млн составила целевая поддержка проектов, $58,6 млн — спонсорство мероприятий и регистрационные взносы на конференциях. Поступления от обучающих курсов и выдачи сертификатов оцениваются в $29,6 млн. Все прочие виды деятельности вместе взятые принесли $6,2 млн. Крупнейшей статьёй расходов является поддержка проектов — $181,8 млн. На программы обучения в 2025 году потрачено $21,6 млн, на инфраструктуру — $17,7 млн, на проведение мероприятий — $16,8 млн. Приблизительно $15,8 млн израсходовано на поддержание корпоративных операций, $15,7 млн — на сопровождение сообщества. На проекты, связанные непосредственно с ядром Linux, затрачено $8,4 млн (менее 3 % от всего бюджета). Примерно $6,8 млн пришлось на международные операции. В отчете говорится, что по итогам 2025 года Linux Foundation курировала почти 1500 проектов против примерно 1300 годом ранее. Их наибольшая доля связана с облачными технологиями, контейнерами и виртуализацией — 23 %. На втором месте находятся сетевые и периферийные решения с 14 %, а замыкают тройку проекты в области искусственного интеллекта, машинного обучения и аналитики данных с 12 %. Около 12 % приходится также на кроссплатформенные решения, 10 % — на разработку веб-сервисов и приложений, 5 % — на безопасность. Суммарный вклад всех прочих проектов (блокчейн, интернет вещей, встраиваемые системы, DevOps и др.) оценивается в 24–25 %.

19.12.2025 [15:20], Владимир Мироненко

США объявили о заключении партнёрских отношений с 24 ведущими IT-компаниями в рамках «Миссии Генезис»В четверг в Белом доме США состоялся круглый стол с участием представителей администрации президента США и 24 ведущих технологических компаний страны, в ходе которого было объявлено о заключении Министерством энергетики США (DoE) партнёрских соглашений с компаниями с целью продвижения «Миссии Генезис» (Genesis Mission) — национальной инициативы для ускорения научных открытий, повышения национальной безопасности и стимулирования инноваций в энергетике с помощью ИИ. Об этом сообщил Bloomberg. Президент подписал указ о запуске «Миссии Генезис» 24 ноября 2025 года, поставив задачу удвоить производительность и повысить влияние американских исследований в течение десяти лет, предоставляя учёным и инженерам инструменты для разработки, обучения и эксплуатации ИИ-систем следующего поколения с большей скоростью, эффективностью и надёжностью. В мероприятии в четверг приняли участие министр энергетики Крис Райт (Chris Wright), заместитель министра энергетики по науке и директор миссии Genesis д-р Дарио Гил (Darío Gil) и директор Управления научно-технической политики Белого дома (OSTP) Майкл Крациос (Michael Kratsios). В число 24 организаций, подписавших меморандумы о взаимопонимании, входят такие крупные технологические компании, как Microsoft, Google, AWS, IBM, NVIDIA, Intel, AMD и OpenAI. Также к инициативе присоединились Anthropic, Accenture, Armada, Cerebras, CoreWeave, Dell, DrivenData, Groq, HPE, Oracle, Periodic Labs, Palantir, Project Prometheus, Radical AI, xAI и XPRIZE.

Источник изображения: CoreWeave «Сегодняшнее объявление о 24 новых исследовательских партнёрствах — это только начало, поскольку мы выполняем указ президента Трампа по вовлечению всего научного сообщества, включая компании, университеты, некоммерческие организации и федеральные агентства, в “Миссию Генезис”», — сказал Крациос. Он добавил, что «Миссия Генезис» поможет американским учёным и исследователям автоматизировать разработку экспериментов, ускорить моделирование и создать прогностические модели, которые приведут к прорывам в энергетике, производстве, разработке лекарств и многом другом. Компания NVIDIA объявила на своём сайте о присоединении к инициативе и планах увеличить инвестиции в ИИ-инфраструктуру и научные исследования и разработки. Также компания сообщила, что в рамках партнёрства с DoE уже «добивается прорывных результатов в ключевых областях». В частности, упомянуты:

Другие компании, присоединившиеся к «Миссии Генезис», тоже выступили с заявлениями. Например, Google сообщила, что DeepMind предоставит учёным всех 17 национальных лабораторий DoE программу ускоренного доступа к передовым моделям ИИ для науки и агентным инструментам, начиная с AI co-scientist в Google Cloud. AI co-scientist — это многоагентный виртуальный научный сотрудник, построенный на платформе Gemini. Он разработан для того, чтобы помочь учёным синтезировать огромные объёмы информации для ускорения разработки научных и биомедицинских открытий. В начале 2026 года компания планирует расширить программу ускоренного доступа для национальных лабораторий, включив в нее AlphaEvolve — программный агент на базе Gemini для разработки сложных алгоритмов, AlphaGenome — ИИ-модель, помогающую учёным лучше понимать ДНК, ускоряя исследования в области геномной биологии и улучшая понимание заболеваний, и WeatherNext — современное семейство моделей прогнозирования погоды. Министерство энергетики и все национальные лаборатории также получат доступ к Gemini for Government. В свою очередь, AWS отметила, что прошлом месяце объявила об инвестициях в размере до $50 млрд в инфраструктуру ИИ и суперкомпьютеров, специально созданную для государственных учреждений США. Инвестиции добавят почти 1,3 ГВт мощности в её регионах Top Secret, Secret и GovCloud. По словам компании, этого достаточно для одновременного запуска тысяч моделей и симуляций ИИ, а также обработки научных данных за десятилетия в режиме реального времени. «Эта инфраструктура обеспечит доступ к вычислительным мощностям по запросу, что позволит государственным заказчикам запускать сложные ИИ-задачи и обрабатывать огромные массивы данных для критически важных приложений — от разработки автономных систем и энергетических инноваций до обработки геномных данных, — подчеркнула Amazon. Компания сообщила, что через Amazon Bedrock организации смогут получить доступ к базовым моделям, таким как Amazon Nova — новейшее семейство современных, экономически эффективных моделей, предлагающих многомодальное понимание, разработку пользовательских моделей и возможности агентного управления, — наряду с моделями от ведущих компаний, таких как Anthropic. Это обеспечит исследователям гибкость в выборе подходящей модели для каждой научной задачи, от анализа сложных геномных данных до создания синтетических обучающих наборов данных для автономных систем. |

|