Материалы по тегу: погружное охлаждение

|

11.02.2026 [15:00], Руслан Авдеев

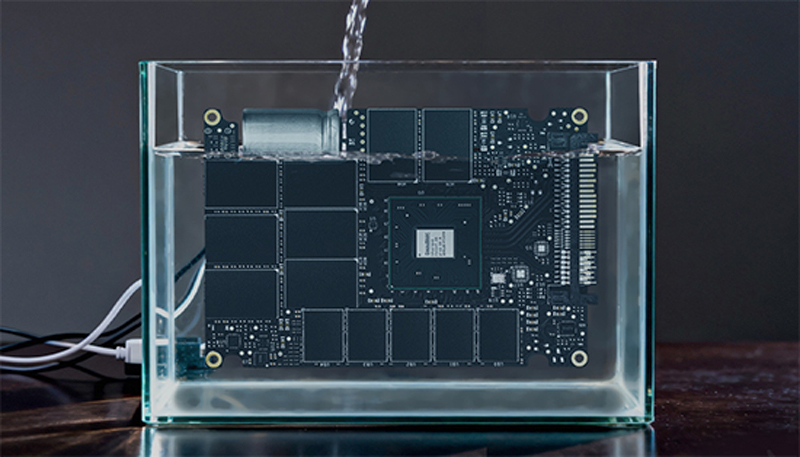

Trane Technologies приобрела поставщика СЖО для ЦОД LiquidStackИндустрия ИИ находится на пике популярности, стимулируя слияния и поглощения в сегменте продуктов для систем охлаждения ЦОД. Так, компания Trane Technologies, занимающаяся разработкой кондиционеров и смежных решений, приобрела стартап LiquidStack, специализирующийся на СЖО, сообщает The Register. Trane инвестировала в LiquidStack в 2023 году. Также в компанию инвестировали Tiger Global Management ($20 млн) и Wiwynn ($10 млн). LiquidStack была одной из первых компаний, разрабатывавших двухфазное иммерсионное охлаждение для систем майнинга криптовалюты. Фактически компания появилась в 2012 году в результате реорганизации Allied Control Limited (ACL, подразделение The Bitfury Group), которая изначально занималась созданием СЖО для майнинговых систем. Технологию LiquidStack протестировала в 2021 году Microsoft. С тех пор компания пополнила портфолио системами одно- и двухфазного погружного охлаждения, а также решениями прямого охлаждения чипов (DLC), в т.ч. CDU. Сообщается, что после закрытия сделки LiquidStack будет работать в составе подразделения Commercial HVAC. Технологии купленной компании пополнят портфолио продуктов Trane, предназначенных для дата-центров. По данным LiquidStack, покупка включает команду стартапа и производственные мощности, а также инженерные и научно-исследовательские подразделения в Техасе и Гонконге.

Источник изображения: LiquidStack По прогнозам экспертов Dell'Oro Group, к 2030 году рынок физической инфраструктуры ЦОД превысит $80 млрд. Одним из самых быстрорастущих сегментов в нём являются системы управления тепловыми режимами, среднегодовой темп прироста составит 20 %. Эксперты уверены, что к концу десятилетия рынок DLC СЖО достигнет оборота $8 млрд, во многом благодаря ИИ-технологиям. Жидкостное охлаждение сегодня перестало быть желательным дополнительным элементом и стало обязательным для получения максимальной отдачи от современного оборудования ИИ ЦОД. Покупка LiquidStack — не первая попытка Trane выйти на рынок технологий жидкостного охлаждения. Ещё в декабре 2025 года была куплена Stellar Energy, выпускавшая модульные охлаждающие решения и CDU, в том числе для ЦОД. Впрочем, это лишь последние из многих слияний и поглощений на рынке физической инфраструктуры для дата-центров, инициированных бумом ИИ-технологий. В конце 2024 года Schneider Electric купила контрольный пакет акицй Motivair. В декабре 2023 года Vertiv приобрела CoolTera. Почти сразу же после этого она запустила производство на полную мощность, увеличив выпуск CDU в 45 (!) раз.

24.01.2026 [14:15], Сергей Карасёв

Nokia и Hypertec построили в Канаде 15-Пфлопс суперкомпьютер Nibi с погружным охлаждением

amd

emerald rapids

granite rapids

h100

hardware

hpc

intel

mi300

nokia

nvidia

ии

канада

отопление

погружное охлаждение

суперкомпьютер

Компании Nokia и Hypertec объявили о запуске суперкомпьютера Nibi, смонтированного в Университете Ватерлоо (University of Waterloo) в Канаде. Эта НРС-платформа будет использоваться для решения широкого спектра задач, в том числе в области ИИ. Проект Nibi финансируется канадским Министерством инноваций, науки и экономического развития через Канадский альянс цифровых исследований, а также Министерством колледжей, университетов, научных исследований и безопасности через некоммерческую организацию Compute Ontario. Система насчитывает в общей сложности более 750 вычислительных узлов. Это, в частности, 700 узлов CPU, каждый из которых несёт на борту два процессора Intel Xeon 6972P поколения Granite Rapids-AP (96C/192T, до 3,9 ГГц) и 748 Гбайт оперативной памяти. Кроме того, задействованы 10 узлов с двумя чипами Xeon 6972P и 6 Тбайт памяти каждый. В состав суперкомпьютера также входят 36 узлов GPU, которые содержат по два процессора Intel Xeon Platinum 8570 серии Emerald Rapids (56C/112T, до 4 ГГц), 2 Тбайт оперативной памяти и восемь ускорителей NVIDIA H100 SXM (80 GB), связанных посредством NVLink. Наконец, Nibi оперирует шестью узлами с четырьмя ускорителями AMD Instinct MI300A. Подсистема хранения VAST Data выполнена на основе SSD суммарной вместимостью 25 Пбайт. Пропускная способность каналов передачи данных между CPU- и GPU-узлами составляет 200 Гбит/с. Подключение к хранилищу обеспечивается благодаря 24 линиям на 100 Гбит/с. Заявленная пиковая производительность Nibi достигает 15 Пфлопс. Новая НРС-платформа оборудована высокоэффективной системой погружного жидкостного охлаждения. Сгенерированное тепло используется для обогрева центра квантовых и нанотехнологий имени Майка и Офелии Лазаридис (Mike and Ophelia Lazaridis Quantum-Nano Centre).

31.12.2025 [12:02], Сергей Карасёв

DapuStor и ZTE внедряют в дата-центрах SSD с иммерсионным охлаждениемКомпания DapuStor объявила об успешном внедрении в серверной инфраструктуре ZTE систем хранения данных на основе SSD с иммерсионным (погружным) жидкостным охлаждением. Применённые накопители семейства DapuStor J5, как утверждается, продемонстрировали исключительную стабильность и надёжность при непрерывных нагрузках чтения/записи. Отмечается, что на фоне стремительного развития ИИ быстро растёт нагрузка на ЦОД — это приводит к увеличению энергопотребления. В результате, возможностей традиционного воздушного охлаждения становится недостаточно, в связи с чем гиперскейлеры и облачные провайдеры внедряют передовые жидкостные решения, в том числе иммерсионные системы. Однако существуют риски: хотя погружное охлаждение обеспечивает эффективный отвод тепла, оно предъявляет дополнительные требования к оборудованию. Длительное нахождение в диэлектрической жидкости может провоцировать химическую эрозию и ускорение старения из-за проникновения состава в микроскопические структурные зазоры электронных компонентов. В случае SSD это чревато системными сбоями. Поэтому для достижения долгосрочной надёжности необходима комплексная адаптация устройств хранения с точки зрения базовых материалов, конструкции и производственных процессов.

Источник изображения: DapuStor Накопители DapuStor J5, оптимизированные для иммерсионного охлаждения, разработаны специально с прицелом на эксплуатацию в экстремальных условиях. Все используемые материалы прошли тщательную проверку, исключающую ухудшение характеристик после длительного контакта с охлаждающей жидкостью. Гарантированы целостность сигнала и долговременная стабильность, говорят компании. Заявленная скорость последовательного чтения и записи данных достигает соответственно 7,4 и 7,0 Гбайт/с. Показатель IOPS при произвольном чтении составляет до 1,75 млн, при произвольной записи — до 340 тыс. Задержка — 67/9 мкс. Отмечается, что при использовании иммерсионного охлаждения средний годовой показатель PUE составляет менее 1,15 против 1,4–1,6 при традиционном воздушном охлаждении, что соответствует снижению на 15–28 %. Плотность мощности в расчёте на стойку возрастает на порядок — с 3–5 кВт до 48 кВт.

23.12.2025 [12:28], Сергей Карасёв

Goodram представила 122,88-Тбайт SSD для ЦОД с иммерсионным охлаждениемКомпания Goodram Industrial, принадлежащая Wilk Elektronik SA, без громких анонсов представила свой первый SSD вместимостью 122,88 Тбайт, предназначенный для использования в системах с иммерсионным (погружным) жидкостным охлаждением. Устройство рассчитано на дата-центры и площадки гиперскейлеров. Накопитель относится к семейству DC25F. В его основу положены чипы флеш-памяти QLC NAND. Доступны модификации в форм-факторах E3.S и E3.L: в обоих случаях для подключения служит интерфейс PCIe 5.0 x4. Заявленная скорость последовательного чтения информации достигает 14 600 Мбайт/с, скорость последовательной записи — 3200 Мбайт/с. Показатель IOPS составляет до 3 млн при произвольном чтении данных 4K-блоками и до 35 тыс. при произвольной записи. Накопители способны выдерживать 0,3 полных перезаписи в сутки (0,3 DWPD) на протяжении пяти лет. Это ставит их в один ряд с другими QLC-устройствами корпоративного класса, предназначенными для «теплого» и «холодного» хранения данных.

Источник изображения: Goodram Goodram отмечает, что накопители прошли всестороннее тестирование с использованием различных диэлектрических жидкостей для иммерсионного охлаждения, включая составы Shell и Chevron. Утверждается, что эти SSD рассчитаны на длительную эксплуатацию без деградации. Помимо модели вместимостью 122,88 Тбайт, Goodram предлагает широкий выбор других SSD для систем с иммерсионным охлаждением. Это устройства ёмкостью от 1,92 Тбайт и выше на основе чипов TLC NAND и QLC NAND с интерфейсами SATA, PCIe 4.0 и PCIe 5.0. Они доступны в форм-факторах SFF U.2 и U.3, E3.S и E1.S, M.2 2280 и M.2 22110.

17.11.2025 [10:14], Руслан Авдеев

Vertiv представила иммерсионные СЖО CoolCenter Immersion на 25–240 кВтVertiv объявила о выпуске системы погружного охлаждения CoolCenter Immersion. Иммерсионная СЖО обеспечивает поддерживает отвод от 25 кВт до 240 кВт на модуль ёмкостью 24U до 52U, обеспечивая при этом PUE на уровне 1,08. По словам компания, иммерсионное охлаждение играет всё более важную роль из-за повсеместного внедрения HPC- и ИИ-платформ. В Vertiv CoolCenter Immersion применяется многолетний опыт, полученный Vertiv в сфере СЖО для создания спроектированных «под ключ» систем, безопасно и эффективно справляющихся с высокоплотными системами. Операторы ЦОД смогут практично масштабировать ИИ-инфраструктуру без ущерба надёжности и удобству обслуживания. Каждая система включает внутренний или внешний резервуар для теплоносителя, блок распределения жидкости (CDU), датчики температуры, а также насосы с регулируемой скоростью работы и трубки. Модуль включает два источника питания и резервные насосы, а также встроенные датчики мониторинга состояния и 9″ сенсорный дисплей. Предусмотрена возможность подключения к системе управления зданием (BMS). Тепло отводится через пластинчатый теплообменник во внешний водяной контур. Vertiv уже заключила контракт с Digital Realty в Италии на поставку электроэнергии и систем охлаждения для римского объекта Digital ROM1 мощностью 3 МВт. Запуск ЦОД запланирован на 2027 год. На объекте будет использоваться фрикулинг и система охлаждения, готовая к ИИ-нагрузкам, передаёт DataCenter Dynamics. Сделка стала ещё одной в череде европейских проектов Digital Realty в Париже, Мадриде, Амстердаме и др.

Источник изображения: Vertiv В Digital Realty подчеркнули, что Рим становится важнейшим шлюзом для цифровой инфраструктуры между Европой и Средиземноморским регионом. Передовые технологии для ROM1 помогут стать дата-центру стратегическим ИИ-хабом, задающим новые стандарты энергоэффективности и производительности в сфере HPC. Также Vertiv работает с Nextra в Африке и намерена сотрудничать с Ezditek для создания ЦОД в Саудовской Аравии. Ранее сообщалось, что нежелание NVIDIA сертифицировать иммерсионные СЖО во многом тормозит их развитие. Прямое жидкостное охлаждение (DLC) менее эффективно, чем иммерсионные системы, но NVIDIA всё ещё считает, что пока достаточно этого. Впрочем, эксперты прогнозируют, что настоящий расцвет технологии придётся на 2027–2028 гг. Ожидается, что она будут активно распространяться после выхода ускорителей NVIDIA Rubin Ultra.

07.11.2025 [12:17], Сергей Карасёв

Sugon ScaleX640 — первая в мире стоечная система с 640 ИИ-ускорителямиКитайская компания Sugon (Dawning Information Industry), специализирующаяся на разработке суперкомпьютеров, серверов и СХД, представила ИИ-систему ScaleX640. Это, как утверждается, первое в мире решение в виде одной стойки, допускающее использование до 640 ускорителей. Суперускоритель выполнен на «сверхскоростной ортогональной архитектуре». Используются вычислительные узлы высокой плотности, которые допускают установку ИИ-карт различных производителей. Говорится о совместимости с существующей экосистемой ПО для задач ИИ. Платформа ScaleX640 предусматривает применение иммерсионного жидкостного охлаждения с фазовым переходом и высоковольтных источников питания постоянного тока (DC). СЖО способна отвести до 1,72 МВт. По заявлениям Sugon, по плотности вычислений новинка до 20 раз превосходит другие суперузлы, доступные на рынке. При этом обеспечивается высокий показатель эффективности использования электроэнергии (PUE) — 1,04. Два суперузла ScaleX640 могут формировать вычислительный блок с поддержкой 1280 ускорителей ИИ. Стойки соединяются между собой посредством высокоскоростной сети. В целом, возможно развёртывание кластеров, насчитывающих до 100 тыс. ИИ-карт. Sugon утверждает, что по сравнению с традиционными платформами новая система обеспечивает повышение производительности на 30–40 % в сценариях обучения больших языковых моделей (LLM) с триллионами параметров и инференса. Проведённое всестороннее тестирование ScaleX640 говорит о высокой надёжности и стабильности работы комплекса.

03.10.2025 [17:24], Руслан Авдеев

UKPN начнёт отапливать дома британских малоимущих кластерами из сотен Raspberry Pi

hardware

raspberry pi

великобритания

кластер

микро-цод

облако

отопление

периферийные вычисления

погружное охлаждение

сжо

экология

Британская UK Power Networks (UKPN) в рамках программы SHIELD (Smart Heat and Intelligent Energy in Low-income Districts) начала устанавливать микро-ЦОД на базе одноплатных компьютеров Raspberry Pi — для отопления домохозяйств, нуждающихся в деньгах для оплаты коммунальных услуг, сообщает The Register. Выбранные домохозяйства оснастят солнечными элементами питания и аккумуляторными системами, треть из них получит и систему HeatHub — сверхкомпактный ЦОД размером с большой тепловой насос, который заменит традиционные газовые котлы. Полученные в рамках пробного развёртывания данные используют для масштабирования SHIELD, к 2030 году UKPN намерена ежегодно развёртывать 100 тыс. систем. Платформа HeatHub разработана компанией Thermify. Она предназначена для запуска облачных контейнеризированных нагрузок. Каждый HeatHub включает до 500 модулей Raspberry Pi CM4 или CM5, погружённых в масло. Полученное тепло передаётся в системы отопления и горячего водоснабжения, а сам HeatHub легко установить вместо бойлера. HeatHub имеет собственное выделенное интернет-подключение. Над внедрением «низкоуглеродных» технологий SHIELD компания UKPN сотрудничает с Power Circle Projects, жилищной ассоциацией Eastlight Community Homes и Essex Community Energy. Также она участвует над установлением нового социального тарифа на отопление на востоке и юго-востоке Англии. Малоимущие клиенты будут платить фиксированную ставку в £5,60 ($7,52) ежемесячно, а SHIELD поможет им сократить счета за электричество на 20–40 %. Куратор SHIELD со стороны Eastlight Community Homes заявил, что результаты пилотного проекта обнадёживают, его планируют опробовать ещё в сотнях домов. Это поможет семьям поддерживать комфортные условия проживания, не беспокоясь о росте цен на энергию. Для обычных пользователей у Thermify иные условия — модуль для типового дома с тремя спальнями обойдётся в £2500 ($3365), ещё £500 ($673) возьмут за установку, а за отопление будут брать £50/мес. ($67/мес.). В особых случаях плата может быть снижена вдвое, а в экстремальных ситуациях тепло будет предоставляться бесплатно. Это уже не первый проект подобного рода. Так, Heata — изначально принадлежавшая British Gas, предлагает использовать серверы в качестве домашних водонагревателей, что позволяет сократить расходы на электричество для домовладельцев. Тепло вырабатывается за счёт рабочих нагрузок облачного оператора Civo. Также пару лет назад начала работать британская Deep Green — она обеспечивает теплом предприятия и бассейны с помощью мини-ЦОД, размещаемых на их территории.

21.08.2025 [19:51], Руслан Авдеев

NVIDIA тормозит развитие погружных СЖО, но через пару лет ситуация может изменитьсяЭксперименты с иммерсионным охлаждением для мейнфреймов и суперкомпьютеров начали проводиться ещё в 1970-х годах прошлого века, но массовой технология так и не стала из-за высокой стоимости и сложности обслуживания. Примечательно, что сегодня, когда чипы становятся всё более горячими, главным препятствием на пути коммерческого внедрения иммерсионных технологий стала NVIDIA, передаёт ZDNet Korea со ссылкой на источники в индустрии. Возрождение интереса к технологии началось в конце 2000-х гг., когда всерьёз встала проблема повышения энергоэффективности дата-центров. С середины 2010-х крупные облачные компании вроде Microsoft, Google и Alibaba начали эксперименты с двухфазным иммерсионным охлаждением, однако рынок таких систем до сих пор находится в зачаточном состоянии. NVIDIA же «виновата» тем, что не сертифицирует подобные системы. Как заявил один из отраслевых инсайдеров, компания не даёт никаких гарантий при использовании иммерсионных систем со своими ускорителями, поскольку неизвестно, какие проблемы могут возникнуть в долгосрочной перспективе. Прямое жидкостное охлаждение (DLC) менее эффективно, чем иммерсионные системы, но NVIDIA всё ещё считает, что пока достаточно и этого.

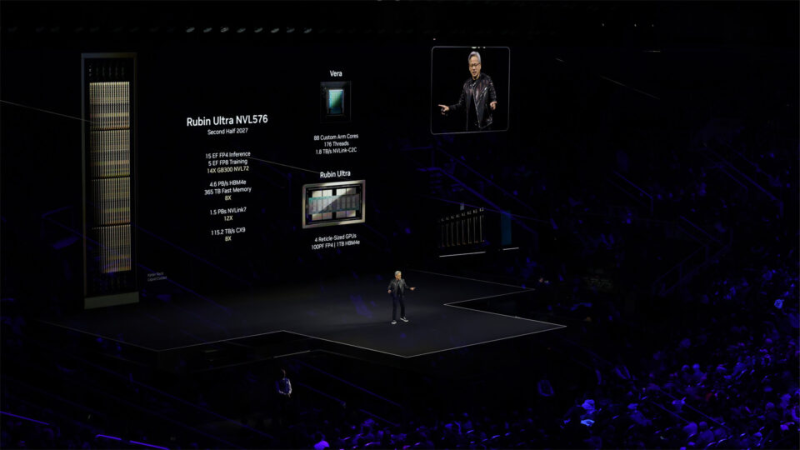

Источник изображения: NVIDIA Влияние на отсутствие повсеместного внедрения иммерсионного охлаждения, вероятно, оказали и экономические причины. Погружные СЖО требуют специальной инфраструктуры, поэтому внедрить их в уже действующие ЦОД с традиционным воздушным охлаждением трудно. При этом системы прямого жидкостного охлаждения (DLC) успешно сочетаются с воздушными системами на базе уже имеющейся инфраструктуры. Эксперты прогнозируют, что настоящий расцвет рынка иммерсионного охлаждения придётся на 2027–2028 гг. Ожидается, что оно будет активно распространяться после выхода ускорителей NVIDIA Rubin Ultra. Так, стойка Rubin Ultra NVL576 будет потреблять 600 кВт, а Google, OCP и Schneider Electric уже проектируют стойки мегаваттного класса. Следующее поколение чипов будет обладать настолько интенсивным тепловыделением, что охладить с помощью привычных СЖО уже не получится, говорит один из инсайдеров. По слухам, NVIDIA активно нанимает специалистов, связанных с иммерсионным охлаждением. Источники свидетельствуют, что в будущем у операторов ЦОД якобы просто не останется выбора. Однако Intel, ZutaCore, CoolIT, Accelsius и др. уже представили водоблоки для чипов с TDP от 1 кВт до 4,5 кВт, так что DLС ещё долго будут сохранять актуальность.

21.05.2025 [12:57], Руслан Авдеев

ИИ-платформа Microsoft Discovery создала жидкость для СЖО за 200 часов вместо нескольких месяцев

hpc

microsoft

microsoft azure

software

ии

ии-агент

квантовые вычисления

погружное охлаждение

разработка

сжо

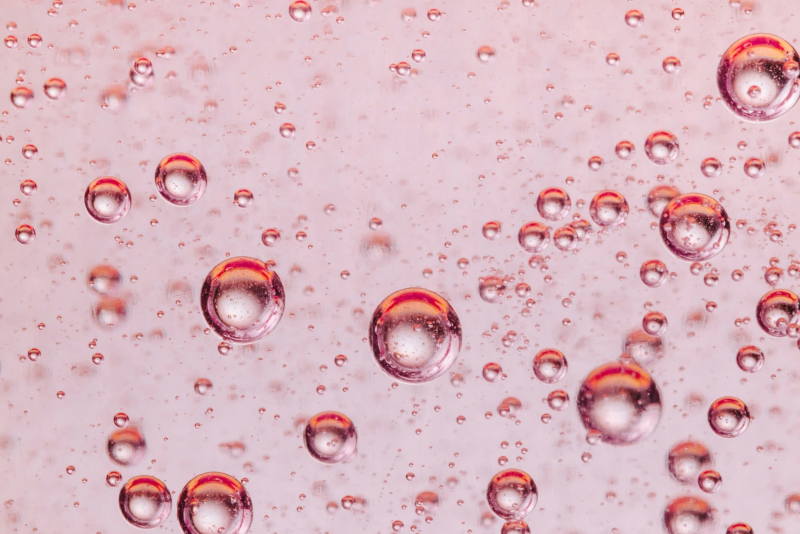

химия

Компания Microsoft запустила для корпоративных пользователей в тестовом режиме ИИ-платформу Microsoft Discovery, использующую ИИ-агентов и HPC для помощи учёным, которым не придётся самостоятельно писать код для своих исследований. Потенциал системы продемонстрировали на примере самой Microsoft — ИИ помог создать новейшую жидкость для погружного охлаждения всего за 200 часов вместо нескольких месяцев или даже лет, сообщает VentureBeat. Microsoft Discovery использовали для поиска охлаждающей жидкости без «вечных» PFAS-химикатов, часто применяемых в иммерсионных СЖО. Регуляторы во всём мире всё чаще запрещают производство и использование этого класса вещества. ИИ Microsoft проверил 367 тыс. веществ-кандидатов, после чего химикат синтезировал один из партнёров компании. Однако сфера применения такого ИИ простирается далеко за пределы создания охлаждающих жидкостей — новые материалы и химикаты требуются в самых разных сферах, но на их поиск часто уходят годы. Microsoft Discovery позволяет взаимодействовать с «невероятными возможностями» ИИ, используя естественный язык, что полностью меняет весь процесс исследований, говорит компания. Обычно учёным приходилось изучать программирование для того, чтобы создавать вычислительные инструменты. Такая демократизация науки сыграет на руку малым исследовательским группам, у которых нет ресурсов на изучение программирования или привлечения сторонних специалистов в этой сфере. Более того, со временем платформа научится работать и с квантовыми компьютерами, написание кода для которых — ещё более сложная задача.

Источник изображения: National Cancer Institute/unsplash.com Работа выполняется с помощью специальных ИИ-агентов, специально обученных для выполнения отдельных научных задач — от написания литературного обзора до создания компьютерной симуляции. По словам Microsoft, ИИ-агенты — это чуть ли не целая команда учёных с докторскими степенями в различных науках. Платформа интегрирует друг с другом базовые модели, занимающиеся общим планированием, и модели, специализирующиеся на физике, химии или, например, биологии. Также Microsoft Discovery позволяет комбинировать закрытые исследовательские данные и результаты уже опубликованных научных исследований по разным дисциплинам, сохраняя прозрачность моделей и контролируя процесс «рассуждений». Для работы с платформой используется интерфейс Copilot, который занимается оркестрацией агентов. Одновременно интерфейс служит и центральным хабом, в котором учёные управляют своей виртуальной ИИ-командой.

Источник изображения: National Cancer Institute/unsplash.com В платформу встроены защитные механизмы — системе заданы «этические координаты». Также применяется модерация контента с проактивным подходом к выявлению злоупотреблений возможностями платформы — маркируются потенциально вредоносные алгоритмы и действия, поскольку все ИИ-инструменты фактически имеют «двойное назначение». С их помощью можно изобретать не только лекарства, но и опасные биологически опасные субстанции. Для своей платформы Microsoft выстраивает экосистему с участием представителей самых разных отраслей, от фармацевтики (GSK) до индустрии красоты (Estée Lauder). NVIDIA интегрирует с Discover микросервисы ALCHEMI и BioNeMo NIM для биотехнологий и фармацевтики. В полупроводниковой сфере Microsoft планирует интеграцию решений Synopsys для ускорения разработки чипов. Адаптацией под конкретные отраслевые задачи, развёртыванием и масштабированием платформы займутся Accenture и Capgemini.

Источник изображения: Microsoft Успех Microsoft Discovery будет зависеть от того, насколько эффективно систему смогут интегрировать в текущие научные процессы — многие учёные скептически относятся к новым методикам, так что компании придётся показать всё, на что способен ИИ. По словам Microsoft, будущее науки именно за сочетанием умственных возможностей человека и масштабного ИИ. Microsoft уже провела предварительную демонстрацию Discovery для ограниченного круга структур. Цены на платформу пока не названы, но доступ к к ней будет организован посредством Azure.

15.05.2025 [09:36], Руслан Авдеев

СЖО с гарантией: Intel и Shell предложили сертифицированные системы погружного охлаждения для платформ на базе XeonПоскольку внедрение ИИ и HPC увеличивает потребность операторов ЦОД в мощной инфраструктуре, необходимы и более экоустойчивые, эффективные и масштабируемые решения для охлаждения оборудования. Компания Intel совместно с Shell Global Solutions предложили сертифицированное комплексное решение для иммерсионного охлаждения серверов с процессорами Intel Xeon Emerald Rapids или Sapphire Rapids, сообщает пресс-служба Intel. По информации Dell’Oro Group, системы жидкостного охлаждения становятся всё популярнее и к 2028 году на них будет приходиться 36 % выручки от общих продаж систем терморегуляции дата-центров. Однако внедрение высокоэффективного погружного охлаждения до недавнего времени тормозилось из-за отсутствия сертифицированных, прошедших проверки и готовых к развёртыванию продуктов. Intel и Shel провели валидацию полной системы иммерсионного охлаждения для ЦОД на основе оборудования Supermicro и Submer. Решение Intel Data Center Certified for Immersion Cooling называется первым в своём роде и задаёт новый отраслевой стандарт по эффективности и надёжности в долгосрочной перспективе. Масштабное тестирование и строгая валидация в лабораториях Intel позволяет операторам ЦОД внедрять проверенную инфраструктуру, будучи уверенными в её готовности к современным рабочим нагрузкам ИИ и HPC, говорится в пресс-релизе.

Источник изображения: Intel В рамках процесса сертификации Intel предлагает дополнительную гарантию на использование процессоров Xeon с однофазным иммерсионным охлаждением Xeon Processor Single-Phase Immersion Warranty Rider, подтверждающей надёжность и эффективность инфраструктуры, а также её совместимость с охлаждающими жидкостями Shell. Дополнительно исследуется возможность будущего сотрудничества для сертификации новейших поколений процессоров компании с жидкостями Shell.

Источник изображения: Intel Как заявил представитель Intel, по мере роста потребностей ЦОД, сертифицированные Intel решения для погружного охлаждения станут играть ключевую роль в обеспечении работы энергоэффективной и масштабируемой вычислительной инфраструктуры — ЦОД получили доступ к проверенным, готовым к внедрению технологиям охлаждения. Другими словами, операторы ЦОД смогут получить доступ к решениям с повышенной производительностью, минуя этап пилотного проекта — можно сразу переходить к внедрению предварительно проверенных вариантов с высокой энергоэффективностью и малым воздействием на окружающую среду. При этом такие решения обеспечены первыми в отрасли сертификатами и гарантиями Intel. |

|