Материалы по тегу: к

|

20.06.2025 [13:46], Руслан Авдеев

«Мегафон» заканчивает строительство 5-МВт ЦОД в НовосибирскеБлизится к финалу строительство дата-центра телеком-оператора «Мегафон» в Новосибирске. Мощность объекта составит 5 МВт с возможностью дальнейшего масштабирования до 20 МВт. ЦОД включает пять машинных залов, запускать которые оператор намерен поэтапно, сообщает «Коммерсантъ». По словам главы «Мегафона», первый зал рассчитан на 50 стойко-мест. Ранее сообщалось, что в создание дата-центра «Мегафон» рассчитывал вложить 2,1 млрд руб. «Мы завершаем строительство центра обработки данных на площадке промышленно-логистического парка, который станет крупнейшим в восточной части России», — приводит «Коммерсантъ» слова главы компании. По словам министра цифрового развития и связи новосибирской области, проект по строительству дата-центра «Мегафона» в Новосибирске сейчас находится «в активной стадии». Стройка достигла этапа завершения — уже начался монтаж инженерного оборудования.

Источник изображения: Vyacheslav Makushin/unspalsh.com Дополнительно «Мегафон» объявил о соглашении с областным правительством, в рамках которого компания вложит не менее 3 млрд руб. цифровое развитие Новосибирской области. Как сообщает оператор, в ближайшие пять лет сотрудничество будет направлено на развитие телеком-инфраструктуры на территории региона, включая отдалённые и малочисленные населённые пункты. В прошлом году в Новосибирске завершили строительство первой очереди крупнейшего в Сибири коммерческого ЦОД ГК Key Point, анонсированного, как и строительство ЦОД для «Мегафона», в 2023 году. Тогда же было запланировано строительство дата-центра компании «Альфа-финанс». Суммарная стоимость всех трёх проектов оценивалась в 6,4 млрд руб. Всего к 2028 году эксперты прогнозируют утроение мощности коммерческих ЦОД в России. При этом нехватка электроэнергии в привычных для размещения ЦОД локациях приведёт к изменению географии их распределения. Сейчас большая часть из них находится в Московском регионе и центральной России в целом.

19.06.2025 [16:13], Руслан Авдеев

Здесь ЦОД с ИИ, здесь Grok'ом пахнет: экоактивисты подали в суд на xAI за использование газовых турбин для суперкомпьютера ColossusОснованная Илоном Маском (Elon Musk) компания xAI столкнулась с судебным иском. Её обвиняют в нарушении «Закона о чистом воздухе» (US Clean Air Act) в Мемфисе. Именно там расположен ЦОД с ИИ-суперкомпьютером Colossus, для питания которого используются турбины на природном газе, сообщает Datacenter Dynamics. Истцами выступили НКО NAACP и SELC. Стартап обвиняют в незаконном использовании на объекте турбин, работающих на природном газе. Согласно иску, xAI не получала разрешений на эксплуатацию 26 турбин, установленных на объекте для обеспечения его электричеством. SELC ранее утверждала, что использование газовых турбин осуществлялось без оповещений местного населения и что оно наносит ему ущерб. В NCAAP заявили, что не могут позволить компаниям с оборотами в миллиарды долларов строить загрязняющие атмосферу производства без разрешений. Представители организации пообещали, что xAI не уйдёт от ответственности. В ответ компания заявляет, что имеют право на эксплуатацию турбин в течение 364 дней без отдельного разрешения, поэтому временные установки функционируют в соответствии с законами. Более того, компания намерена доработать турбины для сокращения выбросов в будущем. В SELC заявили, что для турбин таких временных исключений из правил не предусмотрено. Впрочем, срок в 364 дня уже всё равно истёк, а решение xAI установить и эксплуатировать десятки турбин, загрязняющих окружающую среду — явное нарушение Закона о чистом воздухе. В результате xAI можно привлечь к ответственности за незаконный отказ получать разрешения на газовые турбины.

Источник изображения: Call Me Fred/unsplash.com ЦОД, запущенный в июле 2024 года, имел начальную мощность 150 МВт. Объект подключили к электросети местной коммунальной службы TVA, но поначалу xAI выделили всего 8 МВт, поэтому компания развернула около ЦОД газовые турбины. В конце прошлого года подведённую мощность разрешили довести до 150 МВт. В апреле 2025 года выяснилось, что ЦОД увеличил количество число газовых турбин до 35 — это нарушение выданного разрешения на локальную генерацию, поскольку оно допускало использование только 15 турбин. Дополнительные установки обнаружили на аэрофотоснимках. Общая мощность агрегатов, по оценкам, составляет 422 МВт. После этого была продана жалоба в местный департамент здравоохранения, в которой заявлялось, что ЦОД из-за турбин стал крупнейшим промышленным источником азотных загрязнений NOx, формирующих смог в Мемфисе. С тех пор сообщалось, что xAI начала убирать некоторые турбины с площадки после ввода в эксплуатацию новой подстанции. Также было установлено 168 аккумуляторных хранилищ Tesla Megapack. Компания намерена построить в городе второй ЦОД и уже приобрела для этого участок площадью более 92 тыс. м2. Он расположен рядом с газовой электростанцией Southaven Combined Cycle, вырабатывающей 780 МВт электричества. Однако компании надо гораздо больше мощности и она, по-видимому, готова повторить тот же трюк, развернув десятки турбин суммарной мощностью 1,56 ГВт.

07.06.2025 [16:24], Владимир Мироненко

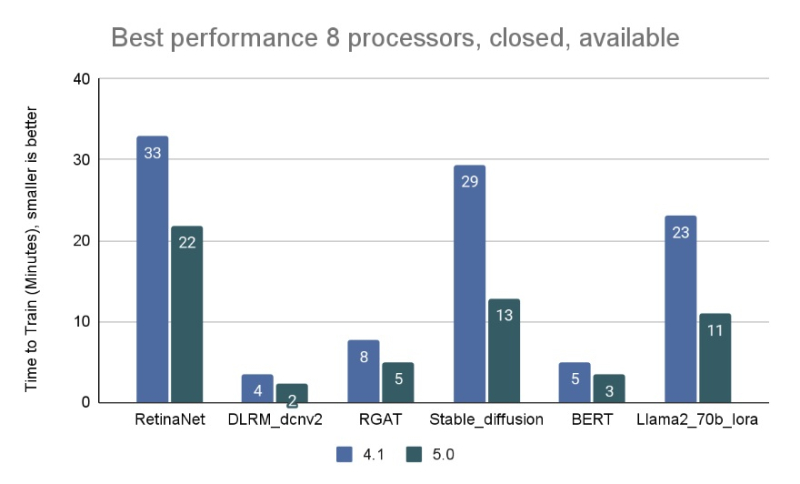

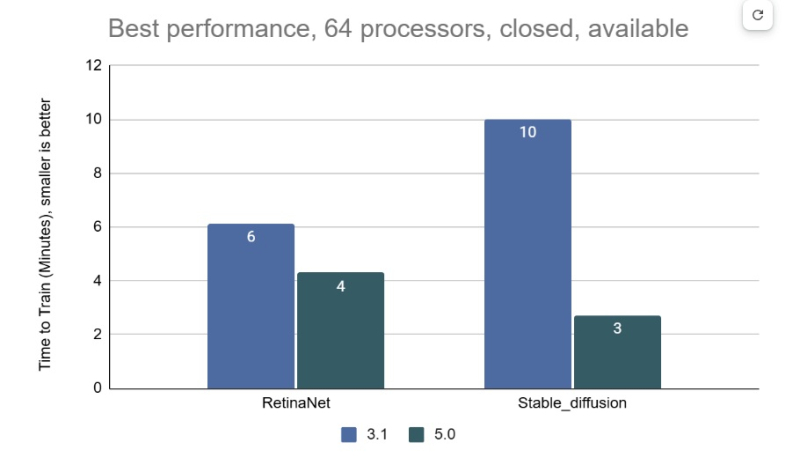

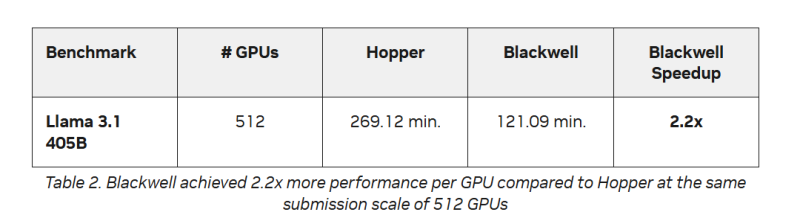

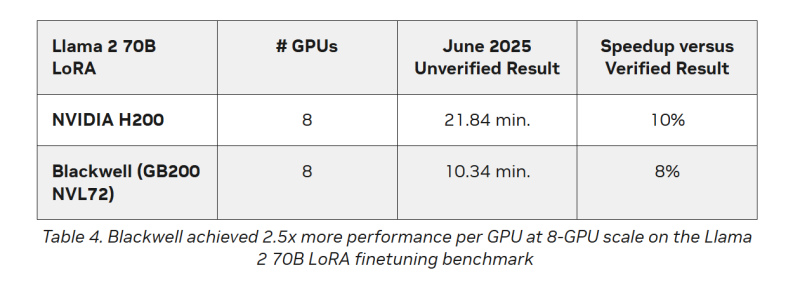

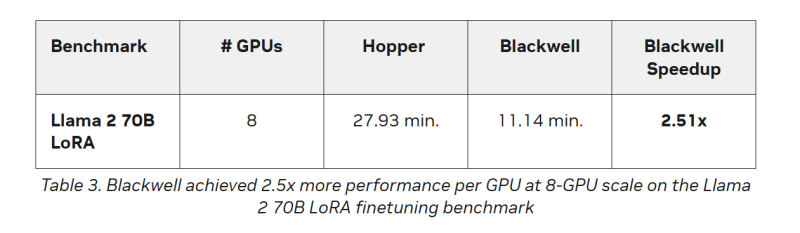

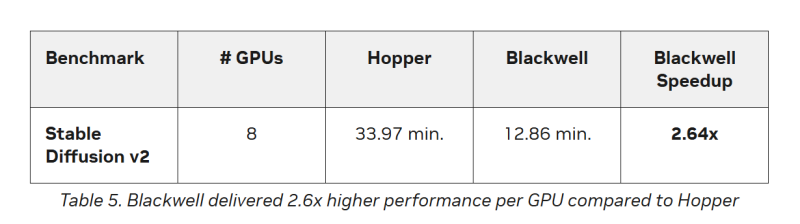

AMD впервые приняла участие в бенчмарке MLPerf Training, но до рекордов NVIDIA ей ещё очень далекоКонсорциум MLCommons объявил новые результаты бенчмарка MLPerf Training v5.0, отметив быстрый рост и эволюцию в области ИИ, а также рекордное количество общих заявок и увеличение заявок для большинства тестов по сравнению с бенчмарком v4.1. MLPerf Training v5.0 предложил новый бенчмарк предварительной подготовки большой языковой модели на основе Llama 3.1 405B, которая является самой большой ИИ-моделью в текущем наборе тестов обучения. Он заменил бенчмарк на основе gpt3 (gpt-3-175B), входивший в предыдущие версии MLPerf Training. Целевая группа MLPerf Training выбрала его, поскольку Llama 3.1 405B является конкурентоспособной моделью, представляющей современные LLM, включая последние обновления алгоритмов и обучение на большем количестве токенов. Llama 3.1 405B более чем в два раза больше gpt3 и использует в четыре раза большее контекстное окно. Несмотря на то, что бенчмарк на основе Llama 3.1 405B был представлен только недавно, на него уже подано больше заявок, чем на предшественника на основе gpt3 в предыдущих раундах, отметил консорциум. MLCommons сообщил, что рабочая группа MLPerf Training регулярно добавляет новые рабочие нагрузки в набор тестов, чтобы гарантировать, что он отражает тенденции отрасли. Результаты бенчмарка Training 5.0 показывают заметный рост производительности для новых бенчмарков, что указывает на то, что отрасль отдаёт приоритет новым рабочим нагрузкам обучения, а не старым. Тест Stable Diffusion показал увеличение скорости в 2,28 раза для восьмичиповых систем по сравнению с версией 4.1, вышедшей шесть месяцев назад, а тест Llama 2.0 70B LoRA увеличил скорость в 2,10 раза по сравнению с версией 4.1; оба превзошли исторические ожидания роста производительности вычислений с течением времени в соответствии с законом Мура. Более старые тесты в наборе показали более скромные улучшения производительности. На многоузловых 64-чиповых системах тест RetinaNet показал ускорение в 1,43 раза по сравнению с предыдущим раундом тестирования v3.1 (самым последним, включающим сопоставимые масштабные системы), в то время как тест Stable Diffusion показал резкое увеличение в 3,68 раза. «Это признак надёжного цикла инноваций в технологиях и совместного проектирования: ИИ использует преимущества новых систем, но системы также развиваются для поддержки высокоприоритетных сценариев», — говорит Шрия Ришаб (Shriya Rishab), сопредседатель рабочей группы MLPerf Training. В заявках на MLPerf Training 5.0 использовалось 12 уникальных чиповых, все в категории коммерчески доступных. Пять из них стали общедоступными с момента выхода последней версии набора тестов MLPerf Training:

Заявки также включали три новых семейства процессоров:

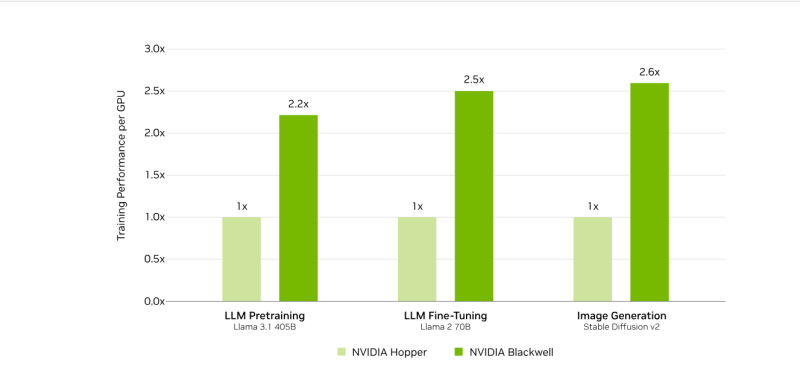

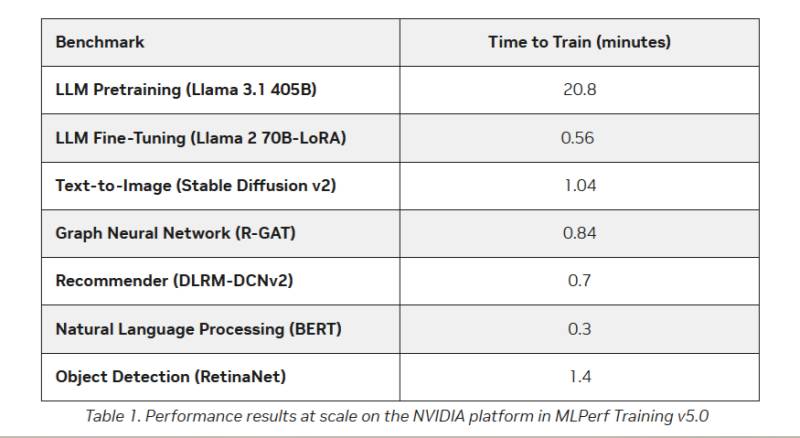

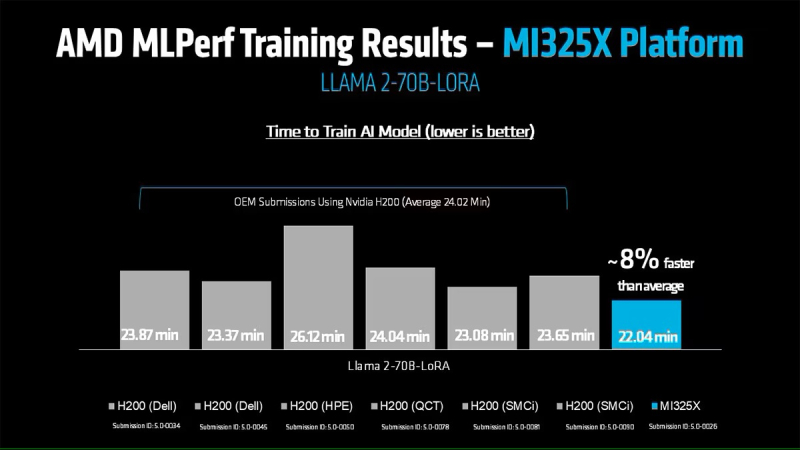

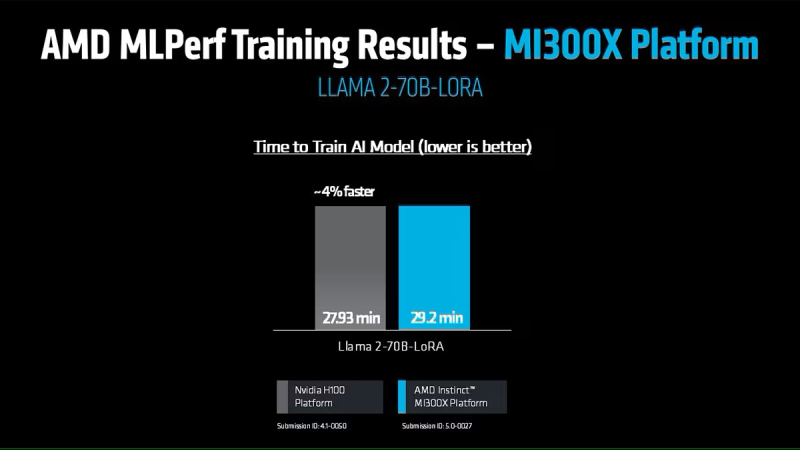

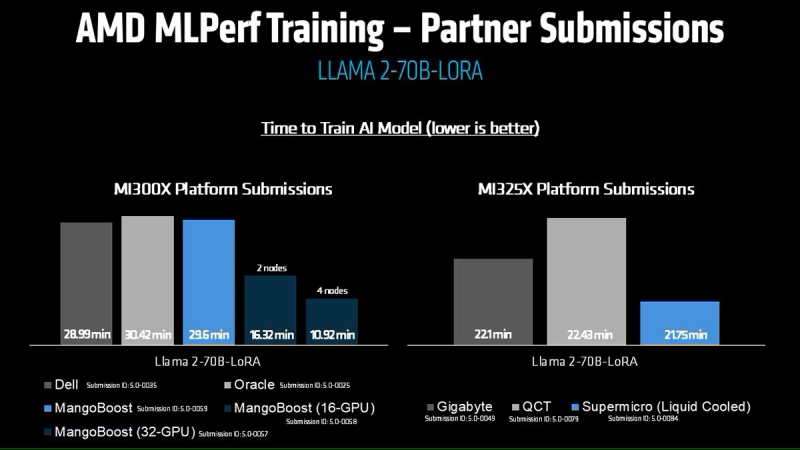

Кроме того, количество представленных многоузловых систем увеличилось более чем в 1,8 раза по сравнению с версией бенчмарка 4.1. Хиуот Касса (Hiwot Kassa), сопредседатель рабочей группы MLPerf Training, отметил растущее число провайдеров облачных услуг, предлагающих доступ к крупномасштабным системам, что делает доступ к обучению LLM более демократичным. Последние результаты MLPerf Training 5.0 от NVIDIA показывают, что её ускорители Blackwell GB200 демонстрируют рекордные результаты по времени обучения, демонстрируя, как стоечная конструкция «ИИ-фабрики» компании может быстрее, чем раньше, превращать «сырые» вычислительные мощности в развёртываемые модели, пишет ресурс HPCwire. Раунд MLPerf Training v5.0 включает 201 результат от 20 организаций-участников: AMD, ASUS, Cisco, CoreWeave, Dell, GigaComputing, Google Cloud, HPE, IBM, Krai, Lambda, Lenovo, MangoBoost, Nebius, NVIDIA, Oracle, QCT, SCITIX, Supermicro и TinyCorp. «Мы бы особенно хотели поприветствовать впервые подавших заявку на участие в MLPerf Training AMD, IBM, MangoBoost, Nebius и SCITIX, — сказал Дэвид Кантер (David Kanter), руководитель MLPerf в MLCommons. — Я также хотел бы выделить первый набор заявок Lenovo на результаты тестов энергопотребления в этом раунде — энергоэффективность в системе обучения ИИ-систем становится всё более важной проблемой, требующей точного измерения». NVIDIA представила результаты кластера на основе систем GB200 NVL72, объединивших 2496 ускорителей. Работая с облачными партнерами CoreWeave и IBM, компания сообщила о 90-% эффективности масштабирования при расширении с 512 до 2496 ускорителей. Это отличный результат, поскольку линейное масштабирование редко достигается при увеличении количества ускорителей за пределами нескольких сотен. Эффективность масштабирования в диапазоне от 70 до 80 % уже считается солидным результатом, особенно при увеличении количества ускорителей в пять раз, пишет HPCwire. В семи рабочих нагрузках в MLPerf Training 5.0 ускорители Blackwell улучшили время сходимости «до 2,6x» при постоянном количестве ускорителей по сравнению с поколением Hopper (H100). Самый большой рост наблюдался при генерации изображений и предварительном обучении LLM, где количество параметров и нагрузка на память самые большие. Хотя в бенчмарке проверялась скорость выполнения операций, NVIDIA подчеркнула, что более быстрое выполнение задач означает меньшее время аренды облачных инстансов и более скромные счета за электроэнергию для локальных развёртываний. Хотя компания не публиковала данные об энергоэффективности в этом бенчмарке, она позиционировала Blackwell как «более экономичное» решение на основе достигнутых показателей, предполагая, что усовершенствования дизайна тензорных ядер обеспечивают лучшую производительность на Ватт, чем у поколения Hopper. Также HPCwire отметил, что NVIDIA была единственным поставщиком, представившим результаты бенчмарка предварительной подготовки LLM на основе Llama 3.1 405B, установив начальную точку отсчёта для обучения с 405 млрд параметров. Это важно, поскольку некоторые компании уже выходят за рамки 70–80 млрд параметров для передовых ИИ-моделей. Демонстрация проверенного рецепта работы с 405 млрд параметров даёт компаниям более чёткое представление о том, что потребуется для создания ИИ-моделей следующего поколения. В ходе пресс-конференции Дэйв Сальватор (Dave Salvator), директор по ускоренным вычислительным продуктам в NVIDIA, ответил на распространенный вопрос: «Зачем фокусироваться на обучении, когда в отрасли в настоящее время все внимание сосредоточено на инференсе?». Он сообщил, что тонкая настройка (после предварительного обучения) остается ключевым условием для реальных LLM, особенно для предприятий, использующих собственные данные. Он обозначил обучение как «фазу инвестиций», которая приносит отдачу позже в развёртываниях с большим объёмом инференса. Этот подход соответствует более общей концепции «ИИ-фабрики» компании, в рамках которой ускорителям даются данные и питание для обучения моделей. А затем производятся токены для использования в реальных приложениях. К ним относятся новые «токены рассуждений» (reasoning tokens), используемые в агентских ИИ-системах. NVIDIA также повторно представила результаты по Hopper, чтобы подчеркнуть, что H100 остаётся «единственной архитектурой, кроме Blackwell», которая показала лидерские показатели по всему набору MLPerf Training, хотя и уступила Blackwell. Поскольку инстансы на H100 широко доступны у провайдеров облачных сервисов, компания, похоже, стремится заверить клиентов, что существующие развёртывания по-прежнему имеют смысл. AMD, со своей стороны, продемонстрировала прирост производительности поколения чипов. В тесте Llama2 70B LoRA она показала 30-% прирост производительности AMD Instinct MI325X по сравнению с предшественником MI300X. Основное различие между ними заключается в том, что MI325X оснащён почти на треть более быстрой памятью. В самом популярном тесте, тонкой настройке LLM, AMD продемонстрировала, что её новейший ускоритель Instinct MI325X показывает результаты наравне с NVIDIA H200. Это говорит о том, что AMD отстает от NVIDIA на одно поколение, отметил ресурс IEEE Spectrum. AMD впервые представила результаты MLPerf Training, хотя в предыдущие годы другие компании представляли результаты в этом тесте, используя ускорители AMD. В свою очередь, Google представила результаты лишь одного теста, задачи генерации изображений, с использованием Trillium TPU. Тест MLPerf также включает тест на энергопотребление, измеряющий, сколько энергии уходит на выполнение каждой задачи обучения. В этом раунде лишь Lenovo включила измерение этого показателя в свою заявку, что сделало невозможным сравнение между компаниями. Для тонкой настройки LLM на двух ускорителях Blackwell требуется 6,11 ГДж или 1698 КВт·ч — примерно столько энергии уходит на обогрев небольшого дома зимой.

27.05.2025 [14:12], Руслан Авдеев

Sophia Space разработала «ИИ-плитки» для сборки космических ЦОД

hardware

nvidia

nvidia jetson

qualcomm

snapdragon

ии

космос

микро-цод

облако

периферийные вычисления

спутник

сша

цод

Финансирование получил очередной космический стартап, намеренный вывести на орбиту дата-центры. Sophia Space из Сиэтла (США) привлекла $3,5 млн — раунд финансирования возглавила Unlock Ventures, участие также приняли «бизнес-ангелы», заинтересованные в орбитальных периферийных вычислениях и космических ЦОД, сообщает Datacenter Dynamics.

Источник изображений: Sophia Space В Sophia Space заявили, что мир находится на заре новой эры, в которой спрос на ИИ-технологии не должен приносить ущерба планете из-за энергетических ограничений. Компанию основали два выходца из Лаборатории реактивного движения NASA (JPL), а также ветеран Intel и Microsoft. Компания предлагает готовую, автономную, защищённую от радиации вычислительную платформу TILE, оптимизированную для ИИ-задач, в том числе в коммерческих и оборонных секторах. Каждый сервер TILE Edge представляет «плитку» размерами 1 × 1 и толщиной 1 см, оснащённую собственной солнечной панелью и пассивной системой охлаждения. Вычислительная часть представлена связкой Qualcomm Snapdragon 865 и Cloud AI 100 или NVIDIA Jetson и Blackwell. «Плитки» можно объединять друг с другом, формируя кластер необходимой мощности. Периферийные вычисления в космосе ценятся за возможность решить проблему перегрузки спутников, генерирующих больше данных, чем когда бы то ни было. Для использования этих огромных массивов информации требуются значительные ресурсы, поэтому предварительная обработка на периферийной платформе может сослужить неоценимую службу владельцам — предназначенные для передачи на Землю данные фильтруются ещё в космосе. Тема будет становиться всё более актуальной, поскольку правительствам и военным нужны всё более сложные системы мониторинга и съёмки на орбите. Компании вроде Axiom Space, Starcloud (ранее Lumen Orbit), NTT, Lonestar, Ramon.Space и Blue Origin давно рассматривают возможность развертывания вычислительных систем на орбите. В мае уже произошли два важных события, связанных с космическими дата-центрами. Во-первых, в начале месяца Эрик Шмидт (Eric Schmidt) купил Relativity Space, чтобы заняться запуском космических ЦОД, а несколько дней назад появилась информация, что китайская ADA Space вывела на орбиту первые 13 из 2,8 тыс. спутников для создания космического ИИ ЦОД.

27.05.2025 [11:48], Сергей Карасёв

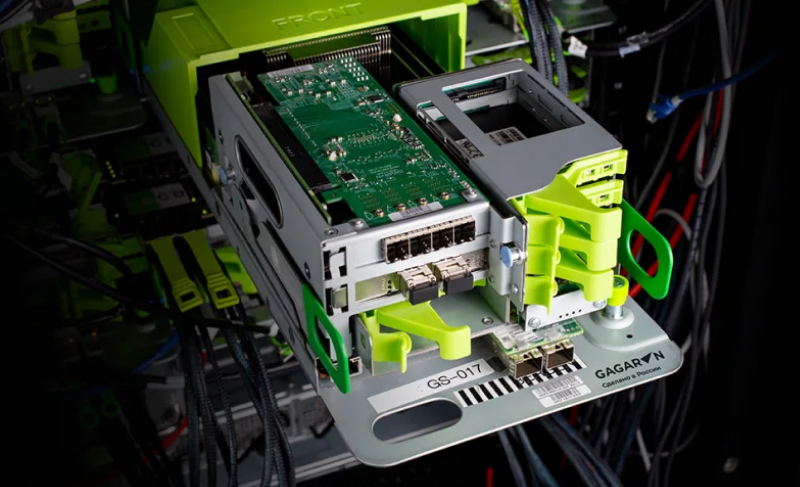

Сбербанк инициировал банкротство российского производителя OCP-серверов Gagar>nСбербанк, по сообщению ресурса IT Channel News, направил в арбитражный суд заявление о признании ООО «Гагар.ин» банкротом в связи с возникшей задолженностью. Сама компания также намерена обратиться в суд с заявлением о собственной несостоятельности. ООО «Гагар.ин» — юридическое лицо компании Gagar>n, российского разработчика и производителя OCP-оборудования. Продукты компании входят в реестр Минпромторга России. Gagar>n реализует модель полного цикла, включающую самостоятельную разработку механики, схемотехники, электроники и встроенного ПО. Сбербанк требует от ООО «Гагар.ин» 106,04 млн руб. Кроме того, на этапе рассмотрения в адрес поставщика серверов находятся иски от ряда других компаний, в число которых входят: «Мастерпост» (312,43 тыс. руб.), «Треолан» (2,1 млн руб.), «КМС-Эксперт» (25,25 млн руб.), «Системы автоматизированного неинвазивного исследования» (4,37 млн руб.), «Матрикс электроника» (1,43 млн руб.), «Центр программных разработок РТсофт» (1,9 млн руб.), «Плексфорс» (1,32 млн руб.), ТД «Симметрон электронные компоненты» (почти 10 млн руб.), «О-Си-Эс-Центр» (344,25 тыс. руб.) и «Гран Груп» (4,2 млн руб.). Таким образом, общая сумма требований в рамках исков превышает 157 млн руб.

Источник изображения: Gagar>n По итогам 2024 года ООО «Гагар.ин» получило выручку в размере 579 млн руб., что на 56,9 % меньше по сравнению с предыдущим годом. При этом компания показала чистые убытки на уровне 107 млн руб., тогда как в 2023-м была зафиксирована чистая прибыль в 262 млн руб. В 2024 году среднесписочная численность работников ООО «Гагар.ин» составила 112 человек — это на 12 сотрудников меньше, чем в 2023 году. По состоянию на 31 декабря 2024-го совокупные активы организации составляли 1,6 млрд руб., что на 27,1 млн руб. (на 1,7 %) больше, чем годом ранее.

25.05.2025 [13:19], Сергей Карасёв

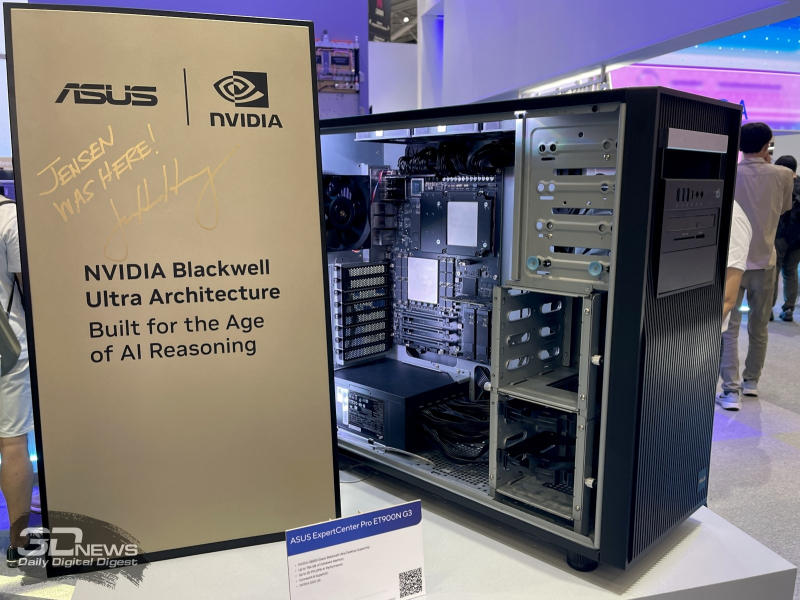

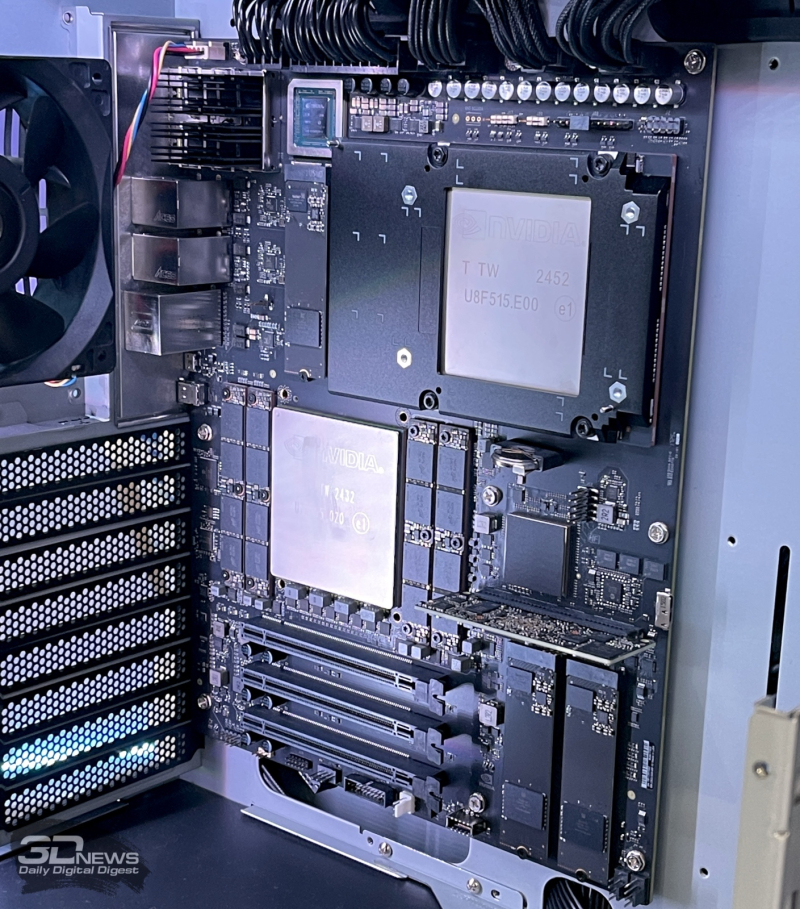

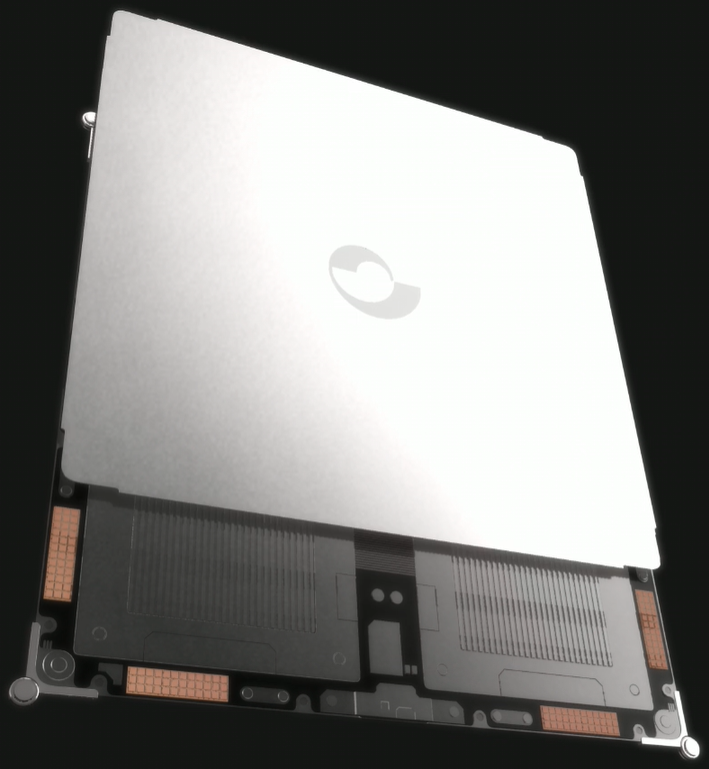

ASUS показала компактный ИИ-суперкомпьютер Ascent GX10 и рабочую станцию ExpertCenter Pro ET900N G3 на базе BlackwellКомпания ASUS продемонстрировала настольные системы с ускорителями NVIDIA на архитектуре Blackwell. В частности, представлены компактный ИИ-суперкомпьютер Ascent GX10 и мощная рабочая станция ExpertCenter Pro ET900N G3 башенного типа. Устройство Ascent GX10 базируется на платформе NVIDIA DGX Spark. Установлен суперчип Grace Blackwell GB10, который содержит ускоритель Blackwell и процессор Grace с 20 ядрами Arm в конфигурации 10 × Arm Cortex-X925 и 10 × Arm Cortex-A725. Новинка обеспечивает ИИ-производительность до 1000 TOPS на операциях FP4. Компьютер располагает 128 Гбайт унифицированной системной памяти, что, как утверждает ASUS, позволяет работать с моделями ИИ, насчитывающими до 200 млрд параметров. В оснащение входит сетевой адаптер NVIDIA ConnectX-7 SmartNIC с двумя QSFP-портами. Также есть 10GbE-порт RJ45. Прочие технические характеристики не раскрываются — вероятно, они унаследованы у эталонного решения NVIDIA DGX Spark: это накопитель M.2 NVMe SSD, контроллеры Wi-Fi 7 и Bluetooth 5.3, порты USB 4 Type-C и HDMI 2.1a. Применяется NVIDIA DGX OS — модификации Ubuntu для работы с ИИ. Устройство предназначено прежде всего для прототипирования и настройки ИИ-моделей, а также инференса. В свою очередь, рабочая станция ExpertCenter Pro ET900N G3 получила ускоритель NVIDIA GB300 Grace Blackwell Ultra с 288 Гбайт памяти HBM3E. Есть 496 Гбайт памяти LPDDR5X в виде четырёх модулей SOCAMM. Упомянут сетевой адаптер NVIDIA ConnectX-8 SuperNIC. Заявленная ИИ-производительность достигает 20 Пфлопс в режиме FP4. Компьютер функционирует под управлением NVIDIA DGX OS. На фронтальную панель корпуса выведены порты USB и 3,5-мм аудиогнёзда. Предусмотрены слоты для флеш-карт.

21.05.2025 [14:34], Руслан Авдеев

Китайская ADA Space вывела на орбиту первые 13 из 2,8 тыс. спутников для создания космического ИИ ЦОДКитайская аэрокосмическая компания Chengdu Guoxing Aerospace Technology Co. (ADA Space) в рамках миссии Space Computing Constellation 021 успешно вывела на орбиту 12 спутников Xingshidai, призванных стать частью будущего космического ИИ-облака AI Cloud. Спутники вывели с помощью ракеты-носителя Чанчжэн-2D (Long March 2D), сообщает Datacenter Dynamics. Группировка Xingshidai будет состоять из 2,8 тыс. аппаратов производительностью 740 TOPS каждый. Компания рассчитывает использовать межспутниковую оптическую лазерную связь для передачи данных со скоростью до 100 Гбит/с. Спутники, как ожидаются, будут способны запускать ИИ-модели с 8 млрд параметров для помощи в астрономических наблюдениях, выполняемых с помощью различных космических инструментов, включая рентгеновский поляриметр, разработанный Университетом Гуанси (Guangxi University) и Национальной обсерваторией Китайской академии наук (National Astronomical Observatory of the Chinese Academy of Sciences). Группировка также обеспечит дистанционное зондирование и поддержку экстренных служб. По словам китайских учёных, поскольку в космосе можно получать большие объёмы данных высочайшего качества, возможность интеллектуальной обработки данных непосредственно на орбите приобрела важное значение. Основанная в 2018 году компания ADA Space в феврале вышла на Гонконгскую фондовую биржу. Компания, начинавшая как разработчик низкоорбитальных спутников для дистанционного зондирования, постепенно перешла на спутники для ИИ-проектов. В конце 2021 года компания успешно привлекла $55,6 млн от китайских инвестфондов в раунде финансирования серии B, возглавленном Hengjian Holding. До этого в раунде серии A+ был привлечён $21,37 млн, раунд возглавили Aplus Capital и Galaxy Holding Group. ADA Space — одна из многих компаний, которая выиграла от новой политики Китай, который с 2014 года пытается сделать аэрокосмическую отрасль, в которой доминируют государственные структуры, более открытой для частного капитала. С тех пор сотни аэрокосмических и смежных компаний получили государственную поддержку, в том числе от военных ведомств. Как заявил недавно представитель структуры China Aerospace Studies Institute, подконтрольной ВВС США, ожидается развитие сотрудничества Китая с коллегами по БРИКС, а также государства поменьше. По словам американских военных, это будет на руку как Китаю, так и другим странам, поскольку освоение космоса в ближайшие десятилетия будет весьма прибыльным делом и все нации захотят принять в этом участие. В этой группе Китай позиционирует себя безусловным лидером. В идее космических ЦОД нет ничего нового. В марте 2025 года Starcloud (бывшая Lumen Orbit) сообщила, что тестовый запуск группировки спутников состоится этим летом, а в апреле Axiom Space объявила, что планирует развернуть в космосе два узла ЦОД Orbital Data Center к концу 2025 года.

21.05.2025 [10:39], Владимир Мироненко

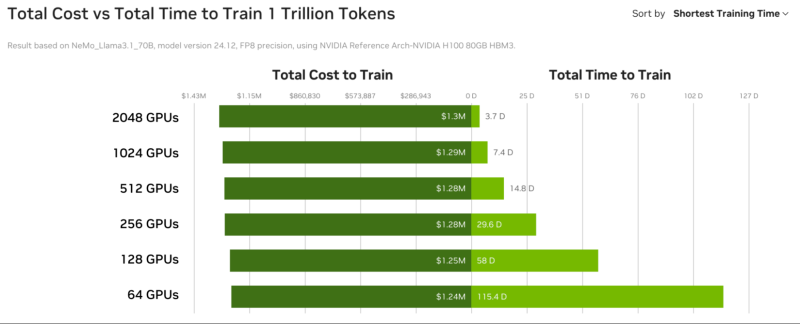

GPU-маркетплейс NVIDIA DGX Cloud Lepton упростит доступ к дефицитным ИИ-ускорителямNVIDIA анонсировала GPU-маркетплейс NVIDIA DGX Cloud Lepton, которая позволит разработчикам со всего мира, создающим агентские и другие ИИ-приложения использовать NVIDIA Blackwell и другие модели ускорителей в глобальной сети партнёрских облаков (NCP): CoreWeave, Crusoe, Firmus, Foxconn, GMI Cloud, Lambda, Nebius, Nscale, Softbank и Yotta Data Services. Ожидается, что ведущие провайдеры облачных услуг и другие GPU-маркетплейсы также присоединятся к DGX Cloud Lepton. Разработчики смогут использовать вычислительные мощности ускорителй в определённых регионах как для вычислений по требованию, так и на постоянной основе. «NVIDIA DGX Cloud Lepton свяжет нашу сеть глобальных поставщиков облачных GPU с разработчиками в сфере ИИ, — заявил основатель и генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang). — Вместе с нашими NCP мы строим ИИ-фабрику планетарного масштаба». По замыслу NVIDIA, платформа DGX Cloud Lepton поможет решить критическую задачу обеспечения разработчиков надёжными, высокопроизводительными ресурсами ускорителей путём унификации доступа к облачным ИИ-сервисам и мощностям собственных ускорителей. Платформа интегрирована с программным стеком NVIDIA, включая микросервисы NIM и NeMo, Blueprints и Cloud Functions. В числе основных преимуществ новой платформы компания назвала:

А для самих провайдеров, участвующих в DGX Cloud Lepton, предоставляется ПО для управления, которое обеспечивает диагностику состояния ускорителей в реальном времени и автоматизирует анализ первопричин возникших проблем, избавляя от ручной диагностики и сокращая время простоев. NVIDIA также анонсировала инициативу Exemplar Clouds, предназначенную для стандартизации прозрачного сравнительного анализа облачной ИИ-инфраструктуры. Это предложение должно решить серьёзную проблему, с которой сталкиваются разработчики и предприятия, развёртывающие рабочие ИИ-нагрузки — прогнозирование эффективности, надёжности и ценовой эффективности облачной платформы. Exemplar Clouds использует NVIDIA DGX Cloud Benchmarking, комплексный набор инструментов и рекомендаций для оптимизации производительности облачных ИИ-нагрузок и количественной оценки связи между стоимостью и производительностью.

12.05.2025 [16:20], Руслан Авдеев

Сотрудник ЦОД пустил китаянку в серверные Deutsche Bank, но уволили в итоге… осведомителяОдин из бывших менеджеров британской компании Computacenter, управляющей компьютерными системами Deutsche Bank в Нью-Йорке, подал иск в суд на бывшего работодателя и причастных лиц. Он утверждает, что сообщил о несанкционированном доступе к серверным Deutsche Bank, но вместо благодарности его неожиданно уволили, свидетельствует The Register. Между компаниями заключён контракт на поставку IT-услуг на сумму более $50 млн. На серверах хранятся миллионы конфиденциальных записей, в том числе о транзакциях сотен тысяч клиентов. В июле 2023 года Джеймс Папа (James Papa), выступавший сервис-менеджером Computacenter, был уволен после того, как сообщил руководству о том, что его коллега неоднократно допускал свою подругу-китаянку по имени Дженни к серверным помещениям без официального разрешения. Более того, он позволял ей пользоваться ноутбуком, подключенным к сети Deutsche Bank, и своей учётной записью. Папа подал иск, в котором фигурируют Computacenter, Deutsche Bank и один из топ-менеджеров последнего. Он обвиняет стороны в незаконном увольнении. По словам истца, записи с камер видеонаблюдения свидетельствуют о том, что служба безопасности банка впускала женщину в серверную без официального разрешения в нарушение всех протоколов. Более того, визиты повторялись с марта по июнь 2023 года и продолжались даже после того, как Папа приказал сотруднику прекратить подобное. Истец уверяет, что женщина обладала «значительными компьютерными знаниями», поэтому он доложил руководству об инциденте безопасности и посоветовал сообщить о происшествии в Комиссию по ценным бумагам и биржам США (SEC).

Источник изображения: Patrick Amoy/unsplash.com Вместо этого, как утверждает истец, его вызвали на встречу с юристами Computacenter и Deutsche Bank, а также представителями службы безопасности финансовой организации, где провели довольно агрессивный допрос, причём давление только усиливалось, когда он указывал на очевидные недостатки системы безопасности. После одной из таких встреч менеджера отстранили от работы, а вскоре уволили. Папа предполагает, что причина именно в том, что он привлёк внимание к недостаткам в системе безопасности. Также истец утверждает, что SEC так и не уведомили об инцидентах, что является обязательным в таких случаях. По словам юриста истца, его просто сделали «козлом отпущения», переложив вину за нарушения сотрудника. Уже после увольнения истец выяснил, что обе компании отслеживали деятельность женщины по камерам, в том числе то, как она касается серверов банка, но так и не установили ни её личности, ни чем она занималась. В результате инцидента уволили только его. В иске Папа утверждается, что обе компании и вице-президент Deutsche Bank нарушили законы Нью-Йорка о защите информаторов и проявили халатность. Теперь Папа требует $20 млн компенсации «эмоционального, физического и денежного ущерба».

12.05.2025 [12:20], Сергей Карасёв

MSI представила мини-компьютер MS-C927 на базе Intel Arrow Lake-U для периферийных вычисленийКомпания MSI анонсировала индустриальный компьютер небольшого форм-фактора MS-C927, предназначенный для решения различных ИИ-задач на периферии: это могут быть обнаружение объектов, распознавание лиц, визуальный контроль, автоматизация тех или иных операций и пр. Устройство оснащается процессором Intel Core Ultra поколения Meteor Lake-U или Arrow Lake-U. Новинка заключена в корпус с габаритами 130 × 155 × 40 мм. Применено пассивное охлаждение, а верхняя ребристая панель выполняет функции радиатора для рассеяния тепла. Диапазон рабочих температур простирается от -10 до +60 °C. Компьютер соответствует стандарту IEC 61373 по ударопрочности и вибронагрузкам, что позволяет использовать его на транспорте. Напряжение питания DC-in может варьироваться от 12 до 24 В.

Источник изображения: MSI Устройство располагает двумя слотами SO-DIMM для модулей оперативной памяти DDR5-6400 суммарным объёмом до 96 Гбайт. Доступны слоты M.2 M-key для NVMe SSD, М.2 B-key для сотового модема и М.2 E-key для комбинированного адаптера Wi-Fi/Bluetooth. Предусмотрены сетевые порты 2.5GbE и 1GbE на основе контроллеров Intel I226-V и Intel I219-LM соответственно. В набор разъёмов входят гнёзда RJ45 для сетевых кабелей, четыре порта USB 3.х Type-A (10 Гбит/с), два интерфейса DisplayPort с поддержкой разрешения до 4096 × 2304 пикселя (60 Гц), два последовательных порта и интерфейс GPIO (4 GPI, 4 GPO). Кроме того, имеются гнёзда для подключения антенн беспроводной связи. Предусмотрен встроенный модуль TPM 2.0 для обеспечения безопасности. Заявлена совместимость с Windows 10/11 IoT Enterprise LTSC и Linux (по запросу). |

|