Материалы по тегу: облако

|

23.10.2024 [14:18], Руслан Авдеев

ByteDance готовится построить дата-центр в ТаиландеВладеющая популярной социальной сетью TikTok компания ByteDance, по слухам, рассчитывает открыть новый дата-центр в Таиланде. Datacenter Dynamics сообщает, что дочерняя структура IT-гиганта BytePlus хочет развернуть в 2025 году новую площадку для поддержки облачных и ИИ-сервисов. Согласно источнику, ByteDance намерена воспользоваться преимуществами развивающейся цифровой экономики Таиланда. В последние году ByteDance активно развивает свою инфраструктуру для удовлетворения растущего спроса, попутно пытаясь убедить власти на местах в том, что персональные данные местных жителей не будут передаваться в Китай — такие опасения особенно характерны для США и Евросоюза. В июне компания сообщила о строительстве ИИ-хаба в Малайзии за RM10 млрд ($2,13 млрд). Также она предположительно рассматривает возможность открытия дата-центра в Австралии для поддержки выполнения задач в Азиатско-Тихоокеанском регионе.

Источник изображения: Andreas Brücker/unsplash.com В Таиланде действительно активно развивается национальная цифровая инфраструктура. Так, в сентябре Google объявила, что намерена инвестировать $1 млрд в дата-центры в Бангкоке, а также находящейся рядом прибрежной провинции Чонбури. В рамках проекта компания намерена сотрудничать с группой Gulf Edge, чтобы создать в Таиланде суверенное облако. AWS также намерена запустить в Таиланде облачный регион в начале 2025 года, а к 2037 году инвестировать $5 млрд. Построить регион ЦОД в стране намерена и Microsoft.

21.10.2024 [17:50], Руслан Авдеев

Вьетнам намерен перевести все сети на IPv6, проложить новые интернет-кабели и возвести ИИ ЦОДВьетнам намерен перевести все сети страны на протокол IPv6, обновить сетевую инфраструктуру и поддержать развитие ЦОД в стране. По данным The Register, новая стратегия правительства отражена в рамках Решения № 1132/QD-TTg, определяющего цели на 2025 и 2030 гг. Так, в течение года страна намерена подключить два новых подводных интернет-кабеля. Ранее в этом году три из пяти кабелей, обеспечивавших Вьетнаму связь с внешним миром, вышли из строя. Также планируется обеспечить домохозяйства FTTH-подключением, покрыть 5G-связью все крупные города и промышленные зоны, а также начать работы над ИИ ЦОД с PUE не выш 1.4. Ещё грандиознее планы на 2030 год. Ожидается, что к этому моменту все сети в стране перейдут на IPv6, скорость широкополосного оптического подключения повсеместно достигнет 1 Гбит/сек, а 5G-сети охватят 99 % населения. Также будут подключены ещё шесть подводных кабелей суммарной ёмкостью 350 Тбайт/сек. Один из них будет находиться в государственной собственности. Население Вьетнама превышает 100 млн человек, при этом количество абонентских договоров составляет 140 на 100 жителей. IPv4-адресов не хватает, поскольку развивающиеся страны и так в своё время получили их не слишком много. Поэтому переход на IPv6 выглядит логичным и своевременным. Например, соседний Китай намерен ускорить внедрение IPv6, причём действует весьма решительно. Ещё с прошлого года поддержка IPv6 стала обязательной для всего нового Wi-Fi оборудования в стране.

Источник изображения: Peter Hammer/unsplash.com Планом предусмотрено строительство ряда ЦОД гиперскейл-уровня, ИИ ЦОД, а также периферийных и региональных дата-центров. Вьетнам также утвердил решение об обеспечении кибербезопасности, в рамках которого организации и частные лица призывают пользоваться услугам местных ЦОД. Предусматривается и поощрение переноса IT-нагрузок бизнеса и властей в облака. Для строительства дата-центров правительство намерено привлечь как местные, так и иностранные инвестиции. Ещё одной целью на 2030 год стало обеспечение каждого жителя Вьетнама четырьмя IoT-подключениями. А 70 % населения к этому времени должны перейти на использование персональных цифровых подписей. Кроме того, правительство решило, что ежегодный оборот полупроводниковой индустрии должен достичь $100 млрд к 2050 году.

17.10.2024 [14:36], Руслан Авдеев

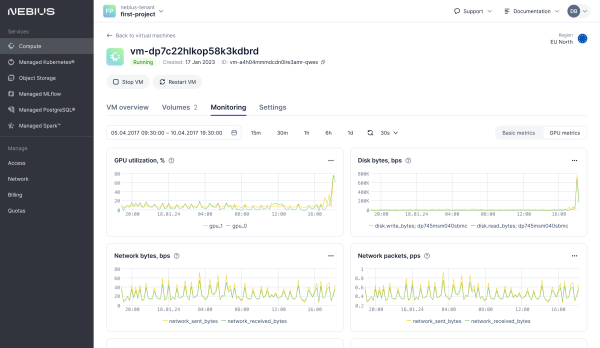

Nebius, бывшая Yandex, представила облачную ИИ-платформу с ускорителями NVIDIA H100 и H200ИИ-компания Nebius, сформированная из бывшей Yandex N.V., представила облачную платформу с современными ускорителями NVIDIA. Как уточняет Datacenter Dynamics, речь идёт о моделях NVIDIA H100 и H200, а также L40S. В скором будущем компания рассчитывает добавить и новейшие суперускорители GB200 NVL72. Облачное хранилище обеспечивает агрегированную скорость чтения до 100 Гбайт/с и 1 млн IOPS. Платформа также предлагает управляемые Apache Spark и MLFlow, а ВМ по умолчанию включают ИИ-библиотеки и драйверы. По словам компании, она прислушалась к запросам клиентов, нуждавшихся в самостоятельном доступе и инфраструктуре, отлично от просто «базовой». Речь идёт о крупномасштабных кластерах с InfiniBand-подключением на базе эталонной архитектуры NVIDIA, но с кастомизированным оборудованием и проприетарной программной облачной платформой. После введения антироссийских санкций Nebius дистанцировалась от «Яндекса», основная часть активов которого была продана группе российских инвесторов. У Nebius остался дата-центр в Финляндии, ёмкость которого она намерена утроить в обозримом будущем. Там разместятся более 60 тыс. ускорителей. В августе сообщалось, что компания увеличила облачную выручку на 60 % год к году во II квартале.

16.10.2024 [12:15], Руслан Авдеев

Crusoe Energy, Blue Owl и Primary Digital Infrastructure построят в Техасе 205-МВт ИИ ЦОД в ТехасеКомпания Crusoe Energy открывает совместное предприятие с Blue Owl Capital и Primary Digital Infrastructure для реализации проекта по строительству ЦОД в Техасе. По данным Silicon Angle, на эти цели будет потрачено $3,4 млрд, специализированный дата-центр должен появиться в кампусе Lancium Clean Campus. Будущий ЦОД Crusoe AI, уже сданный в аренду целиком некому гиперскейлеру из списка Fortune 500, будет кампусом из двух объектов, построенных по индивидуальному проекту. По имеющимся данным, он рассчитан на ёмкость 205 МВт. Конструкция ЦОД оптимизирована для использования систем с прямым жидкостным охлаждением, но будет поддерживаться и воздушное охлаждение. Готовый ЦОД сможет вместить до 100 тыс. ускорителей в составе одной сетевой фабрики. Предполагается, что энергоснабжение кампуса будет обеспечено внутренними и внешними источниками энергии. Освоение мощностей начнётся в I половине 2025 года. Ранее появилась информация, что ключевым арендатором станет компания Oracle, а конечным потребителем вычислительных мощностей — OpenAI. При этом Microsoft, вероятно, станет посредником, сохраняя свой статус поставщика облачных услуг для OpenAI. В руководстве Crusoe подчёркивает, что растущий спрос на ЦОД обусловлен большими перспективами ИИ. Lancium, с которой Crusoe уже сотрудничала, в 2021 году получила одобрение на строительство техасского кампуса ЦОД Project Artemis. Тогда речь шла о кампусе на участке 160–320 га ёмкостью от 200 МВт с возможностью масштабирования до 1 ГВт. Blue Owl Capital управляет активами на $192 млрд. Хотя ранее компания не инвестировала в ЦОД, в последние месяцы она вложила средства в проекты нескольких дата-центров, а недавно создала СП на $5 млрдс Chirisa и PowerHouse для строительства сети ЦОД на территории США, в первую очередь для ИИ-облака CoreWeave. Blue Owl также приобрела владельца Stack и RadiusDC — компанию IPI Partners за $1 млрд. Руководство Primary Digital Infrastructure говорит об инвестиционном буме — только в США в ближайшие четыре-пять лет на ЦОД будет потрачено около $1 трлн. Текущая цель компании — приобретение наиболее стабильных активов на этом рынке, а также инвестиции в строительство собственных облачных и ИИ-объектов. Crusoe Energy, основанная в 2018 году, начинала с доставки контейнерных ЦОД к нефтяным скважинам в США, запитанных от попутного газа. Если изначально Crusoe использовала свои ресурсы для майнинга, то позже появилось предложение Crusoe Cloud для ИИ- и HPC-нагрузок. В конце прошлого года компания занялась стационарными проектами. Компания разместила ускорители в ЦОД ICE02 оператора atNorth в Исландии и объявила о сотрудничестве с Digital Realty.

15.10.2024 [21:15], Сергей Карасёв

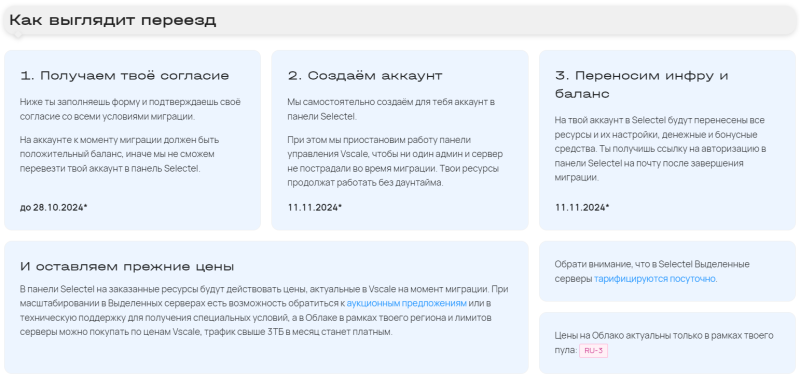

Проект Vscale закрывается: клиентам предлагается мигрировать на платформу SelectelРоссийский провайдер Selectel сообщил о закрытии проекта Vscale, в рамках которого предоставлялись базовые инфраструктурные сервисы предприятиям малого бизнеса, начинающим IT-специалистам, индивидуальным разработчикам, системным администраторам и стартапам. Всем клиентам Vscale предлагается мигрировать на платформу Selectel. Напомним, компания Selectel перезапустила облачный бренд Vscale в конце 2023 года. Тогда сообщалось, что сервисы Vscale предназначены для хостинга сайтов, приложений и чат-ботов, учебных проектов, тестовых стендов, игровых серверов, рендеринга и работы с ресурсоёмким ПО. Клиенты могли арендовать выделенные и облачные серверы в настроенных конфигурациях с почасовой оплатой.

Источник изображения: Vscale На сайте Vscale говорится, что в рамках проекта создавалась базовая и доступная инфраструктура для бизнеса и пользователей любого масштаба. Вместе с тем от клиентов поступали запросы на дополнительную функциональность — DBaaS, S3, CDN, IPv6 и пр. Эти возможности будут доступны в основной облачной платформе Selectel. «Запустив Vscale, мы протестировали спрос на фоне ухода зарубежных игроков с похожими продуктовыми решениями. Мы увидели, что у клиентов есть запрос на расширение их IT-проектов и, как следствие, дополнительную функциональность и сервисы, которые уже реализованы на высоком уровне в Selectel. В связи с этим мы приняли решение не развивать далее бренд базовых инфраструктурных сервисов Vscale. Мы фокусируемся на нашем основном бренде — Selectel, под которым предоставляем, в том числе, и доступные сервисы для бизнеса любых размеров», — говорится в заявлении компании. В процессе миграции будет выполнено создание учётных записей в Selectel для пользователей Vscale с использованием данных, предоставленных при регистрации в Vscale. При этом будет осуществляться создание нового аккаунта, поскольку технически сохранить условия из Vscale можно только таким способом. В новую учётную запись в Selectel будут перенесены виртуальные машины, образы, сетевые диски, публичные IP, приватные подсети и роутеры. Все текущие настройки ресурсов сохранятся. Кроме того, будут перенесены актуальные на время миграции клиентские лимиты на заказ ресурсов в том регионе, зоне доступности и пуле, который был у клиента в Vscale. Для миграции Kubernetes потребуются дополнительные действия. Миграция запланирована на 11 ноября 2024 года. После этого станут доступны дополнительные услуги и продукты Selectel, такие как DBaaS, балансировщики нагрузки, CDN и др. Выделенные серверы будут переведены на посуточный тариф, а облачные серверы и Managed Kubernetes останутся на почасовом. DNS останется бесплатным. В случае переноса ресурсов на уже существующий аккаунт в Selectel компания не сможет обеспечить сохранение цен и условий Vscale. В Vscale предоставлялись виртуальные машины с гарантированной долей vCPU 10 % и 20 %. После миграции цена на них будет такой же, как и была в Vscale.

15.10.2024 [17:46], Андрей Крупин

«Группа Астра» сфокусируется на новой концепции серверной виртуализации«Группа Астра» сообщила о планах по реализации новой стратегии развития одного из ключевых направлений своего продуктового портфеля — виртуализации. Компания намерена обновить свои предложения в этой области, чтобы лучше удовлетворять потребности клиентов. В качестве одной из причин, побудивших руководство «Группы Астра» переосмыслить подход к виртуализации, в компании назвали появление новых технологий, таких как облачные вычисления. «Мы провели тщательный анализ рынка и собрали отзывы клиентов, которые выявили несколько ключевых направлений для улучшения: масштабируемость, безопасность и управление ресурсами», — говорится в заявлении разработчика, намеревающегося сфокусироваться на развитии Hyper Cloud — облачного инфраструктурного ПО, неотъемлемой частью которого станут наработки вендора в области виртуализации.

Источник изображения: «Группа Астра» / astragroup.ru В качестве реальных примеров трансформации направления виртуализации «Группы Астра» в компании привели выпуск программно-аппаратных комплексов с предустановленной платформой для построения защищённого инфраструктурного частного облака Astra Infrastructure Cloud (AIC), одним из ключевых компонентов которой является востребованное у российских заказчиков решение для серверной и облачной виртуализации ПК СВ «Брест», а также облачный сервис Astra Cloud, в основе которого тоже лежит AIC.

Источник изображения: «Группа Астра» / astragroup.ru За вертикаль серверной виртуализации в новом бизнес-направлении «Группы Астра» будет отвечать платформа VMmanager. Решение позволяет решать широкий спектр задач по виртуализации от построения отказоустойчивого кластера и автоматизации выдачи виртуальных машин до предоставления виртуальных рабочих столов (VDI). Кроме того, компания намерена предложить гибридные решения, позволяющие перемещать нагрузки между локальными и облачными средами. «Трансформация нашего направления в виртуализации — это ответ на вызовы современного рынка и стремление обеспечить клиентов инновационными, безопасными и эффективными решениями. Мы уверены, что новые продукты поддержат бизнес-процессы наших клиентов и помогут им успешно развиваться в условиях цифровой трансформации. Наша компания уверенно движется к созданию следующего поколения виртуализации, которое станет основой для будущего IT-инфраструктуры», — поделились планами в «Группе Астра».

15.10.2024 [09:13], Руслан Авдеев

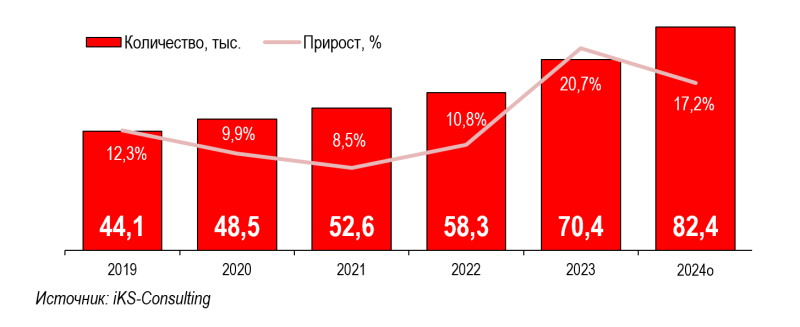

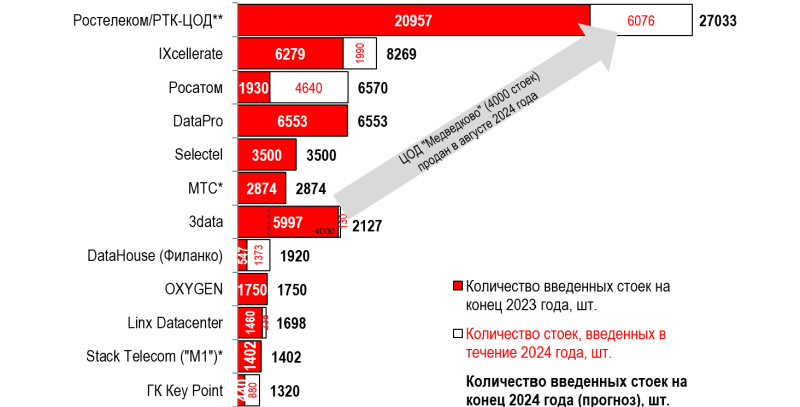

iKS-Consulting: коммерческие ЦОД в России вытесняют корпоративные дата-центрыКоммерческие дата-центры в России пользуются всё большим спросом. По данным Forbes, речь идёт не только об использовании облаков — многие компании вместо эксплуатации собственных ЦОД всё чаще предпочитают размещать собственные серверы на арендованных объектах. Согласно прогнозам iKS-Consulting, уже к 2028 году рынок коммерческих ЦОД в России, возможно, вырастет в 2,1 раза в сравнении с 2023 годом — до 148 тыс. стойко-мест. В денежном выражении на фоне роста спроса рынок может вырасти в 2,8 раза — до 121 млрд рублей. Одной из вероятных причин называется рост арендных ставок для размещения серверов клиентов. При этом рынок облачной инфраструктуры к концу 2024 года может вырасти до 162 млрд руб., а к 2028 году — составить 464 млрд руб. (в 2023 году он составил 121,4 млрд руб.). Из-за быстрого роста объёмов хранимой и обрабатываемой информации компании могут либо развивать собственную IT-инфраструктуру, либо арендовать её у оператора, поскольку собственные ЦОД могут позволить себе лишь очень крупные бизнесы. По данным Forbes, в последние годы доля ЦОД, принадлежащих компаниям, на российском рынке неуклонно снижается. При этом, если в 2023 году доля коммерческих ЦОД составляла 18,6 % по объёму серверных стоек, то в 2027 году она, возможно, превысит 25 %. В мире этот показатель достиг 31 %, а доля корпоративных ЦОД постепенно сокращается. Как отмечают в iKS-Consulting, с 2020 года рынок коммерческих ЦОД в России вырос на 80 %, а в 2024 году, вероятно, составит 82,4 тыс. стойко-мест. Лидером рынка является дочерняя структура «Ростелекома» — РТК-ЦОД. Этим летом она приобрела крупный ЦОД на севере Москвы и теперь располагает 27 тыс. серверных стоек. У ближайших конкурентов IXcellerate, «Росатома» и DataPro насчитывается более 8,3 тыс. стоек, 6,6 тыс. стоек и 6,6 тыс. стоек соответственно. 3data из-за сделки PNK Group с «Ростелекомом» откатилась с четвёртого на седьмое место. Среди российских клиентов популярны как облака, так и колокация. Выбор во многом зависит от возможностей IT-специалистов компаний. При этом облачные сервисы предоставляют далеко не все операторы ЦОД, поскольку для этого требуется немало средств и компетенций. Из десятки операторов коммерческих ЦОД, по данным Forbes, лишь три числятся в десятке облачных провайдеров: РТК-ЦОД, Selectel и МТС. Впрочем, компании всё активнее пользуются облачными сервисами. Основные критерии выбора: кибербезопасность, экономическая целесообразность и бесперебойная работа IT-инфраструктуры. Впрочем, есть и негативные тенденции. По словам iKS-Consulting, среди основных трендов отрасли в России — увеличение сроков эксплуатации инженерного оборудования дата-центров. Основные причины — рост стоимости и сложности с закупками из-за увеличения санкционного давления.

14.10.2024 [11:44], Руслан Авдеев

CoreWeave получила кредитную линию на $650 млн для развития ИИ-облакаОблачный провайдер CoreWeave привлёк кредитную линию на $650 млн от крупного инвестиционного бизнеса для масштабирования своей деятельности по всему миру. По данным Silicon Angle, лидерами раунда финансирования стали JPMorgan Chase, Goldman Sachs и Morgan Stanley, к ним присоединились Barclays, CitiGroup, Deutsche Bank, Jefferies, Mizuho, MUFG и Wells Fargo. За последние 18 месяцев компания уже привлекла $12,7 млрд в виде акционерного капитала и долговых обязательств, оценка компании составила $19 млрд. В компании утверждают, что новая кредитная линия будет способствовать росту в быстроразвивающейся сфере ИИ. Сегодня CoreWeave выступает оператором публичного облака, обеспечивающего доступ к ускорителям NVIDIA для ИИ и рендеринга — в том числе доступны NVIDIA H100 и H200. Ещё в августе компания заявила, что стала первым облачным провайдером, предоставившим клиентам доступ к новейшим ускорителям NVIDIA H200. Обучение и внедрение больших языковых моделей (LLM) требует больших вычислительных ресурсов, но CoreWeave говорит, что её инфраструктура позволяет легко масштабировать ИИ-нагрузки в облаке.

Источник изображения: CoreWeave На сегодня инвестиции в ИИ-платформы очень популярны, поскольку спрос на вычисления продолжает расти. Например, ранее в этом месяце OpenAI уже привлекла кредитную линию на $4 млрд и ещё $6.6 миллиарда в рамках инвестиционного раунда. При этом в формировании кредитных линий CoreWeave и OpenAI зачастую участвуют одни и те же инвестиционные компании. Недавно CoreWeave открыла европейскую штаб-квартиру в Лондоне. При этом она намерена инвестировать $3,5 млрд в расширение бизнеса в Европе. В том числе речь идёт об открытии двух ЦОД в Великобритании, не считая дата-центров в Норвегии, Швеции и Испании. До конца года компания намерена получить в своё распоряжение до 28 ЦОД по всему миру. В 2025 году запланировано открытие ещё 10 дата-центров. В апреле прошлого года CoreWeave получила $221 млн, а потом — ещё $200 млн. В августе 2023 года было объявлено о долговом финансировании в размере $2,3 млрд под залог ускорителей NVIDIA. В декабре того же года CoreWeave провела раунд финансирования на $642 млн, а в мае текущего года она получила $1,1 млрд. Позже компания привлекла ещё $7,5 млрд. Наконец, в октябре появилась информация о намерении Cisco инвестировать в компанию. При этом в рамках сделки CoreWeave может получить оценку в $23 млрд.

10.10.2024 [19:08], Владимир Мироненко

TensorWave привлёк $43 млн на закупку ускорителей AMD Instinct MI300X для своего ИИ-облака, в том числе от самой AMDСтартап TensorWave из Лас-Вегаса провёл раунд финансирования на условиях SAFE (simple agreements for future equity), в результате которого привлёк $43 млн, сообщили ресурсы DataCenter Dynamics и The Register. Условия SAFE означают, что инвесторы имеют право при определённых обстоятельствах конвертировать свои инвестиции в акции компании, но не смогут потребовать возврат денег. Финансовый раунд возглавил вице-президент Nexus, также в нём приняли участие Maverick Capital, Translink Capital, Javelin Venture Partners, Granite Partners и AMD Ventures. Полученные средства TensorWave планирует использовать для оснащения своего основного ЦОД ускорителями AMD Instinct MI300X, на расширение команды, а также на подготовку к внедрению следующего поколения ускорителей Instinct MI325X и запуска новой корпоративной инференс-платформы Manifest в IV квартале 2024 года. По словам компании, Manifest, разработанная для поддержки более крупных контекстных окон ИИ-моделей с уменьшенной задержкой, помимо быстрого инференса позволяет анализировать сложные документы и безопасно обрабатывать и хранить конфиденциальные данные. Основанный в прошлом году стартап TensorWave, в отличие от большинства участников рынка ИИ, использующих ускорители NVIDIA, делает ставку на ускорители AMD Instinct. Разворачивать системы на базе MI300X стартап начал этой весной. Ускоритель MI300X также получил достаточно широкое распространение среди ряда облачных провайдеров. В частности, его использует Microsoft для обслуживания ИИ-модели OpenAI GPT-4 Turbo и многих сервисов Copilot. Oracle готова развернуть кластер из 16 384 MI300X. Также облачный стартап Vultr начал предлагать инстансы на базе MI300X. MI300X имеет больше памяти, чему у того же NVIDIA H100 — 192 Гбайт против 80 Гбайт. С выпуском ускорителей следующего поколения MI325X в конце этого года AMD ещё больше увеличит преимущество, поскольку ёмкость HBM3e-памяти ускорителя вырастет до 288 Гбайт. Это втрое больше, чем у H100, и наполовину больше, чем у будущих ускорителей NVIDIA Blackwell, говорит компания. Больший объём памяти особенно ценен для тех, кто запускает крупные ИИ-модели в FP16-формате. При 1536 Гбайт на узел система на базе MI300X может легко вместить модель Llama 3.1 405B от Meta✴, тогда как при использовании ускорителей H100 для этого её придётся разделить между несколькими системами или ужать с помощью 8-бит квантования. Можно также «втиснуть» несжатую модель в один узел с ускорителями NVIDIA H200, но тогда не останется достаточно места для большего контекстного окна, поддерживаемого моделью.

10.10.2024 [14:54], Владимир Мироненко

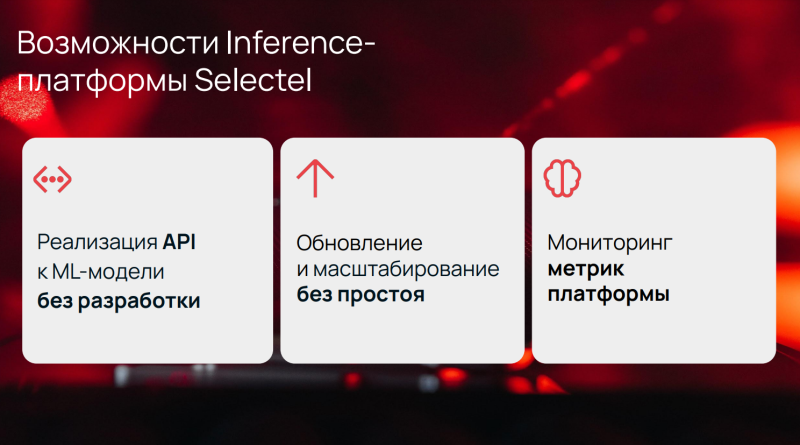

Selectel запустил бета-тестирование собственной инференс-платформы для ускорения запуска ИИ-моделейРоссийский провайдер сервисов IT-инфраструктуры Selectel приступил к бета-тестированию инференс-платформы собственной разработки, которая позволит упростить запуск ML-моделей в промышленную эксплуатацию и ускорить их работу. Как сообщается на сайте провайдера, с помощью нового сервиса можно всего за несколько минут развернуть готовую модель на вычислительных мощностях провайдера без привлечения разработчиков. Решение нацелено на компании, использующие в работе ИИ-модели для обеспечения функционирования голосовых роботов в колл-центрах, чат-ботов для консультаций сотрудников и клиентов, сервисов распознавания изображений и других задач. С помощью платформы можно загружать модели в объектное хранилище Selectel, а на выходе получить готовые API. Также с её помощью можно регулярно обновлять версии моделей без прекращения обработки поступающих пользовательских запросов. Selectel отметил, что благодаря инференс-платформе можно в несколько раз сократить время вывода ИИ-проектов на рынок, причём с учётом конкретных профилей нагрузок и требований к производительности, которые помогут подобрать и донастроить специалисты ML-команды провайдера. Платформа построена на базе GPU-кластеров Managed Kubernetes с использованием открытых инструментов NVIDIA Triton Inference Server, Ray Serve Cluster и Istio Ingress Controller. Решение полностью независимо от привязки к поставщику (vendor lock) и обеспечивает высокую производительность за счёт встроенных возможностей по повышению пропускной способности и максимальной утилизации ресурсов. |

|