Материалы по тегу: облако

|

29.08.2025 [09:20], Владимир Мироненко

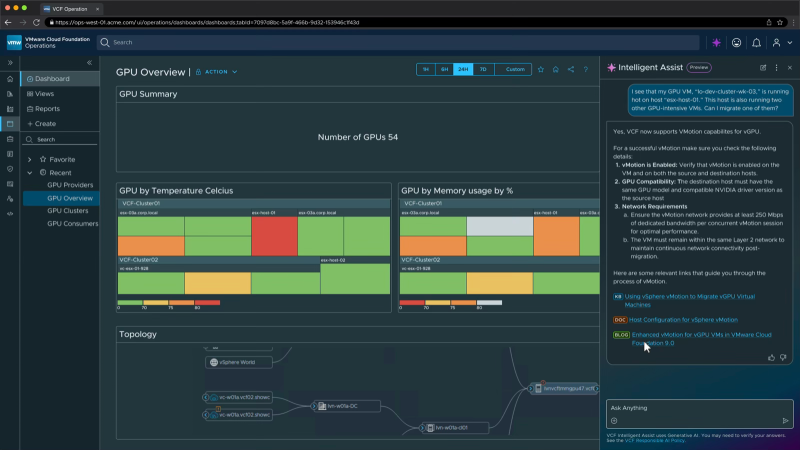

Broadcom расширила инструментарий VCF 9.0, преобразовав её в «унифицированную платформу»Broadcom позиционирует VMware Cloud Foundation (VCF) 9.0 как единую унифицированную платформу, которую можно использовать как для ИИ, так и для других рабочих нагрузок, и с этой целью анонсировала ряд обновлений. Для дальнейшей поддержки ИИ и других ресурсоёмких нагрузок Broadcom объявила о доступности VMware Tanzu Data Intelligence — платформы-хранилища, которая обеспечит унифицированный доступ к разнообразным данным. VMware vSAN получила встроенную поддержку S3-интерфейсов объектного хранилища, что позволит создавать унифицированные политики хранения для блочного, файлового и объектного хранения и снизить сложность инфраструктуры хранения. Компания также интегрировала VCF 9.0 с GitOps, Argo CD и Istio для обеспечения безопасности доставки приложений, используя Git в качестве источника данных для Kubernetes. Теперь разработчики смогут хранить свою инфраструктуру и приложения в виде кода в Git и использовать Argo CD для автоматизации согласованных развёртываний. Кроме того, Istio Service Mesh обеспечивает сетевое взаимодействие с нулевым доверием, управление трафиком и возможность наблюдения для контейнеров. Наряду с VMware Private AI Services платформа VCF 9.0 получила совершенно новый Cyber Compliance Advanced Service — сервис, разработанный для строго регулируемых сред, который обеспечивает улучшенное соответствие кибертребованиям, отказоустойчивость и безопасность платформы для сред VCF. VMware vDefend Security получил новые автоматизированные элементы управления для ускорения внедрения защиты с нулевым доверием, а также расширенные инструменты обнаружения угроз на уровне сети (Network Detection and Response). Также была добавлена функция защиты от бесфайловых атак, использующих PowerShell, VBScript и Jscript. По словам Broadcom, она позволяет проверять и перехватывать вредоносные скрипты до их выполнения, закрывая важнейшую «слепую зону» в кибербезопасности. Avi Load Balancer получил новый инструмент оценки WAF и защиту трафика MCP для агентских рабочих нагрузок. По словам Пола Тернера (Paul Turner), вице-президента по продуктам VMware Cloud Foundation, новые инструменты предоставляют компаниям унифицированный подход к защите инфраструктуры, предотвращению угроз, обеспечению соответствия требованиям и восстановлению после кибератак. Прашант Шеной (Prashanth Shenoy), вице-президент по маркетингу продуктов подразделения VCF, заявил, что ориентация Broadcom на частное облако получила поддержку среди клиентов, особенно среди крупных предприятий и стратегических корпораций. По данным Broadcom, девять из десяти крупнейших компаний из списка Fortune 500 в настоящее время используют VCF. Продажа по всему миру более 100 млн лицензий VCF говорит о значительном доверии к платформе крупных организаций.

28.08.2025 [22:32], Владимир Мироненко

Broadcom интегрировала в VCF ИИ-сервисы и поддержку новейших ускорителей AMD и NVIDIA — всё это будет доступно бесплатноBroadcom объявила об интеграции ИИ-сервисов VMware Private AI в платформу VMware Cloud Foundation (VCF) без дополнительных затрат для клиентов. Компании смогут пользоваться ИИ-функциями в рамках подписки на VCF, начиная с I квартала 2026 года. По словам компании, это упростит и ускорит внедрение новых ИИ-сервисов заказчиков. Некоторые эксперты считают, что дальнейшая модернизации VMware и повышение привлекательности пакета VCF для компаний благодаря интеграции частных ИИ-сервисов могут стать важным шагом для сохранения клиентской базы VMware. Компании получат множество преимуществ: от расширенного планирования инфраструктуры и балансировки нагрузки, предоставляемых с помощью распределенного планировщика ресурсов (DRS), до схем автоматизации, позволяющих развёртывать сложные ИИ-сервисы за считанные минуты, используя оптимизированные драйверы устройств, ядра для конкретных ускорителей и многое другое, обещает Broadcom. VMware Private AI Services помогут компаниям развёртывать и управлять ИИ-приложениями в современной частной облачной инфраструктуре, сохраняя конфиденциальность и безопасность данных. ИИ-сервисы включают среду выполнения моделей, хранилище моделей, мониторинг ускорителей, службу индексации и поиска данных, векторную базу данных, шлюз API и конструктор ИИ-агентов. Целью проекта является создание более интегрированного, безопасного и удобного для разработчиков решения, которое будет выглядеть и работать как публичное облако с точки зрения получения услуг, безопасности и масштабируемости. Это означает большую автоматизацию, больше API и лучшую прозрачность производительности и затрат, отметил ресурс SiliconANGLE. Разработчикам будет помогать генеративный ИИ-помощник VCF Intelligent Assist. Он поможет диагностировать и решить проблемы инфраструктуры, используя базу знаний Broadcom. В дальнейшем будет добавлена функция автоматического исправления ошибок. Broadcom сообщила, что в ближайшее время VCF 9.0 получит поддержку протокола Model Context Protocol (MCP), позволяющего ИИ-агентам подключаться к внешним источникам данных и инструментам и использовать их для совместной работы с другими агентами. Также платформа будет поддерживать функцию Multi-accelerator Model Runtime, которая обеспечивает гибкое развёртывание ИИ-моделей на различном оборудовании, включая ускорители AMD и NVIDIA. Кроме того, клиенты получат многопользовательский доступ к моделям (Multi-tenant Models-as-a-service), что поможет снизить затраты за счёт безопасного доступа арендаторов или отдельных подразделений к общим ИИ-моделям. Broadcom добавила в платформу VCF поддержку оборудования и ПО NVIDIA, в том числе систем Blackwell, включая RTX Pro 6000, и адаптеров ConnectX-7. Также Broadcom заявила о сотрудничестве с AMD, что позволит организациям использовать VCF с ускорителями AMD Instinct серии MI350 и ПО ROCm. Заодно Broadcom объявила о расширенном сотрудничестве с Canonical, благодаря которому клиенты смогут использовать Ubuntu в своих частных облаках с полной корпоративной поддержкой, включая ускоренное управление патчами и повышенную кибербезопасность.

26.08.2025 [13:47], Руслан Авдеев

Crusoe расширит ИИ-мощности в исландском ЦОД atNorth ICE02Crusoe Energy и atNorth объявили о расширении мощностей Crusoe Cloud на 24 МВт в ЦОД ICE02 в Исландии. Дата-центр принадлежит atNorth и работает на «чистой» энергии. Новый проект должен удовлетворить растущий спрос на услуги Crusoe Cloud в Европе и Северной Америке, сообщает пресс-служба Crusoe. Для поддержки новой инициативы Crusoe получила от инвестиционной группы Victory Park Capital (VPC) кредитную линию на $175 млн. Расширение предусматривает использование современных решений NVIDIA, в том числе GB200 NVL72, а также внедрение СЖО. Дата-центр atNorth ICE02 на 100 % снабжается геотермальной энергией и энергией ГЭС. По словам Crusoe, расширения мощностей позволит ускорить удовлетворение «невероятного» спроса на Crusoe Cloud. atNorth сообщает, что в компании рады успехам Crusoe, достигнутым в обслуживании клиентов с использованием её исландского ЦОД. Расширение ICE02 — ключевой этап стратегии развития Crusoe в Европе, реализация которой стартовала в декабре 2023 года. Площадка предлагает доступ к телеком-сетям с низкими задержками и подключение по нескольким подводным кабелям — доступ к ресурсам получат не только европейские клиенты, но и компании из Северной Америки. Расширение регионального присутствия компании также включает и ввод в эксплуатацию недавно анонсированного ЦОД в Норвегии.

Источник изображения: Crusoe Crusoe Cloud представляет собой масштабируемую платформу для выполнения ИИ-задач нового поколения. Crusoe Cloud считается экономичным решением, позволяющим разработчикам и иным IT-специалистам сосредоточиться на инновациях, не уделяя лишнего внимания инфраструктуре. В марте сообщалось, что Crusoe окончательно избавилась от криптобизнеса для концентрации усилий на ИИ-проектах. Тогда же компания привлекла $225 млн на закупку чипов NVIDIA для развития облачной ИИ-инфраструктуры. Компания является одним из ключевых подрядчиков проекта OpenAI Stargate, но попутно развивает и собственное ИИ-облако.

23.08.2025 [12:29], Владимир Мироненко

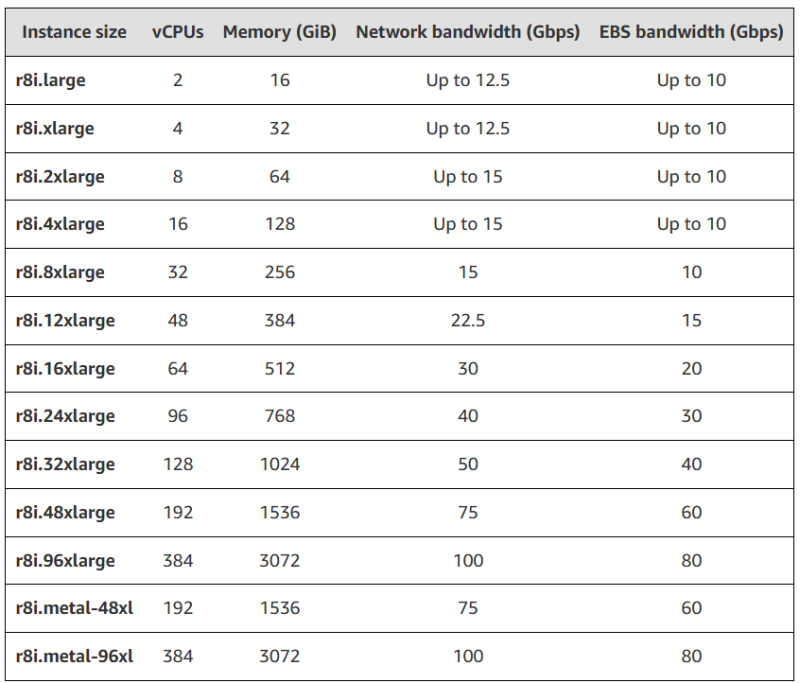

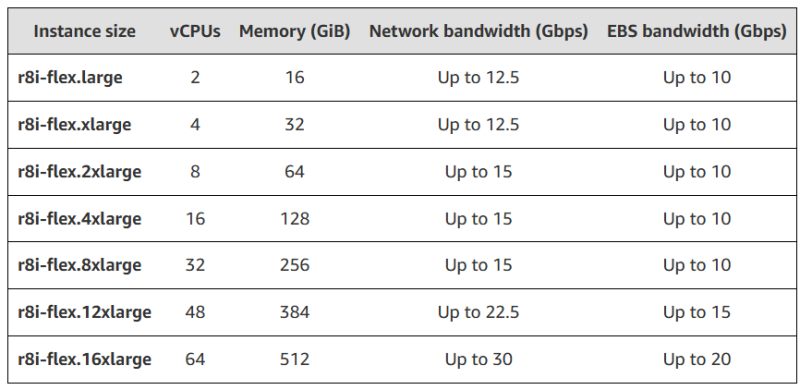

AWS анонсировала инстансы R8i и R8i-flex на кастомных Intel Xeon 6Amazon Web Services объявила об доступности инстансов R8i и R8i-flex, оптимизированных для рабочих нагрузок с интенсивным использованием памяти и базирующихся на кастомных процессорах Intel Xeon 6, доступных только в AWS. По словам компании, эти CPU «обеспечивают самую высокую производительность и самую высокую пропускную способность памяти среди сопоставимых процессоров Intel в облаке». Инстансы R8i и R8i-flex предлагают до 15 % лучшее соотношение цены и производительности и в 2,5 раза большую пропускную способность памяти по сравнению с инстансами предыдущего поколения на базе процессоров Intel. Новинки обеспечивают на 20 % более высокую производительность, чем инстансы R7i, с ещё большим приростом производительности для определённых рабочих нагрузок. Они обеспечивают до 30 % более высокую скорость обработки для баз данных PostgreSQL, до 60 % быстрее работают с NGINX и до 40 % быстрее — с рекомендательными DL-моделями по сравнению с R7i. Инстансы R8i и R8i-flex идеально подходят для различных рабочих нагрузок, требующих больших объёмов памяти, таких как базы данных SQL и NoSQL, распределённые кеши (Memcached и Redis), in-memory СУБД (SAP HANA) и инструменты аналитики больших данных в реальном времени (Apache Hadoop и Apache Spark). R8i-flex — первые оптимизированные для интенсивного использования памяти инстансы Flex — доступны в наиболее распространённых размерах, от L до 16xLarge, и, по словам компании, являются отличным выбором для приложений, которые не используют все вычислительные ресурсы полностью, позволяющим добиться дополнительного 5 % улучшения соотношения цены и производительности при 5 % снижении цен. Инстансы R8i доступны в 13 размерах, включая два bare metal-инстанса и новый экземпляр 96xLarge для самых крупных приложений: 384 vCPU и 3 ТиБ RAM. Инстансы R8i сертифицированы SAP и обеспечивают производительность 142 100 aSAPS, что является самым высоким показателем среди всех сопоставимых машин в локальных и облачных средах. Инстансы R8i и R8i-flex используют карты AWS Nitro шестого поколения с Amazon EBS, что значительно повышает пропускную способность сети для рабочих нагрузок, обрабатывающих небольшие пакеты, таких как веб-серверы, серверы приложений и игровые серверы. Экземпляры R8i и R8i-flex также поддерживают настройку полосы пропускания сети с 25-% корректировкой распределения между внешней сетью и полосой Amazon EBS, что позволяет повысить производительность базы данных, скорость обработки запросов и ведения журнала. Дополнительные улучшения включают поддержку типа данных FP16 в Intel AMX для поддержки ИИ-обучения и инференса. Как отметил ресурс The Register, этот анонс — хорошая новость для Intel, поскольку в эти непростые времена гиперскейлеры являются ключевым клиентом для любого производителя чипов. Инстансы R8i и R8i-flex доступны в регионах AWS: US East (Северная Вирджиния), US East (Огайо), US West (Орегон) и Europe (Испания).

22.08.2025 [11:12], Руслан Авдеев

Meta✴ потратит $10 млрд на ИИ-инфраструктуру в Google CloudMeta✴ намерена потратить более $10 млрд на облачные сервисы Google в течение шести лет, сообщает CNBC со ссылкой на The Information. По словам одного из источников, сделка преимущественно связана с арендой ИИ-инфраструктуры. По данным Reuters, Meta✴ будет использовать серверы Google Cloud, её хранилища данных, сетевые и иные сервисы. Google путается угнаться за более крупными облачными конкурентами вроде AWS и Microsoft Azure. Ранее в этом году она заключила соглашение с OpenAI, которая ранее сильно зависела от Azure, но стала более свободна в выборе облачных партнёров. В июле Alphabet объявила, что подразделение Google Cloud во II квартале принесло $2,83 млрд операционной прибыли за подписки на ПО и инфраструктуру. В то же время выручка в тот же период составила $13,6 млрд, на 32 % больше, чем выручка компании в целом (13,8 %).

Источник изображения: Growtika/unsplash.com В прошлом месяце в отчёте о доходах Meta✴ заявила, что общие расходы в 2025 году составят $114–$118 млрд. Компания активно вкладывает средства ИИ-стартапы, собственные ИИ-модели Llama и иные ИИ-сервисы в своём портфолио услуг. Глава Meta✴ Марк Цукерберг (Mark Zuckerberg) заявил, что компания потратит «сотни миллиардов» долларов на создание огромных ИИ ЦОД. Также компания увеличила минимальную сумму запланированных капитальных затрат на $2 млрд., по итогам года они составят от $66 до $72 млрд. Примечательно, что Google и Meta✴ активно конкурируют на рынке онлайн-рекламы. Тем не менее, Meta✴ нужна буквально вся доступная облачная инфраструктура, до которой она сможет дотянуться, в том числе AWS и Microsoft. Также Meta✴ ищет внешних партнёров для финансирования своих запросов на инфраструктуру для ИИ-проектов. Ранее в этом месяце были раскрыты данные, согласно которым она намерена продать активы своих дата-центров на сумму $2 млрд.

20.08.2025 [16:15], Руслан Авдеев

Fluidstack арендовала 360 МВт у криптомайнера TeraWulf, который частично принадлежит GoogleКриптомайнинговая компания TeraWulf и провайдер ИИ-облака Fluidstack расширили договор аренды, подписанный буквально на прошлой неделе. На тот момент стороны заключили соглашение, предусматривавшее аренду Fluidstack 200 МВт IT-нагрузки (около 250 МВт общей мощности) в кампусе TeraWulf Lake Mariner в Нью-Йорке, а теперь решили добавить ещё 160 МВт, сообщает Datacenter Dynamics. Благодаря очередному расширению законтрактованная мощность увеличилась до 360 МВт, что соответствует $6,7 млрд выручки с потенциалом увеличения до $16 млрд путём дальнейшего развития бизнеса. Для поддержки расширения Google увеличит вливания до $3,2 млрд, доведя свою долю в TeraWulf приблизительно до 14 %. В настоящее время общая мощность кампуса Lake Mariner, расположенного на месте закрытой угольной электростанции, составляет 500 МВт с возможностью расширения до 750 МВт. Изначально кампус был ориентирован на криптомайнинг, но теперь обслуживает ИИ- и HPC-нагрузки. Так, одним из арендаторов кампуса стала Core42 (G42) из ОАЭ. Сделка позволит Fluidstack развернуть 40 МВт IT-нагрузок в I полугодии 2026 года, а 200 МВт будут развёрнуты к концу 2026 года на объектах CB-3 и CB-4. Оставшиеся 160 МВт будут развёрнуты на объекте CB-5, который должен заработать во II полугодии 2026 года. По словам TeraWulf, расширение подчёркивает масштаб и возможности кампуса. Построив CB-5, компания не только увеличит контрактные мощности для Fluidstack, но и укрепит стратегическое сотрудничество с ключевым финансовым партнёром в лице Google для создания ИИ-инфраструктуры нового поколения. Fluidstack основана в 2017 году в Оксфордском университете. Сегодня компания располагает более 100 тыс. ИИ-ускорителей, в число клиентов входят Mistral AI, Character.AI, Poolside и Black Forest Labs. В 2025 году компания объявила о соглашении с Macquarie Group об обеспечение ИИ-мощностями европейских исследовательских лабораторий, занимающихся ИИ-проектами. Кроме того, сообщалось о сотрудничестве с NVIDIA, Borealis и Dell для создания экзафлопсных ИИ-кластеров в Исландии и Северной Европе. В феврале 2025 года Fluidstack подписала меморандум о взаимопонимании с французским правительством, согласно которому она построит во Франции ИИ-суперкомпьютер мощностью 1 ГВт.

17.08.2025 [18:08], Руслан Авдеев

Google потратит $9 млрд на развитие облачной и ИИ-инфраструктуры в Оклахоме — часть пойдёт на обучение электриковКомпания Google взяла обязательство вложить $9 млрд в расширение собственной облачной и ИИ-инфраструктуры на территории штата Оклахома (США). Инвестиции направят на развитие кампуса ЦОД в Стиллуотере (Stillwater) и расширение уже имеющегося объекта в Прайоре (Prior), сообщает Datacenter Dynamics. Часть выделенных средств будет потрачена на программы образования и развития персонала. В марте 2025 года стало известно, что Google подала заявку на строительство кампуса ЦОД в Стиллоутере. Тогда было объявлено, что на него потратят $3 млрд, а площадь кампуса составит более 160 га. Подробных данных о кампусе нет, но согласно проекту плана экономического развития от августа 2024 года, предполагается построить до шести зданий, каждое площадью почти 29 тыс. м2. На каждом этапе строительства предполагается строить по одному ЦОД. Объект в Прайоре Google анонсировала ещё в 2007 году, запуск состоялся в 2011-м. С тех пор дата-центр регулярно расширялся. Университет Оклахомы (University of Oklahoma) и Университет штата Оклахома (Oklahoma State University) готовы участвовать в инициативе Google AI for Education Accelerator. В её рамках можно будет получить сертификаты Google Career Certificates, а также доступ к бесплатным курсам обучения ИИ-навыкам. Также Google финансирует в Оклахоме национальную программу обучения, созданную для подготовки квалифицированных электриков — Electrical Training Alliance.

Источник изображения: Gerson Repreza/unsplash.com Ранее Оклахома никогда не считалась крупным рынком ЦОД и сопутствующих технологий. Среди недавно анонсировавших проекты ЦОД в Оклахоме — компании Cerebras, Damac и CoreWeave с Core Scientific. По слухам, кампус площадью около 138 га готовит и Meta✴. Также есть данные, что в мае подана заявка на строительство кампуса площадью более 200 га в Талсе (Tulsa), но что за компания стоит за проектом, не разглашается.

16.08.2025 [01:23], Владимир Мироненко

Почти 30 тыс. серверов Microsoft Exchange Server оказались уязвимыми из-за нерасторопности администраторовРесурс SiliconANGLE со ссылкой на данные некоммерческой организации Shadowserver Foundation сообщил, что, несмотря на выпущенное Microsoft ещё в апреле этого года обновление ПО, по состоянию на 10 августа у почти 30 тыс. Exchange-серверов по всему миру критическая уязвимость остаётся неисправленной. Уязвимость CVE-2025-53786, имеющая высокую степень опасности (CVSS 8,0 балла из 10), затрагивает Exchange 2016, Exchange 2019 и Exchange Server Subscription Edition в гибридных конфигурациях с Exchange Online. Уязвимость позволяет злоумышленникам с правами администратора локального сервера повышать привилегии в подключённой облачной среде, что потенциально ставит под угрозу весь домен. «В гибридном развёртывании Exchange злоумышленник, который сначала получает административный доступ к локальному серверу Exchange, может потенциально повысить привилегии в облачной среде организации, что сложно выявить», — указано в предупреждении Microsoft. По данным Shadowserver Foundation, по состоянию на 10 августа с этой уязвимостью в Сети нашлось 29 098 серверов Exchange. Больше всего их было выявлено в США (более 7200), за ними следуют Германия (6700) и Россия (2500), ещё тысячи уязвимых серверов находятся во Франции, Великобритании, Австрии и Канаде. Агентство по обеспечению инфраструктурной и кибербезопасности (CISA) США выпустило 7 августа экстренную директиву 25-02 (Emergency Directive 25-02) для федеральных агентств, обновлённую 12 августа, с требованием немедленного принятия мер. Агентствам было предписано провести инвентаризацию сред Exchange с помощью Microsoft Health Checker, отключить от интернета неподдерживаемые Exchange Server или SharePoint Server, не говоря уже о прекращении использования устаревших версий. Также предписано установить исправление и последние накопительные обновления, и применить рекомендации Microsoft по использованию специального гибридного приложения для замены небезопасных субъектов общих служб. Упомянутое в руководстве CISA исправление относится к обновлению, выпущенному Microsoft в апреле, которое тогда было представлено как архитектурное изменение для повышения безопасности гибридной идентификации. Сама Microsoft официально задокументировала уязвимость только 6 августа с последним обновлением от 13 августа. «Это серьёзная уязвимость Exchange, и специалисты по безопасности должны немедленно обратить на неё внимание», — сообщил ресурсу SiliconANGLE Томас Ричардс (Thomas Richards), директор по безопасности инфраструктуры компании Black Duck Software. Он пояснил, что установки патча на сервер недостаточно, и, поскольку обнаружение взлома затруднено, Microsoft предоставила командам по безопасности план необходимых действий, чтобы убедиться, что все скомпрометированные токены будут заменены. «Это крайне важно для полного устранения уязвимости и обеспечения беспрепятственного доступа к ПО. CISA предупреждает, что если система не будет обновлена, возможна полная компрометация Exchange и Active Directory. Компрометация может оказать негативное влияние на бизнес-операции», — добавил эксперт.

15.08.2025 [16:25], Сергей Карасёв

Квартальная выручка Beeline Cloud выросла год к году более чем на четверть«Билайн» отрапортовал о работе во II четверти текущего года: выручка по операционной деятельности достигла 80,55 млрд руб., что на 6,7 % больше по сравнению с результатом за аналогичный период прошлого года, когда компания получила 75,47 млрд руб. Чистая прибыль «Билайна» в период с апреля по июнь включительно составила 4,32 млрд руб. Для сравнения, годом ранее были зафиксированы чистые убытки в размере 1,13 млрд руб. Показатель EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений) в годовом исчислении поднялся на 8,8 % — c 33,11 млрд до 36,03 млрд руб. Компания продолжает быстро развивать облачную платформу Beeline Cloud: выручка по данному направлению по сравнению со II кварталом 2024 года подскочила на 27 % (абсолютное значение не раскрывается). Среди значимых событий отчётного периода названы запуск Beeline Cloud 2.0 с интеллектуальным оркестратором VEGA3, получение трёх международных сертификатов ISO/IEC (27001, 27017 и 27018), а также обеспечение доступности маркетплейсов для клиентов за рубежом с помощью выделенных серверов в Китае, Турции и Белоруссии. В течение квартала были отражены около 32 тыс. DDoS-атак. Сформирован метрокластер, объединивший два дата-центра в отказоустойчивое облако. Помимо этого, модернизирован Ярославский ЦОД. «Билайн» продолжает развивать инфраструктуру связи. Во II четверти 2024 года количество базовых станций увеличилось на 8,7 %, или на 18 тыс. единиц, по сравнению с тем же периодом прошлого года. Объём трафика данных вырос на 11,2 %, а доля VoLTE в голосовом трафике — на 10,9%. Введены в эксплуатацию магистральные каналы волоконно-оптической линии связи суммарной ёмкостью 1,6 Тбит/с по двум ключевым маршрутам транзита международного трафика — южному и восточному. Первый проходит через Европу, Россию, Грузию, Армению, Турцию и доходит до границ со странами Ближнего Востока. Восточный маршрут пролегает через Казахстан в сторону Китая.

14.08.2025 [13:57], Руслан Авдеев

Windows 365 Reserve предложит на время облачный ПК на случай проблем с физическимПользователи Windows 11 смогут пользоваться виртуальными копиями своих компьютеров в облаке в случае поломки ПК. Компаниям предлагается доступ к виртуальным машинам в облаке Azure, если откажет железо или программное обеспечение, сообщает The Register. По словам Microsoft, в условиях постоянного подключения к Сети сбой даже одного устройства может негативно сказаться на работе всей организации, что снизит производительность, создаст дополнительную нагрузку на IT-отделы и др. Как заявляют в компании, если возможные сбои умножить на тысячи сотрудников, последствия станут «колоссальными». Для тех, кто хочет сохранить работоспособность IT-инфраструктуры в любых условиях, предлагается сервис Windows 365 Reserve. Он позиционируется как современное, безопасное и масштабируемое решение, помогающее сотрудникам сохранять продуктивность и быть на связи даже в непредвиденных обстоятельствах. Сервис предназначен для бизнес-пользователей, при этом подписка Reserve не связана с основным продуктом Windows 365.

Источник изображения: Jonathan Borba/unspalsh.com Клиенты могут получить доступ к «временному, безопасному и выделенному облачному ПК», пользоваться которым можно будет до 10 дней, если основная машина выйдет из строя. Виртуальные машины размещаются на облачной платформе Microsoft и управляются через Microsoft Intune, так что их можно предварительно настроить для быстрого развёртывания. Проблема в том, что для использования такого облачного ПК всё равно потребуется ещё одно устройство, имеющее хотя бы рабочий веб-браузер — желательно… ещё один ПК. Ещё одно препятствие для пользователей Windows 365 Reserve — проблема «масштабирования» в случаях, когда неудачное обновление, атака вируса или другая масштабная проблема одновременно оставит без возможности использовать традиционные ПК сразу несколько пользователей. В Microsoft признают, что Windows 365 Reserve ограничен ёмкостью облака Azure и, конечно, требует сетевого подключения для использования виртуального ПК. Пока желающие протестировать Windows 365 Reserve могут подать заявку для доступа к закрытой бета-версии. Участвовать могут только избранные: клиенты Microsoft, MVP-эксперты или партнёры компании, у которых есть лицензии Windows E3, Intune и Azure Active Directory P1 (AADP1). Участники бета-теста Windows 365 Reserve должны выполнить набор тестовых сценариев — как для администраторов, так и для конечных пользователей, предоставив обратную связь о своём опыте использования нового сервиса. Соискателям с одобренными заявками будет предоставлен бесплатный доступ к платформе на срок до 12 недель. |

|