Материалы по тегу: software

|

23.05.2024 [15:33], Андрей Крупин

Вышел коммерческий релиз MaxPatrol Carbon — решения для подготовки IT-инфраструктуры к отражению кибератакРоссийская компания Positive Technologies, специализирующаяся на разработке решений в сфере информационной безопасности, сообщила о выпуске на рынок программного комплекса MaxPatrol Carbon, помогающего организациям подготовить IT-инфраструктуру к отражению атак и обеспечивающего непрерывный контроль её киберустойчивости. MaxPatrol Carbon анализирует уровень защищённости компании и прогнозирует на базе экспертных данных о действиях злоумышленников возможную активность хакера. Исходя из полученной информации, продукт формирует практические рекомендации для ИБ-служб, своевременное выполнение которых повысит защиту IT-инфраструктуры, не позволит злоумышленнику добраться до критически важных активов или существенно усложнят его путь.

Архитектура решения «Для обеспечения результативной кибербезопасности компаниям необходимо поддерживать IT-инфраструктуру в постоянной готовности к отражению атак. Это обязательное условие, чтобы злоумышленник не смог скомпрометировать критически важные системы за считанные минуты. Мы видим потребность рынка в принципиально новых решениях, которые обеспечат непрерывность бизнес-процессов в условиях растущего числа кибератак», — прокомментировал коммерческий релиз продукта Михаил Стюгин, руководитель направления автоматизации информационной безопасности Positive Technologies. Комплекс MaxPatrol Carbon зарегистрирован в реестре отечественного ПО и может использоваться для импортозамещения продуктов зарубежных разработчиков.

23.05.2024 [07:19], Владимир Мироненко

ГК Softline открыла представительство в ОАЭ для выхода на рынки Ближнего ВостокаГК Softline (ПАО «Софтлайн»), поставщик решений и сервисов в области цифровой трансформации и информационной безопасности, объявил об открытии представительства — центра экспертизы в Дубае (ОАЭ). В дальнейшем это позволит компании предлагать отечественные ИТ-решения и услуги на всём Ближнем Востоке. В рамках анонсированной стратегии международной экспансии ГК Softline открыла до этого представительство в Республике Казахстан для развития сотрудничества с центрально-азиатскими компаниями в целях продвижения собственных продуктов, отраслевых решений и экспертизы, а также решений российских вендоров в этом регионе. На всех новых рынках компания планирует использовать единый подход, обеспечивая полный комплекс ИТ-услуг, включая внедрение, техническое сопровождение и поддержку. Softline планирует в новых регионах и открытие новых представительств, и увеличение штата.

Источник изображения: softline.ru Выбор направлений для расширения был сделан на основе собственных исследований, а также аналитической информации из таких источников, как АНО «Цифровая экономика», РУССОФТ, экспортные центры и торговые представительства. Страны ЕАЭС, Ближнего Востока, Юго-восточной Азии и Индия считаются у отечественных разработчиков одними из приоритетных регионов международного развития. Сейчас в этих регионах нет какого-либо системного игрока, ориентированного на продвижение российских ИТ-решений с полноценным сопровождением и реализацией проектов. Таким игроком намерена стать Softline. По словам директора по международному развитию бизнеса ГК Softline, наибольший потенциал компания видит в своей экспертизе в области кибербезопасности и бизнес-решениях на основе ИИ, компьютерного зрения и IoT: «Мы формируем диверсифицированный экспортный портфель, опирающийся как на собственные разработки ГК, так и на высокую экспертизу наших специалистов по различным решениям и продуктам ведущих отечественных производителей, что позволит нам предложить заказчикам и партнёрам данного региона гибкий и при этом комплексный подход в реализации стоящих перед ними задач». На прошлой неделе ГК Softline сообщила неаудированные консолидированные финансовые результаты I квартала 2024 года. За отчётный период валовая прибыль компании выросла более чем в 3 раза год к году, составив 7,8 млрд руб., а оборот увеличился на 52 % до 21,5 млрд руб. При этом скорректированная EBITDA продемонстрировала более чем десятикратный рост до 1,8 млрд руб.

22.05.2024 [22:00], Сергей Карасёв

Selectel создаст собственную отечественную ОС на базе Linux-дистрибутива Debian 12 и выйдет на рынок инфраструктурного ПОSelectel объявила о планах по выходу на рынок инфраструктурного ПО. Первым проектом в данной сфере станет создание собственной ОС корпоративного класса на базе Linux. На сегодняшний день о находящейся в разработке платформе известно не слишком много. По имеющейся информации, Selectel создаёт дистрибутив на базе Debian 12. Официальный анонс ОС запланирован на конец 2024 года. Продукт, как утверждается, позволит обеспечить всестороннюю поддержку инфраструктуры компаний-клиентов благодаря контролю над версиями установленного ПО, а также оперативному исправлению технических ошибок. В состав платформы войдут инструменты резервного копирования, виртуализации и управления базами данных. Кроме того, говорится о наличии перспективных решений в таких сферах, как ИИ, машинное обучение и Big Data. Платформа, как отмечается, подойдёт клиентам с собственной или арендованной IT-инфраструктурой. Среди потенциальных заказчиков названы организации из финтех- и банковской сфер, ретейлеры, IT-разработчики и пр. Selectel предоставит вместе с лицензированной ОС полноценную техническую поддержку. Это особенно актуально для тех организаций, которые не располагают своим штатом IT-специалистов или регулярно сталкиваются со слабым уровнем обслуживания имеющихся систем.  «Новая операционная система станет удобным решением для компаний, для которых критичным является высокая надёжность и стабильность работы коммерческого ПО, а также оперативное и квалифицированное решение технических вопросов. Продукт также актуален для организаций, которым важно подтвердить факт использования российского лицензионного ПО», — говорит заместитель генерального директора по разработке и эксплуатации продуктов Selectel. Новые ОС на базе Linux создают и другие игроки, которые ранее подобными проектами не занимались. Например, дистрибутив Platform V SberLinux OS Server, позволяющий, как говорят разработчики, импортозаместить зарубежные серверные ОС корпоративного уровня на основе Red Hat Enterprise Linux (RHEL), развивает «СберТех», дочерняя структура «Сбера». При этом ещё год назад представитель «Ростелекома» отмечал, что на российском рынке есть множество сходных или дублирующихся продуктов: «У нас 19 Linux, 12 систем виртуализации, три национальные мобильные ОС». Возможно, процесс консолидации продуктов крупными IT-игроками коснётся и рынка ОС.

22.05.2024 [12:54], Сергей Карасёв

Поставщик данных для обучения ИИ Scale AI привлёк $1 млрдСтартап Scale AI, основанный в 2016 году, объявил о проведении раунда финансирования Series F, в ходе которого привлекла $1 млрд, а оценка компании составила $13,8 млрд. Сложные ИИ-модели обучаются на огромных массивах данных, для сбора и подготовки которых может потребоваться много времени. Scale AI предоставляет облачный сервис Generative AI Data Engine, который ускоряет и упрощает этот процесс. Клиенты Scale AI указывают, данные какого типа им необходимы для обучения ИИ-моделей, после чего стартап занимается подготовкой соответствующих наборов. Кроме того, платформа Scale AI упрощает задачу разметки данных. Поддерживается работа с текстовой информацией, изображениями и аудиоматериалами, а также более специализированными данными, такими как журналы датчиков (лидаров) беспилотных автомобилей.

Источник изображения: Scale AI Scale AI также предоставляет ряд дополнительных услуг. В их число входит сервис проверки новый сетей на наличие уязвимостей, галлюцинаций и других проблем. Для организаций государственного сектора компания разработала чат-бота Donovan, который рассчитан на работу с конфиденциальной информацией. Программу финансирования Series F возглавила Accel. Кроме того, средства предоставили существующие инвесторы — Y Combinator, Nat Friedman, Index Ventures, Founders Fund, Coatue, Thrive Capital, Spark Capital, NVIDIA, Tiger Global Management, Greenoaks и Wellington Management. В число новых инвесторов вошли Cisco Investments, DFJ Growth, Intel Capital, ServiceNow Ventures, AMD Ventures, WCM, Amazon, Elad Gil и Meta✴. Полученные деньги будут направлены на улучшение существующих продуктов и развитие новых проектов.

19.05.2024 [21:14], Александр Бенедичук

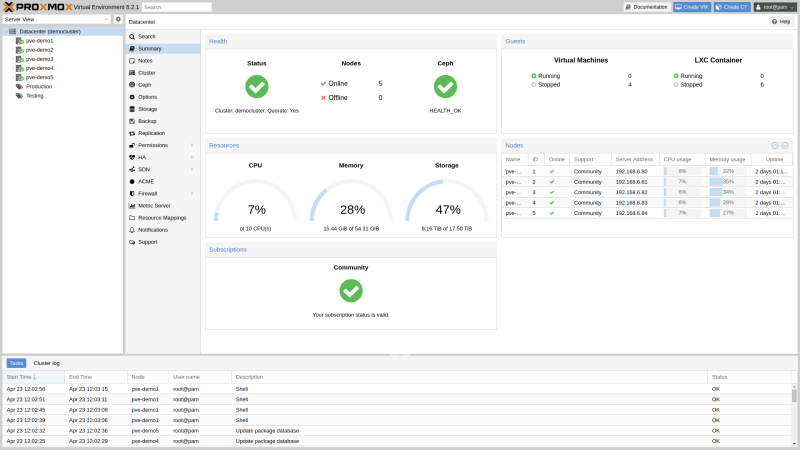

Veeam обзаведётся поддержкой Proxmox VEКомпания Veeam Software объявила о скором внедрении поддержки сред Proxmox VE. Таким образом, будут расширены возможности платформы данных Veeam, уже поддерживающей различные среды, включая VMware vSphere, Microsoft Hyper-V, Nutanix AHV, Oracle Linux Virtualization Manager, Red Hat Virtualization и основные облачные сервисы, такие как AWS, Azure и Google Cloud. Ожидается, что поддержка Proxmox VE станет доступна в III квартале 2024 года. Proxmox VE становится популярнее не только в результате совершенствования продукта, но и из-за изменения политики лицензирования и партнёрской программы VMware после её поглощения компанией Broadcom, вызвавшее отток клиентов. Кроме того, необходимость в средствах виртуализации с низкими уровнем вхождения и стоимостью владения (TCO) испытывают всё больше предприятий малого и среднего бизнеса. Veeam видит в этом возможность увеличить свою долю на рынке. Ключевыми особенностями поддержки Proxmox VE от Veeam являются неизменяемые резервные копии, которые защищают данные от атак программ-вымогателей, а поддержка расширенного отслеживания изменений (CBT) и режима оперативного добавления копий повысит производительность резервного копирования и минимизирует простои, говорит компания. Также отмечается поддержка функции Veeam BitLooker, которая оптимизирует использование хранилища, исключая из резервных копий неиспользуемые блоки, различные варианты хранения резервных копий, возможность полного восстановления виртуальных машин с различных платформ, в том числе облачных, в среде Proxmox VE (и наборот), тонкое управление гранулярностью восстановления и т.д.

19.05.2024 [20:33], Владимир Мироненко

WekaIO стала «единорогом» с рыночной стоимостью $1,6 млрдКомпания WekaIO (WEKA), разработчик платформы хранения данных WEKA Data Platform, объявила о завершении раунда финансирования серии Е, в ходе которого она привлекла $140 млн инвестиций и получила статус «единорога», поскольку её рыночная стоимость по итогам раунда оценивается в $1,6 млрд. Общий объём инвестиций в компанию на данный момент составляет $375 млн. Как сообщает WEKA, раунд прошёл с превышением подписки (объём предлагаемых инвестиций превысил ожидания) с продажей акций на первичном и вторичном рынках. Раунд возглавила уже ранее инвестировавшая в компанию Valor Equity Partners. По условиям сделки основатель, гендиректор и директор по инвестициям Valor Антонио Грасиас (Antonio Gracias) войдёт в совет директоров WEKA. Также в раунде участвовали другие существующие инвесторы, включая Generation Investment Management, NVIDIA, Atreides Management, 10D, Hitachi Ventures, Ibex Investors, Key1 Capital, Lumir Ventures, MoreTech Ventures и Qualcomm Ventures.

Источник изображения: WekaIO Согласно пресс-релизу, привлечённые средства увеличат денежные резервы компании, ускорят масштабирование бизнеса и позволят расширить разработку продуктов, а также предоставят ликвидность сотрудникам WEKA. Компания отметила, что переживает период стремительного роста — более 300 крупнейших в мире ИИ-проектов используют платформу WEKA Data Platform. «Недавнее ускорение внедрения генеративного ИИ и всё более частое использование компаниями облаков спровоцировали резкий рост спроса, что привело к беспрецедентному количеству сделок с восьмизначным ARR (годовой регулярный доход) — впечатляющий результат, если учесть, что WEKA — это бизнес в области ПО», — отметил финансовый директор компании. Он заявил, что сейчас подходящее время для укрепления денежных резервов компании, это позволило инвесторам увеличить свои позиции в ней, одновременно сведя к минимуму размывание акций сотрудников Как сообщается, платформа WEKA Data Platform может быть развёрнута в любом месте. Она обеспечивает беспрецедентную скорость, простоту, масштабируемость и устойчивость для GPU-вычислений, ИИ и других ресурсоёмких рабочих нагрузок. Согласно данным маркетплейса AWS, WEKA Data Platform идеально подходит для ресурсоёмких рабочих нагрузок, таких как ИИ и машинное обучение, финансовое моделирование, медико-биологические исследования, рендеринг, Big Data.

17.05.2024 [23:25], Владимир Мироненко

Microsoft начала веерные остановки подписок на свои облачные продукты для российских корпоративных клиентовMicrosoft начала отключать российских корпоративных клиентов от своих облачных продуктов, сообщила ГК Softline в Telegram-канале для клиентов. «Microsoft, судя по всему, утвердил список продуктов к отключению. Со вчерашнего вечера начались веерные остановки подписок в CSP, партиями отключают по 5–10 заказчиков. Под остановку попали подписки Power BI, Visio, Project», — уведомила клиентов компания, пообещав делиться свежей информацией по этому поводу в режиме 24/7. Ещё в марте появились сообщения о получении российскими корпоративными клиентами Microsoft уведомлений компании о том, что 20 марта будут прекращены подписки «на определённое программное обеспечение для управления или проектирования (включая облачные решения) для организаций, зарегистрированных в России» в связи со вступлением в силу санкций ЕС в отношении России.

Источник изображения: efes/Pixabay Однако этого не произошло. Более того, как сообщило ТАСС, Microsoft тогда не только не заблокировала доступ российским заказчикам к своим продуктам, но и продолжала продлевать лицензии. По словам источника агентства, это было абсолютно ожидаемым в связи с нежеланием Microsoft терять российский рынок и клиентскую базу. По неофициальной информации, которой поделилась в марте ГК Softline, список подлежащих блокировке продуктов включает Azure (в том числе Azure Stack) и все компоненты Microsoft 365. Также назвали возможной деактивацию развёрнутых локально Microsoft Office, SQL Server, BizTalk Server, System Center, Visual Studio. Согласно данным ТАСС, Microsoft может заблокировать доступ к программам для управления бизнес-процессами, корпоративного учёта, автоматизации, бизнес-анализа, управления проектами и IT-средой, совместной работы, мониторинга сервисов, к приложениям для сотрудников и для планирования ресурсов предприятия. Также сообщается, что продукты для физических лиц компания отключать не будет.

16.05.2024 [23:59], Владимир Мироненко

3Logic локализует в России китайскую платформу Gitee и перенесёт 100 тыс. open source проектов3Logic Group объявила о создании платформы gitee.ru для хостинга репозиториев ИT-проектов и их совместной разработки, которая позволит отечественным разработчикам и компаниям использовать ПО китайской платформы gitee.com — крупнейшего китайского репозитория ПО с открытым исходным кодом. В создании участвуют входящая в структуру 3Logic Group компания Xellon, специализирующаяся на заказной локализацией китайских ИТ-решений, а также компания Open Source China, создавшая крупнейший в Китае и второй по величине в мире сервис хостинга репозиториев, содержащий 28 млн проектов, в числе пользователей которого более 12 млн разработчиков и 100 тыс. компаний Китая. Как сообщается в пресс-релизе, платформа gitee.ru развёрнута в дата-центре в Москве. В настоящее время ведётся работа по локализации и адаптации сервиса для России, а также разработка инструментов двухсторонней синхронизации репозиториев с gitee.com. Проводится глубокая локализация интерфейсов и сервисов gitee.com, а также наиболее популярных китайских проектов. Команда 3Logic Group локализует документацию по ним, текущие открытые задачи и описания сферы применения ПО. Поставлена задача разместить до конца года на gitee.ru 100 тыс. локализованных проектов с открытым исходным кодом. Платформа будет предоставлять как бесплатные, так и платные услуги хостинга и работы с репозиториями кода. Оплата будет производиться с использованием российских платёжных систем. Сервис предоставит российским корпоративным заказчикам возможность использовать наиболее передовые open source проекты из Китая, в частности, в области LLM и ИИ. Руководитель проекта gitee.ru компании Xellon, заявил, что было принято решение не создавать репозиторий с нуля, а «выстраивать его вокруг уже существующей экспертизы и большого сообщества». Он отметил, что в Китае разработка ПО на основе open source находится на «высочайшем уровне», а «наш проект, с одной стороны, предлагает российским командам и разработчикам хранить свой код на российской инфраструктуре, с другой стороны, иметь доступ к наработкам и выстраивать взаимодействие с китайскими коллегами». Как отметил «Коммерсантъ», в России за последние годы уже появилось несколько отечественных репозиториев, и у экспертов есть сомнения в том, что крупный бизнес захочет использовать китайский открытый код, опасаясь возможных рисков. Кроме того, платформа, по мнению экспертов, вряд ли будет признана российской, что закроет ей доступ в ряд секторов.

16.05.2024 [01:15], Владимир Мироненко

МТС вложит в облачную платформу MWS 7,5 млрд рублейМТС сообщила о планах своей дочерней компании MWS (MTS Web Services), которой будут переданы все облачные сервисы CloudMTS, ЦОД-инфраструктура МТС, а также некоторые ИБ-сервисы МТС RED. До конца этого года MWS, как ожидается, запустит целый ряд новых сервисов и направлений и займётся разработкой обновлённой публичной облачной платформы, в создание которой до конца 2025 года будет вложено более 7,5 млрд руб. Публичная облачная платформа MWS задумана как экосистема инфраструктурных и сетевых сервисов, инструментов для хранения и обработки данных, PaaS и решений для защиты облачной инфраструктуры собственной разработки. Её создание ведётся в соответствии со стандартами информационной безопасности и защиты персональных данных, говорит компания. Согласно планам MWS, платформа станет доступной для бизнеса и пользователей в 2025 году. MWS также работает над усилением собственной информационной безопасности, для чего интегрирует в своё облако ряд сервисов МТС RED. Решения МТС RED будут обеспечивать защиту всех облачных сервисов компании, включая не связанные с кибербезопасностью, например, инфраструктурных, сетевых, бизнес-приложений, сред разработки и т.д. Как утверждает компания, это сделает миграцию в облако ещё более безопасной.

Источник изображения: MWS Планы MWS на этот год также включают запуск более 30 новых продуктов Enterprise-уровня, в числе которых сервисы по хранению, вычислению и информационной безопасности, базы данных, сетевые и корпоративные сервисы, приложения для разработчиков. Также будет развёрнут выделенный сегмент облака полностью на российском софте и оборудовании. В 2024 году MWS планирует запустить ещё одно новое направление — ИИ-облако. Оно будет включать виртуальную инфраструктуру с ускорителями, специализированное ПО для разработки, обучения и развертывания ML-моделей, уже готовые ИИ-модели для разных индустрий и направлений, доступные по API, и ИИ-сервисы по модели SaaS. Кроме того, в случае необходимости заказчику будет предоставлена команда экспертов на всех этапах внедрения и использования ИИ. А для удовлетворения растущего спроса GPU-мощности компании будут увеличены в два раза. Для решения особых ИТ-задач бизнеса будет создано подразделение Professional Services, специалисты которого помогут клиентам провести аудит ИТ-инфраструктуры и ИБ-решений предприятия, составить стратегию их облачного развития, а также провести миграцию в выделенный сегмент виртуальной инфраструктуры и взять на себя поддержку гибридных и частных инсталляций. При этом специалисты будут привлекать и интегрировать в облако партнёрские решения по модели SaaS в самых разных отраслях.

15.05.2024 [15:37], Андрей Крупин

«Ростех» и «Ростелеком» объединят компетенции в области информационной безопасностиГоскорпорация «Ростех» и компания «Ростелеком» заключили соглашение о сотрудничестве в сфере информационной безопасности. Подписанный документ предусматривает совместную работу профильных центров компетенций в области защиты данных: со стороны «Ростелекома» — это группа компаний «Солар», со стороны государственной корпорации «Ростех» — компания «РТ-Информационная безопасность». В рамках сотрудничества планируется реализация совместных проектов в сфере ИБ, а также обмен данными об актуальных киберугрозах. Стороны договорились о совместном продвижении своих решений, продуктов и технологий на российском и зарубежных рынках, в том числе в целях импортозамещения и обеспечения технологического суверенитета.

Источник фото: пресс-служба «Солар» / rt-solar.ru Также компании намерены обмениваться опытом в области построения систем кибербезопасности, актуальными сведениями об инцидентах и индикаторах компрометации. Отдельное внимание будет уделено проведению совместных киберучений с использованием баз знаний о реальных атаках на защищаемые объекты, особенно относящихся к критической информационной инфраструктуре. «Злоумышленники действуют всё более изощренными методами, угрозы в киберпространстве растут в геометрической прогрессии, что требует от нас адекватно наращивать возможности для противодействия. Консолидация компетенций «Ростеха» и «Ростелекома» поможет не только повысить готовность цифровой инфраструктуры к отражению кибератак, но и даст импульс дальнейшему развитию отрасли информационной безопасности в России», — заявил генеральный директор госкорпорации «Ростех» Сергей Чемезов. |

|