Материалы по тегу: hardware

|

10.05.2024 [13:53], Владимир Мироненко

Lenovo установит в Италии 1,2-Пфлопс суперкомпьютер Cassandra на базе Intel Xeon Max для климатических исследованийКомпания Lenovo сообщила о возобновлении сотрудничества с Европейско-Средиземноморским центром по изменению климата (CMCC), базирующимся в Лечче (Италия), и подписании контракта на установку в этом году новой мощной системы высокопроизводительных вычислений (HPC) Cassandra, предназначенной для исследования изменения климата с помощью повышенных вычислительных возможностей и оптимизации использования энергии. Cassandra включает 180 узлов SD650 V3 с двумя процессорами Intel Xeon Max 9480 (Sapphire Rapids с HBM) на узел и имеет пиковую FP64-производительность 1,2 Пфлопс. Благодаря использованию технологии жидкостного охлаждения Lenovo Neptune Direct Water-Cooling, способной отводить до 98 % тепла, Cassandra потребляет на 15 % ниже электроэнергии, чем аналогичные решения с воздушным охлаждением. Благодаря повышенной эффективности СЖО температура процессоров не достигает критических значений, что позволяет избежать снижения максимальной частоты ядер процессоров, говорит Lenovo. Установкой Cassandra в суперкомпьютерном центре CMCC (SCC) будет заниматься Ricca IT, сертифицированный партнёр Lenovo. В суперкомпьютерном центре CMCC уже имеется HPC-система от Lenovo под названием Juno, установленная в 2022 году, с FP64-производительностью около 1,13 Пфлопс и построенная на базе процессоров Intel и ускорителей NVIDIA. Cassandra будет использоваться для климатического моделирования системы Земли, океана, работы как глобальных, так и региональных систем сезонного прогнозирования, а также запуска приложения по исследованию изменения климата на основе ИИ. CMCC также планирует интегрировать во II полугодии в суперкомпьютер два ИИ-узла с восемью ускорителями NVIDIA H100 в каждом.

10.05.2024 [11:32], Сергей Карасёв

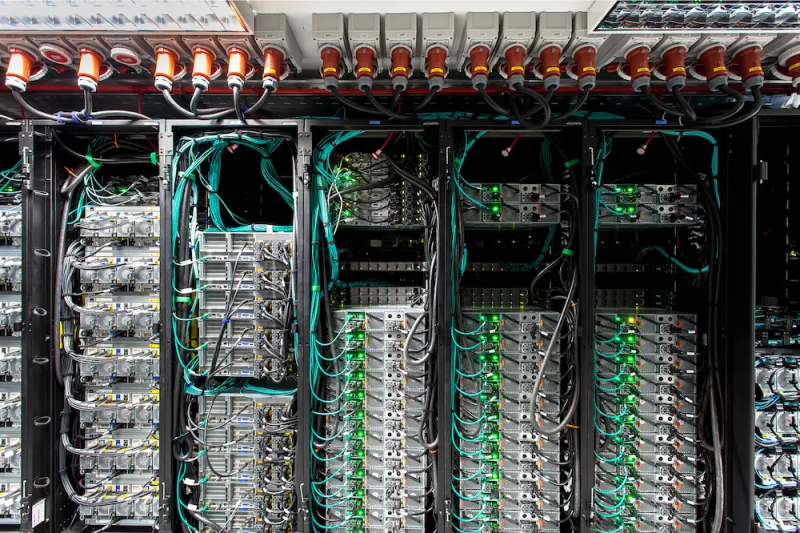

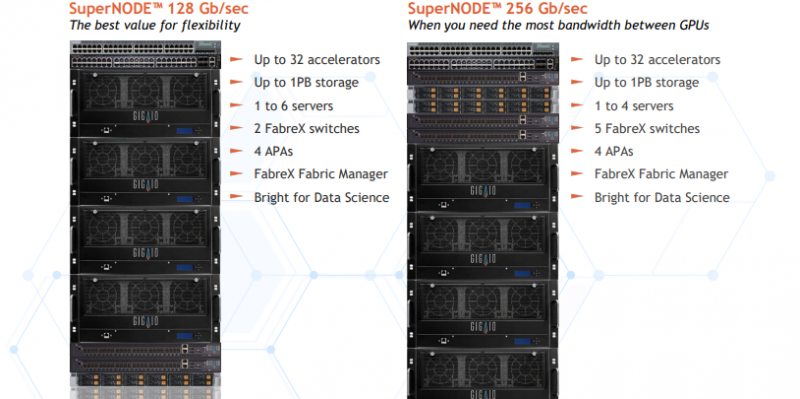

Суперкомпьютер в стойке GigaIO SuperNODE обзавёлся поддержкой AMD Instinct MI300XКомпания GigaIO анонсировала новую модификацию системы SuperNODE для рабочих нагрузок генеративного ИИ и приложений НРС. Суперкомпьютер в стойке теперь может комплектоваться ускорителями AMD Instinct MI300X, благодаря чему значительно повышается производительность при работе с большими языковыми моделями (LLM). Решение SuperNODE, напомним, использует фирменную архитектуру FabreX на базе PCI Express, которая позволяет объединять различные компоненты, включая GPU, FPGA и пулы памяти. По сравнению с обычными серверными кластерами SuperNODE даёт возможность более эффективно использовать ресурсы. Изначально для SuperNODE предлагались конфигурации с 32 ускорителями AMD Instinct MI210 или 24 ускорителями NVIDIA A100. Новая версия допускает использование 32 изделий Instinct MI300X. Утверждается, что архитектура FabreX в сочетании с технологией интерконнекта AMD Infinity Fabric наделяет систему SuperNODE «лучшими в отрасли» возможностями в плане задержек при передаче данных, пропускной способности и управления перегрузками. Это позволяет эффективно справляться с обучением LLM с большим количеством параметров.

Источник изображения: GigaIO Отмечается, что SuperNODE значительно упрощает процесс развёртывания и управления инфраструктурой ИИ. Традиционные конфигурации обычно включают в себя сложную сеть и необходимость синхронизации нескольких серверов, что создаёт определённые технических сложности и приводит к дополнительным временным затратам. Конструкция SuperNODE с 32 мощными ускорителями в рамках одной системы позволяет решить указанные проблемы.

09.05.2024 [23:04], Руслан Авдеев

Дело — труба: Microsoft заключила со Stockholm Exergi крупнейшую в мире сделку по захвату углекислоты прямо из выхлопа ТЭСКомпания Stockholm Exergi объявила о подписании с Microsoft крупнейшей в мире сделки по прямому захвату углерода. Datacenter Dynamics сообщает, что соглашение предусматривает удаление 3,33 млн тонн углекислого газа в Швеции в рамках проекта Värtan BECCS в Стокгольме. Для сравнения — выбросы корпорации в 2022 году составили 13 млн тонн CO2. BECCS предусматривает захват и постоянное хранение CO2, выделяющегося в ходе процессов преобразования биомассы в топливо или её сжигания для получения энергии. В данном случае под биомассой подразумеваются обыкновенные древесные пеллеты. Такой подход считается достаточно экологичным, поскольку деревья являются возобновляемым ресурсом и в процессе роста сами поглощают углекислый газ. Однако добиться полного захвата CO2 при их сжигании не представляется возможным. Как заявляют в Stockholm Exergi, Värtan BECCS чрезвычайно важен — внедрение технологий на существующих электростанциях на биомассе является ключевым этапом на пути создания мощностей по удалению углерода по всему миру. Финансирование проекта предусматривается в том числе из Инновационного фонда Европейского союза, но для достижения приемлемых финансовых результатов потребуются дополнительные доходы от продажи модулей для удаления углерода. Сделка сроком 10 лет вступит в силу в 2028 году, после чего каждый год Stockholm Exergi будет удалять из атмосферы до 800 тыс. тонн CO2. Разрешение от природоохранных регуляторов было получено ещё в марте 2023 года, строительство мощностей для захвата углекислоты, сжижения полученного газа и его промежуточного хранения должно начаться в 2025 году. Впрочем, Stockholm Exergi заявила, что финальное решение об инвестициях планируется принять в IV квартале 2024 года. В проектах захвата углерода Microsoft часто является ключевым инвестором, поскольку компания намерена добиться не только «углеродной нейтральности», но и со временем компенсировать выбросы, которые приходятся на её деятельность за всю историю существования бизнеса. Компания уже заключила несколько сделок, связанных с использованием биоугля и, в частности, соглашение с Carbon Streaming о покупке кредитов с биоугольной площадки в Вирджинии. Также IT-гигант участвует и в других «зелёных» проектах по захвату угля, включая сделку на 300 тыс. тонн с Heirloom и на 10 тыс. тонн с Climeworks, также занимающейся прямым захватом углерода. Кроме того, на неизвестных условиях заключена сделка об удалении углекислоты из атмосферы с Carbon Capture. Microsoft не одинока в своих начинаниях. В захват углерода уже инвестировали и компании вроде Meta✴ и Google.

09.05.2024 [15:13], Руслан Авдеев

Microsoft построит на месте неудавшегося завода Foxconn в Висконсине кампус ЦОД за $3,3 млрдПосле того, как компании Foxconn не удалось наладить крупное производство на площадке в Маунт-Плезант (Висконсин, США), её передали Microsoft для строительства кампуса ЦОД общей стоимостью $3,3 млрд, передаёт The Register. Получив налоговые льготы на сумму в $3 млрд, Foxconn так и не смогла ими воспользоваться — проект не отвечал требованиям штата, например, по количеству созданных рабочих мест. Компанию даже поймали на подтасовке статистики путём найма сотрудников с последующим увольнением сразу после подачи отчётности. К 2021 году объём планируемых инвестиций сократился до $672 млн, а налоговые льготы — до $80 млн. Впрочем, Foxconn так и не удалось реализовать амбициозный проект — инициатива по созданию 13 тыс. рабочих мест провалилась, было снесено порядка 100 домов и ферм, а на подготовку площадки совершенно зря ушло $500 млн средств налогоплательщиков. Компания смогла сформировать только небольшое производство серверов. В 2023 году участок в 400 га, предназначавшийся для строительства завода, приобрела Microsoft. Здесь компания намерена построить кампус ЦОД, модернизировать местную инфраструктуру и совместно с Университетом Висконсина создать центр AI Co-Innovation Lab для внедрения машинного обучения в процессы автоматизации и обучения 100 тыс. местных жителей генеративным ИИ-технологиям вроде Copilot. Дополнительно компания намерена подготовить и сертифицировать 3 тыс. местных разработчиков ИИ-систем и 1 тыс. техников для обслуживания ЦОД. Строительство началось в конце 2023 года. Ранее местные СМИ писали минимум о четырёх дата-центрах на территории кампуса. В Microsoft попытались развеять страхи, что кампус будет потреблять слишком много энергии — компания работает с National Grid над строительством в Висконсине солнечной электростанции на 250 МВт, последняя должна заработать в 2027 году. Также Microsoft намерена использовать замкнутую систему жидкостного охлаждения для большей части мощностей на площадке, которая будет потреблять воду только во время очень жаркой погоды. Ранее Microsoft попала в неприятности в окрестностях Финикса (Аризона), где её фактически заставили отказаться от испарительного охлаждения. Что касается трудоустройства, планы у Microsoft даже близко не столь масштабные, как были у Foxconn: бизнес из Редмонда рассчитывает задействовать 2,3 тыс. человек в строительстве к 2025 году и сформировать 2 тыс. постоянных рабочих мест.

09.05.2024 [13:56], Сергей Карасёв

Ippon представила однофазные ИБП серии Novus мощностью до 10 кВтКомпания Ippon анонсировала однофазные источники бесперебойного питания (ИБП) семейства Novus с чистой синусоидой на выходе. Утверждается, что устройства надёжно обеспечивают стабилизированное питание для важного оборудования. В серию вошли модели Novus 6K, Novus 6KL и Novus 10K с двойным преобразованием. Первые две версии характеризуются полной мощностью 6 кВА и активной мощностью 5,4 кВт. Решения обладают высокой адаптацией к широкому диапазону входного напряжения и частот, включая CVCF (компенсацию коэффициента мощности). Это позволяет использовать ИБП в различных условиях, а также способствует снижению энергопотребления. В свою очередь, модификация Novus 10K имеет полную мощность в 10 кВА и активную мощность в 9 кВт. Данное устройство предлагает высокий уровень надёжности, стабильности и эффективности, что «делает его отличным выбором для обеспечения бесперебойного электропитания в различных промышленных и коммерческих приложениях», говорит компания. Решения Novus 6K и Novus 10K оборудованы необслуживаемыми герметичными свинцово-кислотными аккумуляторами. Время заряда с 0 % до 90 % составляет около 7 часов. Модификация Novus 6KL не имеет установленных батарей в комплекте. Все новинки наделены дисплеем, который позволяет контролировать состояние ИБП и получать информацию о его работе, включая уровень заряда батареи, нагрузку, ошибки и предупреждения. Номинальное напряжение — 220/230/240 В. КПД в линейном режиме составляет 94 %, в режиме ECO — 98 %. Предусмотрена защита от короткого замыкания, от высоковольтных выбросов, а также от перегрузок в линейном режиме, режиме работы от батареи и режиме работы автоматического байпаса. Имеется интерфейс RS232. ИБП могут эксплуатироваться в температурном диапазоне от 0 до +40 °C. Устройства выполнены в соответствии со стандартом IP20.

09.05.2024 [13:47], Сергей Карасёв

Против «дочки» HPE в России поданы новые иски на десятки миллионов рублейПротив ООО «Хьюлетт паккард энтерпрайз», российской структуры Hewlett Packard Enterprise (HPE), как сообщает IT Channel News, поданы сразу несколько новых исков. Они связаны с прекращением деятельности американской корпорации на рынке РФ. На фоне ухода из России «дочка» HPE не выполнила обязательства по договорам и осталась должна партнёрам миллиарды рублей. В частности, дистрибутор OCS Distribution (ООО «О-си-эс-центр») заявил требования на 1,44 млрд руб. и на 551 млн руб. Оба иска были полностью удовлетворены, однако «Хьюлетт паккард энтерпрайз» подала апелляцию. Позднее стороны пришли к мировому соглашению.

Источник изображения: pixabay.com Кроме того, против российской «дочки» НРЕ поданы иски со стороны ООО «Компания Комплит» на сумму 4 859 645,7 руб. и 8 516 746,17 руб. (частично или полностью удовлетворены), ООО «Треолан» на сумму 653 291 714,32 руб. (производство по делу прекращено), ООО «Компинтегро» на сумму 2 035 715,33 руб. (полностью отклонён) и ООО «Марвел КТ» на сумму 1 092 729 542,5 руб. (производство по делу прекращено). Как теперь стало известно, в суд на «Хьюлетт паккард энтерпрайз» подали ещё три компании. Так, ООО «МКТ» («Марвел-Дистрибуция») обратилось с исковым требованием на 24 775 089,8 руб. Кроме того, направлены иски от ООО «Про фактор» на 7 805 627,14 руб. и ООО «Системный софт» на 1 209 985,31 руб. Между тем ООО «Хьюлетт Паккард Энтерпрайз» продолжает деятельность в РФ. В 2023 году компания получила выручку в размере 351 млн руб., что на 2,1 млрд руб. или на 85,7 % меньше результата годичной давности. По состоянию на 31 декабря 2023-го совокупные активы организации составляли 7 млрд руб. — на 1,7 млрд руб. (на 19,1 %) меньше, чем годом ранее.

08.05.2024 [20:20], Владимир Мироненко

SoftBank не прочь приобрести тонущего разработчика ИИ-чипов GraphcoreЯпонская компания SoftBank Group Corp. ведёт переговоры о приобретении переживающего финансовые проблемы британского Graphcore Ltd., разработчика ИИ-ускорителей IPU, сообщил Bloomberg со ссылкой на информированные источники. По их словам, переговоры длятся уже несколько месяцев, но финансовые условия всё ещё не определены и нет никаких гарантий, что будет достигнуто окончательное соглашение. В сентябре 2023 года Financial Times сообщала, что SoftBank сделала предварительное предложение о покупке Graphcore, которое стартап отклонил. SoftBank имеет контрольный пакет акций в другом британском разработчике микросхем, Arm Holdings, объявившем в феврале о хороших перспективах расширения своего бизнеса на рынке ИИ-чипов. С тех пор акции Arm выросли примерно на 40 %.

Источник изображения: Graphcore Основанная в 2016 году компания Graphcore из Бристоля представила в 2020 году серверные ИИ-ускорители IPU (Intelligence Processing Unit). По словам Graphcore, её чипам вполне под силу составить конкуренцию NVIDIA. В числе её инвесторов такие компании, как Samsung Electronics, Bosch и Sequoia Capital. После раунда финансирования в 2020 году стоимость Graphcore оценивалась в $2,8 млрд. Но с тех пор британской компании так и не удалось набрать необходимые обороты и сейчас она активно ищет финансирование, чтобы остаться на плаву на фоне роста убытков из-за сокращения продаж. Как сообщил в феврале ресурс Bloomberg News, переговоры начались в тот время, когда основатель SoftBank Масаёси Сон (Masayoshi Son) решил запустить собственный проект в сфере ИИ стоимостью до $100 млрд, чтобы бросить вызов NVIDIA. SoftBank притормозила инвестиции в технологический сектор в 2022 году, но в конце 2023 года решила вернуться к заключению новых сделок, делая ставку на ИИ. Масаёси Сон представил это как стратегию, ориентированную на бизнес Arm.

08.05.2024 [18:07], Руслан Авдеев

Американский ИИ-стартап Iozera намерен построить в Марокко 386-МВт дата-центрТехасская компания Iozera.ai объявила о строительстве дата-центра ёмкостью в 386 МВт в Марокко. По данным Datacenter Dynamics, реализация проекта Eureka Park обойдётся в $500 млн. Стартап предлагает услуги по хранению, управлению и предобработке данных для ИИ, а также консалтинг в соответствующей сфере. Подписываемый с властями страны меморандум о взаимопонимании предусматривает не только создание ЦОД, но и ИИ-хаба в Тетуане, в непосредственной близости от Гибралтарского пролива. Стратегическое партнёрство рассчитано на «демократизацию» доступа к передовыми ИИ-ресурсам и расширение возможностей доступа к ним учёных, стартапов и предприятий. Строительство начнётся в IV квартале 2024 года, площадка должна будет готова к работе во II квартале 2026-го. Технической информации о проекте практически нет, но планируемая ёмкость в 386 МВт ставит его вровень с некоторыми крупнейшими дата-центрами гиперскейлеров. Энергия, вероятно, будет поступать из двух «зелёных» источников — солнечной электростанции Noor Solar Power Complex и ветроэлектростанции Koudia Al Baida Wind Farm.

Источник изображения: Kamal Bilal/unsplash.com Примечательно, что Iozera была основана только в декабре 2023 года и опыта строительства дата-центров у неё нет. На подписании меморандума с властями будет присутствовать представитель тайваньской Pegatron, поэтому не исключено, что техногигант тоже имеет интерес в этом деле Рядом с ЦОД разместятся инкубатор для ИИ-стартапов Eureka Park, образовательный центр Ryse Research и экспозиция AI Expo. Рынок ЦОД Марокко в мировом масштабе очень невелик (всего 21 дата-центр), но согласно мартовскому докладу Research and Markets, опубликованному в марте, за следующие три года он вырастет до $51 млн. Недавно N+One Datacenters сообщила, что занималась строительством объекта в Касабланке, а в марте Oracle заявила, что запускает марокканский облачный регион в рамках облачной инфраструктуры N+One.

08.05.2024 [17:48], Сергей Карасёв

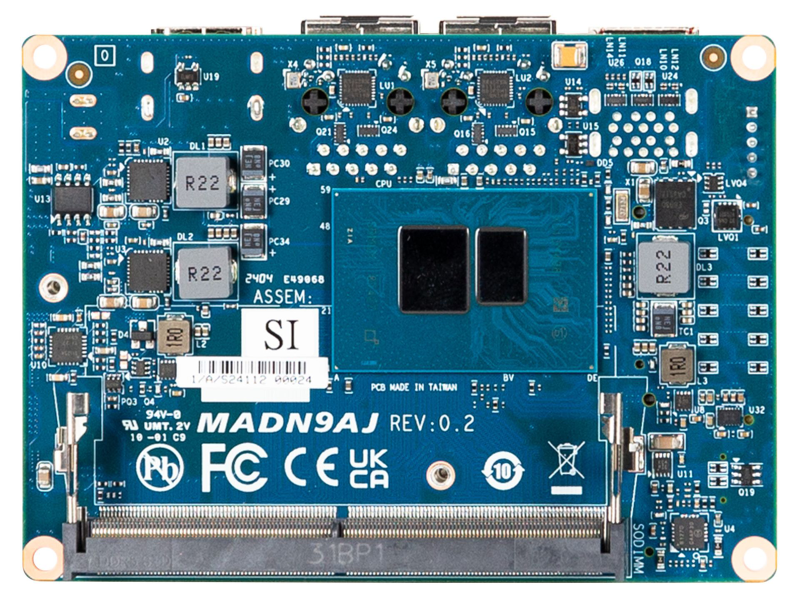

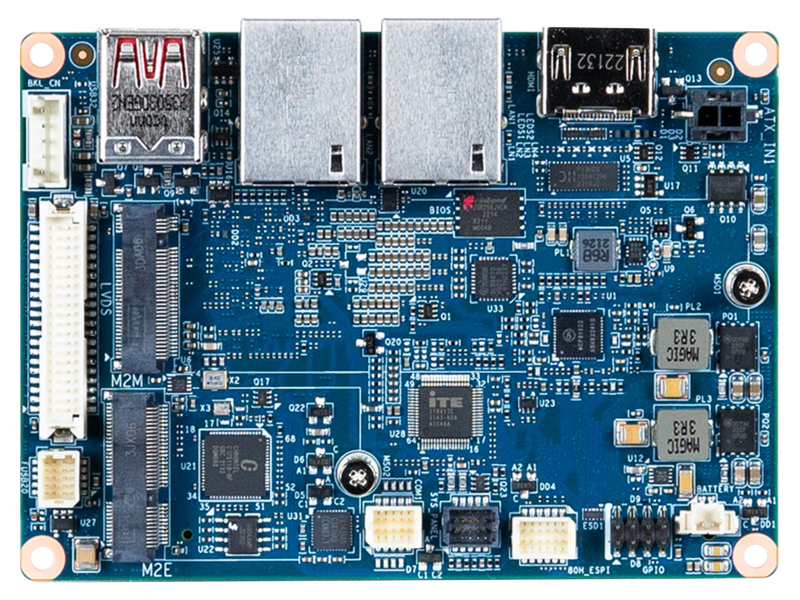

Одноплатный компьютер GigaIPC PICO-N97A на базе Intel Alder Lake-N выполнен в формате Pico-ITXКомпания GigaIPC, подразделение Gigabyte, представила одноплатный компьютер PICO-N97A для приложений Industry 4.0: новинка предназначена для построения различных устройств для умного города, сектора здравоохранения, ретейл-сферы и пр. В основу положена аппаратная платформа Intel Alder Lake-N. Изделие выполнено в формате Pico-ITX с размерами 100 × 72 мм. Установлен чип Intel Processor N97 (4C/4T; до 3,6 ГГц; 12 Вт), работающий в тандеме с оперативной памятью DDR5-4800, объём которой может достигать 16 Гбайт (один слот SO-DIMM). Имеется коннектор M.2 2280 для SSD с интерфейсом PCIe x2 или SATA-3. Новинка оснащена двумя сетевыми портами 1GbE на базе неназванного контроллера Realtek (гнёзда RJ-45), разъёмом M.2 2230 E-Key (PCIe x1; USB 2.0) для комбинированного адаптера Wi-Fi / Bluetooth, двумя портами USB 3.0. Изображение может выводиться через интерфейсы HDMI 2.0 (4096 × 2160@60) и LVDS (1920 × 1200@60). Поддерживается подключение двух независимых дисплеев. Через коннекторы на плате можно задействовать последовательный порт RS-232/422/485, два порта USB 2.0 и пр. Напряжение питания — 12 В (подаётся через 2-контактный коннектор). Одноплатный компьютер располагает чипом TPM 2.0 (Infineon SLB9670VQ2.0) для обеспечения безопасности. Диапазон рабочих температур простирается от 0 до +60 °C. Для изделия предусмотрено использование пассивного охлаждения.

08.05.2024 [17:31], Руслан Авдеев

Рурский университет предложил сохранять тепло ЦОД в заброшенной шахте, чтобы зимой использовать его для отопления домовТепло расположенного в Бохуме (Германия) ЦОД планируется хранить в заброшенной шахте и в дальнейшем использовать в районной системе отопления. По данным Datacenter Dynamics, проект местного Рурского университета призван продемонстрировать потенциал теплоаккумулятора Mine Thermal Energy Storage (MTES). Проект финансируется в рамках поддерживаемой Евросоюзом схемы PUSH-IT, рассматривающей подземные объекты в качестве экоустойчивых хранилищ энергии. Университет управляет собственной теплоэлектростанцией с 2019 года. Станция имеет два комбинированных тепловых/электрических модуля общей мощностью 9 МВт и три газовых котла с общей теплоотдачей 105 МВт. ТЭС не только обогревает университетский кампус, но обеспечивает энергией 5 тыс. квартир, 760 частных домов и 115 промышленных зданий. Оператором выступает Unique Wärme — совместное предприятие университета и коммунальной компании Stadtwerke Bochum, частично принадлежащей местным властям. При этом энергомодули расположены непосредственно над шахтой Мансфельд (Mansfeld) глубиной до 120 м, которая была закрыта в 1963 году. MTES позволит летом отправлять избыточное тепло дата-центра и других технических объектов университета в подземные глубины с помощью тепловых насосов. Там оно будет храниться в скважинах, откуда его по мере необходимости можно возвращать в систему отопления, когда спрос особенно высок, т.е. зимой. MTES, как ожидается, может увеличить использование источников возобновляемой энергии и сгладить пиковые нагрузки в системе отопления в зимние месяцы. Это, в частности, приведёт к снижению углеродных выбросов и стоимости эксплуатации. По данным координаторов PUSH-IT, MTES пока находится на стадии разработки, а создание экспериментальных скважин предусмотрено осенью. Похожий проект разрабатывается в стенах Эдинбургского университета, где «мусорное» тепло суперкомпьютерного ЦОД также предлагается сохранять в старой шахте до того, как использовать его для отопления местных домов. Такая схема позволит обогревать не менее 5 тыс. домов, если расчёты учёных подтвердятся. Впрочем, воду из подземных выработок можно использовать и просто для охлаждения дата-центров. |

|