Материалы по тегу: ff

|

22.06.2025 [23:30], Руслан Авдеев

Meta✴ ведёт переговоры о покупке венчурного фонда NFDG, у которого есть собственный ИИ-кластер AndromedaMeta✴ Platforms решила обновить свои компетенции в сфере ИИ, наняв ведущих отраслевых игроков — Ната Фридмана (Nat Friedman) и Дэниэла Гросса (Daniel Gross). Также компания намерена выкупить их венчурный фонд NFDG, сообщает The Information. Марк Цукерберг (Mark Zuckerberg) сначала пытался купить ИИ-стартап Safe Superintelligence (SSI) бывшего «главным учёным» OpenAI Ильи Суцкевера (Ilya Sutskever). После отказа Цукерберг попросту собрался нанять генерального директора SSI — Гросса. Ранее тот руководил ИИ-разработками в Apple и был партнёром Y Combinator. Фридман был главой GitHub и советником Midjourney. Гросс и Фридман были соучредителями инвестиционного фонда NFDG. NFDG имеет доли в в известных ИИ-компаниях, включая SSI, Perplexity и Character.ai. Ранее компания инвестировала в Weights & Biases, которую приобрела CoreWeave. NFDG занимается не только финансированием компаний, но и предлагает программу грантов, в рамках которой стартапам предоставляется финансирование на $250 тыс., а также $250 тыс. в виде облачных кредитов Microsoft Azure. В период дефицита ИИ-ускорителей NFDG построил собственный суперкомпьютер. Кластер Andromeda изначально включал 2512 ускорителей NVIDIA H100. С тех пор он вырос до 3 200 H100 в 400 узлах и ещё 432 H100 в 54 узлах, связанных 400G-интерконнектом InfiniBand, а также 768 A100 с 200G InfiniBand. Теперь Andromeda могут арендовать и компании, которые не относятся к NFDG, за $2,4–$3 за ускоритель в час. Сейчас можно арендовать до 2 тыс. H100 и получить доступ к ним в течение нескольких часов.

Источник изображения: Amina Atar/unspalsh.com Помимо возможного найма Гросса и Фридмана, Meta✴ ведёт переговоры, конечной целью которых является выкуп значительной части активов NFDG и вывод из него партнёров за сумму более $1 млрд. При этом сделка не даст Meta✴ контроля над фондом или информации о бизнесе. Кому достанется Andromeda, не уточняется. Если сделка будет завершена, она войдёт в число более масштабных реформ в Meta✴, связанных с ИИ. Цукерберг планирует сформировать новую лабораторию по разработке «суперинтеллекта» и пересмотреть стратегию выкупа продуктов. В этом месяце Meta✴ уже подтвердила, что намерена потратить порядка $14 млрд на долю в Scale AI, специализирующейся на разметке данных для обучения ИИ.

20.06.2025 [12:21], Сергей Карасёв

Kioxia анонсировала 61,44-Тбайт SSD CD9P для ИИ-серверов с PCIe 5.0Компания Kioxia анонсировала SSD семейства CD9P, предназначенные для использования в дата-центрах. Накопители будут предлагаться в двух вариантах исполнения — U.2 толщиной 15 мм и EDSFF E3.S. В первом случае вместимость достигает 61,44 Тбайт, во втором — 30,72 Тбайт. В основу новинок положены чипы флеш-памяти 3D BiCS FLASH TLC 8-го поколения. Применена технология CBA (CMOS direct Bonded to Array), которая, как утверждает Kioxia, значительно повышает энергоэффективность, производительность и плотность хранения данных по сравнению с решениями предыдущего поколения, одновременно удваивая максимально возможную ёмкость SSD. Для подключения служит интерфейс PCIe 5.0 (NVMe 2.0, NVMe-MI 1.2c). Заявленная скорость последовательного чтения информации достигает 14,8 Гбайт/с, скорость последовательной записи — 7 Гбайт/с. Показатель IOPS при произвольном чтении (4 КиБ / QD512) составляет до 2,6 млн, при произвольной записи (4 КиБ / QD32) — до 750 тыс. Накопители способны выдерживать до 1 полной перезаписи в сутки (1 DWPD) в варианте для интенсивного чтении и до трёх перезаписей в исполнении для смешанных нагрузок (3 DWPD).

Источник изображения: Kioxia SSD, как отмечается, поддерживают стандарт CNSA 2.0 (Commercial National Security Algorithm Suite) — это набор криптографических алгоритмов, обнародованный Агентством национальной безопасности США (NSA) в качестве замены алгоритмам криптографии NSA Suite B. Таким образом, накопители поддерживают постквантовую криптографию, устойчивую к атакам будущих квантовых компьютеров.

14.06.2025 [17:04], Владимир Мироненко

Scale AI получила от Meta✴ более $14 млрд, но потеряла гендиректора и рискует лишиться крупных контрактов с Gooogle, Microsoft, OpenAI и xAIИИ-стартап Scale AI, занимающийся подготовкой, оценкой и разметкой данных для обучения ИИ-моделей, объявил о крупной инвестиционной сделке с Meta✴, по результатм которой его рыночная стоимость превысила $29 млрд. Сделка существенно расширит коммерческие отношения Scale и Meta✴. Также её условиями предусмотрен переход гендиректора Scale AI Александра Ванга (Alexandr Wang) и ещё ряда сотрудников в Meta✴. Вместо Ванга, который останется в совете директоров стартапа, временно исполняющим обязанности гендиректора Scale AI назначен Джейсон Дроги (Jason Droege), директор по стратегии, имеющий «20-летний опыт создания и руководства знаковыми технологическими компаниями, включая Uber Eats и Axon». Представитель Scale AI уточнил в интервью ресурсу CNBC, что Meta✴ вложит в компанию $14,3 млрд, в результате чего получит в ней 49-% долю акций, но без права голоса. «Мы углубим совместную работу по созданию данных для ИИ-моделей, а Александр Ванг присоединится к Meta✴ для работы над нашими усилиями по созданию суперинтеллекта», — рассказал представитель Meta✴. Переманивая Ванга, который не имея опыта в R&D, сумел с нуля создать крупный бизнес в сфере ИИ, гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) делает ставку на его организаторские способности, полагая, что укрепить позиции Meta✴ в сфере ИИ под силу опытному бизнес-лидеру, больше похожему на Сэма Альтмана (Sam Altman), чем на учёных, стоящих у руля большинства конкурирующих ИИ-лабораторий, пишет Reuters. Инвестиции в Scale AI станут вторыми по величине в истории Meta✴ после приобретения WhatsApp за $19 млрд. Однако сделка может оказаться не совсем выгодной для Scale AI, предупреждает Reuters, поскольку многие компании, являющиеся клиентами Scale AI, могут отказаться от дальнейшего сотрудничества из-за опасений по поводу того, что Ванг, оставаясь в совете директоров стартапа, будет предоставлять Meta✴ внутреннюю информацию о приоритетах конкурентов. Представитель Scale AI заверил, что инвестиции Meta✴ и переход Ванга не повлияют на клиентов стартапа, и что Meta✴ не будет иметь доступа к его какой-либо деловой информации или данным. Тем не менее, по словам источников Reuters, Google, один их крупнейших клиентов Scale AI, планирует разорвать отношения со стартапом. Источники сообщили, что Google планировала потратить $200 млн только в этом году на услуги Scale AI по подгтовке и разметке данных людьми. После объявления о сделке поисковый гигант уже провёл переговоры с несколькими конкурентами Scale AI. Scale AI получила в 2024 году размере $870 млн, из них около около $150 млн от Google, утверждают источники. По их словам, другие крупные клиенты, включая Microsoft, OpenAI и xAI, тоже планируют отказаться от услуг Scale AI. Официальных подтверждений этой информации пока не поступало. А финансовый директор OpenAI заявил в пятницу, что компания, которой источники тоже приписывают намерение отказаться от услуг Scale AI, продолжит работать со стартапом, как с одним из своих многочисленных поставщиков данных.

04.06.2025 [12:40], Руслан Авдеев

Мета✴ выкупила всю энергию атомной станции на 20 лет вперёдКрупнейший в США оператор атомных станций Constellation Energy договорился с Meta✴ Platforms о продаже электричества с АЭС Clinton Clean Energy Center в Иллинойсе — внедрение ИИ способствует резкому росту спроса на электроэнергию. Meta✴ подписала соглашение о закупках 1,121 ГВт сроком на 20 лет, начиная с 2027 года, когда истечёт срок действия государственной субсидии, сообщает Bloomberg. Акции Constellation выросли на 9,1% во вторник, как и акции других атомных компаний, включая Vistra (5,1 %) и Oklo (12 %). Финансовые подробности не разглашаются, но после вступления соглашения в действие вся энергия АЭС будет отдана Meta✴. В рамках сделки Constellation намерена инвестировать в увеличение выработки энергии в округе Клинтон (Clinton), где расположена АЭС. Рассматриваются планы строительства там же ещё одного реактора, разрешение федеральных властей уже получено. Meta✴ активно заключает контракты на новые поставки электроэнергии после того, как её энергопотребление выросло почти втрое с 2019 по 2023 гг. Чуть более года назад AWS приобрела у Talen Energy Corporation кампус Cumulus Data при АЭС Susquehanna в Пенсильвании (США). В прошлом году Microsoft подписала с Constellation договор на возобновление работы АЭС Three Mile Island в Пенсильвании и поставки с неё электричества исключительно для питания ЦОД. Constellation владеет и другими атомными электростанциями, в своё время получившими субсидии от государства, время действия которых истекает в ближайшие годы. Сейчас ведутся переговоры о сделках, сходных с соглашением с Meta✴. Они могут быть закрыты в течение 6–12 месяцев. По мнению экспертов, участие Meta✴ могло бы помочь Constellation с новым реактором, что способствовало бы развитию всей отрасли. Сделка с Meta✴ знаменует значительные изменения для АЭС в Клинтоне. Ранее владевшая станцией компания Exelon грозила закрыть объект в 2017 году, поскольку на тот момент приходилось активно конкурировать с генераторами на дешёвом природном газе и возобновляемой энергетикой. Компания передумала после того, как Иллинойс одобрил субсидию сроком на 10 лет. По данным экспертов, это крупнейшая энергетическая сделка Meta✴. Компания проявляет всё больший интерес к атомной энергетике, в декабре прошлого года она объявила, что рассмотрит предложения на 4 ГВт. Пока получено порядка 50 предложений, в т.ч. от Constellation. Вропчем, эта инициатива направлена на получение электричества в начале 2030-х годов, а сделка, касающаяся АЭС в Клинтоне, рассчитана уже на краткосрочную перспективу. После сделки с Meta✴ появилась гарантия стабильных продаж энергии в течение 20 лет. Это даст Constellation возможность подойти к расширению там мощностей в будущем. Ядерная энергетика — одна из отраслей, выигравших от взлёта спроса на электричество, связанного со взрывным развитием ИИ. Хотя дата-центры активно используют и солнечную,и ветряную энергию, поставки электричества с АЭС более стабильны (как и поставки угольных и газовых электростанций). Дополнительное преимущество атомной энергетики в том, что объекты не имеют углеродных выбросов. Хотя IT-гиганты проявляют большой интерес к новым реакторам, генерирующие компании опасаются вкладывать много средств в АЭС после того, как в 2024 году компания Southern Co. завершила проект Vogtle в Джорджии, опоздав на несколько лет и более чем вдвое превысив бюджет. Хотя на электричество тратится лишь малая часть от связанных с ИИ и ЦОД компаний, огромный спрос на энергию с их стороны означает, что они играют огромную роль в стимулировании спроса на электричество, буквально на все доступные ресурсы, а не только АЭС, в том числе — на газовую энергетику. Уже в прошлом году отмечался рост спроса на электричество, а выбросы Microsoft выросли на 30 %, Google — почти на 50 % в сравнении предыдущими годами. В Microsoft признали, что развитие её ИИ- ставит под угрозу цель превращения в «углеродно-отрицательную» компанию к 2030 году, это же грозит и Meta✴.

01.06.2025 [02:06], Сергей Карасёв

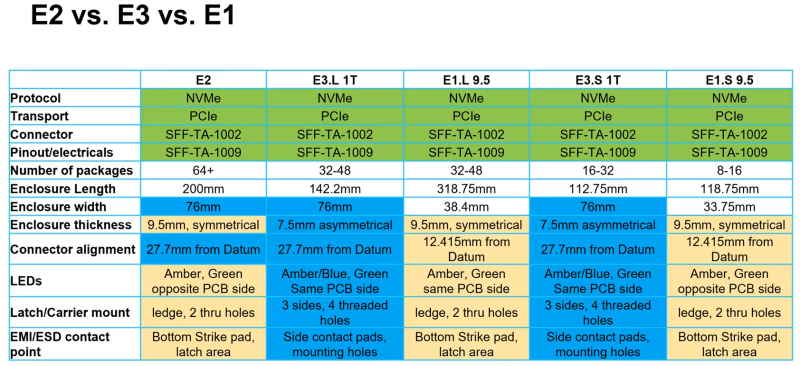

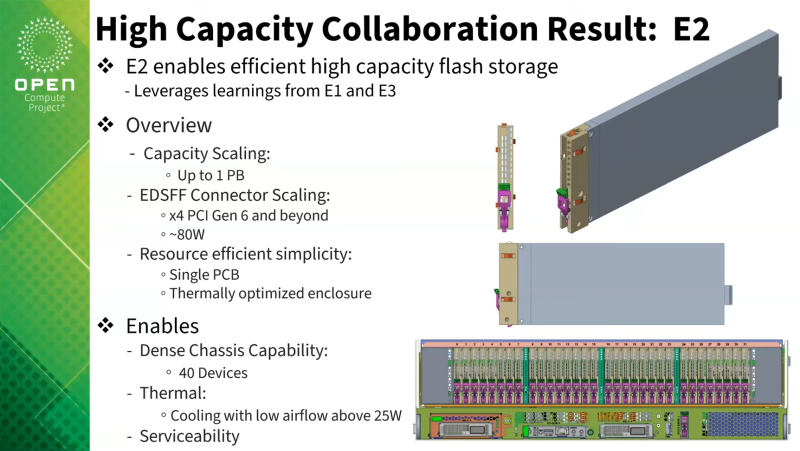

Петабайтные E2 SSD готовы со временем потеснить HDD в ЦОДОрганизации Storage Networking Industry Association (SNIA) и Open Compute Project (OCP), по сообщению ресурса StorageReview, разработали новый форм-фактор твердотельных накопителей, получивший обозначение E2. Устройства данного типа будут обладать большой вместимостью, достигающей 1 Пбайт. Для сравнения, Seagate поставила себе цель довести ёмкость HDD до 100 Тбайт к 2030 году, тогда как Pure Storage уже подготовила 150-Тбайт SSD. Стандарт E2 создаётся для «тёплого» хранения данных. Устройства нового формата займут промежуточное положение между HDD большой ёмкости и традиционными корпоративными SSD. Предполагается, что изделия E2 обеспечат оптимальный баланс производительности, плотности и стоимости при развёртывании крупномасштабных озёр данных для приложений ИИ, аналитики и других задач, которым требуются огромные массивы информации. Добиться этого планируется путём использования большого количества чипов QLC NAND в одном накопителе.

Источник изображения: OCP / Micron Физические размеры накопителей E2 составляют 200 мм в длину, 76 мм в высоту и 9,5 мм в толщину. Применяется коннектор EDSFF, который также используется в устройствах E1 и E3. Отмечается, что по высоте SSD и расположению разъёма (27,7 мм от нижней части) формат E2 соответствуют стандарту E3, тогда как размещение светодиодного индикатора идентично E1.

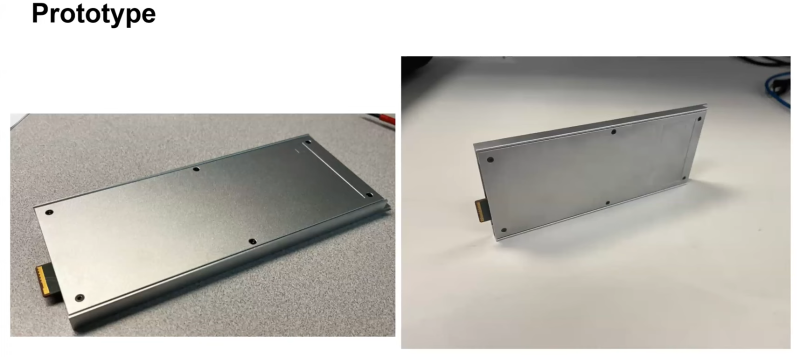

Источник изображения: OCP / Meta✴ Изделия нового типа предназначены прежде всего для установки в серверы с высокой плотностью компоновки. В этом случае система типоразмера 2U сможет нести на борту до 40 устройств E2, что в сумме даст до 40 Пбайт пространства для хранения данных. Новый стандарт предусматривает подключение посредством интерфейса PCIe 6.0 или выше с четырьмя линиями. Заявленная скорость передачи информации может достигать 10 000 Мбайт/с в расчёте на один накопитель. Энергопотребление — до 80 Вт: это означает, что в сервере с 40 такими накопителями только для подсистемы хранения данных потребуется мощность до 3,2 кВт. Таким образом, понадобится эффективное охлаждение — по всей видимости, на основе жидкостных систем. Первая версия спецификации E2 будет готова летом нынешнего года. Значительный вклад в разработку стандарта вносит Micron, которая будет использовать его в своих будущих SSD. Pure Storage и Micron представили прототипы E2 в ходе мероприятия OCP Storage Tech Talk. Проприетарные SSD-модули, отчасти напоминающие E2, уже начали медленно и выборочно вытеснять HDD из дата-центров Meta✴. На подходе и другие гиперскейлеры.

31.05.2025 [12:17], Сергей Карасёв

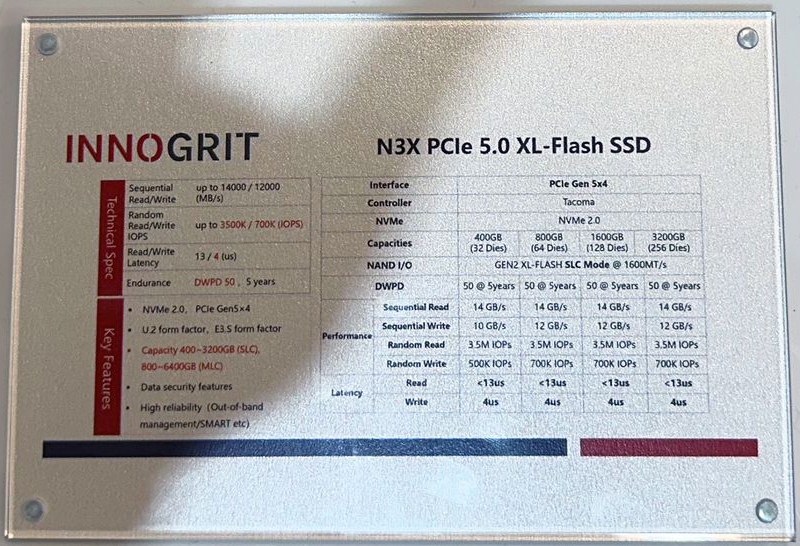

InnoGrit представила SSD серии N3X — альтернативу Intel Optane с показателем IOPS до 3,5 млнКомпания InnoGrit, по сообщению ресурса Tom's Hardware, анонсировала твердотельные накопители N3X, которые будут предлагаться в форм-факторах U.2 и E3.S. Устройства рассматриваются в качестве альтернативы изделиям Intel Optane, производство которых было прекращено. SSD серии InnoGrit N3X используют контроллер InnoGrit Tacoma IG5669 и чипы памяти Kioxia XL-Flash второго поколения, функционирующие в режиме SLC. Задействован интерфейс PCIe 5.0 x4 (NVMe 2.0). Названный контроллер построен на архитектуре RISC-V, а при его производстве применяется 12-нм технология TSMC FinFET. Утверждается, что новые накопители обеспечивают скорость последовательного чтения информации до 14 000 Мбайт/с и скорость последовательной записи до 12 000 Мбайт/с. Показатель IOPS (операций ввода/вывода в секунду) достигает 3,5 млн при произвольном чтении и 700 тыс. при произвольной записи. Одной из особенностей решений N3X являются небольшие задержки. При чтении этот показатель составляет менее 13 мкс, тогда как у обычных накопителей на основе памяти 3D TLC NAND величина варьируется от 50 до 100 мкс. Задержка при записи находится на уровне 4 мкс против 200–400 мкс для 3D TLC NAND. Таким образом, представленные устройства подходят для кеширования, ИИ-инференса, in-memory систем, аналитики в реальном времени и других задач, где задержка имеет критическое значение. Ещё одним преимуществом устройств N3X является высочайшая долговечность. Накопители способны выдерживать до 50 полных перезаписей в сутки (DWPD) на протяжении пяти лет. Это значительно выше средних показателей корпоративных SSD на базе флеш-памяти NAND. Отмечается, что новинки отлично подходят для задач с интенсивными операциями записи, таких как транзакционные рабочие нагрузки и инференс.

Источник изображения: Tom's Hardware / Future Накопители будут выпускаться в модификациях вместимостью 400 и 800 Гбайт, а также 1,6 и 3,2 Тбайт. Упомянута поддержка шифрования AES-256. Гарантированный объём записанной информации (показатель TBW) достигает 292 тыс. Тбайт.

16.05.2025 [13:03], Сергей Карасёв

Kioxia выпустила TLC SSD серии CM9 с интерфейсом PCIe 5.0 вместимостью до 61,44 ТбайтКомпания Kioxia анонсировала семейство SSD корпоративного класса CM9 с интерфейсом PCIe 5.0 (NVMe 2.0, NVMe-MI 1.2c). Изделия доступны в форм-факторах SFF и E3.S в двухпортовом исполнении: в первом случае вместимость достигает 61,44 Тбайт, во втором — 30,72 Тбайт. Утверждается, что устройства серии CM9 — это первые твердотельные накопители, построенные на чипах 3D-флеш-памяти BiCS FLASH TLC 8-го поколения. Используется технология CBA (CMOS directly Bonded to Array), которая обеспечивает повышение энергоэффективности, производительности, плотности и стабильности по сравнению с решениями предыдущего поколения. Заявленная скорость последовательного чтения информации достигает 14,8 Гбайт/с, скорость последовательной записи — 11 Гбайт/с. Показатель IOPS при произвольном чтении данных составляет до 3 400 000 (4 КиБ / QD512), при произвольной записи — до 800 000 (4 КиБ / QD32). Накопители способны выдерживать до 1 полной перезаписи в сутки (1 DWPD) при интенсивном чтении и до трёх перезаписей при смешанном использовании (3 DWPD).

Источник изображения: Kioxia Kioxia отмечает, что SSD серии CM9 демонстрируют прирост производительности примерно на 65 % при произвольной записи, на 55 % при произвольном чтении и на 95 % при последовательной записи по сравнению с устройствами семейства CM7. Кроме того, достигается увеличение быстродействия на 1 Вт затрачиваемой энергии примерно на 55 % при последовательном чтении и на 75 % при последовательной записи. Новые накопители рассчитаны на использование в дата-центрах, поддерживающих ресурсоёмкие рабочие нагрузки машинного обучения, ИИ и НРС. Пробные поставки устройств уже начались.

09.05.2025 [12:17], Сергей Карасёв

ADATA создала бренд Trusta для SSD корпоративного классаКомпания ADATA Technology анонсировала бренд Trusta, под которым будут выпускаться накопители корпоративного класса — в том числе для ИИ-серверов и дата-центров. При разработке изделий Trusta основное внимание планируется уделять производительности, надёжности и энергетической эффективности. Первыми продуктами под новым брендом стали SSD-семейства T7 и T5. Эти решения предназначены для широкого спектра приложений корпоративного уровня, включая обучение ИИ-моделей и инференс, векторные базы данных, HPC-задачи, платформы виртуализации и пр. В частности, дебютировали накопители Trusta T7P5 с интерфейсом PCIe 5.0, которые будут предлагаться в форм-факторах U.2, E1.S (9,5 мм / 15 мм / 25 мм) и E3.S. Вместимость варьируется от 1,92 до 15,36 Тбайт. Заявленная скорость чтения информации достигает 13 500 Мбайт/с, скорость записи — 10 400 Мбайт/с. В устройствах реализована технология Flexible Data Placement (FDP). В серию Trusta T7 также вошли накопители T7P4 с интерфейсом PCIe 4.0 ёмкостью до 7,68 Тбайт. У этих SSD скорости чтения/записи составляют до 7400/5050 Мбайт/с. Устройства подходят для ИИ-приложений и облачных вычислений среднего уровня. Кроме того, разрабатываются модели Trusta T7 большой вместимости на основе чипов флеш-памяти QLC и изделия с интерфейсом PCIe 6.0 для удовлетворения растущих потребностей крупномасштабных ЦОД. Семейство Trusta T5, в свою очередь, представлено накопителями T5P4B, T5S3B и T5S3, оснащёнными интерфейсами PCIe 4.0 и SATA-3. В этих изделиях также предусмотрена система Power Loss Protection (PLP). Устройства могут использоваться в качестве загрузочных SSD в серверах и корпоративном оборудовании.

06.05.2025 [21:12], Руслан Авдеев

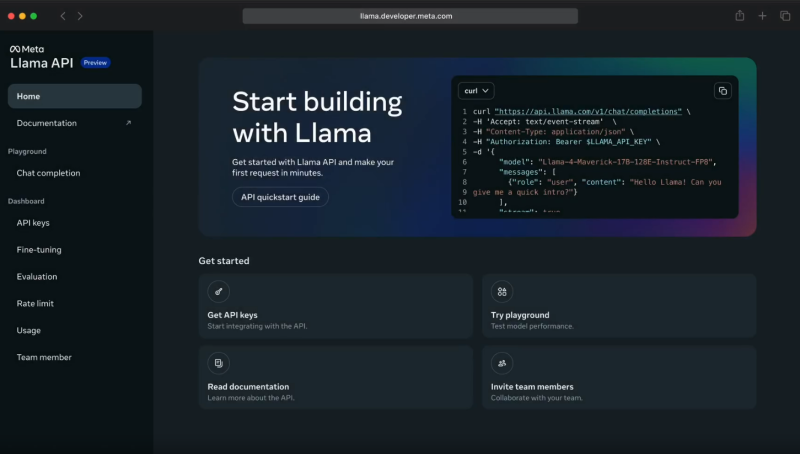

Meta✴ Llama API задействует ИИ-ускорители Cerebras и GroqMeta✴ объединила усилия с Cerebras и Groq для инференс-сервиса с применением API Llama. Открыв API-доступ к собственным моделям, Meta✴ становится чуть более похожа на облачных провайдеров. Как утверждают в Cerebras, разработчики, применяющие API для работы с моделями Llama 4 Cerebras, могут получить скорость инференса до 18 раз выше, чем у традиционных решений на базе GPU. В компании объявили, что такое ускорение позволит использовать новейшее поколение приложений, которые невозможно построить на других ИИ-технологиях. Речь, например, идёт о «голосовых» решениях с низкой задержкой, интерактивной генерации кода, мгновенном многоэтапном рассуждении и т. п. — многие задачи можно решать за секунды, а не минуты. После запуска инференс-платформы в 2024 году Cerebras обеспечила для Llama самый быстрый инференс, обрабатывая миллиарды токенов через собственную ИИ-инфраструктуру. Теперь прямой доступ к альтернативам решений OpenAI получит широкое сообщество разработчиков. По словам компании, партнёрство Cerebras и Meta✴ позволит создавать ИИ-системы, «принципиально недосягаемые для ведущих облаков». Согласно замерам Artificial Analysis, Cerebras действительно предлагает самые быстрые решения для ИИ-инференса, более 2600 токенов/с для Llama 4 Scout.

Источник изображения: Meta✴ При этом Cerebras не единственный партнёр Meta✴. Она также договорилась с Groq об использовании ускорителей Language Processing Units (LPU), которые обеспечивают высокую скорость (до 625 токенов/с), низкую задержку и хорошую масштабируемость при довольно низких издержках. Groq использует собственную вертикально интегрированную архитектуру, полностью контролируя и железо, и софт. Это позволяет добиться эффективности, недоступной в облаках на базе универсальных ИИ-чипов. Партнёрство с Meta✴ усиливает позиции Groq и Cerebras в борьбе с NVIDIA. Для Meta✴ новое сотрудничество — очередной шаг в деле выпуска готовых open source ИИ-моделей, которые позволят сосредоточиться на исследованиях и разработке, фактически передав инференс надёжному партнёру. Разработчики могут легко перейти на новый стек без необходимости дообучения моделей или перенастройки ускорителей — API Llama совместимы с API OpenAI. Пока что доступ к новым API ограничен. Цены Meta✴ также не сообщает. Meta✴ активно работает над продвижением своих ИИ-моделей. Так, она даже выступила с довольно необычной инициативой, предложив «коллегам-конкурентам» в лице Microsoft и Amazon, а также другим компаниям, поделиться ресурсами для развития и обучения моделей Llama.

03.05.2025 [16:30], Владимир Мироненко

Новые пошлины США обойдутся Meta✴ в несколько миллиардов долларов — снижать темпы развития ИИ ЦОД компания не намеренаMeta✴ Platforms сообщила финансовые результаты I квартала 2025 года, завершившегося 31 марта. Основные показатели компании превысили прогнозы аналитиков, а прогноз на II квартал оказался в пределах ожиданий Уолл-стрит, благодаря чему акции компании выросли в цене на расширенных торгах на 5 %, пишет CNBC. Выручка Meta✴ увеличилась год к году на 16 % до $42,31 млрд, что также выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $41,40 млрд. Чистая прибыль подскочила на 35 % до $16,64 млрд по сравнению с $12,37 млрд годом ранее. Прибыль на разводнённую акцию увеличилась на 37 % до $6,43 с $4,37 в прошлом году, также превысив консенсус-прогноз аналитиков LSEG, равный $5,28 на разводнённую акцию. Капитальные затраты составили $13,69 млрд. Meta✴ ожидает, что выручка во II квартале составит от $42,5 до $45,5 млрд. Это соответствует среднему прогнозу аналитиков в $44,03 млрд. Также компания сообщила о планируемом сокращении общих расходов в 2025 году с прежних целевых показателей $114 – $119 млрд до $113 – $118 млрд.

Источник изображений: Meta✴ Вместе с тем Meta✴ объявила о решении увеличить свои капитальные расходы на 2025 год до $64–$72 млрд, что выше предыдущего прогноза в $60–$65 млрд. «Этот обновленный прогноз отражает дополнительные инвестиции в ЦОД для поддержки наших усилий в области ИИ, а также увеличение ожидаемой стоимости инфраструктурного оборудования», — заявила финансовый директор Сьюзан Ли (Susan Li). «Большая часть наших капитальных затрат в 2025 году по-прежнему будет направлена на наш основной бизнес», — добавила она. Отвечая на вопрос о том, являются ли более высокие капитальные затраты Meta✴ на инфраструктуру ЦОД результатом введения новых торговых пошлин администрацией США, Сьюзан Ли сообщила: «Более высокие расходы, которые мы ожидаем понести на инфраструктурное оборудование в этом году, на самом деле исходят от поставщиков, которые закупают продукцию из стран по всему миру. И вокруг этого просто много неопределенности, учитывая продолжающиеся торговые дискуссии». Как отметил The Register, дело не только в пошлинах. Заявление Ли также свидетельствует о том, что компания не просто платит больше за компоненты для ИИ ЦОД, но и развёртывает больше таких объектов. Ли сообщила, что пересмотренный прогноз капитальных вложений также отражает стремление компании увеличить мощности своих ИИ ЦОД. Ожидается, что дата-центры следующего поколения будут поддерживать как внутреннее обучение базовых моделей, так и инференс в экосистеме Meta✴, включая умные очки, помощников на базе LLM и функции «Семейного доступа». Она добавила, что Meta✴ работает над повышением эффективности рабочих нагрузок своих ЦОД. «Многие инновации, полученные в результате нашей работы по ранжированию, направлены на повышение эффективности наших систем, — сказала Ли. — Этот акцент на эффективность помогает нам стабильно получать высокую отдачу от наших основных инициатив в области ИИ». Ранее Meta✴ объявила о намерении ввести в эксплуатацию около 1 ГВт вычислительных мощностей в 2025 году и иметь к концу года более 1,3 млн ускорителей для обучения и обслуживания ИИ-моделей. |

|