Материалы по тегу: cloud

|

26.02.2024 [22:28], Сергей Карасёв

Beeline cloud внедрил российскую платформу виртуализации

beeline cloud

itglobal

software

vstack

виртуализация

импортозамещение

миграция

облако

россия

сделано в россии

Поставщик облачных и IT-услуг beeline cloud развернул сервис миграции инфраструктуры на российскую платформу виртуализации. В проекте приняли участие отечественная компания MIND Software и разработчик системы виртуализации vStack. В середине февраля 2024 года beeline cloud и vStack представили платформу виртуализации BeeCloud Stack. Она предназначена для создания публичного, частного или гибридного облака и управление им из одной точки. Аппаратной основой BeeCloud Stack является отечественное оборудование, размещённое в собственном дата-центре. После запуска BeeCloud Stack потребовалось создание сервиса миграции. Новая служба использует инструмент MIND Migrate от MIND Software. В отличие от традиционного подхода, при котором виртуальная машина преобразуется в файл, а затем импортируется на платформу, MIND Migrate предлагает альтернативный механизм, устраняющий дискретность. В результате, процесс миграции упрощается и ускоряется. В целом, MIND Migrate обеспечивает бесшовную миграцию виртуальных машин с различных платформ, включая VMware, на отечественное решение. Инструмент встроен в любую установку BeeCloud Stack, в том числе при выполнении в закрытом контуре без доступа в интернет. Сервис предоставляется по различным моделям, в частности, в режиме самообслуживания и с технической поддержкой со стороны beeline cloud. Среди ключевых особенностей платформы виртуализации vStack разработчик называет CPU overcommit в вычислительном слое до 900%, высокопроизводительную СХД, возможность создания кастомизированных виртуальных машин, а также поддержку отечественных и зарубежных гостевых операционных систем. В BeeCloud Stack, в свою очередь, реализованы такие функции, как резервное копирование, снапшоты, поддержка iSCSI и NFS.

16.02.2024 [10:33], Сергей Карасёв

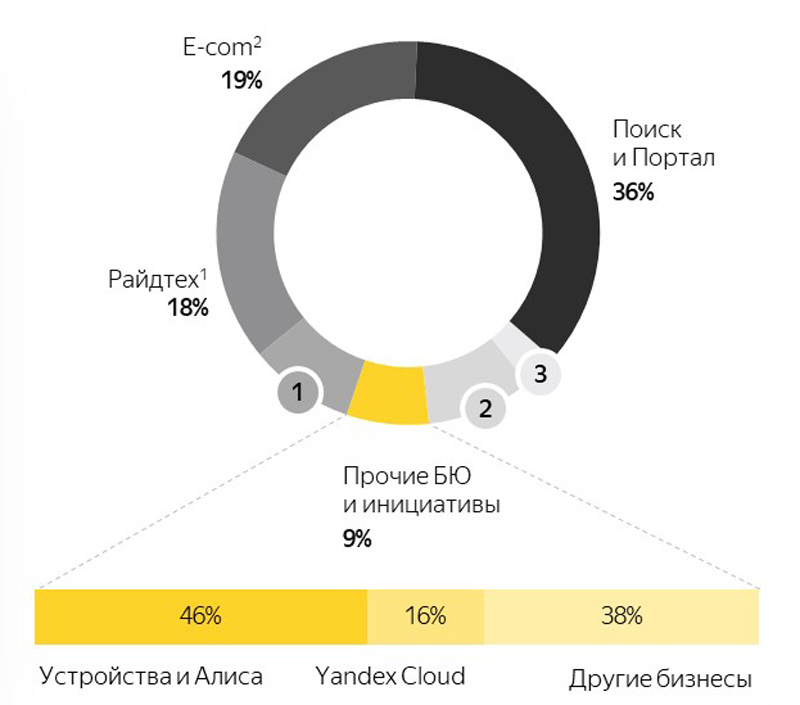

Облако Yandex Cloud увеличило квартальную выучку на 60 %Компания «Яндекс» отчиталась о работе в последней четверти и 2023 году в целом. Общая квартальная выручка группы составила 249,6 млрд руб., что на 51 % больше прошлогоднего результата, когда данный показатель равнялся 164,8 млрд. руб. При этом зафиксированы чистые убытки в размере 6,3 млрд руб., тогда как в IV квартале 2022 года «Яндекс» получил 7,1 млрд руб. чистой прибыли. Квартальная выручка направления «Прочих бизнес-юнитов и инициатив», в которое входит в том числе облачная платформа Yandex Cloud, подскочила в годовом исчислении на 84 %, составив 34,9 млрд руб. против 18,9 млрд руб. годом ранее. За год в целом это значение поднялось на 70 % — с 48,8 млрд руб. до 82,7 млрд руб.

Источник изображения: «Яндекс» В отчёте говорится, что столь значительный рост в группе «Прочих бизнес-юнитов и инициатив» связан в основном с увеличением доходов направления «Устройств и Алисы», Yandex Cloud и финтех-подразделения. В частности, квартальная выручка платформы Yandex Cloud подскочила на 60 % год к году благодаря расширению предоставляемых услуг и увеличению доли рынка на фоне растущего спроса на облачные сервисы. В 2023 году на Yandex Cloud пришлось около 16 % от общей выручки в соответствующем подразделении. Убыток по скорректированному показателю EBITDA в сегменте «Прочих бизнес-юнитов и инициатив» составил в IV квартале 2023-го 15,8 млрд руб., тогда как годом ранее он равнялся 8,4 млрд руб. Рост в абсолютных значениях в основном вызван переносом нераспределённых корпоративных расходов, не относящихся к сегментам напрямую, из скорр. EBITDA отчётных сегментов в скорр. EBITDA «Прочих бизнес-юнитов и инициатив» (хотя эти расходы в целом остаются неизменными в проценте от общей выручки группы), инвестициями в рост финтех-направления и в Yandex SDG (убыток которого по скорр. EBITDA составил 2,9 млрд руб. в IV квартале 2023 года), а также инвестициями в развитие других вертикалей. По итогам 2023 года в целом общая выручка группы «Яндекс» поднялась на 53 % — с 521,7 млрд руб. до 800,1 млрд руб. Вместе с тем чистая прибыль по сравнению с 2022-м уменьшилась на 54 % — 47,6 млрд руб. до 21,8 млрд руб.

30.01.2024 [15:35], Сергей Карасёв

VK Сloud запустила улучшенную версию частного облака для бизнесаVK Сloud представила платформу Private Cloud версии 4.0, предназначенную для построения частного облака на базе дата-центра заказчика. Усовершенствованное решение, как утверждается, обеспечивает повышенный уровень защищённости: ядро облака соответствует 17-му приказу ФСТЭК (Об утверждении требований о защите информации, не составляющей государственную тайну, содержащейся в государственных информационных системах). На обновлённой платформе разработчикам стал доступен маркетплейс приложений. Магазин помогает осуществлять быстрое развёртывание продуктов VK и партнёров в облаке, а также предоставляет возможность загружать собственные приложения и сервисы для внутренних команд. Платформа Private Cloud 4.0 поддерживает сертифицированные ФСТЭК операционные системы Alt Linux, Astra и РЕД ОС. Таким образом, в частном облаке можно размещать критическую информационную инфраструктуру и хранить персональные данные любых типов, в том числе биометрические и специальные. В рамках Private Cloud предлагаются готовые программно-аппаратные комплексы — оборудование с уже инсталлированным ПО частного облака. Поставщиками серверов и СХД являются Aquarius, DEPO, Fplus, ICL, Kraftway, OpenYard, Sitronix, Yadro, «Гравитон» и «Тринити». Среди ключевых преимуществ частного облака VK Сloud называет размещение IT-сервисов в периметре компании с возможностью хранения конфиденциальной информации; построение геораспределённой платформы; сокращение затрат на обслуживание и поддержку инфраструктуры благодаря автоматизации; создание импортонезависимого ЦОД с масштабированием на тысячи серверов; постоянно обновляемый стек технологий для разработки конкурентоспособных продуктов и пр. Стоимость ПО рассчитывается индивидуально в соответствии с требованиями каждого клиента.

28.11.2023 [22:20], Игорь Осколков

NVIDIA анонсировала суперускоритель GH200 NVL32 и очередной самый мощный в мире ИИ-суперкомпьютер Project CeibaAWS и NVIDIA анонсировали сразу несколько новых совместно разработанных решений для генеративного ИИ. Основным анонсом формально является появление ИИ-облака DGX Cloud в инфраструктуре AWS, вот только облако это отличается от немногочисленных представленных ранее платформ DGX Cloud тем, что оно первом получило гибридные суперчипах GH200 (Grace Hoppper), причём в необычной конфигурации.

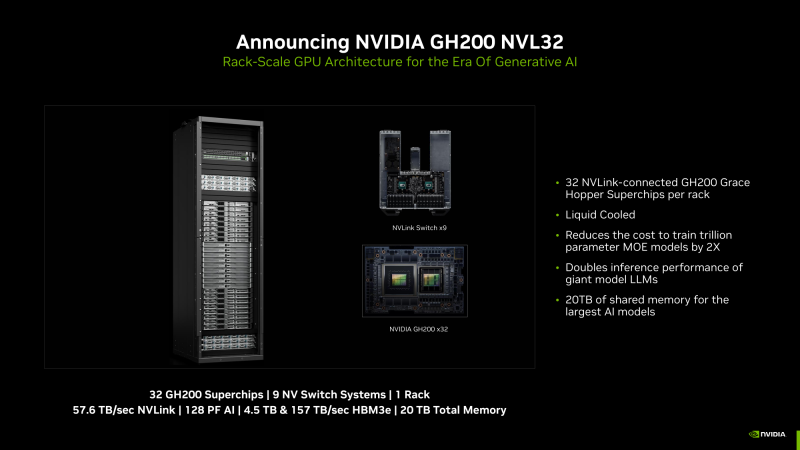

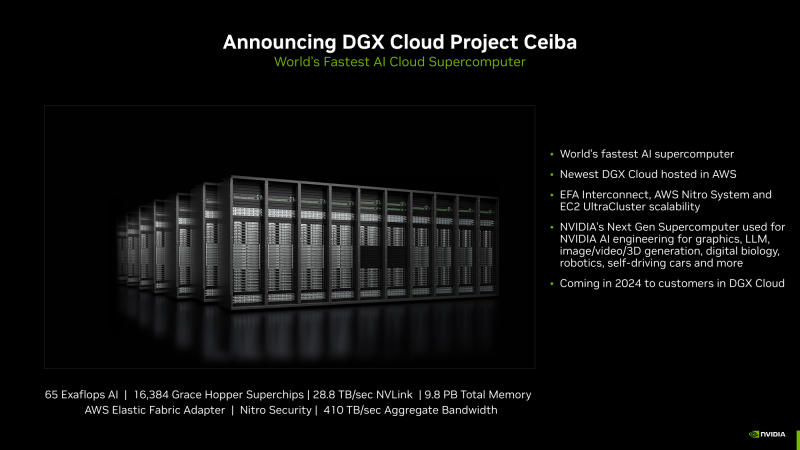

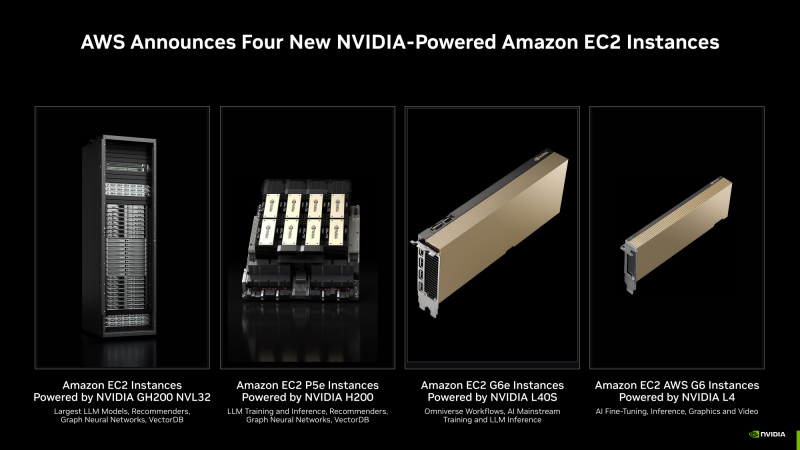

Изображения: NVIDIA В основе AWS DGX Cloud лежит платформа GH200 NVL32, но это уже не какой-нибудь сдвоенный акселератор вроде H100 NVL, а целая, готовая к развёртыванию стойка, включающая сразу 32 ускорителя GH200, провязанных 900-Гбайт/с интерконнектом NVLink. В состав такого суперускорителя входят 9 коммутаторов NVSwitch и 16 двухчиповых узлов с жидкостным охлаждением. По словам NVIDIA, GH200 NVL32 идеально подходит как для обучения, так и для инференса действительно больших LLM с 1 трлн параметров. Простым перемножением количества GH200 на характеристики каждого ускорителя получаются впечатляющие показатели: 128 Пфлопс (FP8), 20 Тбайт оперативной памяти, из которых 4,5 Тбайт приходится на HBM3e с суммарной ПСП 157 Тбайтс, и агрегированная скорость NVLink 57,6 Тбайт/с. И всё это с составе одного EC2-инстанса! Да, новая платформа использует фирменные DPU AWS Nitro и EFA-подключение (400 Гбит/с на каждый GH200). Новые инстансы, пока что безымянные, можно объединять в кластеры EC2 UltraClasters. Одним из таких кластеров станет Project Ceiba, очередной самый мощный в мире ИИ-суперкомпьютер с FP8-производительность 65 Эфлопс, объединяющий сразу 16 384 ускорителя GH200 и имеющий 9,1 Пбайт памяти, а также агрегированную пропускную способность интерконнекта на уровне 410 Тбайт/с (28,8 Тбайт/с NVLink). Он и станет частью облака AWS DGX Cloud, которое будет доступно в начале 2024 года. В скором времени появятся и EC2-инстансы попроще: P5e с NVIDIA H200, G6e с L40S и G6 с L4.

04.10.2023 [14:59], Сергей Карасёв

Без гиперскейлеров: NVIDIA хочет арендовать ЦОД для облачного сервиса DGX CloudКомпания NVIDIA, по сообщению ресурса The Information, ведёт переговоры об аренде площадей у одного из операторов ЦОД, но о ком именно идёт речь, не сообщается. Предполагается, что площадка будет использоваться для поддержания работы собственного облачного сервиса DGX Cloud, предназначенного для обучения передовых моделей для генеративного ИИ. О доступности облака DGX Cloud компания NVIDIA объявила в июле нынешнего года. Тогда сообщалось, что соответствующая вычислительная инфраструктура достанется в первую очередь США и Великобритании. Стоимость доступа к DGX Cloud начинается с $36 999 в месяц. Говорилось, что NVIDIA намерена продвигать DGX Cloud в партнёрстве с ведущими гиперскейлерами. Первым сервис появился в облаке Oracle Cloud Infrastructure (OCI), на очереди Microsoft Azure, Google Cloud Platform и другие. Большая часть выручки в этом случае достаётся именно NVIDIA, а не облакам.

Источник изображения: NVIDIA Теперь же, судя по всему, NVIDIA решила частично отказаться от услуг облачных провайдеров и развернуть DGX Cloud на арендованных ЦОД-площадях. Впрочем, как отмечается, переговоры всё ещё находятся на начальной стадии, а поэтому говорить о том, что NVIDIA сама превратится в гиперскейлера, преждевременно. При этом компания неоднократно упрекали в том, что в последнее время она более благосклонна к небольшим и специализированным облачным провайдерам, которые не пытаются создавать собственные ИИ-ускорители, могущие составить прямую конкуренцию продуктам NVIDIA.

21.03.2023 [20:45], Владимир Мироненко

NVIDIA запустила облачный сервис DGX Cloud — доступ к ИИ-супервычислениям прямо в браузереNVIDIA запустила сервис ИИ-супервычислений DGX Cloud, предоставляющий предприятиям доступ к инфраструктуре и программному обеспечению, необходимым для обучения передовых моделей для генеративного ИИ и других приложений. DGX Cloud предлагает выделенные ИИ-кластеры NVIDIA DGX в сочетании с фирменным набором ПО NVIDIA. С его помощью предприятие сможет получить доступ к облачному ИИ-суперкомпьютеру, используя веб-браузер и без надобности в приобретении, развёртывании и управлении собственной HPC-инфраструктурой. Правда, удовольствие это всё равно не из дешёвых — стоимость инстансов DGX Cloud начинается от $36 999/мес., причём деньги получает в первую очередь сама NVIDIA. Для сравнения — полностью укомплектованная система DGX A100 в Microsoft Azure обойдётся примерно в $20 тыс. Облачные кластеры DGX предлагаются предприятиям на условиях ежемесячной аренды, что гарантирует им возможность быстро масштабировать разработку больших рабочих нагрузок. «DGX Cloud предоставляет клиентам мгновенный доступ к супервычислениям NVIDIA AI в облаках глобального масштаба», — сообщил Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA.

Источник изображения: NVIDIA Развёртыванием инфраструктуры DGX Cloud компания NVIDIA будет заниматься в сотрудничестве с ведущими поставщиками облачных услуг. Первым среди них стала платформа Oracle Cloud Infrastructure (OCI), предлагающая суперкластер (SuperCluster) с объединёнными RDMA-сетью (в том числе на базе BlueField-3 и Connect-X7) системами DGX (bare metal), которые дополняет высокопроизводительное локальное и блочное хранилище. Cуперкластер может включать до 32 768 ускорителей, но этот рекорд был поставлен с использованием DGX A100, а вот предложение DGX H100 пока что ограничено. В следующем квартале похожее решение появится в Microsoft Azure, а потом в Google Cloud и у других провайдеров. Первыми пользователями DGX Cloud стали Amgen, одна из ведущих мировых биотехнологических компаний, лидер рынка страховых технологий CCC Intelligent Solutions (CCC) и провайдер цифровых бизнес-платформ ServiceNow. «Мощные вычислительные и многоузловые возможности DGX Cloud позволили нам в 3 раза ускорить обучение белковых LLM с помощью BioNeMo и до 100 раз ускорить анализ после обучения с помощью NVIDIA RAPIDS по сравнению с альтернативными платформами», — сообщил представитель Amgen. Для управления нагрузками в DGX Cloud предлагается NVIDIA Base Command. Также DGX Cloud включает в себя набор инструментов NVIDIA AI Enterprise для создания и запуска моделей, который предоставляет комплексные фреймворки и предварительно обученные модели для ускорения обработки данных и оптимизации разработки и развёртывания ИИ. DGX Cloud предоставляет поддержку экспертов NVIDIA на всех этапах разработки ИИ. Клиенты смогут напрямую работать со специалистами NVIDIA, чтобы оптимизировать свои модели и быстро решать задачи разработки с учётом сценариев отраслевого использования.

13.07.2022 [16:13], Алексей Степин

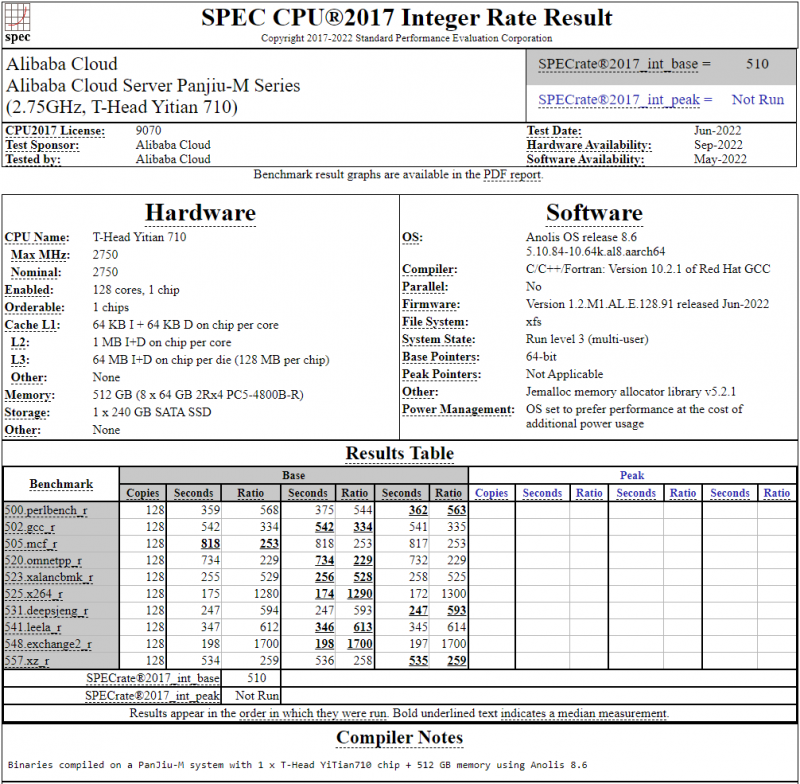

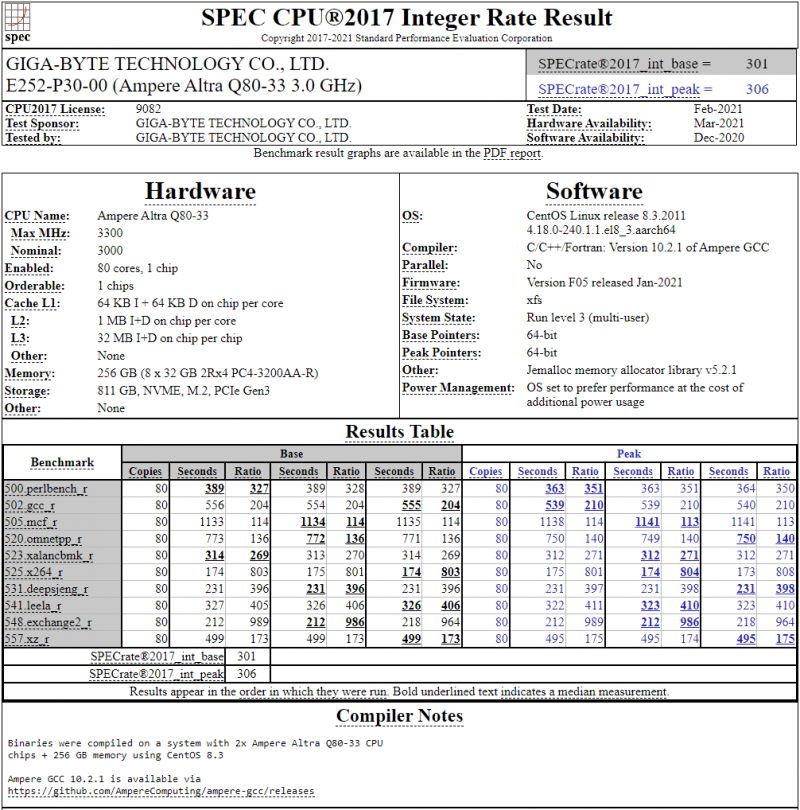

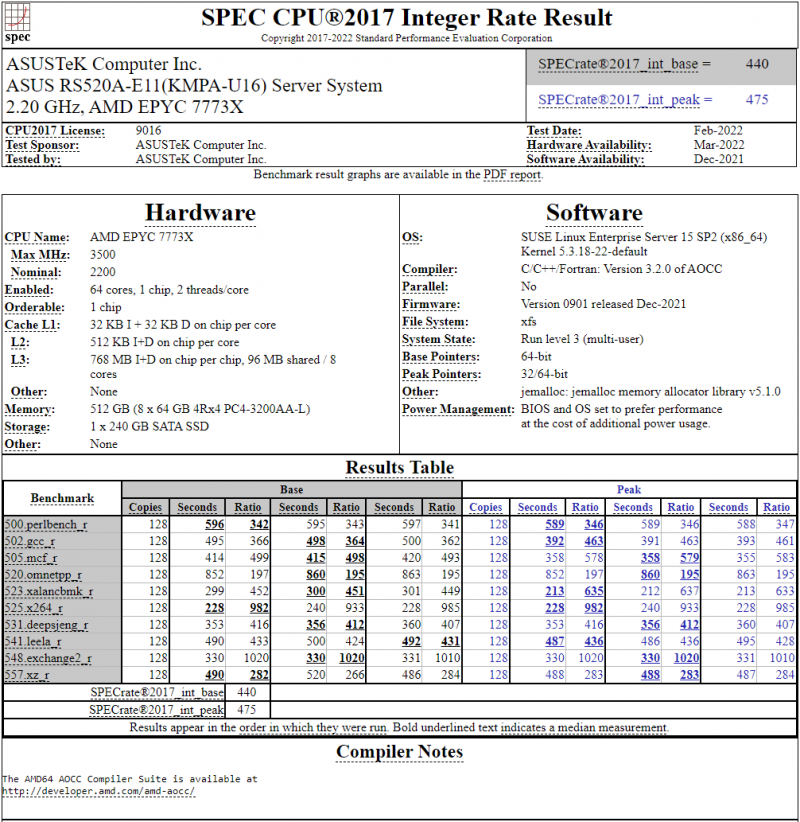

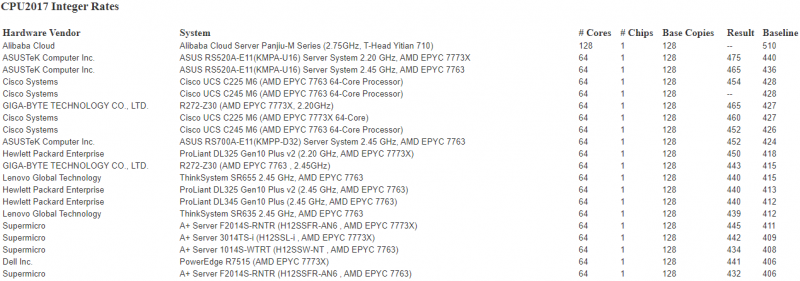

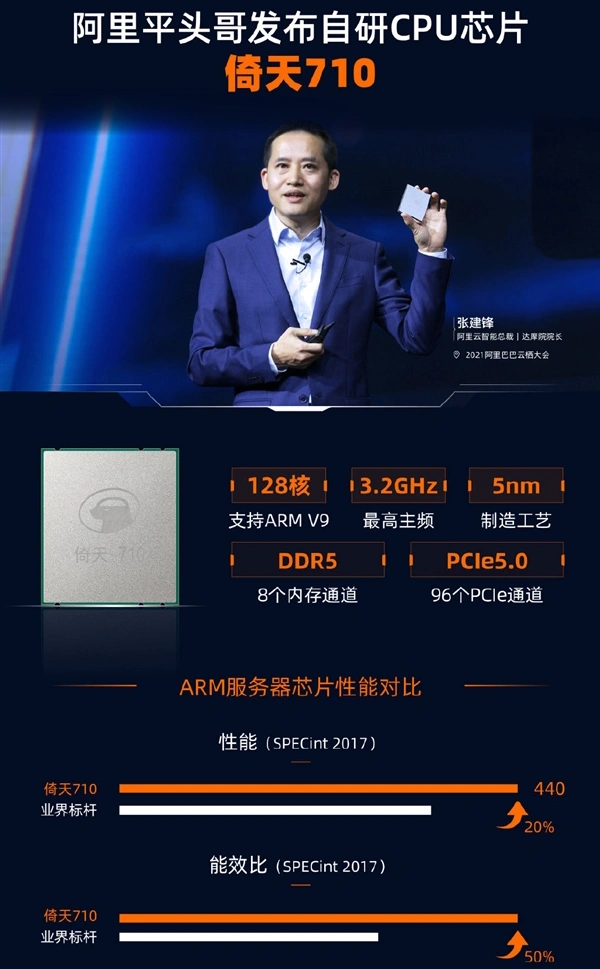

128-ядерный Arm-процессор Alibaba T-Head Yitian 710 показал отличные результаты в SPEC CPU2017Не секрет, что китайские гиганты, такие, как Huawei и Alibaba Cloud, разрабатывают собственные серверные процессоры на базе архитектуры Arm. Однако информации об этих чипах, как правило, не очень много и пользоваться общепринятыми на западе тестами и рейтингами разработчики не спешат, что, к слову, характерно и для китайских суперкомпьютеров. Alibaba Cloud представила чип Yitian 710 ещё осенью прошлого года. Этот процессор построен на базе архитектуры Armv9 и максимально может иметь 128 ядер с частотой до 3,2 ГГц. Однако результаты проверки чипа в популярном тесте SPEC CPU2017 были опубликованы только сейчас. Процессор тестировался в составе референс-сервера Panjiu. Применялась 128-ядерная версия с частотой 2,75 ГГц, 1 Мбайт кеша L2 на ядро и 64 Мбайт кеша L3 на кристалл (128 Мбайт на сборку). Последнее позволяет говорить о том, что Alibaba также использует в своих процессорах чиплетную компоновку. Результаты оказались существенно более высокими, нежели у Ampere Altra Q80-33; правда, стоит сделать скидку на то, что у Ampere использовалась 80-ядерная версия, а не более новая 128-ядерая Altra Max. Но в аутсайдерах оказался также и AMD EPYC 7773X (64 ядер/128 потоков, 2,2-3,5 ГГц, 768 Мбайт L3), показавший 440 очков против 510 у Yitian 710. Увеличенный объём кеша не слишком помог детищу «красных». Таким образом, процессор на базе архитектуры Armv9 занял первое место там, где традиционно господствовали решения с архитектурой x86 — достаточно взглянуть на Топ-20 в рейтинге CPU2017 Integer. Можно сказать, что 128-ядерный процессор не вполне корректно сравнивать с 64-ядерным с поддержкой SMT, однако если технологии и архитектура позволяют разместить вдвое больше полноценных ядер в сопоставимом по размеру с AMD EPYC корпусе, так ли это важно? К сожалению, пока речь идёт только о целочисленных вычислениях. По неизвестной причине, Alibaba Cloud не опубликовала результаты CPU2017 Floating Point, где сравнение вышло бы существенно интереснее. В любом случае, монополия AMD на первые места пошатнулась; что же касается Intel, то в классе однопроцессорных систем самым мощным вариантом является 36-ядерный Xeon Platinum 8351N, который заведомо проиграет 64-128 ядерным монстрам AMD, Ampere, а теперь уже и Alibaba Cloud.

19.06.2022 [13:32], Алексей Степин

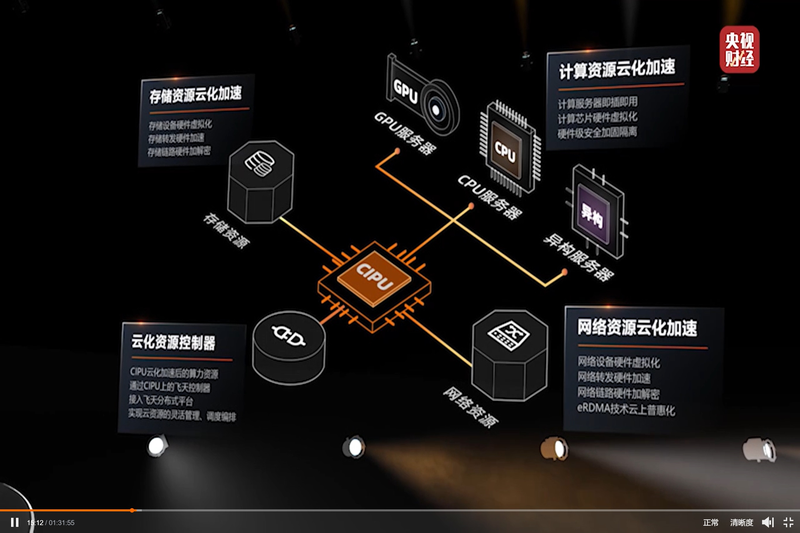

Alibaba Cloud представила свой вариант DPU — Cloud Infrastructure Processing Unit (CIPU)С учётом стремительно наступающей эры DPU/IPU не вызывает удивления, что такой китайский гигант, как Alibaba Cloud, представил своё видение «универсального сетевого сопроцессора», использовав схожий термин Cloud Infrastructure Processing Unit (CIPU). На ежегодном саммите компании Alibaba Cloud анонсировала новый чип, являющийся дальнейшим развитием идей, ранее воплощённых в умном сетевом адаптере X-Dragon, разрабатывавшемся как аналог AWS Nitro. Пока об архитектуре Alibaba CIPU известно не так много, но физически это обычная двухслотовая плата расширения с интерфейсом PCI Express.

Источник: @ogawa_tter Судя по имеющимся данным, в основе лежит четвёртое поколение архитектуры X-Dragon, обеспечившее 20% прирост производительности в сравнении с предыдущим поколением этих процессоров. Что более интересно, в основе новой итерации X-Dragon лежит дуэт технологий Elastic RDMA (eRDMA) и Shared Memory Communications over RDMA (SMC-R). Он позволяет новому ускорителю обращаться к памяти хост-системы напрямую на уровне ядра фирменных ОС Alibaba Cloud Linux 3 и Anolis OS. Для приложений, использующих TCP, всё выглядит прозрачно, но латентность при этом удалось понизить до 5 мкс.

Источник: @ogawa_tter Новые сопроцессоры полностью совместимы со стеком технологий RDMA over Converged Ethernet (RoCE), причём поддерживается даже iWARP, довольно редкий вариант, встречавшийся ранее в адаптерах Intel и Chelsio. Реализации iWARP могут быть сложнее RoCE, т.к. используют многослойную архитектуру и ряд твиков, а в итоге нередко показывают менее высокую производительность. Но благодаря поддержке обеих технологий новое решение Alibaba получилось поистине универсальным.

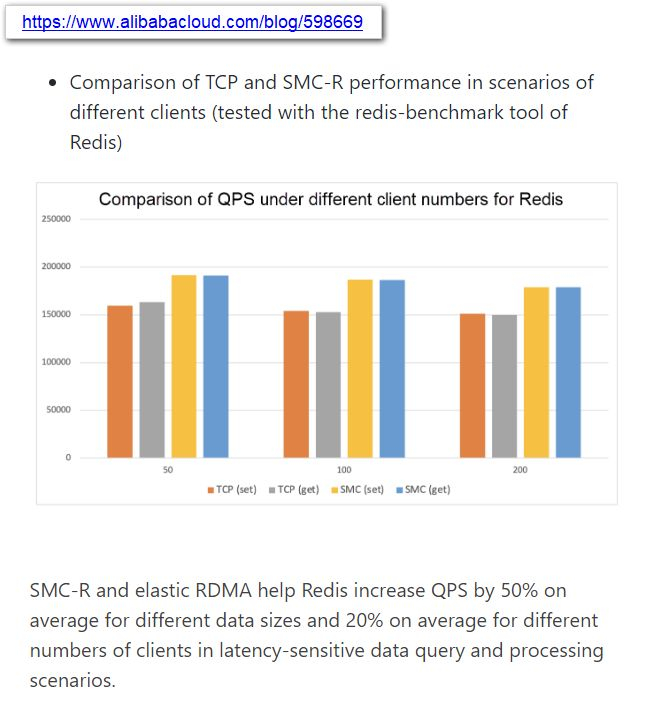

Источник: @ogawa_tter Результаты тестов весьма обнадёживают: в частности, для Redis ускорители CIPU за счёт SMC-R позволили поднять количество обрабатываемых запросов на 50%, а в сценариях с данными, чувствительными к латентности, прирост составил 20%. Исходя из опубликованных в японском блоге Tadashi Ogawa, это действительно полноценный IPU, могущий стать мостом между сетью, подсистемами хранения данных, CPU, GPU и прочими ускорителями. Компания активно развивает собственную аппаратную инфраструктуру и в прошлом году уже представила 128-ядерный 5-нм процессор Yitian 710 на базе набора инструкций Armv9 c 8 каналами DDR5, поддержкой PCIe 5.0 (96 линий) и при этом способный работать на частотах до 3,2 ГГц.

05.02.2022 [22:28], Владимир Мироненко

Глубоководное облако: Subsea Cloud предлагает размещать дата-центры на дне океанаПолку подводных дата-центров прибыло — стартап Subsea Cloud, в отличие от проектов Highlander и Microsoft Natick, предлагает размещать центры обработки данных (ЦОД) не на мелководье в прибрежных водах, а на морском или океанском дне на глубине до 3000 м. Делается это не только для снижения вредных выбросов, поскольку на охлаждение энергию тратить не придётся, но и для безопасности. Именно физическая безопасность является одним из ключевых достоинств проекта Subsea Cloud, так как на такой глубине дата-центрам не страшны не то что дайверы, но и подводные лодки — абсолютный рекорд до сих принадлежит лодке К-278 «Комсомолец», погрузившейся в 1985 году на глубину чуть больше километра. А специализированных аппаратов, способных работать в таких условиях, единицы и незаметно провести с их помощью атаку вряд ли получится. Поэтому компания ориентирована на предоставление услуг для заказчиков в сфере здравоохранения и финансов, а также для вооружённых сил.

Источник изображения: Subsea Cloud Всех технических деталей Subsea Cloud пока не раскрывает. Например, не сообщается, как будут обслуживаться глубоководные ЦОД и будут ли вообще, хотя компания говорит, что уже испытала прототип новых ЦОД на надёжность и возможность работы на глубине 3 км, а часть оборудования внутри таких дата-центров будет иметь резервирование. Также упомянуто, что дата-центры будут вмещать до 800 серверов, а сами они сделаны из экологичных материалов, так что даже при разгерметизации они не навредят морской природе. Основателем Subsea Cloud является Макси Рейнольдс (Maxie Reynolds), которая возглавляет техотдел компании Social Engineer LLC, работающей в сфере информационной безопасности. Ранее она занималась подводной робототехникой в Subsea 7 и даже успела побывать каскадёром. Как сообщает Data Centre Dynamics, в команду Subsea Cloud входят четыре специалиста по подводным технологиям, в том числе основатель Energy Subsea. Среди партнёров компании значатся Chevron, Laborde Marine и Oracle.

19.10.2021 [19:39], Алексей Степин

Alibaba Cloud представила серверный 128-ядерный Armv9-процессор Yitian 710Эпоха неоспоримого господства x86-64 в серверах, похоже, постепенно всё же подходит к концу. Ampere, AWS, Fujitsu, HiSilicon, Phytium и другие производители Arm-процессоров дают бой x86-64 и выигрывает его, пусть и не во всех областях. Эффективность серверных Arm-решений уже неоспорима, количество ядер уже перевалило за сотню, а теперь ещё один крупный провайдер облачных услуг, китайская компания Alibaba Cloud, анонсировала свой вариант высокопроизводительного CPU на базе Arm. Первые попытки Arm проникнуть на рынок серверов или рабочих станций были робкими и неуверенными, но за последние несколько лет ситуация сильно изменилась: уверенно показывают себя такие интересные чипы, как Ampere Altra, недавно доросшие уже до 128 ядер, Amazon активно предлагает инстансы на базе Graviton2, а Huawei даже открывает первый в России ЦОД на базе своих чипов Kunpeng 920.  Более того, мощные многоядерные Arm-процессоры обрастают собственной инфраструктурой: появляются собственные процессорные разъёмы, системные платы, не уступающие x86-моделям, и даже варианты в виде рабочих станций для разработчиков программного обеспечения, без которого любая платформа мертва. Тем интереснее выглядит анонс Alibaba Cloud. Компания сообщила о выпуске нового процессора, который послужит основой для её облачных. И по ряду характеристик можно видеть, что это весьма передовые решения. Новинка носит название Yitian 710, она имеет собственный процессорный сокет и инфраструктуру сопутствующей «обвязки» (есть и референс-дизайн сервера, Panjiu). Впрочем, интереснее то, что эти процессоры — как и Altra Max — могут иметь до 128 ядер.  Но если текущее поколение Ampere Altra базируется на наборе инструкций Armv8.2 с некоторыми заимствованиями из v8.3 и v8.4, то китайский гигант использует более новый вариант, Armv9. Эта версия архитектуры была анонсирована только весной этого года, она, как минимум, на треть быстрее v8, поддерживает аппаратную ускорение работы контейнеров и виртуальных машин, а также наделена востребованными нынче векторными инструкциями со средствами ускорения машинного обучения (SVE2). 5-нм процессоры Yitian 710 поставляются с июля этого года. Они содержат примерно 60 млрд транзисторов и могут иметь тактовую частоту до 3,2 ГГц, а также включают 128 Мбайт L3-кеша, восьмиканальный контроллер DDR5-4400 и 96 линий PCIe 5.0. TDP равен 250 Вт. Так что это один из самых передовых на сегодня серверных процессоров не только в плане чистой производительности. Сама Alibaba называет свое детище универсальным, одинаково хорошо подходящим для нагрузок общего назначения, развёртывания СХД и ИИ-нагрузок, но, разумеется, приоритет отдаётся задачам, характерным для облачных сред.

Alibaba Cloud: Yitian 710 превосходит всех ARM-соперников и в своём классе является лучшим Ввиду санкционных трений решение Alibaba Cloud разработать собственный мощный процессор выглядит вполне обоснованно, как и принятое ранее решение о создании собственной ИИ-платформы Hanguang 800. И это не единственные разработки Alibaba Cloud. Компания собирается сделать открытым дизайн не только четырёх чипов XuanTie (RISC-V), но и некоторых будущих ядер. Открыт будет и сопутствующий набор ПО, так что Alibaba Cloud всерьёз намеревается вырастить вокруг своего «кремния» развитую инфраструктуру аппаратного и программного обеспечения. |

|