Материалы по тегу: cloud

|

08.04.2024 [15:47], Андрей Крупин

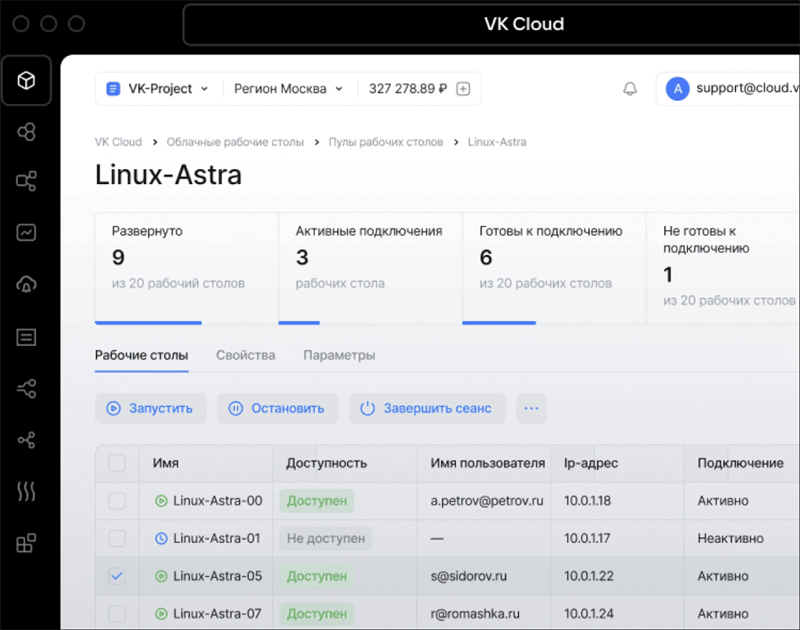

VK Cloud представила облачный сервис для создания виртуальных рабочих местОблачная платформа VK Cloud дополнилась сервисом Cloud Desktop, построенным на базе решения для удалённого доступа Termidesk компании «Увеон — облачные технологии» (входит в «Группу Астра»). Cloud Desktop относится к категории VDI-решений (Virtual Desktop Infrastructure) и предназначен для развёртывания инфраструктуры виртуальных рабочих мест и организации безопасной удалённой работы сотрудников. Продукт поддерживает интеграцию со службами каталогов Active Directory/OpenLDAP, включает средства разграничения прав доступа к пулам виртуальных рабочих столов для отдельных пользователей или их групп и позволяет объединить все корпоративные приложения компании в единую рабочую область, обеспечивая масштабирование и гибкость виртуальных рабочих мест сотрудников.  Предусмотрена поддержка Windows и Linux. Ограничений по приложениям нет — можно установить как стандартные, так и специализированные программы. Передача данных выполняется через протокол RDP. Системный администратор компании может централизованно управлять развёрнутой в облаке VDI-инфраструктурой, что упрощает настройку, техническую поддержку и работу с обновлениями. С помощью сервиса можно выделять вычислительные ресурсы, выбирать операционную систему и настраивать политики доступа, добавлять или отключать удалённых сотрудников. Шифрование и защищённый шлюз для подключения внешних пользователей обеспечивает безопасность работы сервиса. Обработка корпоративной информации разного уровня конфиденциальности происходит изолированно. Решение поддерживает регистрацию событий безопасности, защиту от несанкционированного копирования и потери данных. Данные размещаются на облачной платформе VK Cloud, инфраструктура которой соответствует требованиям 152-ФЗ по уровню защищённости УЗ-1.

22.03.2024 [16:52], Владимир Мироненко

Рост выручки VK Cloud за 2023 год составил 75,4 %VK сообщила финансовые результаты IV квартала и всего 2023 года. По итогам квартала выручка компании выросла на 34 % год к году до 42,5 млрд руб. Выручка за год составила 132,8 млрд руб., превысив показатель 2022 года на 36 %. Наибольший рост показал сегмент «Технологии для бизнеса» (VK Tech), увеличивший выручку в 2023 году на 67,5 % до 9,7 млрд руб. Основными драйверами роста сегмента были облачные сервисы платформы VK Cloud (рост год к году на 75,4 %) и коммуникационные решения VK WorkSpace (рост — 68 %). Выручка HR Tech-сервисов увеличилась за год в 3,1 раза.

Источник изображения: VK По итогам IV квартала выручка VK Cloud выросла год к году в 2 раза, коммуникационной платформы VK WorkSpace — на 36 %, сервисов HR Tech — в 4 раза. Реализация промежуточного ПО для хранения и обработки данных Tarantool увеличилась в 3 раза. Компания сообщила, что в IV квартале 2023 года VK Teams расширил возможности для видеоконференций. За отчётный квартал средняя месячная аудитория сервиса «Облако Mail.ru», входящего в сегмент «Экосистемные сервисы и прочие направления», составила 21,9 млн человек, а средняя дневная аудитория — 2,4 млн человек. Всего за квартал пользователи загрузили в «Облако Mail.ru» около 7,8 млрд файлов. Компания сообщила о формировании резерва сетевого и серверного оборудования. В частности, VK приступила к строительству собственных ЦОД с целью масштабирования, повышения надёжности и отказоустойчивости инфраструктуры. Также был реализован ряд технических обновлений и программ по повышению информационной безопасности и защите персональных данных пользователей.

22.03.2024 [14:56], Сергей Карасёв

Beeline cloud запустил облачный сервис хранения и обработки данных Data PlatformBeeline cloud объявил о запуске облачной платформы Data Platform, предназначенной для хранения и обработки данных любого типа. Говорится, что это фактически экосистема сервисов с возможностью их бесшовной и гибкой интеграции друг с другом. Data Platform является альтернативой системам зарубежных облачных провайдеров, которые начали блокировать доступ для российских пользователей. В основу Data Platform положены open-source-технологий S3, Kafka, NiFi, Greenplum, ClickHouse и PostgreSQL. Утверждается, что новая платформа обеспечивает прозрачность и гибкость использования, позволяет управлять жизненным циклом данных, размещённых в различных корпоративных системах. В состав Data Platform входят три ключевых сервиса. Один из них — Cloud Arenadata DB: это массово-параллельная СУБД для построения корпоративного хранилища данных, основанного на ПО с открытым кодом. Вторым компонентом является Cloud BI — подсистема визуализации и аналитики данных в облаке на базе открытого софта собственной разработки. Третий сервис — объектное хранилище Cloud Object Storage без ограничений по объёму, с возможностью моментального масштабирования и доступом из любой точки.

Источник изображения: pixabay.com Отмечается, что Data Platform даёт возможность хранить, обрабатывать и управлять большим объёмом данных с учётом бизнес-задач. При этом достигается высокая согласованность благодаря объединению разрозненной информации в единую среду управления. Beeline cloud подчёркивает, что инфраструктура обладает высокой надёжностью как на физическом, так и на программном уровне.

21.03.2024 [23:54], Владимир Мироненко

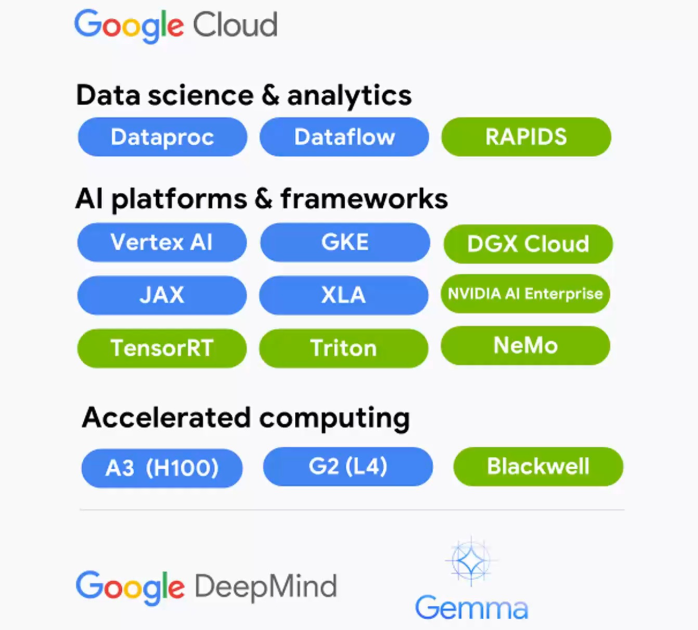

В Google Cloud появятся ускорители NVIDIA Grace BlackwellGoogle Cloud и NVIDIA объявили о расширении партнёрства, в рамках которого новая ИИ-платформа NVIDIA Grace Blackwell и NVIDIA DGX Cloud на её основе появятся в Google Cloud Platform, а клиентам станут доступны инференс-микросервисы NVIDIA NIM. Также было сказано об общедоступности DGX Cloud на базе NVIDIA H100.

Источник изображения: NVIDIA Среди ключевых нововведений отмечены следующие:

21.03.2024 [00:51], Владимир Мироненко

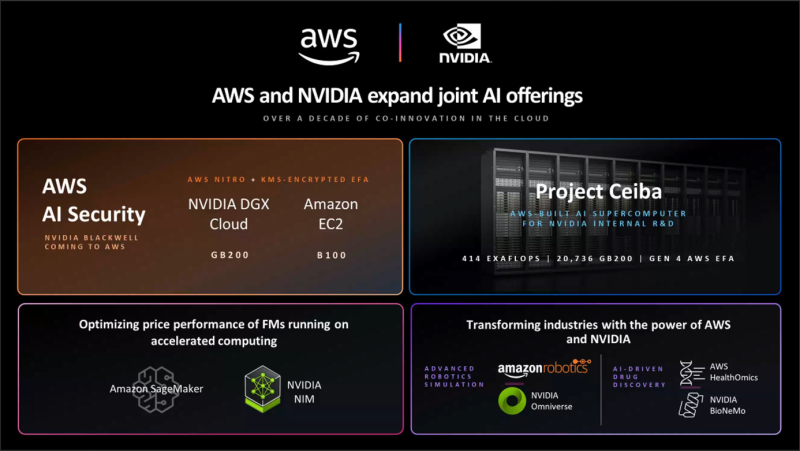

Облачный ИИ-суперкомпьютер AWS Project Ceiba получит 21 тыс. суперчипов NVIDIA GB200

aws

b100

dgx cloud

gb200

gtc 2024

hardware

nvidia

ии

инференс

информационная безопасность

облако

суперкомпьютер

Amazon Web Services (AWS) и NVIDIA объявили о расширении сотрудничества, в рамках которого ускорители GB200 и B100 вскоре появятся в облаке AWS. Кроме того, компании объявили об интеграции Amazon SageMaker с NVIDIA NIM для предоставления клиентам более быстрого и дешёвого инференса, о появлении в AWS HealthOmics новых базовых моделей NVIDIA BioNeMo, а также о поддержке AWS обновлённой платформы NVIDIA AI Enterprise. Сотрудничество двух компаний позволило объединить в единую инфраструктуру их новейшие технологии, в том числе многоузловые системы на базе чипов NVIDIA Blackwell, ПО для ИИ, AWS Nitro, сервис управления ключами AWS Key Management Service (AWS KMS), сетевые адаптеры Elastic Fabric (EFA) и кластеры EC2 UltraCluster. Предложенная инфраструктура и инструменты позволят клиентам создавать и запускать LLM с несколькими триллионами параметров быстрее, в больших масштабах и с меньшими затратами, чем позволяли EC2-инстансы с ускорителями NVIDIA прошлого поколения. AWS предложит кластеры EC2 UltraClusters из суперускорителей GB200 NVL72, которые позволят объединить тысячи чипов GB200. GB200 будут доступны и в составе инстансов NVIDIA DGX Cloud. AWS также предложит EC2 UltraClusters с ускорителями B100. Amazon отмечает, что сочетание AWS Nitro и NVIDIA GB200 ещё больше повысит защиту ИИ-моделей: GB200 обеспечивает шифрование NVLink, EFA шифрует данные при передаче между узлами кластера, а KMS позволяет централизованно управлять ключами шифрования. Аппаратный гипервизор AWS Nitro, как и прежде, разгружает CPU узлов, беря на себя обработку IO-операций, а также защищает код и данные во время работы с ними. Эта возможность, доступная только в сервисах AWS, была проверена и подтверждена NCC Group. Инстансы с GB200 поддерживают анклавы AWS Nitro Enclaves, что позволяет напрямую взаимодействовать с ускорителем и данными в изолированной и защищённой среде, доступа к которой нет даже у сотрудников Amazon. Чипы Blackwell будут использоваться в обновлённом облачном суперкомпьютере AWS Project Ceiba, который будет использоваться NVIDIA для исследований и разработок в области LLM, генерация изображений/видео/3D, моделирования, цифровой биологии, робототехники, беспилотных авто, предсказания климата и т.д. Эта первая в своём роде машина на базе GB200 NVL72 будет состоять из 20 736 суперчипов GB200, причём каждый из них получит 800-Гбит/с EFA-подключение. Пиковая FP8-производительность системы составит 414 Эфлопс.

20.03.2024 [02:17], Владимир Мироненко

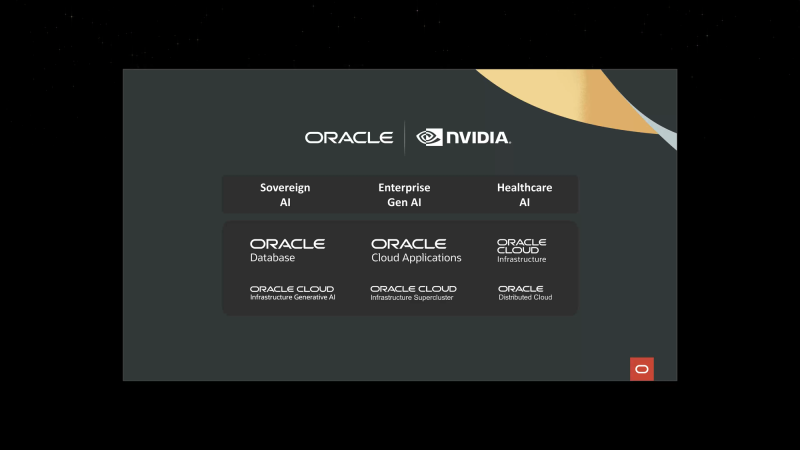

Oracle и NVIDIA предложат суверенные ИИ-фабрики

dgx cloud

gb200

gtc 2024

nvidia

oracle

oracle cloud infrastructure

software

ии

конфиденциальность

облако

частное облако

Oracle и NVIDIA объявили о расширении сотрудничества для предоставления суверенного ИИ клиентам по всему миру — программно-аппаратные решения обеих компаний позволят правительствам и предприятиями формировать ИИ-фабрики, говорится в пресс-релизе. Облачные сервисы Oracle используют ряд платформ NVIDIA, включая аппаратную инфраструктуру и программную платформу NVIDIA AI Enterprise, в том числе недавно анонсированные микросервисы вывода NVIDIA NIM. Такие ИИ-фабрики позволят развернуть облачные сервисы, работающие локально и размещённые в безопасных кампусах на территории страны или организации. Сочетание полнофункциональной ИИ-платформы NVIDIA с корпоративным ИИ-инструментами Oracle, которые можно развернуть в выделенном регионе OCI, позволит получить современное ИИ-решение с повышенным уровенем контроля, защиты и безопасности. По словам Oracle, компания является единственным гиперскейлером, способным предоставлять ИИ-решения и полноценные облачные услуги локально и в любом месте. Oracle также задействует чипы NVIDIA Blackwell (GB200 и B200) в OCI Supercluster и OCI Compute. OCI Supercluster станет значительно быстрее благодаря новым bare metal-инстансам, RDMA-сети со сверхмалой задержкой и высокопроизводительному хранилищу. В OCI появятся и сервисы NVIDIA NIM и CUDA-X, а также NVIDIA NeMo Retriever. Наконец, в DGX Cloud on OCI станут доступны инстансы на базе суперускорителей GB200 NVL72 для работы с LLM с триллионами параметров. Полный кластер DGX Cloud будет включать более 20 тыс. ускорителей GB200, интерконнект NVLink 5 и сеть NVIDIA InfiniBand XDR.

13.03.2024 [19:54], Руслан Авдеев

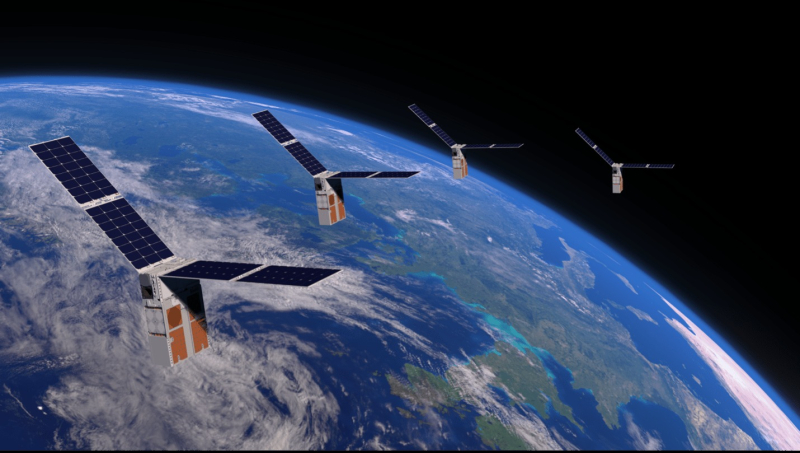

Спутники с GPU: Lumen Orbit намерена развернуть сеть космических микро-ЦОД для ИИ-обработки данныхСтартап Lumen Orbit анонсировал раунд инвестиций, в ходе которого планируется привлечь $2,4 млн на строительство космических дата-центров. По данным Datacenter Dynamics, компания надеется развернуть сотни низкоорбитальных спутников с ускорителями на базе GPU, способных выполнять роль распределённого ЦОД для других космических аппаратов — во многих случаях отпадёт необходимость отправки данных на Землю. По словам главы компании Филипа Джонстона (Philip Johnston), миссия Lumen заключается в запуске группировки орбитальных дата-центров для периферийных вычислений в космосе. Прочие спутники будут отправлять такому космическому ЦОД «сырые» данные на ИИ-обработку, после которой уже готовые результаты будут переправляться на Землю. Это позволит сэкономить пропускную способность космических каналов связи и избежать дорогостоящей переправки массивов данных туда-обратно, да ещё и с высокой задержкой. Компания рассчитывает разместить 300 спутников на высоте около 315 км. Тестовый 60-кг экземпляр намерены отправить уже в мае 2025 года с помощью ракеты SpaceX Falcon 9. Стартап сотрудничает с Ansys и Solidworks, уже подписано несколько меморандумов о взаимопонимании на сумму более $30 млн и даже есть первый потенциальный клиент, который готов опробовать систему в тестовом режиме. Через полгода после теста планируется запустить восемь спутников, а ещё через полгода должны появиться пять орбитальных «колец».

Источник изображения: NASA Lumen стала последней в ряду компаний, желающих разместить вычислительные мощности на орбите. Axiom Space планирует запустить ЦОД на своей космической станции в 2026 году, а NTT и SKY Perfect JSAT уже в 2025 году надеются развернуть спутники для хранения и обработки данных. Крупную вычислительную систему-буксир Blue Ring намерена запустить Blue Origin, но в этом случае речь идёт уже о геосинхронном, а не низкоорбитальном проекте. Концепцию внеземных ЦОД изучают и в Евросоюзе, а ESA сотрудничает с Intel и Ubotica в работе над ИИ-кубсатом PhiSat-1.

12.03.2024 [19:28], Сергей Карасёв

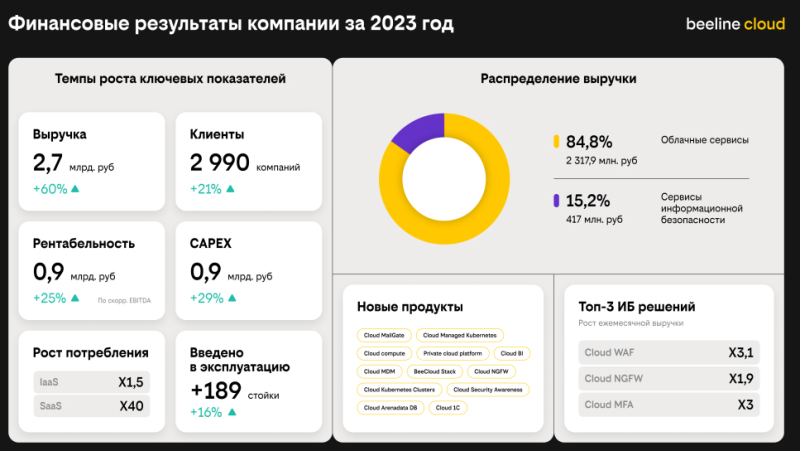

Годовая выручка beeline cloud взлетела на 60 % — до 2,7 млрд руб.Облачная платформа beeline cloud опубликовала показатели деятельности в 2023 году. Выручка достигла 2,7 млрд руб., что на 60 % больше по сравнению с 2022-м. Столь значительный рост, как отмечается, обусловлен расширением спектра предоставляемых услуг и наращиванием присутствия на рынке облачных сервисов. Количество клиентов beeline cloud по итогам 2023-го составило 2990 компаний. Это на 21 % больше в годовом исчислении. Капитальные вложения (CAPEX) оцениваются в 0,9 млрд руб., что соответствует росту на 29 %. Показатель EBITDA увеличился год к году на 25 % — до 0,9 млрд руб. В общем объёме годовой выручки 84,8 %, или 2,3 млрд рублей, пришлось на облачные сервисы. Ещё 15,2 % — около 417 млн руб. — обеспечили сервисы информационной безопасности. По второму сегменту рост годовой выручки зафиксирован на отметке 40,4 %. Среди трёх самых востребованных решений в сфере безопасности называются Cloud WAF с ростом в 3,1 раза по отношению к 2022-му, Cloud NGFW с увеличением продаж в 1,9 раза и Cloud MFA (ИБ-сервис многофакторной аутентификации пользователей) с 3-кратным ростом. В сегменте IaaS годовая выручка поднялась в 1,5 раза, тогда как SaaS-решения показали 40-кратный рост. В течение 2023 года введены в эксплуатацию 189 серверных стоек, что на 16 % больше, чем в 2022-м. Ключевыми достижениями PaaS-направления названы запуск сервисов Managed Kubernetes, а также появление платформы данных и первого сервиса DBaaS на базе Greenplum. В области IaaS упомянут переход на новую архитектуру, что привело к усилению информационной безопасности и значительному улучшению доступности облачных вычислений. Кроме того, в 2023 внедрены новые продукты для управления корпоративными почтовыми сервисами, основанными на платформе Communigate Pro: Cloud Mail Gate и Private Cloud Mail Gate.

01.03.2024 [13:32], Сергей Карасёв

Alibaba значительно снизила цены на облачные услуги в КитаеОблачная платформа Alibaba Cloud, по сообщению ресурса The Register, существенно снизила стоимость услуг для клиентов в Китае, которые заключают многолетние соглашения на обслуживание. Цены на определённые сервисы на базе Alibaba Cloud Elastic Compute Service (ECS) снижены на 36 %. В рамках некоторых соглашений тарифы на объектное хранилище упали на 55 % — при условии увеличения сроков резервирования ресурсов Alibaba Cloud с одного года до двух–пяти лет. Стоимость облачных баз данных снижена до 40 %. При этом удвоен объём бесплатного трафика: он теперь составляет 20 Гбайт против прежних 10 Гбайт. Новая политика, как ожидается, поможет платформе Alibaba Cloud увеличить количество клиентов в КНР и дополнительно стимулировать местные предприятия к переходу на облачные услуги. Кроме того, снижение цен может способствовать развитию приложений на основе ИИ. Причём это уже второе снижение тарифов за год. Ранее облачное подразделение Alibaba столкнулось со снижением темпов роста. В конце прошлого года Alibaba отказалась от планов по выделению облачного бизнеса в самостоятельную публичную компанию. Связано это с ужесточение санкций со стороны США. Говорится, что политика американских властей может негативно повлиять на возможности группы предлагать облачные продукты и услуги, а также выполнять обязательства по существующим контрактам. В такой ситуации Alibaba вынуждена более активно развивать облачный бизнес на китайском рынке. Гиперскейлер также стремился избавиться от низкорентабельных клиентов. Alibaba — не единственная компания, которая пытается сделать долгосрочные контракты более привлекательными для заказчиков. AWS и Microsoft Azure уже сделали резервирование мощностей самым доступным способом потребления своих услуг. Эта тактика позволяет более предсказуемо оценивать расходы на развитие и поддержание облачных инфраструктур.

27.02.2024 [20:45], Руслан Авдеев

Huawei Cloud запустит облачный регион в Египте и построит ИИ-центр в ГонконгеУже в следующем месяце в Египте должен заработать новый облачный регион компании Huawei. Datacenter Dynamics сообщает, что у компании есть и другие планы — она намерена построить облачный вычислительный ИИ-центр в Гонконге. Это первый проект такого рода за пределами материкового Китая. Регион в Египте станет очередным дополнением к 85 зонам Huawei Cloud, разбросанным по 30 странам и территориям планеты. В Китае Huawei является вторым по величине облачным провайдером, но наращивает и глобальное присутствие. Только в прошлом году она ввела в эксплуатацию облачные регионы в Турции и Саудовской Аравии. Кроме того, компания активно осваивает рынки облачных сервисов Латинской Америки. В частности, ведётся строительство регионов в Бразилии и Мексике. Пока нет данных, в каком ЦОД будет размещён египетский регион. Ещё в 2019 году Huawei сообщала о намерении арендовать ЦОД Telecom Egypt в Каире, но, похоже, с тех пор планы по экспансии в Африке и на Ближнем Востоке изменились. Заодно Huawei поделилась планами создания облачного ИИ-центра в Гонконге. Хотя компания имеет несколько подобных объектов на материковой территории КНР, в Гонконге пока ничего подобного у неё нет. При этом в компании назвали ИИ одним из приоритетов для её облачных проектов. Сейчас у оператора есть облачные объекты в материковом Китае и Гонконге, Ирландии, Нидерландах, Франции, Таиланде, Сингапуре, Индонезии, Саудовской Аравии, Турции, Южной Африке, Бразилии, Аргентине, Перу, Чили и других странах. В то же время многие государства по-прежнему считают компанию поставщиком услуг с высоким риском из-за вероятных тесных связей с китайскими властями и крайне напряжённых отношений с США. |

|