Материалы по тегу: azure

|

26.11.2023 [02:16], Владимир Мироненко

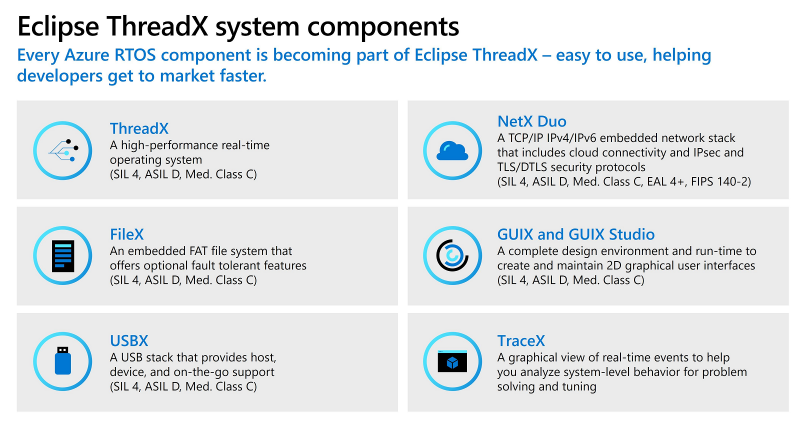

Платформа Microsoft Azure RTOS стала открытой и перешла под эгиду Eclipse FoundationMicrosoft объявила, что набор средств разработки встраиваемых решений Azure RTOS, включающий операционную систему реального времени (ОСРВ) ThreadX, был переведён в категорию решений с открытым исходным кодом под именем Eclipse ThreadX и теперь будет развиваться под эгидой организации Eclipse Foundation. В Eclipse Foundation заявили, что новый проект — «именно то, в чём очень давно нуждался сильно фрагментированный рынок встраиваемого ПО». ThreadX станет первой в мире open source ОСРВ, которая:

Отмечается, что в настоящее время нет аналогичных ОСРВ с открытым исходным кодом, имеющих подобную сертификацию и перечисленные преимущества. Проект Eclipse ThreadX станет доступен в I квартале 2024 года и будет включать ThreadX, NetX Duo, FileX, GUIX, USBX, LevelX, а также соответствующие инструменты и документацию. Microsoft предоставит проекту самые последние сертификаты, чтобы обеспечить непрерывность выпуска сертифицированных релизов. Фонд Eclipse Foundation объявил о создании группы, занимающейся разработкой модели устойчивого финансирования ThreadX, которую согласились поддержать AMD, Cypherbridge, Microsoft, NXP, PX5, Renesas, ST Microelectronics, Silicon Labs и Witekio (Avnet).

24.11.2023 [10:55], Сергей Карасёв

Microsoft увеличит облачную инфраструктуру в Канаде на 750 %, построив несколько новых дата-центровКорпорация Microsoft, по сообщению ресурса Datacenter Dynamics, намерена существенно расширить сеть ЦОД в Канаде. Речь идёт о строительстве нескольких дополнительных объектов, которые расположатся в Квебеке. Инвестиции в проект составят приблизительно $500 млн на протяжении двух лет. У Microsoft уже есть два канадских региона Azure: Canada Central располагается в Торонто (Онтарио), а Canada East — в Квебеке. Оба открылись в 2016 году. При этом в Квебеке действует только одна зона доступности. Строительство новых канадских ЦОД Microsoft намерена начать в ближайшие месяцы. Они будут размещены в Л'Ансьен-Лоретте, Доннаконе, Сен-Огюстен-де-Деморе и Леви. Мощности объектов пока не раскрываются. Но отмечается, что эти дата-центры позволят Microsoft увеличить масштаб локальной облачной инфраструктуры на 750 %.

Источник изображения: Microsoft Ресурсами будущих площадок смогут воспользоваться компании и организации из частного и государственного секторов. ЦОД проектируются с прицелом на НРС и ИИ. Дата-центры создаются с учётом высоких требований к устойчивости и эффективности: предполагается использование низкоуглеродных материалов при строительстве, возобновляемых источников энергии и передовых систем охлаждения. Кроме того, будут предприняты меры по снижению использования дизельного топлива во время эксплуатации. «Эти инвестиции не только предоставят организациям Квебека больше возможностей и дополнительную устойчивость для трансформации операций, но также позволят создать надежную и безопасную основу для более быстрого масштабирования решений и их вывода на рынок», — заявляет Microsoft.

16.11.2023 [02:43], Алексей Степин

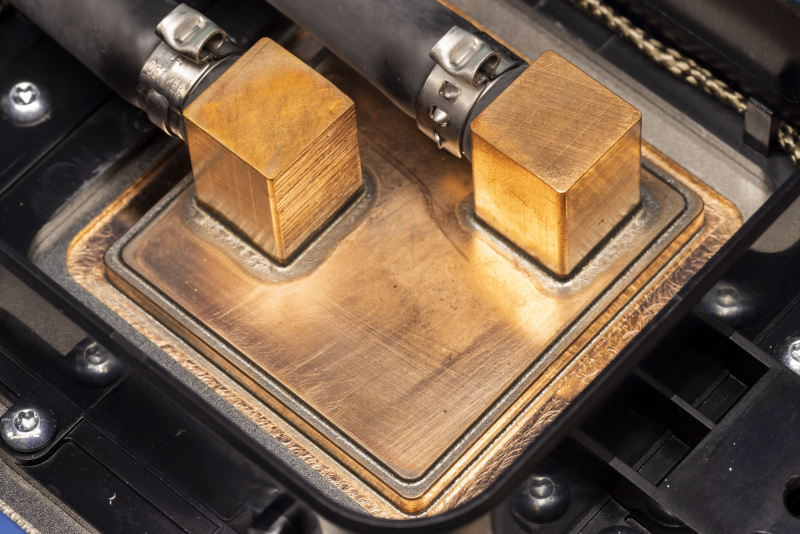

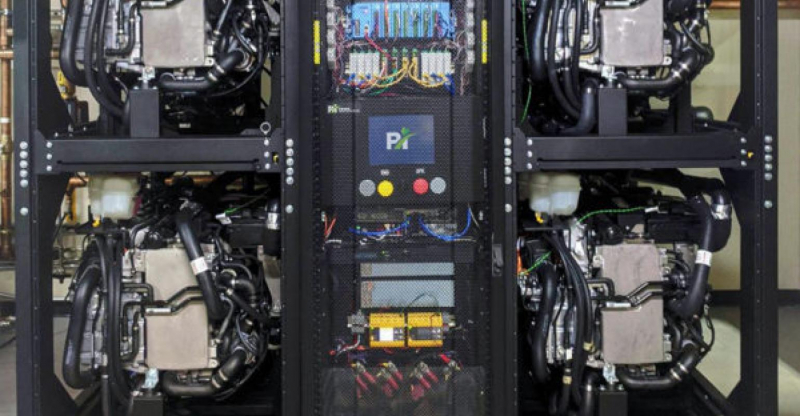

Microsoft представила 128-ядерый Arm-процессор Cobalt 100 и ИИ-ускоритель Maia 100 собственной разработкиГиперскейлеры ради снижения совокупной стоимости владения (TCO) и зависимости от сторонних вендоров готовы вкладываться в разработку уникальных чипов, изначально оптимизированных под их нужды и инфраструктуру. К небольшому кругу компаний, решившихся на такой шаг, присоединилась Microsoft, анонсировавшая Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100. Первопроходцем в этой области стала AWS, которая разве что память своими силами не разрабатывает. У AWS уже есть три с половиной поколения Arm-процессоров Graviton и сразу два вида ИИ-ускорителей: Trainium для обучения и Inferentia2 для инференса. Крупный китайский провайдер Alibaba Cloud также разработал и внедрил Arm-процессоры Yitian и ускорители Hanguang. Что интересно, в обоих случаях процессоры оказывались во многих аспектах наиболее передовыми. Наконец, у Google есть уже пятое поколение ИИ-ускорителей TPU. Microsoft заявила, что оба новых чипа уже производятся на мощностях TSMC с использованием «последнего техпроцесса» и займут свои места в ЦОД Microsoft в начале следующего года. Как минимум, в случае с Maia 100 речь идёт о 5-нм техпроцессе, вероятно, 4N. В настоящее время Microsoft Azure находится в начальной стадии развёртывания инфраструктуры на базе новых чипов, которая будет использоваться для Microsoft Copilot, Azure OpenAI и других сервисов. Например, Bing до сих пор во много полагается на FPGA, а вся ИИ-инфраструктура Microsoft крайне сложна. Microsoft приводит очень мало технических данных о своих новинках, но известно, что Azure Cobalt 100 имеет 128 ядер Armv9 Neoverse N2 (Perseus) и основан на платформе Arm Neoverse Compute Subsystem (CSS). По словам компании, процессоры Cobalt 100 до +40 % производительнее имеющихся в инфраструктуре Azure Arm-чипов, они используются для обеспечения работы служб Microsoft Teams и Azure SQL. Oracle, вложившаяся в своё время в Ampere Comptuing, уже перевела все свои облачные сервисы на Arm. Чип Maia 100 (Athena) изначально спроектирован под задачи облачного обучения ИИ и инференса в сценариях с использованием моделей OpenAI, Bing, GitHub Copilot и ChatGPT в инфраструктуре Azure. Чип содержит 105 млрд транзисторов, что больше, нежели у NVIDIA H100 (80 млрд) и ставит Maia 100 на один уровень с Ponte Vecchio (~100 млрд). Для Maia организован кастомный интерконнект на базе Ethernet — каждый ускоритель располагает 4,8-Тбит/с каналом для связи с другими ускорителями, что должно обеспечить максимально эффективное масштабирование. Сами Maia 100 используют СЖО с теплообменниками прямого контакта. Поскольку нынешние ЦОД Microsoft проектировались без учёта использования мощных СЖО, стойку пришлось сделать более широкой, дабы разместить рядом с сотней плат с чипами Maia 100 серверами и большой радиатор. Этот дизайн компания создавала вместе с Meta✴, которая испытывает аналогичные проблемы с текущими ЦОД. Такие стойки в настоящее время проходят термические испытания в лаборатории Microsoft в Редмонде, штат Вашингтон. В дополнение к Cobalt и Maia анонсирована широкая доступность услуги Azure Boost на базе DPU MANA, берущего на себя управление всеми функциями виртуализации на манер AWS Nitro, хотя и не целиком — часть ядер хоста всё равно используется для обслуживания гипервизора. DPU предлагает 200GbE-подключение и доступ к удалённому хранилищу на скорости до 12,5 Гбайт/с и до 650 тыс. IOPS. Microsoft не собирается останавливаться на достигнутом: вводя в строй инфраструктуру на базе новых чипов Cobalt и Maia первого поколения, компания уже ведёт активную разработку чипов второго поколения. Впрочем, совсем отказываться от партнёрства с другими вендорами Microsoft не намерена. Компания анонсировала первые инстансы с ускорителями AMD Instinct MI300X, а в следующем году появятся инстансы с NVIDIA H200.

21.07.2023 [23:10], Алексей Степин

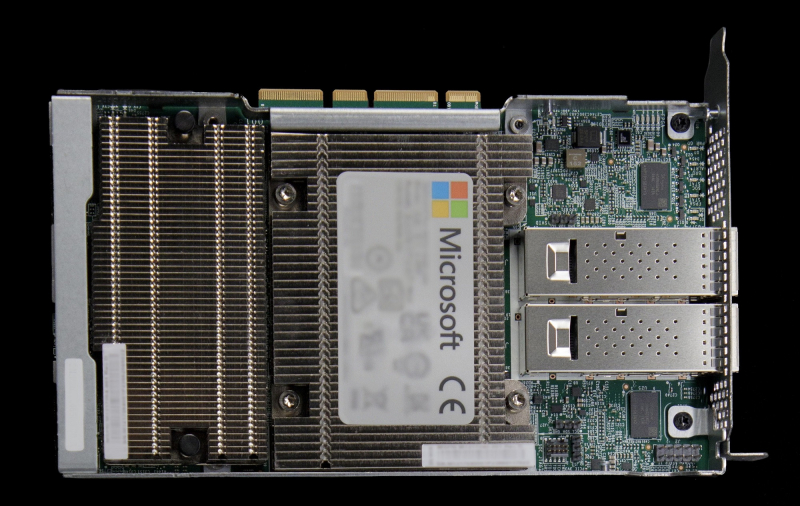

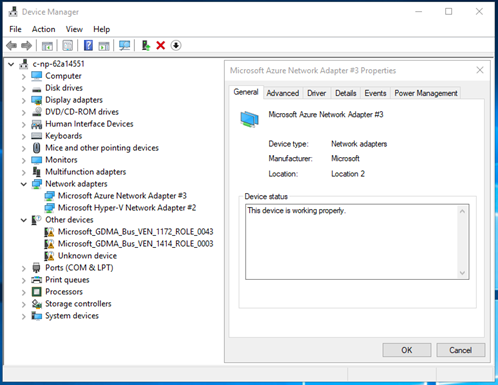

Microsoft предлагает протестировать DPU MANA с Azure BoostКрупные облачные провайдеры давно осознали пользу, которую могут принести DPU и активно применяют подобного рода решения. В частности, AWS давно использует платформу Nitro, Google разработала DPU при поддержке Intel, а Microsoft активно готовит к запуску собственную платформу под названием MANA. Основой MANA является кастомный чип SoC, разработанный специально с учётом обеспечения высокой пропускной способности, стабильности подключения и низкой латентности. DPU на его основе обеспечивает пропускную способность до 200 Гбит/с, а также поддерживает подключение удалённого хранилища данных на скоростях до 10 Гбайт/с при производительности до 400 тыс. IOPS. Отметим, что ранее AMD заявила о появлении DPU Pensando в облаке Azure, а сама Microsoft в прошлом году поглотила разработчика DPU Fungible.

Изображение: Microsoft MANA является частью услуги Azure Boost и берёт на себя управление всеми аспектами виртуализации, включая работу с сетью и данными, а также функции управления хост-системой. Перенос этих функций на отдельную платформу не просто улучшает производительность и масштабируемость, но и обеспечивает дополнительный слой безопасности. MANA уже задействованы в инфраструктуре Azure и подтвердили высочайшую скорость при работе с внешними хранилищами данных для инстансов Ebsv5, а также отличную пропускную способность и низкую латентность сетевого канала для всех инстансов семейств Ev5 и Dv5. MANA поддерживает Windows и Linux, а для более тонкой работы с аппаратной частью ускорителя можно задействовать DPDK. В части информационной безопасности следует отметить наличие криптоядра, соответствующего стандартам FIPS 140. В настоящее время сервис Azure Boost доступен в качестве превью. Компания приглашает к сотрудничеству партнёров и клиентов с высокими запросами к характеристикам сетевого канала и хранилищ.

01.06.2022 [01:18], Владимир Мироненко

Ведущий специалист NERSC перешёл в Microsoft, заявив, что строящиеся экзафлопсные суперкомпьютеры будут последними в своём родеГленн Локвуд (Glenn K. Lockwood), ведущий специалист Национального научного вычислительного центра энергетических исследований (NERSC) при Министерстве энергетики США перешёл на работу в Microsoft. Он является архитектором высокопроизводительных масштабируемых систем хранения данных для суперкомпьютеров. Локвуд, в частности, руководил развёртыванием первого в мире 35-Пбайт All-Flash хранилища с ФС Lustre для суперкомпьютера Perlmutter. В своём блоге Локвуд объяснил, почему он ушёл из NERSC в Microsoft. По его словам, лидирующие HPC-системы балансируют на грани выживания, в то время как HPC-системы среднего клсса практически полностью обесцениваются поставщиками облачных услуг. При текущих тенденциях стоимость строительства нового дата-центра и обширной инфраструктуры питания и охлаждения для каждого нового мощного суперкомпьютера очень скоро станет непомерно высокой, говорит Локвуд. Он высказал мнение, что ЦОД мощностью 50–60 МВт, строящиеся сейчас для экзафлопсных суперкомпьютеров, будут последними в своём роде.

Источник изображения: AMD Что касается менее мощных систем, таких как Perlmutter, то необходимость в них постепенно сокращается по мере того, как облако набирает обороты. «Вы можете установить полную систему [HPE] Cray EX, идентичную той, что вы можете найти в NERSC или OLCF, в Azure <…> и интегрировать её с богатыми инфраструктурными возможностями облака», — говорит Локвуд. Кроме того, облака действительно гораздо быстрее внедряют новинки. Так, процессоры AMD EPYC MilanX и ускорители Instinct MI200 появились в инфраструктуре Microsoft Azure намного раньше, чем в HPC-центрах. «Я не утверждаю, что знаю будущее, и многое из того, что я изложил, является в лучшем случае гипотетическим», — заявил Гленн Локвуд, отметив, что приверженность Министерства энергетики США к независимым HPC-системам сохранится по меньшей мере ещё десятилетие. Локвуд стал очередным специалистом, покинувшем традиционный HPC-сектор и ушедшим в Microsoft. В 2020 году в Microsoft перешёл технический директор Cray Стив Скотт (Steve Scott). Год спустя к Microsoft присоединился соруководитель программы Cray PathForward доктор Дэн Эрнст (Dan Ernst).

14.11.2021 [21:11], Владимир Мироненко

LiquidStack и Microsoft продемонстрировали ИИ-серверы с двухфазным иммерсионным охлаждениемLiquidStack, дочернее предприятие BitFury, специализирующееся на разработке иммерсионных СЖО, и Microsoft продемонстрировали на OCP Global Summit стандартизированное решение с двухфазным погружным жидкостным охлаждением. Демо-серверы Wiwynn, разработанные в соответствии со спецификациями OCP Open Accelerator Infrastructure (OAI), были погружены в бак LiquidStack DataTank 4U, способный отводить порядка 3 кВт/1U (эквивалент 126 кВт на стойку). LiquidStack сообщила, что она впервые оптимизировала серверы OCP OAI для охлаждения путем погружения в жидкость. По словам компании, её двухфазные иммерсионные СЖО DataTank предоставляют наиболее эффективное решение, которое требует немного пространства и потребляет меньше энергии, чем другие системы охлаждения, и вместе с тем повышает плотность размещения компонентов и их производительность.

Фото: LiquidStack В демо-серверах использовались ИИ-ускорители Intel Habana Gaudi, погружённые в жидкий диэлектрик (от 3M) с низкой температурой кипения, который наиболее эффективно отводит тепло благодаря фазовому переходу. Данное решение должно помочь достижению показателя PUE в пределах от 1,02 до 1,03, поскольку оно практически не потребляет энергию. LiquidStack утверждает, что у её СЖО эффективность теплоотвода примерно в 16 раз выше, чем у типичных систем воздушного охлаждения. По мнению компании, системы высокопроизводительных вычислений (HPC) уже сейчас слишком энергоёмки, чтобы их можно было охлаждать воздухом. Поэтому следует использовать платы, специально предназначенные для жидкостного охлаждения, а не пытаться адаптировать те, что были созданы с расчётом на воздушные системы — при использовании СЖО вычислительная инфраструктура может занимать на 60% меньше места.

Изображение: Microsoft LiquidStack и Wiwynn являются партнёрами. В апреле Wiwynn инвестировала в LiquidStack $10 млн. Также Wiwynn протестировала серверы с погружным жидкостным охлаждением в центре обработки данных Microsoft Azure в Куинси (штат Вашингтон). Microsoft, как и другие гиперскейлеры, уже некоторое время изучает возможности иммерсионных СЖО.

01.03.2021 [15:09], Сергей Карасёв

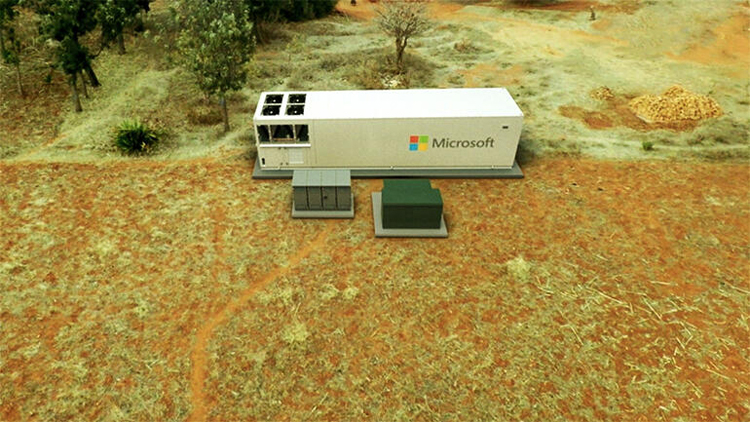

Microsoft Azure MDC: мобильное облако в 40-футовом контейнереКорпорация Microsoft начала поставки любопытного серверного решения — центра обработки данных Azure Modular Data Center (MDC), все составляющие которого заключены в стандартный 40-футовый контейнер. Такое исполнение позволяет перевозить систему на различных видах транспорта и быстро вводить в эксплуатацию. ЦОД может быть развёрнут в любом месте, где есть подходящая площадка для установки контейнера и электрическая сеть необходимой мощности. Более того, питание может подаваться от дизельных генераторов. ЦОД и всё его оборудование сконструированы так, чтобы пережить и транспортировку, и эксплуатацию в не самых благоприятных условиях.  Система позволяет получить доступ к вычислительным мощностям облака Azure. Контейнерный ЦОД может функционировать в суровом климате, обеспечивая бесперебойную работу критически важной инфраструктуры. Платформа MDC может использоваться, к примеру, в центрах гуманитарной помощи, передвижных пунктах управления, а также на территориях предприятий добывающей промышленности. MDC может работать как полностью автономно, так и в связке с «большим» облаком Azure. Причём предусмотрена возможность использования спутниковых средств связи — на случай перебоев в основном интернет-канале. Собственно говоря, именно в рамках совместного со SpaceX проекта Azure Space и были анонсированы эти ЦОД.  Внутри контейнера размещены три серверных блока, каждый из которых содержит две стойки 42U с коммутаторами и контроллерами. На каждый блок приходится 8 серверов и 48 узлов хранения. Все они работают под управлением Azure Stack Hub. Доступ к такому ЦОД предоставляется на условиях аренды, как и в случае более простых и компактных устройств серии Azure Stack Edge.

15.09.2020 [19:33], Алексей Степин

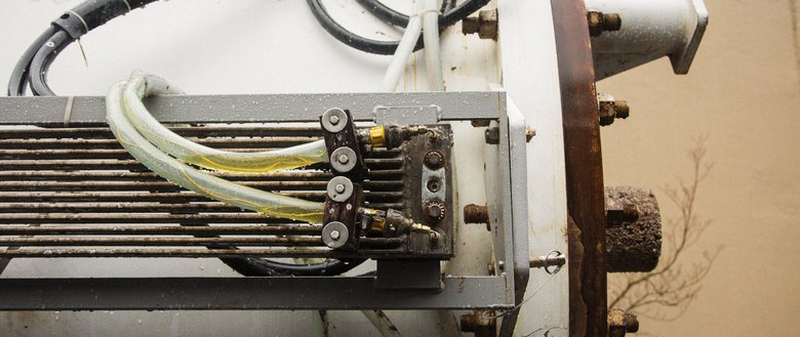

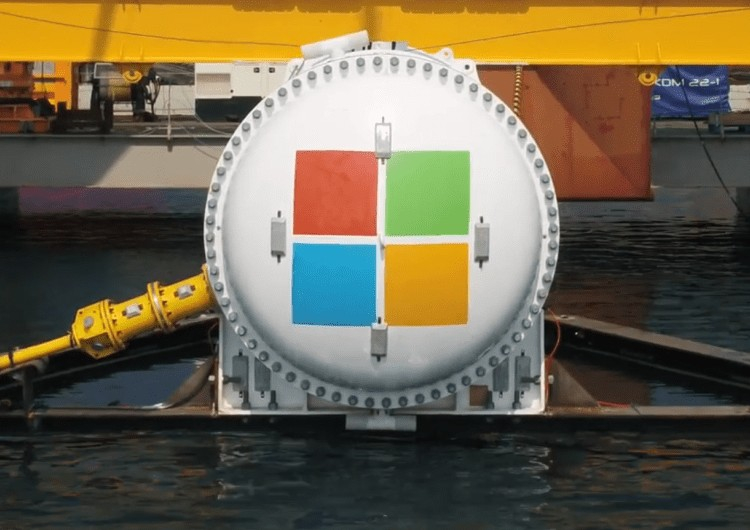

Microsoft Natick может стать будущим периферийных ЦОД, надёжность доказанаЛюбой современный ЦОД — это не только помещение, занимающее определённую площадь, но ещё и серьёзные системы питания и, особенно, охлаждения. Ряд компаний считает, что с точки зрения последнего фактора имеет смысл рассмотреть возможность размещения ЦОД под водой, на дне моря, где температура постоянна и достаточно низка. В их числе Microsoft со своей разработкой Project Natick. Первый прототип Natick, доказавший работоспособность концепции, успешно проработал 105 дней в водах Калифорнийского залива, однако действительно серьёзная мощность была достигнута лишь во второй фазе, о которой и идёт речь в данной заметке. Второй прототип Natick являет собой 12,2-метровый цилиндрический контейнер стандарта ISO 40, внутри размещено 12 стоек с 864 серверами Microsoft (в составе присутствуют ПЛИС-ускорители) и СХД общим объёмом 27,6 Пбайт. Система охлаждения во втором варианте была разработана французской группой Naval Group на основе теплообменников, использующихся в современных подводных лодках.  На этот раз местом размещения подводного ЦОД был выбран район Оркнейских островов в 193 километрах (120 миль) от берега, глубина погружения составляла примерно 35 метров. Для питания и данных использовался общий кабель, содержащий как силовые линии, способные передать около четверти мегаватта, так и оптические волокна. Проект создавался с прицелом на пятилетний срок работы без обслуживания, с прицелом на 20 лет в будущем. Для обеспечения повышенной надёжности внутреннее пространство контейнера заполнено азотом, который практически инертен и способствует уменьшению износа оборудования.  14 сентября Microsoft сообщила об окончании второй фазы Project Natick, которая продлилась два года. Сам контейнер был извлечён из моря ещё летом, и специалисты и эксперты занялись изучением состояния аппаратного обеспечения, входившего в состав второго прототипа автономного ЦОД. Результат проекта признан очень успешным, возглавляющий Project Natick Бен Катлер (Ben Cutler) заявил, что «дело сделано, и второй вариант Natick можно с полным правом назвать подходящим строительным блоком». Согласно статистике, около 50% населения планеты проживает недалеко от берега моря, поэтому размещение подводных ЦОД в прибрежных областях вполне оправдано, а Европейский центр морской энергетики (Europetn Marine Energy Centre) вообще говорит о возможности использования для питания таких ЦОД приливных турбин и волновых конвертеров, что сделает их практически автономными, не считая оптоволоконного подключения.

Часть системы охлаждения Natick Тонкости функционирования Natick ещё предстоит изучить, но предварительные результаты оказались несколько обескураживающими: ЦОД в герметичном контейнере, покоившийся на дне моря, и, естественно, лишённый обслуживания, оказался в восемь раз надёжнее, нежели его копия, расположенная на суше. Причины примерно ясны: стабильные температуры, отсутствие окисляющей атмосферной среды, а также каких-либо серьёзных вибраций. Компания считает, что эти данные могут помочь и в проектировании более надёжных наземных ЦОД.  Microsoft признала, что проект всё ещё далёк от завершения, но считает, что стандартный ЦОД Azure в подводном варианте уже может быть создан. Вице-президент отдела Azure по системам класса mission critical Вильям Чэппел (William Chappell) отметил, что его команда особенно заинтересована в пост-квантовых методах шифрования, критичных для такого рода периферийных центров обработки данных. Также заявлено, что Natick успешно может служить в качестве периферийного ЦОД или ЦОД с повышенной безопасностью; последнее достаточно очевидно — получить доступ к оборудованию, находящемуся под водой, намного сложнее, нежели в обычном ЦОД. Надёжнее в этом плане может быть только сервер на орбите, но по понятным причинам такое решение намного дороже и сложнее, нежели Natick, оно менее мощное, а также не гарантирует постоянной низкой латентности, которая может быть критичной в edge-сценариях использования.

28.07.2020 [11:38], Юрий Поздеев

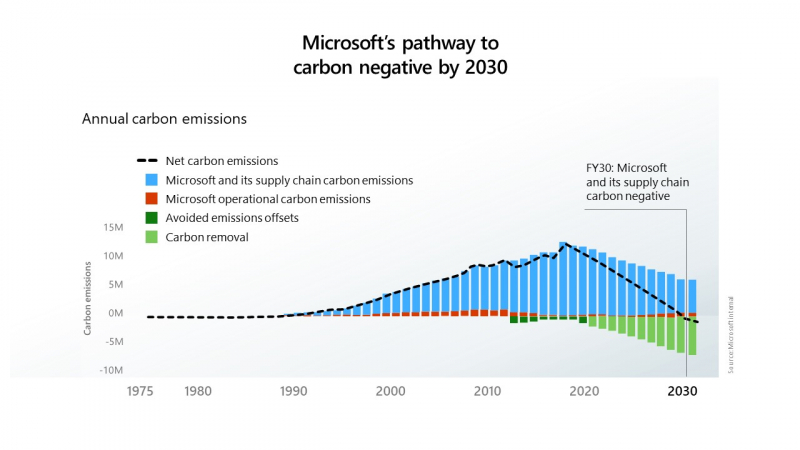

Водород вместо дизеля: Microsoft Azure получит новые источники резервного питанияMicrosoft сообщила, что успешно протестировала использование водородных топливных элементов для резервного питания своих серверов в центрах обработки данных. Это первый шаг к внедрению новых технологий, исключающих использование дизельного топлива в системах аварийного питания. Водород хранился в резервуарах на трейлерах, припаркованных возле лаборатории в Солт-Лейк-Сити, штат Юта. Такой вариант хранения водорода был продемонстрирован в ходе эксперимента, но в дальнейшем планируется использовать стационарные резервуары. Microsoft намерена прекратить использование дизельного топлива к 2030 году в рамках своих инициатив по снижению вредных выбросов.  В эксперименте использовалась нагрузка в виде 10 стоек облачных серверов Microsoft Azure: в течение 48 часов использовалась 250-КВт система на топливных элементах. Такое время работы от топливных элементов выбрано не случайно, поскольку большинство перебоев в подаче электроэнергии длятся менее 48 часов.  Ранее для подобной задачи использовались шесть дизель-генераторов. Следующим шагом Microsoft планирует испытать систему резервного питания на топливных элементах мощностью 3 МВт, чтобы продемонстрировать как масштабируется система для больших дата-центров.  Дизельные генераторы на данный момент являются оптимальным выбором для большинства ЦОД, однако Microsoft стремится к сокращению выбросов углекислого газа и хочет полностью отказаться от дизельного топлива к 2030 году. Цель амбициозная, но достижимая. Пока основным препятствием к ее осуществлению является цена. Водород сам по себе до сих пор остается дорогим топливом, а его транспортировка и хранения обходятся еще дороже. Следует также учесть, что водород более взрывоопасен, чем дизельное топливо, поэтому его хранение может стать большой проблемой для дата-центров, расположенных в крупных городах. Кроме радикальных мер по переводу аварийного питания дата-центров на водород, Microsoft рассматривает и более реальные альтернативы в виде питания генераторов от природного газа, который дает намного меньше выбросов, по сравнению с дизельным топливом, также рассматривается синтетическое дизельное топливо, которое при сгорании выделяет меньше углерода. Проектами по созданию более экологичных источников питания занимаются и другие компании: Rolls-Royce и Daimler Truck AG разработают топливные элементы для ЦОД, а Keppel и Mitsubishi намереваются создать водородную электростанцию. Ещё одной альтернативой могут стать ёмкие аккумуляторы — оператор Switch для своего дата-центра в Неваде построит комплекс из солнечной электростанции мощностью 127 МВт и модулей Tesla MegaPack суммарной ёмкостью 240 МВт∙ч

13.07.2020 [13:58], Юрий Поздеев

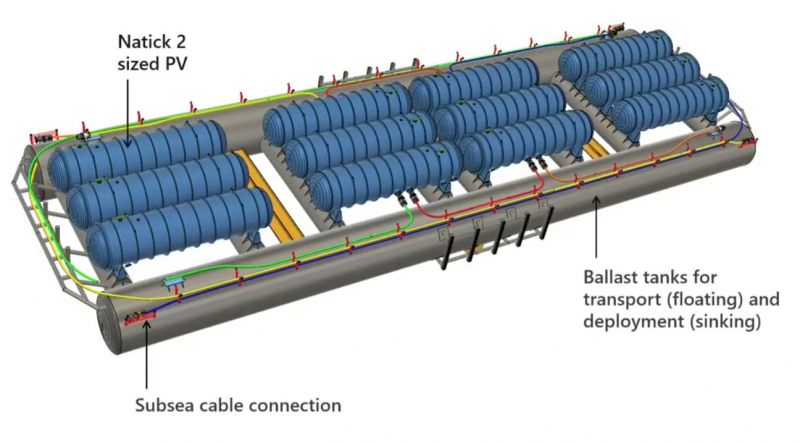

Microsoft продемонстрировала Natick 3 — подводный дата-центр третьего поколенияMicrosoft одновременно решает ряд инженерных задач с проектом Microsoft Azure Natick: снижает эксплуатационные расходы и обеспечивает меньшие задержки для дата-центров. Что же из себя представляет этот уникальный проект?  Начнем с истории: первый концепт Natick представлял собой стойку с серверами в стальной оболочке, которую опустили в океан, чтобы проверить работоспособность идеи. Попытка была удачной, Microsoft доказала, что можно использовать обычные серверы, развернутые в компактном корпусе на расстоянии 200 км в океане, что примерно давало задержку в 1 мс (2 мс в обе стороны). Видео с экспериментальным дата-центром Natick: Первая версия Natick была развернута у берегов Калифорнии и проработала 105 дней, что подтвердило жизнеспособность концепта. Два года спустя Microsoft Research погрузила под воду 14 стоек с серверами у побережья Шотландии. Этот регион был выбран не случайно: именно здесь используется множество возобновляемых источников энергии, что позволило сделать новый Natick еще более экологичным. Видео с демонстрацией Natick второго поколения: После более чем года работы Natick второго поколения Microsoft поделилась некоторыми данными: с точки зрения эффективности энергопотребления Natick демонстрирует коэффициент PUE в 1,07 — это очень мало для текущего производственного центра обработки данных. Низкий PUE означает снижение эксплуатационных расходов, а также делает Natick более экологичным. Обычный наземный дата-центр использует 4,8 литра воды на кВт/ч, при этом Natick не потребляет воду для работы, однако использует ее по-другому (споры с экологами по поводу нагрева океана и влияния на окружающую среду не закончились какими-то конструктивными выводами, по информации от самой Microsoft, влияние Natick на окружающую среду ничтожно мало). Этот аспект особенно актуален для стран, в которых существует дефицит воды и охлаждение дата-центров превращается в существенную проблему. Цилиндрический корпус Natick имеет вакуумную герметизацию, что означает, что серверы и ИТ оборудование избавлены от многих вредных факторов, таких как влажность и пыль. Кроме того, учитывая, насколько хорошо вода поглощает тепло и насколько велики океаны, можно утверждать, что на глубине 200 метров для дата-центра будет поддерживаться постоянная температура, без колебаний, свойственных наземным ЦОД (особенно это актуально для жарких регионов, где приходится использовать системы охлаждения с большим запасом). Natick 2 был рассчитан на эксплуатацию в течение пяти лет без технического обслуживания. Так что же Microsoft может предложить сегодня?  Natick третьего поколения представляет собой множество цилиндрических корпусов, закрепленных на большой стальной раме, в которой проложены коммутационные кабели и кабели питания. Общий размер составляет более 90 м (300 футов), с каждой стороны конструкции есть балластные цистерны для транспортировки и упрощения установки. Natick 3 состоит из 12 цилиндрических корпусов, общая мощность системы достигает 5 МВт, при необходимости могут быть построены и более крупные структуры, так как конструкция модульная и позволяет легко масштабировать мощность при необходимости. Microsoft не единственная компания, которая ведёт разработки в области подводных дата-центров, существуют еще разработки Nautilus Fata Technologies и более мелкие стартапы, однако они находятся только в самом начале пути и не имеют опыта промышленной эксплуатации дата-центров. Одно можно сказать точно: данное направление будет развиваться и в скором будущем мы увидим еще не одно подобное решение. |

|