Лента новостей

|

25.04.2025 [12:02], Сергей Карасёв

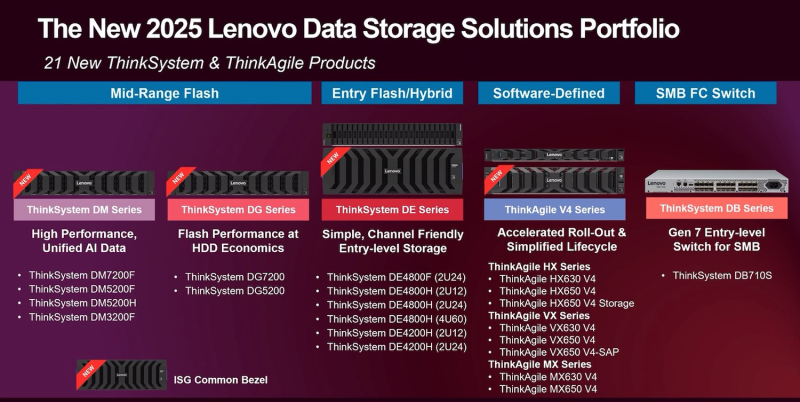

Lenovo обновила портфолио СХД для эпохи ИИКомпания Lenovo анонсировала широкий ассортимент СХД разного класса, предназначенных для поддержания нагрузок, связанных с приложениями ИИ, виртуализацией и пр. В общей сложности представлена 21 модель в семействах ThinkSystem и ThinkAgile для корпоративного сектора. В частности, дебютировали решения серии ThinkAgile SDI V4, применение которых, по заявлениям Lenovo, помогает упростить IT-инфраструктуру. Эти системы подходят в том числе для ИИ-инференса. В свою очередь, новые массивы ThinkSystem обеспечивают до трёх раз более высокую производительность при одновременном снижении энергопотребления по сравнению с СХД Lenovo, построенными на основе HDD. В результате, общая экономия энергии может достигать 97 % при повышении плотности хранения информации на 99 %. Новые конвергентные гибридные облачные и виртуализированные решения Lenovo ThinkAgile и ThinkSystem обеспечивают гибкое и эффективное масштабирование вычислительных мощностей и ресурсов хранения независимо друг от друга. Благодаря этому суммарные расходы на лицензирование ПО сокращаются на 40 %. Кроме того, выделяются устройства ThinkAgile HX Series GPT-in-a-Box, особенностью которых является применение системы жидкостного охлаждения Lenovo Neptune. По сравнению с решениями предыдущего поколения достигается уменьшение энергопотребления на 25 %. В целом, как утверждается, системы ThinkAgile SDI V4 Series и новые массивы ThinkSystem предоставляют полнофункциональную, готовую к использованию инфраструктуру для предприятий, которые начинают внедрение ИИ. При этом обеспечивается высокая производительность при работе с LLM.

25.04.2025 [00:32], Владимир Мироненко

Стараниями Илона Маска IBM потеряла миллионные контракты, но всё равно превзошла ожидания аналитиков по итогам кварталаIBM сообщила финансовые результаты I квартала 2025 года, завершившегося 31 марта. Несмотря на то, что выручка компании и прибыль превзошли ожидания аналитиков Уолл-стрит, её акции упали на 6 %, что отчасти связано с потерей ряда контрактов, которые отменил или отложил Департамент эффективности правительства (DOGE) под руководством Илона Маска (Elon Musk). Финансовый директор IBM Джим Кавано (Jim Kavanaugh) сообщил агентству Bloomberg, что рекомендации DOGE привели к отмене или приостановке 15 контрактов компании с государственными учреждениями на сумму около $100 млн. Однако, как пишет The Register, в ходе телефонной конференции с аналитиками Уолл-стрит он уже говорил об отмене всего лишь «нескольких контрактов», из-за чего потери составили менее $100 млн. Генеральный директор IBM Арвинд Кришна (Arvind Krishna) заявил, что усилиями DOGE в I квартале была отменена всего лишь «пара контрактов». Это, например, сделка с агенством USAID, которое был закрыто агентством Маска. Он назвал влияние расторжения контрактов незначительным, но отказался делать прогнозы по этому поводу относительно будущих кварталов.

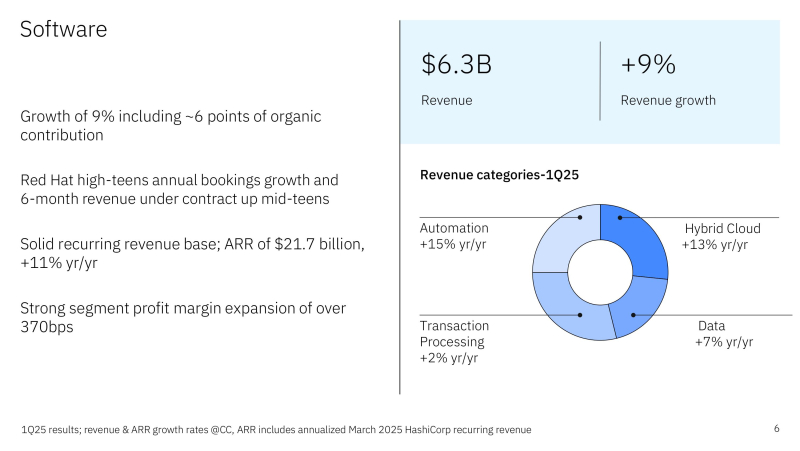

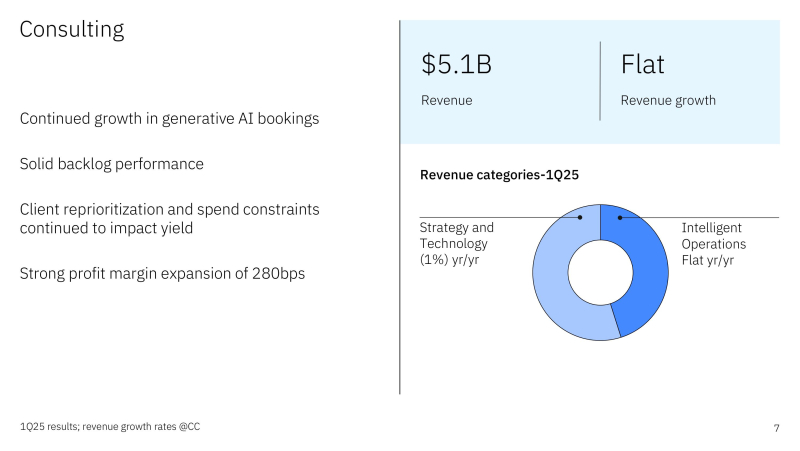

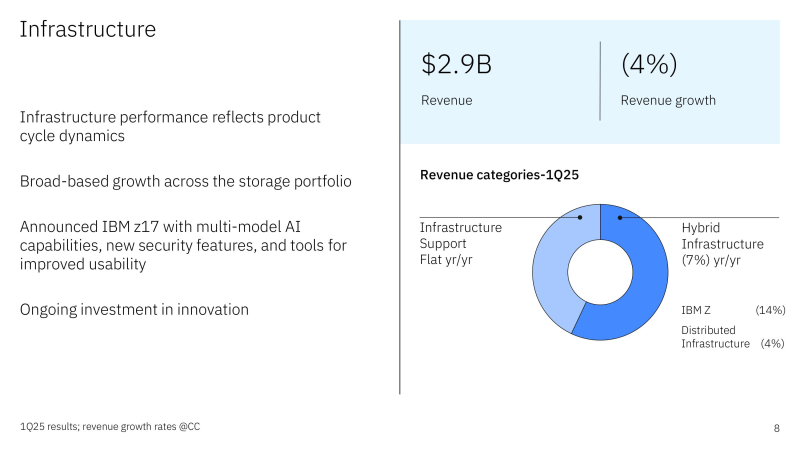

Источник изображений: IBM Чистая прибыль (GAAP) компании составила $1,06 млрд или $1,12 на акцию, что меньше результата в $1,61 млрд или $1,72 на акцию годом ранее. Скорректированная чистая прибыль (Non-GAAP) в размере $1,60 на акцию оказалась ниже прошлогоднего показателя в $1,68, но превзошла прогноз аналитиков в размере $1,40 (по данным CNBC). Выручка выросла на 0,6 % за квартал с $14,46 млрд годом ранее до $14,54 млрд в отчётном квартале при прогнозе $14,4 млрд. При этом выручка от разработки ПО выросла на 7 % до $6,34 млрд, что соответствует консенсус-прогнозу аналитиков, опрошенных StreetAccount. Категория гибридного облачного ПО, включающая Red Hat, показала рост на 12 %, тогда как в IV квартале рост составил 16 % — это уже седьмой квартал подряд продолжающегося роста выручки подразделения. Выручка подразделения по автоматизации увеличилась год к году на 14 %, выручка подразделения по обработке данных и ИИ — на 5 %. Консалтинговое подразделение IBM принесло $5,07 млрд дохода, что на 2 % меньше год к году и немного выше консенсус-прогноза аналитиков StreetAccount в $5,05 млрд. Доходы консалтингового сегмента IBM остались почти на прежнем уровне, поскольку «клиенты откладывают принятие решений в дискреционных (зависящих от личного усмотрения) проектах», сообщил Кавано. IBM прогнозирует, что её консалтинговый бизнес будет в обозримом будущем расти на 5–6 % в год и видит стратегическую ценность в его способности стимулировать продажи инфраструктуры. Инфраструктурное подразделение компании, сообщило о снижении дохода на 6 % до $2,89 млрд, что выше консенсус-прогноза аналитиков в $2,76 млрд. Падение произошло в основном из-за сокращения продаж мейнфреймов z16, находящихся в конце жизненного цикла. Ранее в этом месяце IBM представила их замену — мейнфрейм z17. По словам Кришны, z17 обеспечивает улучшенные ИИ-возможности за счёт мультимодальности, новых функций безопасности для защиты данных и инструментов, которые используют ИИ для повышения удобства использования системы. Кроме того, новинка более энергоэффективна и производительна, добавил он. Также упала выручка от гибридной инфраструктуры — на 9 %, распределённой инфраструктуры — на 5 % и инфраструктуры поддержки — на 3 %. «Мы превзошли ожидания по выручке, прибыльности и свободному денежному потоку, чему способствовала сила всего нашего портфолио ПО», — заявил Кришна. «По-прежнему сохраняется высокий спрос на генеративный ИИ, и наш портфель заказов составляет более $6 млрд с начала года по сегодняшний день, увеличившись более чем на $1 млрд за квартал», — добавил он. Кавано отметил, что компания внедрила ИИ в более чем 70 рабочих процессов и сократила расходы более чем на $1 млрд за счёт повышения эффективности цепочки поставок. Чтобы укрепить доверие инвесторов, IBM вопреки своей давней практике не публиковать квартальные прогнозы, сообщила прогноз на II квартал. «Сейчас, в свете беспрецедентной динамики неопределённости, происходящей на рынке, мы решили дать прогноз по выручке на II квартал, — сказал Кавано. — Мы сочли себя обязанными предоставить как можно больше прозрачности нашей группе инвесторов». Во II квартале IBM прогнозирует выручку в размере от $16,4 до $16,75 млрд. В середине диапазона — $16,58 млрд — это опережает консенсус-прогноз аналитиков, опрошенных LSEG, в $16,33 млрд. IBM также подтвердила свой прогноз на 2025 год по свободному денежному потоку в размере $13,5 млрд и росту выручки не менее 5 %. Акции IBM выросли с начала года почти на 12 %, в то время как индекс S&P 500 упал более чем на 8 %. Руководство IBM утверждает, что компания хорошо подготовилась к тому, чтобы выдержать торговую войну, поскольку всего 5 % её расходов приходится на импортные товары, пишет SiliconANGLE. Федеральные правительственные контракты также составляют менее 5 % выручки компании.

24.04.2025 [21:08], Руслан Авдеев

Швеция не нашла следов намеренного повреждения кабелей на Балтике, но Китай всё равно мешает расследованиюШведские власти объявили, что предварительное расследование повреждений кабелей в Балтийском море не выявило признаков диверсии. Ранее сообщалось, что обрыв кабелей C-Lion1 (Финляндия–Германия) и BCS East-West (Литва–Швеция) в ноябре 2024 года, возможно, являлся актом саботажа со стороны экипажа китайского судна Yi Peng 3, напоминает Datacenter Dynamics. По словам следователей, на текущий момент факт намеренного повреждения достоверно не установлен, но следствие всё ещё продолжается. Вместе с тем расследованию серьёзно мешает Китай. Китайские власти позволили следственной группе из представителей близлежащих стран подняться на борт судна, но «препятствовали нормальным следственным процедурам». Шведская сторона говорит, что многое указывает на несчастный случай, но если злоумышленник что-то делает намеренно, он будет принимать меры для того, чтобы избежать обнаружения настолько, насколько это возможно. Ранее было установлено, что судно Yi Peng 3 проходило над кабелями приблизительно в то время, когда они были повреждены. В последнее время в Балтийском море пострадали другие кабели. В частности, в конце 2024 года был повреждён подводный кабель Estlink 2 между Финляндией и Эстонией и трёх интернет-кабелей между этими же странами, а также кабель между Финляндией и Германией. Финские власти даже задержали корабль Eagle S, попавший под подозрение, но в итоге следов диверсии выявлено не было. В январе подводный кабель, связывавший Латвию и шведский остров Готланд (Gotland) стал последней «жертвой» в серии инцидентов в Балтийском море. Латвийские власти заявили, что кабель был повреждён в результате воздействия «внешних факторов». После того, как шведские власти взяли под контроль грузовое судно, ответственное за происшествие, расследование показало, что виноваты, вероятно, погодные условия и вряд ли это было актом саботажа. А в феврале пострадал уже кабель «Ростелекома» между Санкт-Петербургом и Калининградом. Страны НАТО организуют в регионе активную защиту инфраструктуры в Балтийском море в рамках инициативы Baltic Sentry и других проектов. В декабре 2024 года появилась информация о тестировании плавучих беспилотников, Швеция выделила три корабля и самолёт для патрулирования, а Германия объявила о запуске подводного патрульного беспилотника.

24.04.2025 [17:08], Руслан Авдеев

Видеосервис для совместной работы MWS TeamStream на треть сократит время общения сотрудниковMWS объявила о запуске решения TeamStream для совместной работы распределённых команд сотрудников. TeamStream позволит заменить переписки и звонки видеосообщениями, что даст возможность на 35 % сократить время коммуникации между сотрудниками. В России объём такого рынка оценивают в 4,5–6 млрд руб., сообщает пресс-служба компании. Основным преимуществом TeamStream называется возможность в «один клик» записывать видео и звук (с экрана и камеры) — как через браузер, так и с помощью приложений для Windows и macOS. Дополнительно пользователи смогут комментировать материалы, обмениваться ссылками, редактировать видеоконтент и др., объединяясь в «командные пространства». По словам компании, TeamStream открывает возможности для совместной интерактивной разработки и экономит до 32 часов в месяц на сотрудника. Сервис использует встроенные ИИ-инструменты, для автоматического транскрибирования речи и создания текстовых резюме видеозаписей. Утверждается, что сервис подходит разработчикам, тестировщикам, дизайнерам, аналитикам и другим специалистам, в т.ч. для создания обучающих видео, презентаций, инструкций и получения обратной связи. Готовый контент можно будет пересылать как приватно, так и широкому кругу интернет-пользователей. TeamStream войдёт в пакет сервисов МТС для совместной работы в рамках программы импортозамещения. Целевой аудиторией называются фрилансеры, самозанятые специалисты, а также малый и средний бизнес, имеющий штат до 50 человек. Крупный бизнес тоже сможет пользоваться TeamStream, размещая соответствующее ПО на собственных серверах. В этом случае оступны SSO, глубокая кастомизация и постоянная техническая поддержка. Реализация пилотного проекта TeamStream уже началась в B2B-сегменте и среди корпоративных клиентов в целом. В IV квартале запланирован полноценный вывод продукта на рынок.

24.04.2025 [16:38], Руслан Авдеев

Meta✴ предложила Amazon и Microsoft «скинуться» на обучение ИИ-моделей LlamaMeta✴ уже вложила миллионы долларов в создание и развитие открытых ИИ-моделей семейства Llama, но обучение крупных LLM требует всё больше средств. Поэтому, как сообщает The Information, Meta✴ попросила помощи у своих «коллег», Microsoft и Amazon, что довольно странно, поскольку Meta✴ сама располагает огромными вычислительными ресурсами. Четыре источника сообщили, что Meta✴ предложила этим компаниям некие «стимулы» вроде возможности влиять на развитие будущих ИИ-моделей Llama. В чём выгода Microsoft и Amazon в этом случае, не совсем понятно, поскольку они сами работают над ИИ-проектами, причём в основном коммерческими, тогда как Meta✴ зарабатывает преимущественно на рекламе. Кроме того, Llama относится к open source проектам, так что спонсировать создание сильного конкурента на рынке не слишком выгодно. По данным минимум двух источников, помимо «наиболее серьёзных» дискуссий с Amazon и Microsoft, переговоры также велись с Databricks, IBM, Oracle и представителями как минимум одного ближневосточного инвестора. Meta✴ также обсуждала с компаниями создание группы Llama Consortium в начале 2025 года. В ходе дискуссий, по слухам, она в первую очередь просила денег, а также серверы или другие ресурсы, которые компенсировали бы стоимость обучения моделей. Дополнительно обсуждались иные формы поддержки потенциальных партнёров. Например, высокопоставленные представители Meta✴ могли бы поучаствовать в конференциях партнёров или более подробно рассказать о процессе обучения моделей. Окончательные результаты переговоров не опубликованы, но в обозримом будущем, вероятно, можно будет отследить, в каких мероприятиях конкурентов будут активно участвовать представители Meta✴. В ноябре 2024 года сообщалось, что для обучения новейшей на тот момент модели Llama-4 использовалось более 100 тыс. ускорителей NVIDIA H100. А в марте NVIDIA анонсировала ИИ-модели Llama Nemotron с регулируемым «уровнем интеллекта» на базе решений Meta✴.

24.04.2025 [13:21], Сергей Карасёв

Сэм Альтман уйдёт с поста председателя правления разработчика модульных реакторов OkloГенеральный директор OpenAI Сэм Альтман (Sam Altman), по сообщению ресурса Datacenter Dynamics, намерен покинуть пост председателя совета директоров стартапа Oklo, который специализируется на разработке малых модульных ядерных реакторов (SMR). Компания Oklo проектирует SMR Aurora Powerhouse на быстрых нейтронах. Мощность таких установок сможет достигать 75 МВт. Ожидается, что реакторы будут востребованы прежде всего среди операторов крупных дата-центров и гиперскейлеров, которым угрожает дефицит энергоресурсов на фоне стремительного развития ИИ. Альтман занимал должность председателя правления Oklo с 2015 года. После его ухода соответствующие обязанности возьмёт на себя генеральный директор и соучредитель стартапа Джейк ДеВитт (Jake DeWitte). Альтман отмечает, что для него наступило подходящее время уйти в отставку. Oklo активно изучает варианты стратегического партнёрства для масштабного развёртывания реакторов, в частности, для питания ИИ ЦОД. Под руководством ДеВитта, как ожидается, стартап сможет максимально реализовать свой потенциал.

Источник изображения: OpenAI «Мы глубоко ценим лидерские качества Сэма [Альтмана] и его преданность нашей миссии. Мы продолжим работу по внедрению чистых источников энергии в секторе ИИ и за его пределами, а также будем развивать стратегические партнёрства с ведущими компаниями в области ИИ, включая OpenAI», — отметила Кэролайн Кокран (Caroline Cochran), соучредитель и главный операционный директор Oklo. Компания Oklo уже получила заказы на поставки SMR суммарной мощностью свыше 14 ГВт. В конце 2024 года стартап заключил необязывающее соглашение о поставках 12 ГВт оператору ЦОД Switch. Кроме того, подписаны договор на 500 МВт с Equinix, PPA с Prometheus Hyperscale на 100 МВт, а также партнёрские соглашения с двумя неназванными операторами ЦОД на 750 МВт.

24.04.2025 [13:11], Руслан Авдеев

МТС развернула ВОЛС протяжённостью 1250 км в Республике Коми и Ненецком АОПАО «МТС» запустило в коммерческую эксплуатацию в Республике Коми и Ненецком автономном округе магистральную оптоволоконную линию связи (ВОЛС) на участке Ухта — Печора — Усинск — Нарьян-Мар. Протяжённость линии превысила 1250 км, дополнительно вдоль магистрали модернизирована инфраструктура мобильной связи, сообщает пресс-служба компании. Благодаря новому проекту ёмкость транспортной сети МТС в регионах увеличилась более чем втрое, выросло качество доступа в интернет и увеличилась пропускная способность сетей. Также создан «задел» для абонентской базы, предоставления новых сервисов и перехода к стандарту мобильной связи 5G. Благодаря запуску новой ВОЛС инфраструктура двух регионов была объединена в общую резервируемую цифровую сеть, пропускная способность которой составляет до 100 Гбит/с. С этой целью дополнительно установлены 16 узлов транспортной сети DWDM и 19 узлов MBH (Mobile Backhaul) на опорной мобильной сети, простирающейся от Нарьян-Мара (Заполярье) до Кирова (Поволжье). Инвестиции в проект составили более 880 млн руб. с 2021 года.

Источник изображения: Michail Dementiev/unsplash.com Как сообщают в МТС, долгое время в Коми единственным решением для оказания услуг связи была аренда каналов наземных и спутниковых линий. С ростом потребления трафика перед компанией встала задача создания собственных цифровых магистралей для связи с федеральной сетью МТС. Теперь местные жители получат доступ к современным цифровым сервисам и широкополосному интернету, дополнительно регионы получат импульс для социально-экономического развития. Подчёркивается, что наличие собственной инфраструктуры в регионах позволило компании сократить операционные затраты, связанные с арендой каналов связи. В долгосрочной перспективе появилась возможность масштабирования ёмкости, внедрения новых решений для клиентов и даже развёртывания мобильных сетей нового поколения. До конца 2025 года в МТС намерены завершить строительство в Коми отводов от ВОЛС до узлов транспортной цифровой сети и базовых станций.

24.04.2025 [11:39], Сергей Карасёв

TerraMaster представила стоечный NAS U4-500 на базе Intel Alder LakeКомпания TerraMaster анонсировала сетевое хранилище U4-500 для предприятий малого и среднего бизнеса. Новинка функционирует под управлением TOS 6, предоставляя доступ к набору инструментов TerraMaster BBS (Business Backup Suite) — это комплексное решение для резервного копирования и восстановления информации. Устройство выполнено в форм-факторе 1U на аппаратной платформе Intel Alder Lake. Задействован процессор Core i3-1215U, который содержит шесть ядер (2Р+4Е) с максимальной тактовой частотой 4,4 ГГц в турбо-режиме. Доступны два слота для модулей DDR5 SO-DIMM: объём оперативной памяти в базовой конфигурации составляет 8 Гбайт, в максимальной — 64 Гбайт. NAS оснащён четырьмя фронтальными отсеками для накопителей LFF/SFF с интерфейсом SATA-3. Максимальная суммарная вместимость составляет 96 Тбайт при использовании четырёх HDD по 24 Тбайт каждый. Поддерживается горячая замена. Возможно формирование массивов RAID 0/1/5/6/10. Предусмотрены также два коннектора для NVMe SSD типоразмера M.2 2280 с интерфейсом PCIe 4.0 x4. Хранилище оборудовано двумя сетевыми портами 10GbE RJ45, тремя разъёмами USB 3.1 Type-A, одним портом USB 3.1 Type-C, а также интерфейсом HDMI 2.0. Габариты составляют 45 × 440 × 360 мм, масса — 4,1 кг без установленных накопителей. Используется блок питания мощностью 90 Вт. За охлаждение отвечают три вентилятора диаметром 40 мм. Диапазон рабочих температур — от 0 до +40 °C. Пакет TerraMaster BBS включает Duple Backup (DB), Centralized Backup (CB), TerraSync (TS), CloudSync и Snapshot. Инструмент Duple Backup предназначен для аварийного восстановления данных на серверах резервного копирования TerraMaster. Модуль Centralized Backup обеспечивает централизованное резервное копирование информации с компьютеров сотрудников, файловых серверов и виртуальных машин на локальный сервер TerraMaster. Средства TerraSync отвечают за синхронизацию данных между несколькими серверами резервного копирования и компьютерами. CloudSync облегчает работу с облачными решениями аварийного восстановления. Функция Snapshot позволяет создавать снимки и восстанавливать файловые системы и папки, обеспечивая защиту от атак вымогателей.

24.04.2025 [09:34], Руслан Авдеев

Доступ к чистой воде становится одной из главных забот для операторов ИИ ЦОДСтремительное развитие мировой инфраструктуры ЦОД на фоне повсеместного внедрения ИИ ведёт к огромным затратам питьевой воды на охлаждение оборудования. В результате возникают финансовые, операционные и репутационные риски, сообщает Datacenter Knowledge. По данным доклада агентства Moody, нехватка воды нарастает на ключевых рынках ЦОД. Консалтинговая компания сообщает о растущих рисках для операторов ИИ ЦОД, особенно гиперскейлеров. В докладе подчёркивается, что желание облачных гигантов в целом арендовать новые дата-центры может привести к ограничению доступности ресурсов на некоторых рынках. Большинство новых крупных ЦОД используют водные системы охлаждения, более подходящие для больших нагрузок, но требующие больше воды. ЦОД, которые не смогут установить системы охлаждения с эффективным расходом воды, могут столкнуться с повышенным вниманием со стороны регуляторов и инвесторов. Как сообщили в Moody, дефицит грунтовых вод представляет серьёзный риск для быстрорастущих регионов размещения ЦОД гиперскейлеров — юго-востока США, Чили и Индии. Местные законы, инфраструктурные ограничения и общественное недовольство могут привести к тому, что гиперскейлеры могут отложить реализацию проектов или перенести их в другие, более благоприятные для бизнеса локации, особенно если препятствия приведут к увеличению цены в прежних местах.

Источник изображения: Claudio Biesele/unsplash.com В зависимости от климата и типа инфраструктуры один объект гиперскейл-уровня может потреблять миллионы литров воды в день, наравне с небольшими городами. Хотя компании успешно повысили эффективность использования воды (WUE) до 0,2–0,5 л/кВт∙ч, общий спрос на чистую воду со стороны индустрии ЦОД продолжает расти в связи с быстрым ростом гиперскейлеров и ИИ-инфраструктуры. IT-гиганты могут отложить попытки стать водно-положительными. По информации аналитиков JLL, наиболее известные игроки рынка ЦОД заблаговременно принимают меры, связанные с возможной будущей нехваткой воды и электричества, выбирая подходящие места для строительства и используя поэтапный подход в реализации проектов. Основной вызов — в сохранении баланса между заявляемыми целями и требованиями к безотказной работе и рентабельности. СЖО и адиабатические системы охлаждения могут обеспечить низкий расход воды, но несут собственные риски и сложности — нельзя жертвовать надёжностью ради экоустойчивости. Опытные операторы ищут компромисс, например, используя гибридные подходы к охлаждению. Другие изучают возможность применения очищенных сточных вод, модульного охлаждения или замкнутых систем, но такие варианты часто дороги, особенно при оснащении новыми решениями существующих объектов. Правда, современные «безводные» технологии достаточно рискованны, т.к. отсутствует статистика их применения.

Источник изображения: Olga Angelucci/unsplash.com Более того, в засушливых регионах ЦОД всё чаще конкурируют за ресурсы с местными жителями и сельскохозяйственным бизнесом. Такая конкуренция может привести к ужесточению законов, общественным протестам и задержкам в реализации проектов. По мере того, как нагрузка на окружающую среду будет расти, ужесточатся проверки регуляторов и вырастут репутационные риски, что скажется и на ценах. Инвесторы всё чаще обращают внимание на подобные вопросы, и компании вынуждены, например, покупать «зелёные облигации». А муниципалитеты теперь требуют оценки воздействия на водные ресурсы до того, как выдадут разрешения на строительство. Подобные меры могут стать более распространёнными по мере того, как будут ужесточаться критерии экоустойчивости и отчётности. С точки зрения кредитных рисков заблаговременная модернизация инфраструктуры дата-центров оценивается позитивно и соответствует растущему спросу арендаторов на экоустойчивые решения. Напротив, задержки в обновлении могут сигнализировать о недостатке инвестиций в адаптацию к экологическим требованиям, что в перспективе способно снизить конкурентоспособность оператора.

24.04.2025 [00:15], Владимир Мироненко

Китайские IT-гиганты всё-таки успели закупить NVIDIA H20 на миллиарды долларов до объявления новых санкцийВедущие интернет-компании Китая, включая ByteDance, Alibaba и Tencent, успели сделать запасы урезанных ИИ-ускорителей NVIDIA H20 на миллиарды долларов, прежде чем США прекратили поставки чипов в апреле, сообщил ресурс Nikkei Asia со ссылкой на источники в отрасли. По словам источников, эти компании ещё в прошлом году начали готовиться к тому, что Вашингтон может ограничить и их поставки. Один из источников сообщил, что эти компании обратились к NVIDIA с просьбой поставить в общей сложности около 1 млн ускорителей H20 — примерно годовой запас — как можно скорее, в идеале к концу мая. Он добавил, что по факту было поставлено меньше из-за того, что администрация Трампа объявила о необходимости лицензирования поставок этих чипов в начале апреля. Ещё один источник утверждает, что стоимость срочных заказов превысила $12 млрд, и что NVDIA успела отгрузить чипов на несколько миллиардов долларов до того, как вступили в силу новые требования. Согласно источникам, ByteDance была одной из самых активных в скупке чипов, стремясь приобрести их как можно больше. На активность компаний повлиял резкий роста спроса на ИИ-мощности в Китае, особенно после громкого дебюта DeepSeek в начале этого года. В феврале Tencent начала интегрировать DeepSeek в свою платформу WeChat с аудиторией более 1,2 млрд пользователей, что значительно увеличило требования к вычислительным ресурсам. Топ-менеджер компании сообщил, что ограничения на поставки H20 не стали неожиданностью, поскольку их уже ожидали в отрасли. «Каждая крупная китайская технологическая компания заранее запасалась H20», — отметил он. Помимо размещения срочных заказов на поставку передовых чипов, китайские компании производили закупки чипов NVIDIA за пределами Китая, где они не подпадают под экспортный контроль США, сообщили источники Nikkei Asia. Также для доступа к ИИ-ускорителям китайские игроки прибегали к созданию дочерних компаний или филиалов за рубежом или заключали соглашения о сотрудничестве с отраслевыми партнёрами, такими как операторы связи. «Они знали, что это произойдет, и были готовы к этому дню. Они сказали нам, что их агрессивная цель построить больше ЦОД в этом году остается неизменной», — рассказал топ-менеджер поставщика компаний ByteDance и Alibaba Cloud. Помимо материкового Китая и Гонконга, Alibaba управляет ЦОД в 13 странах, включая два в США, в то время как у ByteDance есть ЦОД в странах Юго-Восточной Азии и Европы, включая Ирландию и Норвегию. Между тем, китайские провайдеры ЦОД ускоряют процесс валидации ИИ-чипов местного производства, таких как Ascend от Huawei, говорят источники. В начале апреля Huawei представила собственный суперускоритель CloudMatrix 384 на базе 384 ускорителей Huawei Ascend 910C в качестве альтернативы NVIDIA GB200 NVL72. H20 — это дважды ослабленная версия NVIDIA H100. H20 имеет примерно одну десятую вычислительной мощности H100 для обучения ИИ и всего 20 % от его возможностей по инференсу. Тем не менее, он очень популярен в Китае. Специалист по ИИ из Гонконга Юджин Ли (Eugene Lee) сообщил, что конфигурация H20 оптимизирована для инференса, в отличие от высокопроизводительных возможностей обучения чипов H100 и H800. Если поставки H20 закончатся, его можно будет частично заменить отечественными альтернативами или облачными решениями для моделей малого и среднего размера. Вместе с тем развёртывание и постоянная оптимизация больших ИИ-моделей могут быть существенно ограничены. Ли отметил, что обучение многих мощных ИИ-моделей обеспечивается ранее закупленными H100 и H800, а основные поставщики облачных услуг также используют их для инференса. «Если существующие запасы H100 и H800 будут исчерпаны, это может серьёзно затруднить обучение передовых моделей и разработку систем следующего поколения, что создаст существенную угрозу конкурентоспособности Китая в разработке высокопроизводительного ИИ», — сказал эксперт. NVIDIA предупредила, что экспортные ограничения на H20 пойдут на пользу её конкурентам. 15 апреля компания заявила, что ущерб от этого за квартал составит около $5,5 млрд. В минувшем финансовом году, который закончился 26 января, на Китай пришлось около 13,1 % от общего дохода NVIDIA, тогда как годом ранее этот показатель составлял почти 17 %. Доля Сингапура, напротив, выросла до 18 % с 11,2 % в предыдущем году. Впрочем, NVIDIA отметила, что эти цифры группируются по месту выставления счетов клиентам, и многие клиенты используют Сингапур для централизации расчётов и поставок чипов в другие места. По фактическим поставкам Сингапур принёс NVIDIA менее 2 % от общего дохода за этот период. |

|