Материалы по тегу: к

|

15.09.2023 [11:29], Сергей Карасёв

СХД DDN AI400X2 показала быстродействие до 16,2 Гбайт/с в ИИ-тесте MLPerf Storage v0.5Компания DataDirect Networks (DDN), специализирующаяся на платформах хранения данных для НРС-систем, сообщила о том, что её массив AI400X2 NVMe показал высокие результаты в ИИ-бенчмарке MLPerf Storage v0.5 при выполнении задач сегментации изображений и обработки естественного языка. Платформа AI400X2 совмещает параллельную файловую систему с новым алгоритмом сжатием данных на стороне клиента. Утверждается, что по сравнению с альтернативными решениями достигается увеличение производительности до 10 раз. В частности, в тесте MLPerf Storage v0.5 при использовании одного узла AI400X2 продемонстрирована пропускная способность на уровне 16,2 Гбайт/с. Утверждается, что этого достаточно для обслуживания 40 высокопроизводительных ИИ-ускорителей. В многоузловой конфигурации скорость передачи данных достигает 61,6 Гбайт/с, что позволяет поддерживать работу до 160 ускорителей ИИ.

Источник изображения: DDN DDN заявляет, что продемонстрированные в бенмарке MLPerf Storage v0.5 показатели говорят о повышении эффективности СХД приблизительно на 700 % в расчёте на каждый узел по сравнению с конкурирующими локальными решениями. Отмечается, что возможность поддерживать ИИ-нагрузки и большие языковые модели с высоким уровнем эффективности и масштабируемости, одновременно минимизируя энергопотребление и занимаемую площадь ЦОД, имеет решающее значение при внедрении передовых приложений и сервисов.

14.09.2023 [16:55], Сергей Карасёв

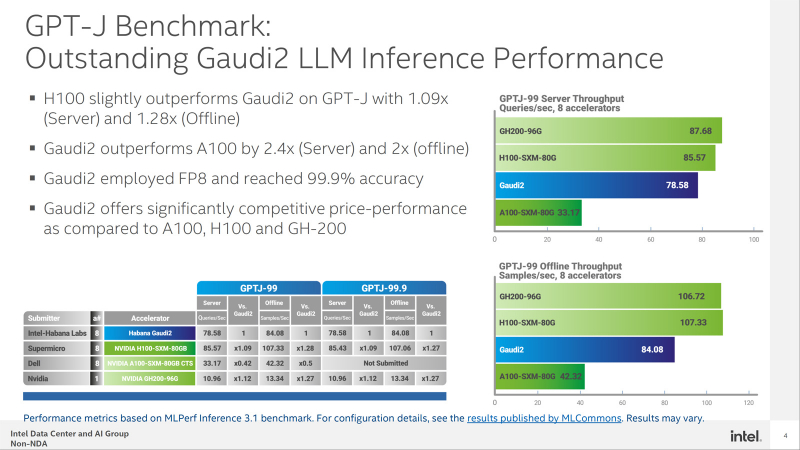

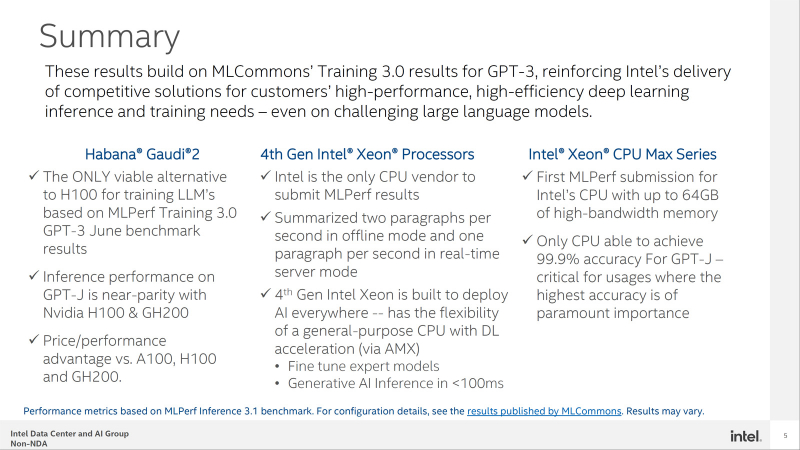

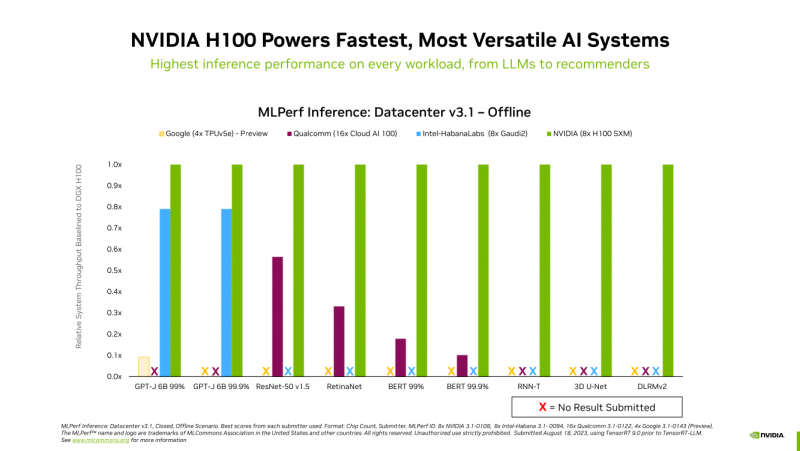

Конкуренцию NVIDIA H100 в MLPerf пока может составить только Intel Habana Gaudi2Корпорация Intel обнародовала результаты тестирования ускорителя Habana Gaudi2 в бенчмарке GPT-J (входит в MLPerf Inference v3.1), основанном на большой языковой модели (LLM) с 6 млрд параметров. Полученные данные говорят о том, что это изделие может стать альтернативой решению NVIDIA H100 на ИИ-рынке. В частности, в тесте GPT-J ускоритель H100 демонстрирует сравнительно небольшое преимущество в плане производительности по сравнению с Gaudi2 — ×1,09 в серверном режиме и ×1,28 в оффлайн-режиме. При этом Gaudi2 превосходит ускоритель NVIDIA A100 в 2,4 раза в режиме server и в 2 раза в оффлайн-режиме. Кроме того, решение Intel опережает H100 на моделях BridgeTower. Этот тест обучен на 4 млн изображений. Говорится, что точность Visual Question Answering (VQAv2) достигает 78,73 %. При масштабировании модель имеет ещё более высокую точность — 81,15 %, превосходя модели, обученные на гораздо более крупных наборах данных. Тест GPT-J говорит о конкурентоспособности Habana Gaudi2. При онлайн-обработке запросов этот ускоритель достигает производительности 78,58 выборки в секунду, а в автономном режиме — 84,08 выборки в секунду. Для сравнения: у NVIDIA H100 эти показатели равны соответственно 85,57 и 107,33 выборки в секунду. В дальнейшем Intel планирует повышать производительность и расширять охват моделей в тестах MLPerf посредством регулярных обновлений программного обеспечения. Но Intel всё равно остаётся в догоняющих — NVIDIA подготовила открытый и бесплатный инструмент TensorRT-LLM, который не только вдвое ускоряет исполнение LLM на H100, но и даёт некоторый прирост производительности и на старых ускорителях.

13.09.2023 [13:45], Сергей Карасёв

«Тренировочный» суперкомпьютер Polaris показал высокое быстродействие СХД в тестах MLPerf Storage AIАргоннская национальная лаборатория Министерства энергетики США сообщила о том, что вычислительный комплекс Polaris, предназначенный для решения ИИ-задач, устанавливает высокие стандарты производительности СХД в бенчмарке MLPerf Storage AI. Суперкомпьютер Polaris, разработанный в сотрудничестве с Hewlett Packard Enterprise (HPE), объединяет 560 узлов, соединенных между собой посредством интерконнекта HPE Slingshot. Каждый узел содержит четыре ускорителя NVIDIA A100 и два накопителя NVMe вместимостью 1,6 Тбайт каждый. Задействована платформа хранения HPE ClusterStor E1000, которая предоставляет 100 Пбайт полезной ёмкости на 8480 накопителях. Заявленная скорость передачи данных достигает 659 Гбайт/с. Вычислительный комплекс смонтирован на площадке Argonne Leadership Computing Facility (ALCF). Пиковая производительность составляет около 44 Пфлопс.

Источник изображения: ALCF Быстродействие Lustre-хранилища оценивалась с использованием двух рабочих нагрузок MLPerf Storage AI — UNet3D и Bert. Данные размещались как в основном хранилище, так и на NVMe-накопителях в составе узлов суперкомпьютера, что позволило эмулировать различные рабочие нагрузки ИИ. В тесте UNet3D с интенсивным вводом-выводом суперкомпьютер достиг пиковой пропускной способности в 200 Гбайт/с для основного хранилища HPE ClusterStor E1000. В случае NVMe-накопителей продемонстрирован результат на уровне 800 Гбайт/с. Менее интенсивная рабочая нагрузка Bert также показала высокие результаты, что говорит о возможности эффективного выполнения современных ИИ-задач.

11.09.2023 [23:01], Алексей Степин

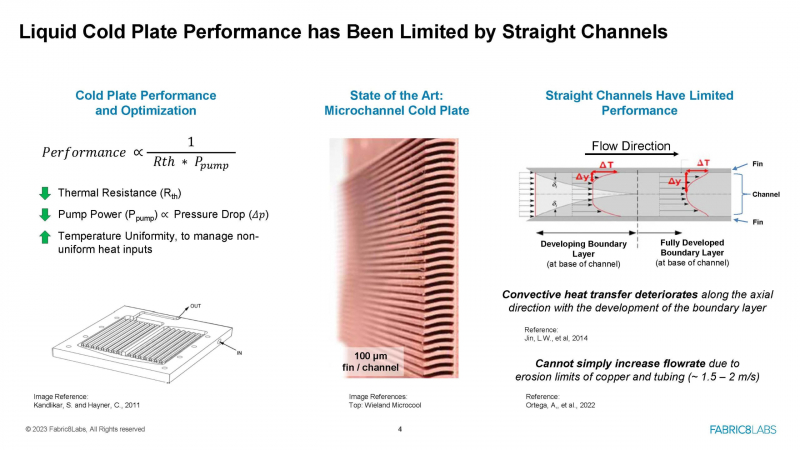

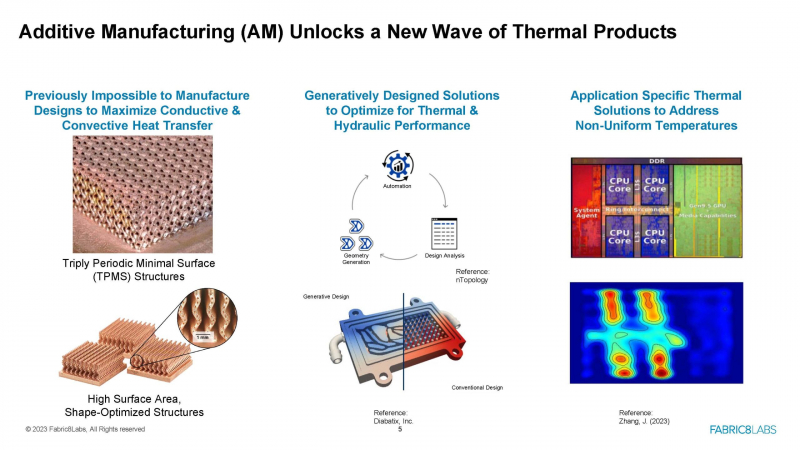

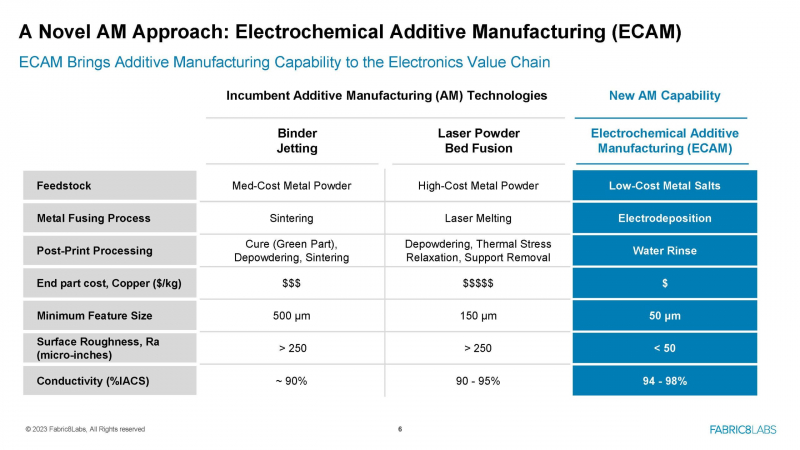

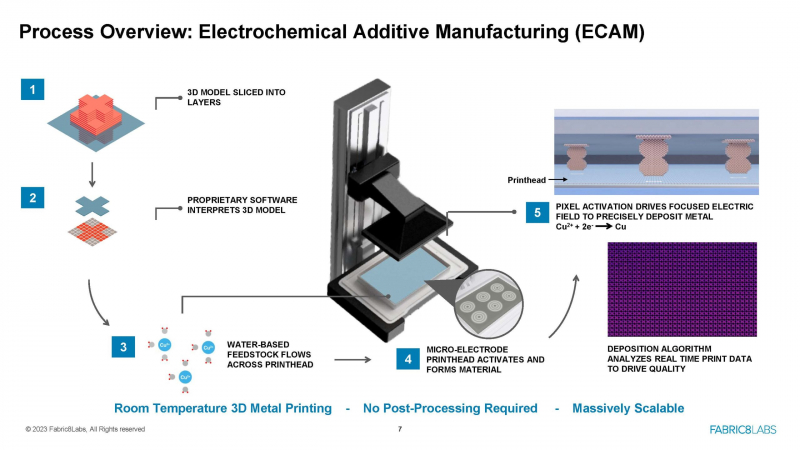

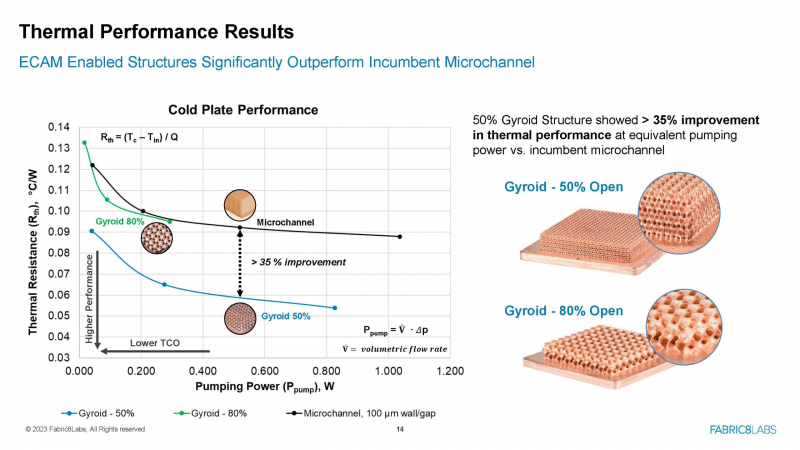

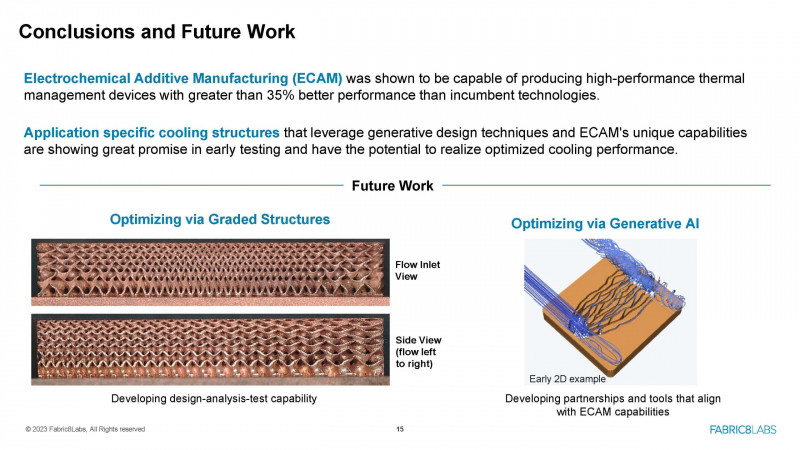

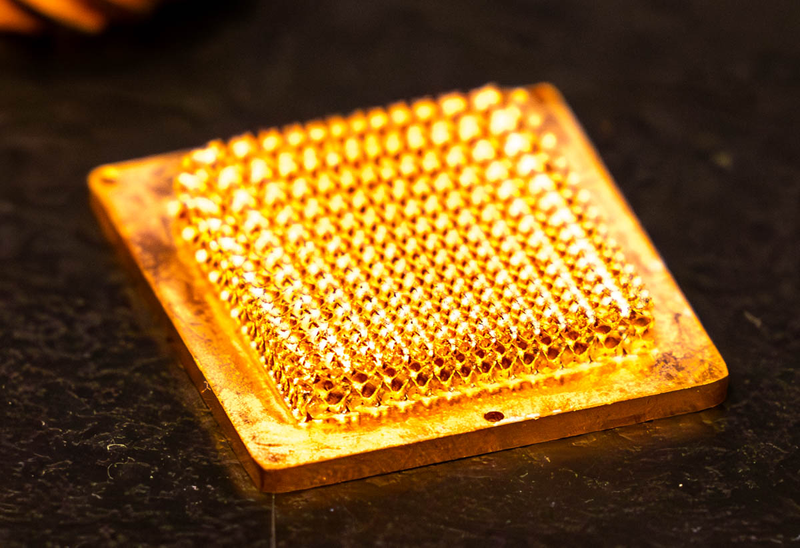

Уникальная 3D-печать Fabric8Labs позволит поднять эффективность СЖО на 35 %На заре СЖО действительно существовали и предлагались совершенно разные конфигурации водоблоков, но постепенно восторжествовала единственная вариация — микроканальная. Совершенство достигнуто? Компания Fabric8Labs считает, что нет, и таким системам есть куда расти, но только при отказе от традиционных технологий изготовления водоблоков и радиаторов охлаждения. Свое видение будущего СЖО она продемонстрировала на конференции Hot Chips 2023.

Источник изображений здесь и далее: Fabric8Labs via ServeTheHome Микроканальная конструкция довольно проста и реализуется классическими методами механической ообработки, которая способна обеспечить ширину каналов и толщину рёбер на уровне 100 мкм. У прямых каналов, впрочем, существует свой предел производительности теплоотвода, накладываемый самой физикой процесса. Рост же тепловыделения современных процессоров отнюдь не собирается останавливаться: уже в порядке вещей теплопакеты в районе боле 300 Ватт, а для сложных ускорителей и того больше. Fabric8Labs считает, что за счёт применения более сложных канальных структур эффективность теплосъёма можно существенно повысить. Формирование таких структур предполагается методом аддитивной печати. Классические методы такой печати в металлургии имеют довольно высокую себестоимость и требуют недёшевых компонентов, а сам техпроцесс имеет много стадий, достаточно энергоёмок и далеко не всегда позволяет получить достаточно гладкие поверхности. Компания Fabric8Labs предлагает уникальную электрохимическую печать, не требующую применения дорогостоящих порошков, а вместо этого использующую дешёвые соли металлов. Техпроцесс в этом случае состоит всего из двух частей: направленного электроосаждения и промывки. По себестоимости такой метод существенно превосходит любые другие методы металлической 3D-печати. Печать Fabric8Labs позволяет получать на выходе сложные гироидные структуры (TPMS), лучше омываемые теплоносителем. Как показывают проведённые компанией эксперименты, водоблоки с такой структурой могут быть на 35 % эффективнее классических микроканальных. Также представляет интерес возможность печати нерегулярных структур, имеющих оптимальную производительность для разных чиплетов процессора с разными тепловыми характеристиками. При разработке таких структур возможно использование методов оптимизации с помощью генеративного ИИ. Благодаря своей дешевизне и относительной простоте, методы, предлагаемые Fabric8Labs, выглядят весьма перспективно. В настоящее время технология находится в экспериментальной фазе, но компания рассматривает возможность строительства первой фабрики уже в 2024 году в Сан-Диего (США), а также открыта для сотрудничества с другими производителями систем охлаждения, если предлагаемая технология вызовет интерес крупных заказчиков.

11.09.2023 [19:00], Сергей Карасёв

Много памяти, быстрая шина и правильное питание: гибридный суперчип GH200 Grace Hopper обогнал H100 в ИИ-бенчмарке MLPerf InferenceКомпания NVIDIA сообщила о том, что суперчип NVIDIA GH200 Grace Hopper и ускоритель H100 лидируют во всех тестах производительности ЦОД в бенчмарке MLPerf Inference v3.1 для генеративного ИИ, который включает инференс-задачи в области компьютерного зрения, распознавания речи, обработки медицинских изображений, а также работу с большими языковыми моделями (LLM). Ранее NVIDIA уже объявляла о рекордах H100 в новом бенчмарке MLPerf. Теперь говорится, что суперчип GH200 Grace Hopper впервые прошёл все тесты MLPerf. Вместе с тем системы, оснащенные восемью ускорителями H100, обеспечили самую высокую пропускную способность в каждом тесте MLPerf Inference. Решения NVIDIA прошли обновленное тестирование в области рекомендательных систем (DLRM-DCNv2), а также выполнили первый эталонный тест GPT-J — LLM с 6 млрд параметров. Примечательно, что GH200 оказался до 17 % быстрее H100, хотя чип самого ускорителя в обоих продуктах один и тот же. NVIDIA объясняет это несколько факторами. Во-первых, у GH200 больше набортной памяти — 96 Гбайт против 80 Гбайт. Во-вторых, ПСП составляет 4 Тбайт/с, а сам чип является гибридным, так что для передачи данных между LPDDR5x и HBM3 не используется PCIe. В-третьих, GH200 при низкой нагрузке на CPU умеет отдавать часть энергии ускорителю, оставаясь в заданных рамках энергопотребления. Правда, в тестах GH200 работал на полную мощность, т.е. с TDP на уровне 1 кВт (UPD: NVIDIA уточнила, что реально потребление GH200 под полной нагрузкой составляет 750–800 Вт).

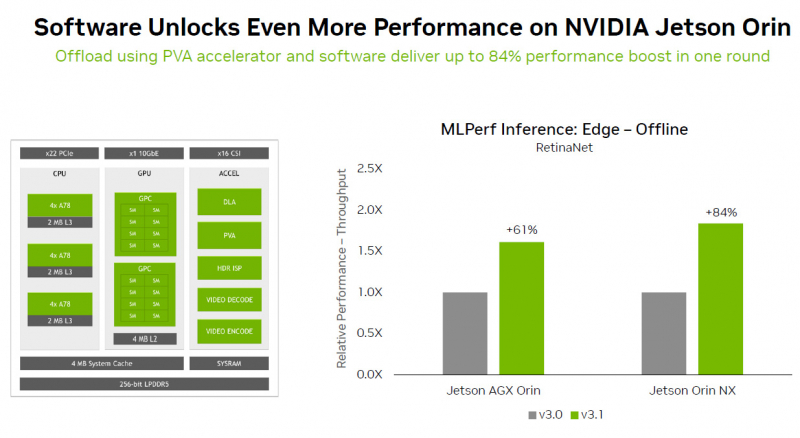

Источник изображений: NVIDIA Отдельно внимание уделено оптимизации ПО — на днях NVIDIA анонсировала открый программный инструмент TensorRT-LLM, предназначенный для ускорения исполнения LLM на продуках NVIDIA. Этот софт даёт возможность вдвое увеличить производительность ускорителя H100 в тесте GPT-J 6B (входит в состав MLPerf Inference v3.1). NVIDIA отмечает, что улучшение ПО позволяет клиентам с течением времени повышать производительность ИИ-систем без дополнительных затрат. Также отмечается, что модули NVIDIA Jetson Orin благодаря новому ПО показали прирост производительности до 84 % на задачах обнаружения объектов по сравнению с предыдущим раундом тестирования MLPerf. Ускорение произошло благодаря задействованию Programmable Vision Accelerator (PVA), отдельного движка для обработки изображений и алгоритмов компьютерного зрения работающего независимо от CPU и GPU. Сообщается также, что ускоритель NVIDIA L4 в последних тестах MLPerf выполнил весь спектр рабочих нагрузок, показав отличную производительность. Так, в составе адаптера с энергопотреблением 72 Вт этот ускоритель демонстрирует в шесть раз более высокое быстродействие, нежели CPU, у которых показатель TDP почти в пять раз больше. Кроме того, NVIDIA применила новую технологию сжатия модели, что позволило продемонстрировать повышение производительности в 4,4 раза при использовании BERT LLM на ускорителе L4. Ожидается, что этот метод найдёт применение во всех рабочих нагрузках ИИ. В число партнёров при проведении тестирования MLPerf вошли поставщики облачных услуг Microsoft Azure и Oracle Cloud Infrastructure, а также ASUS, Connect Tech, Dell Technologies, Fujitsu, Gigabyte, Hewlett Packard Enterprise, Lenovo, QCT и Supermicro. В целом, MLPerf поддерживается более чем 70 компаниями и организациями, включая Alibaba, Arm, Cisco, Google, Гарвардский университет, Intel, Meta✴, Microsoft и Университет Торонто.

06.09.2023 [19:20], Алексей Степин

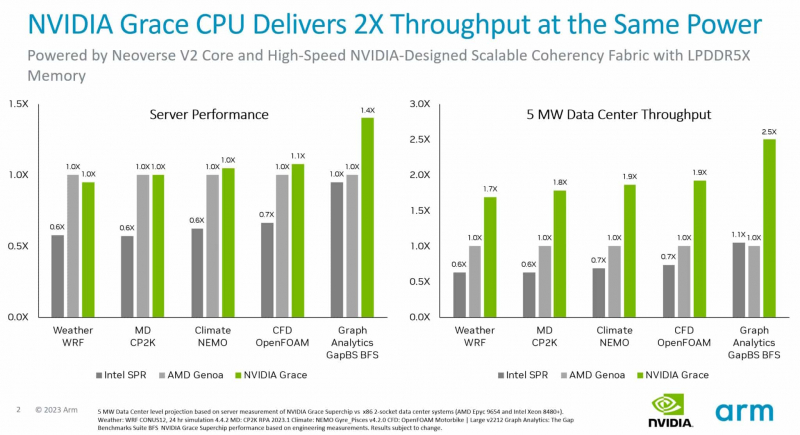

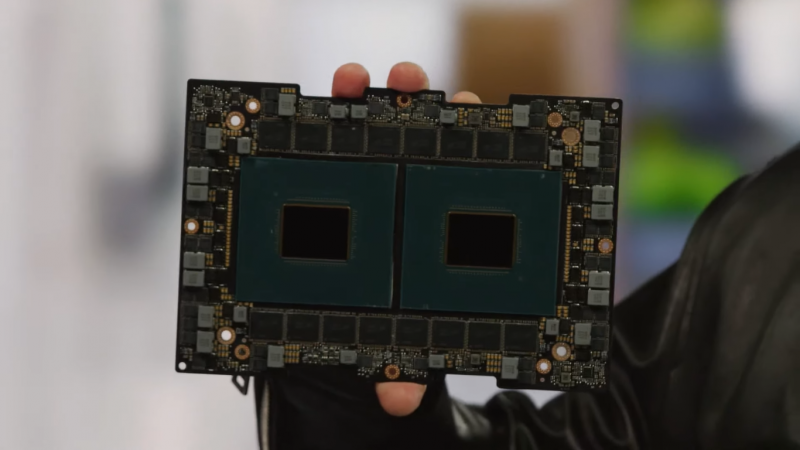

Первые бенчмарки NVIDIA Grace Superchip: не хуже EPYC и быстрее Xeon, а по энергоэффективности намного лучше AMD и Intel144-ядерный Arm-процессор NVIDIA Grace Superchip был продемонстрирован публике ещё весной этого года на конференции GTC 2023. Несмотря на то, что технические характеристики этого решения известны уже давно, первые результаты тестирования компания решила опубликовать только сейчас, вероятно, с подачи Arm, которая готовится к IPO. Производство Grace Superchip уже запущено, а появления ОЕМ-систем на его базе следует ожидать уже во II квартале 2024 года. Напомним, Grace Superchip представляет собой сборку из двух чипов Grace, каждый из которых включает 72 ядра Arm Neoverse V2 (Arm v9) с поддержкой векторных расширений SVE2. Процессор умеет работать с форматами BF16/INT8 и развивает до 7,1 Тфлопс в режиме FP64. С точки зрения системы сборка представляется единым 144-ядерным процессором.

Сборка Grace Superchip. Источник изображения: NVIDIA В качестве соперников Grace Superchip были избраны платформы на базе AMD EPYC Genoa 9654 (2 процессора, 192 ядра) и Intel Xeon Sapphire Rapids 8480+ (также 2 процессора, 112 ядер). Итог довольно любопытен: несмотря на заметное отставание в количестве ядер от системы AMD, решение NVIDIA сумело достичь паритета в подавляющем большинстве тестов, а в сценарии аналитики графов даже продемонстрировало 1,4-кратное превосходство. Возможно, тут новинке помогла мощная подсистема памяти: Grace Superchip оснащается набором чипов LPDDR5x объёмом 960 Гбайт с совокупной ПСП 1 Тбайт/с. Но куда интереснее результаты, приведённые к уровню энергопотребления — сборка Grace Superchip буквально разгромила решения на базе x86-64. Выигрыш в этом случае составил от 70 % до 150 %! Полученные результаты достаточно неплохо согласуются с официальными данными об энергопотреблении систем-участниц тестирования — это 720 и 700 Вт у решений AMD и Intel соответственно против 500 Вт у NVIDIA Grace Superchip. Если опубликованные сегодня результаты будут подтверждены независимыми тестами, можно говорить о появлении у серверных решений x86 серьёзнейшего конкурента. Впрочем, ценовая политика NVIDIA в отношении Grace Superchip пока остаётся тайной.

05.09.2023 [11:48], Сергей Карасёв

ASRock выпустила мини-компьютеры 4X4 Box 7040 на процессорах AMD Ryzen 7040UКомпания ASRock Industrial анонсировала компьютеры небольшого форм-фактора 4X4 Box 7040, рассчитанные на использование в промышленной и коммерческой сферах, а также в области IoT. В основу новинок положены процессоры AMD семейства Ryzen 7040U. В серию вошли модели 4X4 Box-7640U и 4X4 Box-7840U. Первая несёт на борту чип Ryzen 5 7640U (6 ядер; 12 потоков; до 4,9 ГГц), вторая — Ryzen 7 7840U (8 ядер; 16 потоков; до 5,1 ГГц). Доступны два слота SO-DIMM для модулей оперативной памяти DDR5-5600 суммарным объёмом до 64 Гбайт.

Источник изображения: ASRock Industrial В оснащение входят адаптеры Wi-Fi 6E 802.11ax и Bluetooth 5.2, сетевые контроллеры 1GbE (Realtek RTL8111EPV) и 2.5GbE (Realtek RTL8125BG), звуковой кодек Realtek ALC256. Есть коннектор M.2 Key M 2242/2260/2280 для SSD с интерфейсом PCIe 4.0 x4 и порт SATA-3. Применена система активного охлаждения с вентилятором. На фронтальную панель выведены порт USB 3.2 Gen2 Type-A и два порта USB 4 (DP1.4a), а также стандартное аудиогнездо. Сзади расположены два коннектора RJ-45 для сетевых кабелей, два интерфейса HDMI 1.4b, два порта USB 2.0 и DC-гнездо для подачи питания. Размеры составляют 117,5 × 110,0 × 47,85 мм, вес — около 1 кг. Диапазон рабочих температур — от 0 до +40 °C. Допускается монтаж при помощи крепления VESA. Гарантирована совместимость с Windows 10/11.

01.09.2023 [13:46], Сергей Карасёв

Cincoze представила встраиваемые компьютеры DS-1400 на платформе Intel Alder Lake-SКомпания Cincoze, по сообщению CNX-Software, начала продажи встраиваемых компьютеров серии DS-1400 на аппаратной платформе Intel Alder Lake-S. Для устройств заявлена поддержка Windows 10, а опционально может быть использована ОС с ядром Linux. Максимальная конфигурация включает процессор Core i9-12900E (16 ядер; до 5,0 ГГц; графика Intel UHD 770; TDP 65 Вт). Объём оперативной памяти DDR5-4800 может достигать 64 Гбайт (два слота SO-DIMM). Есть возможность установки двух накопителей SFF с интерфейсом SATA-3 (один с доступом через фронтальную панель), а также SSD формата M.2 2280 с интерфейсом PCIe 3.0 x4 или SATA-3. Кроме того, имеются три коннектора mSATA. Поддерживаются массивы RAID 0/1/5/10. В оснащение входят два сетевых контроллера 1GbE — Intel I219 и Intel I210. Возможно одновременное подключение до четырёх дисплеев через интерфейс HDMI 2.0 (до 4096 × 2160 точек; 30 Гц), два разъёма DP (4096 × 2304 пикселя; 60Гц) и коннектор D-Sub (1920 × 1080 точек). Присутствует аудиокодек Realtek ALC888. Модель DS-1400 не располагает слотами расширения, тогда как версия DS-1401 снабжена одним разъёмом PCI/PCIe, а модификация DS-1402 — двумя. Доступны два порта USB 3.2 Gen2 Type-A, четыре коннектора USB 3.2 Gen1 Type-A, два порта USB 2.0 Type-A, два последовательных порта RS-232/422/485, два слота для SIM-карт. Упомянут интерфейс CMI (Combined Multiple I/O). Компьютеры выполнены в соответствии со стандартом MIL-STD-810G. Диапазон рабочих температур в зависимости от установленного процессора простирается от -40 до +70 °C или -40 до +50 °C. Питание подаётся через DC-разъём (9–48 В).

01.09.2023 [12:13], Сергей Карасёв

Сбербанк и «Яндекс» создадут аналоги GitHub CopilotСбербанк, по сообщению газеты «Коммерсантъ», создал инструмент разработки и автоматического дополнения кода GigaCode. Это отечественный аналог системы GitHub Copilot на базе ИИ, которая способна давать советы по написанию кода разработчикам ПО. Отмечается, что Сбербанк зарегистрировал программу GigaCode/JARVIS в реестре Роспатента. Этот инструмент подходит для разных языков программирования. Регистрация оформлена 8 августа нынешнего года, а 3 августа банк зарегистрировал домен gigacode.ru. Условия доступа к GigaCode пока не раскрываются.

Источник изображения: pixabay.com В апреле 2023-го Сбербанк представил нейросеть GigaChat, способную генерировать фрагменты программного кода. Говорится, что инструмент GigaCode «развивается параллельно с GigaChat и имеет ряд пересечений». Новая система может интегрироваться с популярными IDE, включая IntelliJ IDEA и PyCharm, а также Visual Studio Code. Возможность создания ИИ-сервиса для разработчиков также рассматривает «Яндекс». Участники рынка отмечают, что программисты проявляют интерес к инструментам генерации кода. Такие продукты способны ускорить разработку, но их массовое внедрение увеличит порог вхождения в профессию. Сервисы вроде GigaCode потенциально позволят автоматизировать рутинные операции и снизить нагрузку на разработчиков.

31.08.2023 [12:38], Сергей Карасёв

Biostar представила индустриальный мини-компьютер MS-J6412 на платформе Intel Elkhart LakeКомпания Biostar анонсировала компьютер небольшого форм-фактора MS-J6412, предназначенный для использования в промышленной сфере. Устройство, выполненное на платформе Intel Elkhart Lake, совместимо с ОС Windows 10 Pro, Windows 10 IoT Enterprise 2021 и Ubuntu 20.04. Установлен процессор Celeron J6412 (четыре ядра; четыре потока; 2,0–2,6 ГГц; 10 Вт). Объём оперативной памяти DDR4-3200 может достигать 32 Гбайт. Для подключения накопителя служит порт SATA-3.

Источник изображения: Biostar Новинка располагает слотами Mini-PCIe, M.2 key B (для модуля 4G/5G; плюс разъём для SIM-карты) и M.2 key M. Есть двухпортовый сетевой контроллер 2.5GbE (Intel I225V), четыре последовательных порта, интерфейсы HDMI и D-Sub, четыре порта USB 2.0 и два разъёма USB 3.0, два гнезда RJ-45 для сетевых кабелей. Мини-компьютер довольствуется пассивным охлаждением, а верхняя ребристая часть корпуса выполняет функции радиатора для рассеяния тепла. Габариты составляют 160 × 130 × 50 мм. Диапазон рабочих температур простирается от 0 до +40 °C. Питание подаётся через внешний адаптер (12 В / 5 A). |

|