Материалы по тегу: software

|

23.11.2023 [01:50], Руслан Авдеев

Amazon задумала обучить 2 млн человек работе с ИИКомпания Amazon Web Services (AWS) представила новую инициативу AI Ready, благодаря которой она намерена привить 2 млн человек навыки работы с искусственным интеллектом (ИИ) к 2025 году. Как сообщает Silicon Angle, компания хочет обеспечить доступ к образованию в сфере ИИ всем, кто желает учиться. У компании уже есть более 80 курсов, связанных с ИИ. В компании уверены, что ИИ стал самой «преобразующей» технологией нынешнего поколения, поэтому AWS намерена раскрыть её полный потенциал для решения самых серьёзных мировых проблем. AWS создаст несколько бесплатных обучающих онлайн-курсов. Три разработаны для обучающихся без опыта программирования, а прочие предназначены для разработчиков. Большинство курсов включают материалы, помогающие ознакомиться с ИИ-сервисами самой AWS.

Источник изображения: Alexandra_Koch/pixabay.com Вводный курс Introduction to Generative Artificial Intelligence даёт представление об основных концепциях генеративного ИИ и сферах его применения. Ещё два курса для новичков связаны с более подробным изучением предмета. Один предназначен для обучения бизнес-лидеров планированию проектов в области генеративного ИИ, второй представляет собой введение в использование сервиса AWS CodeWhisperer, позволяющего писать программы с помощью речевых запросов. Пять курсов для разработчиков обещают углубленное изучение вопроса. Три связаны с коллекцией моделей Amazon Bedrock, сервисом Amazon Transcribe и набором инструментов Amazon SageMaker, которые разработчики смогут применять для создания, запуска и внедрения нейросетей. Ещё два курса для чуть более опытных слушателей посвящены тюнингу запросов к ИИ для получения оптимальных результатов и подготовке данных для обучения и внедрения ИИ-моделей. Кроме того, AWS представит ещё две программы обучения в партнёрстве с Udacity и Code.org. AWS Generative AI Scholarship предоставит стипендии старшеклассникам и студентам на общую сумму более $12 млн и доступ к разработанному AWS курсу на платформе Udacity. А Code.org получит «облачные кредиты» на сумму до $8 млн. Организация будет использовать инфраструктуру AWS для поддержки инициативы Hour of Code, призванной обучить слушателей навыкам программирования. В рамках сотрудничества AWS представит версию Hour of Code с акцентом на ИИ-навыки.

23.11.2023 [00:10], Руслан Авдеев

Минус 900 МВт·ч ежегодно: ИИ Etalytics помог Equinix снизить энергозатраты во франкфуртском ЦОДОператор ЦОД Equinix повысил энергоэффективность своего дата-центра FR6 во Франкфурте (Германия) на 9 %, оптимизировав распределение энергоресурсов при поддержке ИИ. Как сообщает Datacenter Dynamics, этот результат достигнут с помощью интеллектуальной системы управления охлаждения Etalytics. ПО Etalytics позволило снизить индекс PUE почти до 1,2 и, как ожидается, даст возможность сократить энергопотребление на 900 МВт·ч ежегодно. В дальнейшем Equinix намерена внедрить аналогичные ИИ-решения почти во всех своих франкфутских ЦОД IBX, включая объекты FR4, FR6, FR8 и FR2.6. Стартап Etalytics был сформирован в 2020 году одной из исследовательских групп Технического университета Дармштадта. Сотрудничество с Equinix началось тогда же. ИИ-платформа Etalyctics позволяет регулировать работу систем охлаждения, что ведёт к экономии электроэнергии. ПО собирает телеметрию с помощью IIoT-датчиков для формирования «цифрового двойника», который может использоваться для «динамических расчётов» оптимальной стратегии охлаждения в реальном времени. Учитывается температура, влажность и т.д. Как сообщают в Equinix Germany, речь идёт о многообещающем примере позитивного эффекта цифровизации и влиянии ИИ на рост энергоэффективности. Это, в частности, позволило получить награду Energy Efficiency Award от Германского энергетического агентства (DENA). Впрочем, ПО Etalytics с не меньшим успехом может применяться в химической, фармацевтической и автомобильной промышленности. Считается, что внедрение подобных технологий станет ещё одним ключевым фактором достижения «климатической нейтральности», особенно на фоне амбициозных целей нового Закона об энергоэффективности Германии. В Equinix сообщили, что обсуждают с немецкими политиками способы достижения ещё большей энергоэффективности и устойчивости для того, чтобы новые нормы не помешали цифровизации страны.

20.11.2023 [08:52], Сергей Карасёв

Gartner: мировые затраты на публичные облака в 2024 году достигнут почти $680 млрдКомпания Gartner опубликовала прогноз по глобальному рыку публичных облачных сервисов на 2023–2024 годы. Аналитики полагают, что отрасль продолжит демонстрировать устойчивый рост, несмотря на сложную макроэкономическую обстановку, кризис в США и высокий уровень инфляции. По оценкам, в 2022-м мировые затраты в обозначенной сфере составили около $478,3 млрд. Из них $174,4 млрд пришлось на платформы SaaS (программное обеспечение как услуга), приблизительно $120,3 млрд — на сервисы IaaS (инфраструктура как услуга), примерно $119,6 млрд — на службы PaaS (платформа как услуга). Ещё $61,6 млрд принесли решения BPaaS (бизнес-процессы как услуга), $2,4 млрд — DaaS (десктоп как сервис).

Источник изображения: pixabay.com В 2023 году, как прогнозирует Gartner, объём рынка увеличится до $563,6 млрд, что будет соответствовать росту на 17,8 % в годовом исчислении. При этом SaaS останется крупнейшим сегментом с выручкой в размере $205,2 млрд. Около $145,3 принесут услуги PaaS, приблизительно $143,9 млрд — IaaS. На BPaaS и DaaS придётся соответственно $66,3 млрд и $2,8 млрд. В 2024-м мировая отрасль публичных облаков, по мнению аналитиков, покажет прибавку на уровне 20,4 % — до $678,8 млрд. Услуги SaaS обеспечат $244,0 млрд, решения IaaS — $182,2 млрд, сервисы PaaS — примерно $176,5 млрд. На BPaaS придётся $72,9 млрд, на DaaS — $3,2 млрд. Таким образом, как прогнозируется, в 2024 году во всех сегментах облачного рынка будет наблюдаться увеличение затрат. Наибольший рост ожидается в сферах IaaS — плюс 26,6 %, а также PaaS — около 21,5 %.

19.11.2023 [23:59], Владимир Мироненко

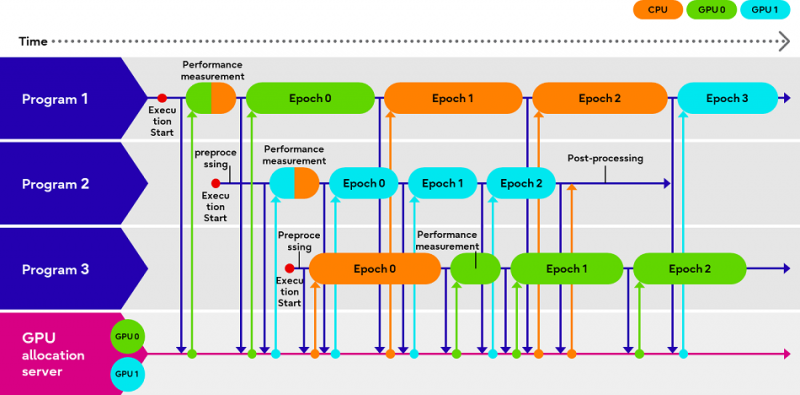

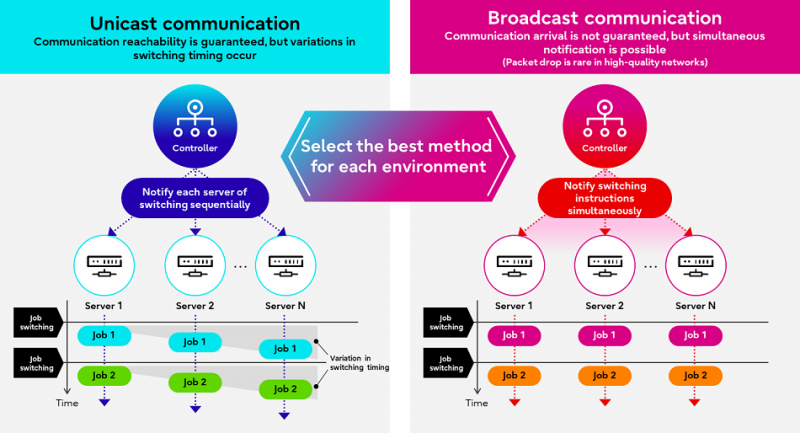

Fujitsu Adaptive GPU Allocator позволит эффективнее использовать дефицитные ИИ-ускорителиКомпания Fujitsu представила технологии Adaptive GPU Allocator и Interactive HPC, позволяющие оптимизировать использования ускорителей и HPC-кластеров. Эти технологии будут использоваться в некоторых из её собственных облачных HPC-продуктов. Компания утверждает, что новые решения призваны помочь решить проблему глобальной нехватки ускорителей в связи с большим спросом на генеративный ИИ, позволяя клиентам оптимизировать использование своих вычислительных ресурсов. По словам Fujitsu, Adaptive GPU Allocator способна динамически определять программы, для работы которых действительно требуется ускоритель, и программы, которым фактически достаточно CPU, и соответствующим образом распределять ресурсы. Технология основана на оценке уровня возможного ускорения при использовании GPU для каждой конкретной программы и выделении ресурсов ускорителей так, чтобы минимизировать общее время обработки всеми программами. Технических деталей о работе этой системы компания не предоставила. Сообщается лишь то, что при запросе программой доступа к ускорителю проводится замер скорости обработки одного и того же кусочка данных на CPU и GPU, на основании чего и принимается решение о дальнейшей обработке на CPU или GPU. Система может измерять производительность кода по мере его выполнения. Как уточняет The Register, что для работы Adaptive GPU Allocator программы должны задействовать фреймворк Fujitsu, который использует TensorFlow и PyTorch. Adaptive GPU Allocator станет частью ИИ-платформы Fujitsu Kozuchi, выход которой ожидается после II половины 2024 финансового года, заканчивающегося 31 марта 2025 года. Чуть раньше появится технология Interactive HPC, которая позволит переключаться между несколькими задачами в HPC-кластерах в режиме реального времени, тогда как, по словам Fujitsu, традиционный подход предполагает отправку узлам команд на переключение по очереди. Деталей компания снова не сообщила, отметив лишь то, что в кластере из 256 узлов Interactive HPC позволила сократить время переключения с одной задачи на другую с нескольких секунд до 100 мс.

19.11.2023 [22:52], Сергей Карасёв

Dell и Hugging Face упростят развёртывание генеративного ИИ на базе локальной инфраструктурыКомпании Dell Technologies и Hugging Face объявили о заключении соглашения о сотрудничестве, цель которого заключается в том, чтобы помочь корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ. Партнёры сформируют новый портал на платформе Hugging Face. Через него будут доступны специальные контейнеры и сценарии, которые помогут заказчикам быстро и безопасно разворачивать открытые ИИ-модели, доступные в репозитории Hugging Face. Ранее похожее решение было представлено для моделей Llama 2.

Источник изображения: pixabay.com Для локального развёртывания ИИ-приложений будет использоваться оборудование Dell — серверы PowerEdge и СХД. Со временем на портале появятся дополнительные контейнеры с оптимизированными моделями для инфраструктуры Dell, предназначенные для внедрения ИИ-систем нового поколения. Ранее компания представила расширеннное портфолио комплексных решений и сервисов для «локализации» генеративного ИИ.

19.11.2023 [02:10], Владимир Мироненко

Fujitsu продала свой частный облачный бизнес в Германии инвестиционной компании AEQUITAFujitsu объявила о «стратегической реорганизации» бизнеса в Германии, в рамках которой она заключила сделку по продаже немецкой инвестиционной компании AEQUITA из Мюнхена своего подразделения Fujitsu Services GmbH, предоставляющего услуги частного облака и управляемых сервисов, а также услуги по обеспечению кибербезопасности клиентской базе, включающей средние и крупные предприятия частного и государственного сектора. Ожидается, что сделка будет завершена в начале 2024 года. Её условия не разглашаются. Японская компания сообщила, что «следует своей глобальной стратегии» и что новая организация под эгидой Fujitsu Group предоставит «адаптированный и оптимизированный» портфель услуг. Обновлённые предложения компании будут включать публичные облачные сервисы, портфель решений Uvance для создания устойчивого мира путём цифровых инноваций, приложения и сервисы, связанные с мейнфреймами BS2000, а также бизнес-приложения, которые помогут клиентам ориентироваться в цифровом мире и использовать его потенциал для роста.

Источник изображения: Fujitsu AEQUITA сообщила, что в прошлом году выручка приобретённой Fujitsu Services GmbH составила около €200 млн, и что её штат насчитывает около 1200 сотрудников. Fujitsu Services GmbH предоставляет услуги с опорой на свои ЦОД во Франкфурте, Неккарзульме и Нойенштадте, которые будет использовать и AEQUITA. Во время переходного периода компании будут сотрудничать, чтобы не прерывать бизнес-процессы клиентов. Fujitsu ранее в этом году объявила о закрытии бизнеса ЦОД в США из-за отсутствия мощностей, необходимых для конкуренции на этом рынке. Также компания недавно сообщила о решении поглотить свою облачную «дочку» FJCT. Кроме того, Fujitsu полностью свернёт бизнес в России.

18.11.2023 [00:38], Владимир Мироненко

NVIDIA и Microsoft развернули в облаке Azure платформу для создания приложений генеративного ИИКомпания NVIDIA представила на конференции Microsoft Ignite 2023 сервис NVIDIA AI Foundry, который позволит предприятиям ускорить разработку и настройку пользовательских приложений генеративного ИИ с использованием собственных данных, развёртываемых в облаке Microsoft Azure. NVIDIA AI Foundry объединяет три элемента: набор базовых моделей NVIDIA AI Foundation, платформу и инструменты NVIDIA NeMo, а также суперкомпьютерные сервисы NVIDIA DGX Cloud AI. Вместе они предоставляют предприятиям комплексное решение для создания пользовательских моделей генеративного ИИ. Компании смогут затем развёртывать свои индивидуальные модели с помощью платформы NVIDIA AI Enterprise для создания приложений ИИ, включая интеллектуальный поиск, обобщение и генерацию контента. «Предприятиям нужны кастомные модели для реализации специализированных навыков, основанных на собственной ДНК их компании — их данных, — сообщил глава NVIDIA Дженсен Хуанг (Jensen Huang), — Сервис NVIDIA AI Foundry сочетает в себе наши технологии моделей генеративного ИИ, опыт обучения LLM и гигантскую фабрику ИИ. Мы создали это в Microsoft Azure, чтобы предприятия по всему миру могли подключить свою собственную модель к ведущим в мире облачным сервисам Microsoft».

Источник изображения: NVIDIA Сервис NVIDIA AI Foundry можно использовать для настройки моделей для приложений на базе генеративного ИИ в различных отраслях, включая корпоративное ПО, телекоммуникации и медиа. При их развёртывании компании смогут использовать метод генерации с расширенным поиском (RAG), чтобы привязать свои модели к базе корпоративных данных для получения актуальных ответов. В сервисе NVIDIA Foundry клиенты смогут выбирать из нескольких моделей NVIDIA AI Foundation, включая новое семейство Nemotron-3 8B в составе каталога моделей Azure AI. Разработчики также могут получить доступ к моделям Nemotron-3 8B в каталоге NVIDIA NGC и к популярным моделям Llama 2, Mistral и Stable Diffusion XL. NVIDIA сообщила, что одними из первых новым сервисом для создания моделей воспользовались SAP, Amdocs и Getty Images. Наконец, в Azure стала доступна и платформа NVIDIA DGX Cloud AI, в рамках которой клиенты смогут арендовать кластеры, состоящие из тысяч ускорителей NVIDIA и воспользоваться ПО NVIDIA AI Enterprise, включая NeMo, для ускорения настройки LLM. Клиенты Azure смогут использовать существующие кредиты Microsoft Azure Consumption Commitment для ускорения разработки ИИ-моделей. Отметим, что первым сервис DGX Cloud получило облако Oracle, где Microsoft арендует ускорители той же NVIDIA для собственных нужд. По слухам, компания также использует ускорители CoreWeave и Lambda Labs, а также разрабатывает более экономичные ИИ-модели. По-видимому, продавать доступ к аппаратным и иным решениям NVIDIA для Microsoft выгоднее, чем использовать для своих нужд. Впрочем, если всё сложится удачно, то компания перейдёт на ИИ-ускорители Maia 100 собственной разработки.

18.11.2023 [00:02], Андрей Крупин

Postgres Pro стала первой отечественной СУБД, сертифицированной по новым требованиям ФСТЭК РоссииКомпания Postgres Professional провела оценку сертифицированных версий систем управления базами данных Postgres Pro Standard и Pro Enterprise согласно новым требованиям Федеральной службы по техническому и экспортному контролю по безопасности информации к СУБД от 14 апреля 2023 года, утверждённых Минюстом в июле 2023 года. Утверждается, что Postgres Pro стала первой отечественной СУБД, сертифицированной по новым требованиям регулятора. Сертификат допускает использование программного комплекса для хранения и обработки данных в критической инфраструктуре первой категории и государственных информационных системах первого класса защищённости.  Ранее сертифицированные версии Postgres Pro в основном уже соответствовали новым требованиям ФСТЭК России и содержали необходимые механизмы защиты. Для полного соответствия новым требованиям в СУБД были доработаны некоторые команды и утилиты, ведены новые роли администратора и ограничены возможности суперпользователя, обновлена документация, а также усовершенствован модуль pg_proaudit, позволяющий регистрировать события, связанные с безопасностью. Обновлённая версия Postgres Pro Certified поддерживает три версии ядра СУБД: 11.21.2, 14.9.2 и 15.4.2. Сертификат соответствия № 3637 переоформлен 20 октября 2023 г. Обновлённая редакция Postgres Pro Enterprise Certified поддерживает четыре версии ядра СУБД: 11.21.2, 13.12.3, 14.9.3 и 15.4.3. Сертификат соответствия № 4063, переоформлен 3 ноября 2023 г. В октябре 2023 года Postgres Professional объявила о выпуске Postgres Pro Standard 16. Её сертифицированная ФСТЭК России версия появится после очередного инспекционного контроля. В декабре компания планирует мажорный релиз новой флагманской Postgres Pro Enterprise 16, в которую войдёт ряд новых крупных решений и доработок. В 2024 году запланирован выпуск очередной сертифицированной версии Postgres Pro Enterprise Certified.

17.11.2023 [19:56], Сергей Карасёв

Счёт, пожалуйста: Amazon, Microsoft, Google и Oracle сделают учёт облачных расходов более прозрачнымОрганизация FinOps Foundation, входящая в некоммерческий технологический консорциум Linux Foundation, представила предварительную редакцию первой версии открытой спецификации FOCUS (FinOps Open Cost and Usage Specification) для оценки стоимости и объёма использования облачных услуг крупных провайдеров. Проект призван сделать затраты на облака более прозрачными. Отмечается, что по мере перехода предприятий в облако становится всё труднее понять, где, как и на что конкретно расходуются средства. Различные поставщики услуг SaaS и облачные платформы используют свои собственные подходы к расчёту затрат. Кроме того, применяются разные форматы данных, что затрудняет анализ финансовых потоков.

Источник изображения: FinOps Foundation На этом фоне сформировалось направление FinOps — дисциплина, которая сочетает принципы управления финансами с облачным проектированием и управлением, чтобы дать организациям лучшее представление о своих расходах на облако. В свою очередь, FOCUS — это основополагающий проект в области FinOps, направленный на создание открытой спецификации для представления данных о затратах на облачные ресурсы. Цель проекта заключается в том, чтобы стандартизировать терминологию и упростить анализ расходов и потребления облачных услуг. Спецификация включает определения часто используемых терминов и показателей. Предусмотрены варианты использования для анализа скидок и ценообразования. В целом, использование стандарта обеспечивает прозрачность тарифов и возможность детальной оценки затрат. Версия FOCUS 1.0 также будет включать в себя библиотеку реальных сценариев использования. Проект FOCUS поддерживают AWS, Microsoft, Google, Oracle Cloud, IBM, Meta✴ и VMware, крупные пользователи облачных платформ, такие как Walmart и Capital One, а также сервис-провайдеры, включая Atlassian, Twilio, Datadog и Snowflake.

17.11.2023 [13:44], Сергей Карасёв

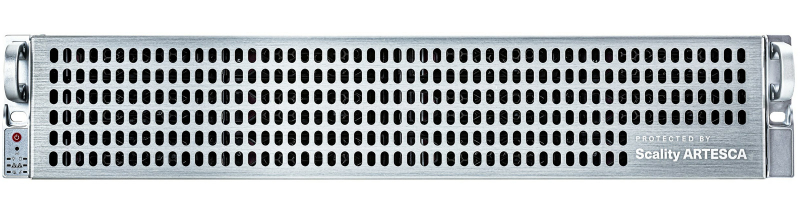

Scality представила СХД серии Artesca для VeeamКомпания Scality анонсировала СХД семейства Artesca, специально разработанные для пользователей Veeam: устройства предназначены для эффективного и надёжного резервного копирования и восстановления информации. В основу новинок положена аппаратная платформа AMD EPYC Genoa. В семейство Artesca вошли три модификации: 1N-73TB, 1N-165TB и 3N-377TB. Первые две представляют собой одноузловые решения в формате 2U, последняя — трёхузловая система 8U. Во всех узлах задействован процессор EPYC 9254 (24 ядра; 48 потоков; 2,9–4,15 ГГц; до 240 Вт). Объём оперативной памяти DDR5-4800 составляет 192 Гбайт у двух младших версий и 576 Гбайт у старшей. Все СХД располагают двумя загрузочными M.2 NVMe SSD вместимостью 480 Гбайт каждый. Модель 1N-73TB комплектуется двумя сервисными U.3 NVMe SSD на 800 Гбайт и 12 дисками LFF с интерфейсом SAS-3 (7200 RPM), ёмкость каждого из которых равна 8 Тбайт. Таким образом, общая «сырая» вместимость составляет 96 Тбайт (полезная ёмкость — 73 Тбайт). Модификация 1N-165TB получила два сервисных SSD на 1,6 Тбайт и 12 SAS-накопителей на 18 Тбайт: это обеспечивает ёмкость в 216 Тбайт (полезная — 165 Тбайт). Наконец, трёхузловая система 3N-377TB получила шесть сервисных U.3 NVMe SSD на 3,2 Тбайт каждый и 36 HDD ёмкостью 18 Тбайт: это обеспечивает суммарную вместимость 648 Тбайт (полезная — 377 Тбайт). Говорится о поддержке различных средств мониторинга и управления (CLI, GUI, IPMI, S3 API, IAM API, Veeam SOSAPI). У всех СХД есть четыре порта 10GbE (2 × RJ-45 и 2 × SFP+) на базе Intel X710. В системе охлаждения применяются 80-мм вентиляторы. Установлены блоки питания — два у версий 2U и шесть у 8U — мощностью 1200 Вт с сертификатом Titanium. Среди прочего упомянуты сетевой порт управления, два разъёма USB 3.0, интерфейс D-Sub и последовательный порт. Диапазон рабочих температур — от +10 до +35 °C. |

|