Материалы по тегу: hardware

|

25.10.2024 [11:18], Сергей Карасёв

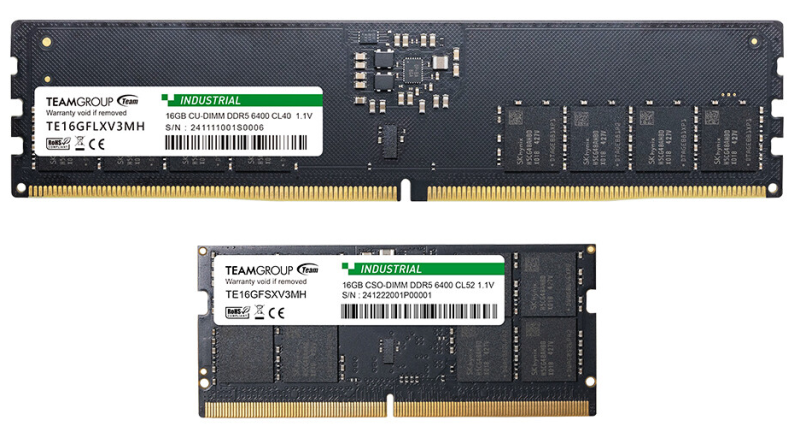

TeamGroup анонсировала первые в отрасли индустриальные модули DDR5-6400 CU-DIMM/CSO-DIMMКомпания TeamGroup анонсировала, как утверждается, первые в отрасли модули оперативной памяти промышленного класса DDR5-6400 стандартов CU-DIMM (Clocked Unbuffered DIMM) и CSO-DIMM (Clocked Small Outline DIMM). Эти изделия, обладающие повышенной надёжностью, ориентированы на требовательные приложения, в том числе связанные с ИИ. Team Group использует технологию, которая даёт возможность регулировать частоту и напряжение в зависимости от нагрузки на систему и условий эксплуатации. Благодаря этому достигаются оптимальные показатели производительности и энергопотребления. Напряжение питания модулей составляет 1,1 В. Реализована поддержка ECC (Error Correction Code). Полностью технические характеристики модулей DDR5-6400 CU-DIMM/CSO-DIMM компания TeamGroup пока не раскрывает. Но отмечается, что они изготавливаются с применением высококачественных чипов DRAM производства SK Hynix. При производстве продуктов применяется уникальная запатентованная технология тестирования и оценки (американский патент №11488679 B1; тайваньский патент №I751093). Модули обоих типов будут предлагаться в нескольких вариантах ёмкости, включая 16 Гбайт.

25.10.2024 [07:14], Владимир Мироненко

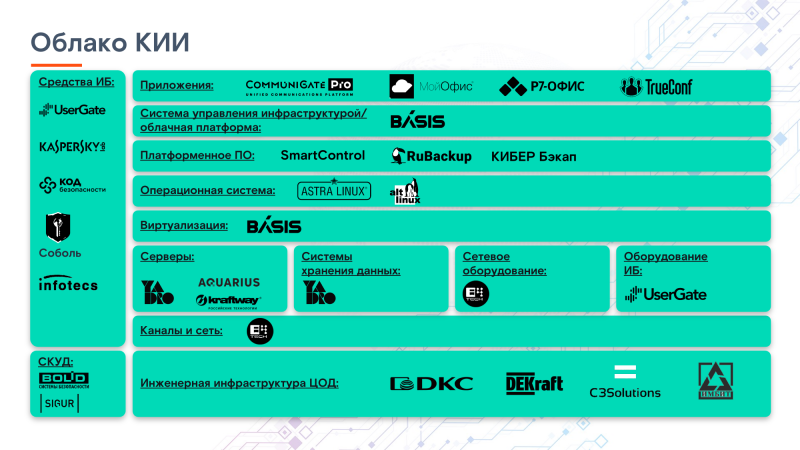

В России запущено первое облако для объектов КИИ, построенное исключительно на отечественных решенияхСервис-провайдер «РТК-ЦОД», являющийся дочерней структурой «Ростелекома», запустил сервис «Облако КИИ», предназначенный для размещения значимых объектов критической информационной инфраструктуры российских компаний. По словам «РТК-ЦОД», «Облако КИИ» предлагает «беспрецедентный уровень безопасности и защиты в комплексе с классическими преимуществами IaaS-решений». Как указано в пресс-релизе, «Облако КИИ» — первое на отечественном рынке импортонезависимое решение для организаций, инфраструктура которых должно быть приведена в соответствие с требованиями регуляторов в сфере КИИ, в первую очередь, с положениями федерального закона №187-ФЗ и приказа ФСТЭК №239 о безопасности критической информационной инфраструктуры РФ. Сообщается, что сервис построен на базе российских решений с соблюдением требований информационной безопасности и импортозамещения для компаний-субъектов КИИ. Средства защиты информации сервиса аттестованы ФСТЭК России, благодаря чему в облачной инфраструктуре можно размещать объекты КИИ до второй категории значимости, государственные информационные системы первой категории и работать с персональными данными до первого уровня значимости включительно. Оборудование «Облака КИИ» включено в реестр Минпромторга, а ПО — в реестр Минцифры. Согласно указу президента РФ о мерах по обеспечению технологической независимости и безопасности критической информационной инфраструктуры России, подписанному в марте 2022 года, с 1 января 2025 года органам государственной власти запрещается использовать иностранное ПО на объектах КИИ.

25.10.2024 [00:35], Игорь Осколков

NVIDIA за год отгрузила более 1 млрд RISC-V ядерВ рамках саммита RISC-V 2024 компания NVIDIA поделилась любопытной статистикой — за год в составе GPU и других ускорителей она отгрузила более 1 млрд ядер RISC-V собственной разработки, передаёт TechPowerUp. Они входят в состав GSP (GPU System Processor), который отвечает за управление GPU и иные служебные функции. В состав GSP входит от 10 до 40 ядер, в зависимости от сложности чипа, которым он управляет. Компания переключилась на разработку нового GSP на базе RISC-V в 2016 году. До этого более десяти лет NVIDIA использовала для GSP проприетарный процессор Falcon, возможностей и гибкости которого со временем стало не хватать. Вместо покупки и доработки готовых ядер от сторонних вендоров (Arm, MIPS, Synopsys ARC) или попыток улучшить Falcon, компания решила обратиться к открытой архитектуре RISC-V и к настоящему моменту разработала три типа ядер. Так, NV-RISCV32 представляет собой самое простое 32-бит ядро без внеочередного исполнения, работающее на частоте до 1,8 ГГц и имеющее производительность до 1,8 CoreMark/МГц. NV-RVV является NV-RISCV32 с 1024-бит векторными расширениями. А NV-RISCV64 — это уже более серьёзное 64-бит ядро с поддержкой внеочередного исполнения и SMP, частотой 2 ГГц и производительностью 5 CoreMark/МГц. Кроме того, NVIDIA разработала более 20 расширений ISA под специфические задачи. Впервые GSP на базе RISC-V появился в поколении Turing в 2018 году. Сейчас GSP отвечает за управление питанием и ресурсами ускорителя, безопасность, межчиповое взаимодействие, управление видеокодеками, вывод видео, работу с NVDLA и т.д. Google выбрала похожий путь — в её ИИ-ускорителях TPU используются ядра SiFive. Впрочем, сейчас есть уже и «большие» ИИ-ускорители, построенные исключительно на ядрах RISC-V: Meta✴ MTIA первого и второго поколений, InspireSemi Thunderbird, Tenstorrent Wormhole и Grayskull, а также Esperanto ET-SoC-1 и ET-SoC-2.

24.10.2024 [17:39], Руслан Авдеев

CoreWeave увеличит ёмкость арендуемых у Core Scientific ИИ ЦОД до 500 МВтИИ-облако CoreWeave заключила очередной контракт с оператором майнинговых ЦОД Core Scientific, предусматривающей получение дополнительной инфраструктуры, передаёт Datacenter Dynamics. В соответствии с новым контрактом будет получено ещё 120 МВт, так что общая ёмкость ИИ ЦОД у Core Scientific в обозримом будущем составит 500 МВт. В своё время CoreWeave рассматривала покупку компании-партнёра, но та отклонила предложение, поскольку потенциальный покупатель «значительно недооценивал» бизнес. Для обеспечения дополнительной ёмкости в 120 МВт Core Scientific придётся модернизировать инфраструктуру для размещения дополнительных ускорителей NVIDIA. Предполагается, что модернизация стартует во II половине 2025 года, а ввод в эксплуатацию новых ёмкостей должен состояться во II половине 2026 года. Согласно имеющимся расчётам, обновлённый 12-летний контракт принесёт Core Scientific около $2 млрд дополнительной совокупной выручки в дополнение к $6,7 млрд, которые будут получены в рамках предыдущих контрактов с CoreWeave.

Источник изображения: Core Scientific В Core Scientific отметили, что сегодня наблюдается значительный спрос на инфраструктуру, поддерживающую ускорители нового поколения. Соглашения с CoreWeave станет основой для эволюции Core Scientific в одного из лидеров рынка ЦОД, способных удовлетворять этот спрос. Впрочем, ещё 500 МВт по-прежнему будут использоваться для майнинга. Аналитики JPMorgan предупреждают, что у криптомайнеров осталось всего девять месяцев, чтобы реорганизовать имеющиеся мощности в дата-центры для ИИ. Многие криптомайнинговые компании, включая саму CoreWeave, уже переориентировались на ИИ-проекты. Ещё один игрок на рынке майнинга, Crusoe Energy, построит и сдаст в аренду Oracle крупный ИИ ЦОД. Oracle разместит там ИИ-кластеры Microsoft в интересах OpenAI. Hive Digital Technologies, Northern Data, Applied Digital, Iris Energy и другие компании теперь тоже уделяют всё больше внимания ИИ и HPC-вычислениям наряду с криптобизнесом.

24.10.2024 [16:12], Руслан Авдеев

Авиабаза ВМС США получит дата-центр, энергохранилище и солнечную электростанцию на 425 МВтЧасть авиабазы Naval Air Station Lemoore близ Фресно (Калифорния) ВМС США совместно с энергетической компанией Ameresco намерены превратить в комплекс из солнечной электростанции мощностью 425 МВт, энергохранилища и дата-центра — всё на площади около 370 га. Ameresco реализует проекты в области солнечной энергетики в США, Канаде и Европе. Авиабаза Naval Air Station Lemoore открыта в 1961 году и является крупнейшей авиабазой ВМС США. После получения в распоряжение участка Ameresco построит солнечную электростанцию с аккумуляторным энергохранилищем, которые будут снабжать дата-центр общей площадью 56 тыс. м2. ЦОД предполагается построить в пять этапов, на каждом из которых будет возведено 20–25 МВт, так что общая ёмкость объекта, вероятно, превысит 100 МВт. По информации СМИ, электростанция и хранилище также будет выступать резервным источником питания самой авиабазы, что обеспечит ей бесперебойное энергоснабжение. Предполагаются поставки энергии и другим клиентам в регионе. Это не единственный проект строительства солнечных электростанций для питания дата-центров, но один из самых масштабных. Так, индийская AmpIn Energy Transition (ранее Amp Energy India) ввела в эксплуатацию солнечную электростанцию, компенсирующую потребление ЦОД AWS. Проект имеет общую мощность 100 МВт (в пике до 135 МВт). А Microsoft в прошлом году анонсировала строительство в США солнечных электростанций суммарной мощностью 2,5 ГВт.

24.10.2024 [14:42], Руслан Авдеев

Для ЦОД и не только: NextEra «крайне заинтересована» в возобновлении работы АЭС Duane Arnold в АйовеNextEra Energy оценивает целесообразность перезапуска остановленной атомной электростанции Duane Arnold в Айове. Bloomberg сообщает, что руководство компании прямо заявило о том, что «чрезвычайно заинтересовано» в возвращении станции к жизни. Информация появилась на фоне роста в США спроса на электроэнергию — технологические компании строят ресурсоёмкие ЦОД. В NextEra Energy подчёркивают, что у клиентов, в частности операторов дата-центров, интерес к восстановлению работы электростанции очень велик. При этом запросы есть и у других игроков рынка. Сообщается о рамочных соглашениях с двумя клиентами из рейтинга Fortune 50 на поставку 10,5 ГВт возобновляемой и иной энергии до 2030 года. Имена клиентов не называются, но подчёркивается, что это не технологические компании. Другими словами, энергодефицит носит общий характер и мало зависит от отрасли. 600-МВт АЭС Duane Arnold была остановлена в 2020 году после того, как крупнейший заказчик решил отказаться от сотрудничества. После урагана в том же году станция была повреждена, из-за чего компания поспешила полностью прекратить её работу на два месяца раньше, чем планировалось. Объект ввели в эксплуатацию ещё в 1974 году, поэтому АЭС опирается на более старые технологии чем те, что применяются на других станциях в США. Но это может оказаться преимуществом — по данным руководства компании, компоненты для станции «менее сложные», поэтому вернуть её в строй будет довольно просто. Тем не менее, как сообщают эксперты Jefferies & Co, возрождение АЭС всё равно обойдётся будет недешёвым. Более того, нет никаких гарантий, что затраты окупятся, поскольку АЭС повреждена, а в регионе активно и устойчиво развивается ветроэнергетика. Это не первая АЭС, которую решено вернуть к работе на фоне роста спроса на электроэнергию. Не дремлют и конкуренты. В прошлом месяце Rival Constellation Energy анонсировала перезапуск АЭС Three Mile Island в Пенсильвании для поставки электричества дата-центрам Microsoft. Набирает силу и новый тренд по заключению соглашений со строителями малых модульных реакторов (SMR), но пока в коммерческой эксплуатации нет ни одного из них.

24.10.2024 [12:40], Сергей Карасёв

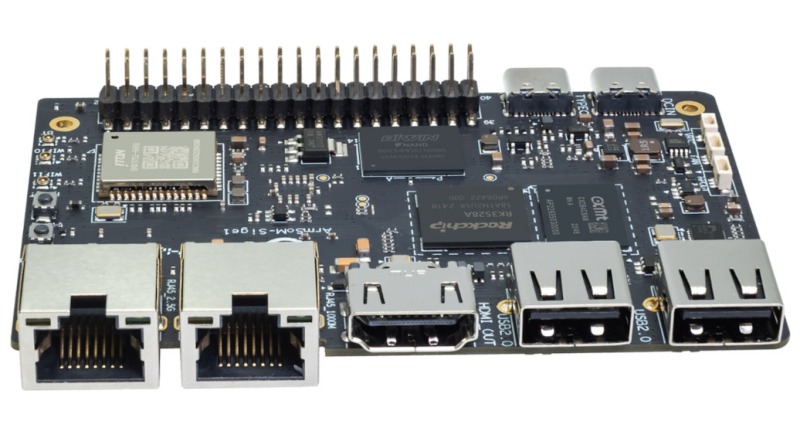

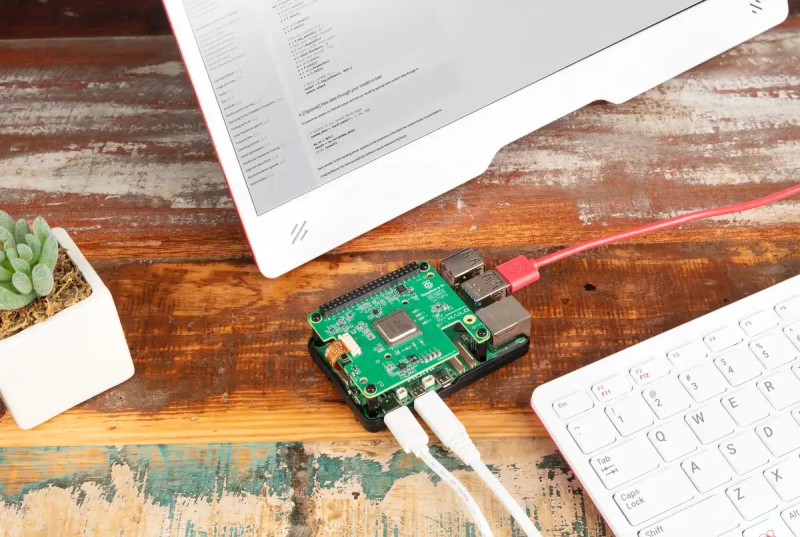

Одноплатный компьютер Banana Pi BPI-M1S получил поддержку HDMI 2.0, 2.5GbE и Wi-Fi 6В ассортименте Banana Pi появился одноплатный компьютер BPI-M1S, подходящий для построения различных терминалов, встраиваемых систем и пр. Изделие выполнено на аппаратной платформе Rockchip и совместимо с Debian11, а также с Android 13. Применён процессор RK3528. Этот чип содержит четыре ядра Arm Cortex-A53 с частотой до 2 ГГц и графический ускоритель Arm Mali-G450 GPU с поддержкой OpenGL ES1.1, ES2.0, OpenVG 1.1. Встроенный блок VPU обеспечивает возможность декодирования видеоматериалов H.264, H.265 и AVS2 в формате 4Kp60, а также кодирования H.264 и H.265 в формате 1080p60. Для вывода изображения служит интерфейс HDMI 2.0b. Одноплатный компьютер несёт на борту 4 Гбайт оперативной памяти LPDDR4x и флеш-модуль eMMC вместимостью 32 Гбайт. Дополнительно можно установить карту microSD. Изделие располагает сетевыми портами 1GbE и 2.5GbE с разъёмами RJ45 для подключения кабелей. На базе контроллера Realtek RTL8852BS реализована поддержка Wi-Fi 6 (802.11a/b/g/n/ac/ax) и Bluetooth 5.2. Новинка получила два порта USB 2.0 Type-A, один порт USB 2.0 OTG Type-C и дополнительный разъём USB Type-C для подачи питания (режимы 9 В/2 A, 12 В/2 A, 15 В/2 A). Есть 40-контактная колодка GPIO, совместимая с Raspberry Pi (UART, SPI, I2C, I2S, PWM, GND и пр.). При необходимости может быть подключён вентилятор охлаждения. Габариты Banana Pi BPI-M1S составляют 92 × 62 мм. Эксплуатироваться устройство может при температурах от 0 до +80 °C. Приобрести одноплатный компьютер можно по ориентировочной цене $53.

24.10.2024 [12:36], Сергей Карасёв

Raspberry Pi выпустила фирменные M.2 SSD и ИИ-модуль AI HAT+Компания Raspberry Pi представила под собственным брендом первые SSD и наборы SSD Kit для одноплатного компьютера Raspberry Pi 5. Дебютировали накопители в форм-факторе M.2 2230 вместимостью 256 и 512 Гбайт. На сайте Raspberry Pi говорится, что SSD используют интерфейс PCIe 3.0 (NVMe 1.4). Однако в описании самого мини-компьютера Raspberry Pi 5 упомянута только поддержка PCIe 2.0 x1 (для подключения периферии). Ресурс Tom's Hardware отмечает, что совместимость с PCIe 3.0 можно задать в настройках raspi-config, что позволит повысить скорость передачи данных. Для установки накопителей на Raspberry Pi 5 требуется модуль Raspberry Pi M.2 HAT+ (Hardware Attached on Top) с коннектором M.2: эта вспомогательная плата изначально включена в комплекты SSD Kit. В набор также входят соединительный шлейф и необходимый крепёж. В характеристиках SSD указан показатель IOPS (операций ввода-вывода в секунду) при работе с блоками данных по 4 Кбайт. У младшей версии он достигает 40 тыс. при произвольном чтении и 70 тыс. при произвольной записи, у старшей — 50 тыс. и 90 тыс. соответственно. Диапазон рабочих температур — от 0 до +70 °C. Стоимость накопителя на 256 Гбайт составляет $30, на 512 Гбайт — $45. Комплекты с модулем Raspberry Pi M.2 HAT+ обойдутся в $40 и $55. Приём заказов уже начался. Производиться новинки будут минимум до января 2032 года. Также компания представила обновлённый вариант ИИ-модуля для инференса — Raspberry Pi AI HAT+. От представленного ранее AI Kit новинка отличается тем, что теперь чип ускорителя интегрирован непосредственно на плату, а не подключается через M.2-коннектор. На выбор по-прежнему доступны чипы Hailo-8 (26 TOPS) и Hailo-8L (13 TOPS). Стоят модули с ними $110 и $70 соответственно. Диапазон рабочих температур — от 0 до +50 °C. Выпускаться модули будут минимум до января 2030 года.

24.10.2024 [12:15], Сергей Карасёв

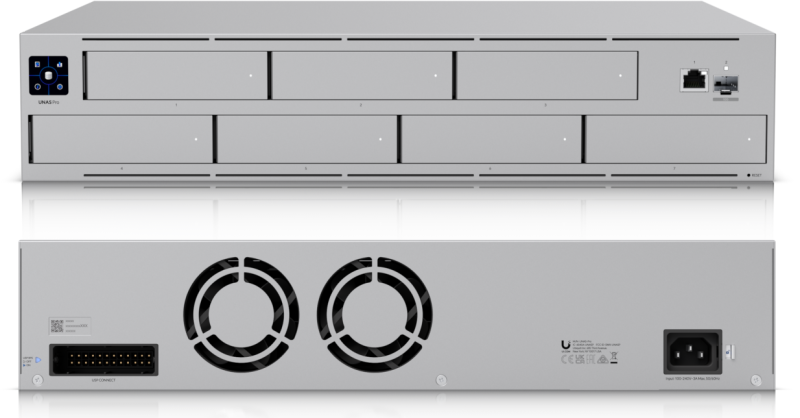

Ubiquiti представила сетевое хранилище UniFi UNAS Pro на семь LFF-накопителейКомпания Ubiquiti анонсировала сетевое хранилище UniFi UNAS Pro (UniFi UNAS Professional Rackmount NAS), ориентированное на корпоративных заказчиков. Устройство выполнено в форм-факторе 2U. В новинке применён неназванный процессор с четырьмя вычислительными ядрами Arm Cortex-A57, функционирующими на тактовой частоте 1,7 ГГц. Объём оперативной памяти DDR4 составляет 8 Гбайт. В оснащение также входят 32 Мбайт памяти SPI NOR и 8 Гбайт флеш-памяти. Во фронтальной части предусмотрены семь отсеков для HDD/SSD в форм-факторе LFF/SFF с интерфейсом SATA-3; допускается горячая замена. Имеется сенсорный дисплей с диагональю 1,3", который служит для управления и отображения информации о работе NAS. Предусмотрены по одному сетевому порту 1GbE RJ45 и 10GbE SFP+: разъёмы для подключения кабелей выведены на лицевую панель. Кроме того, есть контроллер Bluetooth 4.1. Габариты UniFi UNAS Pro составляют 442 × 325 × 87 мм, вес — 9,2 кг (без крепления для монтажа в стойку и накопителей). Диапазон рабочих температур простирается от -5 до +40 °C. В тыльной части расположены два вентилятора охлаждения. Максимальное энергопотребление заявлено на уровне 160 Вт, а энергобюджет для накопителей — 135 Вт. Устройство имеет встроенный блок питания (100–240 В AC или 11,5 В DC). Имеется порт резервного питания с поддержкой UniFi Power Backup, что делает хранилище устойчивым к перебоям в энергоснабжении. Приобрести новинку можно по ориентировочной цене $500.

24.10.2024 [07:57], Владимир Мироненко

JPMorgan: у криптомайнеров осталось всего девять месяцев, чтобы переключиться на ИИУ майнеров биткоинов есть всего девять месяцев на то, чтобы подписать контракты с гиперскейлерами и компаниями в сфере ИИ, считают в аналитической компании JPMorgan, о чём сообщил ресурс Data Center Dynamics. По мнению аналитиков JPMorgan, для майнеров сейчас самое подходящее время, чтобы расширить сферу деятельности, поскольку традиционные ЦОД всё ещё испытывают трудности с поиском мощностей, подключений к энергосетям и масштабированием. «Мы считаем, что у избранных майнеров есть около девяти месяцев, чтобы подписать выгодные сделки с несколькими хорошо финансируемыми ИИ-стартапами и гиперскейлерами, пока [остальные] дата-центры остаются в подвешенном состоянии, ожидая одобрения и/или подключения к энергосетям», — сообщили аналитики Реджинальд Л. Смит (Reginald L. Smith) и Чарльз Пирс (Charles Pearce) в отчёте, впервые опубликованном The Block. Они также отметили, что зарегистрированные в США майнеры биткоинов имеют доступ к более чем 5 ГВт электроэнергии, а ещё 6 ГВт находятся на разных стадиях освоения. JPMorgan оценивает объём заказанных, но пока не реализованных ёмкостей ЦОД в более чем 12 ГВт, на одобрение и строительство которых может уйти до шести лет. В августе американская инвестиционная управляющая компания VanEck заявила, что майнеры биткоинов могут зарабатывать дополнительно $13,9 млрд/год благодаря партнёрству с компаниями в области ИИ. Ряд криптомайнеров вовремя перешли на обслуживание ИИ. Так, CoreWeave полностью переключилась на поддержку ИИ/HPC-задач. Компания также подписала 12-летний контракт с майнинговой фирмой Core Scientific, в рамках которого последняя расширит ёмкости для удовлетворения потребности CoreWeave в ИИ-вычислениях. По словам Core Scientific, сделка принесёт ей за 12 лет $8,6 млрд. Ещё один игрок на рынке майнинга, Crusoe Energy, построит и сдаст в аренду Oracle крупный ИИ ЦОД. Oracle разместит там ИИ-кластеры и сдаст их в аренду Microsoft в интересах OpenAI. Hive Digital Technologies, Northern Data, Applied Digital, Iris Energy и другие майнеры теперь тоже уделяют всё больше внимания HPC/ИИ наряду со криптобизнесом. |

|