Материалы по тегу: hardware

|

08.03.2025 [21:26], Сергей Карасёв

Team Group представила самоуничтожающиеся SSD P250Q, а также DDR5-модули памяти CU-DIMM, CSO-DIMM, (LP)CAMM и CXLКомпания Team Group 2025 анонсировала большое количество новинок для индустриального и коммерческого применения. Дебютировали SSD в различных форм-факторах, модули оперативной памяти, а также флеш-карты micro SD. В частности, представлен накопитель P250Q One-Click Data Destruction SSD, особенность которого заключается в поддержке физического уничтожения флеш-памяти с целью недопустимости извлечения информации. Эта функция дополняет традиционное программное стирание, исключая возможность восстановления конфиденциальных данных. Кроме того, анонсированы накопители RF40 E1.S Enterprise SSD в форм-факторе E1.S для дата-центров. Эти устройства допускают горячую замену, а за отвод тепла отвечает запатентованный медно-графеновый радиатор толщиной всего 0,17 мм. На промышленный сектор ориентированы изделия серий R840 и R250 типоразмера М.2, оснащённые интерфейсом PCIe 5.0 x4. В этих SSD применён контроллер, при производстве которого используется 6-нм технология TSMC. Информация о вместимости и скоростных характеристиках всех перечисленных изделий пока не раскрывается. В список новинок вошли модули оперативной памяти промышленного класса DDR5 стандартов CU-DIMM (Clocked Unbuffered DIMM) и CSO-DIMM (Clocked Small Outline DIMM). Они функционируют на частоте 6400 МГц при напряжении питания 1,1 В. Эти модули могут применяться в серверах, индустриальных ноутбуках повышенной прочности и пр.

Источник изображения: Team Group Анонсированы также модули памяти CAMM2 и LPCAMM2 (Compression Attached Memory Module 2), рассчитанные на промышленные системы, edge-устройства и пр. Такие решения монтируются параллельно материнской плате, благодаря чему занимают меньше места в высоту. Для установки применяются резьбовые стойки. Память соответствует стандарту DDR5-6400.

В число прочих новинок вошли серверные модули памяти CXL 2.0 Server Memory Module. Плюс к этому представлены карты памяти D500R WORM Memory Card и D500N Hidden Memory Card. Первые ориентированы WORM-нагрузки (Write Once, Read Many), что предотвращает стирание или изменение данных. Карты второго типа получили встроенную функцию скрытия разделов.

08.03.2025 [21:24], Сергей Карасёв

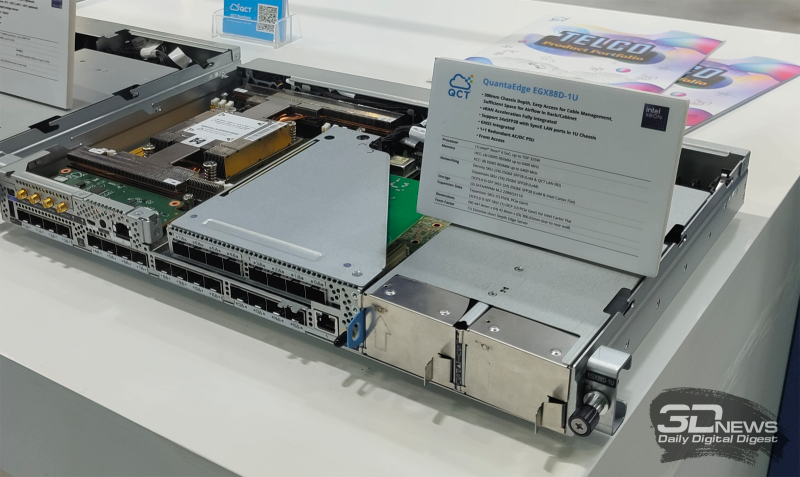

QCT представила компактный edge-сервер QuantaEdge EGX88D-1U с 24 25GbE-портами на базе Intel Xeon Granite Rapids-DКомпания QCT в ходе MWC 2025 продемонстрировала компактный 1U-сервер QuantaEdge EGX88D-1U, предназначенный для выполнения различных задач на периферии: это могут быть приложения ИИ, виртуализованные сети радиодоступа (vRAN), транскодирование мультимедийных материалов и пр. В спецификациях сервера говорится об использовании аппаратной платформы Intel Xeon 6 SoC (Granite Rapids-D): один CPU c TDP до 325 Вт; до 72 P-ядер P-Core; возможность использования четырёх или восьми модулей DDR5-6400; поддержка Intel Quick Assist Technology (Intel QAT), Intel vRAN Boost, Intel Dynamic Load Balancer и Intel Media Transcode Accelerator. Однако среди моделей последнего поколения Xeon-D есть модели с TDP до 235 Вт, насчитывающие до 42 ядер. Нет похожих моделей и среди Granite Rapids-SP 6500P/6700P. Предусмотрены два коннектора для накопителей стандарта М.2 2280/22110 с интерфейсом SATA/NVMe. Новинка заключена в корпус небольшой глубины, которая составляет приблизительно 300 мм. Есть по одному слоту расширения PCIe 5.0 (для карт FHHL) и OCP 3.0 (Intel Carter Flat). Устройство предоставляет до 24 сетевых портов 25GbE SFP28. Общие габариты системы — 447,8 × 300,65 × 42,8 мм.

Кроме того, на мероприятии MWC 2025 компания QCT демонстрирует ряд других серверов. Это, в частности, модели QuantaGrid D55X-1U и QuantaGrid D55Q-2U. Они рассчитаны на работу с двумя чипами Xeon 6700E (Sierra Forest-SP) или 6500P/6700P (Granite Repids-SP) с TDP до 350 Вт. Возможна установка 32 модулей DDR5-6400 RDIMM или 16 модулей MRDIMM DDR5-8000. Поддерживаются различные конфигурации подсистемы хранения данных с накопителями типоразмера LFF, SFF, E1.S и E3.S.

07.03.2025 [17:24], Руслан Авдеев

CoreWeave опровергла слухи о расторжении контрактов с Microsoft перед многомиллиардным IPOCoreWeave опровергла сообщения прессы о том, что Microsoft якобы «отозвала» часть договорных обязательств непосредственно перед выходом облачного провайдера на IPO. Ранее об этом говорили источники, «знакомые с вопросом», сообщает Datacenter Dynamics. В частности, со ссылкой на собственные источники, The Financial Times писала, что Microsoft отозвала некоторые соглашения из-за проблем с поставками услуг и несоблюдением «дедлайнов». Microsoft якобы утратила доверие к CoreWeave, но сохраняла несколько ключевых контрактов и оставалась важным партнёром компании. На запрос Datacenter Dynamics в CoreWeave ответили, что «гордятся» партнёрскими отношениями с клиентами и фактов расторжения контрактов и отказов от обязательств не отмечено. «Любые утверждения об обратном являются ложными и вводящими в заблуждение», — подчеркнули в компании. Официального заявления со стороны Microsoft пока не было. CoreWeave подала заявку для выхода на IPO на этой неделе, так что подобные слухи могут крайне негативно сказаться на её будущей оценке. В заявке для Комиссии по ценным бумагам и биржам США (SEC) компания признаёт, что значительная часть доходов приходится на ограниченное число клиентов, так что потеря даже одного из них может отрицательно сказаться на бизнесе, финансовом положении и перспективах. В документе отмечается, что компании ещё предстоит исполнить договорные обязательства на сумму $15,1 млрд.

Источник изображения: Sebastian Herrmann/unsplash.com Около 77 % выручки CoreWeave в 2024 году пришлось всего на двух клиентов, крупнейшим из них является именно Microsoft (62 %). В ноябре того же года Microsoft утверждала, что потратит на услуги CoreWeave $10 млрд. Анализ обстоятельств вероятного IPO CoreWeave экспертами Next Platform свидетельствует о том, что Microsoft, кажется, «менее восторженно» относится к собственным расходам на ИИ — уже появились данные об отказе от некоторых проектов. В конце прошлого месяца появилась информация о том, что Microsoft отменила договоры аренды ИИ ЦОД приблизительно на 200 МВт. В отчёте TD Cowen предполагается, что компания, вероятно, закупила избыточные ёмкости, сделав некорректные прогнозы спроса. Отчасти это может быть связано с тем, что её ключевой партнёр OpenAI стремится перейти на собственную инфраструктуру в рамках проекта Stargate, поскольку это, вероятно, будет дешевле. Другими словами, хотя $15,1 договорных обязательств — весьма внушительный показатель для CoreWeave, не исключено, что основным клиентом остаётся именно Microsoft, которая может прекратить сотрудничество года через три — по имеющимся данным, средняя продолжительность контракта CoreWeave составляет около четырёх лет. В самой Microsoft отметили, что корректировка расходов в некоторых областях не помешает компании активно расти во всех регионах и она по-прежнему намерена потратить $80 млрд на ИИ-инфраструктуру в текущем финансовом году для удовлетворения рекордного спроса клиентов.

07.03.2025 [17:09], Руслан Авдеев

Saigon Asset Management (SAM) намерена построить «крупнейший во Вьетнаме» кампус ЦОД близ ХанояВьетнамская Saigon Asset Management (SAM) заявила о планах создания кампуса ЦОД SAM DigitalHub в предместьях Ханоя (Hanoi). Проект площадью 50 га претендует на звание «крупнейшего кампуса ЦОД во Вьетнаме» и обеспечит 150 МВт мощности, сообщает пресс-служба SAM. Кампус разместят в технопарке Vietnam Singapore Industrial Park (VSIP) — совместном предприятии вьетнамской Becamex IDC Corporation и сигнапурского консорциума, возглавляемого Sembcorp Development. Основаная цель предприятия — содействие экономическому сотрудничеству Вьетнама и Сингапура. В рамках нового проекта планируется привлечь до $1,5 млрд. SAM объявила, что как минимум 50 МВт будут получены от источников возобновляемой энергии. Правда, ни сроков реализации, ни дополнительных характеристик компания пока не представила. По словам SAM, гиперскейлеров удерживали от выхода на вьетнамский рынок проблемы с лицензированием, а также малая доступность земли и электроэнергии. Совместно с VSIP эти проблемы будут успешно решены. SAM сформировала и специальный фонд Vietnam Data Center Fund на $300 млн, завершение первого этапа привлечения средств ожидается в IV квартале 2025 года. Предполагается, что фонд будет содействовать реализации проектов, связанных с цифровой инфраструктурой SAM и привлечением международных инвестиций.

Истчоник изображения: SAM SAM, основанная в 2007 году в США, является частной инвестиционной компанией со штаб-квартирой в Хошимине (Вьетнам). Компания специализируется на инициативах, связанных с ИИ, безопасностью, дата-центрах, здравоохранении и образовании. В числе её клиентов есть вьетнамский телеком-оператор Viettel. Последняя, кстати, сама намерена построить 24 ЦОД в стране к 2030 году. По данным Datacenter Dynamics, одним из ключевых заинтересованных сторон в SAM DigitalHub является малайзийская PMX, специализирующаяся на строительстве ЦОД. Недавно она отчиталась о реализации в Малайзии трёх соответствующих проектов почти на 125 МВт в совокупности. Сейчас Вьетнам находится на пике популярности среди инвесторов. Так, представительство в Ханое имеет Telehouse, в Хошимине имеются представительства True IDC и Epsilon. У NVIDIA в стране появится центр исследований и разработок, а Wistron намерена расширить там производство ИИ-серверов. Более того, в конце прошлого года вьетнамские и сингапурские компании объявили о намерении проложить подводный интернет-кабель от Вьетнама до Сингапура. О многочисленных IT-проектах для Вьетнама сообщалось ещё осенью 2024 года.

07.03.2025 [15:36], Сергей Карасёв

Стартап Axelera AI анонсировал ИИ-ускоритель TitaniaНидерландский стартап Axelera AI B.V., специализирующийся на разработке ИИ-ускорителей, анонсировал решение Titania — высокопроизводительный, энергоэффективный и масштабируемый чиплет для задач инференса. Полностью технические характеристики изделия пока не раскрываются. Известно, что Titania использует проприетарную модель вычислений в памяти Digital In-Memory Computing (D-IMC). Этот подход, как заявляет Axelera AI, обеспечивает ИИ-производительность свыше 50 TOPS на ядро (эквивалентная точность FP32) и энергоэффективность на уровне 15 TOPS на 1 Вт затрачиваемой энергии. Решение Titania базируется на открытой архитектуре RISC-V. Несколько чиплетов могут быть объединены в виде модуля SiP (System-in-Package). Использование D-IMC обеспечивает практически линейную масштабируемость производительности без значительного увеличения затрат на питание и охлаждение. В качестве потенциальных областей применения Titania названы НРС-платформы, корпоративные дата-центры, робототехника, автомобилестроение и пр. Одновременно с анонсом Titania стартап Axelera AI объявил о привлечении до €61,6 млн от EuroHPC JU в рамках проекта Digital Autonomy with RISC-V for Europe (DARE). Компания Axelera AI будет поддерживать EuroHPC в области разработки суперкомпьютерной экосистемы мирового класса в Европе. В частности, стартап планирует расширять свои научно-исследовательские и опытно-конструкторские подразделения в Нидерландах, Италии и Бельгии. Отмечается также, что основанная в 2021 году компания Axelera AI за три года существования получила инвестиции на общую сумму более $200 млн.

07.03.2025 [12:12], Сергей Карасёв

Advantech представила SSD объёмом до 30,7 Тбайт — интерфейс PCIe 5.0, память TLC, форматы U.2, E1.S и E3.SКомпания Advantech анонсировала SSD семейства SQFlash EU-2 PCIe/NVMe для дата-центров и платформ корпоративного уровня. Изделия выполнены на основе чипов флеш-памяти 3D TLC, а для обмена данными используется интерфейс PCIe 5.0 х4. Дебютировали решения SQF-CU2 EU-2 в форм-факторе SFF U.2 (SFF-8639), SQF-CE3 EU-2 стандарта E3.S (EDSFF 1C), а также SQF-CE1 EU-2 типоразмера E1.S (EDSFF 1C). Во всех случаях реализована поддержка NVMe 2.0, AES-256 и TCG-OPAL. Диапазон рабочих температур простирается от 0 до +70 °C. Накопители могут выдерживать до одной полной перезаписи в сутки (1 DWPD). Серия SQF-CU2 EU-2 включает модификации вместимостью от 1,9 до 30,7 Тбайт. Заявленная скорость последовательного чтения информации достигает o 14 000 Мбайт/с, скорость последовательной записи — 8500 Мбайт/с. Показатель IOPS при произвольном чтении — до 3 млн, при произвольной записи — до 400 тыс. Размеры устройств составляют 100,2 × 69,85 × 15,0 мм.

Источник изображений: Advantech Изделия SQF-CE3 EU-2, в свою очередь, обладают ёмкостью от 1,9 до 15,3 Тбайт. Скорости последовательного чтения и записи — до 14 000 и 8500 Мбайт/с, величина IOPS при произвольных чтении и записи — до 3 млн и 480 тыс. Габариты — 112,75 × 76,0 × 7,5 мм.  В серию SQF-CE1 EU-2 вошли SSD вместимостью от 1,9 до 7,6 Тбайт. Заявленные скорости последовательного чтения и записи достигают 14 000 и 8300 Мбайт/с, величина IOPS — 3 млн и 220 тыс. при произвольных чтении и записи соответственно. Размеры устройств — 118,75 × 33,75 × 9,0/15,0 мм. Кроме того, компания Advantech представила SSD семейства SQF-CE1 930L-D в формате E1.S с интерфейсом PCIe 4.0 х4. Они имеют вместимость от 480 Гбайт до 3,8 Тбайт. Скорость последовательного чтения информации составляет дo 6800 Мбайт/с, скорость последовательной записи — до 2000 Мбайт/с.

07.03.2025 [08:59], Руслан Авдеев

Infleqtion испытает мобильную лабораторию квантовой навигации на борту корабля ВМС ВеликобританииКомпания Infleqtion развернёт мобильную квантовую лабораторию на борту судна Королевских ВМС Великобритании. На прошлой неделе компания объявила, что готовится к «захватывающему» испытанию квантового инерционного датчика в открытом море. Речь идёт о совместном проекте Infleqtion и британских военных. Компания намерена разместить мобильную лабораторию QPOD, размещённую в стандартном 20′ контейнере, на военном грузовом судне для многодневных испытаний, которые пройдут в конце текущего года. Учёные и военные будут изучать возможности квантовой навигации без использования GPS. Детали проекта не разглашаются. Как отмечает Datacenter Dynamics, на контейнере Infleqtion виден логотип NavyPOD (Persistent Operational Deployable Systems) ВМС Великобритании — это серия модулей, которые можно менять в зависимости от специфики миссии. Концепция NavyPOD была представлена в 2021 году. Известно о модулях, предназначенных для командования и управления, логистики, проведения экспериментов, медицинских целей, эксплуатации и обслуживания беспилотных систем. Infleqtion была основана в 2007 году под именем ColdQuanta — она появилась на базе Университета Колорадо, а позже отправилась в «самостоятельное плавание». Сейчас она разрабатывает и проектирует квантовые системы. В частности, она создала компактные оптические атомные часы Tiqker, которые можно использовать для позиционирования, навигации и синхронизации времени (PNT). Сейчас Infleqtion при поддержке государственного британского фонда Innovate UK работает над проектом Quantum Enhanced Inertial Navigation Systems (Q-NAV), и сотрудничает с британским оборонным подрядчиком QinetiQ. Ранее Infleqtion заявляла, что намерена провести морские испытания гибридных навигационных систем на экспериментальном судне ВМС Великобритании XV Patrick Blackett в начале 2025 года. Корабль применяется в качестве испытательной платформы для новых технологий. В 2023 году Имперский колледж Лондона (Imperial College London) провёл на борту этого же судна испытания квантового датчика для навигации Qinetiq NavyPOD. В 2024 году похожие испытания провели на самолёте QinetiQ RJ100.

06.03.2025 [21:36], Владимир Мироненко

Google раскрыла детали уязвимости в процессорах AMD и опубликовала инструментарий для анализа и изменения их микрокодаСпециалисты Google Security Team сообщили детали уязвимости (CVE-2024-56161), позволяющей обойти механизм проверки цифровой подписи при обновлении микрокода в процессорах AMD на базе микроархитектуры от Zen1 до Zen4, о чём пишет ресурс OpenNet. Уязвимости присвоен рейтинг опасности CVSS 7,2 балла из 10, что говорит о серьёзности проблемы. «Неправильная проверка подписи в загрузчике исправлений микрокода CPU AMD может позволить злоумышленнику с привилегиями локального администратора загрузить вредоносный микрокод», — говорится в сообщении Google. Исследователи известили AMD об обнаруженной уязвимости 25 сентября 2024 года. Уязвимость, сделавшая возможной загрузку собственных патчей для микрокода процессоров AMD Zen 1-4, вызвана использованием для верификации вместо рекомендованных хеш-функций алгоритма CMAC, который не подходит для этого и не защищён от подбора коллизий. Компания AMD устранила уязвимость в декабрьском обновлении микрокода путём замены CMAC на криптографически стойкую хеш-функцию. Google также опубликовала под лицензией Apache 2.0 инструментарий Zentool, с помощью которого можно анализировать микрокод, манипулировать им и создавать патчи для изменения микрокода в процессорах AMD Zen. Zentool включает команды: zentool edit — редактирует параметры файлов с микрокодом, изменяет микрокод и заменяет отдельные инструкции; zentool print — выводит информацию о структурах и параметрах микрокода; zentool load — загружает микрокод в CPU; zentool resign — корректирует цифровую подпись с учётом добавленных в микрокод изменений. Также в состав Zentool входят утилиты mcas и mcop с реализациями ассемблера и дизассемблера для микрокода. Специалисты Google также подготовили руководство по микроархитектуре RISC86, применяемой в микрокоде AMD, и рекомендации по созданию собственного микрокода с пояснением, как создавать собственные процессорные инструкции, реализуемые на микрокоде RISC86, менять поведение существующих инструкций и загружать изменения микрокода в процессор.

06.03.2025 [18:45], Владимир Мироненко

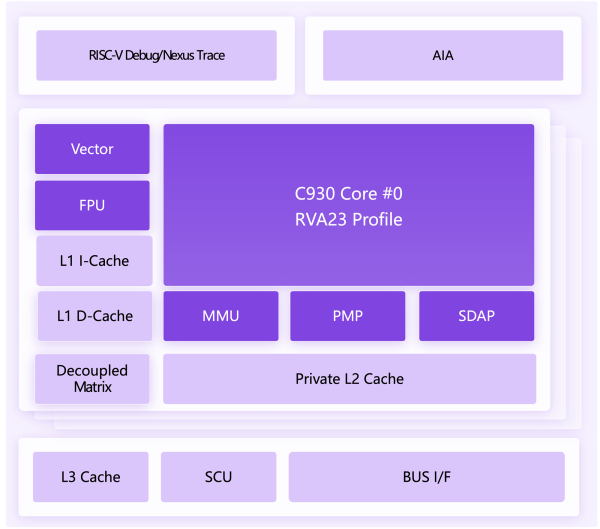

Китай запустит программу господдержки разработки и внедрения чипов RISC-VАрхитектура RISC-V с открытым исходным кодом, похоже, набирает значительную популярность в Китае, сделал вывод ресурс The Register, назвав в качестве свежего примера анонс процессора XuanTie C930, созданного НИИ Damo Academy (Alibaba Group Holding). Ядро C930 позиционируется как идеальное решение для серверов, ПК и автономных автомобилей. Особенно важно соответствие профилю RVA23, поскольку это краеугольный камень экосистемы RISC-V. В частности, профиль определяет расширения для гипервизора, которые являются практически необходимыми для серверных и облачных CPU. Как сообщает XuanTie, «C930 использует передовую микроархитектуру для достижения высокой производительности, включая алгоритм прогнозирования ветвлений на основе TAGE, индивидуальный кеш L2, регулируемый механизм предварительной выборки данных и т. д. Показатель производительности C930 в тесте Specint2006 превышает 15/ГГц». Сообщается, что «типичная конфигурация одного кластера поддерживает четыре ядра» с 64 Кбайт кеша инструкций и данных и L2-кешем на 1 Мбайт. Векторный блок поддерживает расширение RISC-V Vector 1.0, обрабатывает 256-бие векторные регистры и поддерживает вычисления в формате FP16/BF16/FP32/FP64/INT8/INT16/INT32/INT64. Также упомянут блок матричных вычислений. В ходе презентации чипа топ-менеджеры Alibaba Cloud спрогнозировали, что RISC-V станет основной облачной архитектурой в течение 5–8 лет. По данным Reuters, Пекин планирует запустить государственную программу с целью стимулирования широкого использования RISC-V по всей стране. В настоящее время восемь китайских правительственных агентств занимаются подготовкой постановления, которое будет способствовать распространению чипов на базе RISC-V в Китае. Ранее власти призвали китайские компании отказаться от американских чипов в пользу отечественных. Китайский разработчик процессоров Loongson получил возможность участия в пилотном проекте на поставку 10 тыс. ПК китайские школы и контракт на использование его чипов в вычислительной системе на орбитальной станции «Тяньгун», а Lenovo перенесла свой HCI-стек на архитектуру Loongson. Академия наук КНР пообещала в 2021 году выпускать новые проекты на основе RISC-V каждые полгода. Хотя эта цель не была достигнута, в феврале 2025 года академия намекнула на готовящийся мощный проект с использованием RISC-V. В 2023 году технологический гигант Baidu исследовал возможность использования чипов на базе RISC-V уровня ЦОД. В том же году Alibaba сообщила о намерении создать чипы RISC-V для различных сфер, от носимых устройств до облаков. Сейчас крупнейшими коммерческими производителями решений на базе RISC-V в Китае являются XuanTie и Nuclei System Technology, пишет Reuters. На недавнем мероприятии XuanTie было заявлено, что популярность DeepSeek также может стимулировать внедрение RISC-V, поскольку ИИ-модели китайского стартапа эффективно работают на менее мощных чипах. «Даже если решение RISC-V стоимостью ¥10 млн ($1,4 млн) может достичь лишь около 30 % уровня решений NVIDIA или Huawei, три таких комплекта будут всё равно дешевле», — сообщил представитель China Mobile System Integration. В США уже выразили беспокойство по поводу того, что открытая лицензия RISC-V, позволяющая разработчикам использовать архитектуру бесплатно, обеспечит китайским фирмам возможность применять интеллектуальную собственность, созданную в Америке, для разработки передовых технологий. Недавно господдержку запросил и российский альянс RISC-V.

06.03.2025 [17:43], Руслан Авдеев

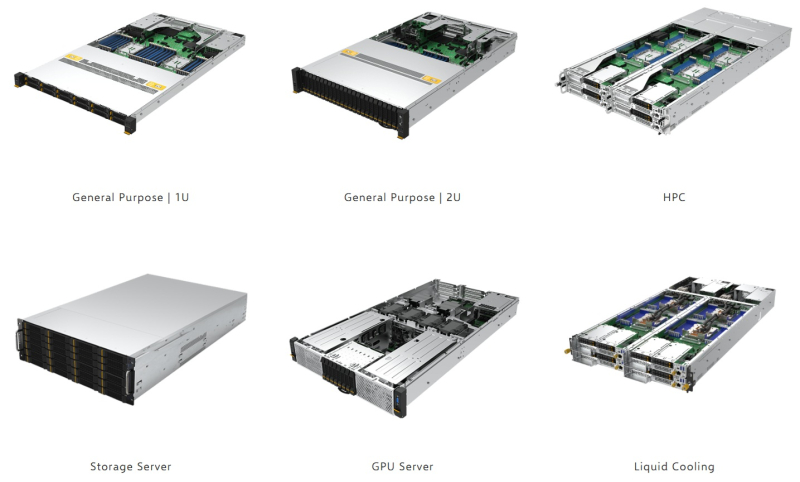

Compal и Kalyani Group займутся совместным выпуском серверов в ИндииCompal Electronics заключила соглашение с подразделением Kalyani Group, занимающимся выпуском электроники. Компании намерены выйти на индийский рынок серверов и подписали меморандум о взаимопонимании — в рамках государственной политики Make in India они будут выпускать соответствующую продукцию на местных заводах, сообщает DigiTimes. Compal уже объявила о планах технической поддержки бизнеса Kalyani Group в части производства, сборки, тестирования и продаж серверов. Также соглашение имеет потенциал для расширения в будущем, с прицелом на сотрудничество в сфере потребительской электроники. Ранее Compal уже управляла заводом по производству смартфонов в Индии, но компания временно прекратила соответствующую деятельность из-за общего сокращения объёмов своего бизнеса. Сегодня Compal расширяет серверный бизнес новыми решениями на базе Intel Xeon 6. Фокус делается на ИИ, HPC и облачных приложениях. Компания ожидает двузначного годового роста (в процентах) выручки от продажи серверных решений в 2025 году. Представитель Compal уже выразил приверженность компании развитию серверного направления с заключением ряда партнёрств. Предполагается, что укреплению сотрудничества будет способствовать опыт работы Kalyani Group на индийском рынке. По мнению отраслевых экспертов, партнёрство компаний повысит конкурентоспособность производственного сектора страны. Подразделение Kalyani Group, выпускающее электронику, в основном специализируется на производстве компонентов для электромобилей и коммерческого транспорта, но в феврале 2025 года оно объявило о намерении начать выпуск ИИ-серверов отечественного производства на предприятии в Пуне (штат Махараштра). Ранее массовый выпуск серверов в стране наладила HPE (совместно с VVDN). Lenovo анонсировала планы по производству ИИ-серверов, но малыми тиражами. А вот Wistron продала свой индийский завод компании Tata Group. Не вызывает сомнений, что серверы будут востребованы в Индии. Только в январе индийская Reliance заявила, что намерена построить «крупнейший в мире» ЦОД на 3 ГВт, в начале февраля 2025 года Сэм Альтман (Sam Altman) заявил, что Индия должна стать лидером в создании малых «рассуждающих» ИИ-моделей, а в конце февраля уже Blackstone и Panchshil Realty объявили о намерении построить за $2,3 млрд «крупнейший в Индии» кампус ИИ ЦОД — и это далеко не все планы. |

|