Материалы по тегу: hardware

|

13.03.2025 [09:53], Руслан Авдеев

Трио компаний в США намерено использовать газ из угольных шахт для энергообеспечения ЦОДТри американских компании объединили усилия для обеспечения растущих из-за ИИ энергетических потребностей дата-центров. Для получения электричества они предложили подавать по трубам шахтный метан к топливным элементам, установленным при уже строящихся ЦОД, сообщает пресс-служба Diversified Energy. Diversified Energy, FuelCell Energy и инвестиционная TESIAC будут сотрудничать для надёжного удовлетворения растущего спроса операторов ЦОД на электричество. В соответствии с соглашением Diversified Energy будет получать природный газ и метан из угольных шахт в трёх локации на территории Вирджинии, Западной Вирджинии и Кентукки. Для получения электричества на месте будут применяться топливные элементы FuelCell Energy, а TESIAC займётся обеспечением финансирования проектов, передаёт The Register. Вирджиния, особенно север штата, славится большой концентрацией ЦОД на довольно ограниченной территории — здесь находится т.н. «Аллея дата-центров». Впрочем, теперь строители начали развивать аналогичные проекты и в соседнем Кентукки. Расширение мощностей обходится не без проблем, не в последнюю очередь из-за дефицита энергии для строящихся дата-центров. Исследование, проводившееся в прошлом году, позволило прийти к выводу, что потребление энергии ЦОД в США к 2030 году вырастет более чем вдвое. Проблема заставила операторов ЦОД искать альтернативные источники питания. Одним из таких вариантов является генерация энергии непосредственно при ЦОД, что гарантирует бесперебойную работу без оглядки на состояние общей энергосети и позволяет продавать последней излишки. В Diversified Energy заявляют, что её точки добычи природного газа и метана из угольных пластов «выгодно расположены» в районе Аппалачей — это позволит напрямую обеспечивать потребности многочисленных близлежащих дата-центров в энергии. Во FuelCell Energy уверены, что партнёры смогут удовлетворить потребности операторов в электричестве быстрее и экологичнее, чем альтернативные проекты на рынке. В компании считают, что будущее ИИ и HPC потребует больших объёмов «чистой» энергии, генерируемой на местах. Впрочем, в норме метан не применяется в топливных элементах — обычно его предварительно преобразуют в водород, в ходе чего всё же выделяется CO2 хотя и в меньших объёмах, чем при сжигании газа напрямую.

13.03.2025 [08:50], Руслан Авдеев

Cerebras развернёт царь-ускорители WSE-3 ещё в шести ЦОД во Франции, США и КанадеКомпания Cerebras начала установку более тысячи ИИ-систем CS-3 на базе гигантских ускорителей WSE-3 по всей Северной Америке и во Франции. Компания стремится зарекомендовать себя как поставщика одной из крупнейших и быстрейших облачных инференс-платформ, сообщает The Register. Кроме того, компания объявила о расширении сотрудничества с Hugging Face. К концу 2025 года развернёт свои ускорители в дата-центрах в Техасе, Миннесоте, Оклахоме и Джорджии, а также в Канаде и во Франции. Cerebras будет целиком владеть площадками в Оклахома-Сити (Оклахома) и Монреале (Канада), а оставшиеся объекты будут эксплуатироваться в рамках соглашения с G42 из ОАЭ. Крупнейший в США новый кластер CS-3 разместится в Миннеаполисе (Миннесота), его оснастят 512 CS-3 с общим быстродействием 64 Эфлопс (FP16). Он заработает уже во II квартале 2025 года. Cerebras давно сотрудничает с фондом G42, который активно спонсирует ИИ-стартап и является его якорным заказчиком — на G42 пришлось 83 % от всей выручки Cerebras за 2023 календарный год. Однако именно это сотрудничество привело к тому, что Cerebras вынужденно отложила IPO — власти США опасаются, что Китай получит доступ к ИИ-суперчипам Cerebras при посредничестве ОАЭ. По слухам, G42 заключила сделку с США, отказавшись от работы с Китаем в обмен на инвестиции.

Источник изображения: SNL В ближайшее время Cerebras также намерена расширить API-доступ к своим ускорителям для разработчиков, договорившись с репозиторием моделей Hugging Face. Также Cerebras выиграла контракты с Mistral AI и Perplexity. Недавно объявлено о намерении аналитической платформы AlphaSense заменить трёх поставщиков моделей с закрытым кодом на модель open source, работающую на CS-3. Летом прошлого года было объявлено о партнёрстве с Dell.

12.03.2025 [20:37], Владимир Мироненко

Евросоюз потратит €240 млн на создание трёх RISC-V чиплетов для суперкомпьютеров в рамках проекта DARE

eurohpc

hardware

hpc

risc-v

европа

ии

импортозамещение

инвестиции

суперкомпьютер

ускоритель

финансы

чиплеты

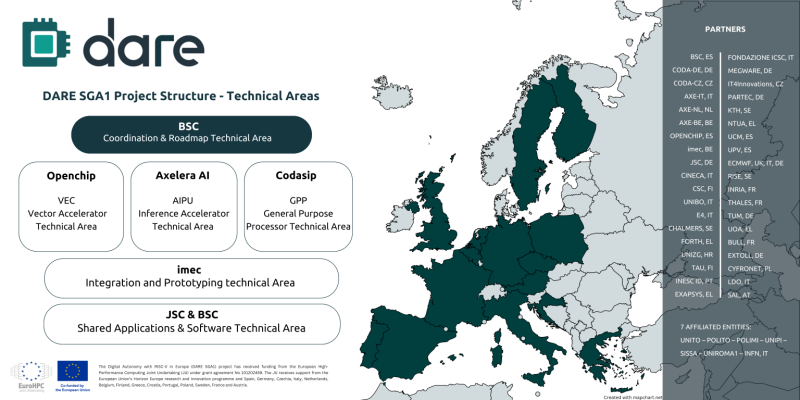

Digital Autonomy with RISC-V in Europe (DARE), крупнейший проект по разработке чипов из когда-либо финансируемых Европейским союзом, созданный с целью укрепления технологического суверенитета Европы в области высокопроизводительных вычислений (HPC) и искусственного интеллекта (ИИ), официально начал первый этап DARE SGA1, на реализацию которого выделено €240 млн ($262 млн), сообщается на сайте проекта. Европа и Китай делают ставку на RISC-V. Финансирование инициативы обеспечат 38 участников, включая ИТ-компании, исследовательские институты и университеты по всей Европе. Проект поддерживается EuroHPC JU и координируется Барселонским суперкомпьютерным центром (BSC-CNS). Последний имеет богатый опыт разработки чипов RISC-V и суперкомпьютерных систем. Половина инвестиций в проект DARE будет предоставлена Европейской комиссией через EuroHPC, а другая половина поступит напрямую от европейских партнёров, включая €34 млн от Министерства науки, инноваций и университетов Испании. Рассчитанный на три года DARE SGA1 является первым этапом шестилетней инициативы DARE. Цель — создание полноценного независимого европейского суперкомпьютерного программно-аппаратного стека для HPC и ИИ, включая чипы, системы на основе чиплетов и ПО. Инициатива направлена на удовлетворение стратегической потребности Европы в цифровом суверенитете и получения полного контроля над критической вычислительной инфраструктурой. Проектом DARE SGA1 предусмотрена разработка трёх чиплетов на основе архитектуры RISC-V, каждый из которых будет выполнять критически важную функцию в вычислениях HPC и ИИ:

В дополнение к указанным компаниям в качестве технических лидеров названы imec и Юлихский исследовательский центр (JÜLICH Supercomputing centre, JSC), которые будут продвигать ключевые инновации в рамках проекта. Помимо координации усилий, BSC также возглавит разработку планов и будет участвовать в разработке программных и аппаратных решений. Изготавливаться чиплеты будут по технологии CMOS с использованием современных техпроцессов. Axelera получит на разработку до €61 млн при условии выполнения различных задач в течение следующих трёх лет, рассказал ресурсу EE Times генеральный директор Axelera Фабрицио дель Маффео (Fabrizio del Maffeo). Хотя нынешний чип Axelera Metis AIPU предназначен для периферийных систем, дель Маффео сказал, что разрабатываемый в рамках DARE продукт на основе чиплетов не несёт кардинальные изменения, речь скорее о масштабировании. Codasip в прошлом году анонсировала 64-бит чип X730 на базе RISC-V с архитектурной защитой CHERI. По данным The Next Platform, за последнее десятилетие компания привлекла $34,6 млн общего финансирования, включая средства в рамках различных инициатив ЕС, а также посевной раунд в размере $2,5 млн в 2016 году и раунд A в размере $10 млн в 2018 году.

12.03.2025 [16:48], Руслан Авдеев

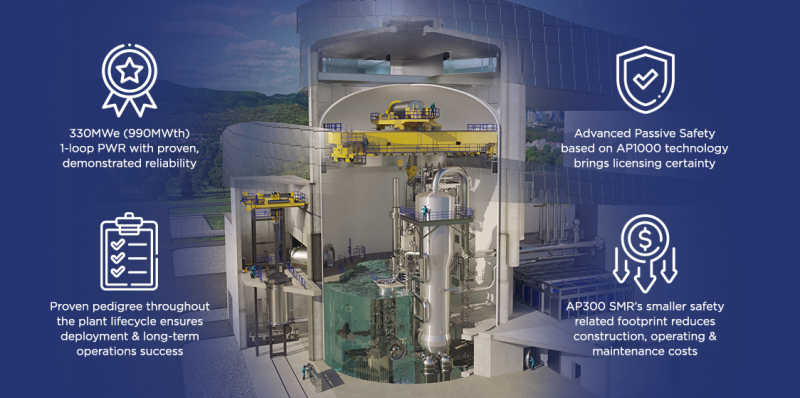

Data4 развернёт малые модульные реакторы Westinghouse AP300 для питания ЦОД в ЕвропеЕвропейский оператор ЦОД Data4, принадлежащий Brookfield, намерен внедрить на своих объектах малые модульные реакторы (SMR) Westinghouse AP300, сообщает Datacenter Dynamics. В рамках соглашения Data4 намерена использовать AP300 в одном из европейских ЦОД для снижения зависимости от ископаемого топлива, дополнительные подробности не разглашаются. Ввод в эксплуатацию состоится в начале 2030-х годов. Как сообщают в Data4, отрасль ЦОД переживает глубокую трансформацию, поскольку с развитием ИИ энергопотребление стремительно увеличивается. Благодаря использованию AP300 компании Westinghouse, кампусы получат относительную энергетическую автономию, снизив зависимость от традиционных сетей. Также они помогут снизить нагрузку на публичные электросети. AP300 с электрической мощностью 330 МВт основан на более крупном реакторе поколения III+ AP1000 мощностью 1 ГВт. Первый AP1000 заработал в 2018 году. Сейчас дюжина таких реакторов строится или уже работает, ещё 19 находятся в стадии планирования. Сейчас Westinghouse собирает заказы на AP300. Так, в 2024 году она подписала соглашение с Community Nuclear Power Limited на поставку четырёх SMR AP300 на северо-восток Англии. SMR весьма востребованы на рынке ЦОД, хотя коммерческие варианты пока отсутствуют. Тем не менее компании Edged, Amazon, Google, Oracle, Sabey, Prometheus Hyperscale, Equinix, Switch и др. подписали соглашение о закупке энергии SMR. Data4, основанная в 2006 году Colony Capital (ныне DigitalBridge) и с апреля 2023 года принадлежащая Brookfield, управляет около 30 ЦОД во Франции, Италии, Испании, Польше и Люксембурге. Во Франции компания намерена инвестировать около €20 млрд ($20,7 млрд) в расширение парка дата-центров в течение следующих пяти лет.

12.03.2025 [14:57], Сергей Карасёв

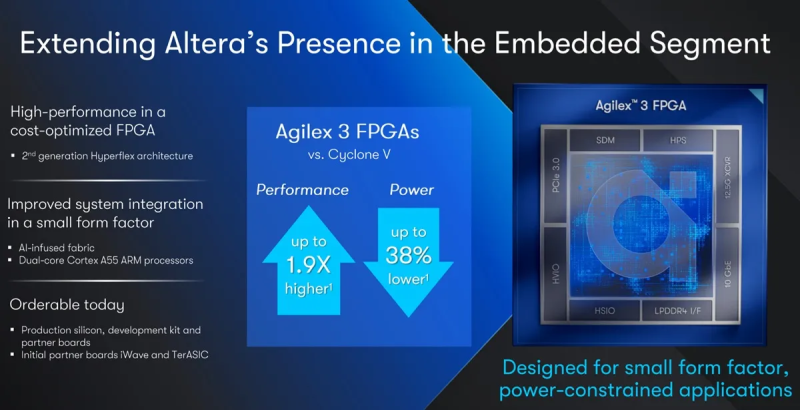

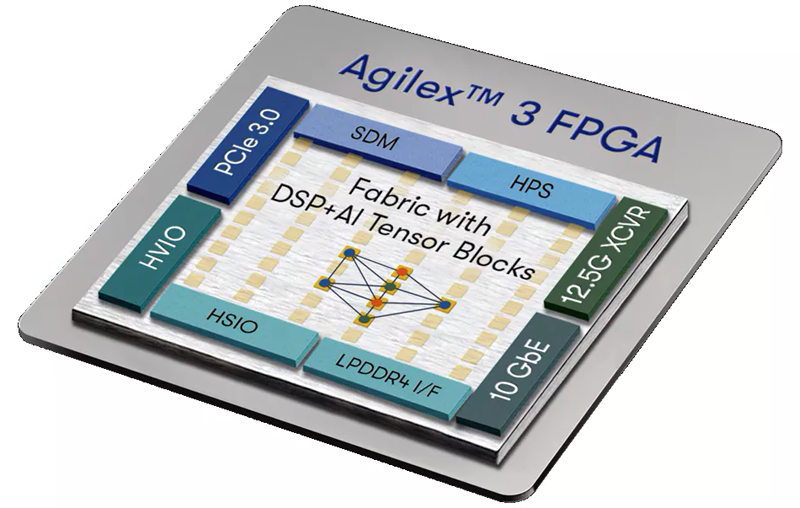

Altera представила малые FPGA семейства Agilex 3 для энергоэффективных системКомпания Altera, сформированная на базе выделенной из Intel группы программируемых решений (PSG), анонсировала FPGA семейства Agilex 3 для маломощных и экономичных систем. Среди сфер применения изделий названы автоматизация производственных процессов, медицинская визуализация, видеонаблюдение, мониторинг транспортных систем, периферийные ИИ-вычисления и пр. О подготовке Agilex 3 сообщалось в сентябре прошлого года. Задействована архитектура HyperFlex второго поколения. В состав решений входят ПЛИС с возможностями ИИ и два ядра Arm Cortex-A55 с тактовой частотой 800 МГц. По заявлениям Altera, чипы Agilex 3 обеспечивают 1,9-кратный рост производительности по сравнению Cyclone V при снижении энергопотребления до 38 %. Для трансиверов Agilex 3 заявлена скорость передачи данных до 12,5 Гбит/с. Говорится о поддержке интерфейсов PCIe 3.0 x4 и 10GbE. Усовершенствованный цифровой сигнальный процессор с блоком AI Tensor Block обеспечивает пиковую ИИ-производительность 2,8 TOPS на операциях INT8. Реализованы различные средства обеспечения безопасности, включая защищённую загрузку, шифрование AES и управление конфигурацией FPGA.  В семейство Agilex 3 вошли модели A3C025, A3C050, A3C065, A3C100 и A3C135, насчитывающие от 25 075 до 135 110 логических элементов. Поддерживается работа с памятью LPDDR4-2133. Изделия могут быть выполнены в корпусе с размерами 12 × 12, 16 × 16 или 18 × 18 мм. В качестве примеров использования Agilex 3 компания Altera приводит роботизированные системы, где FPGA обеспечивают управление в реальном времени для многоосевых манипуляторов. В составе промышленных камер чипы улучшают обнаружение дефектов. Приём предварительных заказов на изделия уже начался.

12.03.2025 [14:45], Сергей Карасёв

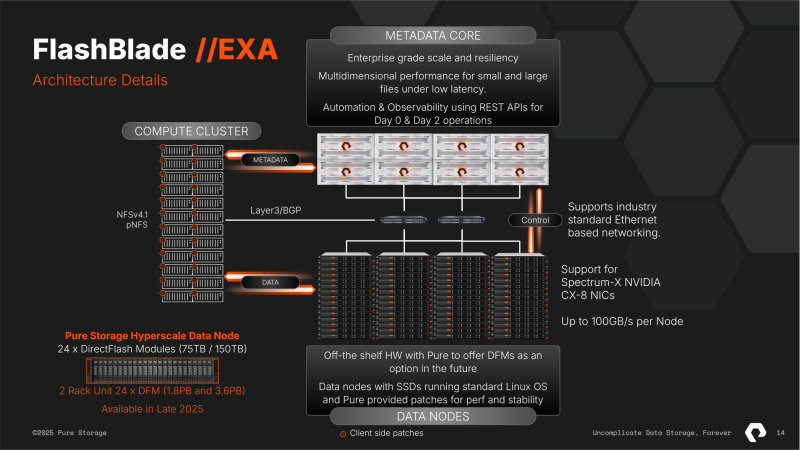

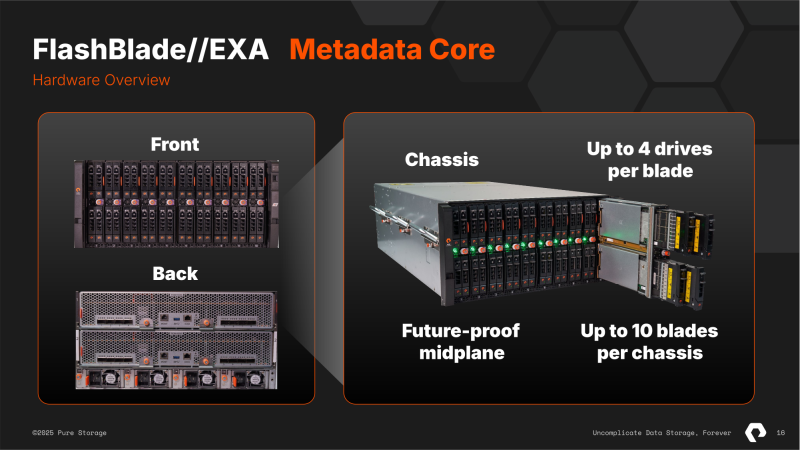

10+ Тбайт/с: Pure Storage представила высокопроизводительную All-Flash СХД FlashBlade//EXA для ИИ и НРСКомпания Pure Storage анонсировала систему FlashBlade//EXA: это, как утверждается, самая производительная на сегодняшний день платформа хранения данных, разработанная специально для наиболее требовательных нагрузок ИИ и HPC. Отмечается, что стандартные СХД оптимизированы для традиционных сред HPC с предсказуемыми операциями. Такие системы разрабатываются с прицелом на масштабирование «чистой производительности». Однако современные нагрузки ИИ являются гораздо более сложными и многомодальными: они предусматривают обработку данных разного типа — текстов, изображений и видео — одновременно на десятках тысяч ускорителей. Из-за этого возникает необходимость в оптимизации обработки метаданных наряду с масштабированием производительности. FlashBlade//EXA, по заявлениям Pure Storage, устраняет узкие места традиционных СХД в плане работы с метаданными. Архитектура новой платформы даёт возможность масштабировать ресурсы для обработки обычных данных и метаданных независимо друг от друга. Эффективная обработка метаданных имеет решающее значение для поддержания высокой производительности, надёжности и эффективности в крупномасштабных средах ИИ. Сегмент метаданных Metadata Core в составе FlashBlade//EXA может объединять от 1 до 10 5U-шасси с десятью blade-узлами в каждом. В каждом узле размещается от одного до четырёх фирменных 37.5-Тбайт модуля DFM. Ещё 2U приходится на пару XFM (External Fabric Modules), которые дают 16 подключений 400GbE. Metadata Core работает с фирменной ОС Purity//FB, общается напрямую с GPU-кластером (NFSv4.1 over TCP) и управляет потоками данных между узлами хранения и кластером (NFSv3 over RDMA). Узлы хранения Data Node обладают неограниченной масштабируемостью. Причём эти узлы могут быть самыми обычными x86-серверами любых вендоров. Каждый такой узел должен содержать 32-ядерный CPU, 192 Гбайт RAM, от 12 до 16 NVMe SSD (PCIe 4.0/5.0) вместимостью до 61,44 Тбайт, а также пару 400GbE NIC. Архитектура платформы предусматривает использование сетевых адаптеров NVIDIA ConnectX, коммутаторов Spectrum, компонентов LinkX и пр. Система FlashBlade//EXA обеспечивает производительность свыше 10 Тбайт/с на операциях чтения в одном пространстве имён. В результате, организации могут значительно ускорить процессы обучения ИИ-моделей и инференса, максимально используя потенциал GPU-ускорителей. Это также способствует снижению временных и финансовых затрат на решение ресурсоёмких задач. По-видимому, именно это решение компания и предлагает гиперскейлерам. У самой Pure Storage есть тестовая конфигурация из 300 узлов, которая показывает производительность на уровне 30 Тбайт/с.

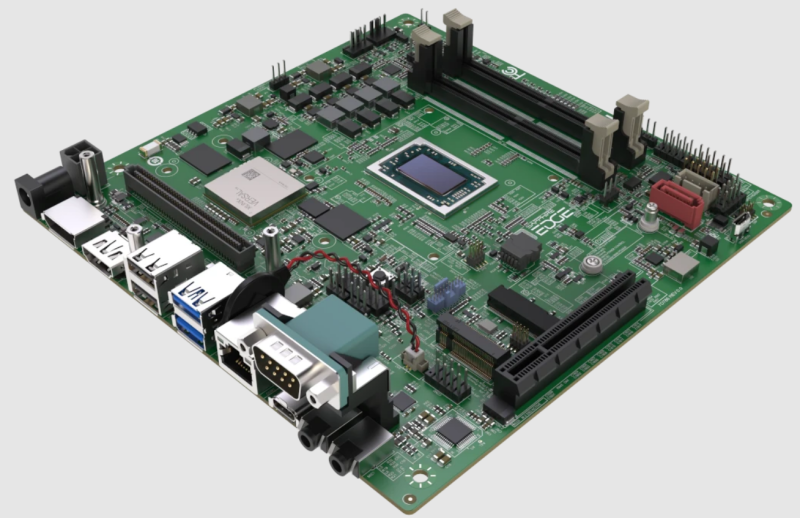

12.03.2025 [12:12], Сергей Карасёв

Mini-ITX-плата Sapphire Edge+ VPR-5050 содержит чип AMD Ryzen V2748 и FPGA VersalКомпания Sapphire анонсировала материнскую плату Edge+ VPR-5050 на платформе AMD Embedded+, выполненную в форм-факторе Mini-ITX с размерами 170 × 170 мм. Новинка предназначена для таких задач, как ИИ-приложения, промышленная автоматизация, обработка данных от различных датчиков в режиме реального времени и пр. Плата содержит процессор AMD Ryzen Embedded V2748 с восемью ядрами (2,9/4,15 ГГц) и графическим ускорителем Radeon RX Vega 7 с частотой 1,6 ГГц. Кроме того, задействована FPGA AMD Versal AI Edge VE2302 с двумя ядрами Arm Cortex-A72 (до 1,6 ГГц), двумя ядрами Arm Cortex-R5F, ИИ-движком с производительностью до 23 TOPS, памятью LPDDR4 (2 × 4 Гбайт или 2 × 8 Гбайт) и опциональным чипом eMMC на 64 Гбайт. Материнская плата располагает двумя слотами SO-DIMM с поддержкой до 64 Гбайт памяти DDR4-3200. Есть коннектор M.2 для SSD (PCIe 3.0 x4 или SATA-3) и порт SATA-3 для дополнительного накопителя (SSD или HDD). В разъём M.2 Key-E 2230 (PCIe 3.0 x1 и USB 2.0) может быть установлен комбинированный модуль Wi-Fi/Bluetooth. Доступен слот расширения PCIe x8. Набор интерфейсов включает выходы DP и HDMI, по два порта USB 3.2 Gen2 Type-A и USB 2.0 Type-A, один порт USB 3.2 Gen2 Type-C, гнездо RJ-45 для сетевого кабеля (контроллер 2.5GbE), последовательный порт и 3,5-мм аудиогнёзда. Диапазон рабочих температур простирается от 0 до +60 °C. Говорится о совместимости с RHEL/CentOS 7.9, RHEL 8.2–8.6 и Ubuntu 22.04. Для новинки доступны различные индустриальные модули расширения, в частности, с двумя портами 10/25GbE или 1GbE. Материнская плата может быть оборудована активным кулером с вентилятором.

12.03.2025 [00:25], Владимир Мироненко

Meta✴ начала тестирование собственного ускорителя для обучения ИИ-моделейMeta✴ Platforms приступила к тестированию ИИ-ускорителя собственной разработки, который, в случае успеха, позволит ей снизить зависимость от поставок чипов NVIDIA, пишет Reuters со ссылкой на информированные источники. По словам одного из источников, новый чип Meta✴ представляет собой специализированный ускоритель, то есть ASIC, предназначенный для обработки только ИИ-нагрузок. Небольшую пробную партию чипов Meta✴ изготовила тайваньская TSMC. По словам собеседника Reuters, тестирование началось после завершения фазы Tape-out — это заключительный этап разработки чипов перед началом производства, что является значительным маркером успеха в их разработке, отметило Reuters. Обычно этап Tape-out занимает от трёх до шести месяцев, причём без гарантии, что всё пройдёт успешно, и обходится в десятки миллионов долларов. В случае неудачи Meta✴ потребуется диагностировать проблему и начать всё заново. Этот чип представляет собой новое поколение ИИ-ускорителей, разработанных в рамках программы Meta✴ Training and Inference Accelerator (MTIA). Разработка продвигается с переменным успехом уже много лет. В прошлом году Meta✴ добилась определённых успехов — второе поколение ИИ-ускорителей Meta✴ MTIA оказалось втрое быстрее первого. В прошлом году Meta✴ начала использовать MTIAv2 для инференса рекомендательных систем Facebook✴ и Instagram✴.

Источник изображения: Meta✴ Meta✴ сообщила, что планирует к 2026 году начать использовать собственные ИИ-чипы для обучения моделей. Как и в случае с чипом для инференса, новый ИИ-ускоритель сначала пройдёт проверку в работе с рекомендательными системами, после чего его задействуют для приложений генеративного ИИ, таких как чат-бот Meta✴ AI, заявили в Meta✴. Крис Кокс (Chris Cox), директор по продуктам Meta✴, сообщил, что разработка чипов идёт с переменным успехом, отметив, что руководство компании посчитала ИИ-ускоритель для инференса первого поколения «большим успехом». Однако тестовые испытания он провалил, так что в 2022 году компания стала заказывать ускорители NVIDIA. С тех она остаётся крупным клиентом NVIDIA, используя её чипы как для обучения своих моделей, так и для инференса. Meta✴ прогнозирует общие расходы в 2025 году в размере от $114 до $119 млрд, в том числе до $65 млрд капитальных затрат, в основном связанных с расширением ИИ-инфраструктуры. Использование собственных чипов позволит компании значительно снизить затраты на это направление.

11.03.2025 [20:13], Татьяна Золотова

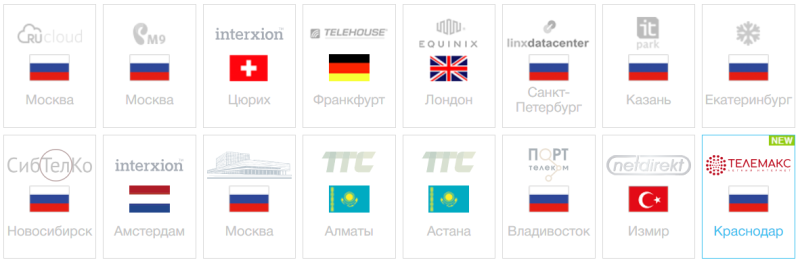

RuVDS развернул вычислительные мощности в КраснодареРоссийский хостинг-провайдер RuVDS запустил в работу площадку с виртуальными серверами в Краснодаре на базе ЦОД. Это уже девятая площадка RuVDS в России, поясняют в пресс-службе компании. Также у RuVDS есть три площадки в Москве, вычислительные мощности в Санкт-Петербурге, Казани, Екатеринбурге, Владивостоке и Новосибирске. В общей сложности в активе хостинг-провайдера мощности в 16 дата-центрах, семь из которых находятся за рубежом (в Швейцарии, Великобритании, Германии, Турции, Нидерландах и Казахстане). Площадка в Краснодаре принадлежит компании «ТелеМакс» соответствует 1-й особой категории надежности электропитания, оснащена двумя независимыми источниками электропитания, а также дополнительными дизельными генераторами с автоматическим запуском. Помещение, в котором расположены серверы, охлаждается с помощью сплит-систем промышленного назначения. «Спрос на вычислительные мощности в России значительно превышает востребованность зарубежных площадок, и Юг нашей страны, как один из самых густонаселенных регионов — логичное место для запуска новой площадки. Мы продолжим расширение присутствия на всей территории страны и за ее пределами», — отметил основатель и глава RuVDS.

11.03.2025 [19:46], Алексей Степин

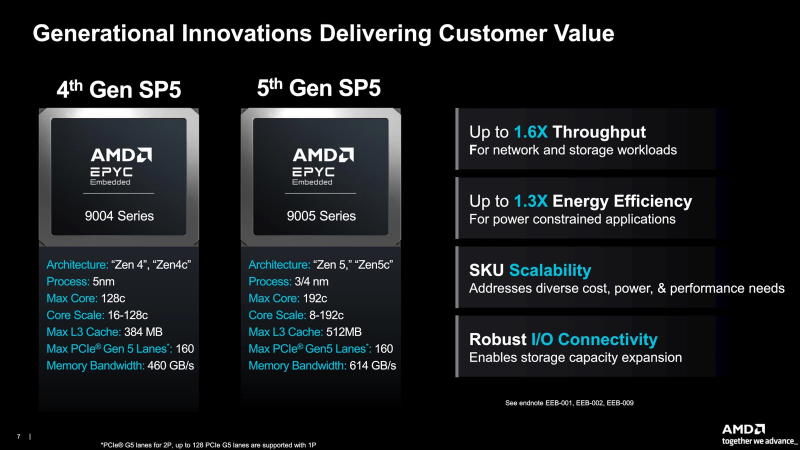

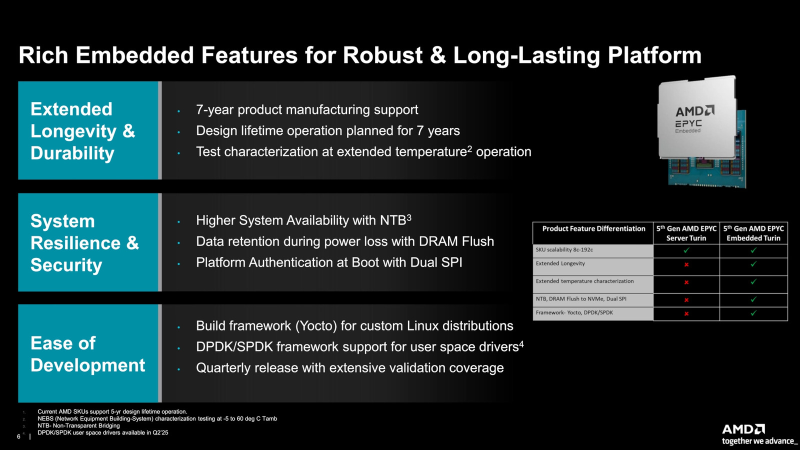

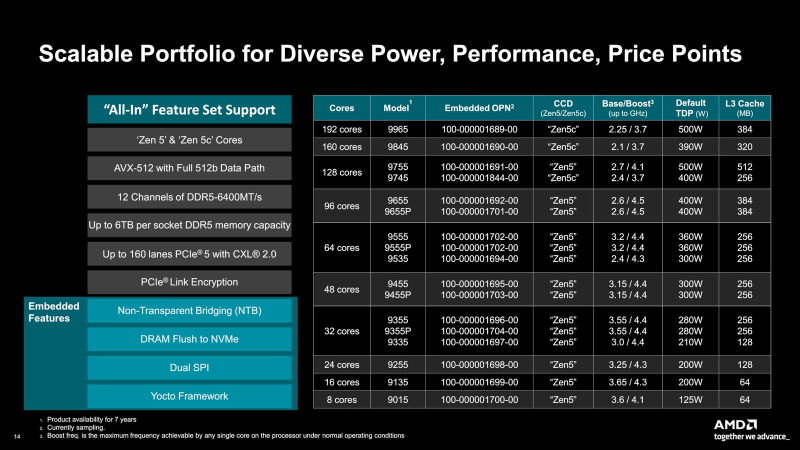

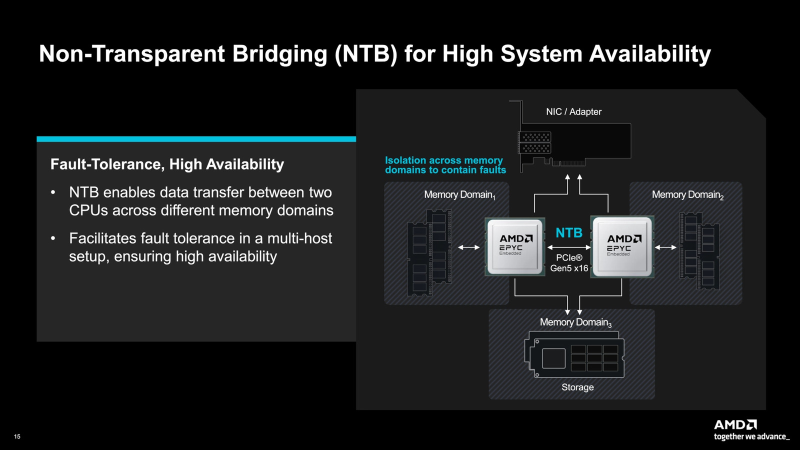

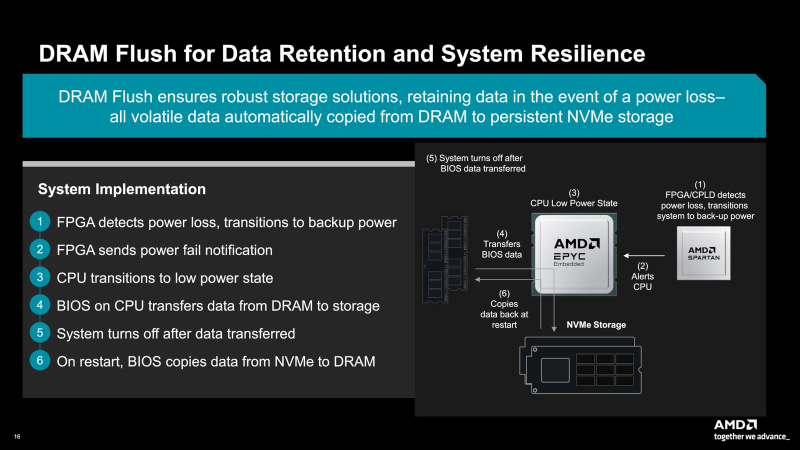

AMD представила EPYC Embedded 9005: до 192 ядер Zen 5(c), расширенная поддержка и высокая надёжностьAMD пополнила арсенал процессоров новыми моделями EPYC Embedded 9005, предназначенными для высоконагруженных встраиваемых решений, в том числе промышленных. Модельный ряд фактически повторяет ассортимент обычных EPYC 9005, но отличается некоторыми характерными для данного класса устройств особенностями, связанными с обеспечением повышенной надёжности и безопасности. Во-первых, конечно, следует отметить расширенный до 7 лет цикл поддержки данных решений. Во-вторых, сами процессоры EPYC Embedded 9005 рассчитаны на работу в более широком температурном диапазоне, так как встраиваемые платформы часто вынуждены функционировать отнюдь не в комфортных машинных залах ЦОД. Новые чипы поддерживают NTB (Non-Transparent Bridge), нужный для горячего резервирования в системах повышенной надежности, а также умеют безопасно сбрасывать содержимое оперативной памяти на NVMe-накопители при сбоях питания. Имеется поддержка CXL-модулей NV-CMM. Реализована аутентификация платформы при загрузке с использованием двух интерфейс SPI — один для образа BIOS, второй для кастомного загрузчика, которые проверяет целостность и корректность образа BIOS. Среди прочих особенностей отмечается наличие Secure I/O (SEV-TIO) и SDCI (Smart Data Cache Injection), а также расширенные функции мониторинга, в том числе OOB. Также реализованы расширенная коррекция ошибок DRAM и возможность переконфигурирования на лету сбойных DIMM. По сравнению c EPYC Embedded 9004 новые EPYC Embedded 9005 не только быстрее за счёт перехода на Zen 5, но и за счёт большего количества процессорных ядер — по этому параметру новый модельный ряд соответствует обычным серверным моделям и заканчивается на отметке 192 ядра. При этом в нём имеются как процессоры с классическими кристаллами Zen 5, так и с энергоэффективными Zen 5c. Новые процессоры AMD сертифицированы для работы с Yocto Linux и с DPDK/SPDK, что делает их пригодными в качестве основы для сетевого оборудования, в том числе маршрутизаторов и систем безопасности. Обновления ПО для разработчиков планируется выпускать на ежеквартальной основе. На данный момент AMD уже поставляет образцы новых процессоров, а полномасштабные отгрузки новинок начнутся во II квартале. |

|