Материалы по тегу: периферийные вычисления

|

06.03.2026 [08:58], Руслан Авдеев

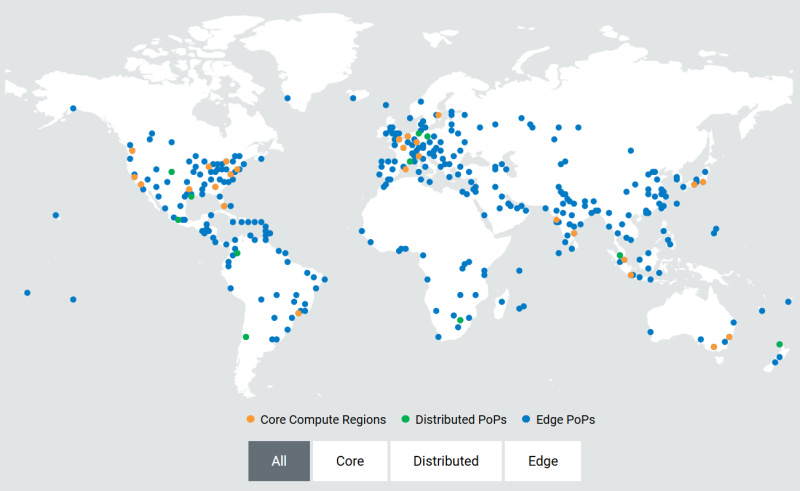

Akamai развернёт тысячи ускорителей NVIDIA RTX Blackwell для распределённого инференсаОблачный провайдер Akamai анонсировал покупку «тысяч» ИИ-ускорителей для развития своей распределённой облачной инфраструктуры по всему миру. Развёртывание новых чипов позволит создать единую оптимизированную ИИ-платформу для быстрого и распределённого инференса в глобальной сети Akamai. По словам компании, она готовит базовую инфраструктуру для «физического» и «агентного» ИИ, где решения необходимо принимать в режиме реального времени. Ранее компания анонсировала проект Akamai Inference Cloud. Как заявляет Akamai, пока крупные облачные бизнесы расширяют проекты обучения ИИ, компания сосредоточилась на удовлетворении потребностей эпохи инференса. Централизованные ИИ-фабрики имеют важное значение для создания моделей, но для их масштабной эксплуатации необходима децентрализованная «нервная система». Внедрение NVIDIA Blackwell в распределённая инфраструктуру, как ожидается, позволит ИИ взаимодействовать с «физическим» миром на местах — с системами автономной доставки, умными энергосетями, роботами-хирургами, антифрод-системами т.п. — без географических и финансовых ограничений, характерных для классических облаков. Интеграция ускорителей Blackwell обеспечит:

Предоставляя инструментарий для выполнения задач ближе к конечным пользователям, Akamai обеспечивает высокую пропускную способность и, как утверждается, одновременно снижает задержку до 2,5 раз. Это позволит бизнесам экономить до 86 % на инференсе в сравнении с обычными облачными компаниями-гиперскейлерами. Платформа объединяет серверы на основе ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition с DPU NVIDIA BlueField-3 и распределённую облачную инфраструктуру Akamai с 4,4 тыс. точек присутствия. Cloudflare применяет платформу с «бессерверным» инференсом в более чем 200 городах. Её Workers AI обеспечивают глобальный инференс с задержкой менее 100 мс без специального выделения кластеров ускорителей. Fastly применяет платформу периферийных вычислений, но предлагает меньшее количество локальных точек присутствия (PoP) для выполнения задач на GPU/CPU.

04.03.2026 [23:30], Руслан Авдеев

Aikido объединила морские ветряки с модульными ИИ ЦОДАмериканская Aikido, поставщик плавучих ветрогенераторов, представила оффшорную ВЭУ-платформу, объединённую с модульным дата-центром, рассчитанным на ИИ-нагрузки, сообщает Datacenter Dynamics. Платформа включает ветряную турбину мощностью 15–18 МВт, способную обеспечить до 10–12 МВт IT-мощности. Непосредственно под стальной оболочкой платформы размещаются три вычислительных модуля мощностью 3–4 МВт каждый. Расчётный PUE — 1,08. Платформа также получит аккумуляторное энергохранилище для обеспечения стабильности работы IT-модулей. В компании рассчитывают на доступность вычислительных мощностей не менее 75 % рабочего времени. Потенциально этот показатель может быть увеличен до 90 % путём использования более ёмких аккумуляторных систем. За охлаждение отвечает система замкнутого цикла на основе пресной воды. Тепло через стальную структуру платформы передаётся окружающей морской воде. Компания уверяет, что тепловое воздействие будет ограниченным — в радиусе всего нескольих метров от платформы. Бизнес-модель Aikido сконцентрирована не на поставках энергии, а на прямой продаже вычислений. Для масштабирования выбран модульный подход, позволяющий собирать платформы до 10 раз быстрее, чем обычные прибрежные конструкции. Кроме того, компания сообщила, что аккумуляторы можно зарядить заранее, что ускорит ввод новых мощностей. На сборку прототипа у Aikido ушло менее недели. Помещения для IT-оборудования в ходе финального монтажа в порту были подключены к системам питания и охлаждения на набережной. Теперь компания работает в Норвегии над более функциональным модулем, призванным стать «доказательством концепции». Он должен заработать в 2026 году. Первый коммерческий проект планируется реализовать в Великобритании в 2028 году. Aikido, являющаяся участником программы NVIDIA Inception, заявила её решение уже вызвало интерес у потенциальных заказчиков. Впрочем, остаются некоторые опасения в связи с состоянием рынка оффшорных ветряных электростанций. Несмотря на предварительные многообещающие результаты, на нём наметилась стагнация из-за роста стоимости. По имеющимся данным, многие проекты сегодня попросту невыгодны без государственной поддержки, так что рынок замер в ожидании более ясных «сигналов». В частности, в США эта отрасль фактически лишилась поддержки. Впрочем, Aikido рассчитывает, что её новая бизнес-модель придать новый импульс сегменту плавучих электростанций. В компании заявляют, что комбинация проверенных прибрежных ветряных энергосистем и вычислений высокой плотности позволит создать новый класс инфраструктуры, где генерация энергии, системы охлаждения и вычислительные мощности размещены в одном месте.

28.02.2026 [09:48], Сергей Карасёв

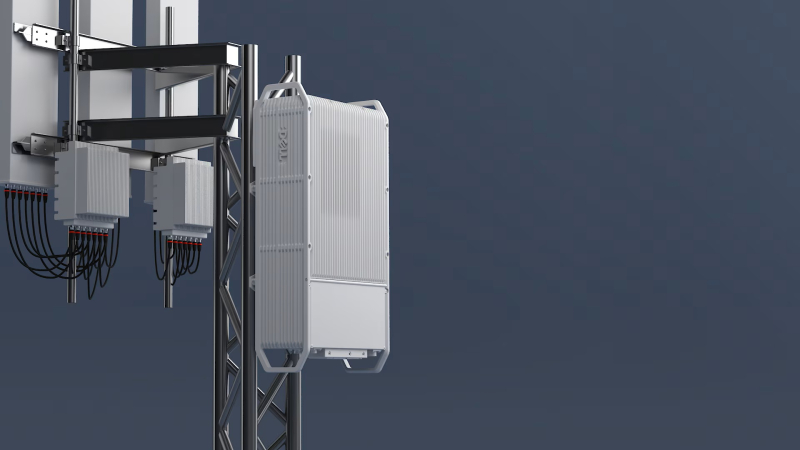

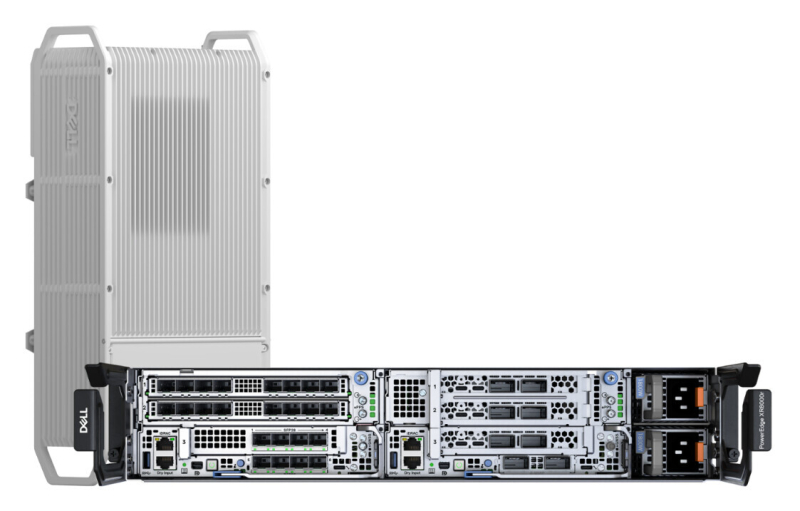

Dell представила подвесной уличный сервер PowerEdge XR9700 с замкнутой СЖОDell анонсировала сервер PowerEdge XR9700, предназначенный для инфраструктур Cloud RAN и ИИ-приложений на периферии. Устройство рассчитано на эксплуатацию в неблагоприятных условиях, в том числе на открытом воздухе: оно может монтироваться на опорах линий электропередач, крышах и фасадах зданий. Новинка заключена в корпус объёмом около 15 л. Говорится о сертификации IP66 и GR-3108 Class 4: серверу не страшны пыль, влага и воздействие прямого солнечного излучения. Диапазон рабочих температур простирается от -40 до +46 °C. В основу PowerEdge XR9700 положена аппаратная платформа Intel Xeon 6 SoC — Granite Rapids-D (до 72 P-ядер, TDP до 325 Вт). Также возможна установка ИИ-ускорителей и различных сетевых карт, в том числе для обработки L1-трафика. Задействована система жидкостного охлаждения с замкнутым контуром, а ребристая внешняя поверхность работает в качестве радиатора. Без СЖО с таким уровнем тепловыделения CPU/GPU и в таком компактном корпусе уже вряд ли можно обойтись. Отмечается, что с технической точки зрения устройство идентично модели PowerEdge XR8720t, которая дебютировала в октябре прошлого года. В зависимости от конфигурации это решения располагает четырьмя или восемью слотами для модулей DDR5. Возможна установка до трёх SSD формата M.2 (NVMe). В оснащение могут входить два порта 100GbE QSFP и восемь портов 10/25GbE SFP. Реализованы интерфейсы USB 3.0 Type-A, UCB Type-C, Mini-DisplayPort и пр. Заявлена поддержка Wind River SUSE Linux Enterprise Server/RT, Ubuntu Server LTS и Red Hat Enterprise Linux/RT. Интегрированный контроллер удалённого доступа Dell (iDRAC) обеспечивает мониторинг и управление. Говорится о совместимости с существующим набором решений для периферийных вычислений в области телекоммуникаций. В продажу PowerEdge XR9700 поступит во II половине текущего года.

25.02.2026 [17:31], Владимир Мироненко

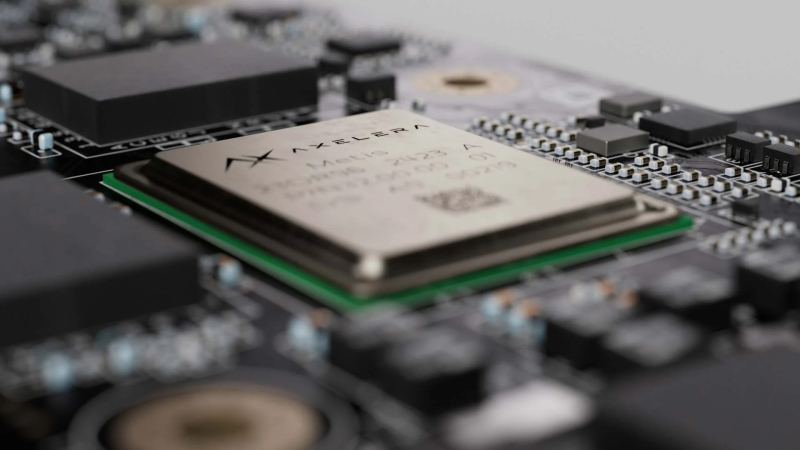

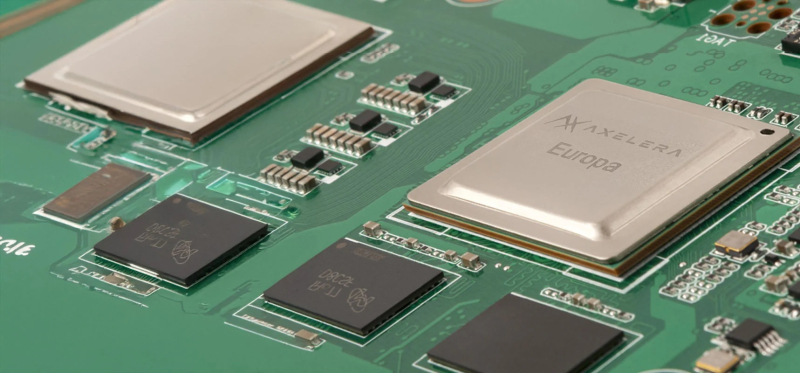

Axelera AI привлекла $250 млн для разработки европейских ИИ-чиповПроизводитель ИИ-чипов Axelera AI из Эйндховена (Нидерланды) привлёк $250 млн в рамках раунда финансирования, который возглавил европейский венчурный фонд Innovation Industries. Наряду с имеющимися инвесторами в нём также приняли участие BlackRock и SiteGround Capital в качестве новых инвесторов. Это одна из крупнейших инвестиций на сегодняшний день в европейскую компанию по производству ИИ-чипов, отметило агентство Reuters. Генеральный директор Фабрицио Дель Маффео (Fabrizio Del Maffeo) указал в своём заявлении, что компания использует привлечённые средства для расширения производства своего чипа Europa, запуск которого запланирован до июня, а также для дальнейшей разработки ПО, упрощающего использование чипов для клиентов. У Axelera «большой портфель возможностей, требующих инвестиций, и этот портфель растет», — заявил Фабрицио Дель Маффео в интервью Bloomberg. По его словам, клиенты ищут более доступные вычислительные ресурсы, более высокую эффективность и способы сокращения расходов на дорогостоящую ИИ-инфраструктуру. Дель Маффео сообщил, что инференс может осуществляться на децентрализованной архитектуре, которая потребляет меньше энергии. Большие потребности крупных ЦОД в энергии, необходимой для обеспечения вычислительных мощностей для обучения ИИ-моделей, подвергаются критике на фоне опасений по поводу перегрузки электросетей и резкого роста цен на электроэнергию для потребителей, отметил Bloomberg. С момента основания в июле 2021 года Axelera AI привлекла более $450 млн в виде акционерного капитала, грантов и венчурного кредитования. В частности, в марте 2025 года Axelera получила грант в размере €61,6 млн ($66 млн) от EuroHPC JU в рамках проекта Digital Autonomy with RISC-V for Europe (DARE) по разработке передового чипа Titania для использования в так называемых ИИ-фабриках. Ожидается, что этот чип появится в 2027 году. Компания отметила, что финансовый раунд прошёл в тот момент, когда она начала поставки своему 500-му глобальному клиенту в области физического и периферийного ИИ в таких отраслях, как оборона и общественная безопасность, промышленное производство, розничная торговля, агротехнологии, робототехника и безопасность. По словам Axelera AI, её клиентская база за последний год увеличилась более чем втрое.

17.02.2026 [11:48], Руслан Авдеев

Прогноз — мультиоблачно: Policliud развернёт тысячу суверенных микро-ЦОД за пять летОблачный стартап Policliud из Франции поделился планом развернуть сотни периферийных суверенных дата-центров в следующие пять лет, сообщает Datacenter Dynamics. В ходе мероприятия World AI Cannes Festival 2026 компания объявила о намерении построить около 1 тыс. микро-ЦОД к концу 2030 года с использованием более 250 тыс. ИИ-ускорителей. Компания специализируется на малых «суверенных» проектах дата-центров, но на текущий момент ввела в эксплуатацию лишь восемь из них — во Франции, в странах, входящих в Совет сотрудничества арабских государств Персидского залива (GCC) и США. По данным компании, фактически речь идёт о контрактах на сумму около €10,5 млн ($12,44 млн) и использовании 1,2 тыс. ИИ-ускорителей. В 2026 году Policloud намерена ввести в эксплуатацию 100 ЦОД в 2026 году с суммарно более чем 25 тыс. ИИ-ускорителей. Компания применяет модульные микро-ЦОД без водяного охлаждения, расположенные как можно ближе к источнику данных. Это контейнерные дата-центры, вмещающие до 400 ускорителей на каждый модуль, площадью до 100 м2 и мощностью до 500 кВт. ЦОД используют распределённую облачную платформу Hivenet. Детали об используемых ИИ-ускорителях и вспомогательном оборудовании пока не раскрываются.

Источник изображения: Policloud Компания основана Дэвидом Гурле (David Gurlé), бывшим топ-менеджером Microsoft и основателем коммуникационной платформу Symphony для бизнеса со сквозным шифрованием трафика. В июне 2025 года Policloud привлекла €7,5 млн ($8,8 млн) в ходе начального раунда финансирования, возглавленного Global Ventures. В нём также приняли участие MI8 Limited, OneRagtime и Национальный институт исследований в области цифровых наук и технологий Франции (INRIA), а также частные инвесторы.

13.02.2026 [13:18], Руслан Авдеев

ECL представила всеядную энергетическую архитектуру для периферийных ИИ ЦОДКомпанией ECL (EdgeCloudLink) анонсирована платформа FlexGrid. Речь идёт об энергетической архитектуре, позволяющей развёртывать ИИ ЦОД высокой плотности в локациях с ограниченными возможностями питания. Решение предлагается как способ масштабирования инфраструктуры инференса за пределы крупных кампусов, в которых осуществляется обучение ИИ-моделей — в городские агломерации, периферийные локации и промзоны, где зачастую доступно не более 50–100 МВт, сообщает Converge Digest. FlexGrid обеспечивает модульное развёртывание на площадках мощностью от 2–10 МВт с возможностью масштабировать подключение до 20–25 МВт на объект с помощью интеграции дополнительных, локальных источников энергии различного происхождения. Основа платформы — патентованная система управления питанием ECL, позволяющая объединять несколько источников энергии, включая классические электросети, водородные топливные элементы, генераторы на природном газе, возобновляемые источники и дизельные генераторы. В результате обеспечивается унифицированная подача постоянного или переменного тока. В отличие от традиционных дата-центров, в норме использующих один тип источников энергии, FlexGrid позволяет менять источники энергии или добавлять к ним новые без изменения базовой энергетической инфраструктуры объектов.

Источник изображения: ECL ECL утверждает, что это позволяет оперативно реагировать на региональные энергетические ограничения, изменения политики энергоснабжения на местах и дефицит топлива, при этом сохраняя стабильное качество электропитания ИИ-инфраструктуры. ECL подчёркивает, что FlexGrid разработана для «нормализации» подачи энергии из любых локальных источников и надёжного энергоснабжения ИИ-объектов в условиях ограничений сетевой энергоинфраструктуры. Пока конкуренты стремятся обеспечить себе мощности от 50 МВт для обучения, ECL работает на обозримую перспективу, делая ставку на периферийные объекты, где жизненно важным становится возможность агрегации и управления питанием таким образом, чтобы обеспечить гибкий выбор площадок и быстрый ввод объектов в эксплуатацию. Летом 2026 года сообщалось, что ECL напечатала свой первый модульный дата-центр, работающий от водородных элементов питания. В сентябре того же года появилась информация, что компаняи построит гигантский «зелёный» ЦОД TerraSite-TX1, а первым арендатором станет ИИ-облако Lambda. Годом позже вышла новость о том, что Lambda и ECL впервые запитали NVIDIA GB300 NVL72 от водорода, но теперь стартап перешёл к более универсальным решениям.

29.01.2026 [18:20], Руслан Авдеев

ИИ и облака вместо телефонов: Telefónica превратит десятки «медных» АТС в периферийные ЦОДИспанский оператор связи и ЦОД Telefónica ускоряет реализацию стратегии расширения периферийных вычислений. Для этого компания переоборудует ненужные более телефонные АТС с медными компонентами в мини-ЦОД на 1–2 МВт. Среднесрочная цель — развернуть в стране более 100 таких узлов, сообщает Datacenter Dynamics. После полного отключения аналоговой телефонной связи в Испании большое количество АТС с медными кабельными системами осталось без дела, поэтому Telefónica España начала переделывать их в распределённые периферийные ЦОД небольшой мощности. Новые ЦОД ориентированы на предоставление ИИ и облачных сервисов с низкой задержкой — они находятся вблизи от конечных потребителей и призваны укрепить цифровой суверенитет страны. На сегодня уже эксплуатируется 12 подобных узлов, коммерческие услуги компания намерена начать предоставлять после завершения тестовой фазы. На горизонте 5–7 лет планируется развернуть более 100 таких дата-центров. Вторую жизнь получит и сеть связанных электростанций. Новые edge-узлы интегрируют с ВОЛС и 5G-сетями. Новый план — часть общеевропейского проекта развития периферийных вычислений, в его рамках Telefónica выделена субсидия в размере €93 млн ($111 млн). Компания дополнила её собственными средствами, хотя объёмы инвестиций не раскрываются. Также в европейском проекте участвуют телеком-операторы Orange, Deutsche Telekom и Telecom Italia.

Источник изображения: Telefonica К концу 2026 года Telefónica рассчитывает запустить ещё 17 периферийных узлов, дополняя свои лидирующие позиции в сегментах FTTH — на её долю приходится более 31 млн подключенных домохозяйств — и 5G, это способствует цифровой трансформации в стране. Telefónica отмечает, что её т.н. Edge Plan выводит Испанию на передний край инноваций в Европе в контексте обеспечения технологического суверенитета, позволяя создавать местную инфраструктуру без помощи «неевропейских» вендоров. Периферийная архитектура комбинирует эластичность облака с возможностью обработки данных в непосредственной близости от их источника. Это минимизирует задержки и в то же время обеспечивает соответствие сопутствующих процессов европейским правовым нормам. Стремление обрести технологический суверенитет, в первую очередь от США, в последнее время стало ключевым вектором деятельности для многих европейских компаний и политиков. Так, Франция в январе 2025 года объявила, что местных госслужащих переведут с Zoom и Teams на суверенный видеочат Visio. Суверенные решения предлагают европейцам и европейские компании вроде SAP, а вот техногиганты из США не пользуются былой популярностью — не так давно Microsoft признала что не может обеспечить настоящий суверенитет европейских данных, поскольку вынуждена подчиняться в первую очередь законам США.

27.01.2026 [13:59], Руслан Авдеев

ИИ-облако в круизе: платформа Oracle RED прокатилась на борту авианосца «Принц Уэльский»Британские ВМС используют периферийную инфраструктуру Oracle Cloud для управления оборонными ИИ-системами на борту авианосца «Принц Уэльский», сообщает The Register. Oracle отметила, что флот применил «суверенные ИИ-возможности» в рамках операции Highmast — миссии, продлившейся восемь месяцев в 2025 году, в рамках которой корабль побывал в Средиземноморье, на Ближнем Востоке и в Индо-Тихоокеанском регионе. Управление ИИ осуществлялось с помощью Oracle Roving Edge Infrastructure (RED) — локальной версии облачной платформы компании, работающей на оборудовании в защищённом корпусе «военного» уровня. Roving Edge представили в 2021 году, заявив, что она позволяет клиентам выполнять различные рабочие задачи, включая машинное обучение и аналитику, в полевых условиях. Собственно ИИ-платформу разработала компания Whitespace из Белфаста, её решение Saga создано для того, чтобы ускорить сбор, управление и использование военными организациями «институциональных» знаний. По данным Whitespace, Saga позволяет экипажам кораблей ВМС закреплять полученные сведения, анализировать данные миссий и получать доступ к ИИ-поддержке.

Источник изображения: Wikimedia Commons По данным Oracle, платформа позволяет авианосцу применять ИИ для поддержки принятия решений и оперативного обучения — получаемые в ходе миссии данные превращаются в практически применимый материал. Использование ИИ-решений в операциях британских ВМС считается в руководстве страны критически важным для её оборонных возможностей. Похожие эксперименты проводятся и другими странами. Так, ещё летом 2024 года ВМС США успешно подключили к облаку авианосец «Авраам Линкольн». Впрочем, как напоминает The Register, на деле нередко выясняется, что на проверку принятых ИИ решений требуется не меньше человеко-часов, чем было сэкономлено за счёт его использования. Более того, ИИ-системы часто страдают «галлюцинациями», что в военных операциях совершенно недопустимо. При этом собственный портал поддержки Oracle после получения интегрированных ИИ-инструментов стал только хуже, говорят клиенты компании. Oracle делает большую ставку на ИИ, тратя миллиарды долларов на инвестиции в дата-центры, чтобы привлечь разработчиков и корпоративных клиентов, в то же время залезая в огромные долги и страдая от судебных разбирательств. Тем временем ПО компании, не только связанное с оборонными проектами, вызывает большие вопросы. Недавно сообщалось, что перезапуск печально известной ERP-системы Oracle Fusion в Бирмингеме вновь отложили.

16.12.2025 [17:50], Владимир Мироненко

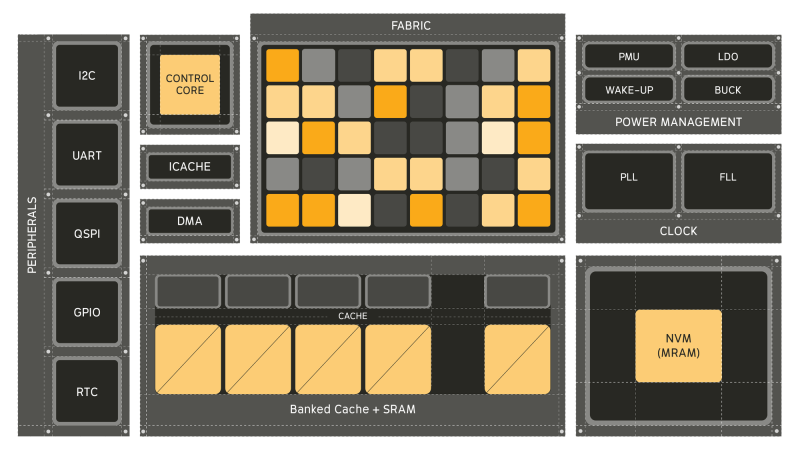

Универсальный ИИ-процессор Electron E1 в 100 раз энергоэффективнее традиционных CPUСтартап из Питтсбурга (Pittsburgh) Efficient Computer выпустил оценочный набор универсального процессора Electron E1 (EVK). Как сообщает компания, Electron E1 представляет собой настоящую альтернативу чипам с использованием традиционной архитектуры фон Неймана, способную обеспечить значительно более высокую энергоэффективность, в 100 раз превышающую показатели обычных маломощных процессоров, таких как Arm Cortex-M33 и Cortex-M85. Electron E1 предназначен для выполнения сложных задач обработки сигналов и инференса. Он основан на т.н. Efficient Fabric, разработанной компанией запатентованной архитектуре пространственного потока данных, которая позволяет снизить «чрезмерное» энергопотребление, связанное с перемещением данных между памятью и вычислительными ядрами, характерное для традиционных систем фон Неймана. При этом «разработчики по-прежнему получают привычный опыт программирования, но с существенно более высокой энергоэффективностью». Генеральный директор Efficient Брэндон Лючия (Brandon Lucia) в интервью EE Times заявил, что предыдущие попытки отойти от подхода фон Неймана так и не были полностью реализованы: «Были мимолётные альтернативы, которые появлялись и исчезали». Он отметил, что одним из ограничений во многих альтернативах был отказ от универсальности вычислений: «Это действительно критически важно». Нечто похожее предлагает и NextSilicon Maverick. Процессор включает 128 Кбайт сверхэкономичной кеш-памяти, 3 Мбайт SRAM и 4 Мбайт энергонезависимой MRAM, а его производительность может достигать 21,6 GOPS (млрд операций в секунду) при 200 МГц в высоковольтном режиме и 5,4 GOPS при 50 МГц в низковольтном режиме. Архитектура Fabric коренным образом переосмысливает способ выполнения вычислений, уменьшая необходимость в перераспределении данных между памятью и процессорами, говорит Лючия. Это достигается за счёт пространственного отображения операций по сетке вычислительных элементов, каждый из которых активируется только тогда, когда доступны его входные данные в отличие от непрерывного цикла инструкций и косвенной адресации данных, которые доминируют в традиционных конвейерах CPU. Лючия отметил, что универсальный процессор важен для ИИ-технологий, поскольку он представляет собой нечто гораздо большее, чем просто алгоритмы в физическом мире — он обеспечивает, в том числе, интеграцию данных с датчиков, цифровую обработку сигналов, шифрование и преобразование: «Если ваша архитектура специализируется только на одном типе вычислений, все остальные функции остаются невостребованными». По словам главы Efficient, Electron E1 разработан для поддержки всего кода, необходимого для работы приложения, что делает его идеальным для периферийных вычислений, встроенных систем и ИИ-приложений: «Разработчики могут использовать уже имеющийся у них код». Лючия отметил, что процессор лучше всего подходит для устройств, требующих длительного времени автономной работы, а также условий ограниченного энергопотребления, например, для использования в дронах и промышленных датчиках. Чип уже используется в устройствах партнёра Efficient, компании BrightAI, позволяя обрабатывать ИИ-нагрузки в реальном времени на периферии и снижая потребность в энергоемких облачных вычислениях для таких задач, как обработка сигналов и инференс. Лючия сообщил, что компания видит большие перспективы для использования чипа в робототехнике, автомобилестроении, космосе и оборонных приложениях, которые имеют ограничения по размерам и мощности. Что касается E1 EVK, то он, по словам компании, разработан для того, чтобы максимально упростить изучение потенциала нового процессора. Независимо от того, разрабатываете ли вы новое ПО, проводите анализ энергопотребления или портируете существующее ПО, EVK предоставляет:

В случае отсутствия оборудования можно использовать решение Electron E1 Cloud EVK, которое предоставляет размещённую среду со всеми возможностями физической платы. Как физический EVK, так и облачный EVK доступны в рамках программы раннего доступа Efficient Computer.

10.12.2025 [10:42], Сергей Карасёв

«Гравитон» выпустил Edge-сервер С2062И на платформе «Тундра» с чипами Intel Xeon Cascade Lake-SPРоссийский производитель вычислительной техники «Гравитон» сообщил о доступности сервера С2062И семейства Edge, предназначенного для решения различных задач на периферии. Устройство, в частности, подходит для создания систем обеспечения безопасности, IoT-платформ, телекоммуникационных решений и пр. Сервер, о подготовке которого впервые сообщалось ещё в 2024 году, выполнен в форм-факторе 2U на платформе «Тундра»: задействована материнская плата собственной разработки типоразмера E-ATX на наборе логики Intel C621. Допускается установка двух процессоров Intel Xeon поколения Cascade Lake-SP в исполнении LGA 3647. Доступны 16 слотов для модулей оперативной памяти DDR4 суммарным объёмом до 2 Тбайт. Устройство оснащено пятью слотами PCIe 3.0 х16 и одним разъёмом PCIe 3.0 x8.

Источник изображений: «Гравитон» Во фронтальной части располагаются шесть отсеков для SFF-накопителей SATA/SAS с возможностью горячей замены. Есть контроллер Aspeed AST2500, четыре сетевых порта 1GbE и выделенный сетевой порт управления 1GbE. На лицевой панели, помимо пяти гнёзд RJ45, находятся четыре порта USB 3.0, аналоговый интерфейс D-Sub и последовательный порт.  Сервер оборудован съёмной передней панелью с противопылевым фильтром. Установлены два блока питания с резервированием мощностью 800 Вт. Устройство оптимизировано для работы в условиях ограниченного пространства. Говорится о совместимости с различными отечественными операционными системами, включая RedOS, «Альт Линукс», Astra Linux и др. Модель С2062И внесена в реестр Минпромторга России. |

|