Материалы по тегу: охлаждение

|

04.02.2026 [12:11], Руслан Авдеев

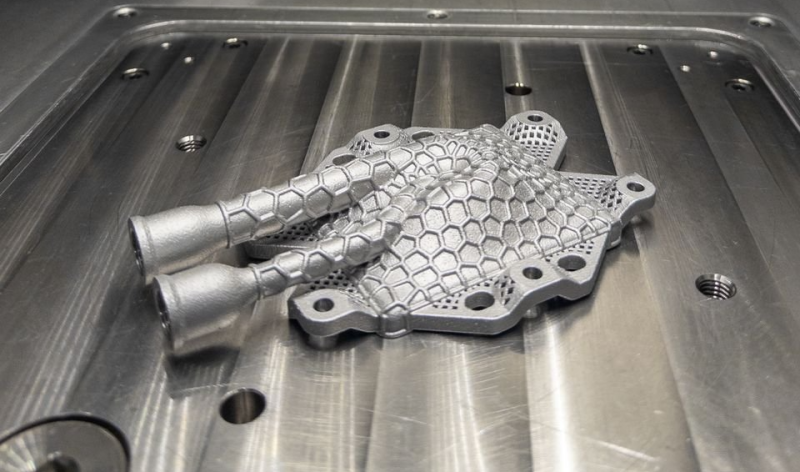

Датские исследователи напечатали в 3D испарительную камеру для пассивной двухфазной СЖОГруппа учёных создала один из ключевых компонентов системы жидкостного охлаждения (СЖО) дата-центров с использованием 3D-печати. В проекте приняли участие исследователи и специалисты практики из Дании, Бельгии и Германии, сообщает Datacenter Dynamics. Датский технологический институт (Danish Technological Institute) совместно с компанией Heatflow (Дания), бельгийской Open Engineering и занимающимся прикладными исследованиями немецким институтом Fraunhofer IWU разработали, напечатали на 3D-принтере и протестировали компонент системы охлаждения для дата-центров и высокопроизводительных компьютеров. В новом решении охлаждающая жидкость испаряется на горячей поверхности. Пар, отводя тепло, поднимается, а потом конденсируется и под действием силы тяжести возвращается к источнику тепла. Ключевой компонент — испарительная камера — изготовлена с помощью 3D-печати компанией Heatflow и Датским технологическим институтом. в ходе испытаний достигнута мощность охлаждения 600 Вт, это на 50 % больше, чем планировалось (400 Вт). Насосы этим элементом системы не используются, что снижает энергопотребление.

Источник изображения: Danish Research Institute Как заявили представители Датского технологического института, благодаря 3D-печати можно интегрировать необходимые функции в единую деталь. Благодаря этому отпадает надобность в узлах соединения, снижается риск протечек и повышается надёжность компонента. Кроме того, используется только один материал, поэтому переработка упрощается. Проект — часть европейской исследовательской инициативы AM2PC. Он поддерживается европейской сетью M-ERA.NET за счёт средств гранта Датского инновационного фонда (Danish Innovation Fund). Основной задачей проекта была разработка и производство испарительной камеры, а также проверка его рабочих характеристик. По словам Heatflow, наблюдается тенденция к беспрецедентному росту удельной мощности серверов, поэтому классического воздушного охлаждения уже недостаточно, а новое двухфазное решение позволяет пассивно отводить тепло без использования насосов и вентиляторов, это значительно снижает энергопотребление.

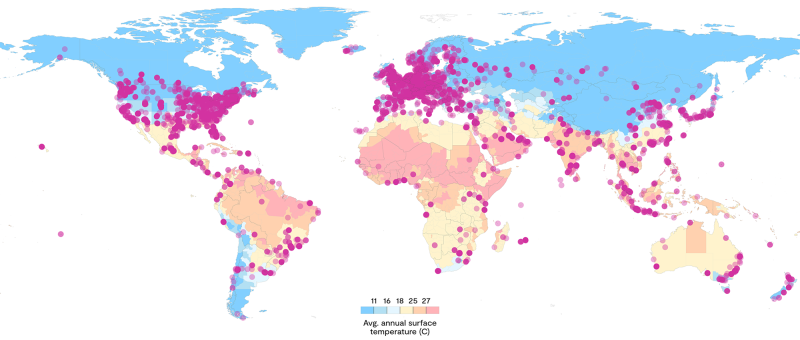

Источник изображения: Danish Research Institute Основанная в 2018 году Heatflow является поставщиком систем охлаждения для электроники. Компания специализируется на двухфазном охлаждении. Испарительная камера изготовлена благодаря лазерному спеканию порошковых слоёв (PBF-LB). При этом методе лазер используется для формирования металлических заготовок. Решение отводит тепло при температурах 60–80 °C и потенциально применимо в системах централизованного теплоснабжения, применяющих отработанное тепло дата-центров. Учёные подчёркивают, что не уделяли особого внимания интеграциям с системами центрального отопления, но наглядно продемонстрировали, что подобная технология обеспечивает такую возможность. Утверждается, что речь идёт о важном шаге на пути создания более энергоэффективных дата-центров, способных внести позитивный вклад в общий энергетический баланс. Развитие технологий охлаждения особенно важно, поскольку, по данным исследования Rest of World, около 80 % всех дата-центров мира построены в неподходящих климатических условиях, речь идёт о почти 7 тыс. объектов.

02.02.2026 [23:44], Андрей Крупин

Экология в приоритете: проект энергоэффективного ЦОД МТС получил прописку в федеральном реестре углеродных единицКомпания «Мобильные ТелеСистемы» сообщила о регистрации проекта «Строительство ЦОД с энергоэффективной системой охлаждения на площадке ПАО "МТС"» в российском национальном реестре углеродных единиц. Проект энергоэффективного дата-центра реализован МТС на территории модульного ЦОД в Тосненском районе Ленинградской области. В основе проектного решения лежит использование энергоэффективной адиабатической системы охлаждения для сокращения показателей удельного потребления энергоресурсов на единицу произведённого холода. Ожидается, что в перспективе до 2032 года проект позволит сократить выбросы парниковых газов совокупным объёмом 1375 тонн СО2-эквивалента. «Ленинградский модульный ЦОД МТС — первый климатический проект в российской телеком-отрасли. Согласно углеродной стратегии, наша цель — снижение углеродоемкости на 60 % к 2030 году по сравнению с 2021 годом, и мы рассчитываем, что тиражирование строительства современных ЦОД повысит энергоэффективность компании за счёт снижения потребления электроэнергии. Регистрация проекта в реестре — важный шаг к достижению стратегических задач МТС в области управления выбросами парниковых газов и углеродного менеджмента», — говорится в заявлении оператора.

24.01.2026 [14:15], Сергей Карасёв

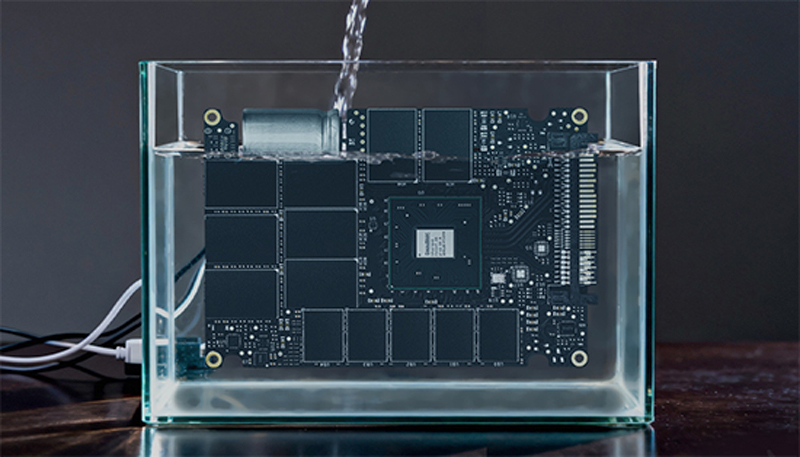

Nokia и Hypertec построили в Канаде 15-Пфлопс суперкомпьютер Nibi с погружным охлаждением

amd

emerald rapids

granite rapids

h100

hardware

hpc

intel

mi300

nokia

nvidia

ии

канада

отопление

погружное охлаждение

суперкомпьютер

Компании Nokia и Hypertec объявили о запуске суперкомпьютера Nibi, смонтированного в Университете Ватерлоо (University of Waterloo) в Канаде. Эта НРС-платформа будет использоваться для решения широкого спектра задач, в том числе в области ИИ. Проект Nibi финансируется канадским Министерством инноваций, науки и экономического развития через Канадский альянс цифровых исследований, а также Министерством колледжей, университетов, научных исследований и безопасности через некоммерческую организацию Compute Ontario. Система насчитывает в общей сложности более 750 вычислительных узлов. Это, в частности, 700 узлов CPU, каждый из которых несёт на борту два процессора Intel Xeon 6972P поколения Granite Rapids-AP (96C/192T, до 3,9 ГГц) и 748 Гбайт оперативной памяти. Кроме того, задействованы 10 узлов с двумя чипами Xeon 6972P и 6 Тбайт памяти каждый. В состав суперкомпьютера также входят 36 узлов GPU, которые содержат по два процессора Intel Xeon Platinum 8570 серии Emerald Rapids (56C/112T, до 4 ГГц), 2 Тбайт оперативной памяти и восемь ускорителей NVIDIA H100 SXM (80 GB), связанных посредством NVLink. Наконец, Nibi оперирует шестью узлами с четырьмя ускорителями AMD Instinct MI300A. Подсистема хранения VAST Data выполнена на основе SSD суммарной вместимостью 25 Пбайт. Пропускная способность каналов передачи данных между CPU- и GPU-узлами составляет 200 Гбит/с. Подключение к хранилищу обеспечивается благодаря 24 линиям на 100 Гбит/с. Заявленная пиковая производительность Nibi достигает 15 Пфлопс. Новая НРС-платформа оборудована высокоэффективной системой погружного жидкостного охлаждения. Сгенерированное тепло используется для обогрева центра квантовых и нанотехнологий имени Майка и Офелии Лазаридис (Mike and Ophelia Lazaridis Quantum-Nano Centre).

22.01.2026 [09:07], Руслан Авдеев

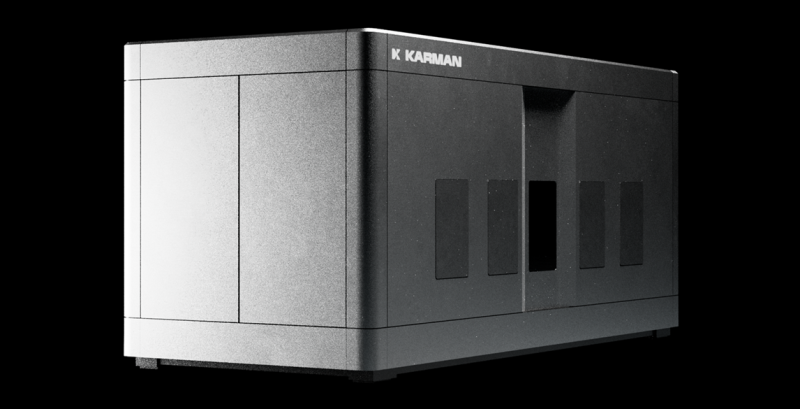

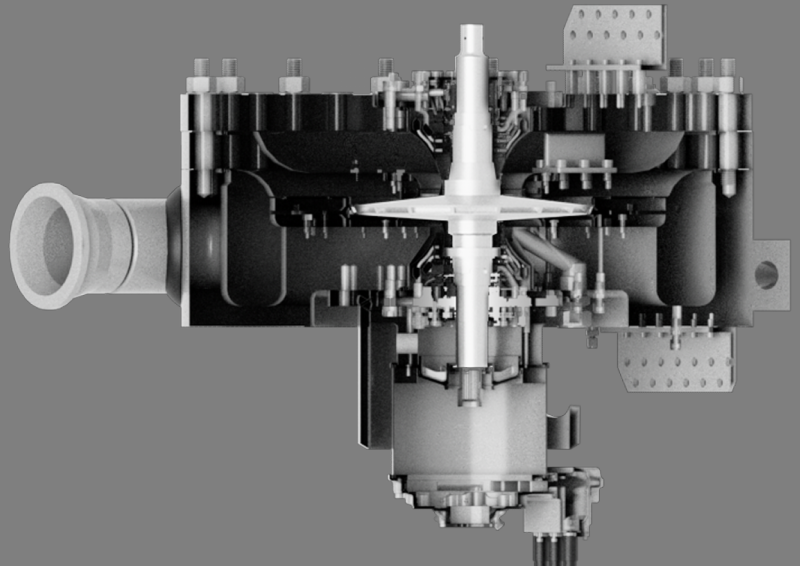

Karman Industries представила систему охлаждения ИИ ЦОД с углекислым газомKarman Industries представила установку HPU (heat processing unit), которая, как утверждается, способна охлаждать дата-центры и перерабатывать «мусорное» тепло, сообщает Datacenter Dynamics. Модульная охладительная система на 10 МВт, использующая CO2, позволяет организовать инфраструктуру в HPU-блоках высокой «плотности». В частности, HPU в ИИ ЦОД может отбирать избыточное тепло кластеров и отдавать на выходе теплоноситель с температурой менее 30 °C, всё это без необходимости использования больших объёмов воды. Если окружающий воздух холодный, HPU способны перерабатывать «мусорное» тепло в электричество или, например, нагревать теплоноситель до температур, достаточных для систем центрального отопления. Охлаждение с помощью CO2 работает в целом по тому же принципу, что и традиционная система воздушного охлаждения, говорит компания, за тем исключением, что в качестве хладагента используются углекислота. Считается, что CO2 безвреднее для атмосферы, чем фреоны и т.п. вещества. Система Karman Industries использует фирменную технологию Kompressor, которая, как утверждается, может сэкономить немало пространства в сравнении с традиционными системами воздушного охлаждения — экономия занимаемой модулем охлаждения площади составляет до 80 %. HPU разрабатывались для утилизации выделяемого тепла и улучшения PUE ИИ ЦОД без применения PFAS-химикатов и больших объёмов питьевой воды. HPU используют питание 800 В DC (HVDC), 3D-печать металлами, высокоскоростные двигатели и силовую электронику на карбиде кремния. Karman привлекла $20 млн в раунде финансирования серии A, возглавленном Riot Ventures, а общий объём привлечённых средств составил более $30 млн. Среди прочих крупных участников Sunflower Capital, Space VC, Wonder Ventures, и бывший глава Intel и VMware Пэт Гэлсингер (Pat Gelsinger). Хотя клиенты компании не раскрываются, она сообщает, что поставки HPU начнутся в III квартале 2026 года. Karman имеет собственный завод GigaWerx в Лос-Анджелесе, способный выпускать HPU общей холодопроизводительностью до 1 ГВт/год с возможностью масштабирования до 4 ГВт/год. Как заявляет Karman Industries, время является самым ценным активом в гонке за увеличение потенциала ИИ. Сократив на 80 % площадь системы охлаждения, компания не просто позволяет экономить землю, но и даёт возможность избежать эффекта «снежного кома» с усложнением инфраструктуры. Это позволит гиперскейлерам реализовать проекты на много месяцев быстрее при масштабировании своей инфраструктуры.

31.12.2025 [12:02], Сергей Карасёв

DapuStor и ZTE внедряют в дата-центрах SSD с иммерсионным охлаждениемКомпания DapuStor объявила об успешном внедрении в серверной инфраструктуре ZTE систем хранения данных на основе SSD с иммерсионным (погружным) жидкостным охлаждением. Применённые накопители семейства DapuStor J5, как утверждается, продемонстрировали исключительную стабильность и надёжность при непрерывных нагрузках чтения/записи. Отмечается, что на фоне стремительного развития ИИ быстро растёт нагрузка на ЦОД — это приводит к увеличению энергопотребления. В результате, возможностей традиционного воздушного охлаждения становится недостаточно, в связи с чем гиперскейлеры и облачные провайдеры внедряют передовые жидкостные решения, в том числе иммерсионные системы. Однако существуют риски: хотя погружное охлаждение обеспечивает эффективный отвод тепла, оно предъявляет дополнительные требования к оборудованию. Длительное нахождение в диэлектрической жидкости может провоцировать химическую эрозию и ускорение старения из-за проникновения состава в микроскопические структурные зазоры электронных компонентов. В случае SSD это чревато системными сбоями. Поэтому для достижения долгосрочной надёжности необходима комплексная адаптация устройств хранения с точки зрения базовых материалов, конструкции и производственных процессов.

Источник изображения: DapuStor Накопители DapuStor J5, оптимизированные для иммерсионного охлаждения, разработаны специально с прицелом на эксплуатацию в экстремальных условиях. Все используемые материалы прошли тщательную проверку, исключающую ухудшение характеристик после длительного контакта с охлаждающей жидкостью. Гарантированы целостность сигнала и долговременная стабильность, говорят компании. Заявленная скорость последовательного чтения и записи данных достигает соответственно 7,4 и 7,0 Гбайт/с. Показатель IOPS при произвольном чтении составляет до 1,75 млн, при произвольной записи — до 340 тыс. Задержка — 67/9 мкс. Отмечается, что при использовании иммерсионного охлаждения средний годовой показатель PUE составляет менее 1,15 против 1,4–1,6 при традиционном воздушном охлаждении, что соответствует снижению на 15–28 %. Плотность мощности в расчёте на стойку возрастает на порядок — с 3–5 кВт до 48 кВт.

29.12.2025 [10:03], Руслан Авдеев

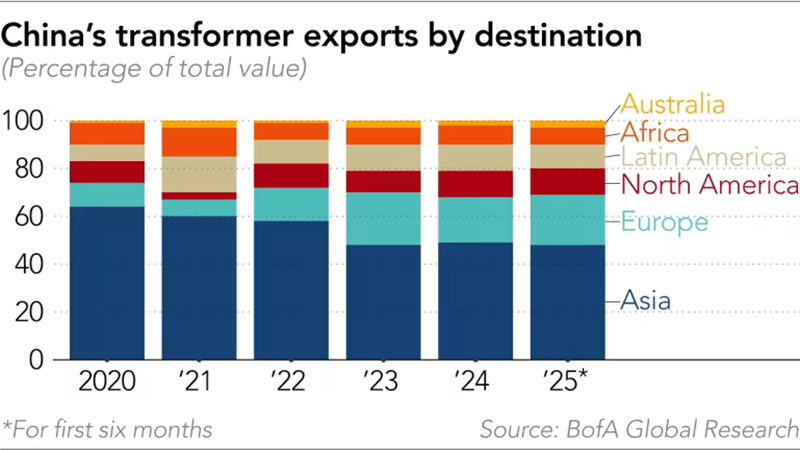

Китайские поставщики заработают на буме ИИ несмотря на напряжённость в отношениях с ЗападомНесмотря на геополитическую напряжённость между Китаем и Западом, китайские поставщики оборудования для ИИ-проектов, от энергетических решений до систем охлаждения, переживают настоящий бум экспорта, сообщает Nikkei Asian Review. ИИ ЦОД потребляют намного больше энергии по сравнению с традиционными дата-центрами и требуют иных технологических решений, например, в области охлаждения. Для обслуживания таких ЦОД нередко нужна модернизация электросетей, поэтому инвестиции в эту сферу стали расти в США, Европе и на Ближнем Востоке с 2022 года. Однако энергооборудование остаётся дефицитным во всём мире. В модернизации электросетей ключевую роль играют трансформаторы. При этом, как сообщает Wood Mackenzie, в США 80 % силовых трансформаторов и 50 % распределительных трансформаторов импортируются в страну из-за рубежа. В 2025 году ожидается дефицит поставок в объёме 30 % и 10 % соответственно. На этом стремится заработать, например, китайская Sieyuan Electric, выпускающая электрооборудование. В прошлом году она создала в США дочернюю компанию для компенсации дефицита в стране трансформаторов. С начала 2025 года акции Sieyuan Electric выросли более чем вдвое, планируется SPO в Гонконге. Производство трансформаторов требует специального оборудования, приобретаемого буквально годами. Кроме того, организация нового производства потребует строительства нового завода и обучения рабочих, поэтому быстрое наращивание производства затруднительно. По данным китайской таможни, за первые 11 месяцев 2025 года экспорт трансформаторов из КНР достиг почти ¥58 млрд ($8,2 млрд), на 36,3 % больше, чем в тот же период 2024 года. На фоне бурного роста спроса за рубежом темпы роста экспорта производителей из КНР превысили рост на внутреннем рынке. Например, крупнейший в мире производитель трансформаторов (по совокупной мощности) Tebian Electric Apparatus нарастил стоимость международных контрактов в годовом исчислении на 65,91 %, на внутреннем рынке рост составил 14,08 %. По мнению экспертов, одним из главных преимуществ китайского бизнеса является скорость организации работ. Как сообщил Bank of America Securities, с момента получения заказа китайским поставщиком до получения готовой продукции проходит менее года, тогда как в США, Европе или Южной Корее речь может идти о двух-трёх годах. По словам экспертов, производство трансформаторов в КНР отличается высокой конкурентоспособностью, поскольку электротехническая листовая сталь раньше импортировалась, а теперь её производство полностью локализовано. Сообщается, что китайские экспортёры постоянно прилагают усилия по расширению бизнеса за рубежом, посколкьу в самой стране жёсткая конкуренция и относительно слабый внутренний рынок. Впрочем, мелкие игроки уровня Dishin с её 150 сотрудниками, вероятно, столкнутся с серьёзными проблемами — стандарты от страны к стране отличаются, что требует технических корректировок и местной сертификации. Кроме того, нужны налаженные каналы сбыта, поскольку трансформаторы обычно продают энергетическим компаниям и одного качества продукции для успеха бизнеса недостаточно. По оценкам UBS, капитальные затраты на ИИ в 2025 году достигнут $423 млрд и $571 млрд — в 2026 году. Ряд инвестиционных банков прогнозирует, что к 2030 году расходы на ИИ превысят $1 трлн. Ожидается, что американские гиперскейлеры, включая Google, Meta✴, Microsoft, Amazon и Oracle в этом году потратят от $350 млрд до $400 млрд, что будет способствовать росту строительства ЦОД и создаст дополнительную нагрузку на электросети. Для сравнения, в Китае, по прогнозам Bank of America, аналогичные капиталовложения в 2025 году составят ¥600–700 млрд ($85–$100 млрд), в основном благодаря правительству и местным крупным компаниям, а к 2030 году достигнут ¥2–¥2,5 трлн ($285–$356 млрд). Около трети этих средств направят на ИИ-инфраструктуру.

Источник изображения: BofA Global Research Системы хранения энергии (ESS) — ещё одна область, где Китай опережает конкурентов. Недавно JP Morgan сообщала, что глобальное развёртывание ИИ ЦОД увеличит спрос на подобные системы. Пока связанный с ИИ спрос на такие системы составляет лишь 2 % от мировых поставок, перспективы очень хорошие. За первые 10 месяцев текущего года поставки аккумуляторных ESS (BESS) выросли на 70 % год к году, во многом благодаря росту китайского экспорта на ключевые рынки на 61 %. JP Morgan прогнозирует рост поставок на 80 % в 2025 году и на 30 % в 2026 году. Дефицит предложения может привести к росту цен. В Bank of America заявляют, что LG также наращивает производственные мощности для энергохранилищ, но темпы роста отстают от реального роста спроса, поэтому заинтересованным сторонам в основном приходится импортировать продукцию из Китая. На мировом рынке аккумуляторов доминируют китайские CATL, EVE Energy и BYD и др. Также, по словам экспертов из Nomura, хотя дефицит сетевых компонентов ожидается до 2026 года из-за высокого спроса и роста технических барьеров, сетевое оборудование для ИИ, включая коммутаторы, маршрутизаторы, оптические и медные кабели и др. станут всё более важными для развёртывания ЦОД. Это может сыграть на руку ведущим поставщикам — вырастет цена и увеличится маржа на мировом рынке. В Bank of America также ожидают роста экспорта из Китая оборудования для охлаждения ИИ-инфраструктуры. В Юго-Восточной Азии, где бурный рост строительства ЦОД стимулирует спрос на компоненты, включая CDU и быстроразъёмные соединения (UQD), по-прежнему доминируют некитайские бренды. Тем не менее, китайские поставщики играют важную роль в обеспечении трубопроводов и коллекторов. По мнению экспертов, поскольку китайские IT-компании всё чаще строят ИИ ЦОД в Юго-Восточной Азии из-за ограничений на экспорт передовых чипов в КНР и высоких цен на электричество в китайских мегаполисах, ожидается, что у китайских производителей охлаждающего оборудования появится больше экспортных возможностей.

23.12.2025 [12:28], Сергей Карасёв

Goodram представила 122,88-Тбайт SSD для ЦОД с иммерсионным охлаждениемКомпания Goodram Industrial, принадлежащая Wilk Elektronik SA, без громких анонсов представила свой первый SSD вместимостью 122,88 Тбайт, предназначенный для использования в системах с иммерсионным (погружным) жидкостным охлаждением. Устройство рассчитано на дата-центры и площадки гиперскейлеров. Накопитель относится к семейству DC25F. В его основу положены чипы флеш-памяти QLC NAND. Доступны модификации в форм-факторах E3.S и E3.L: в обоих случаях для подключения служит интерфейс PCIe 5.0 x4. Заявленная скорость последовательного чтения информации достигает 14 600 Мбайт/с, скорость последовательной записи — 3200 Мбайт/с. Показатель IOPS составляет до 3 млн при произвольном чтении данных 4K-блоками и до 35 тыс. при произвольной записи. Накопители способны выдерживать 0,3 полных перезаписи в сутки (0,3 DWPD) на протяжении пяти лет. Это ставит их в один ряд с другими QLC-устройствами корпоративного класса, предназначенными для «теплого» и «холодного» хранения данных.

Источник изображения: Goodram Goodram отмечает, что накопители прошли всестороннее тестирование с использованием различных диэлектрических жидкостей для иммерсионного охлаждения, включая составы Shell и Chevron. Утверждается, что эти SSD рассчитаны на длительную эксплуатацию без деградации. Помимо модели вместимостью 122,88 Тбайт, Goodram предлагает широкий выбор других SSD для систем с иммерсионным охлаждением. Это устройства ёмкостью от 1,92 Тбайт и выше на основе чипов TLC NAND и QLC NAND с интерфейсами SATA, PCIe 4.0 и PCIe 5.0. Они доступны в форм-факторах SFF U.2 и U.3, E3.S и E1.S, M.2 2280 и M.2 22110.

23.12.2025 [09:39], Руслан Авдеев

Около 80 % всех дата-центров мира построены в не слишком подходящих климатических условияхСогласно исследованию Rest of World, почти 7 тыс. из 8808 дата-центров в мире построены в не самых комфортных, согласно стандартам ASHRAE, климатических условиях. Большинство находятся «за пределами оптимального температурного диапазона» для охлаждения, а 600 — в слишком жарких местах. Проблема в том, что развитие ИИ вынуждает размещать ЦОД и в неблагоприятных регионах. Анализ свидетельствует, что экономические, политические и даже сетевые реалии часто важнее для строителей и операторов, чем экологическая целесообразность. При анализе эксперты Rest of World сопоставляли данные о местоположении дата-центров с информацией о температуре из базы Copernicus. Данные сравниваются с рекомендациями ASHRAE, согласно которым эффективнее всего ЦОД работают при температуре окружающего воздуха 18 °C до 27 °C. Другими словами, почти 7 тыс. ЦОД находятся за пределами рекомендованного температурного диапазона. Большинство находятся в регионах со среднегодовой температурой ниже 18 °C, где решающее значение имеет управление влажностью и циркуляцией. Около 600 объектов, находятся в местах со среднегодовой температурой выше 27 °C, там постоянной проблемой является жара. В 21 стране вообще все ЦОД расположены в зонах с температурой выше рекомендованной. К ним, например, относятся Сингапур, Таиланд, Нигерия и ОАЭ. В Саудовской Аравии и Малайзии почти все дата-центры находятся в таких же горячих зонах, в Индонезии — почти половина, а в Индии — чуть меньше трети. Сингапур является уникальным регионом — на очень небольшой площади размещены дата-центры мощностью более 1,4 ГВт (ещё 300 МВт на очереди), при этом средняя дневная температура составляет около 33 °C, а относительная влажность нередко переваливает за 80 %. Для дата-центров такие условия близки к экстремальным. Сингапур фактически вводил мораторий на развитие ЦОД из-за нехватки энергии, значительная часть которой в случае ЦОД уходила на охлаждение. В общемировом масштабе дата-центры часто приходится строить в не слишком пригодных для их эксплуатации климатических условиях. Спрос на облака и генеративный ИИ быстро растёт, и особенно в регионах с самым жарким климатом. При этом правительства всё чаще требуют хранения данных в пределах национальных границ. В результате ЦОД строят совсем не там, где их использование дешевле всего. Впрочем, даже если операторы не гонятся за суверенитетом данных, в расчёт часто принимается доступность и стоимость электричества и воды. Также учитывается цена земли, частота в регионе стихийных бедствий, местные законы, налоговые льготы, простота получения разрешений на строительство. Рост нагрузки на системы охлаждения создаёт и дополнительную нагрузку на местные электросети. По информации Международного энергетического агентства (IEA), в 2024 году дата-центры потребили около 415 ТВт∙ч, это около 1,5 % от мирового спроса на электричество. По некоторым оценкам, к 2030 году цифра вырастет более чем вдвое по мере развития ИИ, места строительства новых ЦОД будут значить ещё больше. В ответ операторы ЦОД по-новому подходят к охлаждению объектов. Хотя воздушное охлаждение по-прежнему доминирует (на него приходится 54 % рынка), всё популярнее становятся СЖО, особенно для ИИ-стоек высокой плотности. Впрочем, модернизация уже действующих объектов довольно затратна, а многие из наиболее перспективных рынков ЦОД в мире имеют ограниченные ресурсы. По словам экспертов, к 2040 году экстремальная жара может существенно сказаться на ⅔ крупнейших ЦОД по всему миру, в т.ч. на всех основных дата-центрах в Азиатско-Тихоокеанском регионе и на Ближнем Востоке.

18.12.2025 [16:20], Сергей Карасёв

IXcellerate разработала собственное решение для эффективного охлаждения высоконагруженных ЦОДРоссийский оператор коммерческих дата-центров IXcellerate сообщил о разработке передового решения для охлаждения высоконагруженных машинных залов. Компания уже получила патент на изобретение, которое прошло независимую экспертизу Федеральной службы по интеллектуальной собственности. Целью исследовательского проекта являлось создание технологии для увеличения мощности системы кондиционирования при неизменной площади помещения. При этом требовалось решить проблемы неравномерного распределения воздуха, обеспечив возможность размещать стойки в любой точке машинного зала без изменения конфигураций инженерных систем. В процессе разработки специалисты использовали CFD-инструменты. В результате, была получена специальная формула для расчёта объёма расходуемого воздуха, температурного режима и суммарной площади теплообменников для оптимального подбора мощности и количества вентиляторов. Формула позволила сконструировать новую воздухоохладительную камеру статического давления: она обеспечивает равномерное распределение воздушных потоков на все теплообменные аппараты. Инновационное решение внедрено в действующих машинных залах Южного кампуса IXcellerate с общей нагрузкой более 30 МВт. По заявлениям компании, применённая технология обеспечивает ряд преимуществ по сравнению с другими системами. В частности, благодаря оптимизации повышена энергоэффективность ЦОД и снижено потребление электроэнергии. Количество стойко-мест удалось увеличить на 15 % при сохранении прежней площади машинного зала. Исключены риски перегрева высоконагруженного IT-оборудования. Кроме того, достигнут оптимальный температурный график теплоносителя, благодаря чему дата-центр работает в энергосберегающем режиме фрикулинга. Разработка новой технологии особенно важна в свете сформировавшейся геополитической обстановки, из-за которой поставки импортной продукции в Россию ограничены. Предложенное решение позволяет поддерживать параметры климата по стандарту ASHRAE, обеспечивает отказоустойчивость и сервисное обслуживание оборудования без перерывов на ремонты. Система подходит для любых дата-центров и помещений с серверным оборудованием.

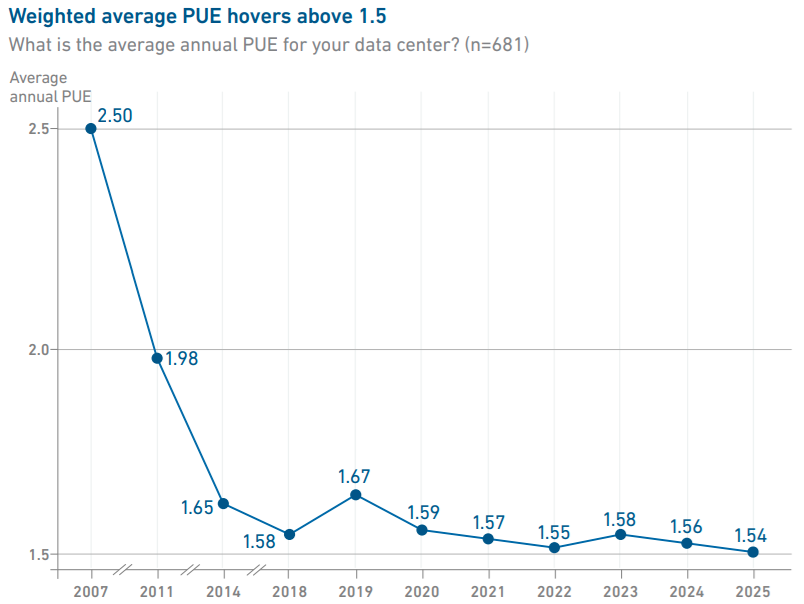

15.12.2025 [09:18], Руслан Авдеев

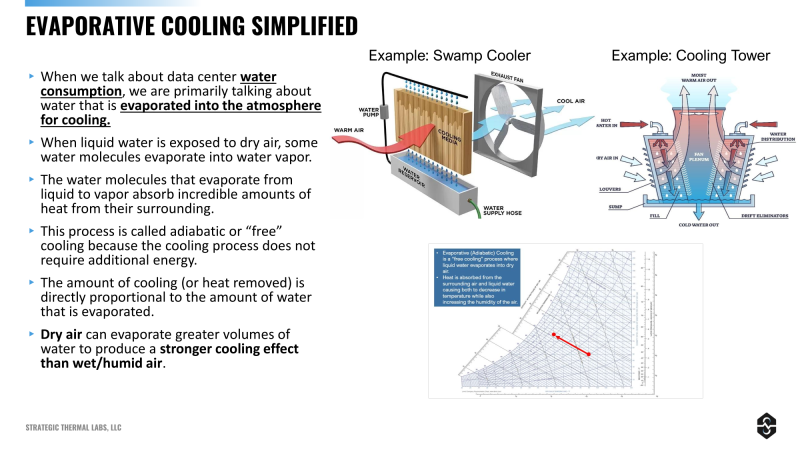

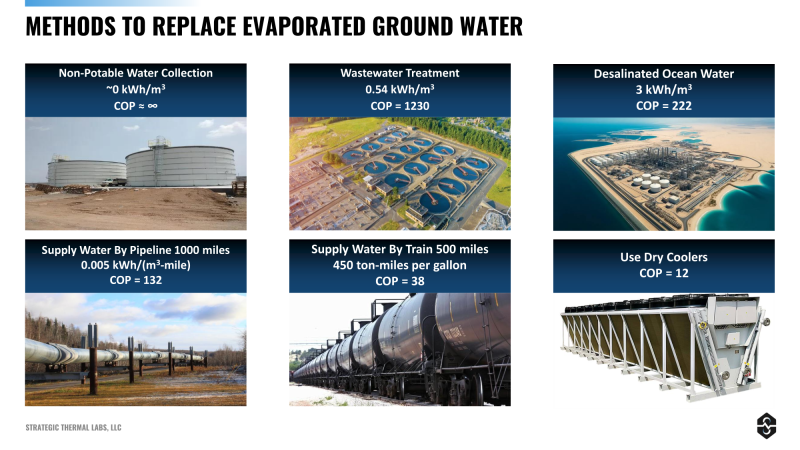

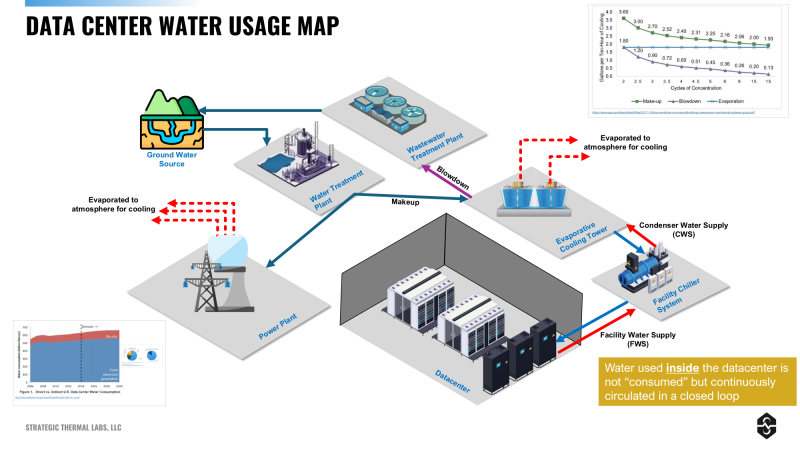

Как ЦОД используют воду и почему никак не могут «напиться»После дебюта ChatGPT в 2022 году и взрывного роста рынка ЦОД вследствие этого, повышенное внимание стало уделяться воздействию последних на окружающую среду. Впрочем, беспокоиться стоит не только об электроэнергии. Любые, даже самые современные ЦОД используют колоссальные объёмы питьевой воды. В презентации техасской Strategic Thermal Labs упоминается, что в США дата-центры потребляют миллионы литров питьевой воды ежедневно для охлаждения оборудования. В некоторых случаях на долю ЦОД приходится до четверти потребления воды муниципалитетами. С распространением энергоёмких систем генеративного ИИ проблема только усугубилась. В апреле 2024 года сообщалось, что потребление воды китайскими ЦОД удвоится к 2030 году, дойдя до более чем 3 млрд м3/год. В августе того же года — что ЦОД в Вирджинии потребляют огромные объёмы питьевой воды, а развитие ИИ только усугубляет ситуацию. В ближайшие годы гиперскейлеры и прочие операторы ЦОД намерены построить гигаваттные ЦОД с миллионами ускорителей, поэтому воды потребуется ещё больше. Эксперты Калифорнийского университета в Риверсайде и Техасского университета в Арлингтоне предполагают, что мировой спрос на ИИ к 2027 году может привести к использованию 4,2–6,6 млрд м3/год. В первую очередь «виноваты» системы испарительного охлаждения, в которых вода берётся из местных источников и подаётся к оборудованию, где и испаряется, передавая тепло воздуху. Главной причиной популярности такой технологии среди операторов ЦОД стала высокая эффективность таких систем и отсутствие необходимости использовать для охлаждения много энергии. Испарения около 40 л/мин. достаточно для оборудования на 1,5 МВт, передаёт The Register со ссылкой на данные Strategic Thermal Labs. При этом испарительные системы обычно эффективнее всего работают в жарких и засушливых пустынных областях, где воды и так мало. Хуже того, 20–30 % воды в таких системах используются для промывки минеральных отложений и смывается в очистительные установки. Нейтрализация таких отложений — отдельная задача. Тем не менее, испарительные системы всё равно дешевле в эксплуатации в сравнении с альтернативами, у них выше КПД, а энергии они тратят мало. А, например, Digital Realty с помощью мониторинга и автоматизации насосов сократила использование воды в системах с испарительным охлаждением на 15 % — полностью исключить его практически невозможно. Любые технологии, даже не потребляющие воду напрямую, всё равно зависят от неё. Например, «сухие» охладительные системы тратят на порядки больше электричества в сравнении с испарительными, что потенциально увеличивает косвенные выбросы воды. Так, статистика свидетельствует, что порядка 89 % электроэнергии США получают от газовых, атомных и угольных электростанций, а многие из них применяют паровые турбины, расходующие чрезвычайно много воды. ЦОД, находящиеся в регионах с большими ресурсами ГЭС, солнечных и ветряных электростанций, обеспечивают меньшее косвенное потребление воды, чем те, что питаются, например, от ископаемого топлива. Примечательно, что при генерации энергии всё равно теряется намного больше воды, чем потребляется современными ЦОД. Как показало исследование Национальной лаборатории Лоуренса в Беркли (LBL) от 2016 года, порядка 83 % потребления воды ЦОД приходится на генерацию энергии. Другими словами, использование энергоёмких систем для «безводного» охлаждения ЦОД в итоге ведёт… к большему потреблению воды. Впрочем, речь может идти о «другой» воде в другом месте — электростанции могут быть очень далеко от ЦОД и часто получают воду из рек и озёр. Операторы ЦОД прекрасно это понимают, пытаясь скрыть расходы воды уровня Scope 2 и 3. Для сокращения прямого и косвенного потребления целесообразно, например, использование фрикулинга везде, где это возможно. Впрочем, действительно комфортный для ЦОД климат, где нет жары, но нет и морозов, есть далеко не везде. В этом отношении выигравают страны Северной Европы, где много ГЭС и других возобновляемых источников. Поэтому даже если использовать вспомогательные чиллеры, косвенное потребление воды будет относительно небольшим, а тепло можно направлять на обогрев теплиц, зданий, бассейнов и т.п. Там, где фрикулинг нецелесообразен, возможен переход на СЖО — как DLC, так иммерсионные. Хотя «сухие» системы охлаждения потребляют больше энергии, чем испарительные, улучшение индекса PUE в итоге может компенсировать разницу. Например, переход на прямое жидкостное охлаждение чипов NVIDIA Blackwell может снизить PUE с 1,69–1,44 до 1,1 и ниже. Впрочем, баланс зависит от многих факторов. Та же NVIDIA пока не готова к погружным СЖО, да и средний по миру PUE с годами особо уже не меняется.

Источник изображения: Uptime Institute Хотя многие новые технологии охлаждения предусматривают внесение изменений в инфраструктуру объектов, в качестве альтернативы можно перераспределить нагрузки между ЦОД — примерно так же, как это делается в часы пиковых нагрузок на электросети, эффективность использования испарителей может меняться даже в зависимости от времени суток. Правда, многим, например колокейшн-провайдерам будет довольно трудно добиться эффективности из-за ограниченного контроля над серверами и нагрузками. Такой подход может не подойти и для инференса, где быстрое выполнение задач играет решающее значение. При этом обучение ИИ не имеет таких ограничений и проводиться удалённого на севере и в заданное время. Тюнинг моделей требует гораздо меньше вычислений, и такие задачи тоже можно планировать, например на ночь, когда температура ниже, как и объёмы испарения. Важнейшую роль играют источники воды для ЦОД. В некоторых регионах не хватает даже воды для питья. Эксперты предлагают операторам дата-центров инвестировать в опреснители, сети распределения воды, локальные очистные сооружения и др. для более широкого использования испарительных охладителей. По некоторым расчётам, опреснение и транспортировка воды с морского побережья всё ещё эффективнее, чем отказ от испарительных систем — даже с доставкой не трубопроводами, а в цистернах. Впрочем, Microsoft готовит ЦОД с почти нулевым расходом воды, а ранее экспериментировала со сбором дождевой воды. AWS обещала перевести ещё 100 дата-центров на использование очищенных сточных вод для охлаждения. |

|