Лента новостей

|

31.03.2025 [10:59], Руслан Авдеев

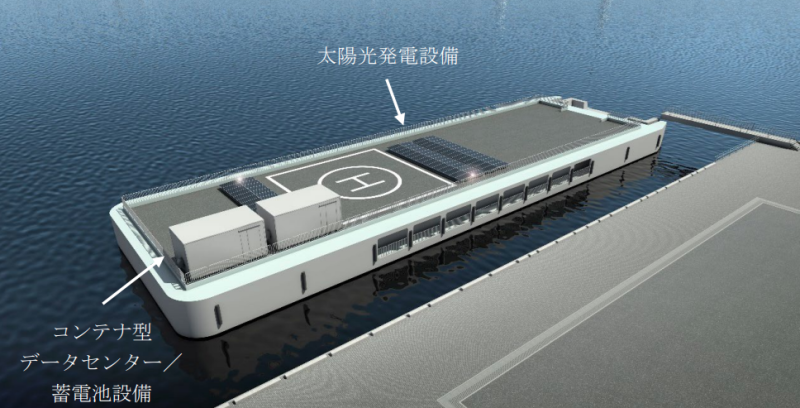

Японский консорциум предложил построить плавучий ЦОД с питанием от возобновляемых источников в ИокогамеКонсорциум японских компаний и финансовых институтов намерен построить прибрежный плавучий дата-центр. Демонстрационный проект планируется разместить в море недалеко от Иокогамы, сообщает Datacenter Dynamics. В числе участников консорциума — транспортная компания NYK Line (Nippon Yusen), архитектурный бизнес NTT Facilities, девелопер проектов возобновляемой энергии Eurus Energy Holdings, MUFG Bank, а также власти города Иокогама. По имеющимся данным проект будет использовать плавучую платформу 25 × 80 м, пришвартованную у пирса Osanbashi Pier в порту Иокогамы. На платформу будут установлены контейнерные ЦОД, аккумуляторные энергохранилища и солнечные элементы питания, которые и будут отвечать за энергоснабжение дата-центра. Также рассматривается использование морских ветрогенераторов. Демонстрационный проект должен помочь оценить целесообразность строительства плавучих ЦОД, полностью снабжающихся электричеством за счёт возобновляемой энергии. Строительство должно начаться осенью 2025 года. В зависимости от результатов, партнёры рассмотрят его дальнейшее расширение близ порта Иокогамы и в морских зонах.

Источник изображения: муниципалитет Иокогамы NTT Facilities построит дата-центр, Eurus будет проводить технический контроль, MUFG обеспечит финансовую поддержку, а NYK Line будет управлять проектом в целом. Энергетическая ёмкость дата-центра пока не раскрывается. Дополнительная информация имеется на портале Иокогамы.

Источник изображения: Муниципалитет Иокогамы Плавучие ЦОД уже пробовали использовать многие компании по всему миру. Пионером в данной сфере стала американская Nautilus, имеющая два плавучих ЦОД: в Стоктоне (Stockton, Калифорния) и Лимерике (Limerick, Ирландия). В прошлом ноябре Nautilus выставила дата-центр в Стоктоне на продажу за $45 млн. Объект обеспечивает 6,5 МВт критической IT-нагрузки, а площадь четырёх помещений для работы с данными составляет 1858 м². В октябре 2024 года французский стартап Denv-R ввёл в эксплуатацию соответствующий объект в Нанте, питание осуществляется за счёт солнечных панелей, покрывающих его поверхность. Кампус плавучих ЦОД планирует построить компания Keppel в Сингапуре, нечто подобное в обозримом будущем намерены организовать и в России.

31.03.2025 [10:49], Руслан Авдеев

Новые нормы энергоэффективности ИИ-ускорителей угрожают бизнесу NVIDIA в КитаеПекин представил новые нормы энергоэффективности для ИИ-ускорителей. Весьма вероятно, что они помешают китайским компаниям приобретать наиболее востребованные в Китае ускорители NVIDIA, если регуляторы всерьёз возьмутся за контроль их исполнения, сообщает The Financial Times. Национальная комиссия по развитию и реформам (NDRC) настоятельно рекомендует местным игрокам рынка ЦОД использовать ускорители, соответствующие требованиям к энергоэффективности, при строительстве новых дата-центров и расширении уже существующих объектов. Популярный в Китае ИИ-ускоритель NVIDIA H20 менее производителен, чем флагманские модели компании, но его можно официально поставлять в страну. Однако, по данным издания, на сегодняшний день H20 не соответствует новым требованиям комиссии. По информации источников, в последние несколько месяцев китайский регулятор без лишнего шума «отговаривает» местные IT-гиганты, такие как Alibaba, ByteDance и Tencent, от использования H20. Впрочем, пока правила применяются не слишком жёстко, и эти ускорители NVIDIA по-прежнему востребованы на китайском рынке. Последствия для бизнеса NVIDIA могут оказаться серьёзнее, если комиссия решит ужесточить запрет — это поставит под угрозу многомиллиардные доходы компании в Китае. Несмотря на активное строительство дата-центров, американский разработчик рискует потерять заказы, а его место займёт Huawei, чьи продукты лучше соответствуют новым «зелёным» требованиям. В настоящее время NVIDIA ищет способы повысить энергоэффективность своих решений и стремится провести переговоры с руководством NDRC для обсуждения сложившейся ситуации. Однако это приведёт к снижению производительности H20 и, соответственно, конкурентоспособности на китайском рынке.

Источник изображения: Henry Chen/unsplash.com Поскольку ограничения распространяются главным образом на новые, строящиеся ЦОД, некоторые компании обходят правила, заменяя в уже действующих дата-центрах старые ускорители на H20. В других случаях несоблюдение норм может привести к проверкам и штрафам. Хотя ограничения вступили в силу ещё в прошлом году, до недавнего времени о них не сообщалось — Китай всеми силами стремится к технологическому суверенитету в полупроводниковой сфере и активно содействует отказу местных компаний от продукции NVIDIA. Прямым конкурентом H20 считается Huawei Ascend 910B, на подходе и вариант 910C. NRDC недвусмысленно намекает на будущее отношений Пекина и NVIDIA. После ужесточения экспортных ограничений США в отношении Китая в октябре 2023 года компания специально разработала ослабленную экспортную версию H20. Однако на фоне триумфа китайских ИИ-моделей стартапа DeepSeek в стране разразился настоящий бум ИИ-технологий, и компании вроде Alibaba и Tencent активно закупают H20, особенно с учётом вероятного дальнейшего ужесточения американских санкций, включая возможный запрет на поставки даже ослабленных ускорителей. Китай — четвёртый по величине рынок для NVIDIA в мире: в 2025 фискальном году выручка компании здесь составила $17,1 млрд, или 13 % от всех продаж. Помимо Huawei, конкуренцию NVIDIA на китайском рынке может составить и Intel с её ускорителями HL328 и HL388, однако они также не соответствуют новым китайским требованиям по энергоэффективности. Впрочем, их доля в китайском импорте изначально была незначительной.

31.03.2025 [09:54], Сергей Карасёв

Маршрутизатор OpenWrt Two предложит поддержку 10GbE и Wi-Fi 7 за $250Команда OpenWrt, по сообщению ресурса Liliputing, приступила к созданию маршрутизатора OpenWrt Two, который поступит в продажу в конце текущего года. В разработке новинки принимают участие специалисты компании GL.iNet. Маршрутизатор OpenWrt One (на изображении) дебютировал в декабре 2024 года. Устройство, спроектированное в сотрудничестве с Banana Pi, несёт на борту процессор MediaTek Filogic 820 (MT7981B) с двумя ядрами Arm Cortex-A53, 1 Гбайт памяти DDR4 и опциональный SSD формата M.2 2242/2230 с интерфейсом PCIe 2.0 x1 (NVMe). Есть сетевые порты 2.5GbE и 1GbE, а также адаптер Wi-Fi 6. Цена составляет около $90. В основу OpenWrt Two ляжет чип MediaTek Filogic 880 (MT7988), который объединяет четыре ядра Arm Cortex-A73 с частотой до 1,8 ГГц и контроллер памяти DDR3/DDR4 (фактический объём ОЗУ пока не уточняется). Реализована беспроводная связь Wi-Fi 7 (802.11a/b/g/n/ac/ax/be) в частотных диапазонах 2,4, 5 и 6 ГГц. Говорится о поддержке модуляции 4096-QAM. Для новинки по сравнению с оригинальной моделью предусмотрен более широкий набор Ethernet-портов: это 10GbE SFP, 5GbE RJ45, 2.5GbE RJ45 (четыре разъёма) и 1GbE RJ45 (один или два разъёма). Благодаря увеличению количества сетевых гнёзд расширятся функциональные возможности маршрутизатора. В качестве программной платформы, как и прежде, будет применяться OpenWrt — встраиваемая ОС с ядром Linux. По заявлениям разработчиков, это обеспечит возможность модификации и настройки устройства в соответствии с конкретными требованиями. Ожидается, что стоимость OpenWrt Two составит около $250.

30.03.2025 [17:24], Владимир Мироненко

Рост цен и штрафы: изменения в лицензионной политике Broadcom VMware побуждают мелких и средних клиентов искать альтернативное решениеФранцузское подразделение глобального дистрибьютора Arrow отправило партнёрам VMware, использующим её решения, электронное уведомление об изменениях в лицензионной политике компании, влекущих за собой существенное повышение затрат клиентов на её продукты. Компания не только резко увеличила минимальные требования к лицензии, но и ввела штрафы за несвоевременное обновление лицензий. «Мы хотели бы сообщить вам о существенных изменениях, внесённых Broadcom, которые повлияют на наш совместный бизнес, — пишет Arrow в меморандуме для партнеров, с которым ознакомился The Register. — Начиная с 10 апреля минимальное количество ядер, требуемых для лицензий VMware, существенно увеличится, с 16 до 72 ядер». Таким образом, если у клиента сервер с одним восьмиядерным процессором, он всё равно будет должен заплатить за лицензию VMware на 72 ядра, т.е. фактически переплачивать за 64 ядра, которые он не может использовать. Также Broadcom «ввела штрафы для конечных клиентов, которые вовремя не продлили свои уже действующие подписные лицензии». «Эти штрафы составляют 20 % от цены первого года подписки и будут применяться задним числом», — говорится в меморандуме. Цель этих изменений вполне очевидна. Как пишет The Register, организации, использующие серверы с восемью ядрами, скорее всего, пользуются продуктами vSphere Foundation и vSphere Enterprise Plus, которые предлагают базовые инструменты виртуализации. При этом ведущее решение VMware — пакет Cloud Foundation (VCF) для вычислений, хранения и сетевых инструментов виртуализации. Пользователям потребуется четыре сервера только для управления VCF, не говоря уже о запуске любых виртуальных машин. Поэтому у пользователей VCF, вероятно, будет потребность в лицензии на гораздо больше ядер, чем 72. Так что эти изменения говорят о желании Broadcom иметь дело с крупными клиентами, которые приносят больше прибыли при меньших затратах. Изменения ударят не только по мелким и средним компаниям, но и по крупным организациям с филиальной сетью, поскольку те не захотят оплачивать для небольшого офиса лицензию на 72 ядра. Крупные клиенты VMware уже столкнулись с ростом расходов, поскольку Broadcom предлагает продукты виртуализации в рамках пакетов по подписке, которая включает услуги поддержки. Хотя номинальная цена продуктов в этих пакетах снизилась, требование покупать пакеты и обслуживание означает, что у большинства клиентов наблюдается рост расходов. «VMware наказывает клиентов малого и среднего бизнеса, которые продолжают использовать платформу, — сообщил ресурсу CRN топ-менеджер партнёра VMware. — Очевидно, что VMware не ценит сообщество малого и среднего бизнеса, которое построило свой бизнес с использованием её платформы». Применение Broadcom 20-% штрафа топ-менеджер расценил как оскорбление для клиентов. «Я не понимаю, почему они пытаются оттолкнуть клиентов», — сказал он. Ещё один собеседник CRN заявил, что изменения лицензионной политики VMware побудят клиентов искать альтернативные решения. Генеральный директор компании из рейтинга CRN Solution Provider 500, пожелавший сохранить анонимность и назвавший штраф в размере 20 % плохой деловой практикой, заявил, что стратегия Broadcom VMware заключается в том, чтобы сосредоточиться на 20 % крупнейших клиентов и отказаться от рынка среднего и малого бизнеса. «Это её проверенная стратегия, — сказал он. — Она снижает эксплуатационные расходы и заключает многолетние сделки с клиентами с завышенными ценами, поэтому её расходы снижаются, доходы растут, и она получает больше прибыли».

30.03.2025 [13:37], Сергей Карасёв

Oklo довела мощность малых модульных реакторов Aurora Powerhouse до 75 МВтКомпания Oklo, поддерживаемая главой OpenAI Сэмом Альтманом (Sam Altman), по сообщению ресурса Datacenter Dynamics, увеличила максимальную мощность своих малых модульных реакторов (SMR) на быстрых нейтронах Aurora Powerhouse в полтора раза — с 50 до 75 МВт. Реакторы Oklo, как ожидается, помогут удовлетворить растущий спрос операторов дата-центров на электроэнергию на фоне стремительного развития ИИ. Развёртывание таких установок позволит снизить нагрузку на традиционные энергосети. SMR рассматриваются как более дешёвая, компактная и быстро внедряемая альтернатива традиционным АЭС. По заявлениям Oklo, компания увеличила мощность Aurora Powerhouse, чтобы удовлетворить потребности крупных клиентов. Диапазон 50–75 МВт, как утверждается, соответствует архитектуре современных ЦОД, ориентированных в том числе на задачи ИИ. Как отмечает Oklo, повышение мощности Aurora Powerhouse не приведёт к каким-либо серьёзным техническим, проектным или нормативным сложностям. При этом будет достигаться «экономия благодаря масштабу», поскольку будущие заказчики смогут наращивать энергетические ресурсы до нужных показателей с меньшим количеством установленных реакторов. На сегодняшний день Oklo получила заказы на поставки SMR суммарной мощностью более 14 ГВт. В частности, в конце 2024 года Oklo заключила не обязывающее соглашение о поставках 12 ГВт оператору ЦОД Switch до 2044 года. Кроме того, подписаны договор на 500 МВт с Equinix, не обязывающее письмо о намерениях, связанное с PPA для Prometheus Hyperscale на 100 МВт, а также партнёрские соглашения с двумя неназванными операторами ЦОД, предусматривающие поставки до 750 МВт.

30.03.2025 [13:29], Сергей Карасёв

Supermicro представила широкий ассортимент односокетных серверов на базе Intel Xeon 6Компания Supermicro анонсировала большое количество однопроцессорных серверов на аппаратной платформе Intel Xeon 6 для различных рабочих нагрузок, включая ИИ-инференс, приложения НРС, аналитику данных и пр. Утверждается, что новинки способны справляться со многими задачами, которым традиционно требуются двухсокетные машины. В зависимости от серии и модификации серверы комплектуются чипами Xeon 6500P/6700P Granite Rapids с производительными Р-ядрами или изделиями Xeon 6700E Sierra Forest с энергоэффективными Е-ядрами. Используя односокетные системы, предприятия и операторы ЦОД, как отмечает Supermicro, могут сократить первоначальные затраты на закупку оборудования и эксплуатационные расходы, включая оплату электроэнергии. Ассортимент серверов Supermicro на платформе Intel Xeon 6 включает флагманские устройства SuperBlade с максимальной производительностью для ИИ, НРС, облачных и корпоративных нагрузок. Эти системы доступны в конфигурациях с воздушным или жидкостным охлаждением. В корпусе 8U может быть размещено до 20 узлов, в шасси 6U — до десяти. Серверы допускают установку до четырёх GPU-ускорителей двойной ширины. Кроме того, представлены стоечные серверы Hyper для масштабируемых облачных рабочих нагрузок, оптимизированные для инференса. На облачные дата-центры также ориентированы устройства CloudDC. Серверы серии WIO предлагают гибкие возможности в плане конфигурации подсистемы ввода-вывода, а модели Edge предназначены для использования на периферии. Вышли также обновлённые решения GrandTwin с возможностью горячей замены узлов и серверы хранения Top-loading Storage.

30.03.2025 [01:58], Владимир Мироненко

IBM сокращает персонал в США, но активно нанимает малоопытных сотрудников в ИндииПосле того, как ресурс The Register сообщил на прошлой неделе о планах IBM сократить около 9 тыс. рабочих мест в США в 2025 году, с ним связались нынешние и уволенные сотрудники, которые подтвердили, что сокращения персонала в США даже более значительные, чем сообщалось, и компания постепенно перемещает рабочие места в Индию. Это подтверждают и размещаемые IBM на своём сайте вакансии. Если 7 января 2024 года на нём было всего 173 открытых вакансии в Индии, то 23 ноября 2024 года для работы в этой стране было размещено 2946 вакансий, а на момент публикации статьи — 3866 вакансий. Сотрудник IBM, которого уже известили о сокращении его рабочего места (Resource Action, RA), рассказал, что об этом ему сообщили после того, как ему поручили обучить навыкам работы недавно нанятых работников в Индии. После получения уведомления о RA сотрудники имеют право в течение установленного периода подать заявку на отрытые вакансии в других подразделениях IBM. Но то, что у IBM в США есть открытые вакансии, вовсе не означает, что компания собирается нанимать здесь сотрудников. «Все, к кому я обращался внутри компании с просьбой о переводе, говорили одно и то же: “Я могу нанимать только в Индии”», — сообщил источник The Register. С подобной ситуацией сталкивались и другие собеседники ресурса. Один из бывших сотрудников IBM рассказал, что в IV квартале 2024 года было много увольнений, по слухам, исчисляемых тысячами, однако в Индии, наоборот, было размещено более тысячи вакансий. «Фаворитизм был вопиющим», — отметил он. По его словам, у многих из уволенных был большой опыт работы с облаком, но их заменили людьми без особого опыта или даже новичками. Также IBM передала на полный аутсорсинг в Индию вопросы обеспечения качества (QA). «Они пытались заменить высококвалифицированных QA-инженеров — некоторые из которых имели более десяти лет опыта — новыми сотрудниками, обученными всего за полгода. Последствия были предсказуемы: резкое снижение качества и эффективности», — рассказал источник. «На этом этапе IBM может также перенести свою штаб-квартиру в Индию, поскольку она больше не отдает приоритет США», — то ли в шутку, то ли всерьёз предположил один из источников. Собеседник The Register, рассказавший о сокращениях в подразделении Cloud Classic, сообщил, что увольнения проводятся и в других подразделениях IBM. Его слова подтверждаются появившимися недавно сообщениями об сокращениях рабочих мест в филиале компании в Северной Каролине, а также в Канаде. В феврале 2024 года представитель IBM сообщил The Register, что компания ожидает завершить 2024 год примерно с тем же уровнем занятости, что и в начале года. Вместе с тем, IBM сократила 11,9 тыс. рабочих мест или 4,2 % общей численности в 2024 году, в то время в Индии было добавлено около 3 тыс. открытых вакансий. Поэтому, как полагает The Register, данные о планируемом IBM сокращении рабочих мест в 2025 году в пределах 9 тыс. являются заниженными, поскольку сокращение, как ожидается, будет более масштабным.

29.03.2025 [10:57], Владимир Мироненко

SK hynix распродала почти всю память HBM, которую выпустит в 2026 годуНа этой неделе состоялось ежегодное собрание акционеров компании SK hynix, на котором Квак Но-чжун (Kwak Noh-jung) заявил, что переговоры компании с клиентами о продажах памяти HBM в 2026 году близки к завершению. Как пишет The Register, заявление гендиректора было воспринято как знак того, что, как и в прошлом году, SK hynix распродаст весь объём выпуска HBM на год вперёд. На мероприятии было объявлено, что в последние недели наблюдается всплеск заказов на поставки HBM, поскольку компании стремятся заключить контракты до ожидаемого увеличения США пошлин на импортируемые полупроводники. Напомним, что в феврале президент США Дональд Трамп (Donald Trump) заявил о намерении ввести тарифы на импорт полупроводников на уровне 25 % и выше, добавив, что в течение года они могут вырасти до 50 % и даже 100 %.

Источник изображений: SK hynix Квак также сообщил акционерам, что SK hynix ожидает «взрывного» роста продаж HBM. На вопрос о том, представляет ли угрозу планам компании то, что DeepSeek использует для обучения своих ИИ-моделей сравнительно небольшие вычислительные мощности, глава SK hynix заявил, что достижения китайского стартапа станут стимулом для более широкого внедрения ИИ, что повлечёт за собой ещё больший спрос на продукцию SK hynix со стороны большего количества покупателей. Такой ответ стал почти стандартным для руководителей компаний, предоставляющих оборудование для обработки рабочих ИИ-нагрузок, на вопрос о том, формируется ли на ИИ-рынке «ценовой пузырь» и что может произойти, если он лопнет, отметил The Register. На прошлой неделе компания заявила, что отправила клиентам первые образцы 12-слойной памяти HBM4, отметив, что «образцы были доставлены с опережением графика» и что «она намерена завершить подготовку к массовому производству 12-слойной продукции HBM4 во второй половине года».

29.03.2025 [10:51], Сергей Карасёв

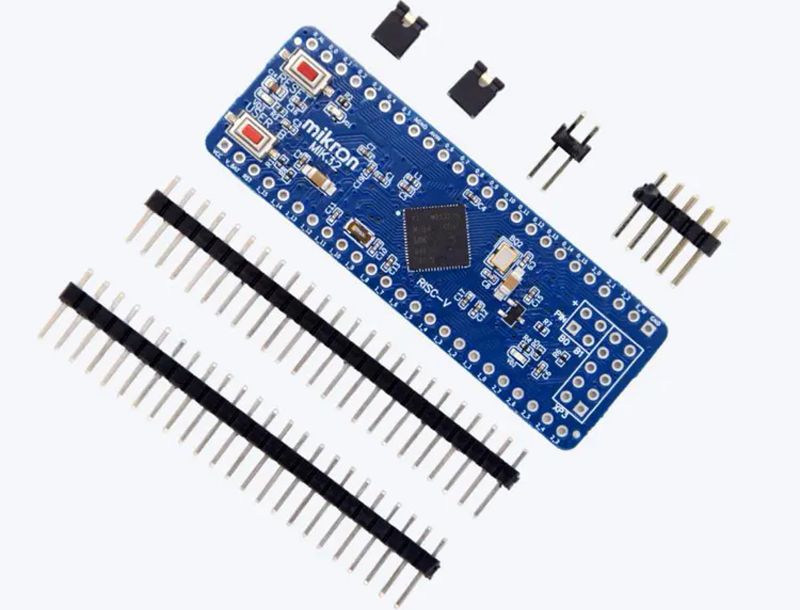

Комплект микроконтроллеров «MIK32 Амур» разработки «Микрон» появился на OzonКомпания «Микрон» (входит в ГК «Элемент») сообщила о том, что в продаже на маркетплейсе Ozon появился комплект микроконтроллеров «MIK32 Амур» (К1948ВК015/018). Эти изделия предназначены для устройств промышленной автоматизации и интернета вещей (IoT), охранных систем, оборудования мониторинга и телеметрии, систем умного дома, беспроводных периферийных устройств и пр. В комплект входят три микроконтроллера «MIK32 Амур» в корпусе QFN64 с размерами размер 8 × 8 × 1 мм и массой 2 г. Решение разработано и производится в России на предприятии группы компаний «Элемент». Микроконтроллер включён в Единый реестр российской радиоэлектронной продукции (ПП РФ 878). Основа «MIK32 Амур» — 32-разрядное ядро RISC-V. Есть 16 Кбайт ОЗУ, 8 Кбайт ПЗУ (EEPROM) и 256 бит ОПЗУ (однократно программируемая ПЗУ). Реализованы интерфейсы SPI, I2C и UART. Упомянуты АЦП (12 бит, 8 каналов) и ЦАП (12 бит, 2 канала) с частотой дискретизации до 1 МГц, датчик температуры, часы реального времени с поддержкой полного календаря. Говорится об аппаратной поддержке криптоалгоритмов ГОСТ 34.12–2018 и AES128. Диапазон рабочих температур простирается от -40 до +85 °C.

Источник изображения: «Микрон» / Ozon «Теперь в дополнение к отладочной плате и модулю на Ozon доступен к покупке непосредственно микроконтроллер. Мы идём навстречу пожеланиям инженеров-разработчиков прототипов устройств, которые пробуют его функционал и применимость в своих пилотных проектах на архитектуре RISC-V», — отмечает заместитель генерального директора АО «Микрон». На маркетплейсе Ozon также доступны отладочные платы «Старт» и DIP (на изображении) на базе «MIK32 Амур» (К1948ВК018), которые можно заказать по цене 7500 и 5500 руб. соответственно. Изделия, управляемые микроконтроллером, применяются в вузовских программах для подготовки инженерных кадров и разработчиков электроники.

29.03.2025 [10:44], Сергей Карасёв

OWC представила хранилища данных Jellyfish B24 и S24 для создателей контентаКомпания Other World Computing (OWC) анонсировала стоечные СХД Jellyfish B24 и Jellyfish S24, рассчитанные прежде всего на создателей контента. Обе новинки допускают подключение модулей расширения, что позволяет наращивать вместимость по мере необходимости. Модель Jellyfish B24 на основе HDD представляет собой упрощённую версию мощного решения Jellyfish R24, разработанную для совместной работы небольших команд. Допускается установка 24 накопителей формата LFF суммарной вместимостью до 576 Тбайт. При необходимости можно подключить до четырёх модулей расширения Jellyfish B24-E посредством интерфейса mini-SAS, получив хранилище общей ёмкостью до 2,8 Пбайт.

Источник изображений: OWC Устройство Jellyfish B24 выполнено в форм-факторе 4U. Задействован неназванный процессор Intel Xeon Silver, работающий в тандеме с 64 Гбайт оперативной памяти DDR4 ECC. В оснащение входит кеширующий SSD на 2 Тбайт. Есть два порта 1GbE, а при необходимости могут быть добавлены сетевые интерфейсы 10GbE (RJ45/SFP+), 25GbE (QSFP), 50GbE (QSFP28) и 100GbE (QSFP28). Предусмотрены четыре порта USB 3.0 и разъём D-Sub. За питание отвечает блок мощностью 875 Вт с резервированием. Габариты СХД составляют 432 × 318 × 198 мм, масса — 15,9 кг без установленных накопителей. Поддерживаются протоколы SMB, NFS, FTP и SSH.  Вариант Jellyfish S24, в свою очередь, рассчитан на 24 SSD формата SFF. При подключении модуля расширения Jellyfish S24-E можно получить суммарную вместимость до 736 Тбайт на основе твердотельных накопителей. Добавив четыре модуля Jellyfish R24-E или B24-E, можно создать гибридное хранилище ёмкостью до 2,3 Пбайт. СХД располагает двумя портами 10GbE RJ45 и двумя блоками питания мощностью 650 Вт с возможностью горячей замены. Форм-фактор — 2U. Упомянуты протоколы SMB, NFS, FTP и SSH. |

|