Материалы по тегу: компьютер

|

12.11.2024 [14:31], Руслан Авдеев

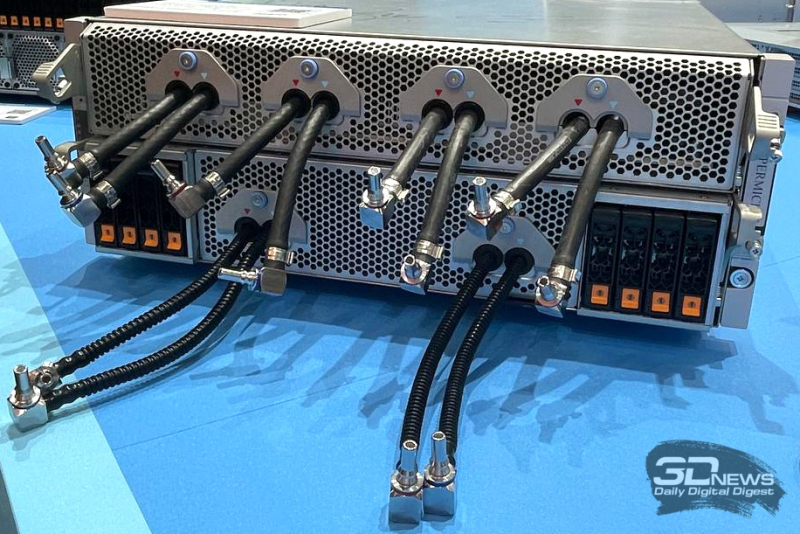

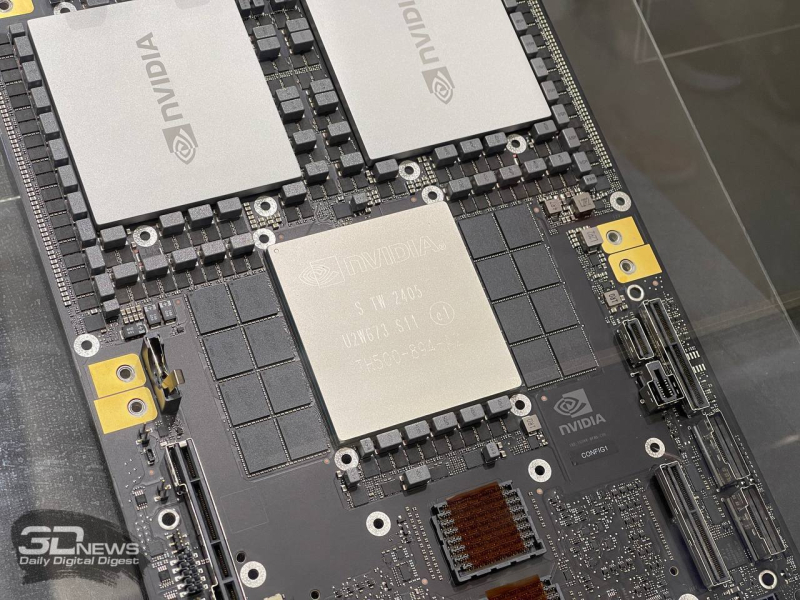

Supermicro лишилась огромного заказа на NVIDIA GB200 NVL72, который был передан WiwynnSupermicro, по данным UDN, лишилась заказа от индонезийской YTL Group (YTLP) на поставку новейших суперускорителей NVIDIA GB200 NVL72 для одного из крупнейших в Юго-Восточной Азии ИИ-суперкомпьютеров. Изначально заказ YTL был поделен между Supermicro и Wiwynn (Wistron), но теперь поставками будет заниматься только Wiwynn. В начале ноября появилась информация о том, что NVIDIA начала менять цепочку поставок, перенаправляя чипы, предназначавшиеся Supermicro, другим вендорам. В последнее время Supermicro была третьим по величине партнёром NVIDIA по объёму закупок чипов. Supermicro, по слухам, остановила расширение двух заводов в Малайзии, которые должны были удвоить её производственные мощности до 10 тыс. полностью укомплектованных стоек с СЖО в месяц. Остановка строительства заводов негативно сказалась на планах YTL Group, крупного покупателя ИИ-серверов NVIDIA и одного из крупнейших клиентов Supermicro. YTL намерена за $4,3 млрд построить кампус ЦОД площадью более 660 га в Джохоре (Малайзия) и разместить там самый производительный в стране или даже регионе ИИ-суперкомпьютер (300 Эфлопс). По данным UDN, YTL вынужденно передала заказ тайваньской Wywinn. Последняя также владеет современным производством в Малайзии, которое недавно было расширено. Крупные неприятности у Supermicro начались в августе, когда Hindenburg Research обвинила компанию в различных злоупотреблениях, включая манипуляции с бухгалтерской отчётностью. Впоследствии собственное расследование открыло Министерства юстиции США. Ernst & Young отказалась от аудита Supermicro, а сама компания уже несколько раз откладывала публикацию финансовой отчётности. Всё это привело к резкому падению стоимости акций компании. А сейчас ей и вовсе грозит делистинг с Nasdaq.

11.11.2024 [07:52], Сергей Карасёв

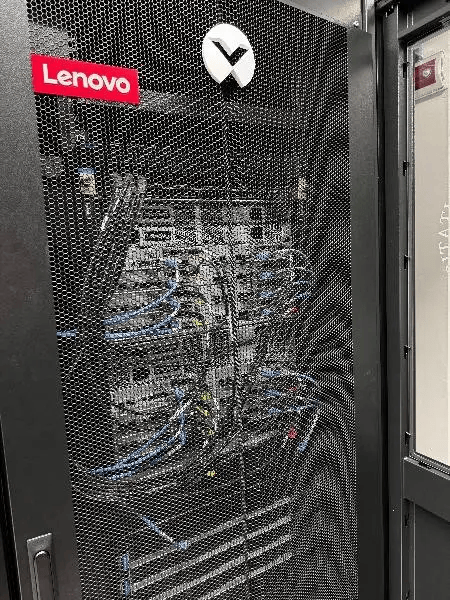

Lenovo поставит Италии НРС-кластер на базе Intel Xeon Emerald Rapids для исследований в области чистой энергииНациональное агентство по новым технологиям, энергетике и устойчивому экономическому развитию Италии (ENEA) выбрало компанию Lenovo для создания нового суперкомпьютера. Использовать НРС-комплекс планируется для ускорения исследований в области чистой энергии, в частности, по направлению ядерного синтеза. Проект нацелен на повышение вычислительной мощности платформы CRESCO (Computational Center for Research on Complex Systems — Вычислительный центр в области исследований сложных систем). Эта суперкомпьютерная система располагается в исследовательском центре Портичи (регион Кампания, административный центр Неаполь). Lenovo развернёт кластер из 758 узлов, в оснащение каждого из которых войдут два процессора Intel Xeon Platinum 8592+ поколения Emerald Rapids (64С/128T; 1,9–3,9 ГГц; 350 Вт). Говорится о применении технологии прямого жидкостного охлаждения Lenovo Neptune Direct Water-Cooling, которая позволяет отводить до 98 % тепла, генерируемого НРС-комплексом. Подчёркивается, что, помимо повышения производительности, оборудование Lenovo обеспечит высокую энергетическую эффективность. Серверы изготавливаются на предприятии Lenovo в Венгрии, а близость к месту установки позволяет сократить расходы по транспортировке и снизить выбросы вредных газов в атмосферу.

Источник изображения: Lenovo После введения в эксплуатацию новой системы общее быстродействие CRESCO поднимется примерно в шесть раз: с нынешних 1,01 до более чем 6,5 Пфлопс. Это выведет платформу в лидеры по вычислительной мощности в Италии. ENEA управляет развитой вычислительной инфраструктурой, которая предоставляет пользователям ресурсы для расчётов, моделирования и трёхмерной визуализации данных. В настоящее время сеть объединяет шесть объектов в разных областях: это Фраскати, Портичи, Болонья, Казачча, Трисайя и Бриндизи.

02.11.2024 [12:04], Руслан Авдеев

ParTec обвинила NVIDIA и Microsoft в нарушении патентов на ИИ-суперкомпьютерыНемецкий разработчик и интегратор HPC-решений ParTec выступил с иском к NVIDIA, обвинив последнюю в нарушении патентных прав. По данным The Register, компания требует запретить продажи ускорителей NVIDIA в 18 странах, участвующих в общей для ЕС патентной системе. ParTec, принимающая участие в создании первой в Европе экзафлопсной машины JUPITER и других суперкомпьютеров вроде MareNostrum5, подтвердила, что предметом спора являются те же самые патенты, из-за которых Partec уже подала иск против Microsoft в США. Впрочем, не исключено, что ParTec намерена добиваться не запрета продаж, а подписания с NVIDIA лицензионного договора — иначе блокировка сбыта в Европе ускорителей NVIDIA может повлиять на реализацию проектов с участием самой ParTec. Оба иска касаются патентов, связанных с динамической модульной системной архитектурой (dMSA). Именно она имеет важнейшее значение для построения высокопроизводительных вычислительных кластеров и обеспечивает оптимальное взаимодействие CPU, GPU и прочей электроники в составе систем, применяемых как для обучения ИИ-моделей, так и для инференса. Ранее в ParTec сообщали, что Microsoft незаконно использовала именно эту интеллектуальную собственность при создании облачной платформы Azure AI.

Источник изображения: Tingey Injury Law Firm/unsplash.com Иск к NVIDIA ParTec и её лицензионный агент BF exaQC AG подали в Единый патентный суд Евросоюза 27 октября. В ParTec намерены добиваться запрета для NVIDIA распространять свои ускорители в странах Евросоюза, в которых действуют патенты, а также возмещения ущерба. По имеющимся данным, речь идёт о патентах EP2628080 и EP3743812, причём последний действует во всех странах ЕС, являющихся частью Единой патентной системы. Речь идёт о 18 государствах, в том числе Германии, Франции и Италии. Если истцы выиграют суд, продажа ряда продуктов NVIDIA в этих странах будет запрещена. В компании утверждают, что давно предвидели перспективы ПО для масштабирования вычислений, поэтому и занялись разработкой dMSA. Компания также утверждает, что вела переговоры с NVIDIA, продемонстрировав свою модульную архитектуру, ПО ParaStation и ключевые патенты. NVIDIA якобы проявила большой интерес к технологии и даже объявила о готовности разрабатывать суперкомпьютеры с использованием ParaStation, но впоследствии эти планы так и не были реализованы. Сейчас компании так или иначе сотрудничают над созданием других суперкомпьютеров, где NVIDIA выступает «предпочтительным поставщиком» ускорителей для ЦОД. В ParTec заявили, что иск был неизбежен, поскольку NVIDIA отказалась вести переговоры о поставках ускорителей. Последняя якобы поступила так из-за иска ParTec к Microsoft — одного из ключевых клиентов NVIDIA. В ParTec подчёркивают, что благодаря её технологиям Германия и Европа в целом получат возможность развить собственную «суверенную индустрию». Однако мир сегодня зависит от нарушителей патентов, т.е. NVIDIA и Microsoft, распространяющих решения, представляющие угрозу для Германии и европейской IT-индустрии, говорит ParTec.

01.11.2024 [11:14], Сергей Карасёв

Марк Цукерберг: для обучения ИИ-модели Llama-4 используются более 100 тыс. ускорителей NVIDIA H100Председатель правления и генеральный директор Meta✴ Марк Цукерберг (Mark Zuckerberg), по сообщению ресурса Tom's Hardware, раскрыл масштабы кластера, который используется для обучения ИИ-модели нового поколения Llama-4. По его словам, для этих целей задействованы более 100 тыс. ускорителей NVIDIA H100. Напомним, в начале сентября нынешнего года стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске ИИ-суперкомпьютера Colossus, в основу которого положены 100 тыс. штук H100. В дальнейшем количество ускорителей в составе Colossus планируется увеличить вдвое. Теперь об эксплуатации кластера схожего масштаба рассказал Цукерберг. Глава Meta✴ не стал вдаваться в подробности о характеристиках Llama-4, ограничившись лишь фразами вроде «новые модальности», «более сильные рассуждения» и «повышенное быстродействие». Ранее Meta✴ заявляла о намерении потратить в 2024-м от $30 млрд до $37 млрд на развитие своей инфраструктуры — прежде всего для задач ИИ. Кроме того, говорилось, что к концу текущего года компания рассчитывает оперировать мощностями, эквивалентными более чем 500 тыс. ускорителей NVIDIA H100.

Источник изображения: Meta✴ Вместе с тем, как отмечается, возникают сложности при обеспечении питанием столь масштабных ИИ-кластеров. Дело в том, что один современный GPU может потреблять до 3,7 МВт·ч электроэнергии в год. Это означает, что массив из 100 тыс. таких ускорителей потребует не менее 370 ГВт·ч в год, чего достаточно для обеспечения энергией более 34 млн среднестатистических американских домохозяйств. Цукерберг признаёт, что трудности, связанные с доступностью энергоресурсов, в перспективе могут ограничить темпы роста отрасли ИИ. Как добавляет ComputerWeekly, Meta✴ также отказалась от практики увеличения срока службы серверов с целью сокращения расходов. Ранее компания сообщила о продлении периода эксплуатации оборудования до пяти лет вместо прежних четырёх с половиной: это, как ожидалось, даст экономию в $1,5 млрд. Однако теперь финансовый директор Meta✴ Сьюзан Ли (Susan Li) заявила, что компания в свете стремительного развития ИИ намерена применять серверы последнего поколения, чтобы максимально эффективно использовать доступную ёмкость существующих дата-центров.

29.10.2024 [20:28], Сергей Карасёв

Раскрыты подробности архитектуры ИИ-кластера xAI Colossus со 100 тыс. ускорителей NVIDIA H100Портал ServeTheHome рассказал подробности об архитектуре вычислительного кластера xAI Colossus, предназначенного для обучения крупных ИИ-моделей. Эта система использует 100 тыс. NVIDIA H100, а в дальнейшем количество ускорителей планируется увеличить вдвое. Это самый крупный из известных ИИ-кластеров на текущий момент. Оборудование для него поставили компании Dell и Supermicro. Стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске суперкомпьютера Colossus в начале сентября нынешнего года. Утверждается, что на создание системы потребовалось всего 122 дня. Причём с момента установки первой стойки с серверами до начала обучения ИИ-моделей прошло только 19 суток. Впрочем, как отмечают эксперты, поскольку машина является «однозадачной», т.е. в отличие от традиционных суперкомпьютеров предназначенной только для работы с ИИ, ускорить строительство было не так уж сложно, хотя результат всё равно впечатляющий. Как сообщается, в составе Colossus применены серверы на платформе NVIDIA HGX H100, оборудованные системой жидкостного охлаждения. Каждый узел Supermicro серии TNHR2-LCC типоразмера 4U содержит восемь ускорителей NVIDIA H100 и два CPU. Узел разделён на две половинки, одна с CPU и PCIe-коммутаторами и одна с HGX-платой, которые могут извлекаться независимо для простоты обслуживания. CPU, коммутаторы и ускорители охлаждаются посредством СЖО. Вентиляторы в шасси тоже есть. Воздух от них попадает на теплообменники на задней двери, которые уносят остаточное тепло. Холодных и горячих коридоров в ЦОД нет, воздух имеет одинаковую температуру во всём зале. В нижней части стоек располагается ещё один 4U-блок Supermicro для CDU с резервированием и поддержкой горячей заменой насосов. Каждый сервер имеет четыре блока питания с резервированием и возможностью горячей замены, которые подключены к трёхфазным PDU. Одна стойка объединяет восемь узлов NVIDIA HGX H100, между которыми располагаются коллекторы СЖО в формате 1U. Таким образом, каждая стойка насчитывает 64 экземпляра H100. Стойки организованы в группы по восемь штук, которые образуют малые кластеры из 512 ускорителей H100. Они в свою очередь объединены в т.н. «острова» по 25 тыс. ускорителей, каждому из которых полагается собственный машинный зал. Общее количество стоек в составе Colossus превышает 1500. Помимо узлов с ускорителями также есть CPU-узлы и узлы хранения All-Flash (1U). Как отмечает NVIDIA, в кластере Colossus задействована сетевая платформа Spectrum-X Ethernet. Применены коммутаторы Spectrum-X SN5600 и сетевые карты на базе чипа BlueField-3. Компания говорит об использовании трёхуровневой Ethernet-сети с 400GbE-подключением, но точная топология не указана. Судя по всему, выделенной сети для работы с хранилищем не предусмотрено. Каждом ускорителю полагается один 400GbE-адаптер SuperNIC, который и объединяет их в RDMA-сеть. Кроме того, у каждого GPU-узла есть ещё один 400GbE DPU, а также подключение к сервисной сети. Сетевые карты находятся в собственных лотках, благодаря чему их можно заменять без демонтажа шасси. По словам NVIDIA, уровень утилизации сети достигает 95 %. В качестве энергетического буфера между электросетью и суперкомпьютером используются аккумуляторные банки Tesla Megapack ёмкостью 3,9 МВт·ч каждый. Они необходимы для того, чтобы компенсировать всплески потребляемой мощности, когда нагрузка на ускорители резко возрастает в силу выполняемых ИИ-задач. Впрочем, вероятно, есть и ещё одна причина для такого решения — на первом этапе Colossus был лишён подключения к основной энергосети и в вопросе питания во многом полагался на генераторы.

26.10.2024 [14:00], Сергей Карасёв

Дженсен Хуанг и король Фредерик X запустили самый производительный в Дании ИИ-суперкомьютер GefionОснователь и генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) и король Дании Фредерик X объявили о запуске крупнейшего в стране суверенного суперкомпьютера для задач ИИ. Система получила название Gefion («Гевьон») — в честь скандинавской богини плодородия. НРС-комплекс эксплуатируется Датским центром инноваций в области искусственного интеллекта (DCAI), который был создан при поддержке фонда Novo Nordisk Foundation и Датского фонда экспорта и инвестиций. В церемонии ввода Gefion в эксплуатацию, проходившей в Копенгагене, приняла участие Надя Карлстен (Nadia Carlsten), генеральный директор DCAI. Суперкомпьютер объединяет 191 систему DGX H100, что в общей сложности даёт 1528 ускорителей NVIDIA H100. Задействованы 382 процессора Intel Xeon Platinum и интерконнект NVIDIA Quantum-2 InfiniBand. Прочие технические характеристики, а также показатели быстродействия системы пока не раскрываются. Пиковая теоретическая FP64-производительность должна составить около 52 Пфлопс, а в FP8-расчётах с разреженностью — порядка 6 Эфлопс. Сообщается, что Gefion будет применяться для решения сложных задач в области квантовых вычислений, «зелёной» энергетики, биотехнологий и пр. В частности, исследователи из Копенгагенского университета (UCPH) намерены задействовать машину для проведения крупномасштабного распределённого моделирования квантовых компьютерных схем. Кроме того, UCPH, Технический университет Дании (DTU), Novo Nordisk и Novonesis совместно разработают многомодальную геномную ИИ-модель для анализа мутаций заболеваний и разработки вакцин. Доступ к Gefion также получат стартапы, реализующие перспективные проекты в области обработки текста, изображений и видео. Суперкомпьютер размещён в одном из дата-центров Digital Realty на территории Дании. Этот объект на 100 % получает питание от возобновляемых источников энергии. Сборкой и установкой вычислительного комплекса занимались специалисты Eviden.

26.10.2024 [00:53], Владимир Мироненко

Tesla до конца месяца запустит ИИ-кластер из 50 тыс. NVIDIA H100Tesla планирует ввести в эксплуатацию ЦОД с 50 тыс. ускорителей NVIDIA H100 в конце этого месяца, пишет Data Center Dynamics (DCD) со ссылкой на заявление компании. «Мы начали использовать кластер на базе нашего завода раньше срока и находимся на пути к развертыванию 50 тыс. GPU в Техасе к концу этого месяца», — сообщил финансовый директор Вайбхав Танеджа (Vaibhav Taneja) в ходе отчёта о финансовых результатах за III квартал. Предполагается, что именно этот кластер, размещённый в Остине (Техас) отставал от графика, из-за чего гендиректор Илон Маск (Elon Musk) уволил в апреле руководителя строительства. В июне по распоряжению Маска 12 тыс. ускорителей H100, предназначавшихся Tesla, были переданы xAI. Сама xAI в сентябре запустила ИИ-кластер со 100 тыс. ускорителей NVIDIA H100. Капитальные затраты Tesla достигли $3,5 млрд в отчётном квартале, «последовательно увеличившись в основном из-за инвестиций в ИИ-вычисления», а капитальные затраты за год, как ожидается, превысят $11 млрд, что на $1 млрд больше год к году. При этом Танеджа сообщил, что компания «очень разумно подходит к расходам на ИИ», пытаясь наилучшим способом использовать существующую инфраструктуру, прежде чем делать дальнейшие инвестиции. Маск заявил, что Tesla продолжает расширять возможности обучения ИИ, чтобы удовлетворить как потребности в обучении автопилота Full Self Driving (FSD), так и роботов Optimus, отметив, что в настоящее время компания не испытывает дефицита вычислительных ресурсов. В квартальном отчёте не упоминается Dojo, ИИ-инфраструктура Tesla на базе ускорителей собственной разработки.

25.10.2024 [19:32], Сергей Карасёв

В Германии появится 500-Пфлопс ИИ-суперкомпьютер ELBJUWELНемецкая компания ParTec и научно-исследовательский Центр им. Гельмгольца Дрезден-Россендорфа (HDRZ) подписали меморандум о взаимопонимании в рамках совместного проекта по созданию нового высокопроизводительного комплекса для ИИ-задач. Создаваемый суперкомпьютер, получивший название ELBJUWEL, разместится в Германии. Эта НРС-система позволит местным учёным, компаниям и государственным учреждениям работать над сложными технологическими задачами. Ожидается, что комплекс повысит конкурентоспособность предприятий в Саксонии, снизив зависимость от международных облачных платформ. Технические подробности о машине ELBJUWEL пока не раскрываются. Но отмечается, что это будет один из самых мощных ИИ-суперкомпьютеров в мире. Планируемая производительность заявлена на уровне 500 Пфлопс (вероятно, FP64), тогда как быстродействие на ИИ-операциях FP8 будет достигать 50 Эфлопс. Цель проекта заключается в том, чтобы значительно облегчить доступ к ИИ-вычислениям для промышленных предприятий, средних коммерческих организаций, а также научных учреждений. Новая НРС-платформа, как предполагается, охватит широкий спектр вариантов использования. Сроки ввода ELBJUWEL в эксплуатацию не уточняются. Нужно отметить, что компания ParTec принимает участие в создании системы JUPITER — первого европейского суперкомпьютера экзафлопсного класса. Монтаж модульного ЦОД для этой машина начался в сентябре. В состав JUPITER войдут энергоэффективные высокопроизводительные европейские Arm-процессоры SiPearl Rhea и решения NVIDIA Quad GH200. ИИ-быстродействие суперкомпьютера до 93 Эфлопс, а FP64-производительность превысит 1 Эфлопс.

22.10.2024 [12:49], Владимир Мироненко

В Пизанском университете установили суперкомпьютер Lenovo на базе Intel Xeon MaxКомпания Lenovo сообщила об установке в дата-центре Пизанского университета (UniPi) нового кластера, благодаря чему HPC-платформа UniPi стала крупнейшей среди университетских суперкомпьютеров в Италии. Система размещена в ЦОД Green Data Center, который включает 104 стойки, где уже размещено 700 узлов (30 тыс. ядер, более ускорителей разных поколений).

Источник изображения: Lenovo Новая HPC-система Lenovo состоит из 16 узлов SD650 V3 с двумя процессорами Intel Xeon Max 9480 (Sapphire Rapids с HBM). Используемая СЖО Lenovo Neptune Direct Water-Cooling позволяет отводить до 98 % тепла, вырабатываемого суперкомпьютером, а также снизить энергопотребление на 40 %. Как утверждает компания, благодаря повышенной эффективности СЖО температура процессоров не достигает критических значений, что позволяет избежать снижения максимальной частоты ядер. Аналогичная платформа используется в суперкомпьютере Cassandra для Европейско-Средиземноморского центра по изменению климата (CMCC) в Лечче (Италия). Как отметил UniPi, решающим фактором при выборе решения Lenovo была адаптивность системы, поскольку проект был изначально разработан с учётом минимального воздействия на окружающую среду с целью создания экологичного ЦОД. Кроме того, стандартизированный подход Lenovo к созданию HPC-узлов упростила и ускорила её установку в ЦОД UniPi. Как ожидается, новый суперкомпьютер будет способен поддерживать рабочие нагрузки HPC и ИИ последнего поколения в течение следующих нескольких лет. UniPi имеет три ЦОД в Пизе. В 2016 году университет запустил проект строительства нового «Зелёного дата-центра» (Green Data Centre) для размещения HPC-нагрузок. По словам UniPi, новый университетский ЦОД является единственным объектом в стране, получившим классификацию «A» от AgID в начале этого года.

09.10.2024 [14:43], Руслан Авдеев

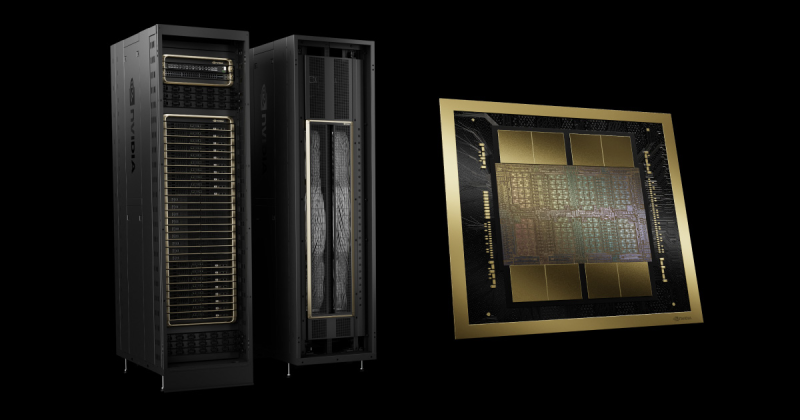

Foxconn и NVIDIA построят самый быстрый на Тайване ИИ-суперкомпьютерКомпании Foxconn и NVIDIA объединили усилия для постройки крупнейшего на Тайване суперкомпьютера. По данным пресс-службы NVIDIA, проект Hon Hai Kaohsiung Super Computing Center был представлен в ходе традиционного мероприятия Foxconn — Hon Hai Tech Day, прошедшего в минувший вторник. Вычислительные мощности будут построены на основе передовой архитектуры NVIDIA Blackwell — будет использована платформа GB200 NVL72, включающая 64 стойки. С ожидаемой производительностью ИИ-вычислений более 90 Эфлопс (FP4), машина может легко считаться самой быстрой на Тайване. Foxconn намерена использовать суперкомпьютер для исследований в области медицины, разработки больших языковых моделей (LLM) и инноваций в системах умного города. Это может сделать Тайвань одним из лидеров ИИ-индустрии. В рамках стратегии «трёх платформ» Foxconn уделяет внимание умному производству, умным городам и электрическому транспорту. Новый суперкомпьютер призван сыграть ключевую роль в поддержке инициатив компании по созданию «цифровых двойников», автоматизации робототехники и созданию умной городской инфраструктуры. Строительство уже началось в тайваньском муниципалитете Гаосюн, первая фаза должна заработать к середине 2025 года. Полностью работоспособным компьютер станет в 2026 году. Проект будет активно использовать технологии NVIDIA вроде робоплатформ NVIDIA Omniverse и Isaac для ИИ и «цифровых двойников». В Foxconn утверждают, что суперкомпьютер будет не только крупнейшим на Тайване, но и одним из самых производительных в мире. Каждая стойка GB200 NVL72 включает 36 CPU Grace и 72 ускорителя Blackwell, объединённых интерконнектом NVIDIA NVLink (суммарно 130 Тбайт/с). Технология NVIDIA NVLink Switch позволит системе из 72 ускорителей функционировать как единый вычислительный модуль — оптимальный вариант для обучения ИИ-моделей и инференса в режиме реального времени, с моделями на триллион параметров. Предполагается использование решений NVIDIA DGX Cloud Infrastructure и Spectrum-X для поддержки масштабируемого обучения ИИ-моделей. Тайваньская Foxconn (официально Hon Hai Precision Industry Co.) — крупнейший в мире производитель электроники, известный выпуском самых разных устройств, от смартфонов до серверов для популярных во всём мире заказчиков. Компания уже имеет производства по всему миру и является ключевым игроком в мировой технологической инфраструктуре. При этом производитель считается одним из лидеров в организации «умного» производства, внедряющим промышленные ИИ-системы и занимающимся цифровизацией заводов с помощью NVIDIA Omniverse Cloud. Кроме того, именно она одной из первых стала пользоваться микросервисами NVIDIA NIM в разработке языковых моделей, интегрированных во многие внутренние системы и процессы на предприятиях, создании умных электромобилей и инфраструктуры умных городов. Суперкомпьютер Hon Hai Kaohsiung Super Computing Center — лишь часть растущей общемировой сети передовых проектов на основе решений NVIDIA. Сеть включает несколько значимых проектов в Европе и Азии. Сотрудничество компаний становится всё теснее. В ходе того же мероприятия объявлено о сотрудничестве Foxconn и NVIDIA в Мексике. Первая построит завод в стране для упаковки полупроводников NVIDIA. |

|