Материалы по тегу: к

|

06.12.2023 [20:05], Сергей Карасёв

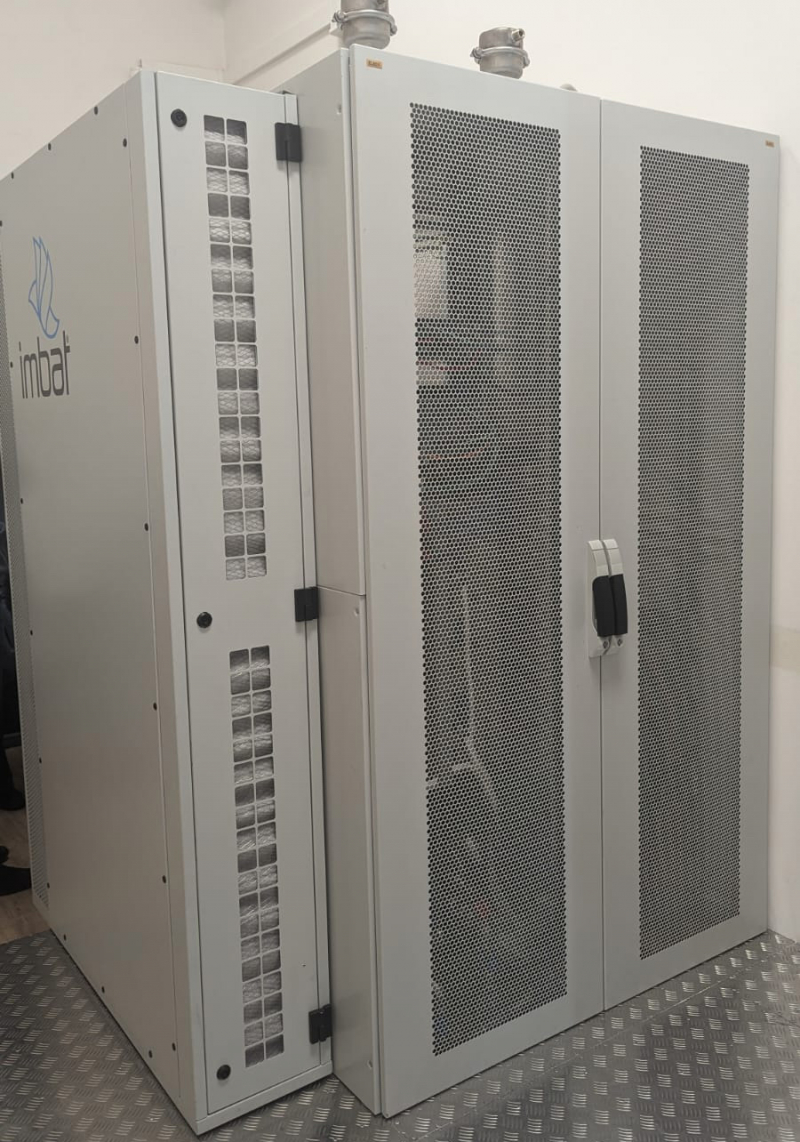

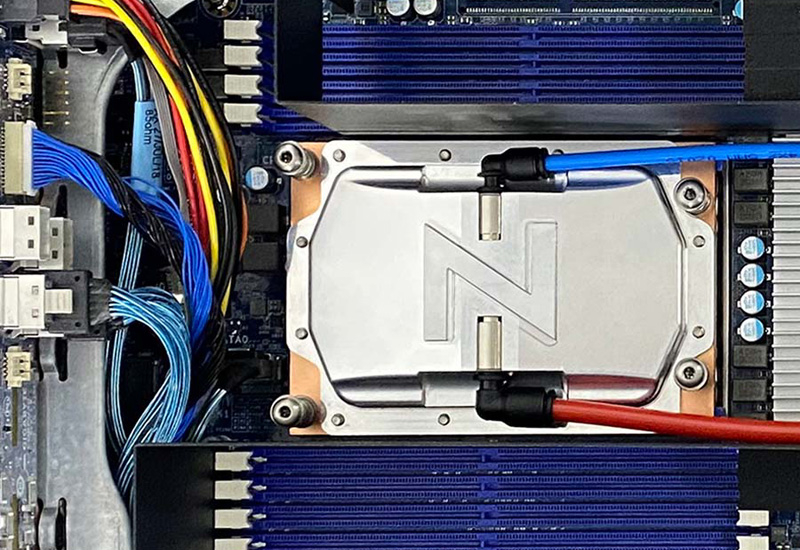

РСК создала для Института математики СО РАН суперкомпьютер с быстродействием 54,4 ТфлопсВ Институте математики имени С.Л. Соболева Сибирского отделения Российской академии наук (ИМ СО РАН) в Новосибирске появился новый суперкомпьютер, который планируется применять для разработки перспективных технологий, анализа данных, выполнения научных исследований и пр. Установку и тестирование системы выполнили специалисты группы компаний РСК. Отмечается, что монтажные и пуско-наладочные работы осуществлены в сжатые сроки — за 3,5 недели. На создание комплекса предоставлен грант в рамках федеральной инициативы «Развитие инфраструктуры для научных исследований и подготовки кадров» Национального проекта «Наука и университеты». В основу суперкомпьютера положена платформа «РСК Торнадо» с жидкостным охлаждением. Задействованы вычислительные узлы, оснащённые двумя процессорами Intel Xeon Ice Lake-SP (38 ядер; базовая частота 2,4 ГГц). Производительность кластера в текущей конфигурации составляет 54,4 Тфлопс. Система, как заявляет РСК, позволит сотрудникам института решать сложные исследовательские задачи в области математики, физики, биологии и пр. В дальнейшем запланированы несколько этапов модернизации комплекса. Так, в ближайшей перспективе будут установлены более 12 вычислительных узлов и узел с GPU-ускорителями. В результате, в 2024 году производительность поднимется на 89 Тфлопс, превысив 140 Тфлопс. Суммарная потребляемая мощность машины составит примерно 41 кВт. До 2025 года планируется повышение быстродействия суперкомпьютера до 234,4 Тфлопс. «У нас появилась возможность решать задачи невероятной сложности, моделировать объёмные процессы и предсказывать поведение сложных математических систем. Ресурсы этого вычислительного комплекса будут использоваться для разработки новых технологий, анализа данных и в образовательных целях, например, мы сможем обучать студентов и молодых учёных современным методам проведения исследований и работы с данными», — отметил и.о. директора ИМ СО РАН Андрей Миронов.

23.11.2023 [20:38], Сергей Карасёв

1,5 кВт на чип: ZutaCore показала высокоэффективную систему прямого жидкостного охлаждения HyperCoolКомпания ZutaCore на конференции SC23 сообщила о том, что её система прямого жидкостного охлаждения HyperCool Direct-On-Chip вошла в состав серверов Dell и Pegatron на платформе Intel Xeon Sapphire Rapids. Двухфазная система HyperCool способна эффективно отводить тепло от самых мощных серверных процессоров — с показателем TDP 1500 Вт и более. Это комплексное решение с замкнутым контуром вместо воды использует специальную диэлектрическую жидкость, благодаря чему оборудование защищено от коррозии. Платформа HyperCool обладает хорошей масштабируемостью и может быть развёрнута в новых или модернизированных дата-центрах — cтандартизированный интегрированный 6U-модуль способен отводить 100 кВт и выше. Система обеспечивает коэффициент PUE меньше 1,02. Конструкция HyperCool позволяет повторно использовать выделяемое тепло — например, для обогрева зданий. СЖО подходит для применения в ЦОД, ориентированных на решение задач ИИ и НРС. Система позволяет снизить общее энергопотребление и сократить выбросы вредных газов в атмосферу.

Источник изображения: ZutaCore Отмечается, что недавно технология HyperCool была сертифицирована для высокопроизводительных серверов ASUS. Кроме того, в экосистему ZutaCore входят AMD, Boston Limited, Dell, Equinix, Intel, World Wide Technologies (WWT) и другие. Утверждается, что по сравнению с традиционными системами охлаждения решение HyperCool обеспечивает сокращение совокупной стоимости владения на 50 %.

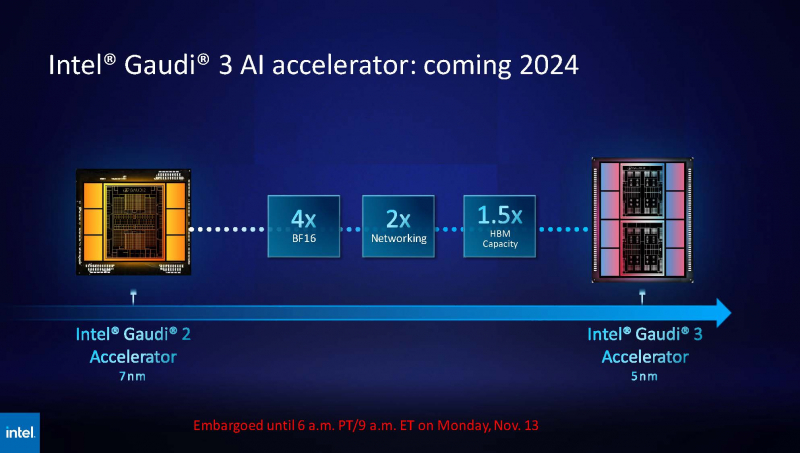

14.11.2023 [03:20], Алексей Степин

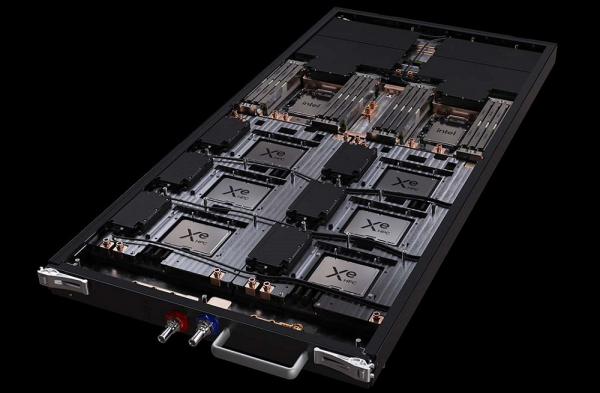

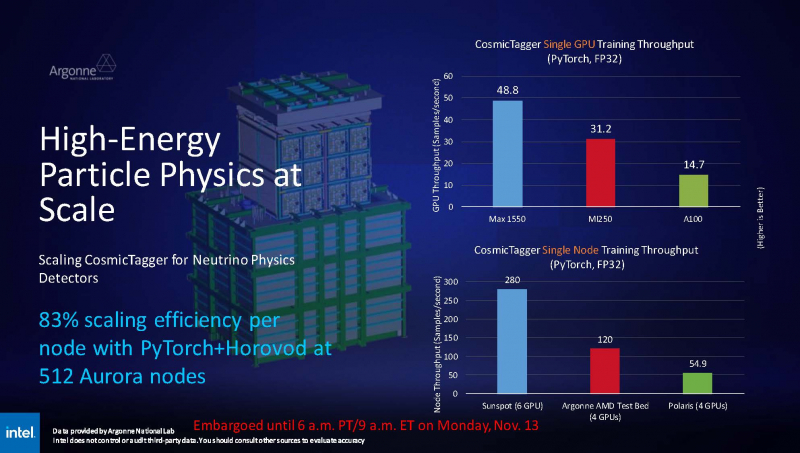

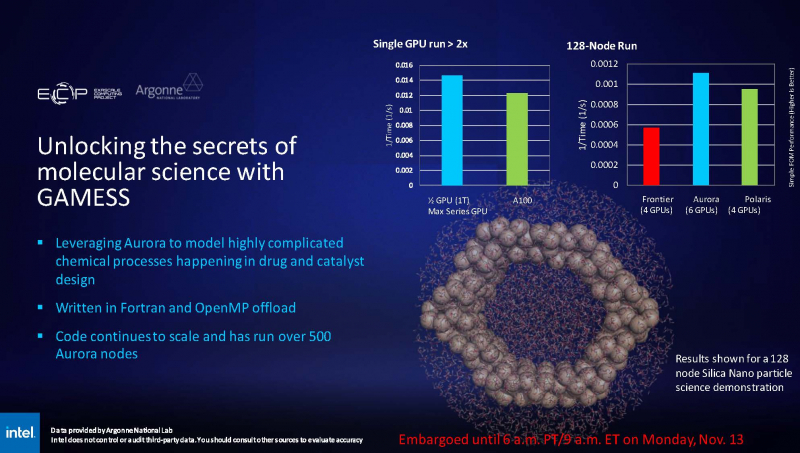

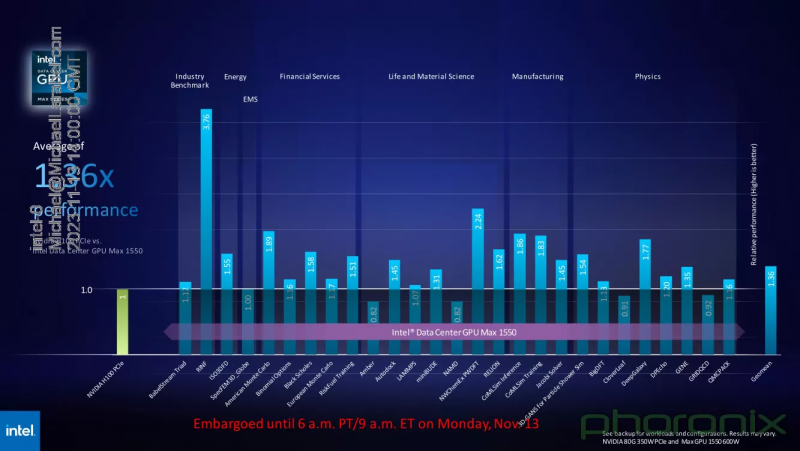

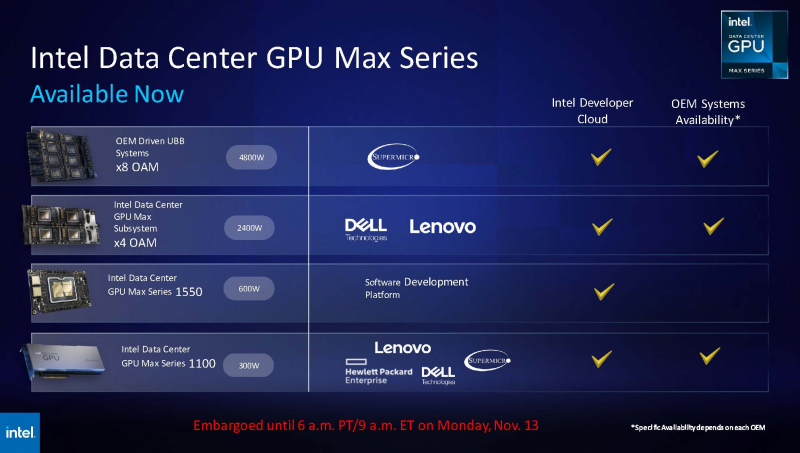

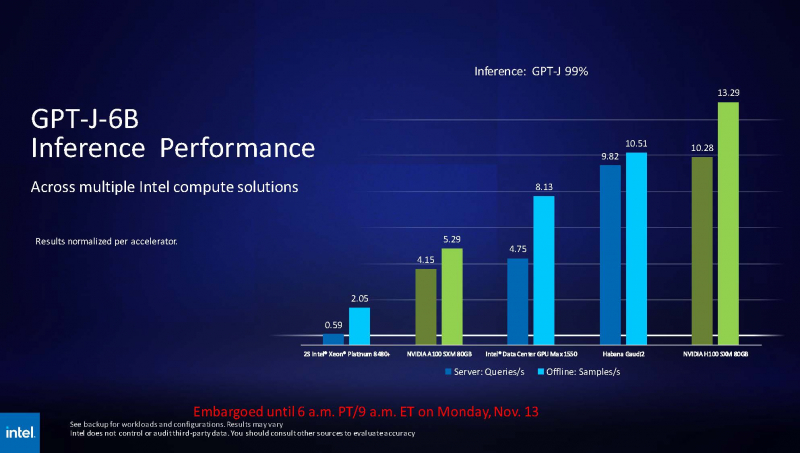

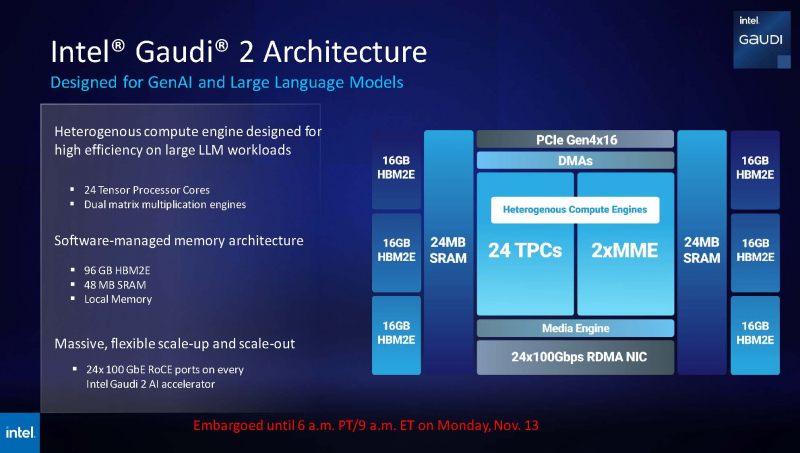

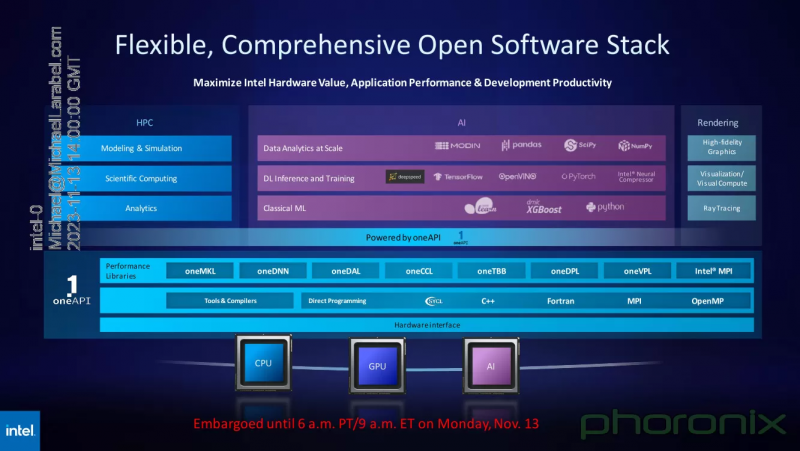

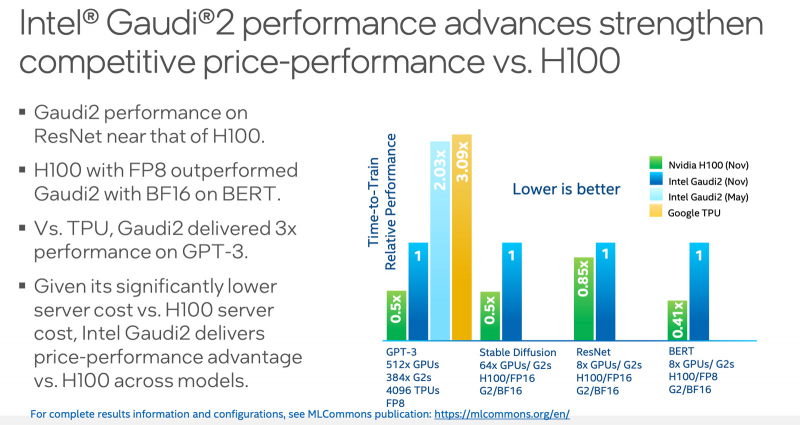

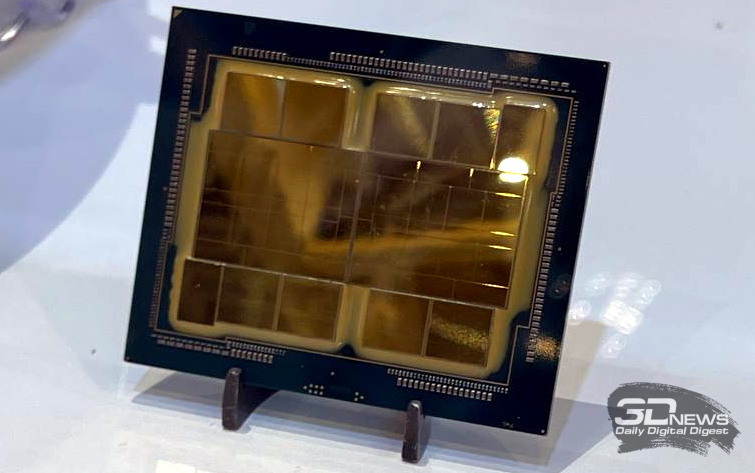

Intel показала результаты тестов ускорителя Max 1550 и рассказала о будущих чипах Gaudi3 и Falcon ShoresВ рамках SC23 корпорация Intel продемонстрировала ряд любопытных слайдов. На них присутствуют результаты тестирования ускорителя Max 1550 с архитектурой Xe, а также планы относительно следующего поколения ИИ-ускорителей Gaudi. При этом компания применила иной подход, нежели обычно — вместо демонстрации результатов, полученных в стенах самой Intel, слово было предоставлено Аргоннской национальной лаборатории Министерства энергетики США, где летом этого года было завершён монтаж суперкомпьютера экза-класса Aurora, занимающего нынче второе место в TOP500.  В этом HPC-кластере применены OAM-модули Max 1550 (Ponte Vecchio) с теплопакетом 600 Вт. Они содержат в своём составе 128 ядер Xe и 128 Гбайт памяти HBM2E. Интерфейс Xe Link позволяет общаться напрямую восьми таким модулям, что обеспечивает более эффективную масштабируемость. Хотя настройка вычислительного комплекса Aurora ещё продолжается, уже имеются данные о производительности Max 1550 в сравнении с AMD Instinct MI250 и NVIDIA A100. В тесте физики высоких частиц, использующих сочетание PyTorch+Horovod (точность вычислений FP32), ускорители Intel уверенно заняли первое место, а также показали 83% эффективность масштабирования на 512 узлах Aurora. В тесте, симулирующем поведение комплекса кремниевых наночастиц, ускорители Max 1550, также оказались первыми как в абсолютном выражении, так и в пересчёте на 128-узловой тест в сравнении с системами Polaris (четыре A100 на узел) и Frontier (четыре MI250 на узел). Написанный с использованием Fortran и OpenMP код доказал работоспособность и при масштабировании до более чем 500 вычислительных узлов Aurora. В целом, ускорители Intel Max 1550 демонстрируют хорошие результаты и не уступают NVIDIA H100: в некоторых задачах их относительная эффективность составляет не менее 0,82, но в большинстве других тестов этот показатель варьируется от 1,0 до 3,76. Очевидно, что у H100 появился достойный соперник, который, к тому же, имеет меньшую стоимость и большую доступность. Но сама NVIDIA уже представила чипы (G)H200, а AMD готовит Instinct MI300. Системы на базе Intel Max доступны в различном виде: как в облаке Intel Developer Cloud, так и в составе OEM-решений. Supermicro предлагает сервер с восемью модулями OAM, а Dell и Lenovo — решения с четырьями ускорителями в этом же формате. PCIe-вариант Max 1100 доступен от вышеуказанных производителей, а также у HPE. Помимо ускорителей Max, Intel привела и новые данные о производительности ИИ-сопроцессоров Gaudi2. Компания продолжает активно совершенствовать и оптимизировать программную экосистему Gaudi. В результате, в инференс-системе на базе модели GPT-J-6B результаты ускорителей Gaudi2 уже сопоставимы с NVIDIA H100 (SXM 80 Гбайт), а A100 существенно уступает как Gaudi2, так и Max 1550. Но самое интересное — это сведения о планах относительно следующего поколения Gaudi. Теперь известно, что Gaudi3 будет производиться с использованием 5-нм техпроцесса. Новый чип будет в четыре раза быстрее в вычислениях BF16, а также получит вдвое более мощную подсистему памяти и в 1,5 раза больше памяти HBM. Увидеть свет он должен в 2024 году. Заодно компания напомнила, что процессоры Xeon Emerald Rapids будут представлены ровно через месяц, а Granite Rapids появятся в 2024 году. В 2025 появится чип Falcon Shores, который теперь должен по задумке Intel сочетать в себе GPU и ИИ-сопроцессор. Он объединит архитектуры Habana и Xe в единое решение с тайловой компоновкой, памятью HBM3 и полной поддержкой CXL. Следует отметить, что такая унификация вполне реальна: Intel весьма активно развивает универсальный, гибкий и открытый стек технологий в рамках проекта oneAPI. В него входят все необходимые инструменты — от компиляторов и системных библиотек до средств интеграции с популярными движками аналитики данных, моделями и библиотеками искусственного интеллекта.

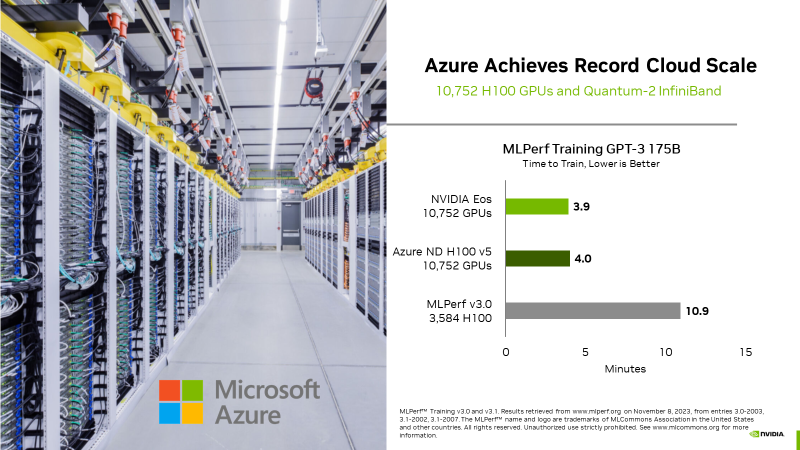

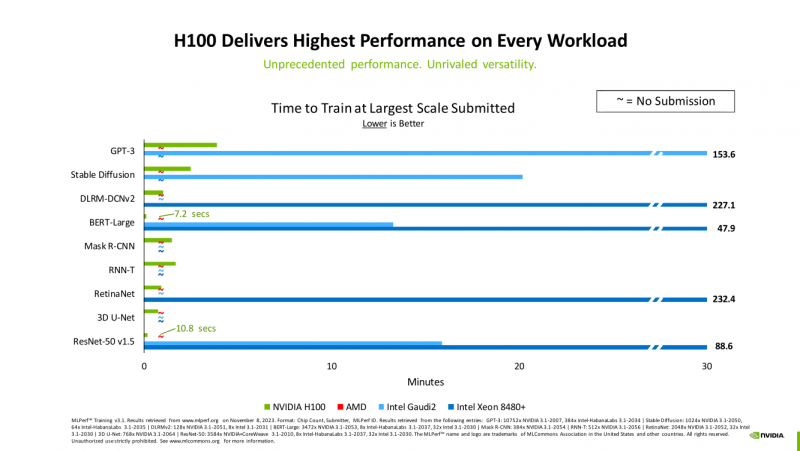

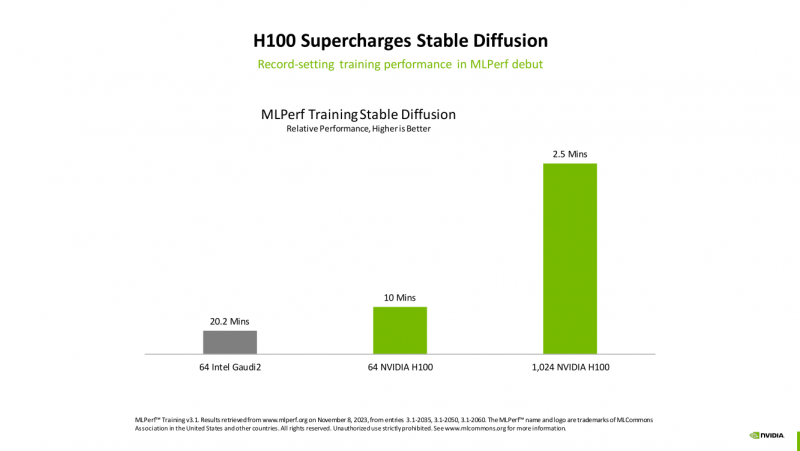

11.11.2023 [15:23], Сергей Карасёв

MLPerf: Intel улучшила производительность Gaudi2, но лидером остаётся NVIDIA H100Консорциум MLCommons обнародовал результаты тестирования различных аппаратных решений в бенчмарке MLPerf Training 3.1, который оценивает производительность на ИИ-операциях. Отмечается, что корпорация Intel смогла существенно увеличить быстродействие своего ускорителя Habana Gaudi2, но безоговорочным лидером остаётся NVIDIA H100. Тесты проводились на платформе Xeon Sapphire Rapids. Отмечается, что для некоторых задач Intel реализовала поддержку FP8-вычислений, благодаря чему производительность поднялась в два раза по сравнению с показателями, которые этот же ускоритель демонстрировал ранее. Согласно результатам тестов, в бенчмарке GPT-3 ускоритель Gaudi2 ровно в два раза проигрывает решению NVIDIA H100. То же самое касается теста Stable Diffusion: при этом нужно отметить, что Gaudi2 использовал формат BF16, а H100 — FP16. В ResNet эти ускорители демонстрируют сопоставимую производительность. В тесте BERT чип H100 при использовании FP8-вычислений показал значительное преимущество перед Gaudi2, который использовал формат BF16. Сама Intel отмечает, что с внедрением поддержки FP8 система с 384 ускорителями Gaudi2 способна завершить обучение GPT-3 за 153,58 мин. При использовании 64 чипов Gaudi2 тест Stable Diffusion может быть завершён за 20,2 мин (BF16). Для тестов BERT и ResNet-50 на восьми ускорителях Gaudi2 (BF16) результат составляет 13,27 и 15,92 мин соответственно. Вместе с тем стоимость и доступность ускорителей Intel, как считается, существенно лучше, чем у решений NVIDIA.

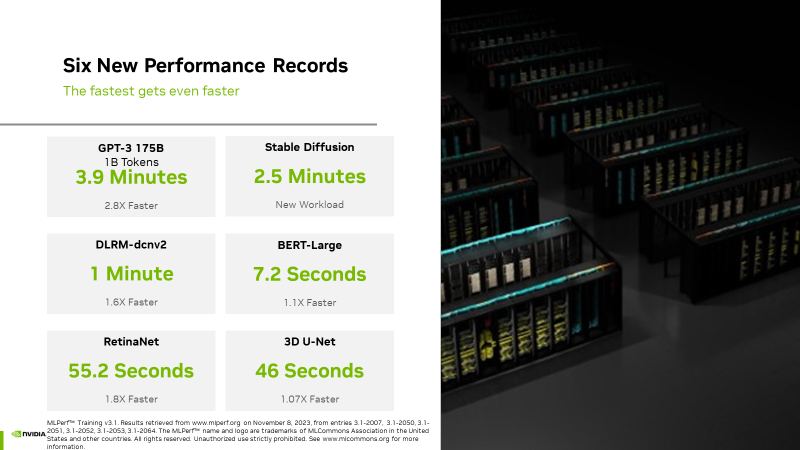

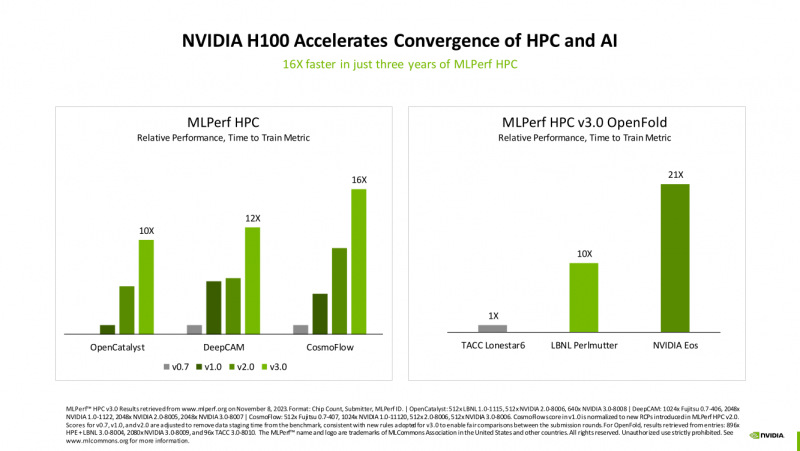

08.11.2023 [20:00], Игорь Осколков

Счёт на секунды: ИИ-суперкомпьютер NVIDIA EOS с 11 тыс. ускорителей H100 поставил рекорды в бенчмарках MLPerf TrainingВместе с публикацией результатов MLPerf Traning 3.1 компания NVIDIA официально представила новый ИИ-суперкомпьютер EOS, анонсированный ещё весной прошлого года. Правда, с того момента машина подросла — теперь включает сразу 10 752 ускорителя H100, а её FP8-производительность составляет 42,6 Эфлопс. Более того, практически такая же система есть и в распоряжении Microsoft Azure, и её «кусочек» может арендовать каждый, у кого найдётся достаточная сумма денег. Суммарно EOS обладает порядка 860 Тбайт памяти HBM3 с агрегированной пропускной способностью 36 Пбайт/с. У интерконнекта этот показатель составляет 1,1 Пбайт/с. В данном случае 32 узла DGX H100 объединены посредством NVLink в блок SuperPOD, а за весь остальной обмен данными отвечает 400G-сеть на базе коммутаторов Quantum-2 (InfiniBand NDR). В случае Microsoft Azure конфигурация машины практически идентичная с той лишь разницей, что для неё организован облачный доступ к кластерам. Но и сам EOS базируется на платформе DGX Cloud, хотя и развёрнутой локально. В рамках MLPerf Training установила шесть абсолютных рекордов в бенчмарках GPT-3 175B, Stable Diffusion (появился только в этом раунде), DLRM-dcnv2, BERT-Large, RetinaNet и 3D U-Net. NVIDIA на этот раз снова не удержалась и добавила щепотку маркетинга на свои графики — когда у тебя время исполнения теста исчисляется десятками секунд, сравнивать свои результаты с кратно меньшими по количеству ускорителей кластерами несколько неспортивно. Любопытно, что и на этот раз сравнивать H100 приходится с Habana Gaudi 2, поскольку Intel не стесняется показывать результаты тестов. NVIDIA очередной раз подчеркнула, что рекорды достигнуты благодаря оптимизациям аппаратной части (Transformer Engine) и программной, в том числе совместно с MLPerf, а также благодаря интерконнекту. Последний позволяет добиться эффективного масштабирования, близкого к линейному, что в столь крупных кластерах выходит на первый план. Это же справедливо и для бенчмарков из набора MLPerf HPC, где система EOS тоже поставила рекорд.

08.11.2023 [17:16], Руслан Авдеев

Перегрев ЦОД Equinix в Сингапуре привёл к срыву 2,5 млн банковских транзакцийТехнические проблемы, возникшие в сингапурском дата-центре Equinix в середине минувшего октября из-за перегрева, привели к серьёзным проблемам в банковской сфере. Как сообщает The Register со ссылкой на Валютное управление Сингапура (MAS), проблемы с системой охлаждения ЦОД привели к остановке 2,5 млн банковских операций. Проблема затронула DBS и Citibank, неприятности у которых начались днём 14 октября 2023 года — в результате клиенты частично утратили доступ к банковским услугам приблизительно на два дня, лишившись возможности осуществлять платежи. По данным властей в результате роста температуры в ЦОД выше допустимого уровня из-за нарушения работы системы охлаждения зарегистрировано 810 тыс. неудачных попыток доступа к двум банковским платформам, понадеявшихся на Equinix, а 2,5 млн онлайн-платежей и операций в банкоматах так и не были завершены. Сам оператор ЦОД винит подрядчика, поскольку его сотрудник якобы «неправильно» отправил сигнал на закрытие клапанов буферных резервуаров с холодной водой в ходе обновления инфраструктуры. Хотя банки немедленно приняли меры для возвращения работоспособности после инцидента, полностью восстановить системы с использованием резервных ЦОД сразу не удалось. DBS — из-за неправильной конфигурации сети, а Citibank из-за проблем с сетевым подключением. В результате оба банка не сумели уложиться в нормативы MAS, требующие, чтобы отключение критически важных систем, влияющих на банковские операции, не превышало 4 часов в год. Управление ввело ряд довольно жёстких наказаний для провинившихся банков сроком на полгода. По мнению экспертов, удивительно не только то, что система охлаждения не сработала, но и то, что банки не смогли своевременно отреагировать на сбой, введя в действие резервные мощности. Считается, что, как часто бывает, инцидент произошёл благодаря стечению неблагоприятных обстоятельств, поскольку на активацию резервной системы в норме уходят секунды или минуты. При этом MAS не контролирует деятельность провайдеров вроде Equinix.

28.10.2023 [14:12], Сергей Карасёв

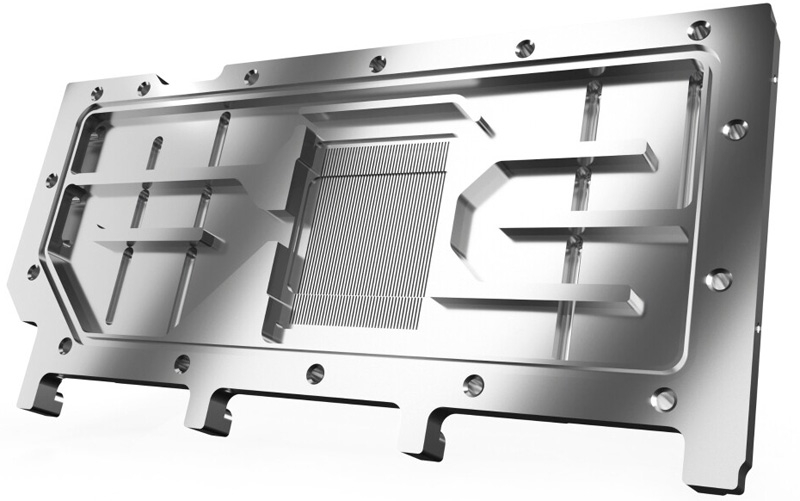

AlphaCool выпустила однослотовый водоблок за €300 для ускорителя NVIDIA H100Компания AlphaCool анонсировала водоблок ES H100 80GB HBM PCIe, предназначенный для использования в составе системы жидкостного охлаждения ускорителя NVIDIA H100. Новинка, получившая однослотовое исполнение, уже доступна для заказа по ориентировочной цене €300. Изделие полностью изготовлено из высококачественной хромированной меди. Верхняя часть водоблока выполнена из углеродного волокна. Новинка специально спроектирована для серверов с ограниченным внутренним пространством. В частности, коннекторы расположены в задней части изделия, благодаря чему упрощается прокладка шлангов. Это позволяет интегрировать решение в водяной контур даже в самых тесных корпусах.

Источник изображений: AlphaCool Задействованы фитинги стандарта G1/4". Габариты составляют 261,89 × 95,71 × 19,40 мм, а тыльная панель из алюминия чёрного цвета имеет размеры 261,89 × 95,71 × 4,00 мм. Максимальная рабочая температура — 60 °C. В комплект поставки входят термопрокладки толщиной 1 мм и термопаста Alphacool Apex с теплопроводностью 17 Вт/м·К.

25.10.2023 [14:46], Владимир Мироненко

«Рег.ру» задумался о скупке российских хостинг-провайдеровРегистратор доменных имён «Рег.ру» выразил желание приобрести российского хостинг-провайдера RUVDS, сообщили «Ведомости» со ссылкой на основателя и гендиректора RUVDS Никиту Цаплина, который получил письмо с предложением о покупке от директора по развитию партнёров группы компаний «Рег.ру» / Ru-Center (nic.ru). По словам Цаплина, подобные письма были разосланы «Рег.ру» ещё нескольким компаниям, названия которых он не стал уточнять. Он предположил, что «Рег.ру» поставил перед собой цель объединить ряд компаний под единым началом, создав тем самым нового крупного игрока, имея для этого необходимые финансовые возможности. Сам Цаплин не видит смысла в сделке с «Рег.ру».

Источник изображения: RuVDS С 1 декабря 2023 г. в соответствии с поправками к законам «Об информации, информационных технологиях и о защите информации» и «О связи» в России будет создан реестр хостинг-провайдеров, без включения в который их дальнейшая деятельность будет невозможна. Кроме того, к ним теперь предъявляется целый ряд требований. Не у всех провайдеров есть возможности для выполнения этих требований, чем и пытается воспользоваться «Рег.ру», который вместе с ещё одним крупным игроком рынка Ru-Center принадлежит холдингу РБК. Представитель «Рег.ру» подтвердил, что регистратор начал сбор предложений по продаже клиентских баз небольших провайдеров или бизнесов, «где хостинг не является основной или сколько-нибудь приоритетной услугой, а потому подготовка к включению в реестр не является экономически целесообразной».

23.10.2023 [15:57], Сергей Карасёв

Intel и Submer разрабатывают систему погружного охлаждения для киловаттных процессоров и ускорителейКомпании Intel и Submer сообщили о новом достижении в области разработки систем однофазного иммерсионного (погружения) жидкостного охлаждения: предложенная технология, как утверждается, позволяет эффективно отводить тепло от процессоров с показателем TDP до 1000 Вт.

Источник изображения: Submer Речь идёт о решении под названием Forced Convection Heat Sink (FCHS) — радиатор с принудительной конвекцией. Говорится, что технология сочетает «эффективность принудительной конвекции с пассивным охлаждением», позволяя отводить тепло от высокопроизводительных CPU и GPU. Система включает массивный радиатор с двумя винтами в одной из торцевых частей. Это является основным отличием от традиционной концепции пассивного иммерсионного охлаждения, основанного на естественной конвекции. «Погружной радиатор, использующий принудительную конвекцию, является ключевой инновацией, позволяющей вывести однофазное погружное охлаждение за пределы существующих барьеров», — заявляет Мохан Джей Кумар (Mohan J Kumar), научный сотрудник Intel. Отмечается, что некоторые элементы новой системы охлаждения могут быть изготовлены методом 3D-печати. Intel и Submer продемонстрировали, что решение способно справляться с охлаждением неназванного процессора Xeon, TDP которого превышает 800 Вт.

20.10.2023 [14:18], Владимир Мироненко

Облако в космосе: Blue Ring от Blue Origin предоставит хостинг на орбитеКомпания Blue Origin представила космическую платформу Blue Ring, ориентированную на обеспечение космической логистики и доставки. Её разработкой будет заниматься недавно созданное бизнес-подразделение In-Space Systems, возглавляемое старшим вице-президентом Полом Эбертцом (Paul Ebertz). Платформа, способная принимать полезную нагрузку весом более 3000 кг, будет предоставлять комплексные услуги, охватывающие логистику, транспортировку, дозаправку, хостинг, ретрансляцию данных и даже облачные вычисления в космосе. «Blue Ring предназначена для решения двух самых сложных задач в космических полётах на сегодняшний день: развитие космической инфраструктуры и повышение мобильности на орбите», — отметил Эберц. «Мы предлагаем нашим клиентам возможность легкого доступа и маневрирования на различных орбитах с минимальными затратами, имея при этом доступ к критически важным данным для обеспечения успешной миссии», — добавил он.

Источник изображения: Blue Origin Помимо целей и решаемых задач компания не стала раскрывать подробности о Blue Ring. В частности, неизвестно, когда планируется запустить эту платформу, и какие будут расценки на её услуги. Также в настоящее время нет никакой информации о том, в какой мере AWS будет участвовать в разработке облачных технологий на базе Blue Ring. AWS уже тестировала свои аппаратные и программные решения в космосе. |

|