Материалы по тегу: ии

|

20.07.2024 [14:36], Сергей Карасёв

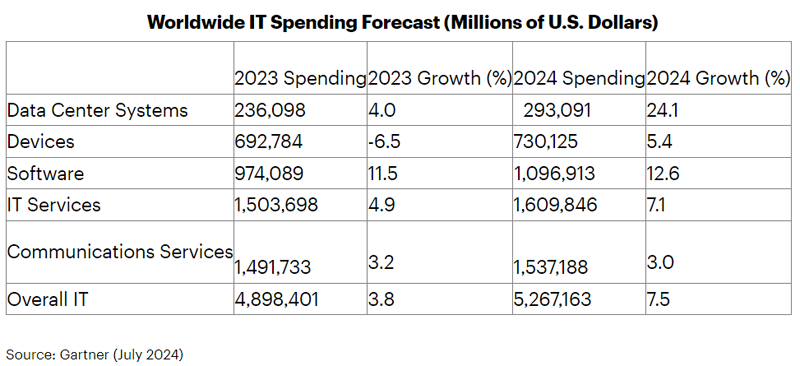

Gartner: затраты в области ЦОД в 2024 году вырастут почти на четвертьКомпания Gartner опубликовала свежий прогноз по мировому IT-рынку на 2024 год. Аналитики полагают, что расходы в области дата-центров в годовом исчислении увеличатся практически на четверть, что связано со стремительным развитием ИИ и облачных платформ. В 2023 году, по оценкам, общий объём мировой IT-отрасли достиг $4,9 трлн. Из них примерно $236,1 млрд пришлось на сегмент ЦОД. Ещё $974,1 млрд обеспечило ПО корпоративного класса. Затраты в области коммуникационных и IT-сервисов составили примерно по $1,5 трлн. Продажи различных электронных устройств обеспечили $692,8 млрд. По итогам 2024 года, полагают специалисты Gartner, объём мирового IT-рынка увеличится на 7,5 %, достигнув $5,3 трлн. Самым крупным сегментом станут IT-сервисы с расходами на уровне $1,6 трлн (плюс 7,1 % год к году). Расходы в сегменте коммуникационных сервисов прогнозируются на уровне $1,54 трлн с прибавкой в 3,0 %. Софт корпоративного класса принесёт $1,1 трлн, показав рост на 12,6 % в годовом исчислении. В сегменте устройств ожидается прибавка на 5,4 % — до $730,1 млрд.

Источник изображения: Gartner Вместе с тем, полагают аналитики Gartner, наилучшую динамику покажет сектор дата-центров: здесь затраты, согласно прогнозам, подскочат на 24,1 %, составив $293,1 млрд. Столь существенный скачок эксперты связывают с двумя факторами. В частности, компания NVIDIA, которая доминирует на рынке GPU-ускорителей для ИИ-серверов, решила большинство проблем с поставками своих продуктов. Дефицит ослабевает, а поставки решений для ЦОД растут. Вторая причина заключается в том, что ажиотаж вокруг ИИ, в том числе генеративного, вынуждает облачных провайдеров и гиперскейлеров наращивать вычислительные мощности. По оценкам Gartner, затраты на облачные инфраструктуры в 2024 году достигнут $70 млрд, а в 2025-м увеличатся вдвое, составив около $140 млрд. В 2028 году расходы могут подняться до $210 млрд.

20.07.2024 [00:19], Руслан Авдеев

Не виноватый ИИ: Google заявила, что развитие ИИ-сервисов на самом деле не так уж сильно повлияло на её выбросы углекислого газаНе так давно Google опубликовала доклад, в котором признала, что её выбросы CO2 в 2023 году выросли на 13 % год к году и на 48 % в сравнении с 2019 годом. Но главный научный сотрудник Google Джефф Дин (Jeff Dean) заявил, что ИИ напрасно обвиняют в росте выбросов углекислого газа компании, передаёт The Register. Он также подчеркнул, что бизнес по-прежнему намерен полностью перейти на «чистую» энергию к 2030 году. Причинами увеличения выбросов названы рост энергопотребления ЦОД, а также цепочки поставок компании. Однако публика неизбежно стала винить в росте выбросов именно ИИ, в том числе из-за того, что Google стремительно наращивала возможности своих ИИ-систем в последние годы. В интервью Fortune Дин заявил, что ИИ на деле не виноват в растущих выбросах ЦОД, поскольку на него приходится лишь малая часть вычислений, но признал, что этот сегмент растёт быстрыми темпами. Дин подтвердил, что Google не намерена отказываться от своей цели по полному переходу на чистую энергию к концу 2030 года, причём уклончиво добавил, что «прогресс в этом деле — вещь нелинейная». Например, некоторые проекты компании в области поставок безуглеродной энергии могут увенчаться успехом лишь годы спустя после старта. В ESG-докладе Google констатируется, что выбросы Scope 2 (в том числе от поставщиков энергии) увеличились на 37 %, составив 24 % от всех углеродных выбросов компании в 2023 году. При этом в компании утверждают, что все её энергопотребности на 100 % компенсируются закупками мощностей возобновляемых источников. В Google отметили, что она использует собственную методику подсчёта выбросов Scope 2, которая отличается от методики Greenhouse Gas (GHG).

Источник изображения: Janusz Walczak/unsplash.com Также в докладе Google утверждается, что хотя потребление всех ЦОД компании выросло на 17 %, достигнув 3,5 ТВт∙ч в 2023 году, сегментам бизнеса, связанных с облачными сервисами и поиском, удалось удержать средний показатель использования безуглеродной энергии на уровне 64 %. Каким образом IT-гигант намерен довести этот показатель до 100 %, если его энергетические аппетиты только растут, а ввод новых «зелёных» источников за ними не поспевает, не уточняется. Google — не единственная компания, имеющая проблемы с достижением поставленных экоцелей. Microsoft признаёт, что её выбросы CO2 выросли с в 2020 году на 29,1 %, но оправдывает это необходимостью строительства и оснащения всё большего числа ЦОД для удовлетворения спроса на облачные и ИИ-сервисы. Зато снизить их удалось AWS, хотя к корректности подсчёта выбросов компании тоже есть вопросы.

19.07.2024 [14:29], Владимир Мироненко

OpenAI обсуждала с Broadcom возможность создания собственного ИИ-ускорителяСтало известно, что компания OpenAI вела переговоры с разработчиками чипов, включая Broadcom, по поводу создания нового серверного ИИ-ускорителя. Сообщивший об этом ресурс The Information утверждает, что данная инициатива, которую возглавил руководитель OpenAI Сэм Альтман (Sam Altman), является частью более широкого плана по увеличению вычислительной мощности компании для разработки ИИ, преодолению дефицита ИИ-ускорителей и снижению зависимости от NVIDIA. На фоне этих сообщений акции Broadcom выросли на 3 %. По словам источников The Information, компания наняла несколько сотрудников Google, участвовавших в создании ИИ-ускорителей TPU. Примечательно, что Broadcom работала с Google над созданием TPU, а это означает, что у компании есть опыт разработки чипов для обработки ИИ-приложений. И у неё есть подразделение, которое занимается созданием кастомных ASIC. «Миру нужно больше инфраструктуры ИИ — больших мощностей, энергии, ЦОД и т. д. — чем в настоящее время планируют построить, — сказал ранее Альтман. — OpenAI постарается помочь!». В настоящее время доля рынка ИИ-чипов NVIDIA оценивается от 70 % до 95 % рынка, а это означает, что компании, занимающиеся ИИ, находятся в полной зависимости от неё с точки зрения доступа к вычислениям. Если OpenAI удастся создать свой ИИ-ускоритель, то ей больше не нужно будет всецело полагаться на NVIDIA.

Источник изображения: Broadcom Если бы такой чип был создан, его производство началось бы не раньше 2026 года, сообщил один из источников, поскольку отдельные детали всё ещё прорабатываются, включая вопросы упаковки и доступности памяти. Альтман вёл переговоры с южнокорейскими компаниями Samsung и SK Hynix о поставках HBM и обсуждал планы по производству чипов, сообщил The Information со ссылкой на информированные источники. Кроме того, Альтман общался с TSMC по поводу возможности выпуска нового чипа, а также увеличения поставок ИИ-ускорителей NVIDIA для его компании. OpenAI не стала подтверждать факты, изложенные в публикации The Information, но и не опровергла её. Представитель компании заявил, что «OpenAI ведёт постоянные переговоры с представителями отрасли и правительства о расширении доступа к инфраструктуре, необходимой для обеспечения широкой доступности преимуществ ИИ». Ускорители собственной разработки есть у Amazon (Trainium и Inferentia), Google (TPU), Microsoft (Maia), Meta✴ (MTIA), а также Tesla (D1). Однако все эти компании всё равно массово скупают ускорители NVIDIA для работы над ИИ или для предоставления их своим клиентам. И всё возрастающая стоимость оборудования их пока не останавливает, хотя новейший суперускоритель NVIDIA GB200 NVL72, как ожидается, будет стоить $3 млн.

19.07.2024 [12:49], Руслан Авдеев

Microsoft инвестировала в стартап Cyclic Materials, извлекающий редкоземельные элементы из старых HDDКомпания Microsoft обратила внимание на ценный источник редкоземельных элементов — отслужившие своё жёсткие диски. По данным Datacenter Dynamics, канадский стартап Cyclic Materials получил инвестиции в акционерный капитал от подконтрольной Microsoft структуры — Climate Innovation Fund. Условия финансирования не разглашаются. Основанная в 2021 году компания Cyclic Materials занимается переработкой металлов. Она разработала и запатентовала технологию CC360, позволяющую извлекать редкоземельное сырьё из HDD. Списанные жёсткие диски часто отправляются на утилизацию, в рамках которой в лучшем случае из комплектующих извлекаются преимущественно драгоценные металлы вроде золота и серебра, говорит стартап. Технология CC360 позволит отделять некоторые компоненты HDD для извлечения редкоземельных элементов, а оставшиеся фрагменты обрабатывать в обычном порядке. По словам представителя Climate Innovation Fund, в Microsoft работают над достижением нулевых выбросов к 2030 году переходу к «экономике замкнутого цикла». При этом важность редкоземельных элементов продолжает расти, а новые инвестиции помогут обеспечить их экобезопасные поставки. Поддержка Microsoft позволит Cyclic Materials ускорить внедрение коммерческих мощностей. Но технология будет полезна и другим крупным операторам дата-центров. Весной 2023 года Cyclic Materials закрыла раунд финансирования серии А, получив $27 млн. Раунд возглавили BMW i Ventures (BiV) и Energy Impact Partners (EIP), также в нём приняли участие Fifth Wall, Bioindustrial Innovation Canada (BIC) и инвестор Planetary Capital. Кроме того, в том же году т.н. Sustainable Development Technology Council of Canada (SDTC) вложил в стартап CA$3,6 млн ($2,6 млн). Недавно Cyclic Materials открыла в Кингстоне (Онтарио, Канада) завод Hub100 — первую в Северной Америке площадку для получения смеси редкоземельных оксидов (rMREO) с использованием проприетарной гидрометаллургической технологии REEPure. Hub100 ежегодно может перерабатывать до 100 т магнитных материалов в концентрат rMREO. Кроме того, попутно добываются соединения никеля и кобальта. Все их можно повторно использовать для создания новых продуктов. Впрочем, жёсткие диски можно не перерабатывать, а восстанавливать, очищать и снова продавать — именно этим с недавних пора занимается Seagate. Другими альтернативными методами переработки отходов занимается не только Microsoft. Например, Meta✴ и Mycocycle ещё в прошлом году начали эксперимент по утилизации отходов после строительства ЦОД с помощью грибов.

18.07.2024 [18:23], Руслан Авдеев

Четвёртый за год: NVIDIA приобрела ещё один облачный стартап — Brev.devNVIDIA приобрела стартап, помогающий ИИ-разработчикам найти среди предложений облачных провайдеров наиболее подходящий по соотношению цена/качество доступ к ускорителям. Как сообщает портал CRN, это уже четвёртая заметная покупка NVIDIA с начала года. Представитель NVIDIA подтвердил, что сделка по приобретению Brev.dev действительно состоялась, но сумму и условия сделки не сообщил. Brev.dev предоставляет платформу для создания, обучения и внедрения ИИ-моделей в облаках. Целью Brev.dev, по словам самого стартапа, является поиск простейшего способа использования ускорителей для разработчиков систем ИИ и машинного обучения. Сотрудничество с NVIDIA обеспечит выполнение этой миссии, с комбинацией максимально возможно производительной аппаратной составляющей с самым передовым программным обеспечением. На сайте Brev.dev официальными партнёрами стартапа названы NVIDIA, Intel и AWS. Там же говорится, что платформа служит единым интерфейсом для взаимодействия AWS, Google Cloud Platform, Fluidstack и прочими облаками с ИИ-ускорителями. Это позволяет разработчикам искать подходящие инстансы на основе их цены и доступности. Хотя NVIDIA поставляет GPU и ИИ-ускорители облачным провайдерам более десяти лет, в последние годы компания уделяет немало внимания расширению собственного бизнеса в сфере облачных инфраструктур.

Источник изображения: NVIDIA В прошлом году компания запустила сервис DGX Cloud, который развёрнут в облачной инфраструктуре других провайдеров и на собственных мощностях и ИИ-суперкомпьютерах. Ранее в этом году NVIDIA купила ещё два стартапа для развития возможностей DGX Cloud. В конце апреля компания анонсировала покупку израильского стартапа Run:ai, занимающегося решениями для оркестрации ИИ-инфраструктур. Его планируется интегрировать в DGX Cloud, а также с DGX- и HGX-серверами. По имеющимся данным, покупка Run:ai обошлась в $700 млн. Практически одновременно с Run:ai компания приобрела ещё один израильский стартап — Deci, предлагающий ПО, способное на любом железе ускорить инференс ИИ-моделей, сохраняя точность данных. Сделку, по слухам, оценили приблизительно в $300 млн. Наконец, месяц назад NVIDIA купила калифорнийский стартап Shoreline.io, основанный бывшим управленцем AWS — компания разрабатывает ПО для автоматического устранения проблем в инфраструктуре ЦОД. По некоторым данным, команда Shoreline присоединилась к DGX Cloud, а покупка обошлась в $100 млн.

17.07.2024 [23:33], Игорь Осколков

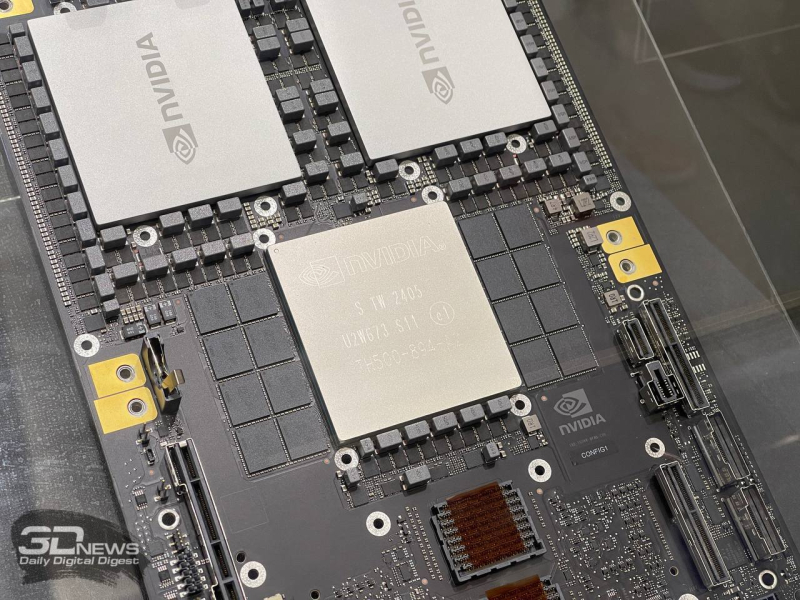

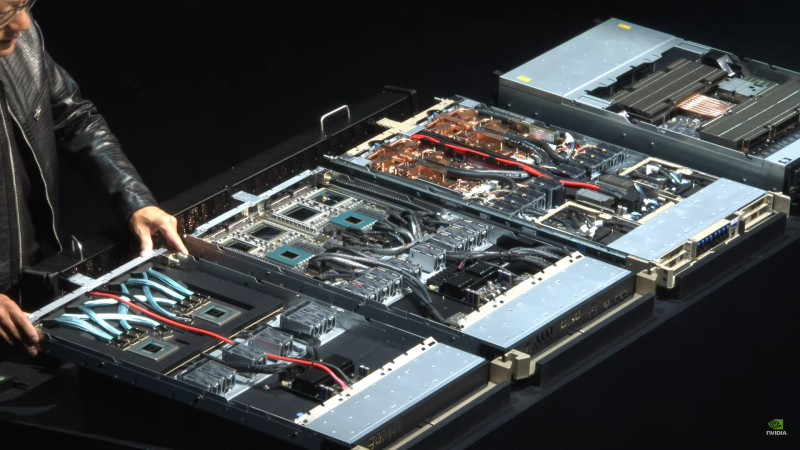

Суперускоритель по суперцене — NVIDIA GB200 NVL72, вероятно, будет стоить $3 млнКомпания NVIDIA значительно увеличила заказ на ускорители Blackwell у TSMC, сообщает TrendForce со ссылкой на United Daily News (UDN). По данным источника, NVIDIA намерена получить уже не 40 тыс., а 60 тыс. суперускорителей нового поколения, причём 50 тыс. из них придётся на стоечные системы GB200 NVL36. При этом Blackwell всё равно будут в дефиците, как и обещал ещё зимой глава NVIDIA Дженсен Хуанг (Jensen Huang). B200 включает два тайла, объединённых 2,5D-упаковкой CoWoS-L и соединённых интерконнектом NV-HBI. Чип имеет 208 млрд транзисторов, изготовленных по кастомному техпроцессу TSMC 4NP. GB200 объединяет два ускорителя B200 и один 72-ядерный Arm-процессор Grace. А суперускоритель GB200 NVL72, в свою очередь, объединяет в рамках одной стойки сразу 18 1U-узлов с парой GB200 в каждом (плата Bianca, 72 × B200 и 36 × Grace), провязанных шиной NVLink 5. Вся эта система потребляет порядка 120 кВт, оснащена СЖО и единой DC-шиной питания. Однако у GB200 NVL72 довольно специфические требования к окружению, поэтому NVIDIA предлагает суперускоритель попроще — GB200 NVL36, который как раз и должен стать наиболее массовым в данной серии. Эта платформа точно так же занимает целую стойку, но использует 2U-узлы с теми же платами Bianca (суммарно 36 × B200 и 18 × Grace), потребляя всего 66 кВт. При этом всё равно подразумевается использование двух стоек GB200 NVL36, объединённых интерконнектом, так что GB200 NVL72 всё равно получается более энергоэффективным решением. Как отмечает SemiAnalysis, GB200 NVL36 также будет доступен в варианте с платами Ariel, имеющими по одному чипу B200 и Grace. Наконец, во II квартале 2025 года появятся системы B200 NVL72 и B200 NVL36 с x86-процессорами (Miranda). Кроме того, NVIDIA представила и отдельные MGX-узлы GB200 NVL2 с парой GB200. В общем, ускорителей B200 компании понадобится много, чтобы наверняка удержать лидерство на рынке. По словам UDN, GB200 NVL36 будет стоить порядка $1,8 млн, а GB200 NVL72 обойдётся уже в $3 млн. Одиночный GB200 будет стоить $60–$70 тыс., а самый простой ускоритель B100 оценён в $30–$35 тыс. Нужно подчеркнуть, что это оценки сторонних аналитиков. Сама компания официально не раскрывает стоимость своих продуктов. Это устоявшаяся практика на данном рынке, против которой пошла только Intel, публично назвавшая стоимость ИИ-ускорителей Gaudi. Впрочем, ранее глава NVIDIA намекнул, что B200 будет стоить приблизительно $30–$40 тыс.

17.07.2024 [17:12], Владимир Мироненко

Swordfish Security предложила платформу AppSec.Code в качестве защищённой отечественной альтернативы GitLab

devops

git

gitlab

software

swordfish

swordfish security

импортозамещение

разработка

россия

сделано в россии

Компания AppSec Solutions (входит в ГК Swordfish Security) сообщила о включении в реестр российского ПО её собственной разработки — платформы AppSec.Code, представляющей собой аналог решения американской компании GitLab. Сообщается, что AppSec.Code является полноценной средой разработки ПО со встроенными функциями информационной безопасности, позволяющей разработчикам перенести код из внешних репозиториев в российскую среду. По словам компании, платформа AppSec.Code не уступает по функциональности премиальной версии GitLab Enterprise. Новая платформа интегрирована с ключевыми отечественными продуктами в сфере DevSecOps, подключаемыми через платформу оркестрации класса ASPM (Application Security Posture Management). Также имеется поддержка сертифицированной в РФ ОС Astra Linux, есть интеграция с российскими ИБ-сканерами для анализа защищенности исходного кода, библиотек с открытым исходным кодом, облачных контейнеров. AppSec Solutions отметила, что AppSec.Code имеет набор всех инструментальных средств для создания корпоративного ПО, где по умолчанию уже решены вопросы защищённости создаваемых продуктов — как с точки зрения разработки, так и с точки зрения полной независимости от вендоров из недружественных стран. Как ожидает AppSec Solutions, решение заинтересует, в первую очередь, крупный бизнес, «который не может приобрести лицензии на GitLab Enterprise и вынужден искать варианты миграции на аналоги, без больших временных и ресурсных затрат». В России уже имеется целый ряд локальных Git-сервисов крупных компаний: «РТК-Феникс» и «Лукоморье» («Ростелеком»), «Сфера» (Холдинг T1), GitVerse («Сбер»), GitFlic («РеСолют»), GitFlame («Иннополис») и Mos.Hub от правительства Москвы. Что касается проекта по созданию национального репозитория открытого кода, то он пока заморожен из-за отсутствия средств в бюджете. В Минцифры предлагают отказаться от идеи создания новой площадки и выбрать один из уже существующих общедоступных отечественных репозиториев.

17.07.2024 [11:21], Руслан Авдеев

Smart Global Holdings (SGH) сменит имя на Penguin SolutionsНа мероприятии Nasdaq MarketSite Analyst Day специалист по HPC-решениям Smart Global Holdings (SGH) объявил о намерении стать Penguin Solutions, Inc. HPCWire сообщает, что необычный ребрендинг продолжит трансформацию калифорнийской компании, идущую уже несколько лет. «Новая» Pengiun Solutions позиционирует себя как эксперт по комплексным инфраструктурным решениям в области ИИ. По словам представителя SGH, ИИ становится драйвером обеспечения конкурентных преимуществ во всех отраслях экономики. Большие языковые модели (LLM), ИИ-аналитика, симуляции и другие связанные темы приобретают критически важное значение, поэтому предприятия любого масштаба стремятся к внедрению систем искусственного интеллекта. В компании отмечают, что ИИ-инфраструктура невероятно сложна и значительно отличается от традиционных корпоративных IT-решений, требует новых технологических навыков, которые у многих организаций всё ещё отсутствуют. Зачастую сложность ИИ-технологий ведёт к их медленному внедрению, использованию неэффективных систем и нереализованной прибыли на инвестиции.

Источник изображения: Businesswire/SGH SGH поглотила Penguin Solutions в 2018 году, так что теперь у неё есть более 25 лет опыта работы с HPC-системами. Компания внедрила и управляет более 75 тыс. ускорителей — она фактически уже является доверенным партнёром для многих клиентов, желающих использовать возможности ИИ. Решение SGH поменять имя строится на заработанной ранее репутации и знаменует новую для компании эру. Ожидается, что SGH завершит своё превращение в Penguin Solutions в этом году после одобрения акционерами. Cree LED — подразделение SGH, сохранит свою идентичность и продолжит вести дела под прежним именем. Ребрендинг — не единственное важное изменение для компании в этом году. Южнокорейская SK Holdings намерена вложить $200 млн в развитие её бизнеса в обмен на акции.

17.07.2024 [11:21], Руслан Авдеев

SK Telecom инвестирует $200 млн в Smart Global Holdings (Penguin Solutions) для совместной работы над ИИ- и HPC-инфраструктуройЮжнокорейская телекоммуникационая компания SK Telecom вложит $200 млн в бизнес Smart Global Holdings (SGH), связанный с системами искусственного интеллекта и инфраструктурными ИИ-проектами. По данным Datacenter Dynamics, в обмен на инвестиции SK получит часть акций SGH. В дальнейшем компании намерены совместно работать над использованием «взаимодополняющих возможностей» для расширения спектра предложений клиентам и создания дифференцированных комплексных решений и сервисов в области ИИ и дата-центров, предлагать передовые решения для рынка памяти и периферийных ИИ-серверов на базе NPU-чипов. Калифорнийская SGH уже продаёт ряд платформ и сервисов для HPC, ИИ, машинного обучения, отказоустойчивых вычислений и Интернета вещей, в том числе периферийные и облачные решения. Благодаря приобретению в 2018 году бизнеса Penguin Solutions компания предлагает интегрированные ИИ-решения для ЦОД, от разработки ИИ-кластеров до внедрения и поддержки эксплуатации таких продуктов. Совсем недавно компания объявила о ребрнединге — теперь SGH почти полностью уходит под «зонтик» Penguin Solutions, компания должна сменить имя до конца текущего года. Стоит отметить, что Penguin Solutions известна как поставщик HPC-решений для государственных и военных ведомств США.

Источник изображения: Alexander Schimmeck/unsplash.com Глава SGH поприветствовал SK Telecom в качестве нового стратегического инвестора, заявив, что новость стала свидетельством возможностей Penguin Solutions по внедрению в больших масштабах «фабрик ИИ», ПО и прочих решений. Ожидается, что сотрудничество принесёт немало выгоды и акционерам. Ранее в текущем году SGH приняла участие в раунде финансирования серии C другой компании — Lambda Labs, привлёкшей $320 млн. SK Telecom получит 200 тыс. привилегированных акций в SGH, которые она сможет конвертировать в простые акции по цене $32,81 каждая. Компания расширяет своё ИИ-портофолио. В прошлом году она инвестировала $100 млн в Anthropic, стоящей за серией LLM Claude. По словам представителя SK Telecom, инвестиции и дальнейшее сотрудничество укрепит позиции южнокорейского гиганта в сфере ИИ.

16.07.2024 [22:32], Владимир Мироненко

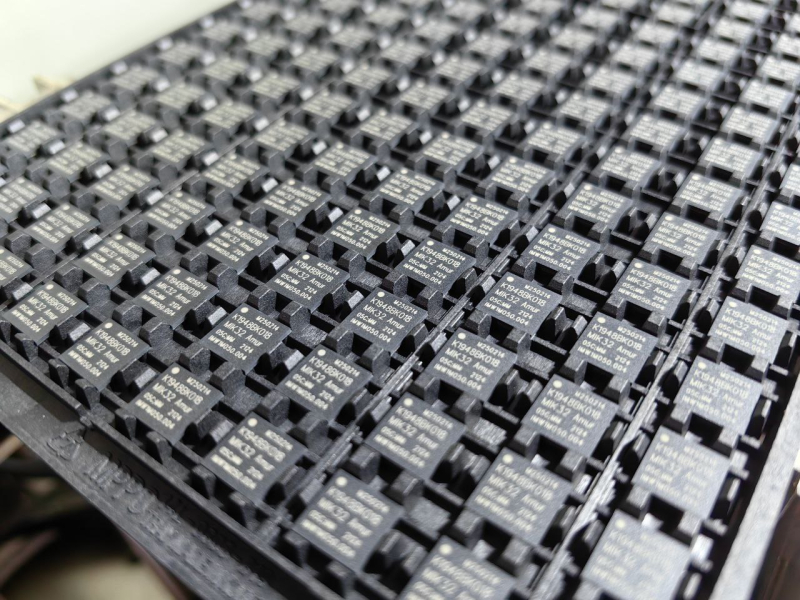

GS Group отгрузила 100 тыс. российских микроконтроллеров «MIK32 Амур» на базе RISC-V — ещё 400 тыс. на подходеПредприятие GS Nanotech из Калининграда, входящее в холдинг GS Group, сообщило о сборке и отгрузке по заказу АО «Микрон» стотысячной партии микроконтроллеров «MIK32 Амур» на открытой архитектуре RISC-V. По словам АО «Микрон», в связи с высоким спросом и в целях наращивания объёмов корпусирования изделий, дополнительно к собственному сборочному производству компания использует мощности предприятия GS Nanotech, которое в рамках соглашения до конца года соберёт в корпус до 0,5 млн микроконтроллеров «Амур». «Мы имеем большой опыт по корпусированию микроконтроллеров и рады применить его в сотрудничестве с нашим давним партнёром», — заявил вице-президент GS Group по развитию производства. Как сообщается, в ходе выполнения заказа GS Nanotech использовала опыт, накопленный ранее при крупносерийной сборке чипов в корпусах BGA, LGA, а также сложных многовыводных микросхем, в том числе по технологии SiP (системы-в-корпусе). Благодаря этому показатель выхода годной продукции составил 99,2 %. Также предприятием была разработана тестовая программа для контроля полного соответствия заявленным характеристикам микроконтроллеров. «MIK32 Амур» (К1949ВК018) представляет собой первый полностью отечественный 32-бит микроконтроллер с ядром на архитектуре RISC-V, который был разработан и производится в России ГК «Элемент» (разработка совместно с НИИМА «Прогресс», производство «Микрона»). Изделие включено в Единый реестр российской радиоэлектронной продукции (ПП РФ 878) и его производство не зависит от лицензируемой зарубежной интеллектуальной собственности. |

|