Материалы по тегу: ии

|

06.05.2025 [12:43], Андрей Крупин

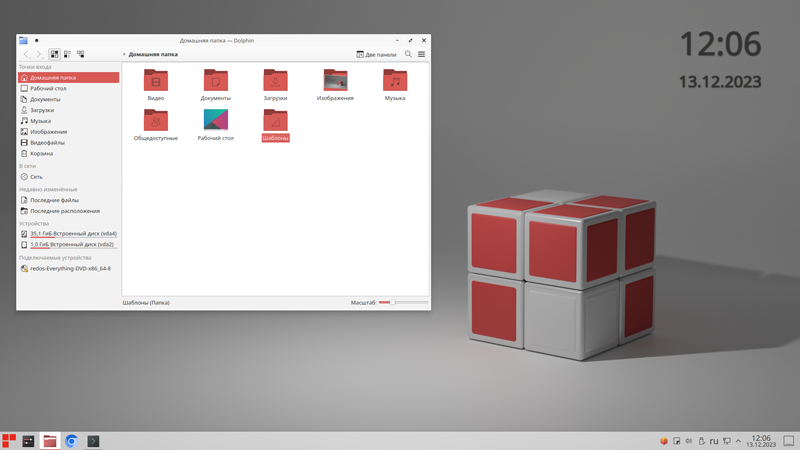

Состоялся релиз отечественной «Ред ОС» 8 для Arm-платформКомпания «Ред Софт» сообщила о доступности установочных ISO-образов операционной системы «Ред ОС» 8 для устройств на базе процессоров с Arm-архитектурой. Программная платформа «Ред ОС» построена на базе ядра Linux, относится к классу операционных систем общего назначения и поставляется на рынок в конфигурациях «Рабочая станция» и «Сервер». Система может применяться для решения офисных задач, организации совместной работы, а также для развёртывания доменной инфраструктуры, файловых хранилищ, почтовых серверов и различных сервисов в составе корпоративной IT-среды. «Ред ОС» включена в реестр российского ПО как рекомендованная для закупки отечественными организациями и государственными структурами. В соответствии с лицензионным соглашением, физические лица могут использовать ОС бесплатно для личных целей. Поддержка «Ред ОС» восьмой версии будет обеспечиваться до 2028 года включительно.

Пользовательский интерфейс «Ред ОС» (источник изображения: redos.red-soft.ru) Ожидается, что реализация поддержки процессоров на архитектуре Arm в «Ред ОС» 8 позволит отечественным организациям снизить зависимость от зарубежного аппаратного обеспечения и значительно расширит сценарии применения продукта. В частности, система может использоваться в качестве рабочего окружения для серверов и рабочих станций, а также входить в состав промышленных решений. Например, обеспечивать функционирование компонентов АСУ ТП. Работоспособность ОС уже подтверждена для российских процессоров «Байкал-М» и «Байкал-S». Также платформа демонстрирует стабильную и корректную работу на чипах серий Ampere Altra и Huawei Kunpeng. «Поддержка процессоров на базе архитектуры Arm позволит значительно расширить набор сценариев для работы с «Ред ОС» 8, а также сделать операционную систему доступнее для большего круга пользователей. Во-первых, мы закрываем потребности пользователей, ранее внедривших решения на базе архитектуры Arm и сейчас находящихся в поиске подходящей платформы. Во-вторых, мы расширяем возможности выбора аппаратных решений для российских компаний, планирующих и осуществляющих переход на отечественное ПО, включая операционную систему», — прокомментировал Рустам Рустамов, заместитель генерального директора «Ред Софт».

06.05.2025 [11:12], Сергей Карасёв

Nebius внедрит системы хранения DDN в свою ИИ-инфраструктуруКомпания DataDirect Networks (DDN), специализирующаяся на системах хранения данных для НРС, объявила о заключении партнёрского соглашения с разработчиком ИИ-решений Nebius (бывшая материнская структура «Яндекса»). В рамках соглашения стороны займутся созданием высокопроизводительной подсистемы хранения данных для ресурсоёмких ИИ-задач. Речь идёт об интеграции решений DDN Infinia и EXAScaler в облачную инфраструктуру Nebius AI Cloud. Эти системы будут использоваться для хранения данных, предназначенных для обучения больших языковых моделей, инференса и поддержания работы ИИ-приложений в реальном времени. По заявлениям DDN, Infinia гарантирует надёжность и передовую производительность, благодаря чему ускоряется обучение и развёртывание моделей ИИ. Вместе с тем EXAScaler обеспечивает высокую пропускную способность и согласованность операций ввода-вывода. Другим преимуществом названных решений является возможность масштабирования в рамках облачных и локальных развёртываний: заказчики смогут быстро наращивать ресурсы в ИИ-облаке Nebius, гибридных и изолированных средах, используя параллельную файловую систему EXAScaler.

Источник изображения: Nebius Утверждается, что Infinia и EXAScaler устраняют проблемы с задержками при обработке данных. В результате, нагрузки ИИ могут обрабатываться с максимальной эффективностью — даже в случае моделей с несколькими триллионами параметров. В целом, как отмечают партнёры, благодаря интеграции систем DDN в облако Nebius клиенты смогут решать ИИ-задачи с более высокой скоростью и с меньшими временными и финансовыми затратами.

05.05.2025 [20:06], Владимир Мироненко

Google и Broadcom совместно обеспечат кибербезопасность своих решенийПоскольку мир становится всё более зависимым от цифровой инфраструктуры, кибербезопасность превратилась из вспомогательной функции в основополагающий элемент, пишет ресурс SiliconANGLE. Следовательно, она должна быть интегрирована на всех уровнях технологического стека — от оборудования до программного обеспечения, сетей и пользовательского опыта. Сотрудничество Google Cloud и Broadcom является наглядным подтверждением этого тезиса. Роберт Садовски (Robert Sadowski), директор по маркетингу продуктов, безопасности и доверию Google Cloud, и Джейсон Роллстон (Jason Rolleston), генеральный менеджер Enterprise Security Group компании Broadcom, в ходе общения на конференции RSAC 2025 рассказали, как Google Cloud и Broadcom объединяют тесную интеграцию, ИИ и десятилетия эволюции ПО для создания решений по кибербезопасности следующего поколения.

Источник изображения: FlyD/unsplash.com Как пояснил Садовски, компания, разработавшая инновационные технологии для таких продуктов, как Google Search и Android, предлагает возможности своей платформы и решения по обеспечению безопасности предприятиям и партнёрам, таким как Broadcom, чтобы те могли создавать и внедрять инновации в собственные продукты. Аналогичным образом Google поступила с Cloud WAN — полностью управляемой корпоративной платформой для подключения к сетевой инфраструктуре Google. В свою очередь, Роллстон подчеркнул, что Google Cloud WAN — это не просто сетевой продукт, а защищённая, масштабируемая и глобально распределённая магистраль, которая позволяет Broadcom развёртывать решения по периметру служб безопасности в масштабе, обеспечивая низкую задержку, высокую производительность и последовательное применение политик в любой точке мира. По его словам, Broadcom использовала это решение для обнаружения и нейтрализации нисходящих угроз, распространяющихся в нижних звеньях цепочки распределения сети. Собеседники отметили, что хотя ИИ обеспечивает такие инновации, как предиктивная аналитика и обнаружение угроз в реальном времени, он также создаёт огромные объёмы данных и открывает новые векторы атак. Топ-менеджеры сообщили, что Google Cloud и Broadcom изначально интегрируют ИИ в функции безопасности своих продуктов. Это позволяет автоматизировать обнаружение, обеспечить расширенную веб-изоляцию и адаптивное применение политик без ущерба для производительности.

05.05.2025 [13:28], Сергей Карасёв

GigaIO и d-Matrix предоставят инференс-платформу для масштабных ИИ-развёртыванийКомпании GigaIO и d-Matrix объявили о стратегическом партнёрстве с целью создания «самого масштабируемого в мире» решения для инференса, ориентированного на крупные предприятия, которые разворачивают ИИ в большом масштабе. Ожидается, что новая платформа поможет устранить узкие места в плане производительности и упростить внедрение крупных ИИ-систем. В рамках сотрудничества осуществлена интеграция ИИ-ускорителей d-Matrix Corsair в состав НРС-платформы GigaIO SuperNODE. Архитектура Corsair основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC), работающих на скорости около 150 Тбайт/с. По заявлениям d-Matrix, ускоритель обеспечивает непревзойдённую производительность и эффективность инференса для генеративного ИИ. Устройство выполнено в виде карты расширения с интерфейсом PCIe 5.0 х16. Быстродействие достигает 2,4 Пфлопс с (8-бит вычисления). Изделие имеет двухслотовое исполнение, а показатель TDP равен 600 Вт. В свою очередь, SuperNODE использует фирменную архитектуру FabreX на базе PCIe, которая позволяет объединять различные компоненты, включая GPU, FPGA и пулы памяти. По сравнению с обычными серверными кластерами SuperNODE обеспечивает более эффективное использование ресурсов.

Источник изображения: d-Matrix Новая модификация SuperNODE поддерживает десятки ускорителей Corsair в одном узле. Производительность составляет до 30 тыс. токенов в секунду при времени обработки 2 мс на токен для таких моделей, как Llama3 70B. По сравнению с решениями на базе GPU обещаны трёхкратное повышение энергоэффективности и в три раза более высокое быстродействие при сопоставимой стоимости владения. «Наша система избавляет от необходимости создания сложных многоузловых конфигураций и упрощает развёртывание, позволяя предприятиям быстро адаптироваться к меняющимся рабочим нагрузкам ИИ, при этом значительно улучшая совокупную стоимость владения и операционную эффективность», — говорит Alan Benjamin (Алан Бенджамин), генеральный директор GigaIO.

05.05.2025 [12:47], Сергей Карасёв

Терабитное облако: Backblaze запустила S3-хранилище B2 Overdrive для рабочих нагрузок ИИ и HPCАмериканская компания Backblaze анонсировала облачное S3-хранилище B2 Overdrive, оптимизированное для нагрузок с интенсивным обменом данными, таких как задачи ИИ и НРС. Утверждается, что платформа в плане соотношения производительности/цены значительно превосходит предложения конкурентов. Backblaze отмечает, что при работе с ресурсоёмкими приложениями ИИ, машинного обучения, доставки контента или аналитики, клиенты зачастую сталкиваются с выбором: платить больше за максимальную скорость доступа к облаку или жертвовать производительностью, чтобы сохранить расходы на приемлемом уровне. B2 Overdrive, как утверждается, решает эту проблему. Новый сервис обеспечивает пропускную способность до 1 Тбит/с, а цена начинается с $15 за 1 Тбайт в месяц. Минимальный заказ — несколько Пбайт. Заявленный показатель безотказного функционирования — 99,9 %. Предоставляется бесплатный вывод данных из облака в трехкратном среднем ежемесячном объёме хранения клиента. После превышения этого значения стоимость составляет $0,01 за 1 Гбайт. Скидки за объём и сроки хранения доступны с сервисом B2 Reserve. Для хранения данных в облаке B2 Overdrive применяются HDD. Подключение к инфраструктуре клиента осуществляется через защищённую частную сеть. Информацию в экзабайтном масштабе можно свободно перемещать в любой кластер GPU или HPC с неограниченным бесплатным выводом. Среди прочих преимуществ B2 Overdrive компания Backblaze выделяет отсутствие требований к минимальному размеру файлов, уведомления о событиях, а также бесплатное удаление информации. Приём заявок на подключение к сервису уже начался.

05.05.2025 [12:38], Сергей Карасёв

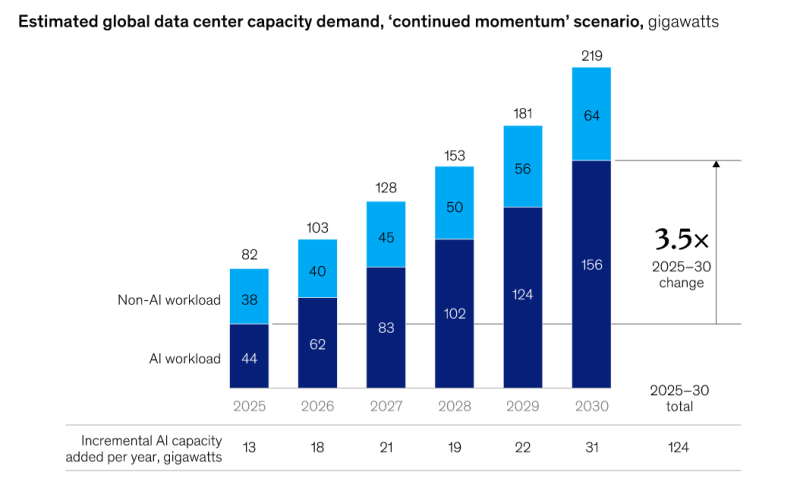

McKinsey: инвестиции в ИИ ЦОД к 2030 году превысят $5 трлнКонсалтинговая компания McKinsey обнародовала прогноз по развитию дата-центров в глобальном масштабе до 2030 года. Аналитики отмечают, что ключевым драйвером отрасли будет оставаться ИИ, а операторы ЦОД и гиперскейлеры продолжат активно наращивать мощности. В общей сложности, как ожидается, капиталовложения в дата-центры по всему миру к концу десятилетия достигнут $6,7 трлн. Из этой суммы, полагают специалисты McKinsey, примерно $5,2 трлн будет потрачено на объекты, оптимизированные для задач ИИ, а оставшиеся $1,5 трлн — на ЦОД, рассчитанные на традиционные рабочие нагрузки. Если прогноз McKinsey оправдается, то в ИИ-сегменте из общей суммы в $5,2 трлн на строительные работы пойдёт приблизительно 15 %, или $800 млрд: это средства на землю, материалы и возведение необходимых сооружений. Ещё около 25 %, или $1,3 трлн, составят затраты, связанные с поставками и использованием энергии, включая электрическую инфраструктуру (трансформаторы, генераторы) и системы охлаждения. Оставшиеся 60 %, или $3,1 трлн, будут направлены на закупки необходимого IT-оборудования и систем, в том числе серверов, GPU-ускорителей, стоечных решений и пр. Вместе с инвестициями будут расти и мощности дата-центров. В 2025 году общемировой показатель, по данным McKinsey, окажется на уровне 82 ГВт, из которых 44 ГВт придётся на ИИ-нагрузки, ещё 38 ГВт — на традиционные задачи. К 2030 году суммарная мощность ЦОД достигнет 219 ГВт, в том числе 156 ГВт под нагрузки ИИ и 64 ГВт под прочие задачи. Таким образом, общая мощность дата-центров для приложений ИИ в период 2025–2030 гг. поднимется приблизительно в 3,5 раза.

05.05.2025 [10:37], Татьяна Золотова

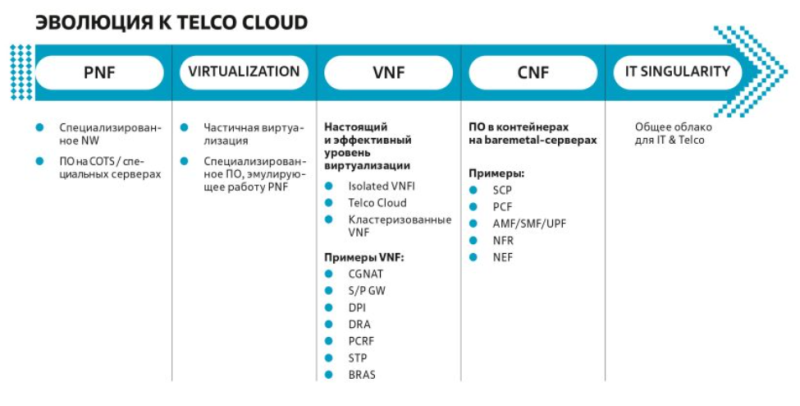

«Билайн» внедрил облачную платформу для виртуализации сетевых функцийСотовый оператор «Вымпелком» (бренд «Билайн») и разработчик ИТ-решений «Инфосистемы джет» разработали единую географически распределенную платформу виртуализации и контейнеризации сетевых функций Telco Cloud. Она представляет собой облачную инфраструктуру для запуска сетевых функций как в виртуализированном (VNF), так и в контейнеризированном исполнении (CNF). ПАК Telco Cloud, разработанный «Инфосистемами джет», — это большое комплексное решение, собранное из отдельных компонентов, в число которых входят: серверное оборудование с унифицированными вариантами конфигурации серверов; аппаратные СХД, аналогичные Huawei Dorado; сетевая фабрика, которая является трехуровневой моделью L2/LЗ-фабрики с поддержкой EVPN-VXLAN, ЕСМР, Multihoming и автоматизированным управлением. Технически это White Вох с открытой NOS на базе SONiC. Решение внедрено на сети «Билайна», в основных дата-центрах, включая ярославский и московский ЦОД, площадки во Владивостоке и Новосибирске. Для части этих ЦОД Telco Cloud внедрен в георезервированном виде для обеспечения надежности и отказоустойчивости. В планах до конца года внедрить георезерирование для всех дата-центров, где уже развернута облачная инфраструктура. Как отмечают в пресс-службе сотового оператора, платформа снижает затраты на инфраструктуру, повышает эффективность и скорость выхода новых продуктов на рынок. В «Билайне» надеются, что облачная инфраструктура Telco Cloud снизит зависимость от конкретных поставщиков, а также позволит в сжатые сроки внедрять альтернативные сетевые функции.

04.05.2025 [21:18], Владимир Мироненко

Три к одному: корпоративные заказчики в России нарастили закупки отечественных серверовВ 2024 году корпоративные заказчики гораздо больше закупали отечественных серверов, чем зарубежных — в примерном соотношении три к одному, несмотря на то что у многих компаний IT-инфраструктура базируется на зарубежном оборудовании, сообщил Forbes со ссылкой на данные IT-холдинга Fplus. Согласно прогнозу Fplus, такое соотношение сохранится и в ближайшие годы, хотя доля в объёме закупок российского оборудования будет понемногу увеличиваться. Согласно оценкам Fplus, объём рынка российских серверов составляет 100–110 млрд руб. при общем объёме (с учётом зарубежного оборудования) в 151 млрд руб., в количественном выражении — 130–150 тыс. единиц. При этом доля отечественных серверов в денежном выражении выросла на четверть. В Топ-5 ведущих производителей входят YADRO, «Аквариус», Depo Computers, Kraftway и Fplus, доля продукции которых в общем объёме поставок не указана. По словам представителя Fplus, в основном в качестве заказчиков серверов выступают компании, владеющие крупной критической инфраструктурой (корпорации с госучастием, финансовый сектор, транспорт, нефтегазовый сектор, госсектор). Также традиционно закупки серверов осуществляют сервис-провайдеры, телеком-операторы и операторы ЦОД. «Наибольшую долю запросов (80 %) составляют серверы общего назначения. Спрос на архитектуру и процессоры, отличные от x86, незначительный», — сообщили в Fplus. То, что многие компании продолжают использовать существующую IT-инфраструктуру, построенную на иностранном оборудовании, эксперты объясняют тем, что на создание инфраструктуры, специально настроенной под российское «железо», требуются значительные инвестиции. Но никто не будет выделять средства без понимания, что отсутствие иностранных вендоров — это всерьёз и надолго. Также в Fplus сообщили, что отечественные производители ощутимо отстают в производстве ИИ-серверов. При этом не все эксперты разделяют мнение по поводу роста российского рынка серверов в 2024 году в количественном выражении, поскольку некоторые считают, что крупный бизнес — банки, телеком-провайдеры, промышленные и госкомпании — чаще покупал мощные системы с высокой стоимостью за единицу.

04.05.2025 [08:49], Татьяна Золотова

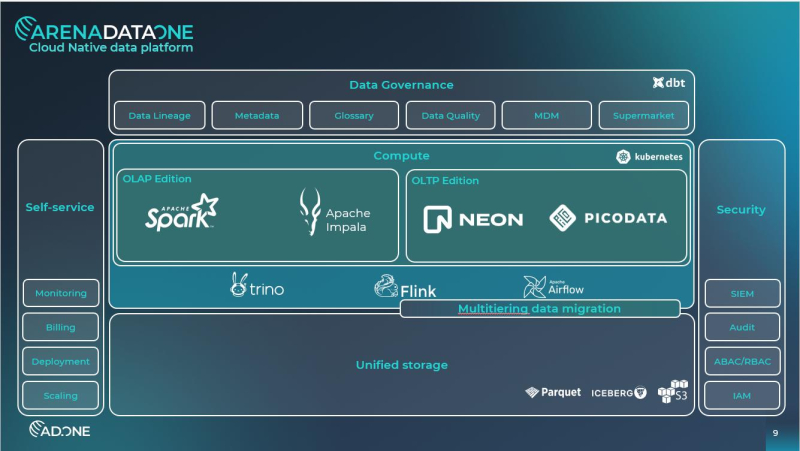

Arenadata запустила облачную платформу Arenadata OneArenadata представила Arenadata One (AD.One) — cloud-native-платформу для обработки и хранения данных. Она предназначена для работы в эластичной облачной инфраструктуре под управлением Kubernetes и совместима с объектным S3-хранилищем. AD.One решает такие задачи, как построение lakehouse, real-time-аналитика, хранение векторов и features, база данных по требованию. Согласно исследованиям Arenadata, в крупных компаниях аналитические СУБД простаивают 40–50 % рабочего времени. Разработчик объясняет это тем, что классические технологии для аналитических и транзакционных задач, размещенные на bare-metal для максимальной производительности при однородных спланированных нагрузках, требуют резервирования оборудования в кластере, чтобы была возможность справляться с пиковыми нагрузками. Это в свою очередь ведет к простоям «железа» и увеличению стоимости владения системой хранения. Arenadata One сочетает мультитенантную архитектуру с низким T2M (time-to-market) DBaaS. Платформа обеспечивает изолированное обслуживание различных групп пользователей в рамках единой инфраструктуры, одновременно предлагая технологии для быстрого развертывания баз данных «по требованию». При этом DBaaS-платформа может быть развёрнуты и на инфраструктуре заказчика. Среди основных особенностей Arenadata One ее разработчики называют архитектурное разделение слоёв выисления и хранения, интегрированное cloud-native OLTP- и AI-хранилище, уменьшение затрат на хранение и обработку данных, повышенная окупаемость инвестиций (ROI), снижение совокупной стоимости владения (TCO) и сокращение времени вывода продуктов на рынок (T2M). Кроме того, отмечаются такие функции как multi-tier-архитектура, Data Governance (интегрированное средство управления моделью, качеством и связанностью данных), и Hybrid Cloud для построения гибридного облачного хранения.

04.05.2025 [01:05], Руслан Авдеев

Google призвала к реформам в области энергетики и внедрению малых модульных реакторовGoogle призывает политиков США заняться модернизацией энергетической и бюрократической систем для удовлетворения растущих потребностей ИИ ЦОД. В недавно опубликованном документе Powering a New Era of American Innovation руководство Google призвало Конгресс США и федеральные ведомства оптимизировать процессы выдачи профильных разрешений, ускорить строительство линий электропередачи (ЛЭП) и расширить доступ к источникам «чистой» энергии, в том числе — поддержать атомные технологии вроде малых модульных реакторов (SMR). В документе утверждается, что стремительный рост ИИ-нагрузок потребует масштабного расширения инфраструктуры в США, которое бывает «раз в поколение». Эксперты предупреждают, что без быстрой выдачи разрешений регуляторами и «энергетической диверсификации» Соединённые Штаты могут отстать в гонке за глобальную технологическую конкурентоспособность. Сама Google обязуется инвестировать в «чистую» энергию, в т.ч. долгосрочные закупки «безуглеродного» электричества. Федеральные власти компания призывает усилить специальные программы вроде LPO Министерства энергетики, а также продвигать технологии нового поколения вроде современных геотермальных электростанций и SMR — помимо проектов солнечной и ветряной энергии для ЦОД. В частности, конгрессменов призывают модернизировать федеральную систему выдачи разрешений, упростив процесс утверждения проектов в сфере ЦОД и энергетики, а малым ядерным реакторам рекомендуют обеспечить федеральную поддержку. То же относится и к геотермальным проектам, которые относятся к «чистым и надёжным» источникам энергии. Компания также намерена добиваться расширения ЛЭП с попутным реформированием подхода к распределению затрат в данном секторе. В Google поддерживают дальнейшее финансирование Управления программ кредитования Министерства энергетики США (Loan Programs Office, LPO) для того, чтобы ускорить внедрение чистой энергии. Особое внимание уделяется необходимости обучения квалифицированной рабочей силы, в т.ч. 100 тыс. электриков и 30 тыс. помощников для ИИ-инфраструктуры. В компании предупредили, что ИИ-инфраструктура способна стагнировать без серьёзных реформ в генерации, передаче и обеспечении доступности электроэнергии. Сама Google участвует во многих энергетических проектах. Например, в июне 2024 года сообщалось, что Google запитает от геотермальной энергии ЦОД в Неваде, в декабре 2024 года сообщалось, что компания пристроит к своим ИИ ЦОД гигаваттные энергокомплексы в некоторых регионах, а минувшем марте появилась информация, что Amazon, Meta✴ и Google помогут утроить мощность АЭС во всём мире к 2050 году. В частности, в октябре 2024 года появились сведения, что Google запитает свои ЦОД от малых модульных реакторов Kairos Power. |

|