Материалы по тегу: software

|

24.03.2025 [11:59], Руслан Авдеев

OpenAI и Meta✴ ведут переговоры с индийской Reliance Jio о сотрудничестве в сфере ИИMeta✴ и OpenAI по отдельности ведут переговоры с индийской Reliance Industries о потенциальном сотрудничестве для расширения ИИ-сервисов, сообщает The Information. Так, OpenAI хотела бы при помощи Reliance Jio расширить использование ChatGPT в Индии — об этом изданию сообщили два независимых источника, знакомых с вопросом. Более того, OpenAI обсуждала с сотрудниками сокращение стоимости подписок на платный вариант ChatGPT с $20/мес. до всего нескольких долларов. Пока неизвестно, велись ли разговоры об этом в ходе переговоров с Reliance. С последней, как утверждается, обсуждали продажу ИИ-моделей OpenAI корпоративным клиентам (через API). Также индийская компания заинтересована в локальном хостинге моделей OpenAI, чтобы данные местных клиентов будут храниться в пределах Индии. По имеющимся данным, с OpenAI и Meta✴ велись переговоры о запуске ИИ-моделей компаний в 3-ГВт ЦОД, который Reliance пока только планирует построить. Утверждается, что это будет «крупнейший дата-центр в мире» — его возведут в Джамнагаре (штат Гуджарат). Стоит отметить, что Reliance Industries является одним из крупнейших конгломератов Индии, имеющих интересы как в нефтегазовой отрасли, так и в IT и смежных отраслях, а также в сфере «зелёной» энергетики.

Источник изображения: Shivam Mistry/unsplash.com Индия в целом считается очень перспективной страной для развития инвестиций в ИИ. Например, в конце прошлого года глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что страна должна стать одним из лидеров в области ИИ и создать собственную инфраструктуру. Тогда сообщалось, что Индия на государственном уровне обсуждает с NVIDIA совместную разработку чипов для ИИ-проектов, адаптированных к местным задачам. Также страна осваивает связанные с ИИ технологии — например, она затратит $1,2 млрд на суверенный ИИ-суперкомпьютер с 10 тыс. ускорителей и собственные LLM, а также готова покупать много ускорителей, включая ослабленные варианты, которые не достались Китаю после ужесточения американских санкций. И это далеко не все проекты, находящиеся сейчас на стадии разработки и реализации.

24.03.2025 [10:20], Андрей Созинов

Orion soft выпустил Termit 2.3: фокус на удобство и безопасность для КИИ, новые сценарии использованияРазработчик инфраструктурного ПО для Enterprise-бизнеса Orion soft выпустил новую версию системы терминального доступа Termit 2.3. В ней реализована возможность перенаправления смарт-карт в удаленных сессиях, многофакторной аутентификации и одновременной работы с несколькими каталогами LDAP, поддержка единого входа SSO Kerberos, а также новая роль ИБ-аудитора, разделение списка приложений и рабочих столов по типу и категориям. Новая функциональность позволяет заказчикам, в частности, субъектам КИИ, усилить защиту ключевых ИТ-систем и расширить количества сценариев применения терминального доступа. Нововведения упрощают повседневные операции, экономят время администраторов и снижают порог обучения для новых пользователей. Интерфейс Termit стал более структурированным, что помогло снизить время поиска необходимых функций.

Источник изображения: Orion soft В прошлых версиях Termit команда Orion soft реализовала поддержку российских каталогов LDAP, а теперь решение позволяет работать сразу с несколькими LDAP. Благодаря этому к терминальному серверу можно подключать одновременно разные базы пользователей. Это актуально компаниям, которым нужно объединить сотрудников из нескольких организаций или филиалов, и в случае переходного периода, когда в инфраструктуре одновременно используется служба каталогов Microsoft AD и ее отечественный аналог. Также система получила механизм упрощенной авторизации по схеме Single Sign-On (SSO) на базе протокола аутентификации Kerberos. Нововведение избавляет пользователя от необходимости повторно вводить свои реквизиты доступа. Если он уже вошел в систему, все сервисы будут доступны, пока не закончится время его сессии. Еще одно нововведение — поддержка многофакторной аутентификации (MFA) через любой доступный RADIUS-сервер. Системные администраторы могут выбрать любой дополнительный фактор, например, SMS или токен, либо оставить выбор за пользователями. Чтобы у заказчиков было больше инструментов для контроля уровня безопасности системы, разработчики также добавили в релиз Termit 2.3 новую роль «аудитор ИБ». Она дает возможность просматривать настройки и проверять их корректность. «В новом релизе Termit мы сделали акцент на безопасности и расширении количества сценариев для терминального доступа, так как ориентируем наше решение на использование в ИТ-инфраструктуре субъектов КИИ. Мы добавили новые функции авторизации, чтобы у заказчиков была возможность настроить систему в соответствии с актуальными требованиями регуляторов. Отметим также, что Termit разработан без использования Open Source. Это исключает возможность эксплуатации уязвимостей общедоступного кода, позволяет повысить безопасность бизнес-процессов и ИТ-инфраструктуры заказчиков, а также ускорить выпуск новой востребованной функциональности. Наш продукт уже в значительной степени закрывает требования к базовой функциональности терминального доступа. Мы продолжаем развивать Termit, учитывая запросы и приближаясь к полному закрытию списка основных ожиданий пользователей от платформы», — резюмирует Константин Прокопьев, лидер продукта Termit Orion soft. Следующее обновление Termit также планируется масштабным. Разработчики планируют реализовать функциональность VDI (виртуализация рабочих мест), управление перемещаемыми профилями с поддержкой различных отечественных ОС, возможность аутентификации в удаленных сессиях при помощи смарт-карт, поддержку ГОСТ шифрования трафика, возможность доступа со смартфонов и планшетов.

24.03.2025 [08:30], Владимир Мироненко

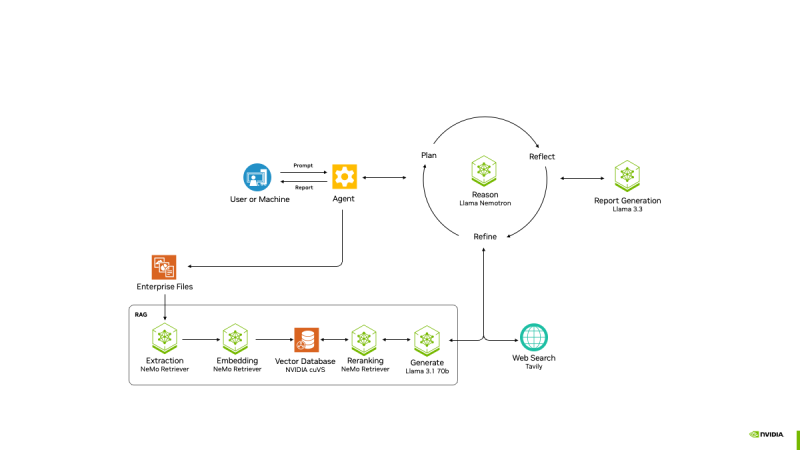

NVIDIA представила проект AI-Q Blueprint Platform для создания продвинутых ИИ-агентовПризнавая, что одних моделей, включая свежие Llama Nemotron с регулируемым «уровнем интеллекта», недостаточно для развёртывания ИИ на предприятии, NVIDIA анонсировала проект AI-Q Blueprint, представляющий собой фреймворк с открытым исходным кодом, позволяющий разработчикам подключать базы знаний к ИИ-агентам, которые могут действовать автономно. Blueprint был создан с помощью микросервисов NVIDIA NIM и интегрируется с NVIDIA NeMo Retriever, что упрощает для ИИ-агентов извлечение мультимодальных данных в различных форматах. С помощью AI-Q агенты суммируют большие наборы данных, генерируя токены в 5 раз быстрее и поглощая данные петабайтного масштаба в 15 раз быстрее с лучшей семантической точностью. Проект основан на новом наборе инструментов NVIDIA AgentIQ для бесшовного, гетерогенного соединения между агентами, инструментами и данными, опубликованном на GitHub. Он представляет собой программную библиотеку с открытым исходным кодом для подключения, профилирования и оптимизации команд агентов ИИ, работающих на основе корпоративных данных для создания многоагентных комплексных (end-to-end) систем. Его можно легко интегрировать с существующими многоагентными системами — как по частям, так и в качестве комплексного решения — с помощью простого процесса адаптации, который обеспечивает полную поддержку. Набор инструментов AgentIQ также повышает прозрачность с полной отслеживаемостью и профилированием системы, что позволяет организациям контролировать производительность, выявлять неэффективность и иметь детальное представление о том, как генерируется бизнес-аналитика. Эти данные профилирования можно использовать с NVIDIA NIM и библиотекой с открытым исходным кодом NVIDIA Dynamo для оптимизации производительности агентских систем. Благодаря этим инструментам предприятиям будет проще объединять команды ИИ-агентов в таких решениях, как Agentforce от Salesforce, поиск Atlassian Rovo в Confluence и Jira, а также ИИ-платформа ServiceNow для трансформации бизнеса, чтобы устранить разрозненность, оптимизировать задачи и сократить время ответа с дней до часов. AgentIQ также интегрируется с такими фреймворками и инструментами, как CrewAI, LangGraph, Llama Stack, Microsoft Azure AI Agent Service и Letta, позволяя разработчикам работать в своей предпочтительной среде. Azure AI Agent Service интегрирован с AgentIQ для обеспечения более эффективных агентов ИИ и оркестровки многоагентных фреймворков с использованием семантического ядра, которое полностью поддерживается в AgentIQ. Возможности ИИ-агентов уже широко используются в различных отраслях. Например, платёжная система Visa использует ИИ-агентов для оптимизации кибербезопасности, автоматизируя анализ фишинговых писем в масштабе. Используя функцию профилирования AI-Q, Visa может оптимизировать производительность и затраты агентов, максимально увеличивая роль ИИ в эффективном реагировании на угрозы, сообщила NVIDIA.

24.03.2025 [01:37], Владимир Мироненко

NVIDIA анонсировала ИИ-модели Llama Nemotron с регулируемым «уровнем интеллекта»NVIDIA анонсировала новое семейство ИИ-моделей Llama Nemotron с расширенными возможностями рассуждения. Основанные на моделях Llama с открытым исходным кодом от Meta✴ Platforms, модели от NVIDIA предназначены для предоставления разработчикам основы для создания продвинутых ИИ-агентов, которые могут от имени своих пользователей независимо или с минимальным контролем работать в составе связанных команд для решения сложных задач. «Агенты — это автономные программные системы, предназначенные для рассуждений, планирования, действий и критики своей работы», — сообщила Кари Бриски (Kari Briski), вице-президент по управлению программными продуктами Generative AI в NVIDIA на брифинге с прессой, пишет VentureBeat. «Как и люди, агенты должны понимать контекст, чтобы разбивать сложные запросы, понимать намерения пользователя и адаптироваться в реальном времени», — добавила она. По словам Бриски, взяв Llama за основу, NVIDIA оптимизировала модель с точки зрения требований к вычислениям, сохранив точность ответов. NVIDIA сообщила, что улучшила новое семейство моделей рассуждений в ходе дообучения, чтобы улучшить многошаговые математические расчёты, кодирование, рассуждения и принятие сложных решений. Это позволило повысить точность ответов моделей до 20 % по сравнению с базовой моделью и увеличить скорость инференса в пять раз по сравнению с другими ведущими рассуждающими open source моделями. Повышение производительности инференса означают, что модели могут справляться с более сложными задачами рассуждений, имеют расширенные возможности принятия решений и позволяют сократить эксплуатационные расходы для предприятий, пояснила компания. Модели Llama Nemotron доступны в микросервисах NVIDIA NIM в версиях Nano, Super и Ultra. Они оптимизированы для разных вариантов развёртывания: Nano для ПК и периферийных устройств с сохранением высокой точности рассуждения, Super для оптимальной пропускной способности и точности при работе с одним ускорителем, а Ultra — для максимальной «агентской точности» в средах ЦОД с несколькими ускорителями. Как сообщает NVIDIA, обширное дообучение было проведено в сервисе NVIDIA DGX Cloud с использованием высококачественных курируемых синтетических данных, сгенерированных NVIDIA Nemotron и другими открытыми моделями, а также дополнительных курируемых наборов данных, совместно созданных NVIDIA. Обучение включало 360 тыс. часов инференса с использованием ускорителей H100 и 45 тыс. часов аннотирования человеком для улучшения возможностей рассуждения. По словам компании, инструменты, наборы данных и методы оптимизации, используемые для разработки моделей, будут в открытом доступе, что предоставит предприятиям гибкость в создании собственных пользовательских рвссуждающих моделей. Одной из ключевых функций NVIDIA Llama Nemotron является возможность включать и выключать опцию рассуждения. Это новая возможность на рынке ИИ, утверждает компания. Anthropic Claude 3.7 имеет несколько схожую функциональность, хотя она является закрытой проприетарной моделью. Среди моделей с открытым исходным кодом IBM Granite 3.2 тоже имеет переключатель рассуждений, который IBM называет «условным рассуждением». Особенность гибридного или условного рассуждения заключается в том, что оно позволяет системам исключать вычислительно затратные этапы рассуждений для простых запросов. NVIDIA продемонстрировала, как модель может задействовать сложные рассуждения при решении комбинаторной задачи, но переключаться в режим прямого ответа для простых фактических запросов. NVIDIA сообщила, что целый ряд партнёров уже использует модели Llama Nemotron для создания новых мощных ИИ-агентов. Например, Microsoft добавила Llama Nemotron и микросервисы NIM в Microsoft Azure AI Foundry. SAP SE использует модели Llama Nemotron для улучшения возможностей своего ИИ-помощника Joule и портфеля решений SAP Business AI. Кроме того, компания использует микросервисы NVIDIA NIM и NVIDIA NeMo для повышения точности завершения кода для языка ABAP. ServiceNow использует модели Llama Nemotron для создания ИИ-агентов, которые обеспечивают повышение производительности и точности исполнения задач предприятий в различных отраслях. Accenture сделала рассуждающие модели NVIDIA Llama Nemotron доступными на своей платформе AI Refinery. Deloitte планирует включить модели Llama Nemotron в свою недавно анонсированную платформу агентского ИИ Zora AI. Atlassian и Box также работают с NVIDIA, чтобы гарантировать своим клиентам доступ к моделям Llama Nemotron.

21.03.2025 [23:08], Руслан Авдеев

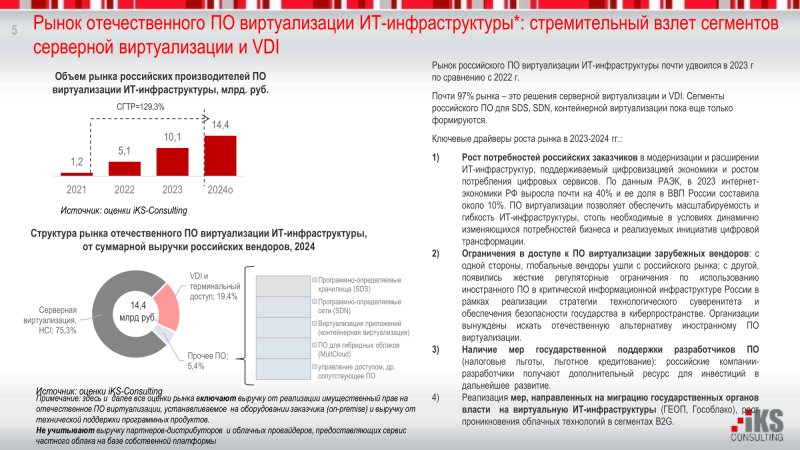

Отечественные решения серверной виртуализации захватили 60,2 % рынка РФ, но VMware не сдаётсяПродукты VMware по-прежнему востребованы на российском рынке виртуальных серверов. Хотя большая его часть это рынка уже занята российским ПО, на долю VMware всё ещё приходится 39 %, сообщают «Ведомости». В сравнении с 2021 годом число установок продуктов VMware упало на 28,4 п.п., гласит статистика 19 крупнейших облачных провайдеров России, собранная iKS-Consulting. Если раньше продукты VMware доминировали на российском рынке виртуализации, то в конце марта 2022 года лицензии компании были отозваны ФСТЭК. В то же время с января 2025 года российским организациям, имеющим объекты критической информационной инфраструктуры (КИИ), запрещено пользоваться VMware, Microsoft Hyper-V и другим зарубежным ПО. Таким образом, российские системы виртуализации активно развивались с 2022 года во многом благодаря уходу глобальных поставщиков ПО и ужесточению требований местных регуляторов, хотя, например, на коммерческие компании давление не так велико, поэтому их больше волнует отсутствие технической поддержки со стороны ушедших вендоров. В итоге доля российских решений на базе KVM с конца 2021 года по конец 2024 года выросла на треть, до 60,2 %. По предварительным оценкам iKS-Consulting, российский рынок виртуализации в 2024 году вырос до 14,4 млрд руб. 75,3 % рынка пришлось на решения для серверной виртуализации и HCI, 19,4 % — на VDI и системы терминального доступа, а ещё 5,4 % — на «прочее ПО». В целом среднегодовой прирост в ближайшие семь лет, по оценкам, составит 23 %, а в 2030 году объём рынка будет на уровне 50,4 млрд руб. По статистике 2023 года 30 % рынка (по выручке) приходилось на ПО компании «Базис», 16 % — на Orion Soft, по 10 % — на vStack и «Астра». Как заявили в «Базисе», в 2022–2023 гг. к компании обращались заказчики с требованием предоставить решения с функциональностью продуктов VMware. Компания смогла сразу удовлетворить более половины, а при вдумчивой оценке выяснялось, что большинство оставшихся требований заказчикам на самом деле не нужны. А даже те, что нужны, имеют разный приоритет. Аналогичная ситуация была и у vStack. По словам представителя «РТК-ЦОД», только массовое развёртывание и работа «в совершенно разных сценариях» с разными заказчиками и в разных отраслях позволит стать отечественному продукту зрелым. Время и реальные внедрения могут повысить доверие к продуктам — это очень важно, поскольку ПО VMware за четверть века стало эталоном в области виртуализации. По оценкам «ТМТ Консалтинг», массовый переход на российские системы виртуализации случится в 2025–2027 гг.

21.03.2025 [19:13], Руслан Авдеев

Стартап Nerdio, развивающий систему управления VDI в Microsoft Azure, привлёк $500 млн, а его капитализация выросла до $1 млрд

microsoft 365

microsoft azure

software

vdi

автоматизация

администрирование

облако

оркестрация

финансы

Стартап Nerdio Inc., обеспечивающий компаниям работу с виртуальными рабочими столами в облаке Microsoft Azure, привлёк $500 млн новых инвестиций в раунде серии C. Капитализация разработчика ПО достигла $1 млрд, что в четыре раза больше, чем два года назад, сообщает Silicon Angle. Продукты Nerdio используют 15 тыс. организаций, в 2022 году речь шла о 5 тыс. Среди клиентов — Comcast, PayPal и другие крупные компании. Платформа доступна в Azure Marketplace. В Nerdio утверждают, что это позволит избежать долгих процедур, сопровождающих корпоративные закупки ПО. Платформа может работать напрямую в облачных средах клиентов, что помогает повысить уровень безопасности. Платформа интегрирована в два VDI-сервиса Azure: AVD (Azure Virtual Desktop) и Windows 365. Nerdio обещает упростить процесс создания виртуальных рабочих столов. По данным компании, в некоторых случаях первоначальная настройка и развёртывание занимают недели. Платформа компании ускоряет процесс в отдельных случаях на 80 %. Платформа включает инструменты, которые упрощают выявление проблем с производительностью виртуальных рабочих столов, а также отключают аккаунты, демонстрирующие потенциально вредоносное поведение.

Источник изображения: Nerdio Встроенный инструмент автоматического масштабирования поможет снизить использование инфраструктуры. Эта функция позволяет автоматически назначить оборудование для выполнения задач в том объёме, в котором это действительно необходимо. В компании считают, что её ПО может снизить стоимость вычислений и хранения данных на 80 % при лучшем сценарии. Компания сохранила прибыльность и, как сообщает её пресс-служба, расширила присутствие в регионах EMEA и APAC. Теперь она намерена использовать полученные средства, чтобы нанять новых разработчиков для расширения функциональности платформы.

21.03.2025 [10:09], Владимир Мироненко

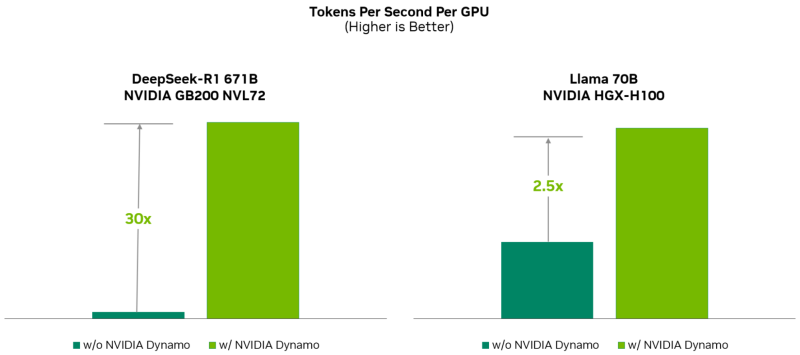

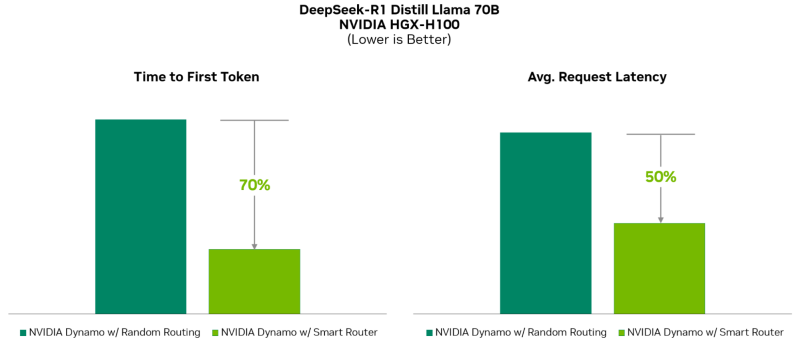

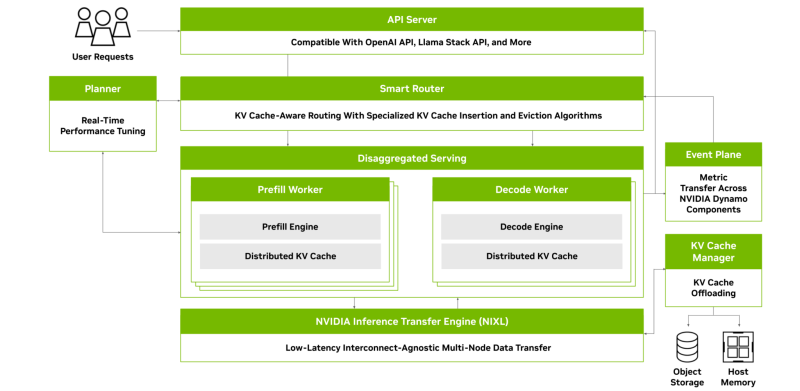

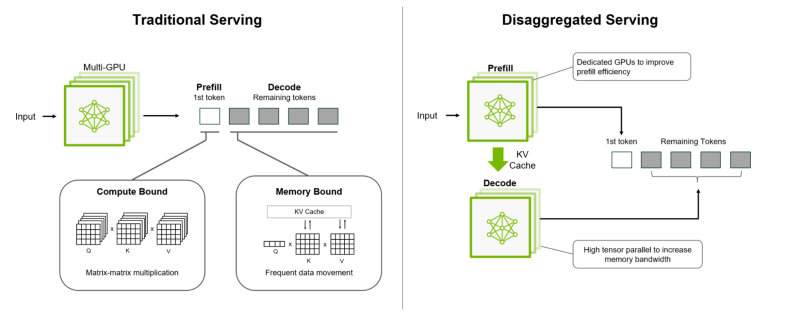

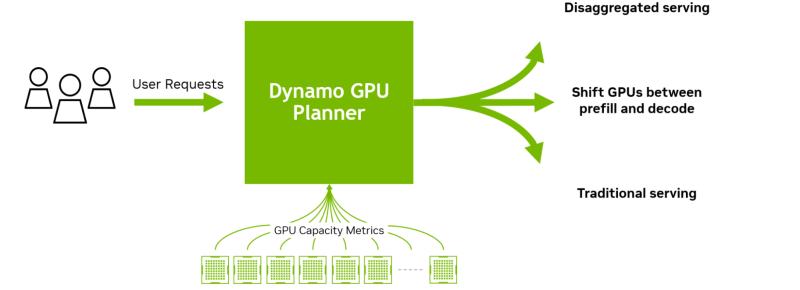

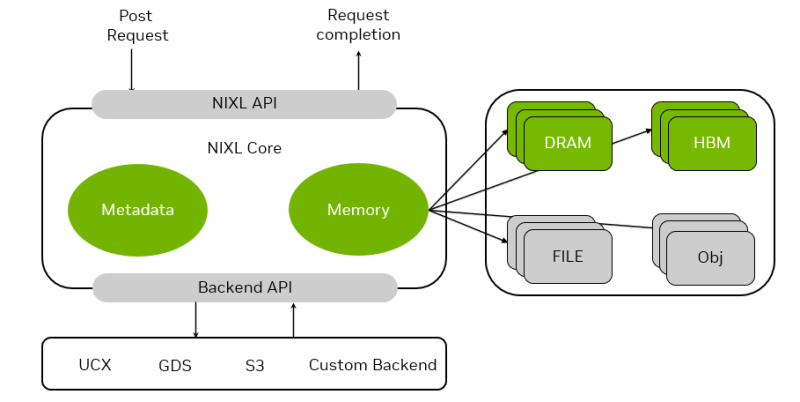

«ОС» для ИИ-фабрик: NVIDIA Dynamo ускорит инференс и упростит масштабирование рассуждающих ИИ-моделейNVIDIA представила NVIDIA Dynamo, преемника NVIDIA Triton Inference Server — программную среду с открытым исходным кодом для разработчиков, обеспечивающую ускорение инференса, а также упрощающую масштабирование рассуждающих ИИ-моделей в ИИ-фабриках с минимальными затратами и максимальной эффективностью. Глава NVIDIA Дженсен Хуанг (Jensen Huang) назвал Dynamo «операционной системой для ИИ-фабрик». NVIDIA Dynamo повышает производительность инференса, одновременно снижая затраты на масштабирование вычислений во время тестирования. Сообщается, что благодаря оптимизации инференса на NVIDIA Blackwell эта платформа многократно увеличивает производительность рассуждающей ИИ-модели DeepSeek-R1. Платформа NVIDIA Dynamo, разработанная для максимизации дохода от токенов для ИИ-фабрик (ИИ ЦОД), организует и ускоряет коммуникацию инференса на тысячах ускорителей, и использует дезагрегированную обработку данных для разделения фаз обработки и генерации больших языковых моделей (LLM) на разных ускорителях. Это позволяет оптимизировать каждую фазу независимо от её конкретных потребностей и обеспечивает максимальное использование вычислительных ресурсов. При том же количестве ускорителей Dynamo удваивает производительность (т.е. фактически доход ИИ-фабрик) моделей Llama на платформе NVIDIA Hopper. При запуске модели DeepSeek-R1 на большом кластере GB200 NVL72 благодаря интеллектуальной оптимизации инференса с помощью NVIDIA Dynamo количество генерируемых токенов на каждый ускоритель токенов увеличивается более чем в 30 раз, сообщила NVIDIA. NVIDIA Dynamo может динамически перераспределять нагрузку на ускорители в ответ на меняющиеся объёмы и типы запросов, а также закреплять задачи за конкретными ускорителями в больших кластерах, что помогает минимизировать вычисления для ответов и маршрутизировать запросы. Платформа также может выгружать данные инференса в более доступную память и устройства хранения данных и быстро извлекать их при необходимости. NVIDIA Dynamo имеет полностью открытый исходный код и поддерживает PyTorch, SGLang, NVIDIA TensorRT-LLM и vLLM, что позволяет клиентам разрабатывать и оптимизировать способы запуска ИИ-моделей в рамках дезагрегированного инференса. По словам NVIDIA, это позволит ускорить внедрение решения на различных платформах, включая AWS, Cohere, CoreWeave, Dell, Fireworks, Google Cloud, Lambda, Meta✴, Microsoft Azure, Nebius, NetApp, OCI, Perplexity, Together AI и VAST. NVIDIA Dynamo распределяет информацию, которую системы инференса хранят в памяти после обработки предыдущих запросов (KV-кеш), на множество ускорителей (до тысяч). Затем платформа направляет новые запросы на те ускорители, содержимое KV-кеша которых наиболее близко к новому запросу, тем самым избегая дорогостоящих повторных вычислений. NVIDIA Dynamo также обеспечивает дезагрегацию обработки входящих запросов, которое отправляет различные этапы исполнения LLM — от «понимания» запроса до генерации — разным ускорителям. Этот подход идеально подходит для рассуждающих моделей. Дезагрегированное обслуживание позволяет настраивать и выделять ресурсы для каждой фазы независимо, обеспечивая более высокую пропускную способность и более быстрые ответы на запросы. NVIDIA Dynamo включает четыре ключевых механизма:

Платформа NVIDIA Dynamo будет доступна в микросервисах NVIDIA NIM и будет поддерживаться в будущем выпуске платформы NVIDIA AI Enterprise.

21.03.2025 [01:15], Владимир Мироненко

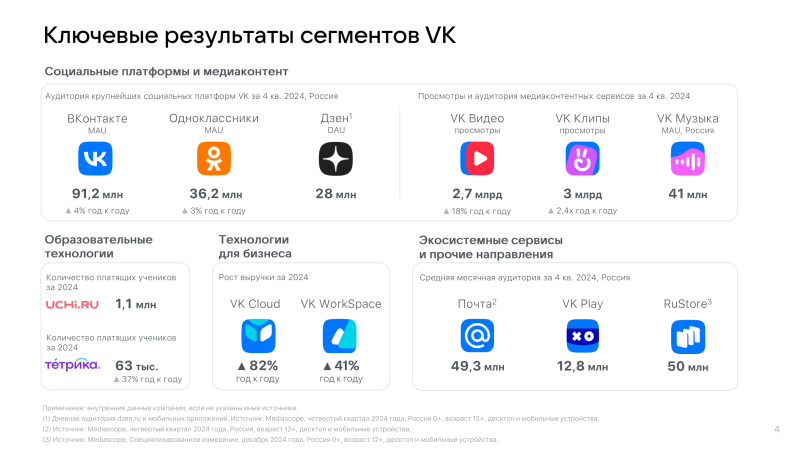

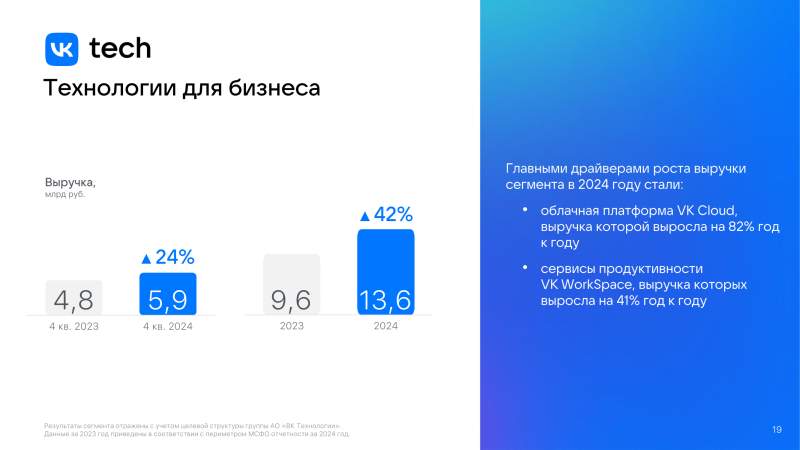

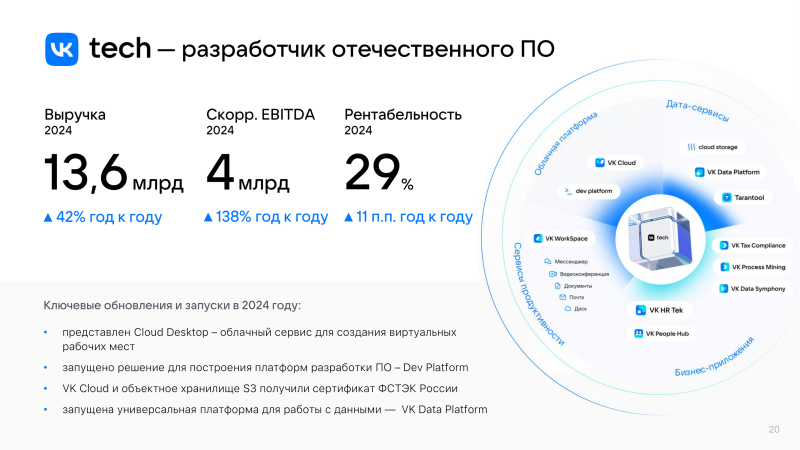

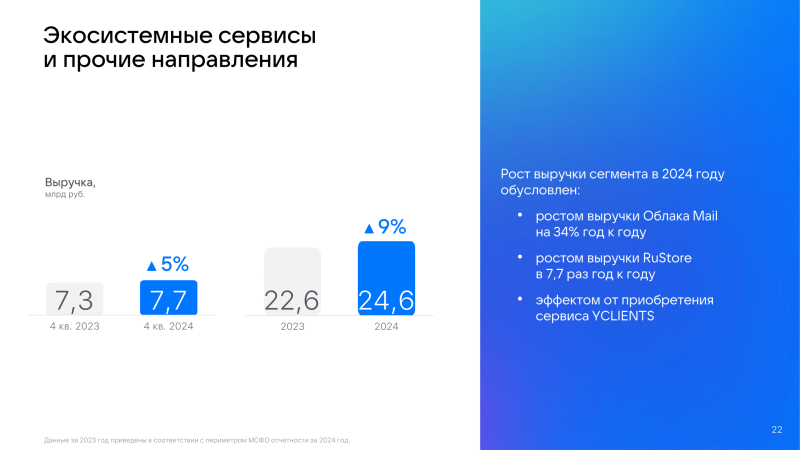

VK увеличила выручку за 2024 год на 23 %, а VK Tech — сразу на 42 %VK объявила аудированные финансовые результаты за 2024 год. Выручка компании выросла на 23 % по сравнению с 2023 годом до 147,6 млрд руб. Основным источником роста была онлайн-реклама, которая принесла компании 96,1 млрд руб. выручки, увеличившись по сравнению с предыдущим годом на 20 %. Вместе с тем выручка сегмента VK Tech увеличилась на 42 % год к году до 13,6 млрд руб., а скорректированная EBITDA выросла в 2,4 раза до 4 млрд руб. С момента выделения в отдельный сегмент в 2018 году среднегодовой рост выручки VK Tech по 2024 год составил 73 %, маржинальность по EBITDA — 29 %. Основными драйверами роста VK Tech в прошлом году были облачные сервисы платформы VK Cloud увеличившие выручку год к году на 82 % и сервисы продуктивности VK Workspace, показавшие рост выручки в 41 %. VK сообщила, что рассматривает возможность проведения первичного публичного размещения (IPO) акций VK Tech, и решение будет принято с учётом рыночной конъюнктуры. Как ожидается, это усилит потенциал развития VK Tech, а также будет способствовать узнаваемости и укреплению бренда. Выручка сегмента «Экосистемные сервисы и прочие направления», включающего сервис «Облако Mail.ru», выросла на 9 % до 24,6 млрд руб. При этом «Облако Mail.ru» увеличил выручку на 34 %. Средняя месячная аудитория сервиса в России за IV квартал 2024 года составила 21,8 млн пользователей, средняя дневная — 2,8 млн. Рост выручки от продаж единой подписки на «Почту» и «Облако Mail Space» за IV квартал составил 49 % год к году. Пользователи загрузили в «Облако Mail.ru» за три месяца 9 млрд файлов, что на 15 % больше, чем за IV квартал 2023 года. В «Облаке Mail.ru» появились тёмная тема, быстрая очистка места на устройстве и возможность кастомизации папок.

19.03.2025 [18:07], Андрей Крупин

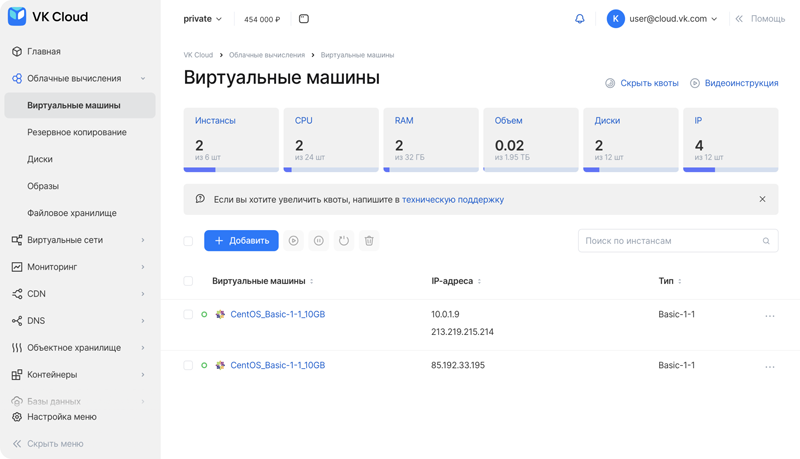

VK представила обновлённую платформу Private Cloud для частного облакаЗанимающаяся разработкой корпоративного ПО компания VK Tech (входит в экосистему VK) сообщила о выпуске новой версии платформы Private Cloud 4.2 — решения для построения частного облака в ЦОД заказчика на базе VK Cloud. Private Cloud включает в себя набор сервисов облачной платформы VK Cloud, необходимый для развёртывания частного облака, включая виртуализацию, управление сетями и контейнерами, базы данных и маркетплейс приложений. Решение поддерживает отечественные операционные системы, сертифицировано во ФСТЭК России и может использоваться для размещения критически важных IT-систем, хранения чувствительных данных и реализации проектов в соответствии с требованиями регулирующих органов в сфере иноформенной безопасности.

Пользовательский интерфейс Private Cloud в составе VK Cloud (источник изображения: cloud.vk.com/private-cloud) Обновлённая платформа Private Cloud получила улучшенный механизм автоэвакуации виртуальных машин и возможность подключения пользователями собственных систем хранения данных по универсальной схеме с поддержкой основных протоколов, таких как iSCSI, Fibre Channel и InfiniBand. Это обеспечивает совместимость с любыми хранилищами и повышает отказоустойчивость. Платформа также поддерживает гибкое выделение части объёма хранилища под конкретные задачи, что позволяет эффективно управлять ресурсами. Дополнительно в Private Cloud версии 4.2 появилась передача данных в сторонние SIEM-системы. Система аудита позволяет фильтровать, искать и выводить предупреждения о событиях информационной безопасности на платформе. Это помогает собирать и анализировать сведения, необходимые для защиты корпоративных данных.

19.03.2025 [17:34], Руслан Авдеев

Google купит стартап Wiz за баснословные $32 млрдКомпания Google объявила о покупке стартапа Wiz Inc., работающего в области информационной безопасности, за $32 млрд., что станет крупнейшей сделкой в истории Google. При этом Wiz в ходе последнего раунда инвестиций в прошлом году была оценена в $12 млрд. Тогда же Google предложила Wiz $23 млрд, но стартап отказался от сделки, заявив о намерении выйти на IPO, сообщает Silicon Angle. Согласно обновлённым данным, Google согласилась выплатить Wiz $3,2 млрд, если сделка не состоится. Например, если ей воспрепятствует один из регуляторов. Некоторые эксперты считают, что именно боязнью блокировки сделки вызван отказ руководства Wiz продать компанию в 2024 году. По слухам, условия новой сделки предполагают, что стартап сможет продолжить действовать независимо в случае, если антимонопольное разбирательство вдруг затянется. Wiz была основана в 2020 году. Двумя годами позже годовая регулярная выручка компании достигла $100 млн, а не так давно, по слухам, выросла до $700 млн. Компания утверждает, что более половины компаний из списка Fortune 100 использует её платформу для обеспечения кибербезопасности. ПО помогает компаниям устранять уязвимости в облачных средах, защищать код разработчиков и отражать кибератаки.

Источник изображения: Google Компания предлагает несколько ключевых продуктов. Wiz Cloud обнаруживает уязвимости вроде неверной конфигурации облачных сред, выявляет известные эксплойты и слабости систем контроля доступа. Wiz Defend обнаруживает и блокирует кибератаки с использованием eBPF-сенсора и аудита логов. Wiz Defend собирает подробные данные об инцидентах безопасности и получает информацию о потенциальных уязвимостях из других источников. Wiz Code умеет выявлять уязвимости напрямую в редакторе кода и даёт советы по их устранению. Инструменты Wiz доступны во всех крупнейших публичных облаках. Google объявила, что не планирует менять подобную практику после покупки. Согласно данным в блоге Google, Wiz сохранит совместимость со всеми конкурирующими облаками, а Google Cloud Marketplace по-прежнему будет предлагать защитные инструменты, созданные сторонними разработчиками.

Источник изображения: Sigmund/unsplash.com При этом IT-гигант выразил намерение разработать «унифицированную платформу для обеспечения кибербезопасности», объединив технологии Wiz с решениями Google Security Operations, которые позволяют проводить аудит безопасности и автоматизировать реакцию на кибератаки. Wiz — не первая многомиллиардная покупка Google в области кибербезопасности. В 2022 году приобрела за $5,4 млрд провайдера защитных сервисов Mandiant. Кроме того, около десяти лет назад внутренний проект компании BeyondCorp помог принятию принципа «нулевого доверия» для любых устройств. Также компания известна разработкой фреймворка SLSA для безопасной разработки ПО. Сделку по покупке Wiz планируется закрыть в 2026 году, пока она ожидает одобрения регуляторов. |

|