Материалы по тегу: hardware

|

27.01.2026 [12:53], Сергей Карасёв

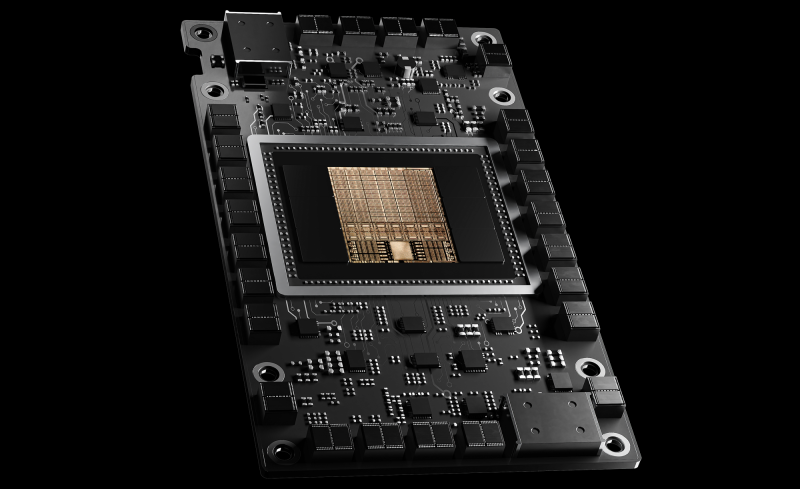

Giga Computing представила ИИ-сервер на базе NVIDIA GB200 NVL4 с СЖОКомпания Giga Computing, подразделение Gigabyte Group, пополнила ассортимент серверов моделью XN24-VC0-LA61, ориентированной на ИИ-задачи и другие ресурсоёмкие нагрузки. Устройство выполнено в форм-факторе 2U на аппаратной платформе NVIDIA GB200 NVL4. В общей сложности задействованы четыре GPU поколения Blackwell со 186 Гбайт памяти HBM3E каждый (пропускная способность до 8 Тбайт/с) и два CPU Grace с 480 Гбайт памяти LPDDR5X (пропускная способность до 512 Гбайт/с). Применяется GPU — GPU интерконнект NVIDIA NVLink и CPU — GPU интерконнект NVIDIA NVLink-C2C. Реализована система прямого жидкостного охлаждения. Доступны четыре сетевых порта OSFP InfiniBand XDR на 800 Гбит/с или два порта Ethernet на 400 Гбит/с на базе NVIDIA ConnectX-8 SuperNIC. Кроме того, имеется порт 1GbE на основе Intel I210-AT и выделенный сетевой порт управления 1GbE. В оснащение входит контроллер ASPEED AST2600. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) с жидкостным охлаждением. Опционально может быть установлен DPU NVIDIA BlueField-3. Есть внутренний разъём для SSD типоразмера M.2 2242/2260/2280/22110 с интерфейсом PCIe 5.0 x4, слот PCIe 5.0 х16 для карты FHHL с СЖО и ещё один разъём PCIe 5.0 х16 FHHL. Предусмотерны коннекторы USB 3.2 Gen1 Type-A, Micro-USB, Mini-DP и RJ45. Сервер имеет габариты 438 × 87 × 900 мм и массу 42,8 кг. За питание отвечают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур простирается от +10 до +35 °C.

27.01.2026 [09:09], Руслан Авдеев

Сингапур потратит S$1 млрд на то, чтобы остаться в авангарде ИИ-прогрессаСингапур намерен потратить свыше S$1 млрд ($786 млн) на финансирование Национального плана исследований и разработок в области ИИ (NAIRD) для укрепления государственного потенциала в соответствующей сфере. По данным местного Министерства цифрового развития и информации (MDDI), финансирование будет осуществляться с 2025 по 2030 гг., сообщает Channel News Asia. Анонсированный главой MDDI Джозефин Тео (Josephine Teo) план призван поддержать укрепление амбиций страны в сфере ИИ в рамках обновлённой национальной стратегии National AI Strategy (NAIS) 2.0. В 2019 году появилась первая национальная стратегия Сингапура в сфере искусственного интеллекта, в рамках которой страна начала реализацию ИИ-проектов в области образования, здравоохранения, логистики, безопасности и др. NAIS 2.0 анонсировали в 2023 году, тогда ставилась цель более чем втрое нарастить количество специалистов в сфере ИИ (до 15 тыс. человек) и помочь Сингапуру стать лучшим регионом для ИИ-разработчиков. Нынешние инвестиции в объёме S$1 млрд — часть общих вложений Национального исследовательского фонда (NRF) Сингапура в объёме S$37 млрд в технологическое развитие страны, объявленных в декабре 2025 года. S$28 млрд на те же цели выделили годом ранее. План NAIRD предусматривает приоритетное развитие трёх направлений: фундаментальных исследований в сфере ИИ, прикладных исследований в той же области, а также поиск талантов для реализации национальной ИИ-стратегии. Для этого Сингапур построит центры исследований в сфере ИИ, в которых будут работать не только местные, но и зарубежные специалисты. По словам Тео, центры будут работать над решением долгосрочных, сложных задач. В частности, речь идёт об исследованиях и разработках в областях защиты от рисков, связанных с внедрением ИИ, и защитой от злоупотреблений такими системами. Центры будут работать и над широким кругом других смежных проблем, например, над разработкой многоцелевого искусственного интеллекта, способного решать задачи в разных сферах. В прикладной сфере новый план предусматривает укрепление потенциала для поддержки внедрения ИИ в промышленности, а также поддержку инициатив, выдвинутых исследовательскими, инновационными и корпоративными структурами. По словам властей, новый план также ориентирован на обучение «двуязычных» исследователей, владеющих и навыками в сфере ИИ, и одновременно являющихся экспертами в какой-либо области. Также Сингапур намерен создать условия для перехода от теории к практике, превращения исследования в прикладные продукты. Планируется и дальше поддерживать инициативы, направленные на поддержку интереса к ИИ-исследованиям среди молодёжи. На уровне высшего образования студентам предоставят возможность взаимодействия с ведущими научно-исследовательскими учреждениями локально и за рубежом, с расширением стипендиальных программ. Создаются и условия для поддержки преподавателей, в т.ч. речь идёт о программе приглашенных профессоров AI Visiting Professorship для обеспечения сотрудничества между местными и международными исследователями. Параллельно привлекаются и ведущие стартапы и ИИ-компании для размещения своих исследовательских команд в Сингапуре. В MDDI заявляют, что исследования в области ИИ позволят Сингапуру оставаться в авангарде в данной сфере. В 2025 году Сингапур занимал третье место в глобальном рейтинге ИИ-исследований издания The Observer, с ранжированием стран по уровню инвестиций, инноваций и внедрения ИИ. Страна уступает только США и Китаю. В последнее время в Сингапуре всё больше компаний, открывших собственные исследовательские лаборатории, включая Microsoft Research Asia и Google DeepMind. Одна из главных проблем Сингапура — острая нехватка свободной энергии и земли для ИИ ЦОД. Поэтому конкуренты не дремлют, и соседняя Малайзия уже недвусмысленно выражала желание стать главным IT-хабом региона. Собственные амбиции того же рода в регионе имеют Индонезия и Вьетнам. Попутно Сингапур всё чаще подозревают в помощи китайским компаниям в обходе санкций США.

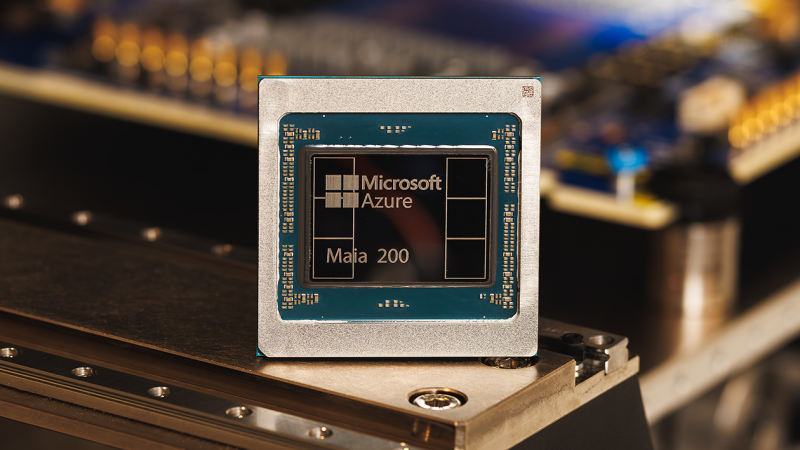

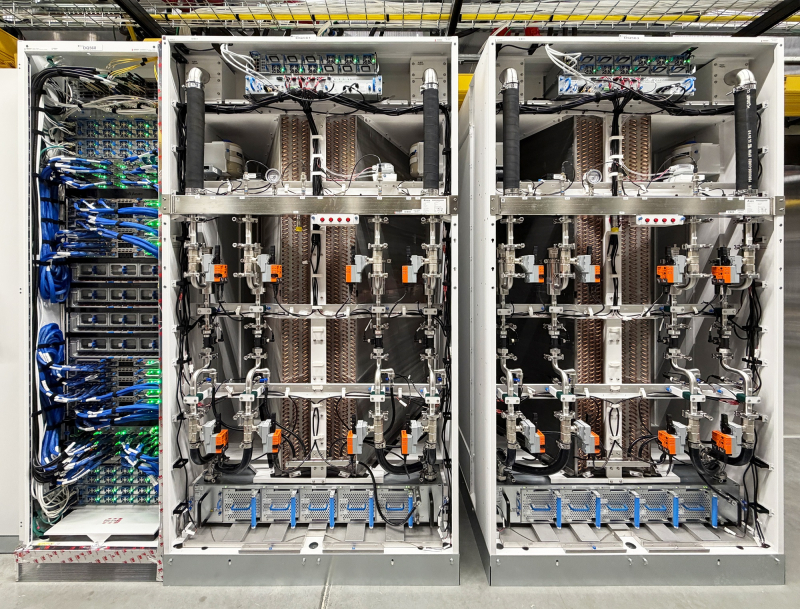

27.01.2026 [01:23], Владимир Мироненко

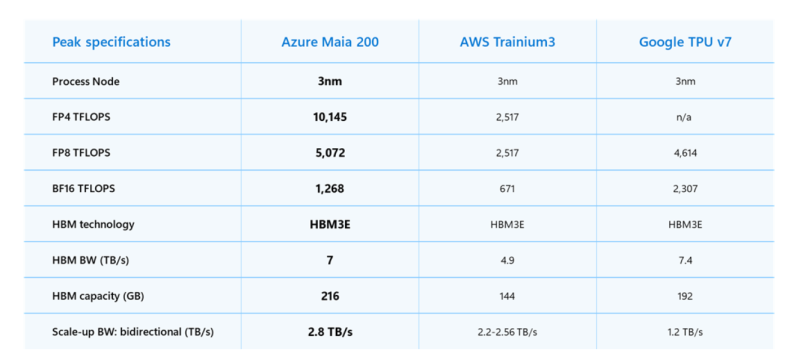

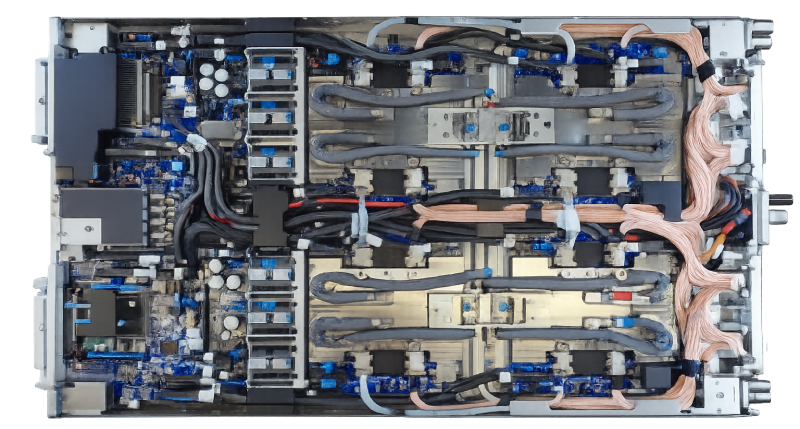

Microsoft представила ИИ-ускоритель Maia 200 с 216 Гбайт HBM3eMicrosoft представила 3-нм ИИ-ускоритель Maia 200 для инференса с собственными тензорными ядрами с поддержкой форматов FP8/FP4, переработанной подсистемой памяти с 216 Гбайт HBM3e (7 Тбайт/с), 272 Мбайт SRAM, DMA-движком, оптимизированной NOC, а также «механизмами перемещения данных, обеспечивающими быструю и эффективную работу масштабных моделей». Maia 200 содержит более 140 млрд транзисторов. FP4-производительность составляет более 10 Пфлопс что в три раза выше, чем у Amazon Trainium3, но почти вдвое меньше, чем у NVIDIA Blackwell, и более 5 Пфлопс в FP8-вычислениях, чуть превосходя по производительности Google TPU v7 Ironwood и опять-таки примерно вдвое уступая Blackwell. При этом TDP составляет 750 Вт, а для охлаждения используются СЖО и фирменные теплообменники второго поколения. На системном уровне Maia 200 использует всего лишь двухуровневую унифицированную сетевую фабрику, построенную на стандартном Ethernet. Специальный транспортный уровень Maia AI, который используется и для вертикального, и для горизонтального масштабирования, и тесно интегрированный сетевой адаптер обеспечивают производительность, высокую надёжность и преимущества по стоимости без использования проприетарных интерконнектов. Каждый акселератор получил выделенный интерфейс с пропускной способностью 2,8-Тбайт/с (в дуплексе). Обещаны предсказуемые, высокопроизводительные коллективные операции в кластерах, объединяющих до 6144 ускорителей. Внутри каждого узла есть четыре ускорителя Maia 200, которые общаются друг с другом напрямую, т.е. без использования коммутатора. «Maia 200 также является самой эффективной системой для выполнения задач ИИ, когда-либо развёрнутой Microsoft, обеспечивая на 30 % лучшую производительность на доллар, чем новейшее оборудование в нашем парке», — сообщила компания. Maia 200 уже используется в регионе US Central недалеко от Де-Мойна (Des Moines, шт. Айова), а в дальнейшем планируется развёртывание новых ускорителей в регионе US West 3, недалеко от Финикса (Phoenix, шт. Аризона). Компания также представила предварительную версию SDK Maia с полным набором инструментов для создания и оптимизации LLM для Maia 200. Он включает в себя полный набор возможностей, в том числе интеграцию с PyTorch, компилятор Triton и оптимизированную kernel-библиотеку, а также доступ к низкоуровневому программированию Maia. Microsoft сообщила, что Maia 200 будет использоваться в рамках её гетерогенной ИИ-инфраструктуры для работы с различными моделями, включая GPT-5.2 от OpenAI, обеспечивая преимущества в соотношении производительности и затрат для Microsoft Foundry и Microsoft 365 Copilot. Команда Microsoft Superintelligence будет использовать Maia 200 для генерации синтетических данных и обучения с подкреплением для улучшения собственных моделей следующего поколения. В сценариях использования конвейера синтетических данных использование Maia 200 позволит ускорить процесс генерации и фильтрации высококачественных данных, специфичных для конкретной предметной области.

26.01.2026 [21:48], Владимир Мироненко

NVIDIA инвестировала в CoreWeave ещё $2 млрд, чтобы та побыстрее построила ИИ ЦОД на 5 ГВтNVIDIA и CoreWeave объявили о расширении партнёрских отношений, что позволит CoreWeave ускорить создание более чем 5 ГВт мощностей ИИ ЦОД к 2030 году. NVIDIA также инвестировала $2 млрд в обыкновенные акции класса А CoreWeave по цене $87,20/шт. Как сообщается в пресс-релизе, «инвестиции отражают уверенность NVIDIA в бизнесе, команде и стратегии роста CoreWeave как облачной платформы, построенной на инфраструктуре NVIDIA». Акции CoreWeave выросли на 14 % в ходе утренних торгов и на 30 % с начала года, несмотря на продолжающиеся операционные убытки, отметил ресурс Investing. Компании сообщили, что с целью удовлетворения продолжающегося роста спроса на ИИ и потребности в вычислительных ресурсах они углубляют согласование своей инфраструктуры, ПО и платформ. Компании намерены:

Несмотря на то, что гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) категорически не согласен с концепцией циклического финансирования, новые инвестиции вряд ли полностью развеют критику, отметил Investing. Многие аналитики по-прежнему рассматривают эти соглашения как косвенную поддержку NVIDIA спроса на собственные чипы. Глава CoreWeave Майкл Интратор (Michael Intrator) ранее назвал обвинения в циклическом финансировании «нелепыми», отметив, что общая доля NVIDIA остаётся относительно небольшой по сравнению с общим объёмом привлечённого CoreWeave капитала, превышающим $25 млрд.

Источник изображения: NVIDIA CoreWeave продолжает осуществлять диверсификацию своей клиентской базы. В ходе последнего квартального отчёта компания сообщила, что вклад крупнейшего заказчика в общую выручку не превышает 35 %. Для сравнения, в 2024-м году около 62 % от суммарной выручки CoreWeave приходилось на Microsoft. Вторым по величине заказчиком была NVIDIA (15 %), которая обязалась выкупить у CoreWeave все нераспроданные ИИ-мощности. У Microsoft имеются контракты с несколькими неооблаками на общую сумму более $60 млрд. Если ранее Microsoft скупала мощности в интересах OpenAI, то теперь OpenAI скупает мощности у CoreWeave напрямую, общая сумма контрактов достигла $22,4 млрд. Кроме того, в рамках партнёрского соглашения с IBM компания CoreWeave обязалась поставить ей один из своих первых ИИ-суперкомпьютеров на базе NVIDIA GB200 NVL72. В числе клиентов CoreWeave также Meta✴, заключившая с ней контракт на $14,2 млрд. Впрочем, для снижения рисков, связанных с крупными заимствованиями для развёртывания ИИ-инфраструктуры IT-гиганты проводят сделки по обеспечению своих проектов через компании специального назначения — SPV (special-purpose vehicle), финансируемые большей частью инвесторами с Уолл-стрит. Чтобы обеспечить выполнение обязательств по развёртыванию ИИ-инфраструктуры в рамках обязательств по контрактам с ИИ-компаниями, CoreWeave прибегает к заимствованиям. В частности, для развёртывания облачной инфраструктуры в рамках долгосрочного соглашения с OpenAI компания договорилась об отложенном кредите (DDTL 3.0) на сумму $2,6 млрд.

26.01.2026 [19:41], Руслан Авдеев

Инвесторы Fermi America подали к компании коллективный искКомпания Fermi America, стоящая за проектом мегакампуса ИИ ЦОД HyperGrid (Project Matador) площадью 167 га и мощностью 11 ГВт в Амарилло (Amarillo, Техас), вероятно, скоро предстанет перед судом. Юридическая компания Berger Montague PC подала против неё коллективный иск от имени инвесторов, купивших ценные бумаги компании с 1 октября по 11 декабря 2025 года, в том числе в ходе IPO, сообщает Datacenter Dynamics. Согласно материалам иска, жалобы возникли после того, как первый арендатор будущего ЦОД Fermi отказался от сделки — его участие могло бы финансово поддержать строительство кампуса. В сентябре Fermi заявляла, что подписала не имеющее обязательной силы письмо о намерениях (LOI) с неназванным «арендатором инвестиционного уровня», который и должен был стать первым клиентом. По оценкам экспертов, стоимость сделки составила $150 млн. В январе 2026 года оговоренный в письме срок «эксклюзивности» возможной сделки истёк, а потенциальный арендатор расторг соглашение, хотя переговоры о возможной аренде мощностей ЦОД с ним продолжаются. Fermi последовательно отрицала, что этим загадочным арендатором была Amazon (AWS), хотя неофициально глава Fermi упоминал именно последнюю. Среди других потенциальных клиентов также называлась Palantir, имеющая тесные связи с госсектором США. Несмотря на то, что компания не имеет ни одного дата-центра в управлении и очень мало опыта в секторе ЦОД вообще, она привлекла $682 млн в ходе IPO в октябре прошлого года, рыночная оценка бизнеса составила $15 млрд. После новости о расторжении соглашения акции Fermi стали практически вдвое дешевле, чем во время IPO. В связи со срывом сделки американская юридическая компания Robbins Geller Rudman & Dowd начала расследовать вероятные нарушения Fermi американских законов. Одним из основателей Fermi выступает бывший губернатор Техаса и министр энергетики США Рик Перри (Rick Perry). Компания планировала построить кампус близ Амарилло на земле, входящей в экосистему Техасского технологического университета. Если проект будет реализован, площадь объектов составит фантастические 1,67 млн м2, для электроснабжения будет использоваться комбинация локальных энергоресурсов, включая газовые турбины, солнечные и ветряные элементы и даже атомные реакторы. Первые два этапа Project Matador мощностью 1,1 ГВт, предположительно, обойдутся в $2 млрд.

26.01.2026 [14:04], Сергей Карасёв

Расходы на аренду GPU-серверов в России достигли 17 млрд руб.В 2025 году объём российского рынка аренды выделенных GPU-серверов (bare-metal) составил приблизительно 17 млрд руб. В 2026-м ожидается двукратный рост с итоговым результатом на уровне 34 млрд руб. Такую оценку, как сообщает газета «Коммерсантъ», приводит отечественный облачный провайдер и поставщик комплексной IT-инфраструктуры «Рег.облако». Отмечается, что около 60 % спроса в сегменте аренды GPU-серверов в РФ приходится на задачи ИИ и машинного обучения. Ещё 30 % выручки обеспечивают сервисы VDI, оставшиеся 10 % — нагрузки, связанные с рендерингом. Спрос на аренду GPU-серверов устойчиво растёт, поскольку такая модель позволяет выполнять НРС-задачи без необходимости формирования собственной дорогостоящей инфраструктуры. Кроме того, компании могут наращивать или сокращать вычислительные мощности в зависимости от меняющихся потребностей, оплачивая только фактически используемые ресурсы. По данным «Рег.Облака», стоимость аренды GPU-систем начинается примерно с 51 тыс. руб. и может превышать 1,5 млн руб. в месяц за сервер (в зависимости от конфигурации). Около половины от суммарной выручки провайдеров обеспечивают клиенты из сферы IT. Приблизительно 17 % поступлений приходится на заказчиков в сегменте торговли, 11 % — на организации из сферы услуг. Представитель ITPOD подчёркивает, что ИИ-технологии в реальном бизнесе в России пока развиваются через пилотные проекты и тесты гипотез. А поэтому аренда GPU-серверов является наиболее рациональным решением, поскольку избавляет от капитальных затрат и позволяет прогнозировать расходы. Представитель «СКБ Контур» добавляет, что в аренде GPU-ресурсов заинтересованы средние и крупные компании, у которых нет собственной ИИ-инфраструктуры. Вместе с тем, по оценкам MWS Cloud, суммарный объём рынка решений на базе GPU для локального развёртывания (on-premises) с учётом аренды и приобретения оборудования в собственность в 2025 году вырос на четверть, превысив 112 млрд руб.

26.01.2026 [13:21], Сергей Карасёв

MSI представила PRO DP10 A14MG, «малолитражный» бизнес-ПК на базе Intel Raptor LakeКомпания MSI анонсировала компьютер небольшого форм-фактора PRO DP10 A14MG, предназначенный для использования в бизнес-сфере и коммерческом секторе. Устройство, выполненное на аппаратной платформе Intel, заключено в корпус объёмом всего 1,1 л. Максимальная конфигурация включает процессор Core i7 14700 поколения Raptor Lake с 20 ядрами (8Р+12Е/28С) с максимальной тактовой частотой 5,4 ГГц в турбо-режиме. В состав чипа входит графический ускоритель Intel UHD Graphics 770 с частотой до 1,6 ГГц. Применена материнская плата на наборе логики Intel H610. Объём оперативной памяти DDR5-5600 достигает 64 Гбайт в виде двух модулей SO-DIMM. Компьютер несёт на борту SSD типоразмера M.2 2280 с интерфейсом PCIe 3.0 x4 (NVMe). В оснащение в зависимости от модификации входит адаптер Intel Wi-Fi 6E AX211, AzureWave AW-CB515NF Wi-Fi 5 или Intel Wi-Fi 7 BE200 с поддержкой соответственно Bluetooth 5.3, Bluetooth 5.0 и Bluetooth 5.4. Есть сетевой контроллер Intel I226V стандарта 2.5GbE, монофонический динамик мощностью 1 Вт и модуль dTPM 2.0.

Источник изображения: MSI На фронтальной панели расположены два порта USB 3.0 Type-A (5 Гбит/с), по одному порту USB Type-C (10 Гбит/с) и USB Type-A (10 Гбит/с), комбинированное аудиогнездо на 3,5 мм. Сзади сосредоточены четыре порта USB 2.0, гнездо RJ45 для сетевого кабеля, а также интерфейсы HDMI 2.1 и DisplayPort 1.4b с поддержкой видео 4K@60. Кроме того, предусмотрен конфигурируемый разъём со стандартным исполнением HDMI+LAN(2.5GbE) и опциями HDMI+COM, DP+LAN(2.5GbE), DP+COM, VGA+LAN(2.5GbE), VGA+COM. Габариты новинки составляют 34,48 × 178,82 × 179 мм, масса — 1,22 кг. Используется блок питания мощностью 120 Вт. Возможен монтаж посредством крепления VESA. Заявлена совместимость с Windows 11.

26.01.2026 [13:20], Сергей Карасёв

Индустриальный компьютер AAEON MEX-BTS допускает установку GPU формата MXMКомпания AAEON анонсировала компьютер небольшого форм-фактора MEX-BTS, который может применяться в качестве индустриальной рабочей станции, платформы визуализации с поддержкой ИИ, системы мониторинга безопасности и пр. Особенностью новинки является возможность установки GPU-ускорителя формата MXM 3.1 Type-A или Type-B. Устройство выполнено в корпусе с габаритами 295 × 186 × 50 мм. В зависимости от модификации используется материнская плата на наборе логики Intel R680E, Intel Q670E или Intel H610E. Поддерживаются процессоры Intel Core 12-го, 13-го и 14-го поколений, а также Intel Core Series 2 (Bartlett Lake) с показателем TDP до 65 Вт. Доступны два слота для модулей оперативной памяти DDR5-5200 SO-DIMM суммарным объёмом до 64 Гбайт. В оснащение входят два разъёма M.2 2280 M-Key (PCIe 4.0 x4 и PCIe 3.0 x4) для SSD, коннектор M.2 3052 B-Key (PCIe 3.0 x2, USB 3.2, USB 2.0) и разъём Mini Card (PCIe 3.0 x1 и USB 2.0) для модулей беспроводной связи. Могут быть реализованы до шести сетевых Ethernet-портов: два 2.5GbE на основе контроллера Intel I226-LM, три 2.5GbE на базе Intel I226-V и один 1GbE на основе Intel I219-LM (во всех случаях применяются гнёзда RJ45). Есть звуковой кодек Realtek ALC897. Изображение может выводиться одновременно на несколько мониторов через интерфейс HDMI 2.0 на основной плате (3840 × 2160 пикселей, 60 Гц) и два коннектора DP++ 1.4 на модуле MXM (3840 × 2160 точек). Во фронтальной части расположены два порта USB 2.0, две колодки GPIO и набор аудиогнёзд. Сзади находятся четыре разъёма USB 3.2 Gen2 и четыре последовательных порта (по два RS-232/422/485 и RS-232), гнёзда RJ45 и 4-контактный коннектор Phoenix для подачи питания. Опционально может быть реализован внутренний порт SATA-3 для подсоединения накопителя. Диапазон рабочих температур простирается от 0 до +50 °C. Заявлена совместимость с Windows 10, Windows 11 и Ubuntu 24.04 Kernel 6.11. За безопасность отвечает модуль TPM 2.0.

26.01.2026 [10:29], Руслан Авдеев

Applied Digital построит 430-МВт ИИ ЦОД для секретного клиента в секретном местеApplied Digital, превратившаяся из криптоманинговой компании в провайдера ИИ-инфраструктуры, анонсировала начало строительства кампуса Delta Forge 1 мощностью 430 МВт (300 МВт IT-нагрузки) на юге США. При этом заказчик и точное место реализации проекта не называются, и тому есть причины, сообщает The Register. Изначально в кампусе Delta Forge 1 построят два здания по 150 МВт на территории более 200 га. Новый объект должен заработать в середине 2027 года. В ходе строительства прошлых проектов Applied Digital неоднократно сталкивалась с противодействием. Например, в Харвуде (Harwood) в Северной Дакоте местные жители выступили против строительства кампуса ЦОД Polaris Forge 2, то же случилось и с кампусом Polaris Forge 1 в Эллендейле (Ellendale) в том же штате. Applied Digital заявила, что подобной секретностью хотят дать муниципалитету время подготовиться к вниманию медиаресурсов. Утверждается, что компания не пытается ничего скрыть, просто маленькие городки не имеют развитых PR-представительств и именно им, а не компании, будет непросто. Ранее компания сообщила, что готовит соглашение с неназванным гиперскейлером о строительстве дата-центров на юге США, где в отличие от Северной Дакоты, заниматься строительством можно и зимой. На этом компания останавливаться не планирует, намереваясь освоить новые локации в Северной и Южной Дакоте и на отдельных рынках юга США. В 2020 году Applied Digital была известна как Applied Blockchain и занималась майнингом криптовалют. 1,5 ГВт строящихся мощностей отчасти принадлежали Bitmain. Планировалось размещение серверов для добычи биткоинов, но в будущем допускалось размещение оборудования других HPC-проектов. Впоследствии Applied Digital сдала в аренду Polaris Forge 1 компании CoreWeave, также в своё время занимавшейся криптомайнингом. Также Applied Digital сдала на 15 лет неназванному клиенту за $5 млрд 200 МВт мощностей в кампусе Polaris Forge 2. В городе с 900 жителями компания столкнулась с противодействием жителей своему 280-МВт кампуса стоимостью $3 млрд — людей беспокоил возможный шум, рост коммунальных тарифов и расширением застройки. Сменила профиль с криптовалют на ИИ и Crusoe, занявшаяся реализацией проекта OpenAI Stargate, а также некоторые другие криптокомпании. В январе 2026 года появилась информация, что майнер Riot Platforms сменит профиль и сдаст AMD 25 МВт мощностей ЦОД.

26.01.2026 [09:39], Владимир Мироненко

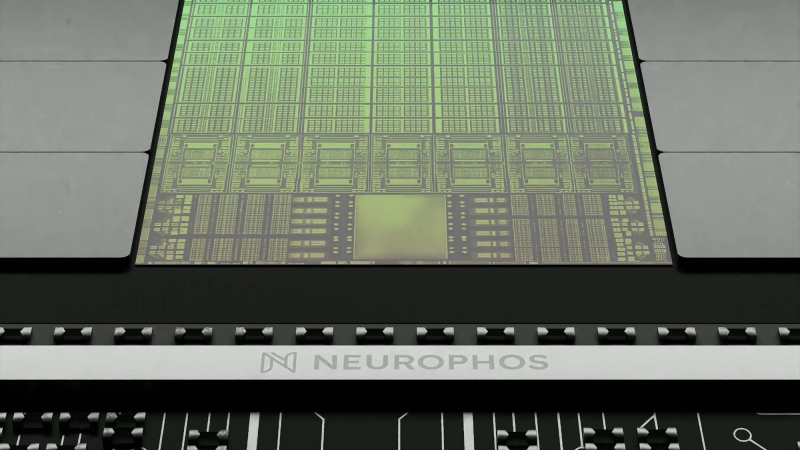

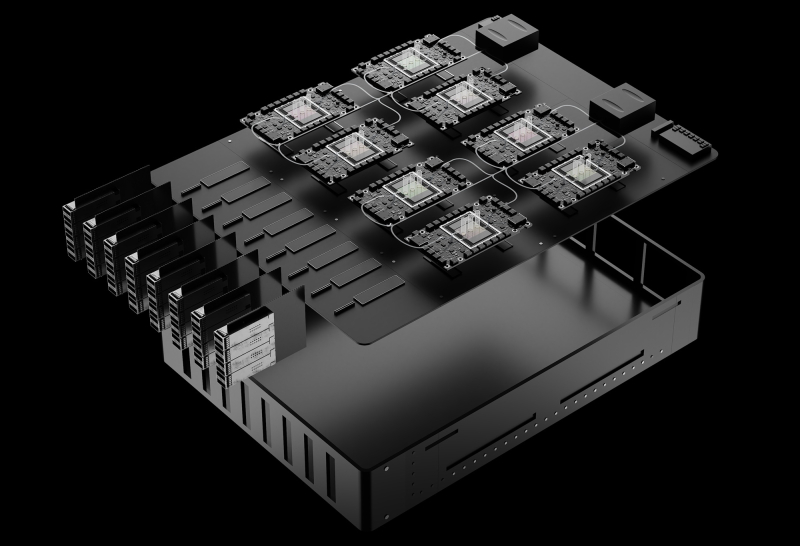

ИИ-расчёты — в OPU: Neurophos готовит 56-ГГц фотонный ускоритель Tulkas T100Стартап Neurophos, специализирующийся на разработках в области фотонных чипов для ИИ-нагрузок, сообщил о привлечении $110 млн в рамках переподписанного раунда финансирования серии А, в результате чего общий объём полученных им инвестиций вырос до $118 млн. Раунд возглавила Gates Frontier Билла Гейтса (Bill Gates) при участии M12 (венчурный фонд Microsoft), Carbon Direct Capital, Aramco Ventures, Bosch Ventures, Tectonic Ventures, Space Capital и др. В число инвесторов также вошли DNX Ventures, Geometry, Alumni Ventures, Wonderstone Ventures, MetaVC Partners, Morgan Creek Capital, Silicon Catalyst Ventures, Mana Ventures, Gaingels и другие. Юридическим консультантом выступает Cooley LLP. Полученные средства компания планирует использовать для ускорения разработки своей первой интегрированной фотонной вычислительной системы. Она включает в себя готовые к использованию в ЦОД модули OPU, полный программный стек и аппаратное обеспечение с ранним доступом для разработчиков. Кроме того, компания расширяет свою штаб-квартиру в Остине и открывает новый инженерный центр в Сан-Франциско для удовлетворения первоначального спроса клиентов. Стартап разработал «метаповерхностный модулятор» с оптическими свойствами, позволяющими его использовать в качестве тензорного процессора для выполнения матрично-векторного умножения. Разработанные стартапом оптические модуляторы на основе метаматериалов микронного масштаба в 10 тыс. раз меньше существующих фотонных элементов, что впервые делает фотонные вычисления реальностью. Эти модуляторы интегрируются с технологией вычислений в памяти для сокращения перемещения данных. «Современные задачи инференса с использованием ИИ требуют колоссальных вычислительных мощностей и ресурсов, — сообщил доктор Марк Трембле (Marc Tremblay), корпоративный вице-президент и технический эксперт по базовой ИИ-инфраструктуре ИИ. — Нам необходим прорыв в вычислительной мощности, сопоставимый с теми скачками, которые мы наблюдаем в самих ИИ-моделях, и именно этим занимается технология Neurophos и ее высококвалифицированная команда». Компания, основанная Патриком Боуэном (Patrick Bowen) и Эндрю Траверсо (Andrew Traverso), включает в себя ветеранов отрасли из NVIDIA, Apple, Samsung, Intel, AMD, Meta✴, ARM, Micron, Mellanox, Lightmatter и др. Neurophos разрабатывает оптический процессор (OPU), который объединяет более миллиона микронных оптических элементов обработки на одном чипе. Он обеспечивает до 100 раз большую производительность и энергоэффективность по сравнению с ведущими современными чипами, утверждает компания. «Закон Мура замедляется, но ИИ не может позволить себе ждать. Наш прорыв в фотонике открывает совершенно новый уровень масштабирования благодаря массивному оптическому параллелизму на одном чипе. Этот сдвиг на уровне физики означает, что как эффективность, так и скорость улучшаются по мере масштабирования, освобождаясь от энергетических барьеров, которые ограничивают традиционные GPU», — говорит Боуэн. «Эквивалент оптического транзистора, который вы получаете сегодня на заводах, огромен. Он имеет длину около 2 мм. Вы просто не можете разместить достаточное количество таких транзисторов на чипе, чтобы получить вычислительную плотность, хотя бы отдалённо конкурирующую с современными CMOS-технологиями», — сообщил ресурсу The Register Боуэн. «В мае мы получили первый кремниевый кристалл, продемонстрировав, что можем сделать это с помощью стандартного CMOS-процесса, что означает совместимость с существующими технологиями производства. На кристалле находится одно фотонное тензорное ядро размером 1000 × 1000 [обрабатывающих элементов]», — сказал он. Это значительно больше, чем обычно встречается в большинстве GPU, которые обычно используют механизмы матричного умножения размером 256 × 256 обрабатывающих элементов. Однако для чипа Neurophos достаточно одного тензорного ядра вместо десятков или даже сотен таких, как в ускорителях NVIDIA. Боуэн говорит, что тензорное ядро в ускорителе Neurophos первого поколения будет занимать примерно 25 мм². Оснащение остальной части микросхемы размером с фотошаблон — это «главная проблема, связанная с поддержкой этого невероятно мощного тензорного ядра», сказал Боуэн. В частности, Neurophos требуется огромное количество векторных процессоров и SRAM, чтобы тензорное ядро не испытывало нехватки данных. Это связано с тем, что само тензорное ядро — которое в чипе будет всего лишь одно — работает на частоте около 56 ГГц. Но поскольку матричное умножение выполняется оптическим методом, единственная потребляемая тензорным ядром энергия уходит на преобразование электрических сигналов в оптические и обратно, сообщил Боуэн. Как сообщает Neurophos, её первый OPU Tulkas T100 получит 768 Гбайт памяти HBM (20 Тбайт/с) и 200 Мбайт L2-кеша. Производительность системы составит 470 POPS (FP4/INT4) или 400 TOPS (FP16/INT16) при потреблении от 1 до 2 КВт под нагрузкой, демонстрируя энергоэффективность до 235 TOPS/Вт. Следует учитывать, что эти цифры пока лишь ориентиры. Чип всё ещё находится в активной разработке, и полномасштабное производство, как ожидается, начнётся не раньше середины 2028 года. Как утверждают в Neurophos, проблем с массовым производством оптических чипов не предвидится, поскольку они могут быть изготовлены с использованием стандартных материалов, инструментов и процессов полупроводниковых фабрик. Боуэн предполагает, что Tulkas T100 будет выполнять аналогичную роль, что и соускоритель NVIDIA Rubin CPX для работы с контекстом и создания KV-кеша. «Текущая концепция, которая может измениться, заключается в том, что мы разместим одну нашу стойку, состоящую из 256 наших чипов, и она будет сопряжена с чем-то вроде стойки NVL576», — сказал он. В долгосрочной перспективе возможен и переход к генерации токенов, но для этого потребуется разработка множества технологий, включая интегрированную оптику. Боуэн сообщил ресурсу TechCrunch, что Neurophos уже заключил контракты с несколькими клиентами (хотя он отказался назвать их имена), и такие компании, как Microsoft, «очень внимательно изучают» продукцию стартапа. Хотя на рынке ИИ-ускорителей и так большая конкуренция, Боуэн уверен, что повышение производительности и эффективности, обеспечиваемое оптическими вычислениями, станет достаточным конкурентным преимуществом чипов стартапа. «Все остальные, включая NVIDIA, в плане фундаментальной физики кремния, скорее эволюционны, чем революционны, и это связано с прогрессом TSMC. Если посмотреть на улучшение техпроцессов TSMC, то в среднем они повышают энергоэффективность примерно на 15 %, и на это уходит пара лет», — сказал он. |

|