Материалы по тегу: hardware

|

12.02.2025 [17:33], Руслан Авдеев

Гигаватт с доставкой: VoltaGrid оснастит дата-центры Vantage в США автономными газовыми электрогенераторамиЗанимающаяся управлением энергоснабжением и микросетевой генерацией компания VoltaGrid заключила договор с оператором Vantage Data Centers. VoltaGrid оснастит североамериканские кампусы Vantage автономными генераторами на природном газе суммарной мощностью 1 ГВт, которые станут основными источниками питания ЦОД. Возможность быстрого развёртывания генерирующих мощностей с использованием природного газа является одним из самых простых решений проблемы энергообеспечения дата-центров в США. Благо политика новой администрации только способствует этому Решающим фактором для Vantage и VoltaGrid является скорость выхода на рынок, что позволит своевременно обеспечить гиперскейлерам необходимую энергетическую инфраструктуру без длинных очередей на подключение к электросетям. Именно её генераторы оперативно запитали дата-центр xAI, который всё ещё ожидал подключения к энергосети. DataVolt отмечает, что микросети (microgrid) обеспечат сокращение выбросов до 98 %, а её решения способны работать исключительно на водороде или биометане. VoltaGrid вместе с поставщиком газовых двигателей Jenbacher займётся разработкой модульных газовых систем питания для рынка дата-центров. Новая платформа QPac способна обеспечить до 20 МВт на каждый модуль, объединяя которые можно получить до 200 МВт, сообщает Datacenter Dynamics. Возможностей партнёров достаточно для развёртывания 50 МВт ежемесячно. Vantage Data Centers считается одним из ключевых поставщиков инфраструктуры ЦОД гиперскейлерам. В прошлом году компания привлекла $9,2 млрд в виде акционерного капитала в раунде финансирования, который возглавили DigitalBridge Group и Silver Lake — было собрано на $2,8 млрд больше, чем планировалось. Компания объявляла, что средства будут потрачены на развитие мощностей в Северной Америке и регионе EMEA (Европа, Ближний Восток, Африка). Тема газовых автономных мощностей сегодня весьма популярна в США. В частности, ожидается, что газовые генераторы получит первый ЦОД мегапроекта Stargate, а в конце января сообщалось, что NextEra с GE Vernova развернут газовые турбины и перезапустят АЭС, чтобы запитать ИИ ЦОД.

12.02.2025 [12:00], Сергей Карасёв

iXsystems представила СХД TrueNAS H30 с возможностью создания гибридных и All-Flash конфигурацийКомпания iXsystems анонсировала СХД TrueNAS H30 в форм-факторе 2U, оптимизированную для поддержания периферийных нагрузок. Устройство допускает создание гибридных конфигураций на базе HDD и SSD, а также формирование массивов All-Flash. В зависимости от версии TrueNAS H30 оснащается одним или двумя контроллерами (256 Гбайт памяти в расчёте на контроллер). Доступны четыре сетевых порта 1GbE и два порта 10GbE, а в качестве опции предлагаются четыре разъёма 10/25GbE или два порта 10/25GbE и два порта 40/100GbE. Во фронтальной части расположены отсеки для 12 накопителей LFF: могут применяться HDD с интерфейсом SAS или NVMe SSD. Максимальная суммарная вместимость при использовании твердотельных накопителей на 60 Тбайт каждый достигает 720 Тбайт.

Источник изображения: TrueNAS Допускается подключение одной полки расширения ES24, ES60 или ES102 с поддержкой соответственно 24, 60 и 102 накопителей. Заявленная суммарная вместимость в гибридной конфигурации составляет до 2,5 Пбайт, эффективная — 5 Пбайт. Обеспечивается пропускная способность до 8 Гбайт/с. За питание отвечают два блока с сертификатом 80 Plus Platinum и возможностью горячей замены. Диапазон рабочих температур — от 0 до +40 °C. Упомянута поддержка протоколов SMB v1/v2/v3, NFS v3/v4, AFP, FTP, WebDAV, iSCSI, OpenStack Cinder, S3. Габариты составляют 681 × 483 × 89 мм. СХД использует ПО TrueNAS 24.10.2 Electric Eel с последующим обновлением до TrueNAS 25.04 Fangtooth. Утверждается, что устройство обеспечивает увеличение производительности и ёмкости более чем на 300 % по сравнению с СХД предыдущего поколения.

12.02.2025 [11:58], Сергей Карасёв

Tencent Cloud открыла в Саудовской Аравии свой первый облачный регион на Ближнем ВостокеКитайская платформа Tencent Cloud, по сообщению ресурса Datacenter Dynamics, развернула свой первый облачный регион на Ближнем Востоке — он расположен в Саудовской Аравии. Предполагается, что запуск платформы будет способствовать улучшению цифровой инфраструктуры Королевства и ускорению внедрения передовых технологий. Об открытии нового облачного региона объявлено на технологическом саммите Министерства связи и технологий Саудовской Аравии LEAP 2025, на котором было объявлено о $14,9 млрд инвестиций в ИИ-сектор страны. Tencent также сообщила о намерении инвестировать в IT-сектор страны более $150 млн в течение нескольких следующих лет. Регион состоит из двух зон доступности с полным резервированием. Клиентам будут предлагаться современные облачные услуги и сервисы на основе ИИ. Дэн Ху (Dan Hu), вице-президент подразделения Tencent Cloud на Ближнем Востоке и в Северной Африке, говорит, что открытие облачной площадки поможет в развитии таких направлений, как цифровые медиа, потоковая передача данных, видеоигры, киберспорт, электронная коммерция, туризм, финансовые услуги, телекоммуникации и пр. Новая площадка является частью глобальной облачной сети Tencent Cloud, которая в настоящее время объединяет 21 регион по всему миру с более чем 50 зонами доступности. Хотя компания в основном ведёт деятельность в Азии, у неё также есть объекты в Северной Америке (Кремниевая долина, Вирджиния, Торонто), Европе (Франкфурт) и Южной Америке (Сан-Паулу). Нужно отметить, что многие другие крупные компании в области ЦОД и ИИ активно развивают бизнес в Саудовской Аравии. Так, в сентябре 2023 года свой первый облачный регион в стране запустила китайская Huawei. О намерении заняться строительством дата-центров на территории Королевства объявили Saudi Call и China Mobile, AWS и DataVolt, а также Armada. А компания Groq развернула в Саудовской Аравии крупнейший в Европе, на Ближнем Востоке и в Африке (EMEA) вычислительный ИИ-центр для задач инференса.

12.02.2025 [08:29], Владимир Мироненко

NXP Semiconductors купила Kinara, разработчика NPU для периферийных вычисленийНидерландский производитель микросхем NXP Semiconductors N.V. сообщил о приобретении за $307 млн калифорнийского стартапа Kinara, специализирующегося на разработке программируемых дискретных нейропроцессорных модулей (NPU) для обработки ИИ-нагрузок на периферии. Как ожидается, сделка будет закрыта во II половине 2025 года после получения одобрения регуляторами. NXP и Kinara являются давними партнёрами, так что интеграция решений не займёт много времени. В пресс-релизе указано, что инновационные NPU и комплексное ПО Kinara обеспечивают высокую производительность в сочетании энергоэффективностью при обработке различных нейронных сетей, включая генеративный ИИ, для удовлетворения быстрорастущих потребностей в интеллектуальных функциях на промышленных и автомобильных рынках. Приобретение Kinara позволит расширить возможности NXP по предложению масштабируемых ИИ-платформ, от облегчённых и оптимизированных вариантов (TinyML) до полноценного генеративного ИИ. Сообщается, что дискретные NPU Kinara, включая Ara-1 и Ara-2, предназначенные для периферийных вычислений, входят в число лидеров отрасли по производительности и энергоэффективности, что делает их предпочтительным решением для новых приложений ИИ в области визуализации, обработки голоса, жестов и множества других многомодальных вариантов генеративного ИИ. Оба чипа имеют инновационную архитектуру, которая отличается не только энергоэффективностью в задачах инференса, но и программируемостью, что позволяет со временем задействовать всё новые модели и сценарии, включая, например, агентный ИИ в будущем.

Источник изображения: Kinara NPU второго поколения Ara-2 обеспечивает производительность до 40 TOPS, оптимизирован для достижения высокой производительности на системном уровне для генеративного ИИ. NPU Ara-1 и Ara-2 можно легко интегрировать со встраиваемыми системами для расширения их возможностей, включая модернизацию уже развёрнутых систем. Также Kiara предоставляет полный комплект инструментов для разработки ПО, позволяющий клиентам оптимизировать производительность моделей и упростить их развёртывание. Инструмены и библиотеки ИИ Kinara будут интегрированы в среду разработки NXP eIQ AI/ML, чтобы клиенты могли быстро и легко создавать сквозные готовые ИИ-решения.

12.02.2025 [00:50], Владимир Мироненко

AMD и французские атомщики вместе займутся развитием технологий для ИИ-инфраструктур будущегоAMD объявила о подписании соглашения о намерениях с французским Комиссариатом по атомной энергии и альтернативным источникам энергии (CEA) с целью совместной работы над созданием передовых технологий, компонентов и системных архитектур, которые определят будущее ИИ-вычислений. Сотрудничество позволит использовать сильные стороны обеих организаций в разработке энергоэффективных систем и технологий для вычислительной инфраструктуры следующего поколения, необходимых для поддержки самых ресурсоёмких в мире рабочих ИИ-нагрузок в различных областях — от энергетики до медицины. AMD и CEA планируют провести в 2025 году симпозиум, посвящённый будущему ИИ-вычислений, который соберёт европейских и глобальных разработчиков технологий, стартапы, суперкомпьютерные центры, университеты и политиков с целью укрепления сотрудничества в разработке современных вычислительных технологий ИИ. В CEA отметили, что сотрудничество с AMD является значительным шагом на пути к укреплению международного партнёрства в области HPC, позволяя объединить экспертные знания мирового уровня для удовлетворения растущих потребностей в обслуживании ИИ-нагрузок. В свою очередь, в AMD подчеркнули, что в сотрудничестве с CEA и ведущими французскими инженерами компания стремится приблизить передовые исследования в области ИИ к реальным приложениям, развивая системные архитектуры, которые отвечают требованиям будущих рабочих нагрузок, одновременно расширяя возможности для совместных исследований и разработок США и Франции. Большая часть электроэнергии во Франции производится АЭС, что позволяет обеспечивать внутренние потребности, а также поставлять излишки за рубеж. Франция рассматривает это как ключевой фактор для привлечения инвесторов, стремящихся развивать инфраструктуру энергоёмких ЦОД в стране. По словам президента Франции Эммануэля Макрона (Emmanuel Macron), это позволит разместить в стране 20 % всех ЦОД в мире. В понедельник Макрон объявил, что объём частных инвестиций в ИИ-сектор страны составит в ближайшие несколько лет около €109 млрд.

11.02.2025 [17:29], Руслан Авдеев

T5 Data Centers намерена построить пять гигаваттных кампусов ЦОД в СШАОператор ЦОД T5 Data Centers готовится построить несколько гигаваттных дата-центров. Реализация проектов начнётся со строительства кампуса ЦОД Chicago IV в в Грейслейке, пригороде Чикаго (Иллинойс). Информация появилась на странице компании в одной из социальных сетей. Речь идёт о ключевой вехе в проекте строительства пяти кампусов дата-центров гигаваттного класса. Кампус Chicago IV получит 20 зданий, каждое из них обеспечит до 60 МВт ёмкости, в общей сложности — до 1,2 ГВт (всего зарезервировано 1,6 ГВт). Размещение вычислительных мощностей на первом этапе запланировано на 2027 год. Обещана поддержка стоек мощностью до 50 кВт и возможность применения СЖО. Впервые T5 объявила о планах создания кампуса в мае 2024 года. Планировалось, что участок площадью 65 га вместит объекты суммарной мощностью 480 МВт, а первое здание на 60 МВт планировалось ввести в эксплуатацию в IV квартале 2027 года. Теперь же ёмкость кампуса значительно увеличили. На сайте компании говорится, что она построила уже 22 дата-центра, а общий объём доступных момщностей достиг 1,7 ГВт.

11.02.2025 [16:26], Руслан Авдеев

Brookfield потратит €20 млрд на ИИ-инфраструктуру во ФранцииBrookfield Asset Management намерена инвестировать во Франции €20 млрд ($20,7 млрд) в развитие дата-центров и вспомогательной ИИ-инфраструктуры. Инвестиции рассчитаны на следующие пять лет — на фоне усиливающейся конкуренции развитых стран на рынке ИИ, сообщает Bloomberg. Компания выделила €15 млрд на развитие ЦОД. Ведущим исполнителем проекта станет компания Data4, входящая в портфолио самого инвестора. Остальные средства будут потрачены на проекты ИИ-инфраструктуры — решения для передачи данных, СХД и генерацию энергии на территории Франции. В Brookfield утверждают, что Франция — прекрасное место для инфраструктуры ИИ благодаря благоприятным политическим условиям и наличию квалифицированных кадров. По словам Bloomberg, Европа отстала в гонке ИИ от США и Китая. Хотя некоторые стартапы из Франции, вроде Mistral AI SAS, привлекли значительные средства, значительными они являются только сравнении с другими европейскими коллегами, а вот конкурировать с лидерами отрасли им нелегко. Поэтому Франция развернула активную деятельность по инвестированию в ИИ-сектор — на днях было объявлено о привлечении €109 млрд. Инвестиции Brookfield входят в эту сумму.

Источник изображения: Anthony Tan/unsplash.com Brookfield, открывшая представительство в Париже в декабре 2024 года, располагает в стране активами на $30 млрд и намерена увеличить их вдвое в следующие пять лет. По всему миру компания инвестировала €150 млрд в цифровую инфраструктуру, возобновляемую энергетику и производство чипов. Недавно сообщалось, что даже триумф технологий китайского стартапа DeepSeek, сумевшего обойтись малыми вычислительными ресурсами для создания эффективной ИИ-модели, не поколебал уверенности Brookfield в необходимости инвестировать в рынок ЦОД. В компании сообщили, что и ранее ожидали качественного скачка в развитии ИИ, но дата-центры по-прежнему будут востребованы за счёт расширения сфер применения искусственного интеллекта.

11.02.2025 [16:24], Владимир Мироненко

ИИ ЦОД за 20 недель: G42 и DataOne построят крупнейший во Франции суперкомьютер на чипах AMD InstinctХолдинг G42 из Абу-Даби (ОАЭ) объявил о стратегических инвестициях во Франции в партнёрстве с недавно образованной DataOne, которая сама себя называет первым в Европе оператором гига-ЦОД для ИИ. Вместе компании в кратчайшие сроки построят в Гренобле ИИ ЦОД, оснащённый ускорителями AMD Instinct. Ожидается, что объект будет полностью введён в эксплуатацию к середине 2025 года. Вычислительные возможности нового ЦОД позволят французским компаниям и учёным разрабатывать передовые модели ИИ, агентов и приложения, а также проводить различные исследования. Реализацией проекта будет заниматься компания Core42, дочернее предприятие G42, совместно с DataOne. По словам главы DataOne Шарля-Антуана Бейни (Charles-Antoine Beyney), на развёртывание крупнейшего ИИ-суперкомпьютера в Европе потребуется всего 20 недель. Для сравнения: кластер xAI Colossus был построен за 122 дня. Как заявила Лиза Су (Lisa Su), председатель и генеральный директор AMD, стратегическое сотрудничество с G42 поможет активизировать французскую экосистему ИИ, предоставив вычислительную мощность, необходимую для поддержки местных стартапов и новаторов, занимающихся передовыми разработками, которые укрепляют французскую экономику. «Работа с G42 является ещё одним примером нашей приверженности объединению открытых экосистем с ведущими в отрасли технологиями ИИ AMD, что обеспечивает возможность государственным учреждениям и частным предприятиям использовать весь потенциал ИИ», — подчеркнула Лиза Су. Инвестиции G42 входят в пакет частных инвестиций в ИИ-инфраструктуру страны на €109 млрд, анонсированный президентом Франции Эммануэле Макроном (Emmanuel Macron) в качестве ответа на представленный в США проект Stargate. Ранее было объявлено о планах ОАЭ вложить при участии фонда MGX €30–50 млрд в проект по созданию кампуса ИИ ЦОД во Франции. В G42 называют инвестиции в ИИ одним из главных направлений своей деятельности. Деятельность холдинга получила поддержку Microsoft, инвестировавшей в него $1,5 млрд. В прошлом году G42 договорился с Cerebras о строительстве в Техасе ИИ-суперкомпьютера со 173 млн ядер.

11.02.2025 [13:47], Руслан Авдеев

Tesla запустила суперкомпьютер Cortex с 50 тыс. ускорителей NVIDIA H100, а общие затраты компании на ИИ уже превысили $5 млрдКомпания Tesla завершила ввод в эксплуатацию ИИ-кластера из 50 тыс. ИИ-ускорителей NVIDIA H100 в IV квартале прошлого года. В презентации для акционеров отмечалось, что кластер Cortex заработал на принадлежащем Tesla объекте Gigafactory в Остине (Техас), сообщает Datacenter Dynamics. Информация впервые появилась в отчёте компании за IV квартал и 2024 финансовый год. Новый кластер не имеет отношения к суперкомпьютеру Dojo, предназначенному для технологий автономного вождения FSD, имеющего собственную архитектуру и оснащенного кастомными чипами D1. При этом в презентации, посвящённой отчёту, Dojo не упоминается вообще. Хотя компания не уточняет, когда именно в IV квартале началось развёртывание системы, на конференции по финансовым вопросам в октябре 2024 года представитель Tesla заявил, что компания находится «на пути к развёртыванию 50 тыс. ускорителей в Техасе к концу текущего месяца». По имеющимся данным, проект реализован с опозданием, поскольку Илон Маск уволил руководителя строительством ещё в апреле, а также приказал передать xAI 12 тыс. ускорителей H100, изначально предназначавшихся Tesla.

Источник изображения: Tesla В презентации сообщается, что именно Cortex уже помог в создании «автопилота» FSD V13 (Supervised). Новая версия повысила безопасность и комфорт вождения благодаря увеличению объёма данных в 4,2 раза, повышению разрешения видеопотока, а также другим усовершенствованиям. Заодно компания сообщила о продолжении работ над программной и аппаратной частями робота Optimus, в т.ч. рук нового поколения и механизмов передвижения. Также осуществлялось обучение выполнению дополнительных задач перед началом пилотного производства в 2025 году. Что касается доходов компании в IV квартале, в конце января Илон Маск (Elon Musk) сообщил, что бизнес продолжает инвестировать в обучающую инфраструктуру за пределами штаб-квартиры в Техасе. В конце января сообщалось, что Tesla наращивает вычислительные мощности для обучения Optimus. По словам миллиардера, на обучение Optimus необходимо потратить, как минимум, в 10 раз больше ресурсов в сравнении с полноценным обучением систем автомобиля. Капитальные затраты Tesla в 2024 году составили $10 млрд, столько же компания намерена потратить в ближайшие два года, хотя большая часть затрат придётся на инфраструктуру для электромобилей. В отчёте о доходах за IV квартал упоминалось, что общие капитальные затраты компании, связанные с ИИ, включая инфраструктуру, превысили $5 млрд.

11.02.2025 [11:43], Сергей Карасёв

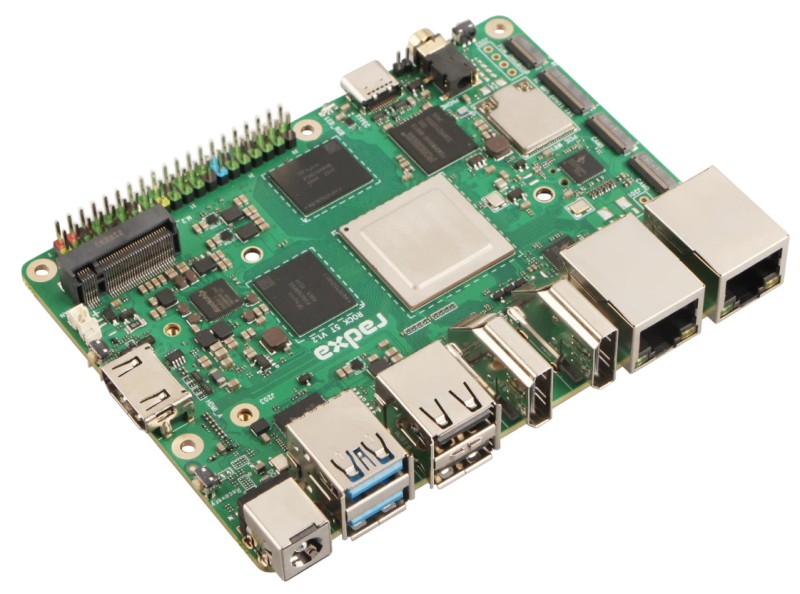

Одноплатный компьютер Radxa Rock 5T может нести на борту 32 Гбайт ОЗУ и два M.2 SSDКомпания Radxa, по сообщению ресурса CNX Software, анонсировала одноплатный компьютер Rock 5T, который является родственником модели Rock 5 ITX, дебютировавшей в мае прошлого года. Новинка доступна для заказа по ориентировочной цене от $115. Устройство несёт на борту процессор Rockchip RK3588, который объединяет четыре ядра Cortex-A76 (2,4 ГГц) и четыре ядра Cortex-A55 (1,8 ГГц), графический блок Arm Mali-G610 MC4 и нейропроцессорный модуль (NPU) с производительностью до 6 TOPS. Объём оперативной памяти LPDDR5 может составлять 4, 8, 16, 24 и 32 Гбайт. Одноплатный компьютер располагает двумя коннекторами M.2 2280 для NVMe SSD (PCIe 3.0 x2), а также разъёмом для карты microSD. Опционально может быть добавлен встроенный модуль eMMC вместимостью от 16 до 128 Гбайт. В оснащение входят два порта 2.5GbE (RJ-45), один из которых поддерживает технологию PoE. Есть и разъём M.2 Key-B 3042 (плюс слот для карты Nano SIM) для подключения модема 4G/5G. Изделие Rock 5T доступно в коммерческом и индустриальном вариантах исполнения: в первом случае диапазон рабочих температур простирается от 0 до +60 °C, во втором — от -40 до +85 °C. Коммерческая версия укомплектована модулем Wi-Fi 6 / Bluetooth 5.2, индустриальная — Wi-Fi 6E / Bluetooth 5.3. Одноплатный компьютер имеет размеры 110 × 80 мм. Он снабжён двумя интерфейсами HDMI (один с поддержкой 8Kp60, второй — 4Kp60), двумя портами USB 3.1 Gen1 Type-A и двумя USB 2.0 Type-A, одним разъёмом USB 3.1 Gen1 Type-C, аудиогнездом на 3,5 мм, коннектором MIPI DSI (4 линии) и двумя коннекторами MIPI CSI (4 линии). Питание (12 В) подаётся через DC-разъём. Предусмотрена 40-контактная колодка GPIO, совместимая с Raspberry Pi. |

|