Материалы по тегу: hardware

|

01.05.2025 [23:28], Руслан Авдеев

TikTok намерена потратить €1 млрд на дата-центр в ФинляндииСоциальная сеть TikTok, по слухам, планирует потратить €1 млрд ($1,14 млрд) на свой первый дата-центр в Финляндии, передаёт Reuters. Представитель компании подтвердил информацию, но не уточнил, собирается ли TikTok построить собственный дата-центр или взять в аренду сторонний объект. Компания также не сообщила о точном местоположении ЦОД, его мощности и сроках строительства. В 2023 году китайская ByteDance, «родительская» компания TikTok, начала реализацию т.н. Project Clover. Эта инициатива предусматривает перенос данных европейских пользователей на серверы, расположенные в Евросоюзе в ответ на озабоченность, выраженную местными законодателями. В США аналогичный проект Project Texas по переносу данных в облако Oracle не спас компанию от преследования со стороны правительства. В рамках Project Clover TikTok целиком получила в своё распоряжение норвежский кампус Green Mountain OSL2-Hamar. Планы были обнародовали ещё в марте 2023 года, первый ЦОД закончили строить в декабре того же года, а ввод его в эксплуатацию был намечен на II квартале 2024 года. Правда, переносить европейские данные в новый кампус компания начала только в октябре того же года. Также компания с 2023 года располагает дата-центром в Ирландии. Дополнительно компания рассматривает строительство дата-центра в Бразилии и пообещала потратить $8,8 млрд на цифровую инфраструктуру в Таиланде. А вот будущее TikTok в США остаётся под вопросом. ByteDance буквально приказали отказаться от работы в стране, продав американскую часть бизнеса. В противном случае приложение просто отключат для американских пользователей по соображениям «национальной безопасности». При этом пока нет ни одной компании, которая заключила бы соглашение о покупке бизнеса, хотя многие, по слухам, выражали интерес и даже прощупывали почву на предмет возможной аренды ЦОД в США.

01.05.2025 [22:55], Руслан Авдеев

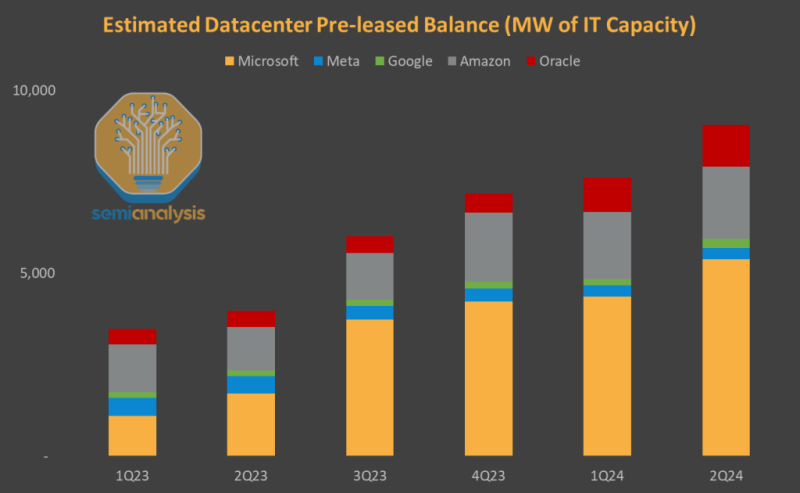

Тысячи гектар земли и гигаватты энергии: Microsoft готовилась к самому масштабному строительству ЦОД за всю свою историю, но затем передумалаВ последние месяцы сразу несколько источников сообщили о резком пересмотре планов Microsoft по аренде ЦОД, что насторожило аналитиков. Компания действительно расторгла несколько контрактов, но история гораздо сложнее, чем кажется, сообщает SemiAnalysis. В прошлом году компания «перестаралась», сумев предварительно застолбить больше мощностей, чем Amazon, Google, Meta✴ и Oracle вместе взятые. Microsoft фактически «заморозила» рынок аренды ЦОД, но в итоге решила существенно скорректировать планы. Так, внимание общественности привлёк отказ от аренды объектов суммарной мощностью 2 ГВт, однако в данном случае речь идёт о необязывающих предварительных соглашениях. По данным SemiAnalysis, в 2023 году и I половине 2024 года Microsoft безраздельно доминировала на рынке аренды и не только «агрессивно» заключала сделки, но и фактически контролировала рынок, резервируя мощности через предварительные соглашения. Microsoft забронировала более 60 % новых мощностей и к июню 2024 года обогнала по этому показателю четырёх других крупных гиперскейлеров вместе взятых. С тех пор компания полностью остановила активности по поиску новых мощностей для аренды. Microsoft успела обсудить аренду чуть ли не с каждым оператором, так что речь идёт об отказе от гораздо больших мощностей, чем 2 ГВт. Что важнее, у Microsoft есть и обязывающие соглашения о предварительной аренде приблизительно 5 ГВт, которые будут введены в строй в 2025–2028 гг. Хотя «замедление» аренды носит существенный характер, оно в кратко- и среднесрочной перспективе не скажется на инфраструктурных проектах, последствия этого шага станут заметны не раньше 2027 года. На этом фоне гораздо важнее заморозка планов Microsoft по строительству собственных дата-центров. Исследования SemiAnalysis показывают, что компания поставила на паузу по всему миру проекты ЦОД на 1,5 ГВт, которые планировалось запустить в 2025–2026 гг. В прошлом году компания занималась покупкой десятков тысяч га земли по всему миру и заключением договоров на поставку гигаватт энергии для будущих объектов. По оценке SemiAnalysis, Microsoft готовилась к самому масштабному строительству инфраструктуры за всю свою историю. Сейчас речь идёт об остановке ряда проектов (хоть и не всех), что обязательно скажется на доступности мощностей в ближайшем будущем. Фактически Microsoft намеренно замедляет свою деятельность в этом направлении. По словам SemiAnalysis, некоторые подготовительные работы на строительных площадках ещё ведутся, но само строительство фактически остановлено, как отложены или отменены новые заказы на охлаждающее и электрическое оборудование. Работы ведутся несопоставимо медленнее, чем в 2023–2024 гг. Несмотря на обещания потратить на инфраструктуру $80 млрд, Microsoft стала менее расточительной и более гибкой. Фактически на рынке неправильно поняли тенденции в поведении Microsoft и их причины. Судя по всему, решения о сокращении последовали за изменениями отношений с OpenAI и слабыми показателями собственных ИИ-разработок. Ранее экспансия основывалась на успехах OpenAI, тесно связанной с Microsoft. OpenAI планировала реализовать масштабные строительные проекты, и в планах по увеличению вычислительной мощности Microsoft играла центральную роль. Но позже OpenAI получила право работать и с другими операторами ЦОД. Ситуация кардинально изменилась в 2025 году, когда закончилось эксклюзивное партнёрство между Microsoft и OpenAI. Последняя перенесла значительные вычислительные мощности на площадки Oracle. Crusoe уже строит дата-центр на 1,2 ГВт для первого кампуса OpenAI Stargate в Техасе. Также OpenAI подписала контракт стоимостью $11,9 млрд сроком на пять лет с CoreWeave и вложила в компанию $350 млн. В будущем CoreWeave будет использоваться и для инференса OpenAI, тогда как ранее право на это принадлежало исключительно Microsoft. По мнению SemiAnalysis, Microsoft столкнулась и с внутренними проблемами. Её собственные ИИ-модели отстают от продуктов конкурентов, а спрос на её корпоративные ИИ-инструменты оказался ниже ожидаемого. Microsoft по-прежнему планирует нарастить мощность ЦОД в 2025–2026 гг., но структура инвестиций меняется. Значительно увеличились затраты на ускорители, а вот строительство новых собственных ЦОД действительно стагнирует или даже слегка идёт на спад. Более того, компания в целом переориентируется на схемы аренды ЦОД, а не их возведения. В целом на мировом рынке значительная часть заранее арендованных дата-центров уже строится. Но и сам рынок меняется — влияние CoreWeave и Oracle растёт, меняя расстановку сил.

01.05.2025 [19:13], Сергей Карасёв

Schneider Electric наращивает выручку благодаря спросу на решения для ЦОДКомпания Schneider Electric отрапортовала о работе в I квартале 2025 года. Выручка французской энергомашиностроительной корпорации достигла €9,33 млрд, что на 7,4 % больше по сравнению с результатом за I четверть прошлого года. Положительная динамика, как отмечается, во многом обусловлена хорошим спросом на энергетические решения для ЦОД. В географическом плане наибольшая доля продаж пришлась на Северную Америку — €3,51 млрд. Западная Европа обеспечила вклад в размере €2,13 млрд, Азиатско-Тихоокеанский регион — €2,58 млрд. На все прочие региональные рынки вместе взятые пришлось €1,11 млрд.

Источник изображения: Schneider Electric В сегменте систем питания выручка увеличилась в годовом исчислении на 9,6 %, достигнув €7,57 млрд по итогам I квартала 2025 года. При этом в Северной Америке зафиксирован результат в €3,12 млрд, в Западной Европе — €1,66 млрд, в Азиатско-Тихоокеанском регионе — €1,99 млрд. На прочие географические рынки пришлось €803 млн. Финансовый директор Schneider Хилари Максон (Hilary Maxson) отмечает, что в сегменте ЦОД сохраняется высокий рост, исчисляемый «двузначными числами» в процентах. При этом наибольшая динамика отмечена в Северной Америке и Восточной Азии. Западная Европа демонстрирует не столь высокие темпы, что отчасти связано с вопросами получения разрешений на энергоснабжение дата-центров. В Азии значительную часть поступлений для Schneider обеспечивает Индия. В I четверти 2025 года суммарная выручка Schneider от поставок средств автоматизации составила €1,76 млрд, снизившись на 0,9 % в годовом исчислении. Северная Америка принесла €391 млн. Продажи такого оборудования в Западной Европе и Азиатско-Тихоокеанском регионе составили соответственно €471 млн и €591 млн. На все прочие рынки пришлось суммарно €302 млн.

01.05.2025 [00:45], Руслан Авдеев

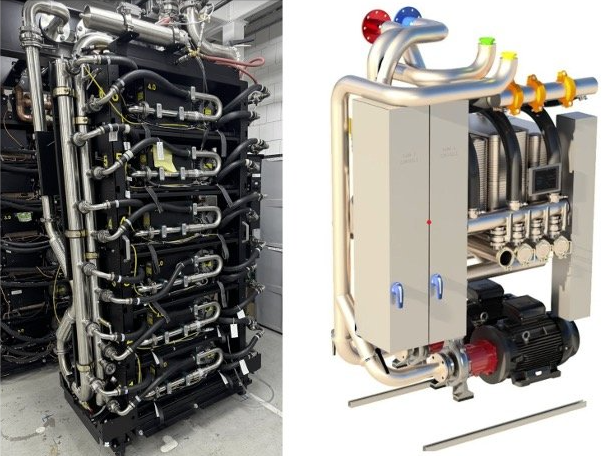

Google готовит мегаваттные стойки с питанием 400 В и СЖО для ИИ-платформ будущегоGoogle представил технологию питания 400 В постоянного тока (DC) и систему жидкостного охлаждения пятого поколения Project Deschutes для стоек нового поколения, которы призваны поддержать стремительное развитие ИИ. В течение последних десяти лет компания использует питание 48 В DC, но переход к новому стандарту позволит повысить максимальную мощность на одну стойку со 100 кВт до 1 МВт. Ожидается, что отдельные стойки с ИИ-системами будут потреблять свыше 500 кВт уже к 2030 году. Так, грядущий суперускоритель NVIDIA Rubin Ultra NVL576, который появится в 2027 году, будет «упакован» в стойку нового поколения Kyber и потреблять порядка 600 кВт. Google, надо полагать, разработает собственную модификацию данного ускорителя, адаптированного к её дата-центрам, как уже сделала для GB200 NVL72. Использование 400 В позволяет задействовать цепочку поставок, используемую индустрией электромобилей, что способствует снижению затрат и повышению качества. Совместно с Meta✴ и Microsoft компания Google работает над проектом Mt. Diablo, в рамках которого вырабатываются общие стандарты электрических и механических интерфейсов. Первая версия спецификаций (v0.5) будет доступна для отраслевого обсуждения в мае 2025 года.

Источник изображения: Google Подсистема питания в Mt. Diablo вынесена в отдельный модуль (sidecar). Это увеличивает полезное пространство в серверных стойках, позволяя целиком отдать их под ускорители, и повышает общую энергоэффективность приблизительно на 3 %, что в масштабах гиперскейлера очень существенно. В перспективе рассматривается переход на прямое распределение высоковольтного постоянного тока внутри ЦОД для ещё большей эффективности и повышения плотности.

Источник изображения: Google С резким повышением энергопотребления чипов использование СЖО стало неизбежным. В последние семь лет Google развернула СЖО в более 2 тыс. кластеров TPU Pod. Впервые жидкостное охлаждение стало применяться для ИИ-ускорителей TPU v3, появившихся в 2018 году. Компания использует водоблоки, что позволяет практически удвоить плотность размещения вычислительных мощностей в сравнении с воздушным охлаждением. При переходе от TPU v2 к TPU v3 это также позволило вчетверо увеличить размер кластеров. СЖО применяются и для ускорителей Ironwood (TPU v7). CDU-архитектура Project Deschutes, в которой используются резервные теплообменники и насосы, обеспечивает уровень доступности 99,999 %. Пятое поколение Project Deschutes Google планирует передать Open Compute Project (OCP) в 2025 году. Публикация спецификаций, проектных данных и рекомендаций по эксплуатации ускорит массовое внедрение СЖО в индустрии. В компании уверены, что совместные усилия помогут индустрии справиться с будущими вызовами в индустрии ИИ и масштабировать вычислительные мощности и дальше.

01.05.2025 [00:15], Владимир Мироненко

«Байкал электроникс» поставила в Россию 85 тыс. процессоров Baikal

arm

baikal-l

baikal-m

baikal-s

cpu

hardware

risc-v

байкал электроникс

импортозамещение

микроконтроллер

россия

санкции

сделано в россии

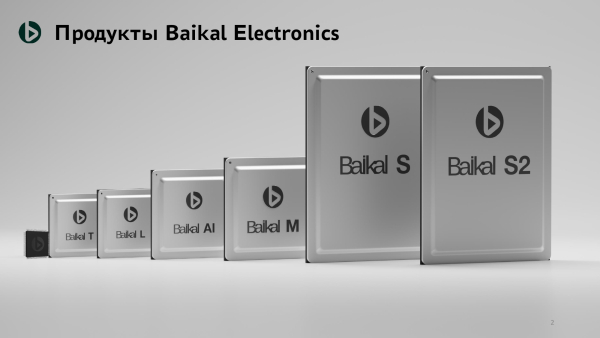

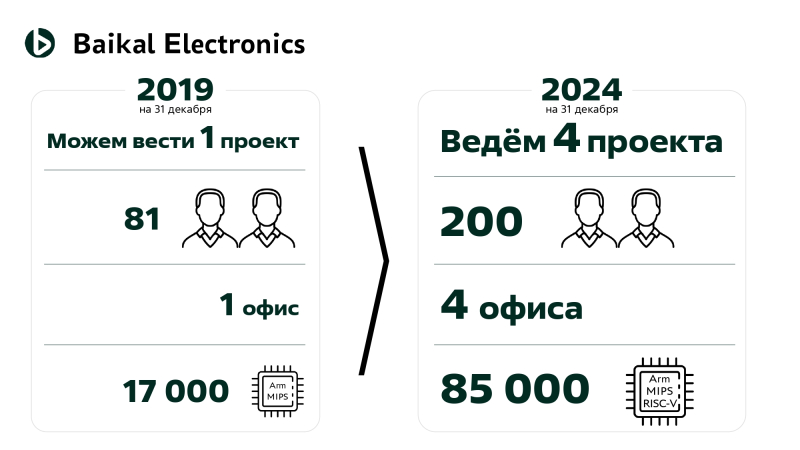

Компания «Байкал электроникс» за время работы ввезла в Россию 85 тыс. процессоров собственной разработки, включая модели Baikal-T, Baikal-M и Baikal-S. Из этого объёма компания поставила на российский рынок в 2019 году 17 тысяч процессоров. Об этом рассказал гендиректор «Байкал электроникс» Андрей Евдокимов на конференции «Планирование карьеры в электронной области», прошедшей в МИЭТ в апреле 2025 года. По словам Евдокимова, поставки должны были быть гораздо больше, но из-за санкций производство чипов было прекращено. Так, на Тайване была арестована партия из 150 тыс. процессоров Baikal-M. Кроме того, «Байкал электроникс» пришлось отменить из-за санкций заказ на изготовление 15 тыс. штук чипа Baikal-S, благо компания не успела его оплатить. В связи с отказом TSMC обслуживать российских заказчиков, выпуск Baikal-S был полностью отменён летом 2022-го года. Кроме того, санкциям подверглись и разработчики open source ПО. Вместе с тем «Байкал электроникс» продолжает работать и расширять свою деятельность. Если в 2019 году в ней работал 81 сотрудник и был один офис, то сейчас у компании четыре офиса и штат сотрудников составляет 205 человек. В настоящее время компания занимается четырьмя проектами. Евдокимов сообщил, что компания в апреле начала серийное производство собственного микроконтроллера Baikal-MCU, о разработке которого сообщалось два года назад, и вскоре будет направлен в серийное производство чип Baikal-L для ноутбуков и планшетов. Также в настоящее время в разработке компании находится следующее поколение серверных чипов Baikal-S2. Ранее компания также рассчитывала разработать Arm-процессоры Baikal-M2 и Baikal-M Lite, RISC-V чипы Baikal-NX, а также ИИ-ускорители Baikal AI SoC-C (для ЦОД) и AI SoC-E (для периферии). ИИ-ускорители, как ожидается, будут анонсированы в следующем году. По-видимому, в результате санкций компания пересмотрела развитие ряда проектов.

30.04.2025 [18:21], Владимир Мироненко

Российские вендоры предложили полностью запретить продажу иностранной электроники на госзакупкахРоссийские производители предложили полностью запретить продажу иностранной электроники на госзакупках. С таким предложением на совещании Минпромторга выступила глава консорциума «Вычислительная техника» (АНО ВТ, входят «Аквариус», YADRO, DEPO, Kraftway, iRU и др.), пишет «Коммерсантъ». Речь идёт о планшетах, компьютерах, СХД, серверах и т. п. В настоящее время на закупку иностранной электроники действует правило «второй лишний», когда госкомпания вправе приобретать иностранную продукцию, если на рынке нет российских аналогов. Согласно данным «Контур.Закупки», в 2024 году по 44-ФЗ было объявлено 57,3 тыс. тендеров на закупку компьютеров и периферийного оборудования на сумму 79,6 млрд руб., что на 20 % больше в количественном выражении и на 1,2 % меньше в денежном год к году. По 223-ФЗ количество закупок увеличилось на 4 %, до 22,7 тыс., в денежном выражении — на 31 %, до 55,6 млрд руб. При этом объём рынка компьютеров и их компонентов в РФ в прошлом году по данным Росстата составил 181 млрд руб. Предпочтение на госзакупках в 2024 году было отдано иностранным производителям серверов и СХД. Как отметила президент Ассоциации предприятий в сфере радиоэлектроники, информационных технологий, цифровых инноваций и инжиниринга, при введении запрета нужно быть полностью уверенными в наличии достаточных мощностей и номенклатур. Директор по проектной деятельности YADRO («ИКС Холдинг») заявил, что по таким категориям, как серверы и СХД, в стране уже выпускаются полнофункциональные аналоги зарубежной продукции. Он высказал мнение, что запрет позволит повысить качество российской продукции, поскольку производители смогут эффективно конкурировать между собой внутри страны. В отличие от производителей электроники, у заказчиков нет единого мнения по этому поводу. В «Росатоме» (владеет крупной долей в Kraftway), например, считают, что изменение подхода к госзакупкам может стать важным шагом к технологическому суверенитету РФ. «На наш взгляд, такая инициатива позволит создать прочную основу для развития отечественной промышленности и минимизировать потенциальные риски, связанные с использованием иностранных технологий и программного обеспечения», — заявил директор по информационным и цифровым технологиям «Росатома». В свою очередь, в «Ростелекоме» сообщили, что полный запрет не решит проблемы российских производителей электроники, которым скорее нужны долгосрочные контракты со стабильной загрузкой производства. Ранее сообщалось, что в РФ мощности по производству электроники загружены не в полной мере.

30.04.2025 [17:20], Владимир Мироненко

Supermicro недосчиталась порядка $1 млрд по итогам квартала — акции рухнули на 19 %Supermicro объявила предварительные неаудированные финансовые результаты за III квартал 2025 финансового года, закончившийся 31 марта, которые оказались значительно ниже оценок аналитиков, в связи с чем её акции упали во вторник на 19 %, пишет CNBC. Ожидаемые показатели продаж в пределах $4,5–$4,6 млрд оказались горазда ниже предыдущего прогноза в размере $5–$6 млрд при консенсус-прогнозе аналитиков, опрошенных LSEG, в $5,5 млрд. Разводнённая чистая прибыль на обыкновенную акцию (GAAP) также значительно ниже предыдущего прогноза — 16–17 центов на акцию по сравнению с объявленными ранее 36–53 цента на акцию при прогнозе Уолл-стрит в 46 центов за акцию (согласно данным SiliconANGLE). Также оказалась ниже скорректированная разводнённая чистая прибыль на обыкновенную акцию (Non-GAAP) — $0,29 – $0,31 против прежнего прогнозного диапазона $0,46 – $0,62 при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $0,54 на акцию. Supermicro сообщила, что из-за некоторых отложенных решений клиентов продажи переместились в IV финансовый квартал. Также компания отметила, что валовая прибыль (по GAAP и Non-GAAP) за отчётный квартал была на 220 базисных пунктов ниже, чем во II квартале, в основном из-за более высоких запасов продуктов старого поколения и ускорения роста затрат, что было необходимо для обеспечения сроков вывода на рынок новых продуктов. В частности, убыстрившийся темп создания новых продуктов NVIDIA поставил в неудобное положение многих производителей серверов. До объявления результатов во вторник акции Supermicro выросли на 18 % с начала 2025 года, демонстрируя рост на фоне спада на рынке технологий в целом. Как отметил The Register, ссылку Supermicro на отложенные покупки и медленное движение старых продуктов можно было бы расценивать как признак охлаждения рынка. Аналитики SiliconANGLE полагают, что падение акций Supermicro оказало опосредованное воздействие на других крупных игроков на рынке серверов. Так, акции Dell упали в цене почти на 5 % в ходе расширенных торгов, а у HPE и NVIDIA — примерно на 2 %.

30.04.2025 [15:30], Руслан Авдеев

RuVDS модернизировала свой ЦОД в бункереХостинг-провайдер RuVDS провёл масштабную модернизацию своего дата-центра Rucloud, расположенного в бункере в Королёве, на 20 % нарастив объём вычислительных мощностей и увеличив общую энергоёмкость ЦОД на 25 % — до 1,5 МВт. В ЦОД появились новые серверные стойки, обеспечено дополнительное электроснабжение, обновлены электропроводка и электрическая схема, увеличена ёмкость ИБП, попутно заменена часть аккумуляторных блоков, увеличена мощность систем охлаждения. RuVDS модернизировала и систему пожарной безопасности. Так, проведено техобслуживание «модуля газового типа» для обеспечения соответствия его характеристик нормативам. Обновлена система датчиков пожаротушения и другая инфраструктура в соответствии с Приказом Росстандарта от 24.10.2024 № 1497-ст по внесению изменений в ГОСТ Р 59636-2021, вступившим в силу 1 декабря 2024 года.

Источник изображения: RuVDS По словам представителя компании, площадка в Королёве — крупнейшая локация RuVDS. При этом ЦОД уже несколько лет был законтрактован клиентами на 90 %. Новая подведённая мощность даст возможность масштабирования задач и предоставить возможность размещения инфраструктуры новым клиентам. Процесс миграции IT-инфраструктуры, монтажные работы и испытания удалось провести совершенно «бесшовно» — непосредственно в процессе модернизации дата-центр работал в штатном режиме, эксплуатировалось оборудование клиентов RuVDS. ЦОД Rucloud заработал в 2015 году. Объект получил сертификаты ФСТЭК по классу технической защиты конфиденциальной информации. Он соответствует стандартам ГOCT P ИCO/MЭK 27001-2006 (ISO/IEC 27001-2006) и ГОСТ Р ИСО 9001-2015 (ISO 9001:2015). Сейчас в активе компании — вычислительные мощности в 16 ЦОД, из них восемь находятся за пределами России. В марте сообщалось, что хостинг-провайдер развернул новые вычислительные мощности в Краснодаре.

30.04.2025 [13:22], Руслан Авдеев

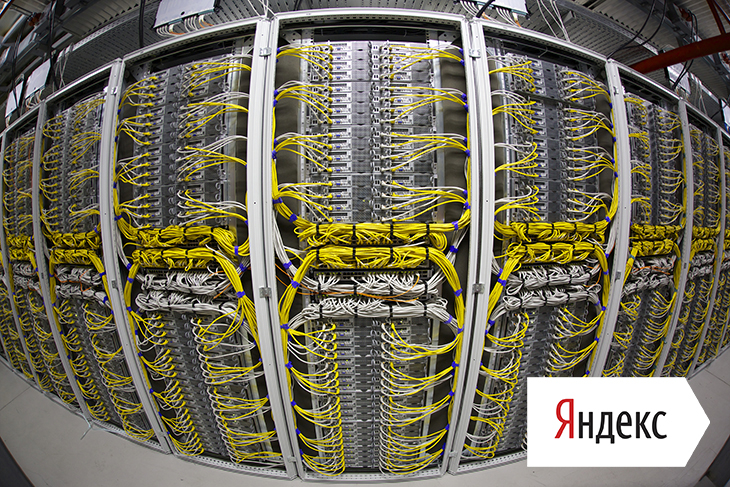

В Можайском округе построят очередной ЦОД «Яндекса»В обозримом будущем в Можайском округе Московской области будет построен и введён в эксплуатацию очередной дата-центр «Яндекса». Краткую заметку о проекте опубликовал местный портал «Можайск Медиа». По информации издания, дата-центр будет построен рядом с деревней Зачатьё. Информация о точном местоположении ЦОД пока не раскрывается, но СМИ сообщают, что объект, вероятно, возведут недалеко от расположенного в этом районе «инфраструктурного объекта». Инвестиции в новый дата-центр составят 16 млрд руб. Ввод дата-центра в эксплуатацию запланирован на 2027 год. Новый проект позволит создать 100 рабочих мест. Журналистам удалось выяснить, что юридическое лицо для ЦОЦ — «Яндекс ДЦ МО» было зарегистрировано ещё в 2024 году, а его офис расположен «в доме 36 по Московской улице».

Источник изображения: «Яндекс» Тем временем Nebius — отделившаяся от «Яндекса» зарубежная структура, вынашивает собственные проекты. Например, в октябре прошлого года появилась информация о её намерении утроить мощность дата-центра в Финляндии. В марте 2025 года опубликованы сведения о том, что Nebius намерена построить ИИ ЦОД на 300 МВт в Нью-Джерси (США), а также разместит оборудование в Исландии.

30.04.2025 [11:55], Сергей Карасёв

Innodisk выпустила 128-Тбайт E3.L SSD с интерфейсом PCIe 5.0Компания Innodisk анонсировала SSD с интерфейсом PCIe 5.0 х4 для дата-центров и систем корпоративного класса. Устройства, разработанные в соответствии со спецификацией OCP Data Center NVMe SSD v2.0, подходят для задач с интенсивной обработкой данных, таких как обучение ИИ-моделей и аналитика. В семейство вошли накопители в различных форм-факторах: U.2 5TS-P, E1.S 5TS-P, E3.S 5TS-P и E3.L 5QS-P. Все устройства оснащены технологией PLP (iCell), которая гарантирует защиту критически важных данных и отсутствие потерь информации при сбоях питания. Реализована поддержка AES и TCG Opal 2.0. Изделия U.2 5TS-P, E1.S 5TS-P и E3.S 5TS-P выполнены на основе чипов флеш-памяти 3D eTLC. Вместимость варьируется от 1,92 до 7,68 Тбайт. Заявленная скорость последовательного чтения информации достигает 14 Гбайт/с, скорость последовательной записи — 10 Гбайт/с. Гарантированный объём записанной информации (показатель TBW) составляет до 14 тыс. Тбайт. Максимальное энергопотребление — 25 Вт. В свою очередь, SSD серии E3.L 5QS-P выполнены на флеш-чипах QLC. Скоростные показатели не раскрываются, а энергопотребление не превышает 40 Вт. Эти изделия обладают ёмкостью до 128 Тбайт. Все накопители могут эксплуатироваться при температурах от 0 до +70 °C. Показатель MTBF (средняя наработка на отказ) заявлен на уровне 2 млн часов. Производитель предоставляет на устройства пятилетнюю гарантию. Новинки поддерживают функцию Secure Boot, которая проверяет подлинность цифровых подписей при обновлении прошивки, предотвращая несанкционированные изменения и обеспечивая использование только проверенного встроенного ПО. Говорится о бесшовной интеграции с платформами VMware. Продажи накопителей начнутся в текущем квартале. |

|