Материалы по тегу: azure

|

25.09.2024 [17:14], Руслан Авдеев

Microsoft инвестирует $1,3 млрд в облачную и ИИ-инфраструктуру в МексикеВ ходе конференции Microsoft AI Tour Mexico 2024 глава Microsoft Сатья Наделла (Satya Nadella) объявил, что компания намерена инвестировать $1,3 млрд в улучшение ИИ-инфраструктуры страны. Пресс-служба компании сообщает, что деньги будут выделяться в течение трёх лет. В числе прочего предусмотрены вложения в программу Artificial Intelligence National Skills, призванную сделать доступ к ИИ-технологиям более демократичным. Также предусмотрены инструменты поощрения использования ИИ малым и средним бизнесом и ускорения цифровой трансформации страны. В течение трёх лет Microsoft обучит 5 млн жителей страны работе с решениями на базе ИИ — от обычных пользователей до учителей, разработчиков и руководителей организаций. Также разрабатывается обучающая платформа для соискателей вакансий и работников. Сфере найма будет уделяться повышенное внимание, а среднему и малому бизнесу помогут выявить, какие навыки работы с ИИ необходимы сотрудникам. Согласно исследованию Microsoft, в 2023 году 57 % опрошенных представителей малого и среднего бизнеса Мексиси уже использовали ИИ, в первую очередь для повышения эффективности работы, обработки данных и персонализации обслуживания клиентов. Благодаря программе The Bridge Accelerator компания стремится помочь местному малому и среднему бизнесу подготовиться к интеграции в бизнес-процессы Северной Америки с внедрением ИИ-платформы PyMAIs. Инициатива позволит 30 тыс. предприятий за три года обновить бизнес, повысить свою конкурентоспособность и увеличить охват потенциальных клиентов, в том числе за пределами Мексики. В рамках программы AI for Good компания занимается вопросами здравоохранения, связи и устойчивого развития. В частности, компания разработала ИИ-модели, позволяющие врачам использовать смартфоны для ранней диагностики ретинопатии недоношенных. В сфере связи проекты Microsoft и Viasat должны к концу года охватить более 1,45 млн человек в стране. В том числе речь идёт об активации новых сетей, способных обеспечить доступ более 150 тыс. мексиканцев, ранее не имевших доступа к сотовой связи. Немалое значение играет и устойчивое развитие — к 2030 году Microsoft намерена стать компанией с отрицательным углеродным выбросом, PPA заключены на более 34 ГВт в 24 странах. В Мексике компания также обещает расширить доступ людей к чистой воде и санитарным решениям, работая над восстановлением запасов воды и экосистем в целом. В частности, с компанией The Next 150 подписано соглашение об удалении до 95 тыс. тонн CO2 в рамках проекта производства биоугля. Также подписано годовое соглашение с Toroto SAPI de CV об удалении 234 тыс. тонн CO2 в рамках восстановления лесной экосистемы в одном из штатов Мексики. Проекты поддерживают и местных фермеров, способствуя сохранению биоразнообразия. Microsoft стремится стать катализатором новой экономики с повышенным вниманием к цифровым услугам, ИИ и смежным решениям. Мексика, географически близкая к США, не может остаться без внимания IT-гиганта.

22.09.2024 [23:40], Владимир Мироненко

Amazon, Google и Microsoft снова пожаловались друг на друга британскому регулятору, который продлил антимонопольное расследование облачного рынкаУправление по конкуренции и рынкам Великобритании (CMA) продлило сроки антимонопольного расследования положения дел на облачном рынке страны на четыре месяца — до 4 августа 2025 года. Ранее планировалось завершить его до 5 апреля следующего года, пишет DataCenter Dynamics. В своём заявлении, опубликованном 19 сентября, британский регулятор сообщил, что ведущая расследование группа считает невозможным завершить его в ранее объявленные сроки. Также указано, что несмотря на перенос крайнего срока на август, группа стремится завершить расследование «как можно скорее». Как предполагает ресурс Computer Weekly, продление расследования связано с необходимостью более подробного изучения практики лицензирования продуктов и сервисов Microsoft, которая может негативно отразиться на уровне конкуренции на облачном рынке Великобритании. Расследование CMA было начато в октябре 2023 года после публикации отчёта Ofcom, телеком-регулятора страны, в котором сообщалось о препятствиях, затрудняющим клиентам переключение между облачными провайдерами и/или одновременное использование услуг нескольких поставщиков облачных сервисов: плата за перенос данных, сборы за облачную репатриацию и скидки, стимулирующие клиентов использовать только одного поставщика, и т.д. Также поступали жалобы на практику лицензирования Microsoft, взимающую повышенную плату за запуск своего ПО в облаках конкурентов. Расследование проходит на фоне взаимных обвинений облачных провайдеров в антиконкурентном поведении. В декабре прошлого года Google, по данным источников, направила в CMA жалобу по этому поводу на Microsoft. Компания Amazon тоже сочла необходимым пожаловаться регулятору на используемую Microsoft практику лицензирования, которая усложняет переход клиентов к другим облачным провайдерам. CMA объявила о продлении расследования после того, как опубликовала отчёты о слушаниях Amazon Web Services (AWS), Google и Microsoft. Во время слушаний AWS, прошедших 2 июля, компания сообщила CMA, что она «считает конкуренцию между поставщиками ИТ-услуг хорошо функционирующей и что облачные сервисы отвечают потребностям клиентов как в Великобритании, так и во всем мире с точки зрения ценообразования, инноваций, выбора продуктов, разнообразия и качества». AWS сообщила, что считает конкурентами локальные ИТ-сервисы, отметив, что облачные сервисы составляют всего 15 % рынка ИТ-услуг Великобритании, и что представление о том, что как только клиенты переходят в облако, они никогда не возвращаются к локальным сервисам, неверно. Об этом сообщается в резюме регулятора, опубликованном 16 сентября. AWS также привела примеры клиентов, возвращающихся в локальные решения, что подчёркивает гибкость её подхода, и отметила, что «приветствует возможность» обсудить практику лицензирования Microsoft. «AWS заявила, что с 2019 года Microsoft ввела лицензионные ограничения, которые не позволяют клиентам использовать ранее приобретённые лицензии Microsoft в AWS (ограничения BYOL). AWS заявила, что это имело огромные финансовые последствия для клиентов и клиенты после покупки продукты Microsoft должны навсегда сохранить к ним доступ и иметь возможность использовать их у ИТ-провайдера по своему выбору», — сообщается в резюме CMA. Что касается сегмента ИИ, AWS указала на рост количества новых игроков, которые появились и составили дополнительную конкуренцию облачным провайдерам — вероятно, имея в виду CoreWeave и других поставщиков облачных ИИ-услуг. В свою очередь, Microsoft тоже отвергла наличие проблем с конкуренцией на рынке облачных сервисов Великобритании, добавив, что «возникшие суждения CMA о конкурентной среде и конъюнктуре рынка игнорируют реальные доказательства того, что рынок очень динамичен и быстро развивается, а степень удовлетворения потребностей клиентов высока». Компания сообщила, что на рынке Великобритании работают три гиперскейлера, и что хотя Google «не добилась такого же уровня успеха, как AWS и Azure на сегодняшний день», её не следует исключать из расследования. В ходе слушаний Microsoft заявила, что лицензионные сборы за её ПО «не столь существенно увеличивают расходы для её конкурентов», добавив, что AWS и Google имеют «достаточную маржу, чтобы конкурировать с Azure», и поэтому лицензионные сборы не приводят к ограничению доступа конкурентов к ключевым ресурсам. По словам Microsoft, соглашения об облачных услугах (CSA) со скидками на основе обязательств необходимы для конкуренции, и их отмена приведёт к более высоким ценам на рынке Великобритании. Google во время слушаний, прошедших 19 июля, а также в опубликованном ранее в этом месяце заявлении сообщила, что разделяет точку зрения CMA по поводу облачного рынка страны, в частности, о «значительной рыночной власти, которой обладают AWS и Microsoft». Для гиперскейлера с наименьшей долей рынка, эта позиция неудивительна, отметил ресурс Data Center Dynamics. Google также поддержала критику AWS в отношении практики лицензирования Microsoft, добавив, что «необходимы срочные и своевременные действия для решения проблемы политики Microsoft». Как и конкуренты, Google считает, что главную роль на рынке Великобритании играют локальные ИТ-решения, а не крупные облака.

03.09.2024 [11:02], Сергей Карасёв

Softline сообщила об отключении в РФ ряда облачных служб Microsoft с 12 сентября12 сентября 2024 года вступают в силу новые санкции США, предусматривающие ограничение доступа российских организаций к иностранному ПО и IT-услугам. В этой связи корпорация Microsoft, по сообщению ГК Softline, распространила уведомление о прекращении предоставления ряда своих облачных сервисов Azure пользователям в РФ. В соответствии с новыми требованиями Минфина США, утверждёнными в июне нынешнего года, запрещается без получения лицензии Минторга США предоставление лицам в РФ услуг в сфере IT-консультирования и проектирования, услуг IT-поддержки, облачных служб и предоставление ПО для управления предприятием, а также проектирования и производства. На фоне сформировавшейся геополитической обстановки Microsoft начала ограничивать доступ к облачным продуктам на территории России с 20 марта 2024 года. Теперь перечень подпавших под ограничение продуктов и сервисов расширился. В него вошли: Azure Data Explorer, Azure Databricks, Azure Managed Grafana, Azure Operator Insights, Azure Quantum, Azure Synapse Analytics, а также Microsoft Fabric и Power BI Embedded. «С сегодняшнего дня, по информации от Microsoft, будет происходить плановое отключение облачных подписок, попавших под ограничения, для компаний, зарегистрированных на территории России», — говорится в сообщении Softline. В сообщении Softline отмечается, что Microsoft запрещает дальнейшее использование перечисленных решений на территории РФ. Заказчики не смогут вносить изменения или обновления в указанном перечне ресурсов, а их применение «может повлечь терминацию тенанта». Для сохранности данных и поддержания бизнес-операций рекомендуется осуществить резервное копирование информации и перейти на отечественные продукты. Ранее Softline совместно с партнёрами предложила ряд российских облачных сервисов, которые могут стать альтернативой зарубежным платформам, ушедшим из РФ.

23.08.2024 [16:00], Владимир Мироненко

Китайские компании нашли лазейку в законах США для доступа к передовым ИИ-ускорителям и моделям в облаках AWS и AzureГосударственные китайские организации используют облачные сервисы Amazon, Microsoft и их конкурентов для доступа к передовым американским чипам и технологиям ИИ, пишет Reuters со ссылкой на тендерную документацию, размещённую в общедоступных китайских базах данных. О попытках китайских компаний получить доступ к ИИ-ускорителям на территории США в условиях запрета на их поставки в Китай сообщалось и ранее. Правительство США ограничивает экспорт высокопроизводительных чипов ИИ в КНР в течение последних двух лет в связи с потенциальной возможностью их использования для укрепления военного потенциала Поднебесной. Однако предоставление доступа к таким чипам или передовым ИИ-моделям в облаках не является нарушением законодательства США, которым регулируется в данном случае только экспорт или передача товара, ПО или технологии, отметило Reuters. Согласно 50 тендерным документам, с которыми ознакомилось агентство, по крайней мере 11 китайских организаций пытались получить доступ к подпадающим под ограничение технологиям США или облачным сервисам. В четырёх случаях Amazon Web Services (AWS) явно названа поставщиком облачных услуг, хотя компании получили доступ к облачным услугам через посредников, а не напрямую у AWS. Таким образом, не только китайские компании обходят ограничения, но и американские компании извлекают выгоду из растущего в Китае спроса на вычислительные мощности. «AWS соблюдает все применимые законы США, включая торговые законы, в отношении предоставления услуг AWS внутри и за пределами Китая», — заявил представитель облачного бизнеса Amazon. По данным Synergy Research Group, AWS контролирует почти треть мирового рынка облачной инфраструктуры. А согласно данным исследовательской компании IDC, AWS является в Китае шестым по величине поставщиком облачных услуг. «Эта лазейка беспокоит меня уже годы, и нам давно пора её устранить», — заявил агентству Reuters председатель Комитета по иностранным делам Палаты представителей США Майкл Маккол (Michael McCaul), имея в виду удалённый облачный доступ иностранных субъектов к передовым вычислительным решениям США. В апреле в Конгресс США был внесён законопроект, дающий Министерству торговли полномочия регулировать удалённый доступ к технологиям США, но пока неясно, будет ли он принят и когда. В январе Министерство торговли США также предложило изменения в законодательства с требованием к сервисам облачных вычислений проверять пользователей крупных моделей ИИ и сообщать регулирующим органам об обучения крупных моделей ИИ, способных на «злонамеренную киберактивность». Поправки также дают ведомству право налагать запрет на доступ тех или иных клиентов. Но этот документ всё ещё находится в стадии доработки. Китайские организации также стремятся получить доступ к облачным сервисам Microsoft. Например, в апреле Сычуаньский университет указал в тендерной документации, что он создаёт платформу генеративного ИИ и закупает 40 млн токенов Microsoft Azure OpenAI. В мае токены поставила компания Sichuan Province Xuedong Technology Co Ltd. В связи с этим OpenAI сообщила Reuters, что её собственные сервисы не поддерживаются в Китае, а сервисы Azure OpenAI работает в соответствии с политикой Microsoft. Наконец, Институт перспективных исследований Сучжоуского университета науки и технологий Китая (USTC) сообщил в тендерной документации в марте этого года, что хотел бы арендовать 500 облачных серверов с восемью ускорителями NVIDIA A100 в каждом. Согласно апрельским документам, тендер был выполнен компанией Hefei Advanced Computing Center Operation Management Co Ltd, но в них не был указан поставщик облачных услуг, и Reuters не удалось его идентифицировать. USTC был добавлен Минторгом США в чёрный список Entity List в мае этого года из-за получения доступа к американской технологии квантовых вычислений, которая могла бы использоваться военно-промышленным комплексом Китая и помочь в развитии ядерной программы. Согласно тендерным документам, Amazon предоставляет китайским организациям доступ не только к передовым ИИ-чипам, но и к передовым моделям ИИ, таким как Claude от Anthropic, к которым они не могут получить доступ иным образом, пишет Reuters. Да и сама AWS в сообщениях на китайском языке подчёркивает возможность опробовать «модели ИИ мирового класса» и упоминает китайскую игровую фирму Source Technology как одного из своих клиентов, использующих Claude. После того как Reuters обратилось к Amazon за разъяснением, компания добавила в десятки постов на своих китаеязычных каналах примечание о том, что некоторые из услуг недоступны в китайских облачных регионах. Она также удалила несколько рекламных постов, включая пост об Source Technology.

22.08.2024 [23:31], Владимир Мироненко

Microsoft изменила отчётность, чтобы полнее отражать вклад ИИ в финансовые результатыMicrosoft изменила принцип формирования отчётности своих бизнес-подразделений, в связи с чем часть доходов от поиска и новостной рекламы теперь отражается в финансовых результатах подразделения облачных вычислений Azure. Microsoft объяснила изменения стремлением дать инвесторам более чёткое представление о вкладе ИИ в работу компании, пишет Reuters. Вместе с тем доходы от услуг ИИ и речевых технологий, которые предлагает подразделение Nuance, теперь будут относиться к сегменту Productivity and Business Processes (офисные приложения Office и Office 365, Dynamics CRM) вместо сегмента Intelligent Cloud, включающего облачные сервисы, а также Enterprise Services, Windows Server и SQL Server.

Источник изображения: Pixabay В компании сообщили, что изменения позволят привести структуру отчётности в соответствие с тем, как управляется её бизнес. Компания уже откорректировала показатели выручки по подразделениям за последний финансовый год и пересмотрела свой прогноз на квартал с июля по сентябрь. Microsoft — одна из немногих крупных технологических компаний, которая отдельно сообщает о вкладе ИИ в своей выручке, поскольку большинство компаний ещё не увидели большого прироста от инвестиций в ИИ. В прошлом месяце компания сообщила, что ИИ обеспечил большее влияние на рост показателей Azure в последнем квартале, несмотря на общее замедление бизнеса. Также Microsoft ожидает ускорение роста показателей Azure во II половине 2025 финансового года. Согласно обновлённому прогнозу, в I квартале 2025 финансового года подразделение Intelligent Cloud получит выручку в пределах от $23,80 млрд до $24,10 млрд по сравнению с предыдущим прогнозам в размере $28,6–$28,9 млрд. Ожидаемый доход подразделения Productivity and Business Processes в I квартале находится в диапазоне от $27,75 до $28,05 млрд по сравнению с предыдущим прогнозом в пределах от $20,3 до $20,6 млрд.

07.08.2024 [00:53], Владимир Мироненко

В третий раз за три недели: в Microsoft Azure снова произошёл глобальный сбойУ Microsoft пятого августа произошёл новый сбой в работе облака Azure, затронувший несколько сервисов для клиентов в Северной и Латинской Америке, пишет ресурс BleepingComputer. По словам компании, проблемы начались около 18:22 UTC (21:22 мск) и повлияли на сервисы, использующие облачную CDN-службу Azure Front Door (AFD). Как сообщила Microsoft, инцидент был вызван «изменением конфигурации». «Мы откатили это изменение, и с 19:25 UTC (22:25 мск) в большинстве сервисов наблюдается восстановление», — рассказала компания. BleepingComputer отметил, что в Великобритании клиенты также сообщали об ошибках при подключении к сервисам Azure (включая Azure DevOps), а на странице состояния Azure DevOps было отмечено, что проблемы коснулись и пользователей из Бразилии. На сайт Downdetector пришли тысячи сообщений пользователей о проблемах с подключением к серверам и входом в систему, хотя на странице состояния работоспособности службы (Service Health Status) не было указано никаких проблем с Azure на протяжении всего сбоя.

Источник изображения: techcommunity.microsoft.com На прошлой неделе Microsoft столкнулась с более продолжительным сбоем, который был вызван DDoS-атакой, нацеленной на несколько сайтов Azure Front Door и CDN. «Хотя первоначальным событием-триггером послужила DDoS-атака, которая активировала наши механизмы защиты от DDoS, первоначальное расследование показало, что ошибка в реализации нашей защиты усилила воздействие атаки, а не смягчила его», — заявила Microsoft.

01.08.2024 [16:34], Владимир Мироненко

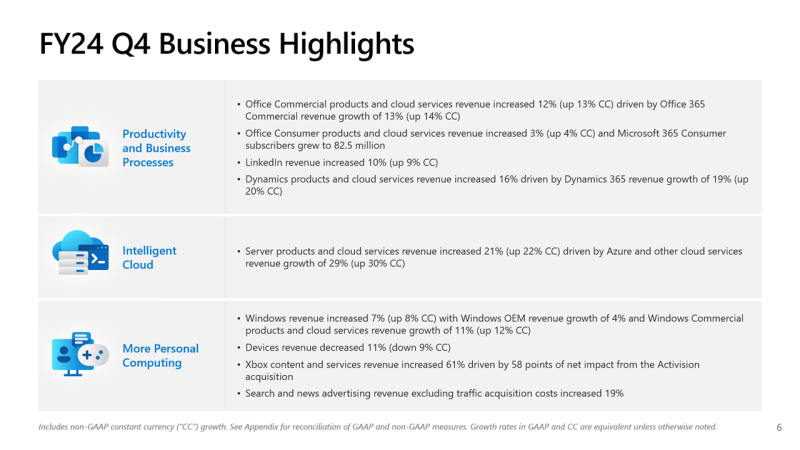

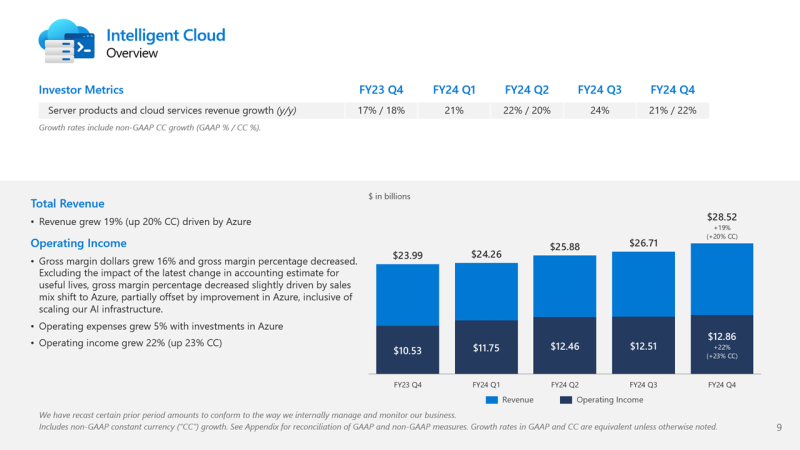

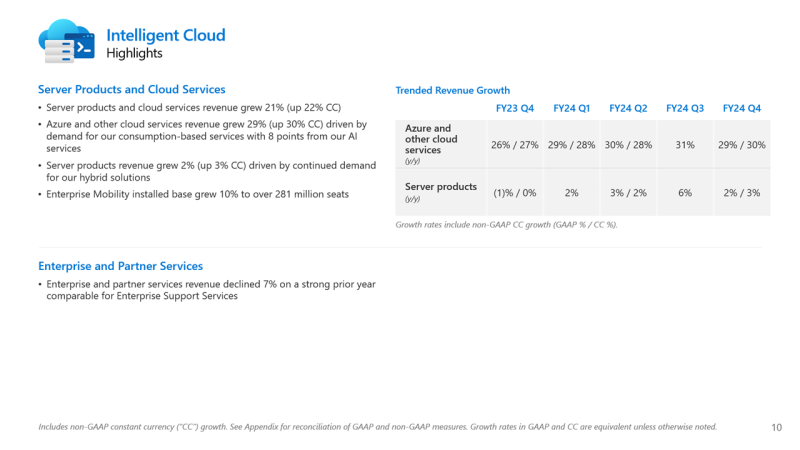

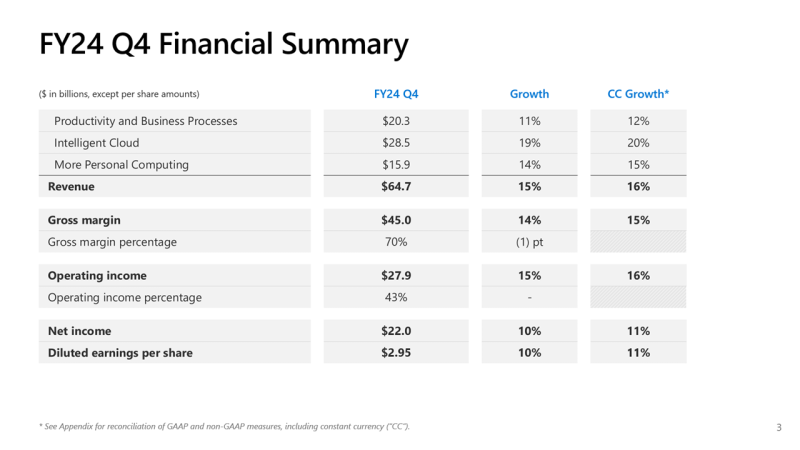

Почти половина выручки Microsoft теперь приходится на облачные сервисы, а четверть дохода Azure OpenAI принёс TikTokMicrosoft сообщила о результатах работы в IV квартале 2024 финансового года, завершившемся 30 июня. Несмотря на то, что выручка и прибыль Microsoft превысили прогнозы аналитиков, акции компании упали более чем на 7 % после публикации отчёта из-за недовольства инвесторов замедлением темпов роста облачной платформы Azure. На облачные сервисы теперь приходится около 45 % выручки корпорации. Microsoft сообщила о прибыли (GAAP) на акцию (EPS) в размере $2,95 при выручке в $64,73 млрд, превысившей показатель аналогичного квартала годом ранее на 15 %. Чистая прибыль компании увеличилась с $20,08 до $22,04 млрд. Согласно прогнозу аналитиков, опрошенных Bloomberg, показатели по прибыли и выручке могли составить $2,94 на акцию и $64,5 млрд. В IV квартале 2023 финансового года у Microsoft была прибыль на акцию в размере $2,69 и выручка в $56,19 млрд. Общий доход Microsoft от облачных вычислений составил $36,8 млрд, что полностью соответствует прогнозу Уолл-стрит, но выручка подразделения Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, оказалась ниже ожиданий аналитиков, составив $28,52 млрд (рост год к году на 19 %) при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $28,68 млрд. По данным Microsoft, на создание ЦОД и вычислительной инфраструктуры для обработки ИИ было израсходовано $13,9 млрд, что на 55 % больше, чем годом ранее. Компания заявила, что увеличение расходов было обусловлено более высокими доходами от ИИ, при этом спрос продолжает превышать предложение. Доход от Azure и других облачных сервисов вырос за квартал на 29 %. Аналитики, опрошенные CNBC и StreetAccount, ожидали рост на 31 %. При этом показатель Microsoft Azure не отставал от консенсус-прогноза с 2022 года. Абсолютные цифры в этой категории компания не раскрывает. Финансовый директор Эми Худ (Amy Hood) объяснила небольшое отставание облачного сегмента «слабостью в нескольких европейских географических регионах в плане потребления сервисов без ИИ». Как ожидает компания, эта тенденция сохранится в первой половине 2025 финансового года. Генеральный директор Microsoft Сатья Наделла (Satya Nadella), что количество клиентов Azure AI выросло на 60 %, и на 50 % увеличилось числа заказчиков ИИ, которые также используют аналитические инструменты Microsoft. Всего более 480 000 организаций использовали возможности ИИ на платформе Microsoft. По словам Наделлы, аудитория пользователей Microsoft Copilot удвоилась по сравнению с предыдущим кварталом. Он сообщил, что с нынешними темпами роста выручка GitHub превысит $2 млрд за год, что 40 % больше, чем в прошлом году. Добавим, что согласно данным ресурса The Information, ссылающегося на внутреннюю информацию компании, примерно четверть выручки Azure OpenAI принёс сервис коротких видео TikTok, чьи ежемесячные поступления составляли около $20 млн по состоянию на март 2024 года. По оценкам, служба Azure OpenAI принесёт $1 млрд за год или $83 млн в месяц. Интересно, что теперь OpenAI с точки зрения Microsoft является конкурентом, хотя IT-гигант и владеет почти половиной ИИ-компании. Продажи подразделения Microsoft Productivity and Business Processes выросли за отчётный квартал на 11 % до $20,3 млрд, превысив консенсус-прогноз аналитиков, опрошенных StreetAccount, в $20,13 млрд. Подразделение More Personal Computing принесло на 14 % больше дохода, составившего $15,90 млрд при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $15,49 млрд. Microsoft прогнозирует рост выручки Azure в I квартале 2025 финансового года в пределах 28–29 %, с более быстрым ростом во II половине финансового года, сообщила Худ. Согласно прогнозу Microsoft, выручка в I квартале 2025 финансового года составит от $63,8 млрд до $64,8 млрд, что подразумевает рост на 13,8 % в середине диапазона. Аналитики, опрошенные LSEG, прогнозируют $65,24 млрд дохода. Прогноз компании включает $15,25 млрд операционных расходов в середине диапазона, при консенсус-прогнозе StreetAccount в $16,10 млрд.

30.07.2024 [21:49], Руслан Авдеев

«Мутят воду»: Microsoft обвинила Amazon и Google в том, что они прикидываются слабыми и беспомощными перед британским регулятором CMAMicrosoft обвнили конкурентов Google и Amazon в том, что те «мутят воду», фактически мешая антимонопольному расследованию в Великобритании, передаёт ComputerWeekly. Соответствующие заявления представлены в публичном обращении Microsoft к британскому регулятору Competition and Markets Authority (CMA). В документах CMA за июнь 2024 года высказано предположение о том, что практика лицензирования продуктов и сервисов Microsoft может ослабить конкуренцию между облачными компаниями в Великобритании — использование лицензионного ПО Microsoft в облаках сторонних бизнесов может быть более дорогим для клиентов и повлиять на конкурентоспособность других облачных провайдеров. Google и AWS неоднократно жаловались британскому регулятору на Microsoft. В материалах Google, посвящённых расследованию, указывается, что практика лицензирования Microsoft ослабляет конкурентов и увеличивает их издержки. Искусственные ограничения делают ПО Microsoft слишком дорогим для использования в сторонних облаках, а конкуренты не могут противопоставить что-либо значительным ценовым различиям. В Google Cloud подчёркивают, что облака помогают цифровой экономике Великобритании, но недобросовестные механизмы лицензирования не дают клиентам свободу выбора и не позволяют внедрять инновации. Аналогичной позиции придерживается и AWS. Компания заявила, что единственным исключением из хорошо действующего рынка IT-услуг Великобритании является именно практика лицензирования Microsoft. В Amazon с оптимизмом смотрят на эволюцию взглядов CMA на предоставление британским пользователям гарантий свободного выбора облака для запуска популярных приложений Microsoft. В самой Microsoft оспаривают заявления и подчёркивают, что ни Google, ни AWS не страдают в той степени, как пытаются изобразить. В Microsoft утверждают, что её условия лицензирования ПО не ведут к существенному повышению затрат при использовании облаков конкурентов. Также заявлено, что бизнесы Amazon и Google, судя по всему, достаточно маржинальны, чтобы получать прибыль даже в условиях конкуренции. В компании напомнили, что капитальные затраты обоих конкурентов составляют $50 млрд и $30 млрд соответственно — это само по себе свидетельствует об их уверенности в прибыльности и конкурентоспособности. Так что речь идёт вовсе не об ослабленных, лишённых надежды конкурентах, какими пытаются представить себя компании, якобы не способные оплатить масштабное использование её интеллектуальной собственности, говорит Microsoft. Более того, за последние пару лет выручка Google и AWS только росла — это плоды конкуренции, а не её отсутствия. В Microsoft прямо заявили, что соперничество не бывает «мягким» или «слабым» — компании «бьют друг друга изо всех сил». По мнению IT-гиганта, Amazon, Google и CISPE попросту «мутят воду» в вопросе определения правильной и неправильной конкуренции. Расследование CMA было начато в октябре 2023 года, крайний срок его завершения — 4 апреля 2025 года. Недавно Microsoft после переговоров добилась примирения с CISPE, согласившись выплатить компенсацию в размере $22 млн в обмен на отказ мелких облачных операторов от претензий к ней. При этом новые правила лицензирования Microsoft в Европе не коснулись AWS, Google Cloud Platform и Alibaba Cloud. Впоследствии выяснилось, Google пыталась предложить CISPE более значимую компенсацию в обмен на продолжение тяжб с Microsoft.

30.07.2024 [21:48], Владимир Мироненко

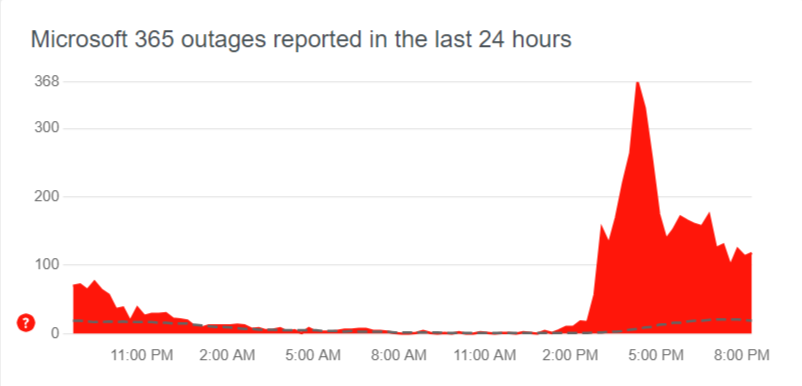

В облаке Microsoft Azure снова произошёл глобальный сбой, затронувший Microsoft 365, Teams, OneDrive, Minecraft и Xbox Live [Обновлено]Microsoft столкнулась с новым глобальным сбоем облака Azure, затронувшим целый ряд служб — от почтового сервиса Outlook до популярной игры Minecraft. Также пользователи по всему миру сообщают о трудностях с подключением к облачной платформе Azure и проблемах в работе с Microsoft 365, Teams, OneDrive и Xbox Live. «В настоящее время мы изучаем проблемы с доступом и снижение производительности нескольких сервисов и функций Microsoft 365», — отреагировали на обращения пользователей в Microsoft. Согласно странице статуса Azure, сбой начался в 11:45 UTC (14:45 мск), когда у целого ряда клиентов возникли проблемы с подключением к службам Microsoft по всему миру, включая Америку, Азиатско-Тихоокеанский регион, Европу и Ближний Восток. Компания сообщила, что внесла изменения в конфигурацию сети, а также задействовала альтернативные маршруты.

Источник изображения: Downdetector Доступность служб повысилась примерно с 14:10 UTC (17:10 мск), но полностью сбои пока не устранены. В частности, сейчас по всему миру всё ещё наблюдаются проблемы с сервисами CDN и Azure Front Door. Напомним, что совсем недавно в облаке Microsoft Azure произошёл масштабный сбой, совпавший во времени с глобальным сбоем из-за неудачного обновления защитного ПО компании CrowdStrike для ПК на Windows, обрушившего работу многих компаний и служб. UPD 31.07.2024: Microsoft объяснила восьмичасовой сбой своего облака масштабной DDoS-атакой. Точнее говоря, проблемой в механизме защиты Azure от таких атак, который вместо того, чтобы отразить DDoS, только ухудшил ситуацию с доступностью сервисов.

25.07.2024 [15:45], Руслан Авдеев

Lumen расширит оптические каналы связи между ИИ ЦОД Microsoft, а сама частично переедет в AzureКомпания Microsoft совместно с магистральным провайдером Lumen Technologies (прежде CenturyLink) объявили о намерении масштабировать пропускную способность каналов связи между дата-центрами техногиганта. По данным The Register, на такие меры Microsoft намерена пойти из-за расширения бизнеса, связанного с ИИ-технологиями. В рамках нового проекта Microsoft будет применять технологию частных сетей Private Connectivity Fabric компании Lumen, а общая пропускная способность между работающими с ИИ-нагрузками дата-центрами будет увеличена благодаря комбинации существующих и новых оптоволоконных линий. Стремление Microsoft нарастить технологические возможности вполне объяснимо — компания рассчитывает получить максимальную отдачу от инвестиций в OpenAI и другие ИИ-стартапы. Поэтому IT-гигант пытается интегрировать ИИ почти во все свои продукты. При этом необходимо обрабатывать и передавать огромные объёмы данных, для чего существующей сетевой инфраструктуры ЦОД уже не хватает. Впрочем, пока неизвестно, какую дополнительную ширину каналов обеспечит Lumen для Microsoft. Сами партнёры сотрудничество пока не комментируют.

Источник изображения: Lumen Technoligies При этом Lumen в рамках сделки обязалась перенести часть рабочих нагрузок в облако Microsoft Azure. Вероятно, ИИ-инструменты Microsoft будут интегрированы и в продукты Lumen. Кроме того, вероятно использование Lumen платформы Microsoft Entra, обеспечивающей управление идентификацией и контролем доступа. В Lumen рассчитывают, что подобная миграция позволит компании экономить более $20 млн уже в следующем году и повысить уровень обслуживания клиентов — не исключено, что часть функций компания передаст чат-ботам Microsoft на основе технологий OpenAI. |

|