Материалы по тегу: суперкомпьютер

|

19.10.2023 [00:41], Руслан Авдеев

Crusoe предложит экобезопасное облако для генеративного ИИ на базе суперкомпьютеров HPE Cray XDСтроитель и оператор модульных дата-центров Crusoe, безопасных для климата планеты, как сообщает HPC Wire, выбрала суперкомпьютеры HPE Cray XD для создания новых облачных сервисов для работы с генеративным ИИ и иными HPC-нагрузками. Для питания своих ЦОД Crusoe использует генераторы, работающие на факельном газе, и иные источники возобновляемой энергии. Попутный газ сжигался бы в любом случае, но его применение для получения электроэнергии позволяет «сэкономить» углеродный выброс. Сообщается, что эта технология помогла предотвратить выброс в атмосферу в 2022 году метана в объёме, эквивалентном устранению с дороги 170 тыс. машин с бензиновыми ДВС. Компания размещает контейнерные ЦОД на нефтяных месторождениях в США и Аргентине, где метан и другие газы сжигаются в генераторах с выделением CO2, который считается менее вредным парниковым газом. Начав с проектов по майнингу биткоинов, Crosoe перешла к работе над HPC и ИИ.

Источник изображения: Crusoe Energy Благодаря новому сотрудничеству Crusoe и HPE, первая получит энергоэффективные суперкомпьютеры HPE Cray XD на основе ускорителей NVIDIA H100 и интерконнекта NVIDIA Quantum-2 InfiniBand. Как заявили в HPE, её суперкомпьютерные решения обеспечивают высокий уровень энергоэффективности, что очень важно, поскольку ИИ-проекты, если не управлять ими правильно, могут значительно повысить углеродный выброс. В компании отметили, что горды сотрудничеством с Crusoe. Целью Crusoe является «преобразование отходов производства энергии в вычислительные ресурсы», которые корпорации, научные и исследовательские учреждения, а также предприниматели смогут использовать для разработки продуктов и решений, способных изменить жизни людей. По словам главы Crusoe, HPE является идеальным партнёром для выполнения миссии, в ходе которой планируется связать будущее вычислительных технологий с будущим климатом планеты.

15.10.2023 [01:15], Сергей Карасёв

Бункер для ИИ: Tesla начала строительство дата-центра для суперкомпьютера DojoКомпания Tesla, по сообщению ресурса The Information, приступила к созданию нового ЦОД, в котором в перспективе расположатся узлы суперкомпьютера Dojo. Площадка НРС находится в штаб-квартире Tesla в Остине (Техас, США), но точные сроки её ввода в эксплуатацию не раскрываются. Компания Илона Маска приступила к формированию комплекса Dojo в июле нынешнего года. В основу системы лягут специализированные чипы собственной разработки — Tesla D1. К концу 2024 года, как ожидается, производительность ИИ-систем Tesla может достичь 100 Эфлопс. Стоимость проекта оценивается в $1 млрд. Подробности о дата-центре Tesla в Остине не раскрываются. Отмечается лишь, что по своей конструкции он напоминает бункер. В этом ЦОД будет размещена часть вычислительных модулей Dojo. Суперкомпьютер компания намерена применять для разработки инновационных технологий автопилотирования. Речь идёт о решении ресурсоёмких задач, связанных с ИИ. Кроме того, ранее господин Маск говорил, что некоторые мощности Dojo могут предоставляться сторонним заказчикам по модели облачных услуг.

Источник изображения: Karpathy / Tesla. По оценкам, запуск Dojo может увеличить рыночную стоимость Tesla на $500 млрд: то есть, капитализация компании поднимется примерно на 60 %. Параллельно Tesla развивает и другие НРС-проекты. Так, недавно компанией был запущен один из мощнейших ИИ-суперкомпьютеров в мире: система с 10 тыс. ускорителей NVIDIA H100 обеспечивает пиковую производительность в 340 Пфлопс FP64 для технических вычислений и 39,58 Эфлопс INT8 для приложений ИИ.

10.10.2023 [13:08], Сергей Карасёв

Великобритания построит экзафлопсный суперкомпьютер в ЭдинбургеВеликобритания, по сообщению ресурса HPCwire, назвала Эдинбург (столица Шотландии) предпочтительным городом для размещения нового суперкомпьютера экзафлопсного класса. Предполагается, что эта площадка станет одной из самых мощных НРС-платформ в мире. Великобритания в связи с Brexit'ом покинула Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU), в создании которого принимала активное участие. При этом страна самостоятельно развивает направление НРС: в частности, ранее говорилось, что Великобритания намерена создать суперкомпьютер на отечественных чипах за почти $1 млрд. Как теперь сообщается, экзафлопсная система, размещённая в Эдинбургском университете, сможет выполнять сложные рабочие нагрузки, а также поддерживать важные исследования в области безопасности и развития ИИ. Ожидается, что новый вычислительный комплекс будет приблизительно в 50 раз мощнее суперкомпьютера Archer2, который также располагается в Эдинбурге: эта система обладает производительностью 19,54 Пфлопс и пиковым быстродействием на уровне 25,80 Пфлопс. Реализация проекта приведёт к формированию дополнительных рабочих мест в Эдинбурге. В целом, как предполагается, инициатива улучшит исследовательский, технологический и инновационный потенциал Великобритании. Кроме того, в этом году в Бристоле появится машина Isambard-3, которая должна стать одной из самых мощных в Европе, а NexGen строит ИИ-супероблако — оба проекта оценены примерно в $1 млрд. Между тем участники EuroHPC создают первый европейский суперкомпьютер экзафлопсного класса — комплекс под названием Jupiter. Эта система получит неназванные ускорители NVIDIA и энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea.

09.10.2023 [07:36], Сергей Карасёв

EuroHPC создаст в Европе единую инфраструктуру суперкомпьютерных и квантовых вычисленийЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило тендер на развертывание и эксплуатацию платформы, которая объединит все НРС-ресурсы Европы и обеспечит предоставление безопасного доступа к ним для широкого круга государственных и частных пользователей на территории региона. Речь идёт о формировании «ведущей федеративной и безопасной экосистемы», объединяющей европейские суперкомпьютеры и квантовые компьютеры. Инициатива, как ожидается, позволит более полно задействовать имеющиеся вычислительные мощности для развития науки и промышленности в Европе. Победителю тендера предстоит разработать и ввести в эксплуатацию платформу для бесшовного объединения суперкомпьютеров и квантовых систем, а также инфраструктуры хранения данных. На базе платформы должны предоставляться услуги с высоким уровнем безопасности. Конечная цель инициативы — создание единой точки доступа к вычислительным мощностям и сервисам обработки данных, управляемым проектом EuroHPC JU. Иными словами, любой клиент получит необходимые ему ресурсы через унифицированный портал.

Источник изображения: europa.eu Говорится, что платформа должна быть безопасной, масштабируемой, гибкой и ориентированной на пользователя. Адаптируемая конфигурация позволит подстраиваться под широкий спектр задач, приложений и потребностей пользователей. Отметим, что в рамках проекта EuroHPC JU разрабатывается первый европейский суперкомпьютер экзафлопсного класса и сразу шесть квантовых компьютеров. На днях к проекту EuroHPC JU присоединился Израиль.

21.07.2023 [15:35], Сергей Карасёв

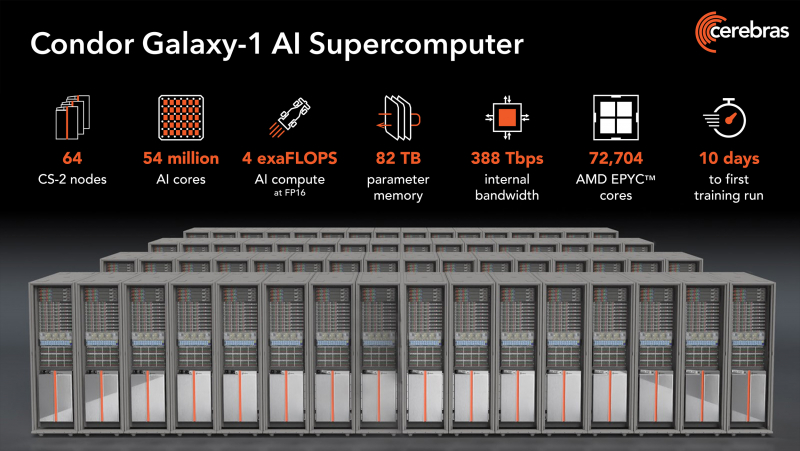

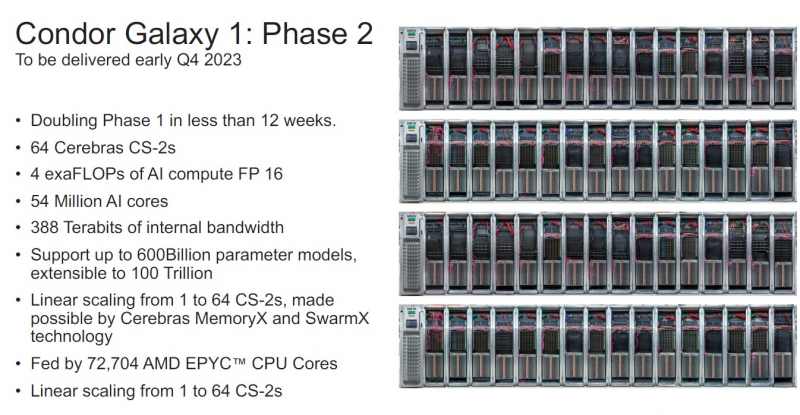

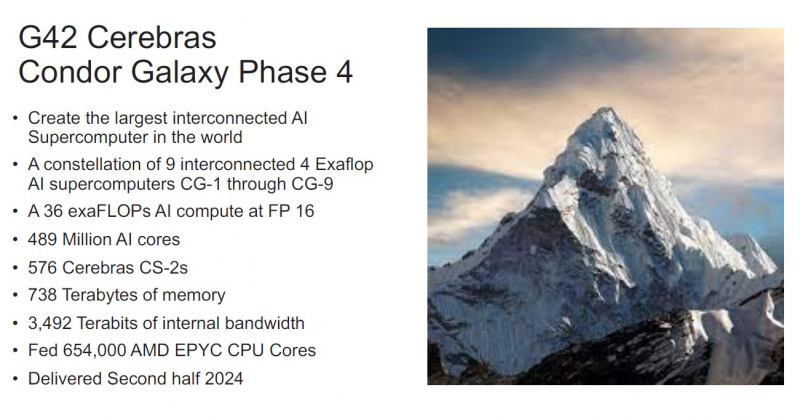

NVIDIA, подвинься: Cerebras представила 4-Эфлопс ИИ-суперкомпьютер Condor Galaxy 1 и намерена построить ещё восемь таких жеКомпания Cerebras Systems анонсировала суперкомпьютер Condor Galaxy 1 (CG-1), предназначенный для решения ресурсоёмких задач с применением ИИ. Это одна из первых действительно крупных машин на базе уникальных чипов Cerebras. В проекте стоимостью $100 млн приняла участие холдинговая группа G42 из ОАЭ, которая занимается технологиями ИИ и облачными вычислениями. G42 является основным заказчиком комплекса. В текущем виде комплекс CG-1, расположенный в Санта-Кларе (Калифорния, США), объединяет 32 системы Cerebras CS-2 и обеспечивает производительность на уровне 2 Эфлопс (FP16). В IV квартале ткущего года будут добавлены ещё 32 системы Cerebras CS-2, что позволит довести быстродействие до 4 Эфлопс (FP16). Ожидаемый уровень энергопотребления составит порядка 1,5 МВт или более. В системах Cerebras CS-2 применяются гигантские чипы Wafer-Scale Engine 2 (WSE-2), насчитывающие 2,6 трлн транзисторов. Такие чипы имеют 850 тыс. тензорных ядер и несут на борту 40 Гбайт памяти SRAM. Системы выполнены в формате 15 RU и укомплектованы шестью блоками питания мощностью 4 кВт каждый. Задействована технология жидкостного охлаждения. Отдельно отмечается, что программный стек позволит без проблем и существенных модификаций кода работать с ИИ-моделями. После ввода в строй второй очереди комплекс CG-1 суммарно получит 54,4 млн ИИ-ядер, 2,56 Тбайт SRAM и внутренний интерконнект со скоростью 388 Тбит/с. Их дополнят 72 704 ядра AMD EPYC Milan и 82 Тбайт памяти для хранения параметров. По словам создателей, мощностей суперкомпьютера хватит для обучения модели с 600 млрд параметров и на очередях длиной до 50 тыс. токенов. При этом производительность масштабируется практически линейно. Cerebras и G42 будут предоставлять доступ к CG-1 по облачной схеме, что позволит заказчикам использовать ресурсы ИИ-суперкомпьютера без необходимости управлять моделями или распределять их по узлам и ускорителям. CG-1 — первый из трёх ИИ-суперкомпьютеров нового поколения. В I полугодии 2024 года будут построены комплексы CG-2 и CG-3, полностью аналогичные CG-1, которые будут объединены в распределённый ИИ-кластер. А к концу следующего года у Cerebras будет уже девять систем CG. Для Cerebras это означает, что компания более не является стартапом, поскольку в её решения заказчики поверили и без участия в индустриальных тестах вроде MLPerf. Кроме того, теперь компания является не просто очередным производителем «железа», а предоставляет услуги, которые и помогут ей заработать в будущем.

29.05.2023 [07:30], Сергей Карасёв

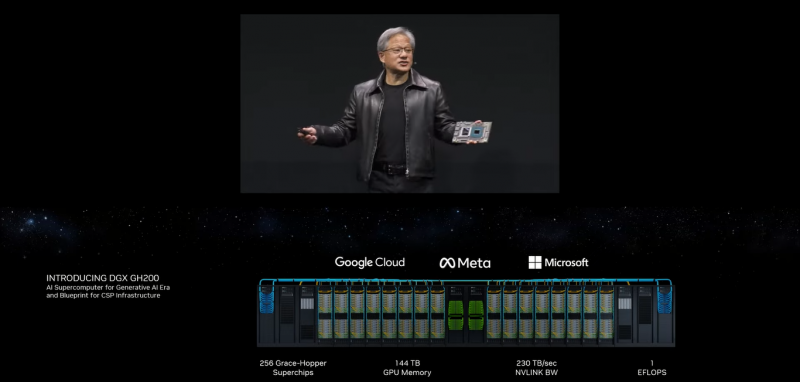

NVIDIA представила 1-Эфлопс ИИ-суперкомпьютер DGX GH200: 256 суперчипов Grace Hopper и 144 Тбайт памятиКомпания NVIDIA анонсировала вычислительную платформу нового типа DGX GH200 AI Supercomputer для генеративного ИИ, обработки огромных массивов данных и рекомендательных систем. HPC-платформа станет доступна корпоративным заказчикам и организациям в конце 2023 года. Платформа представляет собой готовый ПАК и включает, в частности, наборы ПО NVIDIA AI Enterprise и Base Command. Для платформы предусмотрено использование 256 суперчипов NVIDIA GH200 Grace Hopper, объединённых при помощи NVLink Switch System. Каждый суперчип содержит в одном модуле Arm-процессор NVIDIA Grace и ускоритель NVIDIA H100. Задействован интерконнект NVLink-C2C (Chip-to-Chip), который, как заявляет NVIDIA, значительно быстрее и энергоэффективнее, нежели PCIe 5.0. В результате, скорость обмена данными между CPU и GPU возрастает семикратно, а затраты энергии сокращаются примерно в пять раз. Пропускная способность достигает 900 Гбайт/с. Технология NVLink Switch позволяет всем ускорителям в составе системы функционировать в качестве единого целого. Таким образом обеспечивается производительность на уровне 1 Эфлопс (~ 9 Пфлопс FP64), а суммарный объём памяти достигает 144 Тбайт — это почти в 500 раз больше, чем в одной системе NVIDIA DGX A100. Архитектура DGX GH200 AI Supercomputer позволяет добиться 10-кратного увеличения общей пропускной способности по сравнению с HPC-платформой предыдущего поколения. Ожидается, что Google Cloud, Meta✴ и Microsoft одними из первых получат доступ к суперкомпьютеру DGX GH200, чтобы оценить его возможности для генеративных рабочих нагрузок ИИ. В перспективе собственные проекты на базе DGX GH200 смогут реализовывать крупнейшие провайдеры облачных услуг и гиперскейлеры. Для собственных нужд NVIDIA до конца 2023 года построит суперкомпьютер Helios, который посредством Quantum-2 InfiniBand объединит сразу четыре DGX GH200.

23.05.2023 [15:26], Сергей Карасёв

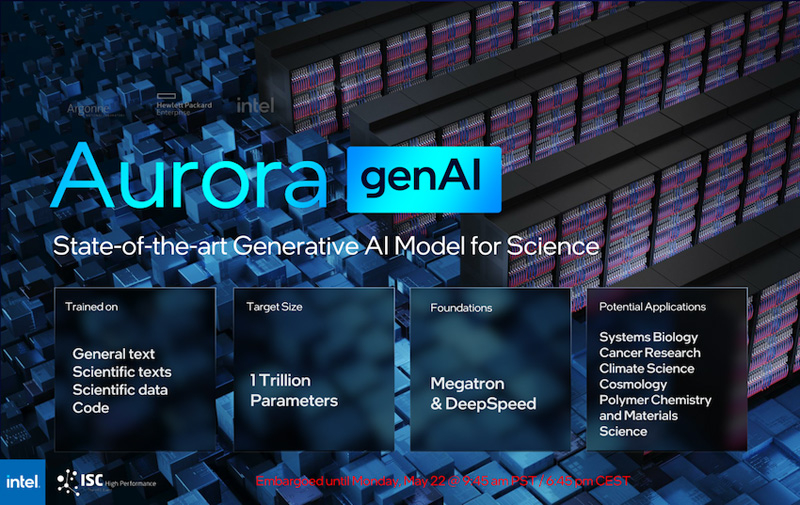

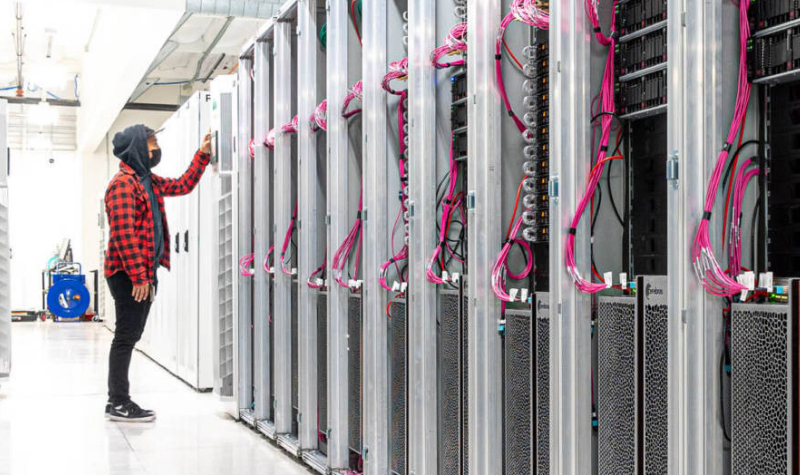

Intel рассказала о суперкомпьютере Aurora производительностью более 2 ЭфлопсКорпорация Intel в ходе конференции ISC 2023, как сообщает AnandTech, поделилась информацией о проекте Aurora по созданию суперкомпьютера с производительностью экзафлопсного уровня. Эта система создаётся для Аргоннской национальной лаборатории Министерства энергетики США. Изначально анонс HPC-комплекса Aurora состоялся ещё в 2015 году с предполагаемым запуском в 2018-м: ожидалось, что машина обеспечит быстродействие на уровне 180 Пфлопс. Однако реализация проекта значительно затянулась, а технические параметры платформы неоднократно менялись. Пока что развёрнуты тестовый кластер Sunspot. Как теперь сообщается, в конечной конфигурации Aurora объединит 10 624 узла, каждый из которых будет включать два процессора Xeon Max и шесть ускорителей Ponte Vecchio. Таким образом, общее количество CPU будет достигать 21 248, число GPU — 63 744. Быстродействие FP64, как и было заявлено ранее, превысит 2 Эфлопс.

Источник изображений: Intel (via AnandTech) Каждый процессор оперирует 64 Гбайт памяти HBM, ускоритель — 128 Гбайт. В сумме это даёт соответственно 1,36 Пбайт и 8,16 Пбайт памяти HBM с пиковой пропускной способностью 30,5 Пбайт/с и 208,9 Пбайт/с. В дополнение система сможет использовать 10,9 Пбайт памяти DDR5 с пропускной способностью до 5,95 Пбайт/с. Вместимость подсистемы хранения данных составит 230 Пбайт со скоростью работы до 31 Тбайт/с.  На сегодняшний день Intel поставила более 10 тыс. «лезвий» для Aurora, а это означает, что практически все узлы готовы к окончательному монтажу. Ввод суперкомпьютера в эксплуатацию намечен на текущий год. Для НРС-платформы готовится специализированная научная модель генеративного ИИ — Generative AI for Science, насчитывающая около 1 трлн параметров. Применять Aurora планируется для решения наиболее ресурсоёмких задач в различных областях.

07.04.2023 [20:36], Сергей Карасёв

Google заявила, что её ИИ-кластеры на базе TPU v4 и оптических коммутаторов эффективнее кластеров на базе NVIDIA A100 и InfiniBandКомпания Google обнародовала новую информацию о своей облачной суперкомпьютерной платформе Cloud TPU v4, предназначенной для решения задач ИИ и машинного обучения с высокой эффективностью. Система может использоваться в том числе для работы с крупномасштабными языковыми моделями (LLM). Один кластер Cloud TPU Pod содержит 4096 чипов TPUv4, соединённых между собой через оптические коммутаторы (OCS). По словам Google, решение OCS быстрее, дешевле и потребляют меньше энергии по сравнению с InfiniBand. Google также утверждает, что в составе её платформы на OCS приходится менее 5 % от общей стоимости. Причём данная технология даёт возможность динамически менять топологию для улучшения масштабируемости, доступности, безопасности и производительности. Отмечается, что платформа Cloud TPU v4 в 1,2–1,7 раза производительнее и расходует в 1,3–1,9 раза меньше энергии, чем платформы на базе NVIDIA A100 в системах аналогичного размера. Правда, пока компания не сравнивала TPU v4 с более новыми ускорителями NVIDIA H100 из-за их ограниченной доступности и 4-нм архитектуры (по сравнению с 7-нм у TPU v4). Благодаря ключевым инновациям в области интерконнекта и специализированных ускорителей (DSA, Domain Specific Accelerator) платформа Google Cloud TPU v4 обеспечивает почти 10-кратный прирост в масштабировании производительности по сравнению с TPU v3. Это также позволяет повысить энергоэффективность примерно в 2–3 раза по сравнению с современными DSA ML и сократить углеродный след примерно в 20 раз по сравнению с обычными дата-центрами.

29.11.2022 [12:20], Сергей Карасёв

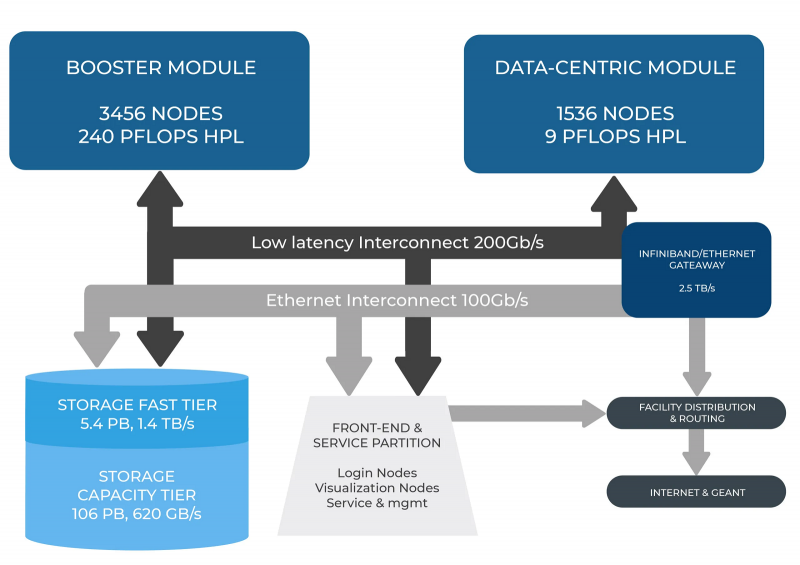

В Италии официально запущен суперкомпьютер Leonardo — четвёртая по мощности HPC-система в миреСовместная инициатива по высокопроизводительным вычислениям в Европе EuroHPC JU и некоммерческий консорциум CINECA, состоящий из 69 итальянских университетов и 21 национальных исследовательских центров, провели церемонию запуска суперкомпьютера Leonardo. В основу комплекса положены платформы Atos BullSequana X2610 и X2135. Система Leonardo состоит из двух секций — общего назначения и с ускорителями вычислений (Booster). Когда строительство системы будет завершено, первая будет включать 1536 узлов, каждый из которых содержит два процессора Intel Xeon Sapphire Rapids с 56 ядрами и TDP в 350 Вт, 512 Гбайт оперативной памяти DDR5-4800, интерконнект NVIDIA InfiniBand HDR100 и NVMe-накопитель на 8 Тбайт.

Источник изображения: HPCwire Секция Booster объединяет 3456 узлов, каждый из которых содержит один чип Intel Xeon 8358 с 32 ядрами, 512 Гбайт ОЗУ стандарта DDR4-3200, четыре кастомных ускорителя NVIDIA A100 с 64 Гбайт HBM2-памяти, а также два адаптера NVIDIA InfiniBand HDR100. Кроме того, в состав комплекса входят 18 узлов для визуализации: 6,4 Тбайт NVMe SSD и два ускорителя NVIDIA RTX 8000 (48 Гбайт) в каждом. Вычислительный комплекс объединён фабрикой с топологией Dragonfly+. Для хранения данных служит двухуровневая система. Производительный блок (5,4 Пбайт, 1400 Гбайт/с) содержит 31 модуль DDN Exascaler ES400NVX2, каждый из которых укомплектован 24 NVMe SSD вместимостью 7,68 Тбайт и четырьмя адаптерами InfiniBand HDR. Второй уровень большой ёмкости (106 Пбайт, чтение/запись 744/620 Гбайт/с) состоит из 31 массива DDN EXAScaler SFA799X с 82 SAS HDD (7200 PRM) на 18 Тбайт и четырьмя адаптерами InfiniBand HDR. Каждый из массивов включает два JBOD-модуля с 82 дисками на 18 Тбайт. Для хранения метаданных используются 4 модуля DDN EXAScaler SFA400NVX: 24 × 7,68 Тбайт NVMe + 4 × InfiniBand HDR. В настоящее время Leonardo обеспечивает производительность более 174 Пфлопс. Ожидается, что суперкомпьютер будет полностью запущен в первой половине 2023 года, а его пиковое быстродействие составит 250 Пфлопс. Уже сейчас система занимает четвёртое место в последнем рейтинге самых мощных суперкомпьютеров мира TOP500. В Европе Leonardo является второй по мощности системой после LUMI. Leonardo оборудован системой жидкостного охлаждения для повышения энергоэффективности. Кроме того, предусмотрена возможность регулировки энергопотребления для обеспечения баланса между расходом электричества и производительностью. Суперкомпьютер ориентирован на решение высокоинтенсивных вычислительных задач, таких как обработка данных, ИИ и машинное обучение. Половина вычислительных ресурсов Leonardo будет предоставлена пользователям EuroHPC.

15.11.2022 [19:08], Сергей Карасёв

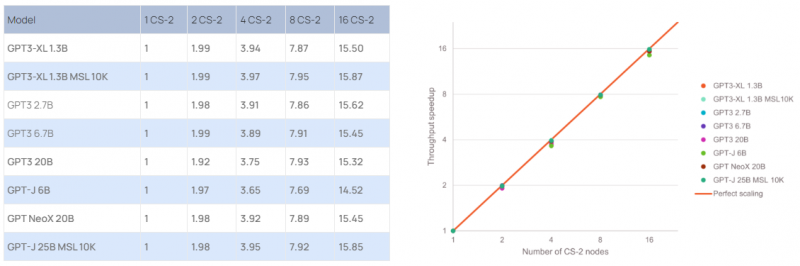

Cerebras построила ИИ-суперкомпьютер Andromeda с 13,5 млн ядерКомпания Cerebras Systems сообщила о запуске уникального вычислительного комплекса Andromeda для выполнения «тяжёлых» ИИ-нагрузок. В основу Andromeda положен кластер из 16 блоков Cerebras CS-2, объединённых 96,8-Тбит/с фабрикой. Каждый из них содержит чип WSE-2, насчитывающий 850 тыс. ядер. Таким образом, общее число ядер достигает 13,5 млн. Кроме того, непосредственно в состав каждого чипа входят 40 Гбайт сверхбыстрой памяти. Система уже доступна коммерческим заказчикам, а также различным научным организациям.

Источник изображения: Cerebras Systems Суперкомпьютер также использует 284 односокетных сервера с процессорами AMD EPYC 7713. Суммарное количество вычислительных ядер общего назначения составляет 18 176. Каждый из этих серверов несёт на борту 128 Гбайт оперативной памяти, NVMe-накопитель вместимостью 1,92 Тбайт и две сетевые карты 100GbE. Эти узлы отвечают за предварительную обработку информации. По заявлениям Cerebras, производительность системы превышает 1 Эфлопс на т.н. разреженных вычислениях и достигает 120 Пфлопс при обычных FP16-вычислениях. Это первый в мире суперкомпьютер, который обеспечивает практически идеальное линейное масштабирование при работе с GPT-моделями, в частности, GPT-3, GPT-J и GPT-NeoX. Иначе говоря, при каждом удвоении числа комплексов CS-2 время обучения моделей сокращается почти в два раза. Суперкомпьютер смонтирован в дата-центре Colovore в Санта-Кларе (Калифорния, США). Стоимость системы составила приблизительно $30 млн, а на её развёртывание потребовалось всего три дня. Использовать ресурсы Andromeda могут одновременно несколько клиентов. |

|