Материалы по тегу: облако

|

08.03.2026 [14:20], Сергей Карасёв

ИИ-облако Iren закупит 50 тыс. ускорителей NVIDIA B300Неооблачная компания Iren объявила о заключении соглашения о покупке более 50 тыс. ускорителей NVIDIA B300. Эта сделка позволит Iren расширить общий парк установленных ускорителей примерно до 150 тыс. ед., что к концу 2026 года обеспечит доход от облачных ИИ-вычислений в размере свыше $3,7 млрд. Закупаемые ускорители NVIDIA B300 в течение этого года будут развёрнуты в существующих дата-центрах Iren с воздушным охлаждением в Маккензи (Британская Колумбия, Канада) и Чилдрессе (Техас, США). При этом подчёркивается, что площадки компании в Чилдрессе и Канал-Флэтс (Британская Колумбия) располагают возможностями для дальнейшего наращивания вычислительных мощностей. За последние восемь месяцев Iren привлекла $9,3 млрд в виде предоплат от клиентов, конвертируемых облигаций, лизинга и средств для приобретения оборудования. В частности, были получены $3,6 млрд на закупку ИИ-ускорителей для нужд Microsoft. Iren намерена использовать эти и другие источники средств для финансирования дополнительных капитальных затрат в размере приблизительно $3,5 млрд: деньги пойдут на покупку серверов, хранилищ, сетевых устройств и вспомогательного оборудования, а также на оплату труда. Условия соглашений предусматривают выполнение платежей после отгрузки техники — это повышает эффективность использования оборотного капитала. «Наращивание мощностей до 150 тыс. ускорителей ставит Iren в число крупнейших мировых поставщиков облачной инфраструктуры для ИИ», — говорит Дэниел Робертс (Daniel Roberts), соучредитель и один из генеральных директоров компании. На сегодняшний день Iren управляет несколькими кампусами ЦОД общей мощностью 810 МВт. Ещё 2,1 ГВт находятся в стадии строительства, 1 ГВт — в стадии разработки. Компания, ранее фокусировавшаяся на майнинге криптовалют, переориентирует свои ресурсы на задачи в сфере ИИ.

06.03.2026 [17:01], Руслан Авдеев

Инференс-нагрузки Perplexity прописались в облаке CoreWeaveКомпания CoreWeave объявила о заключении долгосрочного соглашения с Perplexity. Стратегическое партнёрство призвано обеспечить выполнение рабочих ИИ-нагрузок последней, также предусмотрено пилотное внедрение в обеих организациях новых сервисов. Утверждается, что CoreWeave позволяет клиентам переходить от разработки непосредственно к внедрению без перепроектирования систем и инструментов. Соглашение предусматривает, что платформа CoreWeave будет использоваться Perplexity для инференса нового поколения. Выделенные кластеры на основе суперускорителей NVIDIA GB200 NVL72 гарантируют соответствие инфраструктуры облачного провайдера изменению задач Perplexity и высоким требованиям экосистемы на основе Sonar и Search API. В своё время Perplexity начинала с выполнения задач инференса с помощью CoreWeave Kubernetes Service и применения платформы W&B Models для (до-)обучения моделей и управления ими на всех этапах, от экспериментального до ввода в эксплуатацию. Дополнительно CoreWeave повсеместно внедрит в своей организации инструменты Perplexity Enterprise Max, что позволит её специалистам искать информацию в интернете и внутренней базе данных, проводить углублённые исследования, анализировать данные и визуализировать их. Партнёрство является свидетельством «мультиоблачной» стратегии Perplexity. Чуть более месяца назад Microsoft заключила крупную облачную сделку с Perplexity, но ключевым провайдером ИИ-поисковика останется AWS.

Источник изображения: CoreWeave/Perplexity Это лишь последняя из удачных сделок CoreWeave, сдающей в аренду мощности даже таким компаниям, как Microsoft, Meta✴ и OpenAI. В 2025 году компания получила средства от NVIDIA, которая арендовала свои же ускорители у CoreWeave. В сентябре 2025 года компания обязалась выкупить у неооблачного оператора все нераспроданные мощности. CoreWeave на волне роста спроса на облачные услуги удвоит в 2026 году капитальные затраты, хотя некоторые инвесторы сомневаются в целесообразности таких мер.

06.03.2026 [10:16], Руслан Авдеев

Атака беспилотников на ближневосточные дата-центры AWS заставит пересмотреть подход к отказоустойчивости облаковПрогноз бывшего главы Google Эрика Шмидта (Eric Schmidt) о том, что в будущем критические важные ИИ ЦОД будут защищены военными базами, может оказаться не такими уж фантастическим. Атаки на дата-центры AWS на Ближнем Востоке наглядно показали, что до сих пор в проектах по обеспечению отказоустойчивости некоторые факторы практически игнорировались, сообщает Datacenter Knowkedge. Хотя объекты гиперскейлеров, несмотря на периодические сбои, обычно устойчивее, чем большинство частных ЦОД, облачная инфраструктура обычно противостоит привычным техническим неполадкам — отключение оборудования, перебои в электроснабжении и потеря связности. Планы большинства корпораций, вероятно, не предусматривают защиты от скоординированных атак на физическую инфраструктуру. Если ранее выбор облачного региона был вопросом задержки, суверенитета данных или соответствия местным нормативным требованиям, то теперь остро встают вопросы политической стабильности, вероятности эскалации и возможностей защиты КИИ, в том числе военным путём. Облачные регионы из весьма абстрактных понятий (только у AWS есть более 900 ЦОД различного формата) перешли в категорию физических объектов в конкретных локациях с высокой стоимостью активов. Особенно привлекательны такие цели во время асимметричных конфликтов, когда удар несколькими беспилотниками может вывести из строя критически важный объект, обеспечивающий работу в регионе самых разных структур. Удары по AWS показали, что в геополитических конфликтах концентрация инфраструктуры в одном месте может стать скорее минусом, чем плюсом. В дооблачную эпоху существовали тысячи разнообразных ЦОД с той или иной степенью защиты, но большинство из них не были критически важными для жизни и работы великого множества людей сразу. В эпоху гиперскейлеров нормой стали огромные кампусы, поэтому чрезвычайно надёжные в обычное время дата-центры являются привлекательной целью, поражение которой может принести серьёзный ущерб. Хотя отказываться от облачных технологий уже поздно, возможно, придётся переосмыслить их архитектуру. По словам Datacenter Knowledge, IT-инфраструктура должна служить подспорьем бизнесу и не предназначена для апокалиптических сценариев без экономического обоснования. Другими словами, отраслевые руководители должны выявить уязвимости своих организаций, поскольку игнорирование таких угроз можно назвать «концептуальной» халатностью. IT-управленцы должны оценить, можно ли перенести рабочие нагрузки и важнейшие данные между регионами или даже на другие континенты к альтернативным облачным провайдерам. В расчёт необходимо принимать финансовые ограничения, требования к максимальной задержке, сложность эксплуатации и геополитические риски. Не исключено, что в будущем для пользователей станут привлекательнее не высокоэффективные централизованные ЦОД, а децентрализованные архитектуры с централизованным управлением. Хотя они менее эффективны, рабочие нагрузки будут рассеяны по географически рассредоточенным объектам, что помешает нанести масштабный урон в случае наступления непредвиденных обстоятельств. Пока что отрасль внимательно наблюдает за восстановлением работы AWS в пострадавших зонах доступности, чтобы скорректировать свои планы на будущее. Не исключено, что гораздо востребованнее станут и подземные дата-центры, нередко расположенные в бывших бункерах, оставшихся с прошлых конфликтов, или шахтах и рудниках. Как минимум несколько проектов есть в США и Европе (Швеции, Германии, России и др.). Впрочем, в Израиле подземные ЦОД строят с нуля.

06.03.2026 [08:58], Руслан Авдеев

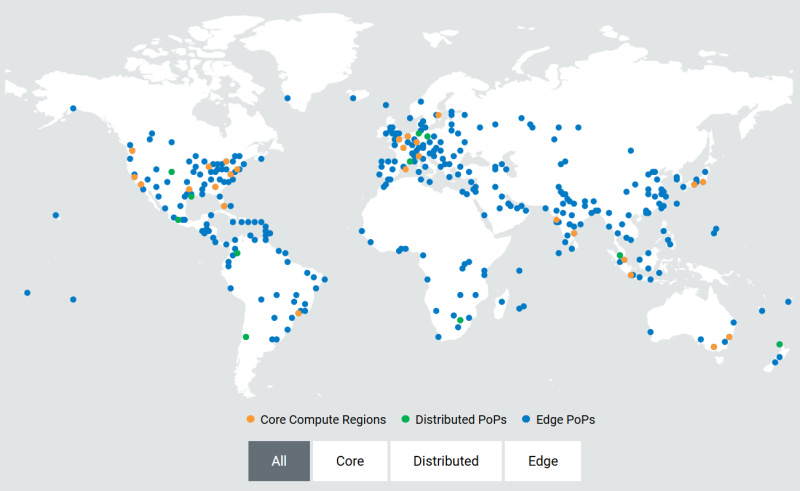

Akamai развернёт тысячи ускорителей NVIDIA RTX Blackwell для распределённого инференсаОблачный провайдер Akamai анонсировал покупку «тысяч» ИИ-ускорителей для развития своей распределённой облачной инфраструктуры по всему миру. Развёртывание новых чипов позволит создать единую оптимизированную ИИ-платформу для быстрого и распределённого инференса в глобальной сети Akamai. По словам компании, она готовит базовую инфраструктуру для «физического» и «агентного» ИИ, где решения необходимо принимать в режиме реального времени. Ранее компания анонсировала проект Akamai Inference Cloud. Как заявляет Akamai, пока крупные облачные бизнесы расширяют проекты обучения ИИ, компания сосредоточилась на удовлетворении потребностей эпохи инференса. Централизованные ИИ-фабрики имеют важное значение для создания моделей, но для их масштабной эксплуатации необходима децентрализованная «нервная система». Внедрение NVIDIA Blackwell в распределённая инфраструктуру, как ожидается, позволит ИИ взаимодействовать с «физическим» миром на местах — с системами автономной доставки, умными энергосетями, роботами-хирургами, антифрод-системами т.п. — без географических и финансовых ограничений, характерных для классических облаков. Интеграция ускорителей Blackwell обеспечит:

Предоставляя инструментарий для выполнения задач ближе к конечным пользователям, Akamai обеспечивает высокую пропускную способность и, как утверждается, одновременно снижает задержку до 2,5 раз. Это позволит бизнесам экономить до 86 % на инференсе в сравнении с обычными облачными компаниями-гиперскейлерами. Платформа объединяет серверы на основе ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition с DPU NVIDIA BlueField-3 и распределённую облачную инфраструктуру Akamai с 4,4 тыс. точек присутствия. Cloudflare применяет платформу с «бессерверным» инференсом в более чем 200 городах. Её Workers AI обеспечивают глобальный инференс с задержкой менее 100 мс без специального выделения кластеров ускорителей. Fastly применяет платформу периферийных вычислений, но предлагает меньшее количество локальных точек присутствия (PoP) для выполнения задач на GPU/CPU.

05.03.2026 [09:07], Владимир Мироненко

5G-виртуализация с ИИ-монетизацией: Broadcom представила VMware Telco Cloud Platform 9 с фокусом суверенные облака

5g

6g

vmware

автоматизация

виртуализация

ии

информационная безопасность

конфиденциальность

сети

частное облако

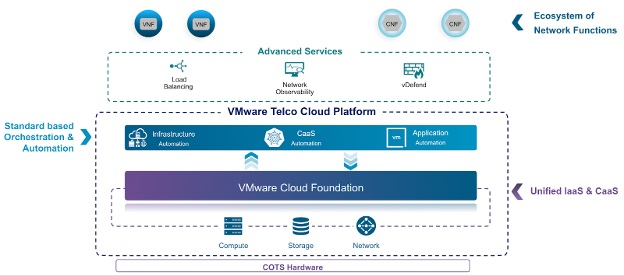

Broadcom представила VMware Telco Cloud Platform 9 — частную облачную платформу для телекоммуникационных ЦОД, которая позволит глобальным телекоммуникационным операторам повысить эффективность оборудования и снизить эксплуатационные расходы при предоставлении суверенных и ИИ-сервисов. Созданная на базе VMware Cloud Foundation 9 с дополнительными возможностями, специфичными для телекоммуникационных компаний, платформа позволит операторам добиться в течение пяти лет совокупной экономии совокупной стоимости владения (TCO) на 40 % по сравнению с изолированными архитектурами; снизить энергопотребление и связанные с ним затраты на 25–30 % за счёт повышения производительности серверов и плотности виртуальных машин. Также сообщается, что благодаря использованию Advanced NVMe Memory Tiering новая платформа позволит достичь до 38 % снижения совокупной стоимости владения (TCO) памятью и серверами, и на 38 % сократить TCO хранилища с помощью функции vSAN ESA Global Deduplication, позволяющей глобально дедуплицировать данные. Кроме того, новая платформа позволит повысить эффективность, управляемость и соответствие нормативным требованиям за счёт интеллектуальной автоматизации, интегрированного управления затратами и соблюдения политик.

Источник изображений: VMware «VMware Telco Cloud Platform 9 позволит телекоммуникационным операторам предоставлять безопасную, суверенную, ориентированную на ИИ инфраструктуру, которая способствует внедрению технологий следующего поколения, ускорению роста доходов и снижению затрат», — заявил Пол Тернер (Paul Turner), главный директор по продуктам подразделения VMware Cloud Foundation. Broadcom отметила, что VMware Telco Cloud Platform развивается, поддерживая как функции ядра сети 4G/5G, так и ресурсоёмкие рабочие ИИ-нагрузки на единой открытой платформе, позволяя операторам предоставлять суверенное облако и ИИ. С целью улучшения монетизации ИИ в Telco Cloud Platform 9 добавят такие возможности, как частный ИИ (Private AI-as-a-Service), GPU-виртуализацию (GPU Virtualization) и GPUaaS (с логической изоляцией конфиденциальных данных). Планы также включают расширенный мониторинг физических и виртуальных GPU. При реализации опции «Частный ИИ как услуга» включение собственных инструментов, таких как хранилище моделей, среда выполнения моделей и векторные базы данных, позволит операторам предлагать клиентам готовые ИИ-среды, обеспечивая при этом строгую изоляцию данных и соответствие нормативным требованиям. vGPU позволят повысить эффективность использования оборудования и снизить затраты. Благодаря этому телекоммуникационным компаниям смогут одновременно запускать высокопроизводительные рабочие нагрузки без необходимости выделения оборудования для каждого пользователя. Также платформа будет поддерживать автоматизированное управление жизненным циклом (LCM), обеспечивая разработчикам развёртывание готовых к производству частных ИИ-сред за считанные минуты, а не недели. Компания также представила «Сервис создания агентов» (Agent Builder) — Low-code платформу, которая упростит создание сложных ИИ-агентов ИИ, автоматизируя оркестрацию моделей, извлечение данных и возможности подключения инструментов. Broadcom отметила, что по мере перехода сетей к модели, ориентированной на ИИ, они должны стать самокорректирующимися и основанными на намерениях. Платформа VMware Telco Cloud Platform обеспечит возможности для автоматизации управления жизненным циклом и оптимизации энергопотребления в ядре 5G и, в конечном итоге, в 6G. Поддержка энергоэффективной инфраструктуры на базе новых процессоров и интеллектуальное планирование ресурсов позволят оптимизировать энергопотребление для энергоёмких приложений 5G и ИИ. Также планируются изменения в работе Kubernetes, с модернизированной моделью управления жизненным циклом CaaS и вариантами обновления, ориентированными на операторов связи. Broadcom внедрит унифицированную автоматизацию на основе GitOps. Планируется использование централизованной панели управления с единым интерфейсом для управления парком, контроля затрат и лицензирования. А ESX Live Patching позволит администраторам применять критически важные обновления безопасности к хостам без необходимости проведения плановых работ или нарушения работы активных ВМ. При этом ИИ-ассистенты помогут оптимизировать процесс подключения к платформе и устранения неполадок. Суверенное облако стало центральным требованием к закупкам для многих рабочих нагрузок государственного сектора и регулируемых отраслей в Европе и других странах. Broadcom заявила, что платформа Telco Cloud Platform 9 будет включать «архитектурные механизмы защиты», соответствующие суверенным требованиям, с акцентом на локальный контроль, проверку и операции в пределах границ.

Также будет использоваться централизованная панель мониторинга SecOps, обеспечена поддержка конфиденциальных вычислений в защищённых анклавах AMD и Intel, и реализовано обеспечение горизонтальной безопасности с использованием VMware vDefend для микросегментации и контроля на основе принципа нулевого доверия.

03.03.2026 [16:05], Руслан Авдеев

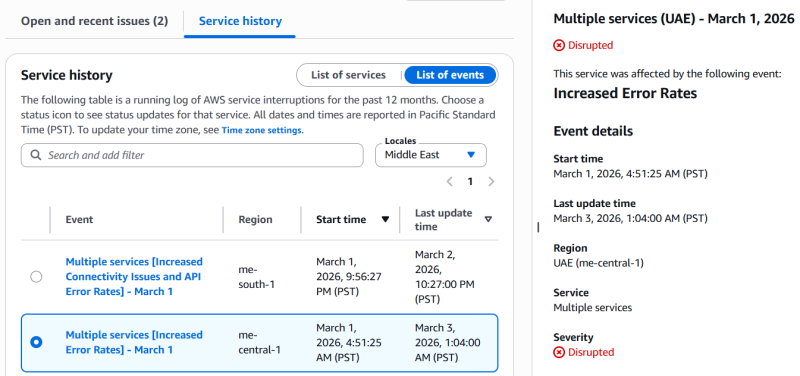

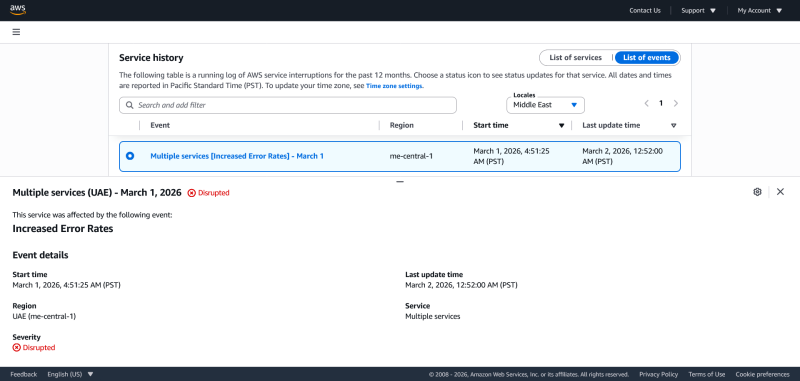

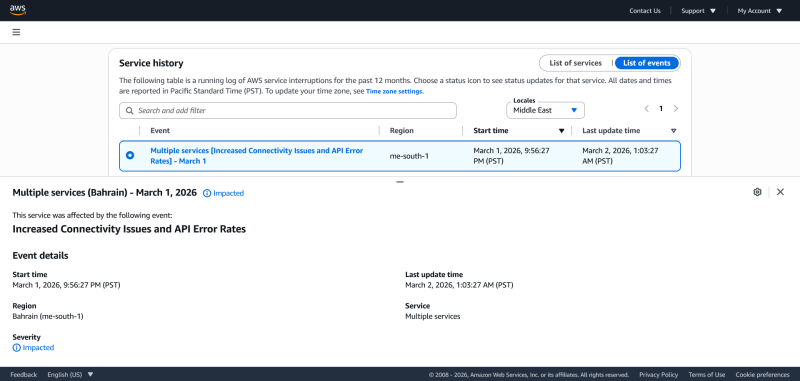

Иранские дроны повредили два дата-центра Amazon в ОАЭ и «зацепили» ещё один в БахрейнеВ результате ударов беспилотников на Ближнем Востоке пострадали три дата-центра Amazon. Компания отказалась от корпоративных эвфемизмов о попадании неких «объектов», которые вызвали «искрение и возгорание», и прямо заявила, что дроны попали в два ЦОД в ОАЭ, обслуживающие зоны доступности mec1-az2 и mec1-az3 региона ME-CENTRAL-1. Третий ЦОД в Бахрейне (mes1-az2 в ME-SOUTH-1) пострадал от удара в «непосредственной близости» от него. Хотя прямо Amazon об этом не говорит, очевидно, что беспилотники были иранские. Как заявила AWS, удары нанесли «структурный урон», нарушили подачу электроэнергии объектам компании, а в некоторых случаях потребовалось тушение пожаров, что причинило дополнительный ущерб, на этот раз от воды. По словам компании, организовано тесное сотрудничество с местными властями, а первостепенное внимание уделяется безопасности персонала. Зоны mec1-az2 и mec1-az3 региона ME-CENTRAL-1 по-прежнему работают с перебоями, третья зона — mec1-az1 продолжает функционировать в обычном режиме, хотя затронуты некоторые сервисы az1, зависевшие и от работы других зон. В регионе ME-SOUTH-1, расположенном в Бахрейне, пострадал один объект. Впрочем, как в Бахрейне, так и в ОАЭ клиенты продолжают сталкиваться ошибками и проблемами доступности ряда сервисов. В компании предполагают, что инфраструктуру ожидает длительный процесс восстановления с учётом «характера причинённого физического ущерба». С учётом ситуации на Ближнем Востоке AWS рекомендует клиентам создавать резервные копии информации и оценить, насколько возможен перенос рабочих нагрузок в другие облачные регионы Amazon.

02.03.2026 [13:00], Руслан Авдеев

Облако AWS пострадало от «удара объектов по ЦОД» в ОАЭ, приведшего к пожаруЗоны доступности mec1-az2 и mec1-az3 в регионе AWS ME-CENTRAL-1 в ОАЭ прекратили работу после того, как по дата-центру ударили «объекты». По данным AWS, объекты вызвали «искры и возгорание». Пожарные отключили сетевое электропитание и генераторы объекта для того, чтобы без помех погасить огонь. Сервисы EC2 и S3 отключены полностью, ещё 84 сервиса подвержены различным проблемам. Зона mec1-az1 не пострадала. Тем, кто не использовал резервирование в нескольких зонах, компания рекомендует развернуть нагрузки из последних бэкапов в незатронутых зонах или регионах. Сообщается, что компания всё ещё ждёт разрешения для того, чтобы вновь подать питание, и как только получит его, будет обеспечено безопасное восстановление работы и связи. Одновременно пострадала и зона доступности mes1-az2 региона ME-SOUTH-1 в Бахрейне. Компания сообщает о проблемах с питанием и сетевым подключением, но не уточняет причины сбоя. Всего проблемы затронули 66 сервисов. Остальные зоны региона не пострадали.

02.03.2026 [09:56], Руслан Авдеев

И не звони мне больше: Microsoft представила по-настоящему автономное частное облако Azure Local

azure stack

microsoft

microsoft azure

software

евросоюз

информационная безопасность

конфиденциальность

облако

частное облако

Microsoft улучшила автономность решения Azure Local, позволяющего теперь создавать полностью «карманные» облака без подключения к интернету. На фоне политических трений между руководством США и Евросоюза всё больше европейских клиентов желают обеспечить себе цифровой суверенитет, сообщает The Register. Как и конкуренты из числа американских гиперскейлеров, Microsoft представила для Европы инициативы, призванные устранить сомнения местных заказчиков в безопасности их данных, включая возможность блокировки доступа к ним или получение доступа к информации американскими властями в рамках закона US CLOUD Act. В марте 2025 года Microsoft завершила формирование сервиса EU Data Boundary, а в ноябре добавила новые функции, призванные дополнительно укрепить уверенность европейских клиентов. Тем не менее всё больше организаций в Европе требуют полного контроля над своими данными, чего сервис обеспечить не может, поскольку Microsoft подчиняется американским законам. Компания даже пообещала судиться с правительством США, если то попытается лишить европейских клиентов её продуктов. Azure Local (Azure Stack HCI) — ответ Microsoft на опасения Европы. Azure Local и ранее позволял работать на собственных мощностях, но требовал подключение к «большому» облаку хотя бы раз в 30 дней для обновлений, мониторинга и проверки лицензий, в противном случае функциональность ограничивалась. Теперь же в Azure Local доступны полностью изолированные от публичных облаков операции. Другими словами, связь с «метрополией» больше не нужна. Кроме того, компания обеспечила локальный доступ к Microsoft 365 Local (в частности, Exchange Server, SharePoint Server и Skype for Business Server), а также анонсировала Foundry Local для «квалифицированных клиентов». Заверения Microsoft могут быть восприняты с недоверием — особенно с учётом того, что в 2025 году компания признала во Франции, что буквально не имеет возможности обеспечить данным полный суверенитет — если с требованием предоставить доступ к данным выступят американские власти. Возможность работать полностью независимо от Сети должна убедить клиентов в привлекательности работы с IT-гигантом, даже с учётом того, что ПО разрабатывается за океаном. По словам представителя ассоциации европейских облачных провайдеров CISPE, суверенитет всё более становится обязательным требованием, поэтому инструменты, позволяющие работать на локальных облачных платформах, приветствуются. Ассоциация намерена оценить новое предложения на предмет гарантий суверенитета и надёжности в рамках программы CISPE Sovereign Cloud Services Framework. CISPE и Microsoft достигли в 2024 году соглашения, в соответствии с которым IT-гигант обещал разработать версию Azure Local для европейских провайдеров и хорошо заплатить, а CISPE обязалась отказаться от обвинений компании в неконкурентных практиках. Правда, Microsoft уже пропустила оговоренные сроки. Microsft — не единственный техногигант, работающий над обеспечением суверенитета для своих клиентов. Amazon Web Services (AWS) предложила всеобщий доступ к своему суверенному облаку European Sovereign Cloud, а Google продаёт клиентам множество суверенных решений, включая Google Cloud Airgapped — сервис работает на серверах, полностью отключенных от интернета. Впрочем, Google в основном предпочитает совместные партнёрские решения с европейскими компаниями. Удовлетворит ли новое решение клиентов Microsoft, покажет практика его применения и то, каким будет определение «суверенитета». Возможность полного отключения от Сети удовлетворит некоторых клиентов, хотя некоторых по-прежнему может беспокоить то, что программное обеспечение может оставаться под контролем Microsoft. И даже если внутренние данные никуда не «утекут», всё равно остаётся вероятность того, что компания сможет тем или иным образом отключить сервисы Azure Local. Корпоративные клиенты уже ищут альтернативные предложения от локальных облачных провайдеров. В конце 2025 года немецкая SAP объявила, что инвестирует более €20 млрд ($23,3 млрд) в расширение суверенного облачного сервиса в Европе. Правда, глава SAP Кристиан Кляйн (Christian Klein) ранее заявлял, что не видит смысла в построении в Европе собственной облачной инфраструктуры в противовес уже созданной здесь американцами. Кроме того, у компании весьма тесные отношения с Azure. Доля же истинно европейских облаков годами остаётся низкой, поэтому отказаться от услуг заокеанских компаний практически невозможно, а open source в обозримом будущем вряд ли поможет.

27.02.2026 [22:55], Владимир Мироненко

Amazon вложит в OpenAI $50 млрд, OpenAI в ответ потратит $100 млрд на 2 ГВт мощностей TrainiumOpenAI и Amazon объявили о заключении соглашения о стратегическом партнёрстве с целью ускорения инноваций в области ИИ для предприятий, стартапов и конечных потребителей по всему миру. В рамках многолетнего соглашения Amazon инвестирует в OpenAI $50 млрд — $15 млрд первым траншем, а затем еще $35 млрд в ближайшие месяцы при выполнении определённых условий. AWS и OpenAI совместно создадут среду выполнения с сохранением состояния (Stateful Runtime Environment) на базе моделей OpenAI, которая будет доступна в Amazon Bedrock для создания приложений и агентов генеративного ИИ. Подобное окружение позволяет разработчикам сохранять контекст, запоминать предыдущую работу, работать с различными программными инструментами и источниками данных, а также получать доступ к вычислительным ресурсам. Новинка будет интегрирована с Amazon Bedrock AgentCore и инфраструктурными сервисами, чтобы приложения и ИИ-агенты клиентов работали согласованно с остальными приложениями инфраструктуры, работающими в AWS. AWS также станет эксклюзивным сторонним поставщиком облачных услуг для платформы OpenAI Frontier, позволяющей компаниям создавать, развёртывать и управлять командами ИИ-агентов, работающих в реальных бизнес-системах с общим контекстом. По мере перехода компаний от экспериментов к внедрению ИИ в производство, Frontier упрощает быструю, безопасную и глобальную интеграцию ИИ-технологий в существующие рабочие процессы. Кроме того, OpenAI и Amazon будут сотрудничать в разработке пользовательских моделей для работы с приложениями Amazon, ориентированными на клиентов. AWS и OpenAI также сообщили о расширении ещё на $100 млрд более раннего соглашения о многолетнем стратегическом партнёрстве стоимостью $38 млрд, в рамках которого AWS обязалась предоставлять OpenAI в течение семи лет доступ к ускорителям NVIDIA. Расширенное соглашение со сроком действия 8 лет включает в себя обязательство OpenAI использовать около 2 ГВт мощностей на базе ускорителей Trainium, чтобы поддерживать спрос на Stateful Runtime, Frontier и другие рабочие нагрузки. Это обязательство распространяется как на чипы Trainium3, так и на чипы следующего поколения Trainium4, которые появятся в 2027 году и получат технологию NVIDIA NVLink. Сегодняшний день оказался богатым на события для OpenAI. Компания объявила о привлечении $110 млрд инвестиций в рамках раунда финансирования с предварительной оценкой её рыночной стоимости в $730 млрд, что значительно больше оценки в $500 млрд в октябре 2025 года. Лидером раунда стала Amazon с инвестициями в $50 млрд, за ней следуют NVIDIA и SoftBank, инвестировавшие по $30 млрд. Компания заявила, что ожидает, что к раунду присоединятся и другие инвесторы. Ранее Anthropic, ключевой конкурент OpenAI, закрыл раунд финансирования на $30 млрд, подняв капитализацию до $380 млрд. У компании долгие и тесные отношения с AWS, которая развернула для стартапа один из крупнейших в мире ИИ-кластеров Project Rainier. Впрочем, Anthropic тоже старается диверсифицировать поставки вычислительных мощностей — она заключила контракты с Microsoft (на чипы NVIDIA), а также с Google (на TPU).

27.02.2026 [15:30], Руслан Авдеев

Шутки в сторону: 1 апреля провайдер Hetzner резко поднимет цены — до +50 %Один из крупнейших европейских хостинг-провайдеров и операторов ЦОД — компания Hetzner предупредила клиентов, что рост цен на её услуги составит до 50 %. Это касается как имеющихся пользователей, так и будущих — в Германии, Финляндии, США и Сингапуре, сообщает The Register. Hetzner известна (пока) недорогими сервисами, в первую очередь IaaS, для разработчиков и корпоративных клиентов. Компания сообщила, что причиной изменений стоимости её продуктов стал рост цен в разных сферах рынка IT. Компания пожаловалась, что выросла стоимость эксплуатации инфраструктуры и нового оборудования, а попытка оптимизации расходов не принесла желаемого эффекта. Список ценовых изменений свидетельствует, что многие услуги действительно значительно подорожают, многие на 30 %, а некоторые даже на 50 %, что может серьёзно сказаться на небогатых клиентах. Стремительное развитие ИИ-индустрии стало одним из факторов, определивших движение рынка инфраструктуры в непредсказуемых направлениях на фоне спроса на всё большие вычислительные мощности. Гиперскейлеры не могут приобрести достаточно HBM, RAM и флеш-памяти, а также ИИ-ускорителей, особенно производства NVIDIA. Ожидается, что цены на DRAM- и NAND-модули в текущем квартале удвоятся, а некоторые серверные CPU уже в дефиците и скоро подорожают. Производители HDD жалуются, что распродали столько жёстких дисков, сколько собирались выпустить за весь год.

Источник изображения: Jon Del Rivero/unspalsh.com В Omdia отметили, что Hetzner фактически является провайдером облачной инфраструктуры, поэтому в подорожании сервисов даже на 50 % нет ничего удивительного — это всего лишь отражение текущей реальности. В Omdia считают, что пользователи могут ожидать повышения цен и со стороны других провайдеров. Наибольшему давлению подверглись компании-операторы второго эшелона, они в более невыгодном положении в сравнении с гиперскейлерами. Эксперты Omdia отмечают, что рынок облачных сервисов ожидает некоторый раскол — гиперскейлеры уровня AWS, Microsoft и Google имеют долгосрочные прямые соглашения напрямую с поставщиками «железа», защищающие их от немедленного ценового шока. Тем временем средние и малые компании, не обладающие гигантской покупательной способности, в том числеHetzner и OVHcloud (тоже анонсировавшей рост цен), не имеют выбора, перекладывая издержки на пользователей. К несчастью для компаний, рассчитывающих на бюджетный облачный хостинг, инфраструктурные издержки взлетят. Рынку необходимо, чтобы компании уровня Hetzner продолжали работать и сохраняли прибыльность. Реакция онлайн-сообщества оказалась смешанной. Одни пользователи говорят, что рост цен непосильный, поэтому им придётся искать возможные альтернативы. У некоторых небольших провайдеров действительно пока что более привлекательные цены в сравнении с Hetzner. Среди плюсов называется относительно недорогая стоимость ухода от к конкурентам. Другие же пользователи пишут, что реакция компании предсказуема. В противном случае пришлось бы вообще отказаться от облачных серверов. Отмечается, что у Hetzner всё ещё лучшее соотношение цены/производительности в сравнении с конкурентами. Стоит отметить, что некоторые компании довольно спорно обосновывают ценообразование. Например, не так давно сообщалось, что Cisco нашла оправдание повышению цен на свои продукты, несмотря на рекордную выручку во II четверти текущего финансового года. |

|