Материалы по тегу: ии

|

02.06.2025 [12:00], Сергей Карасёв

«Базис» и СберТех обеспечат бизнесу удобную и устойчивую инфраструктуру«Базис» и СберТех в рамках ежегодной конференции «Цифровая индустрия промышленной России» (ЦИПР) подписали соглашение о технологическом партнёрстве. Основной целью сотрудничества является повышение технологической совместимости платформы для управления виртуальными средами Basis Dynamix с серверной операционной системой (ОС) СберТеха Platform V SberLinux OS Server. Соглашение подписали генеральный директор «Базиса» Давид Мартиросов и генеральный директор СберТеха Максим Тятюшев. Совместная работа партнёров позволит обеспечить эффективное проектирование, разработку и технологическую совместимость флагманских продуктов компаний. В результате пользователи продуктов получат ещё более удобную и устойчивую инфраструктуру. Для российского рынка инфраструктурного ПО подписанное соглашение станет примером успешного обмена опытом на уровне разработки сложного программного обеспечения. Партнёрство будет способствовать развитию компетенций продуктовых команд СберТеха и «Базиса» за счёт обмена инженерным и научно-техническим опытом, а также снижению операционных затрат на поиск и устранение дефектов в коде продуктов. Участники рассчитывают, что результатом партнёрства станет повышение зрелости и коммерческой привлекательности разрабатываемого ими ПО. «Технологическое партнёрство со СберТехом позволяет нам из первых рук узнать обо всех возможностях и особенностях операционных систем, а нашим коллегам — лучше понять, как устроена крупнейшая на российском рынке платформа виртуализации. Для наших заказчиков это означает получение более надёжной и безопасной ИТ-инфраструктуры при использовании решений "Базиса" и СберТеха. А для рынка отечественного ПО это ещё один сигнал о важности совместной работы над проектами по импортозамещению. Недостаточно просто заменить иностранное ПО на своё, нужно обеспечить его совместимость с другими отечественными решениями, которые будут работать или уже работают в инфраструктуре заказчика», — подчеркнул Давид Мартиросов, генеральный директор «Базиса». «Импортозамещение инфраструктурного и системного ПО — это тот путь, который рано или поздно придётся пройти всем. Наша задача как вендора, сделать так, чтобы для наших клиентов этот путь был максимально комфортным. Ещё лучше, когда вместо простой замены клиент получает новые возможности для роста и повышения эффективности бизнеса. Для решения этой задачи мы объединили усилия с технической командой "Базиса", вместе мы поможем российскому бизнесу достичь технологической независимости на уровне программного обеспечения», — сообщил Максим Тятюшев, генеральный директор СберТеха. Platform V SberLinux OS Server — серверная ОС, которая обеспечивает высокую производительность различных приложений. Решение зарегистрировано в Реестре российского ПО и соответствует высоким корпоративным требованиям в области надёжности, безопасности и производительности. ОС сертифицирована по 4-му уровню доверия и соответствует требованиям по безопасности информации ФСТЭК России к операционным системам, средствам виртуализации и средствам контейнеризации 4-го класса защиты. Basis Dynamix Enterprise — высокопроизводительная платформа для построения динамической инфраструктуры и управления виртуальными средами. Решение зарегистрировано в Реестре российского ПО и соответствует требованиям ФСТЭК России по 4 уровню доверия. Платформа признана лучшей в рейтинге российских платформ виртуализации 2024 года, выпущенным отраслевым изданием CNews. По данным исследования «ТМТ консалтинг», Dynamix Enterprise занимает 35 % российского рынка серверной виртуализации.

02.06.2025 [09:02], Сергей Карасёв

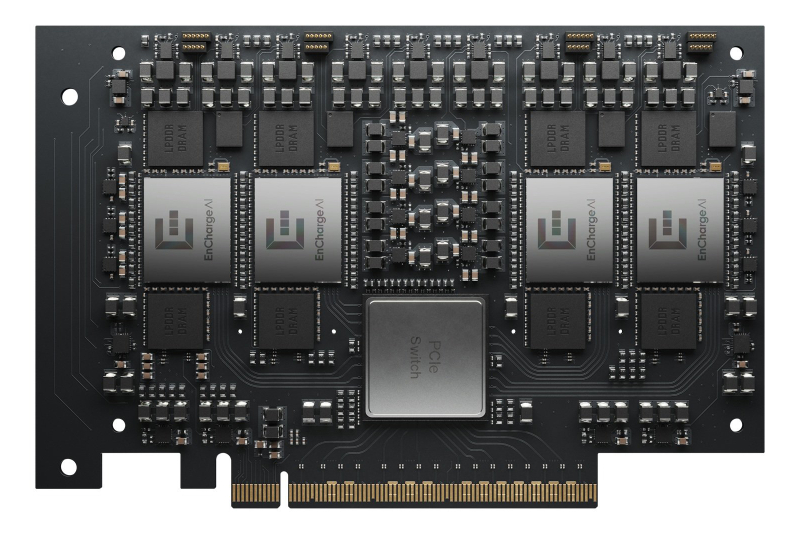

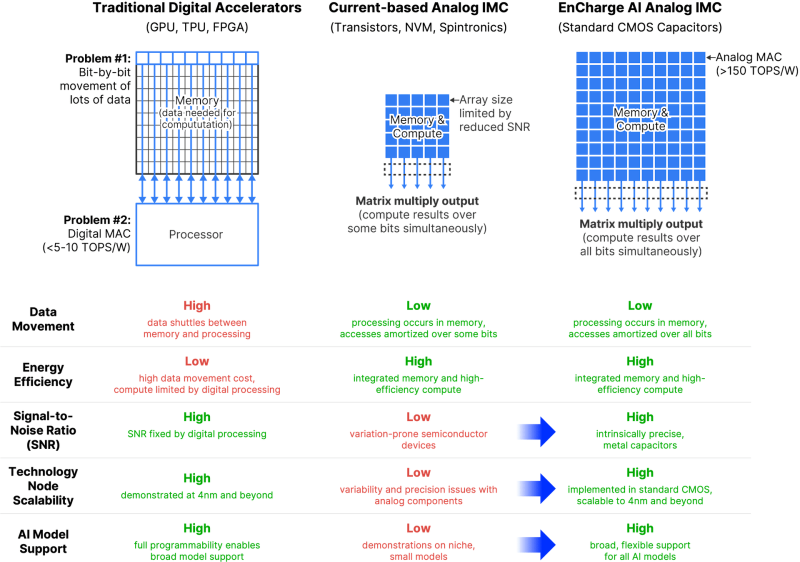

EnCharge AI представила аналоговые ИИ-ускорители EN100Компания EnCharge AI анонсировала изделия семейства EN100 — аналоговые ИИ-ускорители для in-memory вычислений. Дебютировали устройства в форм-факторе M.2 для ноутбуков и карты расширения PCIe для настольных рабочих станций. Стартап EnCharge AI, основанный в 2022 году, разрабатывает чипы, которые дают возможность перенести ИИ-нагрузки из облака на локальные платформы. Для этого применяется концепция вычислений в оперативной памяти, позволяющая увеличить эффективность и устранить узкие места, связанные с перемещением данных. NPU-ядра EnCharge AI, как утверждает сам разработчик, обеспечивают производительность на уровне 40 Топс/Вт (8-бит точность). Ускоритель EN100 для ноутбуков имеет типоразмер M.2 2280. В оснащение входят 32 Гбайт памяти с пропускной способностью до 68 Гбайт/с. Быстродействие превышает 200 Топс при общем энергопотреблении не более 8,25 Вт. Для оркестрации задействована многопоточная архитектура RISC-V. На рабочие станции ориентированы ускорители EN100 в виде карт расширения PCIe HHHL. Они несут на борту 128 Гбайт памяти с суммарной пропускной способностью 272 Гбайт/с. Производительность составляет около 1 Попс. Изделия обоих типов изготавливаются с применением 16-нм CMOS-технологии. Навин Верма (Naveen Verma), генеральный директор EnCharge AI, заявляет, что решения компании позволят выполнять ресурсоёмкие задачи ИИ локально, не полагаясь на облачную инфраструктуру. Утверждается, что такие устройства по сравнению с современными ИИ-ускорителями обеспечат в 20 раз более высокую энергоэффективность (Топс/Вт) и в 9 раз более высокую плотность вычислений (Топс/мм2) при 10-кратном снижении совокупной стоимости владения (TCO).

31.05.2025 [12:03], Сергей Карасёв

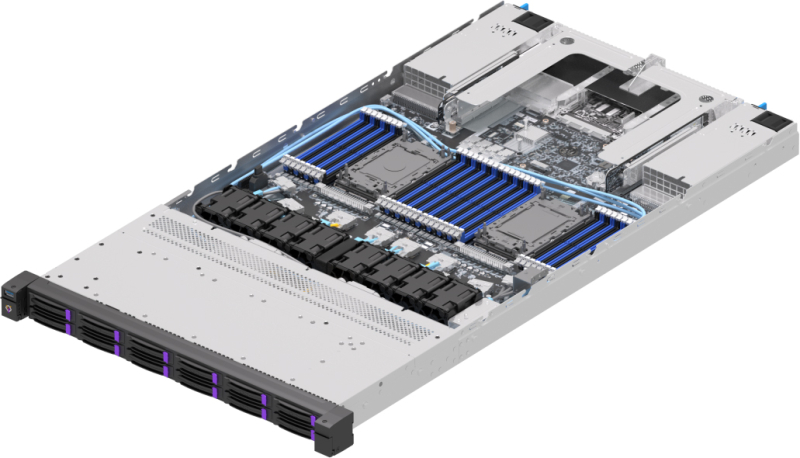

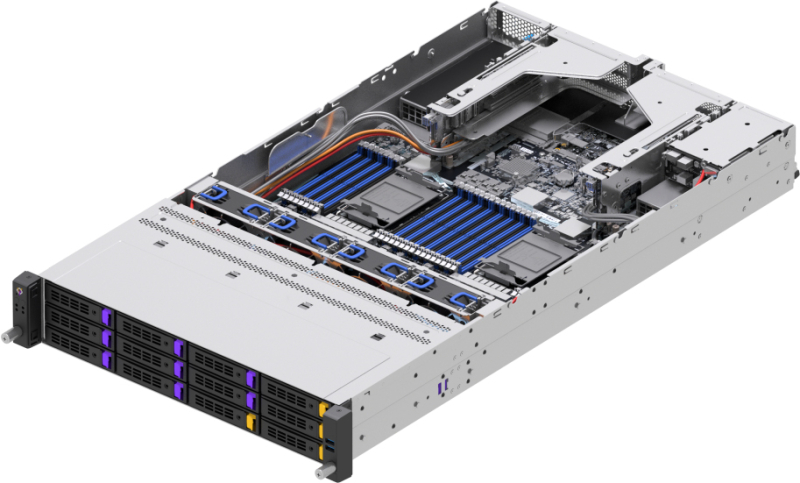

OpenYard представила серверы RS102I и RS202I на базе Intel Xeon Emerald RapidsРоссийский производитель OpenYard анонсировал серверы RS102I и RS202I, выполненные в форм-факторе 1U и 2U соответственно. Новинки простроены на аппаратной платформе Intel с возможностью установки двух процессоров Xeon поколения Emerald Rapids или Sapphire Rapids. Модель RS102I предназначена для таких задач, как виртуализация, облачные приложения и высокопроизводительные вычисления. Доступны 32 слота для модулей оперативной памяти DDR5 суммарным объёмом до 8 Тбайт. Во фронтальной части расположены отсеки для 12 накопителей SFF (интерфейсы PCIe 5.0, SAS или SATA) с функцией горячей замены. При использовании NVMe SSD суммарная вместимость подсистемы хранения данных может достигать 368 Тбайт. Возможна организация массивов RAID 0/1/5/6/10/50/60. Сервер располагает двумя слотами PCIe 5.0 x16 FHHL и двумя разъёмами OCP 3.0 (PCIe 5.0 x16). Могут применяться сетевые карты 10/25GbE или 100/200GbE, а также адаптеры FC 16/32/64Gb. За питание отвечают два блока мощностью 1600 Вт каждый с резервированием. Габариты устройства составляют 438 × 43,5 × 815 мм. В свою очередь, модель RS202I ориентирована на транзакционные и аналитические базы данных, задачи ИИ, виртуализацию, облачные приложения и доставку медиаконтента. Система оснащена 32 слотами DDR5 с поддержкой 8 Тбайт памяти. Поддерживается установка до 24 накопителей SFF или до 12 устройств LFF спереди (PCIe 5.0, SAS или SATA) и до четырёх накопителей SFF сзади (SATA/SAS). Реализована горячая замена; допускается создание массивов RAID 0/1/5/6/10/50/60. Максимальная суммарная вместимость при использовании NVMe SSD — 860 Тбайт. Слоты расширения выполнены по схеме 6 × PCIe 5.0 x16 FHHL, 4 × PCIe 5.0 x8 HHHL и 2 × OCP 3.0 PCIe 5.0 x16 (с поддержкой NCSI). Установлены два блока питания мощностью до 2400 Вт с резервированием. Сервер имеет размеры 438 × 87,5 × 815 мм.

30.05.2025 [16:25], Руслан Авдеев

Скромно, зато всё своё: Bell Canada и Telus развернут в Канаде сеть ИИ ЦОДКрупнейшая по объёму выручки телеком-компания Канады создаст по всей стране сеть ИИ ЦОД, ориентируясь на пример США и других стран. Речь идёт о Bell Canada Enterprises (BCE), намеренной инвестировать в шести городах сотни миллионов долларов, сообщает Bloomberg со ссылкой на данные оператора. Первый объект в Камлупсе (Kamloops, Британская Колумбия) должны ввести в эксплуатацию уже в июне текущего года, а якорным арендатором для него станет стартап Groq, занимающийся разработкой ИИ-чипов и облачными сервисами. В той же провинции, а также в Манитобе и Квебеке в ближайшие годы планируется строительство и других объектов. Ожидается, что после завершения проекта, получившего имя Bell AI Fabric, мощность дата-центров составит 500 МВт, что немало для поддержки ИИ-проектов, но намного скромнее, чем проекты в США, на Ближнем Востоке и в Азии. Groq станет эксклюзивным партнёром сети ЦОД в деле инференса. Как заявляют в BCE, стране необходим суверенный ИИ, которым управляют канадцы — в компании хотят быть уверенными, что Канада «не будет отключена» в случае геополитической напряжённости и сохранит доступ к технологиям, необходимым для канадской экономики. В компании сетуют, что местные учёные во многом стали пионерами в области разработки современного ИИ, но страна отстаёт в коммерциализации соответствующих технологий.

Источник изображения: BCE BCE — не единственная компания, стремящаяся развивать ИИ в стране. Местный телеком-оператор Telus объявил о намерении потратить CA$70 млрд ($50. млрд) на расширение и апгрейд своей инфраструктуры. В частности, речь идёт о поддержке ЦОД, которые Telus также называет «суверенными ИИ-фабриками». Заодно планируется утилизировать тысячи тонн устаревших медных кабелей и расширить оптоволоконную сеть. В следующие пять лет Telus намерена ввести в эксплуатацию суверенные ИИ-объекты в Камлупсе, Британской Колумбии и Квебеке. Ранее в этом году, как сообщает Datacenter Dynamics, компания сотрудничала с NVIDIA над внедрением ускорителей Hopper и Blackwell в дата-центре в Квебеке к лету 2025 года. Сообщалось, что ИИ-фабрика будет использовать сеть PureFibre в сочетании с дата-центрами, на 99 % питаемыми возобновляемой энергией, для предоставления AIaaS.

Источник изображения: BCE Также в апреле сообщалось, что в Канаде построят крупнейший в мире 7,5-ГВт ЦОД с питанием от природного газа. Проект Wonder Valley предусматривает строительство крупного ИИ ЦОД без подключения к магистральным энергосетям в муниципальном округе Гринвью (Greenview) провинции Альберта. Стремление Канады увеличить количество локальных ИИ ЦОД также соответствует растущему спросу на инференс. В то время, как ИИ ЦОД, ориентированные на обучения ИИ-моделей, можно размещать почти где угодно при наличии свободной земли и энергии, для быстрого инференса необходима близость к потребителям и развитая сетевая инфраструктура. Как сообщают в Groq, суверенные ИИ-платформы составляют немалую часть бизнеса компании. Её сервисами пользуются более 1,6 млн разработчиков, которые могут выбрать как ИИ-модель, так и местоположение ЦОД для работы с данными. Над расширением суверенной инфраструктуры работают всё больше стран. В этом месяце Саудовская Аравия (также сотрудничающая с Groq) и Объединённые Арабские Эмираты (ОАЭ) объявили о планах по работе с американскими технологическими компаниями, включая NVIDIA и OpenAI над созданием локальной ИИ-инфраструктуры. Новые проекты подпитываются растущим спросом на вычислительные ресурсы для запуска ИИ-моделей, а также желанием оптимизировать ИИ под региональные потребности и языки.

30.05.2025 [14:47], Руслан Авдеев

Ассоциация больших данных (АБД) России выступила против доступа силовых ведомств к базам данных бизнесаЭксперты Ассоциации больших данных (АБД) подвергли критике проект приказа российских силовых ведомств, в рамках которого допускается доступ спецслужб к базам данных компаний, содержащим персональные данные. Представители бизнеса уверены, что предложенное регулирование доступа к данным силовиков, судей, свидетелей и др. стоит организовать в индивидуальном порядке, сообщает Forbes. АБД «Яндекс», VK, «Сбер», «Мегафон», Avito, HeadHunter и др. Проект приказа спецслужб разработали с целью исполнения закона об особом порядке обработки личных данных сотрудников Федеральной службы безопасности (ФСБ), Службы внешней разведки (СВР), Федеральной службы охраны (ФСО) и министерства внутренних дел (МВД), принятого в феврале 2025 года. Он также касается данных судей, потерпевших, свидетелей, подлежащих государственной защите и граждан, помогающих силовикам на конфиденциальной основе. В проекте предусматривается, что силовые ведомства должны получить доступ к информационным системам коммерческих структур, содержащим сведения о подобных лицах, без ограничений со стороны хранящего данные бизнеса. В АБД объявили, что такая схема несёт «существенные правовые, технологические и бизнес-риски» и угрожает информационной безопасности. Фактически должностные лица могут получить бесконтрольный доступ к информации, с нарушением штатной работы информационных систем. Кроме того, для такого доступа отсутствуют чётко проработанные юридические механизмы. В ассоциации указали, что действующий сегодня т. н. «закон Яровой», уже регламентирует доступ к данным по запросу силовых ведомств и за нарушение требований предусмотрена административная ответственность. Более того, согласно приказу ФСТЭК удалённый доступ не допускается к информационными системам объектов критической информационной инфраструктуры (КИИ) — в числе прочего речь идёт о банковском, энергетическом, транспортном секторах и телеком-операторах. Ассоциация предложила предусмотреть взаимодействие бизнеса и силовиков в индивидуальном порядке, для чего необходимы соглашения, регулирующие доступ к информационным системам с учётом особенностей последних. В Минцифры утверждают, что не принимали участия в разработке нового проекта приказа. По словам близкого к Минцифры источника, по исполнению «пакета Яровой» уже достигнут компромисс, в результате ФСБ заключает с компаниями индивидуальные соглашения, в которых детально прописан механизм предоставления информации, с типовыми и индивидуальными решениями. Некоторые эксперты предполагают, что сферы действия «закона Яровой» и нового документа различны, поскольку первый рассчитан на широкий круг граждан в рамках антитеррористических мер, а второй — на формализацию особой процедуры доступа к данным защищаемых лиц, госслужащих и сотрудников силовых структур.

30.05.2025 [10:19], Руслан Авдеев

Япония планирует крупные закупки ИИ-чипов для сокращения торгового дефицита с СШАВ преддверии переговоров Японии и США относительно американских пошлин, японские власти предложили закупить в Соединённых Штатах полупроводники на несколько миллиардов долларов. Предполагается, что это поможет «задобрить» США и сократить торговый дефицит с Японией, сообщает Digitimes. Источники в японском правительстве сообщили, что в ходе последних обсуждений тарифной политики Япония предложила планы закупок полупроводников, основным поставщиком в которых рассматривается американская NVIDIA — речь идёт о «многомиллиардных» закупках. Японское правительство намерено поощрять и субсидировать телекоммуникационные и IT-компании, чтобы те выступили операторами новых дата-центров и закупали больше ИИ-ускорителей. Если инициатива будет успешно реализована, импорт из США увеличится на сумму от сотен миллиардов до триллиона японских иен (около $7 млрд), что потенциально компенсирует дефицит приблизительно на 10 %. Торговый дефицит с Японией в 2024 году для США составлял $68,5 млрд.

Источник изображения: JJ Ying/unsplash.com Помимо закупок чипов, Япония также предложила поддержать поставки ключевых материалов для производства полупроводников, таких как пластины и химические компоненты, в США. Совместное укрепление цепочки поставок должно усилить и экономическую безопасность стран. По имеющимся данным, США не намерены менять позицию и готовы только к переговорам о дополнительных дифференцированных пошлинах (помимо единой 10 % пошлины для всех). При этом они не хотят «оптимизировать» ставки на отдельные группы товаров, например — автомобили. Япония же настаивает, что пошлины на автомобили, на которые приходится около 30 % местного экспорта в США, должны быть снижены, поэтому позиции двух стран пока не меняются. Рёсей Аказава (Ryosei Akazawa), в 2024 году получивший в японском правительстве сразу несколько министерских портфелей, связанных с экономикой и развитием, должен был посетить США 29 мая для четвёртого раунда переговоров с министром финансов США Скоттом Бессентом (Scott Bessent) и другими представителями федеральных американских властей. Переговоры посвящены импортно-экспортным пошлинам двух стран. Весьма вероятно, что цель правительства несколько другая. В феврале сообщалось, что SoftBank Group и OpenAI объединились для продвижения ИИ-сервисов среди японских корпоративных клиентов, а в марте появились данные о том, что SoftBank купит за $676 млн заброшенный объект Sharp для строительства ИИ ЦОД, вероятно, в интересах OpenAI. Кроме того, SoftBank участвует в создании двух крупных платформ на базе DGX B200 и GB200 NVL72. Сейчас американскими властями очень много внимания уделяется ИИ-проекту Stargate, в котором японская SoftBank является одним из ключевых игроков наряду с OpenAI. Не исключено, что очередной кампус Stargate по результатам переговоров появится именно в Японии. Расширение проекта за пределы США уже началось, OpenAI и G42 построят 5-ГВт кампус в Абу-Даби.

30.05.2025 [09:34], Руслан Авдеев

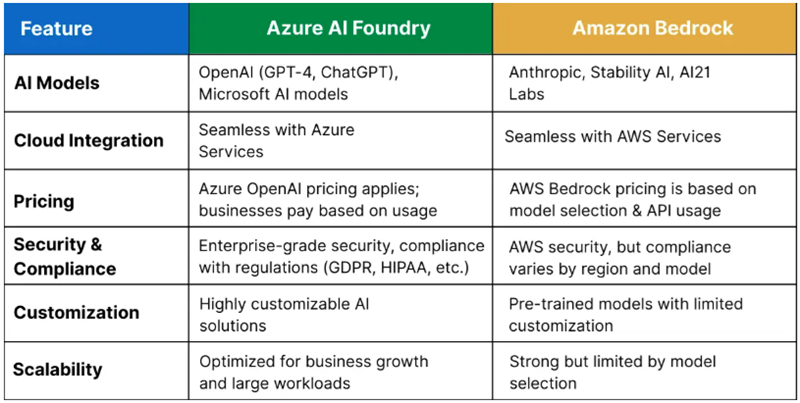

Microsoft закрепляет лидерство в сфере ИИ, предлагая клиентам почти 2 тыс. моделей, в том числе от конкурентовКомпания Microsoft сделала серьёзную заявку на мировое лидерство в сфере искусственного интеллекта, в своё время инвестировав $13 млрд в стартап OpenAI. Позже компания использовала GPT-модели OpenAI в качестве основы для собственного бота Copilot AI, интегрировав его во многие свои продукты, а теперь вышла на новый уровень, сообщает Computer World. Компания запустила хостинг LLM и ИИ-сервисов крупнейших в мире ИИ-компаний и стартапов, включая собственных конкурентов — всего более 1900 моделей, от Llama AI (Meta✴) до разработок xAI и европейских стартапов Mistral и Black Forest Labs, а также китайского DeepSeek и др. Другими словами, даже если Copilot не оправдает ожиданий Microsoft в полной мере, она в какой-то степени разделит и успехи своих конкурентов и, вероятно, останется крупнейшей в мире ИИ-компанией. ЦОД Microsoft стали залогом её успеха на рынке искусственного интеллекта. Благодаря сделке с OpenAI сама Microsoft получает отчисления от каждого подписчика OpenAI. Для монетизации ИИ-решений в 2023 году Microsoft запустила сервис Azure OpenAI, позволяющий клиентам Azure создавать приложения с использованием моделей OpenAI. По некоторым данным, в сервисе зарегистрировано около 60 тыс. клиентов.

Источник изображения: Craig Sybert/unsplash.com Бизнес компании растёт и благодаря договорённостями с другими ИИ-разработчиками. В середине мая Microsoft объявила о размещении моделей Grok в сервисе Azure AI Foundry. Кроме того, в облаке Microsoft размещены и другие популярные модели. Таким образом, Microsoft получает больше денег даже в том случае, когда конкуренты добиваются новых успехов. Недавно компания подробно рассказала о видении того, каким образом компании смогут создавать ИИ-агентов для выполнения широкого спектра задач. В центре внимания — Azure AI Foundry, позволяющий клиентам создавать ИИ-агентов, использую любую из почти 2 тыс. моделей и объединяя их возможности, в том числе, например, для работы на GutHub. Другими словами, заказчикам не придётся подписываться на использование моделей у каждой из компаний по отдельности.

Источник изображения: Q Service Хотя крупнейшим облачным оператором в мире является Amazon (AWS), Microsoft постепенно сокращает разрыв, а подобные площадки для работы с разными ИИ-моделями обеспечивают ей большую фору. Amazon с аналогом Azure AI Foundry — Amazon Bedrock пыталась повторить нечто подобное, но ИИ-моделей у неё гораздо меньше. Высока вероятность, что в этой схватке первенство останется за Microsoft. По расчётам экспертов Q Services, предложение Bedrock лучше подходит разве что для стартапов и компаний, занимающихся разработкой, а Microsoft доминирует на более широком рынке, в том числе сотрудничая с крупными корпорациями. Большое преимущество компании — в использовании всех продуктов, от Microsoft 365 до Azure для продажи существующим клиентам сервисов Azure AI Foundry. У Amazon такая уникальная возможность отсутствует.

30.05.2025 [09:00], Сергей Карасёв

«Базис» признан «Национальным чемпионом»Разработчик инфраструктурного ПО «Базис» попал в Топ-10 самых быстрорастущих технологических компаний и признан «Национальным чемпионом» в рамках проекта «ТЕХУСПЕХ», организованного газетой «Ведомости», Высшей школой бизнеса НИУ ВШЭ совместно с компанией «Иннопрактика» и Российской венчурной компанией (РВК). Для участия в проекте компании должны соответствовать следующим критериям: возраст — свыше четырёх лет, выручка за отчётный период — от 120 млн до 50 млрд руб., а средний ежегодный прирост выручки с учётом масштаба предприятия — минимум от 12 % до 20 %. Также обязательным условием является выпуск хотя бы одного нового продукта на российский рынок за последние три года, разработанного самостоятельно либо путём приобретения прав на технологии, при условии, что расходы на инновационные проекты составляют минимум 10 % от общей выручки компании. На протяжении нескольких лет «Базис» показывает высокие темпы роста. В частности, выручка «Базиса» в 2023 году составила свыше 3 млрд руб., увеличившись на 80 % относительно показателя предыдущего года, а в 2024 году выросла ещё наполовину, достигнув отметки более 4,5 млрд руб. Кроме того, компания разработала первый импортонезависимый продукт для построения программно-определяемых сетей Basis SDN, презентация которого состоялась 28 мая. Заявки, представленные участниками, проходят экспертизу специальной комиссией, включающей профессиональных экспертов, которые оценивают технологический уровень продуктов, степень их инновационности и экспортный потенциал. После этого Наблюдательный совет принимает решение об утверждении финального списка рейтинга. Благодаря попаданию в Топ-10 «Базис» принят в Ассоциацию быстрорастущих технологических компаний «Национальные чемпионы». Организация ставит перед собой цель координировать работу своих членов, представлять и защищать общие интересы, включая разработку новых форм поддержки и подготовку рекомендаций по совершенствованию текущего законодательства. Сегодня участниками проекта являются 105 компаний из разных отраслей промышленности.

29.05.2025 [23:00], Владимир Мироненко

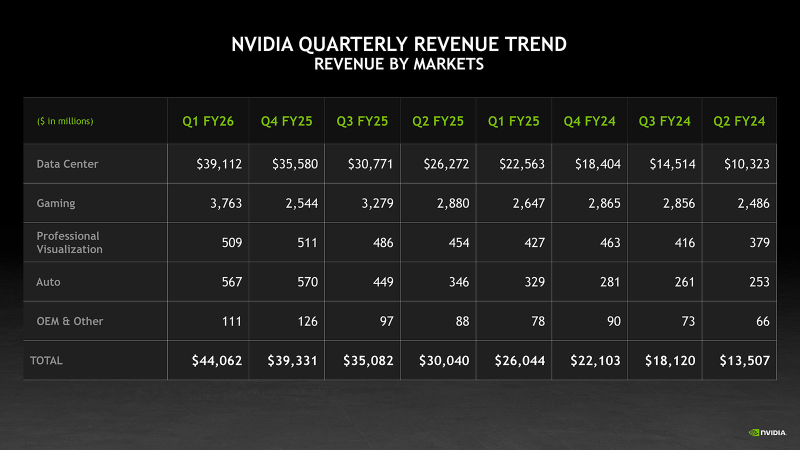

NVIDIA значительно увеличила выручку и прибыль, несмотря на потери из-за санкций СШАNVIDIA опубликовала отчёт о финансовых результатах за I квартал 2026 финансового года, завершившийся 27 апреля 2025 года. Несмотря на ужесточение экспортных ограничений США на поставки чипов в Китай, крупнейший рынок для NVIDIA, компания сообщила о рекордной выручке, превысившей ожидания Уолл-стрит, драйвером которой стали продажи в сегменте решений для ЦОД. Выручка NVIDIA за I финансовый квартал составила $44,06 млрд, что на 12 % больше, чем в предыдущем квартале и на 69 % больше год к году. Показатель оказался выше консенсус-прогноза аналитиков, опрошенных LSEG, равного $43,31 млрд. Чистая прибыль (GAAP) компании выросла на 26 % с $14,88 млрд или $0,60 на разводнённую акцию годом раннее до $18,78 млрд или $0,76 на акцию. Скорректированная чистая прибыль (Non-GAAP) составила $19,89 млрд или $0,96 на разводнённую акцию, что выше консенсус-прогноза от LSEG в размере $0,93 на акцию. В сегменте решений для ЦОД выручка NVIDIA выросла на 73 % по сравнению с прошлым годом до $39,1 млрд, и теперь составляют 88 % от общего дохода компании. При этом решения для вычислений принесли компании на 76 % больше выручки, составившей $34,16 млрд, а выручка от продаж сетевого оборудование выросла за квартал на 56 % до $4,96 млрд. Компания сообщила, что на поставки для крупных облачных гиперскейлеров, таких как Microsoft, AWS и Meta✴, приходится чуть менее половины общего дохода от решений для ЦОД. Кроме того, $5 млрд продаж в подразделении были связаны с сетевыми продуктами InfiniBand, которые используются для формирования ИИ-кластеров. «Архитектура Blackwell обеспечила почти 70 % выручки в сегементе ЦОД-вычислений в квартале, переход с Hopper почти завершён, — сказала финансовый директор Колетт Кресс (Colette Kress). — В среднем, каждый из крупных гиперскейлеров развёртывает около 1000 стоек NVL72 или 72 тыс. ускорителей Blackwell в неделю и находится на пути к дальнейшему наращиванию в этом квартале». NVIDIA отметила, что из-за экспортных ограничений администрации Трампа на поставки H20 в Китай, она понесла расходы в размере $4,5 млрд в I квартале 2026 финансового года, связанные с избыточными запасами и закупочными обязательствами по H20, поскольку спрос на эти чипы снизился. Также было недополучено $2,5 млрд продаж — компании удалось поставить H20 примерно на $4,6 млрд из запланированных $7,1 млрд. По словам Колетт Кресс, если бы не было ограничений, валовая прибыль компании составила бы 71,3 % в отчётном квартале, а не 61 %. Сумма потерь оказалась ниже ожидавшихся $5,5 млрд, поскольку компании удалось сэкономить $1 млрд, благодаря повторному использованию некоторых материалов. В интервью аналитику Бену Томпсону (Ben Thompson) гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) сказал, что этот шаг был «крайне болезненным» и может привести к потере $15 млрд дохода. «Ни одна компания в истории не списывала столько запасов, — отметил Хуанг. — Мы потеряли продажи на $15 млрд, а казна, вероятно, потеряла налоги на сумму $3 млрд (потерянных для казны)». Также из этих ограничений NVIDIA недополучит в текущем квартале порядка $8 млрд. Гендиректор NVIDIA сообщил аналитикам, что рынок ИИ-чипов в Китае объёмлм $50 млрд «фактически закрыт для промышленности США». Он добавил, что запрет на экспорт H20 положит конец бизнесу компании по выпуску Hopper для ЦОД в Китае. Китайский рынок принёс компании меньшую долю выручки, чем в предыдущие два квартала — 12,5 % в I квартале по сравнению с примерно 14 % и 15 % в предыдущие два квартала соответственно.

Источник изображения: NVIDIA «Китайский ИИ движется вперёд, с американскими чипами или без них. У него есть вычислительные мощности для обучения и развёртывания передовых моделей. Вопрос не в том, будет ли у Китая ИИ — он уже есть. Вопрос в том, будет ли один из крупнейших в мире ИИ-рынков работать на американских платформах», — поясняет Хуанг. «Ограждение китайских производителей чипов от конкуренции со стороны США только усиливает их за рубежом и ослабляет позиции Америки», — отметил глава NVIDIA. Но NVIDIA явно не собирается отказываться от китайского рынка. Хуанг сказал, что компания «посмотрит, сможем ли мы предложить интересные продукты, которые могли бы продолжать обслуживать китайский рынок», но добавил: «на данный момент у нас ничего нет». Ожидается, что для КНР будет выпущен ускоритель B40. Другие подразделения NVIDIA тоже продемонстрировали рост в отчётном квартале. Игровое подразделение компании, которое включает чипы для 3D-игр, увеличило выручку на 42 % в годовом исчислении до $3,8 млрд. Автомобильное и робототехническое подразделение компании сообщило о росте продаж год к году на 72 % до $567 млн. В сегменте профессиональной визуализации продажи выросли на 19 % до $509 млн.

Источник изображения: NVIDIA Во II квартале финансового года 2026 года NVIDIA ожидает получить выручку в размере $45 млрд, что ниже прогноза Уолл-стрит в размере $45,9 млрд. Дженсен Хуанг указал в своем заявлении на невероятно высокий глобальный спрос на ИИ-инфраструктуру NVIDIA. «Страны по всему миру признают ИИ как важную инфраструктуру — так же, как электричество и интернет — и NVIDIA находится в центре этой глубокой трансформации», — подчеркнул он.

29.05.2025 [21:06], Андрей Крупин

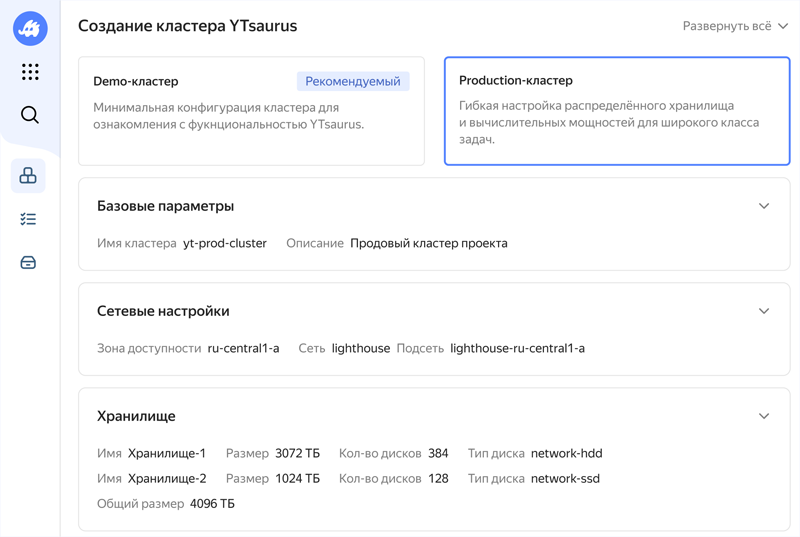

Yandex B2B Tech запустила YTsaurus — платформу обработки данных любого объёма для бизнесаYandex B2B Tech (бизнес-группа «Яндекса», объединяющая технологии и инструменты компании для корпоративных пользователей, включая продукты Yandex Cloud и «Яндекс 360») открыла доступ к платформе собственной разработки для хранения и обработки больших данных YTsaurus. YTsaurus поставляется как управляемое решение в Yandex Cloud, а также on-premises с поддержкой от разработчиков. Платформа обеспечивает хранение, обработку, аналитику данных и машинное обучение в едином окружении: файловая система, динамические таблицы и аналитические инструменты объединены для полного цикла работы с большими данными. Система поддерживает миллионы CPU и тысячи GPU в рамках единого кластера и десятки тысяч вычислительных узлов. Встроенный HDRF‑планировщик распределяет и балансирует вычислительные ресурсы между задачами пользователей.

Источник изображения: yandex.cloud YTsaurus можно использовать как классическую MapReduce-систему, так и применять внутри платформы другие востребованные в профессиональной среде решения для обработки данных, в том числе ClickHouse и Apache Spark. C её помощью можно строить корпоративные хранилища данных, ETL-системы, обрабатывать как структурированные, так и неструктурированные или полуструктурированные данные, в том числе логи или финансовые транзакции. В «Яндексе» YTsaurus разрабатывают с 2010 года — сейчас её используют для хранения данных большинства сервисов, обучения YandexGPT и других нейросетей, задач поискового индекса. Ранее платформа была доступна как open source-проект — её уже применяют большие технологические компании в России и за рубежом. |

|