Лента новостей

|

20.07.2022 [00:56], Владимир Мироненко

Из-за жары лондонские дата-центры вынуждены охлаждать оборудование на крыше, поливая его водой из шланговВ этом году в Великобритании наблюдается аномальная жара. 19 июля температура воздуха в стране установила новый рекорд, превысив 40° С. Как сообщает Bloomberg, в некоторых британских ЦОД выбрали оригинальный способ борьбы с перегревом оборудования, используя обрызгивание водой внешних модулей систем кондиционирования, установленных на крыше. По словам Адриана Тревельяна (Adrian Trevelyan), директора по послепродажному обслуживанию компании Airedale International, которая поставляет и обслуживает системы охлаждения для ЦОД, многие лондонские дата-центры вынуждены прибегнуть к такому необычному способу охлаждения. Небольшие ЦОД в густонаселённых городских районах, работающие почти на полную мощность, просто требуют экстренного орошения во время жары. Тревельян сообщил, что орошение позволяет снизить температуру воздуха вокруг змеевиков внешнего контура охлаждения, чтобы они продолжали эффективно рассеивать тепло. Он отказался назвать конкретные компании, применяющие такой способ охлаждения, но сказал, что это делают «в пределах (кольцевой автомагистрали) M25 и в городе». Однако от жары страдают не только малые, но и крупные дата-центры, которые всё же имеют запас по охлаждению ключевых подсистем — 10 июля в лондонском ЦОД AWS произошёл перебой питания из-за так называемого «теплового события» (thermal event). Использование полива шлангами может выручить в очень жаркий день, но негативно отразится на сроке службы оборудования, сообщила София Флюкер (Sophia Flucker), директор консалтинговой фирмы Operational Intelligence, отметив, что если используется вода повышенной жёсткости (как в Лондоне), это может привести к накоплению накипи. Флюкер также рассказала, что многие операторы колокации, сдающие мощности в аренду третьим лицам, сталкиваются со штрафами за несоблюдение температурного режима в машинных залах.

13.07.2022 [16:13], Алексей Степин

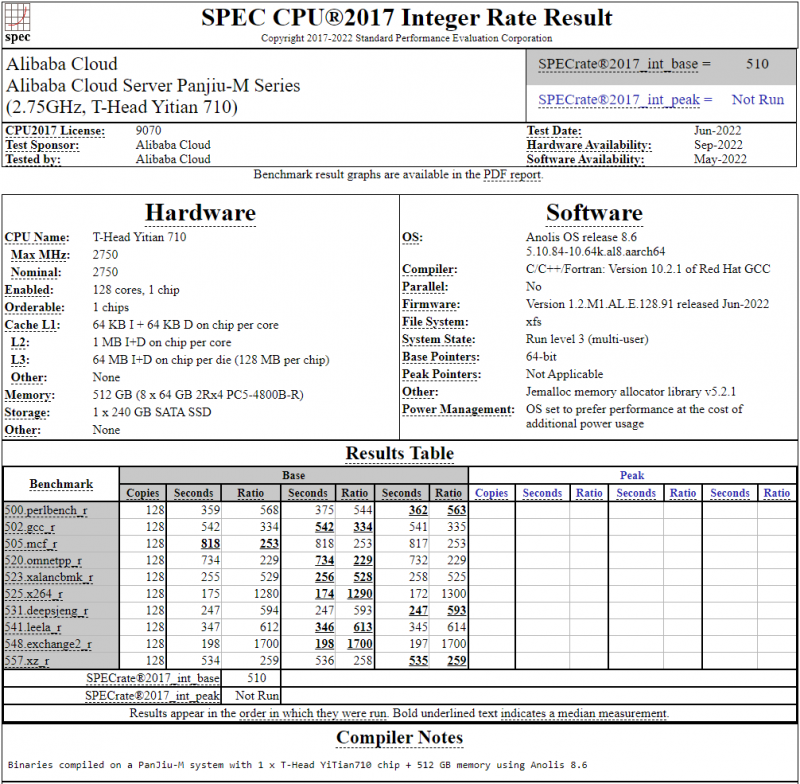

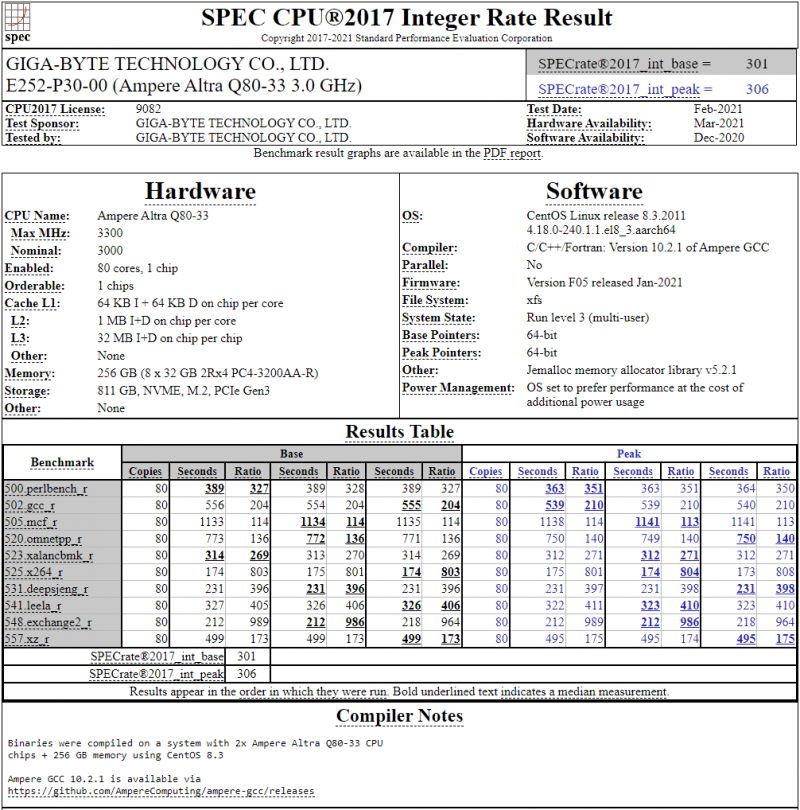

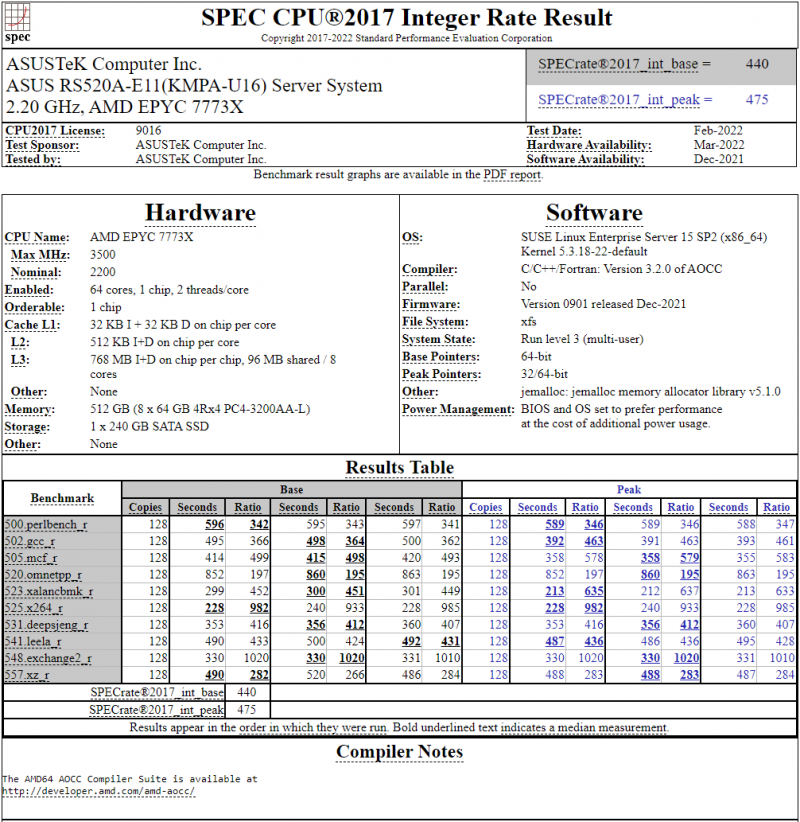

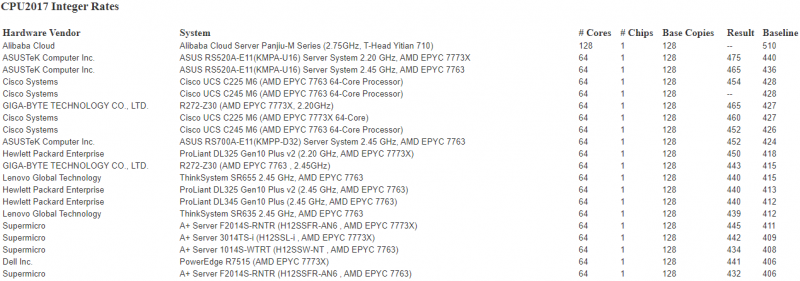

128-ядерный Arm-процессор Alibaba T-Head Yitian 710 показал отличные результаты в SPEC CPU2017Не секрет, что китайские гиганты, такие, как Huawei и Alibaba Cloud, разрабатывают собственные серверные процессоры на базе архитектуры Arm. Однако информации об этих чипах, как правило, не очень много и пользоваться общепринятыми на западе тестами и рейтингами разработчики не спешат, что, к слову, характерно и для китайских суперкомпьютеров. Alibaba Cloud представила чип Yitian 710 ещё осенью прошлого года. Этот процессор построен на базе архитектуры Armv9 и максимально может иметь 128 ядер с частотой до 3,2 ГГц. Однако результаты проверки чипа в популярном тесте SPEC CPU2017 были опубликованы только сейчас. Процессор тестировался в составе референс-сервера Panjiu. Применялась 128-ядерная версия с частотой 2,75 ГГц, 1 Мбайт кеша L2 на ядро и 64 Мбайт кеша L3 на кристалл (128 Мбайт на сборку). Последнее позволяет говорить о том, что Alibaba также использует в своих процессорах чиплетную компоновку. Результаты оказались существенно более высокими, нежели у Ampere Altra Q80-33; правда, стоит сделать скидку на то, что у Ampere использовалась 80-ядерная версия, а не более новая 128-ядерая Altra Max. Но в аутсайдерах оказался также и AMD EPYC 7773X (64 ядер/128 потоков, 2,2-3,5 ГГц, 768 Мбайт L3), показавший 440 очков против 510 у Yitian 710. Увеличенный объём кеша не слишком помог детищу «красных». Таким образом, процессор на базе архитектуры Armv9 занял первое место там, где традиционно господствовали решения с архитектурой x86 — достаточно взглянуть на Топ-20 в рейтинге CPU2017 Integer. Можно сказать, что 128-ядерный процессор не вполне корректно сравнивать с 64-ядерным с поддержкой SMT, однако если технологии и архитектура позволяют разместить вдвое больше полноценных ядер в сопоставимом по размеру с AMD EPYC корпусе, так ли это важно? К сожалению, пока речь идёт только о целочисленных вычислениях. По неизвестной причине, Alibaba Cloud не опубликовала результаты CPU2017 Floating Point, где сравнение вышло бы существенно интереснее. В любом случае, монополия AMD на первые места пошатнулась; что же касается Intel, то в классе однопроцессорных систем самым мощным вариантом является 36-ядерный Xeon Platinum 8351N, который заведомо проиграет 64-128 ядерным монстрам AMD, Ampere, а теперь уже и Alibaba Cloud.

13.07.2022 [13:55], Алексей Степин

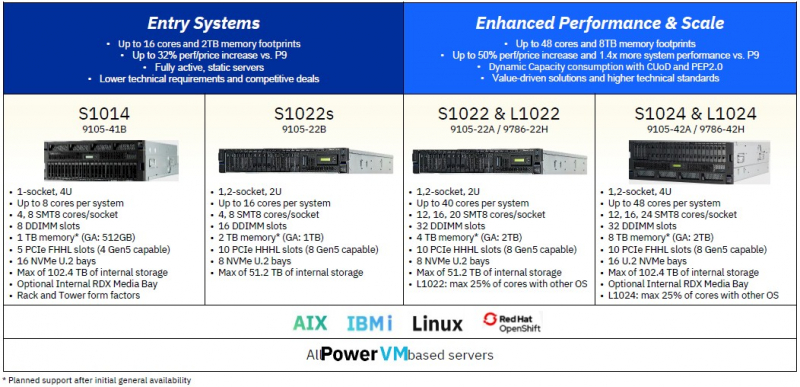

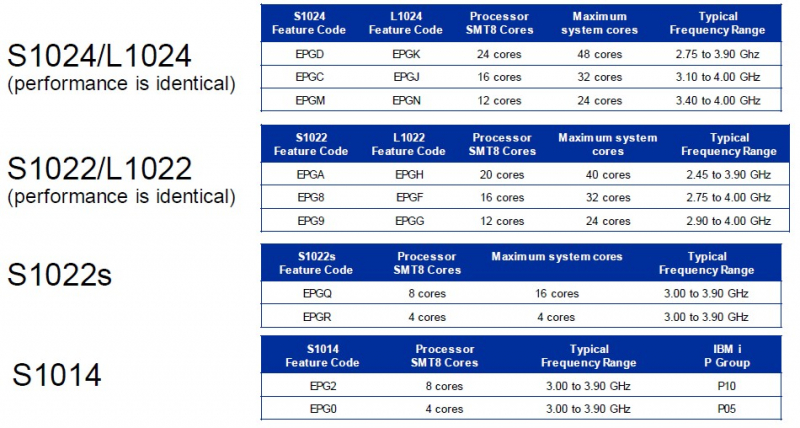

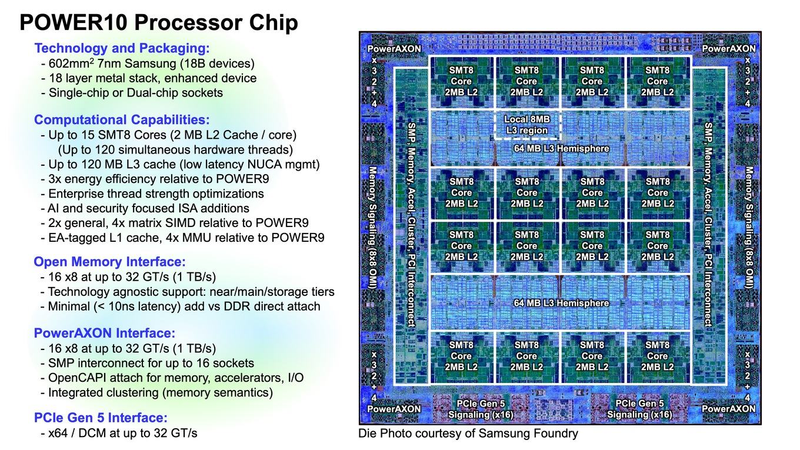

IBM представила новые POWER10-серверы начального и среднего уровняНесмотря на то, что дела у архитектуры POWER идут не слишком хорошо, IBM всё же продолжает выпускать новые системы на её базе. Информация о том, что компания планирует выпуск относительно недорогих серверов на базе 7-нм процессоров POWER10, появилась ещё весной, и теперь эти сведения подтверждаются. Пока речь идёт о четырёх моделях: однопроцессорном S1014, одно- и двухпроцессорном S1022s, а также решениях среднего уровня S1022/L1022 и S1024/L1024. Первая модель получит лишь один процессор с числом ядер не более 8, зато будет иметь 16 отсеков NVMe и 5 слотов PCIe, 4 из которых поддерживают PCIe 5.0. Интересно, что процессоры могут быть как в варианте SMT4, так и SMT8 — ни Arm, ни x86 пока не могут предложить ничего похожего. Максимальный объём памяти 1 Тбайт, дискового пространства — 102,4 Тбайт. Новинка будет поставляться как в стандартном стоечном исполнении 4U, так и в башенном, всё еще востребованном в тех случаях, когда это единственный сервер малого предприятия. S1022s — классический 2U-сервер с двумя процессорными разъёмами, в каждом из которых может быть установлен POWER10 с 8 ядрами в варианте SMT4 или SMT8; в последнем случае это даёт 64 потока. Памяти здесь вдвое больше, 2 Тбайт, а вот дискового пространства в силу форм-фактора меньше, лишь 51,2 Тбайт. Зато слотов PCIe целых 10, хотя и ограниченных форматом HHHL. S1022 — аналог S1022s, который может комплектоваться 12, 16 и 20-ядерными процессорами, что в максимальной конфигурации даёт 320 потоков, чего пока сложно добиться даже системам на базе AMD EPYC. Наконец, S1024/L1024 — это S1022 «на стероидах». Форм-фактор 4U позволяет разместить во флагманской модели систему охлаждения для пары 24-ядерных POWER10 c SMT8, до 8 Тбайт памяти, 16 дисков U.2 с интерфейсом NVMe, а также до десяти плат расширения PCIe формата FHHL. Во всех моделях используется интерфейс памяти OpenCAPI/OMI с пропускной способностью 409 Гбайт/с на процессор и поддержкой модулей объёмом 256 Гбайт и более. Новинки будут на 20-25% дороже аналогичных систем на базе POWER9, но IBM обещает 70-% прирост производительности, который должен это компенсировать.

Основные параметры POWER10. Источник: IBM Все новые серверы IBM на базе POWER10 смогут работать под управлением ОС Linux, IBM i и AIX, они также совместимы с платформой контейнеризации Red Hat Open Shift. Нельзя сказать, что пользовательская база у таких серверов велика, но благодаря поддержке AIX и IBM i она полностью лояльна Голубому Гиганту, поскольку под их управлением нередко работает критически важное ПО. Зарубежные источники полагают, что POWER10 может оказаться с нами надолго, т.е. минимум до 2025 года, даже если IBM продолжит разработку POWER11 и задумывается о POWER12.

12.07.2022 [00:28], Игорь Осколков

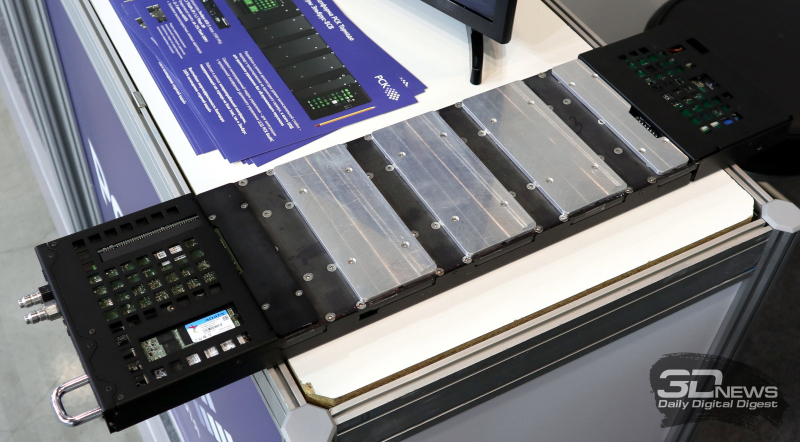

Суперкомпьютер в дорогу: РСК показала на Иннопроме обновлённый мобильный ЦОДГруппа компаний РСК, ведущий российский разработчик суперкомпьютеров и систем для высокопроизводительных вычислений (HPC), дата-центров, облачных платформ и систем хранения данных (СХД) показала на выставке Иннопром-2022 обновлённую версию своей платформы для автономных периферийных вычислений, которая позволяет оперативно, в течение часа силами двух человек, развернуть HPC-кластер практически в любом месте. Решение упаковано в несколько контейнеров (0,7 × 0,7 × 1,1 м), которые можно транспортировать независимо друг от друга и собирать уже на месте. Один контейнер вмещает собственно вычислительную часть, второй — полностью интегрированный модуль распределения теплоносителя с узлом управления, а третий, опциональный — ИБП с инвертором. Дополняет их компактный внешний модуль охлаждения. Вся система имеет весьма солидный запас по возможности отвода тепла — до 60 кВт. Правда, сейчас столько и не требуется. Вычислительный блок фактически является уменьшенной копией платформы «РСК Торнадо»: 2 колонны по 10 слотов. Поэтому мобильная платформа позволяет совмещать в одной системе серверы «Торнадо» с процессорами x86-64 (AMD EPYC и Intel Xeon) и «Эльбрус» (сейчас 8С/8СВ, в перспективе 16С) с любым уровнем TDP, GPGPU-серверы (по два PCIe-ускорителя на сервер, без ограничений по TDP) и серверы хранения (до 12 × M.2 All-Flash). В текущем варианте платформы каждый слот рассчитан на 2 кВт тепловой нагрузки (и столько же по питанию), хотя нынешние серверы укладываются в среднем в 700–800 Вт, а серверы следующего поколения потребуют чуть больше 1 кВт. Подсистема питания имеет два домена, по одному на колонну, и требует однофазный ввод AC 230 В/50 Гц, хотя фактически может работать в диапазоне 105–280 В. Запитать систему можно от генератора, а подстраховать — ИБП. Но возможно и специсполнение с поддержкой 48 В DC. Сетевая подсистема может быть представлена ToR-коммутаторами как двойной (на обе колонны) ширины, так и одиночной. В том числе есть варианты с жидкостным охлаждением. Доступен даже InfiniBand — у Mellanox есть коммутаторы в подходящем форм-факторе, рассчитанные на промышленное применение. Также предоставляется 1 GbE-коммутатор для развёртывания служебной сети. Самая интересная часть — это охлаждение. Как и в «большой» версии платформы здесь используется фирменная СЖО, которая покрывает все компоненты серверов, так что вычислительная часть не требует активного воздушного охлаждения и способна работать даже с закрытыми крышками контейнера. Защиты по какому-либо классу IP в стандартном варианте не предусмотрено, но опять-таки по заказу возможно специсполнение. СЖО всё так же поддерживает охлаждение горячей водой, причём на всех компонентах температура не превышает +45 °C. Для запуска вычислительного модуля необходимо, чтобы он находился в помещении с плюсовой температурой и чтобы не было образования конденсата. А вот внешний контур охлаждения менее прихотлив и способен работать при температурах от -65 °C. Верхний же предел — не менее +40 °C. Требования по питанию у него те же, что и у серверов. Узел управления автоматически отслеживает и регулирует параметры всех компонентов системы во время запуска и работы. По умолчанию используется сценарий защиты оборудования, так что при неблагоприятных условиях серверы могут выключаться. Но возможны и другие сценарии, например, «работа до последнего», когда потеря данных оказывается дороже потери оборудования. Управляется мобильная платформа фирменной системой оркестрации «РСК БазИС», которая позволяет задействовать все возможности компонуемой, программно определяемой инфраструктуры, в том числе для реализации HCI-платформы. «РСК БазИС» предлагает GUI, CLI, открытые API и SDK для интеграции с другими приложениями. Таким образом, заказчик получает полностью интегрированное программно-аппаратное решение, готовое к быстрому развёртыванию и использованию. Изначально платформа создавалась для нужд добывающего сектора, но этой сферой её возможности не ограничиваются. Она также подходит для научных экспедиций и промышленных предприятий (срочная обработка больших массивов данных), медиасферы и обслуживания массовых мероприятий (рендеринг, стриминг с множества камер) и т.д. В общем, везде, где на время требуется действительно мощная, но компактная и удобная в доставке, развёртывании и эксплуатации вычислительная платформа.

04.07.2022 [22:18], Алексей Степин

Intel разработала фотонный техпроцесс с интегрированным мультиволновым массивом лазеровФотоника сулит немалые преимущества, и особенно ярко они проявятся в случае достижения высокой степени интеграции — если внешний источник лазерного излучения может существенно усложнить систему и сделать её более дорогой, то интегрированный на кремниевую пластину, напротив, многое упрощает. Неудивительно, что разработчики, бьющиеся над созданием гибридных фотонных чипов, нацелены именно на такой вариант. Ранее мы рассказывали о варианте Synopsys и Juniper Networks, которые также планируют использовать интегрированные лазеры в рамках возможностей техпроцесса PH18DA компании Tower Semiconductor, а сейчас успеха добилась корпорация Intel.

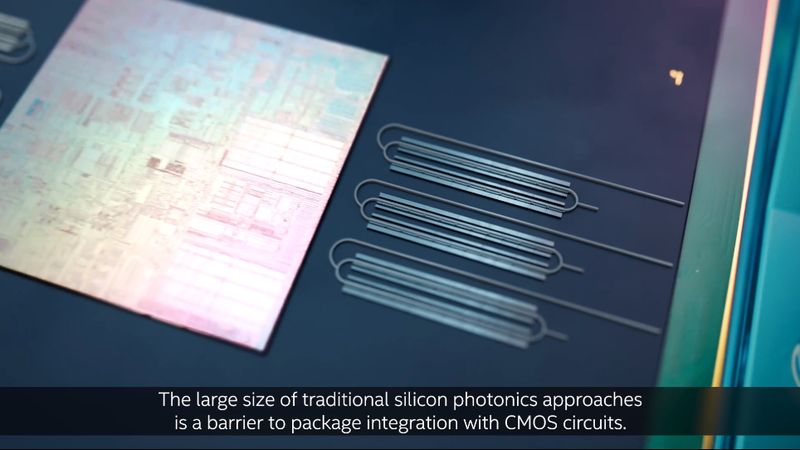

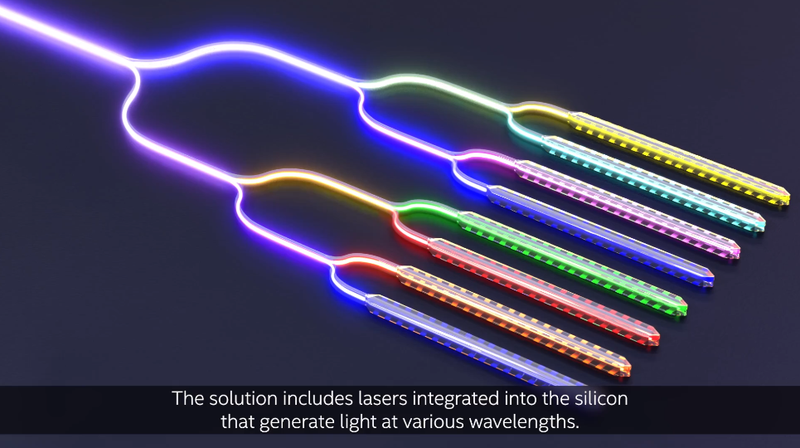

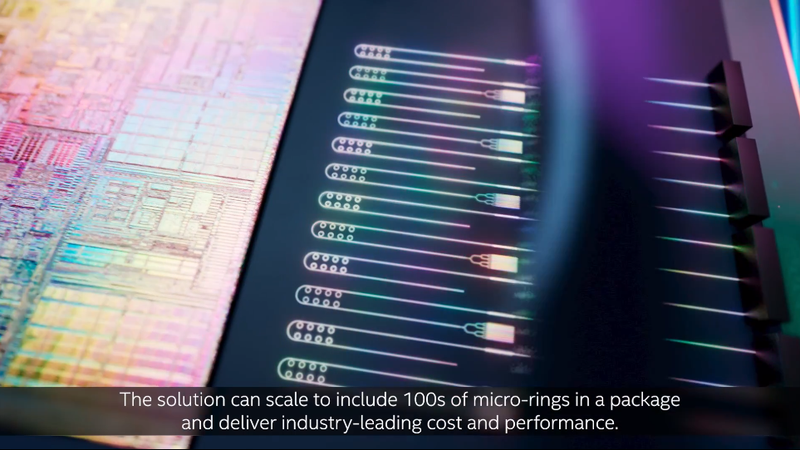

Традиционные оптические модуляторы достаточно громоздки. Источник: Intel Labs Научно-исследовательское подразделение компании, Intel Labs, сообщает, что на базе «существующего кремниевого-фотонного техпроцесса для пластин диаметром 300 мм» удалось создать интегрированный лазерный массив, работающий с восемью длинами волн. Это хорошо отработанная технология, на её основе Intel уже производит оптические трансиверы, что открывает дорогу к достаточно быстрому началу производству фотонных чипов со встроенными лазерными массивами.

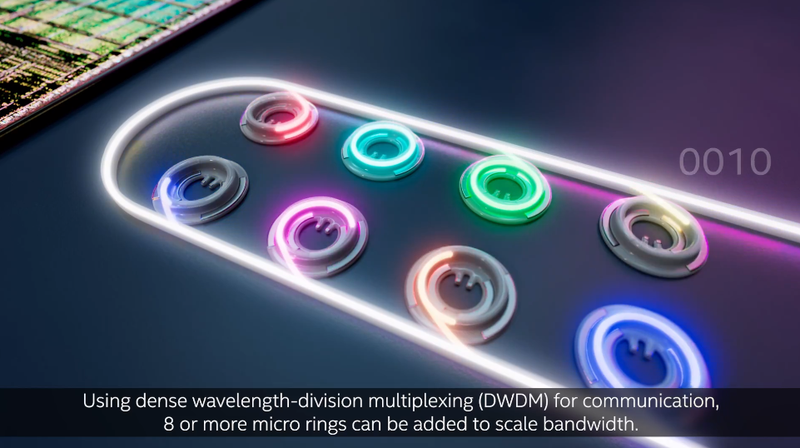

Вариант Intel использует компактные кольцевые микромодуляторы. Источник: Intel Labs В технологии используются лазерные диоды с распределённой схемой обратной связи (distributed feedback, DFB), которая позволяет добиться высокой точности как в мощности излучения в пределах 0,25 дБ, так и в спектральных характеристиках, где отклонения в границах используемых спектров не превышают 6,5%. Достигнутые параметры превышают аналогичные показатели классических полупроводниковых лазеров. Компания также отмечает, что применённая ей новая технология кольцевых микромодуляторов, отвечающих за конверсию электрического сигнала в оптический, существенно компактнее более традиционных решений других разработчиков. Такой подход позволяет поднять удельную плотность фотонных линий передачи данных, то есть, при прочих равных условиях, чип, оснащённый интерконнектом Intel, будет иметь более «широкую» оптическую шину с более высокой пропускной способностью.

В технологии используется массив из 8 лазеров. Источник: Intel Labs Технология гибридной фотоники со встроенными лазерами, использующая мультиплексирование с разделением по длине волны (dense wavelength division multiplexing, DWDM), делает высокоскоростной оптический интерконнект возможным, но до успеха Intel данная технология упиралась именно в точность разделения спектра и в достаточно высокое энергопотребление источников излучения. В настоящее время уже ведутся работы по созданию специального чиплета, который позволит вывести оптический интерконнект за пределы кремниевой пластины, а это в перспективе даст возможность как для фотонного соединения между центральным процессором и памятью или GPU, так и для реализации будущих ещё более скоростных версий стандарта PCI Express или его наследника.

Дорога к высокоскоростному оптическому интерконнекту открыта! Источник: Intel Labs Ayar Labs, один из пионеров в освоении гибридных электронно-оптических технологий однако считает, что у подхода Intel есть и недостатки. Сам по себе оптический интерконнект, конечно, может быть производительнее классического, и к тому же он не подвержен помехам. Однако лазерные диоды по природе своей достаточно капризны, а глубокая интеграция источника излучения в чип при выходе хотя бы одного лазера из строя делает всю схему бесполезной. В своих решениях Ayar Labs полагается на внешний лазерный модуль SuperNova.

21.06.2022 [14:32], Алексей Степин

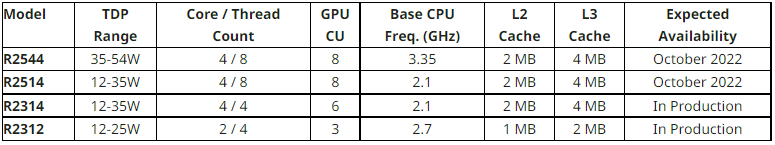

AMD представила индустриальные процессоры Ryzen Embedded R2000: до четырёх ядер Zen+Семейство процессоров AMD Ryzen Embedded довольно консервативно: серия R1000 была представлена еще в 2019 году и включала в себя лишь двухъядерные модели на базе архитектуры Zen первого поколения, а представленные в 2020 году чипы V2000 предлагали до восьми ядер Zen2. Сегодня Advanced Micro Devices объявила о выпуске новых процессоров R2000 с теплопакетом от 12 до 54 Вт и чуть более современной (по сравнению с R1000) архитектурой Zen+. Эти максимально экономичные процессоры предназначены для индустриального применения, в том числе в системах машинного зрения, IoT, тонких клиентах, видеостенах, киосках и тому подобном оборудовании. В серию вошли модели R2544, R2514, R2314 и R2312.

Источник: AMD В сравнении с R1000 производительность новинок выросла на 81%, и неудивительно — количество процессорных ядер возросло с двух до четырёх. Соответственно, с 1 до 2 Мбайт увеличился объём кеша L2, а также появилась поддержка памяти DDR4-3200 (два канала). Нового в Ryzen Embedded R2000 немного, за исключением более совершенной архитектуры ядер, но в количественном отношении новые процессоры во всём лучше старых: больше ядер, вдвое более производительная подсистема памяти, возросшее с 8 до 16 количество линий PCI Express 3.0. Также доступно до двух портов SATA-3 и до шести портов USB (3.2 Gen2 и 2.0).

Текущий модельный ряд AMD Ryzen Embedded. Источник: AMD С трёх до четырёх возросло и количество подключаемых дисплеев с поддержкой разрешения 4К, хотя поддержка HDMI по-прежнему ограничена версией 2.0b. Но есть и DisplayPort 1.4 с eDP 1.3. Можно отметить наличие встроенного сопроцессора безопасности AMD Secure Processor, позволяющего шифровать содержимое оперативной памяти на лету. Поскольку новая серия относится к промышленной, срок сопровождения составляет 10 лет. В число поддерживаемых ОС вошли Windows 10/11 и Ubuntu LTS. В число партнёров AMD, которые представили или собираются представить свои решения на базе Ryzen Embedded R2000, входят компании Advantech, DFI, IBASE и Sapphire Technology. Среди анонсированных продуктов есть платформы для игровых автоматов, цифровые киоски, промышленные системные платы, платформы SD-WAN и многое другое.

20.06.2022 [23:39], Игорь Осколков

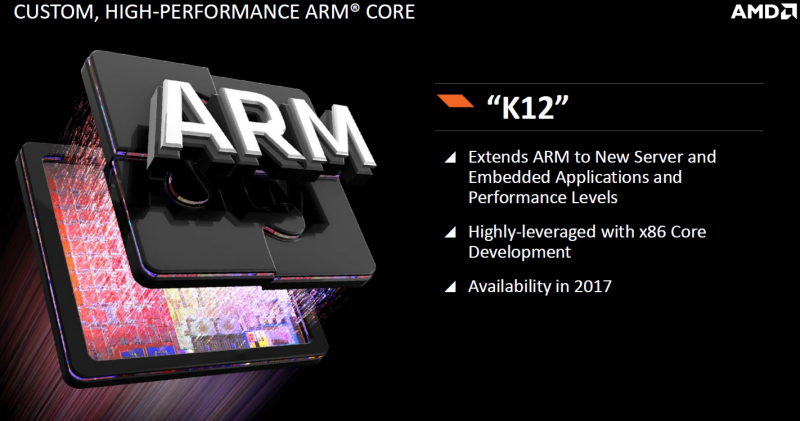

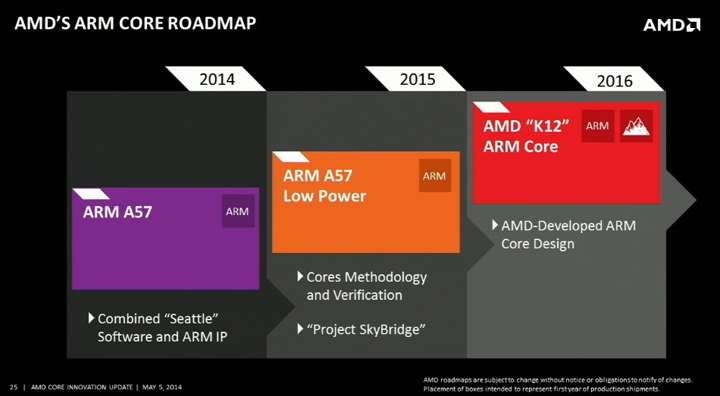

Джим Келлер назвал глупостью отказ AMD от развития серверных Arm-процессоровМы уже рассказывали краткую историю развития серверных Arm-процессоров в обзоре Ampere Altra. Среди неудачных проектов был и AMD Opteron A1100 (Seattle), выход которого задержался на два года. Но вместе с анонсом этого CPU компания AMD озвучила планы по дальнейшему развитию Arm-решений, которые включали Project SkyBridge (ARM Cortex-A57) и K12 (кастомная реализация ARMv8-A). Над последним параллельно с разработкой x86-ядер Zen трудился Джим Келлер (Jim Keller).

Изображения: AMD В своём майском докладе на конференции Future of Compute Келлер сообщил, что во время планирования Zen 3 он и другие инженеры обратили внимание на значительное сходство в реализации архитектур x86 и Arm, поскольку «внутри все современные компьютеры на самом деле являются RISC-машинами». По словам Келлера, отличия по большому счёту кроятся в декодерах инструкций, так что он с командой постарался сделать решение, которое могло бы работать с обоими архитектурами. «Они [AMD] по глупости отменили этот проект» — приводит слова Келлера The Register. Сам Келлер в своё время назвал работу над Zen более приоритетной, но после его ухода из AMD в 2016 году компания полностью забросила K12. K12 должен был стать процессором, ориентированным на энергоэффективность и способным работать на высоких частотах. Он был предназначен для высокоплотных систем, а также для встраиваемых решений и заказных чипов. В конце концов, AMD добьётся этого с помощью, например, Zen 4c (EPYC Bergamo), но к этому моменту появится очередное поколение Arm-чипов Ampere Computuing, CPU которой уже доступны в облаках Oracle, Microsoft и других крупных игроков. А Amazon с Alibaba и вовсе пошли по пути создания собственных Arm-процессоров. Впрочем, и без подобных чипов сейчас дела на серверном рынке у AMD идут прекрасно.

20.06.2022 [13:27], Владимир Мироненко

TikTok, наконец, перенёс данные пользователей из США в облако Oracle, но резервные копии по-прежнему хранит у себя

bytedance

oracle

oracle cloud infrastructure

software

tiktok

информационная безопасность

конфиденциальность

облако

сша

Видеосервис TikTok сообщил в конце прошлой недели, что в рамках т.н. Project Texas «изменил место хранения пользовательских данных в США по умолчанию» на платформу Oracle и что «100% пользовательского трафика в США направляется в Oracle Cloud Infrastructure» после длившихся более года переговоров двух компаний. Решение направлено на устранение опасений властей США по поводу того, что связи социальной сети с Китаем могут представлять угрозу для национальной безопасности страны. Объявление о переносе данных совпало (и вряд ли случайно) с публикацией итогов расследования ресурса BuzzFeed, которое показало, что сотрудники TikTok в Китае на постоянной основе получали доступ к персональным данным пользователей TikTok в США как минимум в период с сентября 2021 года по январь 2022 года. После этого TikTok сообщил, что все личные данные пользователей из США, включая номера телефонов, даты рождения и черновики видео, теперь хранятся на серверах облака Oracle. Принадлежащий китайской компании ByteDance видеосервис также сообщил, что предложил Oracle заняться разработкой протоколов управления данными, которые помогут в защите конфиденциальной информации.

Источник изображения: Pixabay По словам TikTok, резервные копии пользовательских данных TikTok из США по-прежнему хранятся на собственных серверах TikTok в Виргинии и Сингапуре, но в конечном итоге они будут удалены в рамках продолжающегося перехода на платформу Oracle. Сроки запланированного удаления копий пока неизвестны. Однако BuzzFeed сообщает, что сотрудники ByteDance в Пекине по-прежнему будут иметь доступ к публичным данным пользователей из США, включая видео, комментарии и профили, что позволит им делать выводы об интересах американцев. Напомним, что в августе 2020 года власти США выступили с угрозой запретить TikTok в США, сославшись на опасения, что правительство Китая будет использовать данные, собранные TikTok, для слежки за гражданами США. К сентябрю ими был подготовлен контракт, в рамках которого компания ByteDance, материнская компания TikTok, должна была продать миноритарную долю в видеосервисе двум американским компаниям, Oracle и Walmart, при этом Oracle брала на себя хранение данных TikTok в США. В итоге сделка была заключена, но воспользовавшись приходом к власти нового президента, ByteDance выторговала себе возможность не продавать долю в TikTok, а лишь перевести данные на хранение в облаке Oracle. Для Oracle обслуживание более чем 100 млн пользователей TikTok в США является возможностью приблизиться к конкурентам Amazon и Microsoft, взявшим под свой контроль более половины рынка. При этом для самой ByteDance сотрудничество с Oracle, похоже, не является оптимальным вариантом. В прошлом году компания стала вторым по величине арендатором ЦОД в США (суммарно 92 МВт), хотя по сравнению с 2020 годом (134 МВт) объём арендованных мощностей снизился. Ранее компания отказалась от услуг Alibaba Cloud за пределами Китая, что заметно повлияло на выручку последней. А в конце прошлого года ByteDance взялась за развитие собственной облачной платформы Volcano Engine.

19.06.2022 [13:32], Алексей Степин

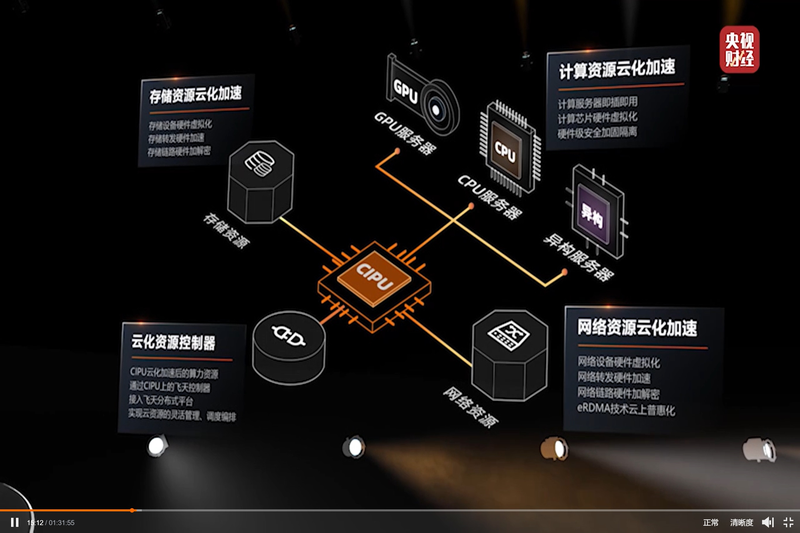

Alibaba Cloud представила свой вариант DPU — Cloud Infrastructure Processing Unit (CIPU)С учётом стремительно наступающей эры DPU/IPU не вызывает удивления, что такой китайский гигант, как Alibaba Cloud, представил своё видение «универсального сетевого сопроцессора», использовав схожий термин Cloud Infrastructure Processing Unit (CIPU). На ежегодном саммите компании Alibaba Cloud анонсировала новый чип, являющийся дальнейшим развитием идей, ранее воплощённых в умном сетевом адаптере X-Dragon, разрабатывавшемся как аналог AWS Nitro. Пока об архитектуре Alibaba CIPU известно не так много, но физически это обычная двухслотовая плата расширения с интерфейсом PCI Express.

Источник: @ogawa_tter Судя по имеющимся данным, в основе лежит четвёртое поколение архитектуры X-Dragon, обеспечившее 20% прирост производительности в сравнении с предыдущим поколением этих процессоров. Что более интересно, в основе новой итерации X-Dragon лежит дуэт технологий Elastic RDMA (eRDMA) и Shared Memory Communications over RDMA (SMC-R). Он позволяет новому ускорителю обращаться к памяти хост-системы напрямую на уровне ядра фирменных ОС Alibaba Cloud Linux 3 и Anolis OS. Для приложений, использующих TCP, всё выглядит прозрачно, но латентность при этом удалось понизить до 5 мкс.

Источник: @ogawa_tter Новые сопроцессоры полностью совместимы со стеком технологий RDMA over Converged Ethernet (RoCE), причём поддерживается даже iWARP, довольно редкий вариант, встречавшийся ранее в адаптерах Intel и Chelsio. Реализации iWARP могут быть сложнее RoCE, т.к. используют многослойную архитектуру и ряд твиков, а в итоге нередко показывают менее высокую производительность. Но благодаря поддержке обеих технологий новое решение Alibaba получилось поистине универсальным.

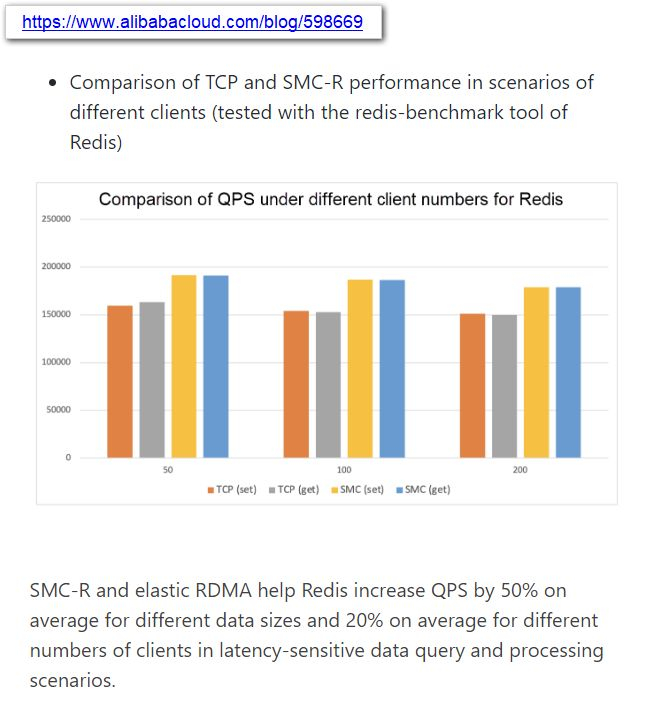

Источник: @ogawa_tter Результаты тестов весьма обнадёживают: в частности, для Redis ускорители CIPU за счёт SMC-R позволили поднять количество обрабатываемых запросов на 50%, а в сценариях с данными, чувствительными к латентности, прирост составил 20%. Исходя из опубликованных в японском блоге Tadashi Ogawa, это действительно полноценный IPU, могущий стать мостом между сетью, подсистемами хранения данных, CPU, GPU и прочими ускорителями. Компания активно развивает собственную аппаратную инфраструктуру и в прошлом году уже представила 128-ядерный 5-нм процессор Yitian 710 на базе набора инструкций Armv9 c 8 каналами DDR5, поддержкой PCIe 5.0 (96 линий) и при этом способный работать на частотах до 3,2 ГГц.

15.06.2022 [23:40], Алексей Степин

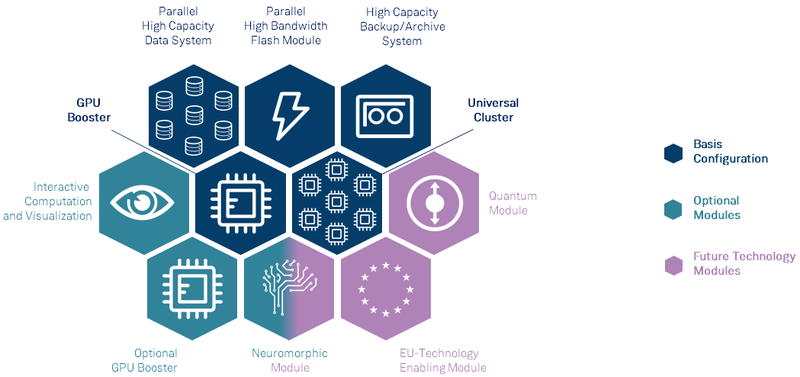

Анонсирован первый европейский суперкомпьютер экзафлопсного класса — JUPITERВсемирная гонка суперкомпьютеров экзафлопсного класса продолжается, и теперь в игру, наконец, вступил Евросоюз — консорциума EuroHPC сегодня раскрыл некоторые подробности о первой европейской система подобного уровня. Им станет машина под названием JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research), которая должна будет войти в строй в следующем году. Система будет смонтирована в Юлихском исследовательском центре (FZJ) в Германии. Сведений об аппаратной начинке JUPITER пока не так много, но в конструкции нового HPC-монстра будет применён тот же модульный подход, что был опробован на его предшественнике, суперкомпьютере JUWELS. Последний вступил в строй в 2018 году и на данный момент содержит несколько кластеров и бустеров с различной архитектурой.

Архитектура европейской экзафлопсной системы включает необычные средства. Источник: FZJ Новая система получит отдельные модули, куда входят вычислительные узлы, пулы памяти, узлы с различными ускорителями, узлы визуализации и т.д. Более того, она может быть дополнена блоками, которые содержат нейроморфные и квантовые системы, а также любые вычислительные модули, построенные на технологиях Евросоюза. Стоимость JUPITER оценивается примерно в €502 млн. Половину оплатит EuroHPC, четверть предоставит Министерство образования и науки Германии, оставшаяся четверть придётся на долю Министерства культуры и науки Северной Рейн-Вестфалии.

Машинный зал JUWELS. Источник: FZJ Проектировщики уделят серьёзное внимание энергоэффективности новой системы. Ожидается, что её потребление составит около 15 МВт, то есть она будет экономичнее нынешнего лидера TOP500 в лице Frontier. Для питания JUPITER планируется задействовать возобновляемые источники энергии, а СЖО будет использовать теплоноситель с относительно высокой рабочей температурой. Рассматривается возможность утилизации выделяемого системой тепла, как это реализовано в финском LUMI.

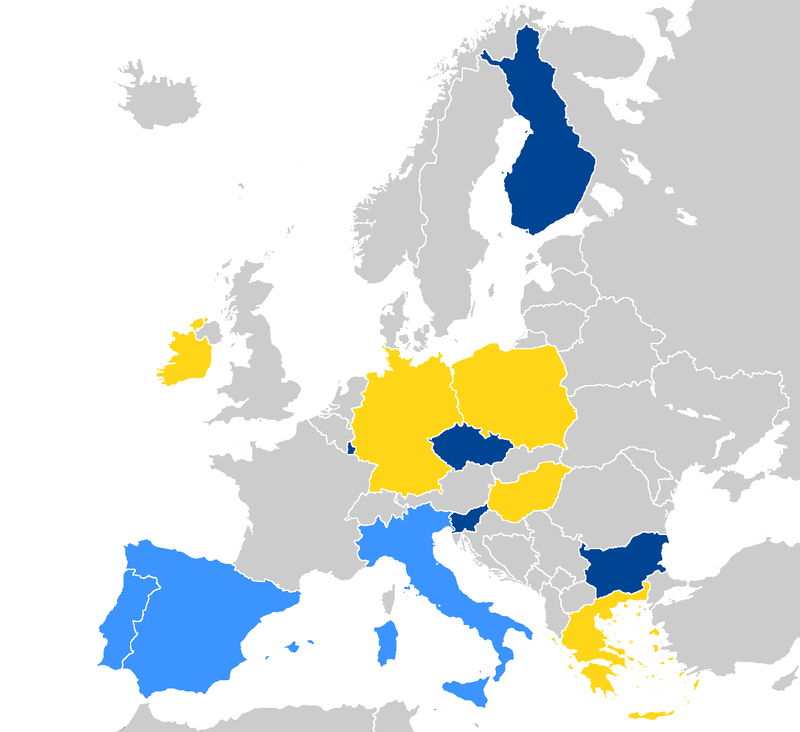

Страны, уже запустившие системы EuroHPC отмечены тёмно-синим, светло-синие — в процессе, жёлтым отмечены новички. Источник: EuroHPC Консорциум также анонсировал ещё четыре, более скромных суперкомпьютера. Это греческий DAEDALUS, венгерский LEVENTE, ирландский CASPIr и польский EHPCPL. В течение следующих нескольких лет EuroHPC планирует ввести в строй ещё минимум два суперкомпьютера экзафлопсного класса, так что гонка за зеттафлопом станет ещё интереснее. Впрочем, и Европе, и США надо опасаться в первую очередь Китая. |

|