Лента новостей

|

10.03.2024 [21:00], Сергей Карасёв

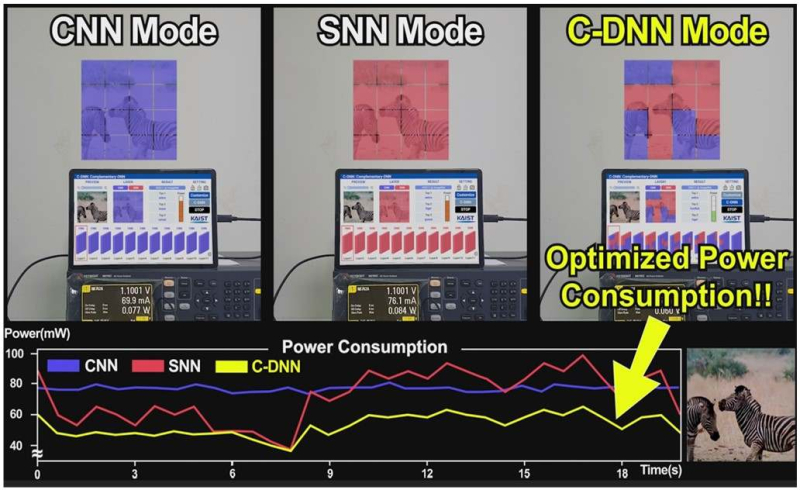

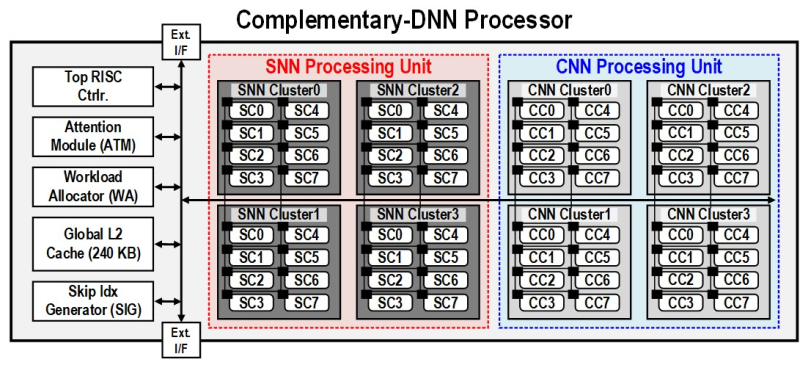

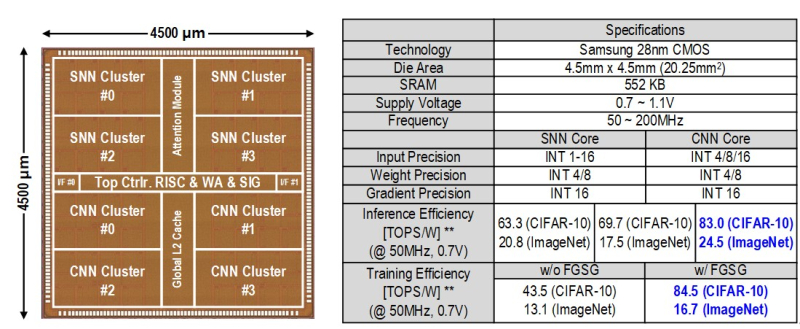

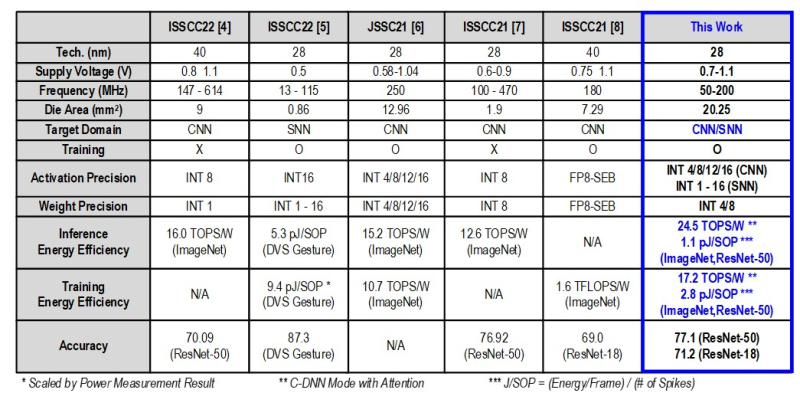

В Южной Корее создан сверхэффекттивный ИИ-чип, сочетающий классический и нейроморфный подходыИсследователи из Южной Кореи разработали, как утверждается, первый в мире полупроводниковый ИИ-чип, который обладает высоким быстродействием при минимальном энергопотреблении. Изделие, предназначенное для обработки больших языковых моделей (LLM), основано на принципах, имитирующих структуру и функции человеческого мозга. В работе приняли участие специалисты Корейского института передовых технологий (KAIST). Утверждается, что при обработке модели GPT-2 новинка по сравнению с ускорителем NVIDIA A100 затрачивает в 625 раз меньше энергии и занимает в 41 раз меньше физического пространства. Таким образом, южнокорейский ИИ-чип теоретически может применяться даже в смартфонах. Чип производится по 28-нм процессу Samsung Electronics. Отмечается, что обычно для обработки модели GPT-2 требуются ускорители на базе GPU, потребляющие около 250 Вт энергии. Разработанное изделие требует для этого всего от 40 мВт, а его размеры составляют 4,5 × 4,5 мм. Причём на выполнение операций затрачивается только 0,4 с. Чип наделён 552 Кбайт памяти SRAM. Напряжение питания варьируется от 0,7 до 1,1 В. Тактовая частота варьируется в диапазоне 50–200 МГц. Технология, получившая название C-DNN (Complementary Deep Neural Network) позволяет использовать свёрточные нейронные сети (CNN) и импульсные нейронные сети (SNN), имитирующие процессы, которые задействованы в человеческом мозге при обработке информации. Иными словами, обучение происходит через несколько слоёв нейронных сетей, а потребление энергии варьируется в зависимости от когнитивной нагрузки. Технология минимизирует энергозатраты благодаря использованию DNN для больших входных значений и SNN для меньших. Правда, чип поддерживает максимум INT16. Утверждается, что C-DNN является первым ускорителем, который может поддерживать распределение рабочей нагрузки CNN/SNN, используя компромисс между производительностью и энергопотреблением. Изделие обеспечивает энергоэффективность на уровне 85,8 TOPS/Вт и 79,9 TOPS/Вт для инференса с наборами данных CIFAR-10 и CIFAR-100 соответственно (VGG-16). Энергоэффективность в случае ResNet-50 составляет 24,5 TOPS/Вт. При обучении чип C-DNN демонстрирует энергоэффективность в 84,5 TOPS/Вт и 16,7 TOPS/Вт для CIFAR-10 и ImageNet соответственно. Результаты получены при напряжении 0,7 В и частоте 50 МГц. «Нейроморфные вычисления, имитирующие функции мозга, — это технология, которую такие крупные компании, как IBM и Intel, пока по-настоящему не реализовали. Мы гордимся тем, что первыми в мире начали использовать LLM со сверхэффективным нейроморфным ускорением», — говорит руководитель проекта профессора Ю Хой-Джун (Yu Hoi-jun).

10.03.2024 [00:30], Владимир Мироненко

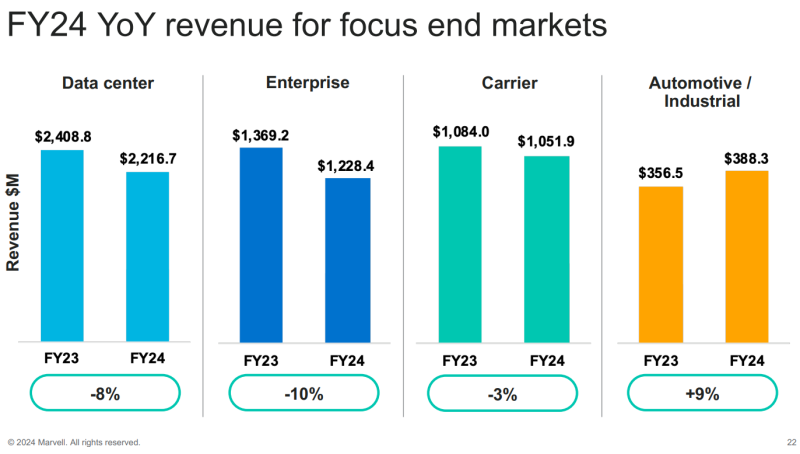

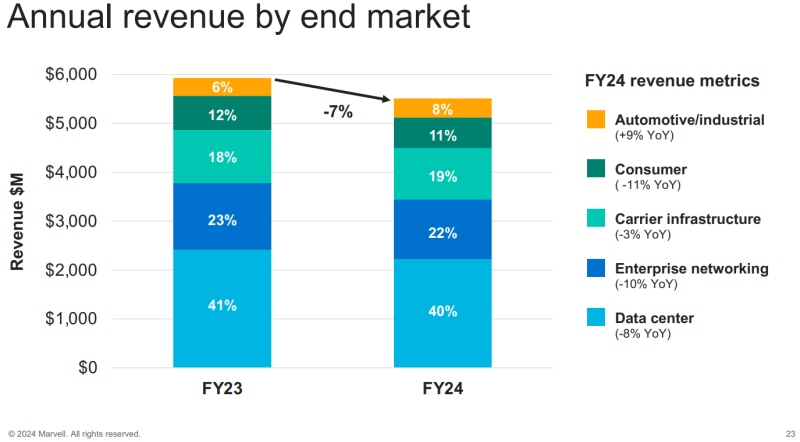

Акции Marvell Technology упали после слабого квартального прогноза, но компания намерена отыграться на заказах для ИИ-инфраструктурАмериканская компания Marvell Technology, занимающаяся производством процессоров, микроконтроллеров и телекоммуникационных решений, объявила итоги IV квартала и 2024 финансового года, завершившегося 3 февраля 2024 года. Показатели Marvell превысили ожидания аналитиков Уолл-стрит, но акции компании упали в минувшую пятницу после объявления результатов работы и разочаровавшего инвесторов прогноза.

Источник изображения: Marvell Technology Выручка Marvell выросла лишь на 1 % год к году и квартал к кварталу, до $1,43 млрд, что чуть выше прогноза аналитиков в размере $1,42 млрд. Скорректированная чистая прибыль (Non-GAAP) за квартал составила $401,6 млн или $0,46 на акцию, превысив прошлогодний показатель на $0,05 на акцию, что соответствует прогнозу Уолл-стрит. Согласно методике GAAP, у компании в отчётном квартале были убытки в размере $392,7 млн или $0,45 на акцию. Денежный поток составил за квартал $546,6 млн. Чистая выручка компании за 2024 финансовый год равняется $5,508 млрд, что на 7 % меньше прошлогоднего результата. Чистый убыток (GAAP) за год составил $933,4 млн или 1,08 на разводненную акцию. Скорректированная чистая прибыль (Non-GAAP) за 2024 финансовый год равняется $1,310 млрд или $1,51 на разводненную акцию. В I квартале 2025 финансового года Marvell прогнозирует чистую выручку в размере $1,150 млрд ±5 %, при этом разводненная прибыль (Non-GAAP) на акцию будет равна $0,23±$0,05, что значительно ниже прогноза аналитиков, составляющего $1,37 млрд и $0,40 соответственно. По словам Мэтта Мерфи (Matt Murphy), председателя и гендиректора Marvell Technology, бум на рынке ИИ способствовал значительному росту выручки компании на конечном рынке ЦОД, увеличившейся на 38 % последовательно и на 54 % год к году. Marvell имеет хорошие возможности для того, чтобы извлечь выгоду из этого масштабного технологического изменения на рынке. Клиенты компании, в число которых входят провайдеры облачных услуг и телеком-компании, работают над устранением избыточных запасов чипов, накопившихся во время пандемии COVID-19. Это будет способствовать новым заказам.

09.03.2024 [23:55], Руслан Авдеев

Liquidstar развернула в Джибути автономный микро-ЦОД Waypoint, способный раздавать воду и интернетКалифорнийская Liquidstar позаботится об обеспечении удалённых сообществ — как сообщает CleanTechnica, модульные микро-ЦОД серии Waypoint обеспечат дадут местным жителям воду, электричество и интернет. Новый ЦОД Waypoint заработал в Таджуре (Джибути). Его установили в августе 2023 года, а функционировать он начал ещё в прошлом октябре. Это уже третий объект на счету стартапа — компания поставляет не требующие подключения к электросетям ЦОД в форм-факторе транспортных контейнеров с дополнительными солнечными модулями питания. Их пользователи получают доступ к аккумуляторам, чистой воде и интернету Starlink, при этом часть ресурсов добывается буквально «из воздуха».

Источник изображения: Liquidstar В компании утверждают, что контейнеры могут обеспечивать электричеством благодаря сдаваемым в аренду аккумуляторам более 80 домохозяйств, получать до 100 л воды в день из атмосферного воздуха с помощью специального генератора, интегрированного с системой кондиционирования вычислительных мощностей и погружной СЖО. Доступ в интернет могут получить до 1,2 тыс. человек. Заодно компания предлагает в аренду электровелосипеды, которые заряжаются от Waypoint. Liquidstar работает над проектом в Джибути совместно с USAID и местным Министерством энергетики. Состояние Waypoint будет отслеживаться в течение двух лет для оценки жизнеспособности подобных ЦОД. Изначально Liquidstar планировала заниматься майнингом криптовалют с помощью Waypoint, параллельно обеспечивая некоторыми благами местные сообщества. Начальными инвестициями компанию обеспечили Mistletoe, TechStars, Flori Ventures, The Edgeof и Startupbootcamp Australia. На сегодня стартап привлёк около $1 млн. После испытания прототипа в 2021 году Liquidstar развернула модули Waypoint в индонезийской деревне на 40 домохозяйств, а также на территории колледжа на Ямайке. Как сообщают представители стартапа, успех подобных проектов является важной вехой — доказано, что можно управлять микро-ЦОД в отдалённых местностях, параллельно обеспечивая жителей интернетом и водой. В дальнейшем планируется протестировать использование «мусорного» тепла для очистки воды. Как утверждает Liquidstar, на сдаче в аренду аккумуляторов ($0,30/день за модуль ёмкостью 250 Вт·ч), предоставлении местным жителям доступа в интернет и вычислительным ресурсам ЦОД, а также перепродаже «углеродных кредитов», получаемых благодаря использованию солнечных элементов питания, каждый микро-ЦОД может приносить до $45 тыс./год, окупаясь за два года.

09.03.2024 [17:47], Сергей Карасёв

Индия потратит $1,2 млрд на суверенный ИИ-суперкомпьютер с 10 тыс. ускорителей и собственные LLMПравительство Индии, по сообщению ресурса The Register, утвердило программу развития национальной инфраструктуры ИИ. На эти цели будет выделено в общей сложности около $1,24 млрд. Одним из ключевых проектов в рамках данной инициативы является создание мощного суверенного суперкомпьютера для ИИ-задач и обработки больших языковых моделей (LLM). Информации о проекте новой НРС-системы на данный момент немного. Говорится, что в её состав войдут как минимум 10 тыс. ускорителей на базе GPU. Комплекс будет создаваться на основе государственно-частного партнёрства и станет частью вычислительной инфраструктуры IndiaAI Compute Capacity. Другим направлением комплексной программы является формирование центра инноваций в области ИИ — IndiaAI Innovation Centre. Он займётся разработкой и внедрением базовых ИИ-моделей. Ожидается, что особое внимание будет уделено LMM и моделям, специфичным для конкретных областей. Центр будет использовать периферийные и распределённые вычисления «для достижения оптимальной эффективности». Выделенные средства будут направлены ещё на несколько проектов. Это, в частности, финансирование индийских ИИ-стратапов IndiaAI Startup Financing, платформа наборов данных IndiaAI Datasets Platform для использования в сфере ИИ и инициатива IndiaAI FutureSkills, которая упростит доступ к различным ИИ-программам и поможет в формировании соответствующих лабораторий. В целом, Индия в рамках финансирования рассчитывает стимулировать технологическую независимость и демократизировать преимущества ИИ во всех слоях общества. Предполагается, что ИИ станет движущей силой цифровой экономики страны. Индия также разрабатывает собственные процессоры с архитектурой RISC-V, которые планируется применять в серверном оборудовании.

09.03.2024 [17:23], Сергей Карасёв

EKF представила российские ИБП серии Е-Power мощностью до 30 кВАКомпания «Электрорешения», производящая электротехническое оборудование под маркой EKF, анонсировала источники бесперебойного питания (ИБП) семейства Е-Power для различных сфер применения, включая инфраструктурный сегмент. Доступны модели мощностью от 400 Вт до 30 кВт. В частности, для массового сегмента предназначены линейно-интерактивные ИБП с аппроксимированной синусоидой Е-Power SSW-200 и Е-Power Номе. Серия SSW-200 имеет стандартное исполнение Tower, а мощность составляет 800, 1200, 1500, 2000 и 3000 ВА. Предусмотрены выходные розетки типа Schuko и информационный ЖК-дисплей. В свою очередь, решения Номе получили плоский корпус: выпущены модели мощностью 800 и 1000 ВА с шестью и восемью выходными розетками Schuko соответственно. Эти ИБП предназначены для защиты персональных компьютеров, бытовой техники, рабочих станций и офисного оборудования. На корпоративный сегмент ориентированы линейно-интерактивные ИБП Е-Power PSW600 и Е-Power PSW-H с чистой синусоидой на выходе, а также решения SW900Pro с двойным преобразованием. Такие устройства подходят в том числе для серверов, маломощного медицинского оборудования, систем безопасности и видеоконтроля и пр. Модели PSW600 выполнены в вариантах со встроенным аккумулятором, без него и для монтажа в стойку. Предлагаются версии мощностью 1000, 2000 и 3000 ВА. В свою очередь, изделия PSW-H получили мощное зарядное устройство и автоматический выключатель коммутации батарей. Мощность — 300, 600, 1000, 1600, 2500 и 3500 ВА. Серия SW900Pro включает модификации в исполнении Тоwer и универсальном корпусе Rack Tower, со встроенными аккумуляторами и без. Мощность — 1000, 2000 и 3000 ВА. Для инфраструктурного сектора предназначены однофазные ИБП E-PowerSW900G4, Е-Power SW800 и трёхфазные Е-Power SW900Pro-G5. Первые доступны в версиях Tower и Rack Tower, со встроенными батареями и для работы с внешними аккумуляторными массивами. Варианты мощности — 6, 10, 20 кВА/кВт. При этом модели на 10 кВт могут поставляться в конфигурациях «1 в 1» и «3 в 1» (три фазы на входе, одна — на выходе), а модель 20 кВт — только в варианте «3 в 1». Устройство Е-Power SW800 в исполнении Tower наделено развязывающим трансформатором на выходе. ИБП построен по схеме «3 в 1», а мощность равна 10, 15, 20 и 30 кВА. Наконец, трёхфазные ИБП Е-Power SW900Pro-G5 представлены моделями башенного типа со встроенным аккумулятором, для работы с внешними блоками батарей, с развязывающими выходными трансформаторами и в исполнении Rack Tower для работы с внешними аккумуляторами.

09.03.2024 [13:51], Сергей Карасёв

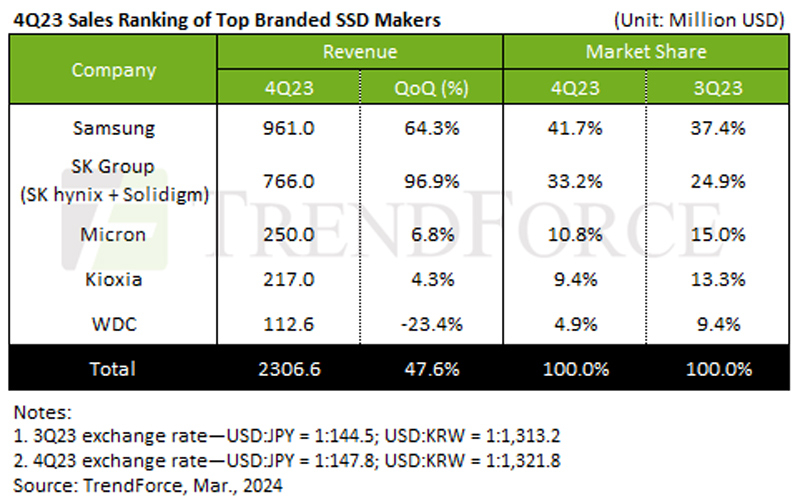

Продажи корпоративных SSD взлетели в IV квартале 2023 года, а сами накопители подорожалиКомпания TrendForce опубликовала результаты исследования мирового рынка SSD корпоративного класса в IV квартале 2023 года. В течение рассматриваемого периода цены на накопители указанного типа выросли более чем на 15 % в квартальном исчислении. Кроме того, наблюдалось увеличение спроса на SSD со стороны производителей серверов. В результате, продажи накопителей в денежном выражении взлетели на 47,6 % по сравнению с III четвертью 2023 года, достигнув примерно $2,31 млрд. Сокращение объёмов складских запасов и восстановление покупательной активности, по мнению аналитиков, приведёт к тому, что контрактные цены на SSD в I квартале 2024-го поднимутся более чем на 25%. Ожидается, что это будет способствовать росту выручки на 20% в квартальном исчислении.

Источник изображения: TrendForce Крупнейшим игроком рынка корпоративных SSD в IV квартале 2023 года осталась компания Samsung с ростом на уровне 64,3 % и результатом $961,0 млн. Доля южнокорейского поставщика достигла 41,7 % против 37,4 % кварталом ранее. На втором месте в рейтинге находится SK Group, которая зафиксировала самые высокие темпы роста: плюс 96,9 % квартал к кварталу. Итоговая выручка составила $766,0 млн, а рыночная доля — 33,2 %. Компания отмечает хороший спрос на SSD со стороны ключевых клиентов в Северной Америке. Замыкает тройку Micron, у которой выручка увеличилась на 6,8 % — до $250,0 млн благодаря повышению контрактных цен. Однако доля в квартальном выражении упала с 15,0 % до 10,8 %. Компания внедряет продукты с поддержкой PCIe 4.0 и готовится к распространению SSD на основе 232-слойной флеш-памяти. На четвёртом и пятом местах располагаются соответственно Kioxia и Western Digital, у которых доли составили 9,4 % и 4,9 %. При этом Kioxia нарастила продажи на 4,3 % — до $217,0 млн, а Western Digital сократила их на 23,4 % — до $112,6 млн, что объясняется снижением спроса на флагманские продукты.

09.03.2024 [13:51], Сергей Карасёв

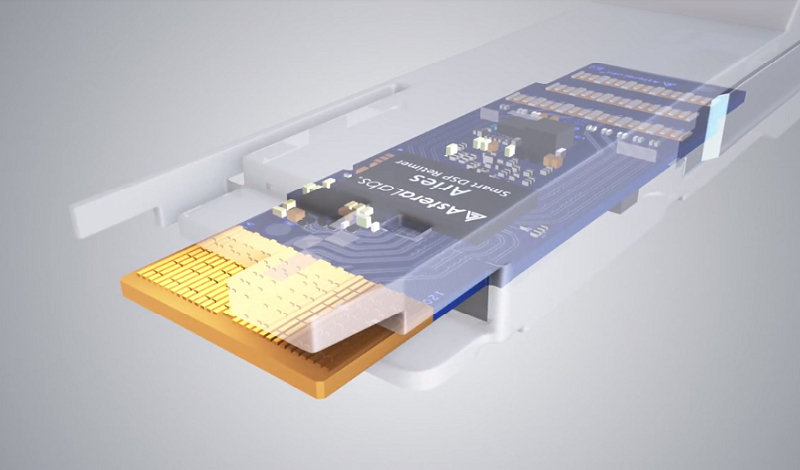

Astera Labs рассчитывает привлечь в ходе IPO более $500 млнСтартап Astera Labs поделился подробностями о процедуре первичного публичного размещения акций (IPO), осуществить которую планируется в ближайшее время. Компания рассчитывает привлечь свыше $500 млн и получить оценку приблизительно $4,0–$4,5 млрд. Информация о планах Astera Labs по выходу на биржу появилась в начале февраля 2024 года. Тогда говорилось, что процедура может состояться в марте. Позднее стартап направил документы об IPO в Комиссию по ценным бумагам и биржам США (SEC). И вот теперь раскрыты детали об этом процессе.

Источник изображения: Astera Labs Предложение включает 14 788 903 обыкновенные акции, которые предоставит собственно Astera Labs, и 3 011 097 обыкновенных ценных бумаг, которые будут проданы некоторыми из существующих акционеров компании. Таким образом, общий объём размещения составляет 17 800 000 акций. Ожидается, что цена бумаг в ходе IPO окажется на отметке $27–$30. В случае размещения по верхней границе указанного диапазона Astera Labs сможет получить до $534 млн. Кроме того, андеррайтеры будут иметь 30-дневный опцион на приобретение до 2 670 000 дополнительных обыкновенных акций у Astera Labs по цене первоначального публичного размещения. Бумаги начнут торговаться на Nasdaq Global Select Market под тикером «ALAB». Помощь в осуществлении IPO окажут Morgan Stanley, JP Morgan, Barclays, Deutsche Bank Securities, Evercore ISI, Jefferies, Needham & Company, Stifel, Craig-Hallum Capital Group, Roth Capital Partners, Loop Capital Markets и Siebert Williams Shank.

08.03.2024 [23:22], Владимир Мироненко

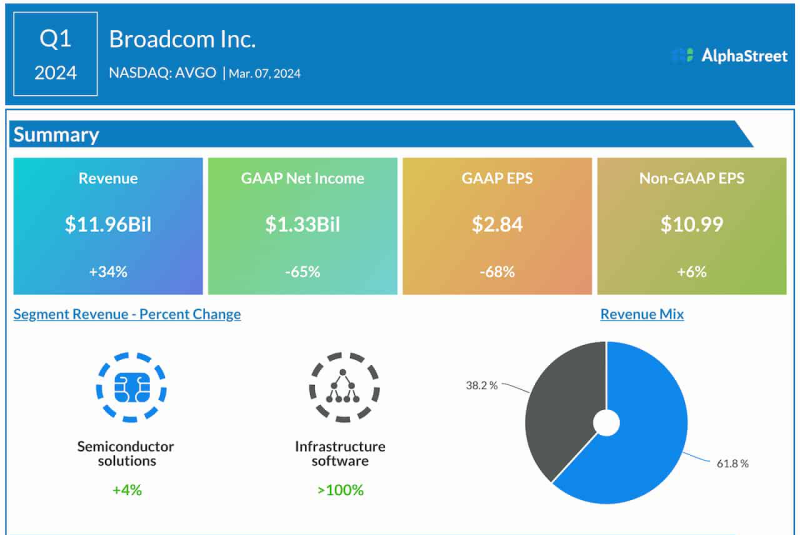

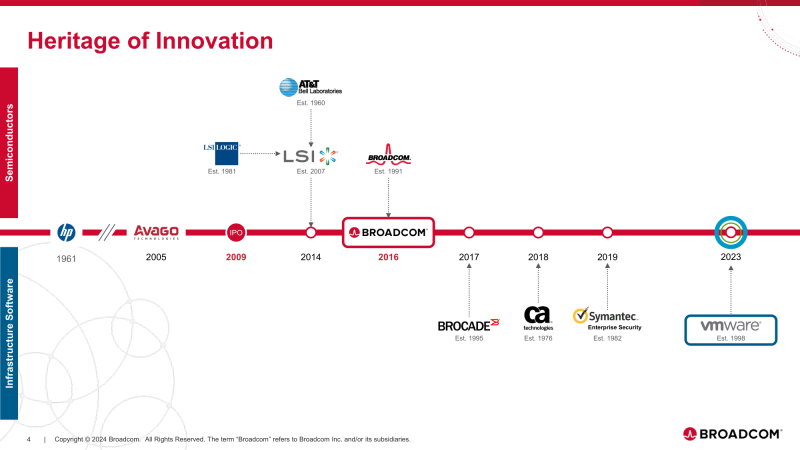

Выручка Broadcom в I финансовом квартале превысила ожидания Уолл-стрит, но акции упали из-за отказа повысить прогнозАмериканская компания Broadcom In объявила результаты I квартала 2024 финансового года, завершившегося 4 февраля 2024 года. Выручка компании превзошла оценки Уолл-стрит, но её акции упали в цене из-за слабого прогноза на текущий квартал. Вместе с тем Broadcom оставила прогноз по выручке на год на уровне $50 млрд, что оказалось ниже ожиданий аналитиков. Выручка Broadcom подскочила на 34 % по сравнению с годом ранее, до $11,96 млрд, превысив целевой показатель Уолл-стрит в размере $11,8 млрд. Росту выручки способствовал спрос на её сетевые чипы со стороны провайдеров облачной инфраструктуры, модернизирующих свои ЦОД с целью обеспечения работы сервисов ИИ. Прибыль (GAAP) упала в 2,9 раза — с $3,8 до $1,3 млрд. Скорректированная прибыль (Non-GAAP) на акцию составила $10,99, что на $0,66 выше прошлогоднего показателя и на $0,59 больше консенсус-прогноза аналитиков. Основной бизнес Broadcom — производство микросхем, но её портфель также включает поставку ПО, доля которого в структуре доходов стала намного больше после приобретения VMware Inc., а до этого — CA Technologies Inc. Если в прошлом году в аналогичном квартале на полупроводники приходилось 80 % всей выручки ($7,1 млрд), а на софт 20 % ($1,8 млрд), то в отчётном квартале поставки полупроводников принесли компании 62 % дохода или $7,4 млрд, а софт — 38 % ($4,6 млрд). Хок Тан (Hock Tan), президент и гендиректор Broadcom Inc. назвал два основных фактора роста доходов в I квартале и 2024 финансовом году. Во-первых, приобретение VMware ускоряет рост доходов в сегменте инфраструктурного ПО, поскольку клиенты развёртывают VMware Cloud Foundation. Во-вторых, высокий спрос на сетевые продукты компании в ЦОД с ИИ, а также специализированныеь ИИ-ускорители для гиперскейлеров способствуют росту её полупроводникового сегмента.

08.03.2024 [01:01], Владимир Мироненко

Вторая очередь трансевразийской ВОЛС TEA NEXT готова к коммерческой эксплуатацииКомпания «Ростелеком» объявила о технической готовности к началу коммерческой эксплуатации второй очереди новой Трансъевразийской волоконно-оптической линии связи (ВОЛС) TEA NEXT протяжённостью 765 км, проложенной между Санкт-Петербургом и Москвой. Согласно пресс-релизу, высокий потенциал линии позволил компании уже на этом этапе задействовать два волокна сверхпроизводительной линии под собственные нужды. TEA NEXT будет простираться от западных до восточных рубежей России с привязками к крупнейшим городам и выходами на границы России с Монголией и Китаем, а также на посадочную станцию в Находке. Для реализации проекта используются компоненты отечественного производства. На готовых участках линии TEA NEXT Идрица — Торжок, Москва — Санкт-Петербург компания предлагает в аренду тёмные волокна и каналы 100 Гбит/с с возможностью размещения собственного активного оборудования заказчиков вдоль трассы ВОЛС. Для линии, по словам компании, впервые в стране используются оптические волокна категории G.654Е с ультранизкими потерями (ULL), которые обеспечивают передачу данных с общей пропускной способностью 19,2 Тбит/с, а также могут использоваться для всех перспективных технологий магистрального оборудования DWDM. Проектная ёмкость ВОЛС составляет 96 тёмных волокон, которые будут использованы в качестве транзитного ресурса для связи Азии и Европы и российскими операторами. Проект имеет особое значение для связи Китая с Европой, поскольку предложит полноценную альтернативу морским кабельным системам, проходящим через Индийский океан и Египет, часть из которых была недавно повреждена. На данный момент уже готово более 1300 км трассы в европейской части РФ. Строительство первой очереди было завершено в конце 2022 года, в декабре 2023 года начата прокладка третьей очереди длиной 6300 км — между Торжком и Кяхтой (Республике Бурятия) на границе России с Монголией. Её планируют завершить до конца 2025 года. Президент «Ростелекома» сообщил, что проект TEA NEXT призван обеспечить быстрорастущие потребности участников рынка в ВОЛС-инфраструктуре для развития цифровой экономики России, позволяя сформировать принципиально новый рынок предоставления телекоммуникационной инфраструктуры как услуги для заказчиков компании.

08.03.2024 [00:03], Алексей Степин

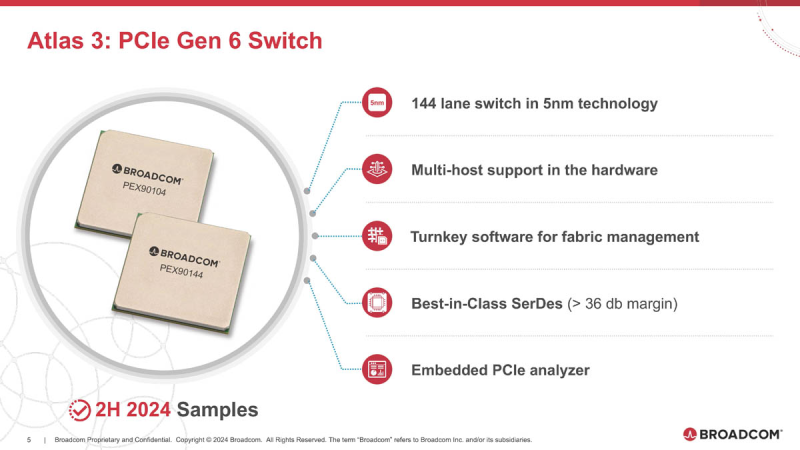

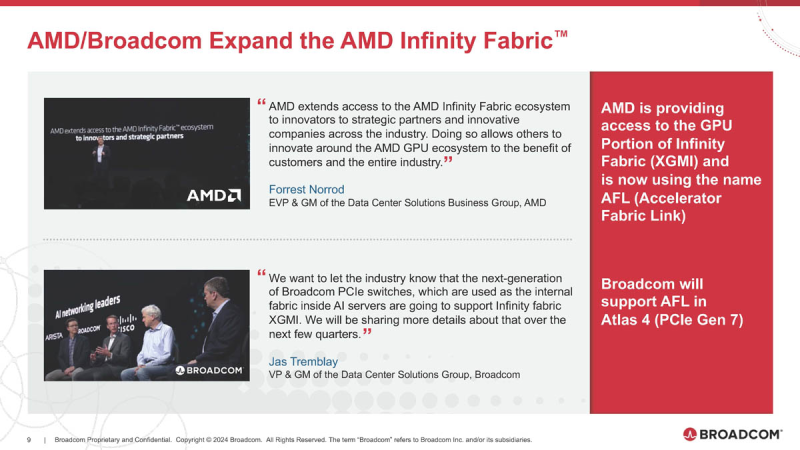

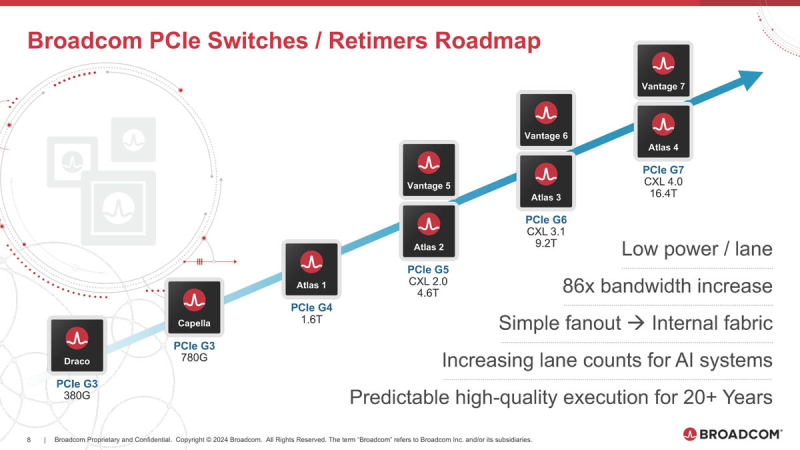

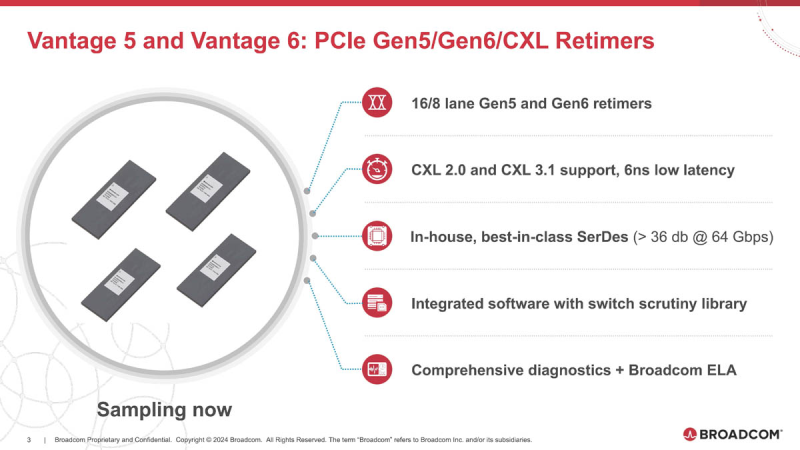

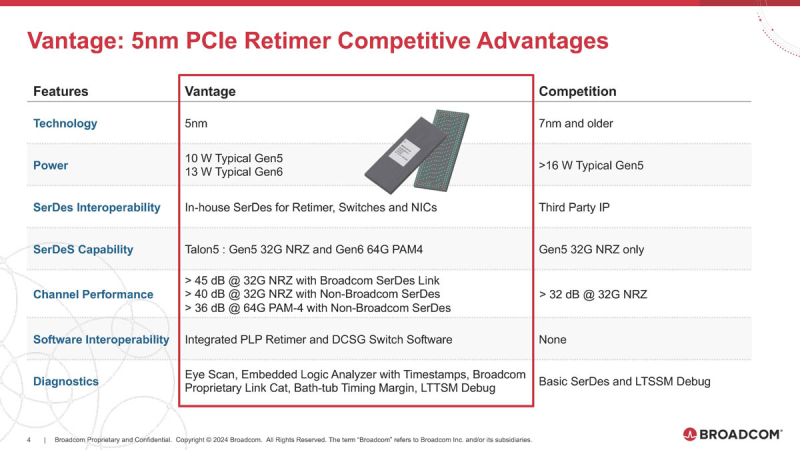

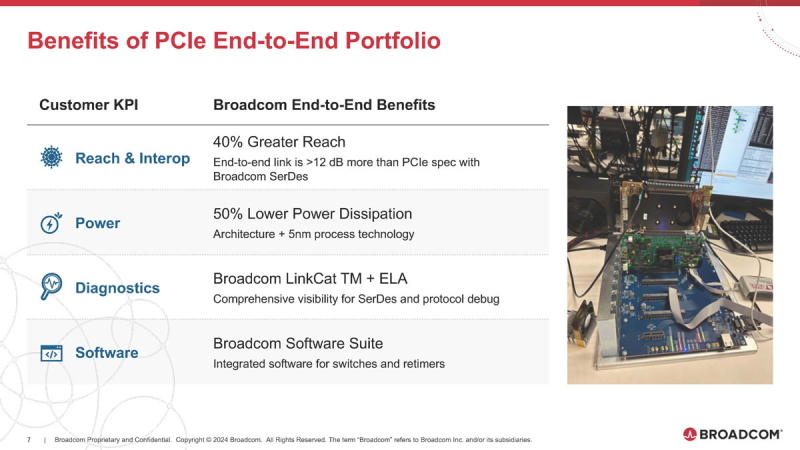

Broadcom готовит чипы для PCIe 6.0/7.0 с поддержкой AMD Infinity FabricОдним из столпов, на которых зиждется господство NVIDIA в мире ускорителей, является NVLink — высокоскоростной интерконнект, позволяющий чипам общаться напрямую не только в составе одного узла, но и за его пределами. AMD пытается ответить на это продвижением XGMI/Infinity Fabric, и в предварительном обзоре Instinct MI300 были затронуты вопросы топологии серверов в исполнении «красных». Ещё тогда, в момент анонса MI300, компания Broadcom объявила о поддержке данного интерконнекта в будущих поколениях своих PCIe-коммутаторов, а сейчас ресурс ServeTheHome поделился новыми подробностями. XGMI действительно станет коммутируемым, что упростит масштабирование систем на базе ускорителей AMD Instinct. Интерконнект получил официально название AFL (Accelerated Fabric Link). В основе AFL по-прежнему будет лежать PCI Express, в данном случае речь идёт уже о PCI Express 7.0. Поддержка данной технологии дебютирует в PCIe-коммутаторах Broadcom Atlas 4. В дополнение к ним будут выпущены и новые ретаймеры Vantage 7, которые также получат поддержку CXL 4.0. Но перед этим Broadcom начнёт поставки образцов чипов-коммутаторов Atlas 3 со 144 линиями PCIe 6.0 во II половине 2024 года, а серверы с такими коммутаторами появятся в 2025 году. Поддержка CXL здесь будет расширена до версии 3.1. Что касается ретаймеров, то здесь Broadcom уже нанесла ответный удар Astera Labs, анонсировав чипы серий Vantage 5 и Vantage 6 для экосистем PCI Express 5.0 и PCI Express 6.0 соответственно. Они будут выпускаться в вариантах с 8 и 16 линиями с опцией бифуркации и поддержкой CXL 2.0 и 3.1. Broadcom заявляет о более низком энергопотреблении, достигнутом за счёт применения 5-нм техпроцесса, лучших в индустрии блоках SerDes и расширенных средствах диагностики, интегрированных в новые ретаймеры. Экономичность здесь играет важную роль: хотя даже 7-нм ретаймер потребляет немного, таких микросхем в составе каждого GPU-сервера несколько, что при дальнейшем масштабировании выливается весьма серьёзные цифры. К тому же меньшая нагрузка ляжет и на систему охлаждения, ведь если CPU и ускорители могут обслуживаться СЖО, то остальные компоненты в таких серверах по-прежнему охлаждаются обычными вентиляторами. Что касается SerDes-блоков, то они позволят на 40 % удлинить соединения при сохранении стабильной работы. Ну а наличие продвинутого диагностического программного обеспечения с расширенными возможностями упростит разработку, отладку и ремонт систем нового поколения. Ретаймеры Vantage 5 будут использоваться в комплекте с коммутаторами Atlas 2 в решениях Broadcom уже сегодня, они обеспечат поддержку CXL 2.0, ну а системы с Vantage 6 и поддержкой CXL 3.1, как уже упоминалось, должны увидеть свет в следующем году. Astera Labs есть о чём беспокоиться: если на данный момент её ретаймерам почти нет альтернативы, то уже в ближайшем будущем ситуация может коренным образом измениться, поскольку Broadcom явно осознала всю важность этого компонента в экосистеме PCI Express и оценила солидный объём потенциальной клиентской базы. |

|