В ушедшем году IT-индустрия окончательно оправилась от пандемии и явно постаралась ускоренными темпами нагнать упущенное. Вспомним самые интересные анонсы, сделки и события не только 2023 года, но и начала 2024-го. Как раз подоспели квартальные и годовые отчёты компаний, исследования и прогнозы аналитиков, а также анонсы, которые компании не успели сделать до рождественских и новогодних праздников.

- CPU

- Ускорители и APU

- ЦОД и охлаждение

- Память и хранилище

- Сети и интерконнект

- HPC и суперкомпьютеры

- Сделки и события

- Российский рынок

- Заключение

CPU

На анонсы процессоров год выдался на удивление богатым. Начнём с того, что Intel умудрилась выпустить сразу два поколения Xeon Scalable: Sapphire Rapids и Emerald Rapids. Однако в заслугу это ставить ей затруднительно. Напротив, выход первых изрядно задержался, а вторые можно охарактеризовать скорее как работу над ошибками, благо платформа Eagle Stream для них едина. Так и не сумев и, возможно, даже не думая догнать AMD по количеству ядер (64 шт. всё ещё предел для «синих»), Intel сделала ставку на расширение возможностей CPU специализированными ускорителями, чем ещё больше запутала потенциальных клиентов. Экстремальным вариантом можно считать Xeon EE, в которых есть ускоритель обработки... 5G-трафика!

Особняком стоят уникальные процессоры Intel Xeon Max — всё те же Sapphire Rapids, но с 64 Гбайт HBM2e-памяти на борту, для которых наличие внешней DDR5 для работы не является обязательным (и такие системы уже есть). Но они дороги, рассчитаны на узкий сегмент и хорошо показывают себя в некоторых нагрузках HPC и ИИ. Первое массовое внедрение Max — это пресловутый суперкомпьютер Aurora, который попал-таки в последний рейтинг TOP500, но полностью свои возможности пока не раскрыл. Не исключено, что в будущем компания подобные процессоры выпускать более не будет.

Для рабочих станций Intel выпустила Xeon W-2400/3400, а для различного рода индустриальных, сетевых, периферийных и просто маломощных систем — Xeon D-1800/2800 и Xeon E-2400, на смену которым со временем придут Granite Rapids-D. Семейство Atom пополнили чипы C1100 (Arizona Beach). AMD, конечно же, без дела тоже не сидела, выпустив в 2023 году Ryzen Threadripper 7000 для рабочих станций и целый ворох разнородных процессоров для задач попроще: EPYC Embedded 9004, Ryzen Embedded 5000 и 7000, а также замечательные EPYC Siena 8004 (с малыми ядрами Zen4c).

Главная же борьба будет идти на совсем других фронтах. AMD в ушедшем году представила EPYC Genoa-X 9x84X и Bergamo 97x4. Первые, как видно из названия, являются Genoa с 3D V-Cache, и такое сочетание даёт до 96 ядер и 1152 Мбайт L3-кеша на процессор. А вот Bergamo — совсем другая история. Эти процессоры имеют до 128 ядер Zen4c, которые по ISA полностью совпадают с обычными Zen4, но сами по себе попроще, медленнее, а оттого значительно компактнее. Ориентированы они на облака и гиперскейлеров, которым важна плотность размещения вычислительных ресурсов. До конца 2024 года появится семейство EPYC Turin с ядрами Zen5(c).

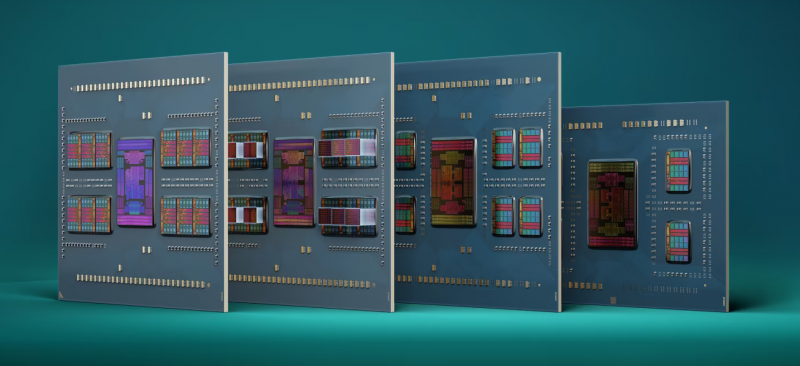

И Bergamo, и Genoa-X благодаря большему количеству ядер во многих нагрузках успешно конкурируют и с обычными Sapphire Rapids, и с Xeon Max. В Turin же, как ожидается, будет уже до 128 ядер Zen5 или 192 ядер Zen5c, да и 3D V-Cache не оставят за бортом. Чем будет отвечать Intel? Granite Rapids и Sierra Forest на базе P- и E-ядер соответственно, изготовленными по техпроцессу Intel 3. Первые, как считается, получат порядка 120 ядер, а вторые — 144 на первом этапе и 288 на втором. Нюанс в том, что ISA у них будет отличаться, поэтому даже нынешние Bergamo могут в итоге оказаться производительнее. Важно и то, что Intel всё глубже осваивает тайловую (чиплетную) компоновку и даже отделила IO-тайлы от вычислительных, хотя контроллеры памяти всё равно привязаны к последним.

Доля AMD на рынке серверных процессоров, по словам главы компании, ещё летом перевалила за 25 %, так что Intel придётся побороться. Но не только с AMD, а ещё и с армией Arm-процессоров, которых «красные» вообще-то тоже опасаются. Глава Oracle и вовсе заявил, что решения Intel x86 в серверном сегменте теряют актуальность. Правда, не стоит забывать, что Oracle сделала ставку на Arm, вложившись в своё время в Ampere Computing, которая представила 192-ядерные процессоры AmpereOne. Oracle портировала свою флагманскую СУБД на Arm-архитектуру и завершила миграцию всех своих облачных сервисов на Arm-процессоры. Exadata перевели с Intel Xeon на AMD EPYC, но переезд на Arm, вероятно, и здесь не за горами.

Softbank около года назад сообщила, что Arm захватила 5 % облачного рынка. Но, как считается, 40 % всех Arm-серверов мира приходится на Китай, который отказывается от западных решений, в том числе поддерживая стартапы вроде Borui Jingxin. Но и более зрелые местные компании даже в условиях санкций не стоят на месте. На другом берегу океана дела тоже идут неплохо. Так, AWS представила уже четвёртое поколение процессоров Graviton, добравшееся до 96 ядер. Microsoft представила 128-ядерный Arm-процессор Cobalt 100 собственной разработки, созданный на базе Arm Neoverse Compute Subsystem (CSS). По слухам, Google тоже разрабатывает Arm-процессоры Maple и Cypress.

В 2024 году должны появиться первые европейские процессоры SiPearl Rhea для суперкомпьютеров. Fujitsu обещает представить к 2027 году 150-ядерный серверный Arm-процессор MONAKA. Это будут универсальные CPU в отличие от A64FX, имеющих HBM2-память. Индия, напротив, добавила к своему 96-ядерному первенцу AUM сразу 96 Гбайт HBM3. Он фактически состоит из двух 48-ядерных чиплетов, объединённых 64 линиями PCIe 5.0 (≈ 252 Гбайт/с). Похожая компоновка у NVIDIA Grace Superchip: два 72-ядерных чиплета (в сумме 144 Arm-ядра), 900-Гбайт/с шина NVLInk между ними + 960 Гбайт LPDRR5X. Процессоры обещают быть не хуже CPU AMD и Intel, но намного энергоэффективнее.

В мире больших чипов RISC-V тоже было интересно. Ventana анонсировала второе поколение чипов Veyron V2. Они по-прежнему могут иметь до 192 ядер, но теперь компания предлагает своего рода конструктор из шести UCIe-тайлов, часть которых может быть представлена специализированными ускорителями. Ступенькой ниже находятся 64-ядерные китайские процессоры SOPHGO SOPHON SG2042. Примечательно, что SOPHGO использует ядра SiFive. Так что США не прочь ограничить использование RISC-V недружественным разработчикам, но как это сделать, если учесть открытость архитектуры, большой вопрос.

Ассоциация RISC-V International, которая ранее как раз из-за опасений чего-нибудь эдакого сменила штатовскую прописку на швейцарскую, задумалась о стандартизации серверных чипов RISC-V. К слову, российская YADRO, которой принадлежит Syntacore, входящая в состав правления RISC-V International, отказалась от развития POWER-платформ как раз в пользу RISC-V. В Китае, конечно, тоже развивают RISC-V, но, что удивительно, там же разработали и новый POWER-процессор, благо архитектура уже несколько лет как стала открытой. Сама IBM в 2023 году представила только младшие варианты мейнфреймов z16 и LinuxONE Rockhopper 4.

Впрочем, в Китае хватает и собственной экзотики вроде 32-ядерных Loongson 3D5000 или 384-ядерных Sunway SW26010 Pro. Последние ближе к ускорителям, как и японские 4096-ядерные процессоры PEZY-SC3. Совсем уж необычно выглядит экспериментальный RISC-процессор от Intel, созданный для DARPA: 8 ядер, 528 потоков и интегрированная фотоника от Ayar Labs. А вот процессор Tachyum Prodigy пока никак не выглядит, поскольку в кремнии, судя по всему, не существует, что не помешало разработчикам увеличить количество ядер с 128 до 192 и даже пообещать 8-Зфлопс машину на их основе.

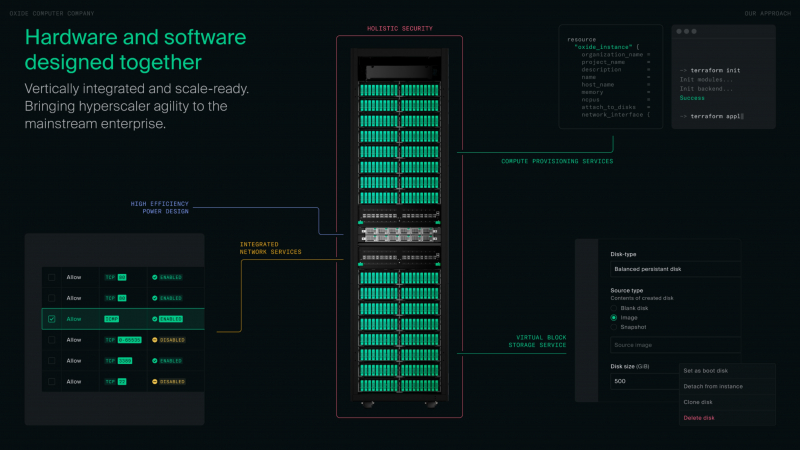

Отдельно стоит упомянуть и удивительный стартап Oxide Computer, который, по его же словам, намерен переизобрести облако. Это вылилось в создание интегрированной программно-аппаратной платформы в виде готовой стойки, разработанной с нуля, хотя и на базе стандартных компонентов. Компания избавилась от UEFI, сделала сетевую фабрику, создала собственный вариант BMC и RoT, переработала гипервизор и оснастила всё это удобным интерфейсом управления, не забыв выложить в open source практически все наработки.

Ускорители и APU

В принципе этот раздел можно было бы назвать «NVIDIA и остальные», поскольку безусловным лидером рынка стали именно решения «зелёных», которые всё ещё страшно дефицитны и на которых компания изрядно заработала. В конце прошлого года Dell призналась, что сроки поставок H100 растянулись минимум на девять месяцев. Однако виной всему политика самой NVIDIA. Традиционных серверных вендоров она оставила за бортом, и даже большая тройка облаков, которая в целом была не очень готова к буму генеративного ИИ (далее для краткости просто ИИ), оказалась чуть обделена вниманием. Одними из первых H100 получили провайдеры второго-третьего эшелона, а то и вовсе нишевые или совсем маленькие игроки.

Всё это привело к росту странноватых облачных провайдеров, готовых предложить доступ к ускорителям по кратно меньшим ценам, чем крупные игроки, но в то же время не способных предоставить весь спектр сопутствующих облачных решений, а подчас и вовсе формирующих физическую инфраструктуру под конкретного клиента или проект. Иными словами, живы они только из-за дефицита и в перспективе ближайших лет могут и вовсе сгинуть, если не выстроят привлекательный для заказчиков программно-аппаратный стек.

Среди подобных компаний особо выделяются CoreWeave и Lambda Labs, которые получили сравнительно крупные партии H100 и услугами которых, по слухам, вынуждена пользоваться Microsoft (и вполне официально — инфраструктурой Oracle). К первой NVIDIA, судя по всему, испытывает особую любовь, поскольку вложилась в неё и прямо, и опосредованно и задействовала её инфраструктуру в публичных бенчмарках. Этого CoreWeave оказалось мало, поэтому она взяла в долг $2,3 млрд под залог имеющихся ускорителей, чтобы... купить ещё больше ускорителей!

Microsoft ещё летом прямо говорила, что дефицит ИИ-ускорителей является для неё фактором риска. Так что компания сделала стратегический ход, создав собственный ИИ-ускоритель Maia 100 (Athena), причём с солидным транзисторным бюджетом. Таким образом Microsoft присоединилась к AWS, у которой есть уже два поколения ускорителей Trainium и Inferentia (для обучения и инференса соответственно), и к Google, которая в ушедшем году представила сразу два варианта пятого поколения фирменных ИИ-чипов: TPU v5p и TPU v5e.

Параллельно Microsoft ищет LLM попроще и подешевле в эксплуатации, чем применяемые ей повсеместно модели OpenAI, в которую редмондская корпорация инвестировала немало средств и ресурсов. Вообще говоря, роль ПО на фоне дефицита железа становится всё важнее и важнее. Практически вся индустрия полагается на экосистему CUDA, которую NVIDIA развивала 15 лет. Intel прямо говорит, что с этой гегемонией пора покончить, причём инструмент-то в лице oneAPI у неё вроде бы есть, но потеснить «зелёных» ей это не очень помогает.

Единственный на текущий момент достойный конкурент H100 из тех, для кого публично даются результаты бенчмарков, — Intel Habana Gaudi2 — наращивает производительность как раз благодаря оптимизации софта. А ускорители Max 1550 Intel предпочитает сравнивать с A100. Сейчас «синие» готовят ускорители Gaudi3, которые должны выйти в этом году, а от серии Greco было решено отказаться, равно как и от Rialto Bridge. В 2025 году Intel обещает представить чиплетные (тайловые) ускорители Falcon Shores, среди которых APU (XPU) не будет.

Таким образом, самыми продвинутыми с точки зрения компоновки остаются представленные в конце прошлого года AMD Instinct MI300: «чистый» ускоритель MI300X и гибридный самодостаточный APU MI300A с x86-ядрами. MI300X, согласно тестам самой AMD, быстрее H100, из-за чего между компаниями возникла даже небольшая онлайн-перепалка. Но главным всё равно остаётся софт. MosaicML, известная оптимизациями для ускоренного обучения моделей, смогла почти безболезненно для конечного пользователя перенести этот процесс с ускорителей NVIDIA на ускорители AMD. Lamini и вовсе полагается исключительно на решения AMD и первой же получила MI300X.

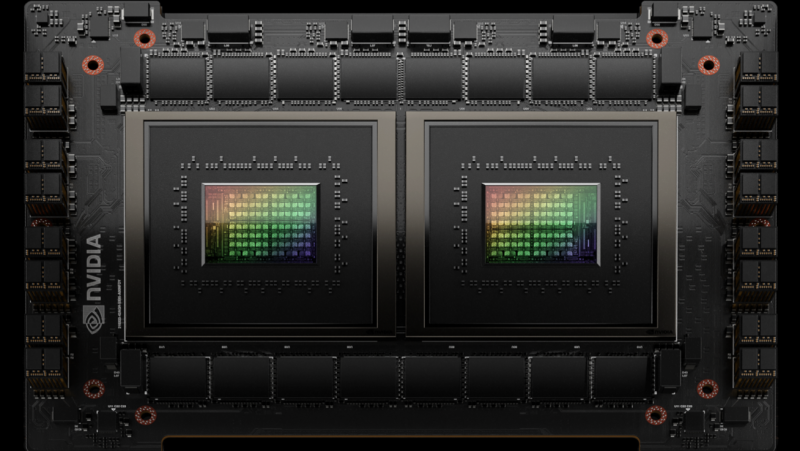

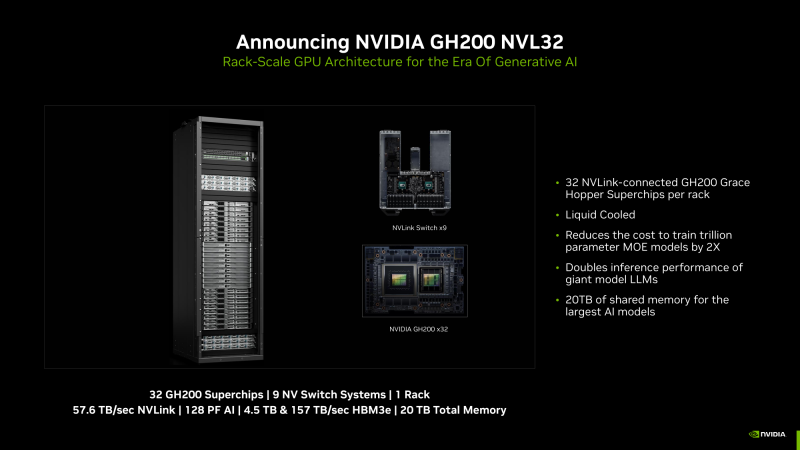

Сама AMD добилась интеграции ROCm в PyTorch 2.0 и OpenAI Triton 3.0. Всё это открывает ей путь к карману крупных компаний. Но бороться с NVIDIA будет непросто. Последняя уже представила ускорители H200 и APU GH200 Grace Hopper (H200 + 72-ядерный Arm-процессор), а также суперускоритель GH200 NVL32 (32 шт. GH200 с NVLink) и (мы уже сбились, какой по счёту) самый мощный в мире ИИ-суперкомпьютер Project Ceiba. Кроме того, компания представила в 2023 году ускорители L4 и H100 NVL, а также L40S, который до некоторой степени может заменить A100. В 2024 году NVIDIA обещала представить B40, B100, GB200 и GB200NVL на новой архитектуре.

Несколько смазали успех NVIDIA очередные антикитайские санкции со стороны США. Урезанные версии ускорителей H800 и A800 экспортным правилам более не соответствуют, так что уже выпущенные чипы частично направили на создание ускорителей попроще для западных рынков, а часть достанется Индии. Для Китая NVIDIA подготовила ещё более урезанные ускорители H20, L20 и L2, но они, похоже, потенциальных покупателей не заинтересовали. Кто-то успел запастись старыми вариантами, кто-то переделывает игровые GPU (тут, к слову, есть и альтернативный подход), кто-то обратился к локальным поставщикам.

Huawei выпустила загадочный ускоритель Ascend 910B, который непонятно чем именно отличается от 910-й модели. Свои ускорители представили Moore Threads, Metax и другие. А в целом китайские разработчики решили объединить усилия, чтобы создать в стране собственную ИИ-экосистему. Свои версии ускорителей для Поднебесной также подготовили AMD и Intel, а вот Graphcore, которой и так не очень хорошо, пришлось свернуть бизнес в КНР.

Вообще говоря, из давних независимых разработчиков «больших» ИИ-ускорителей лучше всех дела, похоже, обстоят у Cerebras, которая раскритиковала NVIDIA как раз за выпуск специализированных версий ускорителей. Потом, правда, выяснилось, что компания G42, которая и выделила Cerebras средства на создание действительно крупных ИИ-кластеров Condor Galaxy, сама неравнодушна к Пекину. Groq новых чипов не выпустила, а старые предлагает задействовать для инференса. SambaNova представила ускоритель SN40L, но среди крупных публичных заказчиков у неё опять Лос-Аламос, т. е. госструктура с бюджетными деньгами.

Среди новичков на рынке можно выделить D-Matrix, которая использует вычисления в памяти, и Lightelligence, опирающуюся на фотонику. Lightmatter, ставшая «единорогом», похоже, будет зарабатывать вовсе не на своих фотонных ИИ-чипах, а на чиплетном интерконнекте. Отличилась Южная Корея, которая стремится к технологической независимости, — здесь представлены чипы Rebellions, Sapeon и совместная разработка Samsung и Naver. Последняя пострадала от дефицита ускорителей «зелёных». Из экзотики можно вспомнить нейроморфный ИИ-процессор IBM NorthPole. Российский NM Quad от НТЦ «Модуль» тоже в каком-то смысле экзотика. А вот уникальные NEC SX-Aurora развиваться более не будут.

Источник изображения: Meta✴

При этом наиболее ожесточённая борьба развернётся в области ускорителей вовсе не для обучения, а для инференса. С «большими» вендорами как раз всё понятно, а вот создать эффективный чип, особенно для работы на периферии, программную экосистему для него и убедить потенциальных заказчиков, что он лучше всех, — дело непростое. Так, Esperanto, явно метившая в Meta✴ со своим 1000-ядерным ускорителем, второе поколение своих RISC-V-чипов сделает более универсальным.

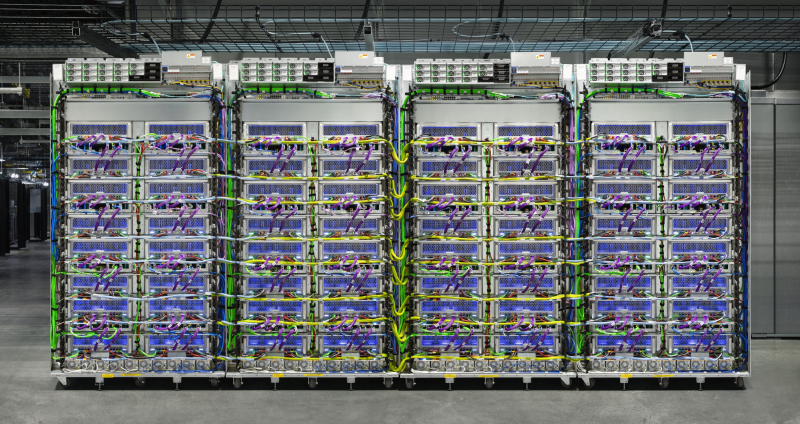

Но винить Esperanto не стоит, поскольку Meta✴ сама запуталась в своих желаниях — собственный ИИ-ускоритель MTIA v1 (Meta✴ Training and Inference Accelerator) она, как выяснилось, разработала ещё в 2020 году, и тоже на базе RISC-V. Он создавался для работы с рекомендательными системами и на поверку оказался не слишком эффективен. Проще говоря, для генеративного ИИ MTIA не подходит. Два года назад Meta✴ пошла на нетипичный для неё шаг, заказав ИИ-суперкомпьютер и хранилище к нему на стороне. Теперь же она до конца года будет иметь аж 350 тыс. NVIDIA H100. Чтобы переварить такое количество ускорителей, ей пришлось сделать всего ничего — поменять архитектуру ЦОД. Более того, компания намерена внедрять и MI300, и новое поколение собственных ускорителей Artemis.

ЦОД и охлаждение

И перед Meta✴, и перед остальными гиперскейлерами и операторами ЦОД в связи с массовым внедрением генеративного ИИ и высокоплотных аппаратных платформ для него остро встал вопрос питания и охлаждения. В 2023 году сразу несколько операторов предложили 300 кВт на стойку: Aligned, CyrusOne и Stack. У Digital Realty предложение скромнее, всего-то 70 кВт, зато география шире. А Equinix просто сказала, что готова к массовому внедрению СЖО. Involta и вовсе собралась брать деньги только за подведённую мощность или фактическое энергопотребление, а там хоть танк с иммерсионным охлаждением ставь.

Вообще о СЖО много говорилось в прошлом году, и всё чаще о погружном, которое хоть и не слишком удобное в практическом отношении, зато всё ещё самое эффективное. В реальности, конечно, скорее стоит ожидать гибридных схем. Тема охлаждения связана с двумя другими. Это, во-первых, водоснабжение, с которым тоже всё не так просто. А во-вторых, утилизация «мусорного» тепла, которое обычно предлагается использовать для отопления, хотя это не везде нужно и далеко не всегда экономически обоснованно. Подводные и прибрежные ЦОД, в общем-то, тоже решают именно проблему охлаждения.

А охлаждать будет что — энергопотребление ЦОД, как ожидается, вырастет вдвое в ближайшие годы. Гиперскейлеры особенно резко нарастят ёмкость, причём они заранее арендуют ещё не построенные мощности. Электроэнергия тем временем дорожает, а её нехватка тормозит развитие рынка. К традиционным источникам возобновляемой энергии помаленьку добавляются проекты по освоению геотермальной и атомной. Более того, операторам всё труднее повышать энергоэффективность и экологичность ЦОД, чего от них всё чаще требуют государства и общественность. Да-да, речь всё так же про тепло, воду и энергию.

Как бы то ни было, благодаря ИИ рынок ЦОД будет расти, во многом из-за гиперскейлеров и провайдеров колокации. При этом структура закупок уже поменялась — в штучном выражении поставки серверов упали, тогда как в денежном выросли. И дело не только в том, что теперь чаще приобретаются дорогие ИИ-системы, но и в том, что старые «обычные» серверы порой служат уже по семь лет и менять их не собираются. Российский рынок ЦОД в 2023 году тоже вырос, хотя не так сильно, как мог бы. Спрос на дата-центры растёт, причём не только в Центральном регионе.

Впрочем, Uptime Institute довольно осторожен в своих прогнозах. Да, влияние ИИ на индустрию будет сильным, но неравномерным. Гиперскейлеры в скором времени опять изменят ландшафт рынка, оттеснив провайдеров колокации. Больно ударит по всей индустрии повсеместное введение правил, касающихся энергоэффективности и устойчивого развития. И СЖО эти проблемы с ходу не решат, поскольку внедряются слишком медленно и слишком поздно. Но есть надежда на общее повышение эффективности работы ЦОД благодаря активному внедрению ПО для мониторинга и управления инфраструктурой.

Память и хранилище

Громче всех о себе в прошлом году заявила Pure Storage, предсказавшая скорую и стремительную смерть HDD. Да, поставки жёстких дисков сокращаются, хотя ёмкость продолжает понемногу расти, и вся большая тройка производителей который квартал показывает если не падение, то переменные успехи. Однако эксперты с Pure Storage не согласны. Пока что цена гигабайта у HDD меньше, чем у SSD, и для тех задач, где скорость не так критична, они подходят. Интерфейсы, соответственно, пока тоже особо не эволюционируют (STA вообще присоседилась к SNIA), а там, глядишь, перейдут на NVMe/CXL или на то, что гиперскейлеры сочтут более удобным.

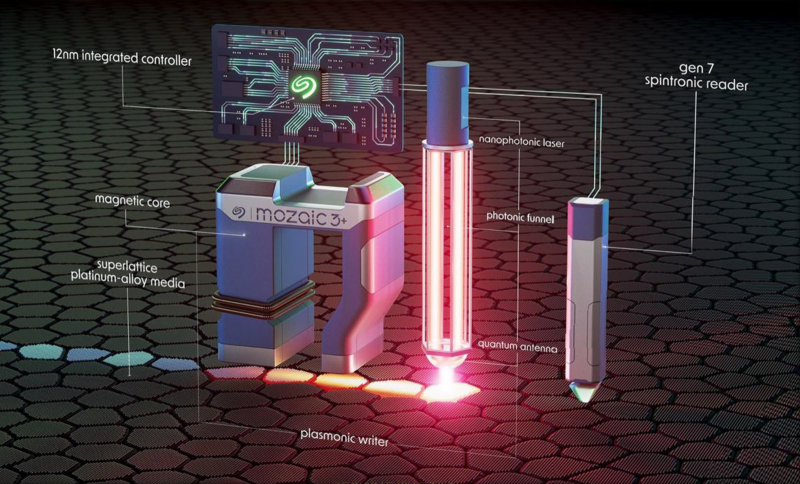

Seagate уже в этом году представила HAMR-платформу Mozaic3+ для 30-Тбайт накопителей и готовит решения на 40 и 50 Тбайт. Есть, конечно, некоторые сложности при внедрении столь ёмких дисков. Western Digital от конкурента явно отстаёт — в 2023 году она представила свои первые двухактуаторные HDD, а максимальную ёмкость накопителей довела только до 28 Тбайт (ePMR с SMR), а с CMR упёрлась в 24 Тбайт. Toshiba и вовсе добралась лишь до 22 Тбайт. При всём этом LTO чувствуют себя совсем неплохо, а «сырая» ёмкость проприетарных JF-картриджей IBM достигла 50 Тбайт (эффективная 150 Тбайт).

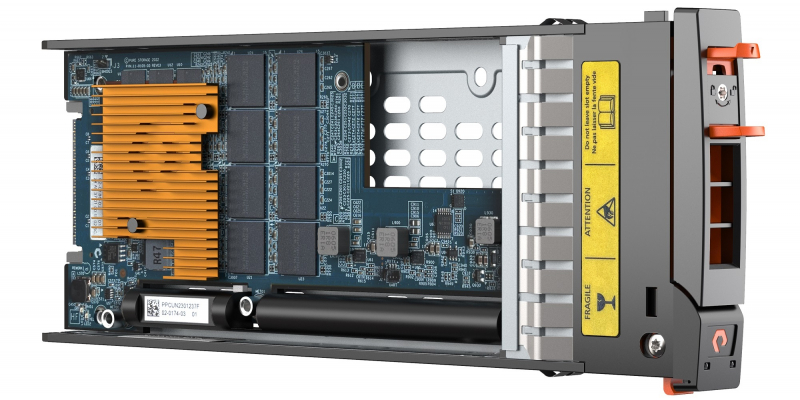

В SSD проприетарные решения тоже опережают массовые. Всё та же Pure Storage представила 75-Тбайт DFM-модули, а через пару лет собирается довести их ёмкость до 300 Тбайт. Они как раз и должны избавить рынок от HDD, которые не справятся с наплывом ИИ. Samsung пока работает над 256-Тбайт SSD, а вот Solidigm уже начала продажи 61,44-Тбайт NVMe SSD. И это безоговорочная победа над жёсткими дисками с точки зрения ёмкости. Естественно, этого удалось добиться благодаря применению QLC, но и форм-фактор (E1.L) тоже сыграл роль. Попутно отметим, что EDSFF потихоньку становится нормой в новых платформах, но U.2 до вытеснения пока далеко.

На смену почившим Optane было предложено сразу несколько накопителей с SLC/MLC-памятью: не названные пока модели Kioxia на базе XL-FLASH второго поколения, Micron XTR и Solidigm P5810. На самом деле флеш-память в них та же, что везде, но работает она в одно- или двухбитовом режиме. O PLC в 2024 году никто из производителей особо не заикался, они пока предпочитают наращивать количество слоёв: 321 у SK hynix, по 232 у Micron и YMTC, 218 у Kioxia/WD. Samsung вот-вот начнёт массовое производство 280-слойной 3D NAND и уже готовит 430-слойную.

Однако одной ёмкостью сыт не будешь, хорошо бы ещё повысить скорость. И не только обращений к хранилищу, но и обработки данных. Так, Scaleflux обновила вычислительные SSD, оптимизировав их для ИИ. Консорциум NVM Express вслед за SNIA добавил в стандарт поддержку вычислительных хранилищ. Pliops обновила свои карты XDP, ускоряющие работу с СУБД, и готовит новое поколение. Они же могут обслуживать и RAID из NVMe SSD, как и решения Graid, которая представила совсем простенький SupremeRAID SR-1001 для восьми SSD. Graid, напомним, фактически использует младшие ускорители NVIDIA. Аналогичного подхода придерживалась и Nyriad, но успешной компания не стала.

ИИ (что, опять?) должен подстегнуть и развитие CXL. В 2023 году о себе заявили сразу несколько стартапов: Enfabrica, Panmnesia и Unifabrix. Более опытные игроки тоже не сидели без дела. И все они пытаются создавать терабайтные пулы памяти. Благо CXL-модулей становится всё больше — к Samsung, снова опередившей всех, и Micron присоединилась ADATA. CXL даже проникает в интерконнекты. Как внутричиповые, так и внешние. SNIA же успела подготовить новый стандарт работы с памятью, который как раз опирается на CXL.

Micron, Samsung и SK hynix последовательно заявили, что они создали самую быструю память HBM3e, которая пойдёт в ИИ-ускорители образца 2024–2025 гг. Общий объём отгрузок HBM увеличится вдвое. Но и обычная память тоже развивается. Micron, например, анонсировала 128-Гбайт RDIMM-модули DDR5-8000. «Небинарные» чипы DDR5, к слову, набирают популярность, и таких предложений всё больше. Дальнейшее повышение ёмкости пока под вопросом. NEO Semiconductor предлагает «трёхмерную» 3D X-RAM, которая пока существует лишь на бумаге. Более практичная AMD в пику Intel с MCR DIMM предлагает MRDIMM. Оба варианта фактически объединяют два модуля DDR5 в одной планке.

Сети и интерконнект

В 2023 году Ethernet исполнилось 50 лет — самое время создать новый стандарт Ultra Ethernet для HPC и ИИ! На самом деле авторы этого стандарта фактически дружат против NVIDIA, которая, став лидером в ИИ-решениях, продвигает и свои сетевые продукты. От «зелёных» в этом году стоит ждать анонса InfiniBand XDR (800G), а в 2023 году компания с запозданием представила 400GbE/800GbE-платформу Spectrum-X и SuperNIC (DPU в другом обличье). Естественно, всё это, как заявляет NVIDIA, оптимизировано для ИИ, за что её и ругают конкуренты. Свои 800GbE-коммутаторы предлагают Marvell, Cisco и Broadcom. У последней есть даже два новых ASIC для ИИ и с ИИ. Omni-Path в исполнении Cornelis Networks пока остановился на 400G.

NVIDIA одержала победу и в совсем уж неожиданном месте — Nebulon, один из пионеров концепции DPU (тогда ещё для хранилищ), отказалась от собственных чипов в пользу BlueField-3. Кажется, последней, кто ещё делает упор на СХД (но тоже для ИИ, конечно) в своих DPU, осталась Kalray. Остальные рассматривают и продвигают DPU как IPU, то есть решения не только и не столько для работы с данными, сколько меняющие подход к инфраструктуре в целом. Microsoft даже предлагает протестировать свои DPU MANA то ли полностью собственной разработки, то ли на базе Pensando или Fungible. Axiado предлагает пойти ещё дальше, взвалив на плечи созданных ею TCU (Trusted Control/Compute Unit) не только работу с виртуализацией, сетью и хранилищем, но и защиту с управлением всем сервером целиком при содействии… правильно, ИИ!

У NVIDIA есть ещё один козырь — шина NVLink выбралась за пределы узла, кроме того, она быстрее всех других имеющихся интерконнектов. Хоть какую-то альтернативу в скором времени должна представить AMD, готовая слегка «приоткрыть» шину Infinity Fabric, которая базируется на PCIe. Как минимум для Broadcom, объявившей о поддержке XGMI в следующем поколении своих PCIe-свитчей. Со временем, быть может, появятся и отдельные XGMI-адаптеры. Прямо сейчас посредством «голого» PCIe объединять множество (буквально тысячи) ускорителей и узлов готова только GigaIO.

И так удачно совпало, что и PCIe 6.0 на подходе, и оптическим вариантом PCI Express тоже уже занимаются. Всё это пригодится не столько для Infinity Fabric, сколько для CXL. Собственно говоря, именно для CXL такой оптический интерконнект Photowave представила Lightelligence. При этом Google уже использует оптические коммутаторы с MEMS-переключателями в своих ИИ-кластерах. Meta✴ же опробовала вариант попроще, приставив к патч-панели роборуку.

HPC и суперкомпьютеры

Практически все анонсы новых машин в ушедшем году так или иначе упоминали ИИ. В этом нет ничего предосудительного, поскольку ИИ-инструменты вполне успешно дополняют традиционные расчёты. Но некоторым вендорам удержаться трудно, поэтому флопсы они считают как попало. Грубо говоря, почти любой условно классический суперкомпьютер с ускорителями, ориентированный на FP64-расчёты, можно использовать и для ИИ-нагрузок, но обратное не всегда верно — ИИ-суперкомпьютер с фантастической FP16-производительнстью для традиционных расчётов использовать обычно нет смысла, а иногда и попросту нельзя (если он построен на узкоспециализированных чипах вроде Cerebras или Gaudi).

Поэтому, когда, например, NVIDIA говорит об очередном самом мощном в мире суперкомпьютере, речь обычно идёт всё же про ИИ, если не оговаривается обратное. Если же опираться на классический рейтинг TOP500, то в нём более двух лет подряд лидирует первая в мире экзафлопсная система Frontier, которая собрала, наверное, все шишки, но позволила наладить процесс создания систем такого класса. Здесь, как обычно, следует оговориться, что в TOP500 попадают только те системы, владельцы которых пожелали это сделать, и что официальный Китай уже не первый год в этот рейтинг заявки не подаёт.

Источник изображения: Nebius

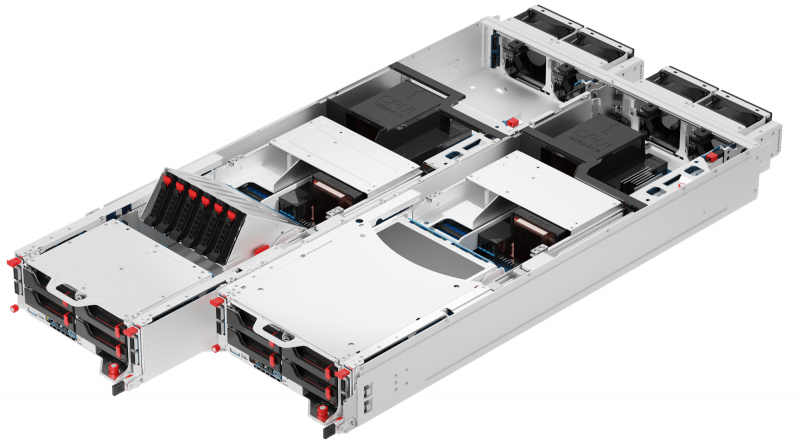

Вероятно, такого же подхода стоит ждать и от России, поскольку часть активов перестала быть российской. Но и про российские машины в условиях постоянного санкционного давления разумно лишний раз не распространяться. Хотя уникальные решения как раз имеются. Такие как универсальная HPC-платформа «РСК Экзастрим» с пиковой плотностью более 570 кВт на шкаф. Но не подаются в TOP500 и другие. Например, Tesla владеет одним из мощнейших в мире кластеров, который наверняка вошёл бы в десятку лидеров рейтинга. Но компания не захотела делать бенчмарки, она занята созданием ИИ-суперкомпьютера Dojo на собственных чипах D1.

Впрочем, в последней редакции TOP500 было несколько важных изменений. Туда наконец попали две многострадальные машины: Aurora и MareNostrum-5. Aurora вообще-то является 2-Эфлопс суперкомпьютером, но довести её до ума вовремя не успели. Противостоять ей будет El Capitan, тоже на 2 Эфлопс. Ещё один значимый новичок рейтинга — облачный суперкомпьютер Microsoft Azure Eagle. Это не первая облачная машина в принципе, но первая с действительно постоянной конфигурацией — кластер сформировали и протестировали буквально за несколько дней до сдачи в эксплуатацию. Eagle наглядно показал, насколько тонка стала грань между суперкомпьютером в облаке и облаком в суперкомпьютере.

Год наступивший обещает быть интересным. Уже в январе итальянская Eni похвасталась 600-Пфлопс машиной HPC6. Первым же европейским экзафлопсным суперкомпьютером должен стать JUPITER. Эта модульная (во всех смыслах) система на первом этапе получит два блока. Один на базе гибридных чипов NVIDIA GH200, второй — на базе европейских процессоров SiPearl Rhea. И в обоих случаях речь идёт об Arm-платформе! Великобритания тоже хочет экзафлопсную машину, но это будет уже в 2025 году. В этом году она получит системы Isambard AI и Isambard 3. Первая мощна, но не слишком интересна в том смысле, что машин на базе GH200 будет уйма. А вот вторая полагается исключительно на Arm-процессоры Grace SuperChip без ускорителей и обещает стать одной из самых энергоэффективных в мире.

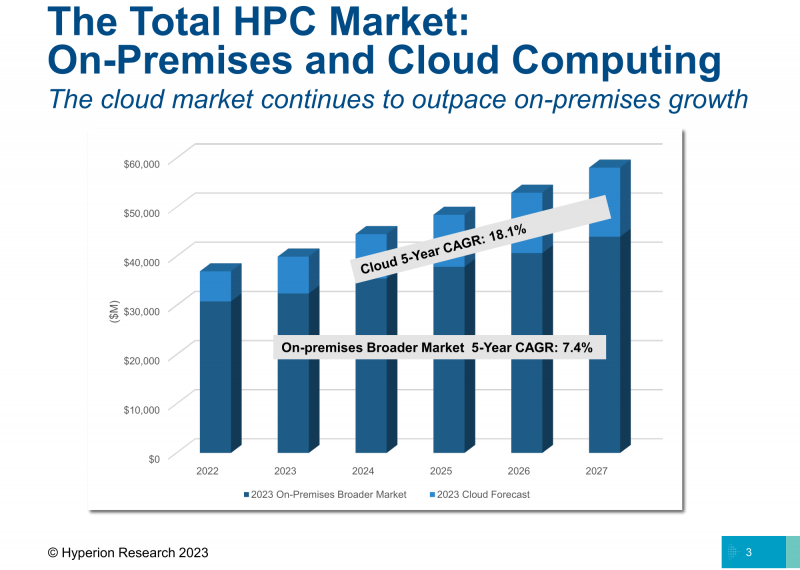

Рынок HPC в целом растёт и меняется. По данным Hyperion Research, на промежутке 2022–2027 гг. CAGR (совокупный среднегодовой темп прироста) всего on-premise-рынка HPC, куда входят железо, ПО и сервисы, составит 7,4 %. А вот для облачных HPC-нагрузок CAGR cоставит аж 18,1 %, причём в 2022–2023 гг. этот показатель и вовсе достиг 22,6 %. Проще говоря, HPC-задачи всё чаще запускают в облаках. Основным драйвером опять-таки является ИИ, инвестиции провайдеров (см. Eagle выше) и лучшее понимание того, какие задачи переносить в облако и как. Среди других факторов традиционно называются экономическая эффективность, гибкость, масштабируемость и доступ к новейшему оборудованию (в случае РФ скорее отсутствие такого у малых игроков).

У облаков есть и ещё один неожиданный козырь — наличие квантовых компьютеров. К ним, как ожидает Hyperion Research, в 2025 году половина пользователей будет иметь как раз облачный доступ. А основными задачами станут моделирование и симуляции, оптимизация и… снова ИИ. Тогда же объём рынка, по предварительным оценкам, вырастет с текущих $770 млн до $1,2 млрд. Для сравнения — объём on-premise-рынка HPC в 2023 году составит $16,5 млрд. Ключевыми препятствиями на пути внедрения квантовых вычислений называют сложность их интеграции с имеющейся IT-инфраструктурой и убедительной демонстрации окупаемости. По данным IQM, инвестиции в квантовые технологии в 2023 году упали вдвое — деньги «украл» ИИ. Но квантовой зимы не будет, лишь небольшое похолодание.

ИИ подтолкнул и без того нараставшее использование ускорителей. И проблемы, с которыми столкнулись ЦОД при повышении плотности вычислений, суперкомпьютерные центры не обошли, даже несмотря на гораздо более богатый опыт. Крупные машины требуют уже не один десяток мегаватт, что не всегда хорошо сочетается с экоустойчивостью. HPC-центры заинтересованы в глубокой телеметрии нагрузок, что может привести к интересным эффектам. Например, пользователь может согласиться на более длительное выполнение задачи просто потому, что теперь с него берут деньги не за машинное время, а за фактическое энергопотребление. Или задуматься, есть ли вообще смысл портировать код на GPU или дешевле сразу уйти в облако.

Сделки и события

Сделка 2023 года — это, вне всяких сомнений, покупка VMware за $69 млрд. После завершения сделки Broadcom рьяно принялась за дело: отказалась от бессрочных лицензий в пользу подписок, закрыла полсотни продуктов и редакций и фактически разрушила партнёрскую сеть VMware. Broadcom оправдывает эти действия несправедливым преимуществом для Dell и других крупных вендоров, но пострадает от её действий в первую очередь малый и средний бизнес. Естественно, что компания также намерена побыстрее отбить затраты на покупку, как это было в своё время с Symantec.

Вторая по величине сделка — покупка Splunk за $28 млрд — должна быть закрыта до конца этого года, в противном случае Cisco ждёт выплата одной только неустойки в размере $1,5 млрд. IBM отметилась покупками Apptio ($4,6 млрд) и пары платформ Software AG (€2,13 млрд) — всё для развития облака и ИИ. Micro Focus была продана за $5,8 млрд, а Alteryx за $4,4 млрд. Приобретение MosaiML (см. выше) за $1,3 млрд на фоне остальных сделок смотрится скромно, но для Databricks, оценка которой уже перевалила за $40 млрд, это важная инвестиция в будущее ИИ-решений. Первой же крупной сделкой, объявленной в 2024 году, является запланированное HPE поглощение Juniper Networks за $14 млрд. А ещё SUSE в 2024-м снова может стать частной компанией.

Действия Intel однозначно попадут в учебники будущего. Только в 2023 году она избавилась от коммутаторов и трансиверов, серверов и NUC (а это не только офисные и игровые ПК), а также FPGA-подразделения PSG, которое было сформировано после покупки Altera за $16,7 млрд в 2017 году. Впрочем, PSG на манер Mobileye выделено в независимую структуру с сохранением контрольного пакета за Intel. Компания надеется привлечь инвесторов и со временем выйти на IPO. Поведение Atos, вероятно, тоже попадёт в учебники. Весной 2023 года она предусмотрительно выделила часть активов в свежесозданную компанию Eviden. Сама Atos находится не в лучшем состоянии и пытается продать некоторые подразделения, чтобы поправить своё финансовое положение. Разве что о существенном сокращении персонала компания не объявляла, хотя подобные новости в 2023 году стали рутиной.

IBM, отчитавшись о том, что приобретение Red Hat за $34 млрд полностью окупилось, вероятно, решила слегка надавить на последнюю. Летом 2023 года Red Hat изменила политику доступа к исходному коду Red Hat Enterpise Linux (RHEL), оставив публичный доступ только к репозиториям CentOS Stream. Проще говоря, запретила создавать клоны RHEL, которые стали набирать популярность после отказа от «классической» CentOS, о чём Red Hat недвусмысленно и заявила. Юридически такой шаг вполне законен, но сообщество и крупные игроки резко раскритиковали компанию. В результате AlmaLinux отказалась от развития клона RHEL, а CIQ, Oracle и SUSE создали ассоциацию OpenELA, которая будет предоставлять исходный код и инструменты для создания downstream-сборок, совместимых с RHEL. В конце концов оказалось, что Red Hat навредила сама себе.

Российский рынок

ГК Softline вернулась на биржу, что, как считается, подтолкнёт и других игроков к IPO. Например, ГК «Астра» уже вышла на биржу, а Selectel, несколько поменявшая структуру владения, только готовится к IPO. YADRO вроде бы тоже не прочь стать публичной, да и ГК «Аквариус» также рассматривает такую возможность. «Росатом» закрыл самую крупную на российском рынке ЦОД сделку, отдав 23,8 млрд руб. за 35-МВт площадку TIER IV, что позволит ему улучшить позиции на растущем, несмотря на все санкции, российском рынке ЦОД. Он же приобрёл половину Kraftway, предположительно за 5 млрд руб. Первой крупной сделкой 2024 года стало отделение российского «Яндекса», которое обошлось в 475 млрд руб.

В целом российский IT-рынок растёт и развивается, но по-прежнему зачастую речь идёт об импортозамещении. С софтом всё не так уж плохо, за исключением ряда категорий вроде ERP или некоторых ИБ-решений, а также случаев закупок в обход санкций или даже пиратства. Затраты компаний на ПО бьют рекорды, а госкомпании и вовсе обязаны перейти на отечественный софт до конца года. Вместе с тем объём инвестиций в сфере ПО резко сократился, крупные компании продолжают скупать игроков поменьше, а избыток конкурирующих друг с другом решений остался. Хотя бы цены договорились резко не повышать, уже хорошо.

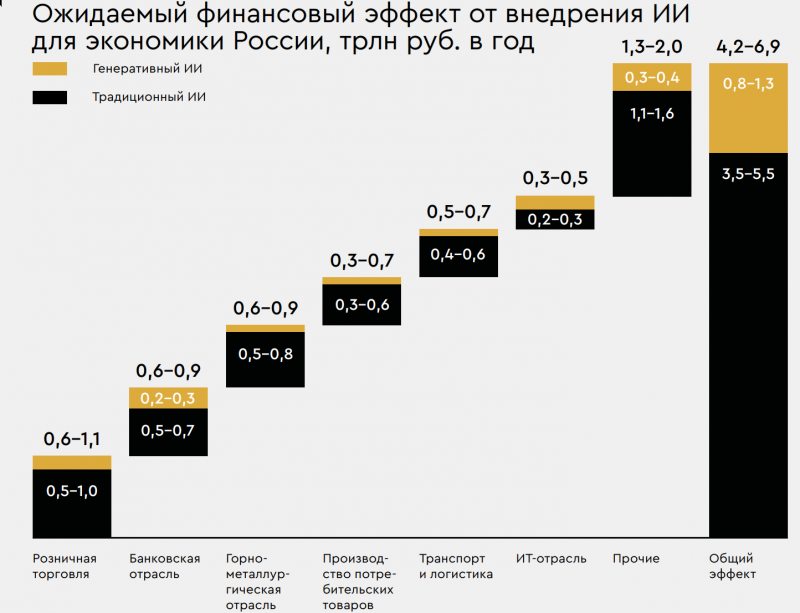

ИИ в России тоже активно развивается. К концу 2023 года каждая пятая крупная российская компания уже применяла генеративный ИИ, причём все они полагались на решения OpenAI, а среди отечественных ИИ-инструментов предпочитали решения «Яндекса» и «Сбера». Экономический эффект от внедрения ИИ, как заявляют официальные лица, составляет около 1 трлн руб., а к концу десятилетия он вырастет на порядок. Более того, использование ИИ в некоторых проектах станет обязательным условием для получения государственных субсидий.

С «железом» по понятным причинам всё сложнее, чем с софтом. Стоимость российских процессоров выросла, а в качестве альтернативы им предлагаются китайские. Вместе с тем большинство российских компаний продолжают использовать зарубежные серверы. Даже отечественные вендоры считают, что на восстановление серверного рынка уйдёт несколько лет, а без господдержки не обойтись. При этом нельзя не отметить, что в России в 2023 году появилось крупное производство серверов — OpenYard.

Телеком-рынок в России по чуть-чуть, но продолжает расти. В 2023 году заработала система «Антифрод», началось создание большой системы защиты от DDoS-атак, зарегулировали хостинг (а несговорчивых оштрафовали), призвали поскорее отказаться от зарубежных VPN и подключиться к Национальной системе доменных имён (НСДИ). И даже предложили обеспечить в стране запуск полного цикла производства оптоволокна. В общем, принят целый ряд мер по повышению устойчивости и безопасности Рунета.

Заключение

Тема генеративного ИИ будет эволюционировать и в 2024 году, но несколько по-иному. Эту технологию ждёт демократизация и переход от количественного развития к качественному. В прошлом году уже были случаи, когда LLM, созданная весной, к зиме становилась попросту неэффективной и дорогой в эксплуатации. Смешные на первый взгляд, но грустные по своей сути скрины переписок с ботами на крупных сайтах или карточки товаров тоже видели многие. ИИ станет более дисциплинированным и поможет максимизировать экономический эффект от имеющихся у компаний данных, но для этого нужна планомерная оценка рисков и уровня доверия к ИИ, его защищённости и безопасности в самом широком смысле, в том числе, например, регулярная аттестация моделей.

Всё потому, что ИИ будет глубже и шире проникать во все сферы деятельности. Это и разработка, для которой придётся выстроить новые платформы, и расширение возможностей всех остальных сотрудников, даже неквалифицированных. Gartner предсказывает интересные эффекты вроде расширения гиперперсонализированной работы с клиентами или роста автономных ботов, которые самостоятельно находят необходимые товары и услуги, подбирают подходящего поставщика и даже торгуются. Компаниям, да и частным пользователям явно придётся по вкусу автоматизация и оптимизация любой работы, если она сделана быстро и корректно. ИИ поможет добиться и устойчивого развития, за ширмой которого нередко скрывается возможность банально сэкономить. Правда, сам ИИ с его энергетическими запросами особенно экоустойчивым пока не назовёшь.

ИИ также сыграет роль и щита, и меча в кибербезопасности. Причём ещё не ясно, где он больше преуспеет, но риск атак будет всё выше и выше. В общем, технологический ландшафт генеративный ИИ если не перекроит, то изменит заметно. Причём мы видим только самое начало изменений. Сами же компании, как предсказывают аналитики, в сложившейся обстановке будут пытаться сохранить устойчивость, аккуратно оценивая инвестиции, просчитывая риски, сохраняя накопленное и оптимизируя всё, что только можно. Возможно, даже с помощью ИИ. А технологии для этого появятся, вот увидите. Главной же ценностью были и останутся люди!