Материалы по тегу: разработка

|

15.09.2024 [15:06], Сергей Карасёв

Германия выделила почти по €700 тыс. на развитие Samba и FreeBSDНемецкий фонд STF (Sovereign Tech Fund), сформированный Федеральным министерством экономики и защиты климата Германии (BMWK), по сообщению ресурса Phoronix, выделил €688 800 на развитие проекта с открытым исходным кодом Samba. Деньги получит организация SerNet, курирующая разработку Samba. Samba — специализированно ПО, которое позволяет обращаться к сетевым ресурсам на различных операционных системах по протоколу SMB/CIFS. Первый выпуск Samba состоялся в 1992 году. Софт работает на большинстве Unix-подобных систем и входит во многие дистрибутивы Linux. Распространяется Samba по условиям лицензии GPL. В течение следующих 18 месяцев разработчики займутся реализацией ряда инициатив, направленных на повышение безопасности, масштабируемости и функциональности ПО. Это, в частности, прозрачное аварийное переключение, расширения SMB3 UNIX и поддержка SMB поверх QUIC. Улучшения, разработка которых поддерживается STF, призваны гарантировать, что Samba останется надёжным и безопасным решением для организаций, которые полагаются на суверенную ИТ-инфраструктуру, максимально независимую от проприетарного ПО и при этом обеспечивающую оптимальную совместимость.

Источник изображения: STF В августе FreeBSD Foundation, координирующая развитие ОС FreeBSD, также сообщила о выделении фондом STF €688 400 на развитие проекта. Средства, в частности, пойдут на улучшение инструментария разработки ОС, повышение безопасности и закрытие технических долгов. Работы будут проводить в 2024–2025 гг. Кроме того, STF уже вложился в развитие и поддержку GNOME, PHP, FFmpeg, coreutils, systemd, curl, OpenSSH и массу других открытых проектов.

11.09.2024 [09:09], Владимир Мироненко

DevOps в России мигрирует на отечественные ОС, платформы и инструменты

devops

kubernetes

software

импортозамещение

исследование

контейнеризация

миграция

разработка

россия

сделано в россии

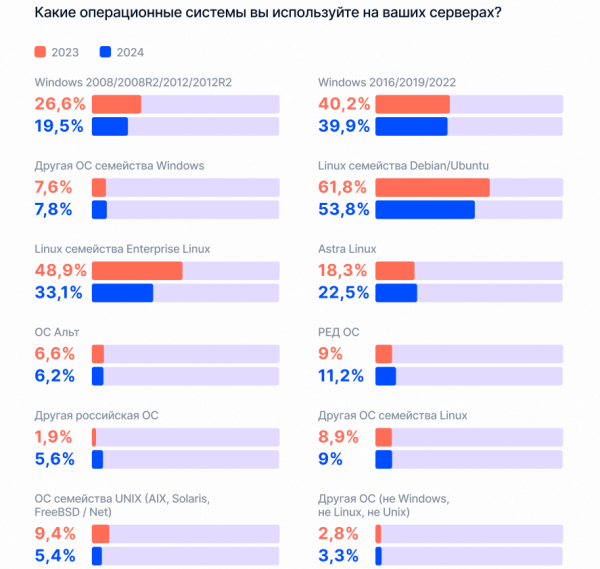

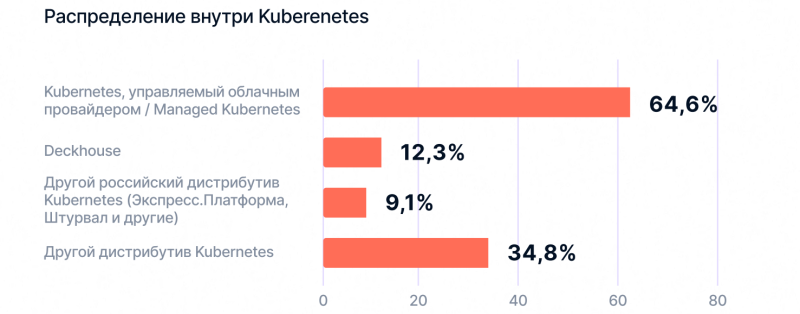

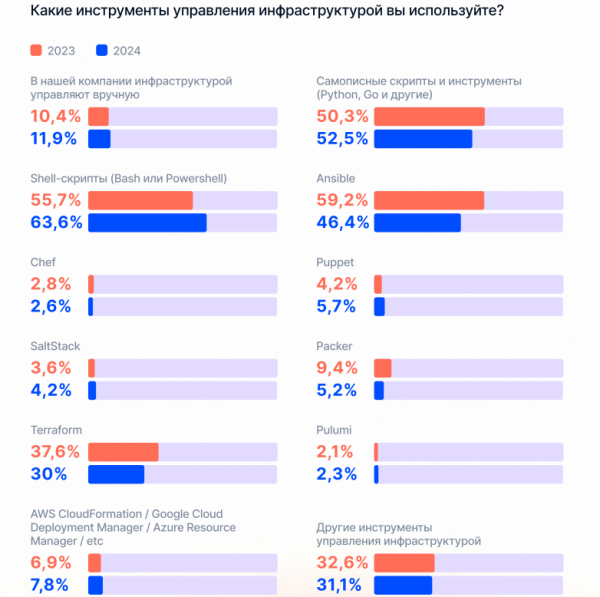

Компания «Экспресс 42» опубликовала результаты ежегодного исследования «Состояние DevOps в России», вышедшего при поддержке Deckhouse, Yandex Cloud, HeadHunter, «OTUS онлайн образование», JUG Ru Group, Avito Tech, «Т-Банк». Благодаря рекордному числу участников — более 4 тыс. человек — в исследовании удалось выявить ключевые закономерности и самые актуальные тренды развития DevOps в России. Исследование подтвердило рост интереса к DevOps, в том числе в новых отраслях. Хотя тройка лидеров сохраняется с 2020 года, доля ИТ уменьшилась с 45,5 до 36,2 %, доля финансового сектора упала на 2,4 % до 12,4 %, у ретейла равна 7,3 %. Суммарная доля отраслей за пределами ИТ-сферы и финтеха выросла с 39,7 % до 51,4 %. По сравнению с прошлым годом среди респондентов выросла доля работающих на российские компании — с 85,8 % до 89,4 %. Также увеличилось количество независимых специалистов — с 2,5 % до 3,8 %. Растущий интерес к DevOps отражает и рынок труда. По востребованности DevOps-специалисты уступают только разработчикам – 27,6 % против 40,6 % соответственно. Далее в рейтинге следуют системные аналитики (13,5 %). Вместе с тем бюджет на наём растёт, как и разрыв между количеством вакансий и резюме. То есть кадровый голод не утолён, но ключевые позиции, похоже, были закрыты, сделали вывод в «Экспресс 42». В числе самых востребованных навыков специалистов в этой сфере работодатели указывают работу с Linux (в 4 5% вакансий), Docker (37 %) и Kubernetes (35 %). Важны также компетенции DevOps (23 %), владение Ansible и Phyton (по 22 %), CI/СD и Bash (по 20 %), PostgreSQL (19 %), Git (17 %). Вместе с тем снизилась доля пользователей Debian/Ubuntu с 61,8 до 53,8 % и RHEL — с 49 до 33,1 %. Попутно растёт доля пользователей российских ОС Astra Linux — с 18,3 до 22,5 %; Ред ОС — с 9,1 до 11,2 %; других российских ОС — с 1,9 до 5,6%. Исключение составила ОС «Альт», доля которой упала с 6,6 до 6,2 %. Исследователи отметили, что большинство российских компаний адаптировалось к изменившимся за последние два года условиям работы. И их фокус смещается с нормализации состояния на развитие. Доля респондентов, выбравших вариант «Сохранить финансовую и операционную стабильность», сократилась с 23 до 19,4 %, в то время как доля выбравших варианты «Продолжить планомерное развитие» и «Воспользоваться появившимися новыми возможностями» увеличилась с 44 до 45,7 % и с 32 до 34,9 % соответственно. В числе первоочередных задач, которые компании ставят перед своими ИТ-департаментами — улучшение качества разрабатываемых продуктов (59,7 % респондентов), повышение скорости реагирования на запросы от бизнеса (43,6 %), создание новых технологий, которые обеспечивают конкурентное преимущество на рынке (42,1 %). Также отмечено увеличение средств, выделяемых на ИТ. 57,2 % опрошенных, которые ознакомлены с распределением, сообщили об увеличении бюджета на ИТ, а у 26,2 % он остался прежним. Исследователи отметили рост количества пользователей managed-решений и российских дистрибутивов Kubernetes. Аналитики расценивают это как начало тренда на переход на управляемые решения и российские дистрибутивы. Также отмечено, что классическими оркестраторами стали пользоваться меньше: доля Kubernetes снизилась с 58,3 до 54,4 %, OpenShift — с 15,1 % до 14,1 %, Rancher — с 9 % до 5,7 %. При этом доля отдельных оркестраторов выросла, больше всего у Docker Swarm — с 14,7 % до 18,6 %. Доля респондентов, которые не используют оркестраторы, увеличилась с 18,7 до 24 %, что объясняется распространением DevOps на новые отрасли, где работают с обычными виртуальными машинами без надобности в решениях уровня Kubernetes, поскольку достаточно Docker Swarm. В числе ключевых функций/компонентов платформ контейнеризации респонденты назвали возможность установки в закрытый контур (49,1 %), централизованное управление множеством кластеров (44,3 %), возможность беспростойных обновлений (41 %), графический интерфейс и удобство и максимальную автоматизацию всех процессов (38,3 %). Наиболее важными аспектами они назвали наличие экосистемы сопутствующего ПО, наличие совместимости с другим ПО и возможность влияния на план развития платформы. При выборе той или иной платформы контейнеризации респонденты руководствуются стоимостью (51,5 %), затратами на обслуживание и эксплуатацию (48,9 %), сложностью внедрения (45, 9%). Основной ценностью использования платформ респонденты считают сокращение вывода решения на рынок (52,4 %), сокращение затрат на поддержку технологических решений (49 %) и на владение инфраструктурой (44,2 %). В исследовании также была зафиксирована тенденция ухудшения ключевых метрик по всем профилям эффективности DevOps: частота релизов ПО, срок поставки, меньшее время восстановления после инцидентов и т.д. Самым популярным инструментом DevOps являются облачные решения. В числе ключевых преимуществ PaaS большинство респондентов назвали ускорение создания и масштабирование приложений (40 %), возможность использование всех сервисов у одного провайдера (37 %), гарантию соблюдения SLA (27 %). Вместе с тем треть респондентов предпочитает размещать данные на собственной инфраструктуре (33 %), чуть меньше трети пользуется гибридной средой (30 %). В основном компании используют управляемые сервисы для администрирования виртуальных машин и систем резервного копирования (4 %), развёртывания серверов (37 %), реже сервисы применяются для помощи с процессом миграции (14 %). В рейтинге популярности PaaS и управляемых сервисы лидируют управляемые SQL (45 %) и оркестраторы (38 %). По-прежнему наименьшее распространение имеют облачные ML-сервисы (8 %) и инструменты для синтеза и распознавания речи (7 %). Ключевые навыки для DevOps-специалиста в облаке включают знание специфики работы в контуре облачного провайдера: управления доступами и безопасностью (57 %), работы с API (62 %), работы с CLI (61 %). Также растёт использование ИИ — 44 % респондентов используют ML/AI-инструменты для решения DevOps-задач и 47 % отмечают их важность в повышении эффективности.

09.09.2024 [12:10], Руслан Авдеев

LLM в комплекте: Red Hat выпустила платформу RHEL AI для работы с генеративным ИИRed Hat объявила о запуске платформы Red Hat Enterprise Linux AI (RHEL AI) для создания генеративных ИИ-решений в облачных средах. По данным Silicon Angle, анонсированный три месяца назад пакет ПО сделали общедоступным в ходе мероприятия Red Hat Summit. Ранее анонсированный пакет включает семейство открытых языковых моделей IBM Granite, а также инструмент настройки моделей InstructLab, разработанный самой RedHat. Всё это объединили в образ RHEL для развёртывания в гибридных облаках и на локальных площадках. В компании сообщили, что RHEL AI упростит и удешевит разработку компактных и недорогих моделей. Затраты на обучение моделей могут быть очень высокими, в Red Hat сообщают, что на создание некоторых передовых моделей уходит до $200 млн. И это только на обучение, без учёта стоимости самих данных и настройки, критически важной для выполнения специальных задач каждой конкретной компании. В Red Hat уверяют, что будущее за небольшими генеративными ИИ-моделями, большинство которых будет open source.

Источник изображения: Red Hat В компании рассчитывают, что RHEL AI станет основной платформой для создания «бюджетных» и открытых решений. По умолчанию предоставляется библиотека бесплатных LLM Granite общего назначения. InstructLab поможет в тонкой настройке моделей без обширных навыков, связанными с наукой о данных. А интеграция с Red Hat OpenShift AI упростит обучение, настройку и обслуживание моделей. RHEL AI позволит разворачивать генеративный ИИ в непосредственной близости от баз данных и хранилищ компаний. RHEL AI оптимизирован для развёртывания на новейших серверах Dell PowerEdge и обеспечивает все возможности, предоставляемые подпиской Red Hat, в т.ч. круглосуточную поддержку, расширенную поддержку жизненного цикла моделей и, например, правовую защиту Open Source Assurance. Поскольку RHEL AI фактически является расширением Red Hat Enterprise Linux, дистрибутив можно использовать и на любом другом оборудовании, в том числе в облаках. Решение уже доступно у AWS и IBM Cloud, в Google Cloud и Azure появится возможность использовать его позже в этом году. В IBM Cloud ожидается появление предложения «как услуги» — по подписке в самом облаке, но только в следующем году. Ранее сообщалось, что для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти и хранилище от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

02.09.2024 [12:44], Андрей Крупин

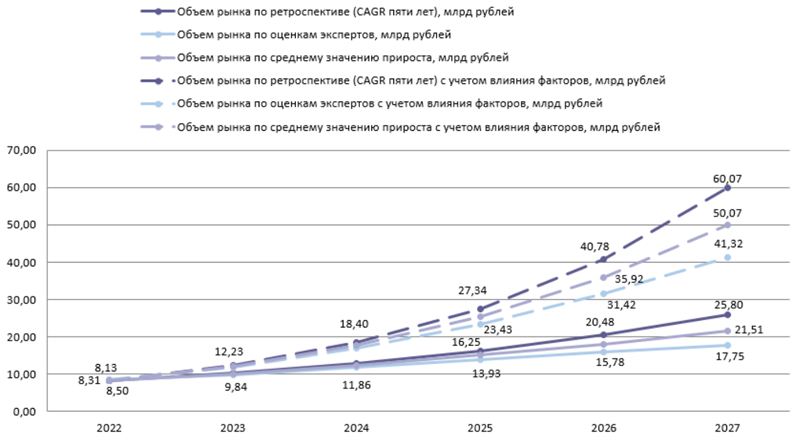

Объём российского рынка безопасной разработки ПО может достичь 60 млрд рублей в 2027 годуК 2027 году рынок безопасной разработки программного обеспечения (DevSecOps) в России достигнет, по самым осторожным сценариям, 17,75 млрд руб. (рост в 2 раза), а по самым оптимистичным — 60 млрд руб. (рост в 7 раз). Такой прогноз приведён в исследовании Центра стратегических разработок. По данным экспертов Центра стратегических разработок, в 2022 году объём упомянутого сегмента IT-рынка составил примерно 8,25 млрд руб., значение 2023 года аналитики оценили в 9,84–12,32 млрд руб. Авторы исследования прогнозируют, что динамика рынка безопасной разработки будет сопоставима с ростом объёма разработки отечественного ПО.

Прогноз объёма российского рынка безопасной разработки ПО (источник изображения: Центр стратегических разработок / csr.ru) Рост отечественного рынка безопасной разработки обусловлен тремя ключевыми факторами: развитием IT-отрасли в целом, уходом иностранных вендоров из РФ и увеличением числа кибератак на государственные организации и бизнес, что мотивирует разработчиков ПО минимизировать киберриски ещё на стадии написания кода. При этом основными сдерживающими факторами развития рынка в среднесрочном периоде станут отсутствие альтернатив зарубежным продуктам и ожидание возобновления поставок западного ПО. После 2026 года, по прогнозам экспертов, влияние этих обстоятельств ослабнет, а на первый план среди сдерживающих факторов выйдет развитие собственных инструментов для безопасной разработки, а не приобретение ПО у вендоров. По прогнозам аналитиков, к 2027 году российский сегмент безопасной разработки стабилизуется: будут определены основные участники, которые займут все свободные ниши продуктовых линеек. Последующий вектор его развития — выход вендоров со зрелыми решениями на зарубежные рынки.

28.08.2024 [00:10], Владимир Мироненко

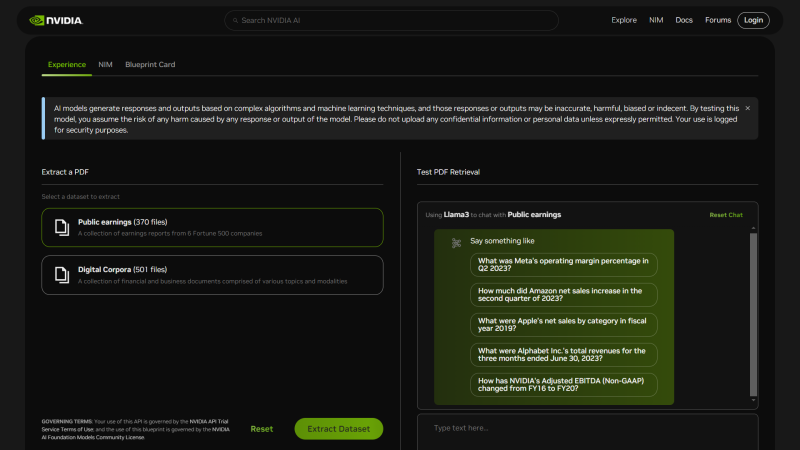

NVIDIA представила шаблоны ИИ-приложений NIM Agent Blueprints для типовых бизнес-задачNVIDIA анонсировала NIM Agent Blueprints, каталог предварительно обученных, настраиваемых программных решений, предоставляющий разработчикам набор инструментов для создания и развёртывания приложений генеративного ИИ для типовых вариантов использования, таких как аватары для обслуживания клиентов, RAG, виртуальный скрининг для разработки лекарственных препаратов и т.д. Предлагая бесплатные шаблоны для частых бизнес-задач, компания помогает разработчикам ускорить создание и вывод на рынок ИИ-приложений. NIM Agent Blueprints включает примеры приложений, созданных с помощью NVIDIA NeMo, NVIDIA NIM и микросервисов партнёров, примеры кода, документацию по настройке и Helm Chart'ы для быстрого развёртывания. Предприятия могут модифицировать NIM Agent Blueprints, используя свои бизнес-данные, и запускать приложения генеративного ИИ в ЦОД и облаках (в том числе в рамках NVIDIA AI Enterprise), постоянно совершенствуя их благодаря обратной связи. На текущий момент NIM Agent Blueprints предлагают готовые рабочие процессы (workflow) для систем обслуживания клиентов, для скрининга с целью автоматизированного поиска необходимых соединений при разработке лекарств и для мультимодального извлечения данных из PDF для RAG, что позволит обрабатывать огромные объёмы бизнес-данных для получения более точных ответов, благодаря чему ИИ-агенты чат-боты службы станут экспертами по темам компании. С примерами можно ознакомиться здесь. Каталог NVIDIA NIM Agent Blueprints вскоре станет доступен у глобальных системных интеграторов и поставщиков технологических решений, включая Accenture, Deloitte, SoftServe и World Wide Technology (WWT). А такие компании как Cisco, Dell, HPE и Lenovo предложат полнофункциональную ИИ-инфраструктуру с ускорителями NVIDIA для развёртывания NIM Agent Blueprints. NVIDIA пообещала, что ежемесячно будут выпускаться дополнительные шаблоны для различных бизнес-кейсов.

25.08.2024 [13:10], Сергей Карасёв

Не только ускорители NVIDIA: разметка данных становится одной из основных причин роста стоимости ИИ-моделейСоздание и обучение мощных ИИ-моделей может обходиться компаниям в сотни миллионов и миллиарды долларов в год. Например, OpenAI в 2024-м намерена потратить на эти цели до $7 млрд. Основная часть затрат приходится на аппаратные ресурсы, включая дорогостоящие ускорители NVIDIA. Но, как сообщает Fortune, существует ещё одна важная статья расходов, которая зачастую упускается из виду — необходимость качественной маркировки данных. Между тем именно эта работа требует всё больших финансовых вложений. Разметка (или маркировка) — процесс идентификации необработанных данных (изображений, текстовых файлов, видео и пр.) и добавления одной или нескольких значимых и информативных меток для обеспечения контекста. Это необходимо для того, чтобы ИИ-модель могла обучаться на таких массивах информации. Разметка данных требуется для различных сценариев использования, включая машинное зрение, обработку естественного языка и распознавание речи. Разметка уже давно используется, например, при разработке ИИ-моделей для беспилотных автомобилей. Камера фиксирует изображения людей, уличных знаков, транспортных средств и светофоров, а комментаторы-люди помечают снимки такими тегами, как «пешеход», «грузовик» или «знак остановки». Это трудоёмкий и кропотливый процесс, который отнимает много времени и требует значительных финансовых вложений. После выпуска ChatGPT в 2022 году OpenAI подверглась широкой критике за аутсорсинг такой работы: компания наняла кенийских работников менее чем за $2/час. Нынешние универсальные большие языковые модели (LLM) проходят обучение с подкреплением на основе отзывов (RLHF). В ходе процедуры люди предоставляют качественную обратную связь или ранжируют то, что генерирует ИИ-модель. Такой подход приводит к значительному увеличению затрат. Ещё одна причина роста расходов при маркировке данных — желание компаний включить в процесс обучения корпоративную информацию, такую как сведения о клиентах или внутренние корпоративные документы. Кроме того, маркировка данных экспертного уровня в таких областях, как юриспруденция, финансы и здравоохранение требует привлечения высококвалифицированных специалистов, оплата труда которых стоит весьма дорого. Поэтому некоторые разработчики перекладывают задачи по разметке данных на сторонние компании, например, Scale AI, которая недавно получила финансирование в размере $1 млрд. Алекс Ратнер (Alex Ratner), генеральный директор стартапа по маркировке данных Snorkel AI, говорит, что корпоративные клиенты могут тратить миллионы долларов на маркировку и обработку информации. Такие операции в некоторых случаях отнимают до 80% времени и бюджета на ИИ. Причём для сохранения актуальности со временем данные должны периодически дополняться и обрабатываться заново. Таким образом, разметка, наряду с необходимостью применения дорогостоящего оборудования, становится одной из основных статей расходов при обучении ИИ-моделей. Некоторые компании снижают затраты, используя синтетические данные — то есть данные, сгенерированные самим ИИ. Последние инновации в области ИИ сделали генерацию синтетических данных эффективной и быстрой, что в ряде случаев позволяет отказаться от применения массивов реальной информации. Однако в некоторых случаях это грозит «самоповторами».

21.08.2024 [15:02], Елена Копытова

AMD взялась за поддержку современных EPYC во FreeBSDПроект FreeBSD опубликовал отчёт за II квартал 2024 года, в котором описана проделанная работа ведущими разработчиками BSD. По данным Phoronix, среди выполненных за последний квартал задач FreeBSD Foundation выделяются проекты по улучшению аудиостека, улучшению OpenZFS, переносу VPP (Vector Packet Processing) на FreeBSD и улучшению поддержки беспроводных сетей. Также стало известно, что AMD и FreeBSD Foundation сотрудничают в разработке полноценного драйвера AMD IOMMU. Цель проекта — улучшить поддержку серверов на базе AMD EPYC во FreeBSD, в том числе с более чем 256 ядрами, сделать интеграцию с системой виртуализации Bhyve и другие усовершенствования. «Продолжалась работа над совместным проектом Advanced Micro Devices (AMD) и FreeBSD Foundation по разработке драйвера AMD IOMMU. Этот драйвер позволит FreeBSD полностью поддерживать более 256 ядер с такими функциями, как отображение [mapping] CPU, а также будет включать интеграцию Bhyve. Константин Белоусов работал над различными частями проекта, включая подключение драйвера, определение регистров, парсер таблиц ACPI и реализацию служебных функций. Два ключевых компонента, которые необходимо доделать, — это обработка контекста, которая в основном является обобщением кода Intel DMAR, и создание таблиц страниц. После этого можно будет активировать драйвер AMD для тестирования. Чтобы следить за работой Константина, ищите коммиты в репозитории с тегом «Sponsored by fields for Advanced Micro Devices (AMD) and The FreeBSD Foundation»», — говорится в отчёте.

Источник изображения: FreeBSD Появление поддержки со стороны AMD для сообщества FreeBSD является значимым событием, поскольку ранее только Intel славилась активным вкладом в развитие проекта и предоставлением инженерных ресурсов на протяжении многих лет. В этом свете интересно, является ли поддержка AMD жестом доброй воли или же у компании есть клиенты, которым необходимы совместимость и оптимизации для FreeBSD. Среди крупных игроков, в инфраструктуре которых активно используется FreeBSD, есть, например, Netflix. В последние годы Arm также начала активно участвовать в развитии ОС. Кроме того, FreeBSD продолжает активную работу по поддержке архитектуры RISC-V. Так, уже существует экспериментальная поддержка Bhyve. Кроме того, одной из новых разработок для ядра FreeBSD стало создание Zcond — легковесного механизма условного выполнения, аналогичного интерфейсу static_key в Linux.

02.08.2024 [08:05], Владимир Мироненко

«Альт Платформа» от «Базальт СПО» сделает сборку ПО и дистрибутивов ОС проще и удобнее«Базальт СПО», российский разработчик ОС семейства «Альт», предложил вниманию разработчиков технологический комплекс «Альт Платформа», который, по словам создателей, имеет всё необходимое для сборки ПО и выпуска дистрибутивов операционных систем и значительно упрощает выполнение этих задач. Решение включено в Единый реестр российского ПО под №21540. «Альт Платформа» может использоваться для широкого круга задач, включая создание специализированных сборок под конкретное оборудование (банкоматы, промышленные контроллеры и т. п.) и под нужды крупных организаций, локализованных ОС, а также для формирования дистрибутивов с предустановленным дополнительным ПО и для разработки прикладного ПО, совместимого с ОС серии «Альт» и другими созданными на «Альт Платформе» дистрибутивами. В состав «Альт Платформы» входят:

«Базальт СПО» готова обучить специалистов заказчика пользоваться программным комплексом «Альт Платформа», вести свой репозиторий и дополнять его сторонним ПО, а также предлагает техническую поддержку трёх уровней: базового, стандартного и расширенного. «Базальт СПО» с 2001 года развивает собственную инфраструктуру разработки, на которой создано уже десять поколений операционных систем. Её центральное звено — бесплатный репозиторий «Сизиф» — один из крупнейших в мире технологически независимых репозиториев, наряду с Debian, Red Hat и SUSE. Репозиторий формируется из свободного ПО международных проектов и собственных разработок компании. Он поддерживается «Базальт СПО» и находится на территории и под юрисдикцией РФ. Каждые несколько лет разработчики «Базальт СПО» выделяют из «Сизифа» бранч — стабильную ветку репозитория. Все помещаемые в него пакеты тестируются, уязвимости исправляются и для всех них обеспечивают совместимость, благодаря чему формируется банк проверенных пакетов с системой контроля зависимостей, на основе которого выпускаются дистрибутивы. Помимо бинарных пакетов в стабильный бранч входит исходный код практически всех пакетов. Бранч можно использовать как для обновления ОС «Альт», так и для создания и обновления собственных дистрибутивов.

26.07.2024 [14:37], Руслан Авдеев

Швейцарские власти переходят на открытое ПОНесколько европейских стран уже делают ставку на открытое ПО (open source) для государственного сектора. По данным ZDNet, на этот раз важный шаг навстречу открытым программным решениям сделала Швейцария, приняв «Федеральный закон об использовании электронных средств выполнения государственных задач» (EMBAG). В частности, он предписывает использование открытого ПО в государственном секторе. Новый закон требует от всех государственных органов раскрыть код программного обеспечения, разработанного ими или для них, за исключением случаев, когда это нецелесообразно по соображениям безопасности или нарушает сторонние права. Такой подход должен способствовать прозрачности, безопасности и эффективности правительственной деятельности. Подобный переход осуществить нелегко. В 2011 году Федеральный верховный суд Швейцарии (Swiss Federal Supreme Court) опубликовал судебное приложение Open Justitia под открытой лицензией. Компания Weblaw, занимающаяся проприетарным юридическим ПО, выступила категорически против такого решения. Разбирательства длились более 10 лет, пока в 2023 году не был принят закон EMBAG. Он не просто разрешает публиковать код программного обеспечения органам власти или их подрядчиками под открытой лицензией, но и требует этого — с учётом названных исключений.

Источник изображения: Henrique Ferreira/unsplash.com По словам сторонников закона, EMBAG открывает большие возможности для правительства, IT-индустрии и общества. Предполагается, что государственный сектор избавится от зависимости от конкретных вендоров, у компаний появится больше возможностей для развития своих цифровых решений, что потенциально позволит снизить себестоимость информационных технологий и улучшить обслуживание налогоплательщиков. Дополнительно EMBAG предписывает публикацию неперсональных и не несущих угрозу безопасности государственных данных в формате Open Government Data (OGD). Другими словами, открытость данных по умолчанию обеспечит большую открытость и многократное практическое применение ПО и информации. Применение EMBAG может послужить примером и другим странам, рассматривающим аналогичные меры. Закон предназначен для продвижения концепции цифрового суверенитета и поощряет инновации и сотрудничество в пределах структур государственного сектора. Федеральное статистическое управление Швейцарии (Swiss Federal Statistical Office, BFS) возглавит применение закона, но организационные и финансовые аспекты всё ещё предстоит прояснить. Некоторые другие страны Европы уже довольно давно поддерживают open source в госструктурах. Например, Национальная жандармерия Франции давно пользуется Linux, а Евросоюз в целом давно способствует продвижению open source с помощью проекта Free and Open Source Software Auditing (FOSSA), направленного на проверку ПО с открытым кодом. Впрочем, многие опасаются, что Еврокомиссия урежет финансирование фонду NGI Zero Commons — важному источнику средств для открытых разработок. В США поддержка «открытой» концепции гораздо ниже, чем в Европе. Доктрина Federal Source Code Policy предписывает федеральным органам делать открытым не менее 20 % выпускаемого ими кода. При этом использование open source решений не обязательно. Управление общих служб США (GSA) также предписывает своим структурам публиковать открытый исходный код, продвигая политику «открытость в первую очередь» при разработке ПО. Другими словами, пока Швейцария фактически является одним из мировых лидеров движения за внедрение open source, Европе и США придётся проделать в этом направлении ещё немало работы.

26.07.2024 [11:10], Владимир Мироненко

OS DAY 2024 в поисках новых средств безопасности

software

импортозамещение

информационная безопасность

мероприятие

операционная система

разработка

сделано в россии

Инженерные и архитектурные решения в обеспечении безопасности операционных систем обсуждали в Москве на XI научно-практической конференции OS DAY 2024. Более 700 представителей российской ИТ-отрасли из разных регионов России и постсоветского пространства принимали участие в обсуждениях и выступали с докладами в зале РЭУ имени Г.В. Плеханова, слушали выступления онлайн. Организатором конференции традиционно выступил консорциум ведущих российских вендоров операционных систем в составе ИСП РАН, НИЦ «Институт имени Н.Е. Жуковского», «Лаборатории Касперского», компаний НТП «Криптософт», «Открытая мобильная платформа», Группа Астра, «Базальт СПО», РЕД СОФТ и НТЦ ИТ РОСА. И разумеется, что обсуждались на OS DAY 2024 вопросы, важные для всего сектора системного программирования. Речь шла о различных подходах к построению безопасной архитектуры операционных систем и преимуществах разных подходов к их созданию — на основе закрытого кода и с использованием Open Source, — о применении принципа secure-by-design, автоматизации процессов анализа безопасности, инструментах доверенной разработки и доверенной загрузки, анализа кода, мониторинга и диагностики. Прозвучало несколько докладов об отечественных операционных системах для мобильных устройств. Отдельное выступление было посвящено разработке нового национального стандарта «Доверенная среда исполнения», а в ходе круглого стола «Национальные стандарты по разработке безопасного программного обеспечения» состоялось бурное обсуждение перспектив внедрения разработанного представителями ИТ-отрасли совместно с государственными регуляторами ГОСТ Р 56939 «Защита информации. Разработка безопасного программного обеспечения. Общие требования». Этот документ, стандартизирующий даже не программные продукты, а процессы их разработки, должен вступить в действие до конца текущего года. А стандартизация и сертификация процессов призвана обеспечить более высокое качество исходного кода, усилить безопасность системного ПО. Однако даже этот подход ещё не гарантирует создания кибериммунной операционной системы. Конечно, руководитель управления перспективных технологий «Лаборатории Касперского» Андрей Духвалов сказал на открытии конференции, что настала пора перейти с наложенных средств — антивирусов, фаейрволов, анти-DDoSа и множества других подобных технологий, которые не в полной мере могут защитить ОС, к системному подходу в разработке доверенного ПО, не требующего дополнительных средств безопасности. «Такой переход не произойдёт ещё долго, — подтвердил Олег Шапошников, начальник отдела ИБ компании РЕД СОФТ. — Код, который сегодня разрабатывается человеком, несовершенен, и какие бы защитные меры не принимались, как бы этот код не исследовался, он уязвим к ошибкам разного рода. А ошибки приводят к появлению и уязвимостей, и угроз безопасности. Поэтому полностью исключить пусть иногда даже взаимно дублирующие средства не получится: там, где не сработает одно, поможет другое». «Внешние системы безопасности и безопасность на уровне кода не исключают друг друга, а дополняют, — подчеркнул Арутюн Аветисян, директор ИСП РАН. — Переход идёт не от внешних систем безопасности к безопасности на уровне кода, а от полного игнорирования безопасности на уровне кода к формированию более адекватной позиции. Сейчас этот переход далёк от завершения, большинство разработчиков все еще воспринимает безопасность на уровне кода просто как требование регуляторов». «Даже самый совершенный антивирус может не обнаружить какие-то вредоносные программы, — отметил Алексей Киселев, руководитель направления разработки операционных систем, РОСА. — Поэтому исходный код нужно подвергать статическому анализу, проверять его на наличие ошибок и уязвимостей. В принципе, для продуктов, которые готовятся к сертификации во ФСТЭК, такой анализ обязателен. Мы его также проходим. Например, у нас в сборочную систему встроен анализатор, который при сборке пакета проводит анализ исходного кода». «Сегодня необходимо не только внедрение подобных практик в создание программного обеспечения, — уточнил Роман Мылицын, руководитель отдела перспективных исследований и специальных проектов Группы Астра, — но и развитие инструментов безопасной разработки, статического и динамического анализа кода, композиционного анализа и контроля цепочек поставки. Отечественные компании находятся на стадии внедрения таких инструментов, а мы ожидаем рост спроса на услуги в этой области». «Обеспечение безопасности ОС — непрерывный динамический процесс, — подчеркнул Алексей Новодворский, советник генерального директора компании «Базальт СПО». — Практически каждая новая версия программы закрывает одни уязвимости и может внести другие. Старые версии со временем перестают поддерживаться апстримом, и вся сложность контроля за их безопасностью ложится на вендора. Защищённость ОС требует его высокой квалификации и немалых ресурсов». Судя по всему, новый национальный стандарт, обсуждавшийся на круглом столе, неизбежно вынудит разработчиков системного программного обеспечения тратить ресурсов еще больше. Нововведение подразумевает разный объем инвестиций для разных компаний, в зависимости от того, какой объем кода им предстоит анализировать, чтобы соответствовать выдвигаемым требованиям. Есть компании, у которых огромные продукты с миллионами строк кода, в том числе и заимствованного. Соблюдение рамок нового ГОСТа потребует соответствующих значительных вложений. Это неминуемо приведёт к тому, что на рынке окажется меньше игроков, которые смогут действительно «потянуть» выдвинутые требования, сформируется ограниченный пул компаний, способных создавать сертифицированное ПО для государственного сектора. Это усилит конкуренцию и приведёт к росту качества программных продуктов. Мало того, как показывают последние события, например, глобальный сбой ОС Windows, ударивший и по конечным пользователям, и по критичной инфраструктуре в большинстве стран мира, введение подобных «рамок» для разработчиков ОС позволит усилить безопасность программных продуктов. Будь они проприетарными или созданными на базе Open Source. Насколько верным окажется этот прогноз, можно будет узнать из первых уст следующим летом, на XII конференции OS DAY. Ее организаторы планируют, что она так же, как в этом году, пройдёт на базе Российского экономического университета имени Г.В. Плеханова. |

|