Материалы по тегу: компьютер

|

22.05.2023 [09:00], Сергей Карасёв

NVIDIA анонсировала суперкомпьютер Isambard 3 на базе собственных Arm-процессоров GraceКомпания NVIDIA анонсировала проект Isambard 3 — это система высокопроизводительных вычислений, которая расположится в Научном парке Бристоля и Бата в Великобритании. Комплекс будет применяться при решении сложных задач в области ИИ, медицины, астрофизики, биотехнологий и пр. Инициативу возглавляет Бристольский университет в составе исследовательского консорциума GW4 Alliance. Кроме того, в проекте принимают участие Университеты Бата, Кардиффа и Эксетера. Строительством суперкомпьютера займётся компания HPE. В основу Isambard 3 лягут 384 суперпроцессора NVIDIA Grace с ядрами Arm Neoverse. Утверждается, что по производительности и энергетической эффективности система в шесть раз превзойдёт своего предшественника — комплекс Isambard 2. В частности пиковое быстродействие FP64 составит 2,7 Пфлопс при энергопотреблении менее 270 кВт. Это позволит комплексу войти в число трёх наиболее энергоэффективных суперкомпьютеров мира, в которых не используются ускорители. Isambard 3 поможет в создании подробных моделей исключительно сложных структур, объектов и установок, таких как ветряные электростанции и термоядерные реакторы. Новая система также продолжит выполнение задач, которыми ранее занималась машина Isambard 2: это исследование на молекулярном уровне, связанные с болезнью Паркинсона, лечением остеопороза и поиском новых препаратов от COVID-19. Суперкомпьютер Isambard 3, как ожидается, позволит Европейскому научно-исследовательскому сообществу ускорить реализацию проектов в ряде важных областей. Ввод системы в эксплуатацию намечен на весну 2024 года.

21.05.2023 [22:50], Сергей Карасёв

HPE создаст для Японии суперкомпьютер TSUBAME4.0 производительностью 66,8 ПфлопсКомпания HPE объявила о заключении соглашения с Глобальным научно-информационным вычислительным центром Токийского технологического института (Япония) о создании нового суперкомпьютера под названием TSUBAME4.0. Полностью ввести эту систему в эксплуатацию планируется весной 2024 года. TSUBAME4.0 будет применяться для обучения больших ИИ-моделей и запуска ресурсоёмких приложений в области аналитики данных. В основу суперкомпьютера ляжет платформа HPE Cray XD6500, которая, как утверждается, обеспечивает высокую производительность и специализированные возможности при выполнении нагрузок, связанных с моделированием, а также ИИ. Заявленное пиковое быстродействие TSUBAME4.0 составит 66,8 Пфлопс (FP64). В случае вычислений половинной точности (FP16) показатель достигнет 952 Пфлопс — это в 20 раз больше по сравнению с мощностью суперкомпьютера предыдущего поколения TSUBAME3.0.

Источник изображения: HPE Вычислительный комплекс TSUBAME4.0 получит 240 узлов, оснащённых двумя процессорами AMD EPYC Genoa, четырьмя ускорителями NVIDIA H100 и 768 Гбайт основной памяти. Говорится о высокой плотности размещения аппаратных компонентов, что позволит уменьшить занимаемую площадь в дата-центре. Задействован 400G-интерконнект NVIDIA Quantum-2 InfiniBand. Отмечается, что в целом архитектура TSUBAME4.0 аналогична системам TSUBAME предыдущих поколений. Благодаря этому возможно использование ранее созданных программных решений, что поможет ускорить реализацию новых НРС-проектов.

17.05.2023 [23:09], Руслан Авдеев

В Нидерландах QMware и QuiX Quantum создадут первый гибридный ЦОД с квантовыми и HPC-технологиямиQMware и QuiX Quantum объявили о создании в нидерландском Энсхеде гибридного дата-центра, в котором сочетается классическая HPC-инфраструктура с квантовыми технологиями. Как сообщает Inside HPC, речь идёт о первой интегрированной гибридной системе такого типа. Ожидается, что ЦОД будет готов к коммерческому использованию уже в августе 2023 года. Пока известно, что проприетарное программное обеспечение QMware позволяет объединить принципиально разные аппаратные вычислительные системы, способные использовать общую память. Повышенные вычислительные мощности позволят обеспечивать более точные результаты, а благодаря QuiX Quantum с её масштабируемой технологией, можно использовать системы для самых разных ресурсоёмких задач.

Источник изображения: QuiX Quantum Квантовый компьютер компании QuiX Quantum оптимально подходит для гибридной системы, поскольку способен работать при комнатной температуре и легко масштабируется. Для соединения с HPC-инфраструктурой используется оптоволоконное подключение. Управление системой обеспечит унифицированная версия Linux — в сравнении с существующими гибридными решениями новая инфраструктура намного производительнее и экономичнее. Если существующие гибридные системы обычно требуют веб-интеграции квантовой составляющей и HPC-оборудования, то в данном случае этого не требуется, взаимодействие на одной площадке обеспечивает проприетарное железо и ПО Qmware. В результате конечные клиенты получают одновременный доступ к мощностям обоих типов с низкой задержкой. Представителями партнёров ожидают, что использование гибридной инфраструктуры позволит обрабатывать данные в некоторых приложениях до 10 раз быстрее. По словам представителя QuiX Quantum, компания намерена обеспечить использование квантовых технологий в прикладной сфере. По его мнению, оптимизация энергосетей, цепочек поставок или дорожного движения — лишь немногие из сфер, где, возможно, будут применяться гибридные технологии при сотрудничестве с Qmware. Квантовые компьютеры довольно активно покупаются и используются операторами ЦОД, в том числе речь идёт и о гибридных системах. Так, только в марте этого года NVIDIA представила систему DGX Quantum для гибридных квантово-классических вычислений.

11.05.2023 [01:38], Владимир Мироненко

ИИ-суперкомпьютер для богатых: теперь в облаке Google Cloud можно получить сразу 26 тыс. ускорителей NVIDIA H100Компания Google Cloud представила на конференции для разработчиков Google I/O инстансы Google Compute Engine A3, специально созданные для обеспечения максимальной производительности рабочих нагрузок машинного обучения. Новинки используют современные CPU, быструю память, ускорители NVIDIA и IPU Intel. Виртуальная машина A3 включает:

Помимо того, что новые инстансы используют DPU/IPU Mount Evans, разработанные совместно с Intel, кластеры A3 также задействуют фирменные оптические коммутаторы Google Jupiter с возможность переконфигурации топологии по требованию, которые компания уже использует в кластерах с собственными ИИ-ускорителями. Всё это позволяет объединять до 26 тыс. ускорителей H100 в облачный ИИ-суперкомпьютер производительность до 26 Эфлопс (TF32). Ключевое отличие от других облачных предложений именно в интерконнекте и масштабируемости. Например, ИИ-суперкомпьютеры в Microsoft Azure объединяют тысячи и даже десятки тысяч ускорителей с использованием InfiniBand и DPU NVIDIA. В Oracle Cloud Infrastructure (OCI), где ранее был поставлен рекорд по объединению 32 768 ускорителей, используется тот же подход. Наконец, в AWS можно объединить до 20 тыс. ускорителей благодаря EFA. Google предложит клиентам несколько вариантов использования A3: клиенты смогут запускать ВМ самостоятельно или в качестве управляемого сервиса, где Google возьмёт на себя большую часть работы. Возможно использование A3 в Google Kubernetes Engine (GKE) или в Vertex AI. В настоящее время виртуальные машины A3 доступны только после регистрации в списке ожидания превью. Сейчас компания занята развёртыванием множественных кластеров A3 в наиболее крупных облачных регионах.

21.03.2023 [19:15], Сергей Карасёв

NVIDIA представила систему DGX Quantum для гибридных квантово-классических вычисленийКомпания NVIDIA в партнёрстве с Quantum Machines анонсировала DGX Quantum — первую систему, объединяющую GPU и квантовые вычисления. Решение использует новую открытую программную платформу CUDA Quantum. Утверждается, что система предоставляет революционно архитектуру для исследователей, работающими с гибридными вычислениями с низкой задержкой. NVIDIA DGX Quantum объединяет средства ускоренных вычислений на базе Grace Hopper (Arm-процессор + ускоритель H100), модели программирования с открытым исходным кодом CUDA Quantum и передовую квантовую управляющую платформу Quantum Machines OPX+. Такая комбинация позволяет создавать ресурсоёмкие приложения, сочетающие квантовые вычисления с современными классическими вычислениями. При этом в числе прочего обеспечивается работа гибридных алгоритмов и коррекция ошибок.

Источник изображения: NVIDIA Представленное решение предполагает соединение Grace Hopper и Quantum Machines OPX+ посредством интерфейса PCIe. Это обеспечивает задержку менее микросекунды между ускорителем и блоками квантовой обработки (QPU). Отмечается, что OPX+ — это универсальная система квантового управления. Таким образом, можно максимизировать производительность QPU и предоставить разработчикам новые возможности при использовании квантовых алгоритмов. Системы Grace Hopper и OPX+ можно масштабировать в соответствии с потребностями — от QPU с несколькими кубитами до суперкомпьютера с квантовым ускорением. О намерении интегрировать CUDA Quantum в свои платформы уже заявили компании по производству квантового оборудования Anyon Systems, Atom Computing, IonQ, ORCA Computing, Oxford Quantum Circuits и QuEra, разработчики ПО Agnostiq и QMware, а также некоторые суперкомпьютерные центры.

29.11.2022 [12:20], Сергей Карасёв

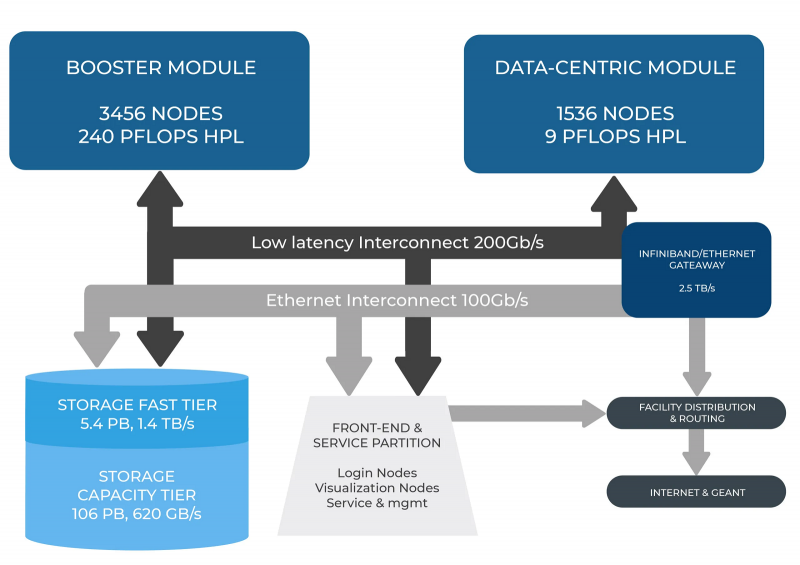

В Италии официально запущен суперкомпьютер Leonardo — четвёртая по мощности HPC-система в миреСовместная инициатива по высокопроизводительным вычислениям в Европе EuroHPC JU и некоммерческий консорциум CINECA, состоящий из 69 итальянских университетов и 21 национальных исследовательских центров, провели церемонию запуска суперкомпьютера Leonardo. В основу комплекса положены платформы Atos BullSequana X2610 и X2135. Система Leonardo состоит из двух секций — общего назначения и с ускорителями вычислений (Booster). Когда строительство системы будет завершено, первая будет включать 1536 узлов, каждый из которых содержит два процессора Intel Xeon Sapphire Rapids с 56 ядрами и TDP в 350 Вт, 512 Гбайт оперативной памяти DDR5-4800, интерконнект NVIDIA InfiniBand HDR100 и NVMe-накопитель на 8 Тбайт.

Источник изображения: HPCwire Секция Booster объединяет 3456 узлов, каждый из которых содержит один чип Intel Xeon 8358 с 32 ядрами, 512 Гбайт ОЗУ стандарта DDR4-3200, четыре кастомных ускорителя NVIDIA A100 с 64 Гбайт HBM2-памяти, а также два адаптера NVIDIA InfiniBand HDR100. Кроме того, в состав комплекса входят 18 узлов для визуализации: 6,4 Тбайт NVMe SSD и два ускорителя NVIDIA RTX 8000 (48 Гбайт) в каждом. Вычислительный комплекс объединён фабрикой с топологией Dragonfly+. Для хранения данных служит двухуровневая система. Производительный блок (5,4 Пбайт, 1400 Гбайт/с) содержит 31 модуль DDN Exascaler ES400NVX2, каждый из которых укомплектован 24 NVMe SSD вместимостью 7,68 Тбайт и четырьмя адаптерами InfiniBand HDR. Второй уровень большой ёмкости (106 Пбайт, чтение/запись 744/620 Гбайт/с) состоит из 31 массива DDN EXAScaler SFA799X с 82 SAS HDD (7200 PRM) на 18 Тбайт и четырьмя адаптерами InfiniBand HDR. Каждый из массивов включает два JBOD-модуля с 82 дисками на 18 Тбайт. Для хранения метаданных используются 4 модуля DDN EXAScaler SFA400NVX: 24 × 7,68 Тбайт NVMe + 4 × InfiniBand HDR. В настоящее время Leonardo обеспечивает производительность более 174 Пфлопс. Ожидается, что суперкомпьютер будет полностью запущен в первой половине 2023 года, а его пиковое быстродействие составит 250 Пфлопс. Уже сейчас система занимает четвёртое место в последнем рейтинге самых мощных суперкомпьютеров мира TOP500. В Европе Leonardo является второй по мощности системой после LUMI. Leonardo оборудован системой жидкостного охлаждения для повышения энергоэффективности. Кроме того, предусмотрена возможность регулировки энергопотребления для обеспечения баланса между расходом электричества и производительностью. Суперкомпьютер ориентирован на решение высокоинтенсивных вычислительных задач, таких как обработка данных, ИИ и машинное обучение. Половина вычислительных ресурсов Leonardo будет предоставлена пользователям EuroHPC.

10.11.2022 [17:15], Владимир Мироненко

HPE анонсировала недорогие, энергоэффективные и компактные суперкомпьютеры Cray EX2500 и Cray XD2000/6500Hewlett Packard Enterprise анонсировала суперкомпьютеры HPE Cray EX и HPE Cray XD, которые отличаются более доступной ценой, меньшей занимаемой площадью и большей энергоэффективностью по сравнению с прошлыми решениями компании. Новинки используют современные технологии в области вычислений, интерконнекта, хранилищ, питания и охлаждения, а также ПО.

Изображение: HPE Суперкомпьютеры HPE обеспечивают высокую производительность и масштабируемость для выполнения ресурсоёмких рабочих нагрузок с интенсивным использованием данных, в том числе задач ИИ и машинного обучения. Новинки, по словам компании, позволят ускорить вывода продуктов и сервисов на рынок. Решения HPE Cray EX уже используются в качестве основы для больших машин, включая экзафлопсные системы, но теперь компания предоставляет возможность более широкому кругу организаций задействовать супервычисления для удовлетворения их потребностей в соответствии с возможностями их ЦОД и бюджетом. В семейство HPE Cray вошли следующие системы:

Все три системы задействуют те же технологии, что и их старшие собратья: интерконнект HPE Slingshot, хранилище Cray Clusterstor E1000 и пакет ПО HPE Cray Programming Environment и т.д. Система HPE Cray EX2500 поддерживает процессоры AMD EPYC Genoa и Intel Xeon Sapphire Rapids, а также ускорители AMD Instinct MI250X. Модель HPE Cray XD6500 поддерживает чипы Sapphire Rapids и ускорители NVIDIA H100, а для XD2000 заявлена поддержка AMD Instinct MI210. В качестве примеров выгод от использования анонсированных суперкомпьютеров в разных отраслях компания назвала:

05.09.2022 [23:00], Алексей Степин

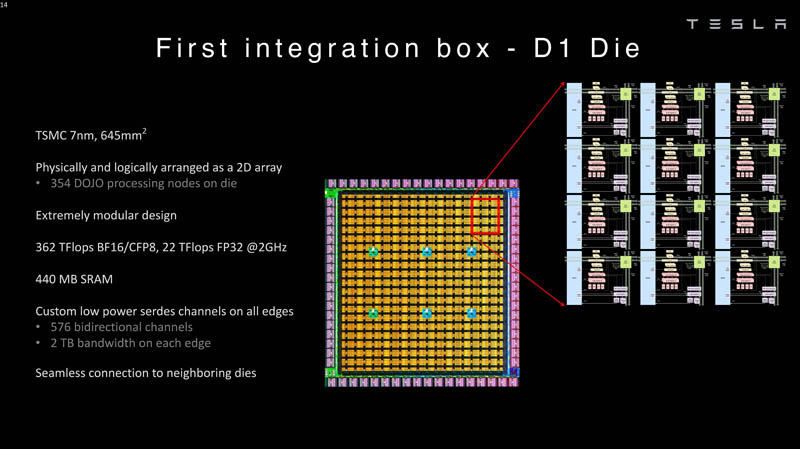

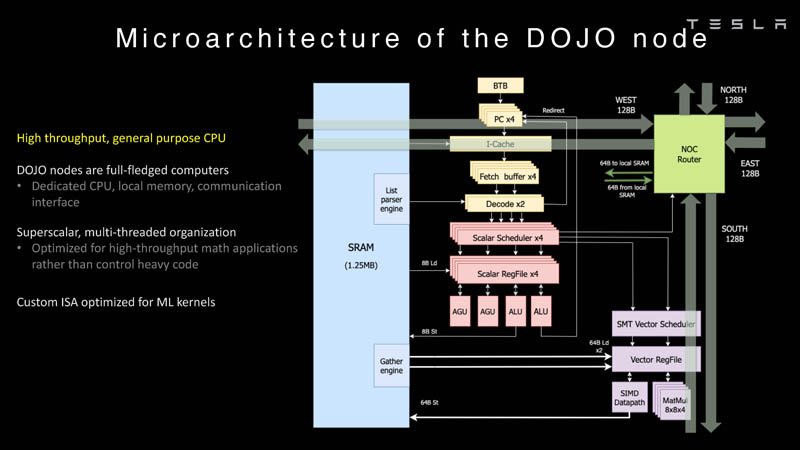

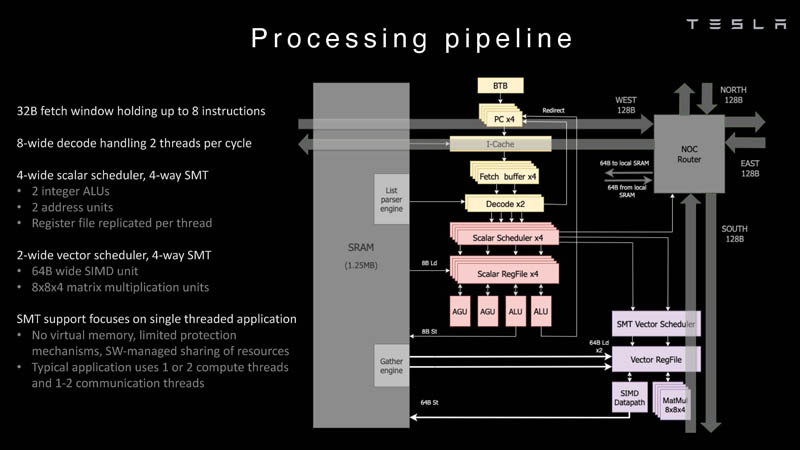

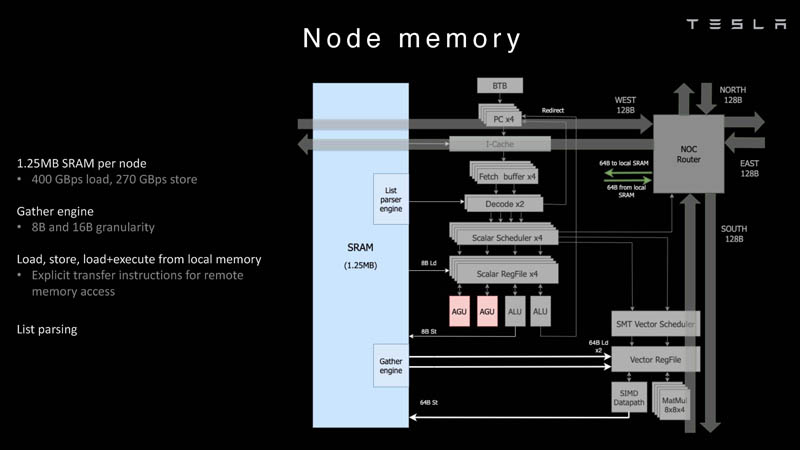

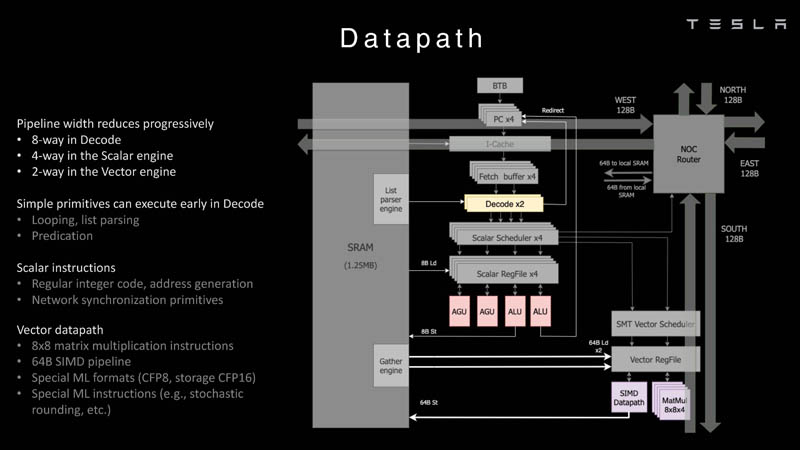

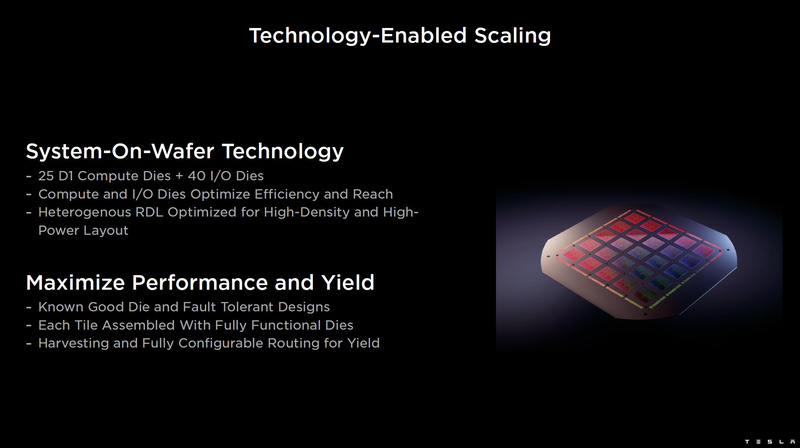

Tesla рассказала подробности о чипах D1 собственной разработки, которые станут основой 20-Эфлопс ИИ-суперкомпьютера DojoКомпания Tesla уже анонсировала собственный, созданный в лабораториях компании процессор D1, который станет основой ИИ-суперкомпьютера Dojo. Нужна такая система, чтобы создать для ИИ-водителя виртуальный полигон, в деталях воссоздающий реальные ситуации на дорогах. Естественно, такой симулятор требует огромных вычислительных мощностей: в нашем мире дорожная обстановка очень сложна, изменчива и включает множество факторов и переменных. До недавнего времени о Dojo и D1 было известно не так много, но на конференции Hot Chips 34 было раскрыто много интересного об архитектуре, устройстве и возможностях данного решения Tesla. Презентацию провел Эмиль Талпес (Emil Talpes), ранее 17 лет проработавший в AMD над проектированием серверных процессоров. Он, как и ряд других видных разработчиков, работает сейчас в Tesla над созданием и совершенствованием аппаратного обеспечения компании.

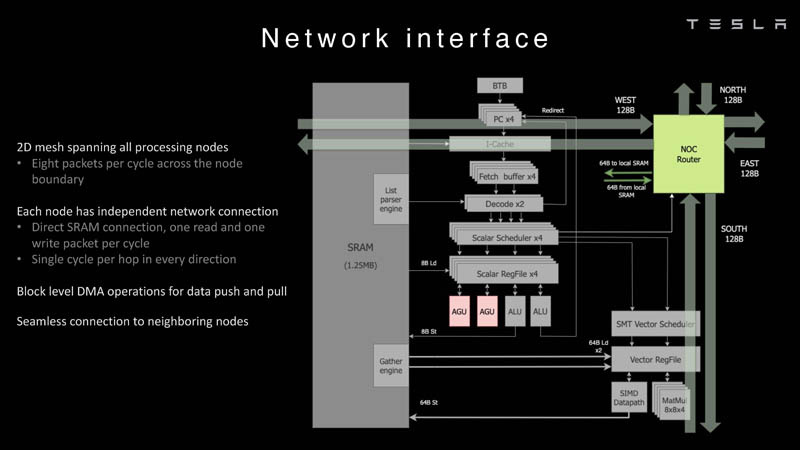

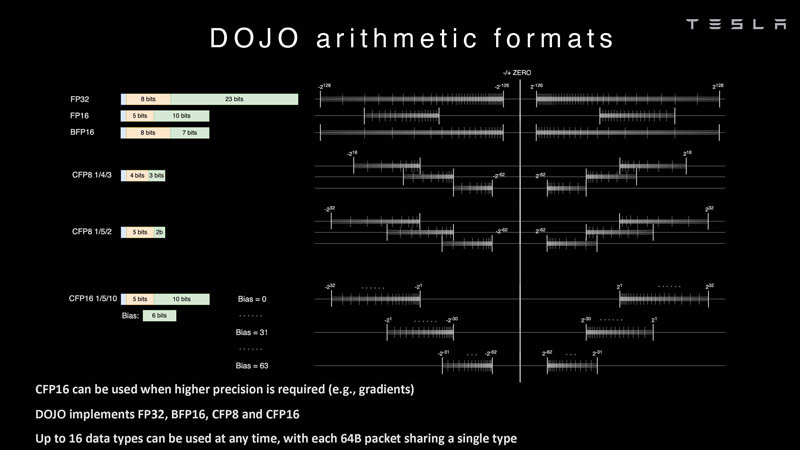

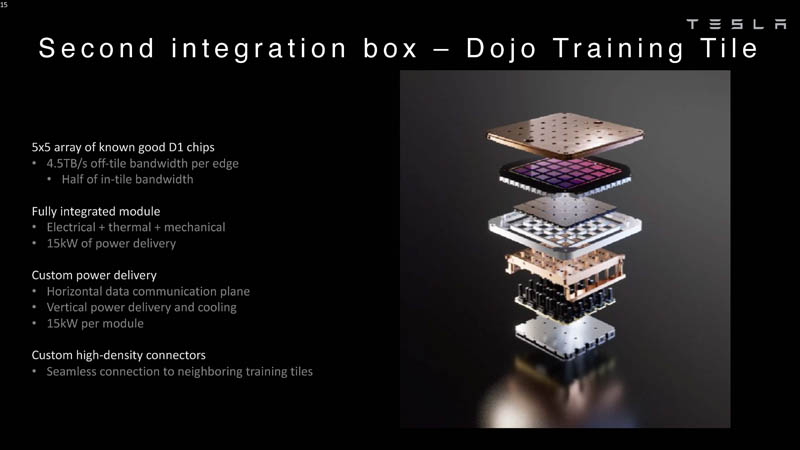

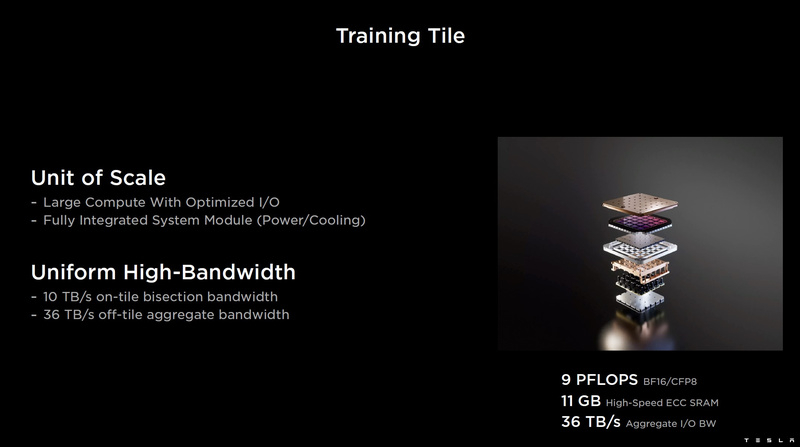

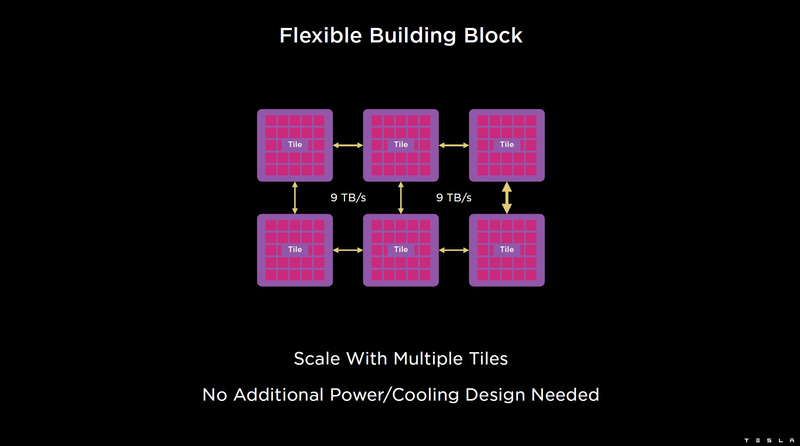

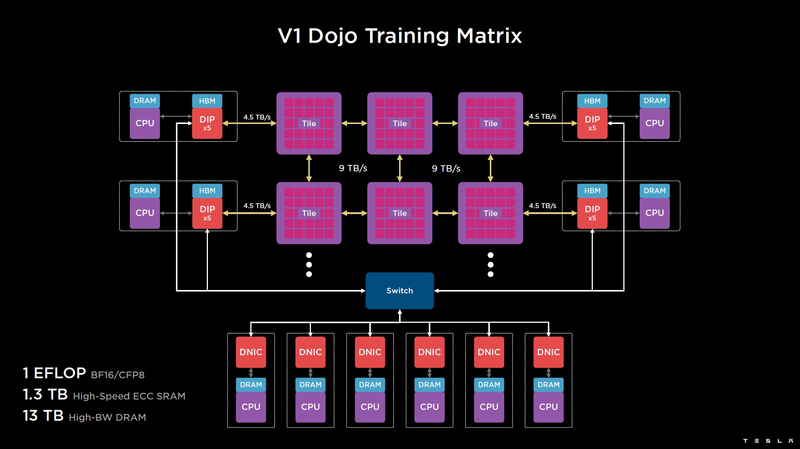

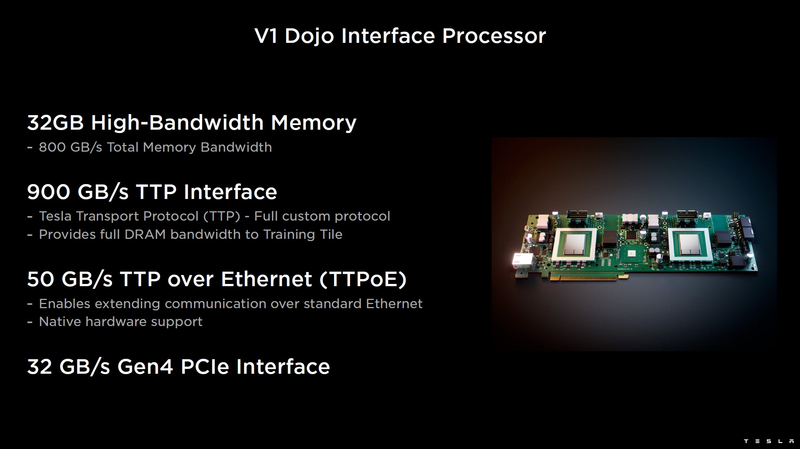

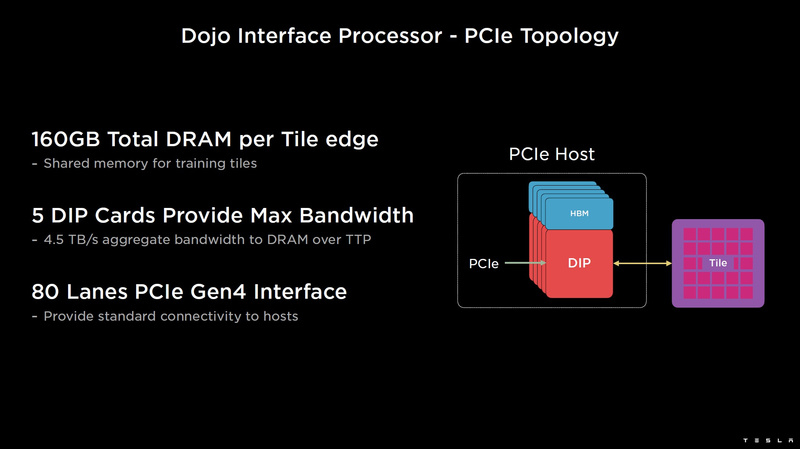

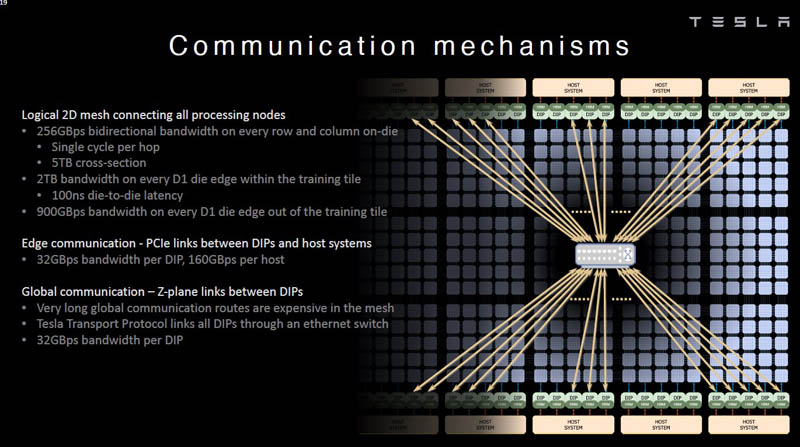

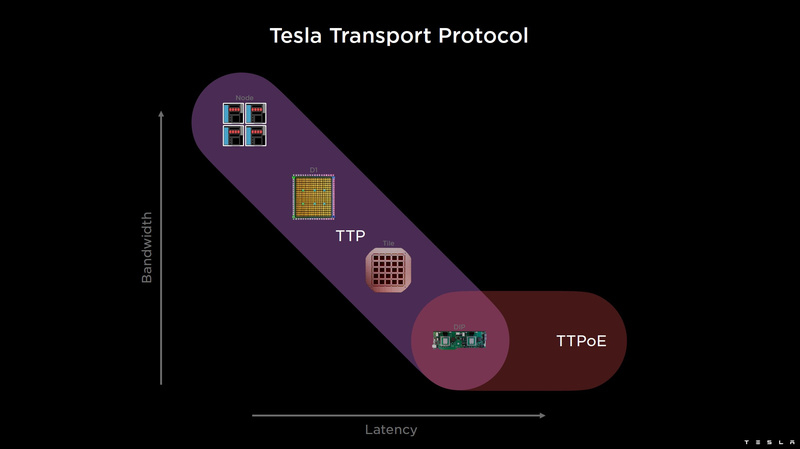

Изображения: Tesla (via ServeTheHome) Главной идеей D1 стала масштабируемость, поэтому в начале разработки нового чипа создатели активно пересмотрели роль таких традиционных концепций, как когерентность, виртуальная память и т.д. — далеко не все механизмы масштабируются лучшим образом, когда речь идёт о построении действительно большой вычислительной системы. Вместо этого предпочтение было отдано распределённой сети хранения на базе SRAM, для которой был создан интерконнект, на порядок опережающий существующие реализации в системах распределённых вычислений.  Основой процессора Tesla стало ядро целочисленных вычислений, базирующееся на некоторых инструкциях из набора RISC-V, но дополненное большим количеством фирменных инструкций, оптимизированных с учётом требований, предъявляемых ядрами машинного обучения, используемыми компанией. Блок векторной математики был создан практически с нуля, по словам разработчиков.  Набор инструкций Dojo включает в себя скалярные, матричные и SIMD-инструкции, а также специфические примитивы для перемещения данных из локальной памяти в удалённую, равно как и семафоры с барьерами — последние требуются для согласования работы c памятью во всей системе. Что касается специфических инструкций для машинного обучения, то они реализованы в Dojo аппаратно.  Первенец в серии, чип D1, не является ускорителем как таковым — компания считает его высокопроизводительным процессором общего назначения, не нуждающимся в специфических ускорителях. Каждый вычислительный блок Dojo представлен одним ядром D1 с локальной памятью и интерфейсами ввода/вывода. Это 64-бит ядро суперскалярно.  Более того, в ядре реализована поддержка многопоточности (SMT4), которая призвана увеличить производительность на такт (а не изолировать разные задачи друг от друга), поэтому виртуальную память данная реализация SMT не поддерживает, а механизмы защиты довольно ограничены в функциональности. За управление ресурсами Dojo отвечает специализированный программный стек и фирменное ПО.  64-бит ядро имеет 32-байт окно выборки (fetch window), которое может содержать до 8 инструкций, что соответствует ширине декодера. Он, в свою очередь, может обрабатывать два потока за такт. Результат поступает в планировщики, которые отправляют его в блок целочисленных вычислений (два ALU) или в векторный блок (SIMD шириной 64 байт + перемножение матриц 8×8×4).  У каждого ядра D1 есть SRAM объёмом 1,25 Мбайт. Эта память — не кеш, но способна загружать данные на скорости 400 Гбайт/с и сохранять на скорости 270 Гбайт/с, причём, как уже было сказано, в чипе реализованы специальные инструкции, позволяющие работать с данными в других ядрах Dojo. Для этого в блоке SRAM есть свои механизмы, так что работа с удалённой памятью не требуют дополнительных операций.  Что касается поддерживаемых форматов данных, то скалярный блок поддерживает целочисленные форматы разрядностью от 8 до 64 бит, а векторный и матричный блоки — широкий набор форматов с плавающей запятой, в том числе для вычислений смешанной точности: FP32, BF16, CFP16 и CFP8. Разработчики D1 пришли к использованию целого набора конфигурируемых 8- и 16-бит представлений данных — компилятор Dojo может динамически изменять значения мантиссы и экспоненты, так что система может использовать до 16 различных векторных форматов, лишь бы в рамках одного 64-байт блока данных он не менялся.  Как уже упоминалось, топология D1 использует меш-структуру, в которой каждые 12 ядер объединены в логический блок. Чип D1 целиком представляет собой массив размером 18×20 ядер, однако доступны лишь 354 ядра из 360 присутствующих на кристалле. Сам кристалл площадью 645 мм2 производится на мощностях TSMC с использованием 7-нм техпроцесса. Тактовая частота составляет 2 ГГц, общий объём памяти SRAM — 440 Мбайт.  Процессор D1 развивает 362 Тфлопс в режиме BF16/CFP8, в режиме FP32 этот показатель снижается до 22 Тфлопс. Режим FP64 векторными блоками D1 не поддерживается, поэтому для многих традиционных HPC-нагрузок данный процессор не подойдёт. Но Tesla создавала D1 для внутреннего использования, поэтому совместимость её не очень волнует. Впрочем, в новых поколениях, D2 или D3, такая поддержка может появиться, если это будет отвечать целям компании.  Каждый кристалл D1 имеет 576-битный внешний интерфейс SerDes с совокупной производительностью по всем четырём сторонам, составляющей 18 Тбайт/с, так что узким местом при соединении D1 он явно не станет. Этот интерфейс объединяет кристаллы в единую матрицу 5х5, такая матрица из 25 кристаллов D1 носит название Dojo training tile.  Этот тайл выполнен как законченный термоэлектромеханический модуль, имеющий внешний интерфейс с пропускной способностью 4,5 Тбайт/с на каждую сторону, совокупно располагающий 11 Гбайт памяти SRAM, а также собственную систему питания мощностью 15 кВт. Вычислительная мощность одного тайла Dojo составляет 9 Пфлопс в формате BF16/CFP8. При таком уровне энергопотребления охлаждение у Dojo может быть только жидкостное.  Тайлы могут объединяться в ещё более производительные матрицы, но как именно физически организован суперкомпьютер Tesla, не вполне ясно. Для связи с внешним миром используются блоки DIP — Dojo Interface Processors. Это интерфейсные процессоры, посредством которых тайлы общаются с хост-системами и на долю которых отведены управляющие функции, хранение массивов данных и т.п. Каждый DIP не просто выполняет IO-функции, но и содержит 32 Гбайт памяти HBM (не уточняется, HBM2e или HBM3).  DIP использует полностью свой транспортный протокол (Tesla Transport Protocol, TTP), разработанный в Tesla и обеспечивающий пропускную способность 900 Гбайт/с, а поверх Ethernet — 50 Гбайт/с. Внешний интерфейс у карточек — PCI Express 4.0, и каждая интерфейсная карта несёт пару DIP. С каждой стороны каждого ряда тайлов установлено по 5 DIP, что даёт скорость до 4,5 Тбайт/с от HBM-стеков к тайлу.  В случаях, когда во всей системе обращение от тайла к тайлу требует слишком много переходов (до 30 в случае обращения от края до края), система может воспользоваться DIP, объединённых снаружи 400GbE-сетью по топологии fat tree, сократив таким образом, количество переходов до максимум четырёх. Пропускная способность в этом случае страдает, но выигрывает латентность, что в некоторых сценариях важнее.  В базовой версии суперкомпьютер Dojo V1 выдаёт 1 Эфлопс в режиме BF16/CFP8 и может загружать непосредственно в SRAM модели объёмом до 1,3 Тбайт, ещё 13 Тбайт данных можно хранить в HBM-сборках DIP. Следует отметить, что пространство SRAM во всей системе Dojo использует единую плоскую адресацию. Полномасштабная версия Dojo будет иметь производительность до 20 Эфлопс. Сколько сил потребуется компании, чтобы запустить такого монстра, а главное, снабдить его рабочим и приносящим пользу ПО, неизвестно — но явно немало. Известно, что система совместима с PyTorch. В настоящее время Tesla уже получает готовые чипы D1 от TSMC. А пока что компания обходится самым большим в мире по числу установленных ускорителей NVIDIA ИИ-суперкомпьютером.

22.07.2022 [21:52], Алексей Степин

Бразильская нефтегазовая компания Petrobras получит самый мощный суперкомпьютер в Латинской Америке — PegasusСовременный суперкомпьютер, а лучше несколько, стремится иметь любая страна или корпорация, и гонка HPC-решений проходит не только между США и Китаем — так, крупнейшая бразильская нефтегазовая компания Petrobras анонсировала создание нового кластера в Рио-де-Жанейро. Будущий суперкомпьютер получил имя Pegasus, и он должен стать самой мощной HPC-системой в латиноамериканском регионе с производительностью около 21 Пфлопс. Система будет включать в себя 2016 ускорителей неизвестной пока модели и 678 Тбайт оперативной памяти, а в качестве интерконнекта планируется использовать 400-Гбит/с сеть. Вероятно, это будeт InfiniBand NDR.

Рио-де-Жанейро. Источник: Pixabay Суперкомпьютеры активно применяются в нефтегазовой отрасли в самых различных сценариях, от поиска новых месторождений до повышения эффективности существующих процессов переработки природных ресурсов. Petrobras уже располагает солидными вычислительными мощностями, составляющими 42 Пфлопс. Главной задачей Pegasus будет обработка обширных массивов данных в рамках геологоразведывательного проекта EXP100, а также поиск способов ускорить начало разработок новых нефтегазовых полей в проекте PROD1000.

Машинный зал Dragão. Источник: Agência Petrobras В июне 2021 года компания Petrobras запустила систему Dragão с 200 Тбайт памяти и 100G-интерконнектом. Система на базе процессоров Xeon Gold 6230R занимает 60 место в TOP500 с пиковой теоретической производительностью 14,01 Пфлопс. Также у Petrobras есть машины Atlas (8,84 Пфлопс) и Fênix (5,37 Пфлопс). Для сравнения — система HPC5, принадлежащая итальянской нефтегазовой компании Eni S.p.A., сейчас находится на 12 месте TOP500 и имеет пиковую теоретическую производительность 51,72 Пфлопс. До момента ввода в строй Pegasus, который запланирован на декабрь 2022 года, Dragão продолжит оставаться мощнейшей латиноамериканской HPC-системой. К концу 2022 года компания намеревается нарастить свой пул вычислительных мощностей до 80 Пфлопс, но пока явно отстаёт от графика. Впрочем, темпы роста впечатляют: ещё в 2018 году в распоряжении Petrоbras было лишь 3 Пфлопс.

12.07.2022 [00:28], Игорь Осколков

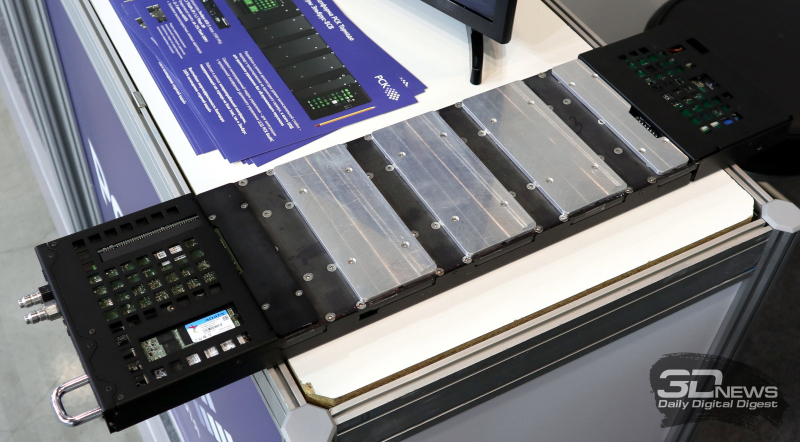

Суперкомпьютер в дорогу: РСК показала на Иннопроме обновлённый мобильный ЦОДГруппа компаний РСК, ведущий российский разработчик суперкомпьютеров и систем для высокопроизводительных вычислений (HPC), дата-центров, облачных платформ и систем хранения данных (СХД) показала на выставке Иннопром-2022 обновлённую версию своей платформы для автономных периферийных вычислений, которая позволяет оперативно, в течение часа силами двух человек, развернуть HPC-кластер практически в любом месте. Решение упаковано в несколько контейнеров (0,7 × 0,7 × 1,1 м), которые можно транспортировать независимо друг от друга и собирать уже на месте. Один контейнер вмещает собственно вычислительную часть, второй — полностью интегрированный модуль распределения теплоносителя с узлом управления, а третий, опциональный — ИБП с инвертором. Дополняет их компактный внешний модуль охлаждения. Вся система имеет весьма солидный запас по возможности отвода тепла — до 60 кВт. Правда, сейчас столько и не требуется. Вычислительный блок фактически является уменьшенной копией платформы «РСК Торнадо»: 2 колонны по 10 слотов. Поэтому мобильная платформа позволяет совмещать в одной системе серверы «Торнадо» с процессорами x86-64 (AMD EPYC и Intel Xeon) и «Эльбрус» (сейчас 8С/8СВ, в перспективе 16С) с любым уровнем TDP, GPGPU-серверы (по два PCIe-ускорителя на сервер, без ограничений по TDP) и серверы хранения (до 12 × M.2 All-Flash). В текущем варианте платформы каждый слот рассчитан на 2 кВт тепловой нагрузки (и столько же по питанию), хотя нынешние серверы укладываются в среднем в 700–800 Вт, а серверы следующего поколения потребуют чуть больше 1 кВт. Подсистема питания имеет два домена, по одному на колонну, и требует однофазный ввод AC 230 В/50 Гц, хотя фактически может работать в диапазоне 105–280 В. Запитать систему можно от генератора, а подстраховать — ИБП. Но возможно и специсполнение с поддержкой 48 В DC. Сетевая подсистема может быть представлена ToR-коммутаторами как двойной (на обе колонны) ширины, так и одиночной. В том числе есть варианты с жидкостным охлаждением. Доступен даже InfiniBand — у Mellanox есть коммутаторы в подходящем форм-факторе, рассчитанные на промышленное применение. Также предоставляется 1 GbE-коммутатор для развёртывания служебной сети. Самая интересная часть — это охлаждение. Как и в «большой» версии платформы здесь используется фирменная СЖО, которая покрывает все компоненты серверов, так что вычислительная часть не требует активного воздушного охлаждения и способна работать даже с закрытыми крышками контейнера. Защиты по какому-либо классу IP в стандартном варианте не предусмотрено, но опять-таки по заказу возможно специсполнение. СЖО всё так же поддерживает охлаждение горячей водой, причём на всех компонентах температура не превышает +45 °C. Для запуска вычислительного модуля необходимо, чтобы он находился в помещении с плюсовой температурой и чтобы не было образования конденсата. А вот внешний контур охлаждения менее прихотлив и способен работать при температурах от -65 °C. Верхний же предел — не менее +40 °C. Требования по питанию у него те же, что и у серверов. Узел управления автоматически отслеживает и регулирует параметры всех компонентов системы во время запуска и работы. По умолчанию используется сценарий защиты оборудования, так что при неблагоприятных условиях серверы могут выключаться. Но возможны и другие сценарии, например, «работа до последнего», когда потеря данных оказывается дороже потери оборудования. Управляется мобильная платформа фирменной системой оркестрации «РСК БазИС», которая позволяет задействовать все возможности компонуемой, программно определяемой инфраструктуры, в том числе для реализации HCI-платформы. «РСК БазИС» предлагает GUI, CLI, открытые API и SDK для интеграции с другими приложениями. Таким образом, заказчик получает полностью интегрированное программно-аппаратное решение, готовое к быстрому развёртыванию и использованию. Изначально платформа создавалась для нужд добывающего сектора, но этой сферой её возможности не ограничиваются. Она также подходит для научных экспедиций и промышленных предприятий (срочная обработка больших массивов данных), медиасферы и обслуживания массовых мероприятий (рендеринг, стриминг с множества камер) и т.д. В общем, везде, где на время требуется действительно мощная, но компактная и удобная в доставке, развёртывании и эксплуатации вычислительная платформа. |

|