Материалы по тегу: коммутатор

|

27.02.2024 [21:27], Сергей Карасёв

«Морион» наладил в Перми серийное производство отечественных управляемых Ethernet-коммутаторовМинистерство промышленности и торговли Пермского края сообщило о том, что местный разработчик и производитель оборудования связи «Морион» организовал серийный выпуск управляемых Ethernet-коммутаторов для построения высокопроизводительных сетей связи. Организовано серийное производство коммутаторов КРМ-5960 и КАМ-3284. Устройства первого семейства относятся к моноблочному типу: они оснащены 20 портами 1GbE RJ-45, четырьмя разъёмами 1GbE RJ-45/SFP и четырьмя портами 10GbE SFP+. Диапазон рабочих температур в зависимости от модификации простирается от 0 до +50 °C или от +5 до +40 °C. Решения КАМ-3284 представлены в блочно-модульном исполнении: они содержат по четыре оптических или электрических порта на модуль — до 24 портов в блоке. Эти коммутаторы могут эксплуатироваться при температурах от -10 до +55 °C при воздействии вибрации, многократных ударов и соляного тумана. Устройства можно применять в подвижных комплексах связи, в прибрежных морских зонах, на надводных лодках и пр. Упомянуты функции контроля доступа с высоким уровнем безопасности и ограничением трафика, в том числе при работе с инфраструктурой, построенной на базе российской платформы Astra Linux. Отмечается, что изделия изготавливаются преимущественно из российских комплектующих — уровень локализации составляет 70 %. Правда, не уточняется, о каких именно компонентах идёт речь. «Морион» уже поставляет коммутаторы для ведомственных и технологических сетей связи нефте- и газотранспортных предприятий, железнодорожных и сетевых компаний энергетической системы. В 2024 году планируется выпуск более 140 моделей управляемых коммутаторов. Инвестиции в проект превышают 140 млн руб. Из них 46 млн руб. предоставил федеральный Фонд развития промышленности (ФРП), ещё 20 млн руб. — региональный ФРП Пермского края. Нужно отметить, что выпуск коммутаторов наладили и многие другие российские компании. В их число входят производитель инфраструктурного IT-оборудования Fplus, поставщик сетевого телекоммуникационного оборудования операторского класса N3COM, дочернее предприятие Росатома «ТВЭЛ» и «Аквариус».

25.02.2024 [19:38], Сергей Карасёв

Энтузиаст превратил коммутаторы Ubiquiti UniFi Professional Max в простейшую «игровую консоль»Сотрудник Ubiquiti Адам Джезек (Adam Jezek) на досуге превратил коммутаторы UniFi Professional Max в матричный индикатор для простейших игр. Разработчик, в частности, показал возможность запуска «Змейки» и T-Rex Dinosaur — как в браузере Google Chrome. Устройства серии UniFi Professional Max оснащены технологией Etherlighting, которая предусматривает наличие многоцветной RGB-подсветки разъёмов для сетевых кабелей. Благодаря этому достигается наглядная визуальная индикация состояния и предназначения портов. В частности, определённым цветом могут быть обозначены разъёмы с разной скоростью подключения, поддержкой PoE и пр.

Источник изображения: Адам Джезек Подсветку можно настраивать через мобильное приложение. А Джезек написал код, который напрямую управляет индикацией портов, позволяя использовать их в качестве матричного индикатора — например, формата 24 × 4 пикселя в случае двух коммутаторов. На такой «панели» может отображаться «змейка», которая управляется джойстиком. Код опубликован на GitHub. Джезек признаёт, что его программа не оптимизирована, а её использование осуществляется «на свой страх и риск».

Источник изображения: Ubiquiti Нужно отметить, что в семейство UniFi Professional Max входят L3-модели Pro Max 24 PoE и Pro Max 48 PoE. Первая располагает 24 портами RJ-45 в конфигурации 8 × 2.5GbE PoE++, 8 × 1GbE PoE+ и 8 × 1GbE PoE++. Кроме того, есть два разъёма 10GbE SFP+. Вторая модификация получила 48 портов RJ-45: 8 × 2.5GbE PoE+, 8 × 2.5GbE PoE++, 24 × 1GbE PoE+ и 8 × 1GbE PoE++. Плюс к этому доступны четыре разъёма 10GbE SFP+. Общая доступная мощность PoE составляет соответственно 400 и 720 Вт. Кроме того, предлагаются варианты без поддержки PoE.

17.08.2023 [20:16], Алексей Степин

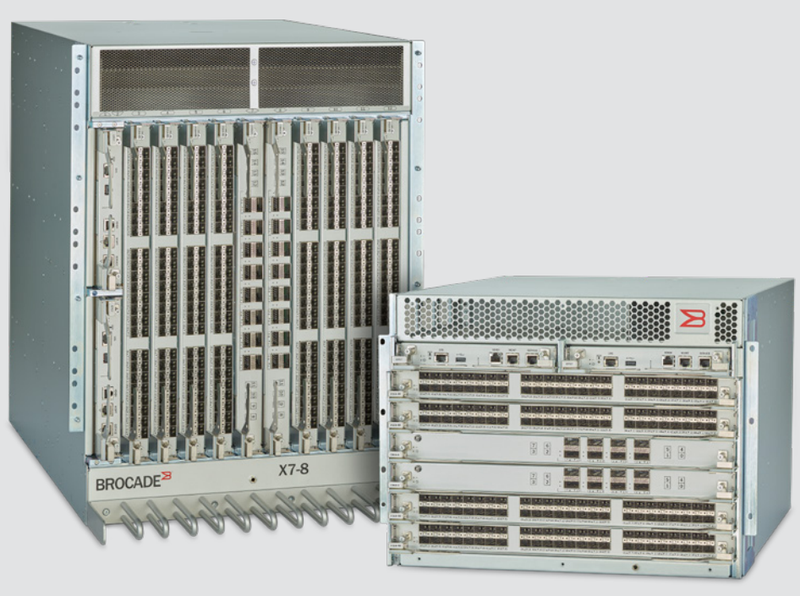

Brocade представила новые FC64-продукты — 512-портовый директор X7 и Ethernet-мост 7850 Extension SwitchПодразделение Brocade Storage Networking компании Broadcom представило новые коммутаторы класса Director, предлагающие до 512 портов FC64. Предельная пропускная способность заявлена на уровне 39,6 Тбайт/с. При этом сохранена совместимость с предыдущими поколениями Fibre Channel. Кроме того, был представлен и новый мост Ethernet ↔ Fibre Channel, который позволяет создавать распределённые SAN. Новые устройства серии Brocade X7 Directors являются наиболее высокоплотными в индустрии — они представлены в вариантах с 256 и 512 портами Fibre Channel седьмого поколения (64 Гбит/с на порт) в исполнениях 8U и 14U соответственно. Первое поколение X7 увидело свет ещё в 2020 году, но тогда оно было ограничено использованием 48-портовых лезвий FC64, что давало максимум 384 порта. Новый вариант использует новые 64-портовые модули с трансиверами SFP-DD, позволившими на треть поднять плотность портов. Устройства работают под управлением Fabric OS 9.0.x.

Источник изображений здесь и далее: Broadcom Другой интересной новинкой Brocade является коммутатор Brocade 7850 Extension Switch, делающий более простым построение географически распределённой SAN. По сути, это мост с 24 портами FC64/FICON, обеспечивающий проброс FC-трафика, для чего имеется 16 портов 25/10GbE, а также два WAN-порта 100GbE. WAN-трафик шифруется на лету на полной скорости по алгоритму AES с 256-битным ключом. Имеются механизмы защиты от кибер-атак, а также автоматическая проверка целостности ПО и аппаратного обеспечения.

10.08.2023 [00:10], Алексей Степин

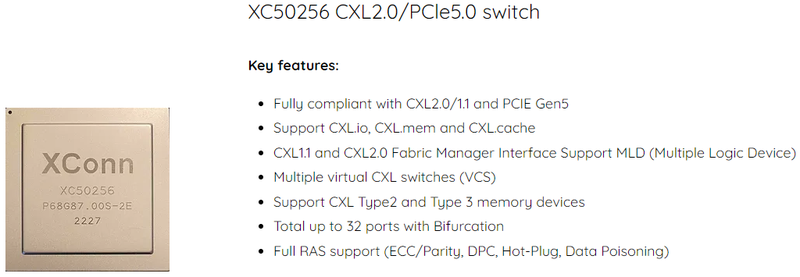

XConn Technologies представила гибридный коммутатор CXL 2.0/PCIe 5.0XConn Technologies представила первый, по её словам, в индустрии гибридный чип-коммутатор CXL 2.0/PCIe 5.0 XC50256, получивший кодовое название Apollo. Утверждается, что он обеспечивает самую низкую латентность port-to-port, а также самое низкое энергопотребление в отрасли. Коммутатор способен работать с 256 линиями интерфейса и разработан с учётом потребностей, характерных для мира ИИ и машинного обучения, а также HPC-сегмента. Чип Apollo совместим с существующей инфраструктурой CXL 1.1, но поддерживает и режим 2.0, включая актуальные режимы CXL.mem или CXL.cache.

Источник изображений здесь и далее: XConn Technologies Но наиболее интересной особенностью Apollo является возможность работы нового коммутатора в гибридном режиме — он способен одновременно обслуживать CXL и PCI Express, что в ряде случаев позволит избежать использования дополнительных коммутаторов под каждый стандарт, а значит, и снизить стоимость и сложность разработки конечной системы.

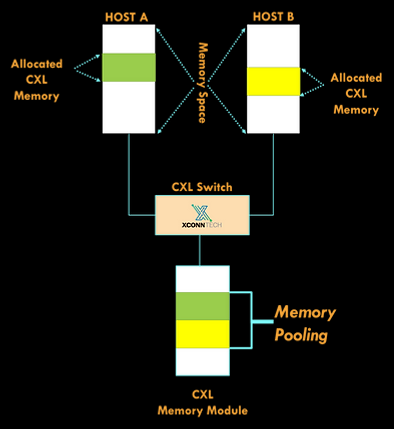

Новый коммутатор поддерживает подключение нескольких хостов к единому CXL-пулу памяти Также компания анонсировала другой коммутатор, XC51256. Он также работает с 256 линиями, но поддерживает только PCI Express 5.0. Тем не менее, это самый высокоплотный PCIe-коммутатор на сегодня, поскольку большинство решений конкурентов обеспечивает в лучшем случае вдвое меньше линий PCI Express, утверждает XConn. ТXC51256 идеален для построения систем класса JBOA (Just-a-Bunch-Of-Accelerators). В настоящее время образцы Apollo XC50256 и XC51256 уже доступны для заказчиков.

19.04.2023 [22:00], Алексей Степин

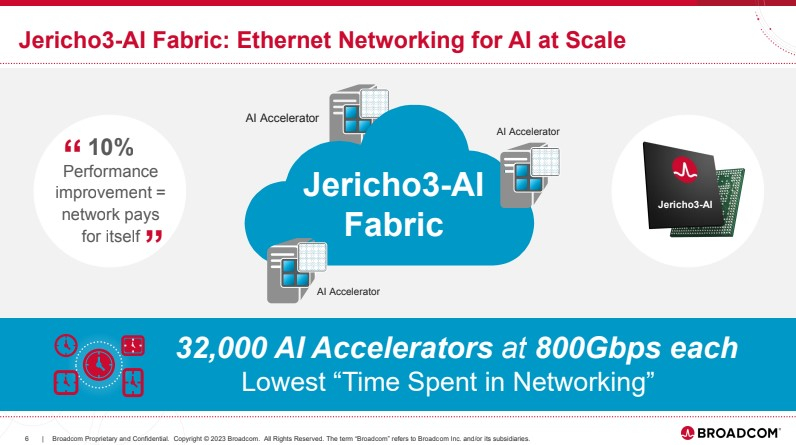

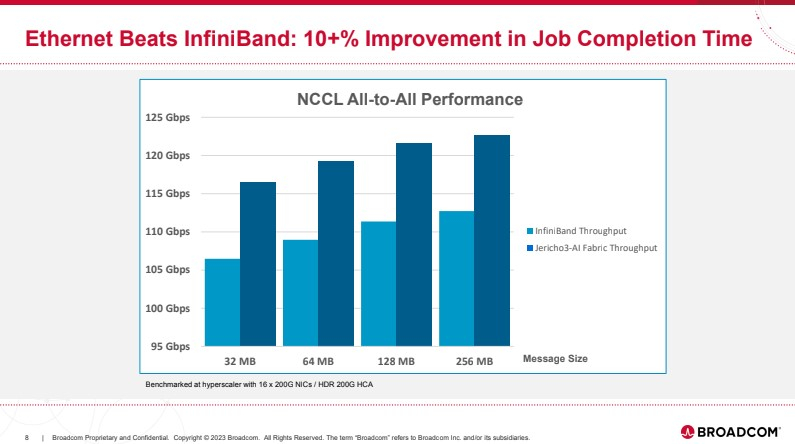

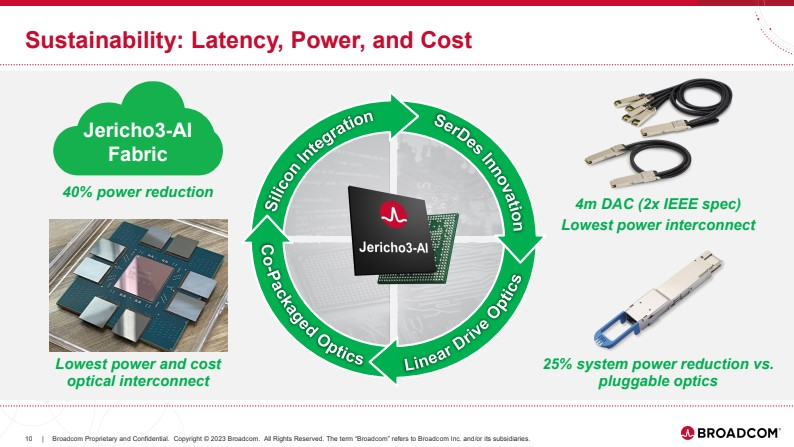

Broadcom представила чип-коммутатор Jericho3-AI для ИИ-платформ, попутно раскритиковав NVIDIAКомпания Broadcom, один из ведущих поставщиков «кремния» для сетевых решений, анонсировала новый сетевой процессор Jerico3-AI, который ориентирован на ИИ-системы. Более того, Broadcom считает подход NVIDIA к «интеллектуальным сетевым решениям» с использованием InfiniBand неверным и даже вредным для кластерных ИИ-систем. Ethernet-коммутаторы компании можно разделить три ветви: наиболее высокопроизводительные чипы Tomahawk, ориентированная на дополнительные возможности ветвь Trident и, наконец, серия Jericho, отличающаяся наибольшей гибкостью в программировании и располагающая более ёмкими буферами. Чип Jericho3-AI BCM88890 — новинка в последней категории, относящаяся к классу 28,8 Тбит/с. Новый коммутатор имеет 144 линка SerDes (106Gbps, PAM4) и может работать в конфигурации 18×800GbE, 36×400GbE или 72×200GbE.

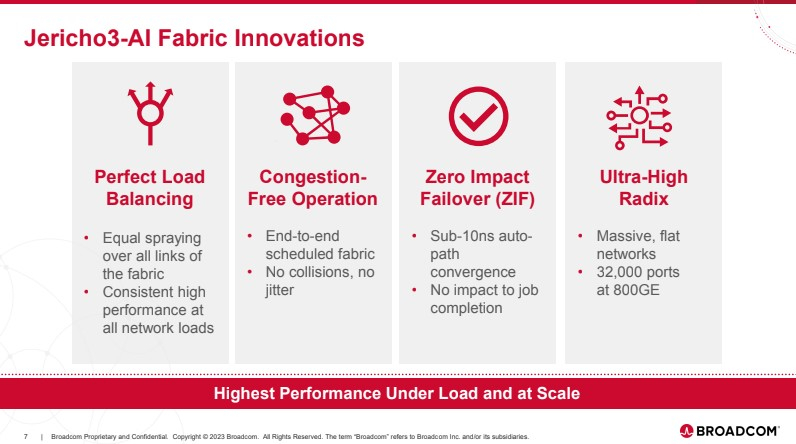

Источник здесь и далее: Broadcom (via ServeTheHome) В своей презентации Broadcom раскритиковала традиционный подход NVIDIA и других крупных игроков на сетевом рынке, заявив о том, что прямое наращивание пропускной способности и снижение латентности кластерной сети якобы является тупиковой ветвью развития. Вместо этого фабрика на базе Jericho3-AI, по словам компании, позволяет сделать так, чтобы процесс обучения нейросети как можно меньше времени тратил не сетевые операции.  Новый коммутатор обеспечивает идеальную балансировку загрузки, гарантирующую отсутствие заторов, и автоматическое переключение отказавшего соединения на резервное менее, чем за 10-нс, а также позволяет создавать большие «плоские» сети (до 32 тыс. портов 800GbE), характерные для ИИ-кластеров. Каждый ускоритель может получить 800G-подключение, а суммарная производительность фабрики на базе новых коммутаторов может достигать 26 Пбит/с.  Broadcom утверждает, что сеть Ethernet на базе Jericho3-AI превосходит аналогичную по классу сеть NVIDIA InfiniBand в тестах с использованием NCCL. При этом новый коммутатор не содержит никаких вычислительных мощностей общего назначения — он проще, а за счёт использования стандарта Ethernet сети на его основе универсальны, что также снижает стоимость владения инфраструктурой.  Высокая степень интегрированности обеспечит и большую экономичность, а значит, решения на базе нового коммутатора Broadcom окажутся и более дружелюбны к экологии. Новые чипы уже доступны избранным клиентам Broadcom.

26.08.2022 [12:45], Алексей Степин

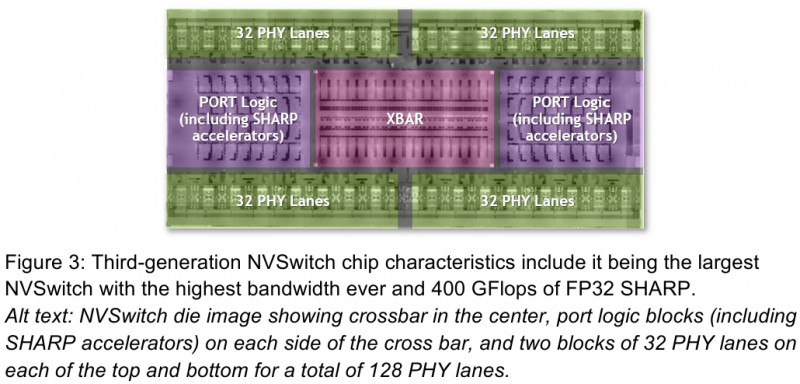

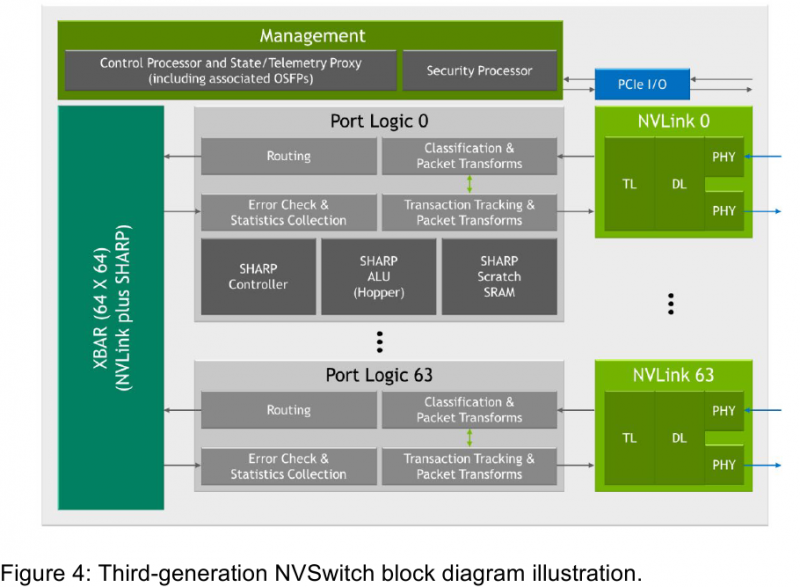

Интерконнект NVIDIA NVLink 4 открывает новые горизонты для ИИ и HPCПотребность в действительно быстром интерконнекте для ускорителей возникла давно, поскольку имеющиеся шины зачастую становились узким местом, не позволяя «прокормить» данными вычислительные блоки. Ответом NVIDIA на эту проблему стало создание шины NVLink — и компания продолжает активно развивать данную технологию. На конференции Hot Chips 34 было продемонстрировано уже четвёртое поколение, наряду с новым поколением коммутаторов NVSwitch.

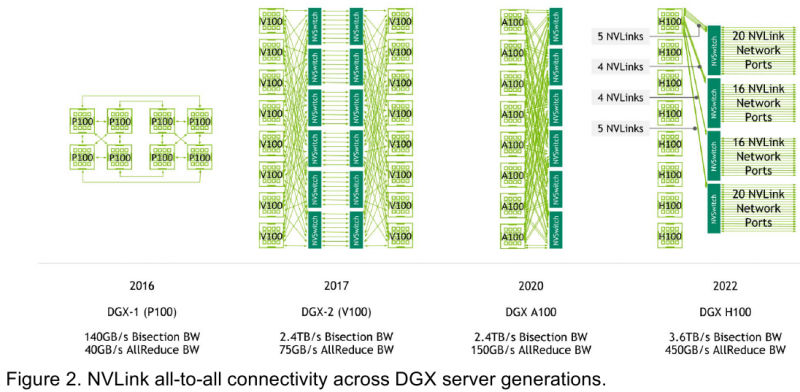

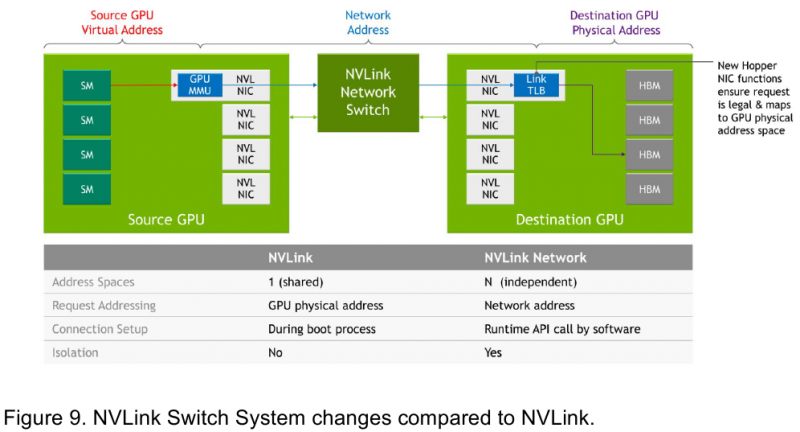

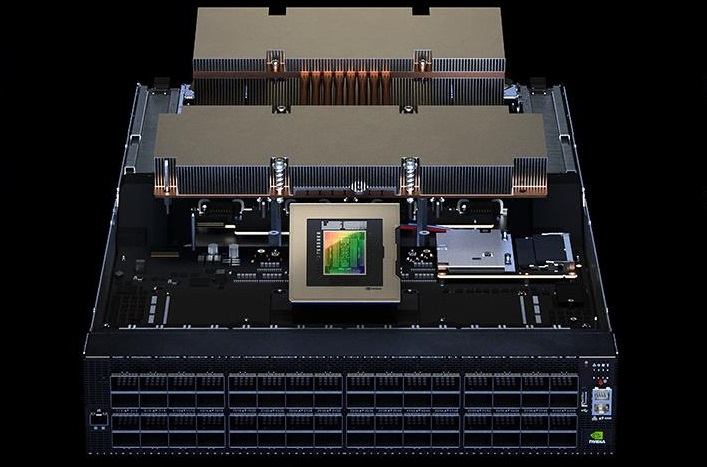

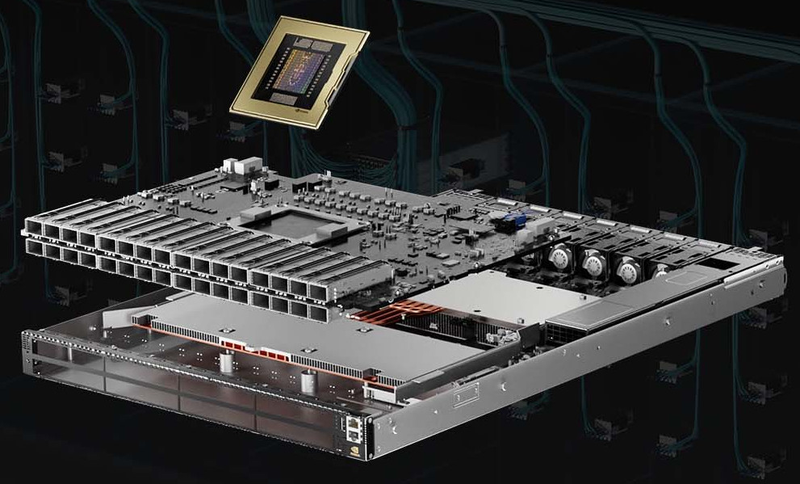

Изображения: NVIDIA Возможность использования коммутаторов для NVLink появилась не сразу, изначально использовалось соединение блоков ускорителей по схеме «точка-точка». Но дальнейшее наращивание числа ускорителей по этой схеме стало невозможным, и тогда NVIDIA разработала коммутаторы NVSwitch. Они появились вместе с V100 и предлагали до 50 Гбайт/с на порт. Нынешнее же, третье поколение NVSwitch и четвёртое поколение NVLink сделали важный шаг вперёд — теперь они позволяют вынести NVLink-подключения за пределы узла. Так, совокупная пропускная способность одного чипа NVSwitch теперь составляет 3,2 Тбайт/с в обе стороны в 64 портах NVLink 4 (x2). Это, конечно, отразилось и на сложности самого «кремния»: 25,1 млрд транзисторов (больше чем у V100), техпроцесс TSMC 4N и площадь 294мм2. Скорость одной линии NVLink 4 осталась равной 50 Гбайт/с, но новые ускорители H100 имеют по 18 линий NVLink, что даёт впечатляющие 900 Гбайт/с. В DGX H100 есть сразу четыре NVSwitch-коммутатора, которые объединяют восемь ускорителей по схеме каждый-с-каждым и дополнительно отдают ещё 72 NVLink-линии (3,6 Тбайт/с). При этом у DGX H100 сохраняются прежние 400G-адаптеры Ethernet/InfiniBand (ConnectX-7), по одному на каждый ускоритель, и пара DPU BlueField-3, тоже класса 400G. Несколько упрощает физическую инфраструктуру то, что для внешних NVLink-подключений используются OSFP-модули, каждый из которых обслуживает 4 линии NVLink. Любопытно, что электрически интерфейсы совместимы с имеющейся 400G-экосистемой (оптической и медной), но вот прошивки для модулей нужны будут кастомные. Подключаются узлы DGX H100 к 1U-коммутатору NVLink Switch, включающему два чипа NVSwitch третьего поколения: 32 OSFP-корзины, 128 портов NVLink 4 и агрегированная пропускная способность 6,4 Тбайт/с. В составе DGX SuperPOD есть 18 коммутаторов NVLink Switch и 256 ускорителей H100 (32 узла DGX). Таким образом, можно связать ускорители и узлы 900-Гбайт/с каналом. Как конкретно, остаётся на усмотрение пользователя, но сама NVLink-сеть поддерживает динамическую реконфигурацию на лету. Ещё одна особенность нового поколения NVLink — продвинутые аппаратные SHARP-движки, которые избавляют CPU/GPU от части работ по подготовке и предобработки данных и избавляющие саму сеть от ненужных передач. Кроме того, в NVLink-сети реализованы разделение и изоляция, брандмауэр, шифрование, глубокая телеметрия и т.д. В целом, новое поколение NVLink получило полуторакратный прирост в скорости обмена данными, а в отношении дополнительных сетевых функций он стал трёхкратным. Всё это позволит освоить новые класса HPC- и ИИ-нагрузок, однако надо полагать, что удовольствие это будет недешёвым.

09.11.2021 [12:17], Алексей Степин

NVIDIA представила Quantum-2, первый 400G-коммутатор InfiniBand NDRNVIDIA, нынешний владелец Mellanox, представила обновления своих решений InfiniBand NDR: коммутаторы Quantum-2, сетевые адаптеры ConnectX-7 и ускорители DPU BlueField-3. Это весьма своевременный апдейт, поскольку 400GbE-решения набирают популярность, а с приходом PCIe 5.0 в серверный сегмент станут ещё более актуальными.

NVIDIA Quantum-2 (Здесь и ниже изображения NVIDIA) Первый и самый важный анонс — это платформа Quantum-2. Новый коммутатор не только обеспечивает вдвое более высокую пропускную способность на порт (400 Гбит/с против 200 Гбит/c), но также предоставляет в три раза больше портов, нежели предыдущее поколение. Это сочетание позволяет снизить потребность в коммутаторах в 6 раз при той же суммарной ёмкости сети. При этом новая более мощная инфраструктура также окажется более экономичной и компактной.  Более того, Quantum-2 относится к серии «умных» устройств и содержит в 32 раза больше акселераторов, нежели Quantum HDR первого поколения. В нём также реализована предиктивная аналитика, позволяющая избежать проблем с сетевой инфраструктурой ещё до их возникновения; за это отвечает технология UFM Cyber-AI. Также коммутатор предлагает синхронизацию времени с наносекундной точностью, что важно для распределённых нагрузок.  7-нм чип Quantum-2 содержит 57 млрд транзисторов, то есть он даже сложнее A100 с 54 млрд транзисторов. В стандартной конфигурации чип предоставляет 64 порта InfiniBand 400 Гбит/с, однако может работать и в режиме 128 × 200 Гбит/с. Коммутаторы на базе нового сетевого процессора уже доступны у всех крупных поставщиков серверного оборудования, включая Inspur, Lenovo, HPE и Dell Technologies. Возможно масштабирование вплоть 2048 × 400 Гбит/с или 4096 × 200 Гбит/с.

NVIDIA ConnectX-7 Конечные устройства для новой инфраструктуры InfiniBand доступны в двух вариантах: это относительно простой сетевой адаптер ConnectX-7 и куда более сложный BlueField-3. В первом случае изменения, в основном, количественные: новый чип, состоящий из 8 млрд транзисторов, позволил вдвое увеличить пропускную способность, равно как и вдвое же ускорить RDMA и GPUDirect.

NVIDIA BlueField-3 DPU BlueField-3, анонсированный ещё весной этого года, куда сложнее с его 22 млрд транзисторов. Он предоставляет гораздо больше возможностей, чем обычный сетевой адаптер или SmartNIC, и крайне важен для будущего развития инфраструктурных решений NVIDIA. Начало поставок ConnectX-7 намечено на январь, а вот BlueField-3 появится только в мае 2022 года. Оба адаптера совместимы с PCIe 5.0.

28.10.2021 [17:02], Алексей Степин

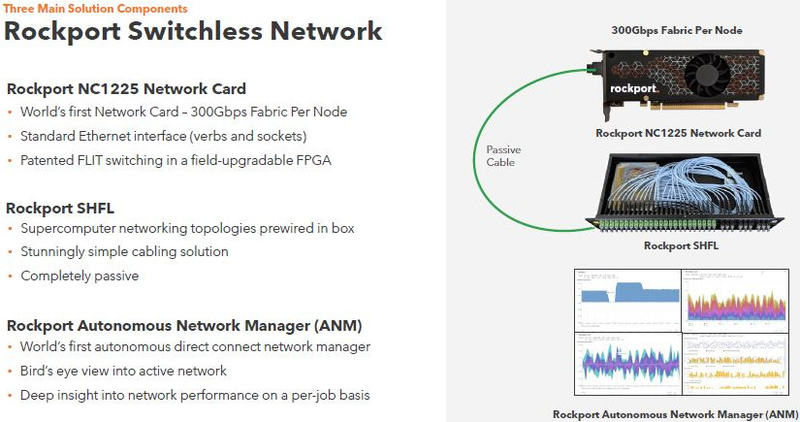

Rockport Networks представила интерконнект с пассивным оптическим коммутаторомПроизводительность любого современного суперкомпьютера или кластера во многом зависит от интерконнекта, объединяющего вычислительные узлы в единое целое, и практически обязательным компонентом такой сети является коммутатор. Однако последнее не аксиома: компания Rockport Networks представила своё видение HPC-систем, не требующее использования традиционных коммутирующих устройств. Проблема межсоединений существовала в мире суперкомпьютеров всегда, даже в те времена, когда сам процессор был набором более простых микросхем, порой расположенных на разных платах. В любом случае узлы требовалось соединять между собой, и эта подсистема иногда бывала неоправданно сложной и проблемной. Переход на стандартные сети Ethernet, Infiniband и их аналоги многое упростил — появилась возможность собирать суперкомпьютеры по принципу конструктора из стандартных элементов.

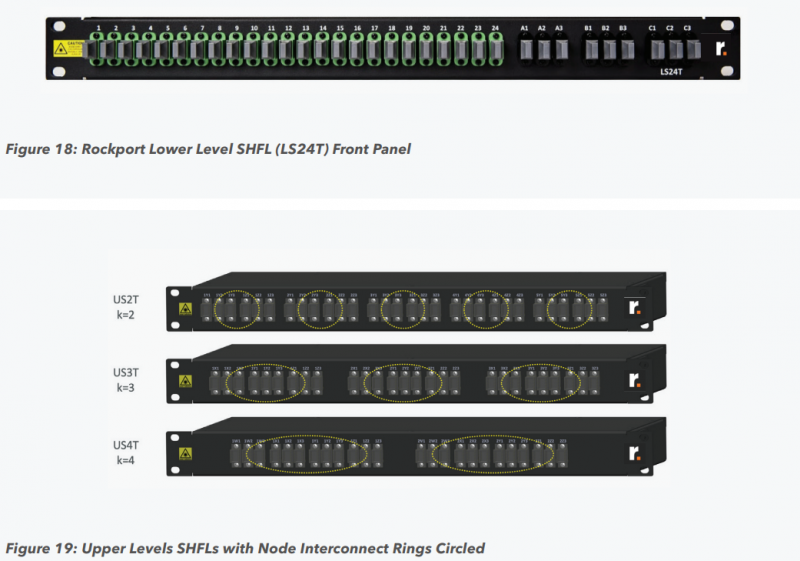

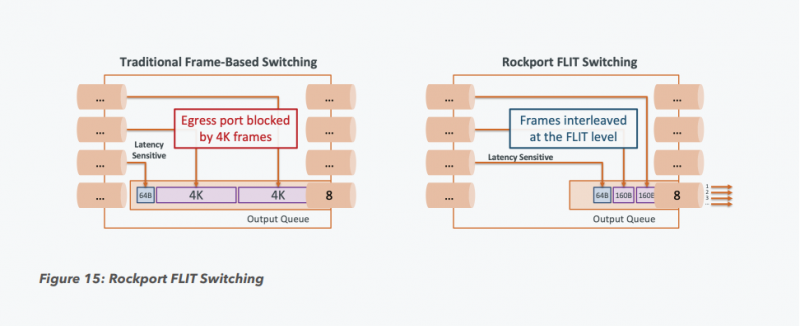

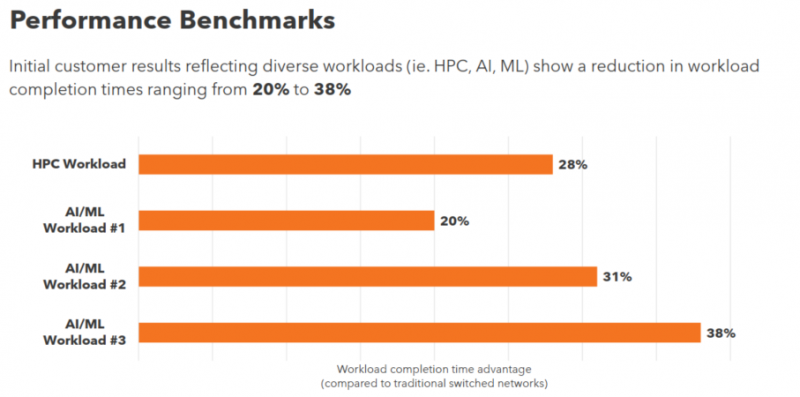

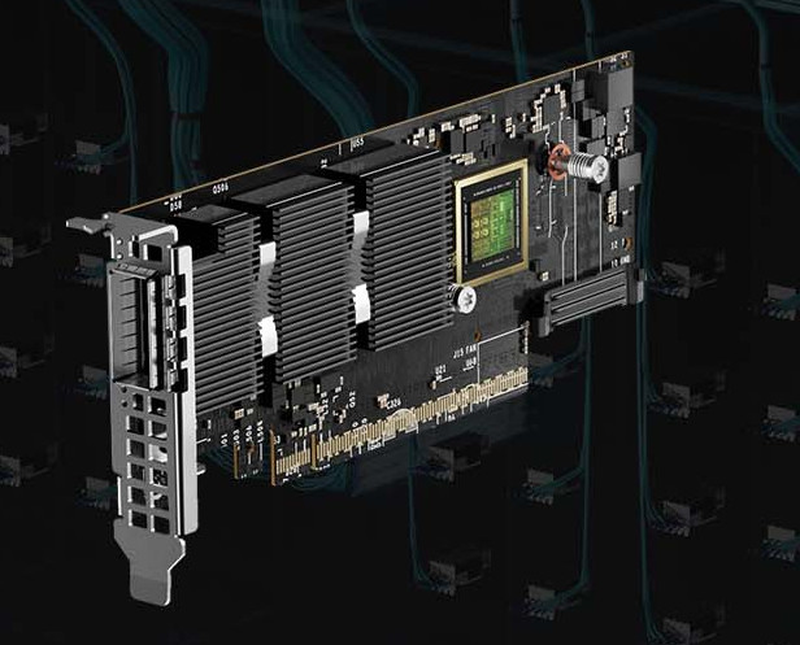

Пассивный оптический коммутатор SHFL Тем не менее, проблема масштабирования (в том числе и на физическом уровне кабельной инфраструктуры), повышения скорости и снижения задержек никуда не делась. У DARPA даже есть особый проект FastNIC, нацеленный на 100-кратное ускорение сетевых интерфейсов, чтобы в конечном итоге сгладить разницу в скорости обмена данными внутри узлов и между ними.  Сам по себе высокоскоростной коммутатор для HPC-систем — устройство непростое, требующее использования недешёвого и сложного кремния, и вкупе с остальными компонентами интерконнекта может составлять заметную долю от стоимости всего кластера в целом. При этом коммутаторы могут вносить задержки, по определению являясь местами избыточной концентрации данных, а также требуют дополнительных мощностей подсистем питания и охлаждения.  Подход, продвигаемый компанией Rockport Networks, свободен от этих недостатков и изначально нацелен на минимизацию точек избыточности и возможных коллизий. А достигнуто это благодаря архитектуре, в которой концепция традиционного сетевого коммутатора отсутствует изначально. Вместо этого имеется специальный модуль SHFL, в котором топология сети задаётся оптически, а все логические задачи берут на себя специализированные сетевые адаптеры, работающие под управлением фирменной ОС rNOS и имеющие на борту сконфигурированную нужным образом ПЛИС. Модуль SHFL даже не требует отдельного электропитания, а вот адаптеры Rockport NC1225 его хотя и требуют, но умещаются в конструктив низкопрофильного адаптера с разъёмом PCIe x16 и потребляют всего 36 Вт. Правда, в настоящий момент речь идёт только о PCIe 3.0, поэтому полнодуплексного подключения на скорости 200 Гбит/с пока нет. Тем не менее, Техасский центр передовых вычислений (TACC) посчитал, что этого уже достаточно и стал одним из первых заказчиков — 396 узлов суперкомпьютера Frontera используют решение Rockport. Использование не совсем традиционной оптической сети, впрочем, накладывает свои особенности: вместо популярных *SFP-корзин используются разъёмы MTP/MPO-24, а каждый кабель даёт для подключения 12 отдельных волокон, что при скорости 25 Гбит/с на волокно позволит достичь совокупной пропускной способности 300 Гбит/с. ОС и приложениям адаптер «представляется» как чип Mellanox ConnectX-5, который и входит в его состав, а потому не требует каких-то особых драйверов или модулей ядра. Rockport фактически занимается транспортировкой Ethernet и реализует уровень OSI 1/1.5, однако традиционной коммутации как таковой нет — адаптеры самостоятельно определяют конфигурацию сети и оптимальные маршруты передачи сигнала по отдельным волокнам с возможностью восстановления связности на лету при каких-либо проблемах. Весь трафик разбивается на маленькие кусочки (FLIT'ы) и отправляется по виртуальным каналам (VC) с чередованием, что позволяет легко управлять приоритизацией (в том числе на L2/L3) и снизить задержки. SHFL имеет 24 разъёма для адаптеров и ещё 9 для объединения с другими SHFL и Ethernet-шлюзами для подключения к основной сети ЦОД (в ней сеть Rockport видна как обычная L2). Таким образом, в составе кластера каждый узел может быть подключён как минимум к 12 другим узлам на скорости 25 Гбит/с. Однако топологию можно менять по своему усмотрению. Компания-разработчик заявляет о преимуществе своего интерконнекта на классических HPC-задачах, могущем достигать почти 30% при сравнении c InfiniBand класса 100G и даже 200G. Кроме того, для Rockport требуется на 72% меньше кабелей. |

|