Материалы по тегу: коммутатор

|

23.07.2024 [10:10], Сергей Карасёв

Управляемый L3-коммутатор QNAP QSW-M3224-24T оснащён 24 портами 10GbEКомпания QNAP Systems представила управляемый L3-коммутатор QNAP QSW-M3224-24T, о подготовке которого стало известно в ходе июньской выставки Computex 2024. Новинка, рассчитанная на монтаж в стойку, выполнена в форм-факторе 1U. Устройство оснащено 24 портами 10GbE (RJ-45) с поддержкой режимов 5GbE, 2.5GbE, 1GbE и 100MbE. Кроме того, есть порт управления 1GbE (RJ-45) и консольный порт USB Type-C. Технологии РоЕ не предусмотрена. Заявленная коммутируемая ёмкость достигает 480 Гбит/с. Упомянута поддержка стандартов IEEE 802.3x Full-Duplex Flow Control, IEEE 802.1Q VLAN Tagging, IEEE 802.1w RSTP, IEEE 802.3ad LACP, IEEE 802.1AB LLDP и IEEE 802.1p Class of Service. Управление осуществляется посредством интерфейса QSS Pro (QNAP Switch System Pro): можно настраивать IP (IPv4, IPv6, DNS), статическую маршрутизацию, DHCP-сервер, SNTP и расширенные функции VLAN. Коммутатор имеет габариты 44,2 × 438,5 × 190 мм и весит 2,93 кг. В системе охлаждения задействованы пять вентиляторов с ШИМ-управлением. Диапазон рабочих температур — от 0 до +40 °C. В устройстве применяется внутренний блок питания; максимальное энергопотребление составляет 116,9 Вт. Модель QNAP QSW-M3224-24T ориентирована на предприятия малого и среднего бизнеса. На устройство предоставляется двухлетняя гарантия.

05.07.2024 [12:07], Сергей Карасёв

Вышел 1GbE-коммутатор MikroTik CRS320-8P-8B-4S+RM с поддержкой PoE++ и четырьмя портами 10GbE SFP+Компания MikroTik анонсировала коммутатор CRS320-8P-8B-4S+RM — своё первое решение с поддержкой стандарта PoE++ (802.3bt). Устройство обеспечивает мощность до 90 Вт на порт, благодаря чему упрощается подключение различного сетевого оборудования, например, камер видеонаблюдения в формате 4К со встроенными нагревательными элементами для работы в зимнее время года. В основу положен чип-коммутатор Marvell 98DX226S с двумя ядрами, функционирующими на частоте 800 МГц. Применена программная платформа RouterOS v7. Объём оперативной памяти составляет 256 Мбайт, ёмкость флеш-чипа — 32 Мбайт. Диапазон рабочих температур простирается от -10 до +50 °C. MikroTik CRS320-8P-8B-4S+RM предлагается по ориентировочной цене $490. Коммутатор располагает 16 портами 1GbE (№1–8 с поддержкой 802.3af/at PoE-out, №9–16 с поддержкой 802.3bt PoE++), дополнительным портом управления 1GbE, консольным портом, а также четырьмя разъёмами 10GbE SFP+. За охлаждение отвечают три вентилятора. Новинка наделена блоком питания мощностью 600 Вт с возможностью установки дополнительного блока, что в сумме даст 1150 Вт. Бюджет мощности PoE — 963 Вт. Заявленный показатель MTBF (средняя наработка на отказ) достигает 200 тыс. часов при температуре 25 °C.

02.07.2024 [12:10], Сергей Карасёв

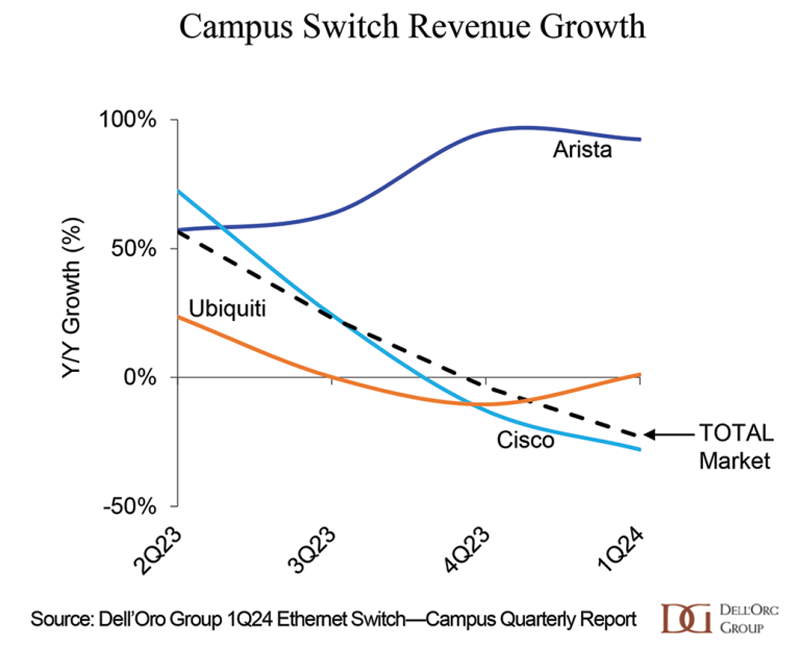

Dell'Oro: продажи кампусных Ethernet-коммутаторов рухнули на 23 %По оценкам Dell'Oro Group, выручка от реализации кампусных Ethernet-коммутаторов в I квартале 2024 года в глобальном масштабе сократилась практически на четверть — на 23 % — по сравнению с аналогичным периодом предыдущего года. В результате объём рынка достиг двухлетнего минимума. Говорится, что снижение спроса зафиксировано во всех регионах, за исключением Центральной и Латинской Америки (CALA). Отмечается сокращение отгрузок портов практически всех типов. Кроме того, в годовом исчислении снизилась средняя стоимость коммутаторов.

Источник изображения: Dell'Oro Group Среди ведущих игроков названы Arista Networks, Cisco и Ubiquiti. У первой из названных компаний выручка от поставок кампусных Ethernet-коммутаторов в I четверти 2024-го поднялась более чем на 80 % год к году. Третий квартал подряд Arista наращивает рыночную долю. Ubiquiti также смогла незначительно увеличить объём реализации. У Cisco продажи, напротив, резко сократились: падение в годовом исчислении превысило 25 %. Годом ранее Cisco продемонстрировала существенный рост, связанный с удовлетворением отложенного спроса. В исследовании отмечается, что некоторые поставщики кампусных Ethernet-коммутаторов в I квартале 2024 года смогли увеличить среднюю стоимость портов благодаря расширению ассортимента продукции. Прогнозируется, что спрос на устройства с поддержкой 5GbE-портов увеличится на фоне роста востребованности точек доступа стандарта Wi-Fi 7.

22.06.2024 [12:42], Сергей Карасёв

«Аквариус» начал производство 1GbE-коммутаторов AQ-N3000, в том числе с поддержкой PoEГруппа компаний «Аквариус» сообщила о том, что на заводе в Твери произведена первая партия отечественных коммутаторов корпоративного класса серии AQ-N3000. Данная платформа, как утверждается, создана для трансформации типовой сетевой инфраструктуры в гибридную производственную среду, где рабочее место не фиксировано в пространстве, а доступ к информационным ресурсам осуществляется с любого устройства. На сегодняшний день в семейство входят четыре модели Aquarius AQ-N3000-48P4Y2Q, Aquarius AQ-N3000-48T4Y2Q, Aquarius AQ-N3000-24P4Y2Q и Aquarius AQ-N3000-24T4Y2Q. Первые две оснащены 48 портами 1GbE, две другие — 24. Все коммутаторы оборудованы четырьмя портами 10/25G SFP28 и двумя разъёмами 40G QSFP. Старшие версии обеспечивают производительность до 456 Гбит/с, младшие — до 408 Гбит/с. Модели AQ-N3000-48P4Y2Q и AQ-N3000-24P4Y2Q поддерживают технологию PoE с бюджетом мощности 2 × 1080 Вт и 2 × 380 Вт соответственно. Новинки оснащены двумя блоками питания с возможностью горячей замены. Для охлаждения применяются четыре вентилятора. Есть консольный порт RJ-45 и порт OOB 1GbE RJ-45. Диапазон рабочих температур — от 0 до +45 °C. Коммутаторы имеют габариты 44 × 440 × 440 мм, а масса в зависимости от модификации варьируется от 7,0 до 8,4 кг. «Аквариус» планирует в ближайшее время внести устройства в реестр телекоммуникационного оборудования российского происхождения Минпромторга. Уже запущен портал технической документации, где пользователи смогут получить всю необходимую информацию об изделиях и ОС коммутаторов Aquarius Network Operating System (AqNOS). Сервис предлагает свободный доступ к актуальным версиям технической документации AqNOS, руководству пользователя, справочникам команд, дизайн-инструкциям и пр. Кроме того, через портал можно будет получить доступ к онлайн-демонстрации оборудования и службе технической поддержки. «Запуск первой партии коммутаторов — важный шаг не только для компании, но и IT-рынка в целом, поскольку это позволит удовлетворить высокий спрос заказчиков на доверенное телекоммуникационное оборудование для построения ведомственных и корпоративных сетей связи. Наша ключевая задача как производителя сегодня — наладить производство, максимально возможно локализовав технологические операции в РФ», — отмечает президент группы компаний «Аквариус».

29.05.2024 [12:08], Сергей Карасёв

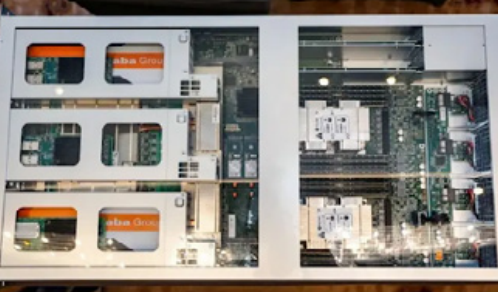

Edge-оборудование Alibaba Cloud построено на Intel TofinoОблачная платформа Alibaba Cloud, по сообщению ресурса The Register, раскрыла аппаратную конфигурацию сетевого оборудования, которое используется на периферии. Речь идёт об устройствах под названием LuoShen, которые рассматриваются в качестве «серверов-коммутаторов».

Источник изображения: Alibaba Отмечается, что изделия LuoShen находятся в производстве приблизительно два года. На сегодняшний день они эксплуатируются на «сотнях периферийных площадок» в составе облачной инфраструктуры Alibaba Cloud. LuoShen имеет форм-фактор 2U. Конструкция включает два CPU общего назначения, FPGA, а также чип Intel Tofino — интегральную схему специального назначения (ASIC) с возможностью программирования. Tofino представляет собой сетевой Ethernet-процессор, ориентированный на дата-центры. Утверждается, что LuoShen обеспечивает пропускную способность до 1,2 Тбит/с. Чип Tofino отвечает за перераспределение 64 портов 100G под различные цели. Это, в частности, обработка трафика виртуальных машин, интернет-трафика и пр. В зависимости от выполняемых задач данные направляются к CPU и FPGA, а после обработки отправляются в конечную точку. Отмечается, что устройствам LuoShen приходится обрабатывать трафик разных типов, а поэтому возможность программирования Tofino имела для Alibaba Cloud ключевое значение — облачная платформа смогла оптимизировать работу оборудования под собственные нужды. Благодаря переходу на LuoShen компания смогла сократить первоначальные затраты, занимаемое место и энергопотребление на 75 %, 87 % и 60 % соответственно по сравнению с ранее использовавшейся сетевой архитектурой.

13.04.2024 [23:00], Сергей Карасёв

«Ростех» начал поставки серверов и обновлённого интерконнекта «Ангара» для отечественных суперкомпьютеров

amd

epyc

hardware

hpc

ангара

импортозамещение

интерконнект

коммутатор

ницэвт

россия

ростех

сделано в россии

сервер

суперкомпьютер

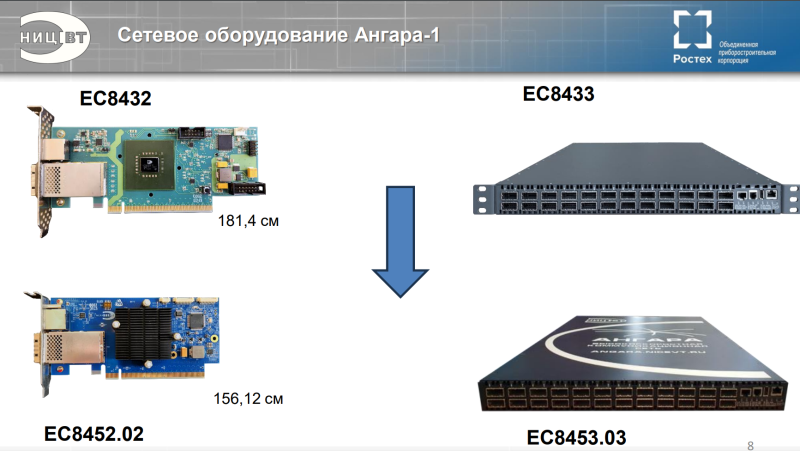

Государственная корпорация «Ростех» объявила о начале поставок оборудования нового поколения для создания отечественных суперкомпьютеров. Речь идёт о высокопроизводительных серверах, 24-портовых коммутаторах и адаптерах интерконнекта «Ангара». В сообщении «Ростеха» говорится, что оборудование стало более компактным по сравнению с предыдущими модификациями. Адаптеры «Ангара» обеспечивают объединение серверов в единый вычислительный кластер для проведения расчётов с высокоинтенсивным обменом информацией и низкими задержками. Новинка разработана специалистами Научно-исследовательского центра электронной вычислительной техники (НИЦЭВТ) в составе холдинга «Росэлектроника» госкорпорации «Ростех». На сайте НИЦЭВТ представлено изделие ЕС8431. Это FHFL-карта с интерфейсом PCIe 2.0 x16, которая обеспечивает до шести (или до восьми при использовании платы расширения) портов для соединения с соседними узлами. Пропускная способность достигает 75 Гбит/с на порт, задержка — 130 нс на хоп. Применяются Samtec-кабели. Поддерживаются топологии сети «кольцо», 2D, 3D и 4D-тор (либо решётка), причём возможно масштабирование до 32 тыс. узлов. Энергопотребление — 30 Вт. Также доступен низкопрофильный 15-Вт адаптер ЕС8432, который по характеристикам в целом повторяет ЕС8431, но имеет только один порт (CXP). Он ориентирован на работу с коммутаторами. И НИЦЭВТ как раз предлагает такое решение — изделие ЕС8433 типоразмера 1U. Оно располагает 24 портами с пропускной способностью до 75 Гбит/с. Возможно масштабирование до 2 тыс. узлов. Энергопотребление не превышает 150 Вт. На мероприятии «Суперкомпьютерные дни в России 2023» НИЦЭВТ также анонсировал более компактный вариант адаптера ЕС8452.02 и 24-портовый коммутатор ЕС8453.03. В сообщении «Ростеха» не уточняется, о каких именно продуктах идёт речь. В маркетплейсе госкорпорации рекомендованная розничная цена коммутатора ЕС8433 составляет 2,8 млн руб., а адаптеров ЕС8431 и ЕС8432 — 396 тыс. руб. и 300 тыс. руб. соответственно. В ассортименте НИЦЭВТ также значится сервер общего назначения Server-NICEVT-044 SP3 на платформе AMD. Он может оснащаться одним или двумя процессорами EPYC Naples/Rome/Milan (от 8 до 48 ядер), до 1 Тбайт RAM, двумя блоками питания с возможностью горячей замены. Возможна установка SSD суммарной вместимостью до 10 Тбайт и HDD общей ёмкостью до 80 Тбайт. Форм-фактор — 2U. Рекомендованная розничная цена составляет 1,2 млн руб. «Мы произвели первые поставки нового поколения сетевого оборудования линейки "Ангара", разработка которого завершилась в 2023 году. Техника установлена на территории двух научно-исследовательских организаций. Устройства позволяют ещё более эффективно выполнять задачи по созданию современных российских суперкомпьютеров для решения сложных научных задач. Сегодня именно от такого оборудования во многом зависит успех и скорость научных изысканий, а значит — и развитие отечественной промышленности», — говорит генеральный директор НИЦЭВТ.

29.03.2024 [17:30], Сергей Карасёв

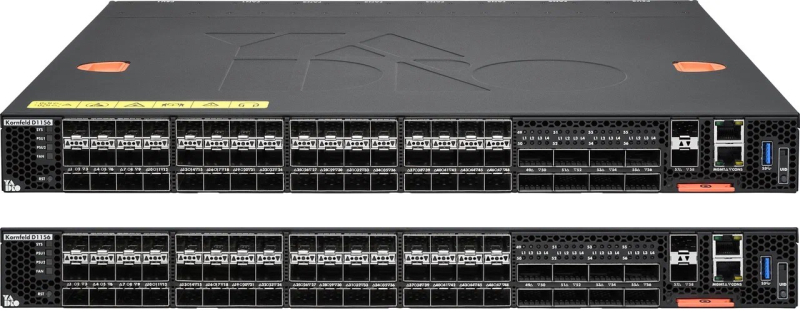

YADRO представила российский 25GbE-коммутатор KornfeldРоссийский разработчик и производитель вычислительной техники YADRO (ООО «КНС групп») анонсировал свой первый высокопроизводительный коммутатор Kornfeld для дата-центров. Устройство поддерживает обработку трафика L2 и L3, а коммутируемая ёмкость достигает 3,2 Тбит/с. Новинка выполнена в форм-факторе 1U. В основу положен неназванный ASIC с пакетным буфером объёмом 32 Мбайт, процессор Intel Xeon D-1712TR поколения Ice Lake (4C/8T; 2,0–3,1 ГГц; 40 Вт). Установлены два модулям оперативной памяти DDR4 SO-DIMM по 8 Гбайт каждый и M.2 SSD ёмкостью 120 Гбайт. Коммутатор оборудован 48 портами 10/25GbE SFP28 и восемью портами 25/40/100GbE QSFP28. Для управления служат разъёмы RJ-45 (1GbE и последовательный порт) и два коннектора SFP+ 1/10GbE. Имеется также порт USB Type-A. Устройство поддерживает традиционный набор протоколов, включая OSPF, BGP, ECMP, VRRP, MLAG и интерфейсы управления SSH, SNMP, REST API. Поддерживаются протоколы аутентификации TACACS+ и RADIUS, сети VLAN (802.1Q), агрегация LACP, а также LLDP. Коммутатор получил загрузчик ONIE и фирменную NOS Kornfeld. Новинка имеет размеры 434 × 536 × 44 мм и весит примерно 10 кг. Установлены два блока питания мощностью 800 Вт с возможностью резервирования. За охлаждение отвечают шесть вентиляторов с функцией горячей замены. Диапазон рабочих температур — от +10 до +35 °C. Коммутатор производится на заводе полного цикла «Ядро Фаб Дубна» и соответствуют всем требованиям к отечественному оборудованию согласно ПП878 (ТОРП). «Kornfeld — это полностью наша разработка, начиная от аппаратной платформы и заканчивая программным обеспечением. Мы стремились создать продукт с оптимальным сочетанием функциональности, производительности и надёжности, который бы максимально подходил для высоконагруженных ЦОД и удовлетворял потребности клиентов в различных сценариях использования, — отмечает директор по продуктам компании YADRO.

27.03.2024 [23:40], Сергей Карасёв

Coherent представила оптические коммутаторы для дата-центров, ориентированных на задачи ИИCoherent анонсировала специализированные оптические коммутаторы для ИИ-кластеров высокой плотности. В основу устройств Optical Circuit Switch (OCS) положена фирменная платформа кросс-коммутации Lightwave Cross-Connect (DLX). В изделиях, в отличие от традиционных коммутаторов, не применяются приемопередатчики для преобразования фотонов в электроны и обратно. Вместо этого все операции осуществляются в оптическом тракте: импульсы поступают в один порт и выходят из другого (конечно, с небольшим ослаблением). Coherent выделяет несколько ключевых преимуществ своей технологии. Прежде всего значительно возрастает производительность, что важно при решении ресурсоёмких задач, связанных с приложениями ИИ. Кроме того, благодаря отказу от преобразования среды сокращаются энерозатраты. Наконец, отпадает необходимость в обновлении собственно коммутаторов при установке в ЦОД оборудования следующего поколения. Это значительно повышает окупаемость капитальных затрат.

Источник изображения: Coherent Представленное решение насчитывает 300 входных и 300 выходных оптических портов. Коммутаторы OCS помогают решить проблемы масштабируемости и надёжности дата-центров, ориентированных на приложения ИИ. Аналитики Dell'Oro Group отмечают, что для ИИ-задач требуется более высокий уровень отказоустойчивости, нежели для традиционных приложений. Крайне важно, чтобы коммутаторы, используемые в составе ИИ-платформ, не провоцировали никаких перебоев во время обучения или эксплуатации больших языковых моделей. Устройства Coherent, как сообщается, обеспечивают необходимый уровень надёжности. Массовые поставки новых коммутаторов планируется организовать в 2025 году. При этом Google уже использует в своих дата-центрах оптические коммутаторы (OCS) собственной разработки на базе MEMS-переключателей для формирования ИИ-кластеров, а Meta✴ совместно с MIT разработала систему TopoOpt, представляющую собой оптическую патч-панель с манипулятором, который позволяет менять топологию сети.

22.03.2024 [09:09], Алексей Степин

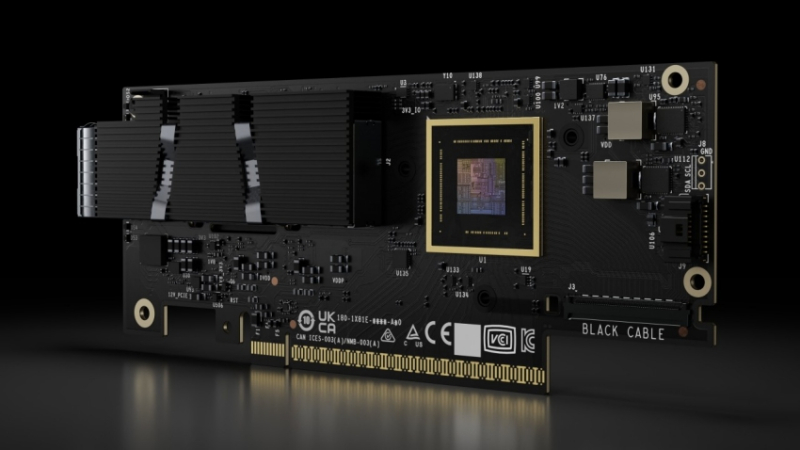

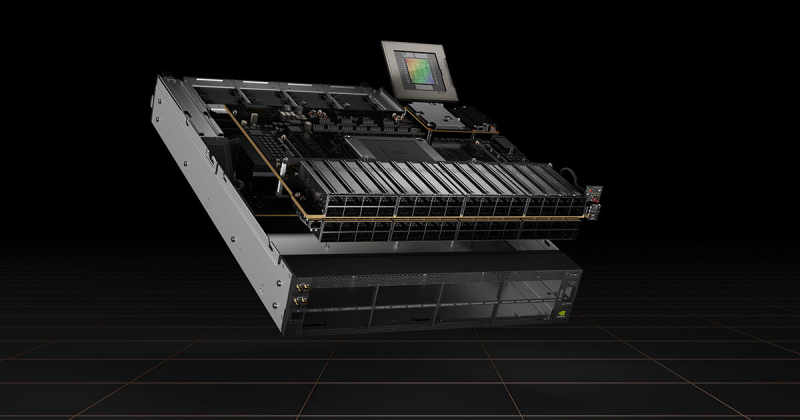

NVIDIA представила 800G-платформы Quantum-X800 и Spectrum-X800 для InfiniBand- и Ethernet-фабрик нового поколенияДополнением к только что представленным ИИ-ускорителям NVIDIA Blackwell станут новые сетевые 800G-платформы Quantum-X800 и Spectrum-X800, а также сетевые адаптеры ConnectX-8. Именно они позволят вывести масштабирование ИИ-кластеров на новый уровень и позволят «прокормить» гигантские массивы ускорителей в дата-центрах гиперскейлеров. Платформа NVIDIA Quantum-X800 ориентирована на наиболее производительные ИИ- и HPC-кластеры. Она использует новое поколение технологии InfiniBand, всё ещё обладающей рядом преимуществ в сравнении с Ethernet, и включает в себя обновлённые SHARP-движки. Технология SHARPv4 реализует «вычисления в сети» (In-Network Computing), что позволяет не только существенно разгрузить вычислительные узлы и серверы, но и обеспечить более высокую пропускную способность интерконнекта вкупе с более серьёзными возможностями его масштабирования. Основой платформы Quantum-X800 стал 4U-коммутатор Q3400-RA, впервые в индустрии, как говорит компания, использующий 200G-блоки SerDes для каждой линии InfiniBand. Коммутатор располагает 144 портами 800G в 72 OSFP-модулях и выделенным портом для Unified Fabric Manager. Новинка имеет стандартное 19″ исполнение с воздушным охлаждением, но есть и вариант Q3400-LD с жидкостным охлаждением, предназначенный для 21″ OCP-стоек. В двухуровневом варианте fat tree коммутаторы позволят объединить 10 368 NIC. Основным адаптером для новой платформы InfiniBand является ConnectX-8 SuperNIC с интерфейсом PCIe 6.0. Он является частью SHARPv4 и предлагается в однопортовом (OSFP224) и двухпортовом (QSFP112) вариантах и в нескольких форм-факторах, включая OCP 3.0. На платах также имеется разъём SocketDirect на 16 линий PCIe. Также компания представила компоненты NVIDIA LinkX: оптические трансиверы 2xDR4/2xFR4 и активные медные кабели (LACC). Не забыла NVIDIA и про Ethernet: здесь вывести производительность сети на новый уровень должна платформа Spectrum-X800. Её основой служит новейший коммутатор SN5600 — это, по словам NVIDIA, первый в мире Ethernet-коммутатор класса 800GbE, специально разработанный для применения гиперскейлерами в крупных облачных ИИ-комплексах. Применяемая архитектура позволяет гарантировать каждому клиенту оптимальный и постоянный уровень производительности, а потоковая телеметрия позволит находить и ликвидировать возможные «бутылочные горлышки» в сети буквально на лету. Общая пропускная способность SN5600 составляет 51,2 Тбит/с. Коммутатор располагает 64 портами 800GbE в формате OSFP. В нём используется ASIC пятого поколения на базе архитектуры Spectrum-4. В качестве основного адаптера предлагается SuperNIC на базе DPU BlueField-3 с двумя 400GbE-портами. Spectrum-X800 сопровождает полноценный спектр инфраструктурных компонентов, включая кабели DAC и LACC. С оптическими трансиверами длина соединения 800GbE может достигать двух километров. Начиная со следующего года, решения на базе новых сетевых платформ NVIDIA будут доступны от широкого круга поставщиков оборудования, включая Aivres, DDN, Dell Technologies, Eviden, Hitachi Vantara, HPE, Lenovo, Supermicro и VAST Data.

11.03.2024 [22:30], Сергей Карасёв

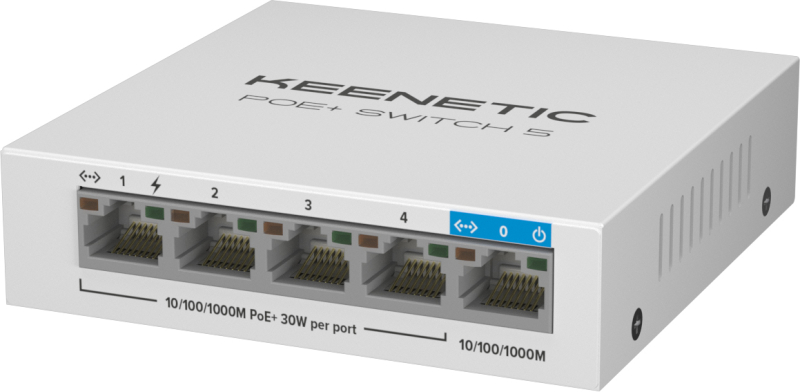

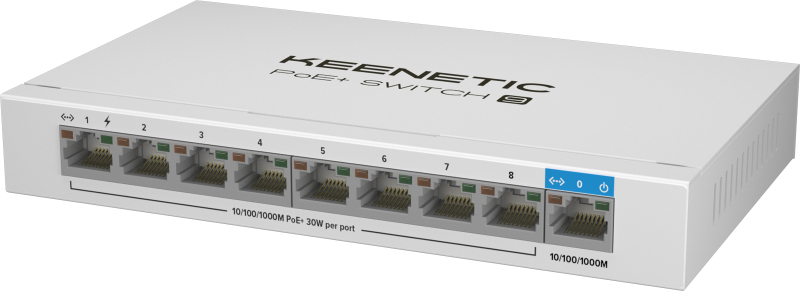

Keenetic представила компактные 1GbE-коммутаторы с поддержкой PoE+Производитель сетевого оборудования Keenetic анонсировал неуправляемые коммутаторы PoE+ Switch 5 и PoE+ Switch 9, которые подойдут, например, для построения mesh-сетей Wi-Fi, систем видеонаблюдения и телефонии. Устройства получили прочный металлический корпус для настольного или настенного размещения. Модель PoE+ Switch 5 (KN-4610) оснащена одним портом 1GbE RJ-45 и четырьмя портами 1GbE RJ-45 с поддержкой стандарта PoE+ (802.3af/at), каждый из которых имеет выходную мощность в 30 Вт. При этом общий бюджет мощности ограничен 60 Вт. Габариты составляют 100 × 100 × 26 мм, масса — 205 г. В свою очередь, вариант PoE+ Switch 9 (KN-4710) снабжён одним портом 1GbE RJ-45 и восемью портами 1GbE RJ-45 с поддержкой стандарта PoE+ с выходной мощностью 30 Вт. Общий бюджет мощности — 120 Вт. Устройство имеет габариты 177 × 105 × 26 мм и весит 427 г. Диапазон рабочих температур обоих коммутаторов — от 0 до +40 °C. Отмечается, что новинки ориентированы прежде всего на подключение нескольких точек доступа Orbiter Pro KN-2810 и Voyager Pro KN-3510. Кабельное соединение между узлами системы Mesh Wi-Fi Keenetic, главным интернет-центром и ретрансляторами обеспечивает максимальные производительность и зону покрытия сигнала, а технология PoE устраняет необходимость в наличии рядом с ТД электрических розеток. На коммутаторы предоставляется трёхлетняя гарантия. Стоимость Keenetic PoE+ Switch 5 и PoE+ Switch 9 на сайте производителя составляет соответственно 4490 и 8990 руб. Кроме того, компания предлагает 30-Вт PoE-инжектор (802.3af/at, PoE+) KN-4510 за 1990 руб. |

|