Материалы по тегу: ии

|

19.03.2025 [11:49], Сергей Карасёв

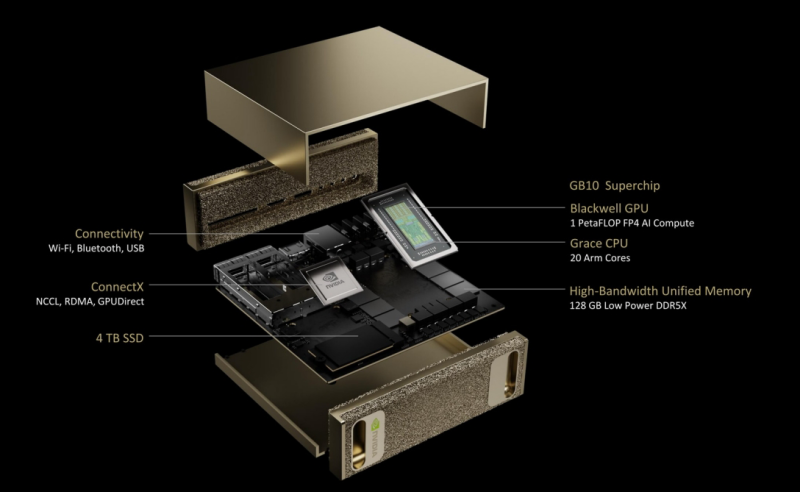

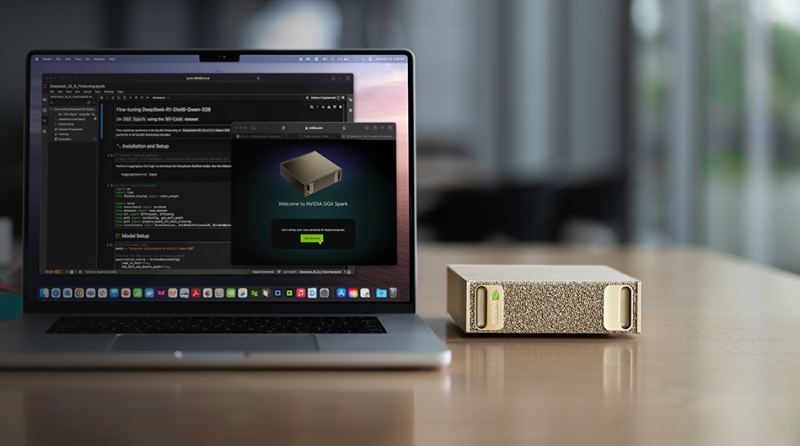

NVIDIA анонсировала мини-суперкомпьютер DGX Spark для ИИ-задачВместе с рабочей станцией DGX Station компания NVIDIA представила и мини-систему DGX Spark: это, как утверждается, самый компактный в мире суперкомпьютер для ИИ-задач. Система заключена в корпус с размерами всего 150 × 150 × 50,5 мм, а масса составляет около 1,2 кг. Новинка создавалась по проекту DIGITS. Основой служит платформа Blackwell Ultra с суперчипом Grace Blackwell GB10. Изделие содержит ускоритель Blackwell с тензорными ядрами пятого поколения, связанный посредством NVLink-C2C с 20-ядерным процессором Grace, который объединяет по 10 ядер Arm Cortex-X925 и Arm Cortex-A725. Заявленная ИИ-производительность достигает 1 Пфлопс на операциях FP4. Мини-ПК располагает 128 Гбайт памяти LPDDR5x с 256-бит шиной и пропускной способностью до 273 Гбайт/с. Установлен M.2 NVMe SSD вместимостью 1 или 4 Тбайт с шифрованием информации. Применяется сетевой адаптер NVIDIA ConnectX-7 SmartNIC. Кроме того, присутствуют контроллеры Wi-Fi 7 и Bluetooth 5.3.

Источник изображений: NVIDIA В набор интерфейсов входят четыре порта USB 4 Type-C (до 40 Гбит/с), коннектор RJ45 для сетевого кабеля (10GbE), разъём HDMI 2.1a. Заявленное энергопотребление составляет 170 Вт. Компьютер функционирует под управлением NVIDIA DGX OS — модификации Ubuntu, адаптированной для работы с ИИ. Отмечается, что новинка позволяет локально запускать «рассуждающие» ИИ-модели DeepSeek, Meta✴, Google и другие с 200 млрд параметров. Программный стек NVIDIA AI предоставляет доступ к необходимым ИИ-инструментам, фреймворкам, библиотекам и предварительно обученным моделям. Приём заказов на DGX Spark уже начался. Выпуском систем на данной платформе займутся ASUS, Dell и HP.

19.03.2025 [09:56], Сергей Карасёв

NVIDIA представила персональный ИИ-суперкомпьютер DGX Station на базе GB300NVIDIA анонсировала настольный ИИ-суперкомпьютер DGX Station на аппаратной платформе Blackwell Ultra. Устройство, оснащённое суперчипом Grace Blackwell GB300, ориентировано на ресурсоёмкие нагрузки ИИ, включая задачи инференса. По заявлениям NVIDIA, система DGX Station обеспечивает производительность уровня ЦОД в настольном формате. Задействован ускоритель GB300 с 288 Гбайт памяти HBM3E, которая обеспечивает пропускную способность до 8 Тбайт/с. Ускоритель Blackwell Ultra связан с процессором Grace с 72 Arm-ядрами Neoverse V2 посредством NVLink-C2C (900 Гбайт/с). При это сам модуль ускорителя съёмный. Система несёт на борту 496 Гбайт памяти LPDDR5X (четыре модуля SOCAMM) с пропускной способностью до 396 Гбайт/с. DGX Station оснащён 800G-адаптером NVIDIA ConnectX-8 SuperNIC (два порта QSFP или OSFP), а также два порта RJ45. На заднюю панель выведены четыре USB-порта Type-A и один Type-C, видеовыход MiniDP и шесть аудиоразъёмов. На самой плате присутствуют три PCIe-разъёма x16 и три слотам M.2. Кроме того, есть слот для карты с BMC. Прочие технические характеристики новинки пока не раскрываются. В качестве программной платформы применяется NVIDIA DGX OS — специализированная модификация Ubuntu, оптимизированная для работы с ИИ. Пользователи могут получить доступ к микросервисам NVIDIA NIM для быстрого развёртывания ИИ-моделей и программной экосистеме NVIDIA AI Enterprise в целом. Система демонстрирует ИИ-производительность до 20 Пфлопс в режиме FP4. Устройства DGX Station будут предлагаться такими партнёрами NVIDIA, как ASUS, Box, Dell, HPE, Lambda и Supermicro. Продажи начнутся позднее в текущем году.

19.03.2025 [08:28], Сергей Карасёв

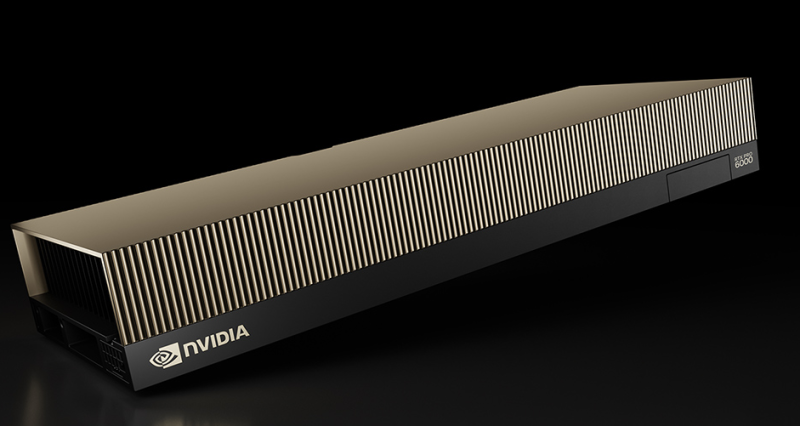

NVIDIA представила ускоритель RTX Pro 6000 Blackwell Server Edition с 96 Гбайт памяти GDDR7Компания NVIDIA анонсировала ускоритель RTX Pro 6000 Blackwell Server Edition для требовательных приложений ИИ и рендеринга высококачественной графики. Ожидается, что новинка будет востребована среди заказчиков из различных отраслей, включая архитектуру, автомобилестроение, облачные платформы, финансовые услуги, здравоохранение, производство, игры и развлечения, розничную торговлю и пр. Как отражено в названии, в основу решения положена архитектура Blackwell. Задействован чип GB202: конфигурация включает 24 064 ядра CUDA, 752 тензорных ядра пятого поколения и 188 ядер RT четвёртого поколения. Устройство несёт на борту 96 Гбайт памяти GDDR7 (ECC) с пропускной способностью до 1,6 Тбайт/с. Ускоритель RTX Pro 6000 Blackwell Server Edition использует интерфейс PCIe 5.0 x16. Энергопотребление может настраиваться в диапазоне от 400 до 600 Вт. Реализована поддержка DisplayPort 2.1 с возможностью вывода изображения в форматах 8K / 240 Гц и 16K / 60 Гц. Аппаратный движок NVIDIA NVENC девятого поколения значительно повышает скорость кодирования видео (упомянута поддержка 4:2:2 H.264 и HEVC). Всего доступно по четыре движка NVENC/NVDEC. По заявлениям NVIDIA, по сравнению с ускорителем предыдущего поколения L40S Ada Lovelace модель RTX PRO 6000 Blackwell Server Edition обеспечивает многократное увеличение производительности в широком спектре рабочих нагрузок. В частности, скорость инференса больших языковых моделей (LLM) повышается в пять раз для приложений агентного ИИ. Геномное секвенирование ускоряется практически в семь раз, а быстродействие в задачах генерации видео на основе текстового описания увеличивается в 3,3 раза. Достигается также двукратный прирост скорости рендеринга и примерно такое же повышение скорости инференса рекомендательных систем. Ускоритель RTX PRO 6000 Blackwell Server Edition может использоваться в качестве четырёх полностью изолированных экземпляров (MIG) с 24 Гбайт памяти GDDR7 каждый. Это обеспечивает возможность одновременного запуска различных рабочих нагрузок — например, ИИ-задач и обработки графики. Упомянута поддержка TEE.

19.03.2025 [02:06], Владимир Мироненко

Dell представили рабочие станции Pro Max с суперускорителями GB10 и GB300Dell представила рабочие станции Dell Pro Max with GB10 и Dell Pro Max with GB300, специально созданные для разработчиков ИИ-технологий, и базирующиеся на архитектуре NVIDIA Grace Blackwell, ранее эксклюзивной для систем ЦОД. Как сообщает компания, решения Dell Pro Max легко интегрируются в экосистему Dell AI Factory, предлагая единый опыт работы с ПО NVIDIA AI Enterprise. Это гарантирует, что разработчики, использующие Dell Pro Max with GB10 и Dell Pro Max with GB300, могут свободно перемещать свои модели между средами — с рабочего стола в DGX Cloud или инфраструктуры ЦОД Dell — практически без изменений кода. Новинки работают под управлением DGX OS и поставляются с предварительно настроенным стеком NVIDIA AI Enterprise, который в том числе включает инструменты NVIDIA Blueprints. Такой целостный подход ускоряет рабочие процессы и упрощает масштабирование, позволяя создавать и тестировать прототипы решений локально, а затем бесшовно масштабировать их в облаке или ЦОД. Объединяя эксперименты на рабочем столе и масштабируемость на уровне предприятия, Dell позволяет разработчикам ИИ с легкостью внедрять инновации, говорит компания. Dell Pro Max with GB10, созданный для разработчиков, исследователей и студентов, представляет собой компактный мощный ПК с FP4-производительностью до 1 Пфлопс. Он позволяя создавать прототипы, настраивать и развёртывать рассуждающие ИИ-модели, включащие до 200 млрд параметров. В свою очередь, Dell Pro Max with GB300 позиционируется как идеальное решение для продвинутых разработчиков ИИ, которым требуется производительность ИИ-сервера на рабочем столе. Dell Pro Max with GB300 базируется на суперускорителе NVIDIA GB300 (Blackwell Ultra) с 784 Гбайт унифицированной памяти (288 Гбайт памяти HBME3e у ускорителя и 496 Гбайт LPDDR5X у CPU) и 800GbE-адаптером (ConnectX-8 SuperNIC). FP4-производительность составляет до 20 Пфлопс, что делает его идеальным решением для обучения и инференса крупномасштабных рабочих ИИ-нагрузок с использованием больших языковых моделей (LLM) с 460 млрд параметров.

18.03.2025 [23:26], Владимир Мироненко

Dell представила сервер PowerEdge XE8712 на базе NVIDIA GB200 NVL4Компания Dell представила сервер PowerEdge XE8712, предназначенный для обработки разнообразных ИИ-нагрузок и HPC, включая обучение ИИ-моделей, молекулярное моделирование, геномное секвенирование, а также моделирование процессов на финансовых рынках.

Источник изображений: Dell В основе PowerEdge XE8712 лежит плата NVIDIA GB200 NVL4. Сервер оснащён суперчипом GB200 Grace Blackwell Superchip, включающим четыре ускорителя B200 Blackwell и два 72-ядерных Arm-процессора NVIDIA Grace. Как отмечает производитель, благодаря возможности установки до 144 ускорителей NVIDIA Blackwell (36 узлов) в одну стойку Dell серии IR7000, XE8712 обеспечивает одну из самых высоких в отрасли плотностей размещения GPU. Это позволяет выполнять больше рабочих нагрузок ИИ и HPC в меньшем физическом пространстве, снижая эксплуатационные расходы без ущерба для вычислительной мощности. Для отвода тепла в XE8712 используется технология прямого жидкостного охлаждения (DLC) — до 264 кВт на стойку. Dell IR7000 отличается раздельными полками питания с общей шиной питания мощностью до 480 кВт. Эта модульная ORv3-стойка легко интегрируется в различное окружения и будет совместима с серверами Dell PowerEdge следующего поколения.

18.03.2025 [21:24], Андрей Крупин

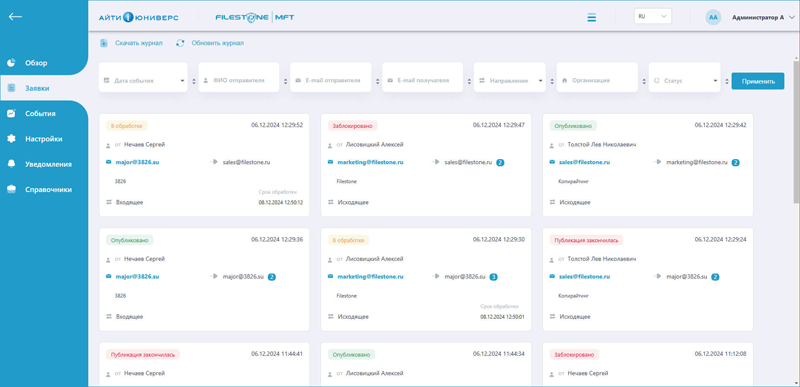

Российская система контролируемого обмена файлами Filestone MFT получила крупное обновлениеКомпания «Центр бизнес-технологий» сообщила о выпуске новой версии программного решения Filestone MFT 2.3, предназначенного для защищённой передачи файлов, в том числе большого объёма, адресатам за пределами корпоративной сети. Созданный отечественными разработчиками продукт позволяет организовать безопасный канал отправки и приёма данных в изоляции от внешней информационной инфраструктуры предприятия. Filestone MFT поддерживает интеграцию со службами каталогов Active Directory/LDAP, включает различные средства мониторинга и контроля пересылаемых данных, работает в различных операционных системах и браузерах, умеет анализировать файлы на наличие вредоносного кода и может быть использован для повышения уровня безопасности чувствительной информации при передаче по незащищённым каналам связи и снижения рисков утечек данных. Решение зарегистрировано в реестре российского ПО и может применяться с целью импортозамещения зарубежных аналогов.

Пользовательский интерфейс Filestone (источник изображения: filestone.ru) В Filestone MFT версии 2.3 команда разработчиков продукта исправила десятки ошибок и уязвимостей, оптимизировала код и интерфейс, а также внедрила новые функции, такие как автоматическое формирование сопроводительных писем, подсказки в заполняемых пользователем полях, фильтрация таблиц и бесшовное применение глобальных настроек. Встроенная в программный комплекс система защиты Guardant теперь позволяет определять лицензионные версии ПО, оберегая от человеческой ошибки или подмены дистрибутива. Вместе с функциональными изменениями обновлённый релиз Filestone MFT принёс расширенный до нескольких месяцев период пилотного тестирования, упрощённое развёртывание, а также новые цены и два типа лицензий, предполагающих пользование продуктом в течение неограниченного срока либо в рамках годовой подписки.

18.03.2025 [20:27], Татьяна Золотова

«ДАТАРК» запустил тест-драйв российской системы мониторинга и управления ЦОД DATCHECKРоссийский разработчик и производитель модульных дата-центров «ДАТАРК» запустил тест-драйв программно-аппаратного комплекса DATCHECK — автоматизированной системы мониторинга и управления ЦОД. Решение позволяет отслеживать состояние инженерной инфраструктуры, контролировать ее работу и предотвращать аварийные ситуации. Решение построено на основе отечественного импортонезависимого ПО и оборудования (минимум 95 % номенклатуры). Как сообщается в пресс-релизе, DATCHECK оперативно и заблаговременно уведомляет об аварийных ситуациях, ведет контроль и расчет PUE, проводит централизацию мониторинга и управления ЦОД. Кроме того, решение оптимизирует задачи персонала, автоматически настраивая отчетности, в том числе с отправкой в РСО, сохраняя эксплуатационную документацию, уменьшая время простоя. Тестовый комплект поставляется в двух защитных боксах. В одном находится шесть беспроводных датчиков температуры и влажности и датчик протечки, в другом — промышленный компьютер с сенсорным дисплеем и предустановленной системой DATCHECK. Датчики работают автономно до семи дней и обеспечивают круглосуточную диагностику. Решение позволяет контролировать работу двух ИБП и двух прецизионных кондиционеров.

18.03.2025 [20:17], Татьяна Золотова

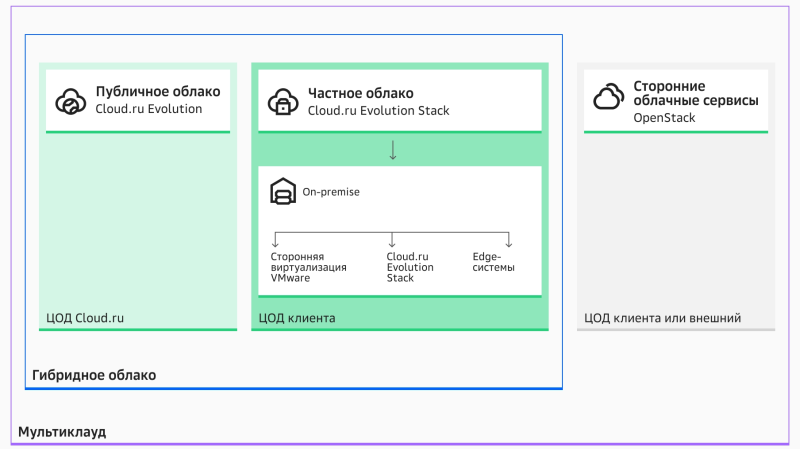

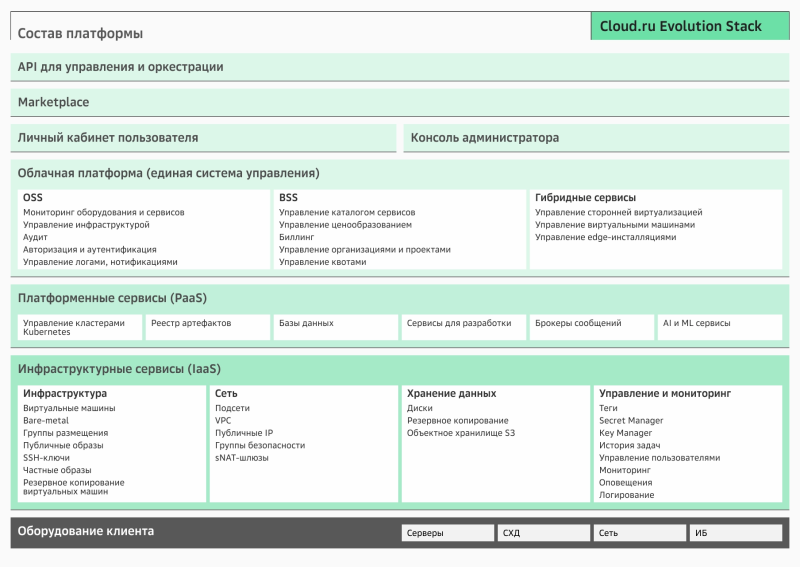

Cloud.ru запустил платформу Evolution Stack для создания частных и гибридных облаковПровайдер облачных и ИИ-технологий Cloud.ru вывел на рынок Cloud.ru Evolution Stack — продукт для создания частных и гибридных облаков в ИТ-ландшафте клиента. Новый продукт сокращает сроки разработки и тестирования отраслевых технологических решений. В том числе предлагаются готовые конфигурации с набором IaaS/PaaS-сервисов. Об этом сообщает пресс-служба компании. В основе решения лежит единый с публичным облаком Cloud.ru Evolution технологический стек собственной разработки. Как сообщает пресс-служба компании, платформа разработана с учетом растущего спроса на гибридное и частное облака, включая периферийные вычисления и поддержку ИИ-нагрузок. Модульная облачная платформа позволяет построить частное облако в собственном дата-центре, а также развернуть гибридную инфраструктуру, объединяя возможности публичного облака Cloud.ru Evolution и on-premise инфраструктуру, включая системы виртуализации. Решение включает функциональные системы управления операциями и эксплуатацией облачной инфраструктуры. Эти модули упрощают учет ресурсов, биллинг, контроль SLA, позволяя вести мониторинг производительности оборудования и сервисов, проактивно выявлять неисправности. Также можно формировать индивидуальные продуктовые каталоги, управлять доступами, тарифами и квотами, настраивать проектную иерархию и гибкое разделение вычислительных ресурсов. Консоль управления и модуль Multicloud Manager позволяют централизованно администрировать облачную инфраструктуру как on-premise, так и в публичном облаке Cloud.ru. Модуль VM Manager позволяет настроить индивидуальные политики управления виртуальной инфраструктурой и в автоматическом режиме проверять ее на соответствие корпоративным стандартам кибербезопасности и наличие угроз.

18.03.2025 [20:08], Татьяна Золотова

«Аквариус» интегрирует российские крипточипы в свои устройства

hardware

аквариус

аладдин рд

информационная безопасность

кии

криптография

сделано в россии

шифрование

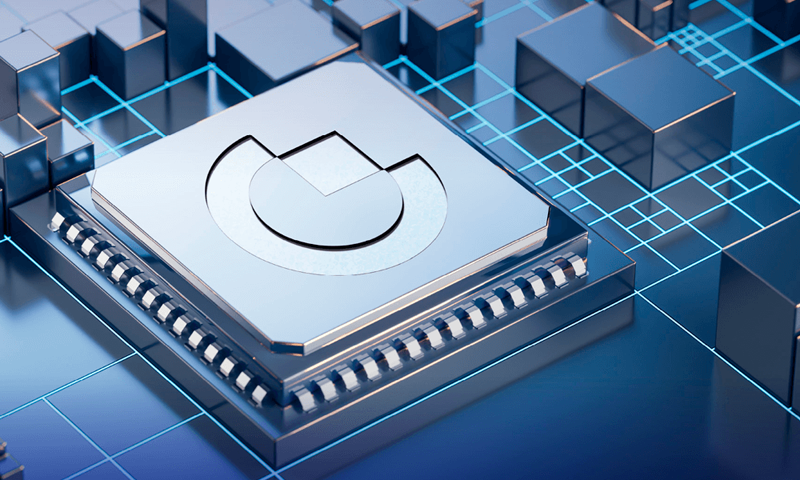

ГК «Аквариус» совместно с разработчиками «Аладдин» и «Актив» интегрирует крипточипы в свои устройства на аппаратном уровне. Это решение позволит российским предприятиям повысить безопасность своей ИТ-инфраструктуры без дополнительных программных доработок. Разработанные чипы безопасности обеспечивают хранение криптографических ключей, а также поддерживают критически важные процессы: аутентификацию доверенных устройств, безопасную загрузку ПО и защиту каналов передачи данных. Модули безопасности могут быть эффективно использованы при создании доверенных изделий для КИИ-отраслей: промышленности, энергетики, медицины и финансового сектора. Пока проект находится на стадии пилота, по его завершению будет запущено серийное производство. Как отмечают в «Аквариусе», в отрасли все больше внимания уделяется вопросам аппаратной безопасности. Предстоящие изменения в регуляторной базе подтверждают необходимость интеграции чипов безопасности в устройства. До 1 января 2025 года на объектах КИИ должен быть завершен процесс импортозамещения всего ПО и программно-аппаратных комплексов (ПАК).

Источник изображения: «Актив» Согласно данным ФСТЭК России, около 47 % из 170 российских организаций критической информационной инфраструктуры (КИИ), защита от киберугроз находится в критическом состоянии. Лишь у 13 % из них установлен минимальный базовый уровень защиты, а у около 40 % он относится к низким. В числе типовых недостатков в защите КИИ представитель ФСТЭК назвал отсутствие двухфакторной аутентификации и критические уязвимости на периметре IT-инфраструктур.

18.03.2025 [19:04], Руслан Авдеев

Crusoe получит 4,5 ГВт от газовых электростанций для питания ИИ ЦОДКомпания Crusoe Energy получит 4,5 ГВт от газовых электростанций для питания ИИ ЦОД. Строитель дата-центров создал совместное предприятие с американским хедж-фондом Engine No. 1, сообщает пресс-служба Crusoe. Ранее Engine No. 1 заключила с американским нефтегазовым гигантом Chevron соглашение о постройке электростанций, работающих на природном газе и использующих турбины GE Vernova. Электростанции будут питать дата-центры напрямую, без подключения к общей энергосети. Энергия, вероятно, будет доступна уже к 2027 году. Первый объект Stargate возводится на площадке Crusoe в техасском Абилине (Abilene). Он будет запитан от газовых турбин мощностью 360 МВт от всё той же GE Vernova. Дополнительно кампус получит солнечную электростанцию и энергохранилище. Пока нет точных данных, сколько из 4,5 ГВт достанется исключительно Stargate. Crusoe заявила, что пока ведёт переговоры с несколькими гиперскейлерами. Огромная мощность, которую получит Crusoe, делает компанию весьма привлекательным партнёром для гиперскейлеров, желающих быстро нарастить ёмкость ЦОД. Для сравнения: год назад ёмкость всех дата-центров Microsoft была на уровне 5 ГВт. Природный газ многими рассматривается как более экобезопасная альтернатива другим видам ископаемого топлива. Впрочем, такая энергия всё равно не столь «чиста», как получаемая из возобновляемых источников. Как сообщают в Engine No. 1, стратегическое партнёрство использует сильные стороны Crusoe в строительстве дата-центров, а фонд займётся обеспечением поставок энергии. Как это соотносится с планами Chevron строить собственные ЦОД и снабжать их энергией от семи генераторов GE Vernova, пока неизвестно. |

|