Материалы по тегу: llm

|

07.08.2025 [16:00], Владимир Мироненко

В Yandex Cloud AI Studio появились открытые модели OpenAIYandex B2B Tech открыла API-доступ на платформе Yandex Cloud AI Studio к новым рассуждающим open source моделям OpenAI gpt-oss-120b и gpt-oss-20b. С помощью новых моделей можно создавать агентские системы для выполнения различных задач, например, для автоматизации рекрутмента и технической поддержки, анализа и обработки документов и первичной коммуникации с клиентами, говорит компания. Доступность новых моделей по API позволяет российскому бизнесу использовать технологии OpenAI в бизнес-процессах без задействования собственной инфраструктуры. Использовать ИИ-модели напрямую у разработчика российским компаниям вряд ли удастся, так как для этого нужно передавать данные для обработки за рубеж, что идёт вразрез с требованиями российского законодательства. Как отметила Yandex B2B Tech, при использовании Yandex Cloud AI Studio данные компаний хранятся и обрабатываются в российских ЦОД, и её сервис полностью соответствует требованиям закона «О персональных данных». Сообщается, что указанные нейросети сопоставимы по качеству с ведущими моделями OpenAI o3-mini и o4-mini, и в некоторых сценариях превосходят GPT-4o и o1. В них допускается регулировка интенсивности рассуждений и скорости генерации ответа. Вскоре для этих моделей будет доступен вызов функций для взаимодействия с внешними приложениями, что позволит осуществлять поиск информации в интернете при генерации ответа.

12.07.2025 [01:00], Руслан Авдеев

NVIDIA, Cisco и Indosat помогут Индонезии встать на ИИ-рельсы

cisco

indosat ooredoo hutchison

llm

nvidia

software

ии

индонезия

информационная безопасность

конфиденциальность

обучение

разработка

Индонезия сделала важный шаг к созданию суверенного ИИ, объявив о создании «Центра передового опыта в сфере ИИ» (AI Center of Excellence, CoE). Проект реализуется под руководством Министерства цифровых коммуникаций и информации (Komdigi) и при поддержке NVIDIA, Cisco и телеком-оператора Indosat Ooredoo Hutchison (IOH). Центр станет частью национальной инициативы «Золотое видение 2045» (Golden 2045 Vision), направленной на цифровую трансформацию экономики и развитие инноваций. В задачи CoE входят развитие локальной ИИ-инфраструктуры, подготовка кадров и поддержка стартапов. Частью CoE станет NVIDIA AI Technology Center, который обеспечит поддержку исследований в области ИИ, предоставит доступ к программе NVIDIA Inception для стартапов и предложит обучение в экосистеме NVIDIA Deep Learning Institute. Также CoE получит типовую суверенную ИИ-фабрику с новейшими ускорителями Blackwell. Дополнительно курируемый государством форум разработает надёжные ИИ-фреймворки для создания решений, соответствующих местным ценностям. Важное внимание уделяется вопросам кибербезопасности. На базе центра заработает система Sovereign Security Operations Center Cloud Platform, разработанная Cisco, сочетающая ИИ-распознавание угроз, локальное управление данными и управляемые сервисы обеспечения безопасности. Проект строится на четырёх стратегических столпах:

Источник изображения: Jeremy Bishop/unspalsh.com Уже сейчас около 30 независимых разработчиков и стартапов используют ИИ-инфраструктуру IOH на базе NVIDIA. С учётом того, что Indosat покрывает связью весь индонезийский архипелаг, компания может обслуживать сотни миллионов носителей индонезийского языка (Bahasa Indonesia) с помощью приложений на основе специальных LLM, таких как Indosat Sahabat-AI. В будущем Indosat и NVIDIA намерены внедрять технологии AI-RAN, позволяющие охватывать ещё более широкий круг людей, которые смогут пользоваться ИИ с помощью беспроводных сетей. Индонезия давно стала весьма привлекательным рынком для инвесторов. Так, Microsoft намерена в течение четырёх лет инвестировать в облачную инфраструктуру и ИИ-проекты Индонезии $1,7 млрд. А NVIDIA и Indosat Ooredoo Hutchison планируют построить ИИ-центр стоимостью $200 млн в Центральной Яве, $500 млн намерена инвестировать Tencent. Даже «Яндекс» имеет там собственные интересы.

15.06.2025 [23:29], Владимир Мироненко

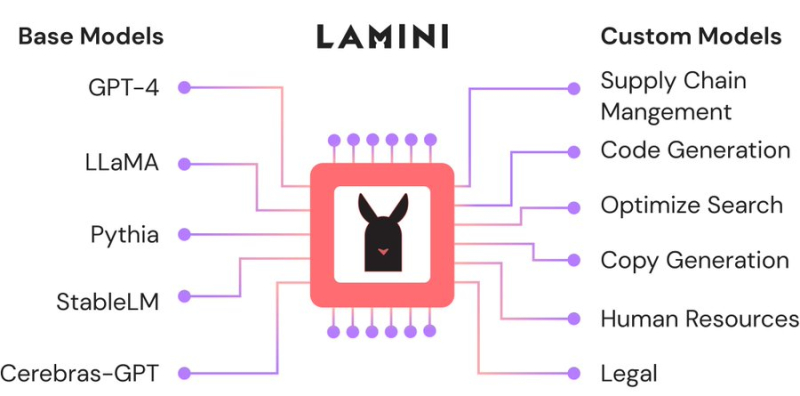

Большая жатва: AMD назначила вице-президентом по ИИ гендиректора ИИ-стартапа Lamini, в который сама же и вложиласьAMD продолжает укреплять команду специалистов в сфере ИИ за счёт привлечения талантливых разработчиков, а также поглощения ИИ-стартапов. На минувшей неделе Шарон Чжоу (Sharon Zhou, вторая справа на фото ниже), соучредитель и гендиректор ИИ-стартапа Lamini (PowerML Inc.) сообщила в соцсети X, что она и несколько сотрудников присоединяются к AMD. Комментируя переход, представитель AMD сообщил ресурсу CRN, что это было наймом специалистов, а не приобретением команды, как это было в случае с разработчиком ИИ-чипов Untether AI, который фактически прекратил существование после сделки. В настоящее время неизвестно, какой будет дальнейшая судьба Lamini, которую в прошлом году покинул Грег Диамос (Greg Diamos), бывший архитектор ПО NVIDIA CUDA, основавший компанию вместе с Чжоу в 2022 году. До основания Lamini Чжоу работала менеджером по ML-продуктам в Google, менеджером по продуктам в ИИ-стартапах Kensho Technologies и Tamr, а также занимала должность внештатного преподавателя компьютерных наук в Стэнфордском университете, где она получила докторскую степень по этой же специальности. В AMD её назначили на должность вице-президента по ИИ. Платформа Lamini позволяет компаниям настраивать и кастомизировать большие языковые модели (LLM) с использованием собственных данных. В частности, Lamini предложила новый подход под названием Mixture of Memory Experts (MoME), направленный на повышение производительности LLM и фактической точности путем радикального снижения частоты галлюцинаций с 50 % до 5 %. Утверждается, что этот подход позволяет значительно сократить объём вычислительных ресурсов для обучения LLM, а также продолжительность этого процесса. В 2023 году AMD представила Lamini как одного из первых независимых поставщиков ПО, поддержавших её ускорители Instinct. В сентябре того же года Lamini сообщила, что использует более чем 100 ускорителей серии Instinct MI200 и что платформа AMD ROCm «достигла программного паритета» с NVIDIA CUDA. До определённого момента ИИ-платформа Lamini была единственной коммерческой платформой, целиком и полностью работающей на базе AMD Instinct. В прошлом году стартап привлек финансирование в размере $25 млн от нескольких инвесторов, включая венчурное подразделение AMD, Эндрю Ына (Andrew Ng), гендиректора Dropbox Дрю Хьюстона (Drew Houston), и Лип-Бу Тана (Lip-Bu Tan), который в начале этого года стал гендиректором Intel. Помимо команды Untether AI, AMD приобрела в течение последних нескольких неделе разработчика систем кремниевой фотоники Enosemi и стартапа Brium, специализирующегося на инструментах оптимизации ИИ ПО для различной аппаратной инфраструктуры.

14.06.2025 [17:04], Владимир Мироненко

Scale AI получила от Meta✴ более $14 млрд, но потеряла гендиректора и рискует лишиться крупных контрактов с Gooogle, Microsoft, OpenAI и xAIИИ-стартап Scale AI, занимающийся подготовкой, оценкой и разметкой данных для обучения ИИ-моделей, объявил о крупной инвестиционной сделке с Meta✴, по результатм которой его рыночная стоимость превысила $29 млрд. Сделка существенно расширит коммерческие отношения Scale и Meta✴. Также её условиями предусмотрен переход гендиректора Scale AI Александра Ванга (Alexandr Wang) и ещё ряда сотрудников в Meta✴. Вместо Ванга, который останется в совете директоров стартапа, временно исполняющим обязанности гендиректора Scale AI назначен Джейсон Дроги (Jason Droege), директор по стратегии, имеющий «20-летний опыт создания и руководства знаковыми технологическими компаниями, включая Uber Eats и Axon». Представитель Scale AI уточнил в интервью ресурсу CNBC, что Meta✴ вложит в компанию $14,3 млрд, в результате чего получит в ней 49-% долю акций, но без права голоса. «Мы углубим совместную работу по созданию данных для ИИ-моделей, а Александр Ванг присоединится к Meta✴ для работы над нашими усилиями по созданию суперинтеллекта», — рассказал представитель Meta✴. Переманивая Ванга, который не имея опыта в R&D, сумел с нуля создать крупный бизнес в сфере ИИ, гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) делает ставку на его организаторские способности, полагая, что укрепить позиции Meta✴ в сфере ИИ под силу опытному бизнес-лидеру, больше похожему на Сэма Альтмана (Sam Altman), чем на учёных, стоящих у руля большинства конкурирующих ИИ-лабораторий, пишет Reuters. Инвестиции в Scale AI станут вторыми по величине в истории Meta✴ после приобретения WhatsApp за $19 млрд. Однако сделка может оказаться не совсем выгодной для Scale AI, предупреждает Reuters, поскольку многие компании, являющиеся клиентами Scale AI, могут отказаться от дальнейшего сотрудничества из-за опасений по поводу того, что Ванг, оставаясь в совете директоров стартапа, будет предоставлять Meta✴ внутреннюю информацию о приоритетах конкурентов. Представитель Scale AI заверил, что инвестиции Meta✴ и переход Ванга не повлияют на клиентов стартапа, и что Meta✴ не будет иметь доступа к его какой-либо деловой информации или данным. Тем не менее, по словам источников Reuters, Google, один их крупнейших клиентов Scale AI, планирует разорвать отношения со стартапом. Источники сообщили, что Google планировала потратить $200 млн только в этом году на услуги Scale AI по подгтовке и разметке данных людьми. После объявления о сделке поисковый гигант уже провёл переговоры с несколькими конкурентами Scale AI. Scale AI получила в 2024 году размере $870 млн, из них около около $150 млн от Google, утверждают источники. По их словам, другие крупные клиенты, включая Microsoft, OpenAI и xAI, тоже планируют отказаться от услуг Scale AI. Официальных подтверждений этой информации пока не поступало. А финансовый директор OpenAI заявил в пятницу, что компания, которой источники тоже приписывают намерение отказаться от услуг Scale AI, продолжит работать со стартапом, как с одним из своих многочисленных поставщиков данных.

07.06.2025 [22:49], Владимир Мироненко

От «железа» до агентов: «К2 НейроТех» представил ПАК-AI для разработки и внедрения ИИ на предприятиях«К2 НейроТех», подразделение компании «К2Тех», представило программно-аппаратный комплекс ПАК-AI, позволяющий оперативно интегрировать ИИ в действующую ИТ-среду организации в соответствии с её требованиями и политиками безопасности. ПАК-AI включает аппаратную часть, программную платформу, а также инструменты для работы с данными, ИИ-моделями, промтами, визуализациями, API-интеграцией и т. д. Первый вариант ПАК-AI построен на базе оборудования YADRO: шесть серверов, включая ИИ-сервер с восемью GPU и сетевые коммутаторы KORNFELD. Управление ПАК-AI осуществляется через портал — специализированную GUI-платформу, служащую единой точкой входа для работы с вычислительными ресурсами, для запуска моделей, настройки среды и контроля загрузки. Платформа обеспечивает управление виртуальными машинами с ускорителями для изолированных задач и контейнерами Kubernetes для обеспечения гибкости и масштабируемости. Платформа обеспечивает доступ к предустановленному ПО: ОС (Astra Linux, CentOS, РЕД ОС), ML-инструментам, моделям и средам разработки.

Источник изображений: «К2 НейроТех» Клиенту доступны функции маршрутизации данных, оркестрации, мониторинга, управления файловыми системами и каталогами, резервного копирования и обеспечения безопасности. Использование ресурсов фиксируется автоматически с отображением их стоимости в разделе биллинга. Разработчикам предоставляется весь необходимый стек инструментов для администрирования моделей. Помимо доступа к востребованным средам, таким как TensorFlow, PyTorch, Keras, HuggingFace Transformers, специалисты имеют возможность разворачивать собственные окружения в виде ВМ или контейнеров, устанавливать дополнительные библиотеки, использовать кастомные образы и конфигурации. Также предоставляется возможность построения MLOps-конвейеров с использованием MLflow, Hydra, Optuna. Прикладной слой платформы представляет собой каталог готовых агентов и моделей, разработанных К2 НейроТех. Он включает решения как на базе открытых, так и вендорских моделей, в том числе YandexGPT mini, GigaChat lite, DeepSeek, Llama, Qwen и другие. Пользователи смогут их обучать на корпоративных данных, адаптировать под бизнес-процессы и применять в прикладных сценариях: от обработки документов и генерации контента до автоматизации клиентского взаимодействия, производственной аналитики и других узкоспециализированных прикладных задач. В ПАК-AI может использоваться отечественное оборудование любых вендоров и ПО, разработанное как на основе решений из реестров Минцифры и Минпромторга России, так и на открытом ПО, что позволяет менять конфигурацию с соответствии с требованиями регуляторов. ПАК-AI реализован в формате IaaS (предоставление вычислительных ресурсов), PaaS (маркетплейс приложений для ML-команд с предоставлением доступа к нужной инфраструктуре и сервисам), SaaS (доступ к предустановленным приложениям от сторонних вендоров). Также с его помощью можно организовать внутренний сервис ИИ-как-услуга (AIaaS) для предоставления LLM и агентов.

07.06.2025 [16:24], Владимир Мироненко

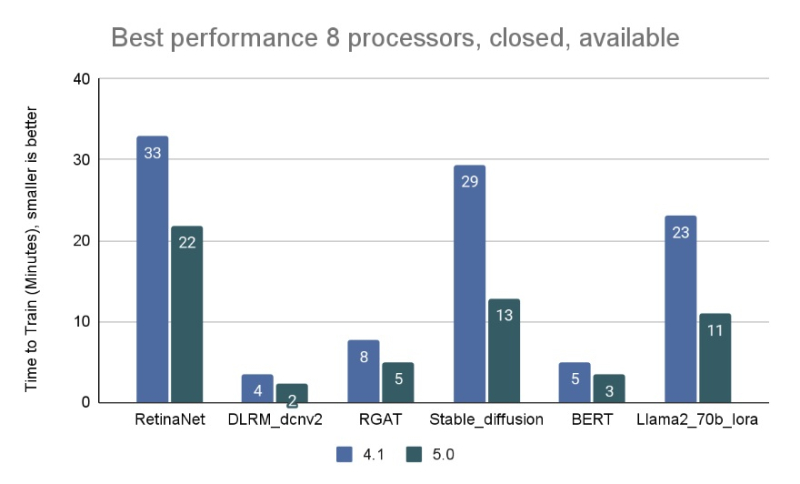

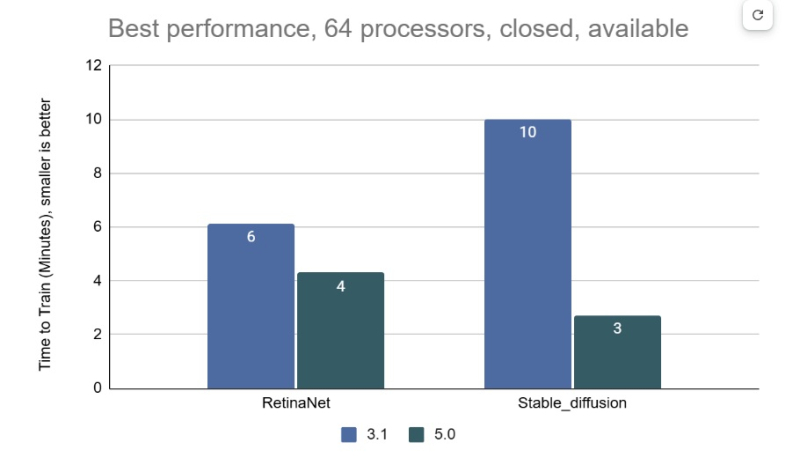

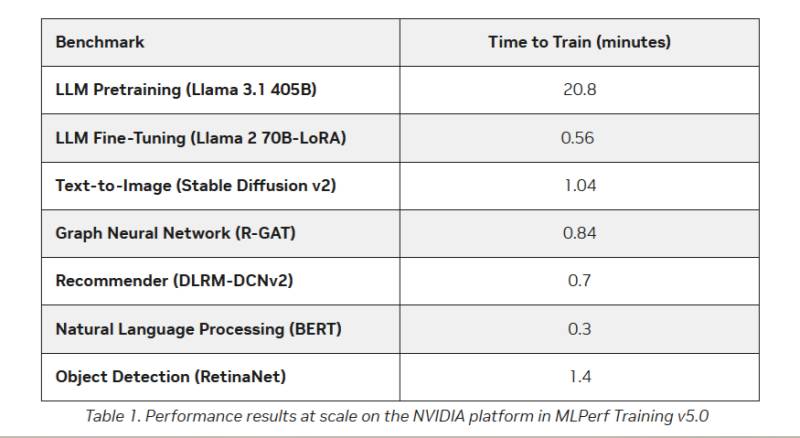

AMD впервые приняла участие в бенчмарке MLPerf Training, но до рекордов NVIDIA ей ещё очень далекоКонсорциум MLCommons объявил новые результаты бенчмарка MLPerf Training v5.0, отметив быстрый рост и эволюцию в области ИИ, а также рекордное количество общих заявок и увеличение заявок для большинства тестов по сравнению с бенчмарком v4.1. MLPerf Training v5.0 предложил новый бенчмарк предварительной подготовки большой языковой модели на основе Llama 3.1 405B, которая является самой большой ИИ-моделью в текущем наборе тестов обучения. Он заменил бенчмарк на основе gpt3 (gpt-3-175B), входивший в предыдущие версии MLPerf Training. Целевая группа MLPerf Training выбрала его, поскольку Llama 3.1 405B является конкурентоспособной моделью, представляющей современные LLM, включая последние обновления алгоритмов и обучение на большем количестве токенов. Llama 3.1 405B более чем в два раза больше gpt3 и использует в четыре раза большее контекстное окно. Несмотря на то, что бенчмарк на основе Llama 3.1 405B был представлен только недавно, на него уже подано больше заявок, чем на предшественника на основе gpt3 в предыдущих раундах, отметил консорциум. MLCommons сообщил, что рабочая группа MLPerf Training регулярно добавляет новые рабочие нагрузки в набор тестов, чтобы гарантировать, что он отражает тенденции отрасли. Результаты бенчмарка Training 5.0 показывают заметный рост производительности для новых бенчмарков, что указывает на то, что отрасль отдаёт приоритет новым рабочим нагрузкам обучения, а не старым. Тест Stable Diffusion показал увеличение скорости в 2,28 раза для восьмичиповых систем по сравнению с версией 4.1, вышедшей шесть месяцев назад, а тест Llama 2.0 70B LoRA увеличил скорость в 2,10 раза по сравнению с версией 4.1; оба превзошли исторические ожидания роста производительности вычислений с течением времени в соответствии с законом Мура. Более старые тесты в наборе показали более скромные улучшения производительности. На многоузловых 64-чиповых системах тест RetinaNet показал ускорение в 1,43 раза по сравнению с предыдущим раундом тестирования v3.1 (самым последним, включающим сопоставимые масштабные системы), в то время как тест Stable Diffusion показал резкое увеличение в 3,68 раза. «Это признак надёжного цикла инноваций в технологиях и совместного проектирования: ИИ использует преимущества новых систем, но системы также развиваются для поддержки высокоприоритетных сценариев», — говорит Шрия Ришаб (Shriya Rishab), сопредседатель рабочей группы MLPerf Training. В заявках на MLPerf Training 5.0 использовалось 12 уникальных чиповых, все в категории коммерчески доступных. Пять из них стали общедоступными с момента выхода последней версии набора тестов MLPerf Training:

Заявки также включали три новых семейства процессоров:

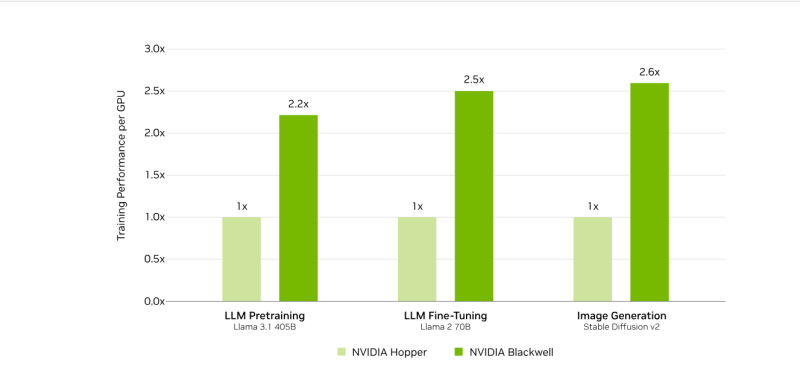

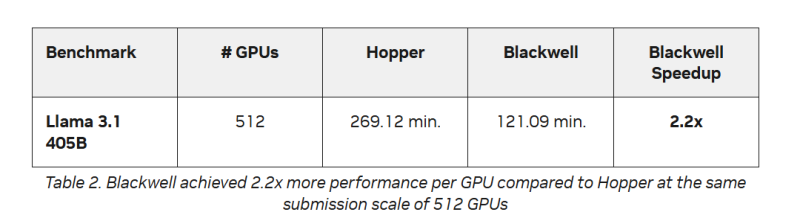

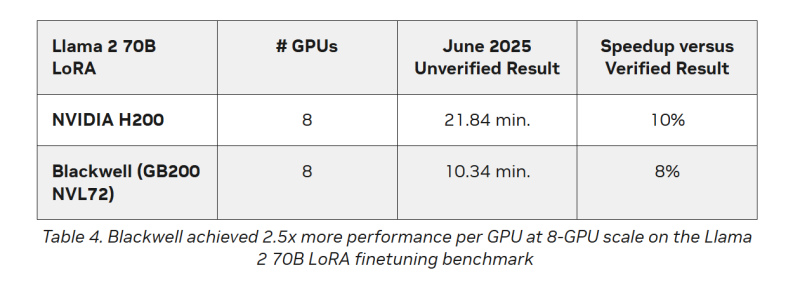

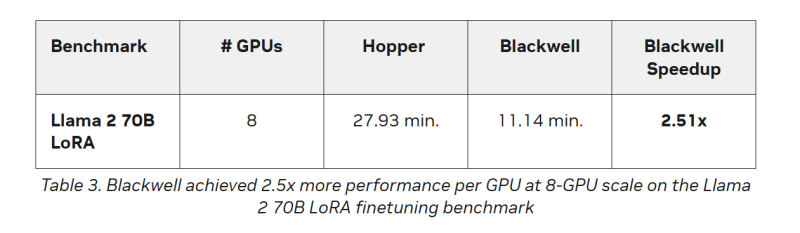

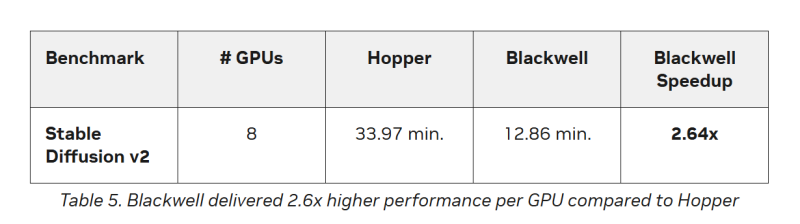

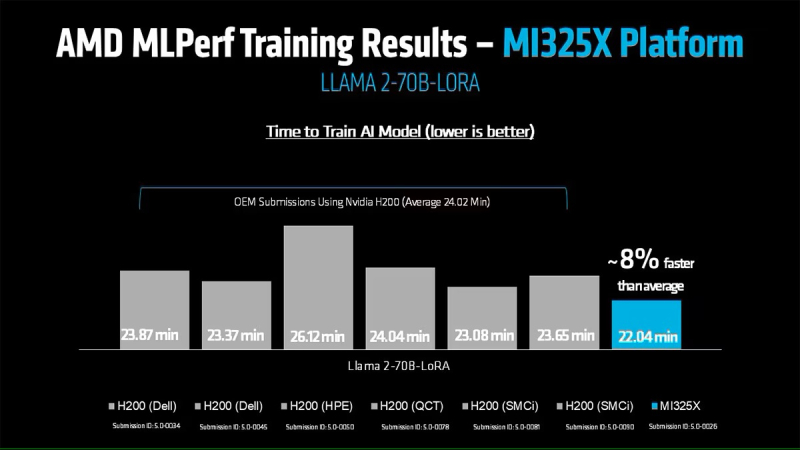

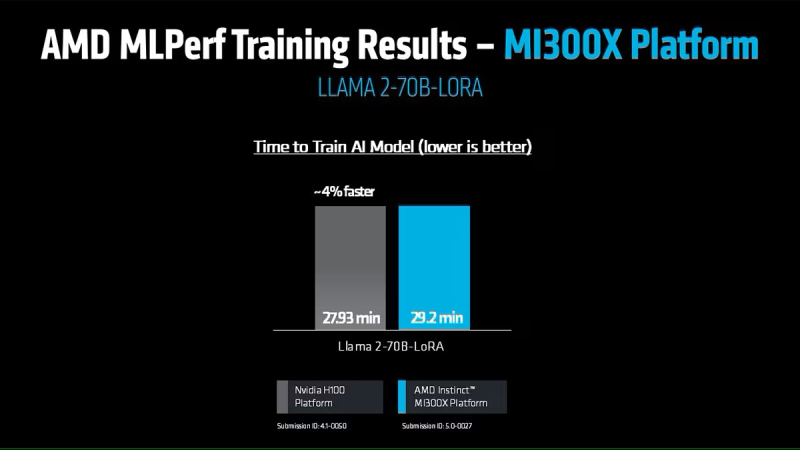

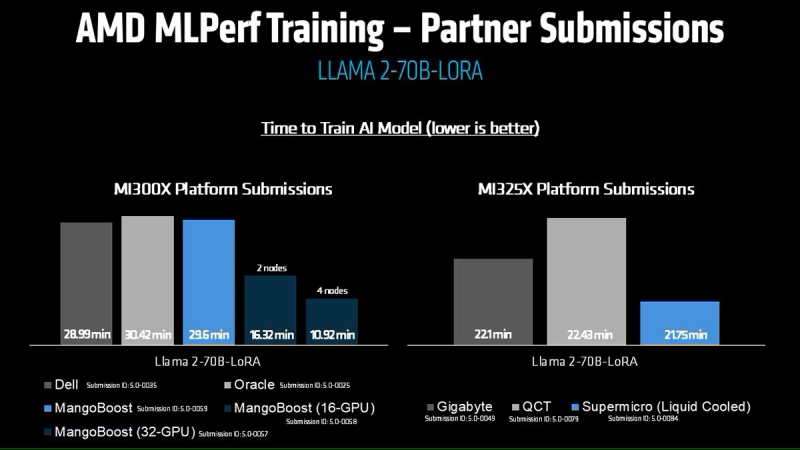

Кроме того, количество представленных многоузловых систем увеличилось более чем в 1,8 раза по сравнению с версией бенчмарка 4.1. Хиуот Касса (Hiwot Kassa), сопредседатель рабочей группы MLPerf Training, отметил растущее число провайдеров облачных услуг, предлагающих доступ к крупномасштабным системам, что делает доступ к обучению LLM более демократичным. Последние результаты MLPerf Training 5.0 от NVIDIA показывают, что её ускорители Blackwell GB200 демонстрируют рекордные результаты по времени обучения, демонстрируя, как стоечная конструкция «ИИ-фабрики» компании может быстрее, чем раньше, превращать «сырые» вычислительные мощности в развёртываемые модели, пишет ресурс HPCwire. Раунд MLPerf Training v5.0 включает 201 результат от 20 организаций-участников: AMD, ASUS, Cisco, CoreWeave, Dell, GigaComputing, Google Cloud, HPE, IBM, Krai, Lambda, Lenovo, MangoBoost, Nebius, NVIDIA, Oracle, QCT, SCITIX, Supermicro и TinyCorp. «Мы бы особенно хотели поприветствовать впервые подавших заявку на участие в MLPerf Training AMD, IBM, MangoBoost, Nebius и SCITIX, — сказал Дэвид Кантер (David Kanter), руководитель MLPerf в MLCommons. — Я также хотел бы выделить первый набор заявок Lenovo на результаты тестов энергопотребления в этом раунде — энергоэффективность в системе обучения ИИ-систем становится всё более важной проблемой, требующей точного измерения». NVIDIA представила результаты кластера на основе систем GB200 NVL72, объединивших 2496 ускорителей. Работая с облачными партнерами CoreWeave и IBM, компания сообщила о 90-% эффективности масштабирования при расширении с 512 до 2496 ускорителей. Это отличный результат, поскольку линейное масштабирование редко достигается при увеличении количества ускорителей за пределами нескольких сотен. Эффективность масштабирования в диапазоне от 70 до 80 % уже считается солидным результатом, особенно при увеличении количества ускорителей в пять раз, пишет HPCwire. В семи рабочих нагрузках в MLPerf Training 5.0 ускорители Blackwell улучшили время сходимости «до 2,6x» при постоянном количестве ускорителей по сравнению с поколением Hopper (H100). Самый большой рост наблюдался при генерации изображений и предварительном обучении LLM, где количество параметров и нагрузка на память самые большие. Хотя в бенчмарке проверялась скорость выполнения операций, NVIDIA подчеркнула, что более быстрое выполнение задач означает меньшее время аренды облачных инстансов и более скромные счета за электроэнергию для локальных развёртываний. Хотя компания не публиковала данные об энергоэффективности в этом бенчмарке, она позиционировала Blackwell как «более экономичное» решение на основе достигнутых показателей, предполагая, что усовершенствования дизайна тензорных ядер обеспечивают лучшую производительность на Ватт, чем у поколения Hopper. Также HPCwire отметил, что NVIDIA была единственным поставщиком, представившим результаты бенчмарка предварительной подготовки LLM на основе Llama 3.1 405B, установив начальную точку отсчёта для обучения с 405 млрд параметров. Это важно, поскольку некоторые компании уже выходят за рамки 70–80 млрд параметров для передовых ИИ-моделей. Демонстрация проверенного рецепта работы с 405 млрд параметров даёт компаниям более чёткое представление о том, что потребуется для создания ИИ-моделей следующего поколения. В ходе пресс-конференции Дэйв Сальватор (Dave Salvator), директор по ускоренным вычислительным продуктам в NVIDIA, ответил на распространенный вопрос: «Зачем фокусироваться на обучении, когда в отрасли в настоящее время все внимание сосредоточено на инференсе?». Он сообщил, что тонкая настройка (после предварительного обучения) остается ключевым условием для реальных LLM, особенно для предприятий, использующих собственные данные. Он обозначил обучение как «фазу инвестиций», которая приносит отдачу позже в развёртываниях с большим объёмом инференса. Этот подход соответствует более общей концепции «ИИ-фабрики» компании, в рамках которой ускорителям даются данные и питание для обучения моделей. А затем производятся токены для использования в реальных приложениях. К ним относятся новые «токены рассуждений» (reasoning tokens), используемые в агентских ИИ-системах. NVIDIA также повторно представила результаты по Hopper, чтобы подчеркнуть, что H100 остаётся «единственной архитектурой, кроме Blackwell», которая показала лидерские показатели по всему набору MLPerf Training, хотя и уступила Blackwell. Поскольку инстансы на H100 широко доступны у провайдеров облачных сервисов, компания, похоже, стремится заверить клиентов, что существующие развёртывания по-прежнему имеют смысл. AMD, со своей стороны, продемонстрировала прирост производительности поколения чипов. В тесте Llama2 70B LoRA она показала 30-% прирост производительности AMD Instinct MI325X по сравнению с предшественником MI300X. Основное различие между ними заключается в том, что MI325X оснащён почти на треть более быстрой памятью. В самом популярном тесте, тонкой настройке LLM, AMD продемонстрировала, что её новейший ускоритель Instinct MI325X показывает результаты наравне с NVIDIA H200. Это говорит о том, что AMD отстает от NVIDIA на одно поколение, отметил ресурс IEEE Spectrum. AMD впервые представила результаты MLPerf Training, хотя в предыдущие годы другие компании представляли результаты в этом тесте, используя ускорители AMD. В свою очередь, Google представила результаты лишь одного теста, задачи генерации изображений, с использованием Trillium TPU. Тест MLPerf также включает тест на энергопотребление, измеряющий, сколько энергии уходит на выполнение каждой задачи обучения. В этом раунде лишь Lenovo включила измерение этого показателя в свою заявку, что сделало невозможным сравнение между компаниями. Для тонкой настройки LLM на двух ускорителях Blackwell требуется 6,11 ГДж или 1698 КВт·ч — примерно столько энергии уходит на обогрев небольшого дома зимой.

30.05.2025 [09:34], Руслан Авдеев

Microsoft закрепляет лидерство в сфере ИИ, предлагая клиентам почти 2 тыс. моделей, в том числе от конкурентовКомпания Microsoft сделала серьёзную заявку на мировое лидерство в сфере искусственного интеллекта, в своё время инвестировав $13 млрд в стартап OpenAI. Позже компания использовала GPT-модели OpenAI в качестве основы для собственного бота Copilot AI, интегрировав его во многие свои продукты, а теперь вышла на новый уровень, сообщает Computer World. Компания запустила хостинг LLM и ИИ-сервисов крупнейших в мире ИИ-компаний и стартапов, включая собственных конкурентов — всего более 1900 моделей, от Llama AI (Meta✴) до разработок xAI и европейских стартапов Mistral и Black Forest Labs, а также китайского DeepSeek и др. Другими словами, даже если Copilot не оправдает ожиданий Microsoft в полной мере, она в какой-то степени разделит и успехи своих конкурентов и, вероятно, останется крупнейшей в мире ИИ-компанией. ЦОД Microsoft стали залогом её успеха на рынке искусственного интеллекта. Благодаря сделке с OpenAI сама Microsoft получает отчисления от каждого подписчика OpenAI. Для монетизации ИИ-решений в 2023 году Microsoft запустила сервис Azure OpenAI, позволяющий клиентам Azure создавать приложения с использованием моделей OpenAI. По некоторым данным, в сервисе зарегистрировано около 60 тыс. клиентов.

Источник изображения: Craig Sybert/unsplash.com Бизнес компании растёт и благодаря договорённостями с другими ИИ-разработчиками. В середине мая Microsoft объявила о размещении моделей Grok в сервисе Azure AI Foundry. Кроме того, в облаке Microsoft размещены и другие популярные модели. Таким образом, Microsoft получает больше денег даже в том случае, когда конкуренты добиваются новых успехов. Недавно компания подробно рассказала о видении того, каким образом компании смогут создавать ИИ-агентов для выполнения широкого спектра задач. В центре внимания — Azure AI Foundry, позволяющий клиентам создавать ИИ-агентов, использую любую из почти 2 тыс. моделей и объединяя их возможности, в том числе, например, для работы на GutHub. Другими словами, заказчикам не придётся подписываться на использование моделей у каждой из компаний по отдельности.

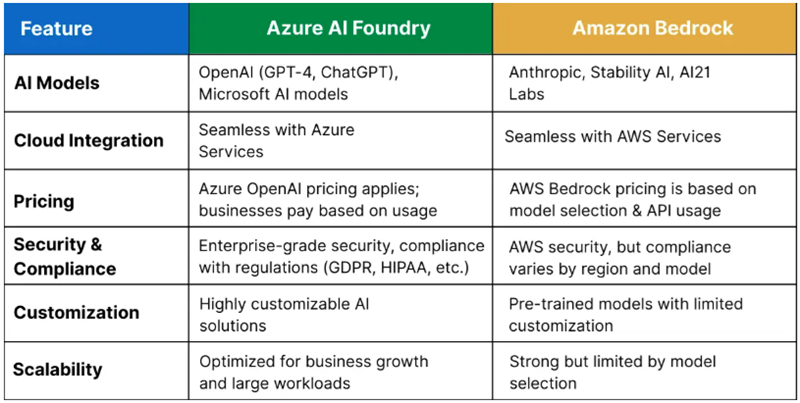

Источник изображения: Q Service Хотя крупнейшим облачным оператором в мире является Amazon (AWS), Microsoft постепенно сокращает разрыв, а подобные площадки для работы с разными ИИ-моделями обеспечивают ей большую фору. Amazon с аналогом Azure AI Foundry — Amazon Bedrock пыталась повторить нечто подобное, но ИИ-моделей у неё гораздо меньше. Высока вероятность, что в этой схватке первенство останется за Microsoft. По расчётам экспертов Q Services, предложение Bedrock лучше подходит разве что для стартапов и компаний, занимающихся разработкой, а Microsoft доминирует на более широком рынке, в том числе сотрудничая с крупными корпорациями. Большое преимущество компании — в использовании всех продуктов, от Microsoft 365 до Azure для продажи существующим клиентам сервисов Azure AI Foundry. У Amazon такая уникальная возможность отсутствует.

02.04.2025 [11:04], Владимир Мироненко

MTS AI выпустила ИИ-модель Cotype Pro 2, которая станет основой ИИ-агентов для бизнесаКомпания MTS AI, дочерняя структура МТС, сообщила о выходе большой языковой модели (LLM) Cotype Pro 2 второго поколения, предназначенной для корпоративного сегмента. Новая модель значительно превосходит по целому ряду показателей предыдущую версию, адаптирована под выполнение более чем 100 сценариев использования компаниями в России и может быть запущена на собственной инфраструктуре предприятия без подключения к внешним серверам, чем обеспечивается защита от утечки данных. На основе Cotype Pro 2 компания подготовит в 2025–2026 гг. новую линейку ИИ-решений для семи отраслей: госсектора, банков, промышленности, ретейла, телекома, медицины и IT. Сначала будут созданы ИИ-помощники, затем — ИИ-агенты с большей автономностью, способные решать, как общие задачи (HR, клиентская поддержка, документооборот и другие), так и специфичные для каждой из этих отраслей. Cotype Pro 2 вошла в пятерку лучших русскоязычных LLM в бенчмарке MERA от Альянса в сфере ИИ. Она на 40 % быстрее предыдущей версии и на 50 % точнее обрабатывает длинные тексты — до 128 тыс. токенов, что соответствует примерно 900 тыс. символов с пробелами, сообщила компания. По сравнению с предшественником её эффективность в области генерации идей возросла с 44 до 57 %, точность в задаче извлечения информации выросла с 81 до 86 %, в части общения на общие темы зафиксировано улучшение с 55 до 64 %, благодаря чему обеспечивается более плавное и осмысленное взаимодействие. Также осталась на высоком уровне эффективность в классификации — 87 %, отмечены улучшения в суммаризации (с 79 до 85 %) и креативном письме (с 61 до 65 %). Для оценки эффективности сравнивалось количество ответов, схожих или превосходящих по качеству ответы модели GPT-4o. Как отметил директор по LLM-продуктам MTS AI, для ИИ-агентов важно не только работать с большим объёмом информации, но и давать ответы в структурированном виде, понятном другим системам. Чтобы оценить качество таких ответов компания разработала специальный бенчмарк, который включает задания с разным объёмом контекста и разной сложностью. В этом тесте Cotype Pro 2 справилась с 94 % задач, а GPT-4o — с 93 %. Также по данным бенчмарка длинного контекста LIBRA, качество работы Cotype Pro 2 в два раза выше, чем у Cotype Pro на задачах длиной 64 и 128 тыс. токенов (до 500 тыс. символов). В дополнение к выполнению базовых задач Cotype Pro 2 поддерживает «ролевой отыгрыш» — способность вести диалог от лица специалиста, адаптируя стиль общения под особенности профессии, что повышает качество взаимодействия в клиентской поддержке, обучении сотрудников и т.д. Перед анонсом Cotype Pro 2 прошла тестирование в реальных условиях. В течение трёх месяцев она автоматически сортировала обращения в поддержку банка, а для МТС Live создавала описания мероприятий. Также тестирование подтвердило возможность интеграции с инструментами RAG (Retrieval-Augmented Generation) для извлечения информации из баз знаний с генерацией текста, что будет востребовано, например, в чат-ботах, где нужно регулярно обновлять данные и в течение нескольких секунд предоставлять ответы на запросы. Как сообщили в MTS AI ресурсу Forbes, семейство корпоративных отраслевых ИИ-агентов, над которыми сейчас ведётся работа, будет, в частности, включать следующие решения:

Сообщается, что МТС также начала предоставлять консалтинговые услуги по внедрению ИИ-продуктов в эти сферы. Как ожидает компания, к 2027 году коммерциализация ИИ-агентов будет приносить её ИИ-направлению более половины выручки.

31.03.2025 [14:20], Сергей Карасёв

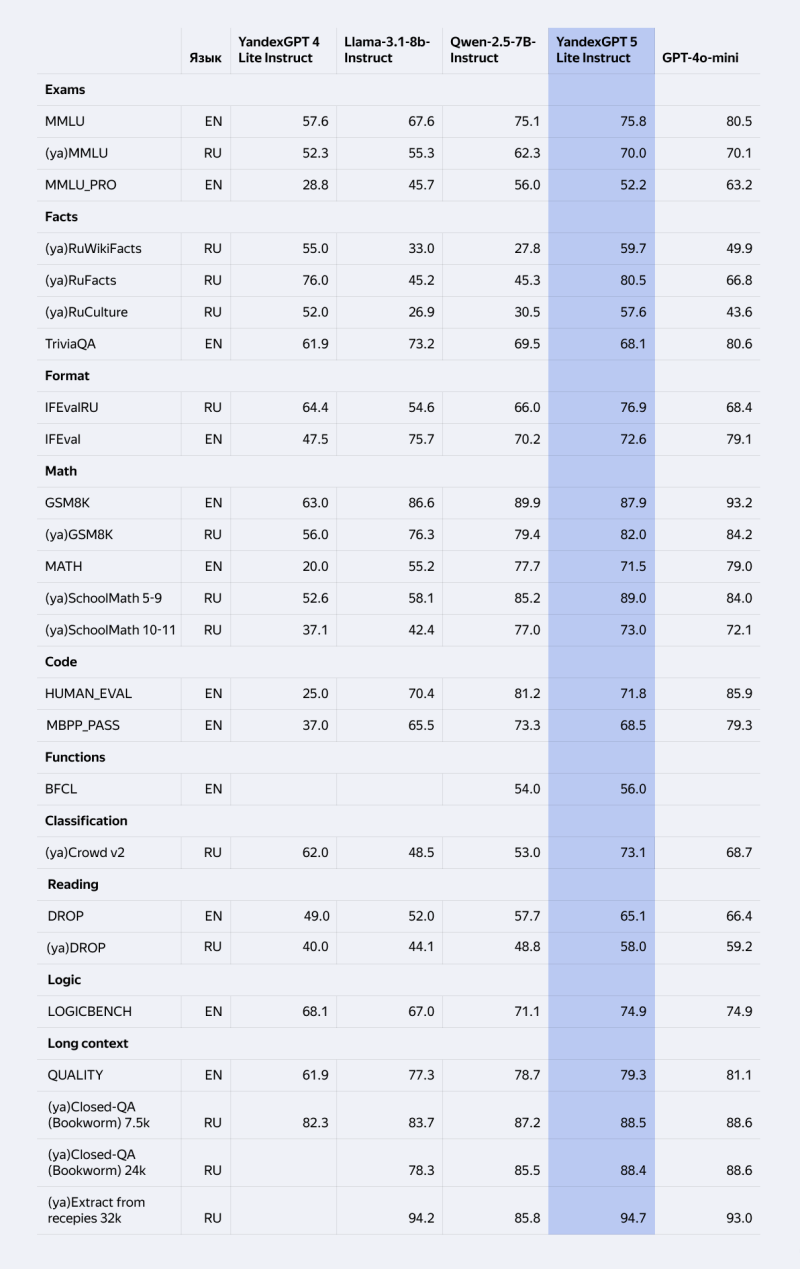

«Яндекс» выпустил открытую ИИ-модель YandexGPT 5 Lite: её можно запускать на обычной рабочей станцииКомпания «Яндекс» сообщила о появлении в открытом доступе Instruct-версии ИИ-модели YandexGPT 5 Lite: применять её можно в некоммерческих и в коммерческих целях. Благодаря сравнительно низким требованиям к оборудованию опробовать модель можно на обычном компьютере без специального оборудования. Модель подверглась стандартному обучению на больших объёмах данных, а также прошла дополнительный этап настройки — так называемое выравнивание (alignment). Это позволяет ей решать конкретные задачи по запросам или инструкциям. Для сравнения: другую открытую версию YandexGPT 5 Lite — Pretrain — пользователям нужно дообучать под свои потребности. Instruct-модификация YandexGPT 5 Lite насчитывает 8 млрд параметров и поддерживает контекст до 32 тыс. токенов. Говорится о совместимости с библиотекой llama.cpp и поддержке GGUF-формата (GPT-Generated Unified Format). По результатам международных тестов и их адаптаций для русского языка (MMLU, IFEval, RuFacts и других) модель соперничает с китайской Qwen2.5-7B-Instruct, превосходя её в таких сценариях, как задачи классификации и разметки текстов, знание русской культуры и фактов, умение отвечать в заданном формате. Более того, YandexGPT 5 Lite Instruct сравнима по качеству ответов с GPT-4o Mini в решении стандартных задач сервисов «Яндекса». Благодаря обновлённой лицензии YandexGPT 5 Lite применять модель можно в коммерческих проектах, если объём выходных токенов не превышает 10 млн в месяц. Утверждается, что этого достаточно для создания и поддержки чат-ботов на небольших и средних сайтах, для генерации описаний товаров в интернет-магазинах с ограниченным ассортиментом, для автоматизации ответов клиентам в сервисных центрах или для анализа отзывов пользователей на площадках с умеренным трафиком. Модель YandexGPT 5 Lite Instruct доступна бесплатно исследователям и разработчикам на Hugging Face. Бизнес-пользователям доступ предоставляется через API в Yandex Cloud: при этом можно дообучить модель для конкретных задач. Причём API стал совместим с OpenAI API: теперь модели «Яндекса» можно использовать с библиотеками OpenAI на Python, JavaScript и других языках программирования. Упрощена интеграция с популярными решениями для работы с технологиями машинного обучения: например, с платформой для запуска ИИ-ассистентов AutoGPT и с инструментом для создания приложений на базе нейросетей LangChain. Пользователи могут протестировать модель в чате с «Алисой».

24.03.2025 [11:59], Руслан Авдеев

OpenAI и Meta✴ ведут переговоры с индийской Reliance Jio о сотрудничестве в сфере ИИMeta✴ и OpenAI по отдельности ведут переговоры с индийской Reliance Industries о потенциальном сотрудничестве для расширения ИИ-сервисов, сообщает The Information. Так, OpenAI хотела бы при помощи Reliance Jio расширить использование ChatGPT в Индии — об этом изданию сообщили два независимых источника, знакомых с вопросом. Более того, OpenAI обсуждала с сотрудниками сокращение стоимости подписок на платный вариант ChatGPT с $20/мес. до всего нескольких долларов. Пока неизвестно, велись ли разговоры об этом в ходе переговоров с Reliance. С последней, как утверждается, обсуждали продажу ИИ-моделей OpenAI корпоративным клиентам (через API). Также индийская компания заинтересована в локальном хостинге моделей OpenAI, чтобы данные местных клиентов будут храниться в пределах Индии. По имеющимся данным, с OpenAI и Meta✴ велись переговоры о запуске ИИ-моделей компаний в 3-ГВт ЦОД, который Reliance пока только планирует построить. Утверждается, что это будет «крупнейший дата-центр в мире» — его возведут в Джамнагаре (штат Гуджарат). Стоит отметить, что Reliance Industries является одним из крупнейших конгломератов Индии, имеющих интересы как в нефтегазовой отрасли, так и в IT и смежных отраслях, а также в сфере «зелёной» энергетики.

Источник изображения: Shivam Mistry/unsplash.com Индия в целом считается очень перспективной страной для развития инвестиций в ИИ. Например, в конце прошлого года глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что страна должна стать одним из лидеров в области ИИ и создать собственную инфраструктуру. Тогда сообщалось, что Индия на государственном уровне обсуждает с NVIDIA совместную разработку чипов для ИИ-проектов, адаптированных к местным задачам. Также страна осваивает связанные с ИИ технологии — например, она затратит $1,2 млрд на суверенный ИИ-суперкомпьютер с 10 тыс. ускорителей и собственные LLM, а также готова покупать много ускорителей, включая ослабленные варианты, которые не достались Китаю после ужесточения американских санкций. И это далеко не все проекты, находящиеся сейчас на стадии разработки и реализации. |

|