Материалы по тегу: hardware

|

25.12.2024 [13:10], Сергей Карасёв

Wistron расширит мировое присутствие и укрепит производство ИИ-серверовWistron, тайваньский производитель электроники, персональных компьютеров, серверов и СХД, анонсировал стратегический план, нацеленный на укрепление глобального присутствия. Совет директоров одобрил несколько инвестиционных проектов в различных регионах мира. В частности, дочернее предприятие SMS Infocomm Corporation (WTX), находящееся в полной собственности Wistron, вложит $25 млн в развитие площадки в Техасе (США), которая специализируется на послепродажном обслуживании. Ожидается, что обновленный объект в перспективе будет использоваться для производства серверов ИИ. Во Вьетнаме дочерняя структура Wistron InfoComm Vietnam (WVN) планирует приобрести около 37,1 га земли у компании Kim Bang Industrial Development Investment Construction Co., Ltd. Речь идёт о территории неподалёку от существующего объекта Wistron. Покупка дополнительных площадей необходима для диверсификации производственных возможностей: Wistron планирует выпускать во Вьетнаме серверные продукты, мониторы и ПК. Бюджет проекта составляет $37,1 млн. При этом будет сформирована дочерняя компания Wistron Property c уставным капиталом в размере $16,5 млн, которая займётся строительством зданий для сотрудников, включая общежития. Wistron после продажи своего индийского завода компании Tata Group намерена продолжить деятельность на местном рынке по направлению послепродажного обслуживания. Для строительства соответствующего предприятия будет инвестировано $20 млн в фирму ICT Service Management Solutions (India) Private Limited (WIN) через структуру SMS InfoComm Singapore Pte. Ltd. (WSSG). Обе эти организации являются дочерними компаниями Wistron. Таким образом, общий объём вложений в трёх регионах составит около $100 млн. О сроках реализации проектов ничего не сообщается.

25.12.2024 [13:05], Сергей Карасёв

Compal представила сервер SD220-8 с «высокоточной» погружной СЖО Intel Targeted Flow

compal electronics

emerald rapids

hardware

intel

sapphire rapids

xeon

погружное охлаждение

сервер

сжо

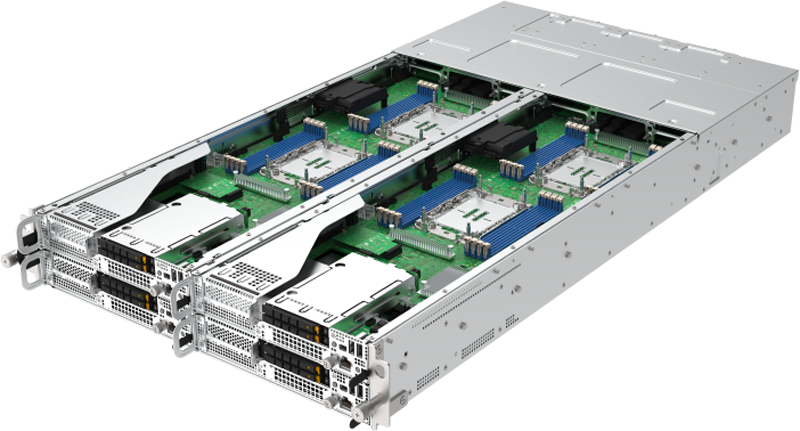

Компания Compal Electronics, по сообщению ресурса DigiTimes, объединила усилия с Intel, BP Castrol, JWS и Priver Technology с целью создания решений с передовой системой жидкостного охлаждения Targeted Flow. Эта технология применяется во флагманском сервере SD220-8. Инновационная СЖО использует запатентованную технологию Intel Targeted Flow, включая проприетарные резервуар Targeted Flow Tank и теплоотвод Targeted Flow Heat Sink. В последнем задействованы специальные методы для направления охлаждающей жидкости именно в те зоны процессора, которые имеют самую высокую температуру. Такой подход гарантирует максимальную эффективность охлаждения и минимизирует вероятность перегрева. В СЖО применяется улучшенная охлаждающая жидкость BP Castrol DC 20 — это синтетический углеводородный диэлектрический хладагент с низкой вязкостью и хорошей текучестью. Применённая система охлаждения допускает повторное использование сгенерированного тепла.

Источник изображений: Compal Сервер SD220-8 представляет собой четырёхузловое решение в форм-факторе 2U. Каждый узел может нести на борту два процессора Intel Xeon Sapphire Rapids или Emerald Rapids, а также 16 модулей DDR5-5600 (L)RDIMM. Во фронтальной части узлов могут быть установлены четыре SFF-накопителя SATA/SAS/NVMe U.2. Кроме того, есть два внутренних коннектора для SSD M.2 2280. Предусмотрен разъём OCP 3.0, а также один или два слота (в зависимости от конфигурации — два или четыре фронтальных SSD) для карт PCIe 5.0 x16 HHHL.  Узлы располагают контроллером BMC/CMC Aspeed AST 2600/2620, опциональным модулем TPM 2.0, портом USB 3.2 Gen1 Type-A. Сервер комплектуется четырьмя блоками питания мощностью 1600 Вт с сертификатом 80 Plus Platinum/Titanium.

25.12.2024 [12:55], Сергей Карасёв

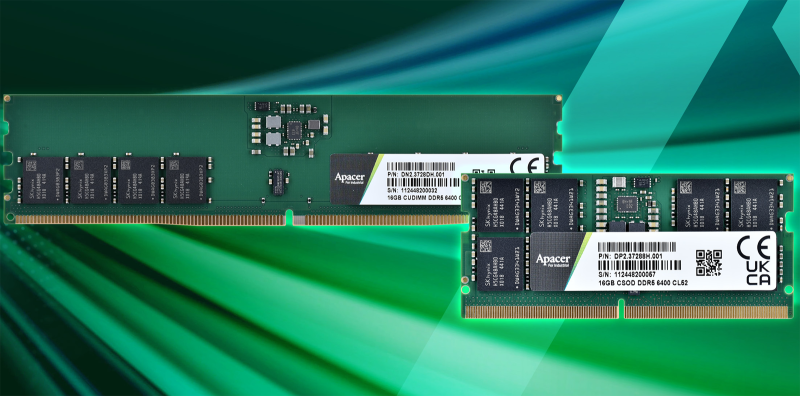

Apacer представила индустриальные модули DDR5-6400 CU-DIMM и CSO-DIMMКомпания Apacer Technology объявила о начале массового производства модулей оперативной памяти DDR5-6400 индустриального класса, спроектированных специально для задач ИИ и НРС. Изделия могут применяться в системах автоматизации, медицинском оборудовании, IoT-устройствах, интеллектуальных автомобильных платформах и пр. Представлены решения DDR5-6400 стандартов CU-DIMM (Clocked Unbuffered DIMM) и CSO-DIMM (Clocked Small Outline DIMM). Они функционируют при напряжении 1,1 В. Ёмкость модулей составляет 8, 16, 32 и 64 Гбайт. По заявлениям Apacer Technology, в конструкции изделий применяются компоненты высокого качества. Упомянуты полностью бессвинцовые резисторы. Кроме того, модули удовлетворяют новейшим стандартам JEDEC Raw Card Revision 1.0, обеспечивая стабильность передачи данных и высокую производительность. Для изделий в качестве опции доступно специальное конформное покрытие, предназначенное для защиты от негативного влияния факторов окружающей среды: повышенных температур, влаги, загрязнений, химических веществ и механических воздействий. Диапазон рабочих температур простирается от 0 до +85 °C. Кроме того, может быть добавлена защита от сульфирования. Сера широко используется во многих отраслях промышленности. Когда серебряные сплавы в DRAM-чипах подвергаются воздействию сернистых газов, происходит коррозионная реакция: сульфирование приводит к снижению проводимости и быстрому выходу изделий из строя. Для решения проблемы Apacer применяет запатентованную технологию.

24.12.2024 [21:50], Руслан Авдеев

xAI одобрили 150-МВт подключение к энергосети, хотя местные жители опасаются роста цен и перебоев с поставками электричестваИИ-кластер xAI Colossus получил «второе дыхание». Энергоснабжающая компания Tennessee Valley Authority (TVA) решила выделить ему 150 МВт мощностей. Это значительно расширяет возможности вычислительного центра, сообщает TechRadar. В частности, теперь можно запитать от энергосети все 100 тыс. ИИ-ускорителей NVIDIA H100. Ранее такая возможность ставилась под вопрос из-за энергетических ограничений. Местные компании выражали озабоченность тем, как огромное эгнергопотребление скажется на электросети Теннесси. Когда xAI впервые запустила кластер в июле 2024 года, ему было доступно лишь 8 МВт. Поэтом временно для питания задействовали генераторы, дополненные энергохранилищами Tesla Megapack. Летом местная коммунальная компания Memphis Light, Gas & Water (MLGW) обновила имевшуюся подстанцию, чтобы обеспечить xAI подачу 50 МВт. А xAI обязалась построить за $24 млн собственную подстанцию на 150 МВт. Суперкомпьютеру Colossus для эксплуатации всех 100 тыс. ускорителей одновременно требуется около 155 МВт. MLGW и TVA пришлось убеждать местных жителей, рост спроса на энергию со стороны xAI не повлияет на надёжность электроснабжения в районе Мемфиса. По словам MLGW, 150 МВт всё ещё находятся ниже допустимого предела прогнозируемой пиковой нагрузки компании. Предпринимаются меры по обеспечения закупок электричества у TVA, если это будет необходимо. Местные экоактивисты и жители уже жалуются, что совет директоров TVA одобрил запрос xAI на энергию, не изучив последствия такого решения для жителей. Не исключено, что решение негативно скажется на ценах для физических лиц, хотя именно их интересы должны были бы быть в приоритете. В начале декабря сообщалось, что xAI получила ещё $6 млрд инвестиций и приступила к расширению Colossus до 1 млн ускорителей.

24.12.2024 [21:00], Сергей Карасёв

«Гравитон» выпустил первый GPU-сервер на российском процессоре для ИИ и НРСРоссийский производитель вычислительной техники «Гравитон» объявил о начале поставок сервера С2124Б. Это, как утверждается, первое устройство на отечественном процессоре, специально предназначенное для задач ИИ и НРС, включая работу с языковыми моделями. Новинка выполнена в форм-факторе 4U. Задействованы два неназванных 48-ядерных процессора с тактовой частотой 2 ГГц. Поддерживается оперативная память DDR4-3200 ECC. Сервер допускает установку до восьми ускорителей на базе GPU с показателем TDP до 350 Вт: их подключение осуществляется через переходную плату со встроенными PCIe-экспандерами. Могут применяться полноразмерные двухслотовые решения с интерфейсом PCIe 4.0 x16. Заявленная производительность достигает 480 Тфлопс в режиме FP64 и 26,726 Пфлопс в режимах FP8 и INT8. Во фронтальной части С2124Б могут быть размещены до 12 накопителей с интерфейсом SATA или до 12 устройств формата U.3 (NVMe). Кроме того, на лицевую панель выведены гнёзда RJ-45 для сетевых кабелей, а также порты USB Type-A. Питание обеспечивают четыре блока мощностью 1600 Вт каждый в режиме 3+1 или 2+2. «Нам удалось разработать и произвести серверы, так необходимые для сложных вычислений, на отечественном процессоре. Этот продукт станет важным шагом в развитии отечественных вычислительных технологий и позволит нашим клиентам эффективно справляться с вызовами в области обработки данных», — говорит Александр Фильченков, руководитель серверных и сетевых систем «Гравитон». Сервер планируется внести в Реестр российской промышленной продукции Минпромторга России в начале 2025 года: он будет причислен к категории радиоэлектронной продукции 1-го уровня локализации. Приём заказов на новинку уже начался. Потенциальным покупателям также предлагается оформить заявку на тестирование устройства.

24.12.2024 [13:01], Руслан Авдеев

Бразильские власти одобрили создание гигантского «ИИ-города» Scala Data CentersБразильский город Эльдораду-ду-Сул (штата Риу-Гранди-ду-Сул) принял закон, разрешающий строительство кампуса ЦОД AI City компании Scala Data Centers. Документ позволяет изменить городское зонирование и упростит бюрократические процедуры для «мегакомплекса», сообщает пресс-служба оператора. По последним данным, периметр городского зонирования будет расширен, чтобы включить предложенную площадку, предназначенную для строительства кампуса. Муниципалитет одобрил закон 3 декабря 2024 года, а 18 декабря он был окончательно утверждён. Предполагается, что проект позволит создать 3 тыс. рабочих мест — напрямую или косвенно. На начальном этапе предполагается инвестировать R$3 млрд ($490 млн), ёмкость составит 54 МВт. Суммарные инвестиции в проект могут достичь $90 млрд. Весь кампус AI City площадью 700 га в конечном итоге обеспечит ёмкость 4,75 ГВт. Относительно умеренный климат юга Бразилии позволяет обеспечить лучшие показатели PUE в латинской Америке на уровне 1,2, а индекс использования воды WUE и вовсе равен нулю, поскольку её применение в системах охлаждения не предусмотрено. Ожидается, что появление кампуса положительно скажется на экономике штата, в частности, секторе возобновляемой энергетики, за счёт которой ЦОД будут снабжаться на 100 %. По мнению местных чиновников, он дополнительно ускорит внедрение ветряных электростанций, что тоже очень важно для штата, поскольку масштабирование проекта ЦОД привлечёт инвестиции и в энергетику для удовлетворения потребностей дата-центров. В регионе уже имеются компании, заинтересованные в поставках возобновляемой энергии для нового кампуса. В августе Scala анонсировала инвестиции в компанию Serena Energia для поставки энергии ветряных электростанций. Основанная в 2020 году после покупки DigitalBridge имущества бразильской IT-компании UOL Diveo, Scala инвестировала около $1,6 млрд в дата-центры гиперскейл-уровня в Бразилии, Чили, Мексике и Колумбии. Ранее в 2024 году компания получила $500 млн на развитие от внешних инвесторов. О создании AI City сообщалось ещё в сентябре, но только теперь проект был официально одобрен и получил законодательную поддержку.

24.12.2024 [12:18], Руслан Авдеев

США планируют внести в чёрный список компанию Sophgo — она подозревается в выпуске на TSMC ИИ-чипов в интересах HuaweiАдминистрация действующего президента США Джо Байдена (Joe Biden) намерена внести в чёрный список компанию из КНР, якобы разработавшую и заказавшую у TSMC чипы, использовавшиеся в ИИ-решениях Huawei. Последняя применяла их в ускорителях Ascend 910B, сообщает Reuters. Речь идёт о китайской Sophgo, дочерней структуры поставщика оборудования для майнинга Bitmain. Это последняя в списке компаний, которые США намерены наказать за помощь Huawei. Сейчас она находится на очереди для включения в «чёрный список» Entity List, куда отправляются компании, например, угрожающие национальной безопасности или внешнеполитическим интересам Соединённых Штатов. В этом месяце Министерство торговли США уже внесло в чёрный список ряд других компаний, посчитав их частью «теневой сети» китайского техногиганта. Представители американских властей ситуацию не комментируют, а Sophgo ещё в октябре заявляла, что никогда не была прямо или косвенно вовлечена в дела с Huawei. Согласно открытым данным, компания является поставщиком китайских органов власти и государственных компаний вроде China Telecom. Также её ИИ-чипы закупались государственными университетами для разработки ИИ-инструментов и полицией для совершенствования систем видеонаблюдения.

Источник изображения: Huawei Компания TechInsights разобрала ИИ-ускоритель Huawei 910B и помимо прочего обнаружила в нём чип производства TSMC, а тот уже донёс сведения до Министерства торговли США. После того как выяснилось, что собственно разработкой занималась Sophgo, TSMC прекратила её поставки. С Huawei сотрудничество TSMC прекратилось ещё в 2020 году. В TSMC отказываются комментировать результаты расследования, но, по данным Reuters, 11 ноября США просто приказали компании прекратить поставки в Китай передовых чипов, выполненных в соответствии с техпроцессом до 7 нм включительно — те модели, которые можно использовать для ИИ. В октябре Huawei объявила, что не выпускала никаких чипов с помощью TSMC с 2020 года и отказалась комментировать последние новости. Ускоритель компании Ascend 910B, выпущенный в 2022 году, считается её самым передовым вариантом. В начале 2025 года Huawei намерена начать выпуск чипов модели Ascend 910C, конкурента NVIDIA H100. В феврале сообщалось, что Sophgo договорилась с российской Softlogic о поставках последней тензорных ИИ-процессоров.

24.12.2024 [12:07], Сергей Карасёв

«Аэродиск» организовал серийное производство СХД на мощностях «Аквариуса» в ТвериРоссийский разработчик аппаратных решений и систем виртуализации «Аэродиск» объявил о запуске серийного производства СХД на предприятии «Аквариуса» в Твери. Отмечается, что данное событие знаменует собой новый этап сотрудничества между двумя компаниями. «Аэродиск» предлагает СХД разного уровня, построенные на платформе «Аквариуса». Это, в частности, решения среднего класса Engine AQ 440/450/460, а также устройства начального уровня Engine AQ Лайт с гибридной и All-Flash конфигурациями. Кроме того, доступны модели high-end на основе NVMe SSD. Летом 2023 года «Аквариус» приобрёл долю в размере 67,8 % в «Аэродиске»: тогда говорилось, что бренд и структура этой организации будут сохранены. Ресурсы тверской площадки «Аквариуса» позволят «Аэродиску» на первом этапе выпускать до 500 СХД в год. Это в пять раз превышает возможности предыдущей производственной линии: ранее устройства изготавливались на мощностях «Аэродиска», которые позволяли достигать показателя в 100 СХД в год на пике. Этого, как отмечается, недостаточно для удовлетворения растущего спроса со стороны заказчиков в условиях активного импортозамещения. В перспективе объём выпуска СХД на заводе в Твери планирует утроить, доведя его до 1500 единиц в год. На этом объекте готовится внедрение автоматизированной системы тестирования СХД, которая, помимо проверки качества оборудования, обеспечит автоматическую установку софта на системы с помощью централизованного сервера. Работа ведётся в рамках организации полного производственного цикла готовых программно-аппаратных комплексов (ПАК). Собственная площадка «Аэродиска» будет трансформирована в центр исследований и разработок для создания новых продуктов и подготовки их перевода в массовый выпуск. «Мы всегда ориентируемся на долгосрочные цели. Новая площадка в Твери — важный шаг к технологическому развитию, полному циклу создания аппаратных платформ, а также ключевой элемент для дальнейшего масштабирования производства наших СХД. В дальнейшем в Твери будет запущена полноценная конвейерная линия для реализации всех этапов производства СХД», — отмечает глава компании «Аэродиск».

23.12.2024 [18:05], Руслан Авдеев

Из-за внедрения СОРМ российские хостинг-провайдеры начнут 2025 год с повышения ценХостинг-провайдеры России намерены повысить стоимость своих услуг. Хотя сами они мотивируют рост цен необходимостью внедрения систем оперативно-розыскных мероприятий (СОРМ) в интересах силовых ведомств, производители СОРМ уверены, что их продукция тут ни при чём, а желание поднять цены вызвана другими причинами, сообщает «Коммерсантъ». Источники СМИ сообщают, что цены «вынужденно» вырастут на 5 % или даже 10 %, а в некоторых случаях речь может идти и о 15 %. Утверждается, что рост стоимости обслуживания клиентов позволит компенсировать обязательное в следующем году внедрение СОРМ. Влияние окажут и грядущие изменения налоговой системы. С 1 февраля 2024 года компаниям, не включившимся в общероссийский реестр хостинг-провайдеров, запрещено оказывать услуги на территории страны. Закон о создании реестра принят ещё в 2023 году, а летом того же года приняты изменения в федеральные законы «Об информации» и «О связи», обязывавшие провайдеров вносить в реестр данные о компаниях. Кроме того, они должны размещать технические мощности на территории России и иметь возможности для защиты информации, а также устанавливать СОРМ. По мнению экспертов, программная реализация СОРМ стоит 5–10 млн руб. Для программно-аппаратного комплекса (ПАК) придётся покупать сертифицированное оборудование. Стоимость технической поддержки и модернизации системы может составить до 30 % от цены самой СОРМ. Кроме того, возрастут административные расходы, затраты на каналы связи для СОРМ и т.д. Однако, как отмечает один из производителей ПАК для СОРМ, внедрение таких систем только началось, что не могло повлиять на рост цен хостинг-провайдеров. В Минцифры отрицают роль в контроле цен на СОРМ, и не участвуют в их реализации, но подчёркивают, что ещё не получали жалоб на рост цен на соответствующие решения от хостинг-провайдеров или операторов связи. В министерстве обещают «выяснить вопрос». Одновременно за ценами следит и Федеральная антимонопольная служба (ФАС), проверки оперативно проводятся при подозрении на нарушение законов. Внедрением СОРМ занимаются и другие игроки рынка. В сентябре 2023 года принят закон, из-за которого на два порядка выросла цена получения лицензии для операторов связи. Цель нового закона состояла в том, чтобы предотвратить выход на рынок РФ операторов, не выполняющих обязательные лицензионные требования в части внедрения оборудования СОРМ.

23.12.2024 [17:20], Сергей Карасёв

Половину выручки от строительства дата-центров в России обеспечивает госсекторВ 2024 году затраты госструктур на создание ЦОД в России составили приблизительно 60 млрд руб. Примерно столько же израсходовано на строительство коммерческих дата-центров. Таким образом, госсектор занял половину соответствующего рынка, сообщает газета «Ведомости». В частности, госструктуры переводят свою инфраструктуру из коммерческих ЦОД в ведомственные. Кроме того, ведётся активное расширение мощностей как на федеральном, так и на региональном уровне. В 2024 году в Южном административном округе Москвы запущен дата-центр «Росатома» «Москва-2» с уровнем надёжности Tier IV. Кроме того, введены в эксплуатацию федеральный ЦОД МВД РФ, единый ЦОД Минприроды и пр. Вместе с тем собственные дата-центры продолжают создавать крупные компании, включая «Ростелеком». В частности, «РТК-ЦОД» («Ростелеком — Центры обработки данных») развернул четвёртую и пятую очереди проекта ЦОД «Москва V» общим объёмом 1024 стойки. О росте интереса к строительству корпоративных площадок заявили в компаниях «Атомдата» (ЦОД-подразделение «Росэнергоатом»), Wildberries, «Газпром», «Сбер», «Т-Банк» и «Северсталь». Корпорациям не хватает вычислительных мощностей, в связи с чем им приходится строить дополнительные объекты. При этом «Сбер», как отмечается, уже не может обходиться 40-МВт дата-центрами и хочет строить объекты мощностью от 200 МВт. В целом, спрос на услуги ЦОД в России продолжают быстро расти, что связано в том числе с уходом зарубежных облачных провайдеров и быстрым развитием сектора ИИ. По оценкам iKS-Consulting, в 2024-м в РФ введено около 12 тыс. новых стойко-мест на коммерческих площадках. Однако существуют и сдерживающие факторы. Один из них — повышение ключевой ставки Банка России: из-за этого значительно увеличиваются затраты на обслуживание займов для строительства дата-центров и обновление оборудования в ЦОД старше пяти лет. Кроме того, существуют проблемы с поиском территорий для строительства ЦОД большой мощности. Если в 2015 году средняя мощность на стойку составляла 5 кВт, то сейчас показатель достигает 7–7,5 кВт. При этом почти весь объём ресурсов ЦОД сконцентрирован в столичном регионе и стойко-мест не хватает. |

|